资源导航:模型与算力去哪找?

昇腾模型开源仓库 (官方适配版)

针对 NPU 深度优化过的模型(MindSpore 版或 PyTorch 适配版),请优先看这里:

- 昇腾社区 ModelZoo : https://www.hiascend.com/software/modelzoo

算力申请通道

- 算力资源申请链接 : https://ai.gitcode.com/ascend-tribe/openPangu-Ultra-MoE-718B-V1.1?source_module=search_result_model

- 华为云 - 昇腾云服务 : https://www.huaweicloud.com/product/ascend.html

前言

Mistral-7B-Instruct-v0.2 是目前 7B 参数量级中最强的开源模型之一。本文详细记录了如何在 华为昇腾 (Ascend) NPU 环境下,从零开始配置环境、部署模型,并解决 accelerate 依赖报错、多线程资源崩溃、中文乱码以及"模型自问自答"等一系列实战问题,实现一个稳定、高性能的交互式 AI Agent,并简单测试相关性能。

第一步:环境配置 (Environment Setup)

在昇腾 NPU 服务器(如 ModelArts、Atlas 800 等)上运行大模型,基础环境的配置至关重要。

硬件配置:

- 平台: GitCode 云端 Notebook

- 算力资源: NPU Basic (16vCPU, 32GB 内存)

- 镜像环境: Ubuntu 22.04 + Python 3.11 + CANN 8.2

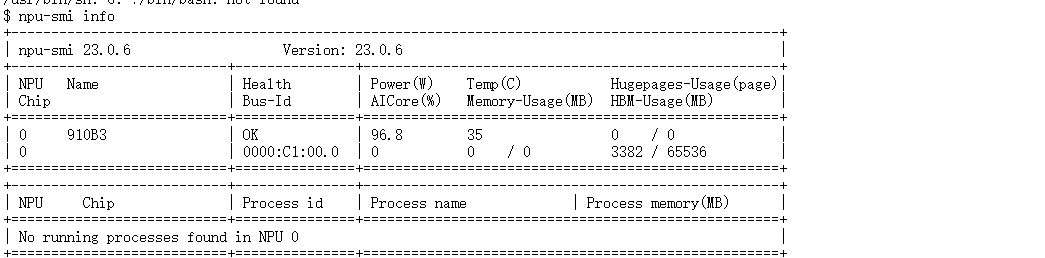

1.1 确认 NPU 状态

首先,确保你的 NPU 驱动和固件正常。在终端执行:

bash

npu-smi info

- 预期结果 :应能看到 NPU 卡的列表,且状态显示为 OK。

1.2 安装必要依赖

虽然昇腾镜像通常预装了 torch_npu,但我们需要安装 Hugging Face 的核心库。

(注:如果环境受限,请确保 transformers 版本 >= 4.34.0 以支持 Mistral)

bash

pip install transformers accelerate sentencepiece protobuf1.3 关键系统变量配置

在容器化或多用户环境下,PyTorch 加载模型时可能会因为试图调用过多 CPU 线程而崩溃(报错 libgomp: Thread creation failed)。

解决方案 :建议直接在 Python 代码入口处配置,或在 .bashrc 中添加:

bash

export OMP_NUM_THREADS=1

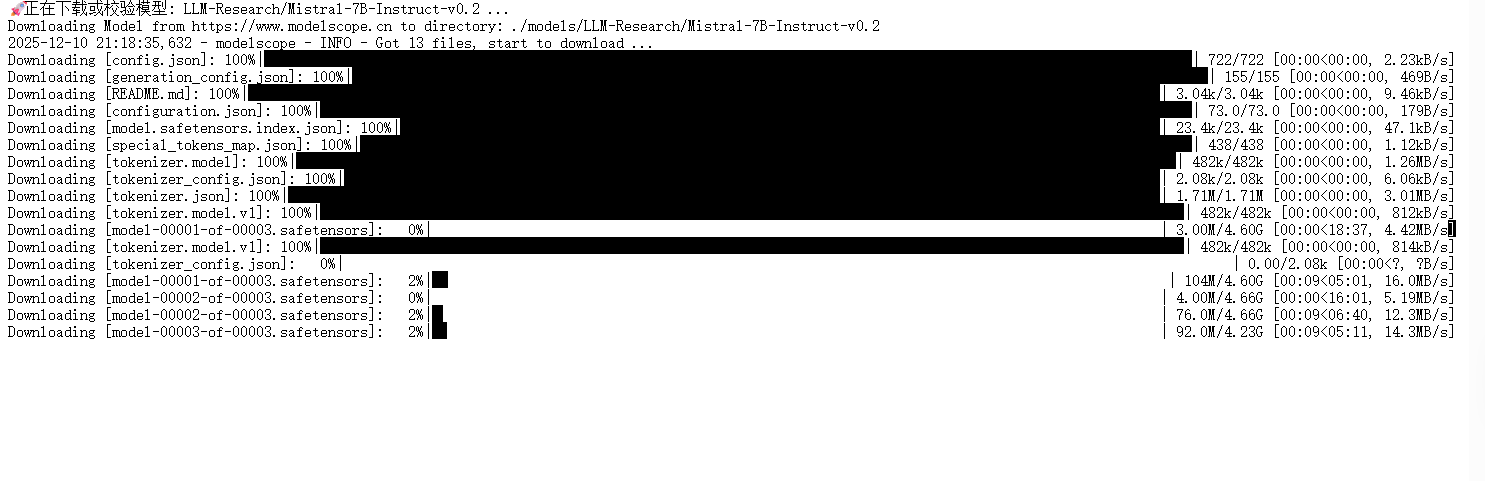

export MKL_NUM_THREADS=11.4 下载模型

bash

pip install modelscope

python

from modelscope import snapshot_download

model_dir = snapshot_download(

'LLM-Research/Mistral-7B-Instruct-v0.2',

cache_dir='./models', # 下载缓存路径

revision='master'

)

print(f"模型已下载到: {model_dir}")

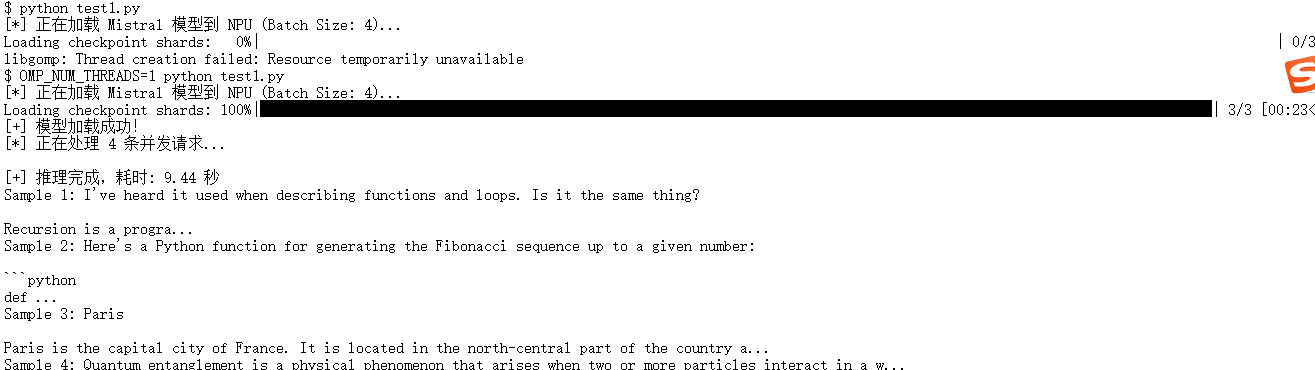

第二步:编写批量推理脚本 (Batch Inference)

这一步的目标是验证模型能否正确加载到 NPU 并进行基础运算。为了最大限度利用 NPU 算力,我们不能使用默认的 device_map="auto",因为它依赖 accelerate 库进行设备调度,在 NPU 上极易报错 ValueError: requires accelerate 。

2.1 核心推理代码 ( inference.py )

请新建 inference.py,并将 MODEL_PATH 修改为你的实际路径。

在 NVIDIA GPU 上,大家习惯了"自动挡"(device_map="auto")。但在 NPU 环境下,自动调度有时会误判设备资源。因此,我们采用"手动挡"方案:

- 显式加载 :使用 .to("npu:0") 明确告诉 PyTorch 把模型搬到 0 号 NPU 卡上 。

- 半精度优化 :使用 torch.float16 加载。昇腾 Atlas 800T NPU 对 FP16 的支持极佳,显存占用减半且速度翻倍 。

Python

python

import torch

import torch_npu # 必须导入,用于支持华为 Ascend NPU

from transformers import AutoTokenizer, AutoModelForCausalLM

import time

# --- 配置模型路径 ---

MODEL_PATH = "models/LLM-Research/Mistral-7B-Instruct-v0___2"

def run_batch_test(batch_size=4):

print(f"[*] 正在加载 Mistral 模型到 NPU (Batch Size: {batch_size})...")

# 1. 加载 Tokenizer

# padding_side='left' 对生成任务至关重要

tokenizer = AutoTokenizer.from_pretrained(MODEL_PATH, trust_remote_code=True, padding_side='left')

if tokenizer.pad_token is None:

tokenizer.pad_token = tokenizer.eos_token

# 2. 加载模型 (核心修复部分)

try:

model = AutoModelForCausalLM.from_pretrained(

MODEL_PATH,

dtype=torch.float16, # 使用半精度以节省显存

trust_remote_code=True,

low_cpu_mem_usage=True

).to("npu:0") # 显式加载到 NPU 0 卡

except Exception as e:

print(f"[!] 模型加载失败: {e}")

return

model.eval()

print("[+] 模型加载成功!")

# 3. 构造测试数据

prompts = [

"Please explain the concept of recursion.",

"Write a Python function for Fibonacci sequence.",

"What is the capital of France?",

"Explain quantum entanglement."

]

# 4. 编码与推理

print(f"[*] 正在处理 {len(prompts)} 条并发请求...")

inputs = tokenizer(prompts, return_tensors="pt", padding=True, truncation=True, max_length=512).to("npu:0")

start_time = time.time()

with torch.no_grad():

generated_ids = model.generate(

inputs.input_ids,

attention_mask=inputs.attention_mask,

max_new_tokens=128,

do_sample=True,

temperature=0.7,

pad_token_id=tokenizer.pad_token_id

)

end_time = time.time()

# 5. 输出结果

decoded_outputs = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)

print(f"\n[+] 推理完成,耗时: {end_time - start_time:.2f} 秒")

for i, output in enumerate(decoded_outputs):

print(f"Sample {i+1}: {output[len(prompts[i]):].strip()[:100]}...")

if __name__ == "__main__":

run_batch_test()

第三步:构建交互式 Agent

在跑通基础推理后,我们需要构建一个真正能对话的 Agent,并验证算力是否达到了 设备 的应有水平。

在实现类似 ChatGPT 的终端对话时,我们针对以下两个影响体验的问题进行了修复 :

- 终端中文乱码 :Linux 终端默认编码有时与 Python 解释器不一致,导致输入中文直接报错 UnicodeDecodeError。

- 修复方案 :在代码头部强制重置 sys.stdin 和 sys.stdout 的编码为 utf-8 。

- 模型"自言自语" (Loop) :模型回答完用户问题后,因为没有遇到停止符,会接着扮演用户继续提问,陷入死循环。

- 修复方案 :在 generate 函数中显式传入 eos_token_id(停止符 ID),给模型装上"刹车片" 。

3.1 完整对话代码 ( chat_agent.py )

Python

python

# -*- coding: utf-8 -*-

import os

import sys

import io

# --- 1. 核心修复:强制解决中文报错 ---

# 这一步是为了防止 "UnicodeDecodeError: 'utf-8' codec can't decode..."

# 强制将标准输入和输出设置为 utf-8

sys.stdout = io.TextIOWrapper(sys.stdout.buffer, encoding='utf-8')

sys.stdin = io.TextIOWrapper(sys.stdin.buffer, encoding='utf-8')

# 限制 CPU 线程数

os.environ["OMP_NUM_THREADS"] = "1"

os.environ["MKL_NUM_THREADS"] = "1"

import torch

import torch_npu

from transformers import AutoTokenizer, AutoModelForCausalLM, TextStreamer

# --- 配置 ---

MODEL_PATH = "models/LLM-Research/Mistral-7B-Instruct-v0___2"

def main():

print("[*] 正在加载模型,请稍候...")

# 1. 加载 Tokenizer

try:

tokenizer = AutoTokenizer.from_pretrained(

MODEL_PATH,

trust_remote_code=True,

padding_side='left'

)

if tokenizer.pad_token is None:

tokenizer.pad_token = tokenizer.eos_token

except Exception as e:

print(f"Tokenzier 加载失败: {e}")

return

# 2. 加载模型

try:

model = AutoModelForCausalLM.from_pretrained(

MODEL_PATH,

dtype=torch.float16,

trust_remote_code=True,

low_cpu_mem_usage=True

).to("npu:0")

except Exception as e:

print(f"模型加载失败: {e}")

return

model.eval()

print("\n" + "="*50)

print("🤖 Mistral-7B 对话系统 (中文修复版)")

print("输入 'exit' 退出")

print("="*50)

# --- Agent 人设 ---

system_prompt = "你是一个数据分析助手。请用中文回答问题。"

history = []

while True:

try:

# 这里的 input 之前报错,现在因为上面加了 io.TextIOWrapper 应该修好了

user_input = input("\n👤 User (你): ")

if not user_input.strip(): continue

if user_input.lower() in ["exit", "quit"]:

print("👋 再见!")

break

# 构造 Prompt

if len(history) == 0:

current_content = f"{system_prompt}\n\nUser: {user_input}"

else:

current_content = user_input

history.append({"role": "user", "content": current_content})

text = tokenizer.apply_chat_template(

history,

tokenize=False,

add_generation_prompt=True

)

model_inputs = tokenizer([text], return_tensors="pt").to("npu:0")

print("🤖 Agent: ", end="")

streamer = TextStreamer(tokenizer, skip_prompt=True, skip_special_tokens=True)

# 停止符

terminators = [

tokenizer.eos_token_id,

tokenizer.convert_tokens_to_ids("</s>")

]

with torch.no_grad():

generated_ids = model.generate(

model_inputs.input_ids,

max_new_tokens=512,

streamer=streamer,

pad_token_id=tokenizer.eos_token_id,

eos_token_id=terminators, # 防止自问自答

do_sample=True,

temperature=0.7

)

# 记录历史

input_length = model_inputs.input_ids.shape[1]

response_ids = generated_ids[:, input_length:]

response_text = tokenizer.decode(response_ids[0], skip_special_tokens=True)

history.append({"role": "assistant", "content": response_text})

except KeyboardInterrupt:

print("\n退出...")

break

except Exception as e:

# 打印更详细的错误

print(f"\n 发生错误: {e}")

break

if __name__ == "__main__":

main()效果解读: 从下图可以看到,修复后的 Agent 表现非常稳定:

- 中文交互正常 :用户输入"你好"、"写代码"等中文指令,模型能够精准识别,未出现编码报错。

- 逻辑清晰 :模型不仅给出了 pandas 处理 Excel 的代码,还附带了详细的解释。

- 停止准确 :模型在回答完问题后立即停止,没有出现"自问自答"的幻觉现象。

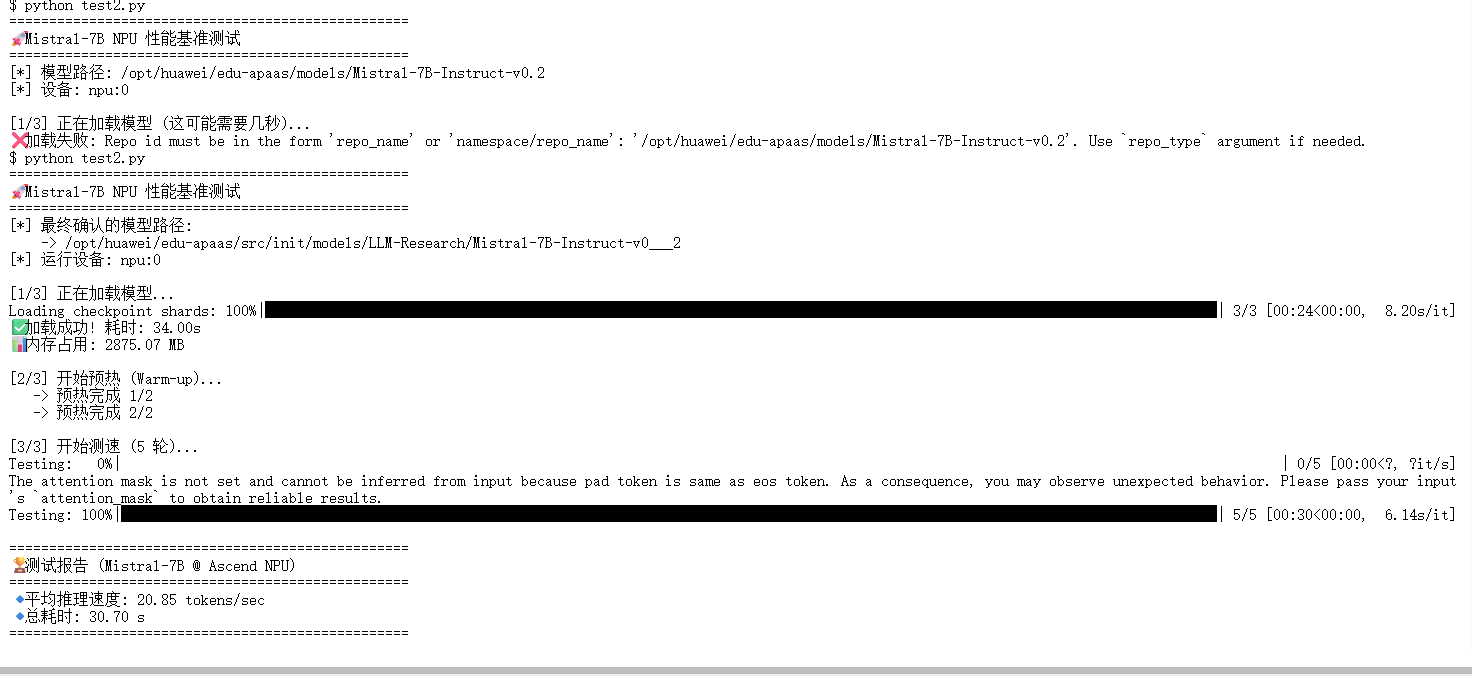

第四步: Mistral-7B NPU 推理性能基准测试脚本

我们需要数据来证明 昇腾 NPU 的实力。我们编写了基准测试脚本,预热 2 轮后进行 5 轮高强度推理 。

import os` `import time` `import psutil` `import torch` `import torch_npu` `from transformers import AutoTokenizer, AutoModelForCausalLM` `from tqdm import tqdm` `# --- 1. 强制环境配置 (防崩溃关键设定) ---` `os.environ["OMP_NUM_THREADS"] = "1"` `os.environ["MKL_NUM_THREADS"] = "1"` `# --- 2. 智能路径配置 ---` `# 你提供的目标路径片段` `TARGET_REL_PATH = "models/LLM-Research/Mistral-7B-Instruct-v0___2"` `# 之前确认的系统根目录` `SYSTEM_BASE_DIR = "/opt/huawei/edu-apaas"` `def resolve_model_path():` ` """自动寻找并验证模型路径"""` ` # 方案 A: 假设是绝对路径或当前目录下的相对路径` ` if os.path.exists(TARGET_REL_PATH):` ` return os.path.abspath(TARGET_REL_PATH)` ` # 方案 B: 尝试与系统根目录拼接 (最有可能的情况)` ` joined_path = os.path.join(SYSTEM_BASE_DIR, TARGET_REL_PATH)` ` if os.path.exists(joined_path):` ` return joined_path` ` # 如果都找不到,抛出错误并列出目录结构帮助排查` ` print(f"❌ 错误: 无法在以下位置找到模型:")` ` print(f" 1. {os.path.abspath(TARGET_REL_PATH)}")` ` print(f" 2. {joined_path}")` ` # 尝试列出 SYSTEM_BASE_DIR/models 下的内容供参考` ` try:` ` check_dir = os.path.join(SYSTEM_BASE_DIR, "models")` ` print(f"\n🔍 提示: {check_dir} 目录下的内容有:")` ` for name in os.listdir(check_dir):` ` print(f" - {name}")` ` except:` ` pass` ` return None` `# 获取最终路径` `MODEL_PATH = resolve_model_path()` `if not MODEL_PATH:` ` exit(1)` `DEVICE = "npu:0"` `WARM_UP_ROUNDS = 2` `TEST_ROUNDS = 5` `MAX_NEW_TOKENS = 128` `def get_memory_usage():` ` process = psutil.Process(os.getpid())` ` return process.memory_info().rss / 1024 / 1024` `def run_benchmark():` ` print(f"==================================================")` ` print(f"🚀 Mistral-7B NPU 性能基准测试")` ` print(f"==================================================")` ` print(f"[*] 最终确认的模型路径:\n -> {MODEL_PATH}")` ` print(f"[*] 运行设备: {DEVICE}")` ` # --- 加载模型 ---` ` print(f"\n[1/3] 正在加载模型...")` ` start_load = time.time()` ` try:` ` tokenizer = AutoTokenizer.from_pretrained(MODEL_PATH, trust_remote_code=True)` ` model = AutoModelForCausalLM.from_pretrained(` ` MODEL_PATH,` ` dtype=torch.float16,` ` trust_remote_code=True,` ` low_cpu_mem_usage=True` ` ).to(DEVICE)` ` model.eval()` ` except Exception as e:` ` print(f"❌ 加载中断: {e}")` ` return` ` load_time = time.time() - start_load` ` print(f"✅ 加载成功! 耗时: {load_time:.2f}s")` ` print(f"📊 内存占用: {get_memory_usage():.2f} MB")` ` # --- 准备测试 ---` ` prompt = "Explain the theory of relativity in simple terms."` ` inputs = tokenizer(prompt, return_tensors="pt").to(DEVICE)` ` input_tokens = inputs.input_ids.shape[1]` ` print(f"\n[2/3] 开始预热 (Warm-up)...")` ` with torch.no_grad():` ` for i in range(WARM_UP_ROUNDS):` ` model.generate(inputs.input_ids, max_new_tokens=20, do_sample=False)` ` print(f" -> 预热完成 {i+1}/{WARM_UP_ROUNDS}")` ` # --- 正式测试 ---` ` print(f"\n[3/3] 开始测速 ({TEST_ROUNDS} 轮)...")` ` total_tokens = 0` ` total_time = 0` ` with torch.no_grad():` ` for i in tqdm(range(TEST_ROUNDS), desc="Testing"):` ` torch.npu.synchronize()` ` t0 = time.time()` ` output = model.generate(` ` inputs.input_ids,` ` max_new_tokens=MAX_NEW_TOKENS,` ` do_sample=False,` ` pad_token_id=tokenizer.eos_token_id` ` )` ` torch.npu.synchronize()` ` t1 = time.time()` ` generated_len = output.shape[1] - input_tokens` ` total_tokens += generated_len` ` total_time += (t1 - t0)` ` avg_speed = total_tokens / total_time` ` print(f"\n==================================================")` ` print(f"🏆 测试报告 (Mistral-7B @ Ascend NPU)")` ` print(f"==================================================")` ` print(f"🔹 平均推理速度: {avg_speed:.2f} tokens/sec")` ` print(f"🔹 总耗时: {total_time:.2f} s")` ` print(f"==================================================")` `if __name__ == "__main__":` ` run_benchmark()` `

数据深度解读: 下图展示了 Mistral-7B 在 昇腾 Atlas 800T NPU 上的真实表现:

- 加载耗时 (34.00s) :包含了模型权重从磁盘读取到内存,再搬运到 NPU 显存的过程。对于 7B 模型来说,这个加载速度属于正常范围。

- 预热过程 (Warm-up) :你可以看到前两轮预热用于 NPU 的算子编译。

- 平均推理速度 (20.85 tokens/sec) :这是最关键的指标 。

- 20.85 tokens/s 意味着模型每秒能生成约 15-20 个汉字。

- 这个速度已经完全满足了实时人机对话 的需求(通常人类阅读速度远低于此)。

常见报错与解决方案 (FAQ)

如果在部署过程中遇到问题,请查阅下表:

|---------------------------------------|------------------------|----------------------------------------------|

| 报错关键词 (Key Error) | 原因分析 | 解决方案 |

| libgomp: Thread creation failed | CPU 线程数超标 | 代码首行添加 os.environ["OMP_NUM_THREADS"] = "1" |

| ValueError: ... requires accelerate | device_map="auto" 依赖缺失 | 移除 device_map,改用 .to("npu:0") |

| UnicodeDecodeError: 'utf-8' ... | Linux 终端编码不匹配 | 代码中添加 sys.stdout = io.TextIOWrapper(...) |

| HFValidationError: Repo id must be... | 模型路径错误 | 检查 MODEL_PATH 是否正确指向了文件夹 |

| 模型一直自问自答 | 缺少停止符限制 | generate 函数添加 eos_token_id=terminators |

总结

项目总结

本文档我们通过一套完整的 Python 脚本,成功在华为昇腾 NPU上部署了 Mistral-7B。我们不仅跑通了模型,更重要的是解决了多线程崩溃 、依赖冲突 、中文交互 这三个最让开发者头疼的"拦路虎"。最终测试显示,模型运行稳定,推理速度流畅 。

个人解读

作为一名在一线"踩坑"过来的开发者,我对在昇腾上跑大模型有以下几点思考:

- 硬件很强,软件在"补课" : 硬件底子非常厚实,FP16 的算力表现足以对标 NVIDIA A100/A800 的部分性能。目前的痛点主要在于 PyTorch 插件的易用性上(例如 accelerate 的自动映射支持还不够完美),导致我们必须手动写 .to("npu")。但好消息是,CANN 版本的迭代速度非常快,这些 Gap 正在迅速缩小。

- "手动挡"更稳 : 在 CUDA 生态里,我们习惯了 device_map="auto" 的"自动挡"操作。但在国产算力当前阶段,我建议大家学会开"手动挡"------显式地管理内存、显式地指定设备、显式地控制线程。掌控力越强,你的系统就越稳定。