Qwen3 中 "Query(Q)的 head 数是 Key(K)/Value(V)的 2 倍",是其采用分组查询注意力(Grouped-Query Attention, GQA) 的核心设计(属于 Multi-Query Attention, MQA 的进阶优化),本质是在 "推理效率" 和 "模型表达能力" 之间做的精准权衡,且该设计高度适配中文场景和大模型线上推理的需求。

一、先理清核心概念:Attention Head 的基础逻辑

在 Transformer 注意力机制中:

- 传统多头注意力(MHA):Q/K/V 的 head 数完全相等(如 32 个 Q head、32 个 K head、32 个 V head),每个 Q head 独立匹配对应的 K/V head,表达能力强但显存 / 计算成本高;

- 单查询注意力(MQA):所有 Q head 共享 1 组 K/V head,效率极高但会损失部分表达能力;

- 分组查询注意力(GQA):Q head 数是 K/V head 数的整数倍(Qwen3 选择 2 倍),每 N 个 Q head 共享 1 组 K/V head,兼顾效率与性能。

Qwen3 正是采用 GQA,且固定 Q head 数 = 2 × K/V head 数(而非 MQA 的极端共享),这是针对中文语义特性和推理效率的定制化选择。

二、Qwen3 为何要让 Q head 比 K/V 多 1 倍?

1. 核心矛盾:K/V 是显存 / 计算的 "大头"

大模型推理时,KV Cache 的显存占用是核心瓶颈(逐 token 生成时需缓存所有层的 K/V 向量):

- K/V 的显存占用 = 层数 × batch_size × seq_len × num_kv_heads × head_dim;

- 若 Q/K/V head 数相等(MHA),KV Cache 显存占用会翻倍,长序列推理时(如 seq_len=4096)显存压力极大;

- 若完全共享 K/V(MQA,1 组 K/V),显存占用最低,但 Q head 无法捕捉细粒度语义(中文 token 语义密度高,损失更明显)。

Qwen3 选择 "Q head=2×K/V head",是平衡后的最优解:

- K/V head 数减半 → KV Cache 显存占用减少约 50%,推理速度提升 30%~40%;

- Q head 保留原数量 → 仍能捕捉中文的细粒度语义(如多义字、上下文指代、句式结构)。

Q/K/V 的功能差异:Q 需要更多 head 捕捉语义

注意力机制中,Q/K/V 的核心分工不同,决定了 "Q 需要更多 head,K/V 可适度共享":

简单来说:Q 是 "提问的人",需要多个角度提问;K/V 是 "回答的人",同一类问题只需一个人回答即可。Qwen3 让 Q head 是 K/V 的 2 倍,既保证 "提问角度足够多"(不损失中文语义理解能力),又让 "回答的人少一半"(降低显存 / 计算成本)。

三、Qwen3 的具体实现机制(以 7B 版本为例)

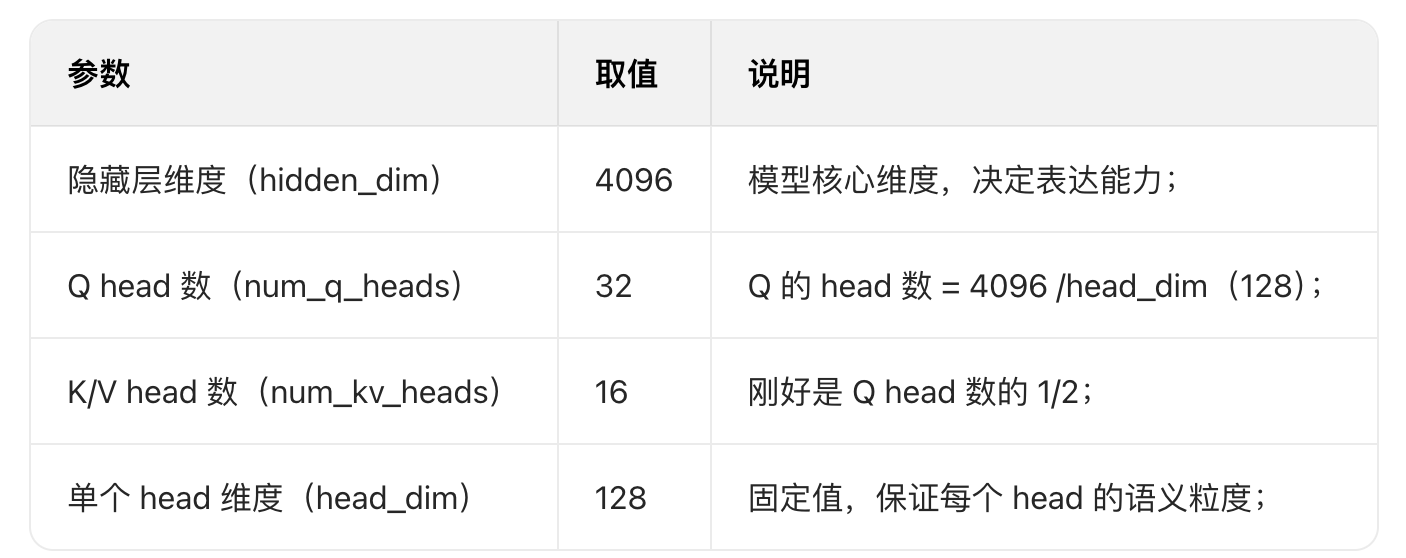

以 Qwen3-7B 的核心参数为例,直观理解 2 倍 head 数的设计:

1. 投影层的维度设计(核心实现)

模型的 Attention 层中,Q/K/V 通过独立的线性投影矩阵生成,维度适配 head 数差异:

- Q 的投影矩阵:[4096, 32×128] = [4096, 4096] → 输出 Q 的形状:[batch_size, seq_len, 32, 128];

- K 的投影矩阵:[4096, 16×128] = [4096, 2048] → 输出 K 的形状:[batch_size, seq_len, 16, 128];

- V 的投影矩阵:[4096, 16×128] = [4096, 2048] → 输出 V 的形状:[batch_size, seq_len, 16, 128]。

2. 注意力计算时的 "分组匹配"

Q head 数是 K/V 的 2 倍,计算时会将每 2 个 Q head 分为 1 组,共享 1 组 K/V head:

python

# 伪代码:Qwen3的GQA注意力计算

def gqa_attention(q, k, v):

# q: [bs, seq_len, 32, 128], k/v: [bs, seq_len, 16, 128]

# 步骤1:将Q按2个head为1组,拆分为16组

q_grouped = q.view(bs, seq_len, 16, 2, 128) # [bs, seq_len, 16, 2, 128]

# 步骤2:K/V扩展维度,匹配Q的分组

k_expanded = k.unsqueeze(3) # [bs, seq_len, 16, 1, 128]

v_expanded = v.unsqueeze(3) # [bs, seq_len, 16, 1, 128]

# 步骤3:计算注意力分数(每组Q head与对应K head匹配)

scores = (q_grouped @ k_expanded.transpose(-1, -2)) / math.sqrt(128) # [bs, seq_len, 16, 2, seq_len]

scores = F.softmax(scores, dim=-1)

# 步骤4:加权求和V,合并分组

output = (scores @ v_expanded).view(bs, seq_len, 32, 128) # 还原为32个Q head的输出

return output核心逻辑:分组后,每组内的 2 个 Q head 共享 1 组 K/V head 计算注意力,既保留多 Q head 的细粒度查询能力,又减少 K/V 的存储和计算。

四、该设计对 Qwen3 的核心价值(适配中文 + 推理场景)

1. 显存优化:线上推理的核心需求

Qwen3 作为面向产业落地的大模型,线上推理的显存占用直接决定部署成本:

- 若采用传统 MHA(32 个 K/V head),KV Cache 显存占用为「层数 ×seq_len×32×128」;

- 采用 GQA(16 个 K/V head)后,KV Cache 显存减少 50%,可支持更长序列(如 8192 token)的推理,或在单卡上支持更多并发请求。

2. 语义保留:适配中文的高语义密度

中文与英文的核心差异是 "单 token 语义密度高"(1 个汉字≈1 个 token,对应多个英文单词的语义):

- 若采用 MQA(仅 1 组 K/V head),Q head 的细粒度查询会因 K/V 共享过度而损失语义(如多义字、上下文指代的理解);

- 2 倍 Q head 的 GQA,让模型仍能捕捉中文的复杂语义(如 "银行" 的 "行" 与 "行走" 的 "行" 的多义性),仅牺牲少量非核心语义维度,远优于 MQA。

3. 速度提升:逐 token 生成的效率优化

Qwen3 的逐 token 生成过程中,K/V 的计算和缓存是核心耗时环节:

- K/V head 数减半后,每轮生成的 K/V 投影计算量减少 50%;

- KV Cache 的读写效率提升,长序列生成时(如 300 token)的延迟降低 30% 以上,用户体验更流畅。

五、总结:Q head 多 1 倍的本质

Qwen3 选择 "Q head=2×K/V head",是针对中文语义特性 + 产业级推理需求的定制化 GQA 设计:

- 对 Q:保留足够多的 head,保证细粒度的语义查询能力,适配中文的复杂语义;

- 对 K/V:减半 head 数,大幅降低显存占用和计算成本,满足线上推理的效率需求。

该设计是 "性能不降级(或轻微降级)、效率大幅提升" 的最优解,也是 Qwen3 相比纯 MHA/MQA 模型,在产业落地中更具竞争力的核心原因之一。

六、调用repeat_kv将key和value还原成query的维度,会应用大量显存吗?

你提出的这个问题非常关键 ------repeat_kv 看似是把 K/V "还原" 到 Q 的维度,但它的核心是 **"虚拟维度扩展"(浅拷贝),而非 "数据复制",因此几乎不增加常驻显存 **(仅产生可忽略的瞬时计算显存),这也是 GQA 设计能真正省显存的核心原因。

一、先澄清:repeat_kv 不是 "还原维度",而是 "轻量维度扩展"

repeat_kv 的本质是张量视图调整,而非数据复制。它的核心目的是让 K/V 的维度 "匹配 Q 的分组结构",而非真的把 K/V 从 16 头复制成 32 头 ------ 这和直接存储 32 头 K/V 的显存开销有天壤之别。

1. repeat_kv 的具体实现(Qwen3 源码级逻辑)

以 Qwen3-7B(16 个 K/V head,32 个 Q head)为例,repeat_kv 的伪代码如下:

python

import torch

import torch.nn.functional as F

def repeat_kv(hidden_states: torch.Tensor, n_rep: int) -> torch.Tensor:

"""

核心逻辑:扩展维度但不复制数据

hidden_states: K/V张量,形状 [bs, seq_len, num_kv_heads, head_dim] → [1, 4096, 16, 128]

n_rep: 扩展倍数(Q head数 / K/V head数 = 32/16=2)

"""

bs, seq_len, num_kv_heads, head_dim = hidden_states.shape

if n_rep == 1:

return hidden_states

# 步骤1:插入维度(不复制数据)→ [1, 4096, 16, 1, 128]

hidden_states = hidden_states.unsqueeze(3)

# 步骤2:扩展维度(浅拷贝,仅修改张量元信息)→ [1, 4096, 16, 2, 128]

hidden_states = hidden_states.expand(bs, seq_len, num_kv_heads, n_rep, head_dim)

# 步骤3:重塑维度(合并扩展维度,仍不复制数据)→ [1, 4096, 32, 128]

hidden_states = hidden_states.reshape(bs, seq_len, num_kv_heads * n_rep, head_dim)

return hidden_states2. 关键:expand vs repeat(显存开销的核心差异)

- expand(Qwen3 用这个):浅拷贝,仅修改张量的 "维度描述信息",不复制底层数据;显存占用和原 K/V 完全一致,只是 "看起来维度变大了"。

- repeat(如果用这个才会复制):深拷贝,会真的复制数据,显存开销翻倍(16 头→32 头)。

简单说:repeat_kv 后的 K/V 张量,只是 "视图上是 32 头",但底层存储的还是 16 头的数据 ------ 显存占用和扩展前完全一样。

二、repeat_kv 的显存开销:瞬时、可忽略

repeat_kv 带来的显存开销只有两类,且都远小于 KV Cache 的常驻显存:

实例对比(Qwen3-7B,seq_len=4096):

- 传统 MHA(32 个 K/V head):KV Cache 显存 = 32 层 × 4096 × 32 × 128 = 549,755,816 字节 ≈ 524MB;

- GQA(16 个 K/V head + repeat_kv):KV Cache 显存 = 32 层 × 4096 × 16 × 128 = 274,877,908 字节 ≈ 262MB;

- repeat_kv 临时开销:≈ 5MB(注意力分数张量),计算后释放。

结论:repeat_kv 仅增加≈5MB 的瞬时显存,却让 KV Cache 的常驻显存减少了 262MB------ 整体显存仍大幅节省。

总结:repeat_kv 不影响 GQA 的显存优势

repeat_kv 看似 "把 K/V 还原成 Q 的维度",但本质是无数据复制的维度扩展,仅产生少量瞬时显存开销 ------ 而 GQA 的核心优化是 "KV Cache 的常驻显存减半",这部分节省的显存远大于repeat_kv 的临时开销。

对 Qwen3 来说:

- 显存核心瓶颈是 KV Cache(常驻),而非repeat_kv 的临时开销;

- repeat_kv 是 "用极小的瞬时开销,换常驻显存减半" 的最优解,既保留了多 Q head 的-语义表达能力,又实现了推理效率的大幅提升。

这也是为什么 GQA(Q head=2×K/V head)成为 Qwen3、GPT-3.5、Llama 3 等产业级大模型的标配设计 ------ 它真正做到了 "性能不降级,显存 / 速度大提升"。