在当今的科技世界中,人工智能(AI)已经成为我们日常生活的一部分。从智能手机的语音助手,到自动驾驶汽车,再到医疗诊断系统,AI 的应用无处不在。而在这些先进技术的背后,多层感知机(MLP)作为神经网络的基本形式,扮演着至关重要的角色。MLP 听起来可能有些高大上,但其实它就像是我们大脑中的神经元网络,通过简单的数学运算来模拟人类的决策过程。本文将用通俗易懂的语言,结合图例,一步步带你理解 MLP 的原理、结构、工作方式以及应用。无论你是初学者还是对 AI 感兴趣的朋友,都能从中获益。

第一部分:从生物灵感到人工智能基础

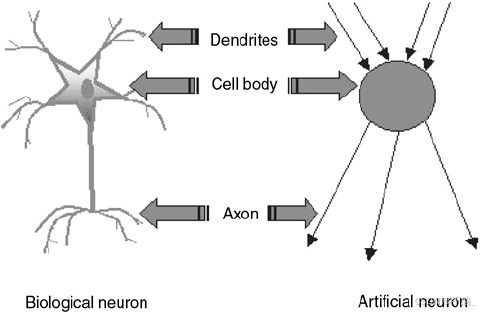

要理解 MLP,我们先从它的起源说起。MLP 的灵感来自于人类大脑的神经元。想象一下,你的大脑里有大约 860 亿个神经元,每个神经元就像一个小小的处理器,通过突触连接起来,传递信号。当你看到一个苹果时,眼睛捕捉到图像,神经元开始工作:一些神经元负责识别颜色(红色),另一些负责形状(圆形),最终大脑得出结论------这是一个苹果。

在人工智能中,科学家们试图模仿这个过程。最早的模型是"感知机"(Perceptron),由弗兰克·罗森布拉特在 1958 年提出。它是一个简单的数学模型,模拟单个神经元的行为。感知机接收多个输入(如特征数据),每个输入有一个权重(表示重要性),然后求和,如果总和超过阈值,就输出 1(激活),否则输出 0(不激活)。这就像一个简单的"是/否"决策机。

如上图所示,人工神经元与生物神经元的类比非常直观。输入对应树突,权重对应突触强度,求和和激活函数对应细胞体,输出对应轴突。通过这个类比,我们可以看到 AI 如何从生物学中汲取灵感。

但是,单层感知机有局限性。它只能处理线性可分的问题,比如区分"直线两侧"的数据点,但无法处理像 XOR(异或)这样的非线性问题。XOR 问题简单来说,就是输入两个比特,如果相同输出 0,不同输出 1。这在二维平面上无法用一条直线分开。为了解决这个问题,研究者引入了多层结构,这就是多层感知机(MLP)的诞生。

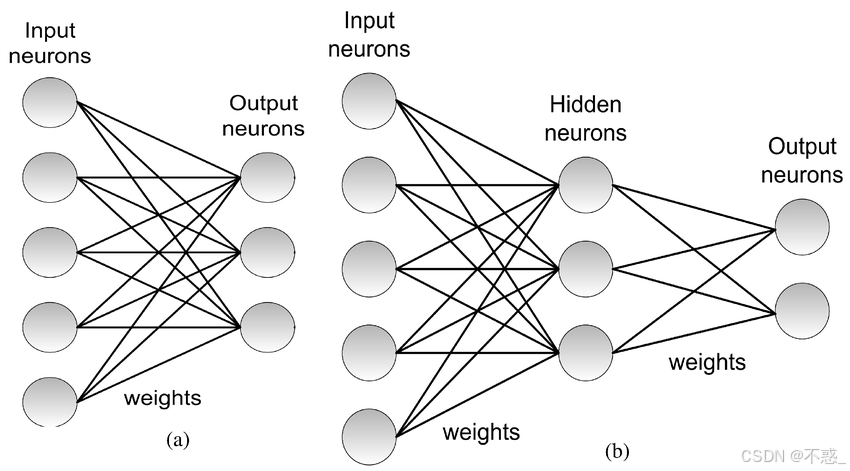

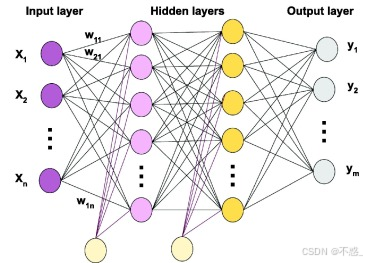

MLP 本质上是多个感知机层叠起来的网络。通常包括输入层、一个或多个隐藏层,以及输出层。输入层接收数据,隐藏层进行复杂计算,输出层给出结果。这种多层设计允许网络学习非线性关系,就像大脑的多层神经元处理复杂信息一样。

第二部分:MLP 的基本结构

现在,让我们深入 MLP 的结构。假设我们有一个简单的 MLP,用于分类任务,比如判断一张图片是猫还是狗。

-

输入层(Input Layer):这是网络的起点。每个输入节点对应一个特征。例如,对于一张 28x28 像素的灰度图像(如 MNIST 手写数字数据集),输入层会有 784 个节点(28*28=784)。每个节点的值是像素的灰度值,从 0 到 1。

-

隐藏层(Hidden Layers):这是 MLP 的"黑箱"部分。可以有一个或多个隐藏层,每层有多个神经元。每个神经元连接到上一层的每个输出,通过权重相乘并求和,然后应用激活函数。隐藏层的数量和神经元个数是超参数,需要根据问题调整。太少可能无法捕捉复杂模式,太多则可能过拟合(记住训练数据但泛化差)。

-

输出层(Output Layer):给出最终结果。对于二分类(如猫/狗),可能只有一个节点,输出概率(接近 1 是猫,接近 0 是狗)。对于多分类(如 10 个数字),有 10 个节点,使用 softmax 函数确保概率和为 1。

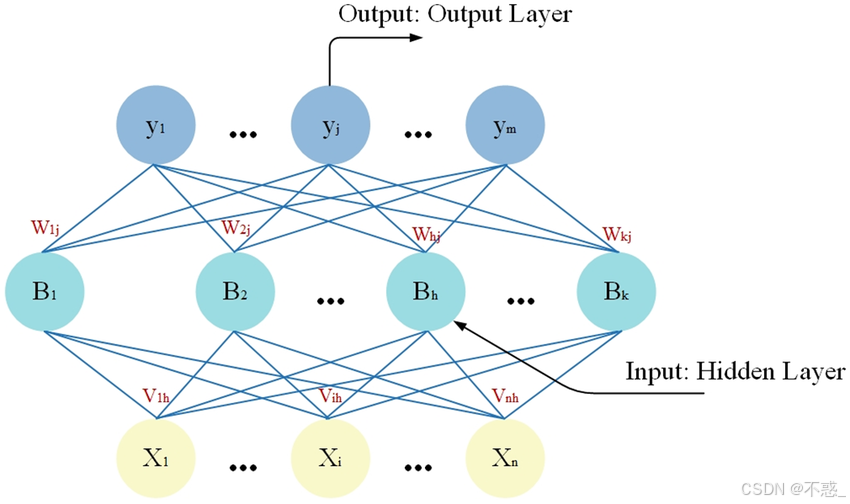

整个网络的连接是全连接的(Fully Connected),意思是每一层的所有神经元都连接到下一层的所有神经元。没有循环连接,所以是前馈网络(Feedforward Neural Network)。

上图展示了一个单层感知机的结构,作为对比。单层只有输入和输出,没有隐藏层,无法处理复杂任务。

而 MLP 的结构则更丰富:

如图所示,一个典型的 MLP 有输入层、两个隐藏层和输出层。箭头表示权重连接。数学上,每个神经元的输出是:z = sum(w_i * x_i) + b,其中 w 是权重,x 是输入,b 是偏置。然后通过激活函数 f(z) 输出。

第三部分:激活函数------让网络"活"起来

为什么需要激活函数?如果没有它,MLP 无论多少层,都等价于一个线性模型,无法捕捉非线性。激活函数引入非线性,让网络能拟合复杂函数。

常见的激活函数包括:

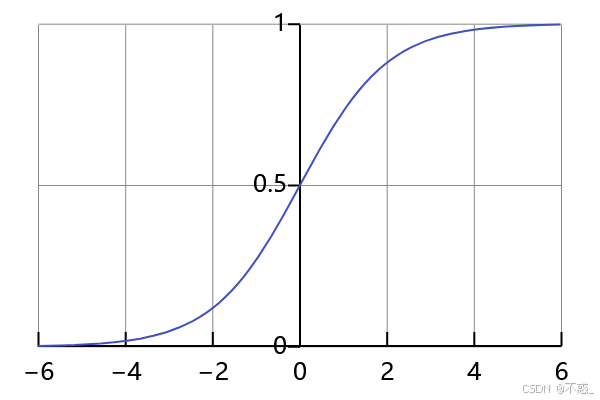

- Sigmoid 函数:f(x) = 1 / (1 + e^{-x})。输出范围 0 到 1,常用于概率输出。但有梯度消失问题(当 x 很大或很小时,梯度接近 0,导致训练慢)。

如图,Sigmoid 呈 S 形,平滑但在两端饱和。

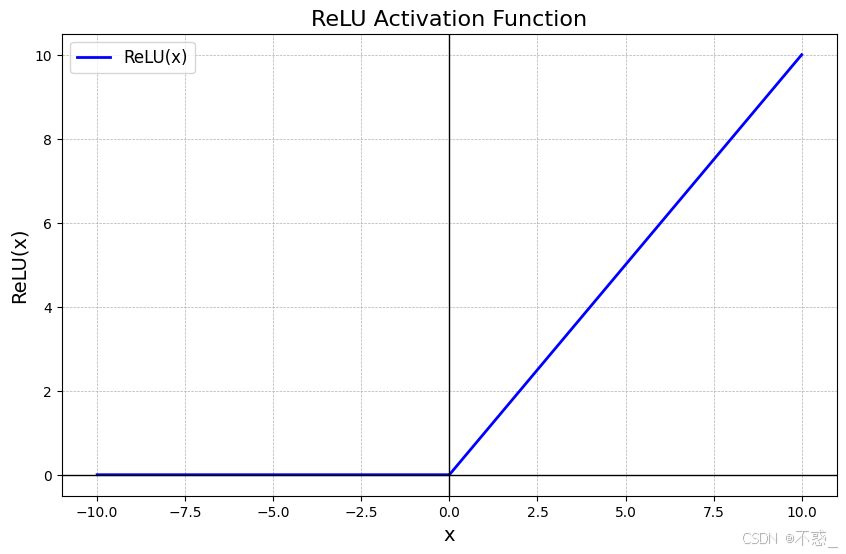

- ReLU(Rectified Linear Unit):f(x) = max(0, x)。简单高效,解决梯度消失,但有"死亡 ReLU"问题(如果神经元输出总是 0,就"死了")。

ReLU 图如上,x<0 时为 0,否则为 x。计算快,现代网络常用。

其他还有 Tanh(类似 Sigmoid,但范围 -1 到 1)、Leaky ReLU 等。选择取决于任务,比如分类用 softmax,回归用线性。

第四部分:前向传播------数据如何流动

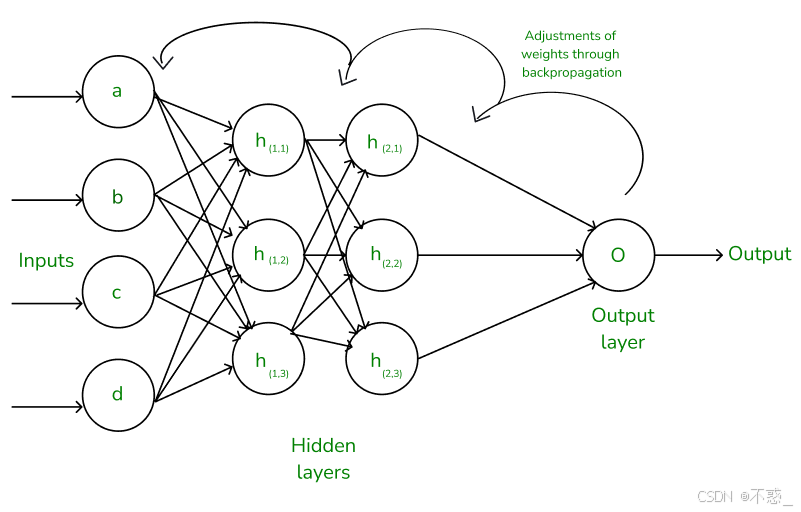

MLP 的工作分为两个阶段:前向传播(Forward Propagation)和反向传播(Backpropagation)。

前向传播是推理过程:数据从输入层逐层向前计算,直到输出。

假设输入向量 X = [x1, x2, ..., xn]。

第一隐藏层:h1_j = f(sum(w1_ji * xi) + b1_j) 对于每个 j。

然后第二隐藏层类似,最后输出 y_k = f(sum(w_out_kj * h_last_j) + b_out_k)。

整个过程像流水线:输入 -> 加权求和 -> 激活 -> 下一层。

上图展示了前向传播的过程。箭头从左到右,层层计算。

在实际应用中,比如手写数字识别:输入像素值,经过隐藏层提取边缘、形状等特征,最终输出数字概率。

第五部分:反向传播与训练------让网络学习

MLP 的强大在于它能"学习"。训练过程使用反向传播算法,结合梯度下降优化权重。

首先,需要损失函数(Loss Function)衡量预测与真实的差距。比如均方误差(MSE) for 回归,交叉熵(Cross-Entropy) for 分类。

反向传播:从输出层开始,计算误差梯度,向后传递,更新每个权重。

数学上,使用链式法则:∂L/∂w = ∂L/∂y * ∂y/∂z * ∂z/∂w,其中 z 是加权和,y 是激活输出。

然后,权重更新:w_new = w_old - η * ∂L/∂w,其中 η 是学习率。

批量梯度下降(Batch GD)、随机梯度下降(SGD)、Adam 等优化器帮助收敛。

训练步骤:

-

初始化权重(随机小值)。

-

前向传播计算输出。

-

计算损失。

-

反向传播计算梯度。

-

更新权重。

-

重复直到损失小。

如图,反向传播从右到左传递误差,调整权重。

过拟合是常见问题:用 dropout(随机丢弃神经元)或正则化解决。

第六部分:MLP 的应用示例

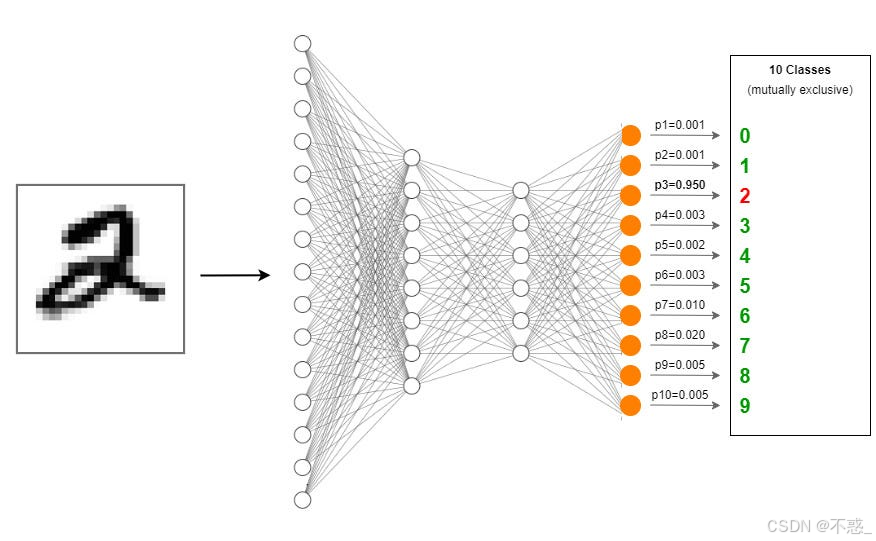

MLP 在许多领域大放异彩。以 MNIST 手写数字数据集为例:10 万张 28x28 图像,目标识别 0-9。

一个简单 MLP:输入 784,隐藏层 128 ReLU,输出 10 softmax。训练后准确率可达 98%。

上图展示 MLP 用于 MNIST 的示例。隐藏层学习数字特征,如"0"的圆圈。

其他应用:

-

金融:预测股票价格。

-

医疗:诊断疾病从 X 光片。

-

游戏:如 AlphaGo 中的部分组件。

-

自然语言:情感分析。

尽管 MLP 强大,但对于图像、序列数据,卷积神经网络(CNN)、循环神经网络(RNN)更高效。MLP 适合表格数据。

第七部分:MLP 的优缺点与未来

优点:

-

通用:能拟合任何连续函数(万能逼近定理)。

-

简单:易实现,用 TensorFlow 或 PyTorch 几行代码。

-

可解释性:权重可分析特征重要性。

缺点:

-

计算密集:训练需 GPU。

-

黑箱:隐藏层难解释。

-

易过拟合:需调参。

未来,随着 Transformer 等模型兴起,MLP 仍是基础。混合模型如 MLP-Mixer 结合 MLP 与注意力机制。

结语

通过本文,我们从生物灵感到训练过程,通俗理解了 MLP。它不是魔法,而是数学与计算的结合。希望这篇文章让你对 AI 有新认识。如果你想实践,试试用 Python 构建一个简单 MLP 分类 iris 数据集。AI 的世界广阔,MLP 是你的起点!