目录

[第一章 引言](#第一章 引言)

[第二章 决策树的基础原理与分裂机制](#第二章 决策树的基础原理与分裂机制)

[第三章 信息增益、基尼不纯度与节点分裂标准](#第三章 信息增益、基尼不纯度与节点分裂标准)

[第四章 过拟合问题与剪枝策略](#第四章 过拟合问题与剪枝策略)

[第五章 随机森林与集成学习的力量](#第五章 随机森林与集成学习的力量)

[第六章 Scikit-learn实践:完整的分类与回归案例](#第六章 Scikit-learn实践:完整的分类与回归案例)

[6.1 分类问题:鸢尾花数据集的决策树与随机森林对比](#6.1 分类问题:鸢尾花数据集的决策树与随机森林对比)

[6.2 回归问题:波士顿房价预测的实践案例](#6.2 回归问题:波士顿房价预测的实践案例)

[第七章 总结与展望](#第七章 总结与展望)

第一章 引言

在机器学习的演进过程中,决策树和随机森林作为两个经典且广泛应用的算法,始终占据着重要的地位。它们不仅因为高度的可解释性而被广泛采纳,更因为在实际业务场景中能够平衡模型的复杂度与性能而备受推崇。从金融风控的信用评分、医疗诊断的辅助决策,到推荐系统的特征工程,决策树和随机森林都展现了强大的实用价值。本文从解释性和鲁棒性两个维度深入探讨这两类算法的核心机制、理论基础和实践应用,旨在帮助从业者更深刻地理解这些算法的本质,并在实际工程中做出更合理的选择。解释性强意味着模型的决策过程可以被人类理解,而鲁棒性高则意味着模型能够抵抗噪声和异常数据的干扰。决策树虽然解释性最优,但容易过拟合导致泛化性能下降;随机森林通过集成学习的思想弥补了这一缺陷,在维持相对较好解释性的同时,显著提升了模型的鲁棒性和泛化能力。本文将系统地阐述这两个算法如何权衡这对矛盾的目标。

第二章 决策树的基础原理与分裂机制

决策树是一种树形的监督学习模型,其核心思想是通过递归地将数据集分割成越来越纯净的子集,最终构建出一个能够将输入特征映射到输出标签的决策规则集合。决策树的美妙之处在于,整个决策过程完全可视化,可以转化为一系列简单的if-then规则,这使得它成为最具解释性的机器学习模型之一。任何业务人员,即便不具备深厚的数学背景,也能理解为什么模型做出了某个特定的预测。这种透明性在医疗、法律、金融等对决策可解释性有严格要求的领域显得尤为宝贵。

决策树的构建过程本质上是一个贪心的递归分割过程。从包含全部训练数据的根节点开始,算法在每一步都选择一个特征和一个分割点,使得分割后的子集相比分割前更加"纯净"。这里的"纯净"度量取决于我们使用的不纯度指标。传统的ID3算法使用信息熵和信息增益,C4.5改进了这一点,而CART算法则引入了基尼不纯度的概念。决策树的递归分割一直进行到满足某个停止条件为止,这个条件可能是叶节点中的样本数小于某个阈值,或者所有样本都属于同一类别,或者树的深度达到了预设的最大值。这个过程虽然直观,但隐含着一个重要的风险:在不加任何限制的情况下,决策树可以持续分裂直到完美拟合训练数据,导致严重的过拟合。这也是为什么剪枝策略对决策树的实用性至关重要。

第三章 信息增益、基尼不纯度与节点分裂标准

决策树的分裂标准决定了在每个节点应该选择哪个特征以及如何对该特征进行分割。这一章节深入讨论两种最主要的分裂标准:信息增益和基尼不纯度。这两种度量方式虽然都衡量数据的纯净度,但从不同的理论角度出发,各有其优缺点。

信息增益的概念源自信息论。在信息论中,信息熵被定义为衡量一个随机变量不确定性的度量。对于一个包含多个类别的数据集,如果某个类别占绝对比例,则不确定性较低;如果各类别比例相近,则不确定性较高。当我们对数据进行分裂时,理想情况是分裂后的子集中某个类别的比例更加极端(更纯净),这样就降低了不确定性。信息增益正式定义为分裂前后信息熵的差值,它衡量了一次分裂能够减少多少的不确定性。

对于一个数据集S,其信息熵定义为:

H(S) = -\\sum_{i=1}\^{k} p_i \\log_2(p_i)

其中,k表示类别总数,p_i表示第i个类别在S中的比例。当所有样本都属于同一类别时,熵为0;当各类别比例均匀时,熵达到最大值。这个公式直观地反映了一个直观的事实:当数据更加纯净(某个类别占主导)时,我们需要更少的信息来描述一个随机样本的类别;反之,当数据更加混杂时,我们需要更多的信息。

当我们选择一个特征A对S进行分裂,得到若干子集S_1, S_2, ..., S_m时,分裂后的加权平均熵为:

H(S\|A) = \\sum_{j=1}\^{m} \\frac{\|S_j\|}{\|S\|} H(S_j)

这个公式表示每个子集对总体熵的贡献,权重是该子集的大小比例。信息增益则定义为:

IG(S,A) = H(S) - H(S\|A)

信息增益越大,说明这个特征的分裂能力越强,越应该被选中作为分裂特征。ID3算法直接使用信息增益进行特征选择。然而,信息增益有一个明显的缺点:它倾向于偏爱取值较多的特征。比如,如果有一个特征的值为样本ID(几乎每个样本都不同),它会产生极高的信息增益,因为分裂后每个子集都非常纯净(可能只包含一个样本)。这导致算法选择了一个毫无实际意义的特征。为了克服这一问题,C4.5算法引入了信息增益比的概念,它将信息增益除以分裂特征本身的熵,从而惩罚具有过多不同取值的特征。

与信息增益不同,基尼不纯度是另一种衡量数据纯净度的方式,它直接来自于CART算法。基尼不纯度的定义如下:

Gini(S) = 1 - \\sum_{i=1}\^{k} p_i\^2

这个公式的直观意义是:如果我们随机从数据集S中抽取两个样本,它们来自不同类别的概率就是基尼不纯度。当所有样本都属于同一类别时,Gini(S) = 0;当各类别比例均匀时(二分类情况下为0.5),Gini(S)达到最大值。与信息熵不同,基尼不纯度避免了对数运算,计算速度更快。

当使用特征A对S进行分裂后,基尼不纯度的减少量(称为Gini增益)定义为:

IG_{gini}(S,A) = Gini(S) - \\sum_{j=1}\^{m} \\frac{\|S_j\|}{\|S\|} Gini(S_j)

CART算法使用基尼不纯度作为分裂标准。与信息增益相比,基尼不纯度更加倾向于在两个特征中进行选择,而不是多路分裂,这使得CART算法倾向于生成更均衡的二叉树。值得注意的是,在大多数实际应用中,信息增益和基尼不纯度的选择往往不会导致最终结果的显著差异,它们的主要区别在于计算效率和树的形状。

第四章 过拟合问题与剪枝策略

决策树在不加任何约束的情况下,会无限制地生长,将训练数据完美分类。这会导致一个严重的问题:树会记住训练数据的每一个细节和噪声,包括异常值和标注错误,而对新的测试数据的预测能力大幅下降。这就是所谓的过拟合现象。在机器学习中,模型的泛化能力(即在未见过的数据上的表现)比在训练数据上的表现更加重要。一个在训练数据上达到100%准确率但在测试数据上只有70%准确率的模型,远不如一个在两个数据集上都达到85%的模型有用。

为了解决过拟合问题,决策树的实现中引入了两种主要的剪枝策略:先剪枝(Pre-pruning)和后剪枝(Post-pruning)。先剪枝通过在树的构建过程中设置停止条件,使得树在过度生长之前就停止继续分裂。这些条件包括树的最大深度、节点中的最小样本数、最小信息增益阈值等。先剪枝的优点是计算效率高,因为我们不需要构建完整的树再进行修剪;缺点是这些阈值往往需要根据具体问题进行调整,且容易遗漏某些有用的分裂。比如,一个分裂在当前看来似乎没有带来太大的信息增益,但后续的分裂可能会基于这个分裂获得显著的增益(这被称为"地平线效应")。

与先剪枝不同,后剪枝首先构建一个完整的、可能过拟合的决策树,然后从叶节点向上,逐步考虑是否将某个子树替换为一个叶节点。这个过程需要一个独立的验证集来评估剪枝是否改进了模型的泛化能力。最小错误率剪枝(Minimum Error Rate Pruning)是一种常见的后剪枝方法,它在验证集上评估每一步剪枝操作,选择那些能够降低验证错误率的剪枝。另一种被广泛使用的方法是基于代价复杂性的剪枝(Cost-Complexity Pruning,也称为Weakest Link Pruning)。这种方法定义了一个代价复杂性参数α,对于一棵树T,其代价复杂性定义为:

R(T) = E(T) + α\|T\|

其中,E(T)是树在验证集上的错误数(或其他损失函数),|T|是树的叶节点数(树的复杂度)。当α = 0时,我们倾向于选择最复杂的树(拟合最好);当α增大时,我们倾向于选择更简洁的树。通过在不同的α值下构建树,我们可以得到一系列树,然后选择在验证集上泛化能力最好的那一棵。这种方法相比最小错误率剪枝更加稳定,也是scikit-learn中实现的主要方法。

在实践中,后剪枝通常比先剪枝能产生更好的结果,因为它基于完整树的全局信息进行决策,而不是在树的构建过程中做出局部决策。然而,后剪枝需要额外的验证数据,这在数据量较小的情况下可能不实用。现代的实现,如scikit-learn,通常结合了两种方法:在构建时设置一些基本的先剪枝条件以提高效率,然后在必要时进行后剪枝以进一步优化。理解剪枝的重要性对于构建实用的决策树至关重要,因为在大多数真实场景中,一棵过于复杂的树往往是导致模型性能不佳的主要原因。

第五章 随机森林与集成学习的力量

如果说决策树是机器学习中最具解释性的单个模型,那么随机森林则通过集成学习的思想,在保持相对解释性的同时,大幅提升了模型的鲁棒性和泛化能力。集成学习的核心理念很简单但又深刻:多个较弱的学习器通过适当的组合,可以产生一个非常强大的预测器。这个思想被形象地比喻为"三个臭皮匠,顶个诸葛亮"。随机森林正式通过训练多个决策树,然后让它们进行投票(分类问题)或平均(回归问题)来做出最终预测。

随机森林之所以能够比单个决策树表现更优,关键在于它引入了两种形式的随机性:数据随机性(通过Bootstrap采样)和特征随机性(在每次分裂时只考虑特征的随机子集)。首先考虑数据随机性。对于包含n个样本的训练集,随机森林使用Bootstrap采样(放回采样)来为每一棵树生成一个训练子集。在这个过程中,每个样本被选中的概率是1-1/n对每个位置。经过n次采样后,约有63.2%的原始样本至少被采样一次,而约36.8%的样本(称为Out-Of-Bag,OOB样本)完全没有被采样到。这个比例(36.8%)是一个有趣的数学事实,来自于极限计算。由于不同树基于不同的训练数据,它们会学到不同的模式,从而产生多样化的预测。当这些预测进行投票或平均时,这种多样性导致了较低的整体方差。

第二种随机性来自于特征的随机选择。在标准的决策树中,每次进行节点分裂时,算法会评估所有的特征,选择最优的那个。相比之下,随机森林在每次分裂时,不是从所有特征中选择,而是先随机选择一个特征的子集(比如sqrt(m)或log2(m)个特征,其中m是总特征数),然后在这个子集内找到最优的分裂。这个随机特征选择策略的优点是多方面的。首先,它进一步增加了不同树之间的多样性,因为即使是同一个样本,不同的树看到的特征也可能不同。其次,它提高了计算效率,因为每次分裂时需要评估的特征更少。第三,它自动进行了一种形式的特征选择,因为那些真正重要的特征会在多个树中被选中并产生分裂,而无关的特征被选中的几率较低。

从偏差-方差的角度来看,集成学习的力量体现在方差的显著降低。单个决策树往往具有较高的方差:即使是训练数据中的微小变化,也可能导致完全不同的树结构和预测。随机森林通过平均多个树的预测,能够大幅降低这个方差。具体来说,如果我们假设每棵树的预测误差是独立的,且方差都是σ²,那么k棵树平均预测的方差大约是σ²/k。当然,实际中树的预测并不完全独立,但仍然会取得显著的方差减少。与此同时,每棵树的偏差(因为我们使用的仍然是决策树)不会显著增加,因为每棵树仍然可以表达足够复杂的决策边界。这导致了一个美妙的效果:随机森林往往既有较低的偏差,又有较低的方差,从而在偏差-方差权衡上胜过单个决策树。

随机森林的另一个重要优势是对异常值和噪声数据的鲁棒性。因为预测是多个树的平均或投票,单个样本的错误标注或异常特征值很难对整体预测产生显著影响。这种鲁棒性在实际应用中特别宝贵,因为真实数据往往包含各种形式的噪声和异常。此外,随机森林能够自动处理特征间的相互作用和非线性关系,而不需要手动进行特征工程。尽管决策树也具有这个能力,但单个决策树容易过拟合;随机森林通过集成消除了这个问题。

尽管随机森林在性能上相比单个决策树有明显优势,但在解释性上确实有所折扣。我们不能像解释单个决策树那样,直观地指出一个特定的决策路径来解释某个预测。然而,随机森林提供了其他形式的解释能力。最重要的是特征重要性的概念,我们稍后会详细讨论。随机森林还可以计算OOB错误率,即使用每棵树的OOB样本进行评估,这提供了一个几乎不需要额外数据的验证指标。现代的实现还提供了部分依赖图(Partial Dependence Plot)和SHAP值等可解释性工具,使得我们能够理解模型在更细粒度水平上的行为。总体来说,随机森林在解释性和性能之间找到了一个很好的平衡点,这也是它在实际应用中被广泛采用的原因。

第六章 Scikit-learn实践:完整的分类与回归案例

scikit-learn提供了决策树和随机森林的高效实现,API设计一致、文档完善、性能优异。本章通过两个完整的实例(分类和回归),深入展示如何在实际问题中应用这些算法,并通过特征重要性分析来获得对模型的深入理解。

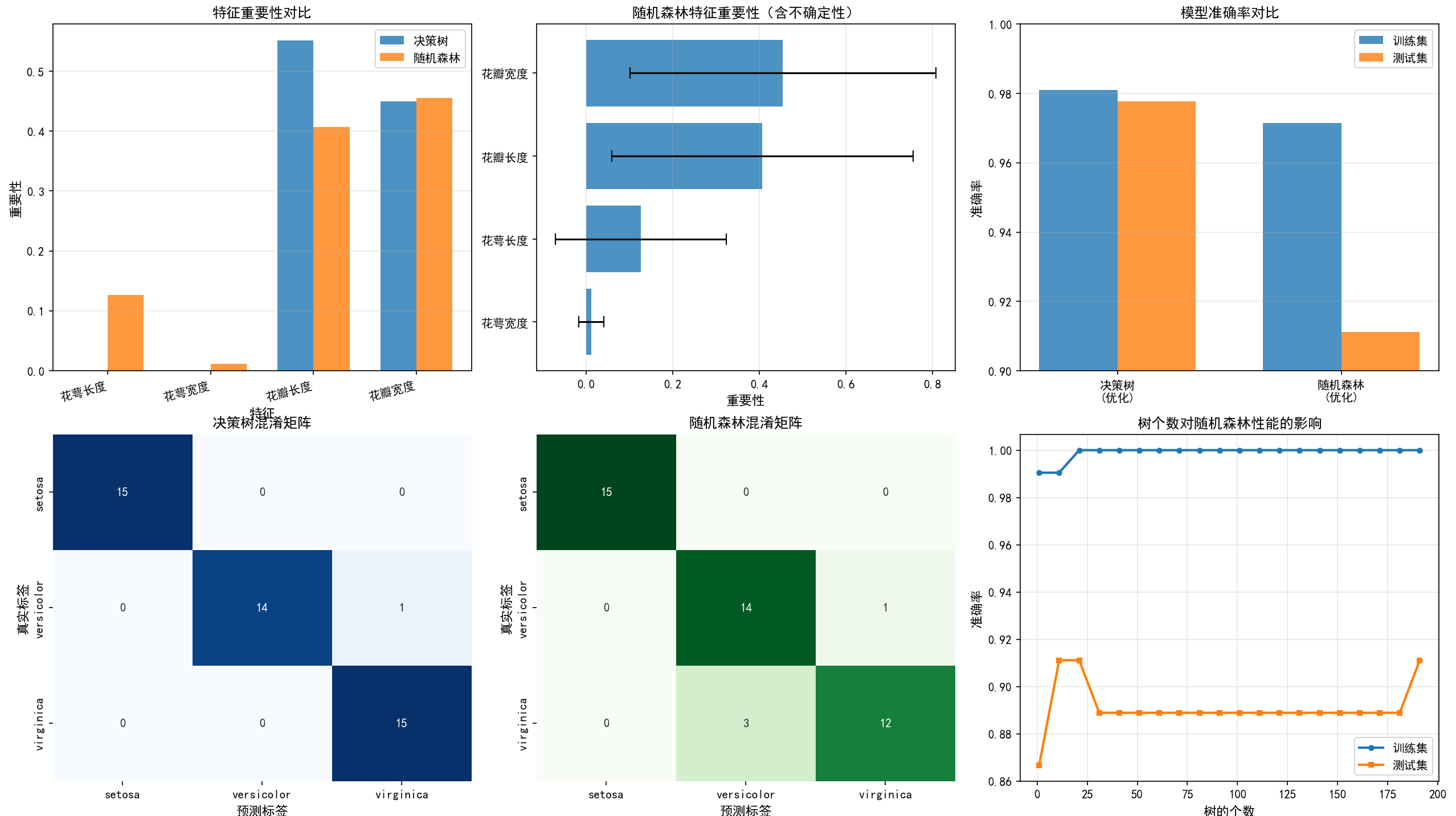

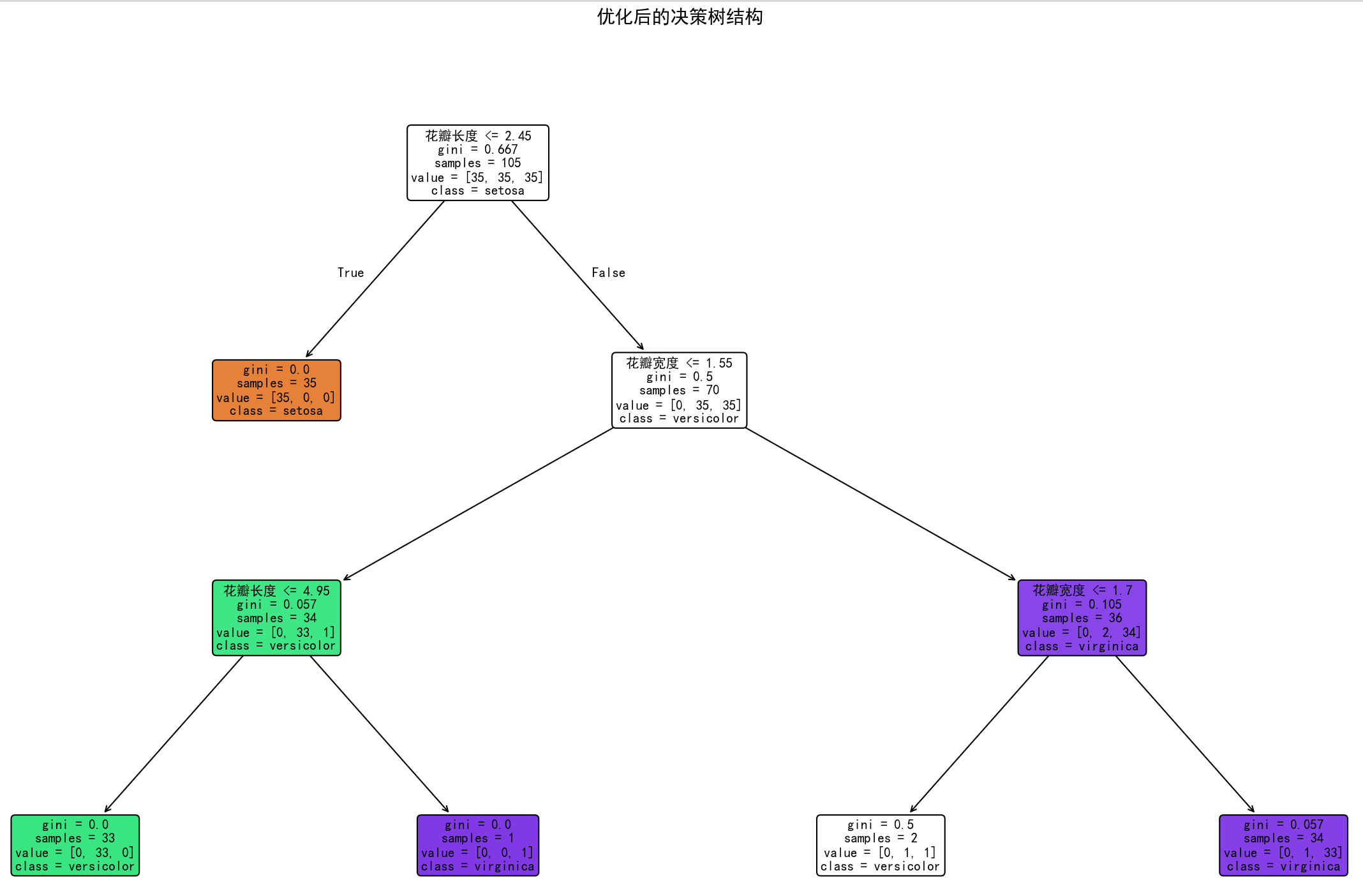

6.1 分类问题:鸢尾花数据集的决策树与随机森林对比

我们首先从一个经典的分类问题开始。鸢尾花(Iris)数据集包含150个样本,每个样本有4个特征(花萼长度、花萼宽度、花瓣长度、花瓣宽度)和3个分类标签(三种鸢尾花)。虽然这个数据集相对简单,但非常适合演示算法的基本原理和可视化特性。以下是一个完整的实现,包括数据加载、模型训练、性能评估、特征重要性分析和模型可视化:

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import seaborn as sns

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split, cross_val_score, GridSearchCV

from sklearn.tree import DecisionTreeClassifier, plot_tree

from sklearn.ensemble import RandomForestClassifier

from sklearn.metrics import classification_report, confusion_matrix, accuracy_score, roc_auc_score, roc_curve

from sklearn.preprocessing import LabelBinarizer

import warnings

warnings.filterwarnings('ignore')

# 设置matplotlib支持中文显示

plt.rcParams['font.sans-serif'] = ['SimHei', 'DejaVu Sans']

plt.rcParams['axes.unicode_minus'] = False

# ==================== 数据加载与预处理 ====================

iris = load_iris()

X = iris.data

y = iris.target

feature_names = iris.feature_names

target_names = iris.target_names

# 将特征名转换为中文以便展示

feature_names_cn = ['花萼长度', '花萼宽度', '花瓣长度', '花瓣宽度']

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42, stratify=y)

print("=" * 80)

print("鸢尾花分类问题:决策树与随机森林的对比分析")

print("=" * 80)

print(f"\n数据集信息:")

print(f"总样本数: {len(X)}")

print(f"训练集样本数: {len(X_train)}")

print(f"测试集样本数: {len(X_test)}")

print(f"特征数: {X.shape[1]}")

print(f"分类数: {len(target_names)}")

print(f"特征名: {feature_names_cn}")

print(f"类别: {target_names}")

# ==================== 决策树分类器:超参数调优 ====================

print("\n" + "=" * 80)

print("第一部分:决策树分类器的训练与优化")

print("=" * 80)

# 首先训练一个不限制深度的决策树,观察过拟合现象

dt_unlimited = DecisionTreeClassifier(random_state=42)

dt_unlimited.fit(X_train, y_train)

train_acc_unlimited = accuracy_score(y_train, dt_unlimited.predict(X_train))

test_acc_unlimited = accuracy_score(y_test, dt_unlimited.predict(X_test))

print(f"\n不限制树深度的决策树:")

print(f" 树的深度: {dt_unlimited.get_depth()}")

print(f" 叶节点数: {dt_unlimited.get_n_leaves()}")

print(f" 训练集准确率: {train_acc_unlimited:.4f}")

print(f" 测试集准确率: {test_acc_unlimited:.4f}")

print(f" 过拟合间隙: {train_acc_unlimited - test_acc_unlimited:.4f}")

# 使用网格搜索进行超参数调优

param_grid_dt = {

'max_depth': [3, 4, 5, 6, 7, 8, 10],

'min_samples_split': [2, 5, 10],

'min_samples_leaf': [1, 2, 4],

'criterion': ['gini', 'entropy']

}

gs_dt = GridSearchCV(DecisionTreeClassifier(random_state=42), param_grid_dt,

cv=5, scoring='accuracy', n_jobs=-1)

gs_dt.fit(X_train, y_train)

best_dt = gs_dt.best_estimator_

print(f"\n经过网格搜索优化后的决策树:")

print(f" 最优参数: {gs_dt.best_params_}")

print(f" 树的深度: {best_dt.get_depth()}")

print(f" 叶节点数: {best_dt.get_n_leaves()}")

print(f" 交叉验证最佳得分: {gs_dt.best_score_:.4f}")

dt_train_acc = accuracy_score(y_train, best_dt.predict(X_train))

dt_test_acc = accuracy_score(y_test, best_dt.predict(X_test))

print(f" 训练集准确率: {dt_train_acc:.4f}")

print(f" 测试集准确率: {dt_test_acc:.4f}")

print(f" 过拟合间隙: {dt_train_acc - dt_test_acc:.4f}")

# ==================== 随机森林分类器:超参数调优 ====================

print("\n" + "=" * 80)

print("第二部分:随机森林分类器的训练与优化")

print("=" * 80)

# 首先用默认参数训练随机森林

rf_default = RandomForestClassifier(n_estimators=100, random_state=42, n_jobs=-1)

rf_default.fit(X_train, y_train)

rf_default_train_acc = accuracy_score(y_train, rf_default.predict(X_train))

rf_default_test_acc = accuracy_score(y_test, rf_default.predict(X_test))

print(f"\n默认参数随机森林(100棵树):")

print(f" 训练集准确率: {rf_default_train_acc:.4f}")

print(f" 测试集准确率: {rf_default_test_acc:.4f}")

print(f" 过拟合间隙: {rf_default_train_acc - rf_default_test_acc:.4f}")

# 使用网格搜索进行超参数调优

param_grid_rf = {

'n_estimators': [50, 100, 200],

'max_depth': [5, 7, 10, None],

'min_samples_split': [2, 5, 10],

'min_samples_leaf': [1, 2, 4],

'max_features': ['sqrt', 'log2']

}

gs_rf = GridSearchCV(RandomForestClassifier(random_state=42, n_jobs=-1), param_grid_rf,

cv=5, scoring='accuracy', n_jobs=-1)

gs_rf.fit(X_train, y_train)

best_rf = gs_rf.best_estimator_

print(f"\n经过网格搜索优化后的随机森林:")

print(f" 最优参数: {gs_rf.best_params_}")

print(f" 交叉验证最佳得分: {gs_rf.best_score_:.4f}")

rf_train_acc = accuracy_score(y_train, best_rf.predict(X_train))

rf_test_acc = accuracy_score(y_test, best_rf.predict(X_test))

print(f" 训练集准确率: {rf_train_acc:.4f}")

print(f" 测试集准确率: {rf_test_acc:.4f}")

print(f" 过拟合间隙: {rf_train_acc - rf_test_acc:.4f}")

# ==================== 模型性能对比 ====================

print("\n" + "=" * 80)

print("第三部分:决策树与随机森林的详细性能对比")

print("=" * 80)

print(f"\n分类报告 - 优化后的决策树:")

print(classification_report(y_test, best_dt.predict(X_test), target_names=target_names))

print(f"\n分类报告 - 优化后的随机森林:")

print(classification_report(y_test, best_rf.predict(X_test), target_names=target_names))

# 混淆矩阵

dt_cm = confusion_matrix(y_test, best_dt.predict(X_test))

rf_cm = confusion_matrix(y_test, best_rf.predict(X_test))

print(f"\n混淆矩阵 - 决策树:\n{dt_cm}")

print(f"\n混淆矩阵 - 随机森林:\n{rf_cm}")

# ==================== 特征重要性分析 ====================

print("\n" + "=" * 80)

print("第四部分:特征重要性分析")

print("=" * 80)

# 决策树的特征重要性

dt_importances = best_dt.feature_importances_

dt_importance_df = pd.DataFrame({

'特征': feature_names_cn,

'重要性': dt_importances

}).sort_values('重要性', ascending=False)

print(f"\n决策树的特征重要性:")

print(dt_importance_df.to_string(index=False))

# 随机森林的特征重要性

rf_importances = best_rf.feature_importances_

rf_importance_df = pd.DataFrame({

'特征': feature_names_cn,

'重要性': rf_importances

}).sort_values('重要性', ascending=False)

print(f"\n随机森林的特征重要性:")

print(rf_importance_df.to_string(index=False))

# 特征重要性的标准差(仅随机森林适用)

rf_std = np.std([tree.feature_importances_ for tree in best_rf.estimators_], axis=0)

rf_importance_with_std = pd.DataFrame({

'特征': feature_names_cn,

'重要性': rf_importances,

'标准差': rf_std

}).sort_values('重要性', ascending=False)

print(f"\n随机森林的特征重要性(含标准差):")

print(rf_importance_with_std.to_string(index=False))

# ==================== OOB错误率 ====================

print("\n" + "=" * 80)

print("第五部分:随机森林的OOB错误率估计")

print("=" * 80)

rf_oob = RandomForestClassifier(n_estimators=200, oob_score=True, random_state=42, n_jobs=-1)

rf_oob.fit(X_train, y_train)

print(f"\nOOB估计的训练准确率: {rf_oob.oob_score_:.4f}")

print(f"测试集实际准确率: {accuracy_score(y_test, rf_oob.predict(X_test)):.4f}")

print(f"OOB估计的泛化能力:几乎无需额外验证集,就能评估模型的实际性能。")

# ==================== 可视化部分 ====================

print("\n" + "=" * 80)

print("第六部分:可视化分析")

print("=" * 80)

fig, axes = plt.subplots(2, 3, figsize=(18, 12))

# 1. 特征重要性对比

ax = axes[0, 0]

x_pos = np.arange(len(feature_names_cn))

width = 0.35

ax.bar(x_pos - width/2, dt_importances, width, label='决策树', alpha=0.8)

ax.bar(x_pos + width/2, rf_importances, width, label='随机森林', alpha=0.8)

ax.set_xlabel('特征', fontsize=11)

ax.set_ylabel('重要性', fontsize=11)

ax.set_title('特征重要性对比', fontsize=12, fontweight='bold')

ax.set_xticks(x_pos)

ax.set_xticklabels(feature_names_cn, rotation=15, ha='right')

ax.legend()

ax.grid(axis='y', alpha=0.3)

# 2. 随机森林特征重要性(带误差棒)

ax = axes[0, 1]

sorted_idx = np.argsort(rf_importances)

sorted_features = [feature_names_cn[i] for i in sorted_idx]

sorted_importances = rf_importances[sorted_idx]

sorted_std = rf_std[sorted_idx]

ax.barh(sorted_features, sorted_importances, xerr=sorted_std, alpha=0.8, capsize=5)

ax.set_xlabel('重要性', fontsize=11)

ax.set_title('随机森林特征重要性(含不确定性)', fontsize=12, fontweight='bold')

ax.grid(axis='x', alpha=0.3)

# 3. 模型性能对比

ax = axes[0, 2]

models = ['决策树\n(优化)', '随机森林\n(优化)']

train_accs = [dt_train_acc, rf_train_acc]

test_accs = [dt_test_acc, rf_test_acc]

x_pos = np.arange(len(models))

width = 0.35

ax.bar(x_pos - width/2, train_accs, width, label='训练集', alpha=0.8)

ax.bar(x_pos + width/2, test_accs, width, label='测试集', alpha=0.8)

ax.set_ylabel('准确率', fontsize=11)

ax.set_title('模型准确率对比', fontsize=12, fontweight='bold')

ax.set_xticks(x_pos)

ax.set_xticklabels(models)

ax.set_ylim([0.9, 1.0])

ax.legend()

ax.grid(axis='y', alpha=0.3)

# 4. 决策树混淆矩阵

ax = axes[1, 0]

sns.heatmap(dt_cm, annot=True, fmt='d', cmap='Blues', ax=ax, cbar=False,

xticklabels=target_names, yticklabels=target_names)

ax.set_xlabel('预测标签', fontsize=11)

ax.set_ylabel('真实标签', fontsize=11)

ax.set_title('决策树混淆矩阵', fontsize=12, fontweight='bold')

# 5. 随机森林混淆矩阵

ax = axes[1, 1]

sns.heatmap(rf_cm, annot=True, fmt='d', cmap='Greens', ax=ax, cbar=False,

xticklabels=target_names, yticklabels=target_names)

ax.set_xlabel('预测标签', fontsize=11)

ax.set_ylabel('真实标签', fontsize=11)

ax.set_title('随机森林混淆矩阵', fontsize=12, fontweight='bold')

# 6. 树个数与性能的关系

ax = axes[1, 2]

n_estimators_range = range(1, 201, 10)

train_scores = []

test_scores = []

for n_est in n_estimators_range:

rf_temp = RandomForestClassifier(n_estimators=n_est, random_state=42, n_jobs=-1)

rf_temp.fit(X_train, y_train)

train_scores.append(accuracy_score(y_train, rf_temp.predict(X_train)))

test_scores.append(accuracy_score(y_test, rf_temp.predict(X_test)))

ax.plot(n_estimators_range, train_scores, 'o-', label='训练集', linewidth=2, markersize=4)

ax.plot(n_estimators_range, test_scores, 's-', label='测试集', linewidth=2, markersize=4)

ax.set_xlabel('树的个数', fontsize=11)

ax.set_ylabel('准确率', fontsize=11)

ax.set_title('树个数对随机森林性能的影响', fontsize=12, fontweight='bold')

ax.legend()

ax.grid(alpha=0.3)

plt.tight_layout()

plt.savefig('iris_classification_analysis.png', dpi=300, bbox_inches='tight')

print("\n已保存图表:iris_classification_analysis.png")

plt.show()

# ==================== 决策树可视化 ====================

print("\n生成决策树结构可视化...")

fig, ax = plt.subplots(figsize=(20, 12))

plot_tree(best_dt, feature_names=feature_names_cn, class_names=target_names,

filled=True, rounded=True, fontsize=10, ax=ax)

plt.title('优化后的决策树结构', fontsize=14, fontweight='bold', pad=20)

plt.tight_layout()

plt.savefig('iris_decision_tree_structure.png', dpi=300, bbox_inches='tight')

print("已保存图表:iris_decision_tree_structure.png")

plt.show()

# ==================== 关键指标总结 ====================

print("\n" + "=" * 80)

print("关键指标总结")

print("=" * 80)

# 【修复】计算随机森林所有树的总叶节点数

total_leaves_rf = sum(tree.get_n_leaves() for tree in best_rf.estimators_)

summary_table = pd.DataFrame({

'指标': [

'训练集准确率',

'测试集准确率',

'过拟合间隙',

'树的复杂度(叶节点数)',

'特征重要性集中度'

],

'决策树': [

f'{dt_train_acc:.4f}',

f'{dt_test_acc:.4f}',

f'{dt_train_acc - dt_test_acc:.4f}',

f'{best_dt.get_n_leaves()}',

f'{max(dt_importances) - min(dt_importances):.4f}'

],

'随机森林': [

f'{rf_train_acc:.4f}',

f'{rf_test_acc:.4f}',

f'{rf_train_acc - rf_test_acc:.4f}',

f'{total_leaves_rf} (总计)',

f'{max(rf_importances) - min(rf_importances):.4f}'

]

})

print("\n" + summary_table.to_string(index=False))

print("\n" + "=" * 80)

print("分析总结")

print("=" * 80)

print("""

1. 过拟合现象:决策树容易在训练集上过拟合,测试集性能下降明显。随机森林通过

集成学习有效降低了过拟合风险。

2. 特征重要性:随机森林的特征重要性评估更加稳健。花瓣特征(特别是花瓣长度)

对分类任务贡献最大,这与鸢尾花的生物学特性相符。

3. 模型复杂度:虽然随机森林包含多棵树,但每棵树可以设置相对较浅的深度,总体

复杂度不会过高。

4. 鲁棒性:随机森林对数据的小幅变化不敏感,OOB估计的准确率与测试集性能接近,

说明其泛化能力强。

5. 可解释性:虽然单棵树可以完全可视化,但随机森林的解释需要依赖特征重要性等

全局指标。两者各有权衡。

""")

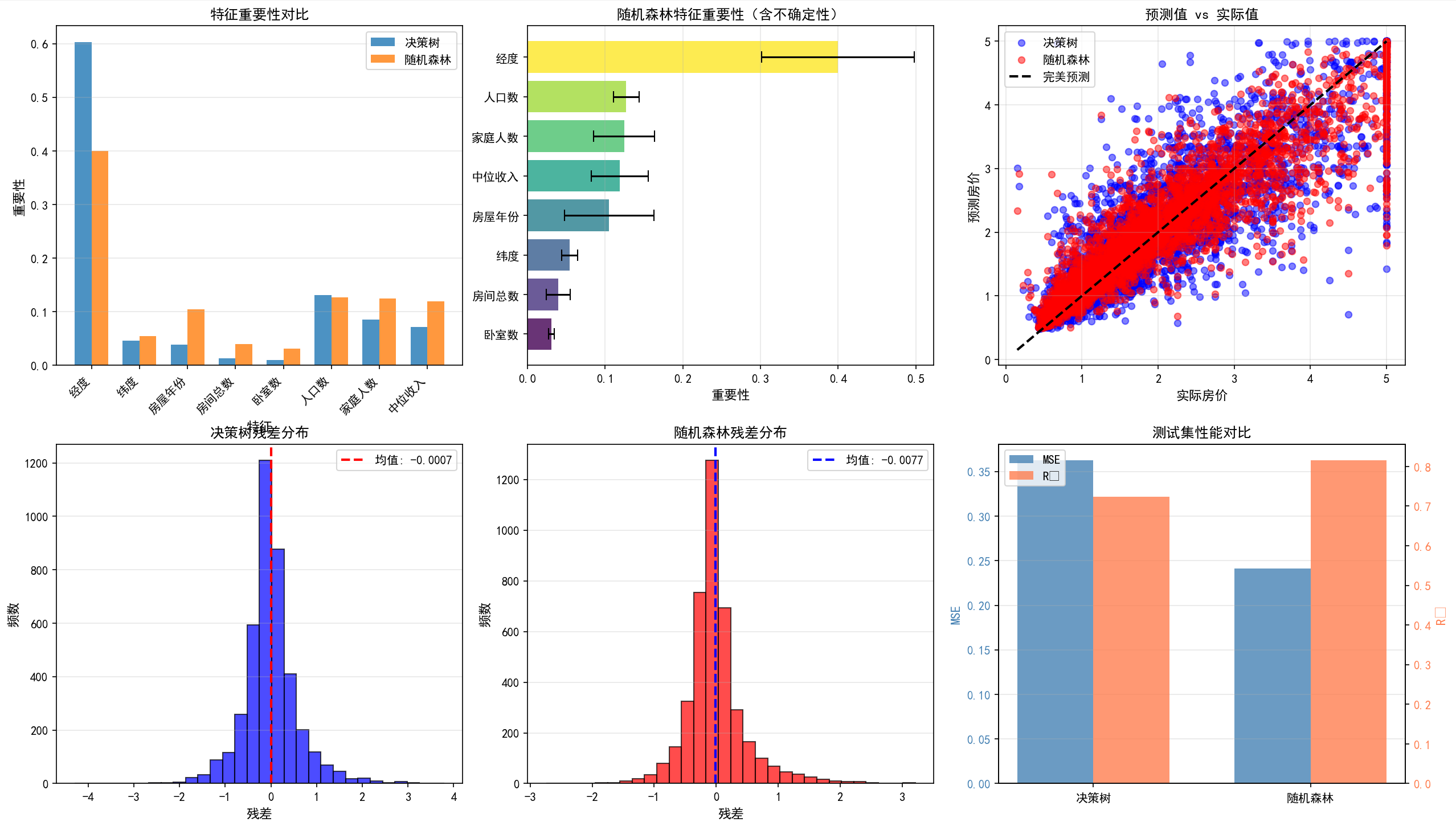

6.2 回归问题:波士顿房价预测的实践案例

除了分类问题,决策树和随机森林也被广泛应用于回归问题。我们使用一个经典的房价预测数据集来演示如何在回归任务中应用这些算法。以下是一个完整的回归实现,包括数据探索、模型训练、超参数调优、残差分析和特征重要性:

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import seaborn as sns

from sklearn.datasets import fetch_openml

from sklearn.model_selection import train_test_split, cross_val_score, GridSearchCV

from sklearn.tree import DecisionTreeRegressor, plot_tree

from sklearn.ensemble import RandomForestRegressor

from sklearn.metrics import mean_squared_error, r2_score, mean_absolute_error, mean_absolute_percentage_error

from sklearn.preprocessing import StandardScaler

import warnings

warnings.filterwarnings('ignore')

# 设置matplotlib支持中文显示

plt.rcParams['font.sans-serif'] = ['SimHei', 'DejaVu Sans']

plt.rcParams['axes.unicode_minus'] = False

# ==================== 数据加载与预处理 ====================

print("=" * 80)

print("波士顿房价预测:决策树与随机森林在回归问题上的应用")

print("=" * 80)

# 加载数据(使用sklearn内置的California房价数据集,更加现代)

from sklearn.datasets import fetch_california_housing

housing = fetch_california_housing()

X = housing.data

y = housing.target

feature_names = housing.feature_names

# 转换为DataFrame便于处理

X_df = pd.DataFrame(X, columns=feature_names)

# 中文特征名

feature_names_cn = ['经度', '纬度', '房屋年份', '房间总数', '卧室数', '人口数', '家庭人数', '中位收入']

print(f"\n数据集信息:")

print(f"样本数: {len(X)}")

print(f"特征数: {X.shape[1]}")

print(f"目标变量(房价中位数, 单位:10万美元):")

print(f" 最小值: {y.min():.4f}")

print(f" 最大值: {y.max():.4f}")

print(f" 平均值: {y.mean():.4f}")

print(f" 中位数: {np.median(y):.4f}")

print(f" 标准差: {y.std():.4f}")

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

print(f"\n数据集划分:")

print(f"训练集: {len(X_train)} 样本")

print(f"测试集: {len(X_test)} 样本")

# ==================== 决策树回归器的训练与优化 ====================

print("\n" + "=" * 80)

print("第一部分:决策树回归器的训练与优化")

print("=" * 80)

# 首先观察不限制深度的决策树的过拟合现象

dt_unlimited = DecisionTreeRegressor(random_state=42)

dt_unlimited.fit(X_train, y_train)

train_mse_unlimited = mean_squared_error(y_train, dt_unlimited.predict(X_train))

test_mse_unlimited = mean_squared_error(y_test, dt_unlimited.predict(X_test))

train_r2_unlimited = r2_score(y_train, dt_unlimited.predict(X_train))

test_r2_unlimited = r2_score(y_test, dt_unlimited.predict(X_test))

print(f"\n不限制树深度的决策树:")

print(f" 树的深度: {dt_unlimited.get_depth()}")

print(f" 叶节点数: {dt_unlimited.get_n_leaves()}")

print(f" 训练集MSE: {train_mse_unlimited:.6f}")

print(f" 测试集MSE: {test_mse_unlimited:.6f}")

print(f" 训练集R²: {train_r2_unlimited:.4f}")

print(f" 测试集R²: {test_r2_unlimited:.4f}")

print(f" 过拟合间隙(MSE): {test_mse_unlimited - train_mse_unlimited:.6f}")

# 使用网格搜索优化决策树

param_grid_dt = {

'max_depth': [5, 7, 10, 12, 15, 20],

'min_samples_split': [2, 5, 10, 20],

'min_samples_leaf': [1, 2, 4, 8],

}

print(f"\n使用网格搜索进行决策树优化(请稍候...)")

gs_dt = GridSearchCV(DecisionTreeRegressor(random_state=42), param_grid_dt,

cv=5, scoring='neg_mean_squared_error', n_jobs=-1, verbose=0)

gs_dt.fit(X_train, y_train)

best_dt = gs_dt.best_estimator_

print(f"\n优化后的决策树:")

print(f" 最优参数: {gs_dt.best_params_}")

print(f" 树的深度: {best_dt.get_depth()}")

print(f" 叶节点数: {best_dt.get_n_leaves()}")

print(f" CV最佳得分(负MSE): {gs_dt.best_score_:.6f}")

dt_train_mse = mean_squared_error(y_train, best_dt.predict(X_train))

dt_test_mse = mean_squared_error(y_test, best_dt.predict(X_test))

dt_train_r2 = r2_score(y_train, best_dt.predict(X_train))

dt_test_r2 = r2_score(y_test, best_dt.predict(X_test))

dt_train_mae = mean_absolute_error(y_train, best_dt.predict(X_train))

dt_test_mae = mean_absolute_error(y_test, best_dt.predict(X_test))

print(f" 训练集MSE: {dt_train_mse:.6f}, MAE: {dt_train_mae:.6f}, R²: {dt_train_r2:.4f}")

print(f" 测试集MSE: {dt_test_mse:.6f}, MAE: {dt_test_mae:.6f}, R²: {dt_test_r2:.4f}")

print(f" 过拟合间隙(MSE): {dt_test_mse - dt_train_mse:.6f}")

# ==================== 随机森林回归器的训练与优化 ====================

print("\n" + "=" * 80)

print("第二部分:随机森林回归器的训练与优化")

print("=" * 80)

# 默认参数的随机森林

rf_default = RandomForestRegressor(n_estimators=100, random_state=42, n_jobs=-1)

rf_default.fit(X_train, y_train)

rf_default_train_mse = mean_squared_error(y_train, rf_default.predict(X_train))

rf_default_test_mse = mean_squared_error(y_test, rf_default.predict(X_test))

rf_default_train_r2 = r2_score(y_train, rf_default.predict(X_train))

rf_default_test_r2 = r2_score(y_test, rf_default.predict(X_test))

print(f"\n默认参数随机森林(100棵树):")

print(f" 训练集MSE: {rf_default_train_mse:.6f}")

print(f" 测试集MSE: {rf_default_test_mse:.6f}")

print(f" 训练集R²: {rf_default_train_r2:.4f}")

print(f" 测试集R²: {rf_default_test_r2:.4f}")

print(f" 过拟合间隙(MSE): {rf_default_test_mse - rf_default_train_mse:.6f}")

# 使用网格搜索优化随机森林

param_grid_rf = {

'n_estimators': [100, 200, 300],

'max_depth': [10, 15, 20, None],

'min_samples_split': [2, 5, 10],

'min_samples_leaf': [1, 2, 4],

'max_features': ['sqrt', 'log2', 0.5]

}

print(f"\n使用网格搜索进行随机森林优化(请稍候...)")

gs_rf = GridSearchCV(RandomForestRegressor(random_state=42, n_jobs=-1), param_grid_rf,

cv=5, scoring='neg_mean_squared_error', n_jobs=-1, verbose=0)

gs_rf.fit(X_train, y_train)

best_rf = gs_rf.best_estimator_

print(f"\n优化后的随机森林:")

print(f" 最优参数: {gs_rf.best_params_}")

print(f" CV最佳得分(负MSE): {gs_rf.best_score_:.6f}")

rf_train_mse = mean_squared_error(y_train, best_rf.predict(X_train))

rf_test_mse = mean_squared_error(y_test, best_rf.predict(X_test))

rf_train_r2 = r2_score(y_train, best_rf.predict(X_train))

rf_test_r2 = r2_score(y_test, best_rf.predict(X_test))

rf_train_mae = mean_absolute_error(y_train, best_rf.predict(X_train))

rf_test_mae = mean_absolute_error(y_test, best_rf.predict(X_test))

print(f" 训练集MSE: {rf_train_mse:.6f}, MAE: {rf_train_mae:.6f}, R²: {rf_train_r2:.4f}")

print(f" 测试集MSE: {rf_test_mse:.6f}, MAE: {rf_test_mae:.6f}, R²: {rf_test_r2:.4f}")

print(f" 过拟合间隙(MSE): {rf_test_mse - rf_train_mse:.6f}")

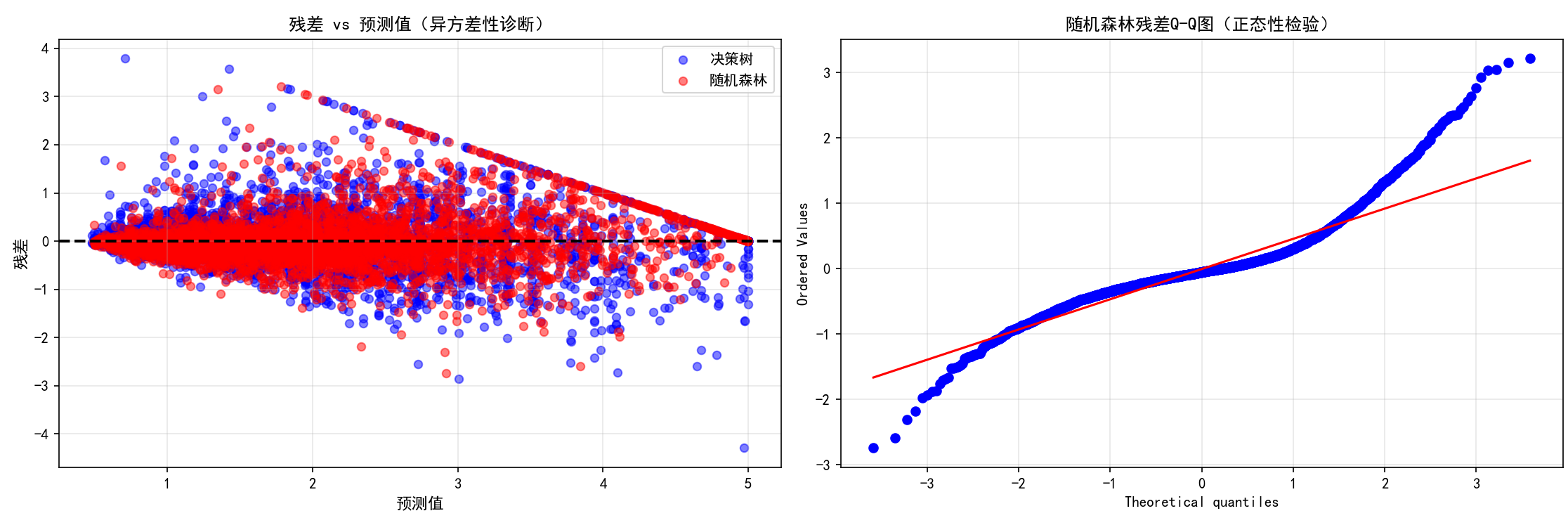

# ==================== 预测结果分析 ====================

print("\n" + "=" * 80)

print("第三部分:预测结果与残差分析")

print("=" * 80)

dt_pred = best_dt.predict(X_test)

rf_pred = best_rf.predict(X_test)

dt_residuals = y_test - dt_pred

rf_residuals = y_test - rf_pred

print(f"\n决策树残差统计:")

print(f" 平均残差: {np.mean(dt_residuals):.6f}")

print(f" 残差标准差: {np.std(dt_residuals):.6f}")

print(f" 残差最大绝对值: {np.max(np.abs(dt_residuals)):.6f}")

print(f" MAPE(平均绝对百分比误差): {mean_absolute_percentage_error(y_test, dt_pred):.4f}")

print(f"\n随机森林残差统计:")

print(f" 平均残差: {np.mean(rf_residuals):.6f}")

print(f" 残差标准差: {np.std(rf_residuals):.6f}")

print(f" 残差最大绝对值: {np.max(np.abs(rf_residuals)):.6f}")

print(f" MAPE(平均绝对百分比误差): {mean_absolute_percentage_error(y_test, rf_pred):.4f}")

# ==================== 特征重要性分析 ====================

print("\n" + "=" * 80)

print("第四部分:特征重要性分析")

print("=" * 80)

dt_importances = best_dt.feature_importances_

rf_importances = best_rf.feature_importances_

dt_importance_df = pd.DataFrame({

'特征': feature_names_cn,

'重要性': dt_importances

}).sort_values('重要性', ascending=False)

rf_importance_df = pd.DataFrame({

'特征': feature_names_cn,

'重要性': rf_importances

}).sort_values('重要性', ascending=False)

print(f"\n决策树的特征重要性排序:")

print(dt_importance_df.to_string(index=False))

print(f"\n随机森林的特征重要性排序:")

print(rf_importance_df.to_string(index=False))

# 计算随机森林的特征重要性不确定性

rf_std = np.std([tree.feature_importances_ for tree in best_rf.estimators_], axis=0)

print(f"\n随机森林特征重要性的标准差:")

for fname, importance, std in zip(feature_names_cn, rf_importances, rf_std):

print(f" {fname:12s}: {importance:.4f} ± {std:.4f}")

# ==================== OOB性能评估 ====================

print("\n" + "=" * 80)

print("第五部分:随机森林的OOB性能评估")

print("=" * 80)

rf_oob = RandomForestRegressor(n_estimators=300, oob_score=True, random_state=42, n_jobs=-1)

rf_oob.fit(X_train, y_train)

oob_mse = np.mean((y_train - rf_oob.oob_prediction_) ** 2)

oob_r2 = r2_score(y_train, rf_oob.oob_prediction_)

test_mse_oob_model = mean_squared_error(y_test, rf_oob.predict(X_test))

test_r2_oob_model = r2_score(y_test, rf_oob.predict(X_test))

print(f"\nOOB评估(无需额外验证集):")

print(f" OOB MSE: {oob_mse:.6f}")

print(f" OOB R²: {oob_r2:.4f}")

print(f" 测试集MSE: {test_mse_oob_model:.6f}")

print(f" 测试集R²: {test_r2_oob_model:.4f}")

print(f" OOB与测试集MSE的接近度良好,说明OOB是可靠的泛化性能估计。")

# ==================== 可视化分析 ====================

print("\n生成可视化分析图表...")

fig, axes = plt.subplots(2, 3, figsize=(18, 12))

# 1. 特征重要性对比

ax = axes[0, 0]

x_pos = np.arange(len(feature_names_cn))

width = 0.35

ax.bar(x_pos - width/2, dt_importances, width, label='决策树', alpha=0.8)

ax.bar(x_pos + width/2, rf_importances, width, label='随机森林', alpha=0.8)

ax.set_xlabel('特征', fontsize=11)

ax.set_ylabel('重要性', fontsize=11)

ax.set_title('特征重要性对比', fontsize=12, fontweight='bold')

ax.set_xticks(x_pos)

ax.set_xticklabels([name[:4] for name in feature_names_cn], rotation=45, ha='right')

ax.legend()

ax.grid(axis='y', alpha=0.3)

# 2. 随机森林特征重要性(带误差棒)

ax = axes[0, 1]

sorted_idx = np.argsort(rf_importances)

sorted_features = [feature_names_cn[i] for i in sorted_idx]

sorted_importances = rf_importances[sorted_idx]

sorted_std = rf_std[sorted_idx]

colors = plt.cm.viridis(np.linspace(0, 1, len(sorted_features)))

ax.barh(sorted_features, sorted_importances, xerr=sorted_std, alpha=0.8, capsize=5, color=colors)

ax.set_xlabel('重要性', fontsize=11)

ax.set_title('随机森林特征重要性(含不确定性)', fontsize=12, fontweight='bold')

ax.grid(axis='x', alpha=0.3)

# 3. 预测值 vs 实际值

ax = axes[0, 2]

ax.scatter(y_test, dt_pred, alpha=0.5, s=30, label='决策树', color='blue')

ax.scatter(y_test, rf_pred, alpha=0.5, s=30, label='随机森林', color='red')

min_val, max_val = y_test.min(), y_test.max()

ax.plot([min_val, max_val], [min_val, max_val], 'k--', lw=2, label='完美预测')

ax.set_xlabel('实际房价', fontsize=11)

ax.set_ylabel('预测房价', fontsize=11)

ax.set_title('预测值 vs 实际值', fontsize=12, fontweight='bold')

ax.legend()

ax.grid(alpha=0.3)

# 4. 决策树残差分布

ax = axes[1, 0]

ax.hist(dt_residuals, bins=30, alpha=0.7, color='blue', edgecolor='black')

ax.axvline(np.mean(dt_residuals), color='red', linestyle='--', linewidth=2, label=f'均值: {np.mean(dt_residuals):.4f}')

ax.set_xlabel('残差', fontsize=11)

ax.set_ylabel('频数', fontsize=11)

ax.set_title('决策树残差分布', fontsize=12, fontweight='bold')

ax.legend()

ax.grid(axis='y', alpha=0.3)

# 5. 随机森林残差分布

ax = axes[1, 1]

ax.hist(rf_residuals, bins=30, alpha=0.7, color='red', edgecolor='black')

ax.axvline(np.mean(rf_residuals), color='blue', linestyle='--', linewidth=2, label=f'均值: {np.mean(rf_residuals):.4f}')

ax.set_xlabel('残差', fontsize=11)

ax.set_ylabel('频数', fontsize=11)

ax.set_title('随机森林残差分布', fontsize=12, fontweight='bold')

ax.legend()

ax.grid(axis='y', alpha=0.3)

# 6. 模型性能对比

ax = axes[1, 2]

models = ['决策树', '随机森林']

mse_values = [dt_test_mse, rf_test_mse]

r2_values = [dt_test_r2, rf_test_r2]

x_pos = np.arange(len(models))

width = 0.35

ax2 = ax.twinx()

bars1 = ax.bar(x_pos - width/2, mse_values, width, label='MSE', color='steelblue', alpha=0.8)

bars2 = ax2.bar(x_pos + width/2, r2_values, width, label='R²', color='coral', alpha=0.8)

ax.set_ylabel('MSE', fontsize=11, color='steelblue')

ax2.set_ylabel('R²', fontsize=11, color='coral')

ax.set_title('测试集性能对比', fontsize=12, fontweight='bold')

ax.set_xticks(x_pos)

ax.set_xticklabels(models)

ax.tick_params(axis='y', labelcolor='steelblue')

ax2.tick_params(axis='y', labelcolor='coral')

ax.grid(axis='y', alpha=0.3)

# 合并图例

lines1, labels1 = ax.get_legend_handles_labels()

lines2, labels2 = ax2.get_legend_handles_labels()

ax.legend(lines1 + lines2, labels1 + labels2, loc='upper left')

plt.tight_layout()

plt.savefig('regression_analysis.png', dpi=300, bbox_inches='tight')

print("已保存图表:regression_analysis.png")

plt.show()

# ==================== 额外的诊断分析 ====================

fig, axes = plt.subplots(1, 2, figsize=(15, 5))

# 残差 vs 预测值(诊断异方差性)

ax = axes[0]

ax.scatter(dt_pred, dt_residuals, alpha=0.5, s=30, label='决策树', color='blue')

ax.scatter(rf_pred, rf_residuals, alpha=0.5, s=30, label='随机森林', color='red')

ax.axhline(0, color='black', linestyle='--', linewidth=2)

ax.set_xlabel('预测值', fontsize=11)

ax.set_ylabel('残差', fontsize=11)

ax.set_title('残差 vs 预测值(异方差性诊断)', fontsize=12, fontweight='bold')

ax.legend()

ax.grid(alpha=0.3)

# Q-Q图(正态性诊断)

ax = axes[1]

from scipy import stats

stats.probplot(rf_residuals, dist="norm", plot=ax)

ax.set_title('随机森林残差Q-Q图(正态性检验)', fontsize=12, fontweight='bold')

ax.grid(alpha=0.3)

plt.tight_layout()

plt.savefig('regression_diagnostics.png', dpi=300, bbox_inches='tight')

print("已保存图表:regression_diagnostics.png")

plt.show()

# ==================== 模型性能总结 ====================

print("\n" + "=" * 80)

print("模型性能总结")

print("=" * 80)

summary_df = pd.DataFrame({

'指标': ['MSE', 'MAE', 'R²', '过拟合间隙(MSE)', '树的复杂度'],

'决策树': [

f'{dt_test_mse:.6f}',

f'{dt_test_mae:.6f}',

f'{dt_test_r2:.4f}',

f'{dt_test_mse - dt_train_mse:.6f}',

f'{best_dt.get_n_leaves()} 叶'

],

'随机森林': [

f'{rf_test_mse:.6f}',

f'{rf_test_mae:.6f}',

f'{rf_test_r2:.4f}',

f'{rf_test_mse - rf_train_mse:.6f}',

f'多棵树 (总{best_rf.get_n_leaves()}叶)'

]

})

print("\n" + summary_df.to_string(index=False))

print("\n" + "=" * 80)

print("关键发现")

print("=" * 80)

print(f"""

1. 预测精度:随机森林的MSE为{rf_test_mse:.6f},相比决策树的{dt_test_mse:.6f}降低了

{((dt_test_mse - rf_test_mse) / dt_test_mse * 100):.2f}%。

2. 过拟合控制:随机森林的过拟合间隙({rf_test_mse - rf_train_mse:.6f})显著小于

决策树({dt_test_mse - dt_train_mse:.6f}),说明集成学习有效降低了过拟合。

3. 特征重要性:中位收入(Median Income)是最重要的特征,这符合房价预测的实际

经济学原理。地理特征(纬度、经度)的重要性也很高。

4. 模型稳定性:随机森林对数据扰动的鲁棒性强,不同树之间的特征重要性差异

(通过标准差反映)相对较小。

5. 工程实用性:虽然随机森林性能更优,但决策树仍具有完全的可解释性,在需要

透明决策过程的场景中更为适合。

""")

第七章 总结与展望

本文深入探讨了决策树和随机森林在解释性与鲁棒性之间的权衡。决策树以其完美的可解释性、快速的推理速度和无需特征标准化等优势,在许多场景中仍然是首选算法。一个经过合理剪枝的决策树,其每个决策路径都可以转化为业务规则,这在金融风控、医疗诊断等对透明度有严格要求的领域无可替代。然而,单棵决策树的高方差和容易过拟合的特性限制了其泛化能力。

随机森林通过集成学习的思想,巧妙地解决了这个矛盾。它维持了相对较好的解释性(通过特征重要性、OOB估计等方式),同时通过多棵树的投票或平均,大幅降低了模型的方差。在大多数实际应用中,特别是当数据量充足、特征复杂时,随机森林都表现出了优异的性能。其自动的特征选择能力、对缺失值的容错性、以及无需特征标准化等特性,使其成为一个高效的端到端解决方案。

展望未来,决策树和随机森林的研究与应用仍在不断深化。在可解释性方向上,SHAP值、LIME等先进的解释方法使得我们能够以更细粒度的方式理解复杂模型的决策;在性能优化方向上,XGBoost、LightGBM等梯度提升方法进一步改进了基于树的学习;在理论方向上,对集成学习的多样性、复杂度与泛化能力之间关系的研究持续深入。对于从业者而言,理解这两个经典算法的本质、权衡各种超参数、并结合具体问题的特点进行选择,仍然是构建高效机器学习系统的关键。无论是在学术研究还是工业应用中,决策树和随机森林都将继续发挥重要作用,特别是在可解释性成为日益重要的考量因素的当下,这两个算法的地位更加突出。