MCP(Model Context Protocol):AI 与外部世界交互的标准化协议

在 AI 技术飞速发展的今天,大语言模型(LLM)的能力边界不断被突破,但模型与外部数据源、工具的对接始终面临"接口碎片化、集成复杂、复用性低"的痛点。2024 年,Anthropic 推出的 MCP(Model Context Protocol,模型上下文协议),为这一问题提供了标准化解决方案。本文将从概念、架构、工作原理、与 Function Call 的关系等维度,全面解析 MCP 的核心价值与应用前景。

1. 什么是 MCP?

MCP(Model Context Protocol,模型上下文协议)是 Anthropic 推出的开放标准协议 ,核心作用是为大语言模型(LLM)提供标准化的上下文交互方式,让 LLM 能够规范地对接各类外部数据源和工具,实现"模型-外部资源"的高效、统一通信。

MCP是一种用于大模型工具调用的开源协议,提供标准化交互方式允许AI模型实时调用外部服务获取信息或执行操作采用分离式架构,模型与工具解耦,系统更灵活可扩展。

1.1 通俗类比:AI 应用的"USB-C 接口"

我们可以用生活中常见的 USB-C 接口来理解 MCP 的价值:

- USB-C 打破了不同电子设备、外设的连接壁垒,提供了统一的供电、数据传输标准,不管是手机、电脑还是充电器、移动硬盘,只要支持 USB-C 就能无缝对接;

- MCP 则打破了 LLM 与外部工具、数据源的"通信孤岛",为实时数据库、第三方工具、本地文件等不同类型的外部资源,提供了标准化接入方式。这意味着 AI 模型无需针对不同工具单独适配,就像手机插 USB-C 接口就能连接各种外设一样,大幅扩展了 AI 系统的能力边界。

工作原理及架构:客户端- 服务端架构,客户端集成AI模型,服务端处理工具调用、使用JSON协议通信,交互分三步:模型识别请求、服务端调用工 具、返回结果整合回答

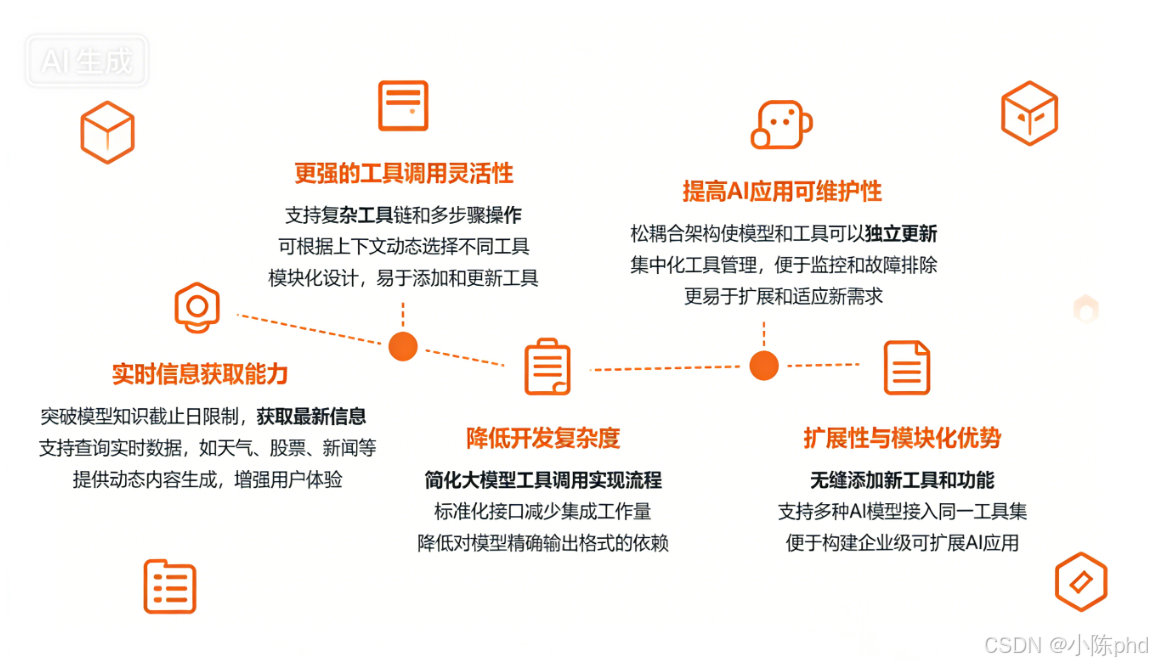

2. MCP 的核心价值

MCP 的推出直击 AI 模型与外部世界交互的四大关键痛点,其核心价值体现在以下四个方面:

2.1 功能扩展:突破模型的"能力天花板"

LLM 存在两大天然局限:一是训练数据的"时间局限性",无法覆盖实时信息(如最新天气、股票行情);二是"能力局限性",仅能处理文本生成,无法执行具体操作(如查询数据库、控制硬件)。

MCP 让模型能够访问实时数据、调用专业工具,轻松突破这两大局限------比如 AI 助手可通过 MCP 对接航班数据库查询实时动态,也能调用计算器完成复杂运算,从"只会说话"升级为"能办实事"。

2.2 标准化通信:降低集成复杂度

在 MCP 出现前,不同工具、数据源的接口格式、请求方式、响应规范千差万别。开发者需要为每个工具编写专属适配代码,不仅工作量大,后续维护也十分繁琐(比如工具接口更新后,适配代码需同步修改)。

MCP 定义了统一的请求格式、响应规范和错误处理机制,相当于为所有"模型-外部资源"的交互制定了"普通话"。开发者无需关注工具的底层实现,只需按照 MCP 协议发起请求,大幅降低了 AI 系统集成外部资源的成本。

2.3 工具重用:提升开发效率

基于 MCP 开发的工具(如数据查询工具、文件解析工具)具备"一次开发、多场景复用"的特性。比如开发者为某 AI 应用开发的 Excel 解析工具,无需修改代码,就能直接用于其他支持 MCP 协议的 AI 平台或应用中,避免了重复开发,显著提升了开发效率。

2.4 跨模型兼容:打破厂商壁垒

MCP 是开放标准,不绑定任何特定 LLM 提供商(如 Anthropic、OpenAI、谷歌等)。不同厂商的模型只要支持 MCP 协议,就能直接使用同一套工具集------比如 Claude 和 GPT-4 可共用一个实时新闻查询工具,无需为每个模型单独适配。这不仅降低了模型迁移的成本,也为多模型协作提供了便利。

3. MCP 的技术架构与核心组件

MCP 采用"主机-客户端-服务端"的三层架构,各组件职责清晰、协同工作,实现了"需求方"与"资源方"的解耦。

| 组件 | 核心职责 | 典型示例 |

|---|---|---|

| MCP 主机端(Host) | 发起请求的"需求方",即需要调用外部资源的 AI 应用或程序,负责整合模型输出与外部工具结果 | Claude 桌面应用、AI 开发 IDE(如 VS Code 插件)、企业内部 AI 助手系统 |

| MCP 客户端(Client) | 协议的"传输中介",与服务端建立一对一专属连接,负责将主机端的请求标准化,同时将服务端的响应解析后返回主机端 | 遵循 MCP 协议开发的轻量级客户端程序、嵌入 AI 应用的协议模块 |

| MCP 服务端(Server) | 提供具体功能的"资源方",通过 MCP 协议暴露特定能力,接收标准化请求后执行操作并返回结果 | 实时数据查询服务器、文件解析服务、第三方工具 API 适配服务(如地图、支付工具) |

3.1 架构优势:解耦与灵活扩展

MCP 架构的核心优势是"解耦":

- 主机端无需关注服务端的具体实现(比如工具的底层逻辑、数据源的存储方式),仅需通过标准化协议发起请求;

- 服务端也无需适配不同主机端的需求,仅需按照协议规范暴露功能。

这种解耦设计让 AI 系统能够灵活扩展------新增工具时,只需开发对应的 MCP 服务端,无需修改主机端代码;更换模型时,只要模型支持 MCP 协议,就能直接复用现有工具集。

4. MCP 的工作原理与流程

MCP 的核心工作逻辑是"标准化请求-执行-响应"的闭环,整个流程无需 LLM 参与底层通信,让模型专注于核心决策与结果整合。具体流程如下:

- 需求发起:MCP 主机端(如 AI 助手)根据用户需求或模型决策,确定需要调用外部资源(如查询实时航班信息),并向 MCP 客户端发送请求(包含操作类型、参数等)。

- 请求标准化:MCP 客户端将主机端的原始请求转换为 MCP 协议规定的统一格式(如标准化的 JSON 结构、请求头信息),确保服务端能够识别。

- 通信传输:客户端通过专属连接将标准化请求发送至对应的 MCP 服务端(如航班信息查询服务端),同时处理传输过程中的网络问题、加密验证等。

- 功能执行:MCP 服务端接收请求后,执行具体操作(如调用航空公司实时数据库查询航班状态),并按照 MCP 协议规范生成响应结果(包含数据、状态码、错误信息等)。

- 响应解析与返回:客户端将服务端的响应解析为主机端可识别的格式,返回给 MCP 主机端。

- 结果整合:主机端将外部工具的响应结果与 LLM 的生成能力结合(如将航班信息整理为自然语言回答),最终反馈给用户。

5. MCP 与 Function Call 的区别与联系

MCP 和 Function Call 都是帮助 LLM 调用外部工具的关键技术,但两者的定位、范围和标准化程度存在本质差异。

5.1 核心联系:目标一致,互为支撑

两者的核心目标完全一致------帮助 LLM 突破自身能力局限,通过对接外部资源实现更复杂的任务(如数据查询、逻辑计算、操作执行)。可以说,Function Call 是"模型发起调用的能力",MCP 是"让调用更高效、更通用的标准",两者互为支撑,共同推动 AI 从"文本生成"向"实用工具"升级。

5.2 核心区别:定位与范围不同

| 对比维度 | MCP(Model Context Protocol) | Function Call(函数调用) |

|---|---|---|

| 核心定位 | 开放的标准化协议,聚焦"模型与外部资源的通信规范" | 模型的功能特性,聚焦"模型如何发起工具调用请求" |

| 覆盖范围 | 全链路覆盖(请求格式、通信方式、响应规范、跨模型兼容),是端到端的交互标准 | 仅覆盖"模型输出调用指令"的环节(如生成函数名、参数),不涉及后续通信和适配 |

| 标准化程度 | 高(开放标准,统一规范),不同工具/模型需遵循同一协议 | 低(无统一标准),不同模型(如 GPT-4、Claude)的函数调用格式、参数要求不同 |

| 工具复用性 | 高(基于 MCP 开发的工具可跨应用、跨模型复用) | 低(需为不同模型适配函数调用格式,工具复用成本高) |

| 适用场景 | 复杂 AI 系统、多工具集成、多模型协作、企业级应用开发 | 简单工具调用场景(如单模型调用单一工具)、快速原型开发 |

5.3 通俗理解

Function Call 是"模型会说话的嘴"------让模型能够发出"调用工具"的指令;而 MCP 是"统一的语言和通信规则"------让不同模型的"嘴"说同一种话,让不同的工具都能听懂。

没有 MCP 时,不同模型的 Function Call 如同"方言",工具需要逐一适配;有了 MCP 后,所有模型和工具都使用"普通话",实现无缝对接。

6. MCP 的应用场景与实践价值

MCP 的标准化、高复用、跨兼容特性,使其在多个场景中具备极高的实践价值,尤其适合复杂 AI 系统和企业级应用。

6.1 典型应用场景

- 企业级 AI 助手:企业内部 AI 助手需对接 CRM 系统(查询客户信息)、ERP 系统(查询库存数据)、考勤系统(查询员工考勤)等多种内部工具,通过 MCP 可实现"一次集成、全工具适配",无需为每个系统单独开发对接模块。

- 实时信息类 AI 应用:如天气查询 AI、股票分析 AI、航班动态查询 AI,通过 MCP 对接实时数据源,确保模型能够获取最新信息,避免依赖过时的训练数据。

- 多模型协作系统:在需要同时使用多个 LLM 的场景(如用 Claude 处理文本理解、用 GPT-4 处理逻辑计算),通过 MCP 可让多个模型共用一套工具集(如数据库查询工具、计算器),提升系统协作效率。

- 第三方工具生态整合:AI 平台(如 Anthropic 的 Claude 平台)通过 MCP 开放接口,允许第三方开发者开发工具并接入平台,形成丰富的工具生态(如文档解析工具、图像识别工具、翻译工具),扩展平台能力。

6.2 实践价值

- 对开发者:降低 AI 系统集成外部资源的成本,提升工具复用率,缩短开发周期;避免因模型迭代、工具更新导致的重复适配工作。

- 对企业:加速 AI 技术在业务场景的落地(如客户服务、数据分析、运营管理),提升 AI 系统的实用性和扩展性;降低多模型协作、跨部门工具整合的难度。

- 对行业:推动 AI 工具生态的标准化发展,打破不同厂商之间的技术壁垒,促进 AI 技术的普及和创新。

7. MCP 的未来发展趋势

作为 AI 与外部世界交互的标准化协议,MCP 未来将朝着"生态更完善、功能更强大、使用更便捷"的方向发展:

- 生态扩张:随着 MCP 协议的普及,会有更多 LLM 提供商(如 OpenAI、谷歌、百度等)和工具开发者支持 MCP,形成更庞大的标准化工具生态,覆盖更多细分场景(如工业控制、医疗数据查询、教育资源对接)。

- 功能增强:未来 MCP 可能会新增更多高级特性,如实时流数据传输、多模态工具对接(如调用图像识别工具、语音合成工具)、权限管理(控制模型对工具的访问权限)等,满足更复杂的应用需求。

- 轻量化与易用性提升:优化 MCP 客户端和服务端的部署成本,推出更多开箱即用的 SDK(软件开发工具包)和模板,让中小开发者也能快速接入 MCP 协议。

- 跨领域适配:从目前的"文本/数据类工具对接"向更多领域延伸,如物联网设备控制(通过 MCP 让 AI 模型调用智能家居设备)、区块链数据查询(对接区块链节点获取实时数据)等,拓展 AI 的应用边界。

MCP(Model Context Protocol)的推出,为 LLM 与外部资源的交互提供了标准化解决方案,其核心价值在于"打破壁垒、降低成本、提升效率"。通过统一的通信协议,MCP 让 AI 模型能够更高效地对接各类工具和数据源,同时让开发者摆脱重复适配的繁琐工作,让企业能够更快地将 AI 技术落地到实际业务中。

随着 MCP 生态的不断完善,未来 AI 系统将具备更强的扩展性和兼容性,能够轻松整合更多外部资源,为用户提供更实用、更智能的服务。对于 AI 开发者和企业而言,提前了解和布局 MCP 相关技术,将在未来的 AI 生态竞争中占据有利地位。