在 AI 语音识别场景中,语音数据来源复杂,通话环境不可控,往往伴随强背景噪声、回声、通道失真以及大量无效静音片段。如果直接对原始语音进行识别或声纹建模,效果会明显下降。因此,在整个系统中,声纹预处理模块是决定后续识别准确率的关键基础环节。

熙瑾会悟系统,基于"可落地、可部署"的原则,设计了一套基于声纹预处理的智能语音处理流程,为后续的诈骗识别、说话人建模和行为分析提供高质量输入。

一、整体处理流程说明

整体流程可以分为四个阶段:

语音采集 → 前端降噪增强 → 语音活动检测(VAD) → 声纹预处理与特征构建

二、语音前端降噪与增强

在真实电话或网络语音中,背景噪声(环境音、电流声)、混响和回声非常常见。这里采用"传统算法 + 深度学习模型"相结合的方式:

-

基础降噪 :

使用谱减法作为第一层处理,对稳定背景噪声进行快速抑制,计算成本低,适合实时场景。

-

深度学习增强 :

针对复杂非平稳噪声,引入基于 UNet 结构的语音增强模型 ,输入为语音幅度谱,输出为增强后的干净语音谱。

该模型在通话类语音上表现稳定,能有效保留说话人音色信息,避免过度"抹平"声纹特征。

这一阶段的目标不是"听起来多好听",而是最大程度保留与说话人相关的个体特征。

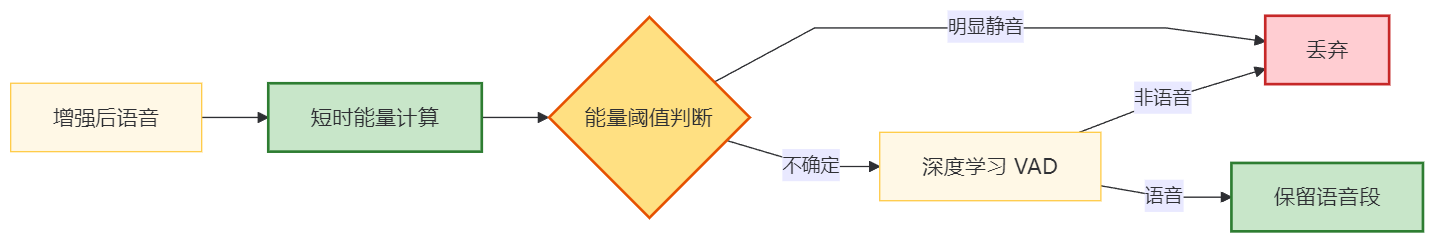

三、语音活动检测(VAD)

降噪完成后,系统会进入 VAD(Voice Activity Detection)阶段,用于区分有效语音与静音、背景段。

实际工程中采用的是能量阈值 + 深度学习 VAD 模型的组合策略:

-

快速能量检测用于初筛,过滤明显的静音段;

-

对边界模糊的片段,使用轻量级神经网络 VAD 模型进行二次判断。

这样做有两个好处:

-

减少后续声纹模型的计算量;

-

避免将静音或噪声错误地纳入声纹特征。

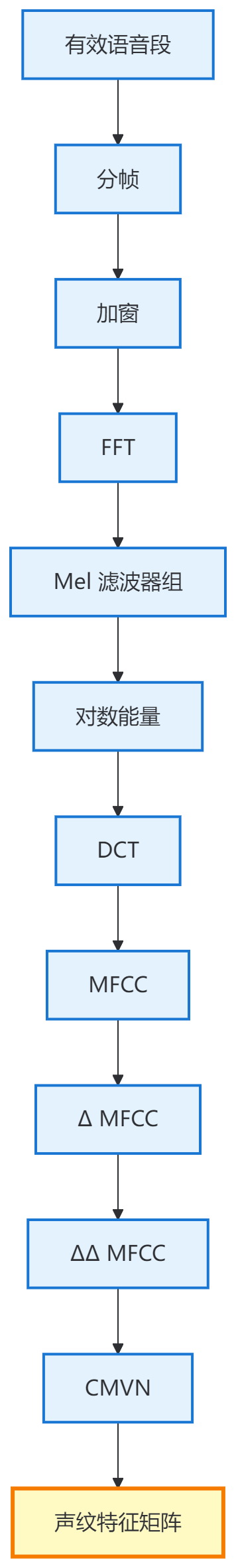

四、声纹预处理关键技术实现

在获取纯净、连续的语音片段后,进入声纹预处理阶段,这是声纹识别和诈骗分析的基础。

1. 分帧与加窗

-

帧长:25ms

-

帧移:10ms

-

加窗函数:Hamming Window

该配置在保证时间分辨率的同时,能够稳定捕捉说话人发声特征。

2. 特征提取

当前系统采用以下特征组合:

-

MFCC(Mel 频率倒谱系数)

-

ΔMFCC(一阶差分)

-

ΔΔMFCC(二阶差分)

这些特征对音色、共振峰变化非常敏感,是声纹建模中最成熟、最稳定的一类方案。

3. 特征归一化

为消除通话设备、信道差异的影响,对每段语音做 CMVN(均值方差归一化),保证特征分布稳定,提升跨设备鲁棒性。

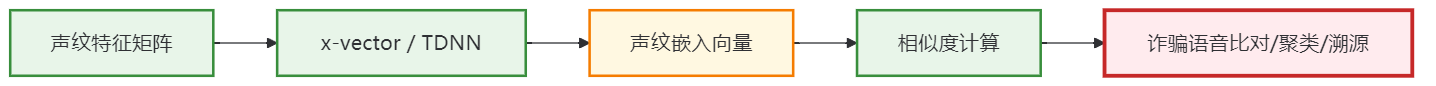

五、声纹建模与后续衔接

经过预处理后的特征,可直接输入到后端声纹模型中,例如:

-

基于 x-vector 的深度嵌入模型

-

或 CNN / TDNN 结构的说话人表示网络

这些模型可以用于:

-

诈骗语音相似度比对

-

多次通话说话人聚类

-

异常说话行为识别

从实际项目经验来看,在语音识别场景中,声纹预处理并不是一个"可有可无"的环节,而是决定整体识别效果能走多远的基础能力。通话语音本身质量参差不齐,如果不先把噪声、静音和通道干扰处理干净,后面的声纹模型再复杂,效果也很难稳定。

通过前端降噪增强、VAD 切分以及标准化的分帧和特征提取,可以明显提升语音的可用性和一致性。一方面减少了无效数据对模型的干扰,另一方面也让声纹特征更加聚焦于说话人的发音习惯和音色差异。实践中,这套预处理流程对不同设备、不同通话环境的适应性都比较好,为后续的诈骗语音比对和说话人分析提供了可靠、稳定的输入基础。