文章目录

- [4. Golang后端服务实现](#4. Golang后端服务实现)

-

- [4.1 系统架构概览](#4.1 系统架构概览)

-

- [4.1.1 架构设计原则](#4.1.1 架构设计原则)

- [4.1.2 整体架构图](#4.1.2 整体架构图)

- [4.1.3 核⼼服务组件](#4.1.3 核⼼服务组件)

- [4.1.4 关键技术栈](#4.1.4 关键技术栈)

- [4.2 事件监听服务 - 区块链数据实时捕获的核⼼引擎](#4.2 事件监听服务 - 区块链数据实时捕获的核⼼引擎)

-

- [4.2.1 事件监听的技术架构与流程](#4.2.1 事件监听的技术架构与流程)

- [4.2.2 事件监听的技术挑战与解决⽅案](#4.2.2 事件监听的技术挑战与解决⽅案)

- [4.2.2 核⼼组件实现](#4.2.2 核⼼组件实现)

- [4.2.3 处理区块链重组 - 数据⼀致性的终极挑战](#4.2.3 处理区块链重组 - 数据⼀致性的终极挑战)

- [4.2.4 性能优化技巧](#4.2.4 性能优化技巧)

- [4.3 数据同步服务 - 构建链下世界的可靠镜像](#4.3 数据同步服务 - 构建链下世界的可靠镜像)

-

- [4.3.1 数据模型设计](#4.3.1 数据模型设计)

- [4.3.2 事件处理流程 - 连接链上与链下世界的数据管道](#4.3.2 事件处理流程 - 连接链上与链下世界的数据管道)

- [4.3.3 数据⼀致性策略](#4.3.3 数据⼀致性策略)

- [4.3.4 性能优化策略](#4.3.4 性能优化策略)

- [4.3.5 指标监控和告警](#4.3.5 指标监控和告警)

- [4.4 ⻛险监控服务 - DeFi协议的安全卫⼠](#4.4 ⻛险监控服务 - DeFi协议的安全卫⼠)

-

- [4.4.1 健康因⼦监控 - 清算预警系统](#4.4.1 健康因⼦监控 - 清算预警系统)

- [4.4.2 价格监控与趋势预测](#4.4.2 价格监控与趋势预测)

4. Golang后端服务实现

DeFi协议不仅仅是智能合约的集合,还需要强⼤的后端服务来⽀持⽤户体验、数据分析和⻛险管理。Aave协议虽然核⼼逻辑在链上实现,但其完整⽣态系统还包括⼀系列链下服务,这些服务主要使⽤Golang实现。

Golang在区块链后端开发中有着显著优势:

- ⾼性能并发处理:goroutine和channel机制⾮常适合处理⼤量区块链事件

- 内存安全:强类型和垃圾回收机制减少内存泄漏⻛险

- 丰富的Web3库:go-ethereum (geth)提供全⾯的以太坊交互能⼒

- 横向扩展性:微服务架构易于部署和扩展

- 低资源消耗:相⽐Node.js,Golang服务通常有更低的内存占⽤和更⾼的吞吐量

本章将深⼊探讨Aave的后端架构,以及如何使⽤Golang构建可靠、⾼效的DeFi基础设施。

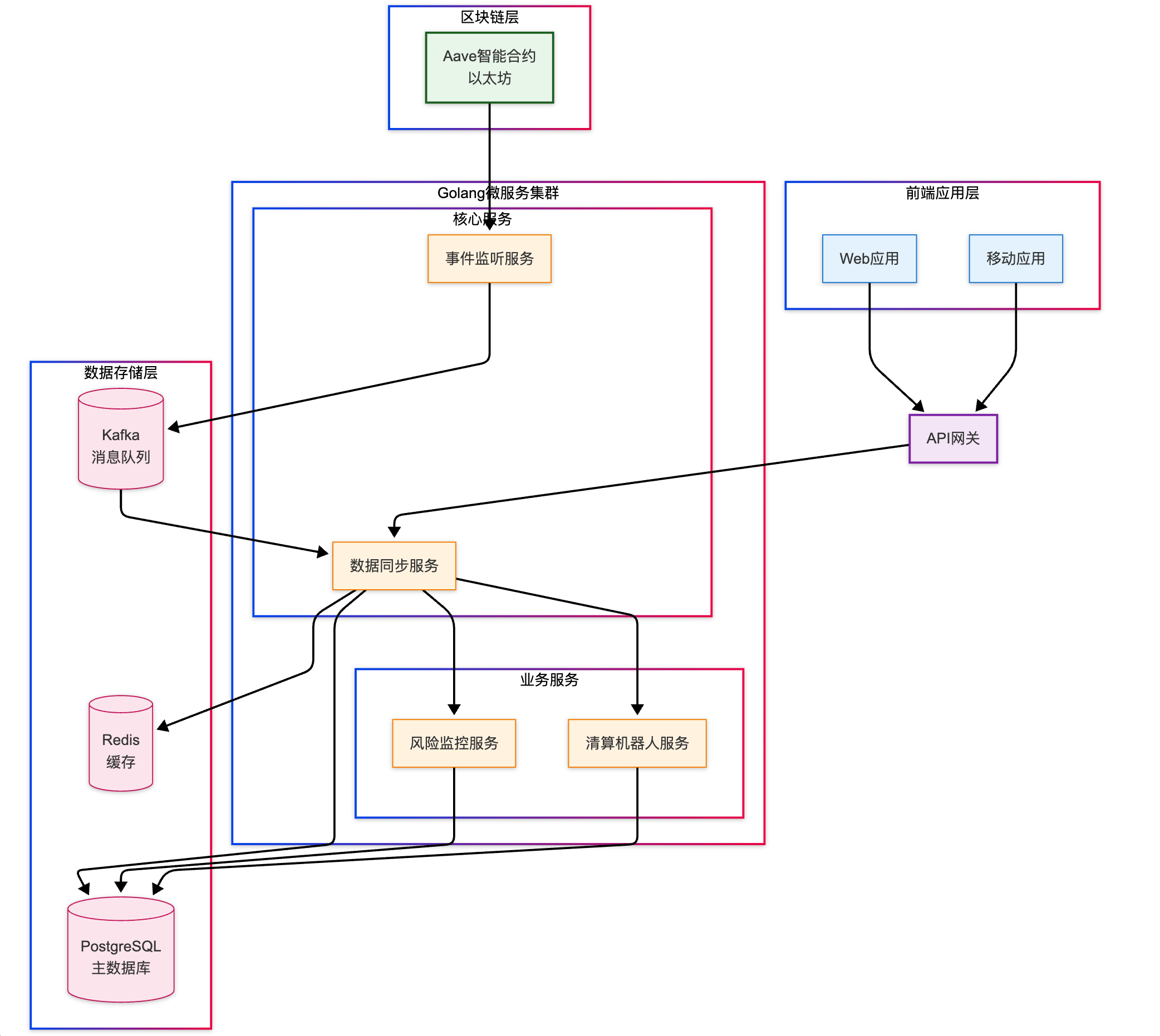

4.1 系统架构概览

Aave的后端系统采⽤微服务架构,由多个专注于特定功能的服务组成,这些服务共同协作提供全⾯的链下功能⽀持。

4.1.1 架构设计原则

在设计DeFi后端服务时,Aave遵循以下核⼼原则:

- ⾼可⽤性:服务中断可能导致⽤户⽆法及时响应市场变化

- 数据⼀致性:链上数据与链下数据必须保持严格⼀致

- 横向扩展:随着⽤户量增⻓,系统应能轻松扩容

- 故障隔离:单⼀服务故障不应影响整个系统

- 可观测性:全⽅位的监控和告警机制

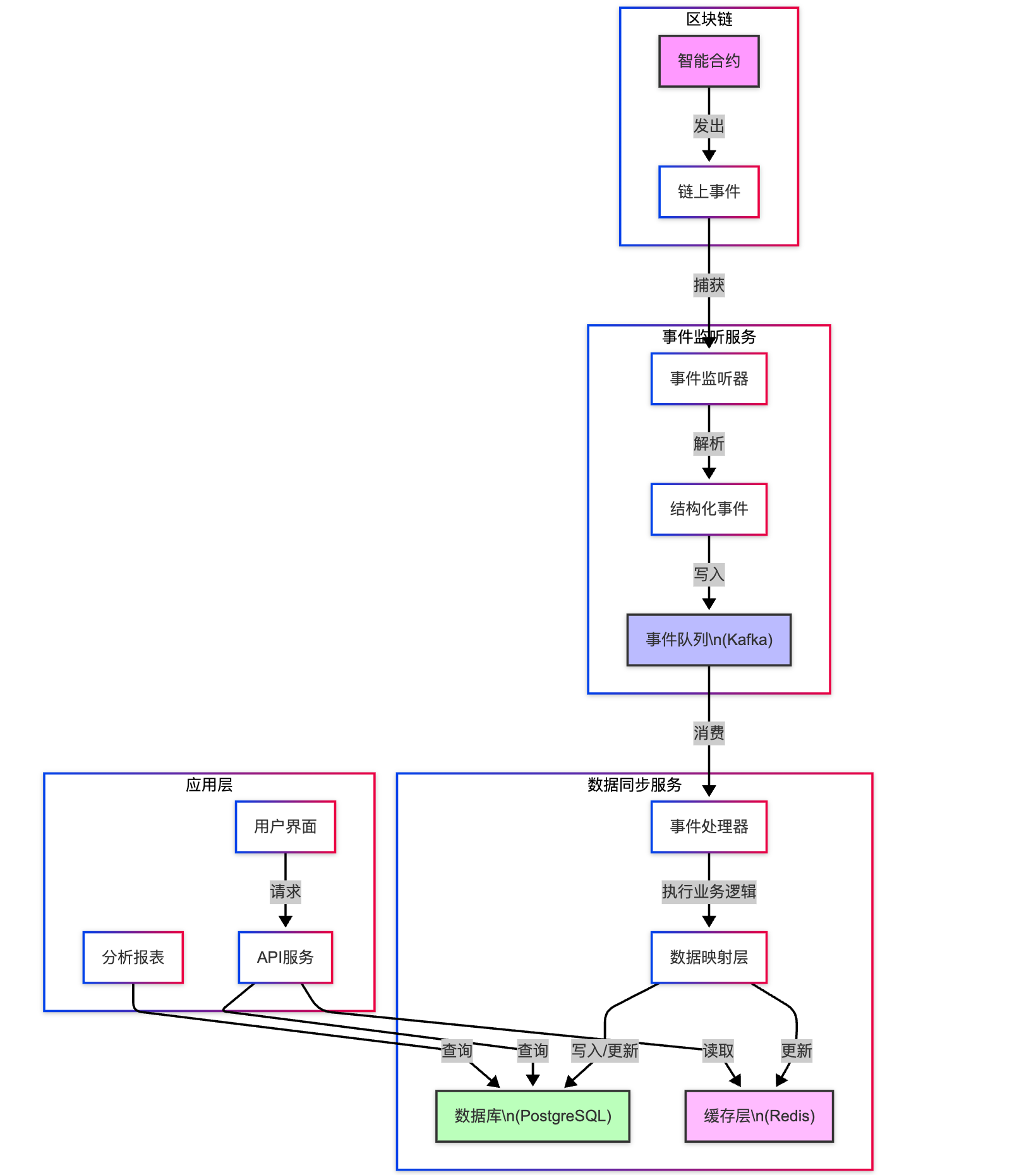

4.1.2 整体架构图

4.1.3 核⼼服务组件

- 事件监听服务(Event Listener)

监听区块链上的合约事件(存款、借款、清算等)

过滤和解析事件数据

将事件推送到消息队列 - 数据同步服务(Data Sync)

消费事件消息并处理

更新数据库和缓存

确保链上数据与链下数据⼀致性 - ⻛险监控服务(Risk Monitor)

实时监控⽤户健康因⼦

预测潜在的清算⻛险

发送⻛险预警 - 清算机器⼈服务(Liquidation Bot)

⾃动识别可清算的头⼨

执⾏清算交易

优化清算策略 - API服务⽹关(API Gateway)

提供RESTful和GraphQL接⼝

处理⽤户认证和授权

实现请求限流和缓存

4.1.4 关键技术栈

Aave后端服务的技术栈主要包括:

下⾯我们将详细探讨这些服务的具体实现。

4.2 事件监听服务 - 区块链数据实时捕获的核⼼引擎

区块链事件监听是DeFi应⽤的神经系统,负责将链上智能合约产⽣的事件实时转化为链下系统可处理的数据流。在

Aave这样的DeFi协议中,事件监听服务是整个后端架构的基础层,它确保了链上发⽣的每⼀笔存款、借款、还款

和清算操作都能被准确地捕获和处理。

为什么事件监听如此重要?

在传统⾦融系统中,数据变更通常直接发⽣在中⼼化数据库中,并通过API或消息队列通知相关系统。⽽在区块链

世界中,数据变更(如⽤户存款、借款等)发⽣在链上智能合约中,链下系统⽆法直接感知这些变化,必须通过监

听合约发出的事件来"获知"这些变化。

Aave的事件监听服务通过两种主要机制实现实时数据同步:

- 区块订阅:订阅区块链节点的新区块通知,实时处理新区块中的事件

- 事件过滤:从区块数据中⾼效过滤出与Aave协议相关的事件⽇志

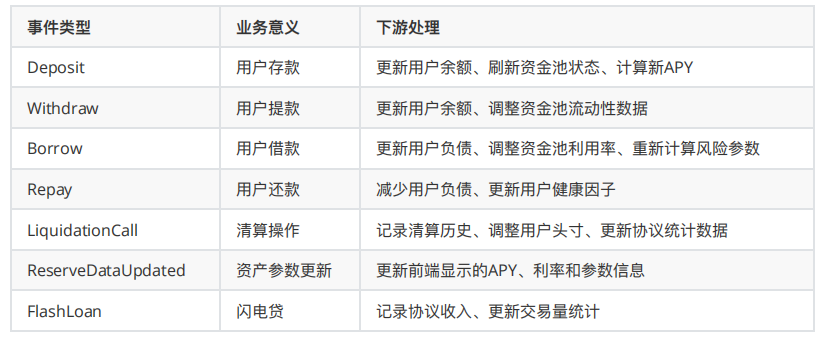

事件在Aave业务中的核⼼作⽤:

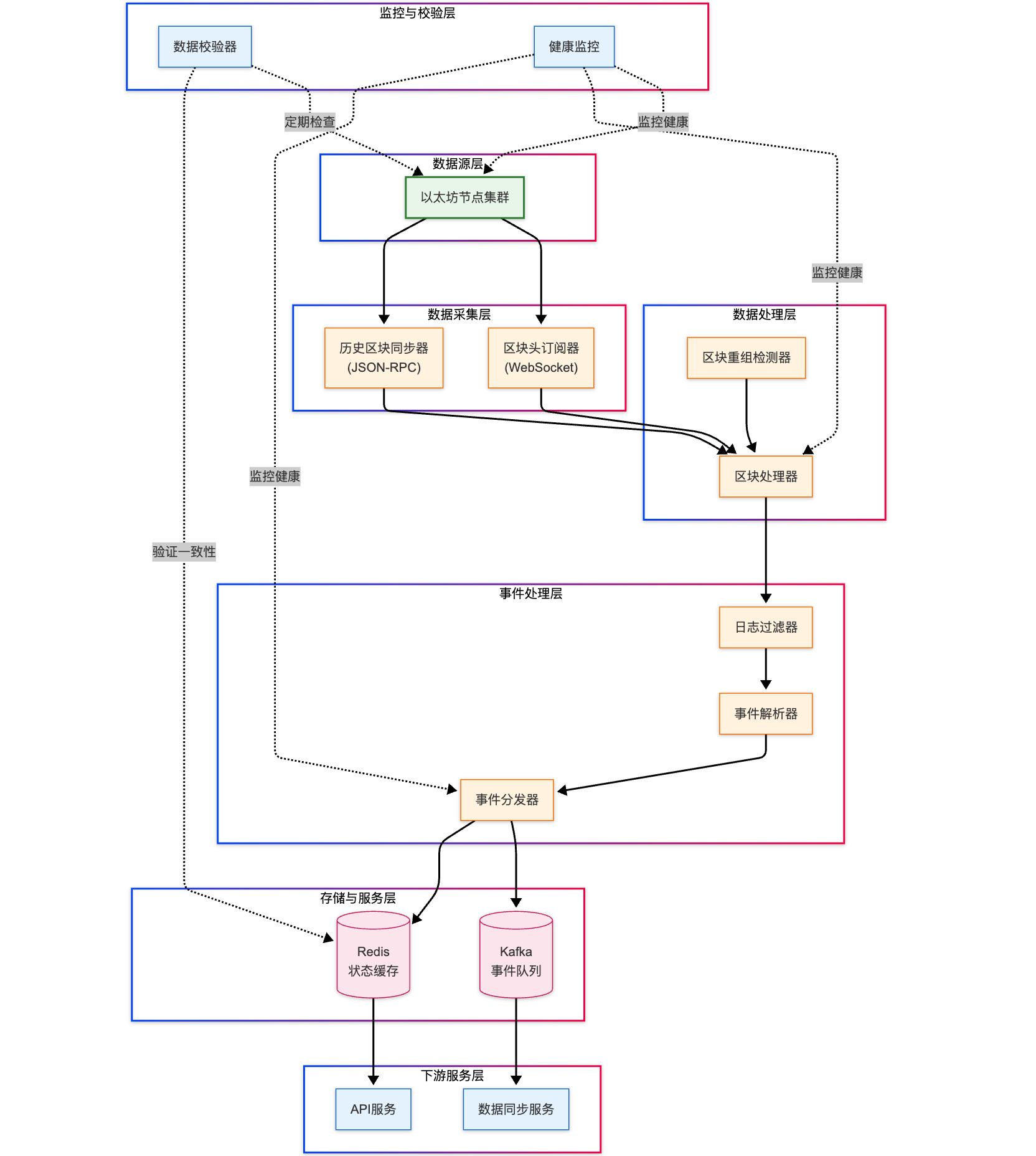

4.2.1 事件监听的技术架构与流程

Aave的事件监听服务采⽤了⼀个复杂但⾼效的架构,包含多个协作组件:

事件监听的完整流程:

- 初始化阶段

加载合约ABI定义,解析出需要监听的事件签名

连接多个以太坊节点,实现⾼可⽤性

从数据库获取上次处理的区块⾼度

初始化重试和错误处理机制 - 同步历史数据阶段

计算当前区块与上次处理区块的差距

分批次请求历史区块数据(通常每批100个区块)

并⾏处理多个批次,提⾼同步效率

记录同步进度,⽀持断点续传 - 实时监听阶段

通过WebSocket订阅新区块通知(newHeads事件)

接收到新区块后,等待确认(通常3-5个确认)

处理已确认区块中的交易⽇志

对⽐上次处理的区块,处理可能的短链重组 - 事件过滤与解析阶段

使⽤合约地址和事件签名过滤相关⽇志

根据ABI定义解析⽇志数据为结构化事件

标准化事件数据格式,添加元数据(区块时间、确认数等) - 事件分发阶段

将事件写⼊持久化队列(Kafka)供下游处理

更新处理状态和监控指标

触发关键事件的实时通知

4.2.2 事件监听的技术挑战与解决⽅案

监听区块链事件看似简单,实际上⾯临诸多复杂挑战。Aave通过⼀系列技术⽅案解决了这些难题:

深⼊解析:链重组处理的技术细节

区块链重组(Chain Reorganization)是区块链系统的固有特性,当⽹络中出现竞争区块时,临时分叉的情况时有

发⽣。在以太坊从PoW迁移到PoS后,重组变得更加罕⻅,但仍然需要处理这⼀情况。

Aave的重组处理机制包含三个核⼼步骤:

- 重组检测:通过⽐对区块哈希检测链重组

- 数据回滚:撤销受影响区块中的事件处理

- 重新同步:从分叉点开始重新处理新链上的事件

4.2.2 核⼼组件实现

下⾯是⼀个⾼性能事件监听服务的Golang实现示例:

go

package listener

import (

"context"

"fmt"

"github.com/aave/go-service/internal/config"

"github.com/aave/go-service/internal/models"

"github.com/aave/go-service/internal/store"

"github.com/ethereum/go-ethereum"

"github.com/ethereum/go-ethereum/accounts/abi"

"github.com/ethereum/go-ethereum/common"

"github.com/ethereum/go-ethereum/core/types"

"github.com/ethereum/go-ethereum/ethclient"

"go.uber.org/zap"

"math/big"

"sync"

"time"

)

// 关键常量

const (

maxRetries = 5 // 连接失败时的最⼤重试次数

retryInterval = 3 * time.Second // 重试间隔

blocksBatchSize = 100 // 同步历史数据时每批次区块数

blockDelay = 3 // 确认延迟块数(避免短链重组)

pollInterval = 12 * time.Second // 轮询新区块的时间间隔

)

// EventListener 是区块链事件监听服务的核⼼结构

type EventListener struct {

client *ethclient.Client // 以太坊客户端

store store.BlockStore // 区块存储接⼝

producer store.EventProducer // 事件⽣产者接⼝

logger *zap.Logger // 结构化⽇志器

contracts []*ContractDefinition // 监听的合约列表

lastBlock uint64 // 上次处理的区块⾼度

networkID *big.Int // ⽹络ID

mutex sync.Mutex // 互斥锁,保护状态更新

isRunning bool // 服务运⾏状态

}

// ContractDefinition 定义了需要监听的合约

type ContractDefinition struct {

Name string // 合约名称,⽤于⽇志和指标

Address common.Address // 合约地址

ABI abi.ABI // 解析后的合约ABI

Topics []common.Hash // 需要监听的事件主题

EventSigs map[string]common.Hash // 事件签名映射

}

// NewEventListener 创建⼀个新的事件监听服务实例

func NewEventListener(

cfg *config.Config,

store store.BlockStore,

producer store.EventProducer,

logger *zap.Logger,

) (*EventListener, error) {

// 连接以太坊节点

client, err := ethclient.Dial(cfg.Ethereum.NodeURL)

if err != nil {

return nil, fmt.Errorf("failed to connect to ethereum node: %w", err)

}

// 获取⽹络ID,⽤于交易签名和验证

networkID, err := client.NetworkID(context.Background())

if err != nil {

return nil, fmt.Errorf("failed to get network ID: %w", err)

}

logger.Info("connected to ethereum node",

zap.String("node_url", cfg.Ethereum.NodeURL),

zap.String("network_id", networkID.String()),

)

// 初始化合约列表

contracts, err := initContracts(cfg)

if err != nil {

return nil, err

}

// 获取上次处理的区块⾼度

lastBlock, err := store.GetLatestProcessedBlock()

if err != nil {

// 如果没有记录,从配置的起始块开始

lastBlock = cfg.Ethereum.StartBlock

logger.Info("no last processed block found, starting from configured block",

zap.Uint64("start_block", lastBlock))

} else {

logger.Info("resuming from last processed block",

zap.Uint64("last_block", lastBlock))

}

return &EventListener{

client: client,

store: store,

producer: producer,

logger: logger.Named("event_listener"),

contracts: contracts,

lastBlock: lastBlock,

networkID: networkID,

}, nil

}

// Start 启动事件监听服务

// 包含两个主要流程:

// 1. 同步历史区块(若有必要)

// 2. 订阅新区块事件

func (l *EventListener) Start(ctx context.Context) error {

l.mutex.Lock()

if l.isRunning {

l.mutex.Unlock()

return fmt.Errorf("event listener is already running")

}

l.isRunning = true

l.mutex.Unlock()

l.logger.Info("starting event listener service")

// 获取当前区块⾼度

latestBlock, err := l.getCurrentBlockHeight(ctx)

if err != nil {

return fmt.Errorf("failed to get current block height: %w", err)

}

// 计算需要同步的区块数量

blocksToSync := int64(latestBlock) - int64(l.lastBlock)

if blocksToSync > 0 {

l.logger.Info("syncing historical blocks",

zap.Uint64("from_block", l.lastBlock),

zap.Uint64("to_block", latestBlock),

zap.Int64("blocks_to_sync", blocksToSync))

// 同步历史区块

err = l.syncHistoricalBlocks(ctx, l.lastBlock, latestBlock)

if err != nil {

return fmt.Errorf("failed to sync historical blocks: %w", err)

}

}

// 开始监听新区块

l.logger.Info("starting to listen for new blocks")

return l.listenForNewBlocks(ctx)

}

// 同步历史区块,分批处理以减少内存占⽤

func (l *EventListener) syncHistoricalBlocks(ctx context.Context, fromBlock, toBlock uint64) error {

for start := fromBlock; start <= toBlock; start += blocksBatchSize {

// 计算本批次结束区块

end := start + blocksBatchSize - 1

if end > toBlock {

end = toBlock

}

l.logger.Debug("processing block batch",

zap.Uint64("from", start),

zap.Uint64("to", end))

// 获取并处理该批次区块的事件

err := l.processBlockRange(ctx, start, end)

if err != nil {

return fmt.Errorf("failed to process blocks from %d to %d: %w", start, end, err)

}

// 更新处理进度

err = l.store.UpdateLatestProcessedBlock(end)

if err != nil {

return fmt.Errorf("failed to update latest processed block: %w", err)

}

l.lastBlock = end

// 检查上下⽂是否取消

select {

case <-ctx.Done():

return ctx.Err()

default:

}

}

l.logger.Info("completed syncing historical blocks",

zap.Uint64("from", fromBlock),

zap.Uint64("to", toBlock))

return nil

}

// 持续监听新区块

func (l *EventListener) listenForNewBlocks(ctx context.Context) error {

ticker := time.NewTicker(pollInterval)

defer ticker.Stop()

for {

select {

case <-ticker.C:

// 获取当前区块⾼度

currentBlock, err := l.getCurrentBlockHeight(ctx)

if err != nil {

l.logger.Error("failed to get current block height", zap.Error(err))

continue

}

// 应⽤确认延迟(避免处理未确认的区块)

if currentBlock <= blockDelay {

continue

}

safeBlock := currentBlock - blockDelay

// 如果有新区块需要处理

if safeBlock > l.lastBlock {

l.logger.Debug("new blocks detected",

zap.Uint64("last_processed", l.lastBlock),

zap.Uint64("new_safe_block", safeBlock))

// 处理新区块

err = l.processBlockRange(ctx, l.lastBlock+1, safeBlock)

if err != nil {

l.logger.Error("failed to process new blocks", zap.Error(err))

continue

}

// 更新处理进度

err = l.store.UpdateLatestProcessedBlock(safeBlock)

if err != nil {

l.logger.Error("failed to update latest processed block", zap.Error(err))

continue

}

l.lastBlock = safeBlock

}

case <-ctx.Done():

l.logger.Info("stopping event listener service")

return ctx.Err()

}

}

}

// processBlockRange 处理指定区块范围内的所有相关事件

func (l *EventListener) processBlockRange(ctx context.Context, fromBlock, toBlock uint64) error {

l.logger.Debug("querying for logs in block range",

zap.Uint64("from_block", fromBlock),

zap.Uint64("to_block", toBlock))

// 为每个合约收集所有事件主题

var allTopics [][]common.Hash

for _, contract := range l.contracts {

// 提取合约中所有需要监听的事件主题

contractTopics := make([]common.Hash, 0, len(contract.Topics))

for _, topic := range contract.Topics {

contractTopics = append(contractTopics, topic)

}

if len(contractTopics) > 0 {

allTopics = append(allTopics, contractTopics)

}

}

// 构建⽇志查询过滤器

addresses := make([]common.Address, 0, len(l.contracts))

for _, contract := range l.contracts {

addresses = append(addresses, contract.Address)

}

// 创建查询过滤器

query := ethereum.FilterQuery{

FromBlock: big.NewInt(int64(fromBlock)),

ToBlock: big.NewInt(int64(toBlock)),

Addresses: addresses,

Topics: nil, // 我们在后⾯处理主题过滤

}

// 查询符合条件的⽇志

logs, err := l.client.FilterLogs(ctx, query)

if err != nil {

return fmt.Errorf("failed to filter logs: %w", err)

}

l.logger.Debug("found logs in block range",

zap.Int("log_count", len(logs)),

zap.Uint64("from_block", fromBlock),

zap.Uint64("to_block", toBlock))

// 处理查询到的⽇志

for _, log := range logs {

err := l.processLog(ctx, log)

if err != nil {

// 记录错误但继续处理其他⽇志

l.logger.Error("failed to process log",

zap.Error(err),

zap.Uint64("block_number", log.BlockNumber),

zap.String("tx_hash", log.TxHash.Hex()))

continue

}

}

return nil

}

// processLog 处理单个⽇志事件

func (l *EventListener) processLog(ctx context.Context, log types.Log) error {

// 找到对应的合约定义

var contractDef *ContractDefinition

for _, contract := range l.contracts {

if contract.Address == log.Address {

contractDef = contract

break

}

}

if contractDef == nil {

return fmt.Errorf("no contract definition found for address %s", log.Address.Hex())

}

// ⽇志应该⾄少有⼀个主题(事件签名)

if len(log.Topics) == 0 {

return fmt.Errorf("log has no topics")

}

// 尝试解析事件

eventSig := log.Topics[0]

eventName := "Unknown"

// 根据事件签名查找事件名称

for name, sig := range contractDef.EventSigs {

if sig == eventSig {

eventName = name

break

}

}

l.logger.Debug("processing event",

zap.String("event", eventName),

zap.String("contract", contractDef.Name),

zap.Uint64("block", log.BlockNumber),

zap.String("tx_hash", log.TxHash.Hex()))

// 解析⽇志数据

event, err := parseEventLog(contractDef, eventName, log)

if err != nil {

return fmt.Errorf("failed to parse event log: %w", err)

}

// 创建事件模型

blockEvent := &models.BlockchainEvent{

BlockNumber: log.BlockNumber,

TransactionHash: log.TxHash.String(),

LogIndex: log.Index,

ContractAddress: log.Address.Hex(),

EventName: eventName,

EventData: event,

Timestamp: time.Now().UTC(),

}

// 发送事件到消息队列

err = l.producer.PublishEvent(ctx, blockEvent)

if err != nil {

return fmt.Errorf("failed to publish event: %w", err)

}

return nil

}

// getCurrentBlockHeight 获取当前区块⾼度

func (l *EventListener) getCurrentBlockHeight(ctx context.Context) (uint64, error) {

var err error

var blockHeight uint64

// 使⽤指数退避重试

for i := 0; i < maxRetries; i++ {

if i > 0 {

// 退避时间增加

time.Sleep(retryInterval * time.Duration(1<<uint(i-1)))

}

// 查询最新区块

var header *types.Header

header, err = l.client.HeaderByNumber(ctx, nil)

if err == nil {

blockHeight = header.Number.Uint64()

return blockHeight, nil

}

l.logger.Warn("failed to get block height, retrying...",

zap.Error(err),

zap.Int("retry", i+1))

}

return 0, fmt.Errorf("failed to get current block height after %d attempts: %w",

maxRetries, err)

}

// parseEventLog 解析⽇志事件为结构化数据

func parseEventLog(contract *ContractDefinition, eventName string, log types.Log) (map[string]interface{}, error) {

// 获取事件ABI定义

eventABI, found := contract.ABI.Events[eventName]

if !found {

return nil, fmt.Errorf("event %s not found in contract ABI", eventName)

}

// 解析⽇志数据

eventData := make(map[string]interface{})

// 解析⾮索引参数

err := contract.ABI.UnpackIntoMap(eventData, eventName, log.Data)

if err != nil {

return nil, fmt.Errorf("failed to unpack event data: %w", err)

}

// 解析索引参数(Topics)

// 第⼀个Topic是事件签名,其余的是索引参数

indexedArgs := eventABI.Inputs.NonIndexed()

for i := 0; i < len(indexedArgs) && i+1 < len(log.Topics); i++ {

arg := indexedArgs[i]

topic := log.Topics[i+1]

// 不同类型的索引参数需要不同的解析⽅式

switch arg.Type.T {

case abi.AddressTy:

eventData[arg.Name] = common.HexToAddress(topic.Hex())

case abi.IntTy, abi.UintTy:

val := new(big.Int).SetBytes(topic.Bytes())

eventData[arg.Name] = val

case abi.BoolTy:

eventData[arg.Name] = topic.Big().Uint64() != 0

case abi.BytesTy, abi.FixedBytesTy, abi.StringTy:

eventData[arg.Name] = topic.Hex()

default:

// 复杂类型(例如数组或结构体)在索引时会被散列,⽆法直接恢复原始值

eventData[arg.Name] = topic.Hex()

}

}

return eventData, nil

}

// Stop 停⽌事件监听服务

func (l *EventListener) Stop() error {

l.mutex.Lock()

defer l.mutex.Unlock()

if !l.isRunning {

return nil

}

l.logger.Info("stopping event listener service")

l.isRunning = false

return nil

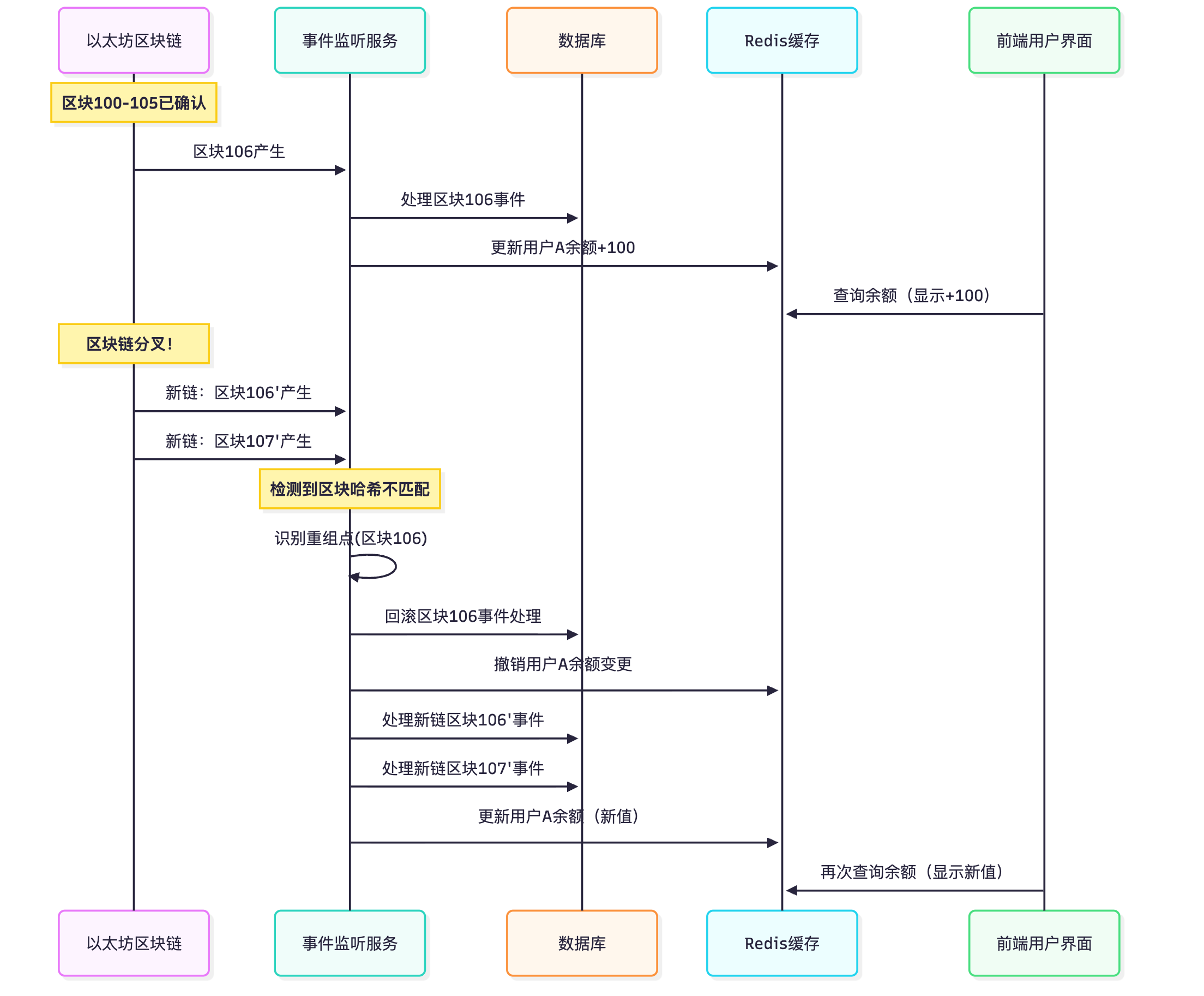

}4.2.3 处理区块链重组 - 数据⼀致性的终极挑战

区块链重组(Chain Reorganization)是DeFi后端服务⾯临的最具挑战性的问题之⼀。区块链本质上是⼀个分布式系统,在⽹络共识过程中可能出现临时分叉,当较⻓的分⽀被确认为主链时,短分⽀上的区块会被丢弃,这⼀过程称为"重组"。

对于链下服务⽽⾔,重组意味着已经处理的区块和事件可能被"撤销",需要回滚已更新的数据库记录,并处理新的主链上的事件。这对数据⼀致性提出了严峻挑战。

重组的技术本质:

重组本质上是区块链⽹络达成最终共识的过程。以太坊从PoW迁移到PoS后,重组变得更加罕⻅,但仍然会发⽣,尤其是在以下情况:

- ⽹络分区:⽹络延迟导致节点临时分裂成不同组

- 软件错误:不同版本的客户端软件对规则有轻微差异

- 恶意攻击:攻击者尝试创建竞争链(虽然在PoS中极其昂贵)

重组对DeFi后端的影响:

Aave的重组处理策略:

Aave采⽤了⼀套完整的重组处理策略,确保即使在⽹络不稳定情况下,也能保持数据⼀致性:

- 确认延迟机制:等待3-5个确认区块后才处理事件,⼤幅降低处理浅层重组的⻛险

- 区块哈希追踪:维护处理过的区块哈希历史,快速检测重组发⽣

- 事务性处理:使⽤数据库事务确保数据更新的原⼦性,⽀持回滚

- 事件缓冲区:最近处理的事件保持在内存缓冲区中,便于快速回滚

- 异步通知机制:重组发⽣时通知下游服务,协调数据恢复

重组处理的完整⼯作流:

- 检测阶段:

⽐较已存储区块哈希与链上哈希

确定分叉点(最早的哈希不匹配区块)

计算需要回滚和重新处理的区块范围 - 回滚阶段:

按照事件ID降序撤销所有分叉点之后的事件处理

发布回滚通知到消息队列

清理相关缓存数据 - 重新处理阶段:

从分叉点开始重新请求新链上的区块数据

按顺序处理新区块中的事件

重建数据库状态和缓存 - 恢复阶段:

验证数据⼀致性

恢复正常事件处理流程

记录重组事件⽤于后续分析

以下是Aave实现的区块链重组处理核⼼代码,展示了如何检测重组并优雅地处理这⼀复杂场景:

go

// 处理区块链重组

func (l *EventListener) handleReorg(ctx context.Context, reorgBlock uint64) error {

l.logger.Warn("blockchain reorg detected", zap.Uint64("reorg_block", reorgBlock))

// 1. 找出受影响的所有事件(从重组点开始的所有事件)

events, err := l.store.GetEventsAfterBlock(reorgBlock)

if err != nil {

return fmt.Errorf("failed to get events after reorg block: %w", err)

}

// 2. 发送撤销事件通知

for _, event := range events {

reorgEvent := &models.ReorgEvent{

OriginalEvent: event,

ReorgBlock: reorgBlock,

Timestamp: time.Now().UTC(),

}

err = l.producer.PublishReorgEvent(ctx, reorgEvent)

if err != nil {

l.logger.Error("failed to publish reorg event",

zap.Error(err),

zap.String("tx_hash", event.TransactionHash))

}

}

// 3. 从数据库中删除这些事件

err = l.store.DeleteEventsAfterBlock(reorgBlock)

if err != nil {

return fmt.Errorf("failed to delete events after reorg block: %w", err)

}

// 4. 更新最后处理的区块

err = l.store.UpdateLatestProcessedBlock(reorgBlock - 1)

if err != nil {

return fmt.Errorf("failed to update latest processed block: %w", err)

}

l.lastBlock = reorgBlock - 1

l.logger.Info("reorg handling completed",

zap.Uint64("new_last_block", l.lastBlock),

zap.Int("events_reverted", len(events)))

return nil

}4.2.4 性能优化技巧

在⾼交易量的区块链上监听事件,性能优化⾄关重要:

- 批量处理:⼀次性查询和处理多个区块的事件

- 并⾏处理:使⽤goroutines并发处理不同合约的事件

- 精确过滤:尽可能在查询阶段使⽤更精确的过滤条件

- 缓存ABI:预先解析和缓存合约ABI以提⾼解析速度

- 定制化查询:根据具体业务需求定制RPC查询,减少不必要数据传输

4.3 数据同步服务 - 构建链下世界的可靠镜像

数据同步服务是DeFi架构中的数据处理中枢,它将来⾃区块链的原始事件数据转换为结构化、易查询的数据模型,并确保链下数据库准确反映链上状态。在Aave协议中,这项服务处理着每天数⼗万条事件,⽀撑着⽤户界⾯、⻛险评估和业务分析等多个关键功能。

数据同步服务的核⼼职责:

- 事件处理:消费事件队列中的区块链事件,并根据事件类型执⾏不同的业务逻辑

- 数据转换:将链上数据模型映射到关系型数据库模型,实现有效的查询和分析

- 状态维护:构建和更新⽤户头⼨、资产余额和协议参数的实时状态

- 缓存管理:维护⾼速缓存层,提供毫秒级的数据访问能⼒

- ⼀致性保障:处理⽹络异常、程序错误等边缘情况,确保数据⼀致性

数据同步服务与区块链事件处理的关系:

数据同步架构的核⼼优势:

- 解耦设计:事件监听与数据处理解耦,提⾼系统弹性和维护性

- 可靠队列:使⽤Kafka等消息队列,确保事件不丢失且可重放

- ⽔平扩展:可独⽴扩展每个组件以应对不同的负载需求

- 多级缓存:结合内存缓存和分布式缓存,平衡性能与⼀致性

数据同步的完整流程:

- 事件获取阶段

从Kafka队列批量消费事件消息

验证事件数据完整性和序列性

根据事件类型路由到对应的处理器 - 业务逻辑处理阶段

应⽤事件特定的业务规则

执⾏数据转换和聚合计算

准备数据库更新操作 - 数据持久化阶段

在事务中执⾏数据库更新

确保原⼦性操作,避免部分更新

处理唯⼀约束和并发问题 - 缓存更新阶段

更新受影响的缓存条⽬

处理缓存⼀致性问题

优化热点数据访问路径 - 事件确认阶段

标记事件为已处理

更新处理统计和监控指标

触发下游事件(如需要)

4.3.1 数据模型设计

数据同步服务需要设计合理的数据模型,以⾼效存储和查询区块链事件和协议状态。下⾯是Aave后端服务的核⼼数据模型:

- 区块链事件模型

go

// 区块链事件模型

type BlockchainEvent struct {

ID uint64 `gorm:"primaryKey;autoIncrement"`

BlockNumber uint64 `gorm:"index;not null"`

TransactionHash string `gorm:"type:varchar(66);index;not null"`

LogIndex uint `gorm:"not null"`

ContractAddress string `gorm:"type:varchar(42);index;not null"`

EventName string `gorm:"type:varchar(100);index;not null"`

EventData map[string]interface{} `gorm:"type:jsonb;not null"` // PostgreSQL的JSONB类型

Timestamp time.Time `gorm:"index;not null"`

CreatedAt time.Time `gorm:"not null"`

ProcessedAt *time.Time `gorm:"index"`

}- ⽤户头⼨模型

go

// ⽤户头⼨模型

type UserPosition struct {

ID uint64 `gorm:"primaryKey;autoIncrement"`

UserAddress string `gorm:"type:varchar(42);index;not null"`

TotalCollateralETH *big.Int `gorm:"type:numeric;not null"`

TotalDebtETH *big.Int `gorm:"type:numeric;not null"`

AvailableBorrowsETH *big.Int `gorm:"type:numeric;not null"`

CurrentLTV uint `gorm:"not null"` // 存储为基点(10000 = 100%)

HealthFactor *big.Int `gorm:"type:numeric;not null"`

LastUpdatedBlock uint64 `gorm:"not null"`

LastUpdatedAt time.Time `gorm:"index;not null"`

}- 资产储备模型

go

// 资产储备模型

type AssetReserve struct {

ID uint64 `gorm:"primaryKey;autoIncrement"`

AssetAddress string `gorm:"type:varchar(42);uniqueIndex;not null"`

Symbol string `gorm:"type:varchar(20);index;not null"`

Decimals uint8 `gorm:"not null"`

LTV uint `gorm:"not null"` // 贷款价值⽐(%) * 100

LiquidationThreshold uint `gorm:"not null"` // 清算阈值(%) * 100

LiquidationBonus uint `gorm:"not null"` // 清算奖励(%) * 100

ReserveFactor uint `gorm:"not null"` // 储备因⼦(%) * 100

TotalLiquidity *big.Int `gorm:"type:numeric;not null"`

AvailableLiquidity *big.Int `gorm:"type:numeric;not null"`

TotalBorrows *big.Int `gorm:"type:numeric;not null"`

UtilizationRate uint `gorm:"not null"` // 使⽤率(%) * 100

LiquidityRate *big.Int `gorm:"type:numeric;not null"` // 存款APY

VariableBorrowRate *big.Int `gorm:"type:numeric;not null"` // 浮动借款APY

StableBorrowRate *big.Int `gorm:"type:numeric;not null"` // 固定借款APY

LastUpdateTimestamp time.Time `gorm:"not null"`

ATokenAddress string `gorm:"type:varchar(42);not null"`

IsActive bool `gorm:"not null;default:true"`

IsFrozen bool `gorm:"not null;default:false"`

}- ⽤户资产余额模型

go

// ⽤户资产余额模型

type UserAssetBalance struct {

ID uint64 `gorm:"primaryKey;autoIncrement"`

UserAddress string `gorm:"type:varchar(42);index;not null"`

AssetAddress string `gorm:"type:varchar(42);index;not null"`

ATokenBalance *big.Int `gorm:"type:numeric;not null"` // 存款余额(aToken)

StableDebt *big.Int `gorm:"type:numeric;not null"` // 固定利率债务

VariableDebt *big.Int `gorm:"type:numeric;not null"` // 浮动利率债务

IsCollateral bool `gorm:"not null;default:true"` // 是否⽤作抵押品

LastUpdatedAt time.Time `gorm:"index;not null"`

// 外键关系

UserPositionID uint64 `gorm:"index"`

AssetReserveID uint64 `gorm:"index"`

}- 交易历史模型

go

// 交易类型枚举

type TransactionType string

const (

TxDeposit TransactionType = "DEPOSIT"

TxWithdraw TransactionType = "WITHDRAW"

TxBorrow TransactionType = "BORROW"

TxRepay TransactionType = "REPAY"

TxLiquidation TransactionType = "LIQUIDATION"

TxFlashLoan TransactionType = "FLASH_LOAN"

)

// 交易历史模型

type TransactionHistory struct {

ID uint64 `gorm:"primaryKey;autoIncrement"`

TransactionHash string `gorm:"type:varchar(66);uniqueIndex;not null"`

BlockNumber uint64 `gorm:"index;not null"`

UserAddress string `gorm:"type:varchar(42);index;not null"`

TransactionType TransactionType `gorm:"type:varchar(20);index;not null"`

AssetAddress string `gorm:"type:varchar(42);index;not null"`

Amount *big.Int `gorm:"type:numeric;not null"`

Timestamp time.Time `gorm:"index;not null"`

GasUsed uint64 `gorm:"not null"`

GasPrice *big.Int `gorm:"type:numeric;not null"`

EventID uint64 `gorm:"index"`

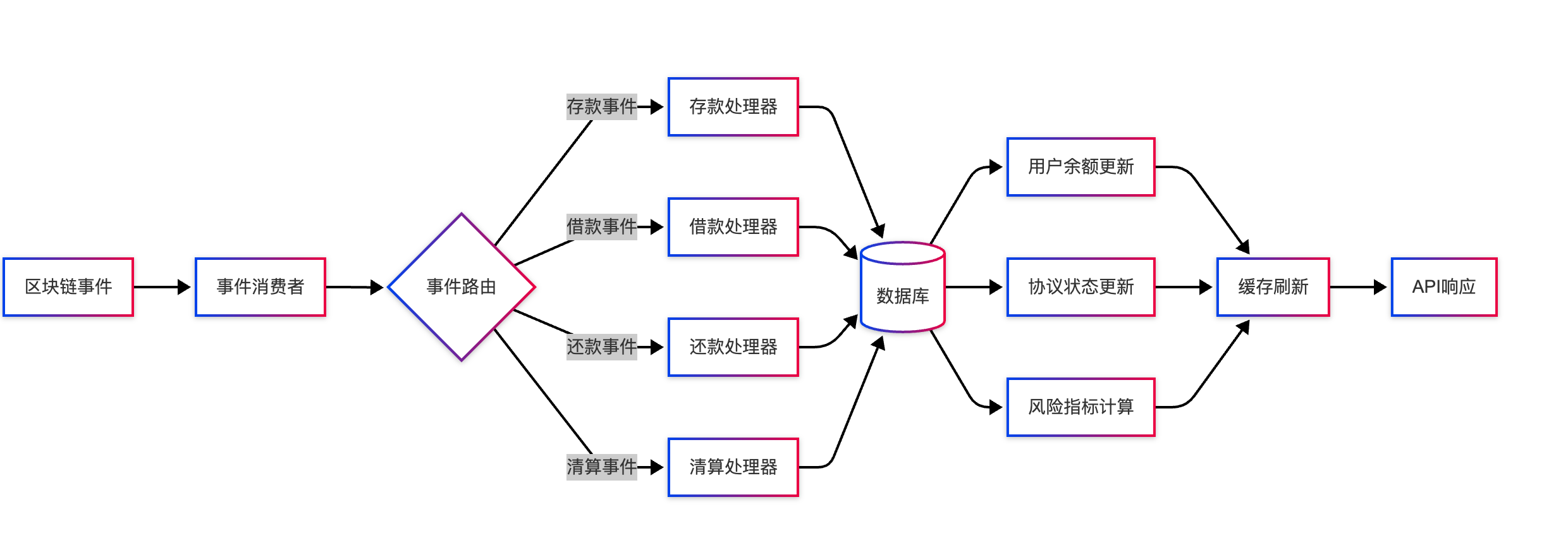

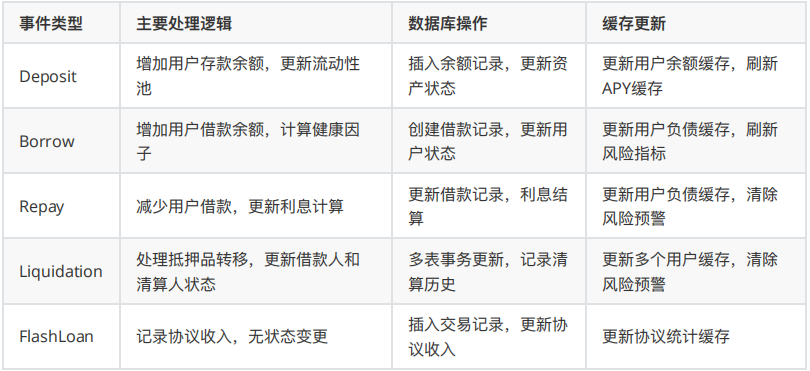

}4.3.2 事件处理流程 - 连接链上与链下世界的数据管道

数据同步服务的核⼼功能是将区块链事件转化为数据库更新操作,实现链上状态到链下状态的精确映射。这⼀流程处理着每⼀笔存款、借款、还款和清算事件,是整个系统数据⼀致性的基础。

事件处理的关键技术原则:

- 完整性:确保处理链上的每⼀个事件,不漏不重

- ⼀致性:保持链下数据与链上状态的严格⼀致

- 顺序性:按区块⾼度和交易索引的顺序处理事件

- 原⼦性:事件处理要么完全成功,要么完全失败

- 可恢复性:⽀持从中断点恢复处理

事件处理的数据流转:

事件处理的详细⼯作流程:

- 事件预处理阶段:

验证事件签名和参数完整性

检查事件是否已被处理(避免重复处理)

根据事件类型确定处理路径 - 业务逻辑处理阶段:

转换事件参数为业务对象

应⽤特定业务规则(如存款、借款、还款逻辑)

准备数据库事务操作 - 数据⼀致性保障阶段:

在单⼀事务中执⾏所有数据库更改

实现读-修改-写操作的原⼦性

处理并发事务的隔离级别 - 缓存管理阶段:

识别需要更新的缓存项

应⽤缓存⼀致性策略(如先更新数据库,后失效缓存)

处理多级缓存的同步问题 - 事件后处理阶段:

标记事件处理完成

触发关联业务流程

发送通知和更新监控指标

不同事件类型的处理差异:

下⾯是⼀个⾼度结构化的事件处理引擎实现,展示了如何设计⼀个可扩展、可靠的数据同步服务:

go

package syncer

import (

"context"

"fmt"

"github.com/aave/go-service/internal/models"

"github.com/aave/go-service/internal/store"

"github.com/ethereum/go-ethereum/common"

"go.uber.org/zap"

"gorm.io/gorm"

"math/big"

"sync"

"time"

)

// DataSyncer 是数据同步服务的核⼼结构

type DataSyncer struct {

db *gorm.DB

cache store.CacheStore

consumer store.EventConsumer

logger *zap.Logger

processingLock sync.Mutex

isRunning bool

supportedEvents map[string]EventHandler

}

// EventHandler 是处理区块链事件的函数类型

type EventHandler func(ctx context.Context, event *models.BlockchainEvent) error

// NewDataSyncer 创建⼀个新的数据同步服务实例

func NewDataSyncer(

db *gorm.DB,

cache store.CacheStore,

consumer store.EventConsumer,

logger *zap.Logger,

) *DataSyncer {

syncer := &DataSyncer{

db: db,

cache: cache,

consumer: consumer,

logger: logger.Named("data_syncer"),

supportedEvents: make(map[string]EventHandler),

}

// 注册事件处理器

syncer.registerEventHandlers()

return syncer

}

// 注册⽀持的事件处理器

func (s *DataSyncer) registerEventHandlers() {

// 存款事件处理

s.supportedEvents["Deposit"] = s.handleDepositEvent

s.supportedEvents["Withdraw"] = s.handleWithdrawEvent

s.supportedEvents["Borrow"] = s.handleBorrowEvent

s.supportedEvents["Repay"] = s.handleRepayEvent

s.supportedEvents["LiquidationCall"] = s.handleLiquidationEvent

s.supportedEvents["ReserveDataUpdated"] = s.handleReserveDataUpdateEvent

s.supportedEvents["FlashLoan"] = s.handleFlashLoanEvent

s.logger.Info("registered event handlers",

zap.Int("handler_count", len(s.supportedEvents)))

}

// Start 启动数据同步服务

func (s *DataSyncer) Start(ctx context.Context) error {

s.processingLock.Lock()

if s.isRunning {

s.processingLock.Unlock()

return fmt.Errorf("data syncer is already running")

}

s.isRunning = true

s.processingLock.Unlock()

s.logger.Info("starting data sync service")

// 开始消费事件

return s.consumeEvents(ctx)

}

// 消费和处理事件

func (s *DataSyncer) consumeEvents(ctx context.Context) error {

for {

// 检查上下⽂是否取消

select {

case <-ctx.Done():

s.logger.Info("stopping data sync service")

return ctx.Err()

default:

// 继续处理

}

// 获取下⼀批事件(批量处理以提⾼效率)

events, err := s.consumer.ConsumeEvents(ctx, 100)

if err != nil {

s.logger.Error("failed to consume events", zap.Error(err))

time.Sleep(5 * time.Second) // 避免频繁重试

continue

}

if len(events) == 0 {

// 没有新事件,等待⼀段时间

time.Sleep(1 * time.Second)

continue

}

s.logger.Debug("received events batch", zap.Int("count", len(events)))

// 处理每个事件

for _, event := range events {

if err := s.processEvent(ctx, event); err != nil {

s.logger.Error("failed to process event",

zap.Error(err),

zap.String("event", event.EventName),

zap.String("tx", event.TransactionHash))

// 对于处理失败的事件,可以实现重试机制

// 这⾥简化处理,记录错误后继续处理下⼀个事件

continue

}

// 标记事件为已处理

if err := s.markEventProcessed(event.ID); err != nil {

s.logger.Error("failed to mark event as processed",

zap.Error(err),

zap.Uint64("event_id", event.ID))

}

}

}

}

// 处理单个事件

func (s *DataSyncer) processEvent(ctx context.Context, event *models.BlockchainEvent) error {

// 查找事件对应的处理器

handler, exists := s.supportedEvents[event.EventName]

if !exists {

s.logger.Debug("no handler registered for event",

zap.String("event", event.EventName))

return nil // 不需要处理的事件不算错误

}

// 使⽤数据库事务处理事件

return s.db.Transaction(func(tx *gorm.DB) error {

// 将事务传递给上下⽂

txCtx := context.WithValue(ctx, "tx", tx)

// 调⽤事件处理器

return handler(txCtx, event)

})

}

// 处理存款事件

func (s *DataSyncer) handleDepositEvent(ctx context.Context, event *models.BlockchainEvent) error {

// 从事件数据中提取参数

reserve, ok := event.EventData["reserve"].(common.Address)

if !ok {

return fmt.Errorf("invalid reserve address in event data")

}

user, ok := event.EventData["user"].(common.Address)

if !ok {

return fmt.Errorf("invalid user address in event data")

}

amount, ok := event.EventData["amount"].(*big.Int)

if !ok {

return fmt.Errorf("invalid amount in event data")

}

// 获取当前事务

tx := ctx.Value("tx").(*gorm.DB)

// 1. 更新⽤户资产余额

var balance models.UserAssetBalance

result := tx.Where("user_address = ? AND asset_address = ?",

user.Hex(), reserve.Hex()).First(&balance)

if result.Error != nil {

if result.Error == gorm.ErrRecordNotFound {

// 创建新的余额记录

balance = models.UserAssetBalance{

UserAddress: user.Hex(),

AssetAddress: reserve.Hex(),

ATokenBalance: big.NewInt(0),

StableDebt: big.NewInt(0),

VariableDebt: big.NewInt(0),

IsCollateral: true, // 默认⽤作抵押品

LastUpdatedAt: time.Now(),

}

} else {

return fmt.Errorf("failed to query user balance: %w", result.Error)

}

}

// 更新aToken余额

balance.ATokenBalance = new(big.Int).Add(balance.ATokenBalance, amount)

balance.LastUpdatedAt = time.Now()

// 保存或更新余额

if result.Error == gorm.ErrRecordNotFound {

if err := tx.Create(&balance).Error; err != nil {

return fmt.Errorf("failed to create user balance: %w", err)

}

} else {

if err := tx.Save(&balance).Error; err != nil {

return fmt.Errorf("failed to update user balance: %w", err)

}

}

// 2. 更新资产储备信息

var reserve models.AssetReserve

if err := tx.Where("asset_address = ?", reserve.Hex()).First(&reserve).Error; err !=

nil {

return fmt.Errorf("failed to find asset reserve: %w", err)

}

// 增加总流动性和可⽤流动性

reserve.TotalLiquidity = new(big.Int).Add(reserve.TotalLiquidity, amount)

reserve.AvailableLiquidity = new(big.Int).Add(reserve.AvailableLiquidity, amount)

// 更新利⽤率

if reserve.TotalLiquidity.Cmp(big.NewInt(0)) > 0 {

// 利⽤率 = 总借款 / 总流动性

utilizationRate := new(big.Int).Mul(reserve.TotalBorrows, big.NewInt(10000))

utilizationRate = utilizationRate.Div(utilizationRate, reserve.TotalLiquidity)

reserve.UtilizationRate = uint(utilizationRate.Uint64())

}

if err := tx.Save(&reserve).Error; err != nil {

return fmt.Errorf("failed to update asset reserve: %w", err)

}

// 3. 更新⽤户总体头⼨

if err := s.updateUserPosition(ctx, user.Hex()); err != nil {

return fmt.Errorf("failed to update user position: %w", err)

}

// 4. 创建交易历史记录

txHistory := models.TransactionHistory{

TransactionHash: event.TransactionHash,

BlockNumber: event.BlockNumber,

UserAddress: user.Hex(),

TransactionType: models.TxDeposit,

AssetAddress: reserve.Hex(),

Amount: amount,

Timestamp: event.Timestamp,

EventID: event.ID,

}

if err := tx.Create(&txHistory).Error; err != nil {

return fmt.Errorf("failed to create transaction history: %w", err)

}

// 5. 更新缓存

cacheKey := fmt.Sprintf("user_balance:%s:%s", user.Hex(), reserve.Hex())

s.cache.Set(cacheKey, balance, 30*time.Minute)

s.logger.Info("processed deposit event",

zap.String("user", user.Hex()),

zap.String("asset", reserve.Hex()),

zap.String("amount", amount.String()))

return nil

}

// 更新⽤户头⼨

func (s *DataSyncer) updateUserPosition(ctx context.Context, userAddress string) error {

tx := ctx.Value("tx").(*gorm.DB)

// 从智能合约获取最新的⽤户头⼨数据

// 这⾥为了简化,我们假设已经有⼀个服务可以获取这些数据

position, err := s.getUserAccountData(userAddress)

if err != nil {

return fmt.Errorf("failed to get user account data: %w", err)

}

// 更新或创建⽤户头⼨记录

var userPosition models.UserPosition

result := tx.Where("user_address = ?", userAddress).First(&userPosition)

if result.Error != nil {

if result.Error == gorm.ErrRecordNotFound {

// 创建新记录

userPosition = models.UserPosition{

UserAddress: userAddress,

TotalCollateralETH: position.TotalCollateralETH,

TotalDebtETH: position.TotalDebtETH,

AvailableBorrowsETH: position.AvailableBorrowsETH,

CurrentLTV: position.CurrentLTV,

HealthFactor: position.HealthFactor,

LastUpdatedBlock: position.BlockNumber,

LastUpdatedAt: time.Now(),

}

if err := tx.Create(&userPosition).Error; err != nil {

return fmt.Errorf("failed to create user position: %w", err)

}

} else {

return fmt.Errorf("failed to query user position: %w", result.Error)

}

} else {

// 更新现有记录

userPosition.TotalCollateralETH = position.TotalCollateralETH

userPosition.TotalDebtETH = position.TotalDebtETH

userPosition.AvailableBorrowsETH = position.AvailableBorrowsETH

userPosition.CurrentLTV = position.CurrentLTV

userPosition.HealthFactor = position.HealthFactor

userPosition.LastUpdatedBlock = position.BlockNumber

userPosition.LastUpdatedAt = time.Now()

if err := tx.Save(&userPosition).Error; err != nil {

return fmt.Errorf("failed to update user position: %w", err)

}

}

// 更新缓存

cacheKey := fmt.Sprintf("user_position:%s", userAddress)

s.cache.Set(cacheKey, userPosition, 5*time.Minute)

return nil

}

// markEventProcessed 标记事件为已处理

func (s *DataSyncer) markEventProcessed(eventID uint64) error {

now := time.Now()

return s.db.Model(&models.BlockchainEvent{}).

Where("id = ?", eventID).

Update("processed_at", &now).

Error

}

// Stop 停⽌数据同步服务

func (s *DataSyncer) Stop() error {

s.processingLock.Lock()

defer s.processingLock.Unlock()

if !s.isRunning {

return nil

}

s.logger.Info("stopping data sync service")

s.isRunning = false

return nil

}4.3.3 数据⼀致性策略

在DeFi应⽤中,确保链上数据和链下数据库的⼀致性⾄关重要,尤其是在处理⽤户资产时。以下是Aave使⽤的数据⼀致性策略:

- 事务性处理

每个区块链事件的处理都在数据库事务中完成,确保所有相关数据更新要么全部成功,要么全部失败。 - 幂等性设计

每个事件处理器都设计为幂等的,意味着多次处理同⼀事件不会导致数据重复或不⼀致:

go

// 幂等性检查示例

func (s *DataSyncer) isEventProcessed(eventID uint64) (bool, error) {

var count int64

err := s.db.Model(&models.BlockchainEvent{}).

Where("id = ? AND processed_at IS NOT NULL", eventID).

Count(&count).Error

if err != nil {

return false, err

}

return count > 0, nil

}- 定期数据校验

实现⼀个周期性的数据校验服务,直接查询链上数据并与数据库记录⽐对:

go

// ⽤户余额校验函数

func validateUserBalances(ctx context.Context) error {

// 获取需要验证的⽤户列表

var users []string

err := db.Model(&models.UserPosition{}).

Where("health_factor < ?", big.NewInt(1.5e18)). // 优先验证⾼⻛险⽤户

Pluck("user_address", &users).Error

if err != nil {

return err

}

for _, user := range users {

// 从链上获取最新数据

onChainData, err := getOnChainUserData(user)

if err != nil {

logger.Error("failed to get on-chain data", zap.Error(err))

continue

}

// 从数据库获取数据

var dbData models.UserPosition

err = db.Where("user_address = ?", user).First(&dbData).Error

if err != nil {

logger.Error("failed to get db data", zap.Error(err))

continue

}

// ⽐较关键字段

if !isPositionDataConsistent(onChainData, dbData) {

logger.Warn("data inconsistency detected",

zap.String("user", user),

zap.String("health_factor_chain", onChainData.HealthFactor.String()),

zap.String("health_factor_db", dbData.HealthFactor.String()))

// 触发数据修复

if err := syncUserData(user); err != nil {

logger.Error("failed to sync user data", zap.Error(err))

}

}

}

return nil

}- 多级缓存架构

Aave使⽤多级缓存架构,包括Redis和本地内存缓存,提⾼数据访问性能的同时确保数据⼀致性:

go

type CacheStore interface {

Get(key string, value interface{}) error

Set(key string, value interface{}, expiration time.Duration) error

Delete(key string) error

}

// 多级缓存实现

type MultilevelCache struct {

localCache *ristretto.Cache // 本地内存缓存

redisClient *redis.Client // Redis客户端

logger *zap.Logger

}

// 获取缓存数据,优先从本地缓存获取

func (c *MultilevelCache) Get(key string, value interface{}) error {

// 尝试从本地缓存获取

if val, found := c.localCache.Get(key); found {

// 反序列化到⽬标变量

return json.Unmarshal(val.([]byte), value)

}

// 从Redis获取

val, err := c.redisClient.Get(context.Background(), key).Result()

if err != nil {

if err == redis.Nil {

return ErrCacheMiss

}

return err

}

// 解析数据

err = json.Unmarshal([]byte(val), value)

if err != nil {

return err

}

// 填充本地缓存

jsonData, _ := json.Marshal(value)

c.localCache.SetWithTTL(key, jsonData, 1, 5*time.Minute)

return nil

}4.3.4 性能优化策略

处理⾼频区块链事件需要⾼效的性能优化策略:

- 批量处理

批量获取和处理事件可以⼤幅减少数据库和⽹络交互:

go

// 批量更新⽤户余额

func (s *DataSyncer) bulkUpdateUserBalances(ctx context.Context, updates []models.UserAssetBalance) error {

// 使⽤事务

return s.db.Transaction(func(tx *gorm.DB) error {

for _, update := range updates {

// 使⽤upsert语法⼀次性插⼊或更新

query := `

INSERT INTO user_asset_balances

(user_address, asset_address, a_token_balance, stable_debt,

variable_debt, is_collateral, last_updated_at)

VALUES

(?, ?, ?, ?, ?, ?, ?)

ON CONFLICT (user_address, asset_address)

DO UPDATE SET

a_token_balance = EXCLUDED.a_token_balance,

stable_debt = EXCLUDED.stable_debt,

variable_debt = EXCLUDED.variable_debt,

is_collateral = EXCLUDED.is_collateral,

last_updated_at = EXCLUDED.last_updated_at

`

if err := tx.Exec(query,

update.UserAddress,

update.AssetAddress,

update.ATokenBalance,

update.StableDebt,

update.VariableDebt,

update.IsCollateral,

update.LastUpdatedAt,

).Error; err != nil {

return err

}

}

return nil

})

}- 并⾏处理

使⽤Golang的goroutines实现并⾏处理,充分利⽤多核CPU:

go

// 并⾏处理多个事件

func (s *DataSyncer) processEventsBatch(ctx context.Context, events []*models.BlockchainEvent) error {

// 使⽤有缓冲通道控制并发数

semaphore := make(chan struct{}, 10) // 最多10个并发处理

errChan := make(chan error, len(events))

var wg sync.WaitGroup

for _, event := range events {

wg.Add(1)

go func(evt *models.BlockchainEvent) {

defer wg.Done()

// 获取信号量

semaphore <- struct{}{}

defer func() { <-semaphore }()

// 处理事件

if err := s.processEvent(ctx, evt); err != nil {

errChan <- fmt.Errorf("failed to process event %d: %w", evt.ID, err)

}

}(event)

}

// 等待所有处理完成

wg.Wait()

close(errChan)

// 收集错误

var errs []error

for err := range errChan {

errs = append(errs, err)

}

if len(errs) > 0 {

return fmt.Errorf("batch processing errors: %v", errs)

}

return nil

}- 数据库索引优化

为⾼频查询创建合适的索引:

go

创建复合索引加速常⽤查询

CREATE INDEX idx_user_asset_balances_user_asset ON user_asset_balances (user_address,

asset_address);

CREATE INDEX idx_events_block_contract ON blockchain_events (block_number,

contract_address);

CREATE INDEX idx_txs_user_type ON transaction_history (user_address, transaction_type);

-- 为时间范围查询创建索引

CREATE INDEX idx_events_timestamp ON blockchain_events (timestamp);

CREATE INDEX idx_txs_timestamp ON transaction_history (timestamp);

-- 为健康因⼦监控创建索引

CREATE INDEX idx_positions_health_factor ON user_positions (health_factor);- 读写分离

将读操作和写操作分离到不同的服务,使⽤只读副本提⾼查询性能

go

type DatabaseConfig struct {

WriterDSN string // 主数据库连接

ReaderDSN string // 只读副本连接

}

// 初始化读写分离数据库

func setupDatabases(cfg DatabaseConfig) (*gorm.DB, *gorm.DB, error) {

// 初始化写⼊数据库

writerDB, err := gorm.Open(postgres.Open(cfg.WriterDSN), &gorm.Config{})

if err != nil {

return nil, nil, fmt.Errorf("failed to connect to writer database: %w", err)

}

// 初始化只读数据库

readerDB, err := gorm.Open(postgres.Open(cfg.ReaderDSN), &gorm.Config{})

if err != nil {

return nil, nil, fmt.Errorf("failed to connect to reader database: %w", err)

}

// 配置只读数据库

sqlDB, _ := readerDB.DB()

sqlDB.SetMaxIdleConns(20)

sqlDB.SetMaxOpenConns(100)

sqlDB.SetConnMaxLifetime(time.Hour)

return writerDB, readerDB, nil

}4.3.5 指标监控和告警

良好的监控系统是确保数据同步服务可靠运⾏的关键:

go

// 指标收集

func registerMetrics(registry *prometheus.Registry) *Metrics {

metrics := &Metrics{

EventsProcessed: prometheus.NewCounterVec(

prometheus.CounterOpts{

Name: "events_processed_total",

Help: "Total number of blockchain events processed",

},

[]string{"event_name", "status"},

),

ProcessingLatency: prometheus.NewHistogramVec(

prometheus.HistogramOpts{

Name: "event_processing_latency_seconds",

Help: "Latency of event processing in seconds",

Buckets: prometheus.ExponentialBuckets(0.01, 2, 10), // 从10ms到约5s

},

[]string{"event_name"},

),

DbQueryDuration: prometheus.NewHistogramVec(

prometheus.HistogramOpts{

Name: "db_query_duration_seconds",

Help: "Duration of database queries in seconds",

Buckets: prometheus.ExponentialBuckets(0.001, 2, 10), // 从1ms到约0.5s

},

[]string{"operation"},

),

CacheHitRatio: prometheus.NewGaugeVec(

prometheus.GaugeOpts{

Name: "cache_hit_ratio",

Help: "Ratio of cache hits to total cache accesses",

},

[]string{"cache_type"},

),

QueueLength: prometheus.NewGauge(

prometheus.GaugeOpts{

Name: "event_queue_length",

Help: "Number of events waiting to be processed",

},

),

HealthFactorAlerts: prometheus.NewCounterVec(

prometheus.CounterOpts{

Name: "health_factor_alerts_total",

Help: "Number of users with health factor below threshold",

},

[]string{"threshold"},

),

}

// 注册所有指标

registry.MustRegister(

metrics.EventsProcessed,

metrics.ProcessingLatency,

metrics.DbQueryDuration,

metrics.CacheHitRatio,

metrics.QueueLength,

metrics.HealthFactorAlerts,

)

return metrics

}

// 关键业务告警配置

var alertRules = []AlertRule{

{

Name: "high_event_processing_latency",

Query: "histogram_quantile(0.95,

sum(rate(event_processing_latency_seconds_bucket[5m])) by (event_name, le)) > 5",

Severity: "warning",

Annotations: map[string]string{

"summary": "High event processing latency",

"description": "95th percentile of event processing latency is above 5

seconds",

},

},

{

Name: "event_queue_backlog",

Query: "event_queue_length > 1000",

Severity: "critical",

Annotations: map[string]string{

"summary": "Event queue backlog",

"description": "More than 1000 events are waiting to be processed",

},

},

{

Name: "users_at_risk",

Query: "health_factor_alerts_total{threshold=\"1.05\"} > 50",

Severity: "critical",

Annotations: map[string]string{

"summary": "Many users at liquidation risk",

"description": "More than 50 users have health factor below 1.05",

},

},

}4.4 ⻛险监控服务 - DeFi协议的安全卫⼠

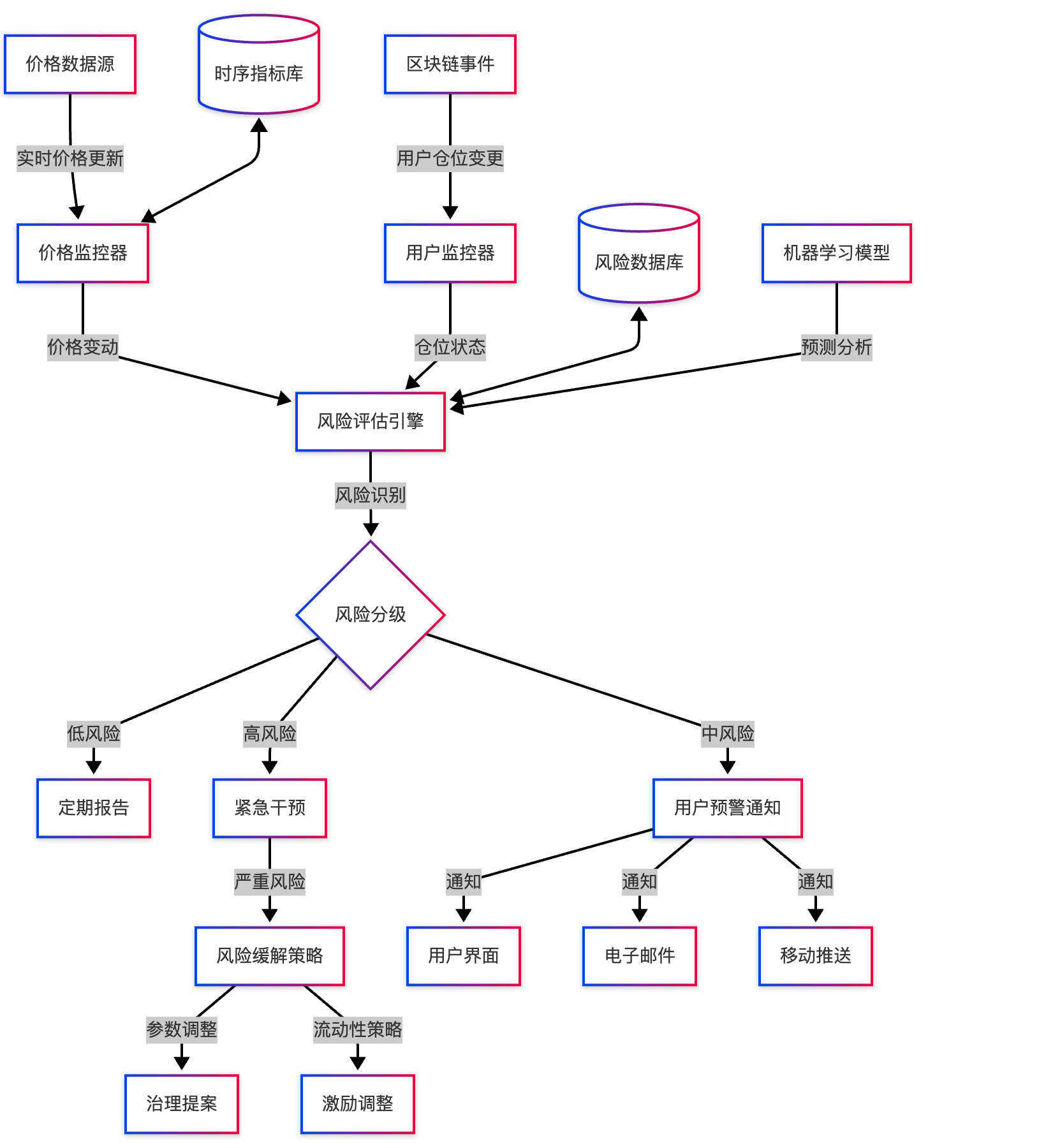

⻛险监控是DeFi借贷协议的安全防线,能够及时识别系统⻛险、预警潜在清算,并保护协议和⽤户资产安全。在Aave这样管理数百亿美元资产的协议中,⻛险监控系统必须达到近乎完美的可靠性和实时性。

⻛险监控系统的三⼤核⼼⽬标:

- 实时⻛险评估:持续监测⽤户仓位健康状况和资产价格波动

- 提前⻛险预警:在清算前向⽤户和协议团队发出预警

- 系统性⻛险防范:识别和缓解影响整个协议的潜在⻛险

⻛险监控系统的整体架构:

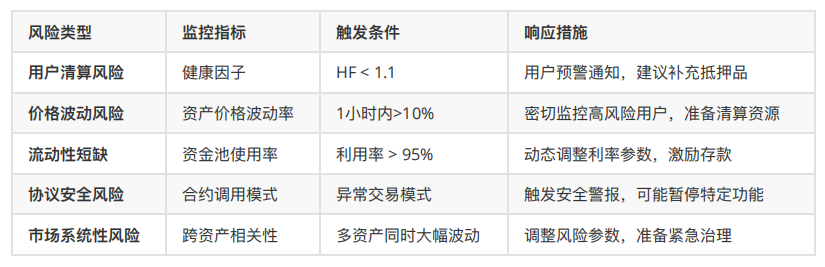

⻛险类型与监控策略:

⻛险监控服务处理多种不同类型的⻛险,每种⻛险需要特定的监控策略:

4.4.1 健康因⼦监控 - 清算预警系统

健康因⼦监控是⻛险监控服务的核⼼组件,通过实时追踪⽤户的健康因⼦变化,预测可能发⽣的清算事件,并采取⼲预措施。

健康因⼦的计算与阈值:

回顾健康因⼦的计算公式:

健康因⼦ = (抵押品价值 × 清算阈值) ÷ 借款价值

健康因⼦的关键阈值:

- HF < 1.0:触发清算(协议⻛险警报)

- 1.0 < HF < 1.05:极⾼⻛险(紧急⽤户通知)

- 1.05 < HF < 1.1:⾼⻛险(⽤户预警)

- 1.1 < HF < 1.25:中等⻛险(建议关注)

健康因⼦监控的核⼼流程:

- 数据收集阶段:

定期从区块链获取⽤户仓位数据

从价格预⾔机获取最新资产价格

计算每个借款⽤户的当前健康因⼦ - ⻛险评估阶段:

根据健康因⼦划分⻛险等级

结合价格波动预测未来健康因⼦变化

识别⾼⻛险⽤户群体 - 预警通知阶段:

通过多渠道向⽤户发送⻛险预警

提供补充抵押品或偿还部分贷款的建议

更新⽤户界⾯中的⻛险指示器 - 清算准备阶段:

为可能的清算事件准备流动性

监控清算奖励的经济可⾏性

准备清算机器⼈资源

下⾯展示了Aave如何实现健康因⼦监控服务的核⼼代码:

go

package web3_interview_sharing

import (

"context"

"fmt"

"math/big"

"sync"

"time"

"github.com/ethereum/go-ethereum/common"

"go.uber.org/zap"

"gorm.io/gorm"

"github.com/aave/go-service/internal/config"

"github.com/aave/go-service/internal/contracts"

"github.com/aave/go-service/internal/models"

"github.com/aave/go-service/internal/notification"

"github.com/aave/go-service/internal/store"

"github.com/aave/go-service/internal/utils"

)

// ⻛险等级定义

type RiskLevel int

const (

RiskLevelNone RiskLevel = iota

RiskLevelLow

RiskLevelMedium

RiskLevelHigh

RiskLevelExtreme

)

// 健康因⼦阈值常量

var (

// 健康因⼦以1e18为基数

HealthFactorLiquidation = new(big.Int).SetUint64(1000000000000000000) // 1.0

HealthFactorExtremeRisk = new(big.Int).SetUint64(1050000000000000000) // 1.05

HealthFactorHighRisk = new(big.Int).SetUint64(1100000000000000000) // 1.1

HealthFactorMediumRisk = new(big.Int).SetUint64(1250000000000000000) // 1.25

)

// HealthMonitor 健康因⼦监控服务

type HealthMonitor struct {

db *gorm.DB

lendingPool *contracts.LendingPool

priceOracle *contracts.PriceOracle

notifier notification.Service

logger *zap.Logger

config *config.RiskConfig

// 并发控制

mutex sync.Mutex

isRunning bool

stopChan chan struct{}

// 统计数据

totalWarnings int

warningsByLevel map[RiskLevel]int

lastScanTime time.Time

}

// NewHealthMonitor 创建健康因⼦监控服务

func NewHealthMonitor(

db *gorm.DB,

lendingPool *contracts.LendingPool,

priceOracle *contracts.PriceOracle,

notifier notification.Service,

logger *zap.Logger,

config *config.RiskConfig,

) *HealthMonitor {

return &HealthMonitor{

db: db,

lendingPool: lendingPool,

priceOracle: priceOracle,

notifier: notifier,

logger: logger.Named("health_monitor"),

config: config,

stopChan: make(chan struct{}),

warningsByLevel: make(map[RiskLevel]int),

}

}

// Start 启动监控服务

func (m *HealthMonitor) Start(ctx context.Context) error {

m.mutex.Lock()

defer m.mutex.Unlock()

if m.isRunning {

return fmt.Errorf("health monitor is already running")

}

m.logger.Info("starting health factor monitoring service")

m.isRunning = true

// 启动周期性扫描协程

go m.runMonitoringLoop(ctx)

return nil

}

// 定期扫描所有借款⽤户

func (m *HealthMonitor) runMonitoringLoop(ctx context.Context) {

// 配置扫描间隔(默认1分钟)

scanInterval := m.config.ScanInterval

if scanInterval == 0 {

scanInterval = 60 * time.Second

}

ticker := time.NewTicker(scanInterval)

defer ticker.Stop()

// 初始扫描

if err := m.scanAllBorrowers(ctx); err != nil {

m.logger.Error("initial borrower scan failed", zap.Error(err))

}

for {

select {

case <-ticker.C:

if err := m.scanAllBorrowers(ctx); err != nil {

m.logger.Error("borrower scan failed", zap.Error(err))

}

case <-m.stopChan:

m.logger.Info("health monitor stopped")

return

case <-ctx.Done():

m.logger.Info("health monitor context cancelled")

return

}

}

}

// 扫描所有借款⽤户

func (m *HealthMonitor) scanAllBorrowers(ctx context.Context) error {

startTime := time.Now()

m.logger.Debug("starting borrower scan")

// 1. 获取所有有借款的⽤户

var borrowers []models.UserPosition

err := m.db.Where("total_debt_eth > ?", 0).Find(&borrowers).Error

if err != nil {

return fmt.Errorf("failed to get borrowers: %w", err)

}

m.logger.Info("found borrowers with debt", zap.Int("count", len(borrowers)))

// 2. 检查每个⽤户的健康状况

var (

wg sync.WaitGroup

semaphore = make(chan struct{}, 20) // 最多20个并发检查

riskCountMutex sync.Mutex

riskCounts = make(map[RiskLevel]int)

)

for _, borrower := range borrowers {

wg.Add(1)

semaphore <- struct{}{}

go func(user models.UserPosition) {

defer wg.Done()

defer func() { <-semaphore }()

// 检查⽤户健康状况

riskLevel, err := m.checkUserHealth(ctx, user)

if err != nil {

m.logger.Error("failed to check user health",

zap.String("user", user.UserAddress),

zap.Error(err))

return

}

if riskLevel > RiskLevelLow {

riskCountMutex.Lock()

riskCounts[riskLevel]++

riskCountMutex.Unlock()

}

}(borrower)

}

// 等待所有检查完成

wg.Wait()

// 3. 更新统计数据

m.mutex.Lock()

defer m.mutex.Unlock()

m.lastScanTime = time.Now()

for level, count := range riskCounts {

m.warningsByLevel[level] += count

}

totalUsersAtRisk := 0

for _, count := range riskCounts {

totalUsersAtRisk += count

}

m.totalWarnings += totalUsersAtRisk

m.logger.Info("borrower scan completed",

zap.Int("total_borrowers", len(borrowers)),

zap.Int("users_at_risk", totalUsersAtRisk),

zap.Int("extreme_risk", riskCounts[RiskLevelExtreme]),

zap.Int("high_risk", riskCounts[RiskLevelHigh]),

zap.Int("medium_risk", riskCounts[RiskLevelMedium]),

zap.Duration("duration", time.Since(startTime)),

)

return nil

}

// 检查单个⽤户的健康状况

func (m *HealthMonitor) checkUserHealth(ctx context.Context, user models.UserPosition) (RiskLevel, error) {

// 1. 获取最新的⽤户数据(直接从链上查询,确保数据最新)

address := common.HexToAddress(user.UserAddress)

accountData, err := m.lendingPool.GetUserAccountData(&bind.CallOpts{Context: ctx},

address)

if err != nil {

return RiskLevelNone, fmt.Errorf("failed to get account data: %w", err)

}

// 2. 分析健康因⼦,确定⻛险级别

riskLevel := m.analyzeHealthFactor(accountData.HealthFactor)

// 3. 对于⾼⻛险⽤户,计算价格影响

if riskLevel >= RiskLevelHigh {

// 预测价格波动对健康因⼦的影响

priceImpact, err := m.calculatePriceImpact(ctx, user)

if err != nil {

m.logger.Warn("failed to calculate price impact",

zap.String("user", user.UserAddress),

zap.Error(err))

} else if priceImpact.IsHighImpact {

// 如果价格波动可能导致清算,升级⻛险等级

if riskLevel == RiskLevelHigh {

riskLevel = RiskLevelExtreme

}

}

// 4. 发送⻛险通知

if err := m.sendRiskNotification(ctx, user, riskLevel, accountData.HealthFactor); err != nil {

m.logger.Error("failed to send risk notification",

zap.String("user", user.UserAddress),

zap.Error(err))

}

// 5. 记录⾼⻛险⽤户

if err := m.recordRiskUser(user, riskLevel, accountData.HealthFactor); err != nil {

m.logger.Error("failed to record risk user",

zap.String("user", user.UserAddress),

zap.Error(err))

}

}

return riskLevel, nil

}

// 根据健康因⼦分析⻛险等级

func (m *HealthMonitor) analyzeHealthFactor(healthFactor *big.Int) RiskLevel {

if healthFactor.Cmp(HealthFactorLiquidation) <= 0 {

return RiskLevelExtreme

} else if healthFactor.Cmp(HealthFactorExtremeRisk) <= 0 {

return RiskLevelExtreme

} else if healthFactor.Cmp(HealthFactorHighRisk) <= 0 {

return RiskLevelHigh

} else if healthFactor.Cmp(HealthFactorMediumRisk) <= 0 {

return RiskLevelMedium

} else if healthFactor.Cmp(big.NewInt(2e18)) <= 0 {

return RiskLevelLow

}

return RiskLevelNone

}

// 发送⻛险预警通知

func (m *HealthMonitor) sendRiskNotification(

ctx context.Context,

user models.UserPosition,

riskLevel RiskLevel,

healthFactor *big.Int,

) error {

// 构建通知内容

healthFactorStr := utils.FormatHealthFactor(healthFactor)

var title, message string

var priority notification.Priority

switch riskLevel {

case RiskLevelExtreme:

title = "紧急⻛险预警: 您的头⼨接近清算"

message = fmt.Sprintf("您的健康因⼦已降⾄ %s,极度接近清算阈值1.0。"+

"请⽴即补充抵押品或偿还部分贷款以避免清算。", healthFactorStr)

priority = notification.PriorityHigh

case RiskLevelHigh:

title = "⾼⻛险预警: 您的头⼨存在清算⻛险"

message = fmt.Sprintf("您的健康因⼦已降⾄ %s,存在清算⻛险。"+

"建议尽快补充抵押品或偿还部分贷款。", healthFactorStr)

priority = notification.PriorityMedium

case RiskLevelMedium:

title = "⻛险提醒: 您的健康因⼦正在下降"

message = fmt.Sprintf("您的健康因⼦为 %s,处于安全范围,但需要关注市场波动。",

healthFactorStr)

priority = notification.PriorityLow

default:

return nil // ⽆需发送通知

}

// 发送通知

notification := notification.Notification{

UserAddress: user.UserAddress,

Title: title,

Message: message,

Type: notification.TypeRiskAlert,

Priority: priority,

Metadata: map[string]interface{}{

"health_factor": healthFactorStr,

"risk_level": riskLevel.String(),

"timestamp": time.Now().Unix(),

},

}

return m.notifier.Send(ctx, notification)

}

// 记录⾼⻛险⽤户

func (m *HealthMonitor) recordRiskUser(

user models.UserPosition,

riskLevel RiskLevel,

healthFactor *big.Int,

) error {

// 仅记录⾼⻛险和极⾼⻛险⽤户

if riskLevel < RiskLevelHigh {

return nil

}

// 记录到数据库

riskRecord := models.RiskAlert{

UserAddress: user.UserAddress,

RiskLevel: int(riskLevel),

HealthFactor: healthFactor.String(),

Timestamp: time.Now(),

Resolved: false,

}

return m.db.Create(&riskRecord).Error

}

// 计算价格波动对健康因⼦的影响

func (m *HealthMonitor) calculatePriceImpact(

ctx context.Context,

user models.UserPosition,

) (*PriceImpactResult, error) {

// 获取⽤户的抵押品和借款

var userAssets []models.UserAssetBalance

if err := m.db.Where("user_address = ?", user.UserAddress).Find(&userAssets).Error; err != nil {

return nil, err

}

// 分析价格波动敏感性

// 这⾥简化处理,实际实现会更复杂,考虑相关性等因素

result := &PriceImpactResult{

IsHighImpact: false,

}

// 如果健康因⼦接近临界值,且主要抵押品是波动性资产,标记为⾼影响

if user.HealthFactor.Cmp(HealthFactorHighRisk) <= 0 {

for _, asset := range userAssets {

if !asset.IsCollateral {

continue // 跳过⾮抵押品资产

}

// 检查资产波动性

volatility, err := m.getAssetVolatility(ctx, asset.AssetAddress)

if err != nil {

continue

}

// ⾼波动性资产

if volatility > 0.05 { // 5%⽇波动率

result.IsHighImpact = true

result.VolatileCollateral = asset.AssetAddress

break

}

}

}

return result, nil

}

// 获取资产波动性

func (m *HealthMonitor) getAssetVolatility(ctx context.Context, assetAddress string) (float64, error) {

// 实际实现会调⽤价格服务或市场数据API

// 这⾥简化为静态数据

volatilityMap := map[string]float64{

"0xC02aaA39b223FE8D0A0e5C4F27eAD9083C756Cc2": 0.06, // WETH

"0x2260FAC5E5542a773Aa44fBCfeDf7C193bc2C599": 0.08, // WBTC

"0x7Fc66500c84A76Ad7e9c93437bFc5Ac33E2DDaE9": 0.12, // AAVE

"0x1f9840a85d5aF5bf1D1762F925BDADdC4201F984": 0.15, // UNI

"0x514910771AF9Ca656af840dff83E8264EcF986CA": 0.14, // LINK

"0xA0b86991c6218b36c1d19D4a2e9Eb0cE3606eB48": 0.01, // USDC

"0xdAC17F958D2ee523a2206206994597C13D831ec7": 0.01, // USDT

"0x6B175474E89094C44Da98b954EedeAC495271d0F": 0.01, // DAI

}

// 默认波动率为5%

volatility, ok := volatilityMap[assetAddress]

if !ok {

return 0.05, nil

}

return volatility, nil

}

// Stop 停⽌监控服务

func (m *HealthMonitor) Stop() error {

m.mutex.Lock()

defer m.mutex.Unlock()

if !m.isRunning {

return nil

}

close(m.stopChan)

m.isRunning = false

m.logger.Info("health monitor service stopped")

return nil

}

// 价格影响分析结果

type PriceImpactResult struct {

IsHighImpact bool

VolatileCollateral string

ImpactPercentage float64

}

// String 返回⻛险等级的字符串表示

func (r RiskLevel) String() string {

switch r {

case RiskLevelNone:

return "None"

case RiskLevelLow:

return "Low"

case RiskLevelMedium:

return "Medium"

case RiskLevelHigh:

return "High"

case RiskLevelExtreme:

return "Extreme"

default:

return "Unknown"

}

}4.4.2 价格监控与趋势预测

除了健康因⼦监控,Aave的⻛险监控系统还包括价格监控和趋势预测组件,⽤于提前识别市场波动可能带来的⻛险。

价格监控的核⼼功能:

- 多源价格验证:

从多个价格预⾔机获取数据,交叉验证

检测价格异常和操纵尝试

实时计算价格偏差统计 - 波动率分析:

计算短期波动率(1⼩时、24⼩时)

识别超出历史范围的价格变动

预测价格波动趋势 - ⻛险敞⼝评估:

计算协议对特定资产的⻛险敞⼝

评估抵押品组合的相关性⻛险

预测市场震荡的系统性影响