2025年的年底,AI圈迎来了一场意料之外的"技术普惠"。就在12月30日,大家还在盘点年度大模型的时候,腾讯默默扔出了一张王炸------混元翻译模型Tencent-HY-MT1.5系列正式开源。

这不仅仅是又一个开源模型那么简单。这次发布的重点不在于"大",而在于"巧"。在长期由云端巨头把持的高质量翻译领域,腾讯这次似乎想告诉所有人:最顶级的翻译体验,其实可以塞进你的手机里。

告别"傻大黑粗",小模型也有大智慧

这次开源之所以引起开发者社区的骚动,核心在于那个名为Tencent-HY-MT1.5-1.8B的小家伙。

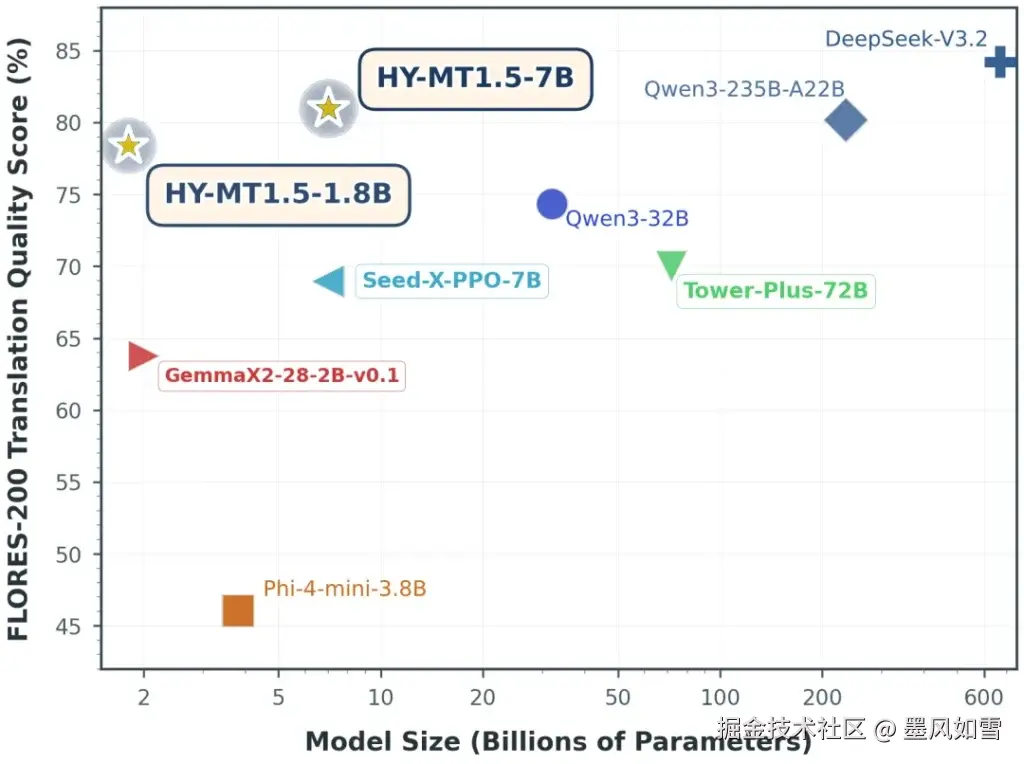

在以往的认知里,翻译模型想要准,参数量就得堆上去。但这个1.8B的模型打破了这个定律。它经过量化后,内存占用仅需约1GB。这是什么概念?这意味着哪怕是几年前的老款安卓机,或者是算力有限的边缘设备,都能毫无压力地跑起来。

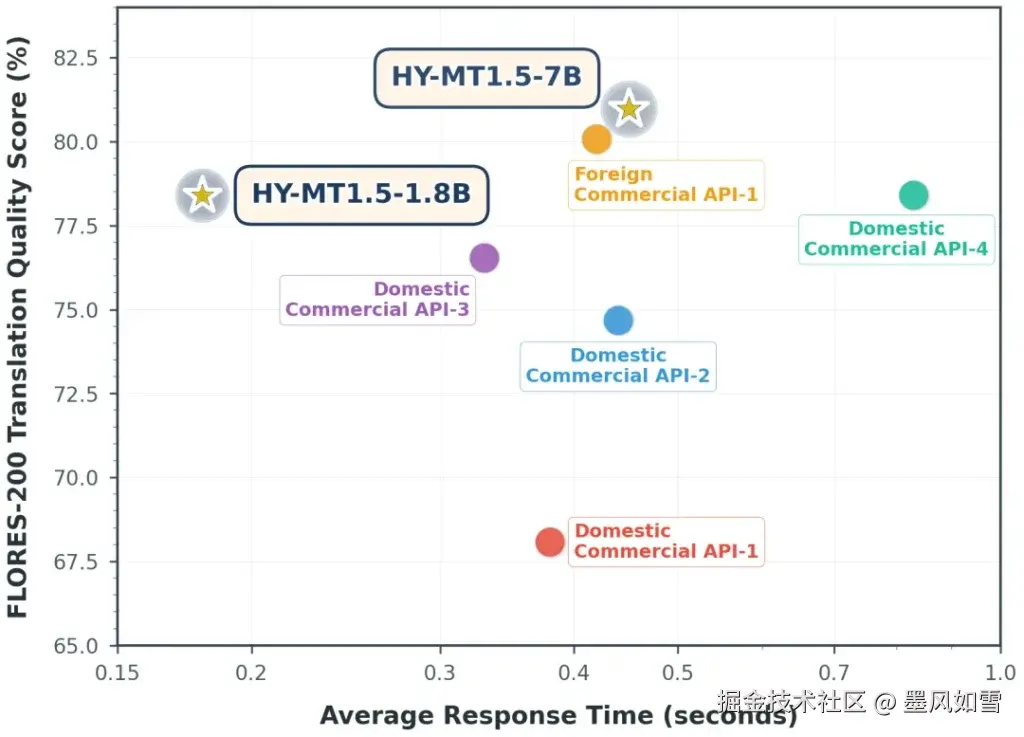

更夸张的是它的速度。在处理50个词元时,它的平均响应时间只有0.18秒。作为对比,市面上主流的商用翻译API通常在0.4秒左右。这不是快了一点点,这是倍杀。对于做实时字幕、同声传译硬件的开发者来说,这种低延迟简直是梦寐以求的。

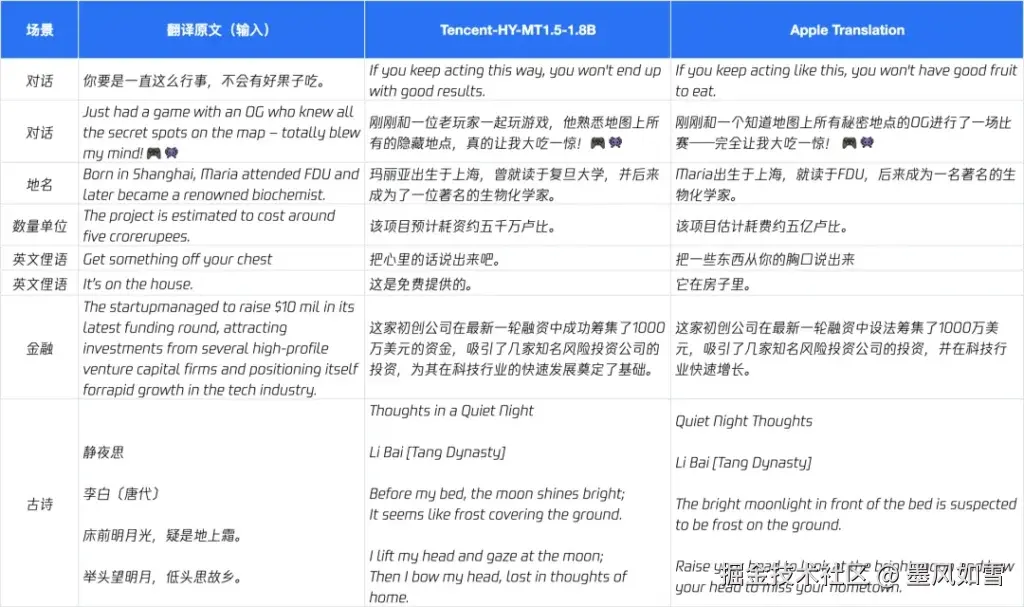

如果你担心"小马拉大车"跑不动,那就多虑了。得益于一种叫"On-Policy Distillation"(策略蒸馏)的技术,这个1.8B的"学生"是在7B"老师"的手把手教导下训练出来的。在Flores200等权威测试集上,它的表现甚至硬刚了谷歌的Gemini-3.0-Pro,达到了后者90分位的水平。

全能选手:从云端到指尖的降维打击

当然,如果你手里有充裕的算力资源,追求极致的翻译信达雅,系列中的老大哥Tencent-HY-MT1.5-7B则是更好的选择。

这个7B模型并非凭空出世,它是WMT25比赛中拿下30个语种冠军的模型的直系升级版。你可以把它理解为一位严谨的语言学家,专门解决那些让人头疼的"译文夹带私货"、注释混乱以及语种混杂的问题。

更有意思的是,这两个模型不是孤立的。在实际应用架构中,腾讯给出的思路是"协同作战":端侧用1.8B做毫秒级实时响应,云端用7B做深度润色。这种组合拳,直接平衡了成本、速度和质量这三个"不可能三角"。

懂行话,也懂方言

在语种支持上,混元MT1.5系列没有止步于中英日韩等"大路货"。它一口气支持了33个语种的互译,甚至还专门照顾了捷克语、冰岛语这些小众领域。

特别值得一提的是,它对中文语境的深度理解。除了常规语言,它还覆盖了粤语、藏语、维吾尔语等5种民汉语言和方言。对于国内的跨境电商、出海应用或者民族地区的数字化建设,这无疑是个巨大的利好。

此外,这个模型非常"懂事"。做过文档翻译的人都知道,最怕翻译完格式乱了。混元MT1.5特别强化了格式保留能力,无论是网页HTML代码还是Markdown文档,翻译后排版依然稳如老狗。同时,它还支持自定义术语库,这对于医疗、法律、金融这些容不得半点歧义的行业来说,是刚需中的刚需。

写在最后

目前,该系列模型已经登录GitHub和HuggingFace,并且原生适配了Arm、高通、Intel等主流硬件平台。

腾讯这一波操作,实际上是把企业级的翻译能力下放到了消费级设备。当一个只要1GB内存的模型就能跑出媲美商用API的效果时,我们有理由相信,未来的翻译工具将不再依赖网络信号,而是真正成为设备本身的一部分。

对于开发者而言,现在的门槛已经降到了地板上。无论你是想给APP加个实时翻译功能,还是想折腾一个离线翻译硬件,Tencent-HY-MT1.5都是目前最值得尝试的开源基座之一。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站