《娜璋带你读论文》系列主要是督促自己阅读优秀论文及听取学术讲座,并分享给大家,希望您喜欢。由于作者的英文水平和学术能力不高,需要不断提升,所以还请大家批评指正,非常欢迎大家给我留言评论,学术路上期待与您前行,加油。

前一篇博客介绍了智能体与入侵检测结合的工作IDS-Agent,其是大语言模型(LLM)驱动的人工智能入侵检测Agent系统,特点是能够解释检测结果、进行自定义设置并适应零日攻击。本文将介绍LAMD,一种LLM上下文驱动的Android恶意软件检测框架,LAMD结合关键上下文提取来隔离安全关键代码区域并构建程序结构,然后应用分层代码推理从低级指令到高级语义逐步分析应用程序行为。注意,由于我们团队还在不断成长和学习中,写得不好的地方还请海涵,希望这篇文章对您有所帮助,这些大佬真值得我们学习。fighting!

- 欢迎关注作者新建的『网络攻防和AI安全之家』知识星球(文章末尾)

文章目录

原文作者 :Xingzhi Qian, Xinran Zheng, Yiling He, Shuo Yang and Lorenzo Cavallaro

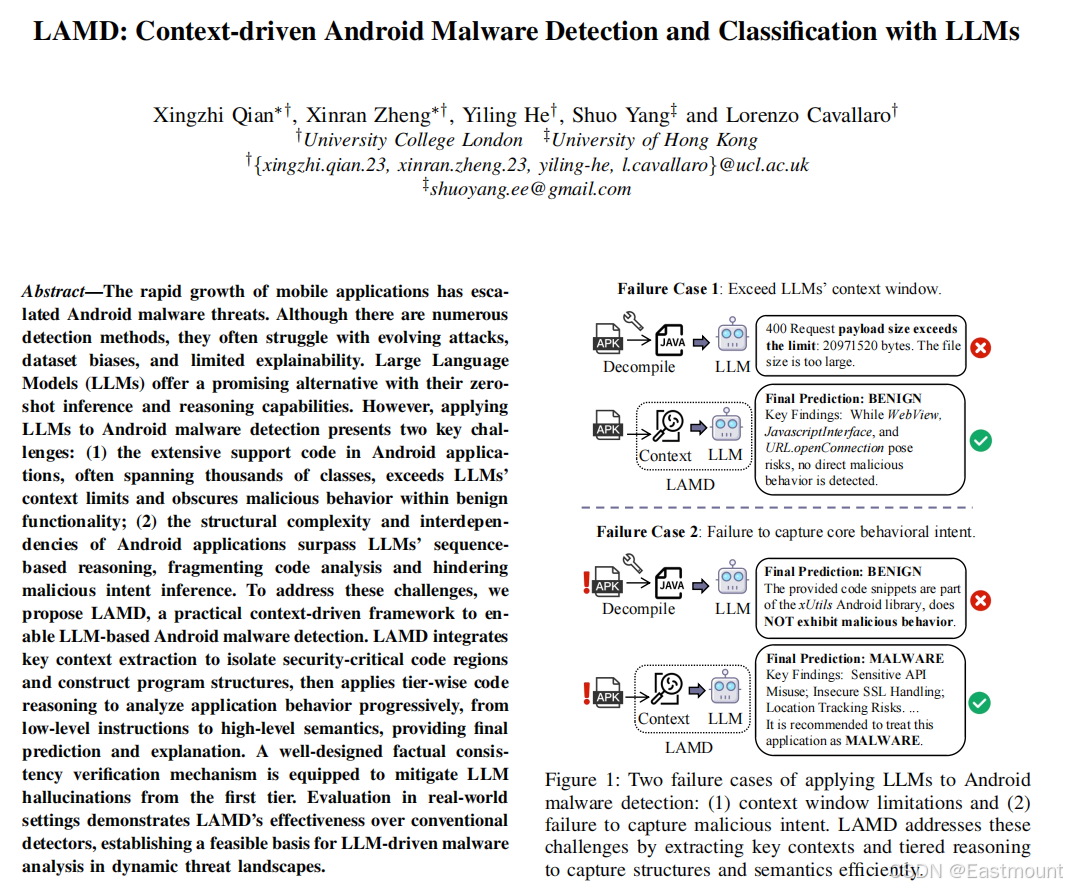

原文标题 :LAMD: Context-driven Android Malware Detection and Classification with LLMs

原文链接 :https://ieeexplore.ieee.org/document/11050830

发表期刊 :2025 IEEE Symposium on Security and Privacy Workshops (SPW)

研究机构 :伦敦大学, 香港大学

笔记作者:贵大0624团队 李琳

一.摘要

随着移动应用的迅猛发展,Android 恶意软件威胁持续加剧。尽管已有大量检测方法被提出,但在应对不断演化的攻击手段、数据集偏差以及检测结果可解释性不足等方面仍面临显著挑战。近年来,大语言模型(Large Language Models,LLMs)凭借其零样本推理与复杂语义理解能力,为 Android 恶意软件检测提供了一种具有潜力的新途径。然而,将 LLMs 应用于 Android 恶意软件检测仍面临两项关键挑战:

- (1)Android 应用通常包含大量支撑性代码,往往涉及成千上万个类,这不仅超出了 LLM 的上下文长度限制,也使恶意行为淹没于大量良性功能之中;

- (2)Android 应用在结构上具有高度复杂性与强依赖关系,其程序结构与执行逻辑超出了 LLM 以序列为中心的推理能力,导致代码分析过程碎片化,从而阻碍对恶意意图的准确推断。

为应对上述挑战,本文提出了一种实用的上下文驱动框架 LAMD,用于实现基于 LLM 的 Android 恶意软件检测。LAMD 首先通过关键上下文抽取机制,定位并隔离安全关键代码区域,同时构建程序结构表示;随后采用分层代码推理策略,对应用行为进行逐级分析,从底层指令级特征到高层语义表示,最终给出检测预测结果及相应解释。此外,框架引入了一种精心设计的事实一致性验证机制,用以缓解 LLM 在初始推理阶段可能产生的幻觉问题。基于真实应用场景的评估结果表明,LAMD 在检测效果上优于传统检测方法,为在动态威胁环境中开展基于大语言模型的恶意软件分析奠定了可行基础。

二.引言

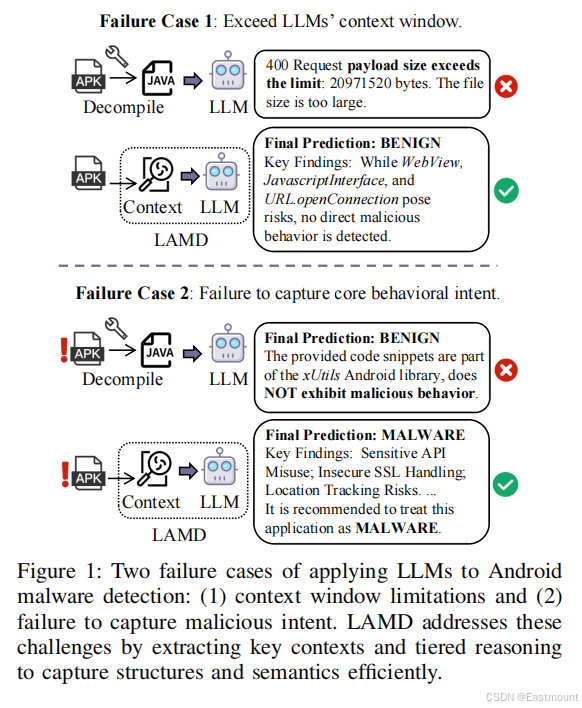

现有研究存在不足:Android的开放和演化特性使自适应恶意软件的检测变得复杂,对特定数据集的依赖 引入了偏差,例如模糊的时间戳和随机选择的样本,这进一步损害模型的可靠性。传统检测器缺乏可解释性,无法提供对恶意行为的清晰,人类可读的见解。将LLMS应用于Android恶意软件检测的主要挑战:

- 上下文窗口限制

- 未能捕获恶意意图

本文的研究创新点:

- 采用LAMD通过提取关键上下文和分层推理有效捕获结构和语义

具体而言,我们对API执行静态分析,并使用定制的向后切片算法来提取关键变量、依赖项和预定义可疑API的调用。这些元素被转换为图形表示,过滤不相关的代码并保留LLM的基本语义,还引入了分层代码推理和事实一致性验证相结合的方法,跨多层传递结构化知识来理解和解释检测结果。

本文的主要贡献如下:

-

提出了 LAMD 框架。本文提出了一种名为 LAMD 的上下文驱动型框架,用于实现基于大语言模型(LLMs)的 Android 恶意软件检测。该框架是首个面向实际应用场景、支持可解释分析的 LLM 驱动 Android 恶意软件检测方法,为 LLM 在恶意代码分析任务中的应用提供了实践性范式。

-

设计了关键上下文抽取与分层代码推理机制。LAMD 将 关键上下文抽取 与 分层(tier-wise)代码推理 相结合,通过过滤无关功能代码、保留关键语义与结构依赖,有效缓解了 Android 应用中代码规模庞大和结构复杂对 LLM 推理能力的限制。同时,引入了有针对性的事实一致性验证机制,以保证推理过程的准确性。

-

在真实场景下验证了方法的有效性并分析了模型范式差异。论文在真实世界设置下对 LAMD 进行了评估,结果表明该方法在分布漂移场景中优于传统学习型检测方法,能够更有效地检测并解释快速演化的 Android 恶意软件。同时,论文讨论了基于学习的方法与预训练 LLM 之间的差异与张力,为后续研究提供了方向性思考。

三.Methodology

1.整体架构

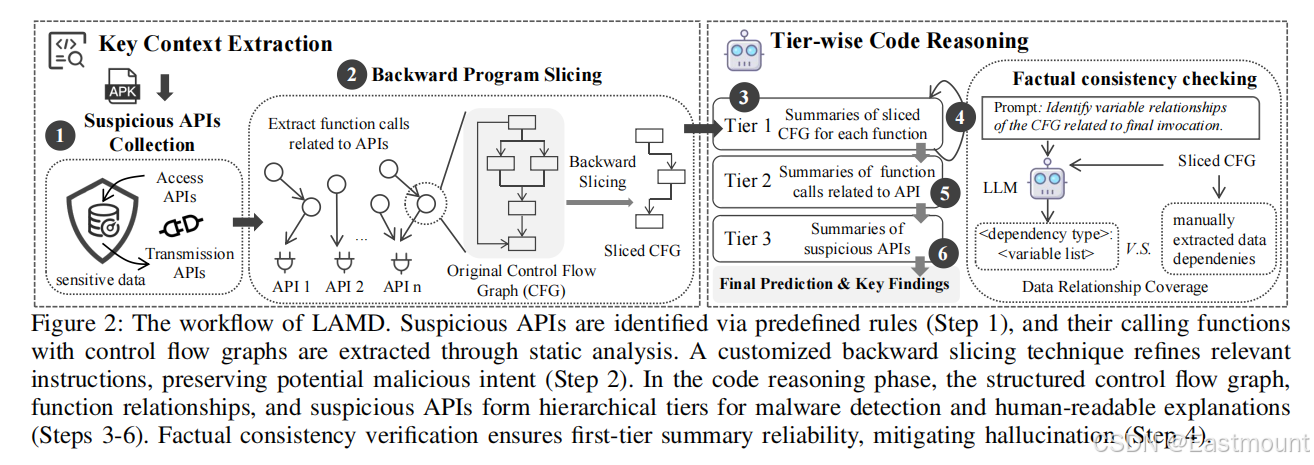

LAMD的原始输入由APK文件组成,从这些文件中提取可疑的API及其切片上下文作为LLMS的输入。然后,通过三层代码推理来确定应用程序的恶意行为。

(1)关键上下文提取

将可疑API识别为种子点,并分析其在应用程序中的控制和数据依赖,通过修剪潜在恶意交互的调用关系来提供关键程序行为的结构化表示。

(2)分层代码推理

LAMD采用分层推理策略,在三个级别:Function、API、APK来处理信息,每个级别的输出通知下一个级别,在第一层应用事实一致性验证。

LAMD的工作流程框架图如下所示:

- 步骤1:通过预定义的规则识别可疑API,通过静态分析提取带有控制流图的调用函数

- 步骤2:定制反向切片技术改进相关指令,保留潜在的恶意意图

- 步骤3-6:在代码推理阶段,结构化控制流程图,函数关系和可疑API形成用于恶意软件检测和人类可读解释的分层

2.关键上下文提取

(1)可疑API收集

恶意软件利用系统漏洞或API权限来窃取数据,操纵资源或维护持久性,许多攻击依赖敏感的API调用来实现恶意行为。通过对API进行静态分析,提取可疑API作为识别恶意软件的关键上下文,为了提取可疑API,利用基于Pscout、Susi和Flowdroid的公开可用只是来标记,这些样本要单独处理。

(2)向后程序切片

提取可疑的API很有用,但单独分析它们往往会模糊它们的上下文,恶意软件可能会利用 sendTextMessage()来获取溢价信息。为了捕获意图,我们提取调用可疑API的函数并细化它们的控制流图(Cfg),由于CFG可能很大且有噪音,我们应用向后切片来隔离影响API调用的指令。

反向切片算法由两个步骤组成:

- 变量检索:识别与可疑API使用的参数(和内部状态)有关的所有变量,并将它们存储在候选集合中

- 切片提取:添加与第一步收集的变量相关的指令

3.层次化代码推理

提出了一种三层推理策略,将API行为分析从粗粒度细化到细粒度,这种分层方法改进了恶意组件识别,缓解了LLM令牌长度限制,并通过可分离的推理捕获结构和调用语义,确保了更有效和更具可扩展性的恶意软件检测框架。

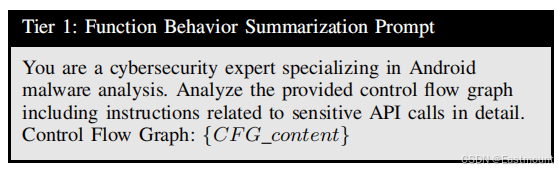

第一级:函数行为摘要

在前一阶段,提取几个调用可疑API的函数并将其切片以维护相关上下文。函数的每个切片CFG被馈送到LLM以捕获低级代码模式和功能。

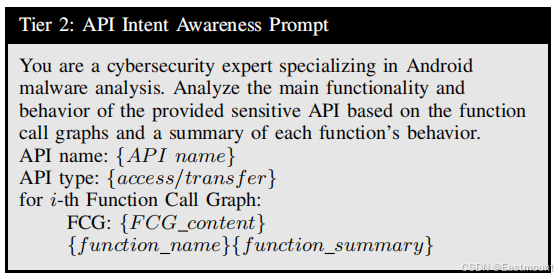

第二级:API意图感知

特定API的上下文由一系列函数确定,由于上下文的不同,一个API可能会出现在多个函数调用图(FCG)中。

- 例如,getDeviceId()在仅用于本地日志记录时是良性的,但在 sendImeiToServer()中调用时会变得恶意,在sendImeiToServer()中它会将IMEI渗透到远程服务器。

因此,在这个中间层,与可疑API关联的所有功能都被组织到多个FCG中,以分析其总体意图,FCG中的每个节点由第1层中生成的函数摘要表示。

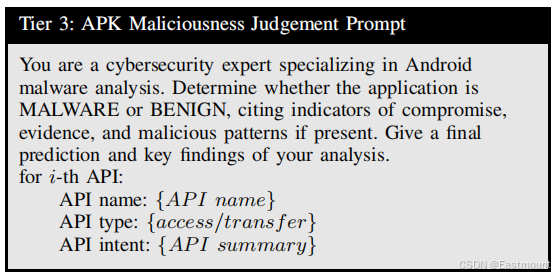

第三级:APK恶意判断

从APK中的可疑API中提取意图后,LLMS评估其恶意并证明其决定的合理性,生成危害指标(IOC),汇总敏感数据访问,外部传输和异常行为,提高透明度和信任度。

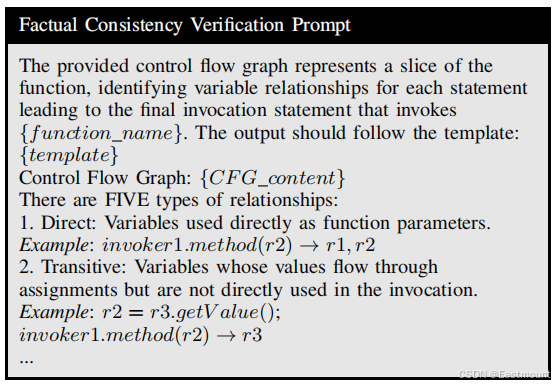

事实一致性验证

本文设计了一个结构化模板来捕获切片CFG中的数据依赖关系,为了加强推理,我们提示LLM根据特定的定义从输入函数中选择相应的数据关系,定义了五个依赖项:变量到API的交互(直接的、可传递的、有条件的)和变量间的关系(并行、派生)。前者跟踪变量如何通过赋值、调用链和控制流影响API执行,而后者捕获联合计算和派生。

四.实验评估

1.数据集构造

构建了一个时间跨度从2014到2023年的数据集,该数据集来自Androzoo平台,这是一个综合资源库,聚合了来自 Google Play、PlayDrone、VirusShare 和 AppChina 等来源的样本。

数据集构造坚持以下原则:

- 在训练和测试中保持时间顺序

- 保持真实世界的恶意软件与良性软件的比率

分类指标:在恶意软件数据集中,存在类别不平衡问题,为了平衡这种不平衡,研究采用F1-score来评估模型性能,同时,还会尽量降低假阳性率(FPR,将正常样本误判为恶意的比例)和假阴性率(FNR,将恶意样本误判为正常的比例),这样做的目的是提升检测准确性,同时减少人工分析的工作量。

摘要指标:有效的恶意软件分析需要提供可解释的洞察,并辅助人工审计。由于恶意软件家族的识别往往需要专家评审,因此初步分类会优先关注行为模式的 "常识性区分"。在评估时,采用了基于ChatGPT的指标:由GPT-40-mini来评估LAMD模型的检测结果是否与每一类恶意软件的预期行为相符。

2.对比实验

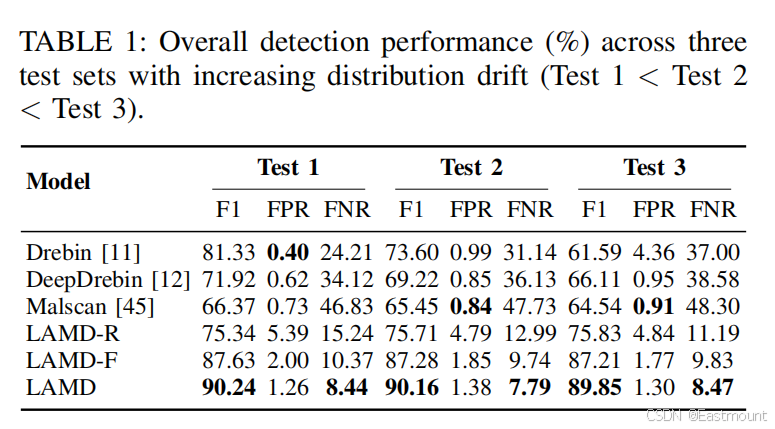

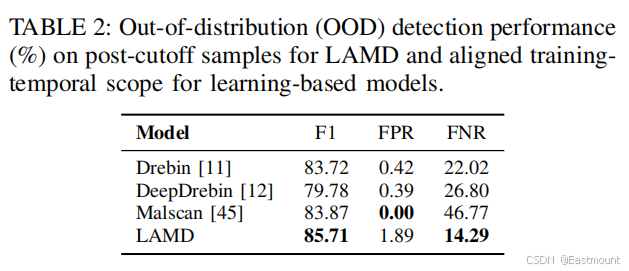

在分布漂移不断增加的三个测试集中的整体检测性能如下表所示:

-

Debrin [11]、Debrin [12]随着测试集分布偏移增大(从 Test 1 到 Test 3),F1分数明显下降,FPR 和 FNR 显著上升,说明对分布偏移的鲁棒性较差。

-

Malscan [52]在 Test 2 中 FPR 低至 0.73,Test 3 中 FPR 为 0.94,假阳性控制较好,但 F1 和 FNR 在偏移后也有一定波动。

-

LAMD 系列(LAMD-R、LAMD-F、LAMD)整体表现最优,F1 分数在三个测试集上均保持较高水平,FPR 和 FNR 也较低,尤其在分布偏移最大的 Test 3 中仍能维持较好性能,说明对分布偏移的适应性更强。为了评估组件影响,LAMD-R删除了分层推理来测试结构和语义分析,而LAMD-F保留了推理但省略了事实一致性验证来评估幻觉控制。

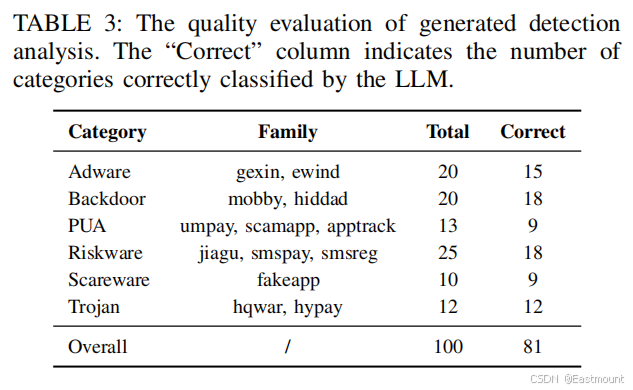

针对具有代表性的Drebin、DeepDrebin和Malcan对LAMD进行评估对生成的检测分析进行质量评价,如下表所示。

在表3中,Category表示恶意软件类别,Family表示该类别下的具体恶意软件家族,Total表示该类别下的样本总数,Correct表示LLM正确分类的样本数。

- 恶意软件检测性能:LAMD-R的性能下降突出了分层代码汇总的必要性,而LAMD-F的轻微下降突出了幻觉缓解的作用。通过改进输入代码和提取关键信息,LAMD将幻觉风险降至最低,确保更可靠的恶意软件检测。

- 解释的有效性:为了评估分析质量,我们验证了100个正确检测到的恶意软件样本,结果表明,在100个样本中,有81个样本被正确分类。

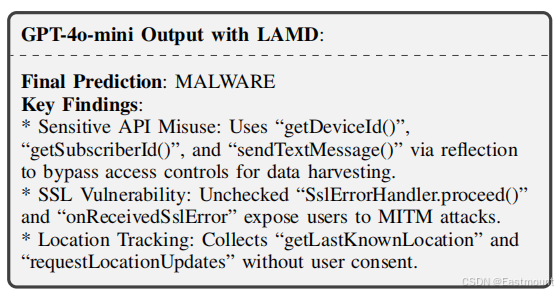

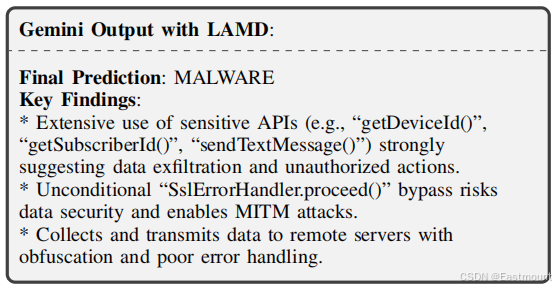

3.案例分析

第 5 部分通过两个具有代表性的真实案例,系统展示了 LAMD 在克服现有大语言模型直接用于 Android 恶意软件检测时所面临关键局限方面的有效性。案例分析围绕 上下文窗口限制 与 恶意行为意图误判 两类典型失败模式展开。

在第一个案例中,作者选取了一个包含大规模支撑代码的 Android 应用样本。即便仅保留关键源码目录,反编译后代码规模仍远超当前主流大模型的上下文处理能力,导致具备超长上下文窗口的模型在直接分析时仍无法完成推理。相比之下,LAMD 通过关键上下文抽取与程序切片,有效压缩分析输入,使得在显著更低上下文容量约束下的模型仍能够完成准确判别,从而验证了该框架在处理大规模复杂应用时的实用性。

第二个案例聚焦于恶意行为意图被良性代码掩盖的情形。针对一个典型的 SMSReg 恶意软件样本,直接使用大模型分析时,由于大量第三方库和良性功能代码的干扰,模型错误地将样本判定为良性应用。LAMD 通过隔离与安全敏感 API 相关的关键程序结构,并结合分层代码推理机制,使模型能够识别出设备信息窃取、未授权短信发送、反射规避机制以及不安全 SSL 处理等核心恶意行为,从而实现对该样本的正确判定与行为解释。

总体而言,该案例研究表明,LAMD 通过上下文驱动的结构化分析与分层推理,有效缓解了大语言模型在 Android 恶意软件检测中因代码规模庞大和结构复杂所导致的分析失败问题,同时显著提升了对真实恶意行为意图的捕获能力。

五.结论

大语言模型卓越的零样本推理能力为 Android 恶意软件检测在真实应用场景中应对分布漂移、数据集偏差以及可解释性不足等问题提供了一种具有前景的解决途径。然而,其在实际应用中仍受制于 Android 应用中大量支撑性代码以及复杂程序结构所带来的分析挑战。为应对上述问题,本文提出了 LAMD,这是一种首个实现大语言模型可解释 Android 恶意软件检测的实用框架。真实场景下的评估结果表明,LAMD 通过对复杂程序结构与语义信息的有效分析,在检测性能上优于传统检测方法。该研究进一步释放了大语言模型在 Android 安全领域中的应用潜力,为面向未来的 AI 驱动恶意软件分析奠定了基础。

Thinking myself:

- 这篇论文试图解决什么样的问题:Android应用程序中广泛的支持代码,往往跨越数千个类,超出了LLMS的上下文限制,Android应用程序的结构复杂性和相关性超过了LLMS的基于序列的推理、碎片化的代码分析和阻止恶意意图推理。由此为应对挑战提出LAMD,一个实用的上下文驱动的框架来实现基于LLM的Android恶意软件检测。

- 提出了什么样的方法和创新点:LAMD结合关键上下文提取来隔离安全关键代码区域并构建程序结构,然后应用分层代码推理从低级指令到高级语义逐步分析应用程序行为,提供最终预测和解释。

- 论文的方法取得了什么样的效果:提出的LAMD是第一个使LLMS能够进行可解释的Android恶意软件检测的实用框架,通过有效分析复杂的结构和语义而优于传统的检测器。LAMD释放了LLMS在Android安全方面的潜力。

2024年4月28日是Eastmount的安全星球------『网络攻防和AI安全之家』正式创建和运营的日子,该星球目前主营业务为 安全零基础答疑、安全技术分享、AI安全技术分享、AI安全论文交流、威胁情报每日推送、网络攻防技术总结、系统安全技术实战、面试求职、安全考研考博、简历修改及润色、学术交流及答疑、人脉触达、认知提升等。下面是星球的新人券,欢迎新老博友和朋友加入,一起分享更多安全知识,比较良心的星球,非常适合初学者和换安全专业的读者学习。

目前收到了很多博友、朋友和老师的支持和点赞,尤其是一些看了我文章多年的老粉,购买来感谢,真的很感动,类目。未来,我将分享更多高质量文章,更多安全干货,真心帮助到大家。虽然起步晚,但贵在坚持,像十多年如一日的博客分享那样,脚踏实地,只争朝夕。继续加油,再次感谢!

(By:Eastmount 2025-12-30 周二夜于贵阳 http://blog.csdn.net/eastmount/ )

前文赏析:

- [论文阅读] (01)拿什么来拯救我的拖延症?初学者如何提升编程兴趣及LATEX入门详解

- [论文阅读] (02)SP2019-Neural Cleanse: Identifying and Mitigating Backdoor Attacks in DNN

- [论文阅读] (03)清华张超老师 - GreyOne: Discover Vulnerabilities with Data Flow Sensitive Fuzzing

- [论文阅读] (04)人工智能真的安全吗?浙大团队外滩大会分享AI对抗样本技术

- [论文阅读] (05)NLP知识总结及NLP论文撰写之道------Pvop老师

- [论文阅读] (06)万字详解什么是生成对抗网络GAN?经典论文及案例普及

- [论文阅读] (07)RAID2020 Cyber Threat Intelligence Modeling Based on Heterogeneous GCN

- [论文阅读] (08)NDSS2020 UNICORN: Runtime Provenance-Based Detector for Advanced Persistent Threats

- [论文阅读] (09)S&P2019 HOLMES Real-time APT Detection through Correlation of Suspicious Information Flow

- [论文阅读] (10)基于溯源图的APT攻击检测安全顶会总结

- [论文阅读] (11)ACE算法和暗通道先验图像去雾算法(Rizzi | 何恺明老师)

- [论文阅读] (12)英文论文引言introduction如何撰写及精句摘抄------以入侵检测系统(IDS)为例

- [论文阅读] (13)英文论文模型设计(Model Design)如何撰写及精句摘抄------以入侵检测系统(IDS)为例

- [论文阅读] (14)英文论文实验评估(Evaluation)如何撰写及精句摘抄(上)------以入侵检测系统(IDS)为例

- [论文阅读] (15)英文SCI论文审稿意见及应对策略学习笔记总结

- [论文阅读] (16)Powershell恶意代码检测论文总结及抽象语法树(AST)提取

- [论文阅读] (17)CCS2019 针对PowerShell脚本的轻量级去混淆和语义感知攻击检测

- [论文阅读] (18)英文论文Model Design和Overview如何撰写及精句摘抄------以系统AI安全顶会为例

- [论文阅读] (19)英文论文Evaluation(实验数据集、指标和环境)如何描述及精句摘抄------以系统AI安全顶会为例

- [论文阅读] (20)USENIXSec21 DeepReflect:通过二进制重构发现恶意功能(恶意代码ROI分析经典)

- [论文阅读] (21)S&P21 Survivalism: Systematic Analysis of Windows Malware Living-Off-The-Land (经典离地攻击)

- [论文阅读] (22)图神经网络及认知推理总结和普及-清华唐杰老师

- [论文阅读] (23)恶意代码作者溯源(去匿名化)经典论文阅读:二进制和源代码对比

- [论文阅读] (24)向量表征:从Word2vec和Doc2vec到Deepwalk和Graph2vec,再到Asm2vec和Log2vec(一)

- [论文阅读] (25)向量表征经典之DeepWalk:从Word2vec到DeepWalk,再到Asm2vec和Log2vec(二)

- [论文阅读] (26)基于Excel可视化分析的论文实验图表绘制总结------以电影市场为例

- [论文阅读] (27)AAAI20 Order Matters: 二进制代码相似性检测(腾讯科恩实验室)

- [论文阅读] (28)李沐老师视频学习------1.研究的艺术·跟读者建立联系

- [论文阅读] (29)李沐老师视频学习------2.研究的艺术·明白问题的重要性

- [论文阅读] (30)李沐老师视频学习------3.研究的艺术·讲好故事和论点

- [论文阅读] (31)李沐老师视频学习------4.研究的艺术·理由、论据和担保

- [论文阅读] (32)南洋理工大学刘杨教授------网络空间安全和AIGC整合之道学习笔记及强推(InForSec)

- [论文阅读] (33)NDSS2024 Summer系统安全和恶意代码分析方向相关论文汇总

- [论文阅读] (34)EWAS2024 基于SGDC的轻量级入侵检测系统

- [论文阅读] (35)TIFS24 MEGR-APT:基于攻击表示学习的高效内存APT猎杀系统

- [论文阅读] (36)C&S22 MPSAutodetect:基于自编码器的恶意Powershell脚本检测模型

- [论文阅读] (37)CCS21 DeepAID:基于深度学习的异常检测(解释)

- [论文阅读] (38)基于大模型的威胁情报分析与知识图谱构建论文总结(读书笔记)

- [论文阅读] (39)EuroS&P25 CTINEXUS:基于大模型的威胁情报知识图谱自动构建

- [论文阅读] (40)CCS24 PowerPeeler:一种通用的PowerShell脚本动态去混淆方法

- [论文阅读] (41)JISA24 物联网环境下基于少样本学习的攻击流量分类

- [论文阅读] (42)ASC25 基于大语言模型的未知Web攻击威胁检测

- [论文阅读] (43)ESWA25 评估大模型在真实攻击活动的恶意代码解混淆能力

- [论文阅读] (44)一种基于LLM少样本多标签的Android恶意软件检测方法

- [论文阅读] (45)C&S24 AISL: 基于攻击意图驱动与序列学习方法的APT攻击检测

- [论文阅读] (46)IDS-Agent: 一种用于物联网可解释入侵检测的大模型Agent

-

论文阅读\] (47)LAMD: 基于大模型上下文驱动的Android恶意软件检测与分类