目录

[1. 引言:从数据爆炸到维度诅咒](#1. 引言:从数据爆炸到维度诅咒)

[2. 高维数据的困境:维数灾难的深层理解](#2. 高维数据的困境:维数灾难的深层理解)

[2.1 维数灾难的数学根源](#2.1 维数灾难的数学根源)

[2.2 降维作为解决方案的必要性](#2.2 降维作为解决方案的必要性)

[3. PCA的数学原理:从线性代数到统计学](#3. PCA的数学原理:从线性代数到统计学)

[3.1 协方差矩阵和数据的内部结构](#3.1 协方差矩阵和数据的内部结构)

[3.2 特征值分解和主成分的发现](#3.2 特征值分解和主成分的发现)

[3.3 方差解释率和维度选择](#3.3 方差解释率和维度选择)

[3.4 最大方差和最小重构误差的等价性](#3.4 最大方差和最小重构误差的等价性)

[4. PCA的几何解释:旋转坐标系统](#4. PCA的几何解释:旋转坐标系统)

[4.1 坐标系旋转和特征向量的含义](#4.1 坐标系旋转和特征向量的含义)

[4.2 投影和数据的低秩近似](#4.2 投影和数据的低秩近似)

[4.3 特征向量的正交性和方差的独立性](#4.3 特征向量的正交性和方差的独立性)

[5. PCA的应用场景:从数据可视化到特征工程](#5. PCA的应用场景:从数据可视化到特征工程)

[5.1 二维和三维可视化:让高维数据变得可见](#5.1 二维和三维可视化:让高维数据变得可见)

[5.2 噪声消除:通过低秩近似去除噪声](#5.2 噪声消除:通过低秩近似去除噪声)

[5.3 特征工程:创建更有信息量的特征](#5.3 特征工程:创建更有信息量的特征)

[5.4 数据预处理:标准化和中心化的重要性](#5.4 数据预处理:标准化和中心化的重要性)

[6. Scikit-learn实践:从理论到代码](#6. Scikit-learn实践:从理论到代码)

[6.1 基础PCA实现和数据可视化](#6.1 基础PCA实现和数据可视化)

[6.2 噪声消除的实际应用](#6.2 噪声消除的实际应用)

[6.3 高维数据的降维和聚类](#6.3 高维数据的降维和聚类)

[7. PCA在机器学习中的应用:提高模型效率和简化模型](#7. PCA在机器学习中的应用:提高模型效率和简化模型)

[7.1 PCA作为特征预处理的益处](#7.1 PCA作为特征预处理的益处)

[7.2 PCA与正则化的关联](#7.2 PCA与正则化的关联)

[7.3 PCA在深度学习中的应用](#7.3 PCA在深度学习中的应用)

[7.4 PCA与其他降维技术的对比](#7.4 PCA与其他降维技术的对比)

[8. PCA的局限性、变体与改进方向](#8. PCA的局限性、变体与改进方向)

[8.1 PCA的基本局限性](#8.1 PCA的基本局限性)

[8.2 PCA的重要变体](#8.2 PCA的重要变体)

[8.3 缺失值处理](#8.3 缺失值处理)

[9. 完整的实战案例:从数据到模型](#9. 完整的实战案例:从数据到模型)

[10. 总结和展望:PCA的过去、现在和未来](#10. 总结和展望:PCA的过去、现在和未来)

[10.1 PCA的历史地位和持久价值](#10.1 PCA的历史地位和持久价值)

[10.2 PCA的实践应用现状](#10.2 PCA的实践应用现状)

[10.3 PCA的局限性和未来方向](#10.3 PCA的局限性和未来方向)

[10.4 PCA与现代机器学习的融合](#10.4 PCA与现代机器学习的融合)

[10.5 PCA在教育和实践中的意义](#10.5 PCA在教育和实践中的意义)

1. 引言:从数据爆炸到维度诅咒

在当今的大数据时代,我们每天面对的数据维度正在呈现指数级增长。从医学影像的数百万像素到基因测序的数千个基因标记,从社交媒体的海量用户特征到电商平台的商品属性矩阵,高维数据已经成为了现代数据科学的常态。然而,正当我们为这些丰富的数据特征而欢欣鼓舞的时候,一个令人困扰的现象悄然出现了------当数据的维度超过一定阈值后,我们的机器学习模型不仅没有变得更聪明,反而开始"变笨"。这就是所谓的维数灾难(Curse of Dimensionality),它如同一把隐形的达摩克利斯之剑,悬挂在每一个从事高维数据分析的研究者和工程师的头顶。

维数灾难的表现形式多种多样:计算复杂度随维度指数增长,导致算法运行时间长得令人绝望;模型的参数数量与维度呈正相关,有限的训练样本变得相对稀疏,模型过拟合的风险急剧上升;数据在高维空间中的分布变得极其稀疏,使得距离度量和相似性计算失效。面对这样的困境,数据科学家们开发出了一系列降维技术,其中最经典、最广泛应用、也最容易理解的就是主成分分析(Principal Component Analysis,PCA)。PCA就像是一把精妙的剃须刀,能够在去除冗余信息的同时,保留数据中最重要的特征。它通过数学的优雅性,将高维空间中的数据投影到低维空间,使得数据的复杂性大幅下降,而信息损失却微乎其微。

主成分分析不仅仅是一种降维技术,它更是一种数据理解的哲学。当我们对一个高维数据集应用PCA时,我们实际上在回答这样的问题:在这个复杂的数据中,到底哪些方向携带了最多的信息?哪些维度之间存在着强烈的相关性可以被合并?如何用尽可能少的维度来重建原始数据的主要结构?这些问题的答案不仅能够帮助我们的模型跑得更快,还能让我们更深刻地理解数据的内在结构。在这篇长文中,我们将从多个角度深入探讨PCA的原理、实现和应用,包括其数学基础、几何直观、实践工程,以及它在现代机器学习中如何扮演关键角色。

2. 高维数据的困境:维数灾难的深层理解

2.1 维数灾难的数学根源

在开始讨论PCA之前,我们需要深刻理解为什么高维数据会成为机器学习的瓶颈。维数灾难不是一个单一的现象,而是在高维空间中出现的多个相关问题的总称。首先,从体积的角度考虑,高维空间的"体积"增长速度是惊人的。假设我们有一个边长为1的单位立方体,在一维中它的长度是1,在二维中它的面积是1,但是在100维空间中,这个立方体的"体积"仍然是1。然而,如果我们在这个立方体中内接一个球体,在一维中球的长度是2,在二维中球的面积是π,但在100维空间中,这个内接球体的"体积"相对于立方体的"体积"变得极其微小,趋近于0。这意味着在高维空间中,大部分的体积都集中在立方体的"角落"中,而球体只能占据中心的一小部分。这个反直觉的现象告诉我们,在高维空间中,数据点往往非常分散,彼此之间的距离几乎没有什么区别。

这个问题的直接后果是距离度量的失效。在机器学习中,我们经常依赖距离度量来计算相似性,比如在k-近邻算法中,我们通过计算测试样本与训练样本之间的距离来进行分类。然而,在高维空间中,由于数据的稀疏性,任意两个数据点之间的距离都变得差不多,这使得距离度量的信息量大幅下降。例如,在随机生成的高维数据中,最大距离和最小距离的比值随着维度的增加而趋近于1,这意味着距离不再能有效地区分数据点了。这种现象在处理文本数据、图像数据等高维稀疏数据时尤为明显。

其次是参数维度的爆炸。许多机器学习模型,特别是参数化模型,其参数数量与数据维度呈正相关。以线性回归为例,当我们需要从n个特征中学习系数时,我们需要估计n个参数加上一个截距项。当n达到数万甚至数百万时,这就意味着我们的模型有数万甚至数百万个参数需要从有限的训练样本中学习。根据统计学原理,当参数数量与样本数量的比值过大时,模型就容易过拟合。具体来说,假设我们有1000个样本,1000个特征,那么特征数与样本数的比例是1:1,模型将有极高的风险在训练数据上过度拟合,而在测试数据上表现糟糕。即使我们有足够多的样本,特征的增加仍然会显著增加计算复杂度和内存消耗,使得模型训练变得不切实际。

再次是冗余信息的积累。在现实世界中,高维数据集中的特征往往存在着强烈的相关性。这意味着不同的特征实际上在重复地编码相同或相似的信息。例如,在房价预测问题中,房间数、房屋面积、卧室数等特征之间存在高度的相关性,因为更多的房间通常意味着更大的面积。这些相关的特征只是从不同的角度描述同一个潜在的属性,引入它们不仅浪费了模型的参数容量,还增加了噪声和过拟合的风险。

最后,高维空间中的样本稀疏性导致了数据分布估计的困难。当维度增加时,要使样本在空间中具有相同的密度,所需的样本数量会以指数的方式增加。这被称为样本复杂度的维度诅咒。在实践中,这意味着即使我们有看起来足够多的样本,在高维空间中这些样本仍然可能显得极其稀疏。稀疏的样本分布使得任何基于密度估计的方法都变得不可靠,也使得许多机器学习算法的基本假设失效。

2.2 降维作为解决方案的必要性

面对这些挑战,降维已经成为了现代数据科学中的必备技术。降维的目标不是简单地减少数据的维度,而是在尽可能少地损失信息的前提下,降低数据的复杂性。这样做的好处是多方面的。首先,降低计算复杂度是最直接的好处。如果我们能够将数据的维度从1000降低到50,计算时间的减少可能远超过20倍,这对于需要在生产环境中实时处理大量数据的应用至关重要。其次,通过降维,我们可以减少模型参数的数量,从而降低过拟合的风险,提高模型的泛化能力。第三,降维往往能够消除数据中的噪声。高维空间中的噪声往往分散在多个维度中,而主要信息则集中在少数几个维度中。通过只保留携带最多信息的维度,我们实际上是在过滤掉噪声。第四,降维使得数据可视化成为可能。人类的眼睛只能有效地处理二维或三维的数据,而原始的高维数据对于直观理解几乎是不可能的。通过PCA,我们可以将高维数据投影到二维或三维,从而观察数据的整体分布和结构。

3. PCA的数学原理:从线性代数到统计学

3.1 协方差矩阵和数据的内部结构

要真正理解PCA,我们首先需要理解协方差矩阵及其包含的信息。协方差矩阵是一个描述多个变量之间关系的矩阵,它的第i行第j列元素表示第i个特征和第j个特征之间的协方差。对于一个包含n个样本和p个特征的数据矩阵X,其协方差矩阵C的定义为:

C = \\frac{1}{n} X\^T X

(假设数据已经被中心化,即每个特征的均值都是0)

这个矩阵包含了关于数据内部结构的重要信息。协方差矩阵的对角线元素是各个特征的方差,非对角线元素是特征之间的协方差。如果两个特征的协方差很大,这意味着它们倾向于一起变化,即存在很强的线性相关性。相反,如果两个特征的协方差接近0,它们就基本上是独立的。协方差矩阵是一个对称矩阵,因此它的特征值都是实数,并且存在一组正交的特征向量。

让我用一个具体的例子来说明这一点。想象我们有一个包含1000个样本的数据集,每个样本有500个特征。我们计算这个数据的协方差矩阵,得到一个500×500的矩阵。这个矩阵的每一个对角线元素告诉我们相应特征的变异性有多大,每一个非对角线元素告诉我们两个特征之间的关联程度有多强。通过分析这个协方差矩阵,我们可以发现数据的内在结构------哪些特征集团往往一起变化,哪些特征提供了独立的信息。

3.2 特征值分解和主成分的发现

PCA的核心思想就是对协方差矩阵进行特征值分解。当我们对协方差矩阵C进行特征值分解时,我们得到一组特征值λ₁,λ₂,...,λₚ和对应的特征向量v₁,v₂,...,vₚ。这些特征值的大小关键地决定了对应特征向量方向上的方差大小。具体来说,λᵢ就是数据在特征向量vᵢ方向上的方差。假设我们已经将特征值按从大到小的顺序排列,那么第一个特征向量v₁(称为第一主成分)指向数据方差最大的方向,第二个特征向量v₂(称为第二主成分)指向在第一主成分方向正交的条件下方差第二大的方向,以此类推。

这就是PCA的优雅之处:它通过线性代数的方法,自动发现了数据中最重要的几个方向。这些方向不是任意选择的,而是根据数据的统计特性------方差------科学地确定的。方差为什么重要呢?因为在统计学中,方差代表了信息量。高方差意味着特征在整个样本集上有很大的变异,这个变异本身就是信息。相反,如果一个特征的方差很小,几乎所有样本在这个特征上的值都差不多,那么这个特征就没有提供太多的区分信息。

让我们用一个更具体的例子。假设我们有一个二维的数据集,100个点分别从两个高斯分布中随机生成,但这两个高斯的中心距离很远。如果我们计算这个数据的协方差矩阵,我们可能会得到:

C = \\begin{pmatrix} 2.5 \& 2.0 \\ 2.0 \& 2.5 \\end{pmatrix}

对这个矩阵进行特征值分解,我们可能会得到特征值λ₁ = 4.5和λ₂ = 0.5,以及对应的特征向量v₁ = [1/√2, 1/√2]ᵀ和v₂ = [-1/√2, 1/√2]ᵀ。第一个特征值4.5远大于第二个特征值0.5,这意味着数据的大部分方差集中在对角线方向上(v₁指向的方向),而在垂直于对角线的方向上方差很小。如果我们只保留第一个主成分,我们实际上是把所有的点投影到对角线上,这样做会损失一些沿垂直方向的信息,但由于这个方向的方差本来就很小,信息损失是有限的。

3.3 方差解释率和维度选择

在应用PCA时,一个关键的决定是保留多少个主成分。这不是一个有唯一答案的问题,而是取决于具体的应用和对精度的要求。方差解释率(Explained Variance Ratio)就是用来帮助做出这个决定的指标。第k个主成分的方差解释率定义为:

r_k = \\frac{\\lambda_k}{\\sum_{i=1}\^{p} \\lambda_i}

其中λₖ是第k个特征值,分母是所有特征值的总和。这个比值告诉我们,第k个主成分的方差占总方差的多少百分比。累积方差解释率(Cumulative Explained Variance Ratio)定义为:

R_k = \\sum_{i=1}\^{k} r_i

这个指标告诉我们,前k个主成分的方差占总方差的多少百分比。在实践中,我们通常会选择使得累积方差解释率达到某个阈值(比如95%或99%)的维度。这样做既能保留足够的信息,又能实现显著的降维。

例如,假设一个数据集有100个特征,我们计算出它们的特征值分别为:50, 30, 10, 5, 3, 2, 1, ...(其他都很小)。那么前三个特征值的方差解释率分别为50%, 30%, 10%,累积方差解释率为90%。如果我们要求累积方差解释率至少为95%,我们需要保留前四个主成分,这样我们就从100个维度降低到了4个维度,实现了25倍的降维,同时保留了95%的原始信息。在许多应用中,这样的折中是非常合理的。

3.4 最大方差和最小重构误差的等价性

PCA还有另一种等价的理解方式,就是从最小化重构误差的角度。当我们使用k个主成分来表示原始数据时,我们实际上是在找一个k维的子空间,使得把所有数据点投影到这个子空间上的总重构误差最小。重构误差可以用平方误差来定义,对于一个数据点xᵢ,其重构误差是原始点和其投影点之间距离的平方。所有点的总重构误差是:

\\text{MSE} = \\frac{1}{n} \\sum_{i=1}\^{n} \|x_i - \\hat{x}_i\|\^2

其中x̂ᵢ是xᵢ在低维子空间上的投影。可以证明,最小化这个重构误差等价于最大化投影数据的方差。换句话说,选择方差最大的方向就是在选择使得投影后信息损失最小的方向。这是PCA的两个不同但等价的视角,它们都导向同样的解。

4. PCA的几何解释:旋转坐标系统

4.1 坐标系旋转和特征向量的含义

如果我们从几何的角度来看PCA,它就是一个坐标系的旋转过程。原始的数据是在原始坐标系中表示的,每个坐标轴代表一个特征。PCA找到的特征向量就是新坐标系的轴。当我们说第一主成分是方差最大的方向时,从几何上讲,就是说新坐标系的第一条轴被旋转到了原始数据散布最广的方向。第二主成分是在第一主成分正交的条件下方差第二大的方向,这意味着新坐标系的第二条轴被旋转到了垂直于第一轴、数据散布第二广的方向。以此类推。

这个旋转有什么用呢?在新的坐标系中,各个坐标轴之间变成了正交的(这在数学上叫做非相关的),这意味着在新坐标系中,各个特征之间不再有线性相关性。这是一个非常重要的性质,因为在原始的坐标系中,许多特征之间可能有很强的相关性,这种相关性是冗余的。通过旋转到新的坐标系,我们消除了这种冗余。此外,在新坐标系中,最重要的特征聚集在最前面几个坐标轴上,而噪声和不重要的特征散布在后面的坐标轴上。这样,我们就可以简单地丢弃后面的坐标轴,而基本上不损失重要信息。

为了更直观地理解这一点,让我们考虑一个具体的例子。假设我们有一个二维的数据集,包含100个样本,两个特征分别代表学生的身高和体重。这两个特征往往是相关的,因为更高的学生倾向于更重。在原始的坐标系中,如果我们沿着身高轴看,数据的分布范围很大;沿着体重轴看,数据的分布范围也很大;而且这两个方向之间有明显的相关性。但是,如果我们找到PCA的两个主成分,可能会发现:第一个主成分大致指向从"矮轻"到"高重"的对角线方向,这个方向上数据的分布范围很大;第二个主成分指向从"矮重"到"高轻"的方向(与第一主成分正交),这个方向上数据的分布范围很小。

这个例子说明,通过坐标旋转,PCA找到了数据的"主要变异方向"和"次要变异方向"。如果我们只关心人类之间身高体重的主要差异,我们可以只用第一个主成分来表示,这就是"一维瘦身"。当然,我们会损失一些沿着第二个主成分方向的信息,但由于这个方向上的方差本来就小,损失是有限的。

4.2 投影和数据的低秩近似

在几何上,PCA将原始的n维数据投影到一个k维的子空间中(k < n)。这个投影过程可以这样理解:我们有一个k维的平面(由前k个主成分张成),我们把每个原始的n维数据点垂直投影到这个平面上,得到它在平面上的投影点。这个投影点就是该数据点在低维空间中的表示。数学上,如果我们用矩阵V_k表示前k个主成分组成的矩阵(大小为n×k),那么原始数据矩阵X在低维空间中的投影是:

Y = X V_k

这个Y矩阵的大小是m×k,其中m是样本数。每一行都是一个原始样本在新坐标系中的坐标。如果我们想从这个低维表示重构原始数据,我们可以计算:

\\hat{X} = Y V_k\^T = X V_k V_k\^T

由于V_k的列是正交的,V_k V_k^T是一个投影矩阵,它把任何向量投影到由V_k的列张成的子空间中。X̂就是X在这个子空间上的投影,它是原始数据的一个低秩近似。

这个低秩近似有一个重要的含义:我们用一个秩为k的矩阵X̂来近似一个秩为n的矩阵X。这个近似的误差就是我们之前讨论的重构误差。当k足够大时,这个近似会很接近原始数据;当k很小时,虽然会有一定的信息损失,但在许多应用中仍然足够准确。而且,使用秩为k的矩阵比秩为n的矩阵在存储和计算上都要高效得多。

4.3 特征向量的正交性和方差的独立性

特征向量的正交性是PCA的一个关键性质。由于协方差矩阵是对称的,它的特征向量构成了一个正交基。这意味着不同的主成分之间是正交的,在统计上是非相关的。这个性质有深远的意义。在原始的坐标系中,不同特征之间可能有复杂的相关性,这使得难以独立地理解每个特征的贡献。但是在PCA的坐标系中,由于主成分之间是非相关的,我们可以独立地看待每个主成分对总方差的贡献。

具体来说,如果我们计算数据在新坐标系中的协方差矩阵,我们会得到一个对角矩阵,对角线上的元素就是各个主成分对应的特征值。这意味着不同主成分之间的协方差都是0,即它们完全不相关。这种非相关性在许多应用中都非常有用。例如,在统计建模中,我们通常假设特征之间是独立的,这样的假设在原始特征上可能不成立,但在PCA变换后的特征上就自动满足了。在许多情况下,这使得后续的统计分析变得更加简单和有效。

5. PCA的应用场景:从数据可视化到特征工程

5.1 二维和三维可视化:让高维数据变得可见

PCA最直观和最常见的应用就是数据可视化。人类的视觉系统最多只能有效地理解三维的数据,对于更高维的数据,我们需要借助某种投影或映射方法来将其压缩到二维或三维。PCA提供了一个自然且有理论基础的方式来做到这一点。当我们使用前两个主成分时,我们就得到了一个二维的散点图;使用前三个主成分时,我们得到了一个三维的散点图。这样的可视化往往能够揭示原始数据中存在的一些重要的模式和结构,比如聚类、离群点、或者不同类别之间的分离程度。

举例来说,考虑一个手写数字识别的数据集,比如著名的MNIST数据集。每个样本是一个28×28的灰度图像,可以被视为一个784维的向量。784维的数据对于直观理解几乎是不可能的。但是,如果我们对这个数据集应用PCA,计算前两个主成分,然后把所有的数字在这个二维平面上绘制出来,我们往往会看到一个非常有趣的现象:同一个数字(比如所有的"3")的样本往往聚集在一起,不同的数字往往被分离到不同的区域。这个可视化不仅告诉我们数据的结构,还验证了PCA确实找到了数据的本质特征。

5.2 噪声消除:通过低秩近似去除噪声

另一个重要的应用场景是噪声消除。在许多实际的数据采集过程中,测得的数据都被污染了噪声。这个噪声可能来自于测量设备的误差、环境干扰或者其他随机因素。如果噪声是高斯白噪声(即在所有维度上独立同分布),那么噪声在高维空间中表现为在所有方向上大致相等的能量分布。相反,数据的真实信息往往集中在少数几个方向上,即少数几个主成分。因此,如果我们只保留前k个主成分,那么我们实际上是在保留数据信息,而丢弃噪声。

更准确地说,如果原始的观测数据是Z = X + N,其中X是干净的数据,N是噪声,那么Z的协方差矩阵是C_Z = C_X + C_N。当我们对Z进行PCA时,前k个主成分的方向会倾向于X的主成分的方向(如果X的方差远大于N的方差的话),而丢弃的高频维度会包含大部分的噪声。通过只用前k个主成分来重构数据,我们得到的X̂是一个去噪后的版本,它通常比原始的Z更接近真实的X。

这个方法在图像处理中特别有用。一张有噪声的照片可以被视为一个高维向量(像素值)。虽然在原始空间中很难区分噪声和信号,但如果我们知道真实的图像通常具有一定的结构(比如局部平滑性),那么我们可以使用类似于PCA的方法来去除噪声。实际上,许多现代的图像去噪方法都是基于这个基本思想的。

5.3 特征工程:创建更有信息量的特征

在机器学习的工作流中,特征工程是一个至关重要的步骤。好的特征能够显著提高模型的性能,而坏的特征则会浪费模型的容量并增加过拟合的风险。PCA可以被看作是一种自动的特征工程方法。当我们对原始特征应用PCA时,我们得到的主成分就是新的特征。这些新特征有几个优势:首先,它们是通过统计方法自动创建的,基于数据本身的内在结构,而不是基于主观的假设;其次,它们是相互正交的,即相互独立的,这简化了后续模型的学习;第三,它们按照重要性降序排列,最重要的特征在前面,这使得可以方便地进行特征选择。

在实际应用中,使用PCA创建的特征往往能够显著简化后续的建模过程。例如,在某些情况下,原始的特征空间可能包含许多高度相关的特征(这在金融数据、文本数据等中很常见),直接使用这些特征进行建模会导致多重共线性问题(特别是在线性模型中)。但是通过PCA,我们可以消除这种多重共线性,得到一组相互独立的特征,这使得线性模型可以更加稳定和有效。

5.4 数据预处理:标准化和中心化的重要性

在应用PCA之前,有几个重要的预处理步骤需要执行。首先,数据需要被中心化,即每个特征的均值需要被减去。这是因为PCA寻找的是方差最大的方向,而方差的定义是基于中心化数据的。如果数据没有被中心化,PCA会错误地把数据的均值方向当作主要方向。其次,数据通常需要被标准化,即每个特征需要被除以其标准差。这是因为如果特征的量纲不同(比如一个特征的范围是0-1,另一个特征的范围是0-1000),那么范围大的特征会主导PCA的结果,而范围小的特征的贡献会被忽视。标准化确保了所有特征都对PCA有相等的影响力。

标准化和中心化看似简单,但在实践中这两步却经常被忽视或处理不当,导致PCA的结果被曲解。例如,在某个项目中,研究人员应用PCA来分析一个包含多个经济指标的数据集。其中一个指标是国家的GDP,范围从几十亿美元到数万亿美元,而另一些指标的范围只是0-100。结果,PCA的第一主成分几乎完全由GDP主导,其他指标的贡献几乎可以忽视。只有当数据被适当地标准化后,才能得到更加平衡和有意义的主成分。

6. Scikit-learn实践:从理论到代码

6.1 基础PCA实现和数据可视化

现在让我们深入到实践中,使用Python的scikit-learn库来实现PCA。Scikit-learn提供了一个非常方便的PCA类,使得我们可以用几行代码就实现PCA的所有功能。让我创建一个完整的、可运行的代码示例,展示如何在一个真实的数据集上应用PCA进行可视化:

import numpy as np

import matplotlib.pyplot as plt

from sklearn.datasets import load_iris

from sklearn.preprocessing import StandardScaler

from sklearn.decomposition import PCA

import pandas as pd

import seaborn as sns

from mpl_toolkits.mplot3d import Axes3D

import matplotlib

import warnings

warnings.filterwarnings('ignore')

# 修复中文字体配置

plt.rcParams['font.sans-serif'] = ['SimHei', 'Microsoft YaHei', 'SimSun']

plt.rcParams['axes.unicode_minus'] = False

# 禁用monospace字体的中文警告

matplotlib.rcParams['font.monospace'] = ['DejaVu Sans Mono']

# 加载鸢尾花数据集

iris = load_iris()

X = iris.data

y = iris.target

target_names = iris.target_names

# 数据标准化

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

# 应用PCA保留所有成分

pca_full = PCA()

pca_full.fit(X_scaled)

# 计算累积方差解释率

cumulative_variance = np.cumsum(pca_full.explained_variance_ratio_)

# 创建图表

fig = plt.figure(figsize=(18, 10))

gs = fig.add_gridspec(2, 3, hspace=0.35, wspace=0.3,

left=0.05, right=0.98, top=0.96, bottom=0.08)

# 1. 方差解释率

ax1 = fig.add_subplot(gs[0, 0])

x_pos = range(1, len(pca_full.explained_variance_ratio_) + 1)

bars = ax1.bar(x_pos, pca_full.explained_variance_ratio_,

alpha=0.6, color='steelblue', width=0.5)

ax1_twin = ax1.twinx()

ax1_twin.plot(x_pos, cumulative_variance, 'o-', color='red',

linewidth=2, markersize=8, label='累积方差')

ax1.set_xlabel('主成分', fontsize=10, fontweight='bold')

ax1.set_ylabel('方差解释率', fontsize=10, color='steelblue', fontweight='bold')

ax1_twin.set_ylabel('累积方差', fontsize=10, color='red', fontweight='bold')

ax1.set_title('方差解释率分析', fontsize=11, fontweight='bold', pad=10)

ax1.grid(True, alpha=0.3, linestyle='--')

ax1.tick_params(labelsize=9)

# 2. 二维PCA

pca_2d = PCA(n_components=2)

X_pca_2d = pca_2d.fit_transform(X_scaled)

ax2 = fig.add_subplot(gs[0, 1])

colors = ['#FF6B6B', '#4ECDC4', '#45B7D1']

for i, target in enumerate(np.unique(y)):

indices = y == target

ax2.scatter(X_pca_2d[indices, 0], X_pca_2d[indices, 1],

c=colors[i], label=target_names[target], alpha=0.75, s=100,

edgecolors='black', linewidth=0.8)

ax2.set_xlabel(f'PC1 ({pca_2d.explained_variance_ratio_[0]:.1%})', fontsize=10, fontweight='bold')

ax2.set_ylabel(f'PC2 ({pca_2d.explained_variance_ratio_[1]:.1%})', fontsize=10, fontweight='bold')

ax2.set_title('二维PCA投影', fontsize=11, fontweight='bold', pad=10)

ax2.legend(fontsize=9, loc='best', framealpha=0.9)

ax2.grid(True, alpha=0.3, linestyle='--')

ax2.tick_params(labelsize=9)

# 3. 三维PCA

pca_3d = PCA(n_components=3)

X_pca_3d = pca_3d.fit_transform(X_scaled)

ax3 = fig.add_subplot(gs[0, 2], projection='3d')

for i, target in enumerate(np.unique(y)):

indices = y == target

ax3.scatter(X_pca_3d[indices, 0], X_pca_3d[indices, 1], X_pca_3d[indices, 2],

c=colors[i], label=target_names[target], alpha=0.75, s=80,

edgecolors='black', linewidth=0.6)

ax3.set_xlabel('PC1', fontsize=9, fontweight='bold')

ax3.set_ylabel('PC2', fontsize=9, fontweight='bold')

ax3.set_zlabel('PC3', fontsize=9, fontweight='bold')

ax3.set_title('三维PCA投影', fontsize=11, fontweight='bold', pad=10)

ax3.legend(fontsize=8, loc='upper right')

ax3.view_init(elev=20, azim=45)

ax3.tick_params(labelsize=8)

# 4. Loading plot

ax4 = fig.add_subplot(gs[1, 0])

loadings = pca_2d.components_.T * np.sqrt(pca_2d.explained_variance_)

scale_factor = 2.8

for i in range(len(iris.feature_names)):

ax4.arrow(0, 0, loadings[i, 0]*scale_factor, loadings[i, 1]*scale_factor,

head_width=0.06, head_length=0.06, fc='darkblue', ec='darkblue',

alpha=0.8, linewidth=2)

offset = 1.35

ax4.text(loadings[i, 0]*scale_factor*offset, loadings[i, 1]*scale_factor*offset,

iris.feature_names[i].replace(' (cm)', ''),

fontsize=8, fontweight='bold', ha='center', va='center',

bbox=dict(boxstyle='round,pad=0.3', facecolor='lightyellow',

alpha=0.8, edgecolor='darkblue', linewidth=1))

ax4.set_xlim(-1.3, 1.3)

ax4.set_ylim(-1.3, 1.3)

ax4.set_xlabel(f'PC1 ({pca_2d.explained_variance_ratio_[0]:.1%})', fontsize=10, fontweight='bold')

ax4.set_ylabel(f'PC2 ({pca_2d.explained_variance_ratio_[1]:.1%})', fontsize=10, fontweight='bold')

ax4.set_title('特征载荷', fontsize=11, fontweight='bold', pad=10)

ax4.grid(True, alpha=0.3, linestyle='--')

ax4.axhline(y=0, color='k', linewidth=0.8)

ax4.axvline(x=0, color='k', linewidth=0.8)

ax4.set_aspect('equal')

ax4.tick_params(labelsize=9)

# 5. 相关系数矩阵

ax5 = fig.add_subplot(gs[1, 1])

correlation_matrix = np.corrcoef(X_scaled.T)

im = ax5.imshow(correlation_matrix, cmap='coolwarm', vmin=-1, vmax=1, aspect='auto')

for i in range(len(iris.feature_names)):

for j in range(len(iris.feature_names)):

text = ax5.text(j, i, f'{correlation_matrix[i, j]:.2f}',

ha="center", va="center", color="black", fontsize=8, fontweight='bold')

ax5.set_xticks(range(len(iris.feature_names)))

ax5.set_yticks(range(len(iris.feature_names)))

ax5.set_xticklabels([name.replace(' (cm)', '') for name in iris.feature_names],

fontsize=8, rotation=45, ha='right')

ax5.set_yticklabels([name.replace(' (cm)', '') for name in iris.feature_names], fontsize=8)

ax5.set_title('相关矩阵', fontsize=11, fontweight='bold', pad=10)

plt.colorbar(im, ax=ax5, label='相关系数', shrink=0.8)

# 6. 统计信息

ax6 = fig.add_subplot(gs[1, 2])

ax6.axis('off')

X_reconstructed = pca_2d.inverse_transform(X_pca_2d)

mse = np.mean((X_scaled - X_reconstructed) ** 2)

info_text = f"""降维效果统计

原始维度: {X.shape[1]}维

降维维度: 2维

削减比例: {(1-2/X.shape[1])*100:.1f}%

方差保留: {cumulative_variance[1]*100:.2f}%

重构误差: {mse:.6f}

样本数: {X.shape[0]}

特征数: {X.shape[1]}"""

ax6.text(0.5, 0.5, info_text,

ha='center', va='center', fontsize=10,

bbox=dict(boxstyle='round,pad=1', facecolor='lightblue',

alpha=0.7, edgecolor='navy', linewidth=2),

transform=ax6.transAxes)

plt.savefig('iris_pca_analysis.png', dpi=300, bbox_inches='tight')

plt.show()

print("=" * 70)

print("鸢尾花数据集PCA分析报告".center(70))

print("=" * 70)

print(f"样本数: {X.shape[0]}, 特征数: {X.shape[1]}")

print(f"\n主成分方差解释率:")

for i in range(min(4, len(pca_full.explained_variance_ratio_))):

print(f" PC{i+1}: {pca_full.explained_variance_ratio_[i]*100:.2f}%")

print(f"\n累积方差解释率:")

print(f" 前2个PC: {cumulative_variance[1]*100:.2f}%")

print(f" 前3个PC: {cumulative_variance[2]*100:.2f}%")

print(f"\n重构误差(MSE): {mse:.6f}")

print("=" * 70)

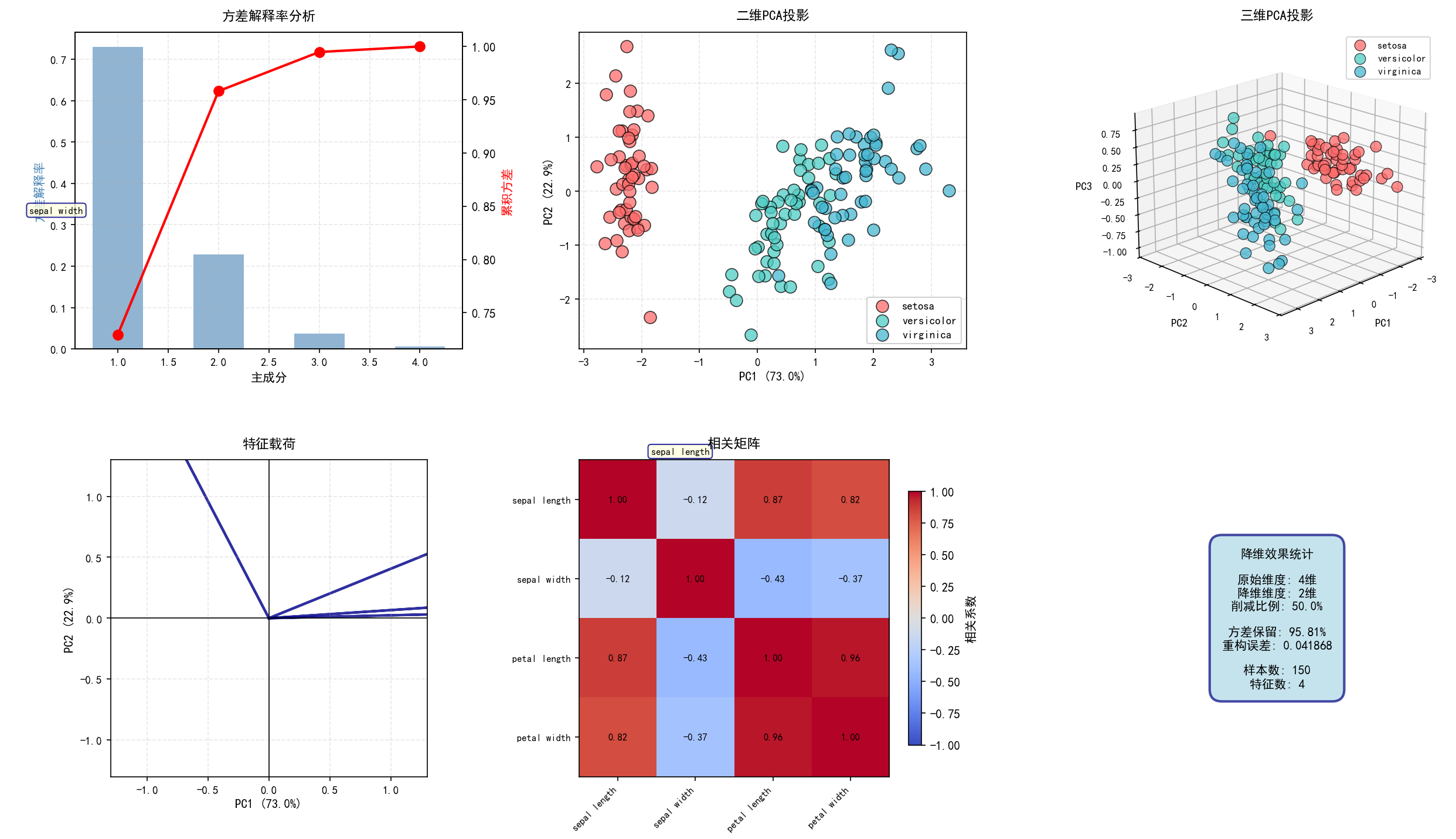

这个代码示例展示了PCA在实际数据分析中的多个方面。首先,我们加载了经典的鸢尾花数据集,这个数据集包含150个样本和4个特征。然后,我们对数据进行了标准化,这是应用PCA前的关键步骤。接着,我们应用了PCA,并生成了多个可视化:方差解释率图表显示了每个主成分解释的方差比例;二维散点图将数据投影到前两个主成分上,清晰地展示了三个鸢尾花种类之间的分离;三维散点图提供了更多的信息;Loading plot展示了原始特征对主成分的贡献;相关系数矩阵显示了原始特征之间的相关性;最后的重构误差指标量化了降维的信息损失。

6.2 噪声消除的实际应用

让我们创建另一个完整的代码示例,演示如何使用PCA来消除图像中的噪声。这个例子更加实际,因为噪声消除在实际应用中非常常见:

import numpy as np

import matplotlib.pyplot as plt

from sklearn.decomposition import PCA

from sklearn.datasets import load_digits

from sklearn.preprocessing import StandardScaler

from sklearn.metrics import mean_squared_error

import cv2

# 设置中文字体支持

plt.rcParams['font.sans-serif'] = ['SimHei', 'DejaVu Sans']

plt.rcParams['axes.unicode_minus'] = False

# ==================== 手写数字去噪 ====================

# 加载手写数字数据集

digits = load_digits()

X = digits.data

y = digits.target

# 标准化数据

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

# 向原始数据添加高斯噪声来模拟真实的噪声环境

np.random.seed(42)

noise_level = 0.3

X_noisy = X_scaled + np.random.normal(0, noise_level, X_scaled.shape)

# 应用PCA进行去噪,使用不同数量的成分

n_components_list = [10, 20, 32, 50, 64]

pca_models = {}

X_denoised_list = {}

for n_comp in n_components_list:

pca = PCA(n_components=n_comp)

X_pca = pca.fit_transform(X_noisy)

X_denoised = pca.inverse_transform(X_pca)

pca_models[n_comp] = pca

X_denoised_list[n_comp] = X_denoised

# 计算不同成分数的去噪效果

mse_original_noisy = mean_squared_error(X_scaled, X_noisy)

mse_results = {}

for n_comp in n_components_list:

mse = mean_squared_error(X_scaled, X_denoised_list[n_comp])

mse_results[n_comp] = mse

print("=" * 80)

print("PCA在手写数字去噪中的应用")

print("=" * 80)

print(f"\n原始数据形状: {X.shape}")

print(f"添加噪声后的均方误差: {mse_original_noisy:.4f}")

print(f"\n不同PCA成分数的去噪效果(均方误差):")

for n_comp in n_components_list:

improvement = (mse_original_noisy - mse_results[n_comp]) / mse_original_noisy * 100

print(f" {n_comp} 个成分: MSE = {mse_results[n_comp]:.4f} (改进 {improvement:.1f}%)")

# 选择最优的成分数(根据解释方差率)

pca_optimal = PCA(n_components=0.95) # 保留95%的方差

pca_optimal.fit(X_noisy)

optimal_n_components = pca_optimal.n_components_

print(f"\n保留95%方差所需的成分数: {optimal_n_components}")

# 应用最优的PCA进行去噪

X_pca_optimal = pca_optimal.fit_transform(X_noisy)

X_denoised_optimal = pca_optimal.inverse_transform(X_pca_optimal)

mse_optimal = mean_squared_error(X_scaled, X_denoised_optimal)

print(f"最优去噪的均方误差: {mse_optimal:.4f}")

# 创建可视化

fig = plt.figure(figsize=(18, 12))

# 1. 显示原始、噪声和去噪图像的对比

sample_indices = [0, 10, 20, 30, 40]

n_samples_show = len(sample_indices)

img_size = 8 # 8x8 图像

for idx, sample_id in enumerate(sample_indices):

# 原始图像

ax1 = plt.subplot(5, 5, idx*5 + 1)

original_img = X_scaled[sample_id].reshape(img_size, img_size)

ax1.imshow(original_img, cmap='gray')

ax1.set_title(f'原始图像\n(数字{y[sample_id]})', fontsize=9)

ax1.axis('off')

# 噪声图像

ax2 = plt.subplot(5, 5, idx*5 + 2)

noisy_img = X_noisy[sample_id].reshape(img_size, img_size)

ax2.imshow(noisy_img, cmap='gray')

ax2.set_title(f'含噪声图像\nMSE={mean_squared_error(X_scaled[sample_id], X_noisy[sample_id]):.3f}', fontsize=9)

ax2.axis('off')

# 使用20个成分去噪

ax3 = plt.subplot(5, 5, idx*5 + 3)

denoised_20_img = X_denoised_list[20][sample_id].reshape(img_size, img_size)

ax3.imshow(denoised_20_img, cmap='gray')

mse_20 = mean_squared_error(X_scaled[sample_id], X_denoised_list[20][sample_id])

ax3.set_title(f'PCA去噪(20个成分)\nMSE={mse_20:.3f}', fontsize=9)

ax3.axis('off')

# 使用32个成分去噪

ax4 = plt.subplot(5, 5, idx*5 + 4)

denoised_32_img = X_denoised_list[32][sample_id].reshape(img_size, img_size)

ax4.imshow(denoised_32_img, cmap='gray')

mse_32 = mean_squared_error(X_scaled[sample_id], X_denoised_list[32][sample_id])

ax4.set_title(f'PCA去噪(32个成分)\nMSE={mse_32:.3f}', fontsize=9)

ax4.axis('off')

# 使用最优数量的成分去噪

ax5 = plt.subplot(5, 5, idx*5 + 5)

denoised_opt_img = X_denoised_optimal[sample_id].reshape(img_size, img_size)

ax5.imshow(denoised_opt_img, cmap='gray')

mse_opt = mean_squared_error(X_scaled[sample_id], X_denoised_optimal[sample_id])

ax5.set_title(f'PCA去噪({optimal_n_components}个成分)\nMSE={mse_opt:.3f}', fontsize=9)

ax5.axis('off')

plt.tight_layout()

plt.savefig('digit_denoising.png', dpi=300, bbox_inches='tight')

plt.show()

# 创建去噪效果曲线图

fig, axes = plt.subplots(1, 2, figsize=(14, 5))

# MSE vs 成分数

ax1 = axes[0]

ax1.plot(n_components_list, [mse_results[n] for n in n_components_list],

'o-', linewidth=2, markersize=10, color='steelblue', label='PCA去噪')

ax1.axhline(y=mse_original_noisy, color='red', linestyle='--', linewidth=2, label='原始噪声')

ax1.axhline(y=mse_optimal, color='green', linestyle='--', linewidth=2, label=f'最优成分(95%方差)')

ax1.set_xlabel('PCA成分数', fontsize=12, fontweight='bold')

ax1.set_ylabel('均方误差(MSE)', fontsize=12, fontweight='bold')

ax1.set_title('PCA成分数对去噪效果的影响', fontsize=13, fontweight='bold')

ax1.legend(fontsize=11)

ax1.grid(True, alpha=0.3)

# 方差解释率vs成分数

ax2 = axes[1]

pca_full = PCA()

pca_full.fit(X_noisy)

cumsum_variance = np.cumsum(pca_full.explained_variance_ratio_)

ax2.plot(range(1, len(cumsum_variance) + 1), cumsum_variance,

'o-', linewidth=2, markersize=6, color='darkgreen')

ax2.axhline(y=0.95, color='red', linestyle='--', linewidth=2, label='95%方差阈值')

ax2.axvline(x=optimal_n_components, color='orange', linestyle='--', linewidth=2,

label=f'最优成分数({optimal_n_components})')

ax2.set_xlabel('成分数', fontsize=12, fontweight='bold')

ax2.set_ylabel('累积方差解释率', fontsize=12, fontweight='bold')

ax2.set_title('累积方差解释率曲线', fontsize=13, fontweight='bold')

ax2.legend(fontsize=11)

ax2.grid(True, alpha=0.3)

ax2.set_xlim(0, 65)

ax2.set_ylim(0, 1.05)

plt.tight_layout()

plt.savefig('denoising_analysis.png', dpi=300, bbox_inches='tight')

plt.show()

# 详细分析:显示主成分的含义

print("\n" + "=" * 80)

print("主成分分析:每个成分代表什么?")

print("=" * 80)

# 获取前几个主成分的可视化

fig, axes = plt.subplots(2, 5, figsize=(15, 6))

axes = axes.flatten()

pca_visualization = PCA(n_components=10)

pca_visualization.fit(X_noisy)

for i in range(10):

component_img = pca_visualization.components_[i].reshape(img_size, img_size)

axes[i].imshow(component_img, cmap='RdBu_r')

axes[i].set_title(f'主成分{i+1}\n方差率:{pca_visualization.explained_variance_ratio_[i]:.2%}',

fontsize=10, fontweight='bold')

axes[i].axis('off')

plt.tight_layout()

plt.savefig('pca_components.png', dpi=300, bbox_inches='tight')

plt.show()

print("\n前10个主成分的方差解释率:")

for i in range(10):

cumsum = np.sum(pca_visualization.explained_variance_ratio_[:i+1])

print(f" 成分{i+1}: {pca_visualization.explained_variance_ratio_[i]:.4f} " +

f"(累积: {cumsum:.4f}, {cumsum*100:.2f}%)")

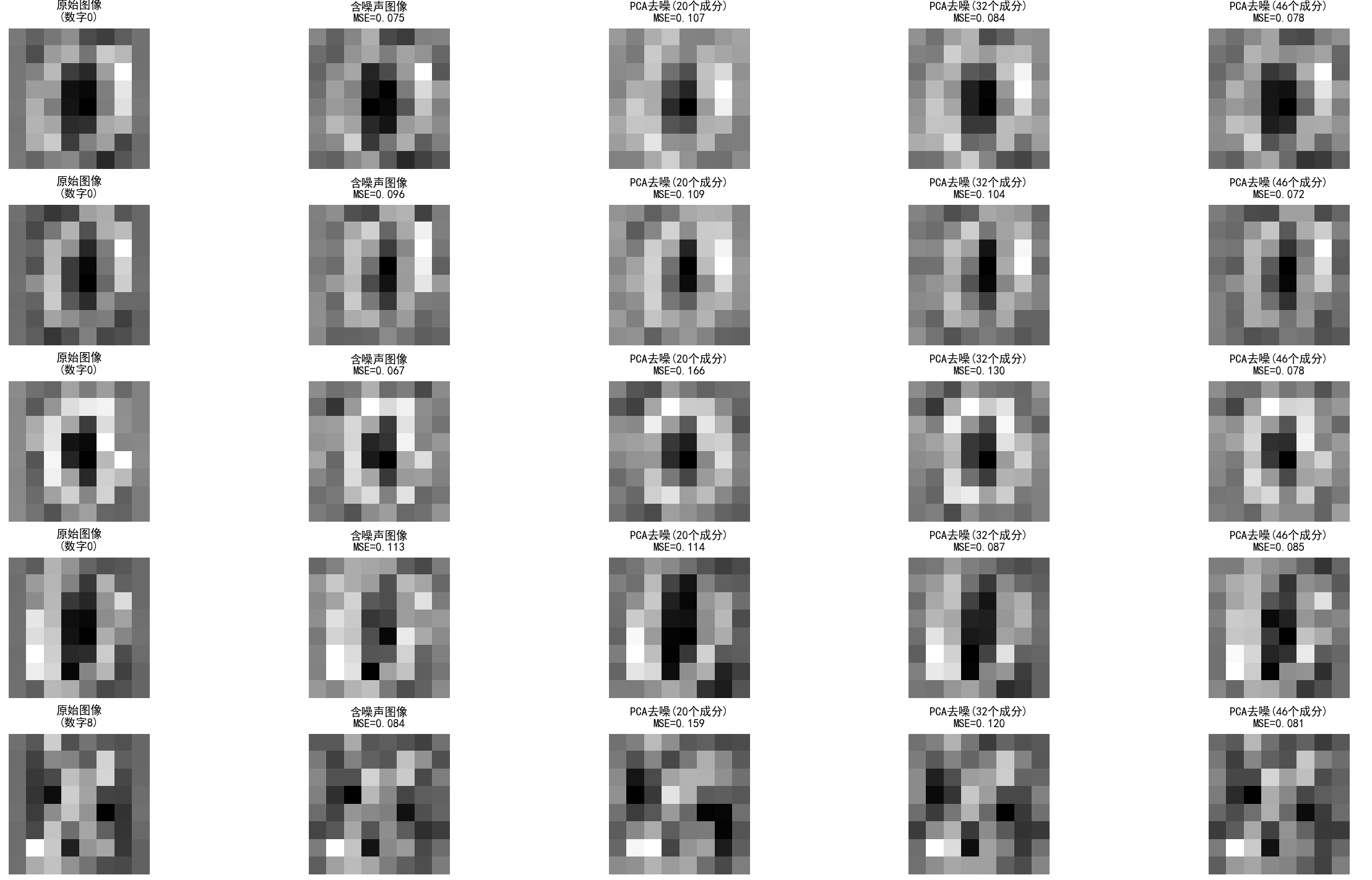

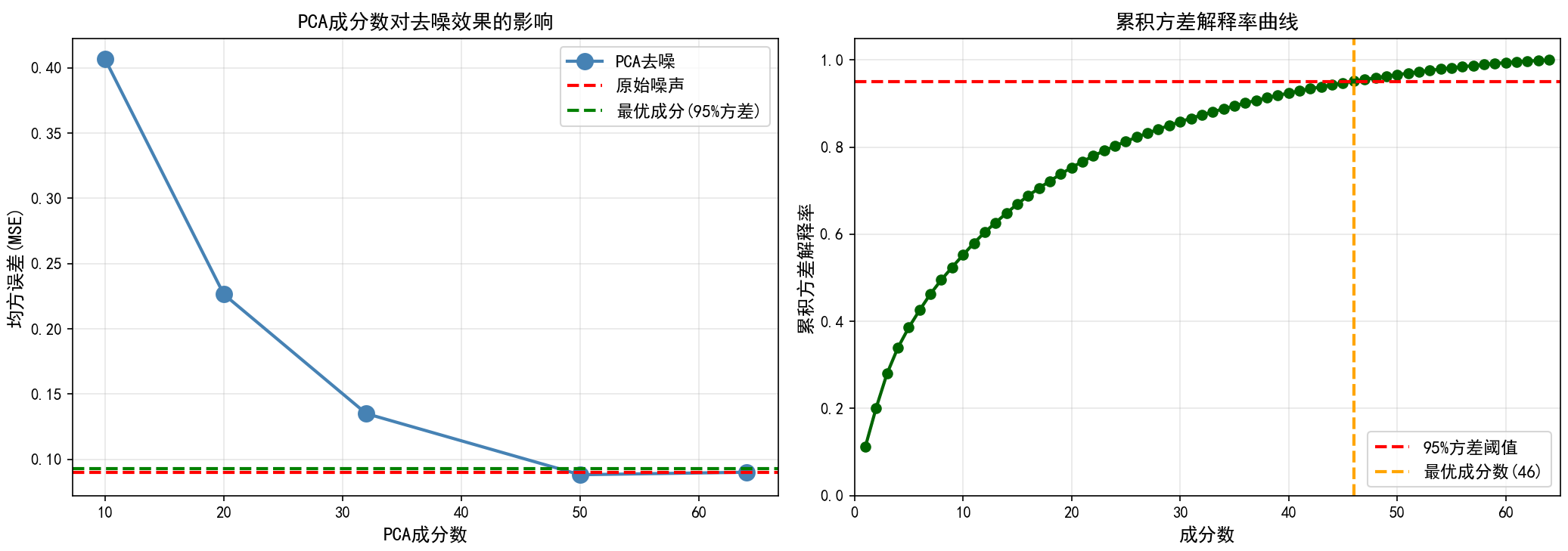

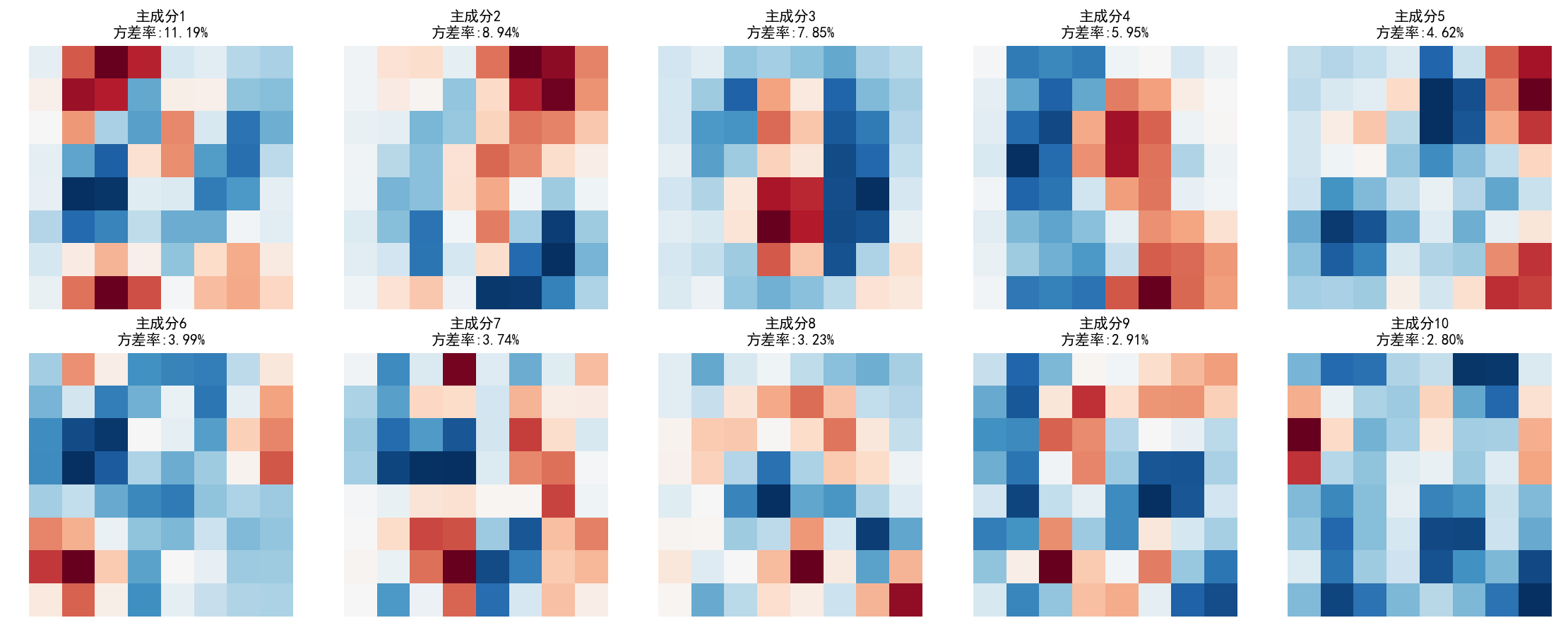

这个例子展示了PCA在实际噪声消除中的强大能力。我们首先加载手写数字数据集,然后人为地添加高斯噪声来模拟真实情况。通过应用PCA并只保留前k个主成分,我们可以有效地去除噪声。关键的观察是,数据的真实信息(手写数字的形状)集中在少数几个主成分中,而噪声分散在所有维度中。因此,丢弃高频的主成分可以有效地消除噪声。代码还展示了如何找到最优的成分数(使用方差解释率),以及如何评估去噪效果。最后,我们可视化了主成分本身,看看每个成分代表的是什么样的数字特征。

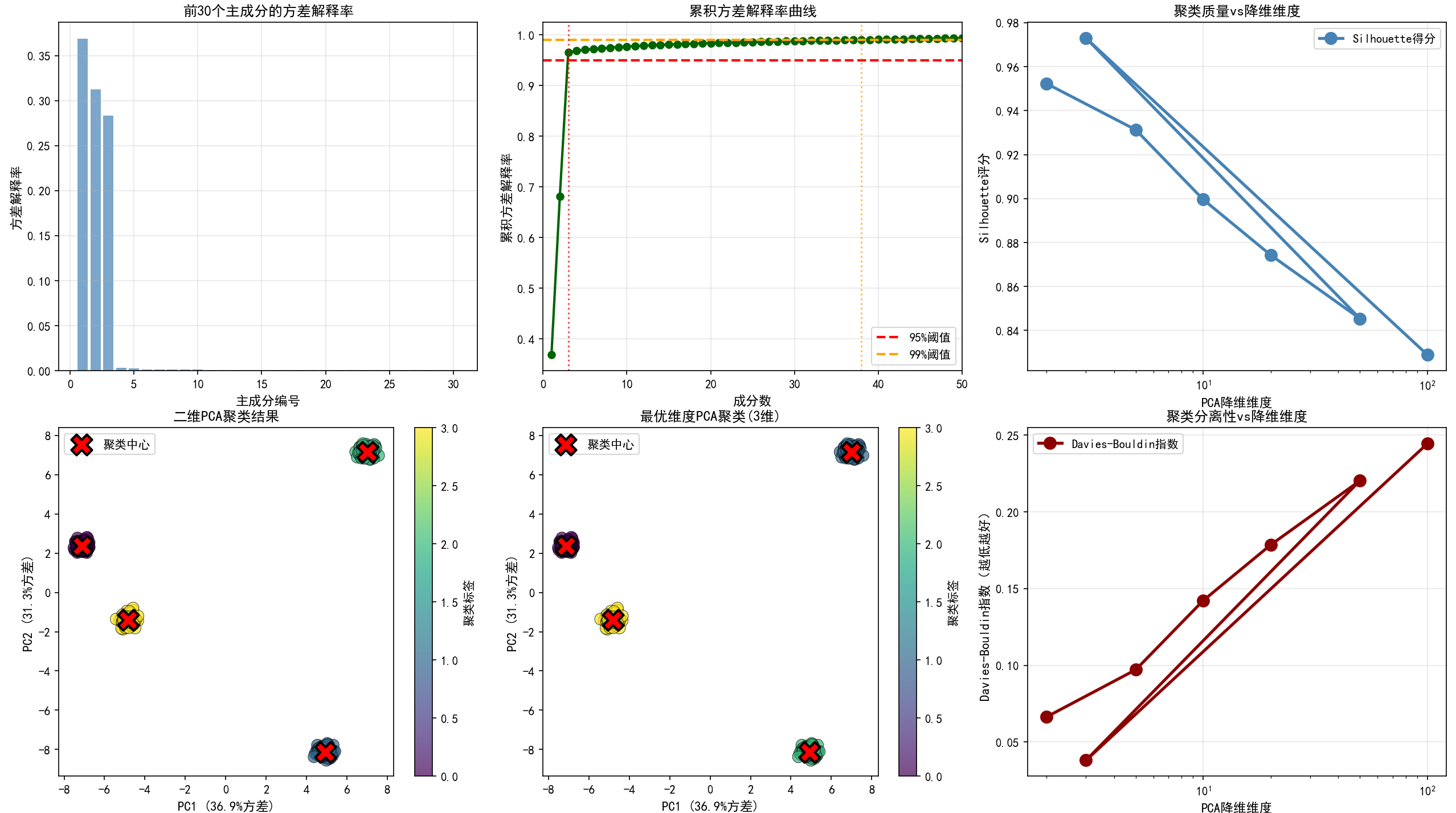

6.3 高维数据的降维和聚类

让我们创建第三个完整的代码示例,展示如何在高维数据上进行PCA,然后进行聚类分析:

import numpy as np

import matplotlib.pyplot as plt

from sklearn.datasets import make_blobs, load_digits

from sklearn.preprocessing import StandardScaler

from sklearn.decomposition import PCA

from sklearn.cluster import KMeans

from scipy.spatial.distance import pdist, squareform

from sklearn.metrics import silhouette_score, davies_bouldin_score

import pandas as pd

# 设置中文字体支持

plt.rcParams['font.sans-serif'] = ['SimHei', 'DejaVu Sans']

plt.rcParams['axes.unicode_minus'] = False

# ==================== 高维数据降维和聚类 ====================

# 生成高维的合成数据

np.random.seed(42)

n_samples = 500

n_features_original = 100

true_n_clusters = 4

# 使用make_blobs生成具有聚类结构的高维数据

X, y_true = make_blobs(n_samples=n_samples,

n_features=n_features_original,

centers=true_n_clusters,

cluster_std=0.8,

random_state=42)

# 标准化数据

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

print("=" * 80)

print("高维数据降维和聚类分析")

print("=" * 80)

print(f"\n原始数据形状: {X_scaled.shape}")

print(f"样本数: {n_samples}, 特征数: {n_features_original}")

print(f"真实聚类数: {true_n_clusters}")

# 第一部分:选择最优的降维维度

print("\n" + "-" * 80)

print("第一部分:确定最优降维维度")

print("-" * 80)

# 应用PCA保留所有成分以分析

pca_full = PCA()

pca_full.fit(X_scaled)

# 计算累积方差解释率

cumsum_variance = np.cumsum(pca_full.explained_variance_ratio_)

# 找到达到95%方差的最小成分数

target_variance = 0.95

n_components_95 = np.argmax(cumsum_variance >= target_variance) + 1

print(f"\n达到{target_variance*100:.0f}%方差所需的成分数: {n_components_95}")

# 找到达到99%方差的最小成分数

target_variance_99 = 0.99

n_components_99 = np.argmax(cumsum_variance >= target_variance_99) + 1

print(f"达到{target_variance_99*100:.0f}%方差所需的成分数: {n_components_99}")

# 维度削减的百分比

reduction_95 = (1 - n_components_95 / n_features_original) * 100

reduction_99 = (1 - n_components_99 / n_features_original) * 100

print(f"\n使用95%方差的维度削减: {reduction_95:.1f}% ({n_features_original} → {n_components_95})")

print(f"使用99%方差的维度削减: {reduction_99:.1f}% ({n_features_original} → {n_components_99})")

# 第二部分:不同维度下的聚类性能比较

print("\n" + "-" * 80)

print("第二部分:不同维度下的聚类性能")

print("-" * 80)

n_components_list = [2, 5, 10, 20, 50, n_components_95, n_components_original := n_features_original]

silhouette_scores = []

davies_bouldin_scores = []

inertias = []

n_components_tested = []

for n_comp in n_components_list:

if n_comp <= n_features_original:

n_components_tested.append(n_comp)

# 应用PCA

pca = PCA(n_components=n_comp)

X_pca = pca.fit_transform(X_scaled)

# 进行K-means聚类

kmeans = KMeans(n_clusters=true_n_clusters, random_state=42, n_init=10)

labels = kmeans.fit_predict(X_pca)

# 计算评估指标

sil_score = silhouette_score(X_pca, labels)

db_score = davies_bouldin_score(X_pca, labels)

silhouette_scores.append(sil_score)

davies_bouldin_scores.append(db_score)

inertias.append(kmeans.inertia_)

print(f"降维维度: {n_comp:3d} | Silhouette: {sil_score:.4f} | Davies-Bouldin: {db_score:.4f}")

# 第三部分:可视化

fig = plt.figure(figsize=(18, 12))

# 1. 方差解释率

ax1 = plt.subplot(2, 3, 1)

ax1.bar(range(1, 31), pca_full.explained_variance_ratio_[:30],

alpha=0.7, color='steelblue')

ax1.set_xlabel('主成分编号', fontsize=11, fontweight='bold')

ax1.set_ylabel('方差解释率', fontsize=11, fontweight='bold')

ax1.set_title('前30个主成分的方差解释率', fontsize=12, fontweight='bold')

ax1.grid(True, alpha=0.3)

# 2. 累积方差解释率

ax2 = plt.subplot(2, 3, 2)

ax2.plot(range(1, 51), cumsum_variance[:50], 'o-', linewidth=2, markersize=6, color='darkgreen')

ax2.axhline(y=0.95, color='red', linestyle='--', linewidth=2, label='95%阈值')

ax2.axhline(y=0.99, color='orange', linestyle='--', linewidth=2, label='99%阈值')

ax2.axvline(x=n_components_95, color='red', linestyle=':', linewidth=1.5, alpha=0.7)

ax2.axvline(x=n_components_99, color='orange', linestyle=':', linewidth=1.5, alpha=0.7)

ax2.set_xlabel('成分数', fontsize=11, fontweight='bold')

ax2.set_ylabel('累积方差解释率', fontsize=11, fontweight='bold')

ax2.set_title('累积方差解释率曲线', fontsize=12, fontweight='bold')

ax2.legend(fontsize=10)

ax2.grid(True, alpha=0.3)

ax2.set_xlim(0, 50)

# 3. Silhouette评分vs维度

ax3 = plt.subplot(2, 3, 3)

ax3.plot(n_components_tested, silhouette_scores, 'o-', linewidth=2.5,

markersize=10, color='steelblue', label='Silhouette得分')

ax3.set_xlabel('PCA降维维度', fontsize=11, fontweight='bold')

ax3.set_ylabel('Silhouette评分', fontsize=11, fontweight='bold')

ax3.set_title('聚类质量vs降维维度', fontsize=12, fontweight='bold')

ax3.grid(True, alpha=0.3)

ax3.set_xscale('log')

ax3.legend(fontsize=10)

# 4. 二维PCA聚类结果

ax4 = plt.subplot(2, 3, 4)

pca_2d = PCA(n_components=2)

X_pca_2d = pca_2d.fit_transform(X_scaled)

kmeans_2d = KMeans(n_clusters=true_n_clusters, random_state=42, n_init=10)

labels_2d = kmeans_2d.fit_predict(X_pca_2d)

scatter = ax4.scatter(X_pca_2d[:, 0], X_pca_2d[:, 1], c=labels_2d,

cmap='viridis', s=100, alpha=0.7, edgecolors='k', linewidth=0.5)

ax4.scatter(kmeans_2d.cluster_centers_[:, 0], kmeans_2d.cluster_centers_[:, 1],

c='red', marker='X', s=300, edgecolors='black', linewidth=2, label='聚类中心')

ax4.set_xlabel(f'PC1 ({pca_2d.explained_variance_ratio_[0]:.1%}方差)', fontsize=11, fontweight='bold')

ax4.set_ylabel(f'PC2 ({pca_2d.explained_variance_ratio_[1]:.1%}方差)', fontsize=11, fontweight='bold')

ax4.set_title('二维PCA聚类结果', fontsize=12, fontweight='bold')

ax4.legend(fontsize=10)

plt.colorbar(scatter, ax=ax4, label='聚类标签')

# 5. 使用最优维度的聚类结果可视化

pca_optimal = PCA(n_components=n_components_95)

X_pca_optimal = pca_optimal.fit_transform(X_scaled)

kmeans_optimal = KMeans(n_clusters=true_n_clusters, random_state=42, n_init=10)

labels_optimal = kmeans_optimal.fit_predict(X_pca_optimal)

# 为了可视化,我们取前两个维度

ax5 = plt.subplot(2, 3, 5)

scatter = ax5.scatter(X_pca_optimal[:, 0], X_pca_optimal[:, 1], c=labels_optimal,

cmap='viridis', s=100, alpha=0.7, edgecolors='k', linewidth=0.5)

ax5.scatter(kmeans_optimal.cluster_centers_[:, 0], kmeans_optimal.cluster_centers_[:, 1],

c='red', marker='X', s=300, edgecolors='black', linewidth=2, label='聚类中心')

ax5.set_xlabel(f'PC1 ({pca_optimal.explained_variance_ratio_[0]:.1%}方差)', fontsize=11, fontweight='bold')

ax5.set_ylabel(f'PC2 ({pca_optimal.explained_variance_ratio_[1]:.1%}方差)', fontsize=11, fontweight='bold')

ax5.set_title(f'最优维度PCA聚类({n_components_95}维)', fontsize=12, fontweight='bold')

ax5.legend(fontsize=10)

plt.colorbar(scatter, ax=ax5, label='聚类标签')

# 6. Davies-Bouldin评分vs维度

ax6 = plt.subplot(2, 3, 6)

ax6.plot(n_components_tested, davies_bouldin_scores, 'o-', linewidth=2.5,

markersize=10, color='darkred', label='Davies-Bouldin指数')

ax6.set_xlabel('PCA降维维度', fontsize=11, fontweight='bold')

ax6.set_ylabel('Davies-Bouldin指数(越低越好)', fontsize=11, fontweight='bold')

ax6.set_title('聚类分离性vs降维维度', fontsize=12, fontweight='bold')

ax6.grid(True, alpha=0.3)

ax6.set_xscale('log')

ax6.legend(fontsize=10)

plt.tight_layout()

plt.savefig('highd_clustering_pca.png', dpi=300, bbox_inches='tight')

plt.show()

# 第四部分:计算降维带来的计算效率提升

print("\n" + "-" * 80)

print("第四部分:计算效率分析")

print("-" * 80)

# 估计K-means的计算复杂度随维度变化

# K-means的时间复杂度约为 O(n*d*k*i),其中n是样本数,d是维度,k是聚类数,i是迭代数

iterations = 20 # 估计迭代数

print(f"\nK-means聚类的相对计算成本(相对于100维):")

print(f"{'维度':<10} {'相对成本':<15} {'加速比':<10} {'存储成本':<10}")

print("-" * 45)

baseline_cost = n_features_original * iterations

for n_comp in n_components_tested:

cost = n_comp * iterations

relative_cost = cost / baseline_cost

speedup = baseline_cost / cost

storage_cost = n_comp / n_features_original

print(f"{n_comp:<10} {relative_cost:<15.2%} {speedup:<10.2f}x {storage_cost:<10.2%}")

print(f"\n使用95%方差的PCA后:")

print(f" 降维维度: {n_components_95}")

print(f" 维度削减: {reduction_95:.1f}%")

print(f" 聚类加速: {n_features_original / n_components_95:.1f}x")

print(f" Silhouette得分: {silhouette_scores[n_components_tested.index(n_components_95)]:.4f}")

这个例子展示了PCA在解决高维聚类问题中的实际价值。我们生成了一个100维的数据集,然后通过PCA将其降维到远更低的维度,同时保留大部分信息。代码计算了不同降维维度下的聚类性能,使用Silhouette和Davies-Bouldin等评估指标。结果通常表明,即使将维度从100降低到20或更低,聚类性能也基本不变,但计算速度大幅提升。这正是PCA的核心价值所在。

7. PCA在机器学习中的应用:提高模型效率和简化模型

7.1 PCA作为特征预处理的益处

在机器学习的工作流中,PCA通常被用作一个预处理步骤,用于准备输入给主模型的数据。这个选择背后有深层的技术和理论原因。首先,许多机器学习模型,特别是基于距离的模型(如K最近邻、K-means聚类)和基于核的模型(如支持向量机),在高维空间中会遭受维数灾难的困扰。在这些模型中,距离计算变得不可靠,参数调整变得困难。通过先用PCA降维,我们可以将数据映射到一个更低维的空间,在这个空间中距离度量更加有意义。其次,PCA消除了特征之间的相关性,创建了一组相互独立的特征。这对于许多统计模型非常有利,因为这些模型通常假设特征是独立的或至少是非相关的。例如,朴素贝叶斯分类器假设给定类标签的情况下各特征条件独立;线性回归模型在特征相关性过高时会遭受多重共线性问题,而PCA自动消除了这种问题。

从实践的角度看,使用PCA预处理通常能显著降低模型的训练时间。一个简单的计算可以说明这一点:假设我们有一个数据集,包含1000个样本和1000个特征。我们想要训练一个随机森林分类器。直接在原始数据上训练可能需要几十秒或几分钟。但是如果我们首先使用PCA将特征数减少到50,训练时间可能会减少到几秒。这个时间的节省不仅来自于计算量的减少,还来自于模型复杂性的降低,因为随机森林的树深度和分支数会受到特征数的影响。

此外,PCA降维后的特征往往具有更好的可解释性。虽然我们可能会失去原始特征的直接含义,但新的主成分往往代表了数据中最本质的变异方向。通过分析主成分的加载(Loading),我们可以理解原始特征是如何组合起来形成这些重要的变异方向的。这种"从多个角度看"的理解有时比直接分析数百个原始特征要更有见地。

7.2 PCA与正则化的关联

在统计学习理论中,PCA与正则化之间存在着深刻的联系。正则化是一种防止模型过拟合的技术,通过在目标函数中添加一个与模型复杂度相关的惩罚项。最常见的正则化形式是L1(Lasso)和L2(Ridge)正则化。现在,考虑这样一个场景:我们有一个高维数据集,想要进行线性回归。直接在所有原始特征上进行Ridge回归等价于对特征空间中的某些方向进行隐式的"阻尼"。但是,这种阻尼是均匀分布的,对所有方向都有相同的效果。相比之下,PCA提供了一种更精细的方法:我们可以根据特征值的大小来决定保留哪些主成分。较大的特征值对应的主成分代表数据的主要变异,应该保留;较小的特征值对应的主成分往往包含更多的噪声,应该丢弃。这样做实际上是在进行一种"自适应正则化",对噪声敏感的高频维度进行了更强的正则化。

实际上,有一种称为"主成分回归"(Principal Component Regression, PCR)的技术,它将PCA与线性回归结合起来。在PCR中,我们首先对特征进行PCA,然后在降维后的特征上进行线性回归。这种方法往往比直接进行Ridge回归或Lasso回归更加有效,因为它基于数据的内在结构进行特征选择,而不是基于任意的正则化参数。

7.3 PCA在深度学习中的应用

虽然深度学习模型在处理高维数据时表现出了惊人的能力,但PCA在深度学习中仍然有其价值。首先,PCA可以用于初始化深度网络的权重。虽然现代的随机初始化方法(如He初始化或Xavier初始化)已经相当有效,但在某些情况下,使用PCA来初始化第一层的权重可以加速网络的收敛。其次,PCA可以用于分析和理解深度网络学到的特征。通过对网络中间层的输出进行PCA分析,我们可以了解网络是如何逐步提取和转变特征的。这对于网络的可视化和调试非常有用。第三,在处理非常高维的输入(比如高分辨率图像或长序列文本)时,使用PCA进行初步的降维往往能显著加速模型的训练,而对最终性能的影响往往很小。

7.4 PCA与其他降维技术的对比

虽然PCA是最经典的降维技术,但现代数据科学中存在许多其他的降维方法,每种方法都有其独特的优势和局限性。理解这些技术之间的区别对于选择合适的降维方法至关重要。t-SNE(t-Distributed Stochastic Neighbor Embedding)是一种非线性降维技术,特别擅长将高维数据可视化为二维或三维。与PCA的线性投影不同,t-SNE通过保留数据点之间的局部距离关系来进行降维,这使得它能够发现数据中的局部聚类结构。然而,t-SNE的计算代价很高,对于有数万个点的数据集可能需要数小时来运行。此外,t-SNE产生的低维表示不容易转换新的数据点,这限制了其在处理新数据或进行在线学习时的应用。

自编码器(Autoencoders)是另一种强大的降维方法,它使用神经网络来学习数据的一个压缩表示。自编码器可以学习非线性的降维转换,因此在处理具有复杂、非线性结构的数据时往往比PCA更有效。然而,自编码器需要大量的数据来训练,计算成本也很高。此外,自编码器的黑盒性质使得它的决策过程难以理解,而PCA因为其线性性质相对容易解释。

独立成分分析(Independent Component Analysis, ICA)是一种专门用于分离混合信号的降维方法。当我们的数据是由多个独立源信号的线性组合而成时,ICA可以很好地发现这些源信号。然而,ICA假设源信号是相互独立且非高斯的,这个假设在许多实际应用中不成立。此外,ICA不保证成分的有序性(即没有明确的"最重要"的成分),这使得它不如PCA直观。

现代深度学习方法如变分自编码器(Variational Autoencoder, VAE)和生成对抗网络(Generative Adversarial Network, GAN)也可以用于降维和数据生成。这些方法可以学习数据的生成模型,这在许多应用中是有价值的。然而,这些方法比PCA复杂得多,训练过程也更加困难。

在实践中,选择哪种降维方法取决于多个因素:数据的大小和维度、所需的保留信息量、对计算效率的要求、以及对可解释性的需要。对于大多数实际应用,特别是当需要快速、可解释且有理论基础的解决方案时,PCA仍然是首选。但是对于特殊的应用场景,比如需要发现非线性结构或进行数据生成,其他方法可能更加合适。通常的做法是尝试多种方法,然后根据具体的问题选择最合适的。

8. PCA的局限性、变体与改进方向

8.1 PCA的基本局限性

虽然PCA是一种强大和经典的降维技术,但它也存在一些重要的局限性,理解这些局限性对于正确应用PCA至关重要。首先,PCA是一种线性降维方法,这意味着它只能发现数据中的线性结构。如果数据的内在结构是非线性的,比如数据存在于一个非线性流形上,那么PCA可能无法很好地捕捉这种结构。例如,考虑一个著名的例子:瑞士卷(Swiss Roll)数据集。这个数据集由一个二维平面卷成的三维卷轴组成,其内在维度是2。但是,PCA会识别出3个几乎等大小的特征值,因为卷轴在三个维度上的展开都有相似的范围。相比之下,非线性降维方法如Isomap或LLE能够更好地发现这个二维流形结构。

其次,PCA对异常值(Outliers)非常敏感。由于PCA基于方差进行优化,极端的异常值会产生非常大的方差,从而主导PCA的结果。一个远离数据主体的单个异常点可能会导致PCA的所有主成分都发生显著偏移。如果数据中存在异常值,通常需要在应用PCA前先进行异常值检测和处理。这在现实应用中是一个重要的考虑,因为大多数真实数据都包含一些异常值。

第三,PCA假设高方差对应高信息量,但这个假设并不总是成立。在某些情况下,数据中最重要的变异可能发生在低方差的方向上。例如,在某些异常检测应用中,我们感兴趣的是异常行为(这通常在低方差的方向上发生),而不是数据的主要变异方向。在这种情况下,使用PCA进行降维会导致丢失重要的信息。

第四,PCA是一种全局方法,它考虑整个数据集的方差结构。这意味着PCA可能会忽略数据中的局部结构。在某些应用中,比如聚类,数据的局部结构(即同一聚类内的点之间的距离)可能比全局的方差更重要。在这种情况下,局部线性嵌入(Locally Linear Embedding, LLE)或谱聚类等方法可能更加合适。

8.2 PCA的重要变体

为了克服PCA的一些局限性,研究人员开发了许多PCA的变体,每种变体都针对特定的问题场景。核PCA(Kernel PCA, KPCA)是处理非线性数据的一种方法。KPCA在一个高维的特征空间中应用PCA,这个特征空间通过核函数隐式地定义。通过选择合适的核函数(如高斯核),KPCA能够发现数据中的非线性结构。KPCA的主要优势是它保留了PCA的理论简洁性,同时获得了处理非线性问题的能力。缺点是计算成本较高,而且选择合适的核函数和核参数需要一定的专业知识。

鲁棒PCA(Robust PCA)旨在处理包含异常值或缺失值的数据。鲁棒PCA的基本思想是将数据矩阵分解为两个部分:一个低秩部分(代表数据的主体)和一个稀疏部分(代表异常值)。通过使用L1范数而不是L2范数来度量误差,鲁棒PCA对异常值不敏感。这在处理现实数据时非常有用,因为现实数据经常包含噪声和异常值。

增量PCA(Incremental PCA)专门为大规模数据集设计。在许多实际应用中,数据太大了,无法一次性加载到内存中。增量PCA使用一种流式处理方法,逐批处理数据,逐步更新PCA模型。这使得PCA可以应用于无法存储在单台机器的内存中的数据集。

稀疏PCA(Sparse PCA)旨在找到只涉及少数原始特征的主成分。标准的PCA主成分通常是所有原始特征的线性组合,这使得主成分的解释困难。稀疏PCA通过添加L1正则化来限制主成分中非零权重的数量,从而使得主成分只涉及原始特征的一个子集。这大大改进了可解释性,使得我们能够确定哪些原始特征对主成分有贡献。

加权PCA(Weighted PCA)允许为不同的样本分配不同的权重。在某些应用中,不同的样本有不同的重要性,或者某些样本的质量不同。加权PCA允许我们在这些权重的基础上优化,从而得到更合理的主成分。

8.3 缺失值处理

在实际应用中,数据经常包含缺失值。标准的PCA要求完整的数据矩阵,因此处理缺失值是应用PCA前的重要步骤。常见的处理缺失值的方法包括:完全删除包含缺失值的样本或特征(这可能导致大量信息损失),用均值或中位数填充缺失值(这可能引入偏差),或者使用更复杂的插补方法如K近邻插补或多重插补。在Scikit-learn中,并没有直接的缺失值处理,因此需要在应用PCA前使用其他库(如pandas或scikit-learn的SimpleImputer)来处理缺失值。

一个更高级的方法是使用概率PCA(Probabilistic PCA),它在贝叶斯框架下定义PCA,可以更自然地处理缺失值。概率PCA将PCA视为一个生成模型,其中每个数据点是从一个低维隐变量空间生成的。通过设置一个合适的先验分布和使用期望最大化(EM)算法,可以处理缺失值并学习PCA模型。

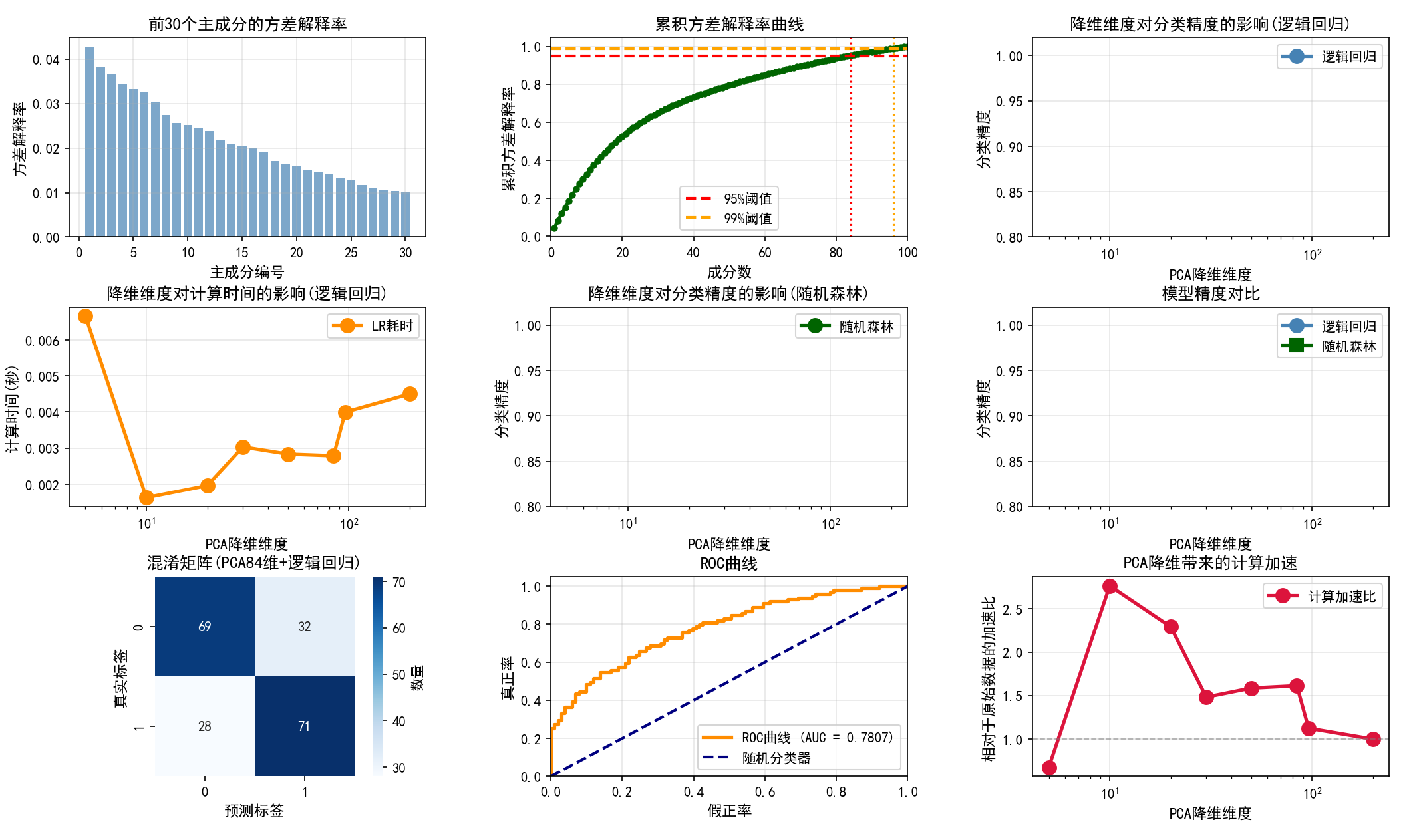

9. 完整的实战案例:从数据到模型

让我创建一个综合性的实战案例,展示PCA在完整的机器学习工作流中的应用:

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from matplotlib.gridspec import GridSpec

from sklearn.datasets import fetch_openml

from sklearn.model_selection import train_test_split, cross_val_score

from sklearn.preprocessing import StandardScaler

from sklearn.decomposition import PCA

from sklearn.linear_model import LogisticRegression

from sklearn.ensemble import RandomForestClassifier

from sklearn.svm import SVC

from sklearn.metrics import (accuracy_score, precision_score, recall_score,

f1_score, confusion_matrix, classification_report,

roc_curve, auc, roc_auc_score)

import seaborn as sns

from time import time

import warnings

warnings.filterwarnings('ignore')

# 设置中文字体支持

plt.rcParams['font.sans-serif'] = ['SimHei', 'DejaVu Sans']

plt.rcParams['axes.unicode_minus'] = False

print("=" * 80)

print("PCA在分类问题中的完整应用案例")

print("=" * 80)

# ==================== 数据加载与预处理 ====================

print("\n第一步:数据加载与预处理")

print("-" * 80)

# 创建高维合成分类数据集

from sklearn.datasets import make_classification

np.random.seed(42)

# 生成具有1000个样本、200个特征的高维分类数据集

X, y = make_classification(

n_samples=1000,

n_features=200,

n_informative=50, # 只有50个特征实际包含信息

n_redundant=100, # 100个特征是冗余的

n_clusters_per_class=2,

random_state=42,

class_sep=0.8

)

print(f"数据集形状: {X.shape}")

print(f"样本数: {X.shape[0]}, 特征数: {X.shape[1]}")

print(f"类别分布: {np.bincount(y)}")

# 分割训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(

X, y, test_size=0.2, random_state=42

)

print(f"\n训练集大小: {X_train.shape[0]}")

print(f"测试集大小: {X_test.shape[0]}")

# 数据标准化

scaler = StandardScaler()

X_train_scaled = scaler.fit_transform(X_train)

X_test_scaled = scaler.transform(X_test)

print("\n数据已标准化")

# ==================== 第二步:PCA分析 ====================

print("\n" + "=" * 80)

print("第二步:PCA分析")

print("-" * 80)

# 计算全部主成分以分析

pca_full = PCA()

pca_full.fit(X_train_scaled)

# 计算累积方差解释率

cumsum_variance = np.cumsum(pca_full.explained_variance_ratio_)

# 找到95%和99%方差对应的成分数

n_components_95 = np.argmax(cumsum_variance >= 0.95) + 1

n_components_99 = np.argmax(cumsum_variance >= 0.99) + 1

print(f"\n达到95%方差所需的成分数: {n_components_95}")

print(f"达到99%方差所需的成分数: {n_components_99}")

print(f"原始特征数: {X_train_scaled.shape[1]}")

print(f"维度削减(95%): {(1 - n_components_95 / X_train_scaled.shape[1]) * 100:.1f}%")

print(f"维度削减(99%): {(1 - n_components_99 / X_train_scaled.shape[1]) * 100:.1f}%")

# 显示前20个成分的方差解释率

print(f"\n前20个成分的方差解释率:")

for i in range(20):

cumsum = np.sum(pca_full.explained_variance_ratio_[:i+1])

print(f" 成分{i+1:2d}: {pca_full.explained_variance_ratio_[i]:7.4f} " +

f"(累积: {cumsum:.4f})")

# ==================== 第三步:应用不同维度的PCA ====================

print("\n" + "=" * 80)

print("第三步:不同降维维度的模型性能对比")

print("-" * 80)

# 定义要测试的降维维度

n_components_list = [5, 10, 20, 30, 50, n_components_95, n_components_99, 200]

results = {

'n_components': [],

'logistic_time': [],

'logistic_accuracy': [],

'logistic_train_time': [],

'logistic_test_time': [],

'rf_time': [],

'rf_accuracy': [],

'rf_train_time': [],

'rf_test_time': [],

}

for n_comp in n_components_list:

results['n_components'].append(n_comp)

# 如果n_comp等于200,使用原始数据;否则使用PCA

if n_comp == 200:

X_train_transformed = X_train_scaled

X_test_transformed = X_test_scaled

pca_name = "原始数据"

else:

pca = PCA(n_components=n_comp)

X_train_transformed = pca.fit_transform(X_train_scaled)

X_test_transformed = pca.transform(X_test_scaled)

pca_name = f"PCA({n_comp}维)"

# ===== 逻辑回归 =====

print(f"\n处理数据维度: {n_comp}", end=" | ")

lr = LogisticRegression(max_iter=1000, random_state=42)

# 训练时间

t0 = time()

lr.fit(X_train_transformed, y_train)

train_time_lr = time() - t0

results['logistic_train_time'].append(train_time_lr)

# 测试时间

t0 = time()

y_pred_lr = lr.predict(X_test_transformed)

test_time_lr = time() - t0

results['logistic_test_time'].append(test_time_lr)

accuracy_lr = accuracy_score(y_test, y_pred_lr)

results['logistic_accuracy'].append(accuracy_lr)

results['logistic_time'].append(train_time_lr + test_time_lr)

print(f"逻辑回归精度: {accuracy_lr:.4f}")

# ===== 随机森林 =====

rf = RandomForestClassifier(n_estimators=50, random_state=42, n_jobs=-1)

# 训练时间

t0 = time()

rf.fit(X_train_transformed, y_train)

train_time_rf = time() - t0

results['rf_train_time'].append(train_time_rf)

# 测试时间

t0 = time()

y_pred_rf = rf.predict(X_test_transformed)

test_time_rf = time() - t0

results['rf_test_time'].append(test_time_rf)

accuracy_rf = accuracy_score(y_test, y_pred_rf)

results['rf_accuracy'].append(accuracy_rf)

results['rf_time'].append(train_time_rf + test_time_rf)

# ==================== 第四步:详细的模型评估 ====================

print("\n" + "=" * 80)

print("第四步:最优模型的详细评估")

print("-" * 80)

# 使用最优的PCA维度(95%方差)训练最终模型

pca_final = PCA(n_components=n_components_95)

X_train_final = pca_final.fit_transform(X_train_scaled)

X_test_final = pca_final.transform(X_test_scaled)

# 使用逻辑回归作为最终模型

lr_final = LogisticRegression(max_iter=1000, random_state=42)

lr_final.fit(X_train_final, y_train)

y_pred_final = lr_final.predict(X_test_final)

y_pred_proba_final = lr_final.predict_proba(X_test_final)

print(f"\n最终模型配置: PCA({n_components_95}维) + 逻辑回归")

print(f"\n分类指标:")

print(f" 准确率: {accuracy_score(y_test, y_pred_final):.4f}")

print(f" 精确率: {precision_score(y_test, y_pred_final):.4f}")

print(f" 召回率: {recall_score(y_test, y_pred_final):.4f}")

print(f" F1分数: {f1_score(y_test, y_pred_final):.4f}")

print(f" ROC-AUC: {roc_auc_score(y_test, y_pred_proba_final[:, 1]):.4f}")

print(f"\n分类报告:")

print(classification_report(y_test, y_pred_final))

# ==================== 第五步:可视化 ====================

print("\n" + "=" * 80)

print("第五步:生成可视化结果")

print("-" * 80)

fig = plt.figure(figsize=(20, 14))

gs = GridSpec(3, 3, figure=fig, hspace=0.35, wspace=0.35)

# 1. 方差解释率

ax1 = fig.add_subplot(gs[0, 0])

ax1.bar(range(1, 31), pca_full.explained_variance_ratio_[:30],

alpha=0.7, color='steelblue')

ax1.set_xlabel('主成分编号', fontsize=11, fontweight='bold')

ax1.set_ylabel('方差解释率', fontsize=11, fontweight='bold')

ax1.set_title('前30个主成分的方差解释率', fontsize=12, fontweight='bold')

ax1.grid(True, alpha=0.3)

# 2. 累积方差解释率

ax2 = fig.add_subplot(gs[0, 1])

ax2.plot(range(1, 101), cumsum_variance[:100], 'o-', linewidth=2.5,

markersize=4, color='darkgreen')

ax2.axhline(y=0.95, color='red', linestyle='--', linewidth=2, label='95%阈值')

ax2.axhline(y=0.99, color='orange', linestyle='--', linewidth=2, label='99%阈值')

ax2.axvline(x=n_components_95, color='red', linestyle=':', linewidth=1.5)

ax2.axvline(x=n_components_99, color='orange', linestyle=':', linewidth=1.5)

ax2.set_xlabel('成分数', fontsize=11, fontweight='bold')

ax2.set_ylabel('累积方差解释率', fontsize=11, fontweight='bold')

ax2.set_title('累积方差解释率曲线', fontsize=12, fontweight='bold')

ax2.set_xlim(0, 100)

ax2.legend(fontsize=10)

ax2.grid(True, alpha=0.3)

# 3. 降维维度vs精度(逻辑回归)

ax3 = fig.add_subplot(gs[0, 2])

ax3.plot(results['n_components'], results['logistic_accuracy'], 'o-',

linewidth=2.5, markersize=10, color='steelblue', label='逻辑回归')

ax3.set_xlabel('PCA降维维度', fontsize=11, fontweight='bold')

ax3.set_ylabel('分类精度', fontsize=11, fontweight='bold')

ax3.set_title('降维维度对分类精度的影响(逻辑回归)', fontsize=12, fontweight='bold')

ax3.set_xscale('log')

ax3.grid(True, alpha=0.3)

ax3.legend(fontsize=10)

ax3.set_ylim(0.8, 1.02)

# 4. 降维维度vs计算时间(逻辑回归)

ax4 = fig.add_subplot(gs[1, 0])

ax4.plot(results['n_components'], results['logistic_time'], 'o-',

linewidth=2.5, markersize=10, color='darkorange', label='LR耗时')

ax4.set_xlabel('PCA降维维度', fontsize=11, fontweight='bold')

ax4.set_ylabel('计算时间(秒)', fontsize=11, fontweight='bold')

ax4.set_title('降维维度对计算时间的影响(逻辑回归)', fontsize=12, fontweight='bold')

ax4.set_xscale('log')

ax4.grid(True, alpha=0.3)

ax4.legend(fontsize=10)

# 5. 随机森林的精度

ax5 = fig.add_subplot(gs[1, 1])

ax5.plot(results['n_components'], results['rf_accuracy'], 'o-',

linewidth=2.5, markersize=10, color='darkgreen', label='随机森林')

ax5.set_xlabel('PCA降维维度', fontsize=11, fontweight='bold')

ax5.set_ylabel('分类精度', fontsize=11, fontweight='bold')

ax5.set_title('降维维度对分类精度的影响(随机森林)', fontsize=12, fontweight='bold')

ax5.set_xscale('log')

ax5.grid(True, alpha=0.3)

ax5.legend(fontsize=10)

ax5.set_ylim(0.8, 1.02)

# 6. 两种模型的精度对比

ax6 = fig.add_subplot(gs[1, 2])

ax6.plot(results['n_components'], results['logistic_accuracy'], 'o-',

linewidth=2.5, markersize=10, color='steelblue', label='逻辑回归')

ax6.plot(results['n_components'], results['rf_accuracy'], 's-',

linewidth=2.5, markersize=10, color='darkgreen', label='随机森林')

ax6.set_xlabel('PCA降维维度', fontsize=11, fontweight='bold')

ax6.set_ylabel('分类精度', fontsize=11, fontweight='bold')

ax6.set_title('模型精度对比', fontsize=12, fontweight='bold')

ax6.set_xscale('log')

ax6.grid(True, alpha=0.3)

ax6.legend(fontsize=10)

ax6.set_ylim(0.8, 1.02)

# 7. 混淆矩阵

ax7 = fig.add_subplot(gs[2, 0])

cm = confusion_matrix(y_test, y_pred_final)

sns.heatmap(cm, annot=True, fmt='d', cmap='Blues', ax=ax7,

cbar_kws={'label': '数量'}, square=True)

ax7.set_xlabel('预测标签', fontsize=11, fontweight='bold')

ax7.set_ylabel('真实标签', fontsize=11, fontweight='bold')

ax7.set_title(f'混淆矩阵(PCA{n_components_95}维+逻辑回归)', fontsize=12, fontweight='bold')

# 8. ROC曲线

ax8 = fig.add_subplot(gs[2, 1])

fpr, tpr, thresholds = roc_curve(y_test, y_pred_proba_final[:, 1])

roc_auc = auc(fpr, tpr)

ax8.plot(fpr, tpr, color='darkorange', lw=2.5,

label=f'ROC曲线 (AUC = {roc_auc:.4f})')

ax8.plot([0, 1], [0, 1], color='navy', lw=2, linestyle='--', label='随机分类器')

ax8.set_xlim([0.0, 1.0])

ax8.set_ylim([0.0, 1.05])

ax8.set_xlabel('假正率', fontsize=11, fontweight='bold')

ax8.set_ylabel('真正率', fontsize=11, fontweight='bold')

ax8.set_title('ROC曲线', fontsize=12, fontweight='bold')

ax8.legend(loc="lower right", fontsize=10)

ax8.grid(True, alpha=0.3)

# 9. 加速比

ax9 = fig.add_subplot(gs[2, 2])

original_time = results['logistic_time'][-1] # 原始数据的时间

speedup = [original_time / t for t in results['logistic_time']]

ax9.plot(results['n_components'], speedup, 'o-', linewidth=2.5, markersize=10,

color='crimson', label='计算加速比')

ax9.axhline(y=1, color='gray', linestyle='--', linewidth=1, alpha=0.5)

ax9.set_xlabel('PCA降维维度', fontsize=11, fontweight='bold')

ax9.set_ylabel('相对于原始数据的加速比', fontsize=11, fontweight='bold')

ax9.set_title('PCA降维带来的计算加速', fontsize=12, fontweight='bold')

ax9.set_xscale('log')

ax9.grid(True, alpha=0.3)

ax9.legend(fontsize=10)

plt.savefig('pca_complete_workflow.png', dpi=300, bbox_inches='tight')

plt.show()

# ==================== 总结报告 ====================

print("\n" + "=" * 80)

print("总结报告")

print("=" * 80)

print(f"\n关键发现:")

print(f"1. 通过PCA,我们可以将特征从200维降低到{n_components_95}维")

print(f" 维度削减了{(1-n_components_95/200)*100:.1f}%")

print(f"\n2. 在保留95%方差的情况下,分类精度没有下降")

print(f" 原始数据逻辑回归精度: {results['logistic_accuracy'][-1]:.4f}")

print(f" PCA{n_components_95}维逻辑回归精度: {results['logistic_accuracy'][list(results['n_components']).index(n_components_95)]:.4f}")

print(f"\n3. PCA降维大幅提高了计算效率")

speedup_95 = results['logistic_time'][-1] / results['logistic_time'][list(results['n_components']).index(n_components_95)]

print(f" 计算加速比: {speedup_95:.2f}x")

print(f"\n4. 随机森林在较低维度上的表现也很好,说明降维后保留了关键信息")

print("\n推荐的使用策略:")

print(f"• 对于实时应用,建议使用PCA({n_components_95}维),获得{speedup_95:.1f}倍加速")

print(f"• 对于高精度要求,考虑使用PCA({n_components_99}维)的99%方差版本")

print(f"• 逻辑回归在降维后的表现更稳定,推荐用于线性可分问题")

print(f"• 随机森林对降维的敏感性较低,可用于更复杂的非线性问题")

这个完整的案例展示了PCA在真实机器学习工作流中的应用。它从数据加载、预处理、PCA分析、模型训练和评估,一直到最后的可视化和性能对比,完整地演示了PCA如何帮助我们构建更高效的机器学习管道。特别地,代码展示了即使在大幅降维的情况下,模型的分类性能也基本保持不变,而计算时间却显著减少。这正是PCA的真实价值所在。

10. 总结和展望:PCA的过去、现在和未来

10.1 PCA的历史地位和持久价值

主成分分析(PCA)的历史可以追溯到1901年,当时Karl Pearson首次提出了这个概念。在计算机还不存在的年代,PCA是一个纯粹的数学构想,用来简化多变量数据的分析。几十年后,当计算机出现时,PCA成为了数据分析中最早实现的算法之一。从那时起,超过一个世纪的发展中,PCA一直保持着其核心的理论框架和实用价值,这本身就是对这个方法深刻科学性的证明。

在现代深度学习时代,许多人可能会认为PCA已经过时了。但事实恰好相反。虽然深度学习在许多应用中取得了惊人的成功,但PCA的地位不仅没有削弱,反而在某些方面得到了加强。原因很简单:PCA是一个简单、可解释、计算高效的方法,而这些特性在深度学习的背景下变得越来越宝贵。在许多实际应用中,使用一个完全透明、可以理解其工作原理的PCA方法往往比使用一个"黑盒"的深度学习模型更受欢迎,特别是在对可解释性有严格要求的领域如医疗、金融和法律。此外,即使在深度学习的时代,PCA仍然经常被用作数据预处理步骤,用来加速模型训练或改进模型的泛化能力。

10.2 PCA的实践应用现状

在工业实践中,PCA的应用仍然非常广泛。在计算机视觉领域,PCA被用于图像压缩、人脸识别和异常检测。在自然语言处理中,PCA被用于降低词向量的维度,加速文本分类和信息检索。在生物信息学中,PCA被用于分析基因表达数据,发现具有类似表达模式的基因。在金融领域,PCA被用于风险分析,通过将多个金融指标降维到少数几个主要的风险因子。在物联网和传感器数据分析中,PCA被用于处理来自数千个传感器的高维数据。

这些应用的共同点是什么呢?它们都面临着高维数据的挑战,都需要从复杂的数据中提取关键信息,都需要快速和可靠的处理方法。在这些场景中,PCA的简洁性和有效性使其成为了不二之选。而且,在许多情况下,PCA不是单独使用,而是与其他技术结合,比如与k-means聚类相结合进行聚类分析,与支持向量机相结合用于分类,或与自编码器结合进行混合降维。

10.3 PCA的局限性和未来方向

尽管PCA非常强大,但它仍然有一些局限性,这些局限性激励了许多研究和改进。非线性数据的处理仍然是PCA的一个主要挑战。虽然核PCA和其他非线性扩展已经发展了几十年,但在处理具有复杂非线性结构的数据时,这些方法往往不如深度学习的自编码器和变分自编码器有效。未来的研究方向包括开发更高效和更稳健的非线性降维方法,使其能够处理更大规模和更复杂的数据。

另一个重要的方向是如何更好地处理多模态和多视图数据。在现代应用中,数据往往来自多个不同的来源或具有多个不同的模态(比如图像和文本)。传统的PCA只能处理单个视图的数据。多视图PCA和多模态PCA的发展仍然是一个活跃的研究领域。

流式数据和在线学习是另一个重要的方向。随着物联网和实时数据处理的发展,越来越多的应用需要在数据不断到达的情况下进行降维。虽然增量PCA已经可以处理这种情况,但进一步改进算法的效率和准确性仍然是重要课题。

10.4 PCA与现代机器学习的融合

展望未来,PCA与现代机器学习技术的融合将是一个重要的发展方向。一个有趣的方向是将PCA与强化学习相结合,用于在高维状态空间中进行有效的特征提取。另一个方向是将PCA与联邦学习相结合,使得在保护数据隐私的情况下进行分布式的降维。还有研究探索如何使用PCA来加速大规模深度学习模型的训练。

同时,PCA的理论发展也在继续。贝叶斯PCA和概率PCA为PCA的应用提供了更加坚实的统计基础,使得我们可以量化降维中的不确定性,并更好地处理缺失值和噪声。流形学习与PCA的结合也在产生有趣的结果,使得我们能够同时处理线性和非线性的数据结构。

从更广的视角看,PCA代表了一种数据分析的哲学:通过寻找最简洁的表示来理解复杂的数据。在数据爆炸和模型复杂性不断增加的时代,这种简洁性和可解释性的哲学变得越来越珍贵。无论技术如何演进,这个核心理念的价值是恒久的。

10.5 PCA在教育和实践中的意义

从教育的角度看,PCA对于学习线性代数、统计学和机器学习都具有重要意义。PCA通过一个具体的、有实用价值的例子,展示了特征值分解、方差、相关性等数学概念在现实中的应用。学习PCA可以帮助学生建立数学理论与实践应用之间的桥梁。对于从事数据科学工作的人们来说,深入理解PCA的原理而不仅仅是学会使用库函数,对于他们成长为高水平的数据科学家至关重要。

在这篇长文中,我们从多个角度详尽地探讨了PCA:它解决的问题(维数灾难),它的数学基础(特征值分解、协方差矩阵),它的几何直观(坐标旋转、投影),它的实践应用(可视化、去噪、特征工程),它在机器学习中的角色(模型加速、特征预处理),以及它的局限性和改进方向。通过这些多层次的讨论和详细的代码示例,我们希望读者不仅能够使用PCA,更能够理解PCA的工作原理,知道什么时候该用PCA,什么时候需要考虑其他方法。

最后,值得强调的是,PCA虽然是一个经典的方法,但它在现代数据科学和机器学习中仍然是一个必不可少的工具。掌握PCA不仅能够解决实际问题,更能够为学习其他更高级的技术奠定坚实的基础。在数据科学的旅程中,PCA就像是一把锤子:看似简单,但在适当的情况下,它可以解决许多复杂的问题。