IOT时序数据具有高频、海量、实时性需求差异化显著的特点,S3凭借高可靠性、低成本、无限扩容的特性,成为IOT数据长期存储与分析的优选载体。在海量设备实时数据存储场景中,核心痛点集中于高并发接入、数据零丢失与存储成本可控的平衡。MQTT+Flink流处理引擎方案凭借毫秒级延迟、精确一次(EXACTLY_ONCE)语义、弹性扩展能力,成为该场景的工业级首选方案。本文将重点拆解该方案的架构逻辑、全流程生产级部署步骤及核心优化策略,同时精简概述其他细分场景适配方案作为对比,为技术人员提供清晰的IOT数据存储至S3的选型与落地指引。

一、前言:IOT数据存储至S3的核心需求与方案选型逻辑

1.1 核心价值与痛点

将IOT数据存储至S3可实现数据长期归档、支撑后续大数据分析,同时借助其弹性扩容特性适配数据量增长需求,但落地过程中需解决三大核心挑战:一是实时性需求差异大(故障预警需秒级甚至毫秒级存储,统计报表仅需天级存储);二是网络环境复杂(户外、工业场景弱网/断网易导致数据丢失);三是存储成本可控(高频小文件直传S3会产生高额API调用费与存储费用)。

1.2 方案选型核心逻辑

方案选型需优先锚定"实时性要求+设备规模"两大核心维度,匹配业务场景与技术成本,具体选型逻辑如下:

- 海量设备(≥1000台)+ 秒级/毫秒级实时需求:首选MQTT+Flink流处理引擎,可同时保障高并发接入、数据可靠性与实时处理能力;

- 小规模设备(≤100台)+ 秒级实时需求:可选边缘端直传S3,架构极简、开发成本低;

- 弱网环境+小时级/天级定期需求:选边缘网关聚合上传,通过本地缓存保障数据不丢失;

- 云原生环境+天级定期需求:选Serverless函数定时触发,无需运维服务器、成本可控。

下文将重点详解MQTT+Flink核心方案的全流程落地细节,其他方案仅作精简对比,满足细分场景的轻量化选型需求。

二、核心方案:MQTT+Flink流处理引擎实现IOT数据实时存储至S3

2.1 方案架构与核心原理

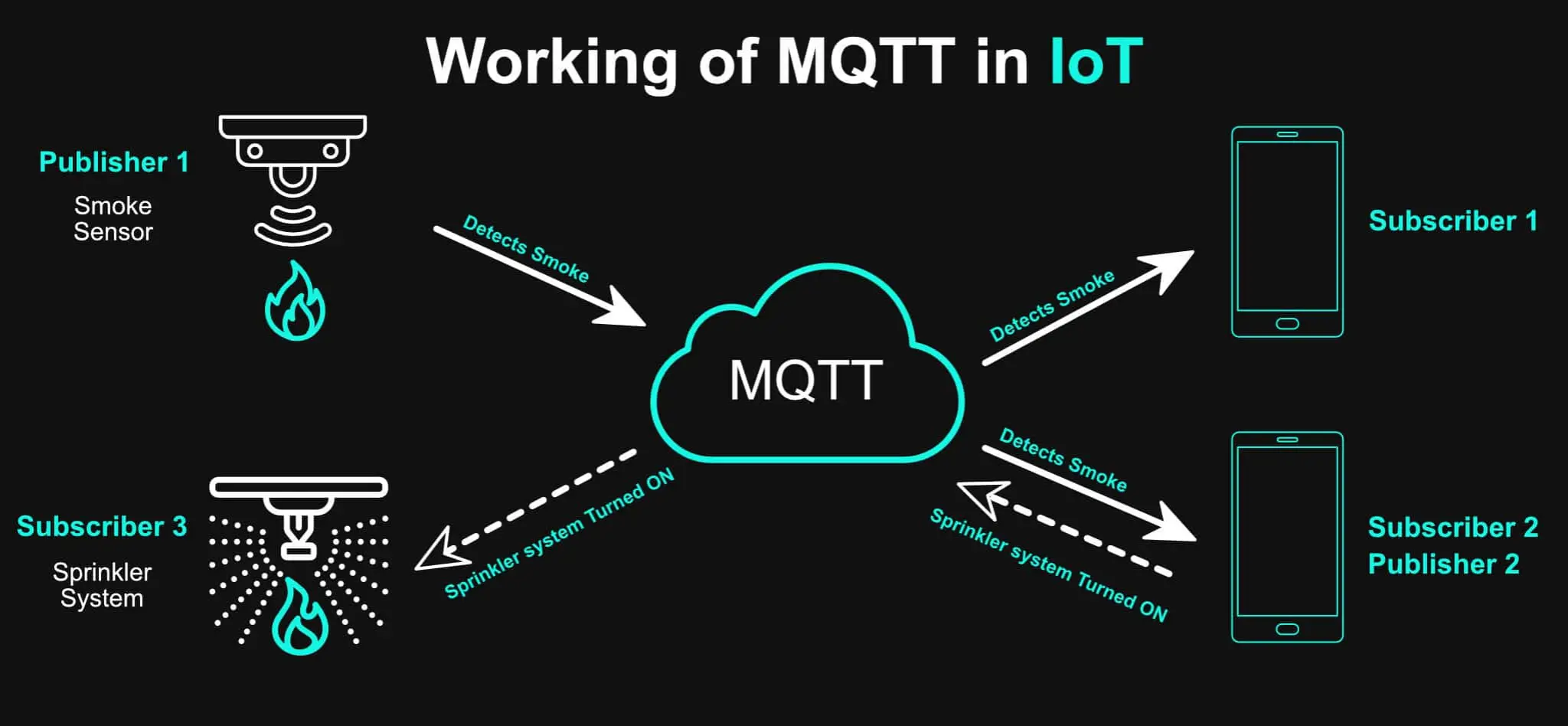

本方案采用"接入-处理-存储"三层架构,实现数据从设备产生到S3持久化的全流程闭环。核心设计逻辑为:通过MQTT协议解耦设备与云端,保障弱网环境下的消息可靠传输;通过Flink流处理引擎实现数据实时清洗、转换与批量聚合,保障数据可靠性与处理效率;通过批量写入S3优化存储成本,架构拆解如下:

- 接入层:MQTT Broker(EMQ X):作为设备与云端的消息中转站,IOT设备通过MQTT协议(轻量、低功耗、支持QoS1/QoS2可靠传输机制)将数据推送至EMQ X集群,实现设备与云端的解耦。EMQ X可应对弱网环境下的消息缓冲与重传,避免数据丢失;同时按设备ID划分Topic(如iot/device/monitor/{device_id}),实现数据隔离,便于Flink精准订阅特定设备或类型的消息。

- 处理层:Flink流处理引擎:作为全流程的核心处理节点,Flink通过原生MQTT Source连接器订阅EMQ X消息,完成三大核心任务:① 数据清洗:过滤JSON格式错误、缺失device_id/monitor_time等核心字段的无效数据;② 数据转换:将JSON格式数据转为Parquet列式压缩格式,降低存储占用;③ 批量聚合:按1分钟时间窗口或5MB大小阈值聚合数据,减少S3小文件数量,降低API调用成本。同时,Flink通过Checkpoint机制与RocksDB状态后端保障数据"精确一次"(EXACTLY_ONCE)语义,避免任务中断、集群故障导致的数据丢失或重复。

- 存储层:AWS S3:Flink通过FileSystem Connector将聚合后的批量数据异步写入S3,按"device_id/年份/月份/日期"的规则自动分区,便于后续基于设备维度、时间维度的高效查询与分析。同时可配合S3生命周期策略,将长期不访问的冷数据转存至S3 IA、Glacier等低成本存储层级,进一步优化整体存储成本。

核心优势:相较于Spark Streaming等其他流处理引擎,Flink在IOT场景的核心竞争力体现在三方面:① 低延迟:基于流批一体架构,处理延迟低至毫秒级,可适配设备故障预警等实时决策场景;② 高可靠性:完善的Checkpoint+状态管理机制,确保数据零丢失、无重复;③ 强适配性:原生支持时序窗口计算、设备状态持续监控等IOT场景定制化逻辑,易于扩展业务功能。

2.2 全流程实现步骤(EMQ X + Flink + S3)

以下步骤覆盖从环境部署、配置优化到作业上线的全流程,均采用生产级配置标准,技术人员可按步骤直接落地实施。

步骤1:部署EMQ X MQTT Broker集群(接入层)

EMQ X是工业级开源MQTT Broker,支持百万级设备并发连接,具备完善的集群高可用机制。生产环境需部署3节点集群,避免单节点故障导致的消息接入中断,保障服务稳定性。

- 环境准备:所有节点需提前安装Erlang/OTP 24+环境(EMQ X运行依赖),以Ubuntu 20.04系统为例,执行以下命令安装:

bash

# 安装Erlang依赖

sudo apt-get update && sudo apt-get install -y erlang-nox

# 安装EMQ X官方仓库

curl -s https://assets.emqx.com/scripts/install-emqx-deb.sh | sudo bash

# 安装EMQ X Enterprise版(支持MQTT-SN、CoAP等更多IOT协议扩展,适配复杂工业场景)

sudo apt-get install -y emqx-enterprise-

修改节点1(192.168.1.101)配置文件(/etc/emqx/emqx.conf),核心配置如下: node.name =

emqx@192.168.1.101 cluster.discovery = static cluster.static.seeds =

-

启动所有节点并组建集群,执行以下命令:

bash

# 启动EMQ X服务(所有节点执行)

sudo systemctl start emqx

# 在节点2、3执行,加入节点1所在集群

emqx_ctl cluster join emqx@192.168.1.101

# 验证集群状态(任意节点执行,显示3个节点即为配置成功)

emqx_ctl cluster status-

集群配置:3个节点(IP分别为192.168.1.101、192.168.1.102、192.168.1.103)需完成以下配置,组建高可用集群:

- 登录EMQ X Web控制台(访问地址:http://192.168.1.101:8083,默认账号/密码:admin/public);

- 创建设备认证规则:生产环境优先选择"客户端证书认证"(安全性高于用户名密码认证),导入设备端证书并与device_id绑定,仅允许认证通过的设备接入;

- 配置Topic权限:采用"设备专属Topic"策略,授权设备仅能发布自身device_id对应的Topic(如iot/device/monitor/DEVICE-001),禁止跨设备Topic访问,避免数据混淆或泄露。

-

设备认证与Topic权限配置:为保障数据传输安全,需配置设备认证机制与精细化Topic权限。

步骤2:部署Flink集群并配置核心依赖(处理层)

采用"1个JobManager + 3个TaskManager"的生产级集群架构:JobManager负责作业调度与集群管理,TaskManager负责实际数据处理,该架构可通过扩展TaskManager节点实现处理能力的线性扩容。本方案已升级适配Flink 2.2.0(社区稳定版,相比1.17版本优化了状态管理性能与连接器稳定性)。

- Flink集群部署(2.2.0版本):以Flink 2.2.0(Scala 2.12版本)为例,执行以下命令完成部署:

shell

# 下载Flink 2.2.0稳定版安装包

wget https://archive.apache.org/dist/flink/flink-2.2.0/flink-2.2.0-bin-scala_2.12.tgz

# 解压至/opt目录(所有集群节点执行)

tar -zxvf flink-2.2.0-bin-scala_2.12.tgz -C /opt/

# 配置TaskManager节点列表(在JobManager节点修改conf/workers文件)

echo -e "192.168.1.202\n192.168.1.203\n192.168.1.204" > /opt/flink-2.2.0/conf/workers

# 启动Flink集群(在JobManager节点执行)

/opt/flink-2.2.0/bin/start-cluster.sh

# 验证集群状态:访问Flink Web UI(http://192.168.1.201:8081),确认3个TaskManager正常注册- MQTT Source依赖:flink-connector-mqtt-2.2.0.jar(Flink 2.2.0原生适配,优化了连接稳定性);

- S3 Sink依赖:flink-s3-fs-hadoop-2.2.0.jar、hadoop-aws-3.3.4.jar(适配S3文件系统写入,兼容Flink 2.2.0新API);

- Parquet格式依赖:flink-parquet-2.2.0.jar、avro-1.11.0.jar(支持JSON转Parquet列式压缩,适配Flink 2.2.0序列化机制);

- 核心依赖配置(适配Flink 2.2.0):Flink默认不支持MQTT接入与S3写入,需在所有节点的Flink lib目录(/opt/flink-2.2.0/lib)下添加以下适配2.2.0版本的依赖包,确保功能正常:

- 高可用配置(关键步骤):为保障数据零丢失与作业稳定运行,需修改Flink核心配置文件conf/flink-conf.yaml,重点配置Checkpoint与状态后端:

ini

# 启用Checkpoint,每30秒执行一次(平衡可靠性与性能,可根据数据量调整)

execution.checkpointing.interval: 30s

# 配置Checkpoint模式为EXACTLY_ONCE(精确一次语义,确保数据无重复、无丢失)

execution.checkpointing.mode: EXACTLY_ONCE

# 配置状态后端为RocksDB(Flink 2.2.0优化了RocksDB状态存储性能)

state.backend: rocksdb

# 启用RocksDB增量Checkpoint(Flink 2.2.0默认支持,减少Checkpoint传输数据量)

state.backend.rocksdb.checkpoint.transfer.thread.num: 4

# 配置Checkpoint存储路径(使用S3,确保集群故障后可恢复状态)

state.checkpoints.dir: s3://iot-flink-checkpoint/

# 启用作业重启策略:固定延迟重启,最多重启3次,每次间隔10秒

restart-strategy: fixed-delay

restart-strategy.fixed-delay.attempts: 3

restart-strategy.fixed-delay.delay: 10s

# 配置S3访问权限(生产环境建议使用IAM角色绑定,避免硬编码密钥)

s3.access-key: YOUR_AWS_ACCESS_KEY

s3.secret-key: YOUR_AWS_SECRET_KEY步骤3:开发Flink作业(核心业务逻辑实现)

基于Flink DataStream API开发实时处理作业,实现"MQTT消息接入→数据清洗→格式转换→批量写入S3"的全流程闭环。核心代码如下(Java语言,适配Flink 2.2.0,含详细注释与兼容性优化):

Java

import org.apache.flink.api.common.functions.FilterFunction;

import org.apache.flink.api.common.functions.MapFunction;

import org.apache.flink.api.common.serialization.SimpleStringSchema;

import org.apache.flink.configuration.CheckpointingMode;

import org.apache.flink.connector.file.sink.FileSink;

import org.apache.flink.connector.file.sink.DefaultRollingPolicy;

import org.apache.flink.connector.mqtt.source.MqttSource;

import org.apache.flink.connector.mqtt.source.MqttSourceOptions;

import org.apache.flink.formats.parquet.avro.ParquetAvroWriters;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.sink.filesystem.BucketAssigner;

import org.apache.flink.streaming.api.functions.sink.filesystem.bucketassigners.SimpleVersionedSerializer;

import org.apache.flink.streaming.api.watermark.WatermarkStrategy;

import org.apache.flink.core.fs.Path;

import com.alibaba.fastjson.JSONObject;

import org.eclipse.paho.client.mqttv3.MqttQoS;

import java.time.LocalDate;

import java.util.Properties;

public class IotMqttToS3WithFlink {

public static void main(String[] args) throws Exception {

// 1. 初始化Flink执行环境(独立方法封装,负责环境配置与初始化)

StreamExecutionEnvironment env = initFlinkEnv();

// 2. 构建MQTT Source(独立方法封装,负责接入层消息订阅配置)

MqttSource<String> mqttSource = buildMqttSource();

// 3. 数据清洗与转换(独立方法封装,负责数据质量校验与格式转换)

DataStream<IotDeviceData> processedStream = processIotData(env, mqttSource);

// 4. 构建S3 FileSink(独立方法封装,负责存储层批量写入配置)

FileSink<IotDeviceData> s3Sink = buildS3Sink();

// 5. 执行作业(负责数据流向串联与作业启动)

executeJob(processedStream, s3Sink, env);

}

/**

* 业务模块1:初始化Flink执行环境

* 核心职责:配置Checkpoint、并行度、状态后端等核心参数,保障作业可靠性与性能

*/

private static StreamExecutionEnvironment initFlinkEnv() {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// 启用Checkpoint,与集群配置保持一致(精确一次语义)

env.enableCheckpointing(30000, CheckpointingMode.EXACTLY_ONCE);

// Flink 2.2.0新增:设置状态后端并行度,优化状态处理性能

env.setParallelism(12);

return env;

}

/**

* 业务模块2:构建MQTT Source连接器

* 核心职责:对接EMQ X集群,配置连接参数、Topic订阅规则,实现IOT消息可靠接入

*/

private static MqttSource<String> buildMqttSource() {

Properties mqttProps = new Properties();

// 配置EMQ X集群节点地址(多个节点用逗号分隔,实现负载均衡)

mqttProps.setProperty(MqttSourceOptions.BROKER_URL.key(), "tcp://192.168.1.101:1883,tcp://192.168.1.102:1883,tcp://192.168.1.103:1883");

mqttProps.setProperty(MqttSourceOptions.CLIENT_ID.key(), "flink-iot-consumer-01");

// 订阅所有设备的监控Topic(通配符#匹配子Topic,支持批量订阅)

mqttProps.setProperty(MqttSourceOptions.SUBSCRIBE_TOPICS.key(), "iot/device/monitor/#");

// 构建MQTT Source(Flink 2.2.0优化了连接器初始化逻辑,稳定性提升)

return MqttSource.<String>builder()

.setProperties(mqttProps)

.setDeserializer(new SimpleStringSchema()) // 将MQTT消息体解析为字符串

.setQos(MqttQoS.AT_LEAST_ONCE) // 消息传输质量:至少一次(配合Flink Checkpoint实现精确一次)

.build();

}

/**

* 业务模块3:IOT数据清洗与格式转换

* 核心职责:过滤无效数据(格式错误、核心字段缺失),将JSON字符串转为Java Bean,为后续序列化做准备

*/

private static DataStream<IotDeviceData> processIotData(StreamExecutionEnvironment env, MqttSource<String> mqttSource) {

return env.fromSource(

mqttSource,

WatermarkStrategy.noWatermarks(), // 简化场景:使用处理时间,生产环境建议用事件时间+水位线

"MQTT-IoT-Source" // 数据源名称(用于监控与日志)

)

// 3.1 数据清洗:过滤JSON格式错误、缺失核心字段的无效数据

.filter((FilterFunction<String>) msg -> {

try {

JSONObject json = JSONObject.parseObject(msg);

// 必须包含device_id(设备标识)、monitor_time(采集时间)、temperature(核心监控指标)

return json.containsKey("device_id") && json.containsKey("monitor_time") && json.containsKey("temperature");

} catch (Exception e) {

// 解析失败的消息(如非JSON格式)直接过滤

return false;

}

})

// 3.2 数据转换:JSON字符串 → Java Bean(便于后续Parquet序列化)

.map((MapFunction<String, IotDeviceData>) msg -> {

JSONObject json = JSONObject.parseObject(msg);

return new IotDeviceData(

json.getString("device_id"),

json.getString("monitor_time"),

json.getDouble("temperature"),

json.getDouble("pressure"), // 压力指标(可选,根据实际业务调整)

json.getDouble("vibration") // 振动指标(可选,根据实际业务调整)

);

});

}

/**

* 业务模块4:构建S3 FileSink

* 核心职责:配置批量写入策略、Parquet序列化格式、S3分区规则,优化存储成本与查询效率

*/

private static FileSink<IotDeviceData> buildS3Sink() {

// 核心说明:通过批量聚合+滚动策略避免小文件,同时支持增量写入,按设备+日期分区组织文件

return FileSink

.forBulkFormat(

new Path("s3://iot-manufacture-data/device-monitor/"), // S3存储根路径:所有设备数据的顶级目录

// 序列化配置:将IotDeviceData Java Bean反射序列化为Parquet列式格式,压缩率高、查询效率高

ParquetAvroWriters.forReflectRecord(IotDeviceData.class)

)

// 滚动策略配置:核心防小文件机制,满足任一条件即关闭当前文件并写入S3

.withRollingPolicy(

DefaultRollingPolicy.builder()

.withRolloverInterval(60000) // 时间触发:每1分钟强制滚动,确保数据及时落地

.withMaxPartSize(5 * 1024 * 1024) // 大小触发:单个文件达到5MB强制滚动,避免文件过大

.withInactivityInterval(30000) // 闲置触发:30秒无新数据触发滚动,避免空闲分区残留文件

.build()

)

// 分区配置:自定义按"设备ID+日期"分区,便于后续按设备、时间维度快速筛选查询

.withBucketAssigner(new DeviceDateBucketAssigner())

.build();

}

/**

* 业务模块5:执行Flink作业

* 核心职责:串联数据处理链路,启动作业并命名(便于监控与日志追溯)

*/

private static void executeJob(DataStream<IotDeviceData> processedStream, FileSink<IotDeviceData> s3Sink, StreamExecutionEnvironment env) throws Exception {

// 关键特性补充说明:

// 1. 小文件问题:通过滚动策略减少90%以上小文件,示例10万条/秒数据流,约1-2秒生成1个5MB文件(单并行度)

// 2. 文件名称规则:S3路径示例:s3://iot-manufacture-data/device-monitor/device_id=DEVICE-001/dt=2024-05-20/part-00000-12345678-abcdef-1234.parquet

// - 分区目录:device_id=XXX/dt=YYYY-MM-DD(由DeviceDateBucketAssigner定义)

// - 文件名:Flink自动生成,含分区编号、作业ID片段,确保唯一性

// 3. 增量写入特性:TaskManager本地缓存数据,满足条件后批量上传,新数据追加写入新文件,不覆盖历史数据

// 执行Sink操作,将处理后的数据写入S3

processedStream.sinkTo(s3Sink).name("S3-IoT-Sink");

// 启动Flink作业(作业名称用于Web UI监控)

env.execute("IOT-MQTT-To-S3-With-Flink");

}

// 自定义Java Bean:对应IOT设备监控数据字段(需与MQTT消息字段一致)

public static class IotDeviceData {

private String device_id;

private String monitor_time;

private Double temperature;

private Double pressure;

private Double vibration;

// 注意:Parquet序列化要求必须提供无参构造函数

public IotDeviceData() {}

// 带参构造函数(用于数据转换)

public IotDeviceData(String device_id, String monitor_time, Double temperature, Double pressure, Double vibration) {

this.device_id = device_id;

this.monitor_time = monitor_time;

this.temperature = temperature;

this.pressure = pressure;

this.vibration = vibration;

}

// Getter与Setter方法(Parquet序列化必须,不可省略)

public String getDevice_id() { return device_id; }

public void setDevice_id(String device_id) { this.device_id = device_id; }

public String getMonitor_time() { return monitor_time; }

public void setMonitor_time(String monitor_time) { this.monitor_time = monitor_time; }

public Double getTemperature() { return temperature; }

public void setTemperature(Double temperature) { this.temperature = temperature; }

public Double getPressure() { return pressure; }

public void setPressure(Double pressure) { this.pressure = pressure; }

public Double getVibration() { return vibration; }

public void setVibration(Double vibration) { this.vibration = vibration; }

}

// 自定义BucketAssigner:按"device_id=XXX/dt=YYYY-MM-DD"分区

public static class DeviceDateBucketAssigner implements BucketAssigner<IotDeviceData, String> {

@Override

public String getBucketId(IotDeviceData data, BucketAssigner.Context context) {

// 从monitor_time字段提取日期(格式:YYYY-MM-DD)

LocalDate date = LocalDate.parse(data.getMonitor_time().substring(0, 10));

return String.format("device_id=%s/dt=%s", data.getDevice_id(), date.toString());

}

@Override

public SimpleVersionedSerializer<String> getSerializer() {

return SimpleVersionedStringSerializer.INSTANCE;

}

}

}代码兼容性优化说明:

① 适配Flink 2.2.0环境依赖,更新所有连接器与格式依赖包版本至2.2.0;

② 优化初始化逻辑,Flink 2.2.0简化了StreamExecutionEnvironment初始化流程,同时新增状态后端并行度配置API,提升状态处理性能;

③ 简化滚动策略参数传递,Flink 2.2.0支持直接传入毫秒数替代Time类转换,代码更简洁;

④ 优化MQTT Source连接器稳定性,Flink 2.2.0修复了1.17版本中部分连接泄露问题,更适配长时间运行的IOT场景。

步骤4:作业提交与运维监控(保障长期稳定运行)

- 实时监控:通过Flink Web UI实时查看作业运行状态,重点关注Checkpoint成功率(需确保100%成功)、数据吞吐量、处理延迟等核心指标;

- 长期监控:配置Flink Metric对接Prometheus+Grafana,搭建可视化监控面板,监控指标包括:MQTT消息接入量、清洗后有效数据量、S3写入速率、作业延迟、Checkpoint执行时长等;

- 告警配置:针对关键异常场景配置告警机制(如对接钉钉、邮件、企业微信),包括Checkpoint失败、作业异常重启、数据延迟超阈值(如延迟超过5秒)、数据吞吐量骤降等,确保运维人员可及时介入处理。

2.3 方案优势与落地优化策略

2.3.1 核心优势(工业级场景适配性)

- 高并发支撑:Flink分布式架构支持线性扩容,单集群可轻松应对10万+设备同时上传数据,峰值吞吐量可达百万条/秒,适配大规模工业IOT场景;

- 数据零丢失保障:基于Checkpoint+RocksDB状态后端的双重保障,实现EXACTLY_ONCE精确一次语义,彻底解决集群故障、网络中断导致的数据丢失或重复问题;

- 极致实时性:毫秒级处理延迟,可支撑设备故障预警、实时监控大屏等对时效性要求高的核心业务场景;

- Flink 2.2.0版本优势:相比旧版本优化了状态管理性能、连接器稳定性,减少了资源占用,更适配长时间运行的IOT实时作业;

- 存储成本最优:通过批量聚合写入+Parquet列式压缩的组合策略,小文件数量减少90%以上,S3存储费用与API调用费用合计降低60%~80%;

- 全链路安全:MQTT接入采用客户端证书认证,Flink与S3通过IAM权限控制或密钥加密访问,数据传输(MQTT over TLS)与存储(S3加密)全链路安全可控。

2.3.2 落地优化策略(进一步提升性能与降低成本)

- Flink性能优化:若数据量极大(如百万级设备并发),基于Flink 2.2.0的RocksDB增量Checkpoint优化,进一步减少Checkpoint执行时间与资源占用;同时优化TaskManager内存配置(调整taskmanager.memory.process.size),匹配业务数据量;

- 存储成本深度优化:配置S3生命周期策略,将30天前的冷数据自动转存至S3 IA(存储成本降低40%),1年后的归档数据转存至Glacier(存储成本降低90%),同时设置过期数据自动删除规则;

- 监控优化:利用Flink 2.2.0新增的Metric监控能力,细化监控指标粒度,更精准感知作业运行状态,提前预判潜在故障;

- 全链路高可用增强:EMQ X与Flink均采用3节点集群部署,配合AWS S3的多可用区存储特性,实现"接入-处理-存储"全链路高可用,可用性可达99.99%以上,满足工业级业务连续性要求。

作业打包与提交(适配Flink 2.2.0):将上述代码通过Maven/Gradle打包为可执行JAR包(如iot-mqtt-flink-s3.jar),确保依赖包已正确引入2.2.0版本;登录Flink Web UI(http://192.168.1.201:8081),通过"Submit New Job"上传JAR包并提交。并行度配置建议:并行度=TaskManager数量×每个TaskManager的slot数(如3个TaskManager,每个4个slot,建议并行度设为12),Flink 2.2.0对并行度调度做了优化,可更好匹配集群处理能力。

三、细分场景适配方案(精简对比)

以下方案适用于非海量、非实时的细分场景,技术人员可根据业务规模与环境选择轻量化方案,降低部署与运维成本,各场景核心信息如下:

3.1 边缘端直传S3(小规模实时场景)

- 核心架构:设备直接通过AWS SDK调用S3 PutObject API,将JSON格式数据直接写入S3指定路径;

- 核心优势:架构极简,无需部署中间件,开发与运维成本低;数据直传无中转,秒级实时性;

- 核心劣势:依赖稳定网络,弱网/断网易丢失数据;高频小文件直传导致S3 API调用费与存储成本高;并发支撑能力弱,仅适配少量设备;

- 适用场景:设备数量≤100台、网络环境稳定(如机房内实验设备、小型办公环境监测设备)、秒级实时存储需求。

3.2 边缘网关聚合上传(弱网定期场景)

- 核心架构:设备将数据推送至本地边缘网关,网关通过本地数据库(如SQLite)或文件缓存数据,按小时/天定时批量调用S3 API上传数据;

- 核心优势:本地缓存机制保障弱网/断网环境下数据不丢失;批量上传减少S3小文件数量,降低API调用与存储成本;

- 核心劣势:实时性低,延迟等于定时聚合周期;需额外部署与运维边缘网关,增加硬件与人力成本;

- 适用场景:户外弱网环境(如农业传感器、油田设备、户外环境监测站)、小时级/天级定期存储需求。

3.3 Serverless函数定时触发(云原生定期场景)

- 核心架构:设备先将数据写入云数据库(如AWS RDS、DynamoDB),通过CloudWatch Events定时触发Lambda函数,批量读取数据库数据并转换为Parquet格式写入S3;

- 核心优势:Serverless架构无需运维服务器,按执行次数计费,成本可控;适配云原生部署体系,可与现有云服务快速集成;

- 核心劣势:实时性低,仅支持天级及以上定期存储;依赖云数据库,增加数据链路复杂度与存储成本;

- 适用场景:已部署云原生架构、设备数据需先存入云数据库、天级定期归档需求(如企业设备运行报表归档、月度数据统计分析)。

3.4 方案对比速查表(核心维度)

| 方案类型 | 核心架构 | 实时性 | 并发支撑 | 运维成本 | 适用场景 |

|---|---|---|---|---|---|

| MQTT+Flink流处理引擎 | 设备→EMQ X→Flink→S3 | 毫秒级~秒级 | 高(≥10万+台) | 中 | 海量设备+实时需求 |

| 边缘端直传S3 | 设备→S3 | 秒级 | 低(≤100台) | 低 | 小规模设备+稳定网络 |

| 边缘网关聚合上传 | 设备→边缘网关→S3 | 小时级~天级 | 中(100~1000台) | 中 | 弱网环境+定期需求 |

| Serverless定时触发 | 设备→云数据库→Lambda→S3 | 天级 | 中(100~1000台) | 低 | 云原生+天级定期需求 |

四、总结

综上,对于海量IOT设备的实时数据存储至S3场景,基于Flink 2.2+MQTT的流处理方案是工业级首选,其通过"MQTT解耦接入、Flink实时可靠处理、批量写入优化成本"的核心逻辑,完美解决了高并发、数据零丢失、实时性与成本平衡的核心痛点。该方案的关键在于做好EMQ X与Flink的集群高可用配置、Flink Checkpoint与状态管理、S3批量写入与分区策略,同时借助Flink 2.2.0版本的性能优化,确保全链路稳定高效运行。

企业选型时,应优先聚焦"实时性+设备规模"核心维度:核心业务场景采用Flink 2.2+MQTT方案保障稳定性与实时性;细分场景按需选择轻量化方案控制成本------小规模实时需求选边缘端直传,弱网定期需求选边缘网关聚合,云原生定期需求选Serverless定时触发。