2025年的跨年夜,当大多数人还在倒数计时迎接新年的时候,DeepSeek的团队干了一件非常极客的事------他们甩出了一篇重磅论文。

这篇名为《mHC: Manifold-Constrained Hyper-Connections》的论文,看似标题充满了晦涩的数学名词,但实际上,它可能刚刚解开了困扰大模型界已久的一个死结:模型越大,越容易练崩。

今天我们就抛开那些复杂的公式,用人话聊聊这项可能定义"后Transformer时代"的新技术。

贪婪的代价:当"宽带"变成灾难

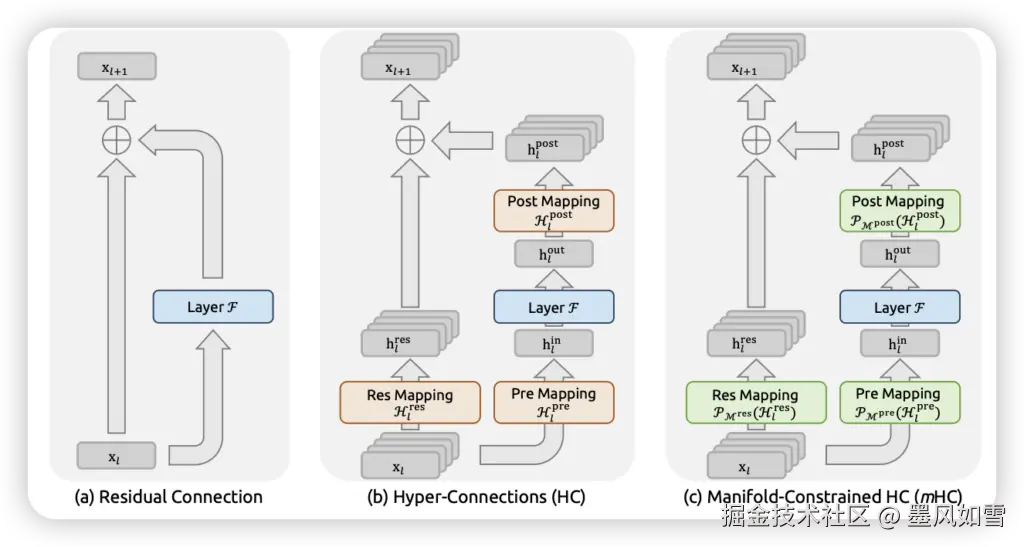

过去这十年,深度学习能发展这么快,何凯明大神的ResNet(残差连接)功不可没。你可以把它想象成一条"直通车道",保证了信息在深层网络中不会迷路。

到了2024年,字节跳动搞出了一个叫"超连接"(Hyper-Connections, HC)的东西。思路很直接:既然一条直通车道好用,那我把车道拓宽成十条、百条,让信息在不同车道间随意穿梭、交互,模型能力岂不是要起飞?

确实,HC让模型的表达能力变强了,但也带来了一个致命副作用------信号失控。

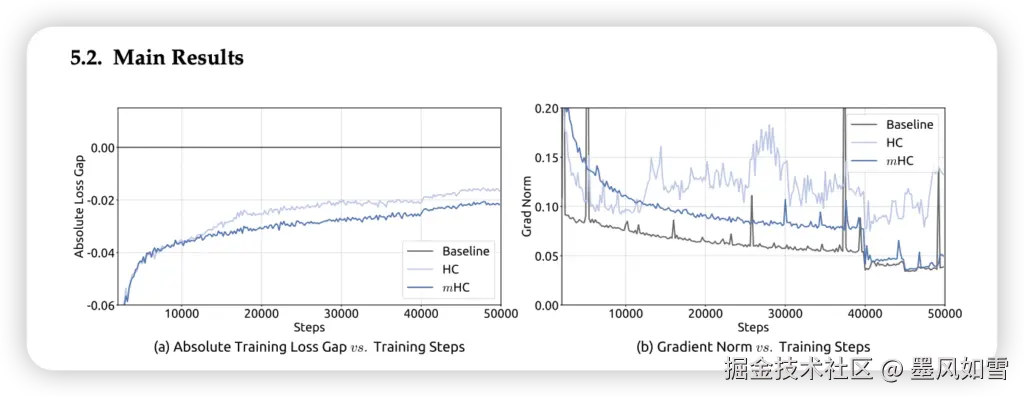

想象一下,你把原来的单行道改成了一个没有交通规则的超级广场。信息在里面疯狂碰撞、叠加。DeepSeek的实验数据显示,在传统的HC架构下,随着层数加深,信号强度可能会被无脑放大3000倍。这就好比你在麦克风前轻声说句话,音响里出来的却是核爆般的噪音。

结果就是:显存爆炸,梯度消失,训练曲线像过山车一样出现尖峰,最后模型彻底"练废了"。

戴着镣铐跳舞:mHC的优雅解法

DeepSeek提出的mHC(流形约束超连接),本质上就是给那个混乱的超级广场装上了一套极其精密的"智能红绿灯系统"。

这里的核心魔法在于**"流形约束"**。

团队引入了数学上的"双随机矩阵"概念。简单来说,他们通过一个叫Sinkhorn-Knopp的经典算法,强制要求网络中的每一次信息交换都必须遵守一个规则:能量守恒。不管信息怎么变道、怎么混合,进去多少能量,出来还是多少能量。

这种做法把原本狂野的信号放大变成了信号的"凸组合"(Convex Combination)。这就像调鸡尾酒,不管你怎么摇晃混合,酒的总量不会凭空变多,也不会凭空消失。

这一改,奇迹发生了。

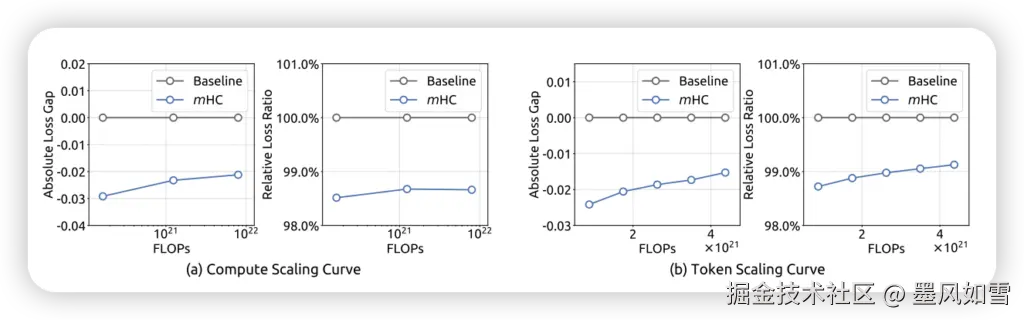

原本可能放大3000倍的信号,现在被稳稳控制在1.6倍左右。那条原本还要靠运气才能跑通的训练曲线,瞬间变得丝般顺滑。

极其抠门的工程优化

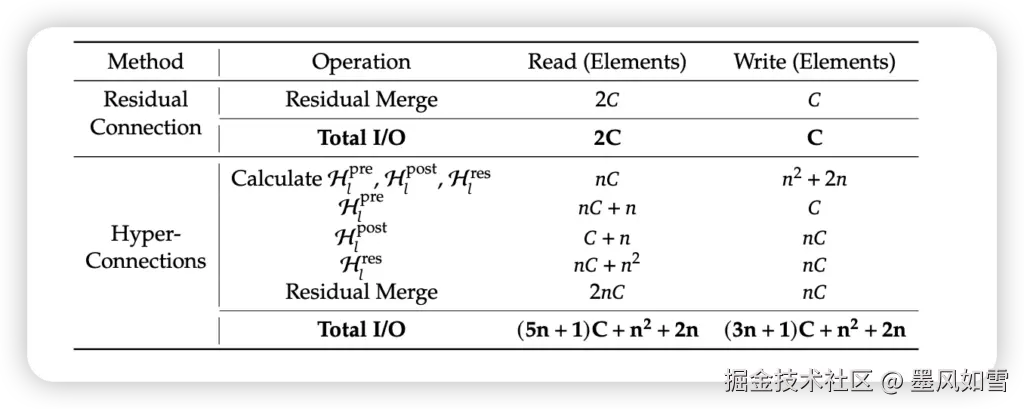

光有数学理论没用,如果跑得慢,工业界根本不会看一眼。DeepSeek这帮人最可怕的地方在于,他们不仅懂数学,还极其擅长抠算力。

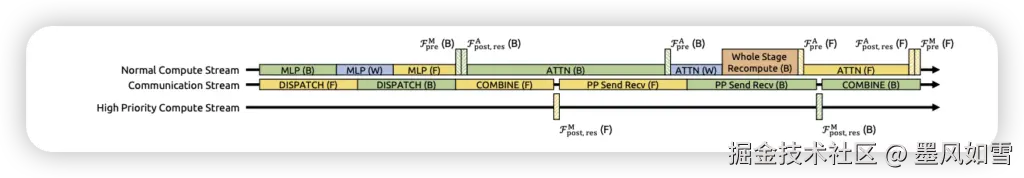

为了把这个复杂的数学约束搬到GPU上跑,他们做了一系列"丧心病狂"的优化:

- 算子融合:把好几个计算步骤揉成一步做,减少GPU读取内存的次数。

- 选择性重计算:为了省显存,有些中间结果算完就扔,需要时再算,而且他们算准了哪些该扔、哪些该留。

结果如何?在把模型宽度扩展4倍的情况下,mHC架构只增加了**6.7%**的额外训练时间。这就好比你给法拉利换了个更稳的引擎,极速没掉,油耗也没怎么涨。

实战:27B模型的全面碾压

DeepSeek没在小模型上玩过家家,直接拿27B参数的模型开刀。

实验结果非常"凡尔赛":

- 稳:那些让工程师头秃的Loss尖峰完全消失。

- 强:在数学推理(GSM8K)、常识问答(BBH)等8项硬核测试中,全面吊打基线模型。特别是在需要绕弯子思考的BBH和DROP任务上,直接提升了约2%的性能。

为什么这很重要?

你可能会觉得,这不就是一个架构微调吗?

其实不然。mHC的出现标志着大模型设计的一个转折点。它告诉我们,单纯地堆参数、堆层数已经快走到头了。未来的方向,是研究层与层之间如何更"几何"地连接。

DeepSeek用mHC证明了:在这个算力昂贵的时代,数学上的严谨约束,反而是通向更大自由度的捷径。

这不仅仅是让大厂能更稳地训练万亿模型,也让资源有限的团队不再因为一次"炸炉"而倾家荡产。这就是技术的浪漫之处------用最抽象的数学,解决最现实的难题。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站