序言:奇点临近,可观测性的代际跨越

站在 2026 年的时间节点回望,我们正处于 IT 基础设施历史上最深刻的变革之中。这不仅是云计算的延续,更是一场由人工智能(AI)主导的"认知革命"。如果说云原生(Cloud Native)时代解决了资源的弹性问题,那么 AI 原生(AI Native)时代则致力于解决决策的自主性问题。

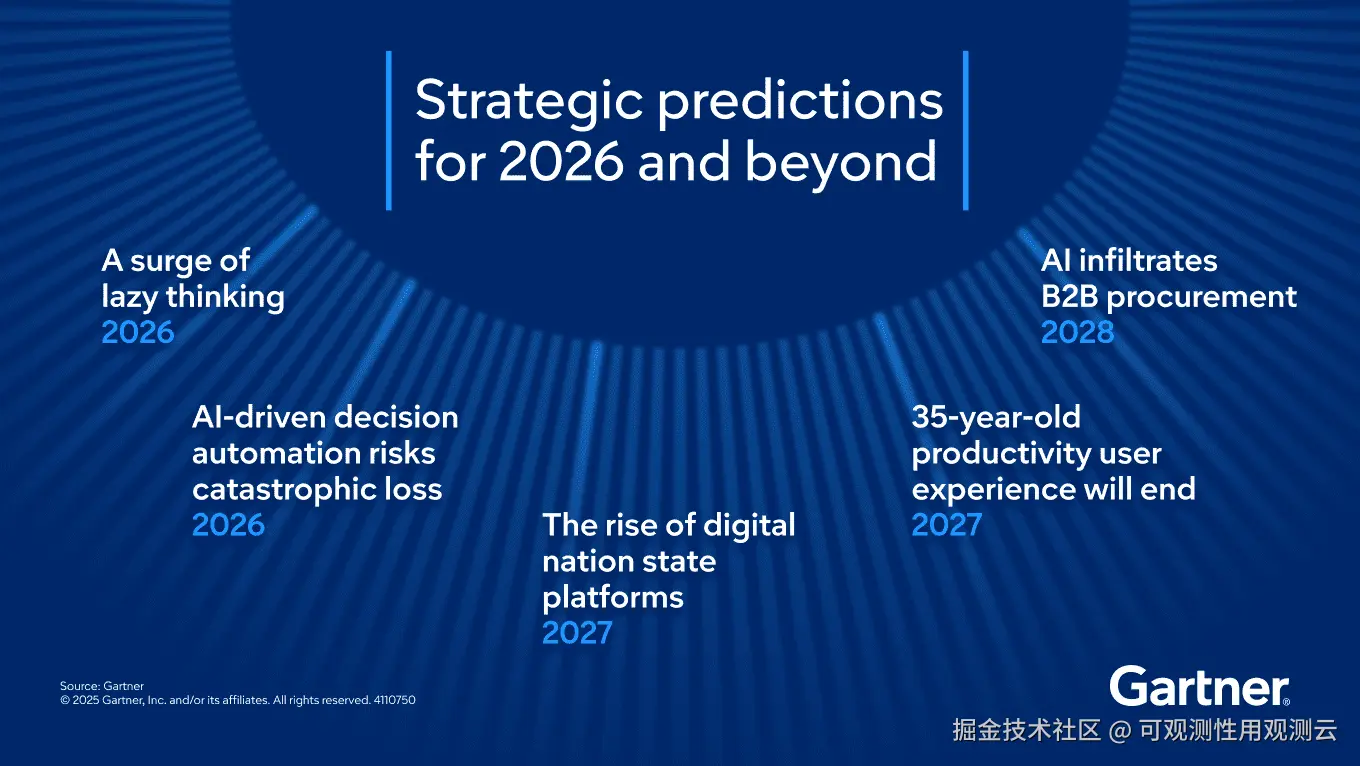

Gartner 的战略预测早已指出,到 2026 年底,由于缺乏足够的 AI 风险护栏,甚至可能出现数千起因 AI 决策失误导致的法律索赔案件。这一预测不仅揭示了 AI 技术的双刃剑效应,更深刻地指出了当前技术栈中最大的空白------对于自主智能体(Autonomous Agents)的深度可观测性与治理能力。

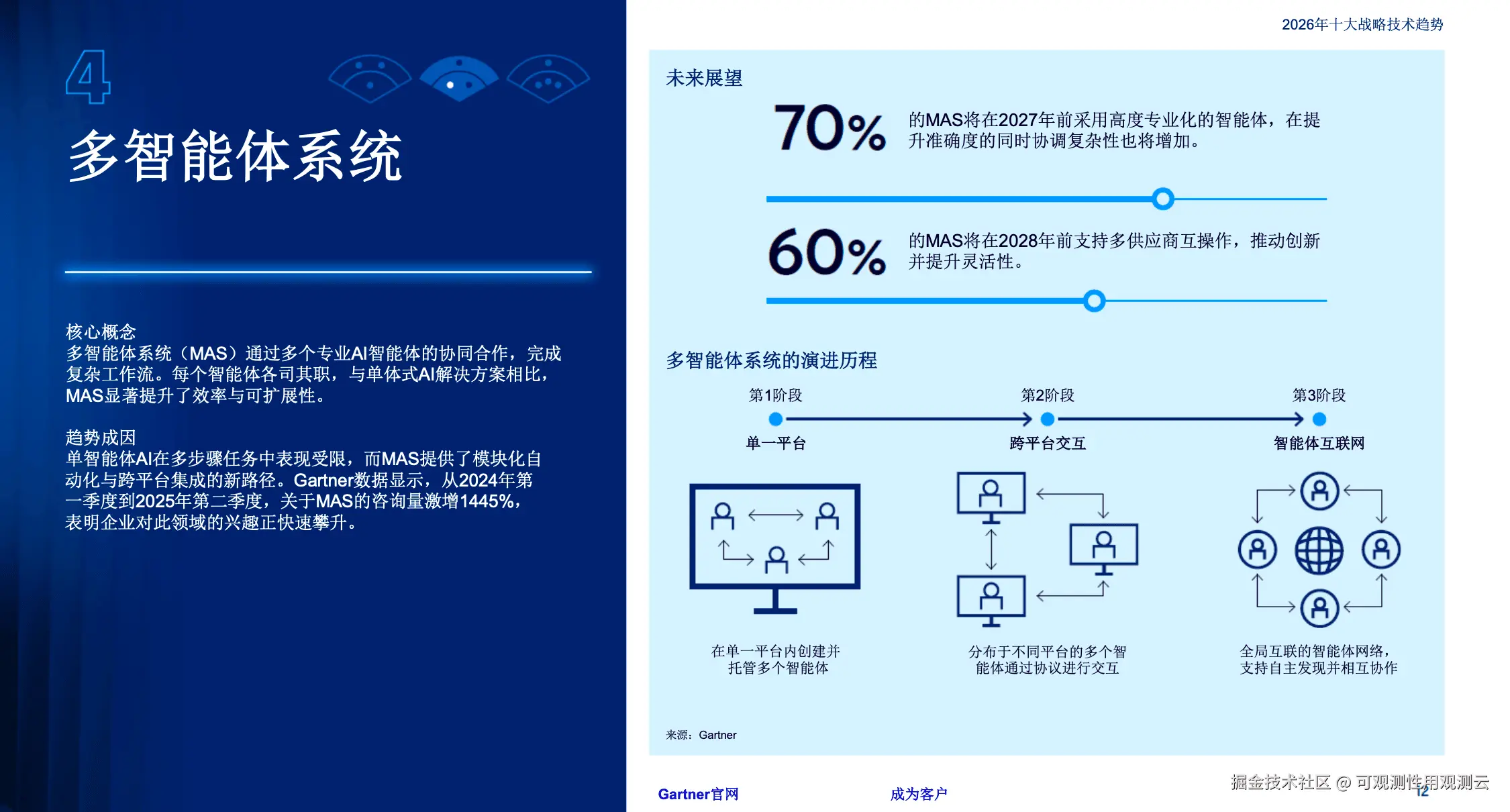

在 2026 年的企业环境中,由于 Agentic AI 的普及,软件不再仅仅是执行预定义代码的静态指令集,而是变成了具有推理、规划和执行能力的"数字员工"。这些智能体像 F1 赛车的维修团队一样协作,以模块化的方式处理复杂的业务逻辑。然而,这种自主性带来了前所未有的不确定性:一个简单的用户请求可能触发成百上千次非确定性的模型推理、工具调用和数据库交互。传统的应用性能监控(APM)工具,基于确定性的堆栈跟踪和静态的拓扑图,已无法完全解释这种动态生成的行为链路。

与此同时,数据重力的法则依然生效且愈发严苛。随着生成式 AI 和多模态交互的爆发,企业产生的数据量呈指数级增长,但 IT 预算的增长却远远滞后。如何在数据爆炸的背景下,既保持对所有信号的敏锐捕捉,又严格控制存储成本,成为了 SRE 和 CIO 面临的头号难题。传统的"索引一切"(Index Everything)的日志管理模式在经济上已然破产,市场迫切呼唤一种全新的、基于存算分离架构的数据底座。

本文将作为观测云(Guance)2026 年的产品技术展望,深入剖析在这一大变革背景下,我们如何通过产品演进解决测试、业务、数分、SRE 等多角色的核心痛点。我们将沿着"从上层业务应用到底层基础设施"的逻辑脉络,抽丝剥茧,呈现一个全栈可观测的 2026 图景。

1. 市场趋势:驱动变革的四股力量

在展开产品细节之前,我们需要厘清推动 2026 年可观测性技术变革的宏观力量。

1.1 AI Agent 的崛起与黑盒治理危机

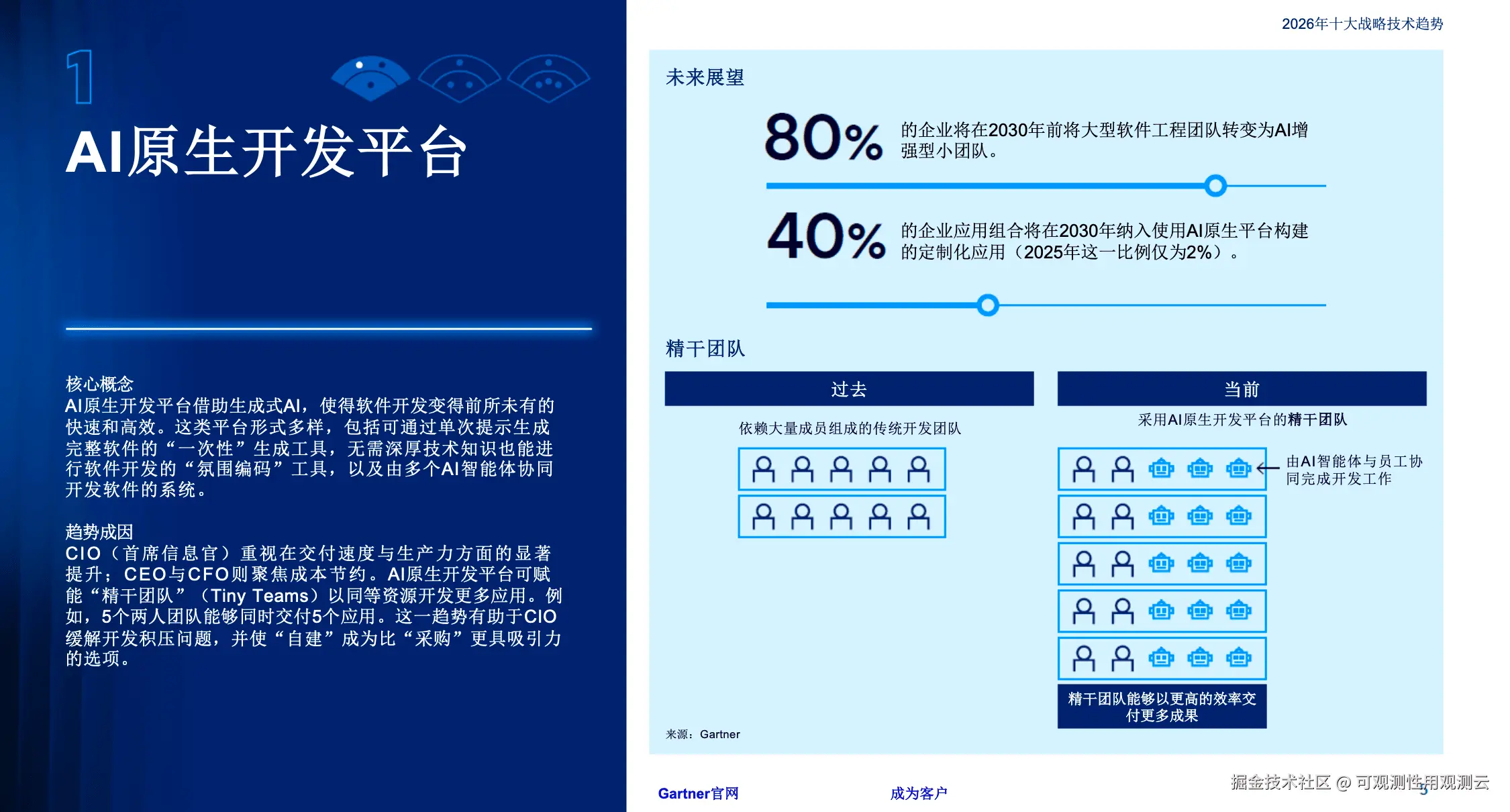

2026 年,AI 不再是辅助工具,而是核心生产力。Gartner 指出,AI 原生开发平台正在让自主 Agent 协作完成复杂任务。然而,Agent 的引入带来了全新的不可预测性:

- 非确定性路径:Agent 的决策逻辑是动态生成的,传统的基于固定代码路径的 APM 难以追踪其思维链。

- Token 经济学:每一次 API 调用都对应着真金白银。监控系统的核心指标从 CPU 使用率转向了"Token 消耗率"与"任务完成成本"。

- 黑盒风险:当 Agent 陷入死循环或产生幻觉时,传统的监控告警往往滞后,导致巨额的 API 费用浪费。

1.2 数据引力与存算分离的必然

随着数字化转型的深入,企业数据量正以每年 180 EB 的速度增长。传统的基于本地磁盘(SSD/HDD)的存储架构(存算耦合)面临巨大的成本压力:

- 扩容困境:为了增加存储空间,不得不增加计算节点,导致计算资源闲置浪费。

- 冷热数据鸿沟:90% 的查询集中在最近 24 小时的数据,但为了合规,企业必须存储数年的历史数据。将所有数据都放在昂贵的块存储上在经济上已不可行。

- 解决方案:市场正全面转向基于对象存储(S3/OSS)的存算分离架构,这也是 GuanceDB 演进的必然方向。

1.3 平台工程(Platform Engineering)与左移

DevOps 正在进化为平台工程。开发者不再满足于被动接收告警,他们需要自服务的、可编程的观测能力。可观测性正在"左移"进入 CI/CD 流水线,开发者要求能够通过代码(Monitoring as Code)定义监控规则,并通过 API 触发自动化修复流程。

1.4 FinOps 与数据主权的博弈

随着全球数据法规(GDPR 等)的收紧,大型企业越来越倾向于"控制面与数据面分离"的架构。他们希望利用 SaaS 厂商提供的先进 AI 分析能力(控制面),但要求原始遥测数据保留在自己的云账号下的对象存储桶中(数据面),即 BYOS(Bring Your Own Storage)模式。

2. 观测云新的产品功能:蓝图 (Blueprint)

------ 可观测性编排与自动化引擎

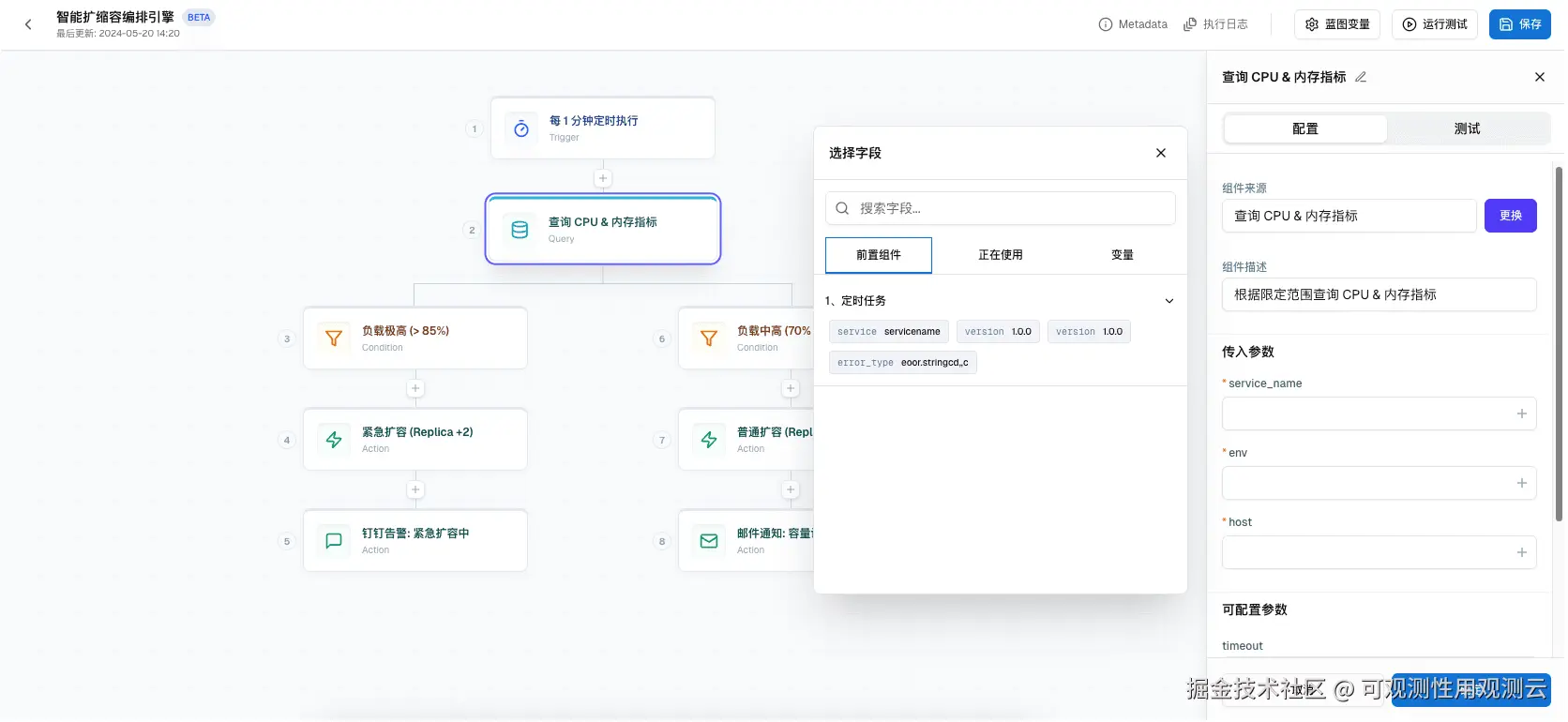

在观测云 2026 的规划中,"蓝图"(Blueprint)不是一张静态的架构图或一套预设的 Dashboard 模板。基于最新的用户需求与 UI 设计,蓝图被重新定义为"官方组件支持计划"的核心载体,是一个低代码/无代码的可观测性编排与自动化引擎。

它通过可视化工作流(DAG - 有向无环图)将分散的观测能力串联起来,形成从 数据查询 -> 逻辑转换 -> AI 分析 -> 行动 的完整闭环。

2.1 蓝图的核心架构:可视化 DAG 工作流

传统的监控告警是离散的:一个阈值触发一封邮件。而 2026 年的蓝图引擎引入了状态机与流式处理的概念。蓝图工作流由以下四类核心节点构成,支持用户通过拖拽方式构建复杂的运维逻辑:

2.1.1 数据查询节点(Input / Sensor)

-

DQL (Data Query Language) 驱动:支持复杂的查询逻辑,包含了简单的指标阈值(如 CPU > 80%),更加支持跨数据源的关联查询。

- 示例:"查询最近 5 分钟支付接口的 P99 延迟,且仅当该延迟不仅超过阈值,同时伴随错误日志激增时触发。"

-

多源异构:支持 Metrics、Logs、Traces、RUM(用户体验数据)的混合查询。

2.1.2 转换与逻辑节点(Processor / Logic)

- 低代码处理:支持 JavaScript/TypeScript 片段或表达式语言(Expression Language)。

- 上下文丰富:原始告警往往缺乏上下文。转换节点可以调用外部 CMDB 或 K8s API,为告警数据打上"业务线"、"负责人"、"部署版本"等标签。

- 价值:解决"告警疲劳"的核心手段。通过逻辑判断(如去重、抑制、时间窗聚合),将 100 条原始告警压缩为 1 条高价值根因分析。

2.1.3 AI 分析节点(Intelligence / Obsy AI)

- ObsyAI 智能体介入:这是蓝图的智能核心。当逻辑节点检测到异常后,自动唤起 ObsyAI 进行根因分析。

- 能力:自动关联该时间段内的变更事件(Change Events)、错误日志聚类(Log Patterns)和异常链路等等。

- 输出:一段自然语言描述的诊断建议:"检测到支付服务延迟升高,关联到 3 分钟前 payment-service 的 v2.1 发布,且 DB 连接池报错激增。"

2.1.4 行动节点(Action / Actuator)

-

OpenAPI 闭环:这是蓝图与传统监控的最大区别。它通过 OpenAPI 与外部系统对接,执行实质性操作。

-

场景覆盖:

- 通知:发送富文本消息到 Slack/钉钉/企业微信(包含 AI 诊断结果)等任意communication channel。

- 监控器管理:自动静默非核心服务的告警,或在流量高峰期动态调整阈值。

3. 更加全面的变更观测 (Change Observability)

------ 根因分析的时间维度

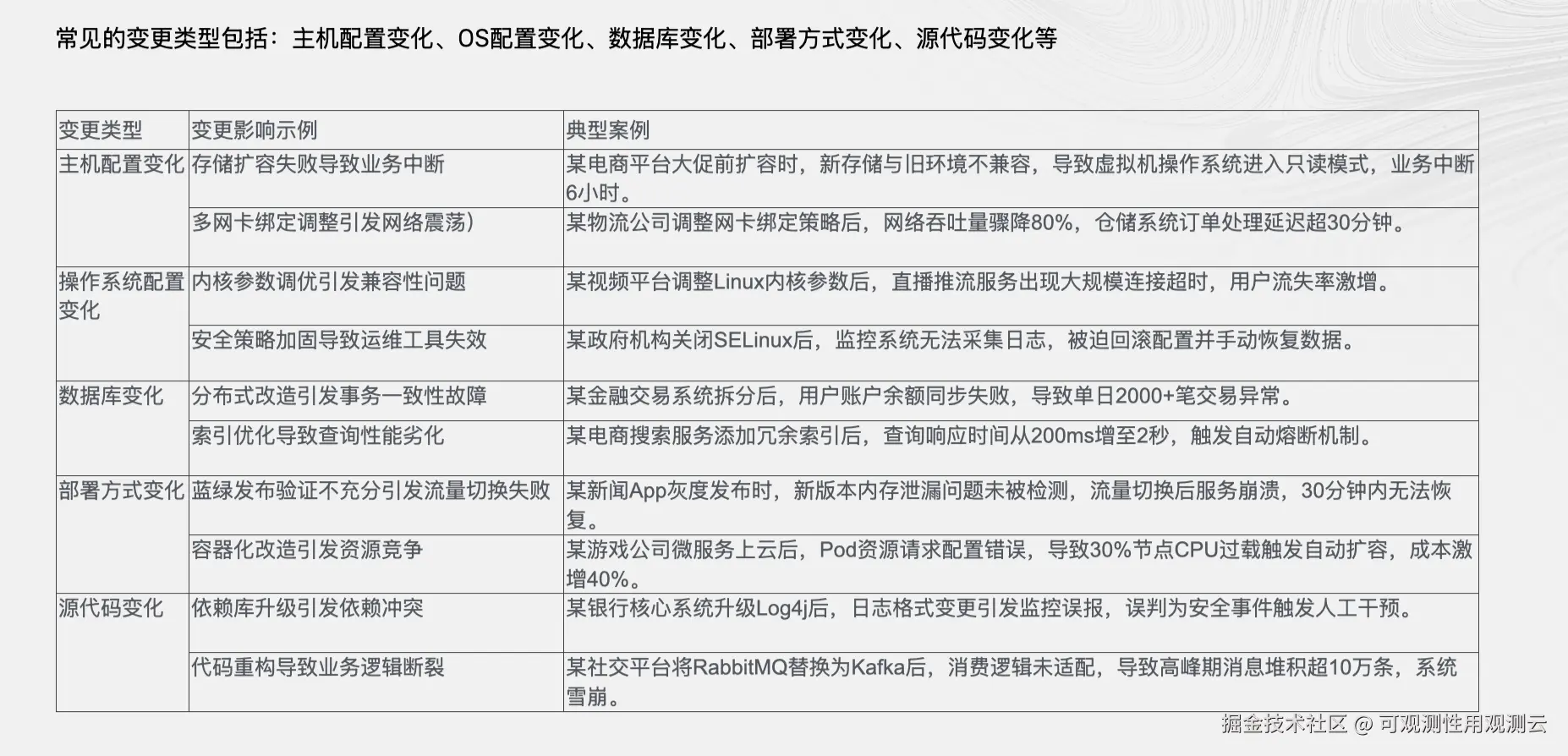

3.1 变更:系统熵增的核心问题

根据 SRE 的经验法则,80% 的生产事故是由变更(Change)引起的。无论是代码发布、配置文件的修改、Feature Flag 的切换,还是基础设施的扩缩容操作,都是打破系统稳态的潜在因素。然而,传统的监控工具往往只记录了"结果"(Metrics 的突变、Logs 的报错),却丢失了"原因"(谁、在什么时候、做了什么变更)。

观测云 2026 将"变更"提升为与 Logs、Metrics、Traces 同等的一级数据公民(First-Class Citizen),构建了全维度的 变更观测(Change Observability) 体系。

3.2 变更数据的全栈采集与关联

3.2.1 统一变更数据模型

为了捕捉系统中的每一次变化,观测云 2026 建立了一套标准化的变更数据模型:

- 应用层:深度集成 Jenkins、GitLab、GitHub Actions 等 CI/CD 工具,自动捕获部署事件(Deployment)、Commit 信息、Artifact 版本。

- 基础设施层:监听 Kubernetes Events(如 Pod Killing, Scaling)、云厂商审计日志(如 AWS CloudTrail、阿里云 ActionTrail),捕获资源的创建、销毁和规格变更。

- 配置层:对接 Nacos、Apollo、Consul 等配置中心,实时记录配置项的 Diff。记录配置变了,还记录从什么变成了什么。

3.2.2 变更叠加分析(Change Overlay)

变更观测的核心价值在于上下文的融合。在观测云的所有时序图表(Metric Charts)上,系统会自动叠加变更事件的标记(Annotations)。

-

场景示例:

- 传统视图:看到 API 错误率曲线在 14:00 突然飙升,SRE 开始排查日志。

- 变更观测视图:看到错误率飙升的同时,时间轴上显示 13:59 分有一个"支付服务 v3.2 Canary 发布"的标记。鼠标悬停即可看到该发布的 Commit Message 和变更人。

这种直观的视觉关联,能够将 MTTR(平均修复时间)从小时级缩短至分钟级。运维人员不再需要去各个聊天群里询问"刚才谁动了线上环境?",变更观测直接给出了答案。

3.2.3 变更风险评分与智能门禁

结合 Arbiter 引擎的历史分析能力,系统能对每一次变更进行风险评分。如果某次代码提交修改了核心链路的关键文件,且缺乏足够的测试覆盖率,或者历史数据显示该开发者的变更回滚率较高,系统将在变更发生前发出预警,甚至联动 CI/CD 流水线进行阻断。

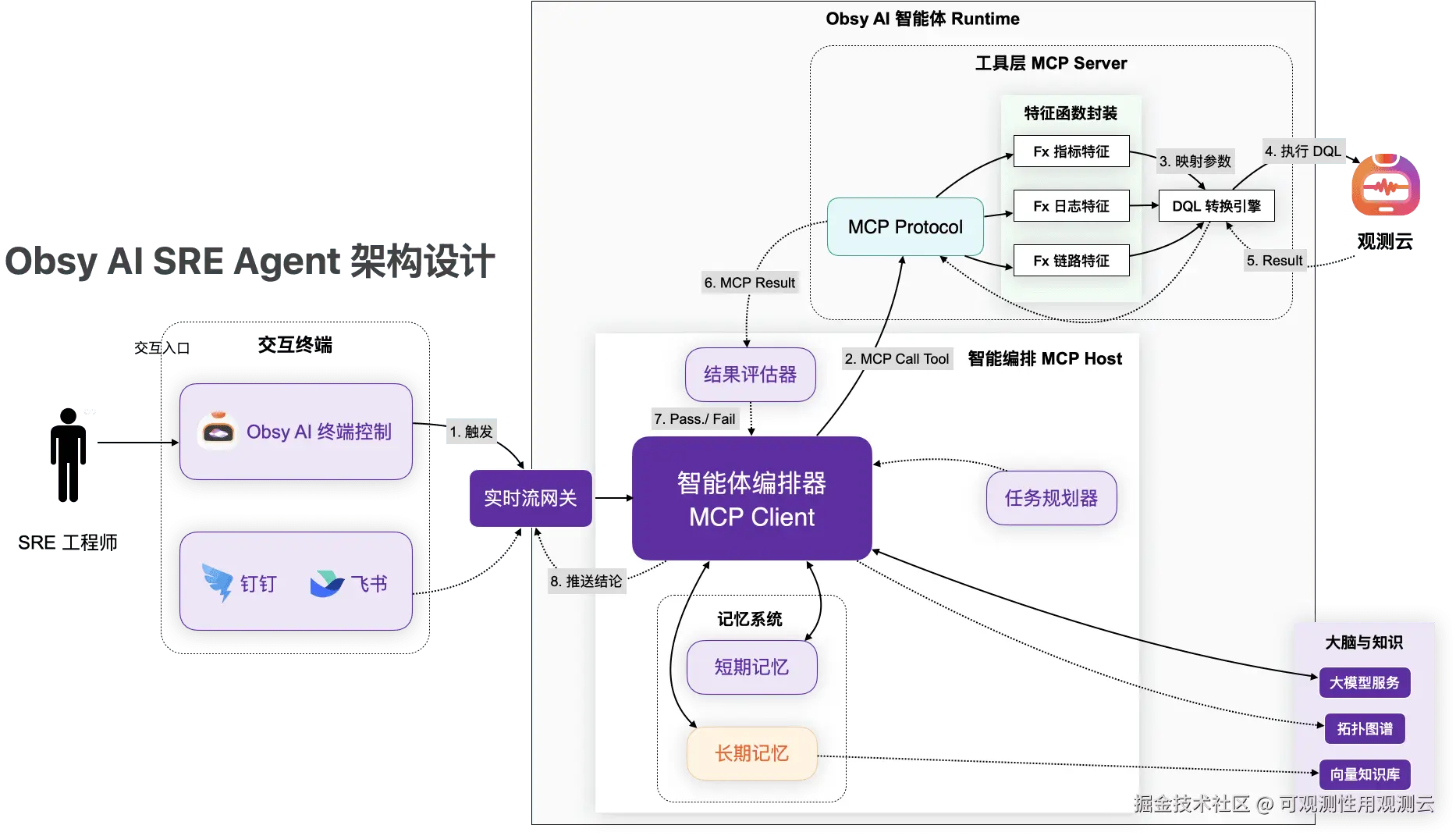

4. Obsy AI SRE Agent 推出:可交互的根因分析侦探

观测云 2026 颠覆了传统人找数据的排查模式,推出了一套基于 动态假设树(Dynamic Hypothesis Tree) 的交互式排查界面。

4.1 触发与情境感知

当监控器发现异常(例如 flight-query-api 接口响应时间 P99 > 2s),系统将直接启动 Obsy AI SRE Agent。在观测云的 Console 中,用户会看到一个关联了错误上下文(Error Trace、Latency Chart)的交互式卡片。

4.2 动态假设引擎(Dynamic Hypothesis Engine)

AI Agent 不会盲目列出所有指标,而是像一位经验丰富的 SRE 工程师一样进行逻辑推演。它会基于当前的异常特征,生成多条排查路径(Investigative Plans),并依据历史数据和专家知识库计算出每一条路径的置信度概率:

- Plan A (概率:高):假设为数据库超时(DB Connection Block / Slow SQL)。

- Plan B (概率:低):假设为上游依赖服务响应变慢。

- Plan C (概率:低):假设为网络网关故障。

4.3 交互式思维导图与递归诊断

用户点击高概率的 Plan A,界面将展开一个可视化的排查思维导图。这不仅仅是静态图表,而是 AI 正在执行的逻辑动作流:

- 节点展开:Agent 自动检查 "RDS 资源水位" -> "数据库连接池状态" -> "慢查询日志分析"。

- 执行验证:每个节点会显示执行状态(Check Passed / Failed)。例如,AI 发现连接池正常,但捕获到了一条全表扫描的慢 SQL。

- 根因锁定:当 AI 找到确凿证据(如:flight_no 字段缺失索引导致全表扫描),它会标记为"Root Cause Identified",并生成自然语言的结论报告。

4.4 闭环与反馈

- 对话式追问:在锁定根因后,用户可以直接与 Agent 对话:"如何修复这个问题?"Agent 会根据知识库提供 Runbook 建议(如:添加索引的 SQL 语句)。

- 多路径回溯:如果 Plan A 的排查结果显示一切正常(Negative Result),Agent 会智能建议用户切换至 Plan B 或 Plan C。系统会自动保留已排查过的路径记录,避免重复工作,直到递归找到真正的问题源头。

- 人工接管:整个 UI 包含清晰的 "Abort/Take Over" 按钮,允许工程师随时打断 AI 的自动化逻辑,手动介入排查。

这套设计融合了现代工程美学与 AI 智能,将原本黑盒的 AI 思考过程透明化(White-box),让 SRE 既能享受 AI 的效率,又能保持对排查逻辑的掌控。

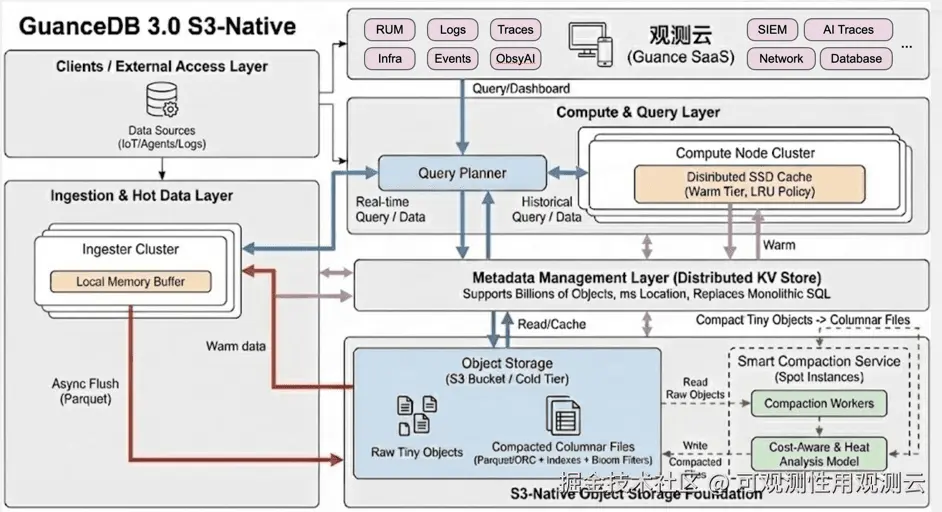

5. GuanceDB 演进策略:云原生内核的重构

GuanceDB 3.0 是观测云强健的心脏。现有的数据库架构大多基于本地磁盘(Shared-Nothing 架构),在面对 PB 级数据时,扩展成本高昂且缺乏弹性。GuanceDB 3.0 的核心目标是演进为基于对象存储(S3-Native)的存算分离架构。在这一演进过程中,我们必须正视目前与行业标杆的技术差距,并提出针对性的优化策略。

5.1 关键演进挑战与探索方向

GuanceDB 的演进要解决对象存储带来的物理限制:高延迟与元数据管理。

5.1.1 挑战一:海量小文件元数据瓶颈 (Metadata Bottleneck)

-

痛点:在实时写入场景下(如 IoT),会产生数以亿计的小文件(Objects)。如果 GuanceDB 3.0 的元数据层不够强大,查询时的"列出文件"操作就会成为瓶颈,导致查询超时。

-

演进方向:分布式元数据架构

- 探索:不再依赖单体 SQL 数据库存储元数据。探索分布式 Key-Value 存储来构建元数据层。

- 目标:支持每秒数十万次的元数据读写,确保即使底层有百亿个 S3 对象,查询规划器也能在毫秒级定位到需要扫描的文件。

5.1.2 挑战二:存算分离后的查询延迟 (Cold Start Latency)

-

痛点:S3 的首字节延迟(TTFB)通常在几十到几百毫秒。对于"老板看数"的实时 Dashboard 场景,这种延迟是不可接受的。

-

演进方向:智能分层与分布式缓存 (Smart Tiering & Caching)

- 热数据 (Hot):近期的数据查询直接走本地内存/磁盘,速度极快。

- 温数据 (Warm):引入分布式缓存层。对于经常访问的"昨天"或"上周"的数据,在计算节点的 SSD 上进行 LRU 缓存。

- 冷数据 (Cold):完全沉淀在 S3。查询时按需拉取,接受秒级延迟,换取极致成本。

- 价值:实现"像 SSD 一样快,像 S3 一样便宜"。

5.1.3 挑战三:Compaction (压缩) 策略与写放大

-

痛点:为了优化查询,必须将 S3 上的小文件合并为大文件(Compaction)。但 S3 的 PUT 操作是收费的,且消耗网络带宽。

-

演进方向:成本感知的智能 Compaction

- 策略:不盲目压缩。引入基于"查询热度"和"S3 计费模型"的代价函数。

- 探索:利用 Spot Instances(竞价实例)在云厂商的闲时运行 Compaction 任务,将小文件合并为列式存储(Parquet/ORC 变体),同时构建布隆过滤器(Bloom Filters)和 Min/Max 索引,以减少未来的扫描量。

6. 落地 Targeting Needs:场景化痛点的精准打击

技术必须服务于业务。不同的大客户场景对数据平台的需求是截然不同的,甚至是互斥的。我们不能用一套参数满足所有人,而是提供灵活,可以满足特种需求的的数据引擎。

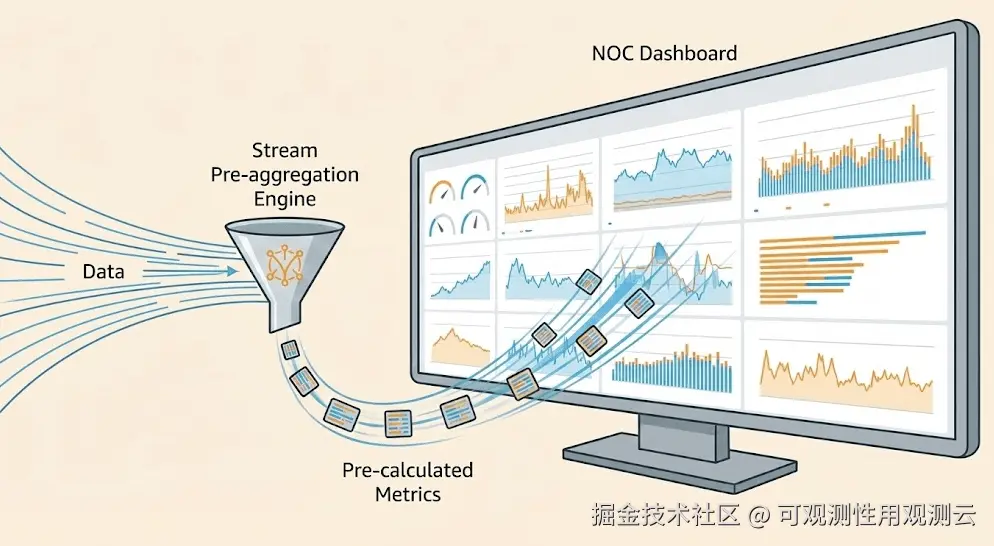

6.1 场景一:实时查询(Real-Time Query)------ 老板看数

-

用户:CIO、CTO、NOC 监控大屏。

-

痛点:Dashboard 需要秒级刷新。读多写少,并发高。传统的 OLAP 引擎在处理聚合查询时延迟较高,且并发能力受限。

-

观测云 2026 解决方案:流式聚合。

- 原理:GuanceDB 不再每次刷新都扫描原始日志。在数据摄取(Ingest)阶段,通过流式预聚合引擎(Pre-aggregation Engine)自动维护常用指标(如 Global_Error_Rate)。

- 效果:Dashboard 查询实际上是在读取一张极小的预计算表,无论原始数据量是 1TB 还是 1PB,大屏刷新始终保持在亚秒级。

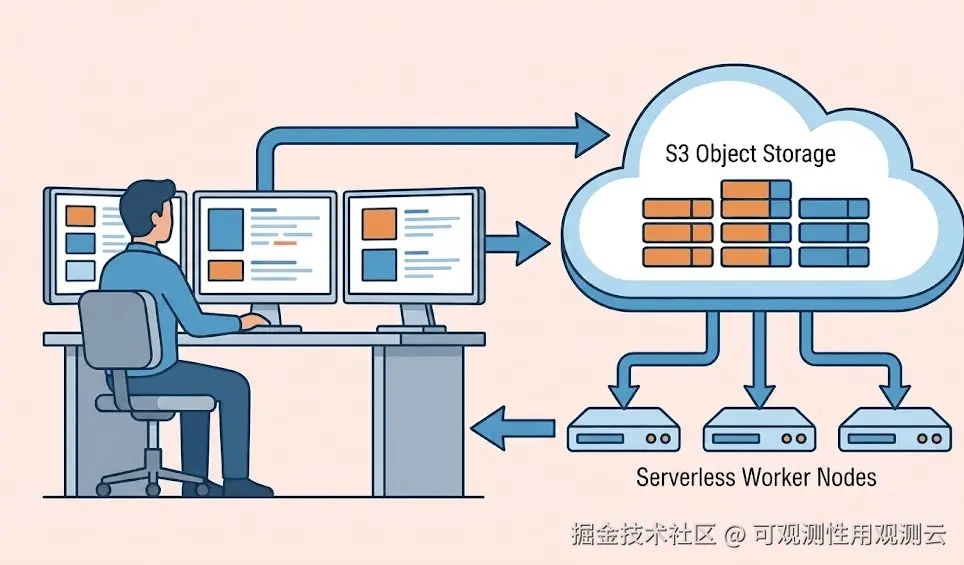

6.2 场景二:批量报表与数据挖掘 ------ 分析师的深潜

-

用户:SRE 专家、安全分析师、运营人员。

-

痛点:读少,但 IO 极重。需要扫描过去 30 天的海量日志进行根因分析或生成月度运营报告。容易导致数据库 OOM (Out of Memory) 或查询超时。

-

观测云 2026 解决方案:向量化执行引擎 + Serverless 扫描。

- 原理:利用存算分离架构,当检测到此类大查询时,GuanceDB 动态弹出一组 Serverless 计算节点(Worker),并行扫描 S3 上的数据块。利用 SIMD 指令集和向量化执行(Vectorized Execution)加速过滤。

- 开放性:支持通过 DQL 导出数据到 Notebook 或外部数仓,满足深度挖掘需求。

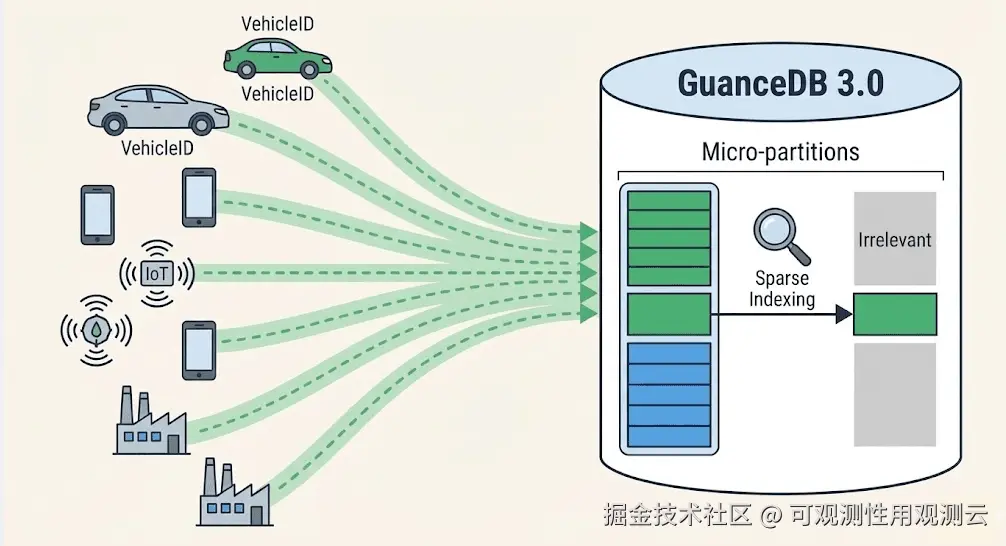

6.3 场景三:高并发写入 ------ IoT 与车联网数据海啸

-

用户:车企(V2X)、智能制造、IoT 架构师。

-

痛点:写多读少。Tag(标签)基数极高(High Cardinality)。例如,百万辆车,每辆车有唯一的 VehicleID,传统时序数据库的倒排索引会因此膨胀爆炸,导致内存溢出。

-

观测云 2026 解决方案:稀疏索引与列式存储优化。

- 原理:放弃对高基数 Tag 建立全量倒排索引。GuanceDB 借鉴先进的架构设计,采用 稀疏索引(Sparse Indexing)和数据分区(Micro-partitions) 技术。

- 效果:将 VehicleID 作为排序列,通过 Min/Max 索引快速跳过无关数据块。在不牺牲写入性能的前提下,支持对高基数标签的高效过滤,彻底解决"索引爆炸"问题。

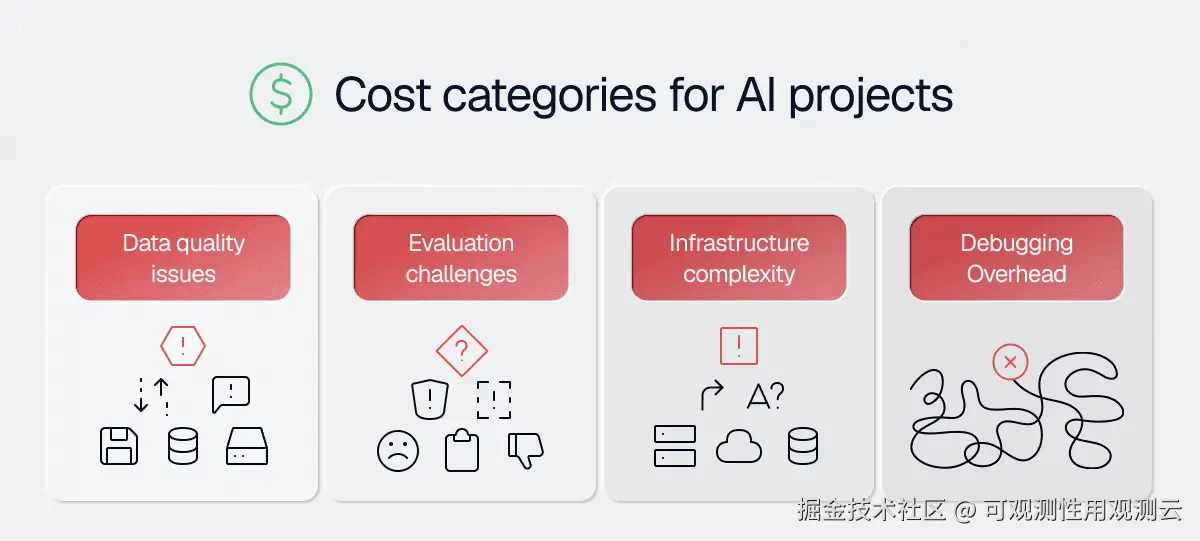

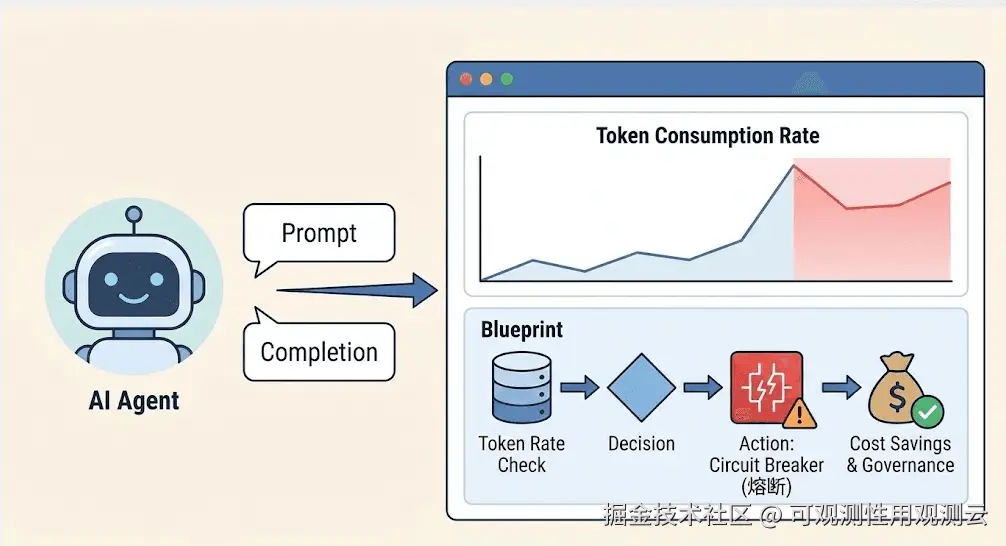

6.4 场景四:AI/LLM 可观测 ------ Agent 行为治理

-

用户:AI 平台工程师、大模型应用开发者。

-

痛点:Agent 行为具有不确定性(幻觉、死循环),且 Token 成本昂贵。传统的 CPU/内存监控无法反映 AI 业务的健康度。

-

观测云 2026 解决方案:Model Telemetry 与成本归因。

- 数据模型:引入专用的数据类型追踪 Prompt 和 Completion 的 Token 消耗、延迟、模型版本。

- 蓝图集成:通过蓝图实时监控 Token 消耗速率。一旦发现某个 Agent 陷入死循环(Token 消耗斜率异常),立即触发熔断机制(Action 节点),并通知开发者。

- 价值:进阶到 AI 业务治理,为企业节省真金白银的算力成本。

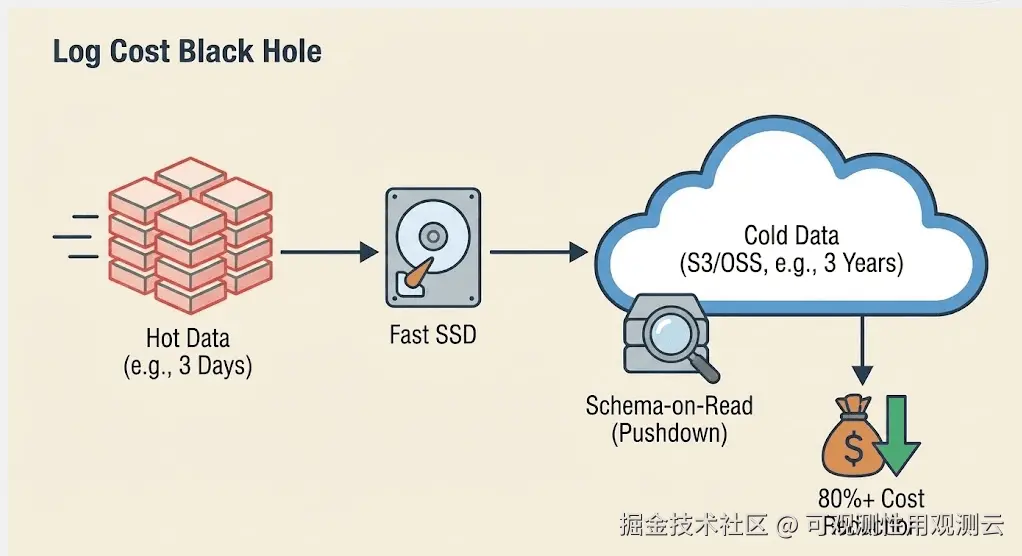

6.5 场景五:日志成本黑洞 ------ 拒绝存不起,查不到

-

用户: 运维总监、合规审计部门、FinOps 负责人。

-

痛点: 日志数据量呈指数级增长(每天几十 TB),但 99% 的日志通常都用不上,只有故障时才需要回溯。传统方案要么全量索引导致存储成本天价,要么为了省钱只存 3 天导致关键数据丢失。

-

观测云 2026 解决方案: 冷热分层(Tiered Storage)+ Schema-on-Read(读时建模)。

- 原理: GuanceDB 引入智能分层策略。热数据(最近 3 天)存高性能 SSD 并建立全索引;温/冷数据(3 天 - 3 年)自动下沉至对象存储(S3/OSS),不建立繁重倒排索引。当需要查询冷数据时,利用算子下推(Pushdown)临时扫描目标块。

- 效果: 将日志的长期存储成本降低 80% 以上。让企业存得起海量日志,还能在需要审计时,无需数据迁移即可直接查询历史归档。

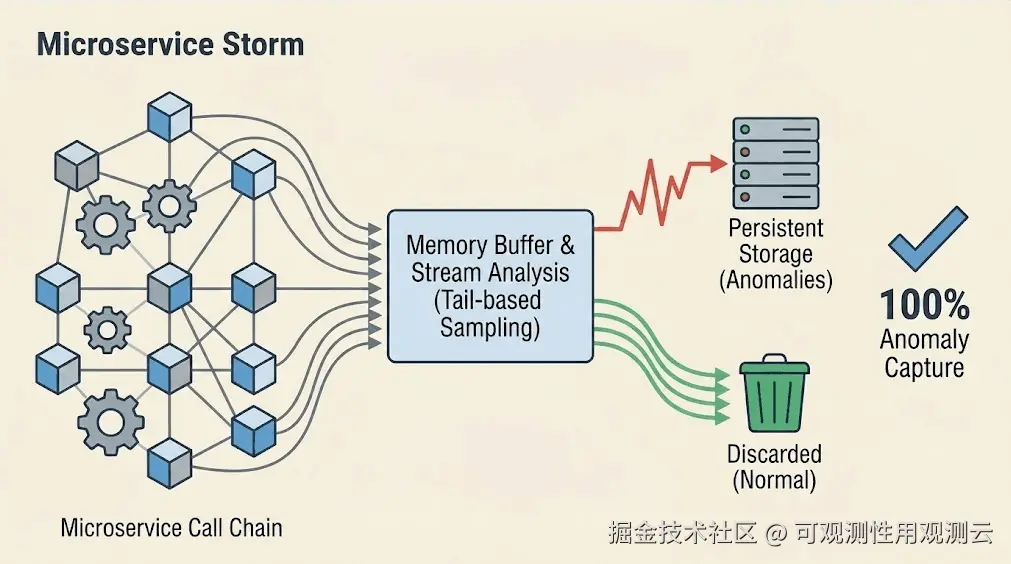

6.6 场景六:微服务风暴 ------ 抓住百万分之一的异常

-

用户: 架构师、中台研发负责人。

-

痛点: 在成百上千个微服务的调用链中,每天产生数亿条 Trace 数据。传统 APM 采用头部采样(Head-based Sampling)(如只采 1%),容易导致"关键的报错请求正好被丢弃了",无法还原故障现场。

-

观测云 2026 解决方案: 100% 全量摄取 + 尾部采样(Tail-based Sampling)。

- 原理: 数据进入系统时不做丢弃,先在内存缓冲区暂存。通过流式引擎实时分析整条链路的尾部状态(是否报错、是否高延迟)。只有有问题或高价值的链路才会被持久化存储,正常的无用链路自动丢弃。

- 价值: 在不增加存储预算的前提下,实现100% 的异常捕获率。不再靠运气抓 Bug,而是靠精准的算法。

当然以上仅是冰山一角。观测云的统一数据底座已打破场景壁垒,无论是日志降本还是链路追踪,皆能以一套架构,从容应对万千需求。

结语:观测云的2026

观测云 2026 的产品预告是对未来观测形态的一次预判与押注。

- 市场在变:AI Agent 带来了复杂性,FinOps 带来了成本压力,数据主权带来了架构约束。

- 产品在变:蓝图将会成为企业的自动化中枢;GuanceDB 拥抱 S3,打破存储的物理边界,用云原生的架构解决云时代的规模问题。

- 价值在变:我们针对不同角色(CIO、SRE、IoT 架构师、AI 工程师等等)提供不同场景都可用的灵活解决方案。

对于 CTO 和 CIO 而言,选择观测云 2026,不仅是选择了一个监控平台,更是选择了一套能够驾驭 AI 时代不确定性、从容应对数据洪流的系统。请查收这份产品路线图。