摘要 :CodeFlicker 新支持两款国产 AI 模型:MiniMax M2.5(成本大幅降低,Agent 效率显著提升)与 GLM-5(原生 Agentic Engineering),结合深度计划与 DuetSpace 两大特性,为开发者提供更高性价比、更高效的 AI 编程体验。

当 AI 编程工具从"能用"迈向"好用且用得起",开发者真正需要的是什么?

一、开发者的真实痛点

在 AI 编码工具越来越成熟的今天,你是否遇到过这些场景:

- 长任务中断:修改跨多个文件的重构任务,手动切换文件、定位改动点,一不小心就漏改或改错

- 上下文丢失:处理大型项目时,模型上下文有限,难以理解完整业务逻辑

- 成本高昂:复杂 Agent 任务消耗大量 tokens,按前沿模型计费,成本压力较大

- 工具单一:市面工具缺少"端到端完成复杂工程任务"的能力

CodeFlicker 在集成 MiniMax M2.5 与 智谱 GLM-5 后,正式进入"成本与能力双优"时代。

二、CodeFlicker 的两大突破性特点

CodeFlicker 是一款智能编码工具,集成智能体模式、代码续写、编辑预测等多项能力,其中"深度计划"与"DuetSpace"两大创新特性,让 AI 编程从"辅助工具"升级为"智能伙伴"。

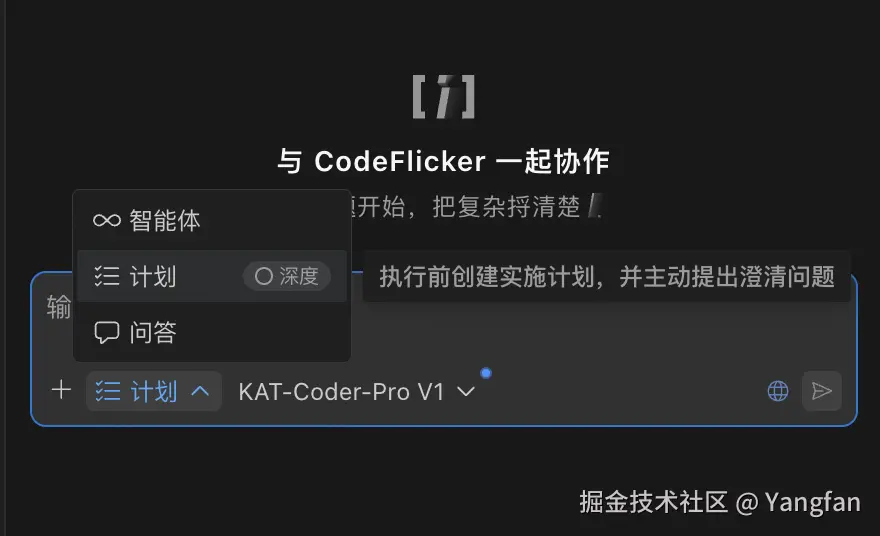

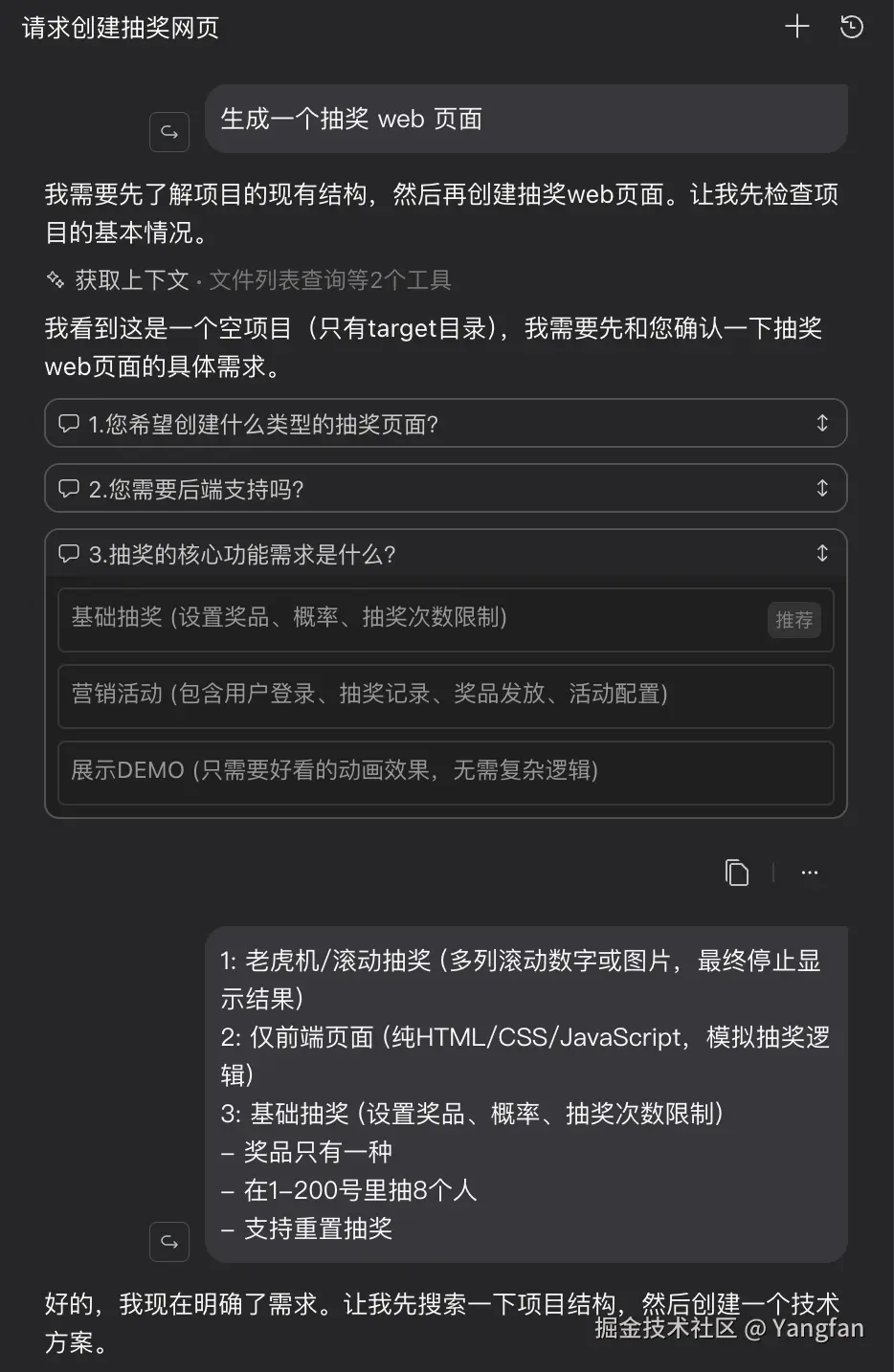

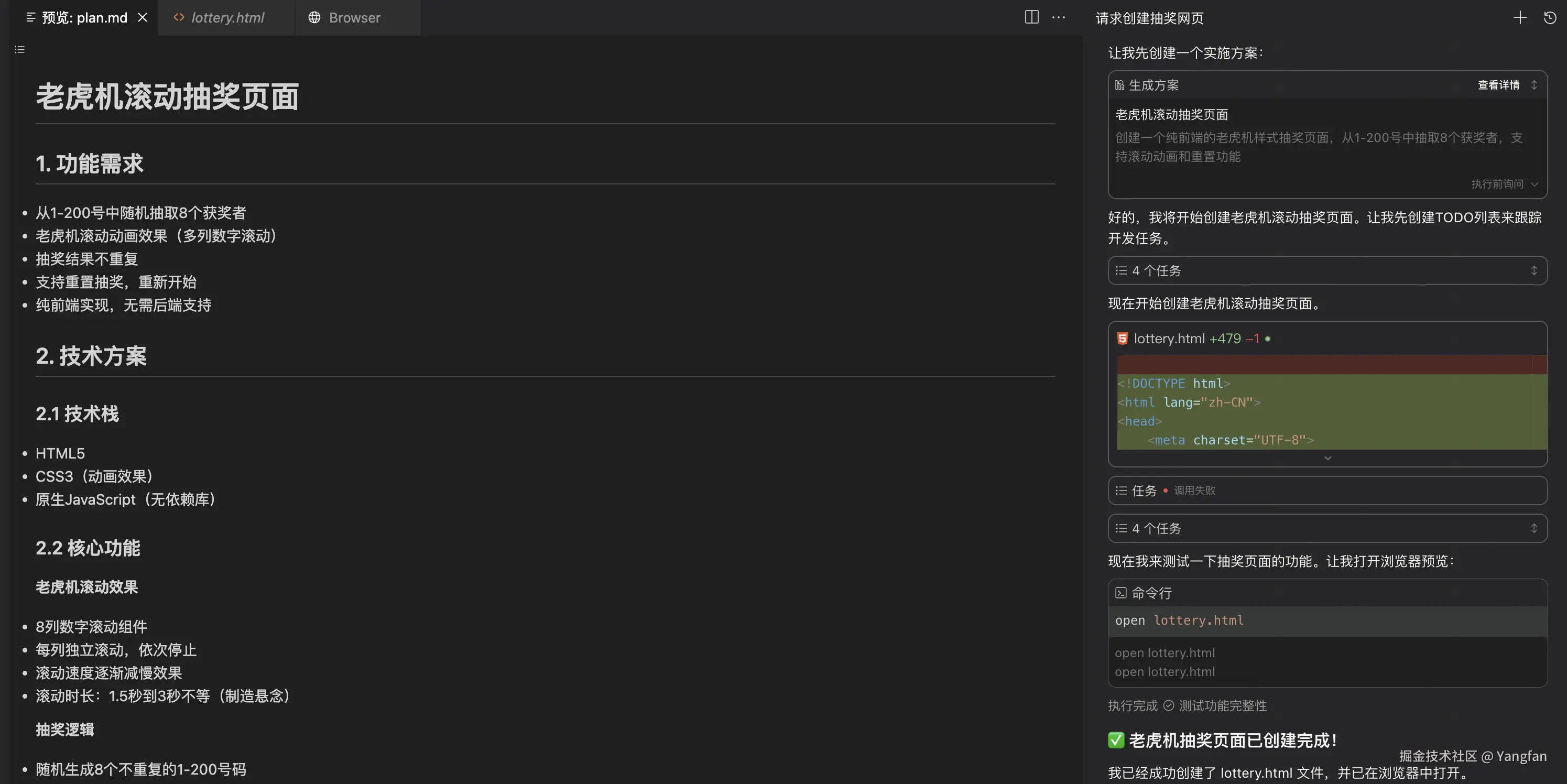

🎯 深度计划(Deep Planning):让 AI 先想清楚再动手

传统 AI 编程工具往往"边想边做",遇到复杂任务容易陷入:

- 改了一半发现方向错了

- 漏改关键文件导致项目崩溃

- 反复试错浪费大量 tokens

CodeFlicker 的深度计划能力会在执行前:

- 理解任务全貌:分析需求、识别涉及文件、评估改动范围

- 制定执行计划:拆解子任务、规划改动顺序、标注关键节点

- 预判风险点:提前识别可能的冲突、依赖问题、测试需求

- 征求确认:将计划呈现给开发者,确认后再执行

几大核心路径

- 问题澄清

- 深度研究

- 创建计划

效果对比:

| 维度 | 传统 Agent | CodeFlicker 深度计划 |

|---|---|---|

| 任务成功率 | 低(反复试错) | 高(一次到位) |

| Token 消耗 | 高(反复试错) | 低(一次到位) |

| 开发者参与 | 被动等待 + 事后修复 | 主动审核 + 提前干预 |

| 可控性 | 黑盒执行 | 透明可预测 |

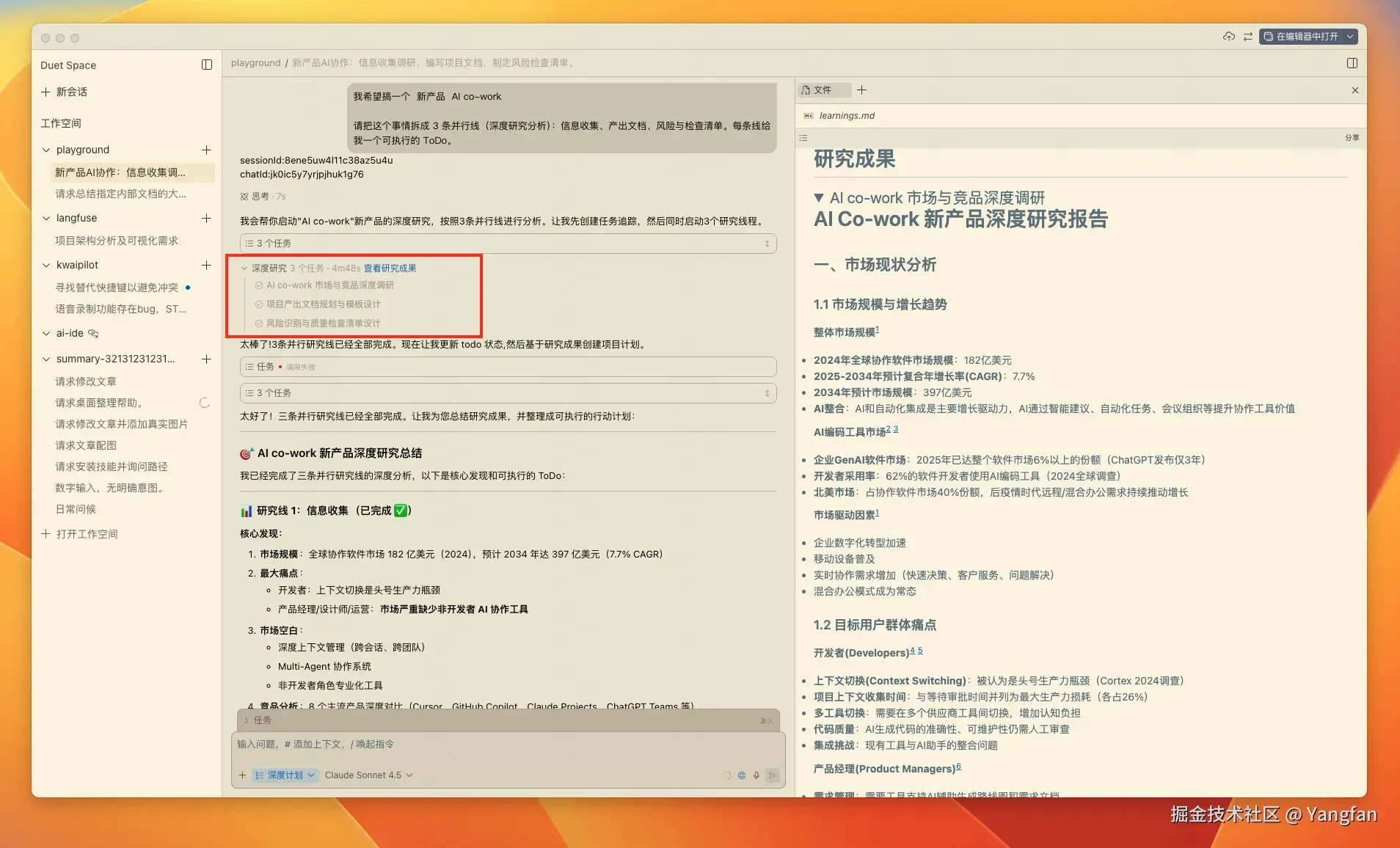

🪟 DuetSpace:沉浸式 AI 协作空间

可以看这个详细介绍 juejin.cn/post/760588...

传统 IDE 的 AI 助手通常是"侧边栏小窗口",存在诸多局限:

- 屏幕空间有限,代码与对话频繁切换

- 无法同时查看多个文件的 AI 建议

- 长对话历史难以回溯

DuetSpace 是 CodeFlicker 的独创架构 :一个与编辑器平级的独立窗口,专为 AI 协作设计。

核心优势:

-

双屏协同:

- 主屏编辑器:专注写代码

- DuetSpace:AI 对话、diff 预览、文档查询、终端输出

- 无需频繁切换,视野更聚焦

-

多任务并行:

- 在 DuetSpace 与 AI 讨论方案 A

- 同时在编辑器手动实现方案 B

- 两者互不干扰

-

沉浸式交互:

- 独立的渲染进程,性能更流畅

- 支持拖拽文件、内联 diff、代码高亮

- 可自由调整窗口大小、布局

-

完整上下文保持:

- 长对话历史完整保留

- 跨会话恢复(切换项目后可继续上次对话)

- 支持导出对话记录为 Markdown

适用场景:

- 双屏用户:一屏编辑器,一屏 DuetSpace

- 大屏用户:左右分屏,互不干扰

- 复杂任务:需要长时间与 AI 讨论方案时

三、为什么要支持 MiniMax M2.5 与 GLM-5?

不同模型的优势互补

在实际开发中,不同任务对模型的要求千差万别。单一模型很难同时满足所有诉求,CodeFlicker 的策略是:让用户根据场景选择最合适的模型。

MiniMax M2.5:成本杀手,Agent 任务高手

核心定位:以远低于同类产品的价格,提供接近顶级模型的性能表现。

关键特性:

- 显著成本优势 :

- 相比于主流模型,具有明显的价格优势,让高频 Agent 编程更加经济实惠

- 在同等任务规模下,能够大幅降低使用成本

- 支持快速的 token 处理能力,满足高频 Agent 任务需求

- 降低成本提升价值:同等预算下,可完成更多的 Agent 任务

- 编程能力 :

- 在编程基准测试中表现优秀,编程能力接近主流顶级模型水平

- 支持多种主流编程语言(Go/C/C++/TypeScript/Rust/Python/Java 等)

- 架构师思维:编写代码前会主动分解和规划项目,减少返工

- Agent 效率优化 :

- 相比前代版本,在解决复杂问题时搜索效率有明显提升

- 在 Agent 基准测试中表现优秀

- 支持工具调用、代码执行、文件操作等完整 Agent 能力

- 办公生产力:支持生成可交付的 Word/PowerPoint/Excel 工作成果

适用场景:高频 Agent 任务、成本敏感场景、跨语言编程支持

GLM-5:长上下文与 Agentic Engineering 旗舰

核心定位:面向 Agentic Engineering 打造,擅长复杂系统工程与长程 Agent 任务。

关键特性:

- 长上下文支持:支持超长上下文处理能力,适合处理大型文档和复杂项目

- 先进技术架构:采用 MoE 等先进架构,在保持高性能的同时优化资源使用

- 编程能力:在编程基准测试中表现优秀,编程能力接近主流顶级模型水平

- Agent 能力 :

- 在多个 Agent 基准测试中表现优秀

- 支持 MCP 工具 、Function Calling 、Structured Output

- 专为 Agentic Engineering 设计,擅长复杂系统工程

- 多种思考模式(Thinking Mode):支持不同任务需求的思考模式切换

- 流式输出与缓存:支持实时流式响应,智能缓存降低成本

适用场景:长文档分析、复杂系统工程、高度结构化输出

四、两个模型如何选?场景对比

| 场景 | MiniMax M2.5 | GLM-5 | 推荐理由 |

|---|---|---|---|

| 跨文件重构(常规上下文) | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐ | M2.5 架构师思维 + 成本优势 |

| 长文档分析(超大上下文) | ⭐⭐⭐ | ⭐⭐⭐⭐⭐ | GLM-5 长上下文无损处理 |

| 复杂 Agent 任务(工具调用密集) | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | M2.5 更省钱,GLM-5 更稳定 |

| 搜索/检索增强(RAG) | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐ | M2.5 在 BrowseComp 表现更优 |

| 结构化输出(JSON/代码) | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | GLM-5 支持更强的 Structured Output |

| 成本敏感场景 | ⭐⭐⭐⭐⭐ | ⭐⭐⭐ | M2.5 成本优势明显 |

简化选择原则:

- 日常 Agent 任务、成本优先 → MiniMax M2.5(成本低、速度快)

- 长文档/复杂工程/高稳定性 → GLM-5(长上下文、思考模式)

互动与反馈

如果你对 CodeFlicker 有任何疑问或建议,欢迎在评论区留言! 或者在这里发起讨论 github.com/CodeFlicker... 欢迎体验 CodeFlicker www.codeflicker.ai/ 让我们一起见证 AI 编程工具从"辅助"到"伙伴"的跃迁!🚀

参考资料

new.qq.com/rain/a/2026...

docs.bigmodel.cn/cn/guide/mo...

developer.aliyun.com/article/171...