2026年的CES注定会被载入科技史册。

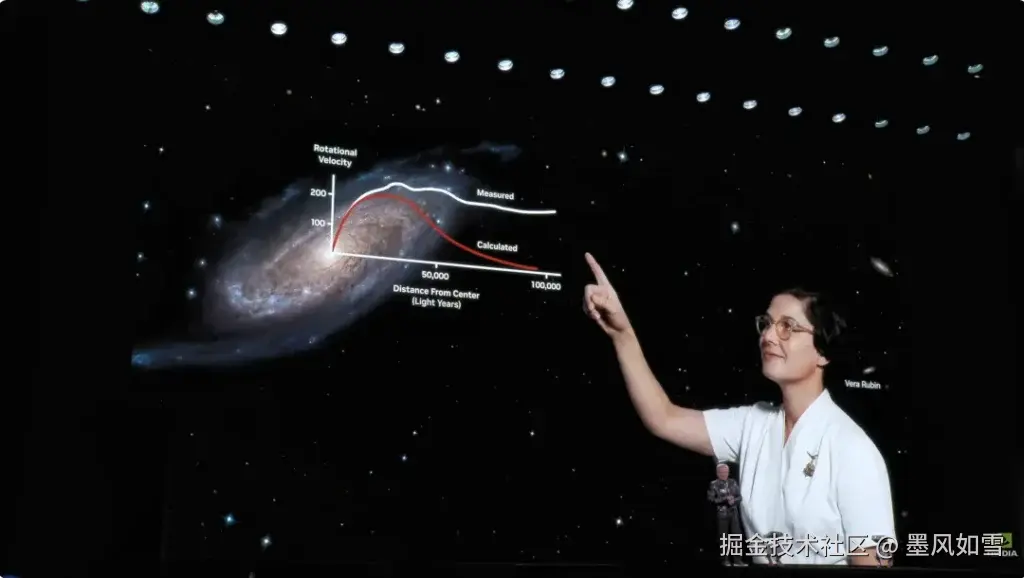

并没有像往常那样掏出一张能跑满光追的新游戏显卡,黄仁勋穿着标志性的皮衣,站在拉斯维加斯的聚光灯下,直接把整个数据中心搬上了舞台。这一次,他的手里不再只是拿着一颗芯片,而是一张通往这一代AI终极形态的门票------Vera Rubin AI计算平台。

如果说之前的Blackwell是在给AI大模型"输血",那么Vera Rubin更像是一次彻底的"换心手术"。

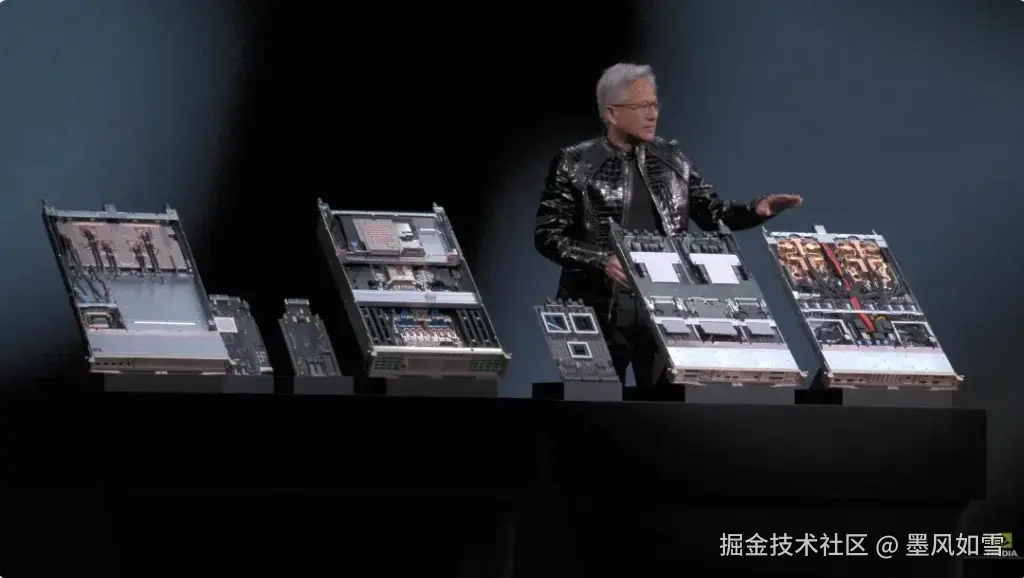

不止是一颗GPU,而是六位一体的"超级大脑"

很多人习惯盯着显卡看,但这次老黄的野心显然更大。Vera Rubin不是一颗孤独的GPU,它是英伟达为了解决数据传输瓶颈而精心设计的一套"六合一"全栈系统。

想象一下,这不仅是换了更快的引擎,而是连变速箱、底盘、油路全部重构了。这个平台的核心由6款全新芯片深度协同:

- Rubin GPU:绝对的主角,拥有3360亿晶体管的怪兽,搭载了HBM4超高速显存。

- Vera CPU:不再依赖别人,这是英伟达自研的"心脏",拥有88个定制Olympus核心。

- NVLink 6 Switch:让芯片间对话速度飙升至3.6 TB/s的交换芯片。

- 再加上ConnectX-9网卡 、BlueField-4 DPU 和Spectrum-X以太网交换机。

这六大金刚不再是简单的拼凑,而是通过所谓的"极致协同设计(Extreme Codesign)",将计算、网络和存储熔铸成了一个整体。简单说,英伟达不再卖砖头了,它现在直接卖给你一栋精装修的摩天大楼。

暴力美学:数据碾压Blackwell

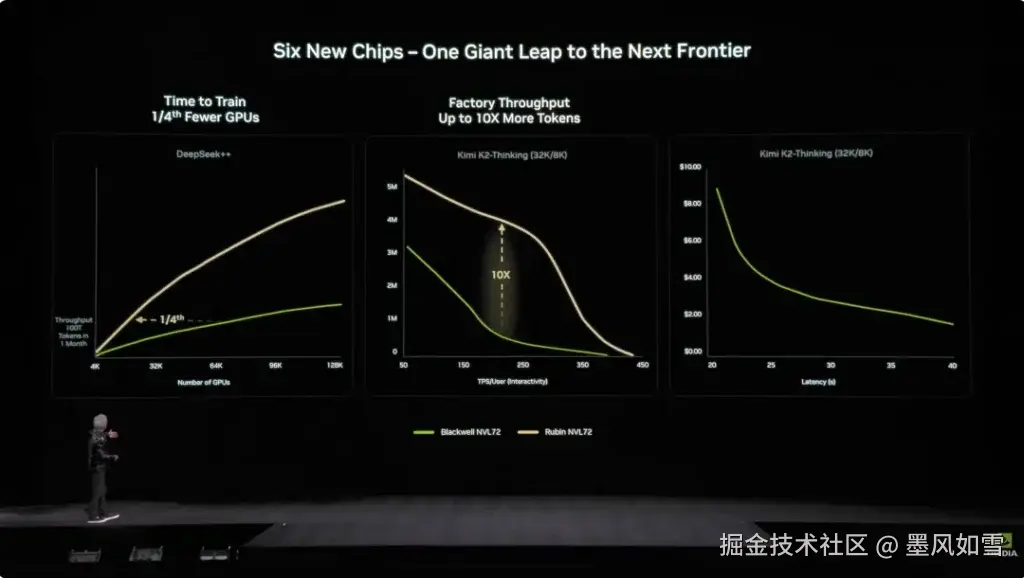

当你觉得Blackwell已经够快时,Rubin用数据告诉你什么叫"降维打击"。

在AI最常用的NVFP4精度下,单颗Rubin GPU的推理算力达到了惊人的50 PFLOPS ,这是上一代Blackwell的5倍。即便是更吃力的训练任务,算力也提升了3.5倍。

更疯狂的是那个被称为"NVL72"的机柜系统------塞进了72颗Rubin GPU和36颗Vera CPU。这一柜子的算力,足以让任何现存的超算汗颜。

但对企业来说,最性感的数字不是算力,而是成本。

黄仁勋在现场抛出了一个让所有云厂商眼红的承诺:成本降低90%。 利用Rubin平台,处理每100万个Token的推理成本将降至Blackwell时代的十分之一。这意味着,以后不管是ChatGPT还是各种AI助手,它们的"思考"费用将大幅缩水。对于训练那些万亿参数级别的"专家混合模型"(MoE),你只需要以前四分之一的硬件数量就能搞定。

真正的战略意图:物理AI与推理时代

为什么英伟达这么急?因为AI变了。

如果说过去几年是AI都在"读万卷书"(训练),那么2026年开始,AI要"行万里路"(推理与应用)。

黄仁勋敏锐地捕捉到了这一点。Rubin平台的很多特性,比如高达22 TB/s的内存带宽和全新的"推理上下文内存存储",都是为了解决大模型在实际应用中"记性不好"和"反应太慢"的问题。

更重要的是,英伟达开始通过Rubin平台全面进军**"物理AI"**。不管是现场开源的自动驾驶模型Alpamayo,还是机器人模型GR00T,都在暗示一件事:英伟达的算力不仅要在云端生成文字,还要下凡到物理世界,去控制机器人、去驾驶汽车。

尾声:铲子越卖越好

虽然这次CES上没有看到新的GeForce游戏显卡(毕竟RTX 50系列早在2025年初就已经铺货了),但这恰恰释放了一个最强烈的信号:英伟达的战略重心已经彻底锁死在企业级基础设施上。

目前,Vera Rubin已经进入全面生产阶段,2026年下半年,微软、谷歌、亚马逊这些巨头就会收到第一批货。

在这场AI淘金热中,黄仁勋不仅在卖铲子,他现在连挖矿的挖掘机、运输队和精炼厂都给你造好了。至于你是挖金子还是挖石头,那就是你自己的事了。对于我们普通人来说,这或许意味着,那个更加聪明、反应更快且更便宜的AI时代,真的要来了。

如果你也对最新的AI信息感兴趣或者有疑问 都可以加入我的大家庭 第一时间分享最新AI资讯、工具、教程、文档 欢迎你的加入!!!😉😉😉

公众号:墨风如雪小站