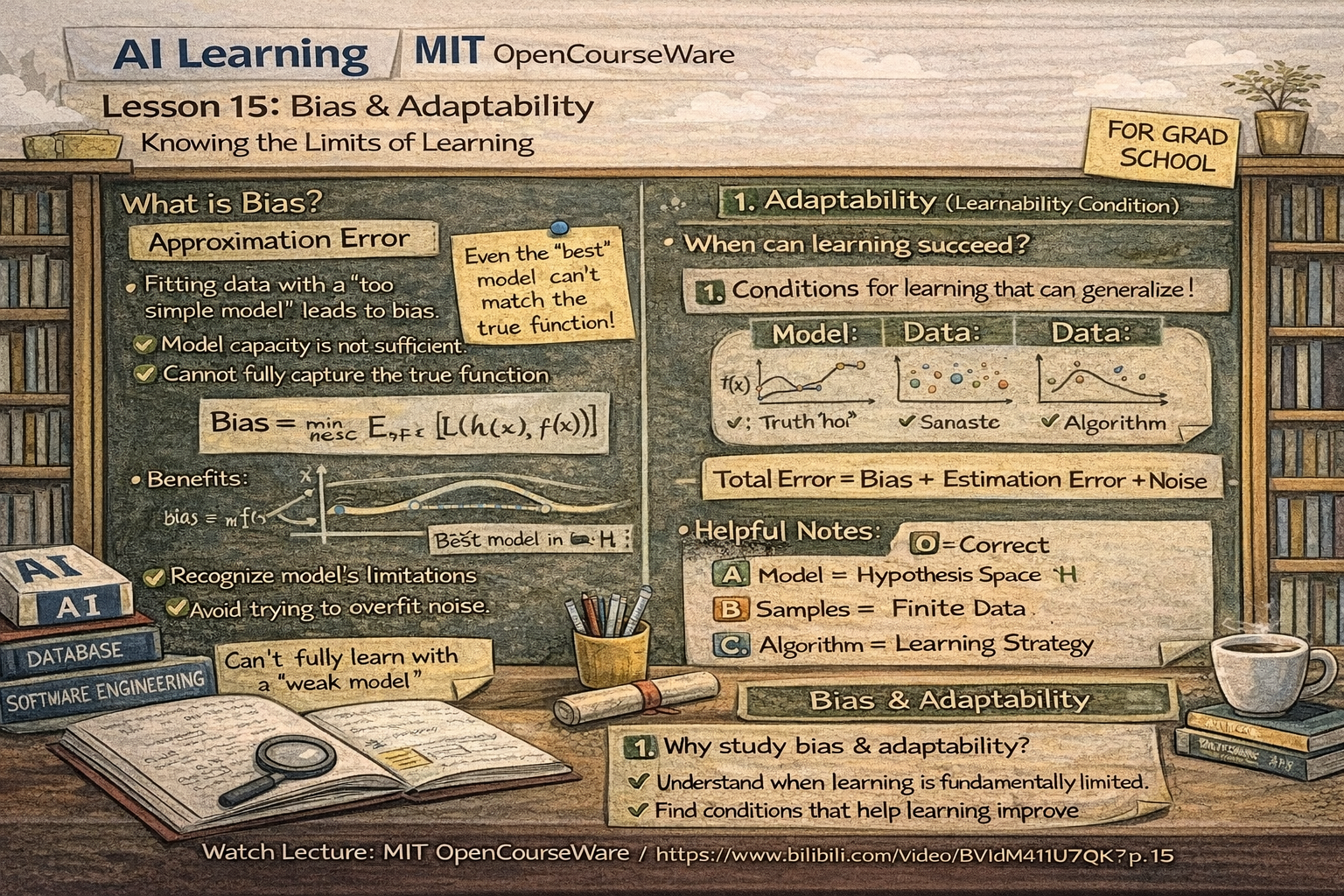

人工智能学习-AI-MIT公开课第 15 讲学习:相近差错、受适应条件

- 1-前言

- 2-课程链接

- 3-具体内容解释说明

-

- [一、什么是「相近差错」(近似误差 / Approximation Error)](#一、什么是「相近差错」(近似误差 / Approximation Error))

-

- [1️⃣ 一句话版](#1️⃣ 一句话版)

- [2️⃣ 正式一点的解释](#2️⃣ 正式一点的解释)

- [3️⃣ 生活类比(非常重要,面试/考试好用)](#3️⃣ 生活类比(非常重要,面试/考试好用))

- [4️⃣ 相近差错大的原因](#4️⃣ 相近差错大的原因)

- [二、什么是「受适应条件」(可学习条件 / Learnability Condition)](#二、什么是「受适应条件」(可学习条件 / Learnability Condition))

-

- [1️⃣ 一句话版](#1️⃣ 一句话版)

- [2️⃣ 核心问题](#2️⃣ 核心问题)

- [3️⃣ 关键思想(考试常考)](#3️⃣ 关键思想(考试常考))

- [4️⃣ 和「相近差错」的关系(重点)](#4️⃣ 和「相近差错」的关系(重点))

- [三、为什么这节课排在 SVM、Boosting 前面?](#三、为什么这节课排在 SVM、Boosting 前面?)

- [四、考试 & 面试用标准表述(可背)](#四、考试 & 面试用标准表述(可背))

- 4-课后练习(日语版本)

- 問題5(誤差分解)

- 問題6(仮説空間と学習)

- 問題7(学習の成立条件)

- 問題8(学習観・認知的側面)

- 5-课后答案解析

- 6-总结

1-前言

为了应对大学院考试,我们来学习相关人工智能相关知识,并且是基于相关课程。使用课程为MIT的公开课。

通过学习,也算是做笔记,让自己更理解些。

2-课程链接

是在B站看的视频,链接如下:

https://www.bilibili.com/video/BV1dM411U7qK?spm_id_from=333.788.videopod.episodes&vd_source=631b10b31b63df323bac39281ed4aff3&p=15

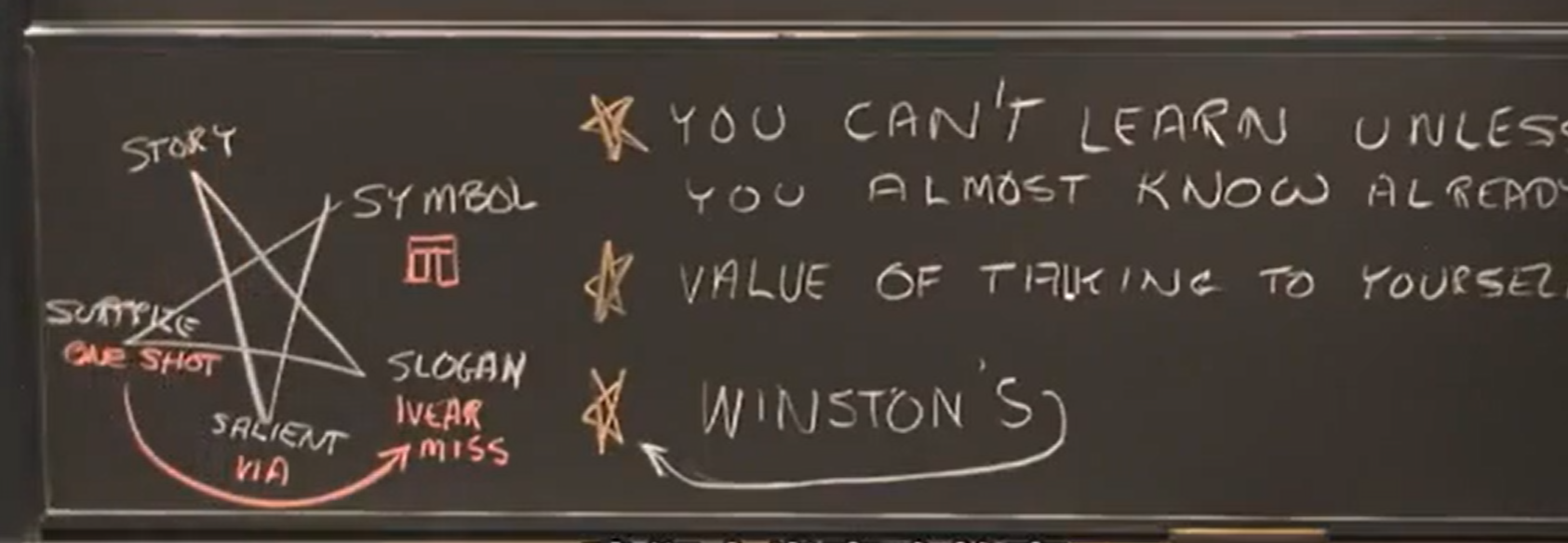

思想出名五个条件

- Story(故事)

- Symbol(符号)

- Slogan(口号)

- Salient(显著特征)

- Surprise / One shot(一次性冲击)

3-具体内容解释说明

一、什么是「相近差错」(近似误差 / Approximation Error)

1️⃣ 一句话版

模型能力不够强 → 就算学到最好,也和真实目标有差距

2️⃣ 正式一点的解释

在监督学习中,我们想学的是真实目标函数 ( f(x) ),

但我们只能在一个假设空间(模型集合)( \mathcal{H} ) 里选模型。

相近差错指的是:

在所有能选的模型中,最好的那个模型

距离真实函数 ( f(x) ) 仍然存在的误差

📌 换句话说:

- 不是没学好

- 而是模型"先天能力"不够

3️⃣ 生活类比(非常重要,面试/考试好用)

- 用直线 去拟合正弦曲线

- 不管你怎么调参数

👉 都不可能拟合得完全一致

这时候产生的误差就是:

👉 相近差错(模型偏差 / bias)

4️⃣ 相近差错大的原因

- 模型太简单(线性模型拟合非线性)

- 特征表达能力不够

- 假设空间受限

二、什么是「受适应条件」(可学习条件 / Learnability Condition)

这个词在不同教材里翻法不完全一样

常见等价概念包括:

- 可学习性条件

- PAC 学习条件

- 经验风险最小化成立条件

1️⃣ 一句话版

在什么条件下,学习算法真的能"学会"

2️⃣ 核心问题

受适应条件回答的是:

❓ 我们能不能保证:

- 用有限样本

- 通过某种学习算法

- 学到一个在"真实世界"也表现好的模型?

3️⃣ 关键思想(考试常考)

要"能学",通常需要满足以下几类条件:

✅(1)假设空间不能太复杂

- 太复杂 → 过拟合

- 太简单 → 相近差错大

👉 需要合适的模型容量

✅(2)样本数要足够

- 样本太少 → 学不到规律

- 样本足够多 → 经验误差 ≈ 泛化误差

✅(3)学习算法是"稳定的"

- 小扰动不导致大变化

- 能从经验风险收敛到真实风险

4️⃣ 和「相近差错」的关系(重点)

学习误差通常被分成三部分:

\\text{总误差} = \\underbrace{\\text{相近差错}}*{\\text{模型能力}} + \\underbrace{\\text{估计误差}}* {\\text{样本有限}} + \\underbrace{\\text{噪声}}

📌 受适应条件讨论的是:

在什么条件下

👉 后两项可以随着数据增多而变小

但:

- 相近差错是模型"先天决定的"

- 数据再多也消不掉

三、为什么这节课排在 SVM、Boosting 前面?

这是一个非常经典的课程结构:

-

先讲

👉 "理论上,什么能学 / 什么学不了"

-

再讲

👉 SVM / Boosting 这些具体算法

-

让你理解:

- 为什么要控制模型复杂度

- 为什么要最大间隔

- 为什么 boosting 能降低偏差/方差

四、考试 & 面试用标准表述(可背)

相近差错是指在给定假设空间内,

即使选择最优模型,

由于模型表达能力有限,

与真实目标函数之间仍然存在的误差。

受适应条件是指在样本数、假设空间复杂度以及学习算法等条件满足时,经验风险最小化能够保证模型对未知数据具有良好的泛化能力。

4-课后练习(日语版本)

問題5(誤差分解)

学習における誤差の要因に関する説明として,最も不適切なものはどれか。

A. 相近差错は,仮説空間の表現能力に依存する

B. 推定誤差は,学習データ数の増加によって小さくなる可能性がある

C. ノイズ誤差は,仮説空間を拡大することで完全に除去できる

D. 全体の誤差は,複数の要因の和として考えられる

問題6(仮説空間と学習)

仮説空間に関する次の記述のうち,本節の内容と最も一致するものはどれか。

A. 仮説空間は大きければ大きいほど学習性能が向上する

B. 仮説空間が小さいほど,相近差错は常に小さくなる

C. 仮説空間は,対象問題に十分近い構造を持つ必要がある

D. 仮説空間の選択は,学習結果にほとんど影響を与えない

問題7(学習の成立条件)

次のうち,学習が成立しにくい状況として最も適切なものはどれか。

A. 仮説空間が真の関数と十分に近い場合

B. 学習データが仮説空間に適合している場合

C. 仮説空間が真の概念とかけ離れている場合

D. 学習アルゴリズムが安定している場合

問題8(学習観・認知的側面)

Patrick Winston の学習観に基づく説明として,最も適切なものはどれか。

A. 学習は完全に未知な状態から始まる

B. 学習は反復回数の多さのみによって決まる

C. 学習は既存の知識構造との関連付けによって促進される

D. 学習は常に大量の訓練データを必要とする

5-课后答案解析

問題5

你的答案:C

👉 判定:✅ 正确

要点一句话:

ノイズ誤差は仮説空間を拡大しても除去できない。

(噪声不是模型问题)

問題6

你的答案:A

👉 判定:❌ 错误

错因核心:

「仮説空間は大きいほど良い」

这是典型错误观点,忽略了过拟合与相近差错的权衡。

本节课立场:

仮説空間は 問題に十分近い構造 を持つ必要がある。

問題7

你的答案:C

👉 判定:✅ 正确

要点一句话:

真の概念とかけ離れた仮説空間では学習は成立しにくい。

問題8

你的答案:C

👉 判定:✅ 正确

要点一句话:

学習は既存の知識構造との関連付けによって促進される

(Winston の "almost know already")

📊 最终结果汇总

| 题号 | 你的答案 | 判定 |

|---|---|---|

| 5 | C | ✅ |

| 6 | A | ❌ |

| 7 | C | ✅ |

| 8 | C | ✅ |

正确率:3 / 4(75%)

6-总结

知识一点点记录吧,最后应对考试,打下基础