目录

[1. 安装基础环境](#1. 安装基础环境)

[2. 安装vllm启动本地模型](#2. 安装vllm启动本地模型)

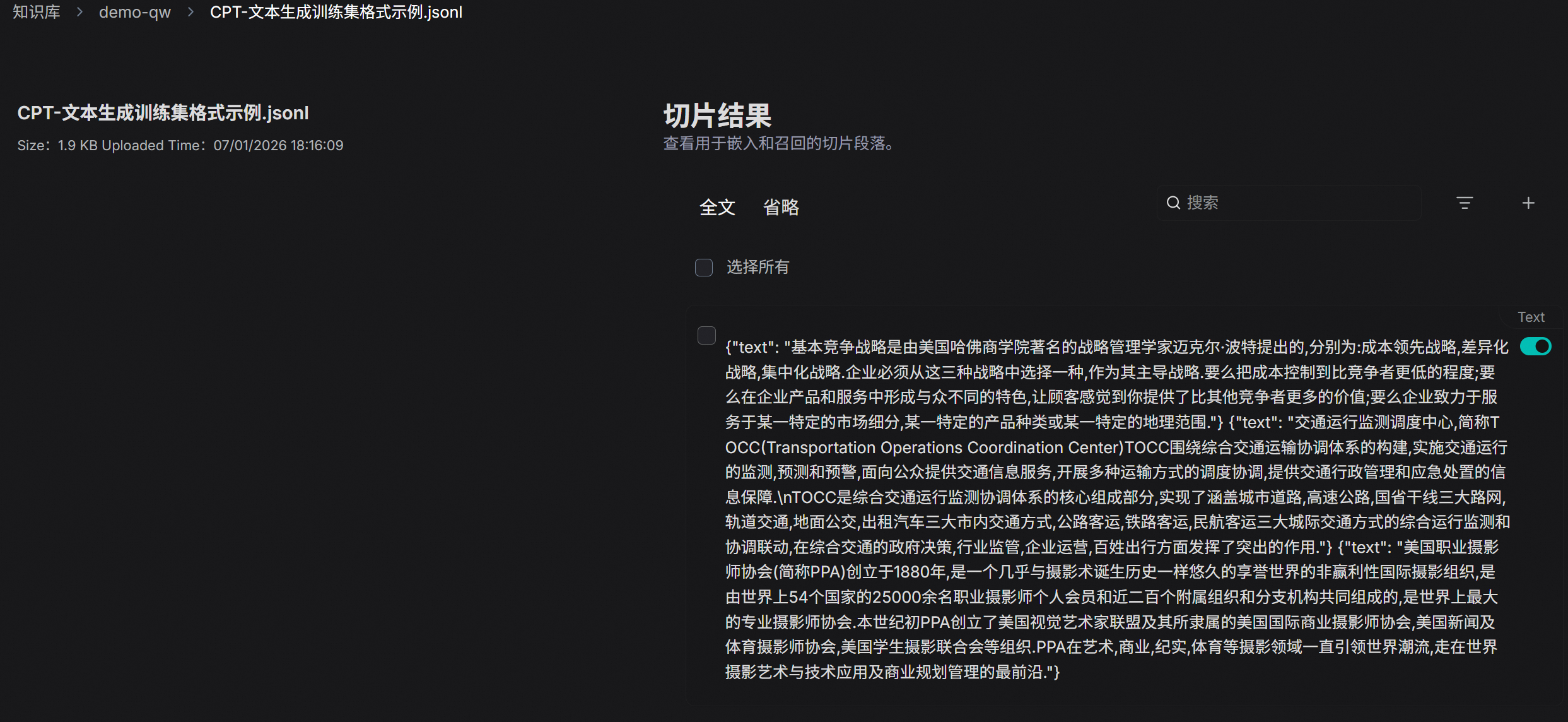

[3. 配置本地知识库](#3. 配置本地知识库)

[4. 扩展](#4. 扩展)

官方文档 https://ragflow.com.cn/docs/

1. 安装基础环境

curl -SL https://github.com/docker/compose/releases/download/v2.30.3/docker-compose-linux-x86_64 -o /usr/local/bin/docker-compose

#将可执行权限赋予安装目标路径中的独立二进制文件

sudo chmod +x /usr/local/bin/docker-compose

sudo ln -s /usr/local/bin/docker-compose /usr/bin/docker-compose

sudo sysctl -w vm.max_map_count=262144

git clone https://github.com/infiniflow/ragflow.git

cd ragflow/docker

git checkout -f v0.23.0

使用预构建的 Docker 镜像并启动服务器

# Use CPU for DeepDoc tasks:

docker compose -f docker-compose.yml up -d一共五个容器,如果镜像拉取不下来可以去 https://docker.aityp.com/ 手动先pull下来,把镜像tag改成 docker-compose-base.yml 里面的内容

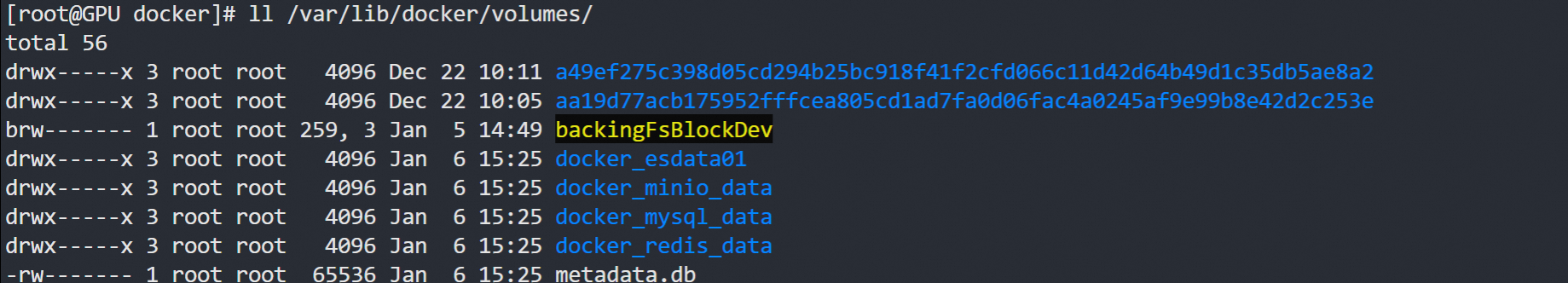

默认数据都在docker的volume下面,可以改docker-compose-base.yml自定义目录

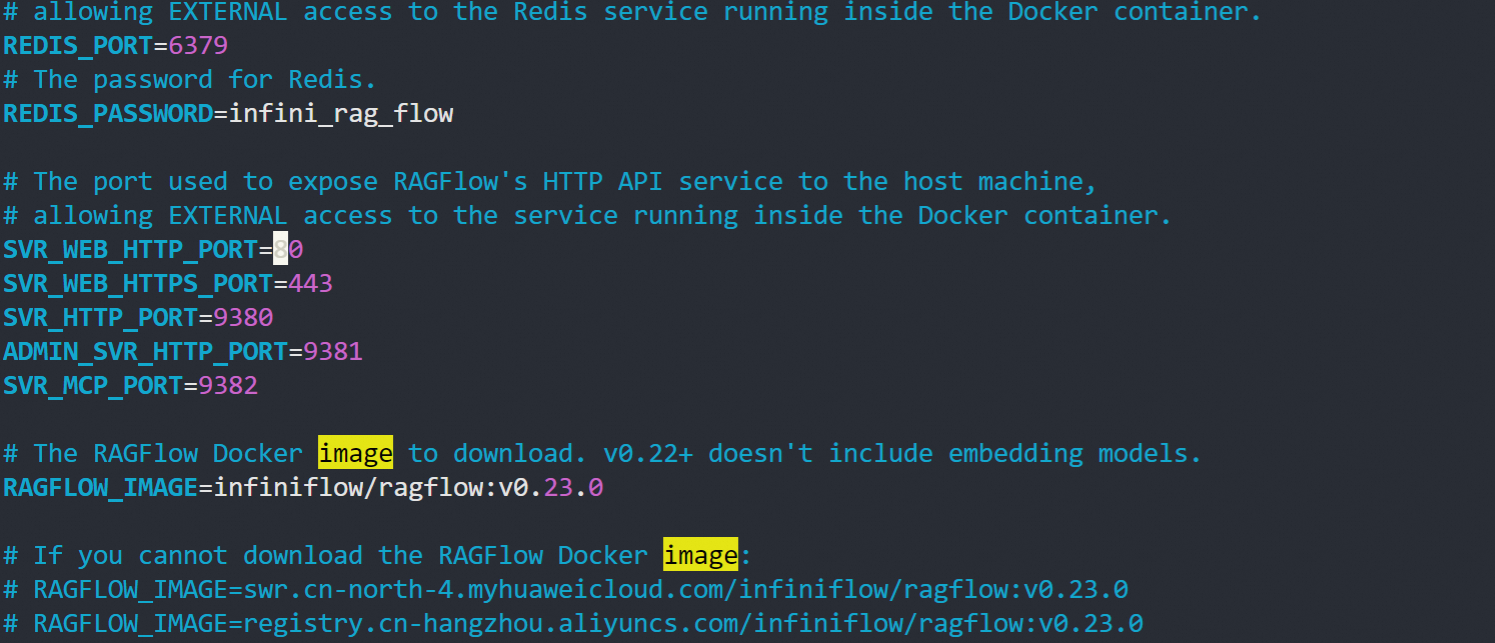

默认端口80;.env文件可以改端口

2. 安装vllm启动本地模型

ollmam比较简单新手建议使用可以参考:https://likaiyuan00.github.io/2025/05/12/%E9%83%A8%E7%BD%B2%E6%9C%AC%E5%9C%B0%E5%A4%A7%E6%A8%A1%E5%9E%8B/

集成

https://github.com/infiniflow/ragflow/blob/main/docs/guides/models/deploy_local_llm.mdx

bash

#https://modelscope.cn/models/deepseek-ai/DeepSeek-R1-Distill-Qwen-7B

#vllm启动Embedding和llm模型

#python3.12 pip install vllm modelscope

modelscope download --model deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B --local_dir /mnt/DeepSeek-R1-Distill-Qwen-1.5B

source vllm/bin/activate

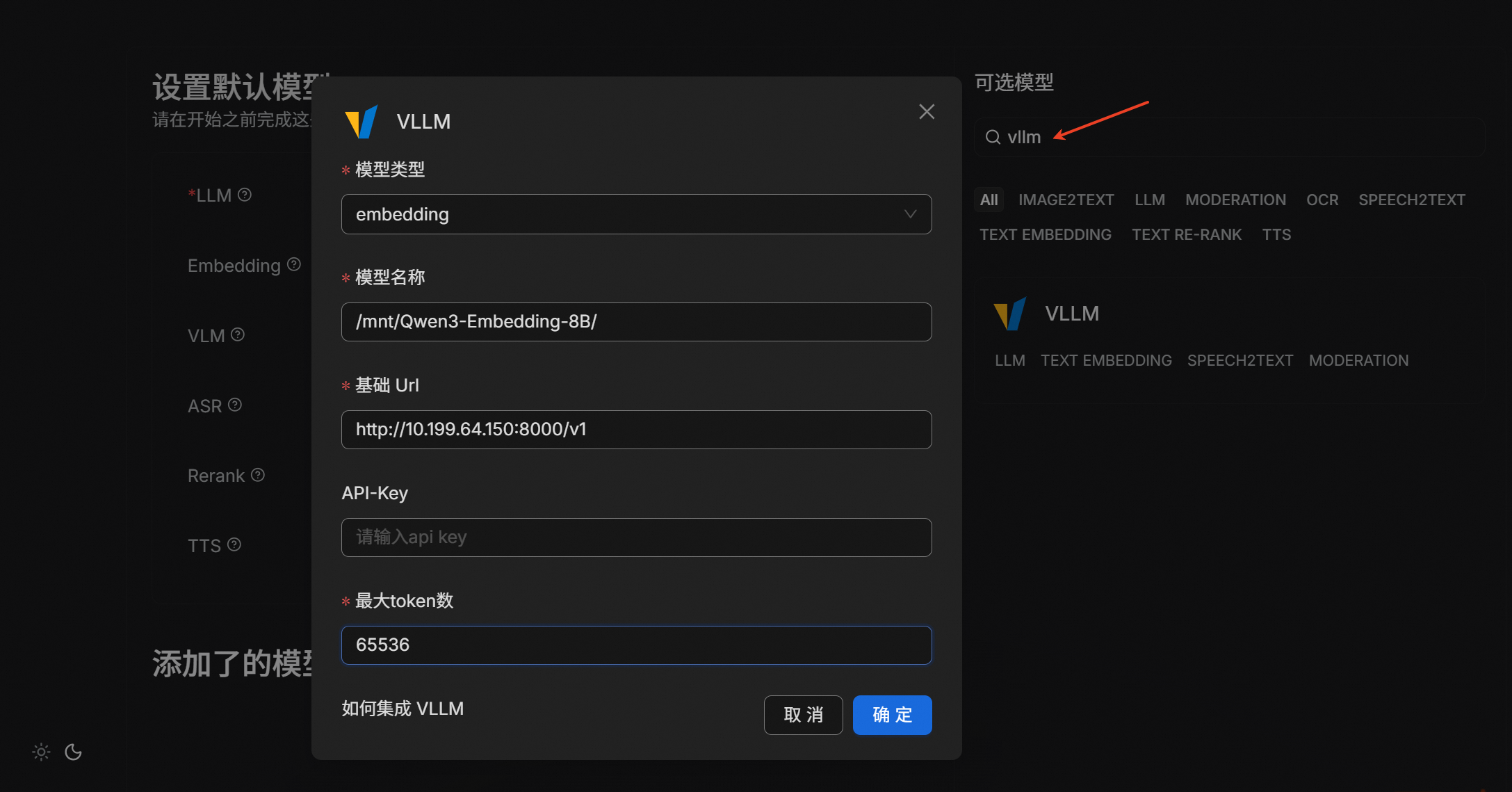

vllm serve /mnt/Qwen3-Embedding-8B/ --host 0.0.0.0

CUDA_VISIBLE_DEVICES=1 vllm serve /mnt/DeepSeek-R1-Distill-Qwen-1.5B/ --port 8001 --host 0.0.0.0

#如果知识库文本较多,需要提升召回质量可以再跑一个Rerank模型去排序3. 配置本地知识库

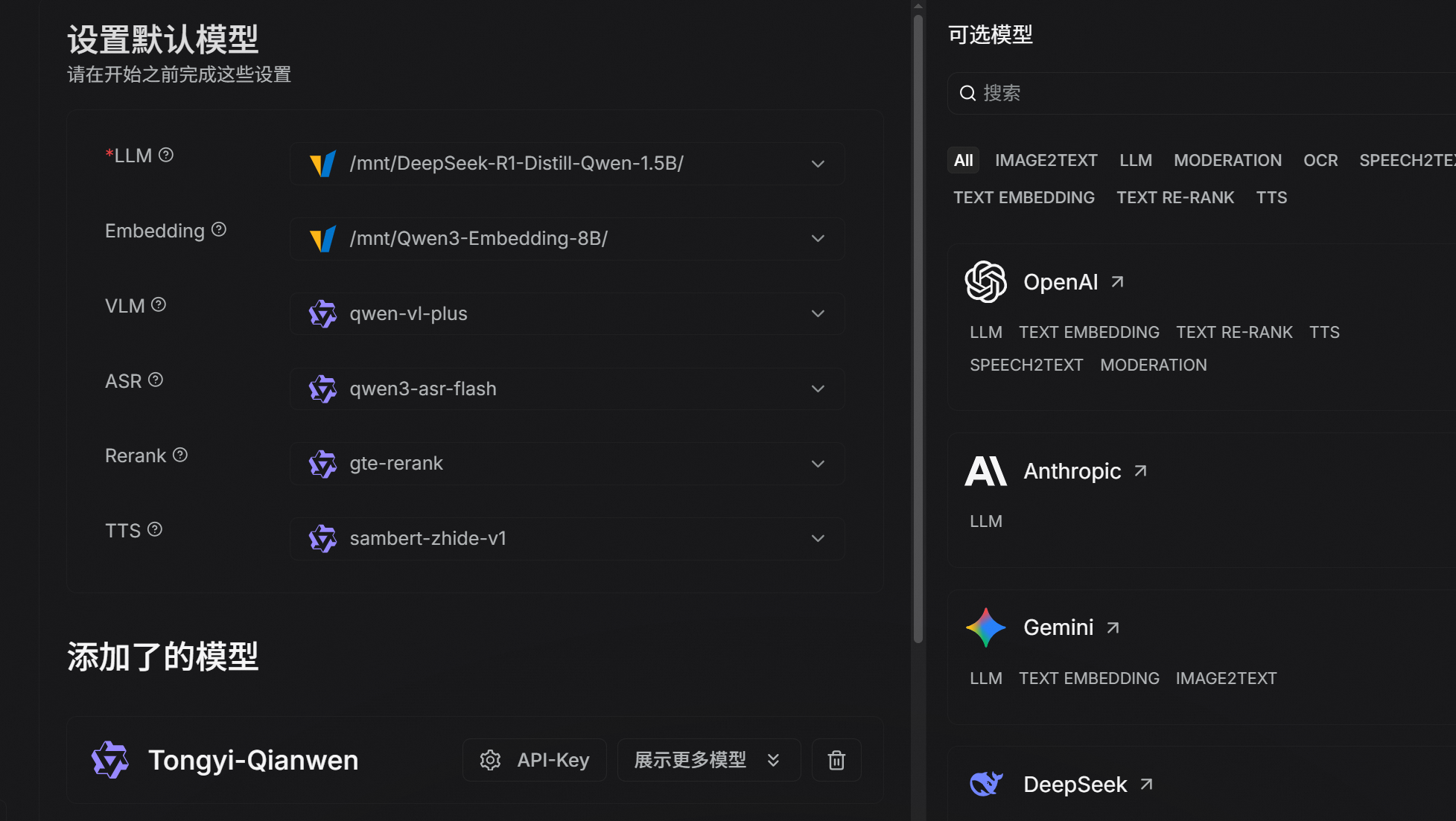

一定要点下面的保存,发现已经去检索知识库了

4. 扩展

如果想用代码自定义开发可以使用 LlamaIndex