"我们的系统越来越难维护,是不是该拆微服务了?"------这是许多技术负责人在业务增长期常问的问题。但微服务不是解药,而是手术刀。拆得好,系统焕然一新;拆不好,反而陷入"分布式单体"的泥潭:部署更复杂、调试更困难、数据更不一致。

本文不谈理想,只讲实战。我们将围绕一个可复用的迁移方法论 ,从评估、拆分、数据迁移到发布与监控,一步步还原一次真实、可控、可回滚 的微服务迁移过程,并揭示那个被所有人低估的难点。

一、评估阶段:识别高内聚模块与数据耦合点

迁移的第一步,不是写代码,而是画边界。

1. 业务模块识别

- 通过代码调用图、数据库表关系、团队分工,找出高内聚、低耦合的业务单元;

- 例如:用户管理、订单、库存、支付,往往是天然的微服务候选。

2. 数据耦合分析(关键!)

- 共享数据库表 是最大阻力。例如:

orders表被订单、风控、报表三个模块直接读写; - 外键跨模块 :

user_id在多个表中被引用,但用户逻辑散落在各处; - 事务跨功能:一个"下单"事务同时更新订单、库存、积分。

原则 :优先拆分数据边界清晰的模块,避免"拆服务不拆库"导致的隐式耦合。

二、拆分策略:按业务域(DDD)优先

技术上,微服务可以按功能、按团队、按部署拆,但最可持续的是按业务域(Domain-Driven Design, DDD)拆分。

- 限界上下文(Bounded Context) 定义服务边界;

- 每个服务拥有独立的数据库 ,不共享表;

- 服务间通过明确的 API 或事件通信,而非直接查对方 DB。

示例:

- 用户上下文:管理注册、登录、资料;

- 订单上下文:管理创建、支付、状态;

- 库存上下文:管理扣减、回滚、预警。

避免"贫血模型"拆分(如把 UserController、OrderController 拆成两个服务但共用一个库)。

三、数据迁移:双写 + 校验 + 切流(含回滚预案)

拆服务的核心挑战,是如何安全迁移数据。推荐三阶段策略:

1. 双写(Dual Write)

- 新旧系统同时写入:单体写旧库,新服务写新库;

- 通过消息队列或事务日志保证双写一致性;

- 风险:双写不一致,需严格幂等。

2. 数据校验

- 开发数据比对工具,定期对比新旧库记录;

- 关键字段(如订单金额、状态)必须 100% 一致;

- 不一致时自动告警 + 人工介入。

3. 切流与回滚

- 切流:将读流量从旧库切到新服务;

- 回滚预案:

-

- 若新服务异常,立即切回旧路径;

- 双写期间保留旧写入,确保数据不丢失;

- 回滚不是"撤销",而是"切换回已验证路径"。

关键 :切换必须可逆,数据必须可对齐。

四、发布策略:蓝绿 or 金丝雀(结合 GitLab CI)

微服务上线不能"一把梭哈"。推荐两种渐进式发布:

1. 蓝绿部署(Blue-Green)

- 同时部署新(绿)、旧(蓝)两套环境;

- 流量切换前,全量验证新环境;

- 切换瞬间完成,回滚只需改路由;

- 适合低频、高风险发布(如核心支付)。

2. 金丝雀发布(Canary)

- 先放 5% 流量到新版本;

- 观察错误率、延迟、资源使用;

- 无异常则逐步放大至 100%;

- 适合高频、快速迭代场景。

与 GitLab CI 集成:

-

在

.gitlab-ci.yml中定义多阶段流水线:deploy-canary:

script:

- kubectl apply -f canary-deployment.yaml

- ./run-smoke-tests.sh

only:

- mainpromote-to-prod:

when: manual # 人工确认

script:

- kubectl apply -f production-deployment.yaml

自动化 + 人工确认,兼顾效率与安全。

五、监控覆盖:迁移前后对比是唯一真理

没有监控的迁移,等于"闭眼开车"。

必须对比以下指标:

- 延迟(Latency):P99 是否上升?

- 错误率(Error Rate):5xx、超时是否增加?

- 资源消耗:CPU、内存、网络是否异常?

- 业务指标:下单成功率、支付转化率是否波动?

建议:

- 迁移前建立基线(Baseline);

- 迁移中开启实时告警;

- 迁移后保留旧系统监控至少一周。

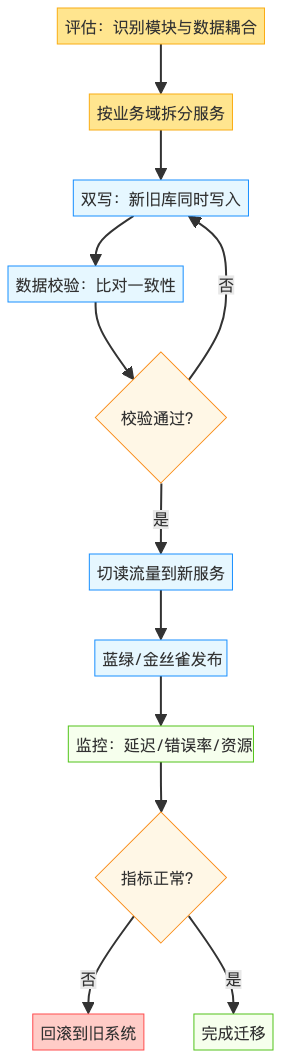

六、迁移流程全景图

下图展示了从评估到上线的完整迁移流程:

图示说明:

- 迁移是循环验证过程,非线性;

- 数据校验与监控是决策依据;

- 回滚是安全网,必须可执行;

七、经验总结:最难的是组织协作,不是技术

技术上,拆服务、迁数据、配 CI/CD 都有章可循。但真正的挑战在于人:

- 团队职责模糊:新服务谁维护?旧代码谁下线?

- 跨团队依赖:订单团队等用户团队先拆完,互相卡住;

- KPI 冲突:业务团队要快,架构团队要稳。

成功关键:

- 明确迁移Owner,端到端负责;

- 拆分与业务节奏对齐(如大促后);

- 建立跨团队协作机制(如每日站会同步阻塞点)。

结语:微服务是演进而非革命

从单体到微服务,不是一夜间推倒重建,而是一步步演进 。

每一次拆分,都应带来可度量的收益:部署更快、故障隔离、团队自治。

但请记住:微服务不是目标,而是手段 。

如果单体还能跑,就别急着拆;

如果拆了更痛,就停下来反思。

好的架构,是让业务跑得更快,而不是让技术人更忙。