✨道路是曲折的,前途是光明的!

📝 专注C/C++、Linux编程与人工智能领域,分享学习笔记!

🌟 感谢各位小伙伴的长期陪伴与支持,欢迎文末添加好友一起交流!

- 目录

-

- [引言:多模型 API 调用------构建灵活 AI 应用的核心能力](#引言:多模型 API 调用——构建灵活 AI 应用的核心能力)

- 一、各平台调用详解

- 二、代码示例:三大模型调用实现

-

- [1. 调用 OpenAI API 生成文本](#1. 调用 OpenAI API 生成文本)

- [2. 使用 Anthropic SDK 调用 Claude](#2. 使用 Anthropic SDK 调用 Claude)

- [3. 通过 Ollama 本地调用 LLaMA 3](#3. 通过 Ollama 本地调用 LLaMA 3)

- [三、统一抽象层调用多模型 API 流程图](#三、统一抽象层调用多模型 API 流程图)

- 四、最佳实践与避坑指南

-

- [1. 速率限制处理](#1. 速率限制处理)

- [2. Token 计费优化](#2. Token 计费优化)

- [3. Prompt 工程技巧](#3. Prompt 工程技巧)

- [4. 私有部署安全建议(LLaMA 3)](#4. 私有部署安全建议(LLaMA 3))

- [5. 常见坑点规避](#5. 常见坑点规避)

- 总结

目录

引言:多模型 API 调用------构建灵活 AI 应用的核心能力

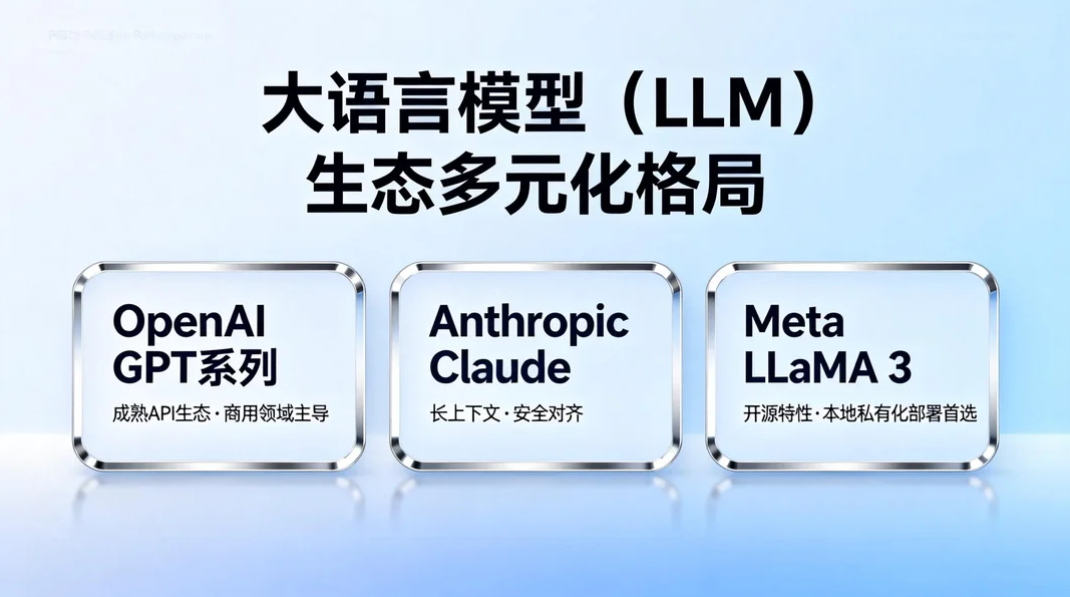

当前大语言模型(LLM)生态已形成多元化格局:OpenAI 的 GPT 系列凭借成熟的 API 生态占据商用领域主导地位,Anthropic 的 Claude 以长上下文和安全对齐见长,Meta 的 LLaMA 3 则凭借开源特性成为本地私有化部署的首选。

在实际开发中,单一模型往往无法满足所有场景需求------GPT-4o 擅长多模态交互,Claude 适合超长文档处理,LLaMA 3 则能规避商用 API 的成本和隐私风险。掌握多平台 API/本地接口的调用能力,不仅能让开发者根据场景灵活切换模型,还能通过统一抽象层构建"模型无关"的 AI 应用,大幅提升系统的灵活性、成本可控性和容错能力。

本文将系统讲解 OpenAI、Claude、LLaMA 3 的接入方式、核心差异及最佳实践,帮助开发者高效、安全地集成多模型能力。

一、各平台调用详解

1. OpenAI API(GPT-4o/GPT-4 Turbo)

核心特点

- 商用化程度最高,API 生态完善,支持文本生成、多模态交互、函数调用等能力;

- 认证机制:基于 API Key 的密钥认证,需在请求头中携带;

- 请求格式:采用 JSON 格式,核心参数包括

model(模型名称)、messages(对话历史)、temperature(随机性)等; - 输出结构:返回结构化 JSON,包含生成文本、token 消耗、结束原因等信息。

前置准备

- 注册 OpenAI 账号并创建 API Key(OpenAI API 控制台);

- 安装官方 SDK:

pip install openai(推荐使用 v1.x 版本); - 确保账户有可用额度,避免调用失败。

2. Claude API(Anthropic SDK)

核心特点

- 主打超长上下文(最高 200k tokens),合规性和安全性更优;

- 认证机制:API Key 认证,需通过 Anthropic 控制台申请;

- 请求格式:核心参数包括

model(如 claude-3-5-sonnet-20240620)、max_tokens(生成长度)、messages(对话列表); - 输出结构:返回包含

content字段的 JSON,支持流式和非流式返回。

前置准备

- 注册 Anthropic 账号并获取 API Key(Anthropic 控制台);

- 安装 SDK:

pip install anthropic; - 注意模型名称规范,不同 Claude 版本参数略有差异。

3. LLaMA 3(本地部署调用)

核心特点

- 开源免费,支持本地私有化部署,无 API 调用成本和隐私风险;

- 调用方式:主流方案包括 Ollama(一键部署)、llama.cpp(轻量级推理)、Hugging Face Transformers(灵活定制);

- 无 API Key 认证,通过本地端口或直接加载模型文件调用;

- 输入输出:需自行封装请求格式,输出为纯文本或自定义结构化数据。

前置准备

- Ollama 方式 :安装 Ollama(官网),拉取 LLaMA 3 模型:

ollama pull llama3:8b; - Transformers 方式 :安装依赖

pip install transformers torch accelerate,下载 LLaMA 3 权重(需通过 Meta 申请授权)。

二、代码示例:三大模型调用实现

1. 调用 OpenAI API 生成文本

python

import os

from openai import OpenAI

from openai.error import RateLimitError, AuthenticationError, APIError

# 初始化客户端(推荐 v1.x 版本方式)

# 方式1:通过环境变量设置 API Key(推荐,避免硬编码)

os.environ["OPENAI_API_KEY"] = "your-openai-api-key"

client = OpenAI()

# 方式2:直接传入 API Key(不推荐,存在安全风险)

# client = OpenAI(api_key="your-openai-api-key")

def call_openai(prompt: str, model: str = "gpt-4o-mini") -> str:

"""

调用 OpenAI API 生成文本

:param prompt: 用户输入提示词

:param model: 模型名称,如 gpt-4o、gpt-4o-mini、gpt-3.5-turbo

:return: 生成的文本内容

"""

try:

# 构建请求

response = client.chat.completions.create(

model=model,

messages=[

{"role": "system", "content": "你是一个专业的技术助手,回答简洁准确。"},

{"role": "user", "content": prompt}

],

temperature=0.7, # 随机性,0-2 之间,值越高越随机

max_tokens=1024, # 最大生成 token 数

timeout=30 # 请求超时时间

)

# 提取生成结果

result = response.choices[0].message.content.strip()

# 打印 token 消耗(用于成本核算)

print(f"Token 消耗:输入 {response.usage.prompt_tokens} | 输出 {response.usage.completion_tokens}")

return result

except AuthenticationError:

print("错误:API Key 认证失败,请检查密钥是否正确")

return ""

except RateLimitError:

print("错误:API 调用速率超限,请等待或升级额度")

return ""

except APIError as e:

print(f"错误:OpenAI API 调用失败 - {e}")

return ""

except Exception as e:

print(f"未知错误:{e}")

return ""

# 调用示例

if __name__ == "__main__":

prompt = "解释一下大模型的 token 计费机制"

result = call_openai(prompt)

print("OpenAI 响应结果:\n", result)2. 使用 Anthropic SDK 调用 Claude

python

import os

import anthropic

from anthropic import AnthropicError, RateLimitError, AuthenticationError

# 初始化客户端

os.environ["ANTHROPIC_API_KEY"] = "your-anthropic-api-key"

client = anthropic.Anthropic()

def call_claude(prompt: str, model: str = "claude-3-5-sonnet-20240620") -> str:

"""

调用 Claude API 生成文本

:param prompt: 用户输入提示词

:param model: 模型名称,如 claude-3-5-sonnet、claude-3-opus

:return: 生成的文本内容

"""

try:

response = client.messages.create(

model=model,

max_tokens=1024,

temperature=0.7,

system="你是一个专业的技术助手,回答简洁准确。",

messages=[

{"role": "user", "content": prompt}

]

)

# 提取结果(Claude 返回的是 content 列表,需拼接)

result = "".join([content.text for content in response.content]).strip()

print(f"Token 消耗:输入 {response.usage.input_tokens} | 输出 {response.usage.output_tokens}")

return result

except AuthenticationError:

print("错误:API Key 认证失败,请检查密钥")

return ""

except RateLimitError:

print("错误:调用速率超限,请稍后重试")

return ""

except AnthropicError as e:

print(f"错误:Claude API 调用失败 - {e}")

return ""

except Exception as e:

print(f"未知错误:{e}")

return ""

# 调用示例

if __name__ == "__main__":

prompt = "解释一下大模型的 token 计费机制"

result = call_claude(prompt)

print("Claude 响应结果:\n", result)3. 通过 Ollama 本地调用 LLaMA 3

python

import requests

import json

from typing import Optional

# Ollama 默认本地端口:11434

OLLAMA_BASE_URL = "http://localhost:11434/api"

def call_llama3(prompt: str, model: str = "llama3:8b", stream: bool = False) -> Optional[str]:

"""

通过 Ollama 调用本地部署的 LLaMA 3

:param prompt: 用户输入提示词

:param model: 模型名称(需先通过 ollama pull 下载)

:param stream: 是否流式返回

:return: 生成的文本内容

"""

# 构建请求数据

data = {

"model": model,

"prompt": prompt,

"system": "你是一个专业的技术助手,回答简洁准确。",

"temperature": 0.7,

"max_tokens": 1024,

"stream": stream

}

try:

# 非流式调用

if not stream:

response = requests.post(

f"{OLLAMA_BASE_URL}/generate",

json=data,

timeout=60 # 本地推理可能较慢,设置较长超时

)

response.raise_for_status() # 抛出 HTTP 错误

result = response.json()["response"].strip()

print(f"Token 消耗:输入 {response.json()['prompt_eval_count']} | 输出 {response.json()['eval_count']}")

return result

# 流式调用(逐字返回)

else:

result = ""

with requests.post(

f"{OLLAMA_BASE_URL}/generate",

json=data,

stream=True,

timeout=60

) as response:

response.raise_for_status()

for line in response.iter_lines():

if line:

line_data = json.loads(line)

if "response" in line_data:

result += line_data["response"]

# 实时打印(可选)

# print(line_data["response"], end="", flush=True)

if line_data.get("done"):

print(f"\nToken 消耗:输入 {line_data['prompt_eval_count']} | 输出 {line_data['eval_count']}")

return result.strip()

except requests.exceptions.ConnectionError:

print("错误:无法连接到 Ollama 服务,请确认服务已启动(ollama serve)")

return None

except requests.exceptions.Timeout:

print("错误:请求超时,本地推理耗时过长")

return None

except Exception as e:

print(f"未知错误:{e}")

return None

# 调用示例

if __name__ == "__main__":

prompt = "解释一下大模型的 token 计费机制"

# 非流式调用

result = call_llama3(prompt)

print("LLaMA 3 响应结果:\n", result)

# 流式调用(可选)

# result = call_llama3(prompt, stream=True)

# print("\nLLaMA 3 流式响应结果:\n", result)三、统一抽象层调用多模型 API 流程图

为了避免重复开发和快速切换模型,推荐构建统一的抽象层封装多模型调用逻辑。以下是核心流程的 Mermaid 流程图:

文本/参数

OpenAI

Claude

LLaMA 3

用户输入

请求预处理

校验输入格式

标准化 Prompt

模型路由选择

选择调用模型

OpenAI 格式适配

Claude 格式适配

LLaMA 3 格式适配

发起 API 请求

本地推理调用

结果接收

结果标准化

提取核心文本

统一 Token 统计格式

错误信息标准化

返回输出

给用户结构化结果

日志/监控记录

流程图解读

- 请求预处理:统一校验输入合法性,将用户 Prompt 转换为各模型通用的格式;

- 模型路由:根据业务规则(如成本、性能、场景)选择调用的模型;

- 格式适配:将标准化请求转换为对应模型的 API 格式(如 OpenAI/Claude 的 messages 结构、LLaMA 3 的 prompt 格式);

- 请求/推理:根据模型类型发起远程 API 请求或本地推理调用;

- 结果标准化:将不同模型的返回结果转换为统一格式,屏蔽底层差异;

- 输出返回:给用户返回结构化结果,并记录日志用于监控和成本核算。

四、最佳实践与避坑指南

1. 速率限制处理

-

限流策略:针对 OpenAI/Claude 的 API 速率限制,实现令牌桶限流机制,避免超限;

-

重试机制 :使用

tenacity库实现带退避策略的重试(如指数退避),示例:pythonfrom tenacity import retry, stop_after_attempt, wait_exponential @retry(stop=stop_after_attempt(3), wait=wait_exponential(multiplier=1, min=2, max=10)) def call_api_with_retry(prompt): return call_openai(prompt) -

降级策略:当某模型 API 超限/故障时,自动切换到备用模型(如 OpenAI 故障切到 LLaMA 3)。

2. Token 计费优化

-

输入裁剪:对超长输入进行摘要处理,只保留核心信息,减少输入 Token 消耗;

-

模型选型:简单任务使用轻量模型(如 GPT-4o-mini、LLaMA 3 8B),复杂任务使用大模型,平衡效果与成本;

-

Token 预估 :调用前使用

tiktoken库预估 Token 数,避免超出预算:pythonimport tiktoken encoder = tiktoken.encoding_for_model("gpt-4o-mini") token_count = len(encoder.encode(prompt))

3. Prompt 工程技巧

- 标准化 Prompt:为不同模型设计统一的 Prompt 模板,避免重复开发;

- 指令前置:将核心指令放在 Prompt 开头(如"简洁回答,不超过 200 字"),提升模型响应准确性;

- 少样本示例:在 Prompt 中加入少量示例,引导模型输出符合预期的格式。

4. 私有部署安全建议(LLaMA 3)

- 网络隔离:本地部署的 LLaMA 3 服务仅对内网开放,禁止公网访问;

- 资源限制:通过 Docker 容器限制模型推理的 CPU/内存/显卡资源,避免资源耗尽;

- 数据安全:本地推理无需传输数据到第三方,适合处理敏感数据,但需做好模型文件的权限管理(如仅授权用户可访问)。

5. 常见坑点规避

- API Key 安全:禁止硬编码 API Key,通过环境变量/配置中心管理,避免泄露;

- 超时设置:本地推理(LLaMA 3)需设置较长超时时间(如 60 秒),避免提前中断;

- 模型版本:注意各模型的版本差异(如 Claude 3 的模型名称格式、LLaMA 3 的 8B/70B 版本),避免调用错误;

- Token 计数:不同模型的 Token 计算规则不同(如 Claude 按字符数近似,OpenAI 按分词),需单独统计。

总结

- 三大主流模型的核心差异:OpenAI/Claude 以商用 API 为主,需 API Key 认证和按 Token 计费;LLaMA 3 支持本地部署,无调用成本但需硬件资源;

- 统一抽象层是多模型集成的关键,通过格式适配和结果标准化可屏蔽底层差异,提升开发效率;

- 生产环境需重点关注速率限制、Token 成本、安全合规(如 API Key 管理、本地部署隔离),同时做好降级和重试策略保证系统稳定性。

掌握以上技巧,开发者可灵活构建适配不同场景的 AI 应用,兼顾成本、性能和隐私需求。

✍️ 坚持用 清晰易懂的图解 + 可落地的代码,让每个知识点都 简单直观!

💡 座右铭 :"道路是曲折的,前途是光明的!"