一、准备环境

bash

1、GPU:NVIDIA GeForce RTX3060

2、CPU:12th Gen Intel(R) Core(TM) i7-12700

3、内存:32GB

4、版本:Windows11 专业版、版本号:24H2、操作系统版本:26100.7623二、python环境准备

bash

# 安装python

## LLaMA-Factory 官方推荐 Python 3.8-3.10、本次使用的时3.10版本

下载python-3.10.0-amd64.exe # Windows后,双击安装即可

# cmd命令行下、验证版本

python --version三、CUDA环境安装

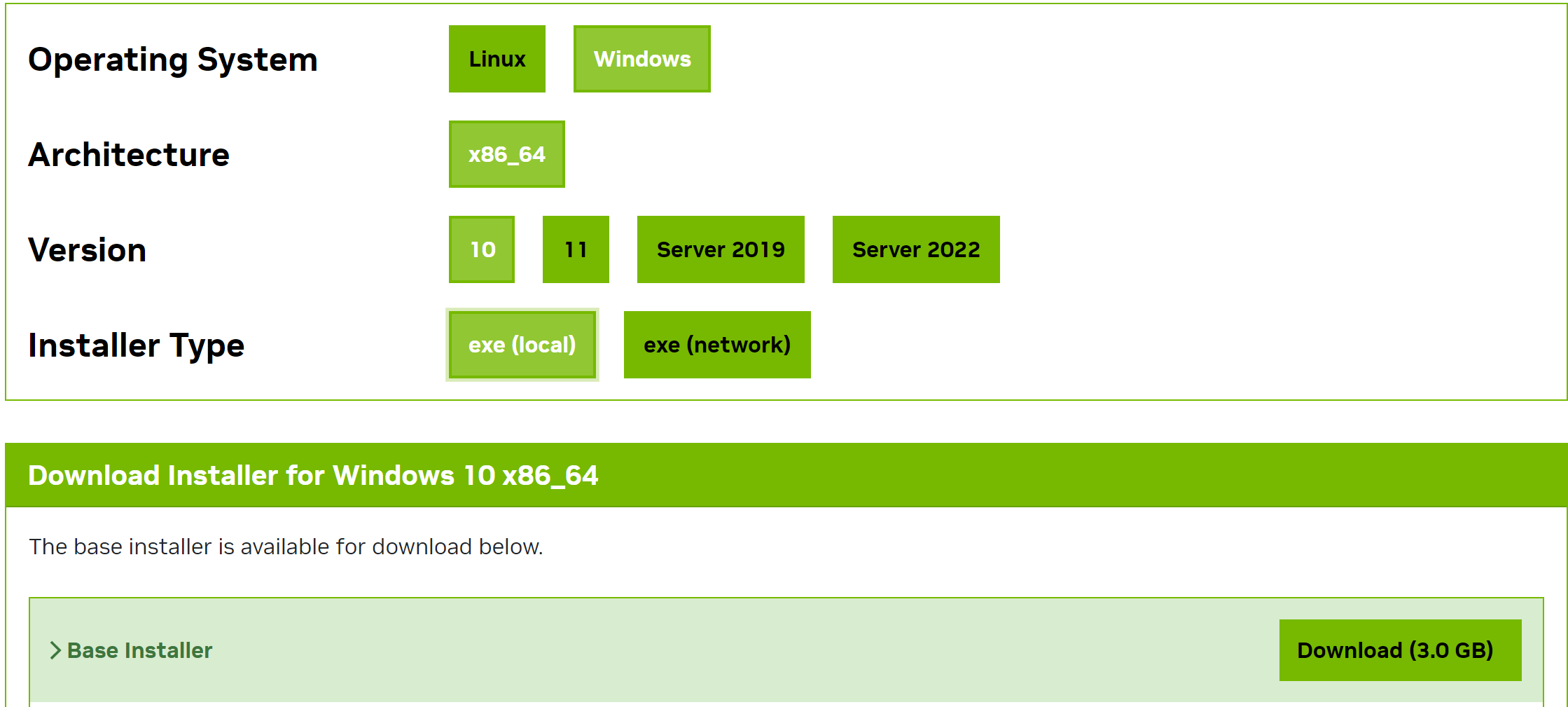

bash

# 下载、安装NVIDIA的并行计算平台和编程模型CUDA

https://developer.nvidia.com/cuda-gpus

# 安装完成后,运行命令验证

nvcc -V

bash

# 卸载CPU版

pip uninstall torch torchvision torchaudio

# 查看CU版本

nvidia-smi

# 右上角有CUDA Version

# 安装GPU版(示例CUDA 12.6)大约需要十几分钟吧

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu126

# 命令验证

C:\Windows\System32>python

Python 3.10.0 (tags/v3.10.0:b494f59, Oct 4 2021, 19:00:18) [MSC v.1929 64 bit (AMD64)] on win32

Type "help", "copyright", "credits" or "license" for more information.

>>> import torch

>>> print("CUDA 可用:", torch.cuda.is_available())

CUDA 可用: True

>>> print(f"PyTorch 版本: {torch.__version__}")

PyTorch 版本: 2.10.0+cu126

>>> print(f"CUDA 版本: {torch.version.cuda}")

CUDA 版本: 12.6四、LLaMA-Factory安装

bash

git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git

# 从国内资源中,直接download下来zip包解压也可以

https://gitcode.com/qq_52095705111/LLaMA-Factory

# 执行以下命令,大约需要十几分钟吧

cd LLaMA-Factory

pip install -e .

pip install -r requirements.txt

# 安装完成后,验证版本

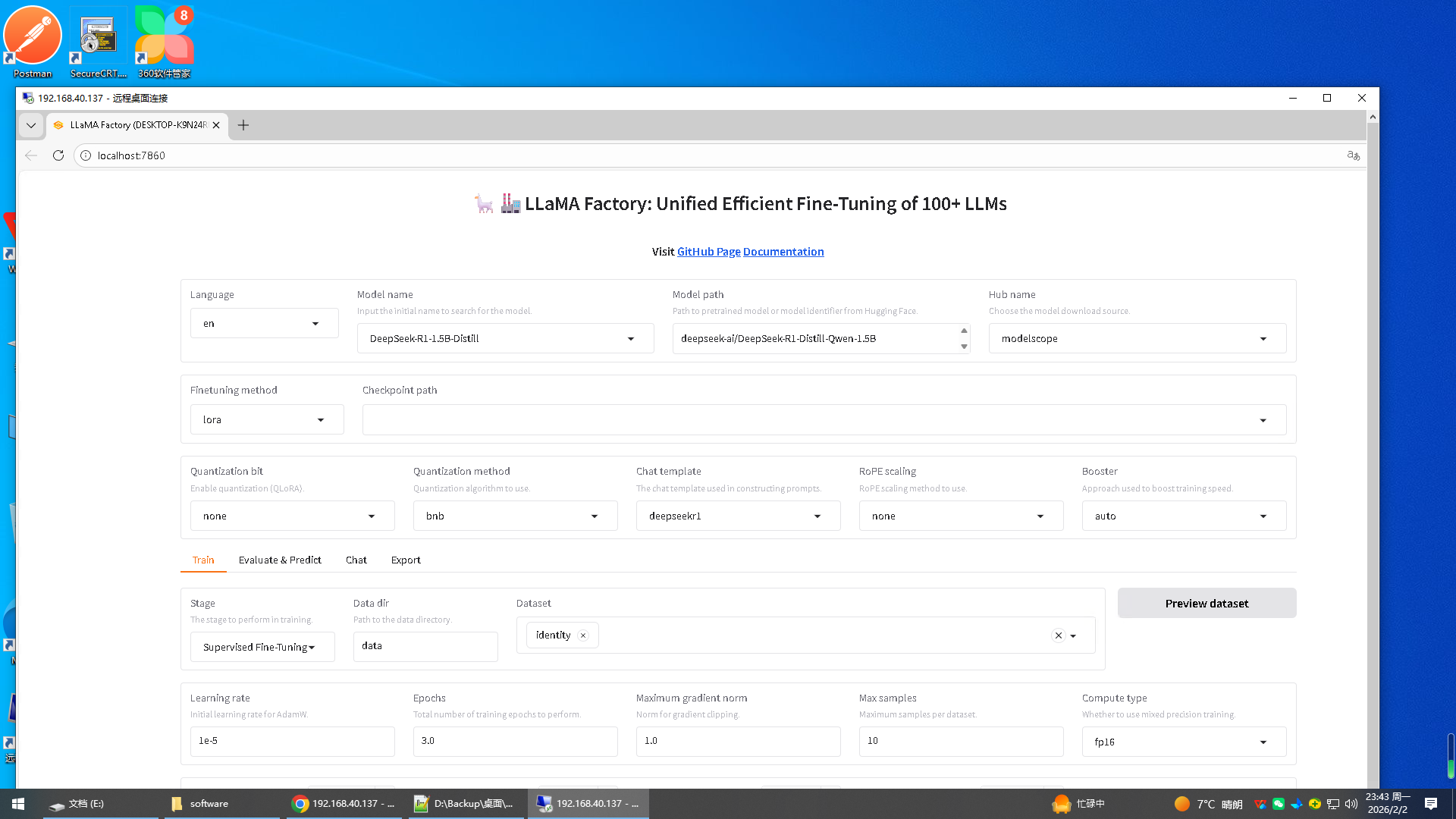

llamafactory-cli version五、运行LLaMA-Factory

bash

cd LLaMA-Factory

llamafactory-cli webui至此、全部结束!!