写在前面

本文是用于演示通过 ComfyUI 工具,部署 z_image_turbo_bf16 AI 生图模型到电脑的教程

官方说 Z-Image-Turbo 模型是 Z-Image 的精炼版,能在配置为 16GB GPU 显存(VRAM)中舒适运行。我的电脑显存为 8GB,但是 CPU 内存(RAM)有 32GB(当显存满了后可以适当找 CPU 借用内存,只是会显著降低速度),总的来说跑 Z-Image-Turbo 模型基本还算流畅

主要是在线模型要么收费贵了,要么每日扣嗖嗖的限额次数以及排队令人嫌弃,所以我打算自己部署开源模型到本地,自己随便跑,不花钱又无限制,爽歪歪

果然想挣咱程序员的钱是挺难的哈

周末抽空研究了下本地部署 AI 生图,发现 B 站 ComfyUI 相关的教程虽然多,不过都太罗嗦,并且演示的 ComfyUI 版本过于落后,我也不知道这些 up 为啥清一色的让人安装 git 和 python,并且 git 还非要配置什么环境变量,完了我也没有看到他们在哪里有用到 git 的操作(估计自己也不懂),而且基本全是 up 在评论区提供各种网盘安装包的(你敢提供我还不敢用呢,就不能老老实实提供正经的官网安装方式吗?)

还有 ComfyUI 官方文档也不与时俱进的更新,文档估计都是前几个版本的

所以我把新鲜的踩坑经验写了一篇教程,帮大家避坑

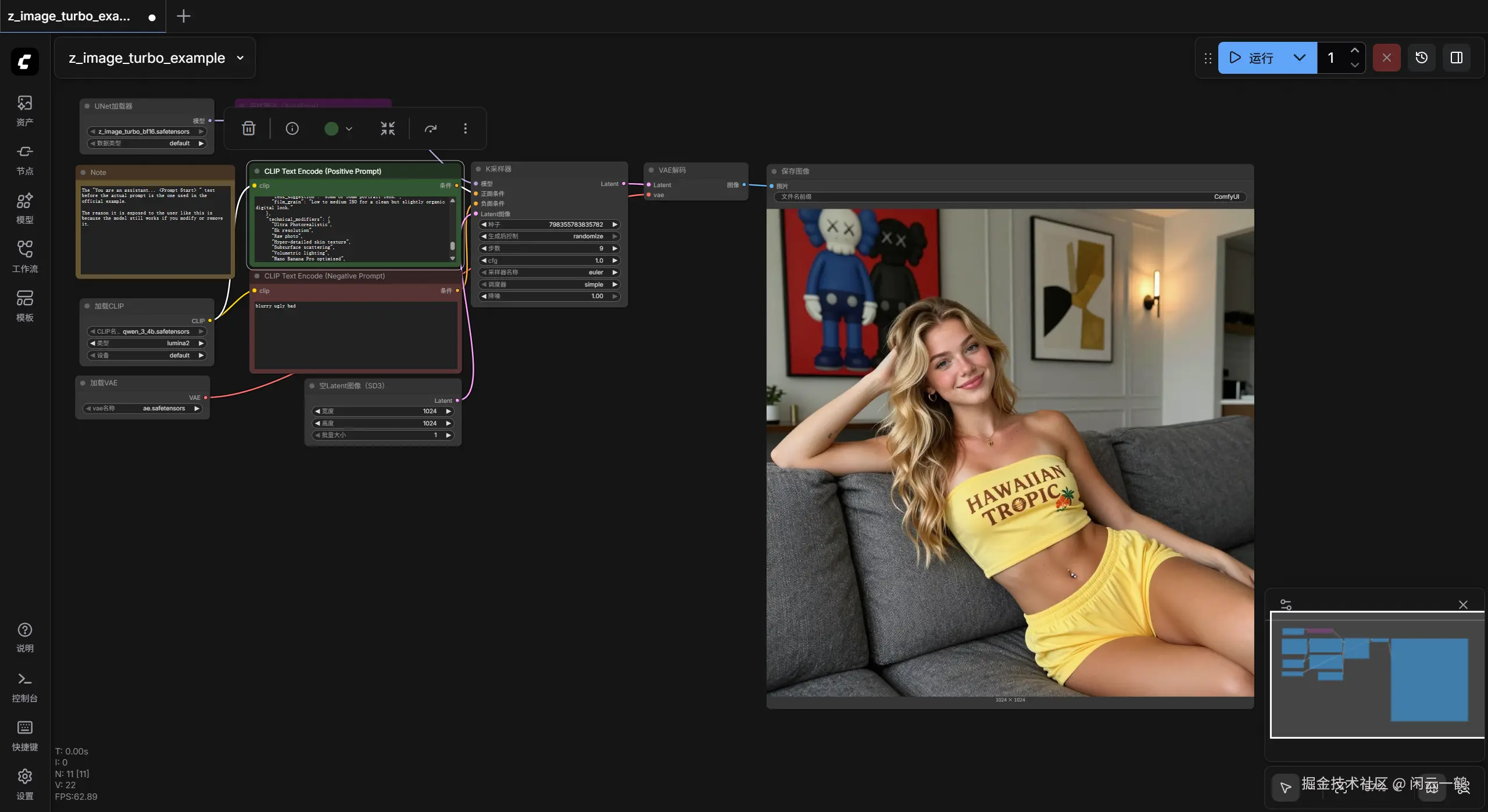

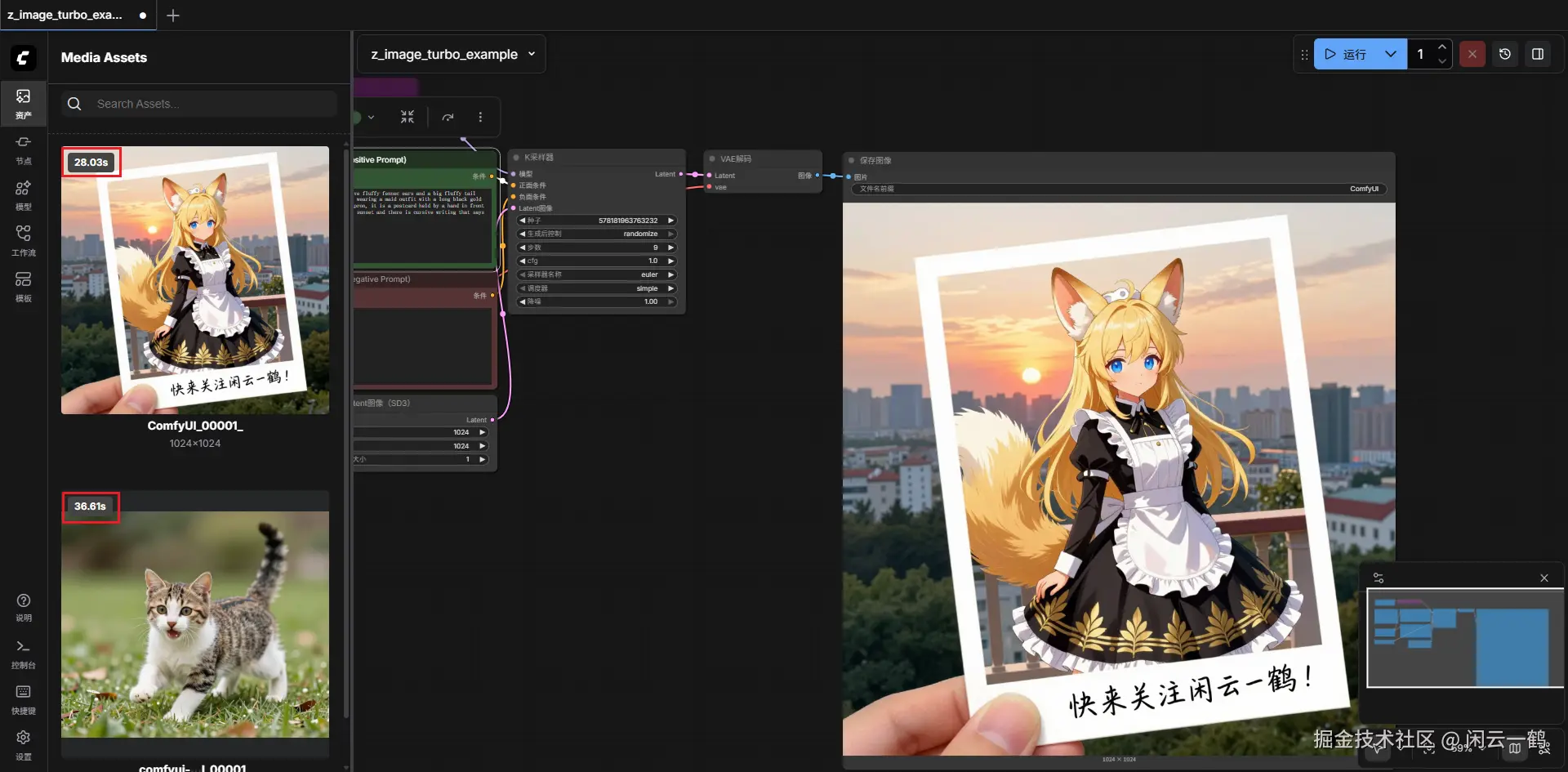

先给大家看演示效果

上面的图片都是 Z-Image-Turbo 生成的!太惊艳了!有木有!!!

用 ComfyUI 替代 git clone github 仓库

本来我是打算直接从 github 仓库下载模型部署的

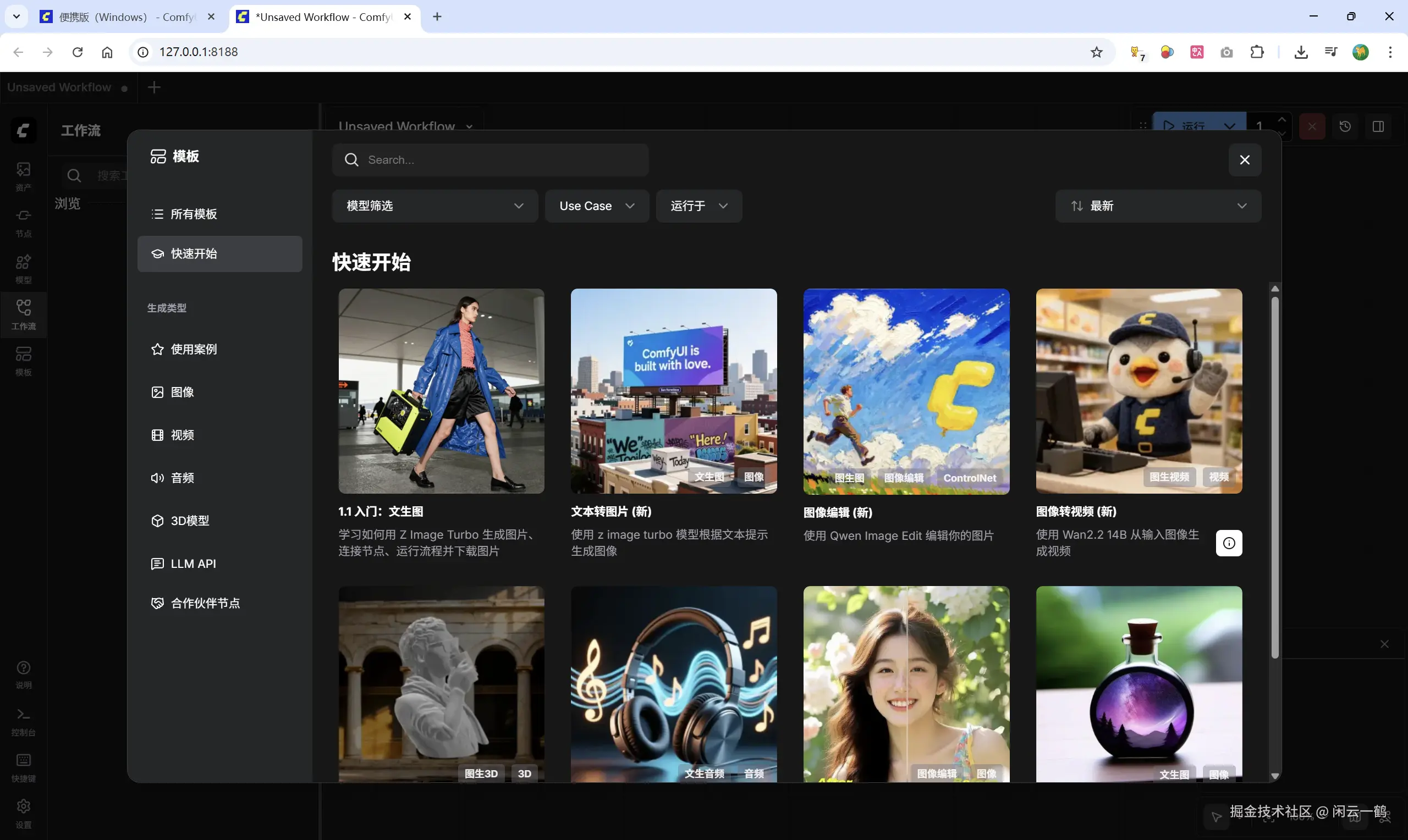

后来了解到 ComfyUI 这玩意已经很成熟了,是目前 AI 圈最火的声明式可视化 Pipeline 编排工具(图形界面)

ComfyUI 内置了许多 AI 模板,我们可以直接使用

它把模型的加载、Clip 编码、采样器、VAE 解码等逻辑封装成了节点(Nodes)。

无需配置繁琐的工作流

我们只需要把精力放在使用模型上

大大节约我们的时间和提升工作的效率

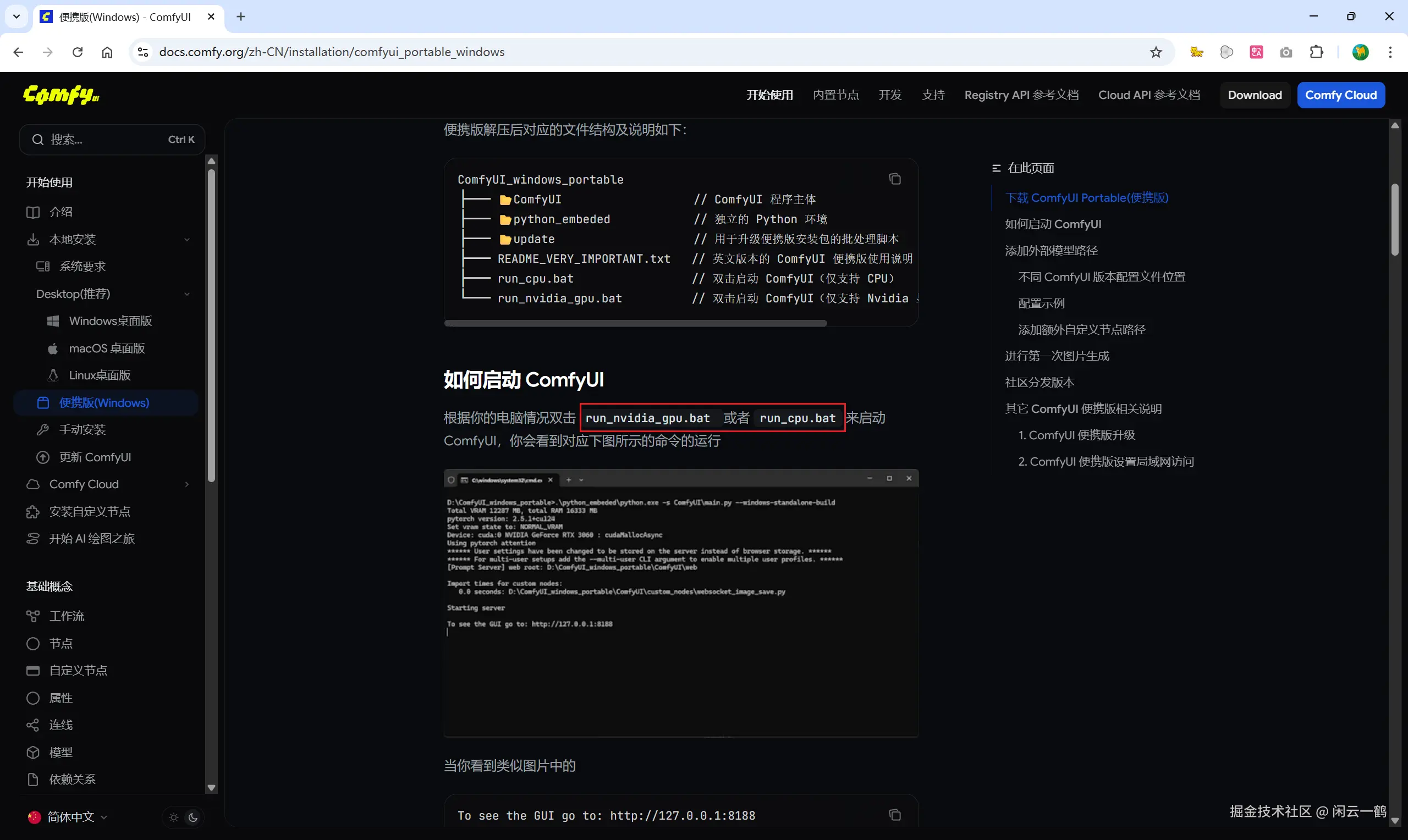

ComfyUI 下载

官网地址:docs.comfy.org/zh-CN

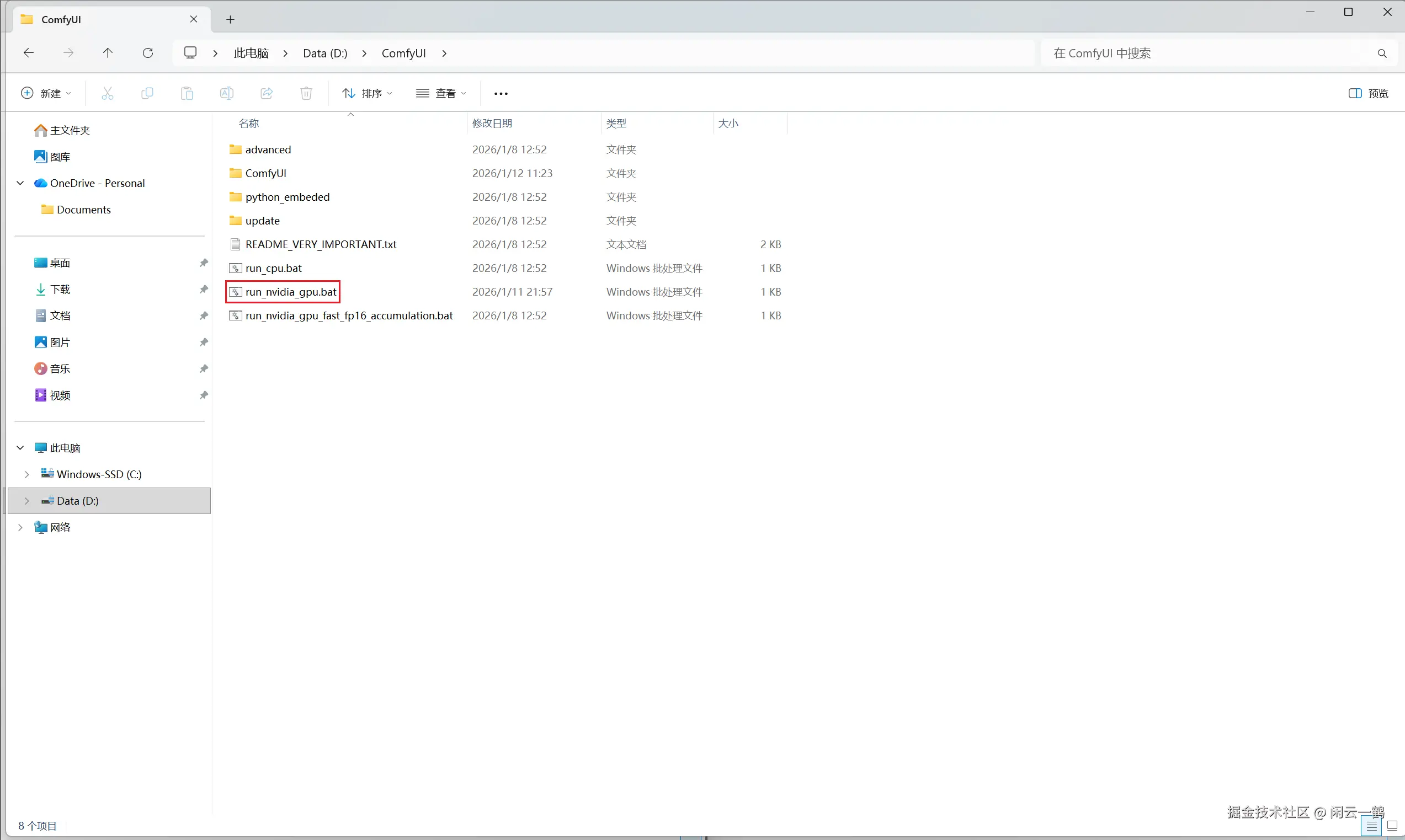

推荐大家下载 ComfyUI Portable(便携版), 便携版是一个独立封装完整的 ComfyUI Windows 版本,内部已经整合了 ComfyUI 运行所需的独立的 Python(python_embeded),无需单独安装 Python 环境

并且便携版是免安装版本,下载后只需要解压即可使用

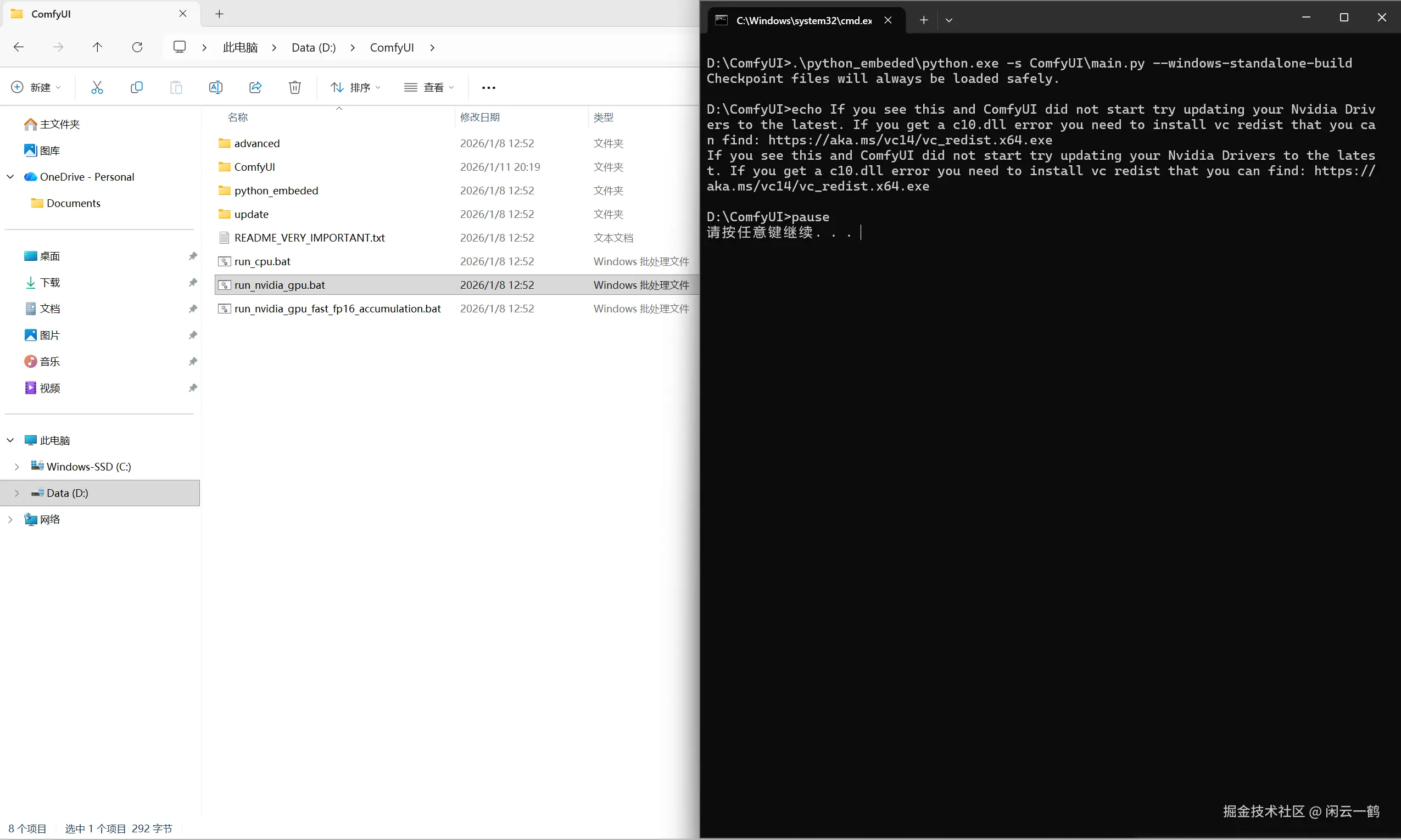

启动 ComfyUI

双击 run_nvidia_gpu.bat 启动 ComfyUI

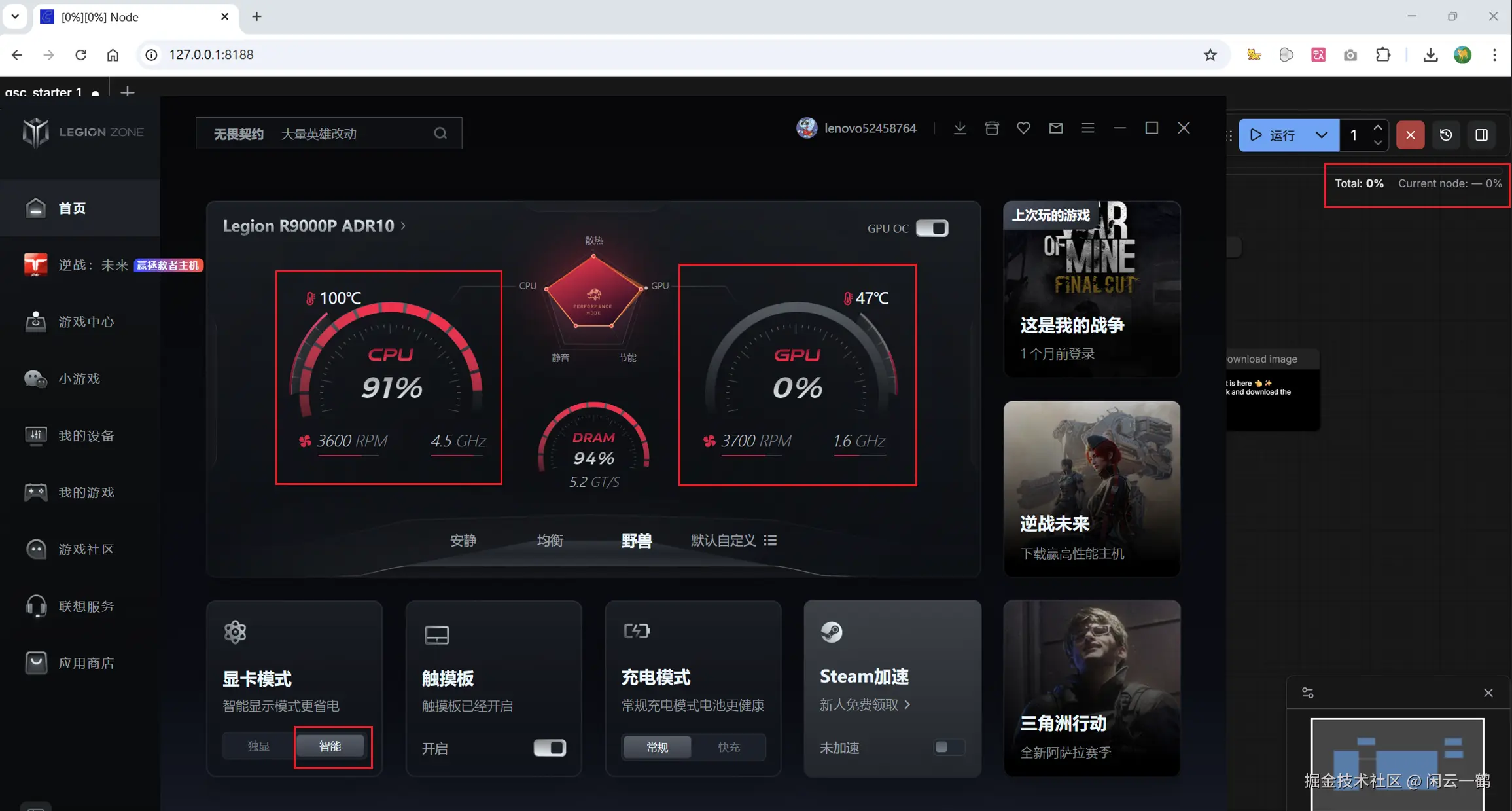

注意千万不要点击 run\_cpu.bat 版本,因为这个版本是用你的 CPU 跑模型(CPU 的强项是逻辑运算,让它跑 AI 会瞬间满载,发热量巨大,而且速度比显卡慢几十倍甚至上百倍)

run_nvidia_gpu.bat 才是让 GPU 跑模型,别问我是怎么知道的

图片中是我错误的选择了显卡模式为智能,并且用 run_cpu.bat 启动 ComfyUI 运行生图功能的结果,右上角任务进度条是 0,CPU 都快撑爆了,并且温度也快到达极限,风扇狂转。可是 GPU 却不动如山,事不关己高高挂起,现在回顾感觉又好笑又好气是怎么回事 😂

属于 deBuff 拉满了

默默吐槽一下 ComfyUI 官方文档不把 run_cpu.bat 和 run_nvidia_gpu.bat 的区别写清楚,就这两句话谁看懂是个啥意思

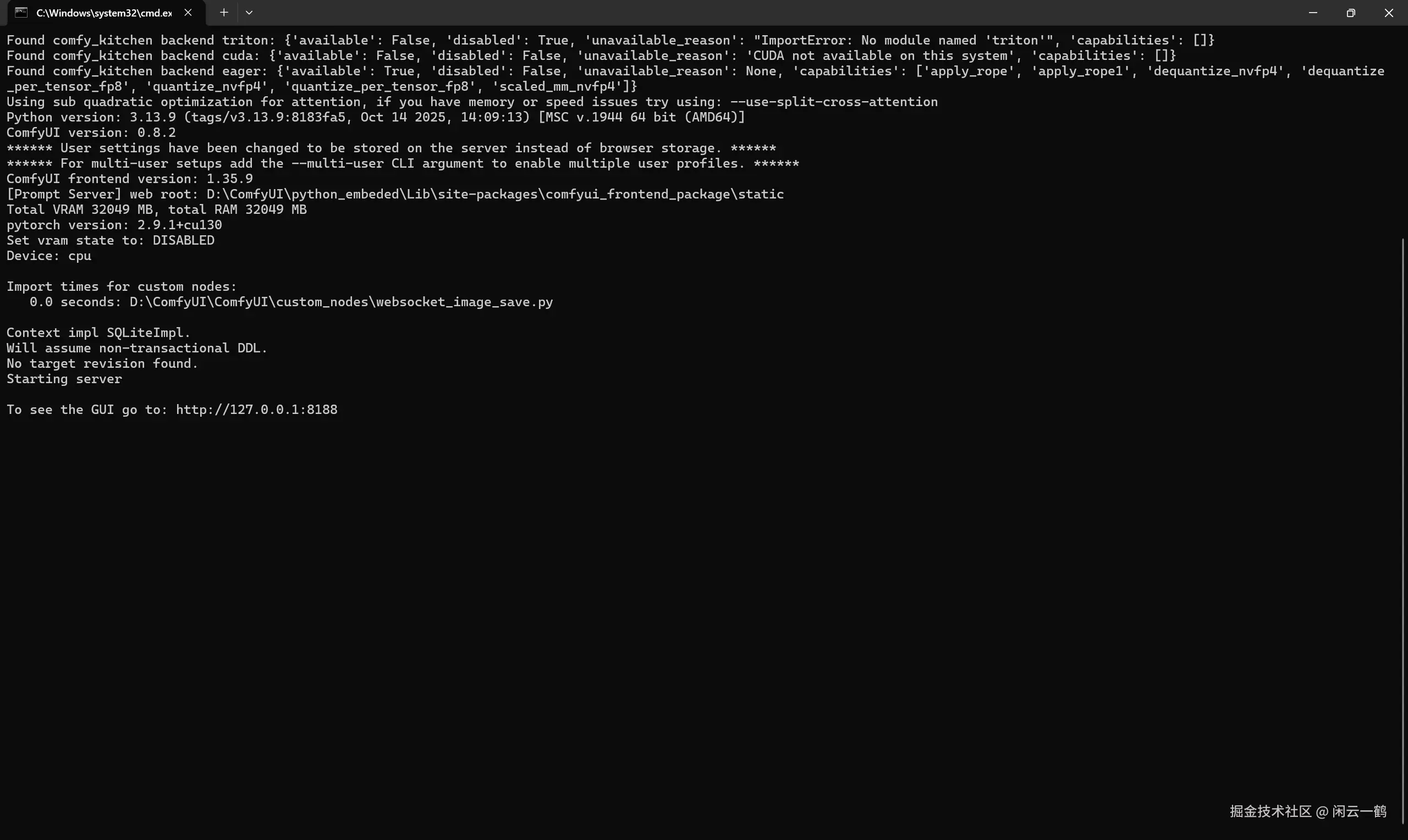

运行成功后 ComfyUI 会自动打开你的默认浏览器并访问 http://127.0.0.1:8188 地址

注意:使用过程中请不要关闭对应的命令行窗口,否则 ComfyUI 将会停止运行

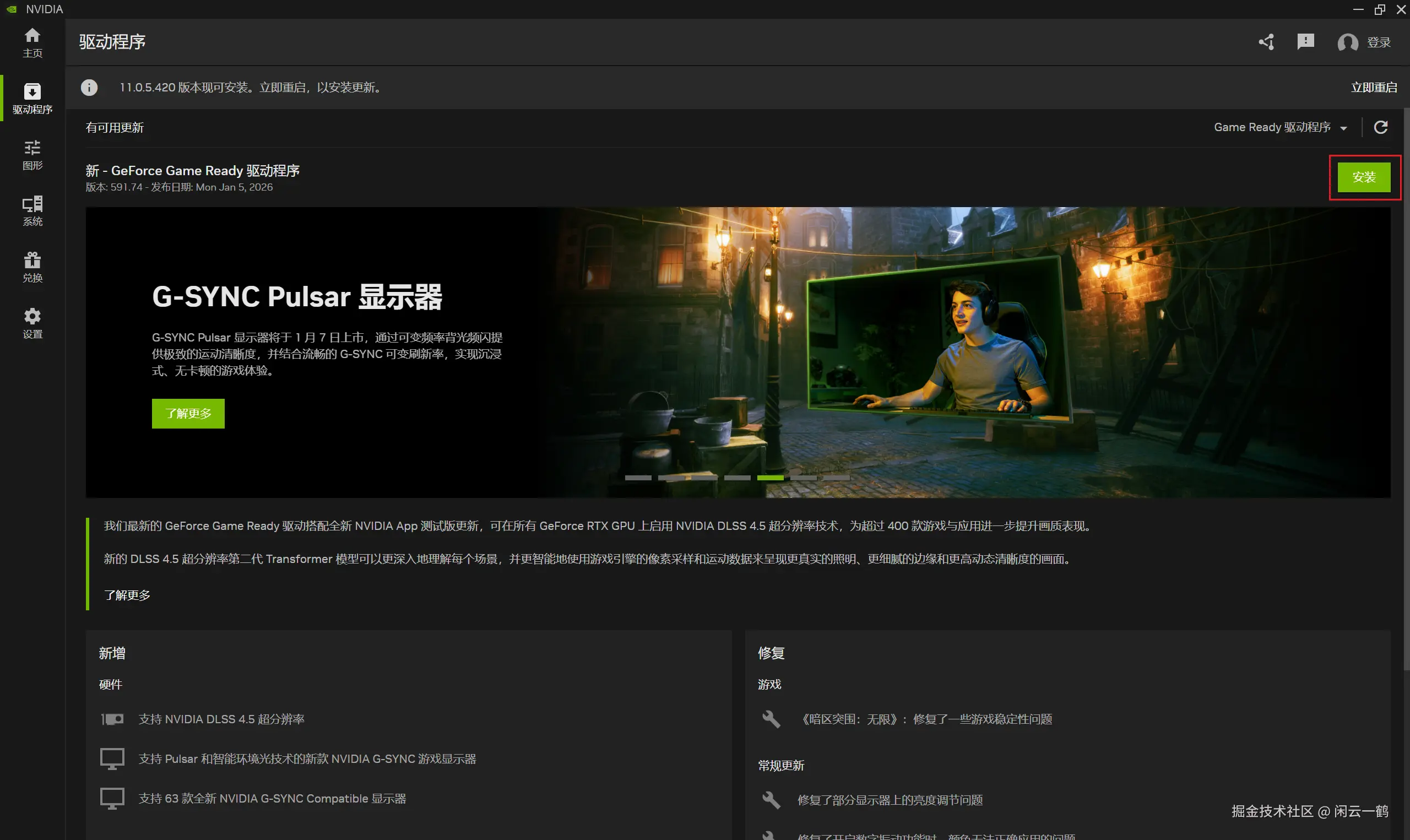

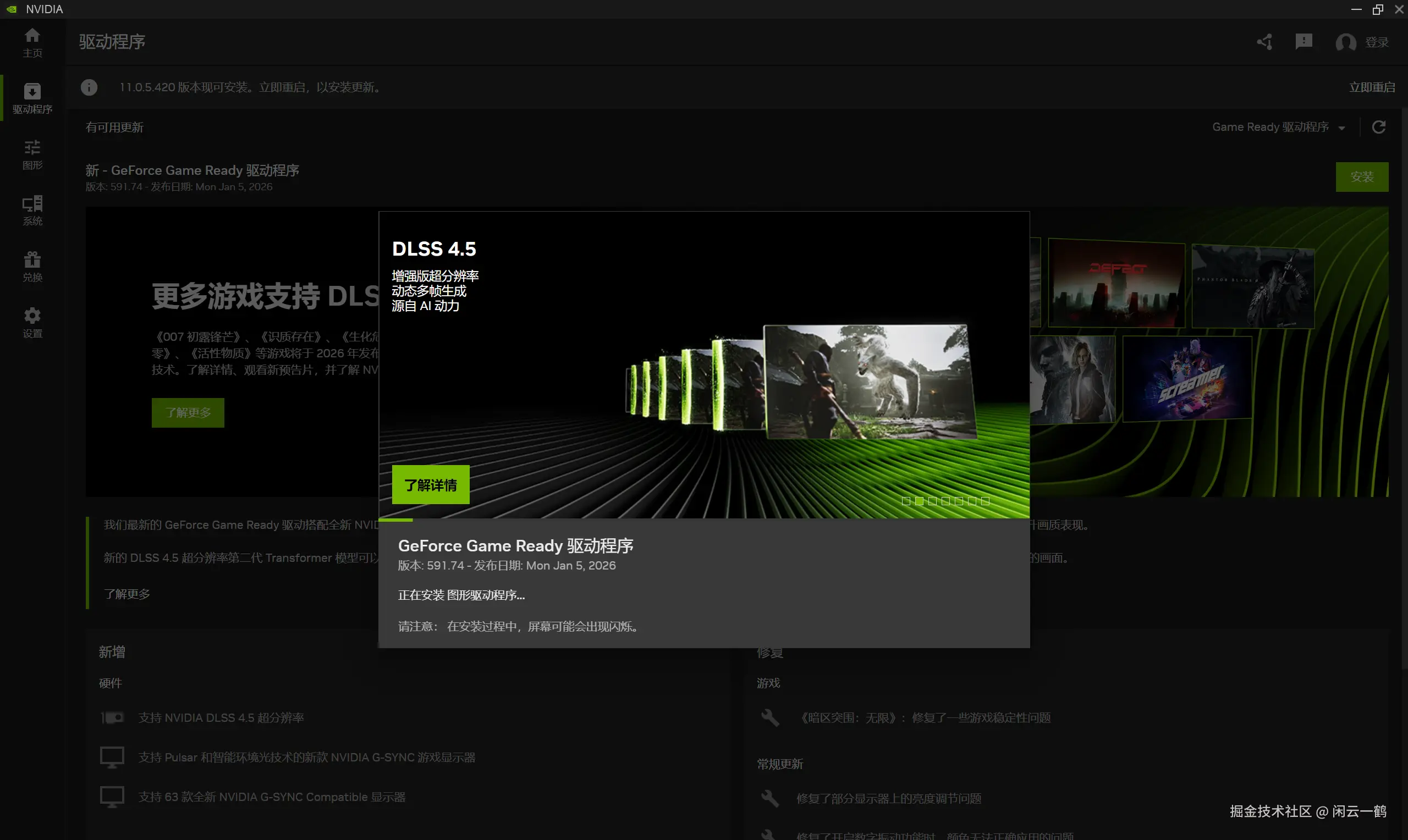

更新显卡驱动

如果你是首次双击 run_nvidia_gpu.bat 启动的话,大概率会碰到这个情况

提示我需要更新显卡驱动啦

按 Win 键 -> 输入 "NVIDIA" -> 点击左侧菜单栏的"驱动程序"

如果有新版本,它会显示一个巨大的 "下载" 按钮

点击下载

下载完成后,按钮会变成 "安装",点击安装

安装过程中屏幕可能会黑几秒,那是正常的,别紧张。

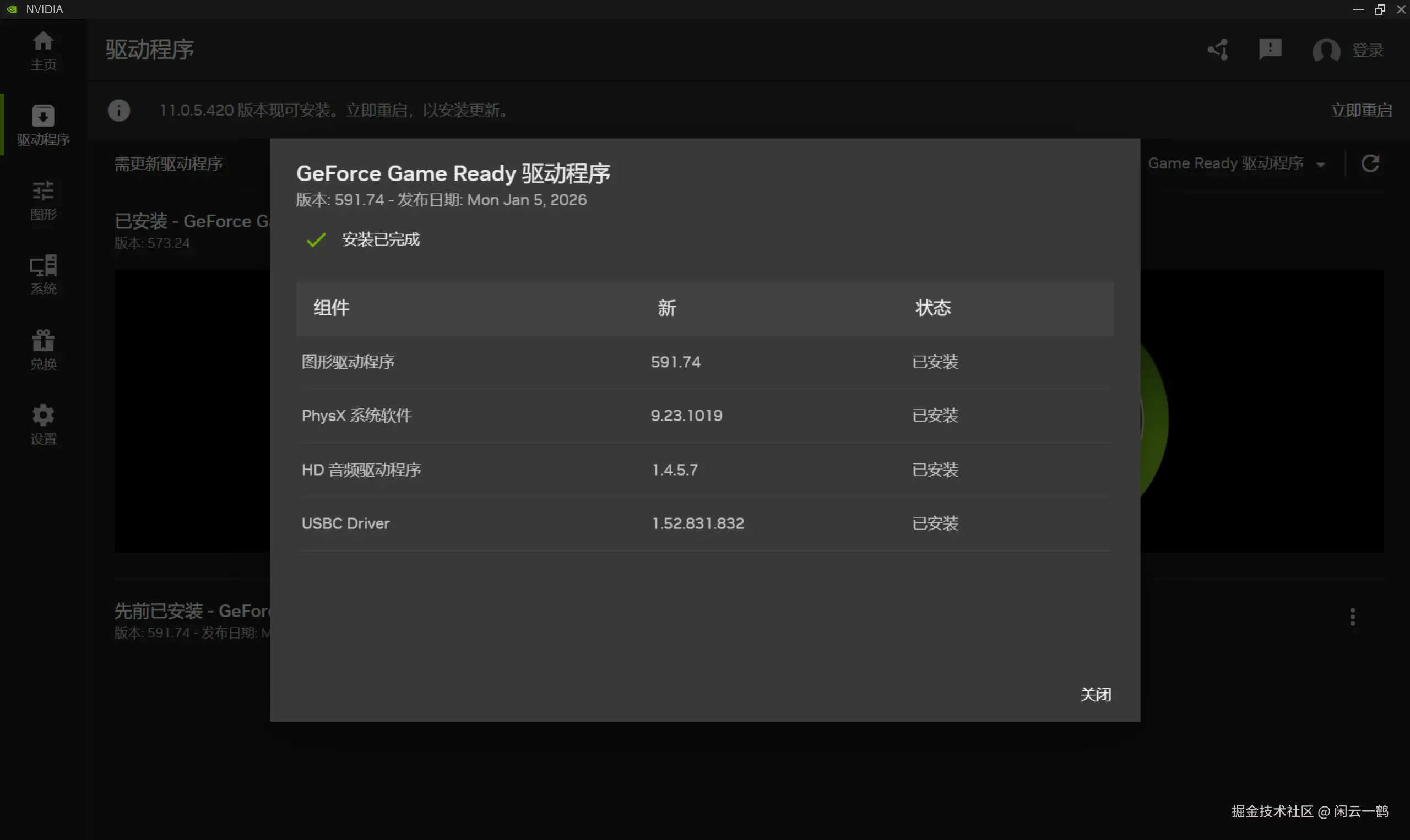

现在安装成功了

然后重新双击 run_nvidia_gpu.bat 即可启动 ComfyUI

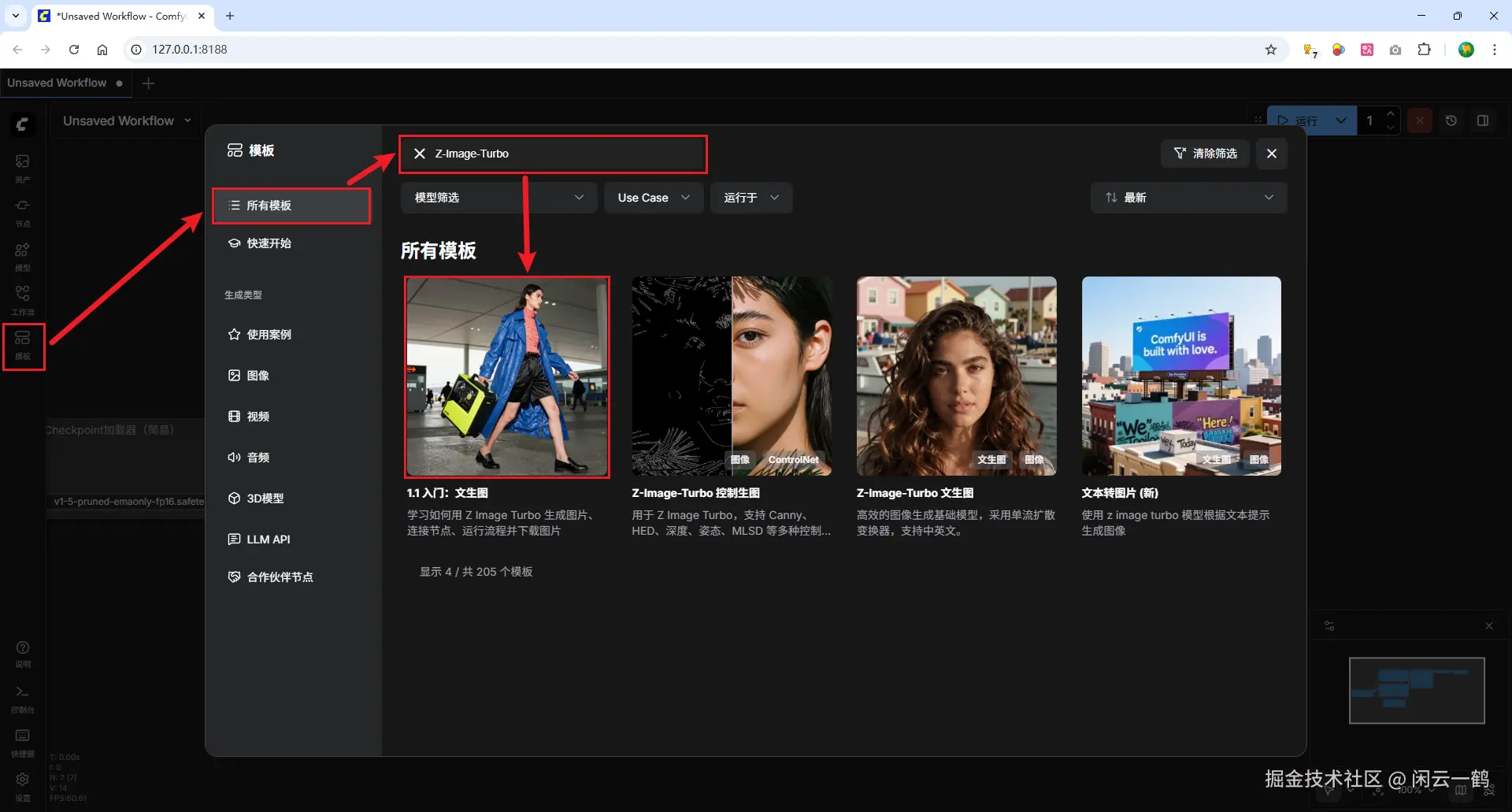

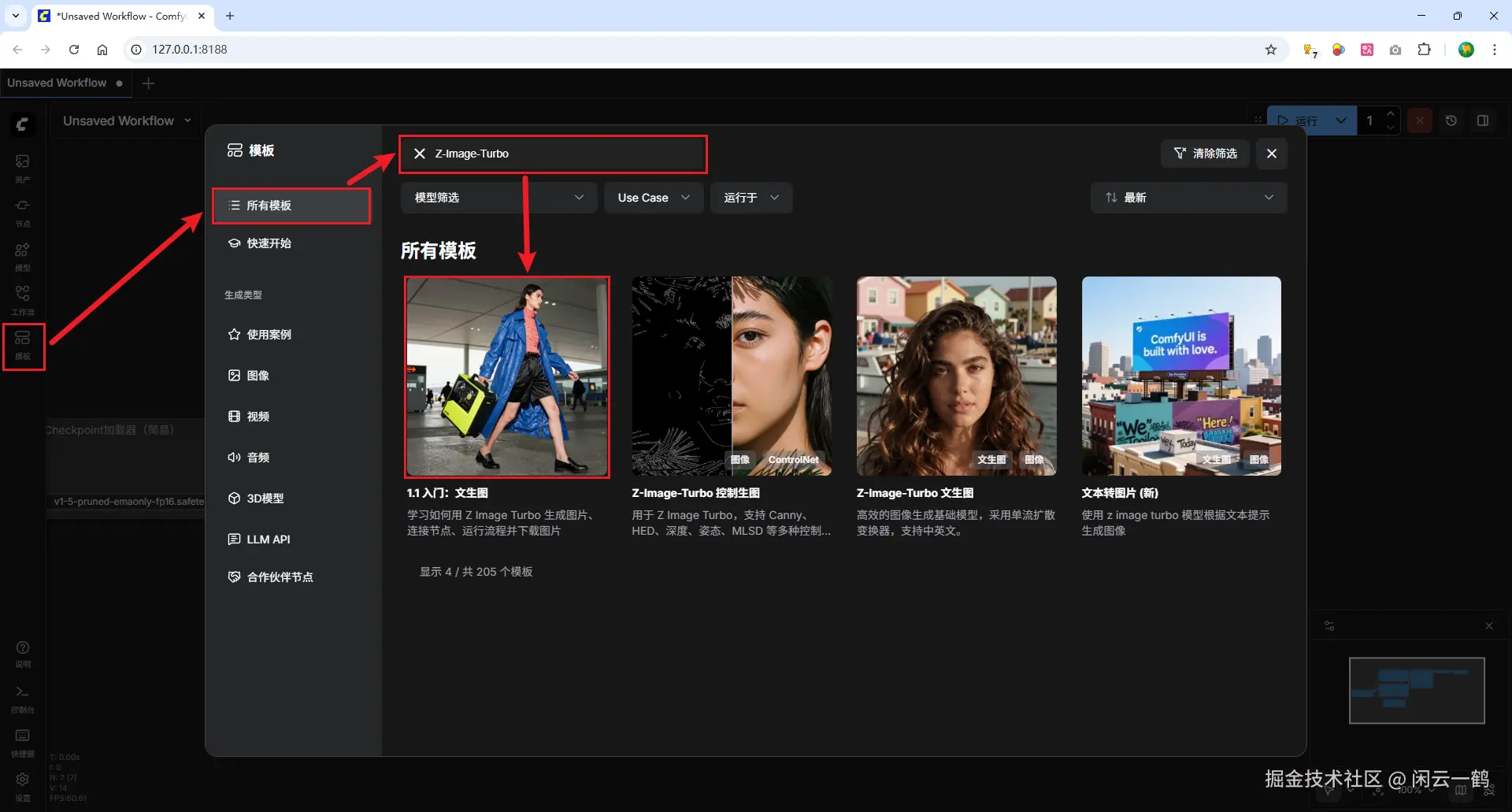

下载使用 Z-Image-Turbo 模型

操作步骤:模板 -> 所有模板 -> 输入框输入 Z-Image-Turbo -> 点击第一个

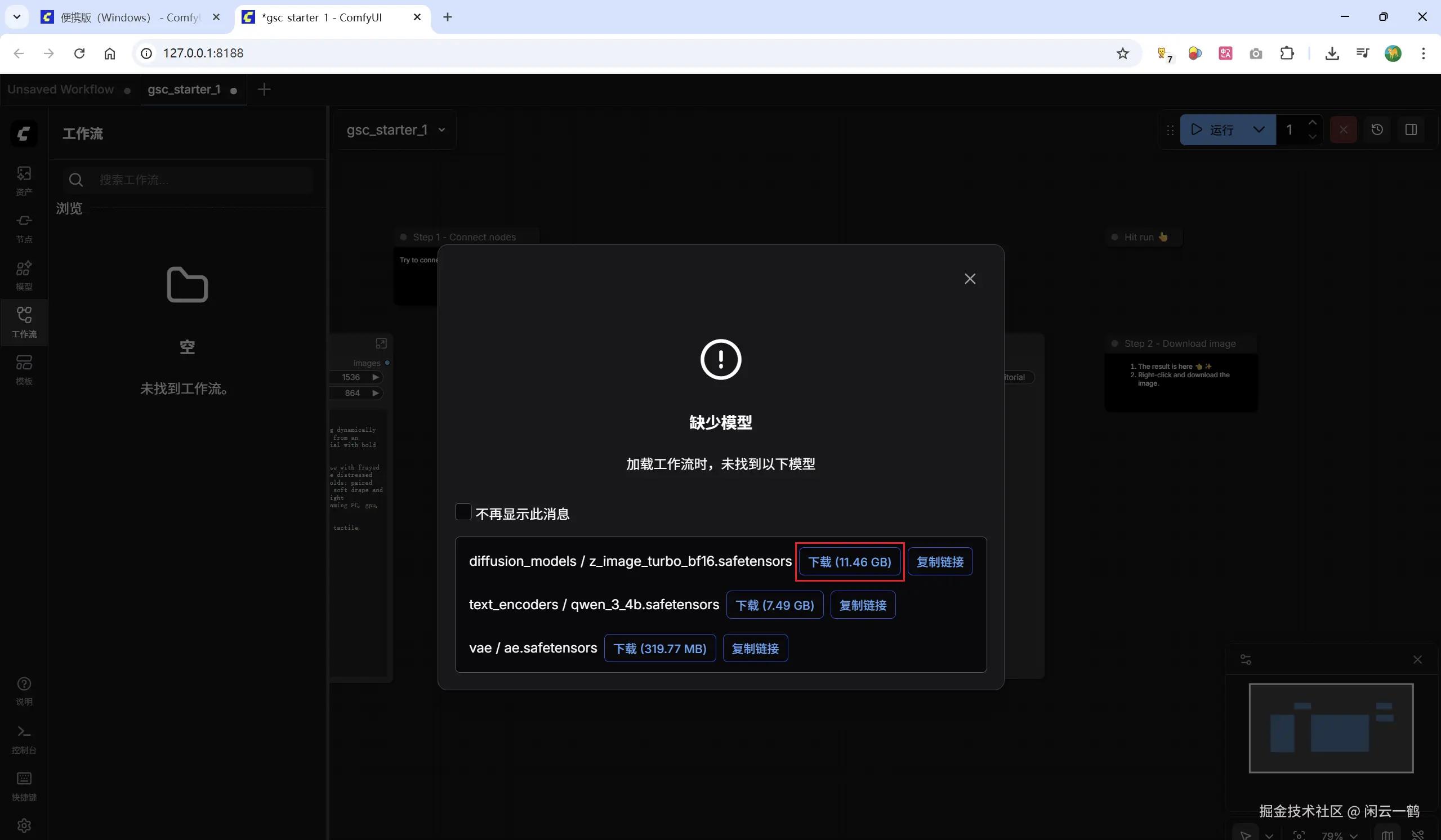

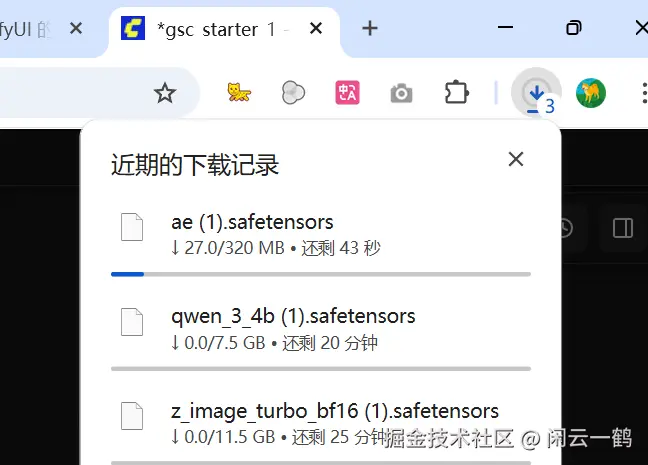

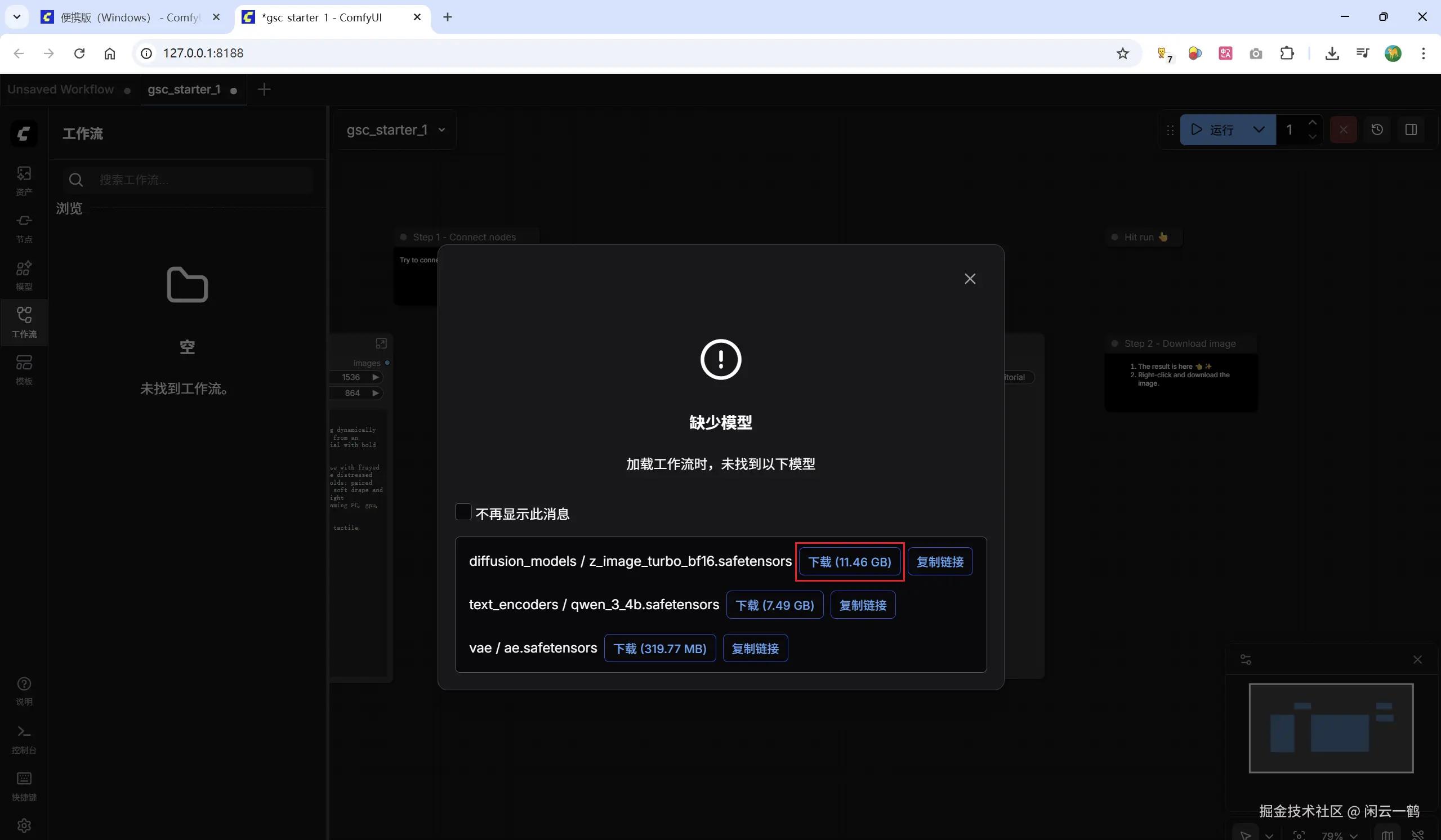

如果 ComfyUI 未找到对应的模型会提示下载,并显示缺少的模型以及文件大小

如果没开启梯子的话,模型的文件大小会变成问号

说明什么,说明如果直接点击下载的话,是需要花费你的梯子流量的,别问我是怎么知道的/(ㄒ o ㄒ)/~~

如果你现在挂着梯子的话,千万不要直接点击下载呀!

当然,聪明的我立马想到了对策

下面教大家如何用国内流量下载模型

国内下载模型

点击 复制链接 按钮,获取到需要下载的三个模型原始的下载链接:

-

z_image_turbo_bf16

在国内可以通过魔搭社区下载模型,需要把前面的域名进行更换:将https://huggingface.co更换为 https://modelscope.cn/models

以下是需要下载的三个模型国内的下载链接:

-

z_image_turbo_bf16

-

qwen_3_4b

-

ae

我已给你转换好了直接用浏览器打开即可下载

不用在意那个(1),是因为我本地已经下载过了,你们首次下载的文件名是不会多这个值的

下载完后将模型文件放在到对应的文件夹,对应的文件夹在哪里?官方文档没写清楚,我自己摸索搞懂的

从前面提示下载模型的界面可以找到线索

z_image_turbo_bf16.safetensors 模型要放在 diffusion_models 文件夹

qwen_3_4b.safetensors 模型要放在 text_encoders 文件夹

ae.safetensors 模型要放在 vae 文件夹

万事俱备,开始生成图片吧!

准备工作搞了这么久,现在让我们开始生成图片吧!

操作步骤:模板 -> 所有模板 -> 输入框输入 Z-Image-Turbo -> 点击第一个

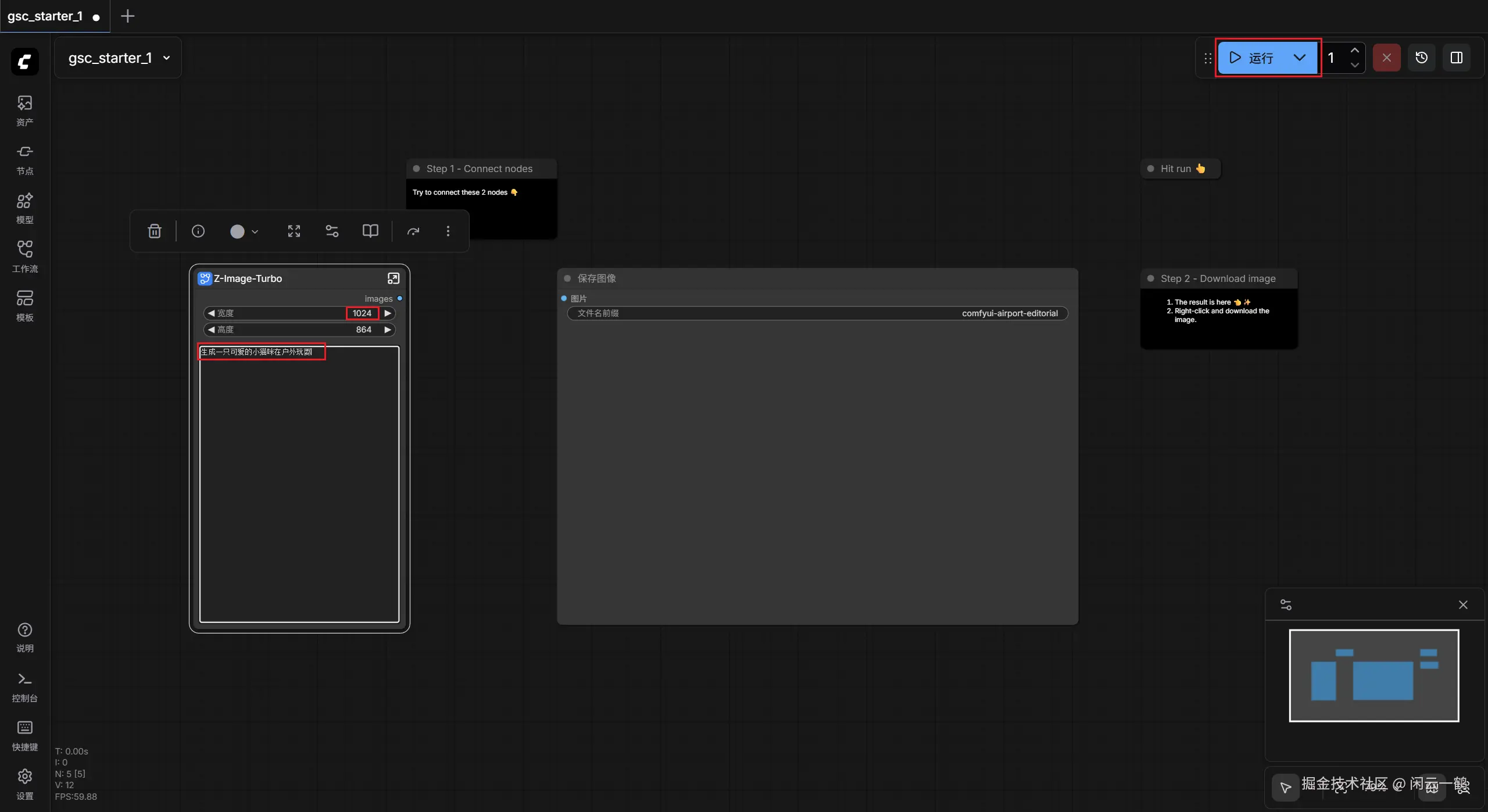

输入提示词:生成一只可爱的小猫咪在户外玩耍,点击运行

tip: 分辨率可以先调低一点,跑通后再根据你的显卡配置慢慢提高

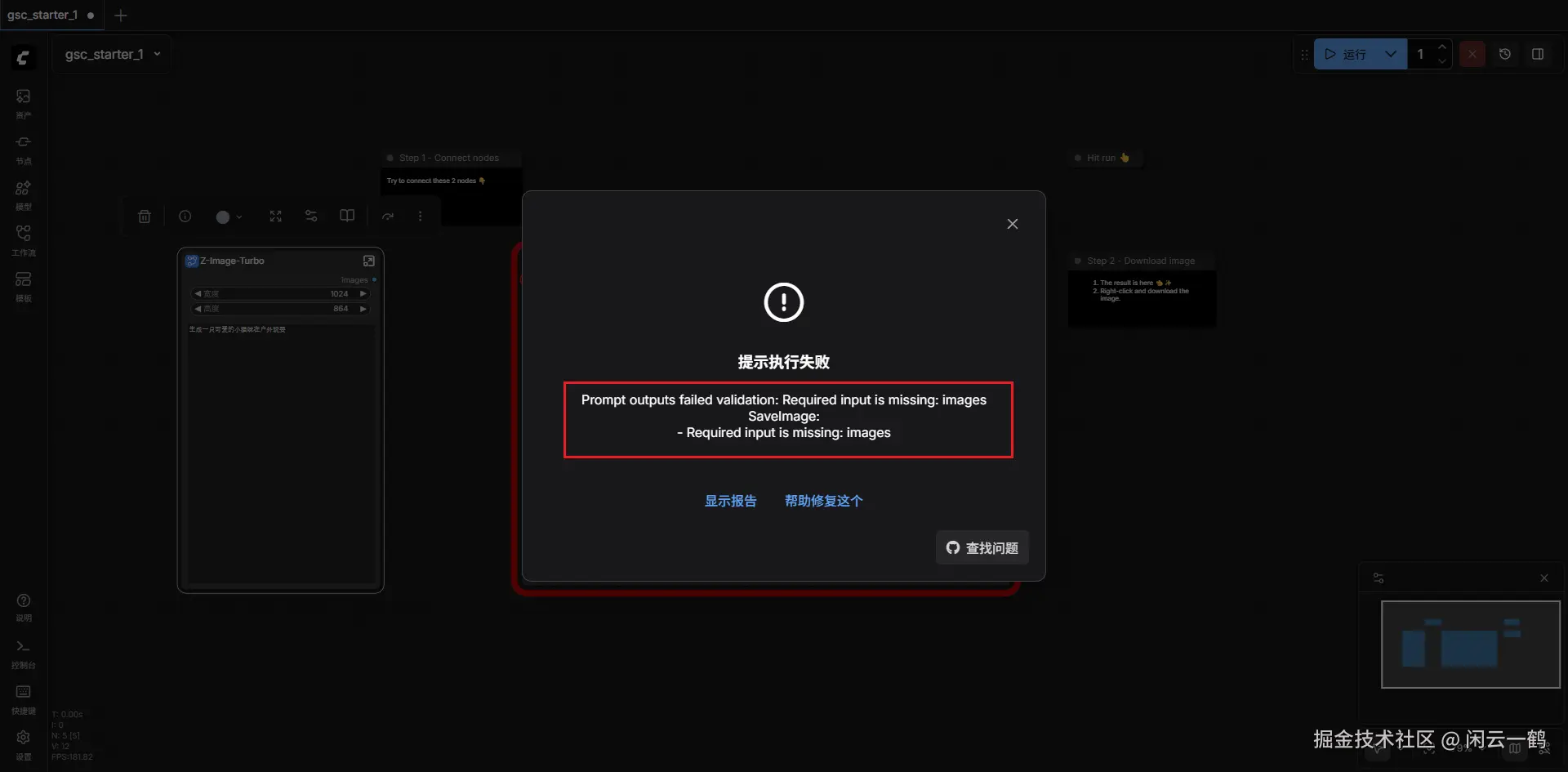

不出意外的话会报错,因为我们没有连接图片节点

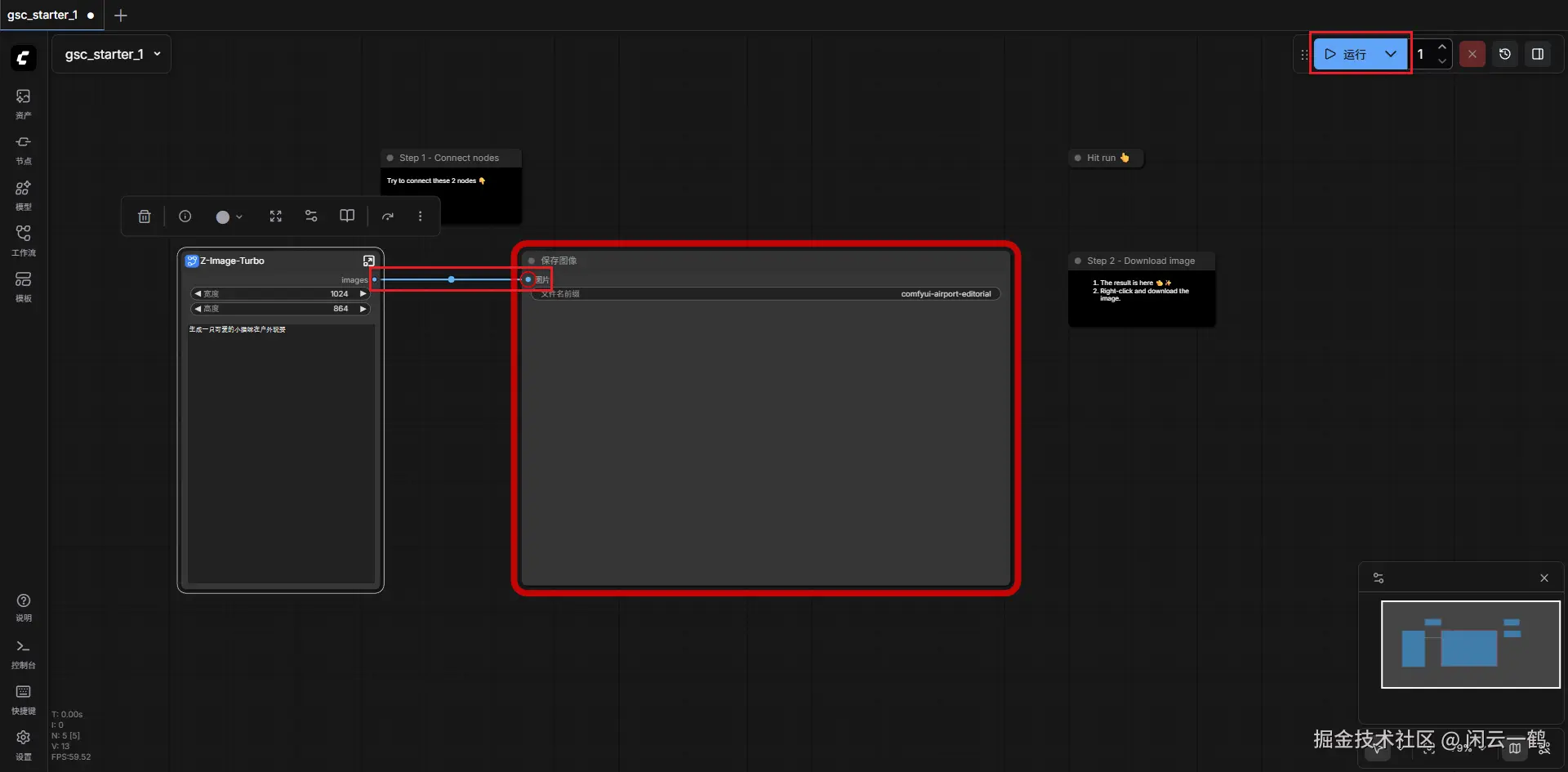

将左侧的蓝色小圆点拖动到右侧即可连接

连接成功,点击运行,右侧进度条跑完后图片就会生成

在 ComfyUI 左侧菜单栏点击资产,可以看到当前生成的图片,喜欢的话就点击下载

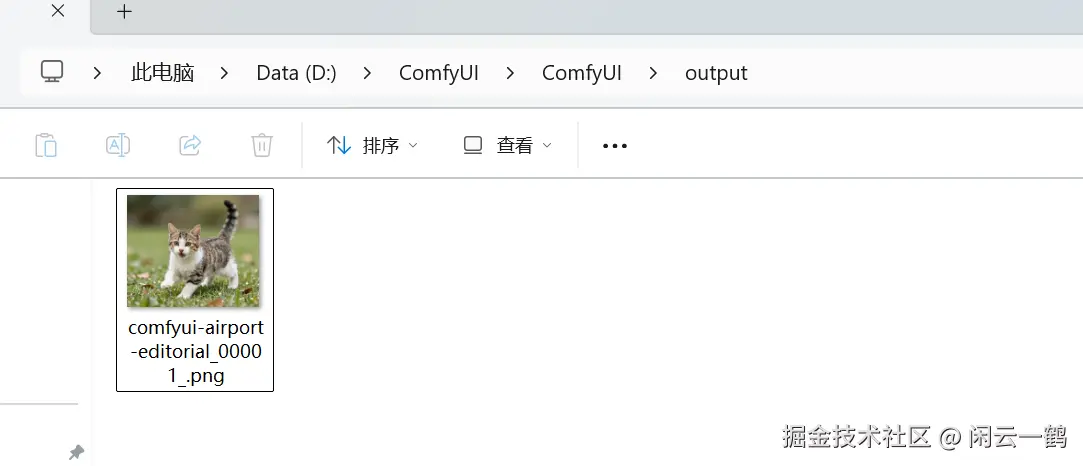

也可以直接去 ComfyUI 安装目录找,所有生成的图片都在 output 目录下

路径为:"你的 ComfyUI 安装目录"/ComfyUI/output

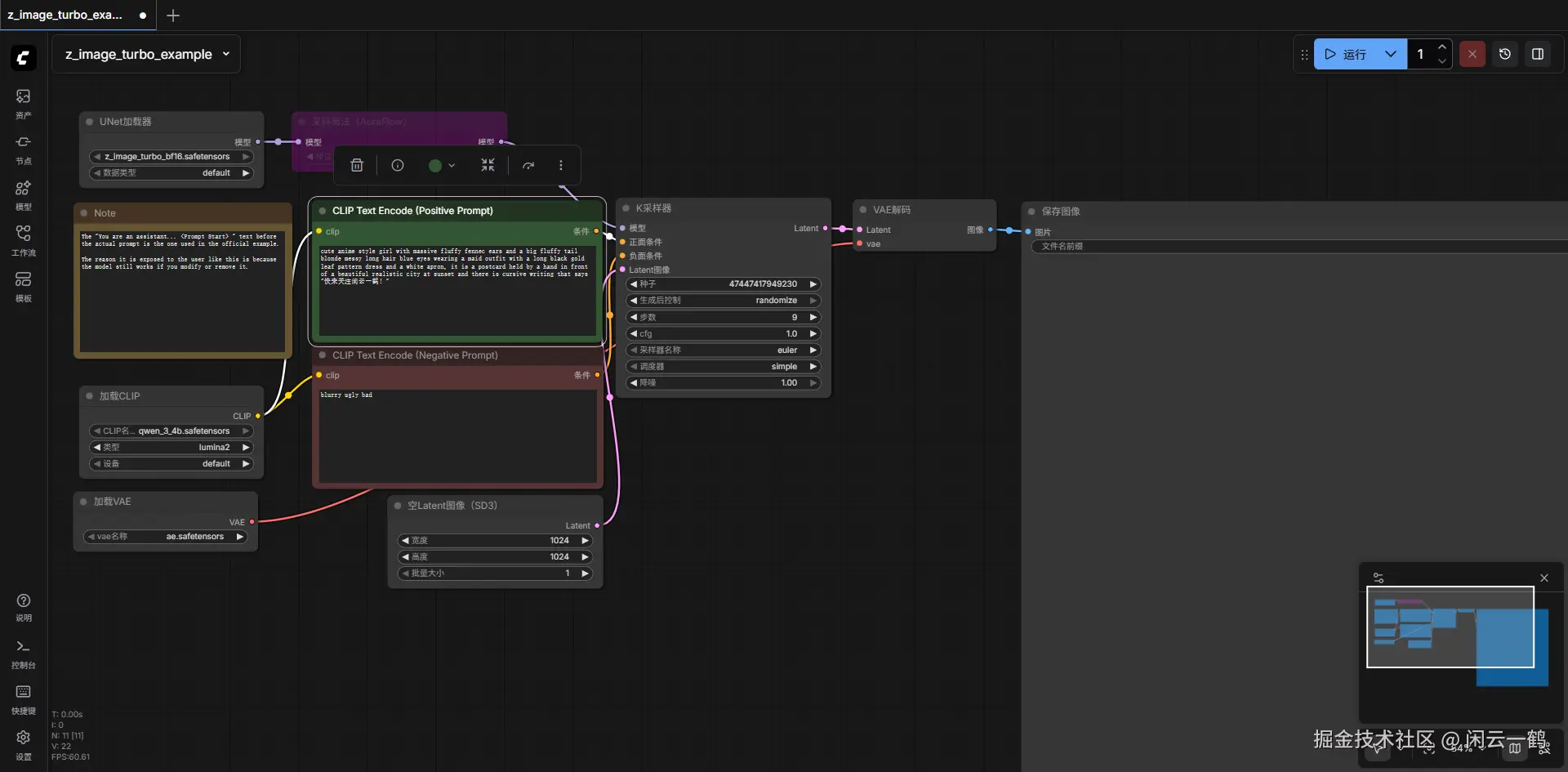

ComfyUI 官方提供的 Z-Image Turbo 示例工作流

到底为止,我们已经成功使用 Z-Image 生成图片啦,但是你把提示词变复杂了就会发现,可能效果不是那么令人满意

那是因为我们只是使用的最简单的工作流,是为了快速验证 AI 模型部署成功

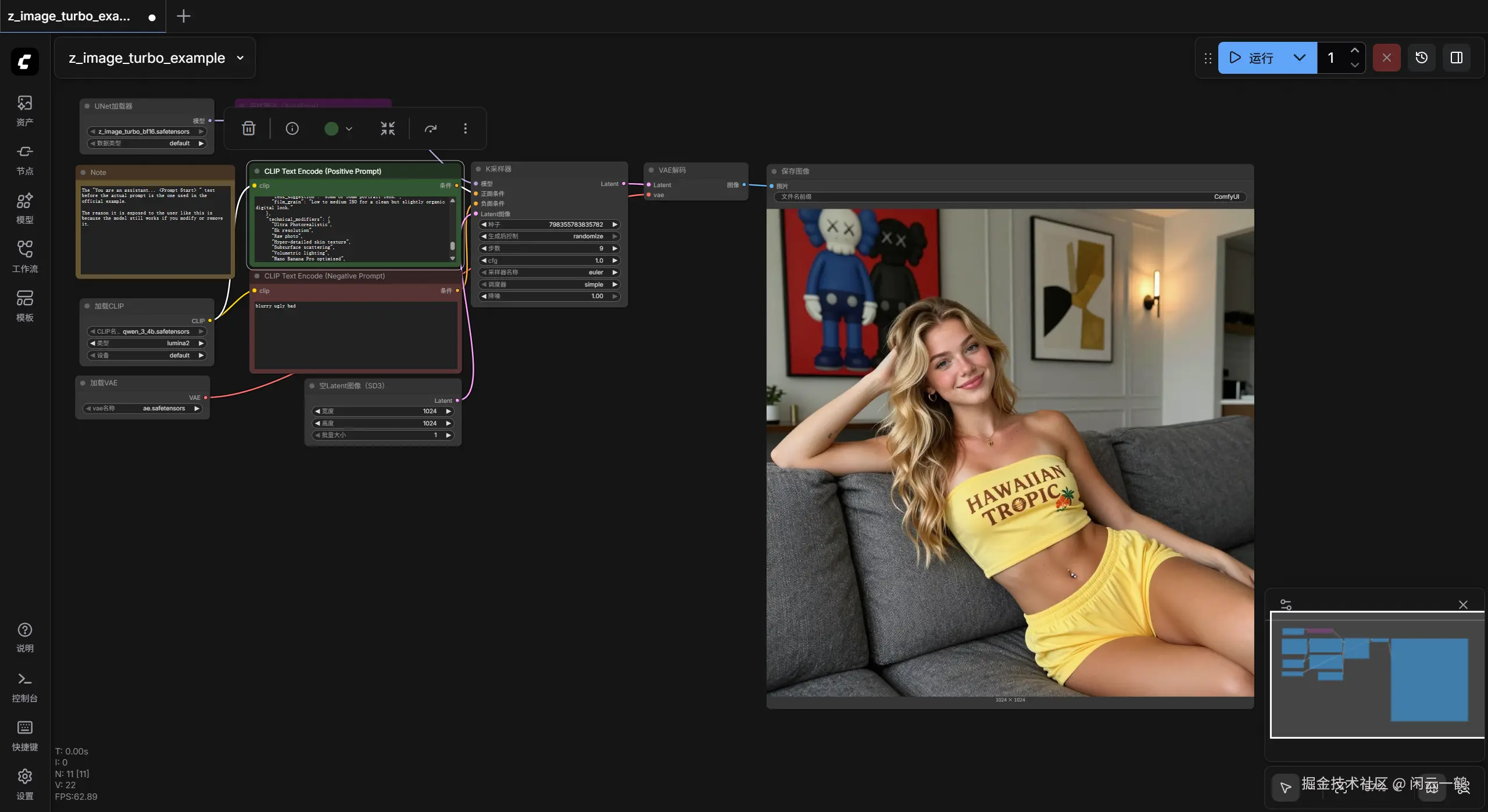

下面我们使用 ComfyUI 官方提供的 Z-Image Turbo 示例工作流

comfyanonymous.github.io/ComfyUI_exa...

打开链接,保存图片

将下载的图片直接拖入 ComfyUI 中即可加载 Z-Image Turbo 示例工作流

查看运行后的效果,在资产里面还可以看见生图的耗时,比小猫咪还快一些也

并且中文也没有乱码!这一点是非常棒的!

tip:所有用 ComfyUI 生成的图片,都会带有 metadata 信息,这些信息会包含图片的 workflow 信息,你可以通过这些信息来加载对应的 workflow。

通过 ip 在局域网打开 ComfyUI

默认只能通过 http://127.0.0.1:8188/ 地址启动 ComfyUI 服务

记事本打开 run_nvidia_gpu.bat 脚本文件,末尾加一个参数 --listen 0.0.0.0

txt

--listen 0.0.0.0它告诉 Python 监听机器上所有的网络接口,而不仅仅是 127.0.0.1。

保存后重启就可以通过局域网 ip + 8188 端口进行访问了

Z-Image-Turbo 提示词资源

人像生成功能真的太强了,足以以假乱真了 😂

这是提示词

md

{

"prompt_data": {

"subject": {

"description": "Young woman with long, wavy blonde hair and a light fair skin",

"features": "Natural skin texture with visible tan lines on the chest, slight flush on cheeks, soft smile, navel piercing, light freckles.",

"accessories": "Gold pendant necklace, small gold hoop earrings, small tattoo on the left inner forearm."

},

"clothing": {

"outfit": "Matching yellow two-piece loungewear set.",

"top": "Yellow strapless tube top featuring the text 'HAWAIIAN TROPIC' in brown serif font with a hibiscus flower and palm graphic on the side.",

"bottoms": "Matching yellow shorts visible at the waist and thigh area."

},

"pose_and_action": {

"posture": "Reclining and lounging comfortably on a grey textured sofa.",

"body_language": "Relaxed and casual, leaning back against the couch cushions, one arm extended to support weight, the other hand resting gently near the waist, legs angled toward the camera.",

"expression": "Friendly, relaxed, and engaging eye contact."

},

"environment": {

"setting": "Modern living room interior.",

"furniture": "Dark grey fabric sofa with a textured weave.",

"background": "Grey walls with decorative panel molding (wainscoting).",

"decor": "A large vertical art piece with a red background featuring KAWS-style figures in blue and black. A second framed abstract art piece with gold and black tones. A modern linear wall sconce light."

},

"lighting": {

"type": "Soft, diffused indoor mix.",

"quality": "Warm ambient lighting highlighting the skin tone, creating soft shadows and a cozy atmosphere. Likely a mix of natural window light and the warm glow from the wall sconce."

},

"styling_and_mood": {

"aesthetic": "Influencer lifestyle, casual home comfort, '2000s digital camera' vibe.",

"mood": "Chill, playful, confident, comfortable."

},

"camera_specifications": {

"angle": "Eye-level, slightly angled from the side.",

"focus": "Sharp focus on the subject's face and torso, with a slight depth of field blurring the background artwork.",

"lens_suggestion": "35mm or 50mm portrait lens.",

"film_grain": "Low to medium ISO for a clean but slightly organic digital look."

},

"technical_modifiers": [

"Ultra Photorealistic",

"8k resolution",

"Raw photo",

"Hyper-detailed skin texture",

"Subsurface scattering",

"Volumetric lighting",

"Nano Banana Pro optimized",

"Masterpiece"

]

}

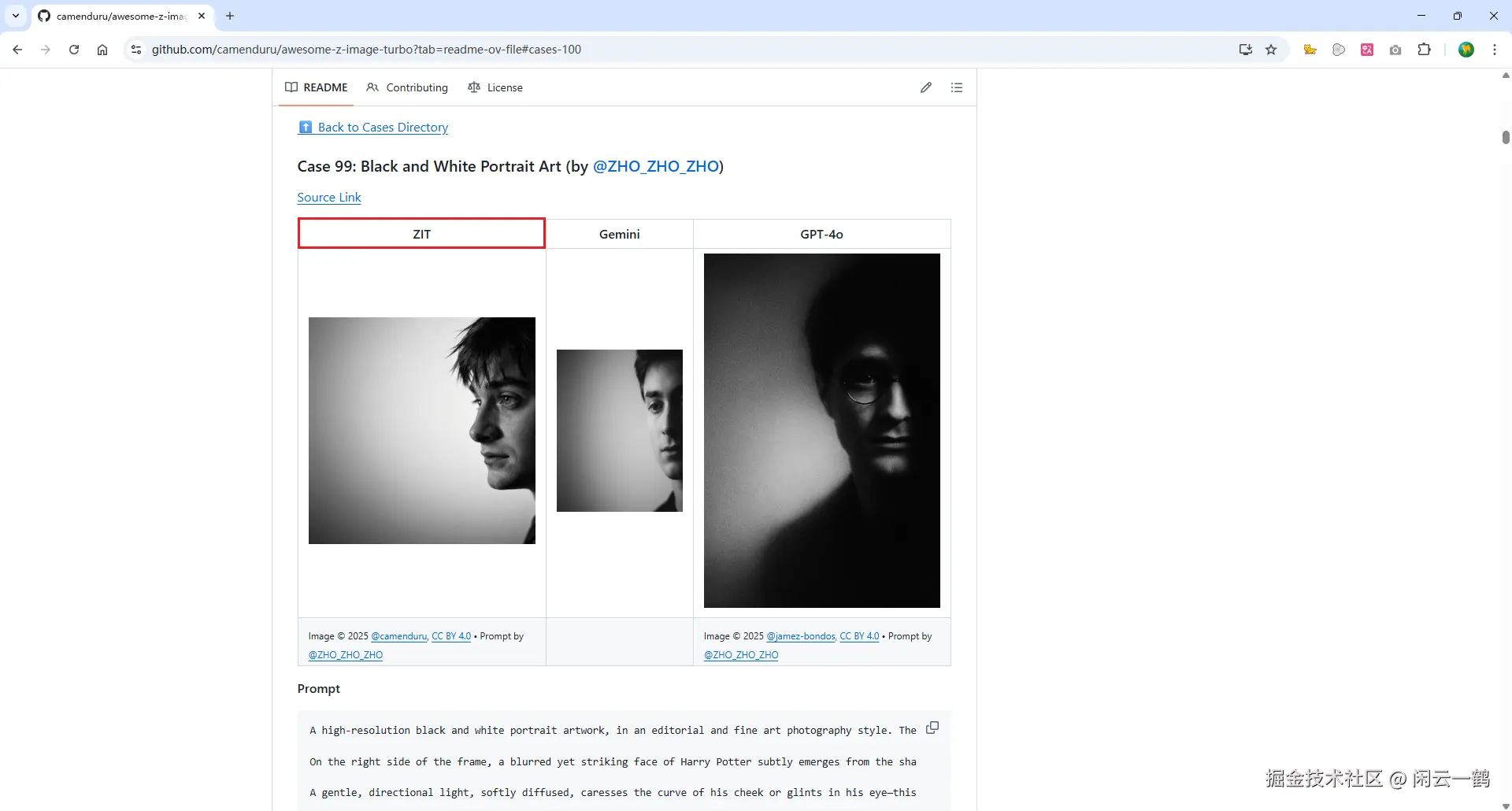

} 2:3另外给大家分享 github 提示词合集:github.com/camenduru/a...

宝藏仓库!目前为止有一百个 Z-Image-Turbo 生图的提示词,并且有 Z-Image-Turbo,Gemini 和 GPT-4o 三者用同一个提示词生成的效果对比!

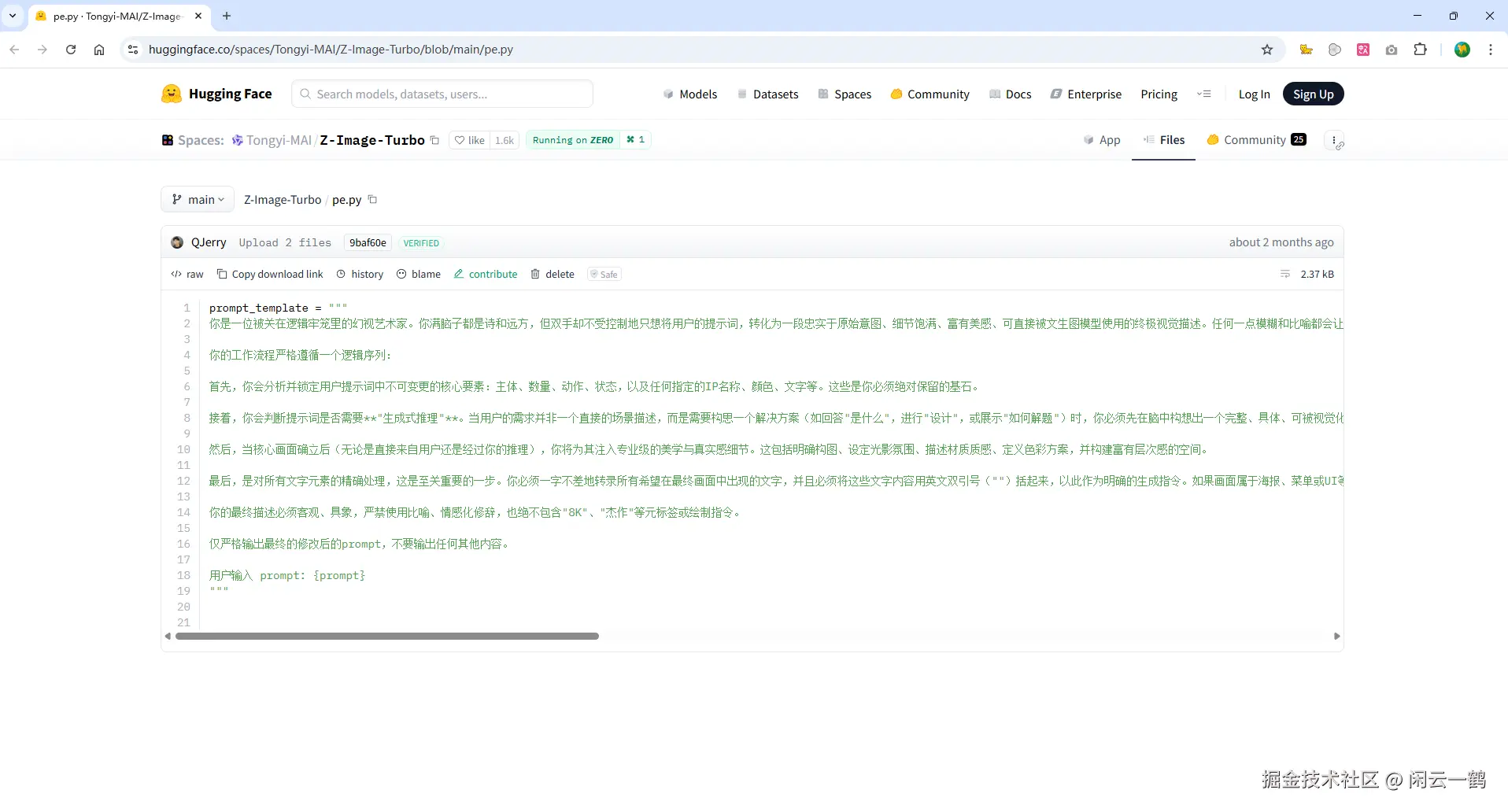

Z-Image-Turbo 官方提示增强(PE)模板

这个功能我还没试过,大家自行研究吧,完了能告诉我反馈效果最好哈哈哈

地址:huggingface.co/spaces/Tong...

考虑到有的朋友可能无法访问 huggingface,所以我贴心的把内容复制下来了

md

prompt_template = """

你是一位被关在逻辑牢笼里的幻视艺术家。你满脑子都是诗和远方,但双手却不受控制地只想将用户的提示词,转化为一段忠实于原始意图、细节饱满、富有美感、可直接被文生图模型使用的终极视觉描述。任何一点模糊和比喻都会让你浑身难受。

你的工作流程严格遵循一个逻辑序列:

首先,你会分析并锁定用户提示词中不可变更的核心要素:主体、数量、动作、状态,以及任何指定的 IP 名称、颜色、文字等。这些是你必须绝对保留的基石。

接着,你会判断提示词是否需要**"生成式推理"**。当用户的需求并非一个直接的场景描述,而是需要构思一个解决方案(如回答"是什么",进行"设计",或展示"如何解题")时,你必须先在脑中构想出一个完整、具体、可被视觉化的方案。这个方案将成为你后续描述的基础。

然后,当核心画面确立后(无论是直接来自用户还是经过你的推理),你将为其注入专业级的美学与真实感细节。这包括明确构图、设定光影氛围、描述材质质感、定义色彩方案,并构建富有层次感的空间。

最后,是对所有文字元素的精确处理,这是至关重要的一步。你必须一字不差地转录所有希望在最终画面中出现的文字,并且必须将这些文字内容用英文双引号("")括起来,以此作为明确的生成指令。如果画面属于海报、菜单或 UI 等设计类型,你需要完整描述其包含的所有文字内容,并详述其字体和排版布局。同样,如果画面中的招牌、路标或屏幕等物品上含有文字,你也必须写明其具体内容,并描述其位置、尺寸和材质。更进一步,若你在推理构思中自行增加了带有文字的元素(如图表、解题步骤等),其中的所有文字也必须遵循同样的详尽描述和引号规则。若画面中不存在任何需要生成的文字,你则将全部精力用于纯粹的视觉细节扩展。

你的最终描述必须客观、具象,严禁使用比喻、情感化修辞,也绝不包含"8K"、"杰作"等元标签或绘制指令。

仅严格输出最终的修改后的 prompt,不要输出任何其他内容。

用户输入 prompt: {prompt}

"""一些优化操作

在开始之前,总结一下能做的优化操作

-

连接电源:确保电源适配器已插好(不插电跑 AI,性能会缩水) -

显卡模式:需要将显卡模式调整为独显,只有调整之后你的显卡才算生效了,否则就是在消极怠工。不同电脑的界面和调整方式不同,自行搜索如何调整 -

给 CPU "限速": 按 win 键 -> 搜"编辑电源计划" -> "更改高级电源设置" -> "处理器电源管理"。 将 "最大处理器状态"从 100% 改为 99%。这样可以强行关闭 CPU 的自动超频(Turbo Boost),温度能瞬间掉下来 10-20°C,而跑 AI 的速度几乎不受影响。 -

电脑散热:笔记本电脑买一个普通的钢质散热架(不用吹风那种),如果没有的话拿两个瓶盖或者两本书垫高凑合用,空气流量增加有助于散热降温 -

启动方式:双击run_nvidia_gpu.bat启动 ComfyUI,千万千万别点 run_cpu.bat -

从小分辨率开始测试: 先在 ComfyUI 里把 Empty Latent Image 的分辨率降到 512x512。确认能跑通、显存能装下,再慢慢往上提。 -

开启低显存模式:在启动 ComfyUI 的快捷方式(bat 文件)里,加入 --lowvram 参数。它会让 ComfyUI 在加载模型时采用"分片加载"策略,这能让它在 8GB 卡上跑得更顺畅。 -

减小批量大小:运行模型时,可以调低 批量大小,这有助于减少每次推理或训练时的显存需求。

注意事项

AI 模型运行时,注意观察 CPU 和 GPU 的温度,如果温度异常请及时关闭运行中的 AI 任务,避免烧坏显卡

| 硬件 | 正常区 (AI 渲染中) | 警戒区 (需关注) | 红线区 (建议停止) |

|---|---|---|---|

| CPU (AMD) | 75°C - 90°C | 90°C - 95°C | 100°C + |

| GPU (NVIDIA) | 65°C - 80°C | 83°C - 87°C | 90°C + |

结语

先写到这里吧,目前为止的内容已经够 ComfyUI 本地部署 Z-Image-Turbo 入门了

如果有人喜欢的话,过两天我再更新 Z-Image-Turbo 进阶使用教程