前言:从"能用"到"高效"的跨越

在上一篇文章《从零正确配置GPU运算,彻底解决CPU运行与使用率低问题》中,我们解决了让ComfyUI正确识别和使用GPU这一根本问题。现在,你可能会发现:虽然GPU开始工作了,但在运行复杂的Wan视频生成等高级工作流时,仍然会遇到卡顿、显存不足、生成速度不理想等问题。

本文将带你深入ComfyUI节点层面,通过优化配置让GPU算力得到最大化利用,特别是在资源密集型的视频生成工作流中。

一、为什么需要专门的节点优化?

1.1 高级工作流的特殊挑战

Wan视频生成等复杂工作流与简单的文生图有着本质区别:

-

多模型协同:需要同时加载CLIP、VAE、ControlNet、T5文本编码器、Wav2Vec音频模型等多个大型模型

-

显存动态管理:视频生成涉及逐帧处理,显存分配和释放需要精细控制

-

数据流复杂:音频、文本、图像、控制信号等多模态数据需要高效流转

1.2 GPU利用率低下的常见表现

即使正确配置GPU,以下问题仍可能导致效率低下:

-

模型重复加载,造成不必要的I/O等待

-

数据在CPU和GPU之间频繁拷贝

-

显存碎片化导致大模型无法加载

-

计算图未优化,存在冗余计算

二、核心优化节点分类详解

2.1 🚀 模型智能加载与缓存管理

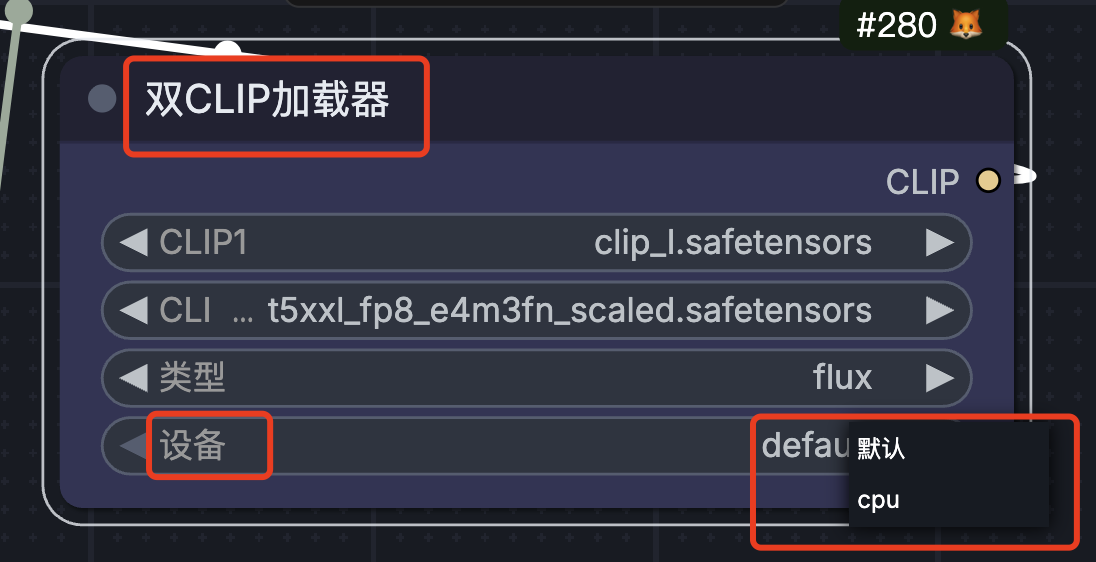

双CLIP加载器

作用:分别处理正面和负面提示词的CLIP编码

优化原理:

-

传统的单CLIP编码器需要顺序处理正负提示词

-

双CLIP允许并行编码,减少等待时间

-

特别适用于复杂的提示词工程

配置建议:

python

# 传统方式(顺序执行)

正面提示词编码 → 负面提示词编码 → 总耗时 = t1 + t2

# 优化方式(并行执行)

正面提示词编码 →

总耗时 ≈ max(t1, t2)

负面提示词编码 →实际效果:在提示词较长时,可缩短约30%的文本编码时间。

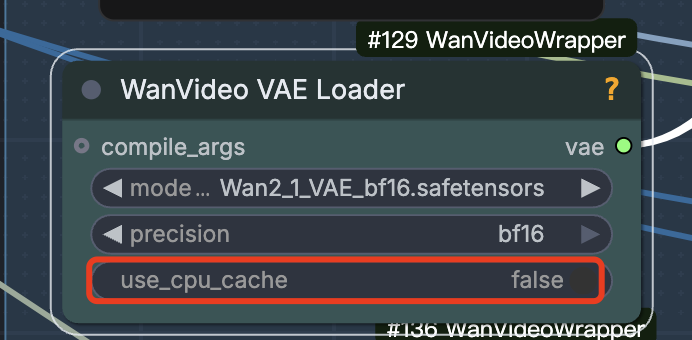

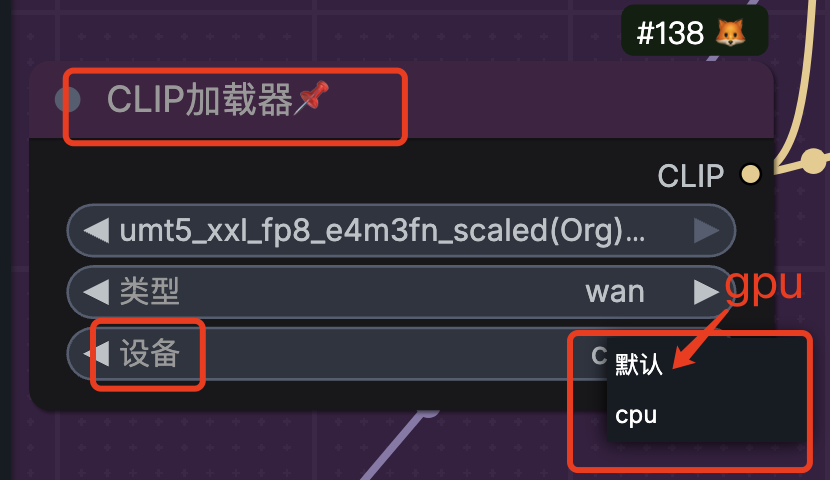

WanVideoVAELoader & CLIP加载器

关键优化点 :模型缓存机制

这些专用加载器通常内置了智能缓存逻辑:

-

首次加载:从硬盘读取模型到显存

-

后续使用:直接使用显存中的模型副本

-

生命周期管理:在工作流执行期间保持加载状态

避免的陷阱:

-

❌ 错误:每个Sampler节点都连接独立的VAE Loader

-

✅ 正确:使用一个VAE Loader,连接到所有需要它的节点

2.2 🎬 Wan视频工作流核心引擎

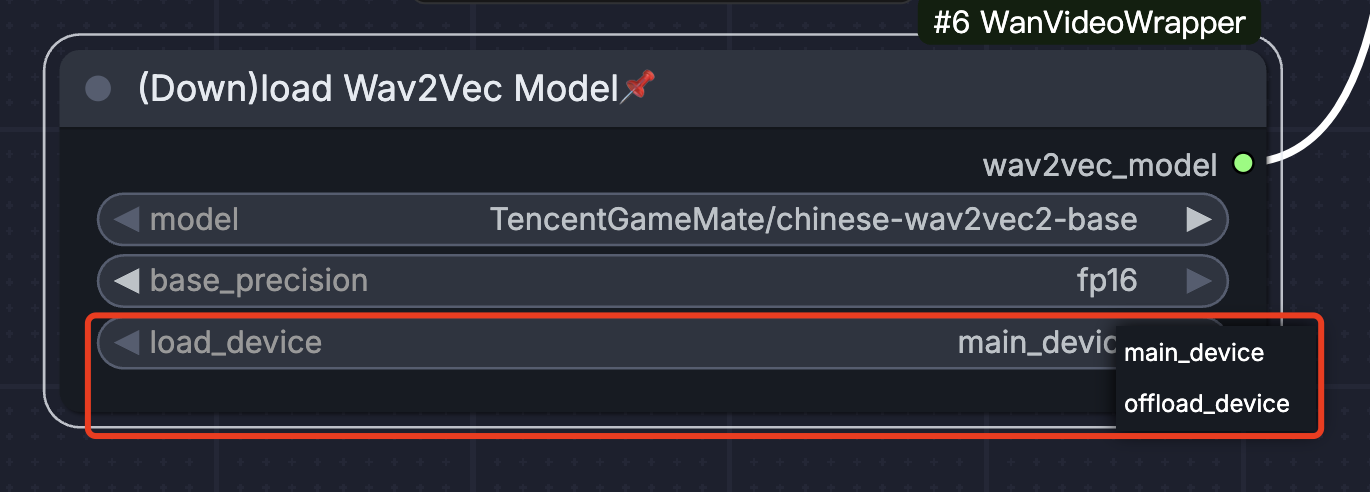

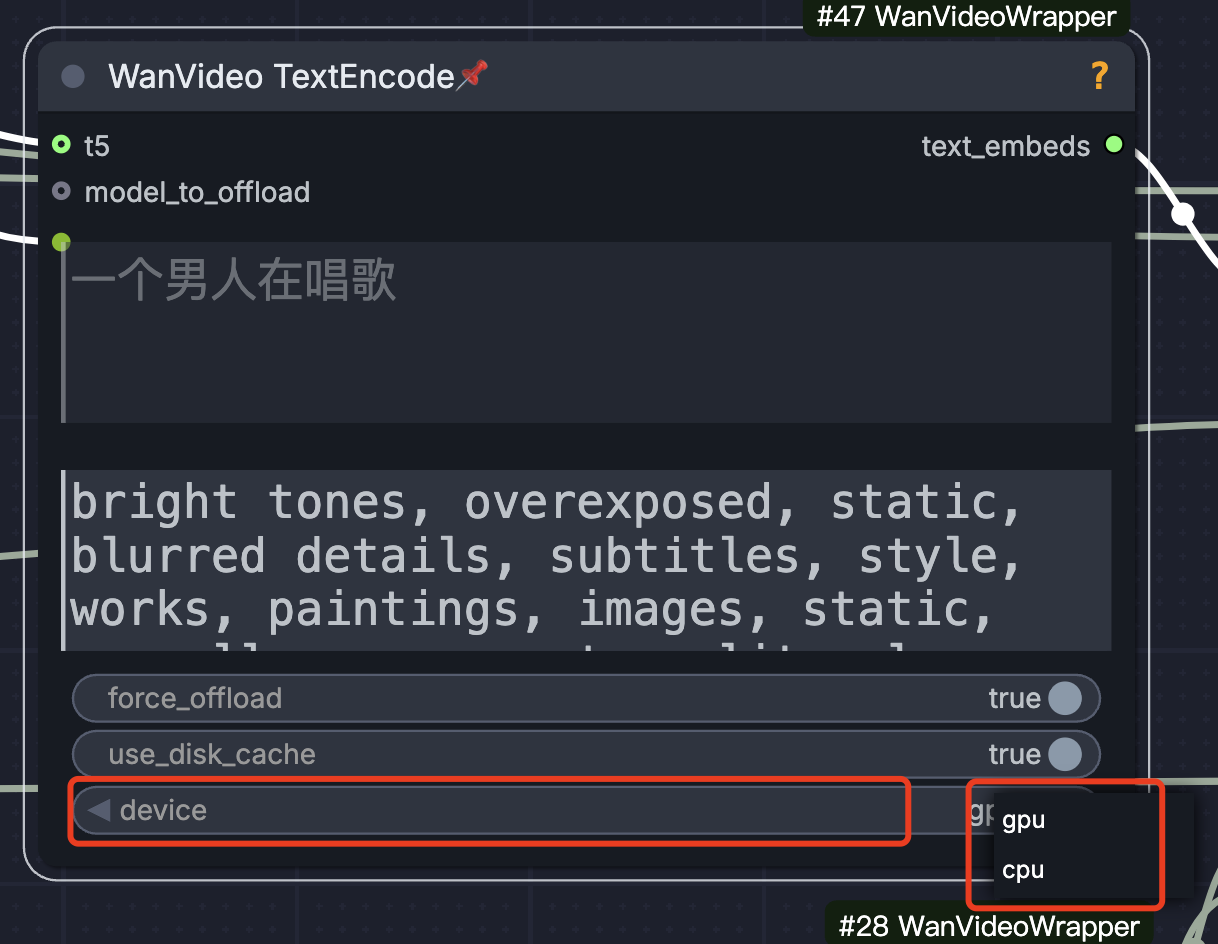

DownloadAndLoadWav2VecModel 与 LoadWanVideoT5TextEncoder

挑战:这些是多模态大模型,体积庞大(通常2-10GB)

优化策略:

1. 预加载与并行初始化

python

# 优化前:顺序加载,总等待时间长

加载T5模型(30秒)→ 加载Wav2Vec(25秒)→ 加载ControlNet(20秒)

总等待时间:75秒

# 优化后:并行加载(如果显存允许)

同时加载T5、Wav2Vec、ControlNet

总等待时间:~35秒(最慢的模型加载时间)2. 工作流结构优化

python

# 推荐的工作流开头部分

┌─────────────────────────────────────┐

│ 并行加载所有必要的大模型 │

│ ┌─────────┬─────────┬──────────┐ │

│ │ T5加载器│Wav2Vec │ControlNet│ │

│ │ │加载器 │加载器 │ │

│ └─────────┴─────────┴──────────┘ │

└─────────────────────────────────────┘

↓

【等待所有模型加载完成】

↓

开始处理输入数据(音频、文本)3. 错误处理与恢复

-

利用ComfyUI的工作流持久化功能

-

即使中断,重新启动时可从已加载状态继续

-

避免因网络问题导致整个流程失败

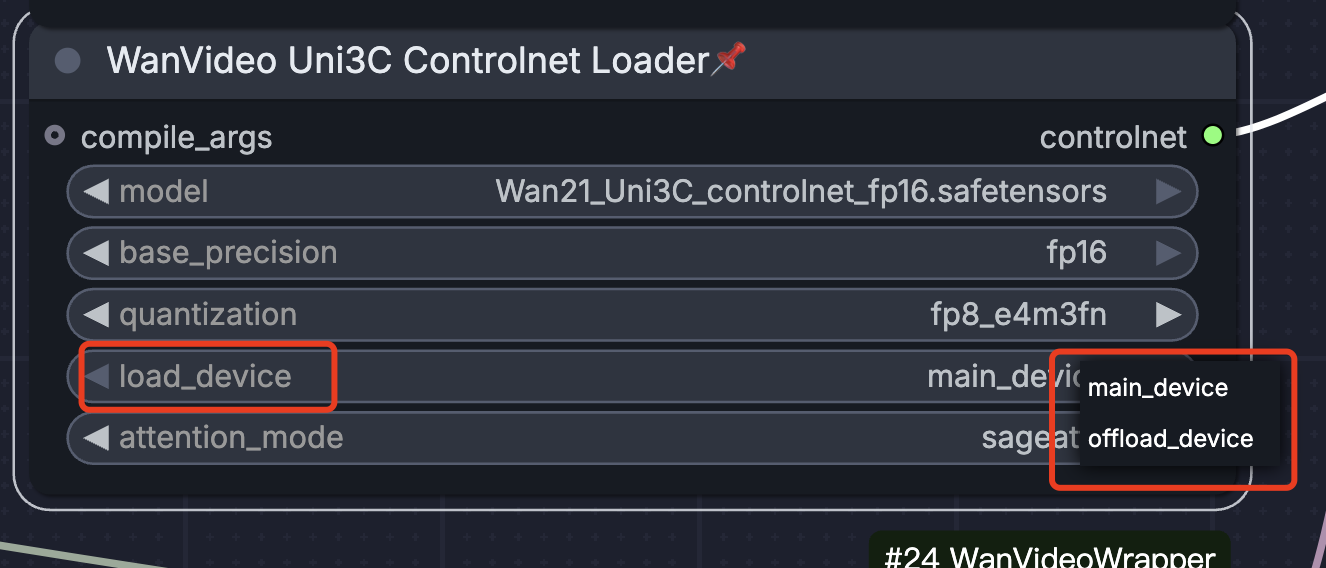

WanVideoUni3C_ControlnetLoader

作用:为视频生成提供时空一致性控制

优化技巧:

-

选择合适的ControlNet权重:根据任务选择(姿态、深度、边缘等)

-

控制强度调节:避免过强的控制导致生成僵硬

-

与预处理节点配合:确保输入的控制信号质量

2.3 🖼️ 图像预处理与Mask优化

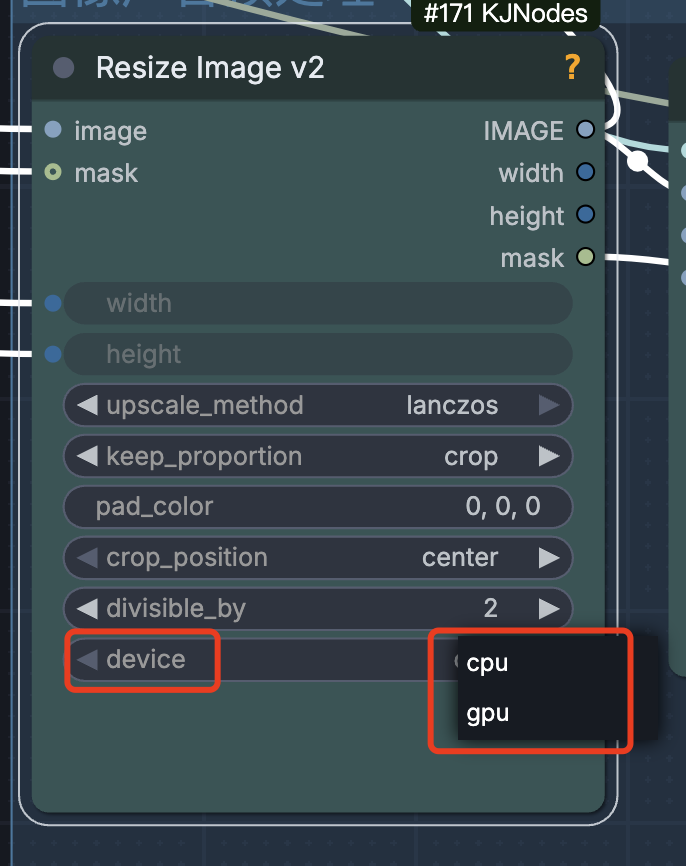

ImageResizeKJv2

优势对比普通Resize节点:

-

更高质量的重采样算法:特别是放大时,减少模糊和伪影

-

直接输出适合GPU处理的格式:减少后续节点的数据格式转换开销

-

批处理优化:对多帧图像进行统一缩放,减少函数调用开销

配置示例:

python

输入分辨率:1920×1080(视频原帧)

目标分辨率:768×432(模型输入尺寸)

缩放算法:Lanczos(适合缩小)/ Mitchell(适合放大)

输出格式:Tensor(直接送GPU)BlockifyMask 与 DrawMaskOnImage

显存节约原理:

优化前的问题:

python

# 低效的Mask处理

原始图像(全尺寸)→ 全图送入VAE编码 → 生成完整Latent

实际需要:仅编辑脸部区域

结果:90%的算力浪费在不需要修改的区域优化后的流程:

python

# 使用BlockifyMask优化

原始图像 → BlockifyMask识别有效区域 →

仅将有效区域(如脸部)送入后续处理 →

VAE编码区域减少70-90% → 显存占用大幅降低实际应用场景:

-

视频人脸修复:只处理检测到的人脸区域

-

局部风格迁移:仅对特定物体应用效果

-

背景替换:分离前景和背景处理

2.4 ⚙️ 流程控制与预处理

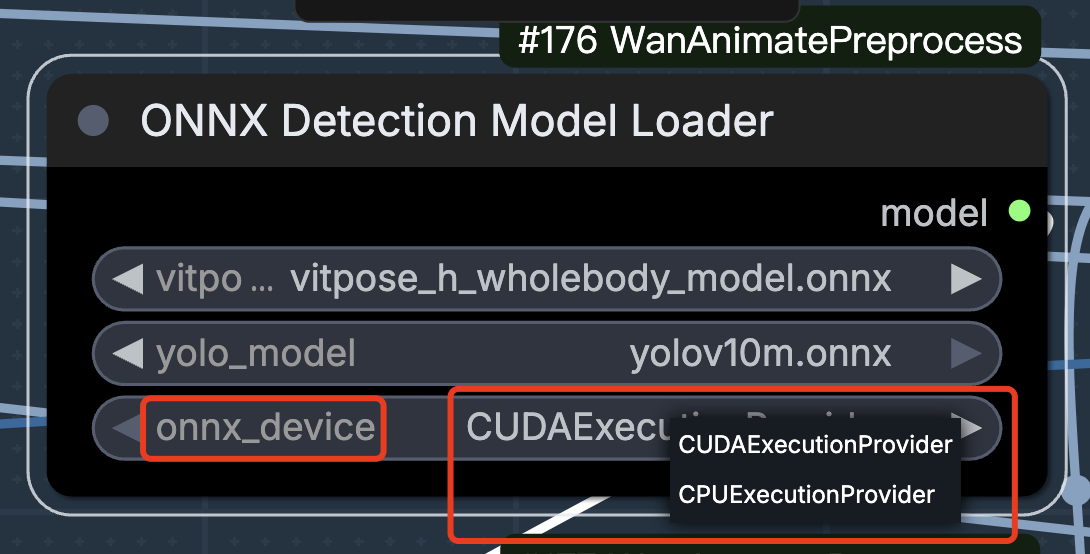

OnnxDetectionModelLoader

定位:工作流的"前哨"节点

最佳实践:

-

放置位置:工作流的最前端

-

加载时机:在视频处理开始前完成加载

-

模型选择:根据任务选择专用模型(人脸检测、姿态估计、物体分割等)

优化工作流结构:

┌─────────────────────────────────────────┐

│ 第一阶段:预处理模型加载与初始化 │

│ • OnnxDetectionModelLoader(姿态检测)│

│ • 其他专用预处理模型 │

└─────────────────────────────────────────┘

↓

┌─────────────────────────────────────────┐

│ 第二阶段:主模型并行加载 │

│ • WanVideo系列模型 │

│ • VAE/CLIP等基础模型 │

└─────────────────────────────────────────┘

↓

┌─────────────────────────────────────────┐

│ 第三阶段:逐帧处理与生成 │

│ • 视频帧输入 → 预处理 → 生成 → 输出 │

└─────────────────────────────────────────┘

三、实战:构建高效的Wan视频生成工作流

3.1 优化前后工作流对比

原始工作流(存在效率问题):

视频输入 → 逐帧Resize → CLIP编码 → 加载T5 → 加载VAE

→ 加载ControlNet → 生成 → 输出

问题:顺序加载,大量等待时间

优化后工作流:

┌─ 并行加载区 ──────────────────────┐

│ Onnx检测模型 T5加载器 VAE加载器 │

│ Wav2Vec加载器 ControlNet加载器 │

└───────────────────────────────────┘

↓

视频输入与预处理

(使用ImageResizeKJv2等优化节点)

↓

多模态数据融合与编码

(使用WanVideoTextEncode等专用编码器)

↓

时空控制信号注入

(WanVideoUni3C_ControlnetLoader)

↓

生成与输出

3.2 关键配置参数建议

显存管理配置:

(yaml)在启动ComfyUI时添加这些参数(如果支持)

--highvram # 优先使用显存,减少CPU交换

--force-fp16 # 强制使用半精度浮点数

--disable-smart-cache # 如果显存充足,禁用智能缓存以减少开销

节点特定配置:

-

WanVideoVAELoader :启用

cache_in_fp16选项(如果支持) -

ImageResizeKJv2 :设置

prefer_tensor_output=True -

所有加载器 :检查并启用

keep_in_memory选项

四、监控与调试技巧

4.1 GPU利用率监控

使用以下工具实时监控优化效果:

Windows用户:

-

GPU-Z:查看显存占用、GPU负载

-

Windows任务管理器:性能选项卡

Linux用户:

bash

# 安装并运行nvtop

sudo apt install nvtop

nvtop

# 或使用nvidia-smi的监控模式

watch -n 1 nvidia-smi4.2 性能基准测试

建立自己的性能基准:

python

测试场景1:简单文生图(基准)

测试场景2:Wan视频生成(优化前)

测试场景3:Wan视频生成(优化后)

记录指标:

- 总生成时间

- 峰值显存使用量

- GPU平均利用率

- 模型加载时间占比五、常见问题与解决方案

Q1:优化后显存仍然不足?

解决方案:

-

使用

BlockifyMask进一步减少处理区域 -

降低批处理大小(batch size)

-

考虑使用

--lowvram模式(以速度为代价)

Q2:节点优化是否会影响生成质量?

答案:合理优化通常不会降低质量。例如:

-

ImageResizeKJv2使用高质量算法 -

专用编码器针对任务优化

-

模型缓存不影响计算精度

Q3:如何判断某个节点是否需要优化?

检查清单:

-

✅ 该节点是否涉及模型加载?

-

✅ 是否处理大量数据(如高清图像)?

-

✅ 是否在循环/逐帧处理中被多次调用?

-

✅ 是否有更高效的替代节点?

六、总结与进阶建议

核心收获:

-

并行化加载是多模型工作流的速度关键

-

专用节点往往比通用节点更高效

-

数据流优化 和显存有效利用同等重要

-

监控和测量是持续优化的基础

进阶方向:

-

自定义节点开发:针对特定需求编写高效节点

-

混合精度训练:探索FP16/FP8在推理中的应用

-

模型蒸馏:使用轻量级模型替代部分重型模型

-

流水线并行:将工作流分阶段在不同GPU上执行

最后的建议:

今天的深度剖析只是一个开始,真正的优化之旅需要你亲自动手实践、测试和调整。建议从本文的优化策略开始,逐步建立自己的性能档案,记录每种配置下的表现。随着ComfyUI生态的发展,也会有更多高效节点不断涌现,保持学习和实验的心态是关键。

下一步行动:

-

打开你的ComfyUI,应用至少一项本文提到的优化

-

记录优化前后的性能差异

-

在评论区分享你的优化经验或遇到的问题

相关资源:

系列文章回顾: