人工智能学习-AI入试相关题目练习-第四次

- 1-前言

- 2-AI入试相关题目概念解释

- 3-概念解释-知道中文也需要知道日文什么意思

- (1)探索アルゴリズム(最短経路探索)

- (2)編集距離(動的計画法)

-

- (ア)DP中记录的是什么?

- [(イ)"abebc" → "babbe" 的编辑距离](#(イ)"abebc" → "babbe" 的编辑距离)

- (ウ)其中"置换(替换)"的次数

- (3)クラスタリング(聚类)

- [(4)Q 学習](#(4)Q 学習)

-

- (ア)Q值表示什么?

- [(イ)加到当前 Q 的是?](#(イ)加到当前 Q 的是?)

- (ウ)学习含义

- (5)命题逻辑证明(归结原理)

-

- [(ア)Z 要证明为什么式?](#(ア)Z 要证明为什么式?)

- [(イ)¬Z 等价于?](#(イ)¬Z 等价于?)

- (ウ)使用什么方法反复化简?

- (エ)最终结论

- [✅ 全部最终答案汇总(可直接填)](#✅ 全部最终答案汇总(可直接填))

- 5-练习(日语版本)解析

- (1)探索アルゴリズム(最短経路探索)

- (2)編集距離(動的計画法)

-

- (ア)DP中记录的是什么?

- [(イ)"abebc" → "babbe" 的编辑距离](#(イ)"abebc" → "babbe" 的编辑距离)

- (ウ)其中"置换(替换)"的次数

- (3)クラスタリング(聚类)

- [(4)Q 学習](#(4)Q 学習)

-

- (ア)Q值表示什么?

- [(イ)加到当前 Q 的是?](#(イ)加到当前 Q 的是?)

- (ウ)学习含义

- (5)命题逻辑证明(归结原理)

-

- [(ア)Z 要证明为什么式?](#(ア)Z 要证明为什么式?)

- [(イ)¬Z 等价于?](#(イ)¬Z 等价于?)

- (ウ)使用什么方法反复化简?

- (エ)最终结论

- [✅ 全部最终答案汇总(可直接填)](#✅ 全部最终答案汇总(可直接填))

- 6总结

1-前言

为了应对大学院考试,我们来学习相关人工智能相关知识,并做各种练习。

通过学习,也算是做笔记,让自己更理解些。

2-AI入试相关题目概念解释

3-概念解释-知道中文也需要知道日文什么意思

(1)探索アルゴリズム(最短経路探索)

已知定义:

- ( g(s)):初期ノード → s 的已知最短路径代价

- ( h(s)):s → 目的ノード 的启发式估计

- ( f(s)=g(s)+h(s) )

三种算法的排序标准:

| 算法 | 排序依据 |

|---|---|

| 最適探索(ダイクストラ) | 只看已走代价 |

| 最良優先探索 | 只看启发 |

| A* | 看总代价 |

因此:

- 最適探索:按 ( g(s) ) 小的

- 最良優先探索:按 ( h(s) ) 小的

- A*:按 ( f(s)=g(s)+h(s) ) 小的

答案:

- ア:a(g(s))

- イ:b(h(s))

- ウ:c(f(s)=g(s)+h(s))

(2)編集距離(動的計画法)

(ア)DP中记录的是什么?

对"部分字符串"的编辑距离进行记录 → メモ化

→ エ = f(メモ化)

(イ)"abebc" → "babbe" 的编辑距离

一种最优变换示例(3步):

- abebc → babebc(插入 b)

- babebc → babbe(删除 e,c)

- 或等价 3 次操作

编辑距离 = 3

→ オ = d(3)

(ウ)其中"置换(替换)"的次数

在最优解中 替换 1 次

→ カ = b(1)

(2)最终答案

- エ:f

- オ:d

- カ:b

(3)クラスタリング(聚类)

(ア)机器学习分类

聚类是 教师なし学習(无监督学习)

→ キ = d(教師なし学習)

(イ)确定性聚类算法

"反复更新聚类中心、按距离分类" → k-means 法

→ ク = g(k-means 法)

(ウ)目标函数性质

k-means 的平方距离和 单调减少

→ ケ = a(単調減少)

(3)最终答案

- キ:d

- ク:g

- ケ:a

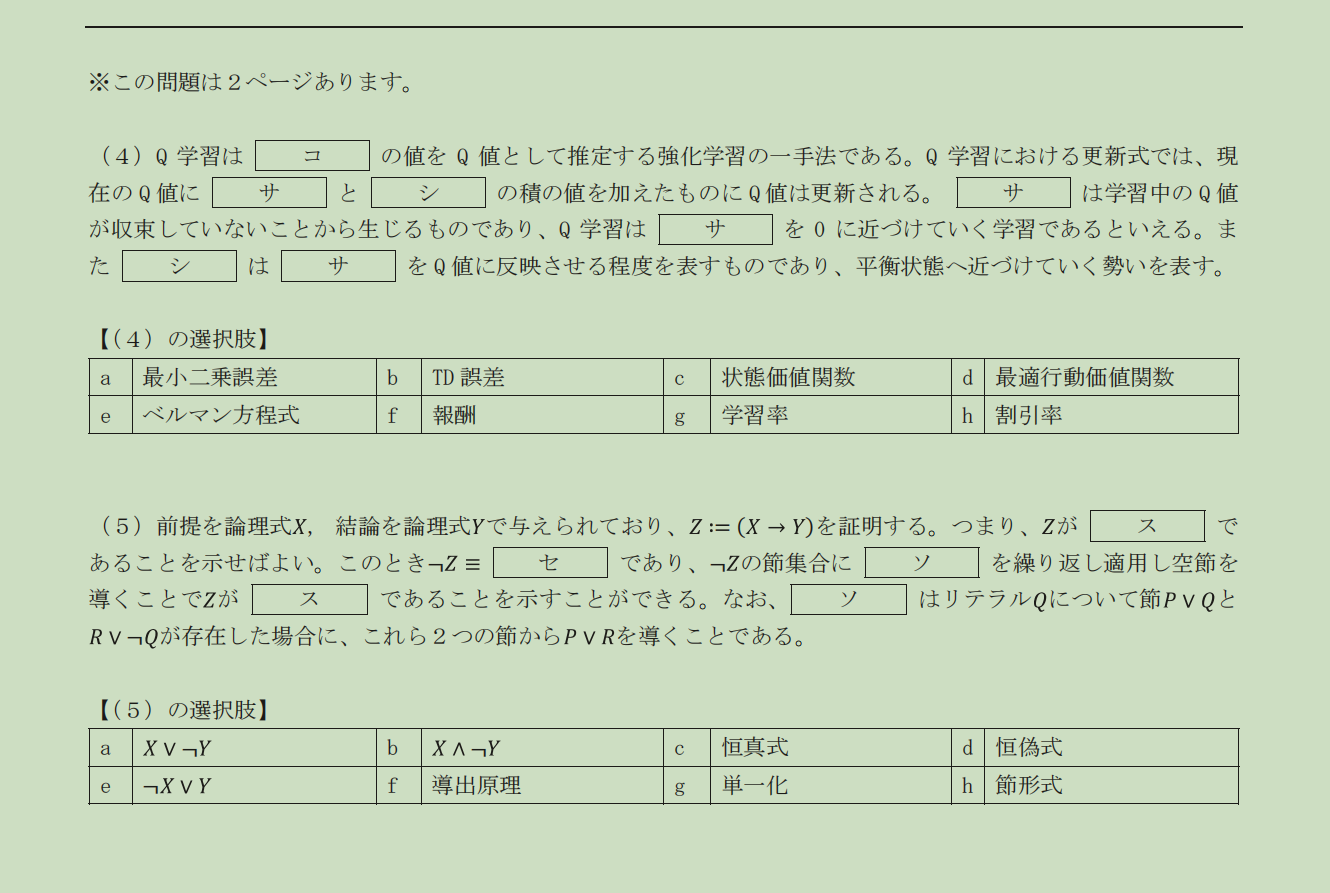

(4)Q 学習

Q-learning 更新公式本质:

Q \\leftarrow Q + \\alpha \\cdot \\delta

其中:

- (\delta):TD誤差

- (\alpha):学习率

逐空分析:

(ア)Q值表示什么?

Q值是 最优行动价值函数

→ コ = d(最適行動価値関数)

(イ)加到当前 Q 的是?

当前 Q +(サ × シ)

- サ:TD誤差

- シ:学習率

→

- サ = b(TD誤差)

- シ = g(学習率)

(ウ)学习含义

- Q学习就是让 TD误差 → 0

- 学习率控制反映程度

逻辑完全一致 ✔

(4)最终答案

- コ:d

- サ:b

- シ:g

(5)命题逻辑证明(归结原理)

目标:证明

Z := (X \\rightarrow Y)

等价证明流程:

(ア)Z 要证明为什么式?

要证明 Z 为 恒真式

→ ス = c(恒真式)

(イ)¬Z 等价于?

\\neg(X \\rightarrow Y) \\equiv X \\land \\neg Y

→ セ = b(X ∧ ¬Y)

(ウ)使用什么方法反复化简?

描述的是:

若存在 (P∨Q) 与 (R∨¬Q),推出 (P∨R)

→ 導出原理(Resolution)

→ ソ = f(導出原理)

(エ)最终结论

通过归结导出空节 → 原命题为恒真 ✔

(5)最终答案

- ス:c

- セ:b

- ソ:f

✅ 全部最终答案汇总(可直接填)

(1) ア=a イ=b ウ=c

(2) エ=f オ=d カ=b

(3) キ=d ク=g ケ=a

(4) コ=d サ=b シ=g

(5) ス=c セ=b ソ=f5-练习(日语版本)解析

(1)探索アルゴリズム(最短経路探索)

已知定义:

- ( g(s)):初期ノード → s 的已知最短路径代价

- ( h(s)):s → 目的ノード 的启发式估计

- ( f(s)=g(s)+h(s) )

三种算法的排序标准:

| 算法 | 排序依据 |

|---|---|

| 最適探索(ダイクストラ) | 只看已走代价 |

| 最良優先探索 | 只看启发 |

| A* | 看总代价 |

因此:

- 最適探索:按 ( g(s) ) 小的

- 最良優先探索:按 ( h(s) ) 小的

- A*:按 ( f(s)=g(s)+h(s) ) 小的

答案:

- ア:a(g(s))

- イ:b(h(s))

- ウ:c(f(s)=g(s)+h(s))

(2)編集距離(動的計画法)

(ア)DP中记录的是什么?

对"部分字符串"的编辑距离进行记录 → メモ化

→ エ = f(メモ化)

(イ)"abebc" → "babbe" 的编辑距离

一种最优变换示例(3步):

- abebc → babebc(插入 b)

- babebc → babbe(删除 e,c)

- 或等价 3 次操作

编辑距离 = 3

→ オ = d(3)

(ウ)其中"置换(替换)"的次数

在最优解中 替换 1 次

→ カ = b(1)

(2)最终答案

- エ:f

- オ:d

- カ:b

(3)クラスタリング(聚类)

(ア)机器学习分类

聚类是 教师なし学習(无监督学习)

→ キ = d(教師なし学習)

(イ)确定性聚类算法

"反复更新聚类中心、按距离分类" → k-means 法

→ ク = g(k-means 法)

(ウ)目标函数性质

k-means 的平方距离和 单调减少

→ ケ = a(単調減少)

(3)最终答案

- キ:d

- ク:g

- ケ:a

(4)Q 学習

Q-learning 更新公式本质:

Q \\leftarrow Q + \\alpha \\cdot \\delta

其中:

- (\delta):TD誤差

- (\alpha):学习率

逐空分析:

(ア)Q值表示什么?

Q值是 最优行动价值函数

→ コ = d(最適行動価値関数)

(イ)加到当前 Q 的是?

当前 Q +(サ × シ)

- サ:TD誤差

- シ:学習率

→

- サ = b(TD誤差)

- シ = g(学習率)

(ウ)学习含义

- Q学习就是让 TD误差 → 0

- 学习率控制反映程度

逻辑完全一致 ✔

(4)最终答案

- コ:d

- サ:b

- シ:g

(5)命题逻辑证明(归结原理)

目标:证明

Z := (X \\rightarrow Y)

等价证明流程:

(ア)Z 要证明为什么式?

要证明 Z 为 恒真式

→ ス = c(恒真式)

(イ)¬Z 等价于?

\\neg(X \\rightarrow Y) \\equiv X \\land \\neg Y

→ セ = b(X ∧ ¬Y)

(ウ)使用什么方法反复化简?

描述的是:

若存在 (P∨Q) 与 (R∨¬Q),推出 (P∨R)

→ 導出原理(Resolution)

→ ソ = f(導出原理)

(エ)最终结论

通过归结导出空节 → 原命题为恒真 ✔

(5)最终答案

- ス:c

- セ:b

- ソ:f

✅ 全部最终答案汇总(可直接填)

(1) ア=a イ=b ウ=c

(2) エ=f オ=d カ=b

(3) キ=d ク=g ケ=a

(4) コ=d サ=b シ=g

(5) ス=c セ=b ソ=f6总结

知识一点点记录吧,最后应对考试,打下基础