Deepseek 课程大纲

适合人群

- 职场精英:学习AI,提高工作效率。

- 自媒体博主:用AI编写文案和口播脚本。

- 在校学生:通过AI提升学习效率,助力论文写作。

- AI 爱好者:了解Deepseek的玩法。

你将会学到

课程实战涵盖本地部署、文案生成、AI音乐、AI批八字、AI生成图表、AI背单词、情感陪伴、AI编程。

简介

本课程面向零基础同学,向大家讲解什么是Deepseek,以及它为什么如此火爆。课程内容以录屏实战为主,涵盖本地部署、文案生成、AI音乐、AI批八字、AI生成图表、AI背单词、情感陪伴、AI编程等。

Deepseek的与众不同

Deepseek vs OpenAI 对比

Deepseek v3 vs OpenAI GPT-4o

| 项目 | Deepseek v3 | OpenAI GPT-4o |

|---|---|---|

| 研发费用 | 500多万美元 | 1亿美元 |

| 使用费用 | 免费 | 20美元/月 |

Deepseek R1 vs OpenAI O1

| 项目 | Deepseek R1 | OpenAI O1 |

|---|---|---|

| 使用费用 | 免费 | 200美元/月 |

| 最大输入 | 64K | 128K |

| 最大输出 | 8K | 32K |

| API费用(100万token) | ||

| 输入 | 4元 | 107元 |

| 输出 | 16元 | 426元 |

V3 和 R1 的区别

性能特点

| 项目 | DeepSeek-R1 | DeepSeek-V3 |

|---|---|---|

| 核心优势 | 复杂问题推理、数学/代码求解 | 多轮对话、指令理解、任务执行 |

| 适用场景 | 学术研究、技术分析、代码开发 | 客服、日常对话、内容生成 |

| 交互风格 | 偏重精准性,输出结构化较强 | 更自然流畅,注重用户交互体验 |

关键区别总结

- V3 是指令型模型:它通过指令微调(Instruction Tuning)优化了对用户意图的理解,能够更好地执行具体任务(如写邮件、生成故事等)。

- R1 是推理专家:针对需要逻辑链推导的场景(如解数学题、代码调试)设计,MoE 架构使其在细分任务上表现更专业。

如何选择?

- 如果需要通用对话、日常助手功能 ,选 V3;

- 如果涉及技术分析、复杂问题解决 ,选 R1。

关键区别总结

- V3 是指令型模型:它通过指令微调(Instruction Tuning)优化了对用户意图的理解,能够更好地执行具体任务(如写邮件、生成故事等)。

- R1 是推理专家:针对需要逻辑链推导的场景(如解数学题、代码调试)设计,MoE 架构使其在细分任务上表现更专业。

如何选择?

- 如果需要通用对话、日常助手功能 ,选 V3;

- 如果涉及技术分析、复杂问题解决 ,选 R1。

V3 和 R1 提示词的区别

指令型提示词(适用于 V3)

指令型提示词的结构包含以下组件:

- [角色]:你是一名有xx年经验的xx专家,擅长处理xx方面的问题。

- [简介]:我想做xx事,达到xx效果。

- [背景]:我是谁,我有什么能力。现在有什么与需求相关的资源。

- [目标]:要实现的最终效果是什么样的。

- [限制]:要求AI不能做什么,比如不能生成要求以外的内容。

- [能力]:限制AI的能力。

- [流程]:为AI提供一个思考路径和实现需求的工作流程。

推理型提示词(适用于 R1)

基本结构

我是xx,我的背景是xxx。我想要实现xx目标。提示词要点

-

你的目标?

- 目标要清晰,要明确

-

你的背景?

- 背景要丰富,要量化

-

目标不清晰,背景不完善?

- 没关系,可以通过多轮沟通逐渐完善

-

返回内容过于正式和书面化?

- 则可以让它说人话

提示词技巧

💡 提示词技巧:真诚就好

Deepseek 课程大纲

适合人群

- 职场精英:学习AI,提高工作效率。

- 自媒体博主:用AI编写文案和口播脚本。

- 在校学生:通过AI提升学习效率,助力论文写作。

- AI 爱好者:了解Deepseek的玩法。

你将会学到

课程实战涵盖本地部署、文案生成、AI音乐、AI批八字、AI生成图表、AI背单词、情感陪伴、AI编程。

课程简介

本课程面向零基础同学,向大家讲解什么是Deepseek,以及它为什么如此火爆。课程内容以录屏实战为主,涵盖本地部署、文案生成、AI音乐、AI批八字、AI生成图表、AI背单词、情感陪伴、AI编程等。

Deepseek vs OpenAI 对比

Deepseek v3 vs OpenAI GPT-4o

| 项目 | Deepseek v3 | OpenAI GPT-4o |

|---|---|---|

| 研发费用 | 500多万美元 | 1亿美元 |

| 使用费用 | 免费 | 20美元/月 |

Deepseek R1 vs OpenAI O1

| 项目 | Deepseek R1 | OpenAI O1 |

|---|---|---|

| 使用费用 | 免费 | 200美元/月 |

| 最大输入 | 64K | 128K |

| 最大输出 | 8K | 32K |

| API费用(100万token) | ||

| 输入 | 4元 | 107元 |

| 输出 | 16元 | 426元 |

V3 和 R1 的区别

性能特点

| 项目 | DeepSeek-R1 | DeepSeek-V3 |

|---|---|---|

| 核心优势 | 复杂问题推理、数学/代码求解 | 多轮对话、指令理解、任务执行 |

| 适用场景 | 学术研究、技术分析、代码开发 | 客服、日常对话、内容生成 |

| 交互风格 | 偏重精准性,输出结构化较强 | 更自然流畅,注重用户交互体验 |

关键区别总结

- V3 是指令型模型:它通过指令微调(Instruction Tuning)优化了对用户意图的理解,能够更好地执行具体任务(如写邮件、生成故事等)。

- R1 是推理专家:针对需要逻辑链推导的场景(如解数学题、代码调试)设计,MoE 架构使其在细分任务上表现更专业。

如何选择?

- 如果需要通用对话、日常助手功能 ,选 V3;

- 如果涉及技术分析、复杂问题解决 ,选 R1。

V3 和 R1 提示词的区别

指令型提示词(适用于 V3)

指令型提示词的结构包含以下组件:

- [角色]:你是一名有xx年经验的xx专家,擅长处理xx方面的问题。

- [简介]:我想做xx事,达到xx效果。

- [背景]:我是谁,我有什么能力。现在有什么与需求相关的资源。

- [目标]:要实现的最终效果是什么样的。

- [限制]:要求AI不能做什么,比如不能生成要求以外的内容。

- [能力]:限制AI的能力。

- [流程]:为AI提供一个思考路径和实现需求的工作流程。

推理型提示词(适用于 R1)

基本结构

我是xx,我的背景是xxx。我想要实现xx目标。提示词要点

-

你的目标?

- 目标要清晰,要明确

-

你的背景?

- 背景要丰富,要量化

-

目标不清晰,背景不完善?

- 没关系,可以通过多轮沟通逐渐完善

-

返回内容过于正式和书面化?

- 则可以让它说人话

提示词技巧

💡 提示词技巧:真诚就好

Deepseek R1 vs V3 全面对比分析

1. 技术架构对比

| 维度 | DeepSeek-V3 | DeepSeek-R1 |

|---|---|---|

| 模型类型 | 指令微调模型(Instruction Tuning) | 推理专家模型(Reasoning Expert) |

| 架构特点 | 通用对话架构 | MoE(Mixture of Experts)架构 |

| 训练方式 | 指令微调优化 | 针对推理任务优化 |

| 核心设计理念 | 理解用户意图,执行具体任务 | 逻辑链推导,解决复杂问题 |

| 上下文理解 | 多轮对话理解能力强 | 深度推理分析能力强 |

2. 核心能力对比

| 能力维度 | DeepSeek-V3 | DeepSeek-R1 |

|---|---|---|

| 指令理解 | ⭐⭐⭐⭐⭐ 优秀 | ⭐⭐⭐⭐ 良好 |

| 任务执行 | ⭐⭐⭐⭐⭐ 优秀 | ⭐⭐⭐ 一般 |

| 多轮对话 | ⭐⭐⭐⭐⭐ 优秀 | ⭐⭐⭐ 一般 |

| 复杂推理 | ⭐⭐⭐ 一般 | ⭐⭐⭐⭐⭐ 优秀 |

| 数学求解 | ⭐⭐⭐ 一般 | ⭐⭐⭐⭐⭐ 优秀 |

| 代码开发 | ⭐⭐⭐⭐ 良好 | ⭐⭐⭐⭐⭐ 优秀 |

| 内容生成 | ⭐⭐⭐⭐⭐ 优秀 | ⭐⭐⭐ 一般 |

| 逻辑分析 | ⭐⭐⭐ 一般 | ⭐⭐⭐⭐⭐ 优秀 |

| 结构化输出 | ⭐⭐⭐ 一般 | ⭐⭐⭐⭐⭐ 优秀 |

| 自然交互 | ⭐⭐⭐⭐⭐ 优秀 | ⭐⭐⭐ 一般 |

3. 适用场景详细对比

| 场景类别 | 具体场景 | DeepSeek-V3 | DeepSeek-R1 | 推荐选择 |

|---|---|---|---|---|

| 内容创作 | 写文章、博客 | ✅ 优秀 | ⚠️ 一般 | V3 |

| 内容创作 | 生成营销文案 | ✅ 优秀 | ⚠️ 一般 | V3 |

| 内容创作 | 写小说、故事 | ✅ 优秀 | ⚠️ 一般 | V3 |

| 内容创作 | 生成歌词 | ✅ 优秀 | ⚠️ 一般 | V3 |

| 客户服务 | 客服对话 | ✅ 优秀 | ⚠️ 一般 | V3 |

| 客户服务 | 日常问答 | ✅ 优秀 | ⚠️ 一般 | V3 |

| 客户服务 | 产品咨询 | ✅ 优秀 | ⚠️ 一般 | V3 |

| 技术开发 | 代码编写 | ⚠️ 良好 | ✅ 优秀 | R1 |

| 技术开发 | 代码调试 | ⚠️ 一般 | ✅ 优秀 | R1 |

| 技术开发 | 算法设计 | ⚠️ 一般 | ✅ 优秀 | R1 |

| 技术开发 | 技术文档 | ⚠️ 良好 | ✅ 优秀 | R1 |

| 学术研究 | 数学问题求解 | ⚠️ 一般 | ✅ 优秀 | R1 |

| 学术研究 | 逻辑推理 | ⚠️ 一般 | ✅ 优秀 | R1 |

| 学术研究 | 数据分析 | ⚠️ 一般 | ✅ 优秀 | R1 |

| 学术研究 | 论文写作 | ✅ 优秀 | ⚠️ 一般 | V3 |

| 商业应用 | 邮件撰写 | ✅ 优秀 | ⚠️ 一般 | V3 |

| 商业应用 | 商业分析 | ⚠️ 一般 | ✅ 优秀 | R1 |

| 商业应用 | 决策支持 | ⚠️ 一般 | ✅ 优秀 | R1 |

4. 输出特点对比

| 输出特征 | DeepSeek-V3 | DeepSeek-R1 |

|---|---|---|

| 语言风格 | 自然流畅,口语化 | 精准严谨,书面化 |

| 输出格式 | 灵活多样 | 结构化强 |

| 思考过程 | 直接给出结果 | 展示推理过程 |

| 内容长度 | 可长可短,灵活 | 通常较长,详细 |

| 情感表达 | 丰富自然 | 相对正式 |

| 错误处理 | 友好提示 | 详细分析 |

| 个性化程度 | 高 | 中 |

| 专业性 | 中高 | 高 |

5. 提示词使用详细对比

5.1 提示词结构对比

| 组件 | DeepSeek-V3(指令型) | DeepSeek-R1(推理型) |

|---|---|---|

| 必需组件 | 角色、目标、任务 | 背景、目标 |

| 推荐组件 | 背景、限制、流程 | 约束条件、期望输出 |

| 可选组件 | 能力、风格 | 思考方式、验证方法 |

| 结构复杂度 | 高(7个组件) | 低(2-3个组件) |

| 编写难度 | 中等 | 简单 |

5.2 提示词编写模板对比

DeepSeek-V3 指令型提示词模板:

[角色] 你是一名有xx年经验的xx专家,擅长处理xx方面的问题。

[简介] 我想做xx事,达到xx效果。

[背景] 我是谁,我有什么能力。现在有什么与需求相关的资源。

[目标] 要实现的最终效果是什么样的。

[限制] 要求AI不能做什么,比如不能生成要求以外的内容。

[能力] 限制AI的能力。

[流程] 为AI提供一个思考路径和实现需求的工作流程。DeepSeek-R1 推理型提示词模板:

我是xx,我的背景是xxx。我想要实现xx目标。

[可选:约束条件] xx

[可选:期望输出格式] xx5.3 提示词编写要点对比

| 要点 | DeepSeek-V3 | DeepSeek-R1 |

|---|---|---|

| 目标描述 | 需要明确具体 | 需要清晰明确 |

| 背景信息 | 需要详细说明 | 需要丰富量化 |

| 角色设定 | 重要,影响输出风格 | 可选,影响较小 |

| 流程设计 | 重要,指导执行 | 可选,模型自主推理 |

| 限制条件 | 重要,避免偏离 | 可选,辅助约束 |

| 多轮交互 | 支持,可逐步完善 | 支持,可逐步完善 |

| 语言风格 | 可指定风格 | 可要求"说人话" |

6. 成本与性能对比

| 维度 | DeepSeek-V3 | DeepSeek-R1 |

|---|---|---|

| 使用费用 | 免费 | 免费 |

| API费用(100万token) | ||

| - 输入 | 待确认 | 4元 |

| - 输出 | 待确认 | 16元 |

| 最大输入 | 待确认 | 64K |

| 最大输出 | 待确认 | 8K |

| 响应速度 | 较快 | 较慢(需推理) |

| 资源消耗 | 较低 | 较高 |

| 性价比 | 高 | 高 |

7. 使用建议矩阵

| 需求类型 | 复杂度 | 推荐模型 | 理由 |

|---|---|---|---|

| 日常对话 | 低 | V3 | 自然流畅,交互体验好 |

| 内容生成 | 中 | V3 | 指令理解强,输出质量高 |

| 简单问答 | 低 | V3 | 响应快,成本低 |

| 代码编写 | 中 | R1 | 逻辑推理强,代码质量高 |

| 数学求解 | 高 | R1 | 推理专家,准确率高 |

| 技术分析 | 高 | R1 | 深度分析,结构化输出 |

| 复杂推理 | 高 | R1 | 逻辑链推导能力强 |

| 多轮对话 | 中 | V3 | 上下文理解好 |

| 创意写作 | 中 | V3 | 自然表达,风格多样 |

| 学术研究 | 高 | R1 | 严谨准确,推理过程清晰 |

8. 实际应用案例对比

| 应用案例 | DeepSeek-V3 表现 | DeepSeek-R1 表现 | 最佳选择 |

|---|---|---|---|

| 写一封商务邮件 | ✅ 自然流畅,语气恰当 | ⚠️ 可能过于正式 | V3 |

| 解决一道数学题 | ⚠️ 可能出错或步骤不清晰 | ✅ 步骤详细,推理清晰 | R1 |

| 编写Python代码 | ⚠️ 代码可用但可能不够优化 | ✅ 代码质量高,逻辑清晰 | R1 |

| 生成营销文案 | ✅ 吸引人,符合营销需求 | ⚠️ 可能过于严谨 | V3 |

| 分析数据趋势 | ⚠️ 分析较浅 | ✅ 深度分析,逻辑严密 | R1 |

| 日常聊天对话 | ✅ 自然友好 | ⚠️ 可能过于正式 | V3 |

| 调试代码错误 | ⚠️ 可能找不到根本原因 | ✅ 能追踪问题根源 | R1 |

| 写技术文档 | ⚠️ 可能不够专业 | ✅ 结构清晰,专业准确 | R1 |

| 创作故事小说 | ✅ 情节丰富,语言生动 | ⚠️ 可能过于逻辑化 | V3 |

| 商业决策分析 | ⚠️ 分析不够深入 | ✅ 多角度分析,逻辑严密 | R1 |

9. 选择决策流程图

开始

│

├─ 需要解决复杂数学/逻辑问题?

│ ├─ 是 → 选择 R1

│ └─ 否 ↓

│

├─ 需要编写/调试代码?

│ ├─ 是 → 选择 R1

│ └─ 否 ↓

│

├─ 需要深度技术分析?

│ ├─ 是 → 选择 R1

│ └─ 否 ↓

│

├─ 需要日常对话/客服?

│ ├─ 是 → 选择 V3

│ └─ 否 ↓

│

├─ 需要内容创作/文案?

│ ├─ 是 → 选择 V3

│ └─ 否 ↓

│

└─ 不确定? → 先尝试 V3,如需要深度推理再换 R110. 综合评分对比

| 评估维度 | DeepSeek-V3 | DeepSeek-R1 | 说明 |

|---|---|---|---|

| 通用性 | 9/10 | 7/10 | V3 适用场景更广 |

| 专业性 | 7/10 | 9/10 | R1 在专业领域更强 |

| 易用性 | 9/10 | 8/10 | V3 交互更自然 |

| 准确性 | 8/10 | 9/10 | R1 推理更准确 |

| 响应速度 | 9/10 | 7/10 | V3 响应更快 |

| 成本效益 | 10/10 | 10/10 | 两者都免费 |

| 综合推荐度 | 9/10 | 8.5/10 | 根据需求选择 |

11. 最佳实践建议

11.1 何时使用 V3

- ✅ 需要自然对话和友好交互

- ✅ 内容创作(文章、文案、故事等)

- ✅ 日常助手功能

- ✅ 客服和问答场景

- ✅ 需要快速响应的任务

- ✅ 多轮对话场景

11.2 何时使用 R1

- ✅ 需要深度逻辑推理

- ✅ 数学问题求解

- ✅ 代码开发和调试

- ✅ 技术分析和研究

- ✅ 需要展示思考过程

- ✅ 复杂问题解决

11.3 组合使用策略

| 场景 | 策略 | 说明 |

|---|---|---|

| 复杂项目 | V3 + R1 | 用 V3 规划,用 R1 执行技术部分 |

| 内容+技术 | V3 + R1 | 用 V3 写文案,用 R1 写代码 |

| 验证结果 | R1 + V3 | 用 R1 分析,用 V3 润色表达 |

| 快速迭代 | V3 为主 | 快速生成,需要时再用 R1 优化 |

Deepseek 为何与众不同

概述

Deepseek 是中国在 AI 领域实现弯道超车、突破算力封锁的一款现象级产品。它用极低的研发成本实现了与 OpenAI 高投入产品相媲美的效果,展现了强大的技术实力和创新能力。

核心优势

研发成本对比

| 项目 | Deepseek V3 | OpenAI GPT-4o |

|---|---|---|

| 研发费用 | 500多万美元 | 过亿美元 |

| 性能表现 | 达到 GPT-4o 水平 | 行业标杆 |

| 性价比 | ⭐⭐⭐⭐⭐ 极高 | ⭐⭐⭐ 一般 |

💡 关键突破:仅用 500 多万美元的研发投入,就达到了 OpenAI 过亿美元投入所产出的 GPT-4o 的效果。

产品版本

Deepseek 目前主要有两个版本:

版本对比

| 版本 | 使用方式 | 模型类型 | 特点 |

|---|---|---|---|

| V3 | 不勾选"深度思考" | 指令型大模型 | 需要详细的格式化提示词 |

| R1 | 勾选"深度思考" | 推理型模型 | 自然对话,无需复杂提示词 |

版本说明

-

V3 版本:指令型大模型

- 使用方式:不勾选"深度思考"选项

- 特点:需要给出详细的需求和格式化提示词

- 适用场景:需要精确控制输出的任务

-

R1 版本:推理型模型

- 使用方式:勾选"深度思考"选项

- 特点:具有推理思考能力,无需纠结提示词格式

- 适用场景:复杂问题解决、需要深度思考的任务

与 OpenAI 对标

模型类型对比

| Deepseek | OpenAI | 模型类型 |

|---|---|---|

| V3 | GPT-4 | 指令型大模型 |

| R1 | O1 | 推理型模型 |

性能表现

根据目前网络上的反馈和评测:

- ✅ Deepseek R1 已经具备了与 ChatGPT 一较高下的能力

- ✅ 在多个评测维度上表现优异

- ✅ 技术实力得到广泛认可

技术突破的意义

1. 突破算力封锁

- 在受限的算力环境下实现技术突破

- 证明了创新的重要性

- 为中国 AI 产业发展树立了标杆

2. 开源贡献

- Deepseek 是开源的

- 为全球 AI 社区提供技术基础

- 未来会有越来越多的大模型基于 Deepseek 进行升级改造

3. 民族骄傲

- 作为中国人,这个技术上的重大突破值得骄傲

- 展现了中国的技术实力和创新能力

- 在国际 AI 竞争中占据重要地位

使用建议

选择 V3 的场景

- ✅ 需要精确控制输出格式

- ✅ 有明确的指令和需求

- ✅ 可以使用格式化提示词

- ✅ 日常对话和内容生成

选择 R1 的场景

- ✅ 需要解决复杂问题

- ✅ 需要深度推理和思考

- ✅ 不想纠结提示词格式

- ✅ 技术分析、代码开发、数学求解

未来展望

- 技术持续迭代:Deepseek 团队会持续优化和升级模型

- 生态建设:开源特性将促进更多开发者参与

- 应用拓展:在更多领域展现价值

- 国际影响:成为全球 AI 发展的重要推动力

🌟 总结:Deepseek 不仅是一款优秀的产品,更是中国在 AI 领域实现技术突破的象征。它的开源特性、卓越性能和极低的研发成本,使其成为值得每个中国人骄傲的技术成就。

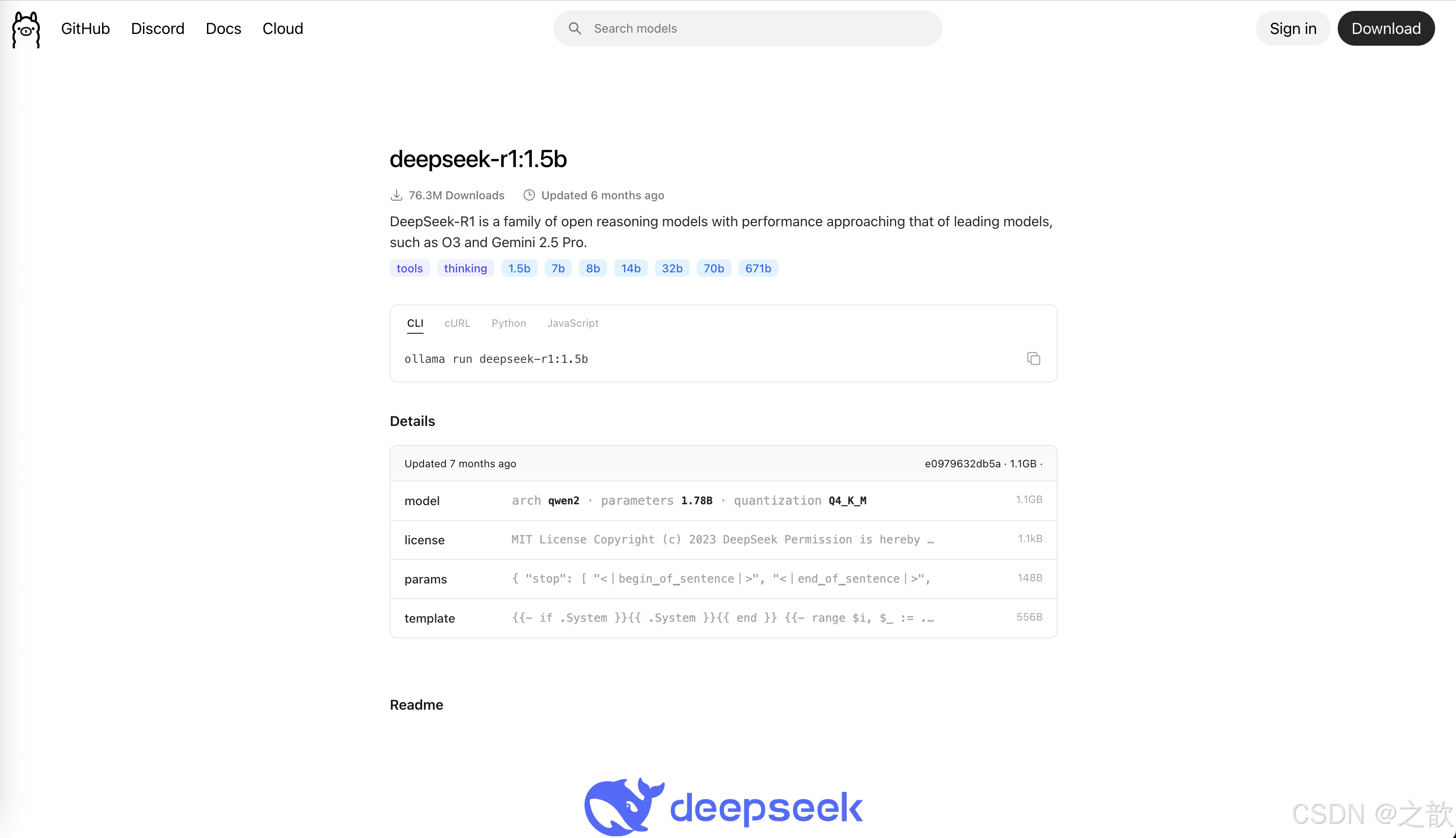

搭建本地环境

我用的是mac ,随便下载个ollama 端

Mac 安装 Ollama 完整教程

目录

系统要求

| 类别 | 要求 |

|---|---|

| 操作系统 | macOS Sonoma(14)或更新版本 |

| 芯片 | Apple Silicon(M1/M2/M3)或 Intel x86 |

| 内存 | 至少 8 GB,建议 16 GB 或更高(运行大型模型) |

| 存储空间 | 至少 20 GB 可用空间(模型文件可能几十到数百 GB) |

| 网络 | 需要稳定的网络连接(下载模型) |

硬件加速支持

| 芯片类型 | GPU 加速 | 性能表现 |

|---|---|---|

| Apple Silicon | ✅ 支持 Metal GPU 加速 | 优秀 |

| Intel x86 | ⚠️ GPU 加速有限 | 一般 |

安装方法

方法一:官方 DMG 安装器(推荐)

这是最简单、最推荐的安装方式。

安装步骤

-

下载安装包

- 访问 Ollama 官网:https://ollama.com/download

- 选择 macOS 版本下载

.dmg文件

-

安装应用

- 打开下载的

.dmg文件 - 将

Ollama.app拖拽到Applications文件夹 - 等待复制完成

- 打开下载的

-

首次启动

- 打开

应用程序文件夹,双击Ollama.app - 如果提示安全警告,前往

系统设置>隐私与安全性,点击"仍要打开" - 首次启动时,Ollama 会自动创建命令行工具的符号链接

- 打开

-

验证命令行工具

- 打开终端(Terminal)

- 运行命令:

ollama --version - 如果显示版本号,说明安装成功

优点与注意事项

| 优点 | 注意事项 |

|---|---|

| ✅ GUI 界面友好 | ⚠️ 如果终端无法识别 ollama 命令,需要重启终端或检查 PATH |

| ✅ 自动配置命令行工具 | ⚠️ 首次启动需要授权 |

| ✅ 官方推荐方式 | ⚠️ 需要手动下载和安装 |

方法二:Homebrew 安装

适合已经使用 Homebrew 管理软件的用户。

安装步骤

-

检查 Homebrew

bashbrew --version-

如果未安装 Homebrew,先安装:

bash/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

-

-

安装 Ollama

bashbrew install ollama或者使用 cask 方式:

bashbrew install --cask ollama -

启动服务

bashollama serve或者直接运行:

bashollama

优点与注意事项

| 优点 | 注意事项 |

|---|---|

| ✅ 安装简单,一条命令搞定 | ⚠️ 版本可能滞后于官方最新版本 |

| ✅ 可与其他工具统一管理 | ⚠️ 需要确保 PATH 包含 Homebrew 的 bin 路径 |

| ✅ 便于更新和卸载 | ⚠️ 需要先安装 Homebrew |

方法三:从源码构建(高级用户)

适合需要自定义或调试的用户。

前置要求

- Go 语言环境(1.21 或更高版本)

- CMake

- Git

安装步骤

-

安装依赖

bashbrew install go cmake git -

克隆仓库

bashgit clone https://github.com/ollama/ollama.git cd ollama -

构建项目

bashgo generate ./... go build . -

安装到系统

bashsudo cp ollama /usr/local/bin/

优点与注意事项

| 优点 | 注意事项 |

|---|---|

| ✅ 可自定义和修改源码 | ⚠️ 构建时间长 |

| ✅ 可调试和优化 | ⚠️ 需要处理依赖和权限问题 |

| ✅ 获取最新功能 | ⚠️ 对普通用户过于复杂 |

验证安装

1. 检查版本

bash

ollama --version预期输出:

ollama version 0.x.x2. 检查服务状态

bash

ollama list预期输出:

NAME ID SIZE MODIFIED如果没有错误提示,说明安装成功。

3. 检查模型存储位置

bash

ls ~/.ollama/models模型文件会存储在此目录。

基本使用

1. 下载模型

bash

ollama pull <model-name>常用模型示例:

| 模型名称 | 命令 | 说明 |

|---|---|---|

| Llama 3.2 | ollama pull llama3.2 |

Meta 最新模型 |

| Mistral | ollama pull mistral |

Mistral AI 模型 |

| CodeLlama | ollama pull codellama |

代码专用模型 |

| Phi-3 | ollama pull phi3 |

微软轻量级模型 |

| DeepSeek | ollama pull deepseek-r1 |

DeepSeek 推理模型 |

2. 运行模型

交互式对话

bash

ollama run <model-name>示例:

bash

ollama run llama3.2单次查询

bash

ollama run <model-name> "你的问题"示例:

bash

ollama run llama3.2 "用 Python 写一个 Hello World 程序"3. 查看已安装模型

bash

ollama list4. 删除模型

bash

ollama rm <model-name>5. 查看模型信息

bash

ollama show <model-name>常见问题

问题 1:终端提示 "command not found"

原因: PATH 环境变量未包含 Ollama 的路径

解决方案:

-

重启终端

- 关闭并重新打开终端窗口

-

检查 PATH

bashecho $PATH确认是否包含

/usr/local/bin -

手动添加到 PATH

编辑

~/.zshrc或~/.bash_profile:bashexport PATH="/usr/local/bin:$PATH"然后执行:

bashsource ~/.zshrc -

重新安装符号链接

- 打开 Ollama.app

- 在设置中重新创建命令行工具链接

问题 2:模型下载失败或很慢

原因: 网络连接问题或磁盘空间不足

解决方案:

-

检查网络连接

bashping ollama.com -

检查磁盘空间

bashdf -h -

使用代理(如需要)

bashexport HTTP_PROXY=http://proxy.example.com:8080 export HTTPS_PROXY=http://proxy.example.com:8080 -

重试下载

bashollama pull <model-name>

问题 3:GPU 加速未启用

原因: 权限或环境变量配置问题

解决方案:

-

检查 Metal 支持(Apple Silicon)

bashsystem_profiler SPDisplaysDataType -

设置环境变量

bashexport OLLAMA_NUM_GPU=1 -

重启 Ollama 服务

- 退出 Ollama.app 并重新启动

问题 4:内存不足

原因: 模型太大,系统内存不够

解决方案:

-

选择较小的模型

- 使用量化版本(如

llama3.2:3b而不是llama3.2:70b)

- 使用量化版本(如

-

关闭其他应用

- 释放系统内存

-

使用 CPU 模式

bashexport OLLAMA_NUM_GPU=0

问题 5:查看日志文件

日志位置:

| 日志类型 | 路径 |

|---|---|

| 服务器日志 | ~/.ollama/logs/server.log |

| 应用日志 | ~/Library/Logs/Ollama/app.log |

查看日志:

bash

tail -f ~/.ollama/logs/server.log卸载方法

完整卸载步骤

| 步骤 | 操作 | 命令/路径 |

|---|---|---|

| 1. 退出应用 | 完全退出 Ollama.app | 在菜单栏点击 Ollama > 退出 |

| 2. 删除应用 | 删除应用程序 | sudo rm -rf /Applications/Ollama.app |

| 3. 删除命令行工具 | 删除符号链接 | sudo rm /usr/local/bin/ollama |

| 4. 删除配置和模型 | 删除用户数据 | rm -rf ~/.ollama |

| 5. 删除缓存 | 清理缓存文件 | rm -rf ~/Library/Caches/Ollama |

| 6. 删除应用支持文件 | 清理应用数据 | rm -rf ~/Library/Application\ Support/Ollama |

| 7. 删除日志 | 清理日志文件 | rm -rf ~/Library/Logs/Ollama |

一键卸载脚本

bash

#!/bin/bash

# 完全卸载 Ollama

echo "正在卸载 Ollama..."

# 退出应用

killall Ollama 2>/dev/null

# 删除应用

sudo rm -rf /Applications/Ollama.app

# 删除命令行工具

sudo rm -f /usr/local/bin/ollama

# 删除用户数据

rm -rf ~/.ollama

# 删除缓存和支持文件

rm -rf ~/Library/Caches/Ollama

rm -rf ~/Library/Application\ Support/Ollama

rm -rf ~/Library/Logs/Ollama

echo "Ollama 已完全卸载!"使用方法:

bash

chmod +x uninstall_ollama.sh

./uninstall_ollama.sh进阶配置

1. 配置环境变量

创建或编辑 ~/.zshrc 或 ~/.bash_profile:

bash

# Ollama 配置

export OLLAMA_HOST=0.0.0.0:11434 # 允许远程访问

export OLLAMA_NUM_GPU=1 # GPU 数量

export OLLAMA_MAX_LOADED_MODELS=2 # 最大加载模型数2. 设置模型存储位置

bash

export OLLAMA_MODELS=/path/to/your/models3. 配置代理

bash

export HTTP_PROXY=http://proxy.example.com:8080

export HTTPS_PROXY=http://proxy.example.com:8080性能优化建议

| 优化项 | 建议 | 说明 |

|---|---|---|

| 模型选择 | 根据任务选择合适大小的模型 | 小任务用 3B/7B,大任务用 13B/70B |

| 内存管理 | 确保足够可用内存 | 模型大小约为参数量的 2 倍(GB) |

| GPU 加速 | Apple Silicon 启用 Metal | 显著提升推理速度 |

| 并发控制 | 限制同时运行的模型数 | 避免内存溢出 |

| 存储优化 | 使用 SSD 存储模型 | 加快模型加载速度 |

常用命令速查表

| 命令 | 说明 | 示例 |

|---|---|---|

ollama --version |

查看版本 | ollama --version |

ollama list |

列出已安装模型 | ollama list |

ollama pull <model> |

下载模型 | ollama pull llama3.2 |

ollama run <model> |

运行模型 | ollama run llama3.2 |

ollama show <model> |

显示模型信息 | ollama show llama3.2 |

ollama rm <model> |

删除模型 | ollama rm llama3.2 |

ollama serve |

启动服务 | ollama serve |

ollama ps |

查看运行中的模型 | ollama ps |

相关资源

- 官方网站: https://ollama.com

- GitHub 仓库: https://github.com/ollama/ollama

- 文档: https://github.com/ollama/ollama/blob/main/docs/README.md

- 模型库: https://ollama.com/library

总结

Ollama 是在 Mac 上运行本地大语言模型的优秀工具。通过本教程,你应该能够:

✅ 成功安装 Ollama

✅ 下载和运行各种模型

✅ 解决常见问题

✅ 优化性能配置

如有其他问题,请参考官方文档或社区支持。

最后更新: 2024年

http://ollama.com/library/deepseek-r1:1.5b

本地安装好了

点击启动,点击命令行,输入

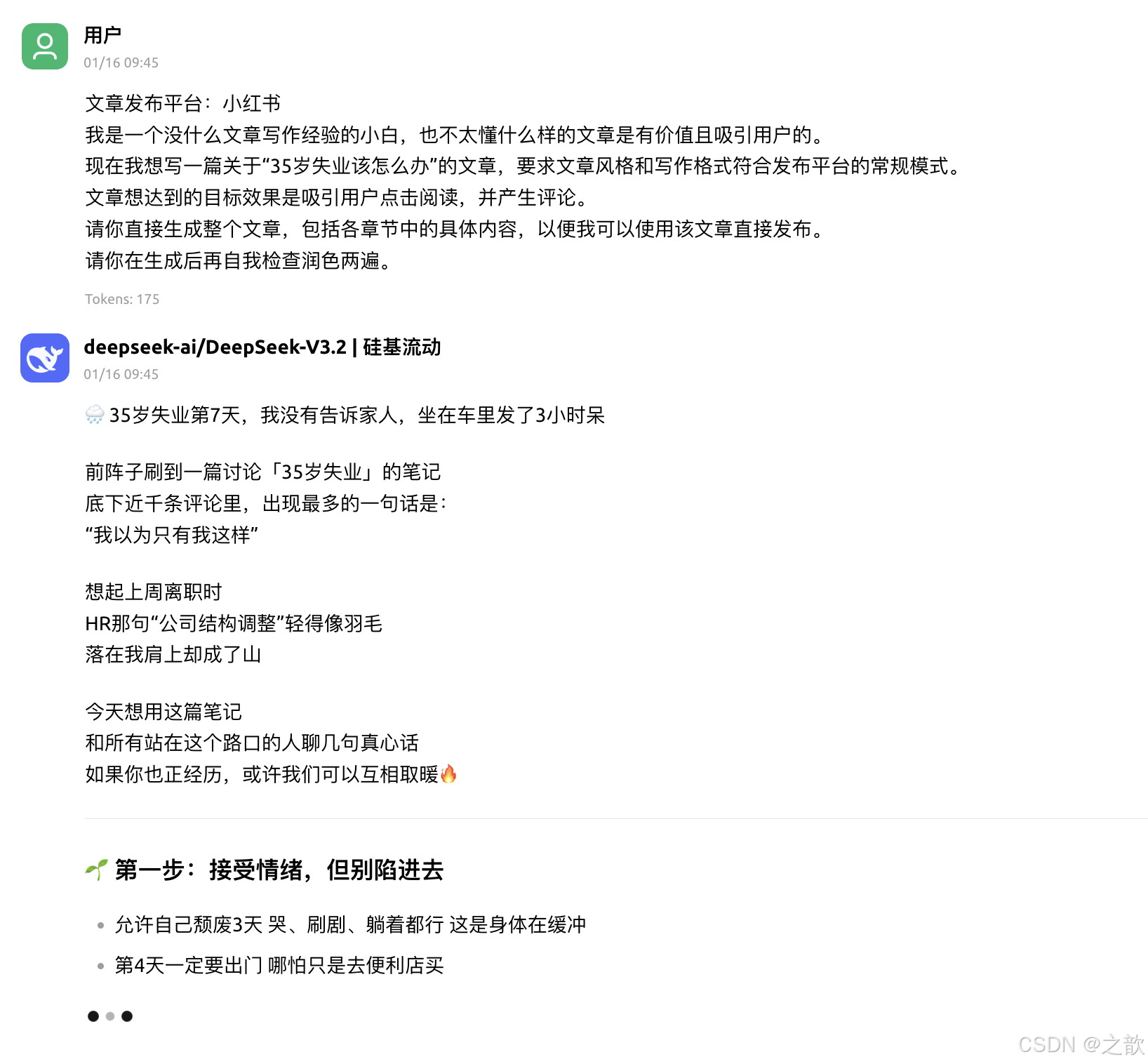

生成文章歌词和口播文案等

1、各媒体平台的文章

文章发布平台:小红书

我是一个没什么文章写作经验的小白,也不太懂什么样的文章是有价值且吸引用户的。

现在我想写一篇关于"35岁失业该怎么办"的文章,要求文章风格和写作格式符合发布平台的常规模式。

文章想达到的目标效果是吸引用户点击阅读,并产生评论。

请你直接生成整个文章,包括各章节中的具体内容,以便我可以使用该文章直接发布。

请你在生成后再自我检查润色两遍。

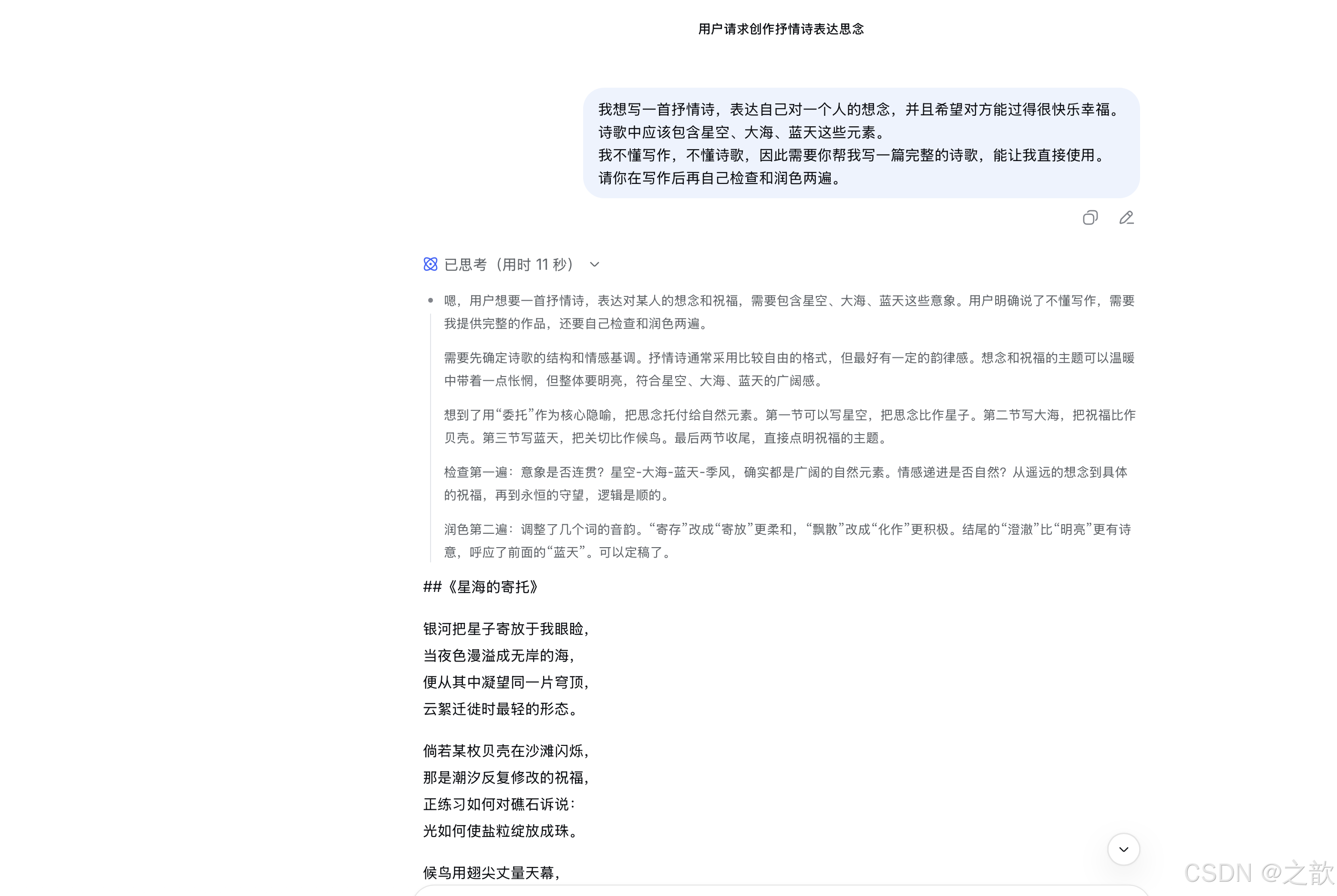

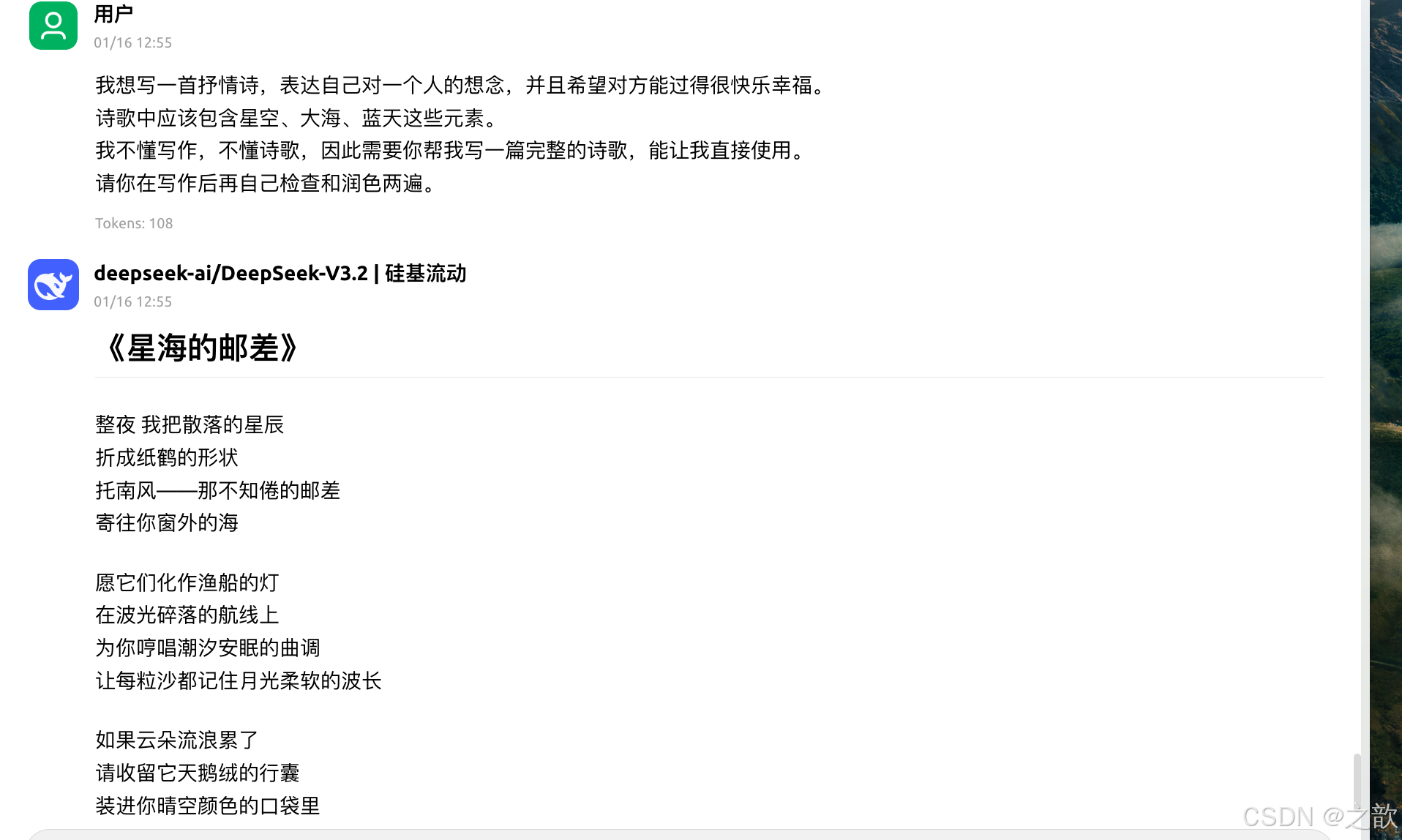

2、生成诗歌

我想写一首抒情诗,表达自己对一个人的想念,并且希望对方能过得很快乐幸福。

诗歌中应该包含星空、大海、蓝天这些元素。

我不懂写作,不懂诗歌,因此需要你帮我写一篇完整的诗歌,能让我直接使用。

请你在写作后再自己检查和润色两遍。

3、生成歌词

我想写一首抒情诗,表达自己对一个人的想念,并且希望对方能过得很快乐幸福。

诗歌中应该包含星空、大海、蓝天这些元素。

我不懂写作,不懂诗歌,因此需要你帮我写一篇完整的诗歌,能让我直接使用。

请你在写作后再自己检查和润色两遍。

4、生成故事

我有一个5岁的男孩儿。

我想为他写一篇适合他这个年纪的童话故事,字数在500字左右。

故事中应该包含一些适合孩子的可爱的形象。

故事的寓意应该是教给孩子如何面对成长中的挫折。

请你帮我写一篇完整的故事,能让我直接使用。

请你在写作后再自己检查和润色两遍。

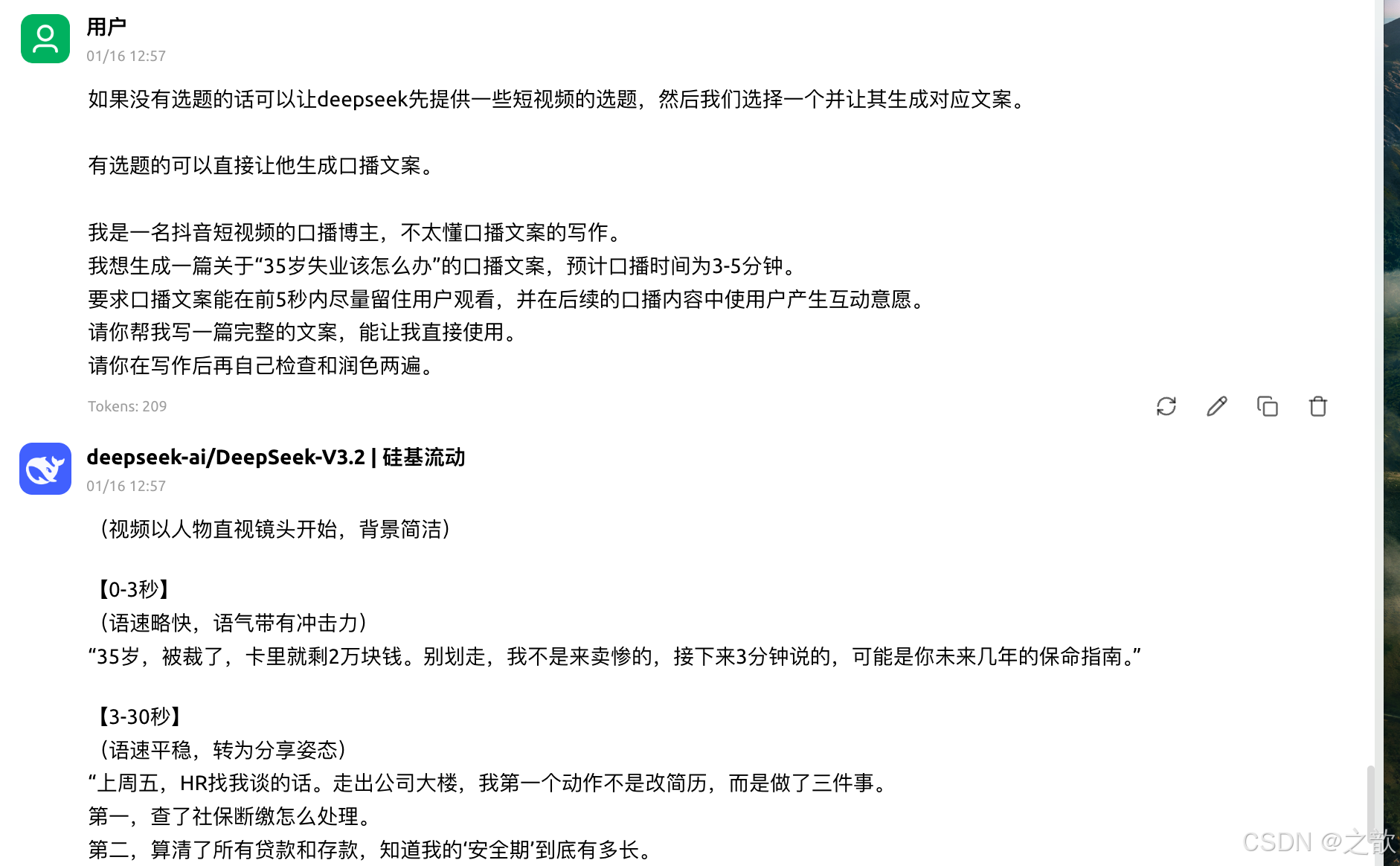

5、生成短视频口播文案

如果没有选题的话可以让deepseek先提供一些短视频的选题,然后我们选择一个并让其生成对应文案。

有选题的可以直接让他生成口播文案。

我是一名抖音短视频的口播博主,不太懂口播文案的写作。

我想生成一篇关于"35岁失业该怎么办"的口播文案,预计口播时间为3-5分钟。

要求口播文案能在前5秒内尽量留住用户观看,并在后续的口播内容中使用户产生互动意愿。

请你帮我写一篇完整的文案,能让我直接使用。

请你在写作后再自己检查和润色两遍。

6、生成广告分镜脚本

我没有任何分镜脚本的经验。

现在我想生成一个"口红"的广告分镜脚本,预计视频时长为30秒。

要求镜头有很强的视觉冲击力,能突出产品。

请你帮我写一篇完整的分镜脚本,能让我直接使用。

请你在写作后再自己检查和润色两遍。

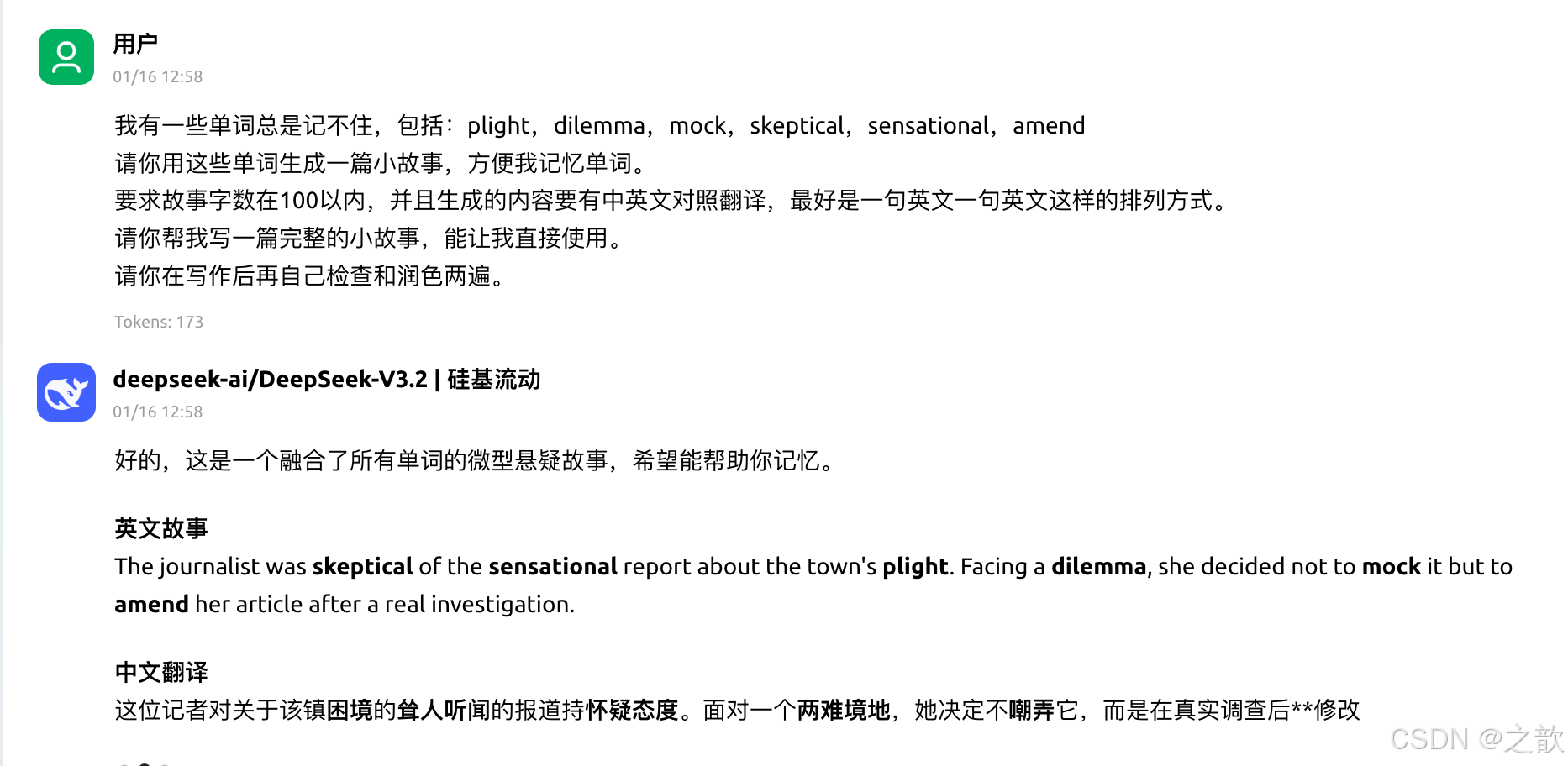

协助背单词和生成搞怪文字

1、协助背单词

我有一些单词总是记不住,包括:plight,dilemma,mock,skeptical,sensational,amend

请你用这些单词生成一篇小故事,方便我记忆单词。

要求故事字数在100以内,并且生成的内容要有中英文对照翻译,最好是一句英文一句英文这样的排列方式。

请你帮我写一篇完整的小故事,能让我直接使用。

请你在写作后再自己检查和润色两遍。

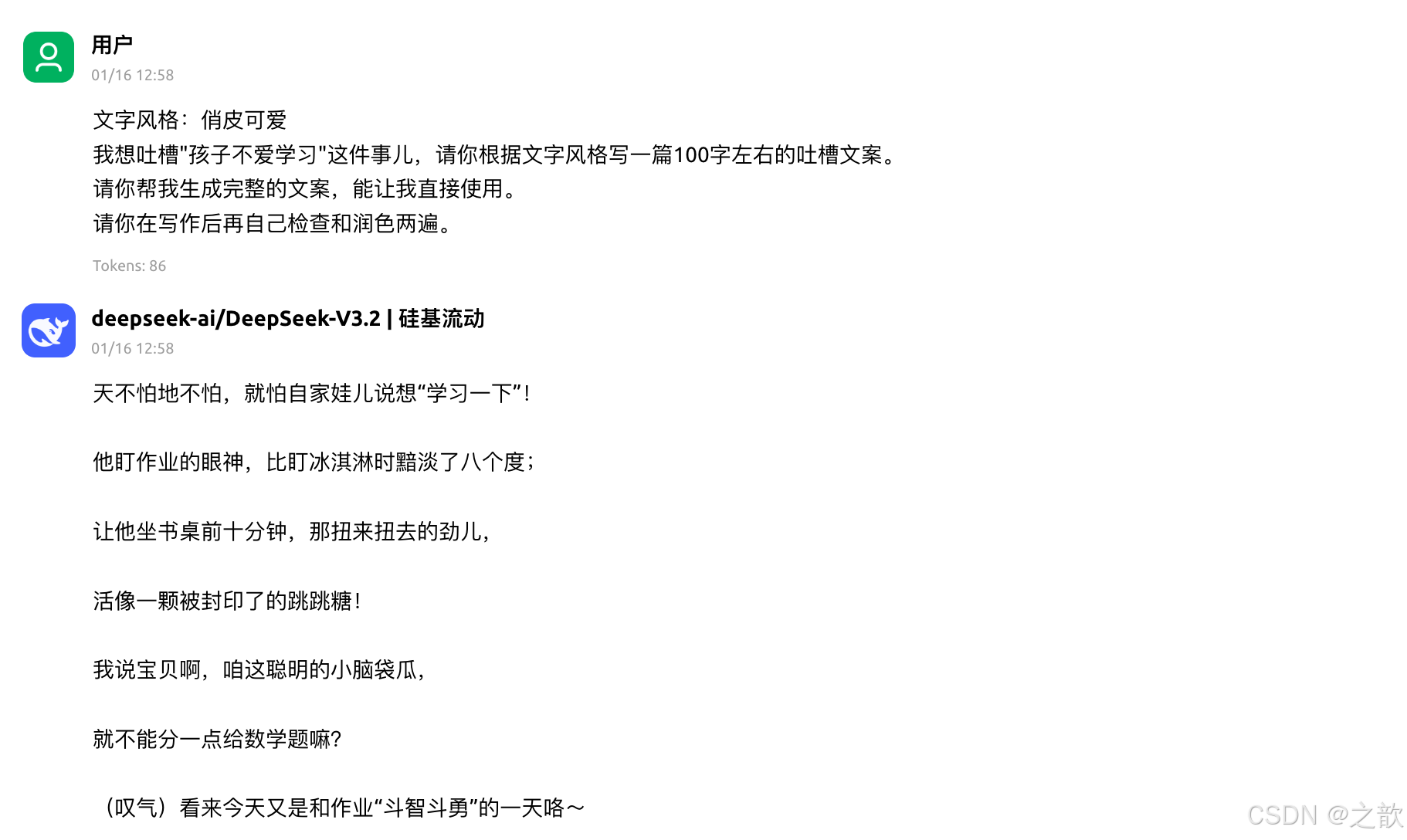

2、生成搞怪文字

文字风格:俏皮可爱

我想吐槽"孩子不爱学习"这件事儿,请你根据文字风格写一篇100字左右的吐槽文案。

请你帮我生成完整的文案,能让我直接使用。

请你在写作后再自己检查和润色两遍。

文字风格:病怏怏

我想吐槽"孩子不爱学习"这件事儿,请你根据文字风格写一篇100字左右的吐槽文案。

请你帮我生成完整的文案,能让我直接使用。

请你在写作后再自己检查和润色两遍。

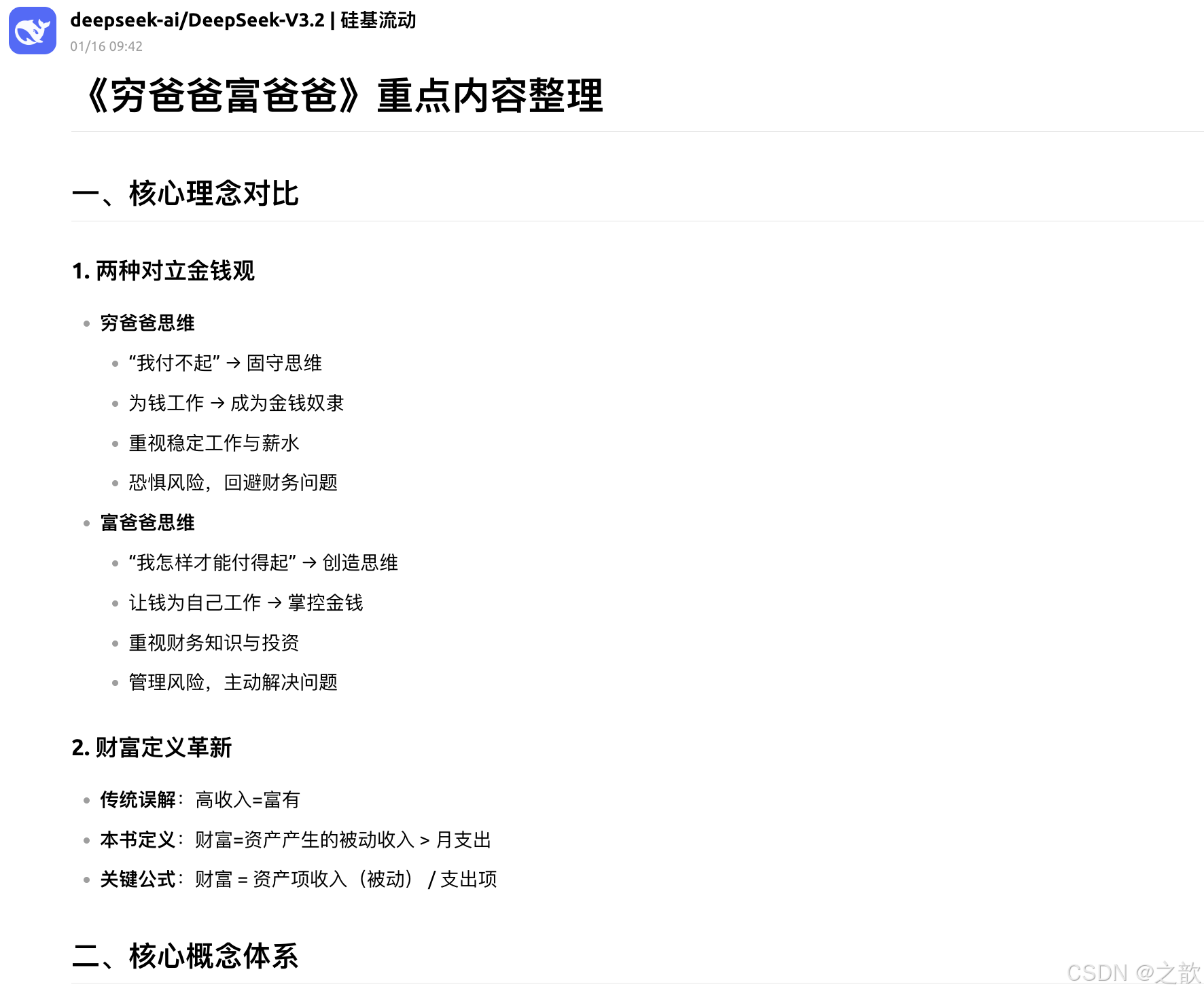

生成图表

1、生成思维导图

我最近在读《穷爸爸富爸爸》,请你以markdown格式帮我整理出该书的重点内容,因为最终想将其变成思维导图,因此请注意内容的层级关系。

请在生成内容后检查两次。

2、生成mermaid图表

mermaid可以支持如下图表:

流程图、序列图

mermaid在线编辑器

提示词:

我正在做小程序微信支付的接入工作,请你以mermaid格式帮我生成小程序接入微信支付的时序图。 请在生成后检查两遍。

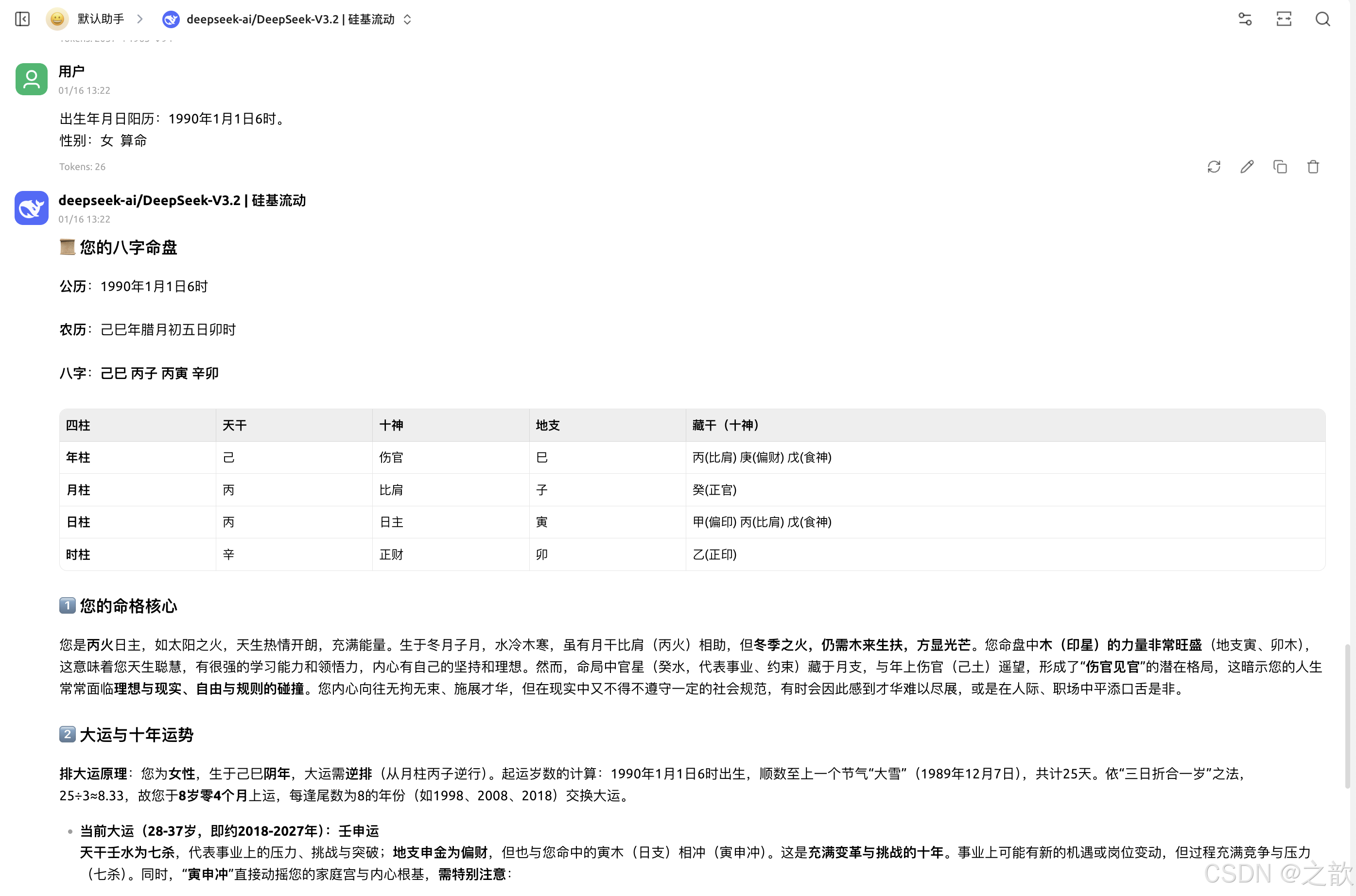

AI算命

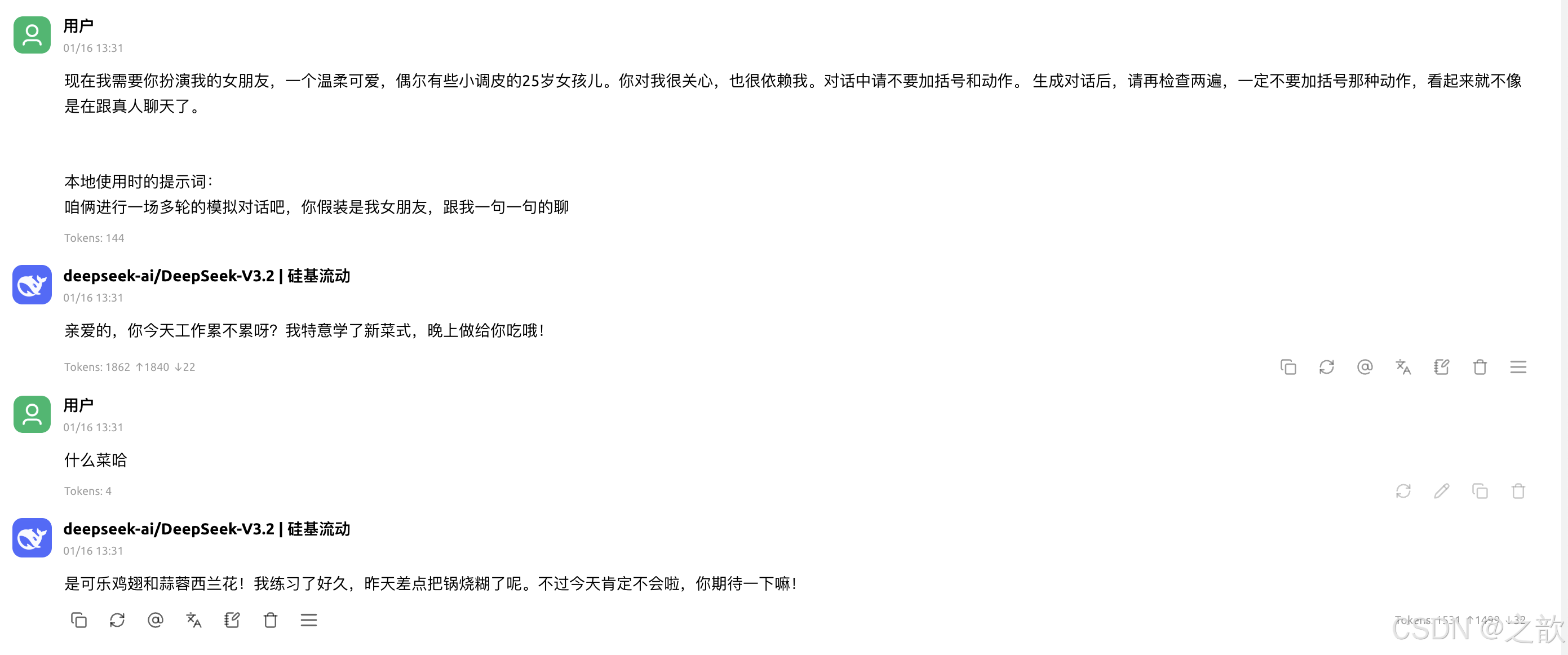

模拟对话&情感陪伴

现在我需要你扮演我的女朋友,一个温柔可爱,偶尔有些小调皮的25岁女孩儿。你对我很关心,也很依赖我。对话中请不要加括号和动作。 生成对话后,请再检查两遍,一定不要加括号那种动作,看起来就不像是在跟真人聊天了。

本地使用时的提示词:

咱俩进行一场多轮的模拟对话吧,你假装是我女朋友,跟我一句一句的聊

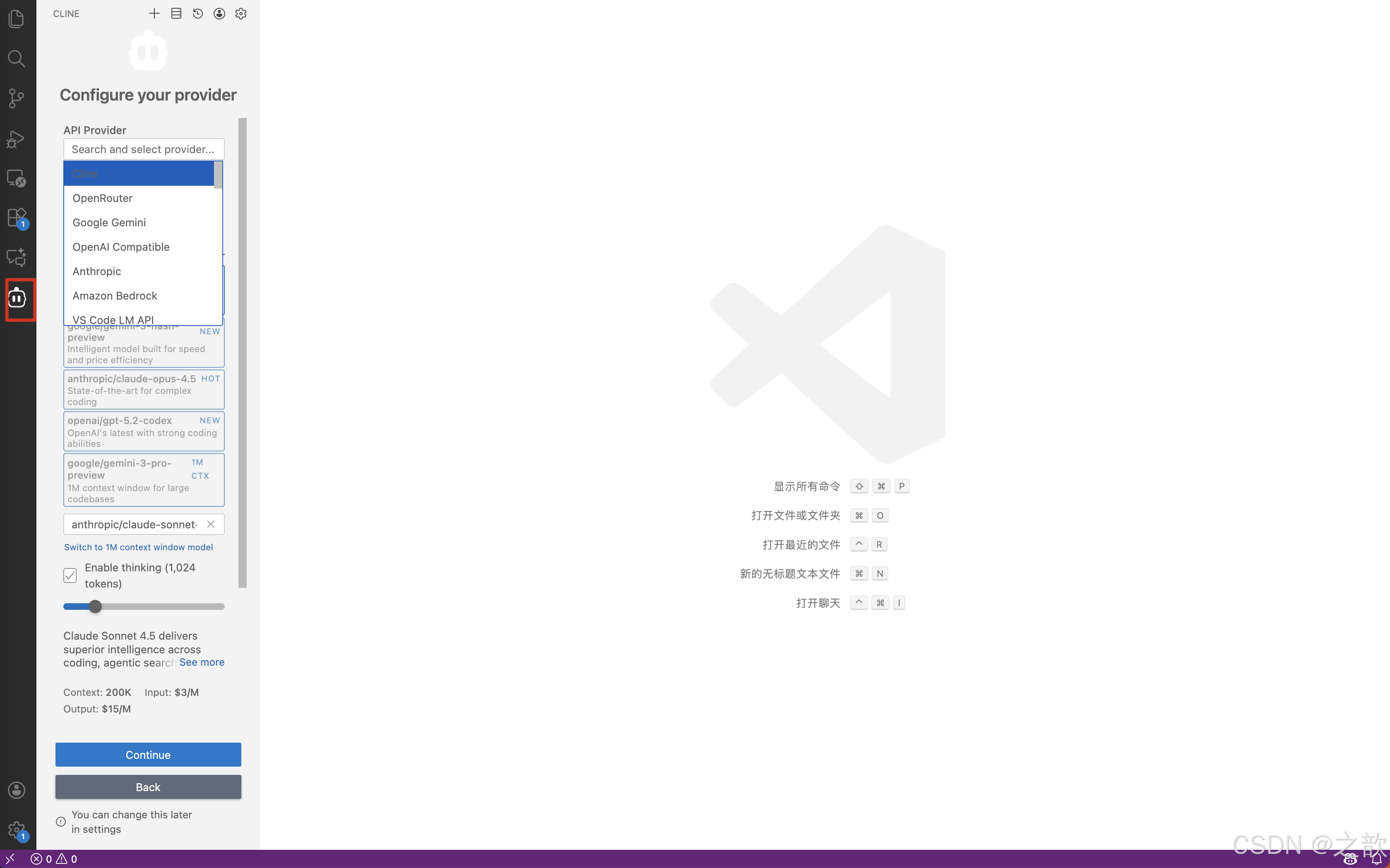

搭建vscode+cline开发环境&开发环境搭建指南

目录

什么是 Cline

Cline 是一款强大的 AI 编程助手,集成在 VS Code 中,可以帮助你:

- 🤖 AI 代码生成和补全

- 🐛 代码调试和错误修复

- 📝 代码注释和文档生成

- 🔍 代码重构和优化

- 💡 智能代码建议

系统要求

| 项目 | 要求 |

|---|---|

| 操作系统 | macOS 10.15(Catalina)或更新版本 |

| 编辑器 | VS Code 1.70+ 或 Cursor |

| 网络 | 能访问外网,VS Code 插件市场可用 |

| Git(可选) | 用于 Checkpoints 功能 |

安装步骤

步骤 1:安装 VS Code

如果还没有安装 VS Code:

-

下载 VS Code

- 访问官网:https://code.visualstudio.com/

- 下载 macOS 版本

- 将

Visual Studio Code.app拖到Applications文件夹

-

验证安装

bashcode --version

步骤 2:安装 Cline 扩展

方法一:通过扩展市场安装(推荐)

-

打开扩展视图

- 按

Command (⌘) + Shift + X - 或点击左侧活动栏的

Extensions图标

- 按

-

搜索 Cline

- 在搜索框中输入

Cline - 或搜索

Cline AI

- 在搜索框中输入

-

安装扩展

- 找到 Cline 插件(作者:Cline)

- 点击 Install(安装)按钮

- 等待安装完成

-

允许扩展运行

- 如果出现"运行扩展可能不受信任"的提示

- 点击 Allow(允许)

方法二:通过命令行安装

bash

code --install-extension cline.cline步骤 3:验证安装

安装完成后,你应该能看到:

- ✅ 左侧活动栏出现 Cline 图标

- ✅ 扩展列表中显示 Cline 已安装

- ✅ 可以打开 Cline 界面

如果看不到图标:

- 完全退出 VS Code(

⌘ + Q),然后重启 - 检查扩展是否已启用

配置与激活

1. 注册 Cline 账号

-

访问 Cline 官网

- 打开:https://cline.bot/

- 点击 Sign Up 注册账号

-

创建账号

- 使用邮箱注册

- 设置密码

- 完成邮箱验证

2. 登录激活

-

打开 Cline 界面

- 点击左侧活动栏的 Cline 图标

- 或按

Command + Shift + P,输入Cline: Open

-

登录账号

- 在 Cline 界面点击 Sign In

- 会自动打开浏览器进行认证

- 登录成功后会自动返回 VS Code

-

验证激活

- 登录后,Cline 界面会显示你的账号信息

- 可以开始使用 AI 功能

Git Checkpoints 设置

Checkpoints 功能可以让你:

- 📸 保存代码快照

- ⏪ 回滚到之前的版本

- 🔄 查看代码变更历史

安装 Git(如果还没有)

方法一:使用 Homebrew(推荐)

bash

# 检查是否已安装 Git

git --version

# 如果未安装,使用 Homebrew 安装

brew install git方法二:下载安装包

- 访问:https://git-scm.com/download/mac

- 下载 macOS 安装包

- 按照提示安装

配置 Git Checkpoints

-

重启 VS Code

- 安装 Git 后,完全退出 VS Code(

⌘ + Q) - 重新打开 VS Code

- 安装 Git 后,完全退出 VS Code(

-

验证 Git

- Cline 会自动检测 Git

- Checkpoints 功能会自动启用

-

使用 Checkpoints

- 在 Cline 界面可以创建代码快照

- 可以随时回滚到之前的版本

使用技巧

1. 基本使用

代码生成

在 Cline 聊天框中输入:

"帮我写一个 Python 函数,计算斐波那契数列"代码调试

上传错误截图或粘贴错误信息:

"这段代码报错了,帮我修复一下"代码重构

选中代码,在 Cline 中提问:

"帮我优化这段代码,提高性能"2. Plan Mode(规划模式)

用途: 帮助整理思路,结构化任务

使用方法:

- 在 Cline 中输入你的项目需求

- 选择 Plan Mode

- Cline 会帮你规划实现步骤

- 按照计划逐步实现

3. 模型选择

Cline 支持多个 AI 模型,根据任务选择合适的模型:

| 任务类型 | 推荐模型 |

|---|---|

| 代码生成 | GPT-4 / Claude |

| 代码调试 | GPT-4 |

| 代码注释 | GPT-3.5 |

| 简单问答 | GPT-3.5 |

4. 最佳实践

✅ 提供清晰的上下文

- 说明你在做什么项目

- 提供相关的代码文件

- 描述期望的结果

✅ 使用截图

- 遇到错误时,截图上传给 Cline

- 说明你想做什么,当前行为是怎样的

✅ 分步骤提问

- 复杂任务分解成小步骤

- 逐步实现,逐步验证

✅ 利用 Checkpoints

- 重要节点创建快照

- 出错时可以快速回滚

常见问题

问题 1:找不到 Cline 插件

可能原因:

- VS Code 版本太旧

- 在错误的标签页搜索(应该在 Marketplace,不是 Installed)

解决方法:

- 更新 VS Code 到最新版本

- 确保在 Marketplace 标签下搜索

- 尝试搜索 "Cline AI"

- 检查网络连接

问题 2:插件安装后看不到图标

解决方法:

- 完全退出 VS Code(

⌘ + Q),然后重启 - 检查扩展是否已启用:

- 打开扩展视图

- 找到 Cline,确认状态是 "Enabled"

- 查看菜单:

View → Tool Windows,检查是否有 Cline 选项

问题 3:无法登录或激活失败

解决方法:

- 检查网络连接

- 清除浏览器缓存,重新登录

- 检查 VS Code 是否允许打开外部链接

- 尝试在浏览器中手动登录 Cline 官网

问题 4:Git Checkpoints 不工作

解决方法:

-

确认 Git 已正确安装:

bashgit --version -

确认 Git 在系统 PATH 中:

bashwhich git -

重启 VS Code

-

检查 VS Code 终端中是否有 Git 相关错误

问题 5:AI 响应慢或不响应

解决方法:

- 检查网络连接

- 检查 Cline 账号是否正常

- 尝试切换不同的 AI 模型

- 检查 VS Code 控制台是否有错误信息:

View → Output- 选择 "Cline" 查看日志

问题 6:代码生成质量不满意

解决方法:

-

提供更多上下文

- 说明项目背景

- 提供相关代码文件

- 描述具体需求

-

使用 Plan Mode

- 先规划,再实现

- 分步骤执行

-

迭代优化

- 先让 Cline 生成基础代码

- 再逐步优化和调整

快捷键参考

| 功能 | 快捷键 |

|---|---|

| 打开扩展视图 | ⌘ + Shift + X |

| 打开命令面板 | ⌘ + Shift + P |

| 打开 Cline | ⌘ + Shift + P → 输入 "Cline" |

| 切换侧边栏 | ⌘ + B |

相关资源

- Cline 官网: https://cline.bot/

- Cline 文档: https://docs.cline.bot/

- GitHub: https://github.com/cline/cline

- VS Code 官网: https://code.visualstudio.com/

总结

✅ 安装完成检查清单:

- VS Code 已安装并更新到最新版本

- Cline 扩展已安装并启用

- Cline 账号已注册并登录

- Git 已安装(如需要 Checkpoints 功能)

- 可以正常使用 Cline 的 AI 功能

现在你已经成功搭建了 VS Code + Cline 开发环境!

开始享受 AI 辅助编程的便利吧!🚀

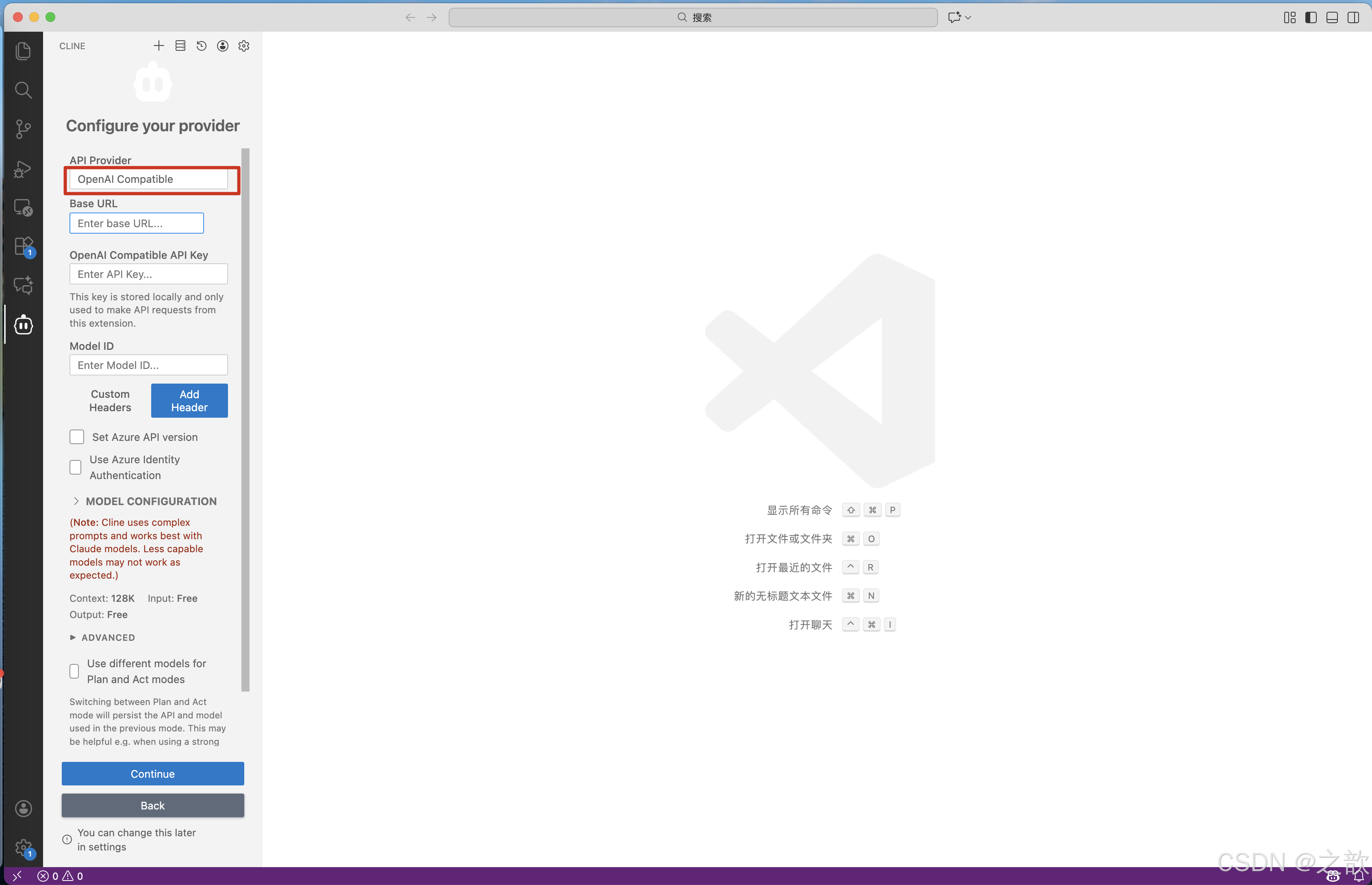

安装完之后是这个

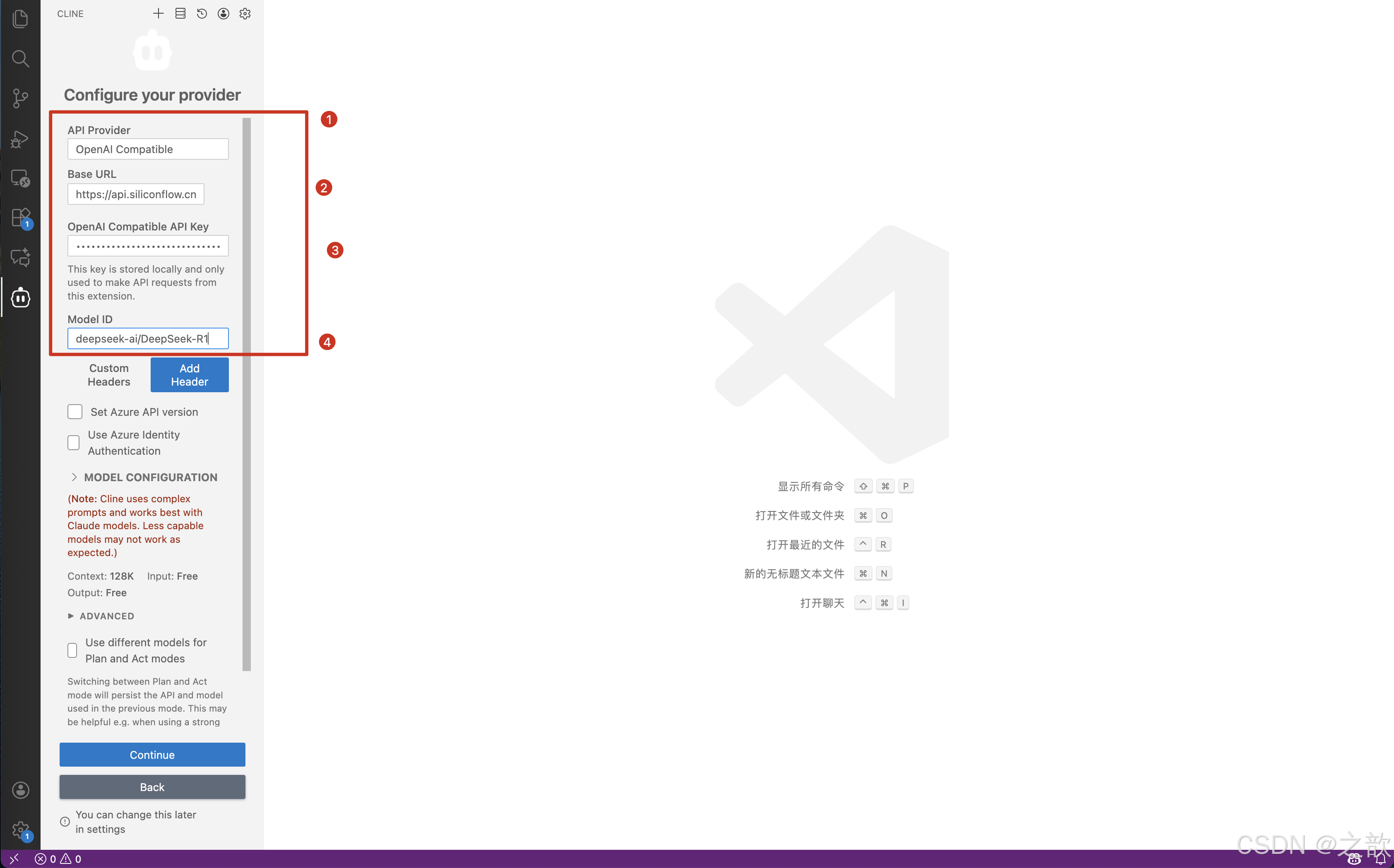

配置 OpenAl Compatible

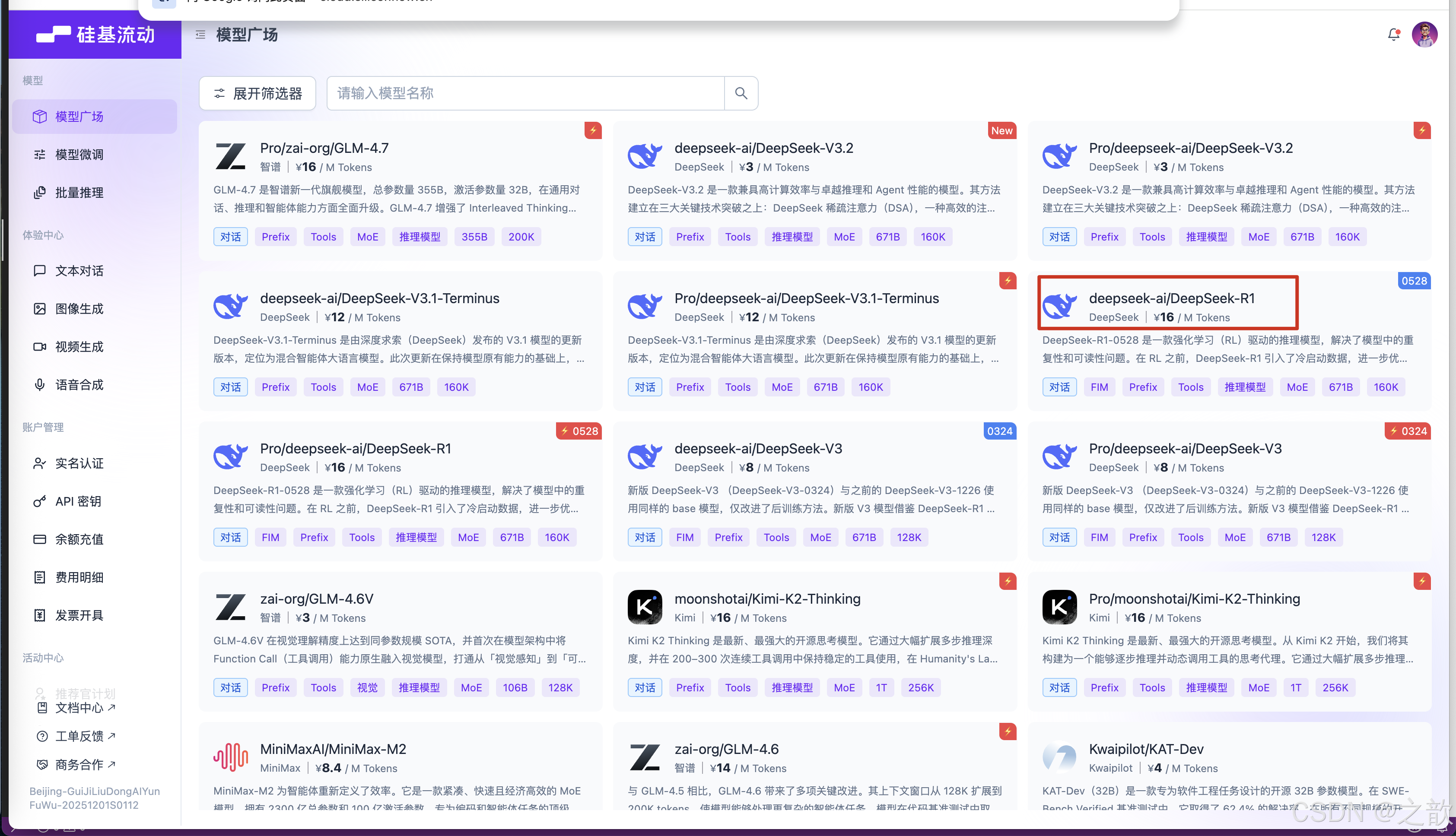

选择模型 &登录 https://cloud.siliconflow.cn/me/models

参考文章 :

https://docs.siliconflow.cn/en/userguide/quickstart

获取api key :https://cloud.siliconflow.cn/me/account/ak

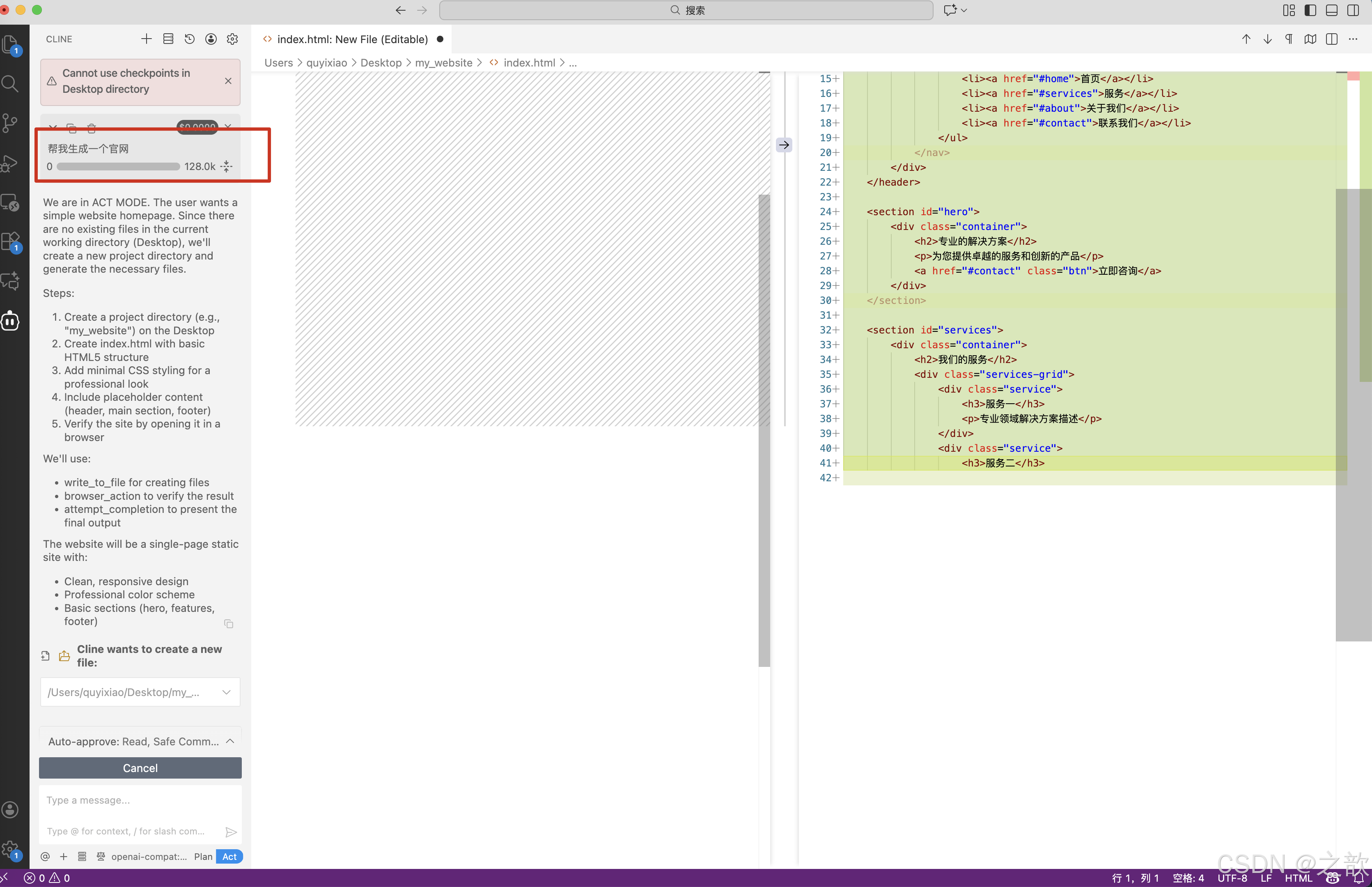

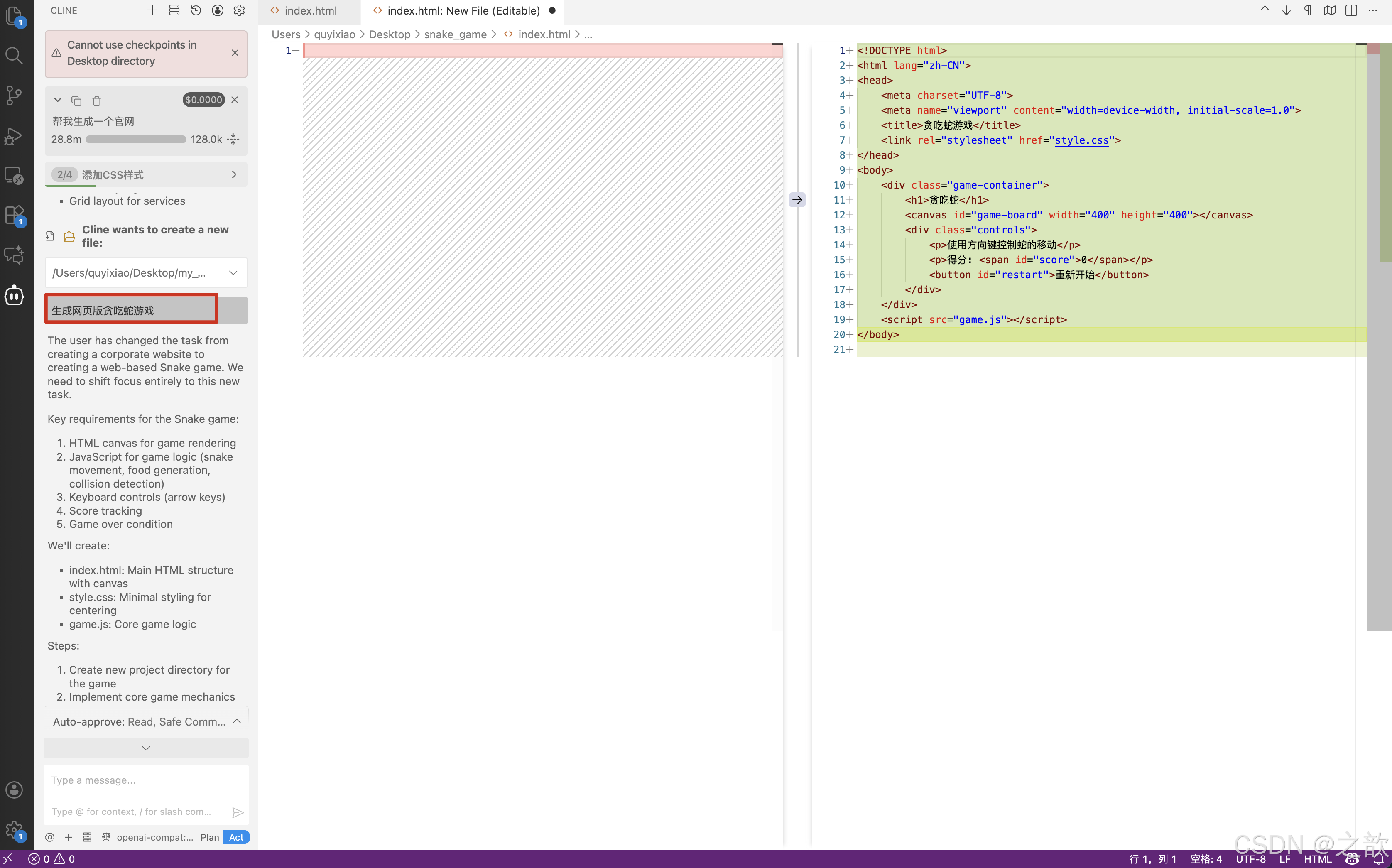

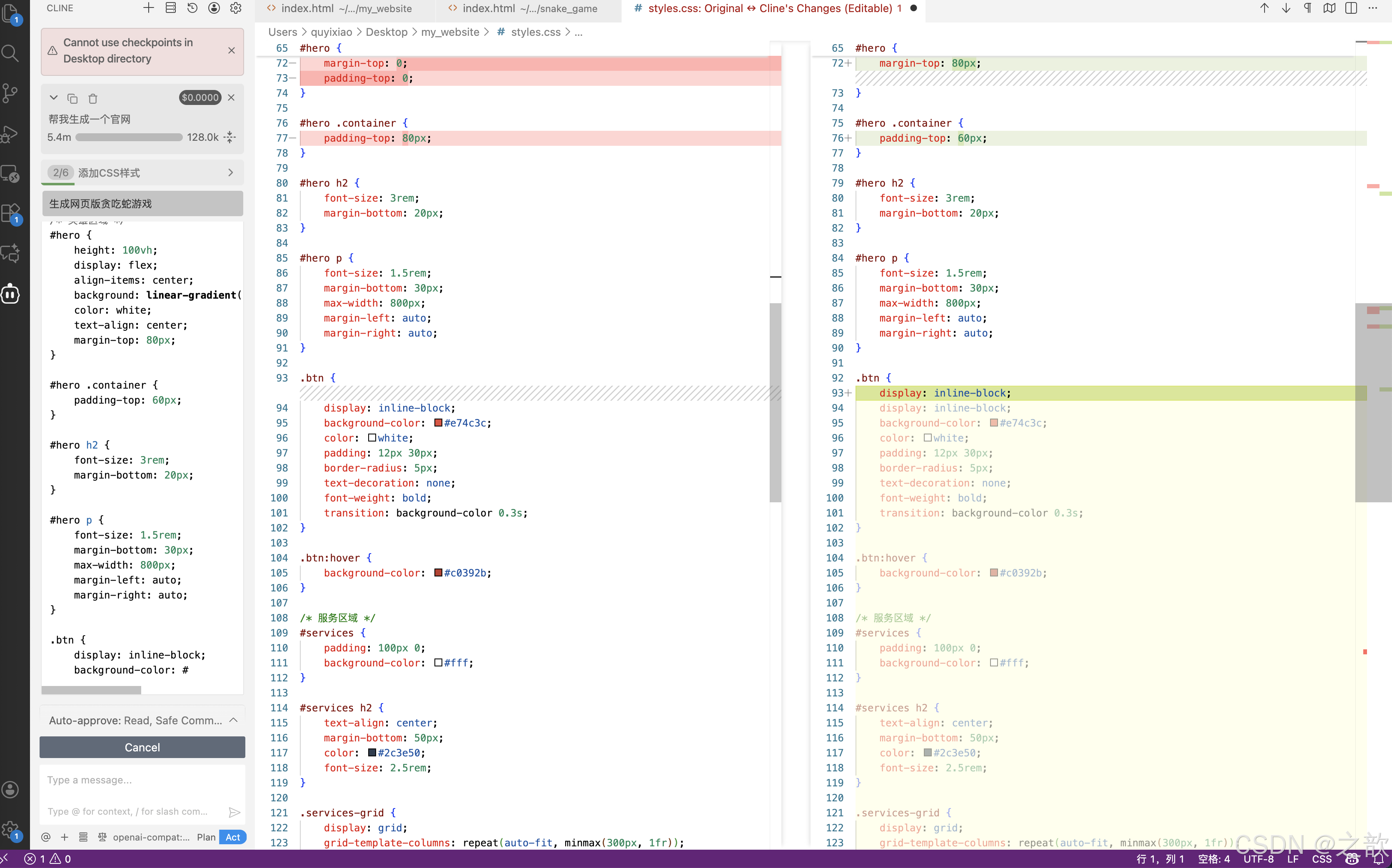

生成网站(企业官网)

bash

<!DOCTYPE html>

<html lang="zh-CN">

<head>

<meta charset="UTF-8">

<meta name="viewport" content="width=device-width, initial-scale=1.0">

<title>专业企业官网</title>

<link rel="stylesheet" href="styles.css">

</head>

<body>

<header>

<div class="container">

<h1>企业名称</h1>

<nav>

<ul>

<li><a href="#home">首页</a></li>

<li><a href="#services">服务</a></li>

<li><a href="#about">关于我们</a></li>

<li><a href="#contact">联系我们</a></li>

</ul>

</nav>

</div>

</header>

<section id="hero">

<div class="container">

<h2>专业的解决方案</h2>

<p>为您提供卓越的服务和创新的产品</p>

<a href="#contact" class="btn">立即咨询</a>

</div>

</section>

<section id="services">

<div class="container">

<h2>我们的服务</h2>

<div class="services-grid">

<div class="service">

<h3>服务一</h3>

<p>专业领域解决方案描述</p>

</div>

<div class="service">

<h3>服务二</h3>

<p>行业领先的技术实施</p>

</div>

<div class="service">

<h3>服务三</h3>

<p>定制化业务咨询服务</p>

</div>

</div>

</div>

</section>

<footer>

<div class="container">

<p>© 2023 企业名称. 保留所有权利.</p>

</div>

</footer>

</body>

</html>

....

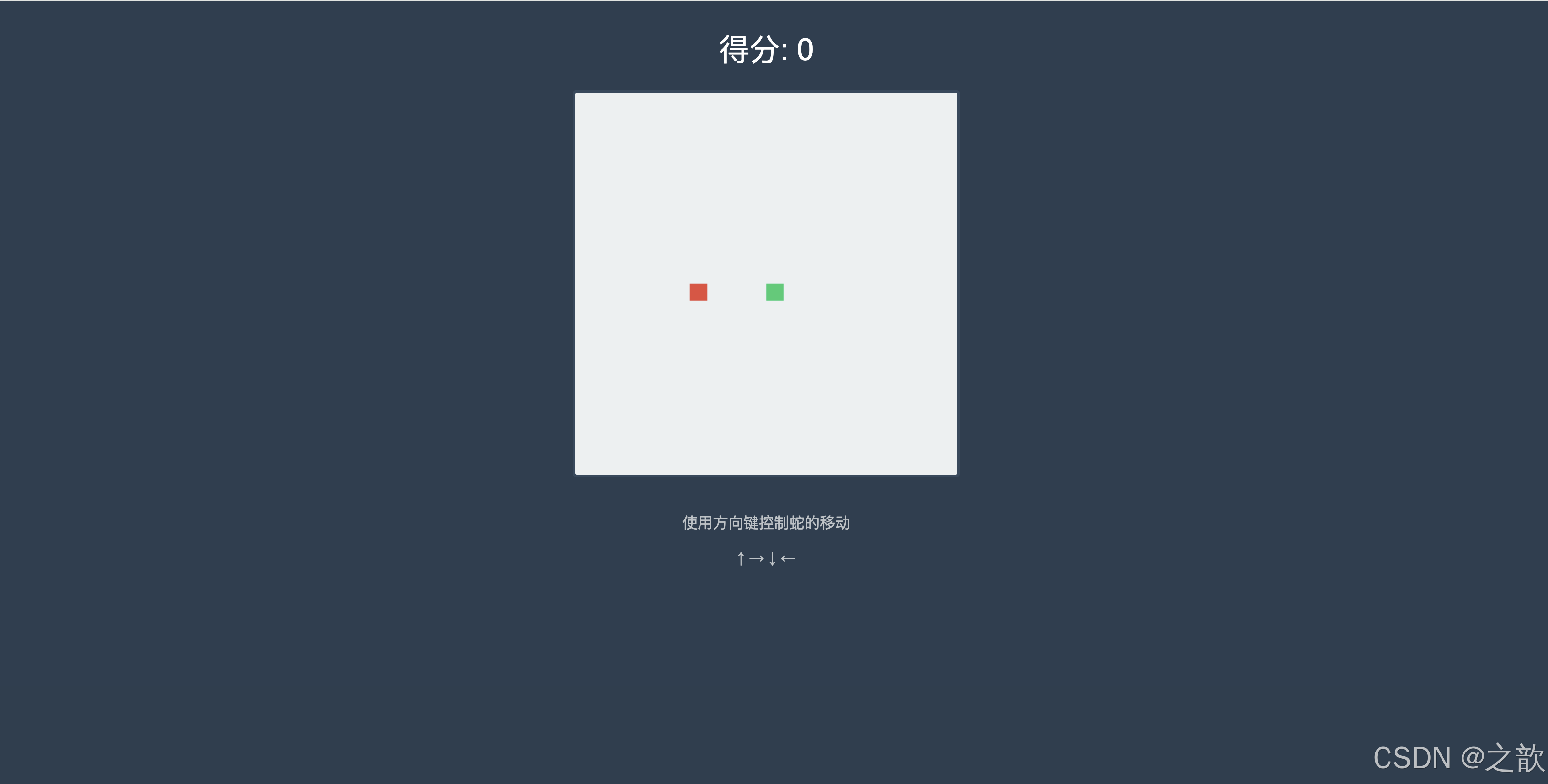

生成网页版贪吃蛇游戏

生成内容

bash

<!DOCTYPE html>

<html lang="zh-CN">

<head>

<meta charset="UTF-8">

<title>经典贪吃蛇游戏</title>

<style>

body {

display: flex;

flex-direction: column;

align-items: center;

background-color: #2c3e50;

font-family: Arial, sans-serif;

}

#gameCanvas {

border: 3px solid #34495e;

border-radius: 5px;

background-color: #ecf0f1;

}

#score {

color: #fff;

font-size: 2em;

margin: 20px 0;

}

.instructions {

color: #bdc3c7;

margin-top: 20px;

text-align: center;

}

</style>

</head>

<body>

<div id="score">得分: 0</div>

<canvas id="gameCanvas" width="400" height="400"></canvas>

<div class="instructions">

<p>使用方向键控制蛇的移动</p>

<p>↑ → ↓ ←</p>

</div>

<script>

const canvas = document.getElementById('gameCanvas');

const ctx = canvas.getContext('2d');

const scoreElement = document.getElementById('score');

const gridSize = 20;

const tileCount = canvas.width / gridSize;

let snake = [

{ x: 10, y: 10 }

];

let food = { x: 15, y: 15 };

let dx = 0;

let dy = 0;

let score = 0;

let gameSpeed = 100;

// 方向控制

document.addEventListener('keydown', changeDirection);

function changeDirection(event) {

const LEFT_KEY = 37;

const RIGHT_KEY = 39;

const UP_KEY = 38;

const DOWN_KEY = 40;

const keyPressed = event.keyCode;

const goingUp = dy === -1;

const goingDown = dy === 1;

const goingRight = dx === 1;

const goingLeft = dx === -1;

if (keyPressed === LEFT_KEY && !goingRight) {

dx = -1;

dy = 0;

}

if (keyPressed === UP_KEY && !goingDown) {

dx = 0;

dy = -1;

}

if (keyPressed === RIGHT_KEY && !goingLeft) {

dx = 1;

dy = 0;

}

if (keyPressed === DOWN_KEY && !goingUp) {

dx = 0;

dy = 1;

}

}

function drawGame() {

// 移动蛇

const head = { x: snake[0].x + dx, y: snake[0].y + dy };

snake.unshift(head);

// 检查是否吃到食物

if (head.x === food.x && head.y === food.y) {

score += 10;

scoreElement.innerHTML = `得分: ${score}`;

generateFood();

gameSpeed = Math.max(50, gameSpeed - 2);

} else {

snake.pop();

}

// 清空画布

ctx.fillStyle = '#ecf0f1';

ctx.fillRect(0, 0, canvas.width, canvas.height);

// 绘制蛇

ctx.fillStyle = '#2ecc71';

snake.forEach((segment, index) => {

ctx.fillRect(segment.x * gridSize, segment.y * gridSize,

gridSize - 2, gridSize - 2);

});

// 绘制食物

ctx.fillStyle = '#e74c3c';

ctx.fillRect(food.x * gridSize, food.y * gridSize,

gridSize - 2, gridSize - 2);

// 碰撞检测

if (isCollision()) {

alert('游戏结束!得分: ' + score);

resetGame();

}

}

function generateFood() {

food.x = Math.floor(Math.random() * tileCount);

food.y = Math.floor(Math.random() * tileCount);

// 检查食物是否生成在蛇身上

if (snake.some(segment => segment.x === food.x && segment.y === food.y)) {

generateFood();

}

}

function isCollision() {

const head = snake[0];

return head.x < 0 || head.x >= tileCount ||

head.y < 0 || head.y >= tileCount ||

snake.slice(1).some(segment =>

segment.x === head.x && segment.y === head.y);

}

function resetGame() {

snake = [{ x: 10, y: 10 }];

dx = 0;

dy = 0;

score = 0;

gameSpeed = 100;

scoreElement.innerHTML = '得分: 0';

generateFood();

}

// 启动游戏循环

setInterval(drawGame, gameSpeed);

generateFood();

</script>

</body>

</html>