语言类的AI的三大类,其中的两个类别分别就是之前说的Bert和下面的GPT

BERT属于 Encoder-only 架构(基于 Transformer 编码器),核心是双向注意力机制 ,天然擅长语义理解类任务,比如文本分类、命名实体识别、语义相似度计算、阅读理解等主要擅长的语义理解。

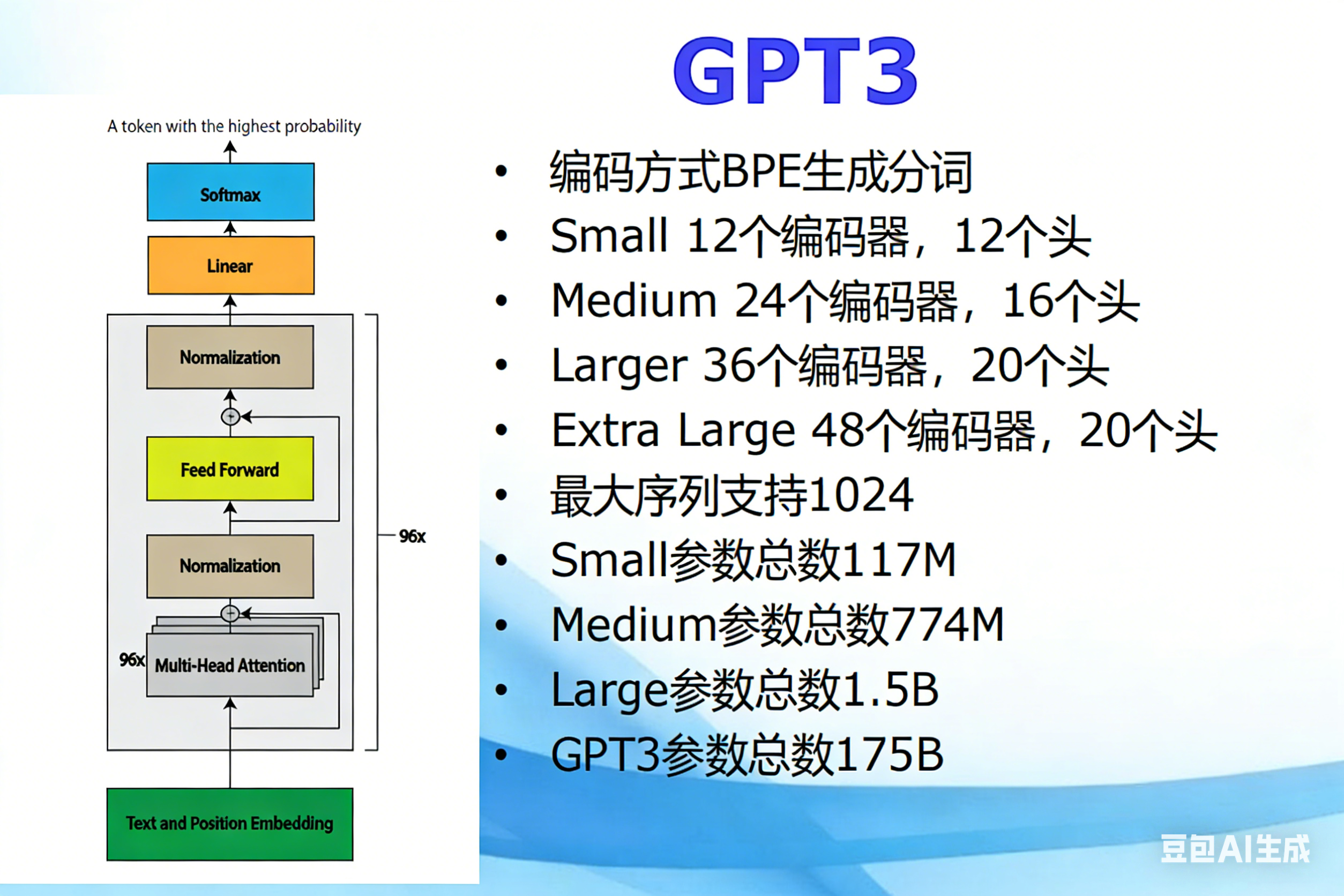

GPT 属于 Decoder-only 架构(基于 Transformer 解码器),核心是自回归注意力机制 ,天然擅长文本生成类任务,比如内容续写、对话生成、文案创作等

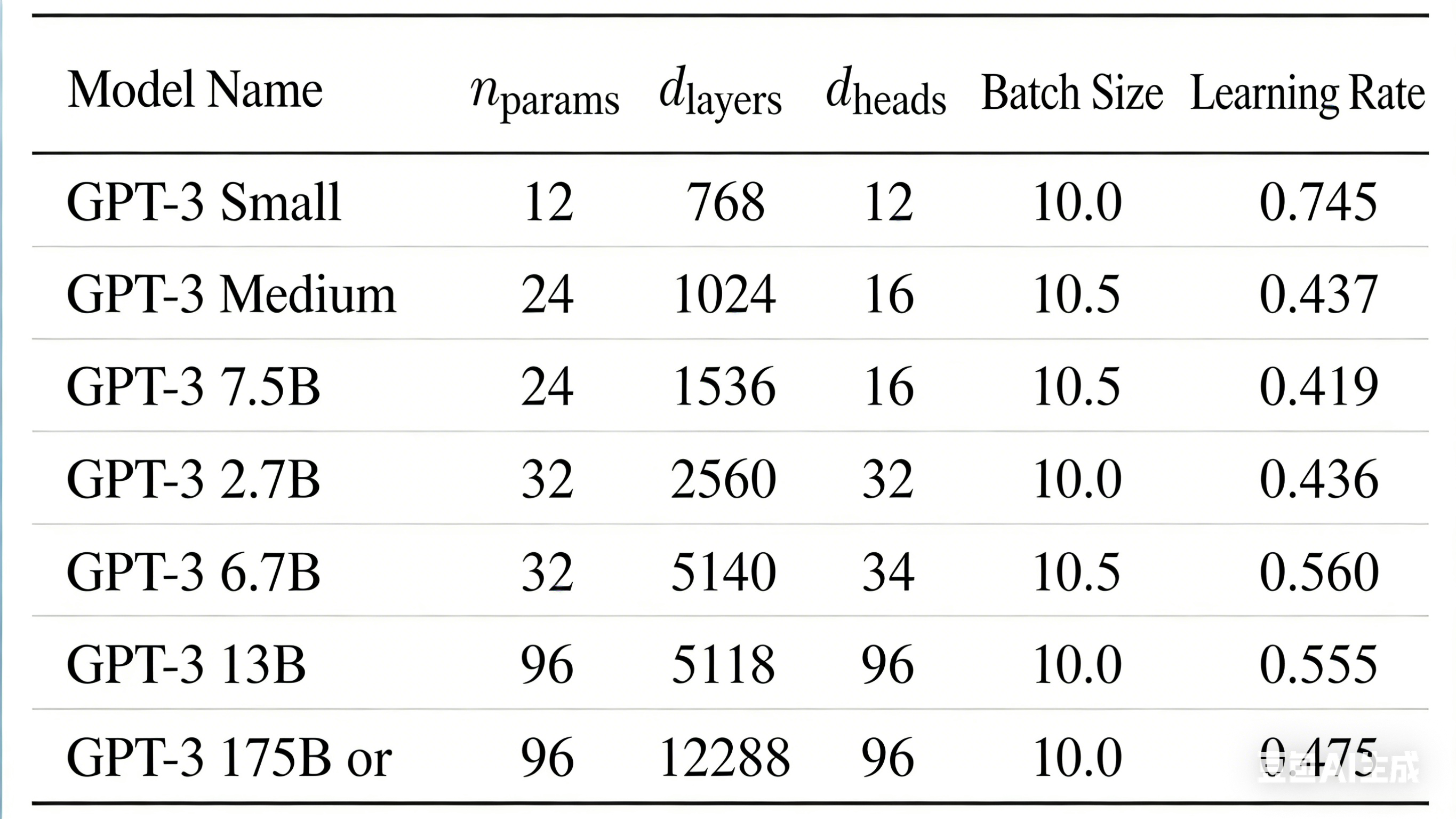

|--------|---------------------|-------------|-----------------------------------|----------|

| 模型 | Transformer 块数量 | 最大上下文长度 | 架构细节 | 核心任务 |

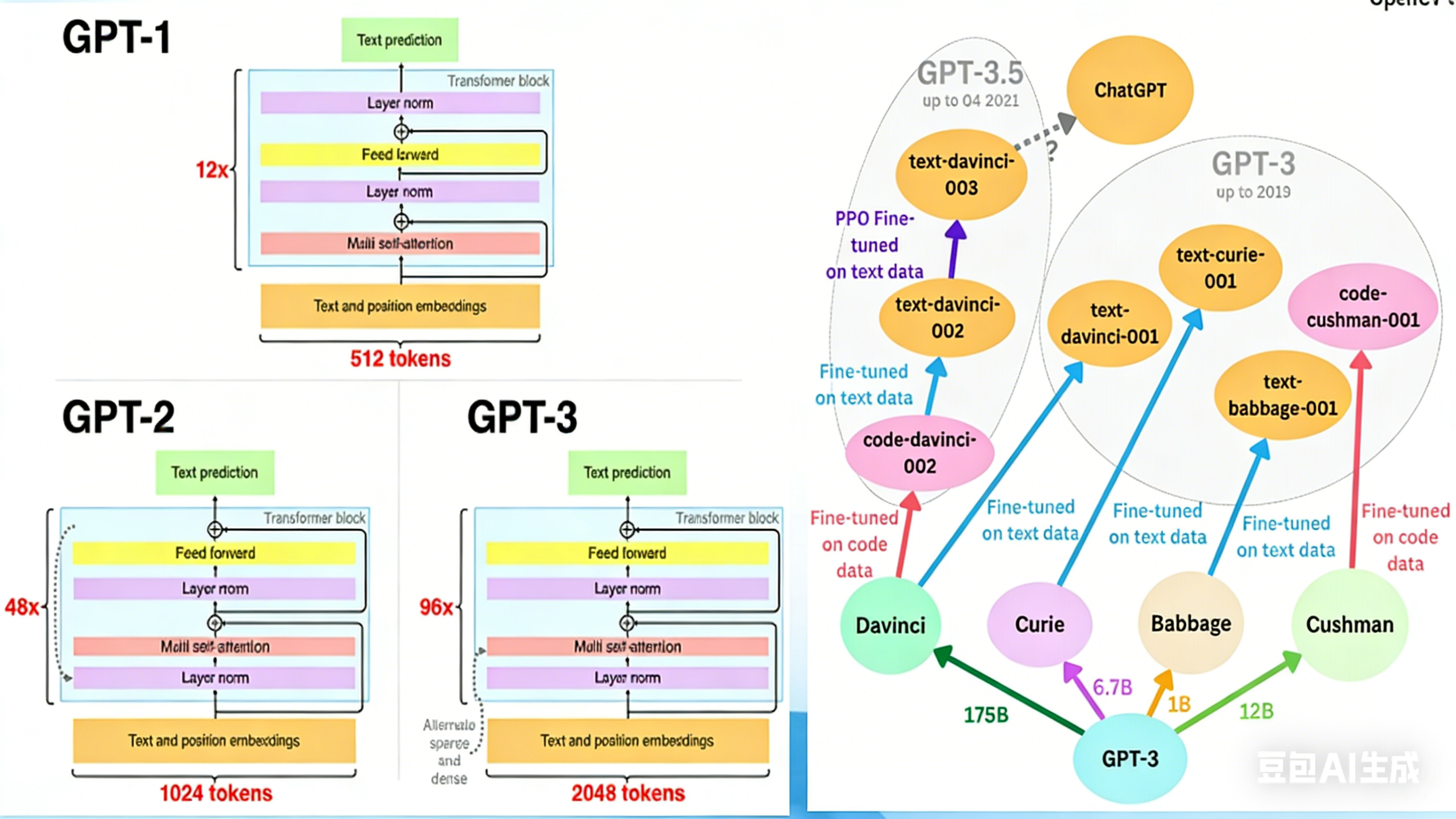

| GPT-1 | 12 层 | 512 tokens | 单块结构:LayerNorm→前馈→LayerNorm→自注意力 | 文本预测 |

| GPT-2 | 48 层 | 1024 tokens | 块结构调整:前馈→LayerNorm→自注意力→LayerNorm | 文本预测 |

| GPT-3 | 96 层 | 2048 tokens | 持 "稀疏 / 密集交替" 注意力(实际以密集为主) | 文本预测 |