研究背景与核心需求

在双机械臂策略学习中,大规模高质量的真实世界操作数据一直是瓶颈------相比仿真或纯人类数据,真实机械臂数据对训练鲁棒政策的直接适用性最强。而当前获取这类数据的主要方式仍是人类演示,这就需要可靠的遥操作接口支撑。

现有演示接口主要分两类:

- 末端执行器轨迹记录设备(如DexCap、UMI、OpenTelevision):虽轻便易用,但收集的数据常出现运动学奇点、超出机械臂工作空间、精度不足等问题,还需复杂后处理;

- 主从遥操作系统(如ALOHA、GELLO):通过机械同构的主臂实现直观、物理约束下的演示,能确保轨迹可被机械臂执行,但存在两大痛点------适配不同商用机械臂需大量工程工作,且成本极高(ALOHA双臂超5万美元,GELLO单臂仍需270美元)。

正是为解决"高兼容性"与"低成本"的矛盾,U-ARM应运而生:目标是打造一款开源、超低成本、易适配的主从遥操作系统,让研究者能快速为各类商用机械臂搭建数据收集 pipeline。

现有方案的痛点与U-ARM的定位

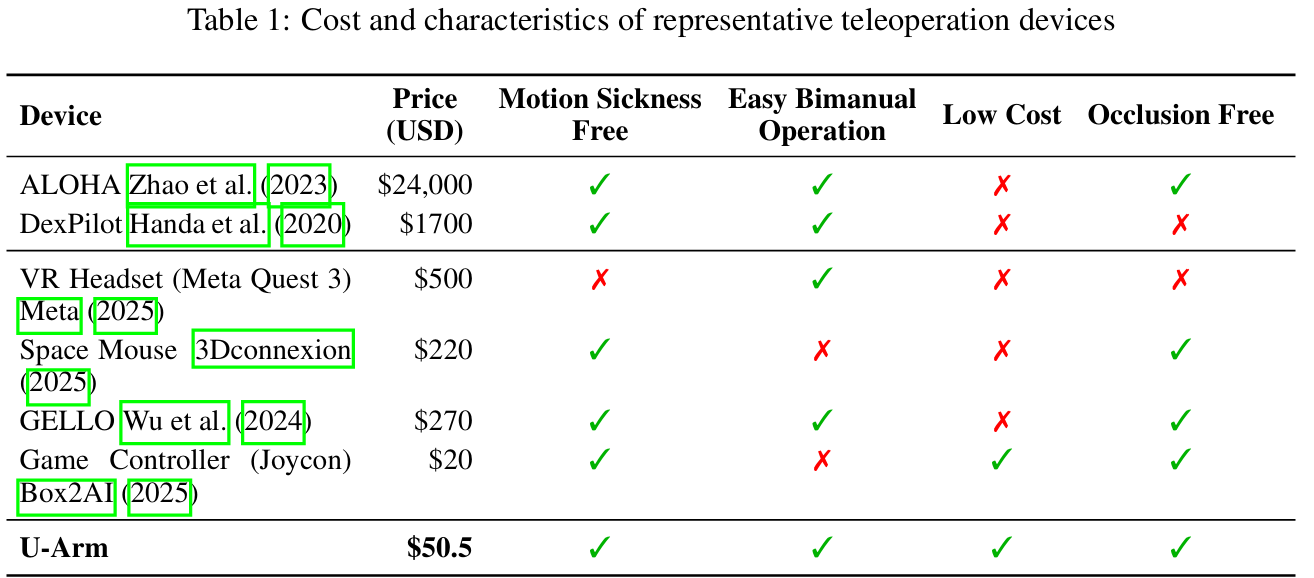

为更清晰体现U-ARM的价值,可先对比现有主流遥操作设备的核心特性(如Table 1所示):

- 高成本方案(如ALOHA):虽支持重力补偿、易用性强,但成本过高限制普及;

- 低成本方案:VR头显存在晕动症问题,SpaceMouse难以实现双手操作,Joycon(游戏手柄)虽仅20美元,但实际操作效率低;

- 过渡方案(如GELLO):虽支持3D打印、适配多商用臂,但依赖较贵的Dynamixel电机,成本仍有下降空间;

- 入门级方案(如LeRobot):5自由度桌面级机械臂虽便宜,但无法适配更常用的6/7自由度商用臂,导致训练模型难以泛化。

U-ARM的定位正是填补"超低成本"与"高兼容性"之间的空白:借鉴GELLO的3D打印思路,但进一步简化设计------主臂无需主动驱动(仅需记录关节角度,无需Dynamixel电机),同时通过机械优化保证关节活动范围约束与结构刚性,最终将单臂成本压至50.5美元(6DoF)和56.8美元(7DoF),且满足"无晕动症、易双手操作、无遮挡"的实用需求。

U-ARM系统设计

硬件设计:适配商用臂的标准化构型与成本优化

三种构型的设计逻辑

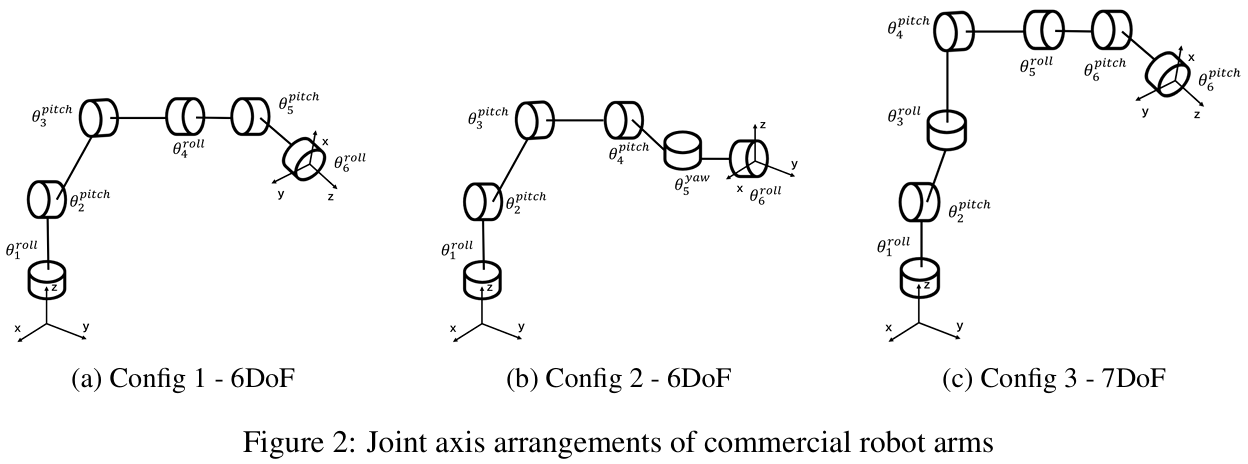

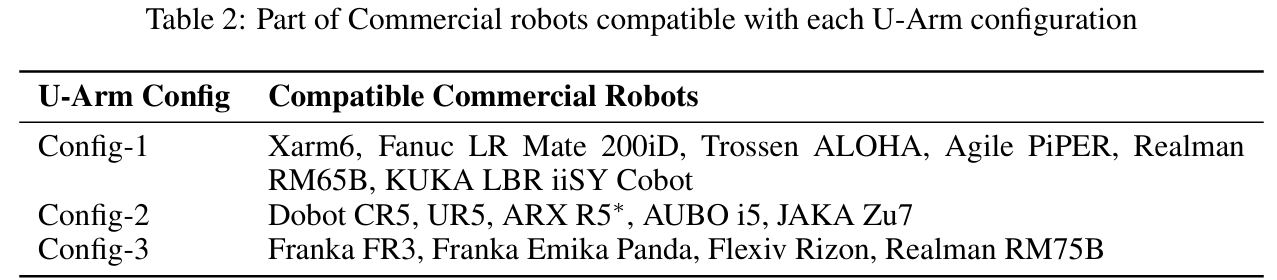

多数商用6/7自由度机械臂会遵循3种标准化关节序列(满足Pieper准则、优化灵活工作空间、拟人化结构),即使连杆长度不同,关节类型与排序也基本统一。基于这一观察,U-ARM设计了三种主臂构型(两种6DoF、一种7DoF,如Figure 2所示),每种构型对应适配不同商用机械臂(如Table 2所示):

- Config-1(6DoF):适配Xarm6、Fanuc LR Mate 200iD、KUKA LBR iiSY等;

- Config-2(6DoF):适配Dobot CR5、UR5、AUBO i5等(特别调整了Joint5与Joint6的顺序,适配这类机械臂的交叉轴腕部结构,通过软件反转控制逻辑保证操作直观性);

- Config-3(7DoF):适配Franka FR3、Franka Emika Panda、Flexiv Rizon等。

机械结构与电机改造

- 基础材料与耐用性优化:所有部件采用PLA 3D打印,最小壁厚设为4mm(保证PLA材质的耐用性);针对低-cost 3D打印主臂常见的"关节连接板松动/断裂"问题,所有关节采用双轴固定设计,缓解前几个关节承受的高径向往复载荷。

- 电机改造:降本与体验的关键:主臂无需主动驱动,仅需记录关节角度------因此拆解中菱舵机,移除内置齿轮箱(原齿轮箱导致关节阻力过大,无法顺滑移动),仅保留编码器用于角度测量;同时通过调整关节轴螺丝松紧控制阻尼,平衡"易移动性"与"稳定性":既避免阻力过大导致操作卡顿,也防止阻力过小导致关节(如Config-1的Joint3、Config-3的Joint4)在水平延伸时因重力下坠。

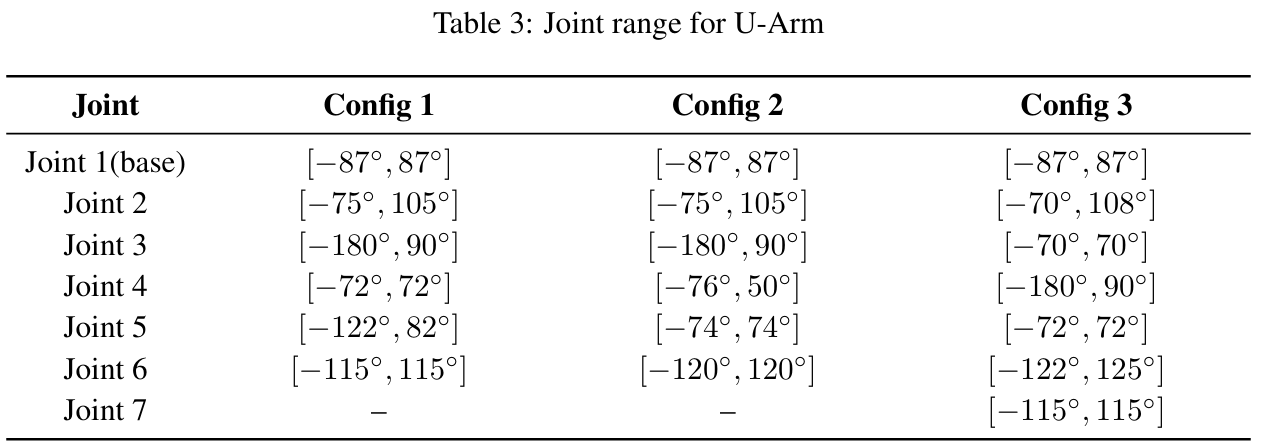

- 关节活动范围设计:U-ARM主臂的关节活动范围(如Table 3所示)故意设为较窄区间------既能覆盖典型桌面操作需求,又能避免极端姿态破坏结构完整性或引发异常关节行为,提升系统稳定性。

算法设计:确保运动平滑与适配性

编码器标定

中菱舵机编码器的有效范围为0-270°,且移除齿轮箱后无法通过指令反馈修正位置------因此安装前需手动将编码器调至135°中性位,确保主臂在正常操作中不会超出编码器范围,避免不可预测的运动。

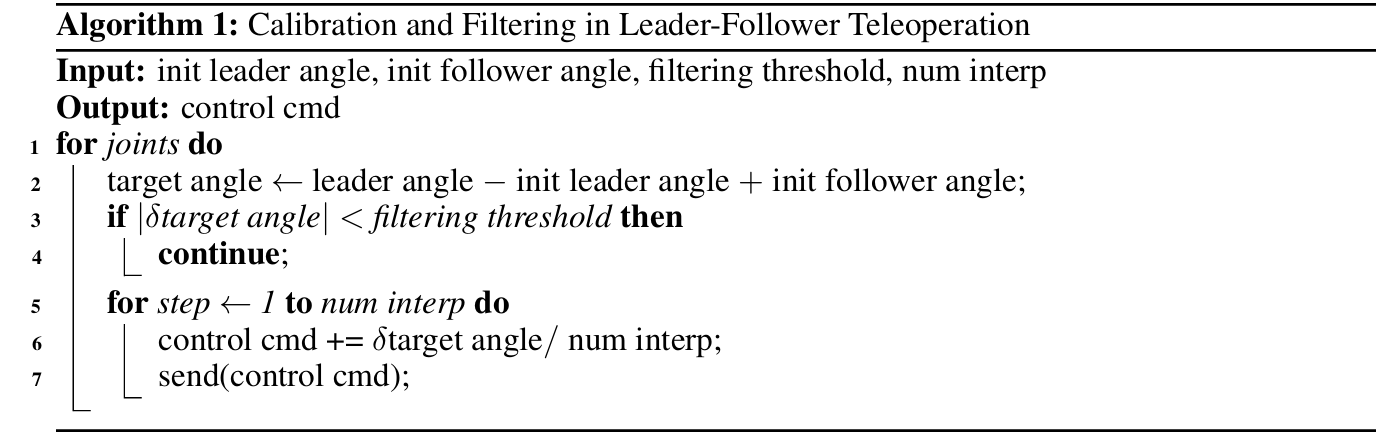

标定与滤波插值

不同商用机械臂的结构差异大,无法设定统一初始位置,因此每次遥操作需执行以下流程:

- 初始化:让从臂先移动到预定义初始姿态,主臂靠近该姿态后完成初始化并接管控制;

- 角度映射:目标角度计算逻辑为:

target angle ← leader angle − init leader angle + init follower angle \text{target angle} \leftarrow \text{leader angle} - \text{init leader angle} + \text{init follower angle} target angle←leader angle−init leader angle+init follower angle - 滤波与插值:若目标角度变化量( δ target angle \delta\text{target angle} δtarget angle)小于滤波阈值,则不执行动作(避免微小扰动导致从臂抖动);否则将角度变化量分为 num interp \text{num interp} num interp步,逐步发送控制指令(如Algorithm 1所示),确保从臂运动平滑、准确。

实验验证与结果分析

实验分为"仿真适配"与"真实世界对比"两部分,核心验证U-ARM的"适配性"与"效率优势"。

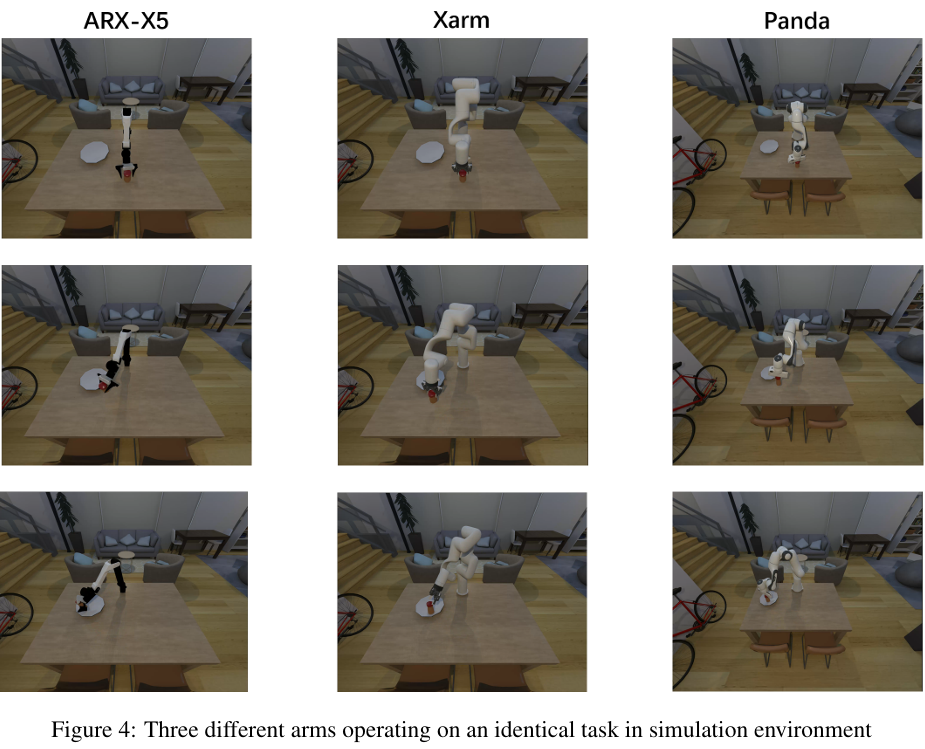

仿真适配:提前验证与数据准备

在基于SAPIEN的ManiSkill环境中适配U-ARM,支持7种商用机械臂(如Arx-x5、Xarm、Panda等,如Figure 4所示)------用户可在操作真实机械臂前,在仿真中验证关节角度映射错误等潜在问题;同时可在仿真中收集演示数据,用于MimicGen等数据扩展方法,降低真实世界数据收集成本。

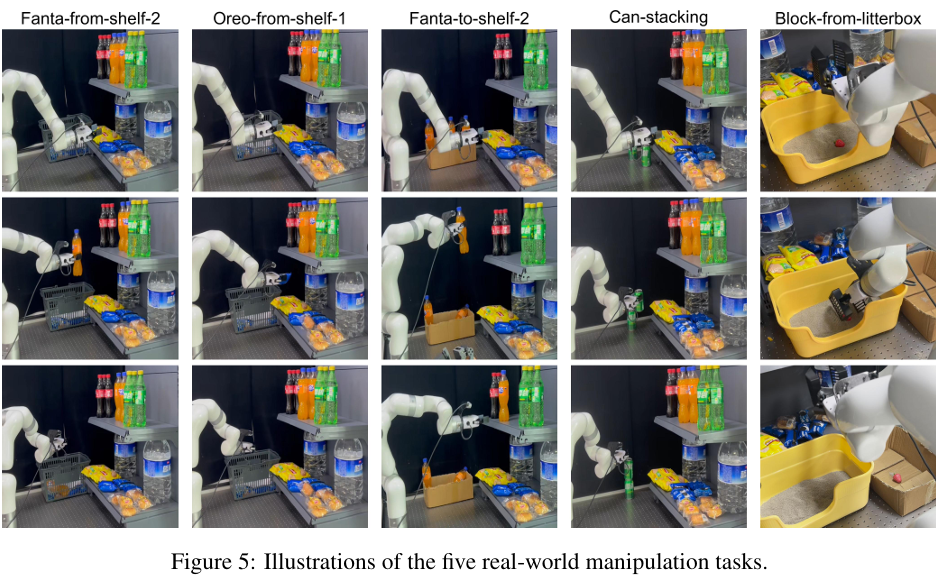

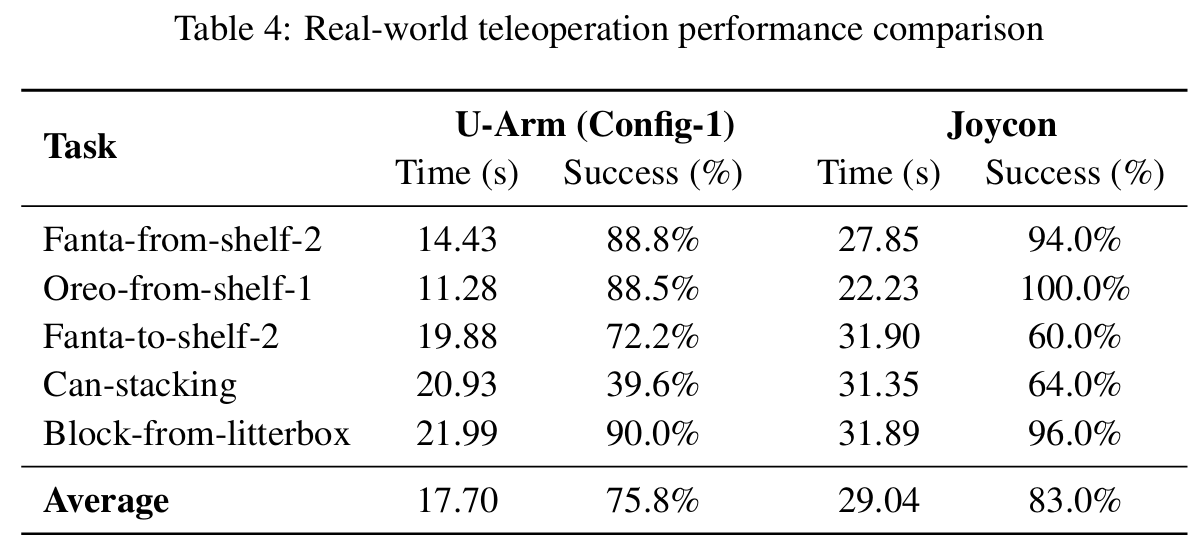

真实世界实验:对比Joycon

以U-ARM(Config-1)和Joycon(低成本遥操作代表)操控Xarm6执行5种典型桌面任务(如Figure 5所示:Fanta从货架2层到篮子、Oreo从货架1层到篮子、Fanta从纸箱到货架2层、叠罐头、从猫砂盆拿积木),记录"任务耗时"与"成功率"(紧急停止计为失败),结果如Table 4所示:

- 效率优势显著:U-ARM平均耗时17.7秒,Joycon平均耗时29.04秒,数据收集效率提升39%------原因在于桌面任务的"大范围移动"阶段:Joycon作为末端控制设备,难以直观实现主臂的大范围扫掠运动;而U-ARM的主从关节映射设计,让操作者能更自然、快速地完成"靠近目标"的动作。

- 成功率可接受:U-ARM平均成功率75.8%,略低于Joycon的83%------主要因为Joycon松开摇杆即可停止运动,能减少精细操作中的误操作;而U-ARM需实时传输手部动作,精细操作(如叠罐头)时易出现微小误差,但这一牺牲被"效率大幅提升"覆盖,属于可接受的trade-off。

参考

1\]U-ARM : Ultra low-cost general teleoperation interface for robot manipulation ### 具身求职内推来啦 [近50家主流具身公司,校招\&社招\&实习均可](https://mp.weixin.qq.com/s/jL20AolSpJJqu8F0cOMmpQ) ### 国内最大的具身智能全栈学习社区来啦! [具身智能之心知识星球:国内最大的具身智能全栈技术社区来啦!](https://mp.weixin.qq.com/s/aLRwG433sA0QjzPZecp9OQ) ### 推荐阅读 [从零部署π0,π0.5!好用,高性价比!面向具身科研领域打造的轻量级机械臂](https://mp.weixin.qq.com/s/4K7QBk7ucXDvR-DLXk6DlA) [工业级真机教程+VLA算法实战(pi0/pi0.5/GR00T/世界模型等)](https://mp.weixin.qq.com/s/kHXwMdtqT9fTouVg9glbAQ) [具身智能算法与落地平台来啦!国内首个面向科研及工业的全栈具身智能机械臂](https://mp.weixin.qq.com/s/HvuMpbIoAe1bSlQBHCFgiQ) [VLA/VLA+触觉/VLA+RL/具身世界模型等!具身大脑+小脑算法与实战全栈路线来啦\~](https://mp.weixin.qq.com/s/x6p9VVtZXUdyBqVOnmUqcg) [MuJoCo具身智能实战:从零基础到强化学习与Sim2Real](https://mp.weixin.qq.com/s/9h8DNg2P3SzUwcoOF7DliA) [从零训练你的足式机器人!让你的足式机器人真正动起来\~](https://mp.weixin.qq.com/s/foYf_g9PvFVDJG2jjQE_-A) [具身领域的目标导航到底是什么?有哪些主流方法?](https://mp.weixin.qq.com/s/92oaQWQ18lNguDPgctIlSQ) [Diffusion Policy在具身智能领域是怎么应用的?为什么如此重要?](https://mp.weixin.qq.com/s/JSMQG9bGPpiX9aSkGI_3wA) [具身智能视觉语言动作模型,VLA怎么入门?](https://mp.weixin.qq.com/s/UhO0yLT74tA8WyCspCKkRg) [视觉语言导航的主流方法有哪些?是怎么用的?](https://mp.weixin.qq.com/s/AmxbgeL4X40KoVBaFzfmtQ) ### 1v1 科研论文辅导来啦! [重磅!具身智能之心论文辅导来啦(近20+方向,顶会/顶刊/SCI/EI/中文核心/申博等)](https://mp.weixin.qq.com/s/J9ECh3r3rzjNrajAjtumFQ)