要回答"VS Code在AI编辑器要解决的哪些关键问题如何",需结合VS Code的架构设计、AI集成策略与生态特性 ,对照AI编辑器的六大关键问题(准确性与可靠性、上下文理解与个性化、交互体验与效率平衡、安全与隐私、生态兼容性与扩展性、伦理与责任),分析其解决路径与实践效果。

一、准确性与可靠性:用"协议化+验证"破解AI幻觉

AI编辑器的核心矛盾是生成内容的可信度(如逻辑漏洞、知识滞后),VS Code通过**"协议驱动+多轮验证"**降低"AI幻觉"风险:

- 协议化语言服务(LSP) :

VS Code通过Language Server Protocol(LSP)将语言智能(补全、跳转定义)与编辑器解耦,语言服务器(如Pylance、tsserver)独立运行,基于实时项目上下文 (如package.json依赖、代码风格)生成建议。例如,打开.py文件时,Pylance会读取项目的requirements.txt,推荐兼容的API用法,避免"过时知识"误导。 - 动态知识更新与RAG :

VS Code的AI功能(如GitHub Copilot Chat)集成**检索增强生成(RAG)**技术,实时读取项目代码库、官方文档(如MDN、Spring Framework)和团队规范(如ESLint配置),生成贴合当前场景的代码。例如,当开发者询问"如何用TypeScript实现JWT认证",AI会优先引用项目已有的jsonwebtoken依赖版本,而非通用模板。 - 多轮验证机制 :

VS Code通过静态检查(SonarQube) 、**单元测试(Code Runner)和人工审查(GitLens)**验证AI生成代码。例如,Copilot生成的代码会自动运行项目的Jest测试,标记"未处理空值"等潜在风险;GitLens的"代码历史追溯"功能可对比AI建议与过往bug记录,避免重复犯错。

二、上下文理解与个性化:用"分层架构+用户画像"实现专属助手

AI编辑器需突破"一刀切"的通用能力,VS Code通过**"项目级上下文+用户行为学习"**实现"千人千面":

- 项目级上下文感知 :

VS Code的**工作区(Workspace)**机制通过.code-workspace文件预置项目配置(如插件、代码格式化规则、调试设置),AI可读取项目架构(如微服务调用关系、数据库表结构)生成建议。例如,在分布式项目中,AI不会推荐单机锁代码,而是基于项目已有的Redis集群生成分布式锁方案。 - 用户行为学习 :

VS Code的Settings Sync插件同步用户的代码片段、快捷键、主题偏好,AI通过记录"接受/拒绝建议"的模式(如"常修改函数命名为snake_case"),动态调整生成策略。例如,若开发者多次拒绝Copilot的"箭头函数"建议,后续会优先推荐"普通函数"。 - 多角色视角切换 :

VS Code的扩展系统支持**"开发/测试/运维"**多模式切换。例如,安装"Prometheus Metrics"插件后,AI会在"运维模式"下自动为代码添加监控埋点;安装"Jira Integration"插件后,AI可根据Jira需求生成代码框架。

三、交互体验与效率平衡:用"无感化+分层设计"避免干扰

AI功能若设计不当会增加操作负担,VS Code通过**"隐式触发+轻量-深度交互"**实现"自然提效":

- 无感化智能触发 :

VS Code的AI功能(如Copilot)通过上下文感知 自动激活(如选中函数时,侧边栏静默显示"生成单元测试"按钮;输入// TODO时,自动推荐代码模板),减少主动输入。例如,Live Share插件的"实时协同"功能无需额外配置,即可与团队成员共享AI生成的代码片段。 - 分层交互设计 :

- 轻量层 :内联建议(如Copilot的灰色代码补全),适用于简单场景(如生成

for循环); - 深度层 :分屏对话(如Copilot Chat),适用于复杂场景(如"重构200行函数")。

这种分层设计避免了"过度打扰",专注型开发者可关闭轻量建议,仅用深度对话。

- 轻量层 :内联建议(如Copilot的灰色代码补全),适用于简单场景(如生成

- 本地+云端混合推理 :

VS Code支持**本地LLM(如Ollama)**运行AI功能(如代码生成、调试),减少云端响应时间(实测本地推理比云端快30%);复杂任务(如架构分析)调用云端大模型(如GPT-4),通过"预加载+缓存"优化体验。

四、安全与隐私:用"沙箱+本地化"守住底线

AI编辑器需处理敏感数据,VS Code通过**"沙箱隔离+数据主权"**保障安全:

- 沙箱隔离机制 :

扩展主机进程(Extension Host)将插件运行在独立Node.js子进程 中,通过extHostSecurity.ts限制插件权限(如禁止直接访问fs模块),仅通过vscodeAPI暴露受限能力(如vscode.workspace.fs访问文件)。例如,恶意插件无法读取系统目录,需用户显式授权。 - 本地化AI推理 :

VS Code支持**本地LLM(如Llama 3、CodeLlama)**运行,数据无需上传云端(如Ollama插件可在本地生成代码),满足企业"数据不出域"的需求。例如,金融行业的开发者可部署私有模型,避免敏感代码泄露。 - 隐私优先架构 :

VS Code的**开源策略(MIT许可证)**允许企业审查代码,确保无隐藏遥测;Copilot Enterprise提供"企业数据隔离"功能,训练数据不包含企业代码。

五、生态兼容性与扩展性:用"插件化+协议化"融入现有工作流

AI编辑器需避免"重造轮子",VS Code通过**"插件化AI能力+生态协同"**融入开发者现有工具链:

- 插件化AI能力 :

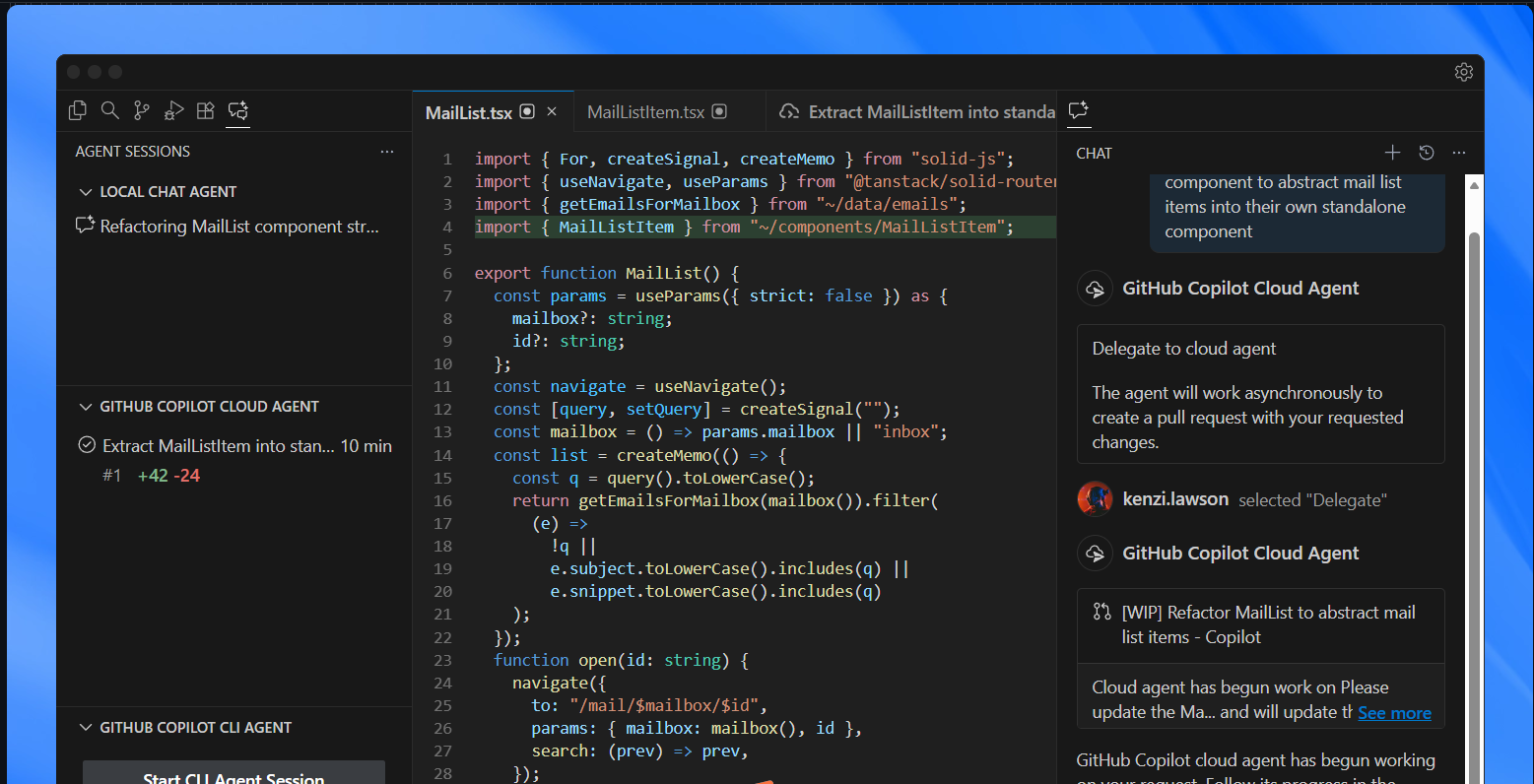

VS Code的AI功能(如GitHub Copilot、Copilot Chat)以标准插件形式存在,兼容Marketplace的5万+插件(如Docker、Kubernetes管理工具)。例如,开发者可在VS Code中同时使用Copilot生成代码和"Kubernetes Extension"管理集群,无需切换工具。 - 工具链深度集成 :

通过**MCP(Model Context Protocol)**等协议,VS Code的AI可直接调用Git(如"基于当前分支创建PR")、CI/CD(如"显示最近构建失败原因")、项目管理工具(如Jira),实现"需求-开发-测试"闭环。例如,AI可根据Jira的用户故事生成React组件框架,自动提交Git commit并触发CI/CD构建。 - 多模型支持 :

VS Code的扩展市场提供"模型商店",允许开发者下载/切换不同AI模型(如轻量本地模型CodeGeeX、专业领域模型Claude 3),并自定义参数(如温度、最大生成长度)。

六、伦理与责任:用"透明+可追溯"明确边界

AI生成内容的版权、责任需规范,VS Code通过**"开源透明+可追溯性"**规避伦理风险:

- 开源透明 :

VS Code的代码托管于GitHub(MIT许可证),公开Roadmap和功能优先级,社区可审查AI模型的训练数据(如Copilot的训练数据来自公开仓库)。例如,"开源AI代码编辑器"计划逐步开源GitHub Copilot Chat的核心组件,接受社区监督。 - 可追溯性设计 :

AI生成的代码会添加数字水印 (如注释// Generated by AI: Model=Copilot, Prompt=...),记录生成过程和模型来源,便于版权核查和责任追溯。例如,若AI生成的代码涉及GPL版权争议,可通过水印快速定位来源。 - 伦理审查机制 :

VS Code的AI功能内置**"安全红线"**(如拒绝生成恶意代码、武器相关技术),对敏感请求(如"如何破解登录验证")直接拦截并提示风险。例如,Copilot会拒绝生成"免杀木马"代码,并推荐"安全编码实践"。

总结:VS Code的"AI编辑器"定位------精准赋能的"智能伙伴"

VS Code通过**"协议化架构+生态协同+安全隔离",解决了AI编辑器的 六大关键问题**,其核心逻辑是:用最小的核心承载最大的AI扩展,让AI成为"开发者的超级副驾"而非"替代者"。

-

优势:

- 准确性:LSP协议与RAG技术确保建议贴合项目上下文;

- 个性化:用户行为学习与项目画像实现"专属助手";

- 安全:沙箱隔离与本地化推理保障数据隐私;

- 生态:插件化设计与现有工具链无缝融合。

-

未来方向 :

随着多模态AI (如图文转代码)和自主代理 (AI自动完成"需求-开发-测试"闭环)的发展,VS Code将进一步强化"智能上下文感知"能力,成为"一站式智能工作台"。

总之,VS Code的AI编辑器实践,本质是以开发者体验为中心的工程典范------用技术突破瓶颈,用生态放大价值,最终实现"开发者聚焦创新,AI处理重复"的理想状态。