大型语言模型(LLM)在自然语言理解和生成任务中取得了显著的性能。然而,它们常常面临一些局限性,例如难以整合新知识、生成幻觉以及解释其推理过程。为了应对这些挑战,我们提出了一种名为MindMap 的新型提示流程 ,该流程利用知识图谱(KG)来增强 LLM 的推理能力和透明度。我们的方法使 LLM 能够理解 KG 输入,并结合隐式知识和外部知识进行推理。此外,我们的方法还能提取 LLM 的思维导图,从而揭示其基于知识本体的推理路径。我们在各种问答任务(尤其是在医学领域)上评估了我们的方法,结果表明其性能显著优于基线方法。我们还引入了一个新的幻觉评估基准,并分析了我们方法中不同组件的影响。我们的结果表明,我们的方法能够有效地融合来自 LLM 和 KG 的知识,从而实现联合推理。

一、问题

大语言模型(LLMs)在自然语言理解与生成任务中表现优异,但在实际应用(尤其是医疗等高风险领域)中存在三大关键问题:

- 知识僵化:预训练知识易过时,参数更新成本高且易引发灾难性遗忘,难以融入新知识。

- 幻觉现象:生成看似合理但不符合事实的输出,严重影响高风险场景的可靠性。

- 缺乏透明:推理过程呈 "黑箱" 特性,知识隐含在参数中无法验证,推理路径难以解释。

二、挑战

- 现有增强方案缺陷:文档检索增强存在检索不准确、文本冗长的问题;知识图谱(KG)增强多将图谱视为纯文本,忽略其结构化特性,导致输出难以验证。

- 图谱与模型协同难:现有方法要么过度依赖 KG 的事实正确性,要么忽视 KG 与问题不匹配的情况,无法实现 LLM 隐含知识与 KG 显式知识的有效融合。

- 复杂场景适配不足:在长对话、知识错配等场景中,现有方法难以平衡外部知识与模型自身逻辑,推理准确性和鲁棒性不足。

三、创新点

- 提出 "图谱 - 思维" 协同框架:首次通过知识图谱提示(KG Prompting)激发 LLM 的 "思维图谱"(Graph of Thoughts)能力,实现隐含知识与显式知识的协同推理。

- 结构化证据处理机制:将 KG 拆解为路径型和邻居型证据子图,保留图谱结构化信息,避免传统方法中 "文本化图谱" 导致的信息丢失。

- 可解释推理可视化:通过 "思维导图"(MindMap)输出推理路径,明确标注证据来源(KG 或 LLM),解决 LLM 推理透明度不足的问题。

- 鲁棒性设计:即使 KG 存在知识错配或冗余,仍能通过 LLM 隐含知识修正偏差,适配实际应用中 KG 不完美的场景。

四、贡献

- 方法论贡献:提出 plug-and-play 的 MindMap 提示流水线,无需微调即可让 LLM 理解 KG 输入并进行协同推理,适配商业 LLM API。

- 性能提升:在医疗 QA、长对话 QA 等任务中,显著降低幻觉率,提升答案准确性和完整性,优于 GPT-3.5、GPT-4 及传统检索增强方法。

- 评估创新:引入新的幻觉量化指标,通过 GPT-4 成对比较评估,覆盖答案多样性、事实正确性、诊断准确性等多维度。

- 开源资源:公开代码库和数据集配置,为 LLM 与 KG 协同推理研究提供基准。

五、提出的方法(MindMap)

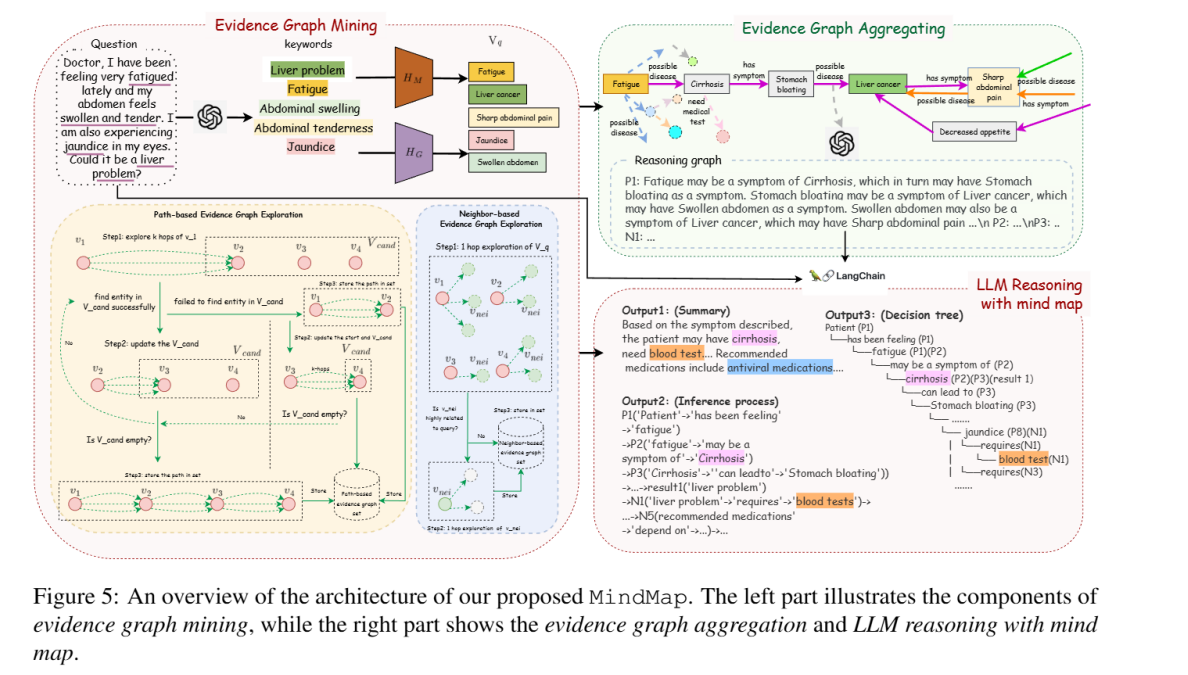

核心框架:三阶段流水线

-

证据图谱挖掘

- 实体识别:通过 LLM 提取问题关键词实体,结合 BERT 相似度匹配 KG 中的目标实体。

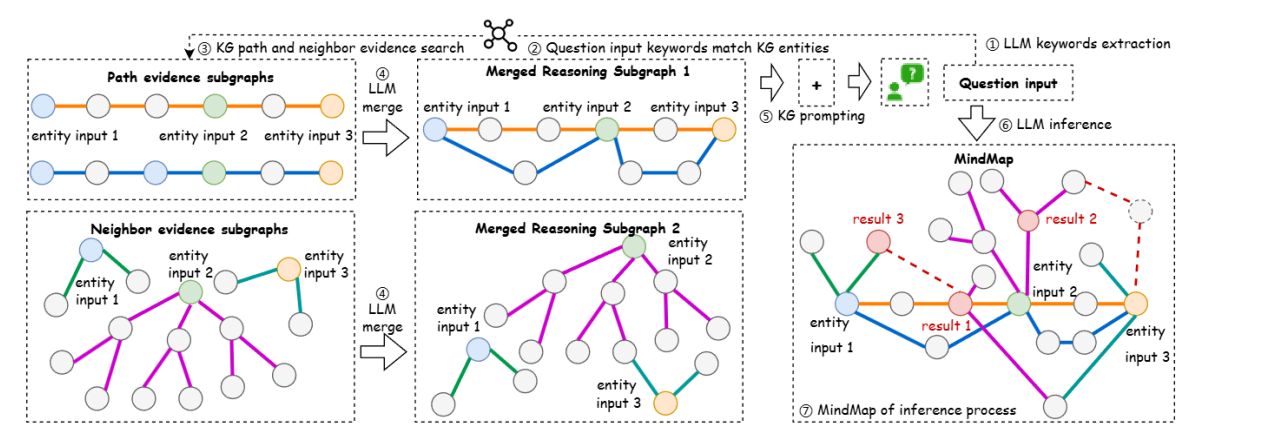

- 子图探索:构建两类证据子图 ------ 路径型子图(追踪实体间多跳关联路径)、邻居型子图(扩展实体 1-hop 邻居及相关关联),经聚类采样优化信息密度。

-

证据图谱聚合

- 将路径型和邻居型子图转换为 "实体 - 关系 - 实体" 的自然语言描述,统一语义相似实体,消除歧义。

- 生成统一推理图谱(Gₘ),为 LLM 提供结构化外部知识输入。

-

LLM 思维导图推理

- 基于 Langchain 设计提示模板,包含系统指令、问题、推理图谱、思维引导和示例。

- LLM 融合推理图谱(显式知识)与自身隐含知识,输出三类结果:答案摘要(疾病、检测、药物)、推理过程(标注证据来源)、思维导图(可视化推理路径)。

-

总:本研究旨在构建一种即插即用的提示方法,以激发大语言模型(LLMs)的思维图谱推理

能力。我们将其命名为MindMap(思维导图),因为该方法能帮助LLMs理解图形化输

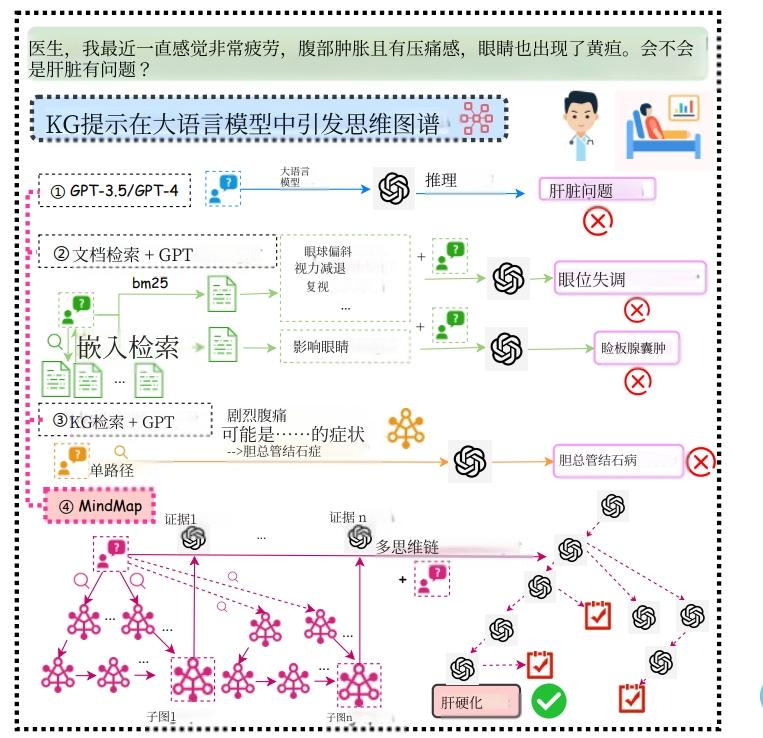

入,构建支持证据驱动生成的思维导图。图2展示了该框架的概念性演示。 -

具体而言,MindMap通过以下三个步骤激发LLMs的思维图谱:(1)整合知识图谱(KGs)检索到的事实与LLMS的隐性知识;(2)发现输入KGs中的新规律;(3)基于思维导图进行推理以生成最

终输出。我们在三个数据集上进行实验,结果表明MindMap在多个维度上显著优于现有提示

方法。这项研究揭示了LLMS如何通过整合隐性与显性知识,实现与知识图谱的协同推理。通过这种知识融合机制,LLMs能够获得透明可靠的推理能力,并能适应不同准确度要求的附加知识图谱信息。 -

六、指标

1. 核心评估指标

- BERTScore:衡量生成答案与参考答案的语义相似度(Precision/Recall/F1)。

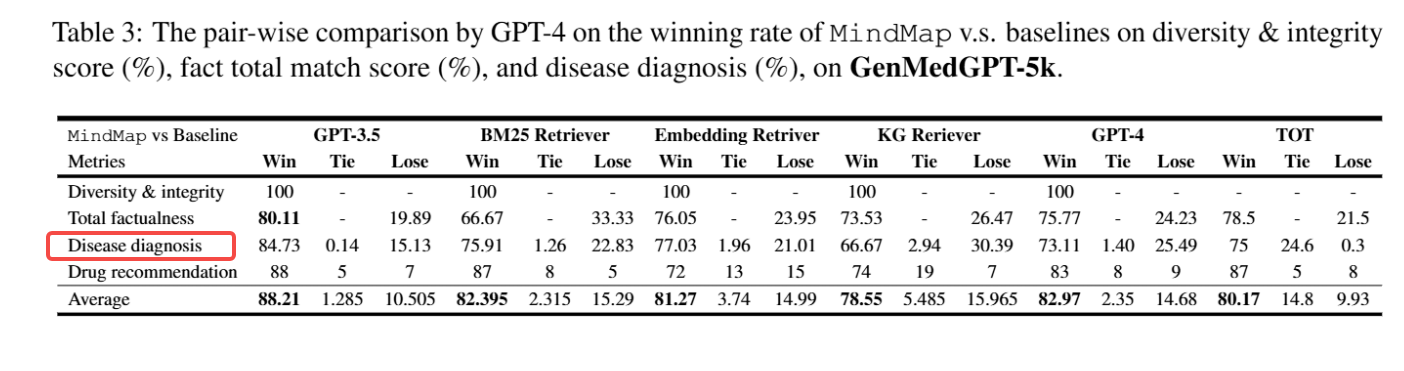

- GPT-4 排名:由 GPT-4 从 "多样性与完整性""事实正确性""疾病诊断准确性""药物推荐准确性" 四维度对方法排序。

- 幻觉量化指标:通过 NER-MT5 提取答案关键词,计算与参考关键词的 TF-IDF 相似度,分数越低幻觉越严重。

- 成对胜率:GPT-4 成对比较 MindMap 与基线方法的答案质量,统计 MindMap 获胜比例。

2. 辅助指标

- 准确率:在选择题数据集(ExplainCPE)中计算正确答题比例。

- 推理透明度:通过思维导图的证据溯源完整性评估。

七、模型结构

MindMap 为无微调的提示框架,核心结构由三部分组成:

- 输入层:原始问题 + 外部知识图谱(EMCKG/CMCKG)。

- 中间处理层

- 实体识别模块:LLM + BERT 相似度匹配。

- 子图挖掘模块:路径探索器 + 邻居探索器 + 聚类采样器。

- 图谱聚合模块:LLM(将子图转换为自然语言推理图谱)。

- 输出层:LLM(基于提示模板生成答案摘要、推理过程、思维导图)。

- 底层骨干模型:GPT-3.5-turbo-0613(所有基线及 MindMap 共用),对比模型含 GPT-4、TOT(Tree-of-Thought)。

八、结论

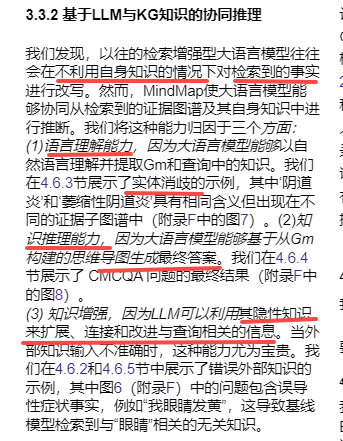

- MindMap 通过 KG 提示激发 LLM 的思维图谱能力,有效融合隐含知识与显式知识,显著提升答案准确性和透明度。

- 在医疗 QA、长对话 QA、知识错配场景中,MindMap 均优于纯 LLM、文档检索增强、KG 检索增强等基线,幻觉率更低。

- 路径型与邻居型证据子图的结合是提升性能的关键,证明结构化 KG 输入比纯文本输入更适配 LLM 推理。

- MindMap 为高风险领域(如医疗)提供了可靠、可解释的 LLM 推理方案,验证了 KG 与 LLM 协同推理的可行性。

九、剩余挑战和未来工作

剩余挑战

- 知识图谱覆盖度限制:在长对话任务中,KG 难以覆盖所有必要事实,导致性能提升幅度缩小。

- 集成复杂性:KG 与 LLM 的协同可能引入逻辑不一致,尤其在处理模糊查询时。

- 过度依赖风险:LLM 可能对 KG 产生依赖,在 KG 不可用或信息缺失时性能下降。

- 可解释性深度不足:思维导图的复杂性可能影响用户对推理路径的理解。

未来工作

- 优化 KG 动态适配:构建更灵活的证据子图挖掘策略,适配不同领域、不同完整性的 KG。

- 增强推理可解释性:简化思维导图呈现形式,提升用户对推理过程的理解效率。

- 扩展应用场景:将框架推广到法律、金融等其他高风险领域,验证通用性。

- 减少依赖风险:设计 KG 缺失时的 fallback 机制,平衡外部知识与 LLM 自身能力。

十、数据集

1. 核心数据集(均为医疗领域,覆盖不同 QA 场景)

| 数据集 | 领域场景 | 任务类型 | 数据规模 | 配套 KG |

|---|---|---|---|---|

| GenMedGPT-5k | 英文医患对话 | 疾病诊断、药物推荐、检测推荐 | 714 个问题,1122 个节点、5802 个三元组 | EMCKG |

| CMCQA | 中文多轮临床对话 | 多任务 QA(疾病、药物、检测、饮食) | 468 个问题,62282 个节点、506490 个三元组 | CMCKG |

| ExplainCPE | 中国执业药师考试选择题 | 5 选 1 选择题(含选项解释) | 400 个问题,同 CMCQA 的 KG | CMCKG |

2. 知识图谱详情

- EMCKG:针对英文医疗 QA 构建,包含疾病、症状、药物、检测 4 类实体,6 种关系(如 "has_symptom""need_medication")。

- CMCKG:针对中文医疗场景构建,包含疾病、症状、综合征、食物等 7 类实体,12 种关系(新增 "food__is_good_for_disease" 等饮食相关关系)。

我的想法

1.他们的创新点 :原来的知识图谱检索是,检索到之后,最多整理一下格式,就给大模型。这里是引导大模型对获得的图谱碎片进行整合、推理,获得"推理图"。其实就是知识的在整理和再思考,最后再基于推理图片生成答案和思维导图。

其实就是大模型解决:实体消歧、链接碎片知识推理结果、去除查询无关知识。最终得到精细化处理后的"推理图"

2.他们的知识图谱挖掘:

实体识别,大家都是这么做的:我们首先利用大语言模型(LLM)从问题查询Q中识别关键实体。具体而言,我们采用包含三个部分的提示:待分析的问题、模板短语"额外实体是"以及两个示例。完整提示详见附录D中的表9。随后通过BERT相似度算法进行实体与关键词匹配。具体来说,我们将LLM提取的所有关键词实体M和外部知识图谱中的实体G分别编码为高密度嵌入向量Hm和Hg,进而计算二者之间的余弦相似度矩阵。针对每个关键词,

证据子图 探索 如图5所示【有点像深度检索和广度检索】,我们采用两种方法 从源知识图谱构建证据子图集Gq:(1)路径探索技术通过追踪图G中的中间路径,将查询中的重要实体相互连接。具体而言,我们从选定节点出发,通过遍历相连节点来构建路径段。 最多k次跳。该过程持续进行,直至所有分段连接完成,生成一组存储在

最多k次跳。该过程持续进行,直至所有分段连接完成,生成一组存储在 (2)基于邻居的探索通过扩展每个节点n来增加相关知识

(2)基于邻居的探索通过扩展每个节点n来增加相关知识 单跳到其邻居,添加三元组

单跳到其邻居,添加三元组 向

向 该方法将额外的查询相关证据整合至Gq中。经过探索后,我们通过桥接通路中新添加的中间节点更新Vq。为管理信息开销并保持多样性,我们进行了剪枝处理。

该方法将额外的查询相关证据整合至Gq中。经过探索后,我们通过桥接通路中新添加的中间节点更新Vq。为管理信息开销并保持多样性,我们进行了剪枝处理。 和

和 根据其头部实体对子图进行聚类和采样。这些剪枝步骤最终生成证据图Gq,既优化了信息又保持了多样性。具体细节详见附录。

根据其头部实体对子图进行聚类和采样。这些剪枝步骤最终生成证据图Gq,既优化了信息又保持了多样性。具体细节详见附录。

我们在实验部分展示了基于路径探索和基于邻域探索组件的结果对幻觉的影响。

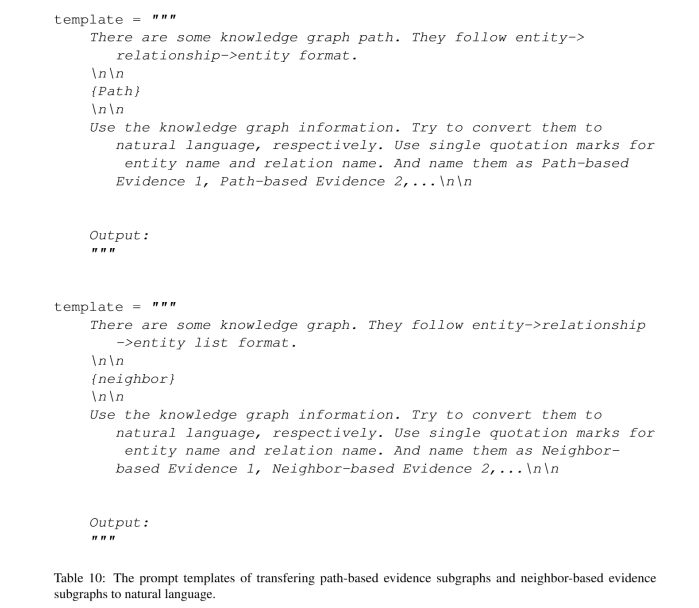

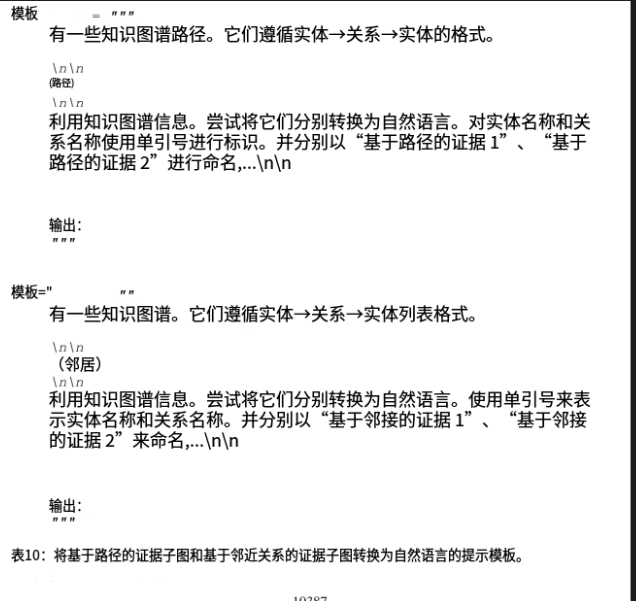

3.他们怎么整合的子图,提示词是啥

为生成最终的附加知识子图输入,我们首先从前一部分中提取了至少k个基于路径和k个基于邻

接的证据子图,每个子图代表查询实体之间的一种可能连接。然后,我们将每个子图格式化为实体链, 例如"(Fatigue,Nausea)-IsSymptomOf-肝脏问题

并为每个实体链分配了序列号,例如P1、P2、N1、N2。随后,我们引导大语言模型(LLM)

使用附录D表10中的模板 ,将每个实体链转换为自然语言描述 ,并将其定义为推理图Gm 。该设

计具有双重优势:(a)将子图简化为简洁统一的格式,精准捕捉核心信息;(b)充分发挥LLM的自然语言理解与生成能力,实现语义相近实体的统一处理,并消除潜在歧义。

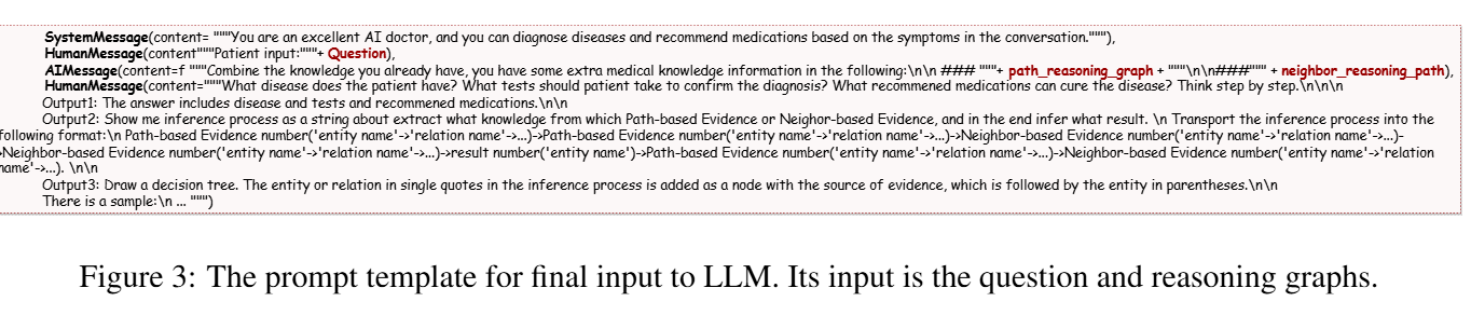

为生成思维导图并得出最终结果,我们为大语言模型(LLM)提供包含五个组成部分的提示:系统指令、问题、证据图Gm 、思维图指令及示例。其中,思维图指令采用Langchain技术引导LLM理解并增强输入内容,构建其推理用的思维导图,并索引该思维导图的知识来源。 提示模板详见图3。最终答案包含摘要回答、推理过程以及展示图推理路径的思维导图。如附录D中图5右侧红色方框所示,思维导图中的实体来源于证据图Gm及LLM自身的检索增强。

4.他们的思维导图怎么搞的,挺有意思的一个小噱头,挺实用的

思维图指令采用**Langchain技术引导LLM理解并增强输入内容,构建其推理用的思维导图,并索引该思维导图的知识来源。**提示模板详见图3。

5.他们的实验

MindMap在三个医学问答数据集(GenMedGPT-5k、 CMCQA 和ExplainCPE )中利用外部知识图谱进行复杂问答任务的能力。这些数据集分别涵盖医患对话、多轮临床对话和中国国家执业药师考试的多项选择题。

我们采用两项评估指标进行定量分析:BERTScore (Zhang 等人,2019a)和GPT-4评分 。BERTScore用于衡量生成答案与参考答案之间的语义相似度,而GPT-4评分则用于(1)将生成答案的质量与真实答案进行排序,(2)从四个维度对比答案对:回答的多样性与完整性、整体事实准确性、疾病诊断的正确性以及药物推荐的准确性。此外,我们还引入了幻觉量化指标,该指标通过评估生成答案与事实的偏离程度来量化偏差程度(Liang 等人,2023)。

通过在三个问答数据集上的大量实验,我们证明MindMap方法相较传统大语言模型和检索增强生成方法具有显著的实证优势,且对检索知识不匹配具有鲁棒性。这项研究为在生产环境中实现可靠透明的大语言模型推理开辟了新途径。

和其它方法的对比

总的来说,这种深度+广度检索,再用大模型后处理证据的方法挺好的,能去除无关查询,但是当查询到子图特别多的情况下,可能要限制关系,可以让大模型统计相关的关系,先把无关的关系也去掉