前言

随着 "人工智能 +" 行动被纳入国家战略,Agentic AI(智能体驱动的人工智能)已成为连接技术与产业的核心桥梁。从电商智能客服到教育创新课堂,从多智能体协作到私有化部署,Agentic 架构正在重塑各行各业的应用形态。作为一名 AI 领域的开发者,结合 Datawhale 开源社区的实践经验与《Agent 设计模式与工程化》的核心内容,本文将从学习心得、核心知识归纳、代码实战、踩坑指南到知识点扩展,全方位拆解 Agentic AI 的落地路径,助力零基础开发者(含文科生)快速入门。

一、学习心得:打破认知边界,AI 入门无门槛

作为见证 AI 从概念到落地的实践者,有三点深刻感悟:

- 技术普惠性:AI 不再是技术人员的专属 ------ 文档中提到的文科生通过 "提示词工程→大模型调用→Python 编程→Agent 开发" 的路线,两年内实现独立开发,证明 "兴趣 + 方法" 远胜于专业背景。

- 架构先行理念:Agentic AI 的核心是 "系统化设计",而非单纯的模型调参。三大核心能力(Planning、Tool-use、Miming)与六大资源维度(数据、模型、工具、算力、场景、组织)的框架,能让开发少走 90% 的弯路。

- 开源社区价值:Datawhale 的 "协作学习 + 项目实战" 模式,整合了高校与企业资源,其免费开放的课程、教程和项目代码,是零基础开发者的最佳跳板。

二、核心内容归纳:Agentic AI 的底层逻辑与框架

2.1 三大核心能力:Agent 的 "原子级功能"

Agentic AI 的本质是通过三大核心能力实现 "自主决策、高效执行、持续优化",具体拆解如下:

| 核心能力 | 核心价值 | 典型应用场景 |

|---|---|---|

| Planning(规划重复) | X1 - 重复性任务自动化;X2 - 多领域能力复制 | 自动生成会议纪要、批量处理邮件分类 |

| Tool-use(向外扩展) | Z1 - 突破思维限制;Z2 - 突破能力限制 | AI 编程、3D 模型生成、API 调用整合 |

| Miming(纵向知识挖掘) | Y1 - 个性化推荐 / 生成;Y2 - 数据分析与决策 | 智能客服问答、用户行为分析、医疗症状自查 |

2.2 六大资源维度:AI 落地的 "基建清单"

落地 Agentic 应用需统筹六大资源,缺一不可:

- 模型:选型(如 Claude 3.5 Sonnet、Qwen)、精调、评估、调用全流程

- 数据:涵盖数据集、数据库、知识库,核心是 "清洗→增强→评估→使用" 闭环

- 工具:插件、API、工作流(如 LangChain、MCP 工具插件)

- 算力:云服务器(EC2)、GPU 资源、容器化部署(Docker/K8s)

- 场景:Chatbot、智能客服、教育 / 医疗垂直领域

- 组织:团队配置、AI 小组、协作模式(如 Datawhale 周训)

2.3 六大架构维度:可控可落地的 "保障体系"

卓越的 Agentic 应用需满足 "开发→评估→部署→安全→观测→治理" 全流程管控:

- 开发:Prompt 设计、工作流搭建、多智能体协作

- 评估:模型效果、Prompt 优化、知识库命中率监测

- 部署:本地 / 云端 / SaaS 嵌入(飞书 / 企业微信)、私有化部署(Coze/Dify)

- 安全:内容安全检测、权限隔离、算法备案、合规审查

- 观测:成本监控、用户反馈收集、性能指标跟踪

- 治理:数据预处理 / 后处理跟踪、生成内容过滤

2.4 典型应用案例:从理论到实践

- 批量生成类:电商 1000 张宣传素材自动生成、教育批量出题 / 批改

- 智能问答类:制造业内部文档问答、HR 入职培训助手、医疗症状自查

- 创新交互类:古诗词 3D 场景生成、博物馆文物互动故事、工业 3D 模型设计

三、代码运行记录:多智能体协作与模型调用实战

3.1 环境准备

bash

# 安装核心依赖

pip install agentscope==0.1.63.2 多智能体对话实战(基于 AgentScope)

实现 3 个智能体协同完成 "轮流报数" 任务,核心代码如下:

python

from agentscope.agents import DialogAgent

from agentscope.message import Msg

from agentscope.pipelines import sequential_pipeline

from agentscope import msghub

import agentscope

# 初始化模型配置(以通义千问为例)

agentscope.init(

model_configs=[

{

"config_name": "my_config",

"model_type": "dashscope_chat",

"model_name": "qwen-max", # 可替换为claude-3-sonnet、gpt-3.5-turbo等

}

]

)

# 创建3个智能体

friday = DialogAgent(

name="Friday",

sys_prompt="You're a helpful assistant named Friday, only report one number each time",

model_config_name="my_config",

)

saturday = DialogAgent(

name="Saturday",

sys_prompt="You're a helpful assistant named Saturday, only report one number each time",

model_config_name="my_config",

)

sunday = DialogAgent(

name="Sunday",

sys_prompt="You're a helpful assistant named Sunday, only report one number each time",

model_config_name="my_config",

)

# 创建聊天场景,智能体轮流报数

with msghub(

participants=[friday, saturday, sunday],

announcement=Msg(

sender="user",

content="Counting from 1 and report one number each time without other words",

role="user"

),

) as hub:

# 按顺序执行报数

sequential_pipeline([friday, saturday, sunday], x=None)注意:agentscope所使用的版本,当前代码使用的是 0.x ,不同版本有所差异,具体可以查看对应方法。

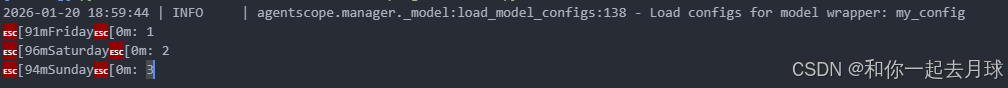

运行结果:

Friday: 1

Saturday: 2

Sunday: 3

3.3 大模型调用实战(含 LLM Gateway 高可用配置)

python

import os

from openai import OpenAI

# 配置LLM Gateway(高可用部署关键)

client = OpenAI(

base_url="https://address.to.ai.gateway", # 替换为实际网关地址

api_key="API-KEY-VALUE" # 替换为实际API密钥

)

# 用户输入交互

user_input = input("请输入您的问题:")

chat_completion = client.chat.completions.create(

messages=[

{"role": "user", "content": user_input}

],

model="gpt-3.5-turbo", # 可替换为本地化模型(如DeepSeek)

temperature=0.7

)

# 输出结果

print("AI回复:", chat_completion.choices[0].message.content)四、踩坑填坑记录:Agentic 落地常见问题与解决方案

4.1 模型选型坑:盲目追求大模型,忽略场景适配

- 问题:新手常直接选用 GPT-5 等大模型,导致成本过高、响应缓慢,且部分场景无需复杂能力。

- 解决方案:根据场景分层选型 ------ 通用场景用 Qwen-2.5-Max、DeepSeek;垂直场景用精调后的小模型;私有化部署优先选择支持本地运行的模型(如通义千问本地化版本)。

4.2 数据质量坑:知识库构建不规范,问答准确率低

- 问题:直接导入原始文档到 ChromaDB,导致 RAG(检索增强生成)命中率低、答非所问。

- 解决方案:遵循 "数据清洗→增强→评估" 三步法 ------ 去除无效文本、拆分长文档(按章节 / 段落)、添加关键词标签,定期检测知识库命中率并优化。

4.3 Prompt 优化坑:提示词过于简单,模型输出不可控

- 问题:仅简单描述任务,未添加约束条件、输出格式和角色设定,导致结果杂乱。

- 解决方案:采用 "角色 + 任务 + 约束 + 格式" 四要素 Prompt------ 例:"作为电商客服,回答用户的退货政策疑问,需包含退货期限、流程、运费规则,输出格式为分点说明,避免使用专业术语"。

4.4 安全合规坑:忽略生成内容审核,存在违规风险

- 问题:未配置内容过滤,导致生成敏感信息、违规内容,不符合监管要求。

- 解决方案:集成 Guardrail API、敏感词过滤、算法备案 ------ 参考 Amazon Bedrock 的安全方案,对用户输入和模型输出双向检测,隔离高危话题。

4.5 算力成本坑:未做资源管控,云服务器费用超支

- 问题:长期开启 GPU 实例,未设置自动扩缩容,导致闲置时成本浪费。

- 解决方案:采用 "按需分配 + 容器化部署"------ 用 Docker 封装应用,K8s 管理资源,非高峰时段自动关闭闲置 GPU,优先使用 Spot 实例降低成本。

五、知识点扩展论证:Agentic AI 的深度价值与趋势

5.1 RAG 技术:智能问答的核心支撑

RAG(检索增强生成)是 Agentic 问答场景的关键技术,其核心逻辑是 "先检索再生成",解决了大模型知识滞后、幻觉问题。文档中电商智能客服、制造业文档问答均基于 RAG 实现 ------ 通过 ChromaDB 检索相关文档片段,再结合大模型生成精准回答。扩展价值:RAG 不仅适用于客服场景,还可落地于医疗知识库(症状 - 诊疗方案匹配)、法律文档检索(法条快速定位)、教育题库构建(知识点 - 题目关联),是连接静态数据与动态生成的桥梁。

5.2 多智能体协作:复杂任务的高效拆解

文档(参考1)中斯坦福小镇案例(25 个 Agent 模拟人类生活)证明,多智能体协作能突破单一 Agent 的能力边界。其核心逻辑是 "任务拆解 + 专业分工"------ 每个 Agent 负责最小单元工作(如学术研究中,一个 Agent 负责文献检索,一个负责实验设计,一个负责论文撰写)。行业趋势:多智能体将成为企业级 AI 应用的主流形态,例如:电商场景中,客服 Agent + 物流 Agent + 营销 Agent 协同工作;医疗场景中,诊断 Agent + 用药 Agent + 护理 Agent 联动服务。

5.3 "人工智能 +" 政策:Agentic 落地的政策红利

国务院《关于深入实施 "人工智能 +" 行动的意见》(国发〔2025〕11 号)明确提出 "推动人工智能与各行业深度融合",Agentic AI 作为 "AI + 行业" 的载体,将享受三大政策支持:

- 基础设施补贴:企业部署 AI 算力、私有化平台可申请政策补贴;

- 行业应用试点:教育、医疗、制造等领域的 Agentic 应用可参与试点项目;

- 安全合规支持:算法备案、数据安全等方面提供绿色通道。

六、总结与学习建议

Agentic AI 的落地不是 "模型堆砌",而是 "架构设计 + 场景适配 + 工程化实现" 的系统工程。对于零基础开发者(含文科生),推荐遵循文档中的学习路线:

- 入门阶段:学习提示词工程(掌握四要素 Prompt 设计)→ 熟悉通用大模型调用(OpenAI / 通义千问 API);

- 进阶阶段:学习 Python 编程→ 掌握 RAG 技术(ChromaDB+LangChain)→ 搭建简单 Agent 应用(如智能问答机器人);

- 高阶阶段:学习多智能体协作(AgentScope)→ 工程化部署(Docker/K8s)→ 安全合规与治理。

最后,推荐加入 Datawhale 等开源社区,通过 "协作学习 + 项目实战" 快速成长 ------AI 时代的核心竞争力,不是 "懂技术",而是 "用技术解决问题"。希望本文能成为你 Agentic AI 之旅的起点,一起在 "人工智能 +" 的浪潮中实现技术落地与个人成长!