背景

VSCode 1.105.0发布了,但是用户最期待的Copilot功能却没更新!!!

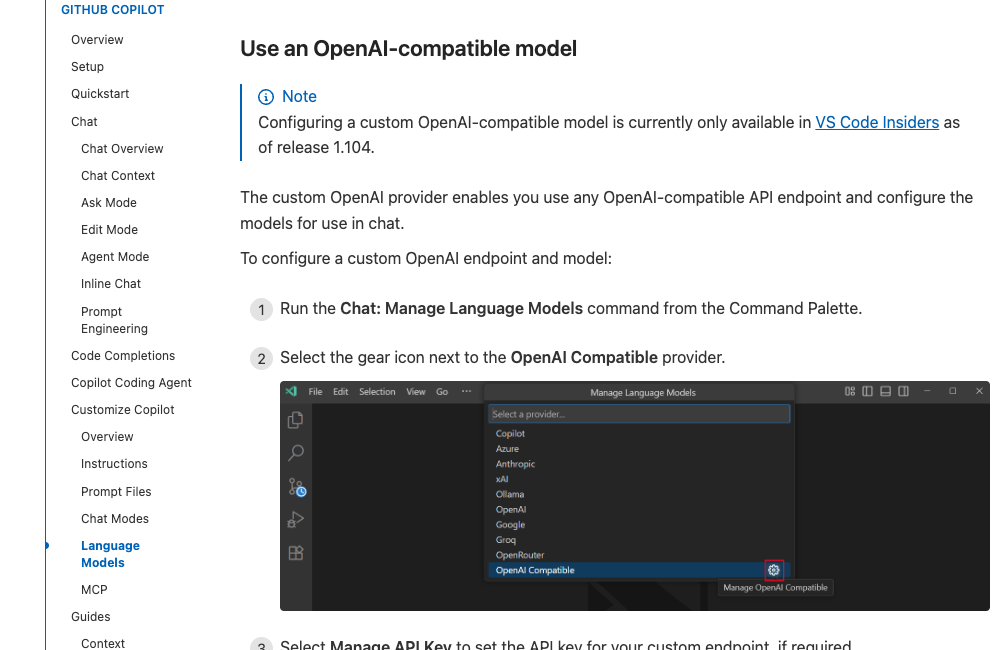

(Github Copilot Chat 中使用OpenAI兼容的自定义模型。)

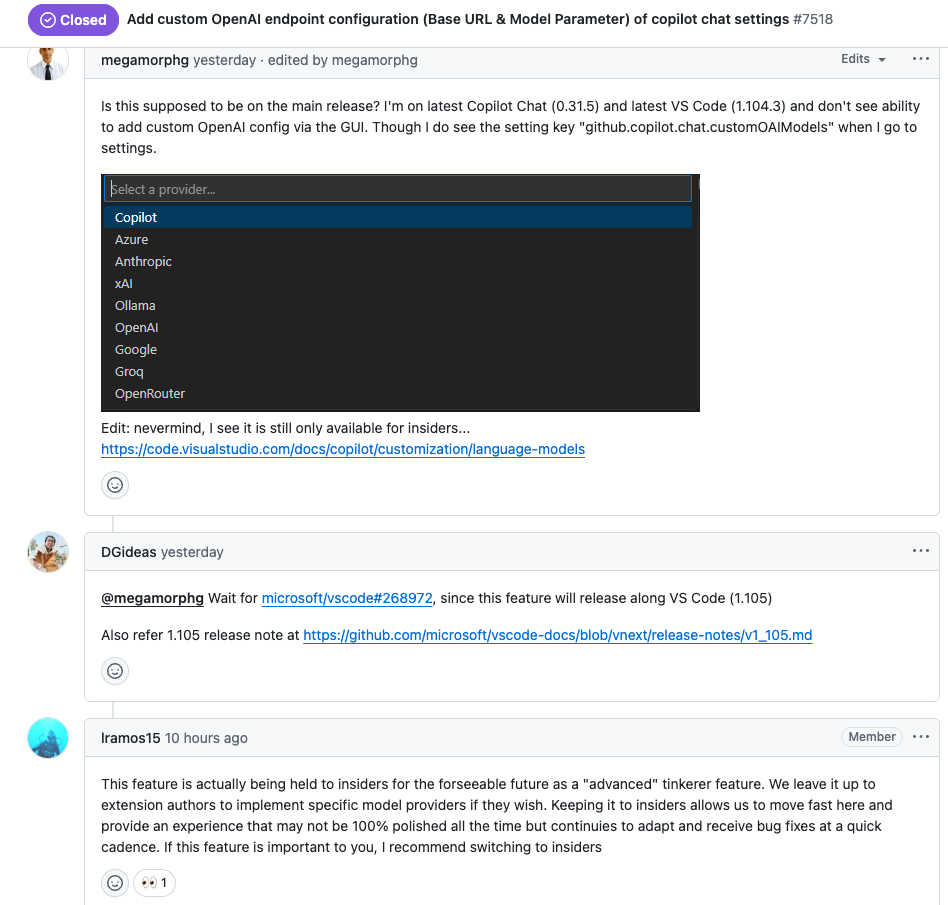

🔥官方也关闭了Issue,并且做了回复,并表示未来也不会更新这个功能:

"实际上,这个功能在可预见的未来只面向内部人员开放,作为一种"高级"实验功能。是否实现特定模型提供者的功能,我们交由扩展作者自行决定。仅限内部人员使用可以让我们快速推进,并提供一种可能并非始终百分之百完善,但能够持续改进并快速修复 bug 的体验。如果这个功能对你很重要,我建议切换到内部版本 insider。"

🤗 官方解决方案:安装VSCode扩展支持

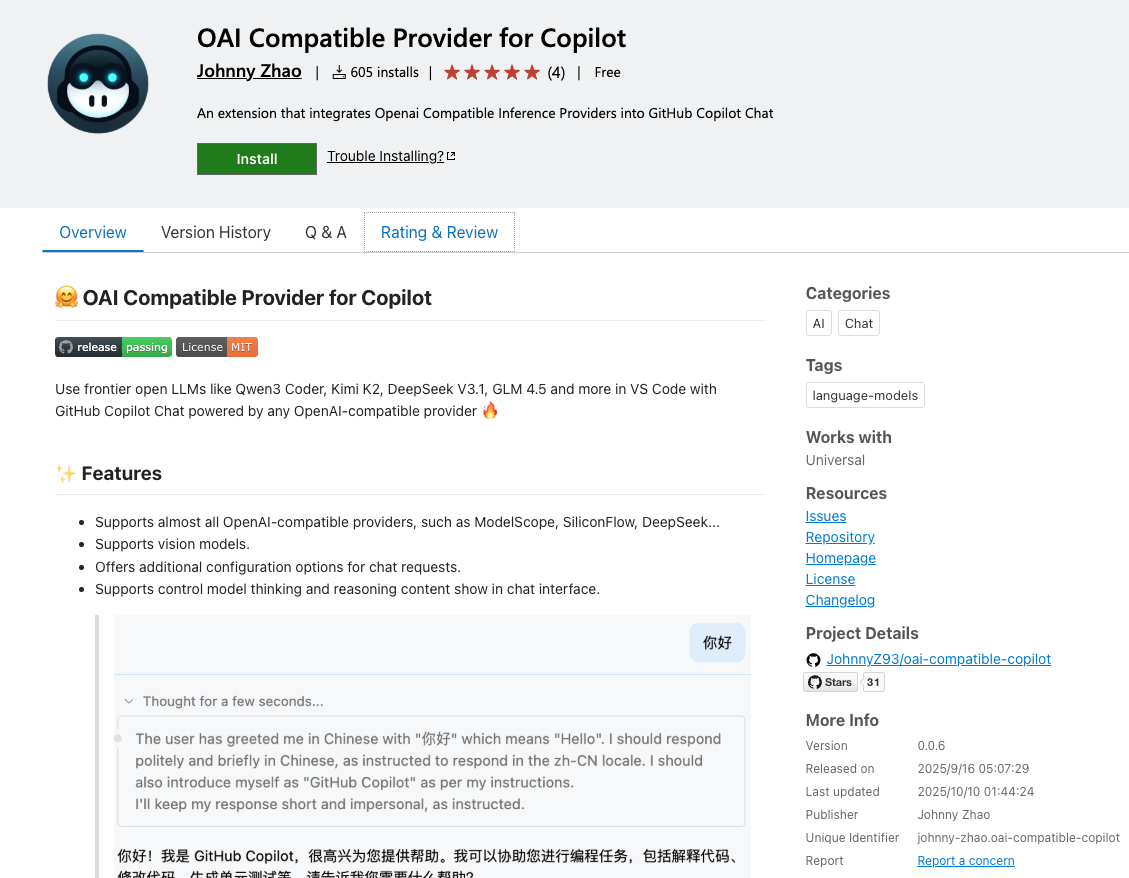

你们完全不用担心只需要在 VS Code 中安装扩展:OAI Compatible Provider for Copilot

通过任何兼容 OpenAI 的提供商驱动的 GitHub Copilot Chat,使用前沿开源大模型,如 Kimi K2、DeepSeek V3.2、GLM 4.6 等。

✨ 特色功能

-

支持几乎所有与 OpenAI 兼容的供应商,例如 ModelScope、SiliconFlow、DeepSeek...

-

支持视觉模型。

-

为聊天请求提供额外的配置选项。

-

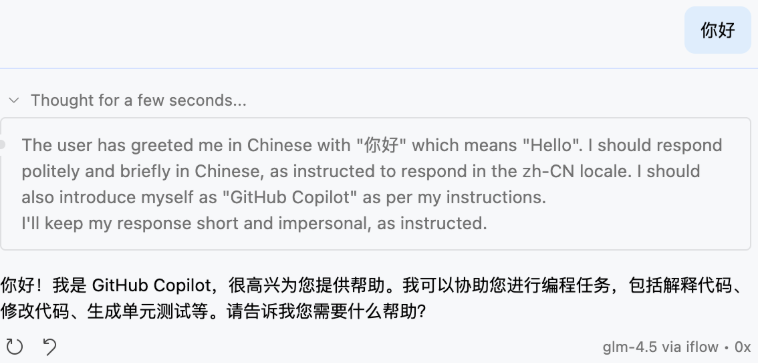

支持控制模型在聊天界面中显示思考与推理内容。

-

支持同时配置来自多个供应商的模型,自动管理 API 密钥而无需反复切换。

-

支持为同一模型 ID 定义多种配置(例如为 GLM-4.6 启用/禁用思考功能)。Supports almost all

⚡ 快速开始

- 安装"OAI Compatible Provider for Copilot"扩展。

- 打开 VS Code 设置,配置

oaicopilot.baseUrl和oaicopilot.models。 - 打开 Github Copilot聊天界面。

- 点击模型选择器,选择"管理模型..."。

- 选择"OAI Compatible"提供商。

- 输入您的 API 密钥 ------ 它将被本地保存。

- 选择您希望添加到模型选择器中的模型。

Settings Example

json

"oaicopilot.baseUrl": "https://api-inference.modelscope.cn/v1",

"oaicopilot.models": [

{

"id": "Qwen/Qwen3-Coder-480B-A35B-Instruct",

"owned_by": "modelscope",

"context_length": 256000,

"max_tokens": 8192,

"temperature": 0,

"top_p": 1

}

]