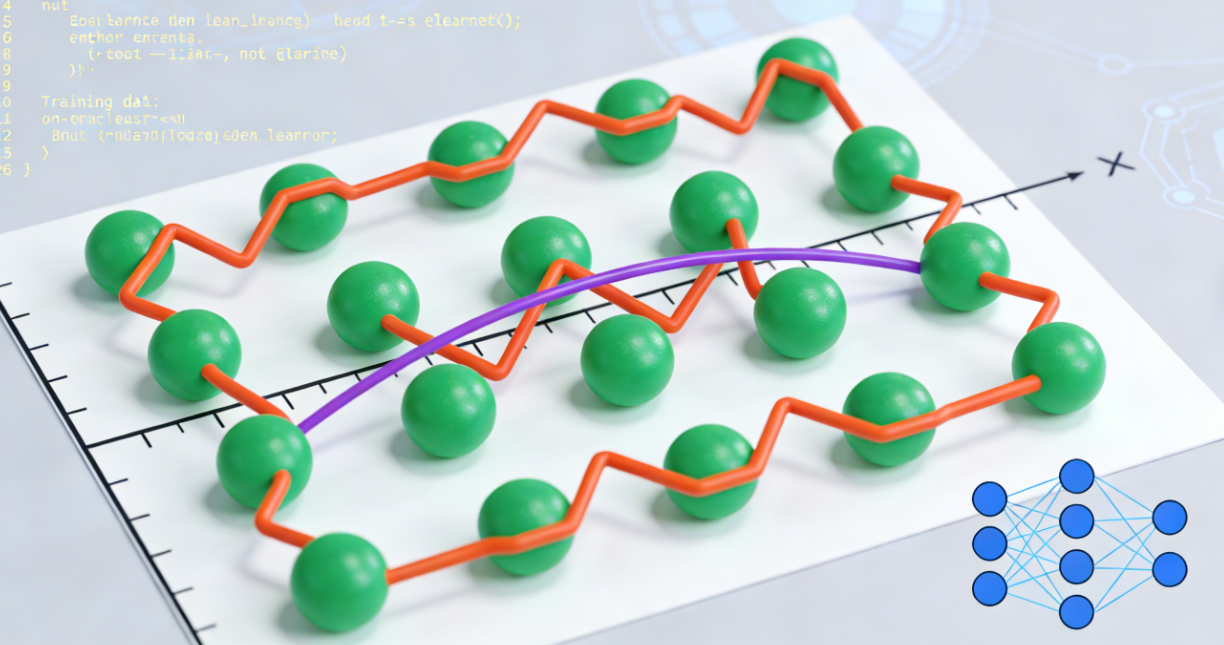

过拟合(Overfitting)是机器学习中的一个重要概念,指的是模型在训练数据上表现得很好,但在未见过的新数据(例如测试数据)上表现较差的现象。过拟合表明模型学习到了训练数据中的噪声和细节,而不是刻画了一般的规律或趋势。

过拟合的成因

- 模型复杂度过高:选择了复杂的模型(如深度神经网络、具有大量参数的线性模型等),导致模型能够记住训练数据中的每个细节。

- 训练数据量不足:只有少量的训练样本,计算出的模型可能无法代表真实的普遍规律。

- 噪声和异常值:训练数据中包含大量噪声或异常值,模型试图拟合这些错误内容。

- 不当的特征选择:包括了过多无关或无效的特征,导致模型对训练数据表现良好但对新数据泛化能力差。

识别过拟合

- 性能对比:训练误差较低,而验证误差显著较高。

- 学习曲线:绘制训练和验证集损失随训练次数的变化,如果训练集损失持续降低,而验证集损失在某一点之后开始上升,则可能存在过拟合。

解决过拟合的方法

-

简化模型:

- 选择更简单的模型,减少模型的复杂度。例如,从深度神经网络切换到浅层网络,或者使用更简单的线性模型。

-

增加训练数据:

- 收集更多的训练样本,以帮助模型更好地理解数据的整体分布。

- 使用数据增强技术(如图像变换等)来人工增加训练数据的多样性。

-

特征选择/降维:

- 选择与目标变量更相关的特征,去除无关或噪声特征。

- 使用降维技术(如主成分分析PCA)来减少特征空间的维度。

-

正则化:

- 使用正则化技术,如L1正则化(Lasso)和L2正则化(Ridge),来约束模型参数,从而限制模型的复杂性。

- Dropout技术在深度学习中非常有效,可以在训练过程中随机忽略一定比例的神经元,从而使模型更具鲁棒性。

-

交叉验证:

- 使用交叉验证(如K折交叉验证)来评估模型的性能,使模型在不同的数据子集上进行训练和验证,从而更好地评估泛化能力。

-

提前停止(Early Stopping):

- 在训练过程中定期监测验证集上的性能,当验证集损失不再下降时,停止训练。

-

集成方法:

- 采用集成学习方法(如随机森林、梯度提升等),通过组合多个模型的预测来改善性能,并降低过拟合风险。

-

调整超参数:

- 通过网格搜索(Grid Search)或随机搜索(Random Search)等方法来调整模型的超参数,选取最佳参数配置,以提高模型的泛化能力。

通过这些方法,可以有效地降低过拟合的风险,提高模型在新数据上的表现。正确地处理过拟合问题是构建一个鲁棒和可靠的机器学习模型的关键。