note

- Qwen3-TTS全面支持音色克隆、音色创造、超高质量拟人化语音生成,以及基于自然语言描述的语音控制,为开发者与用户提供最全面的语音生成功能。

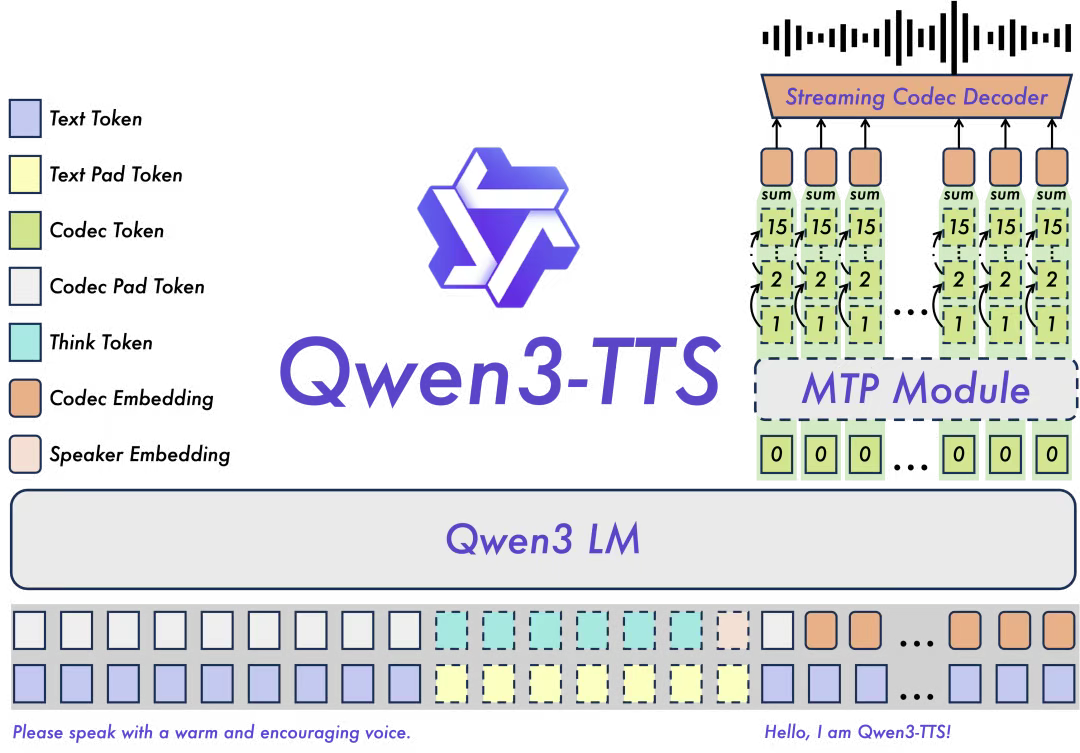

- 依托创新的 Qwen3-TTS-Tokenizer-12Hz 多码本语音编码器,Qwen3-TTS 实现了对语音信号的高效压缩与强表征能力,不仅完整保留副语言信息和声学环境特征,还能通过轻量级的非 DiT 架构实现高速、高保真的语音还原。Qwen3-TTS 采用 Dual-Track 双轨建模,达成了极致的双向流式生成速度,首包音频仅需等待一个字符。

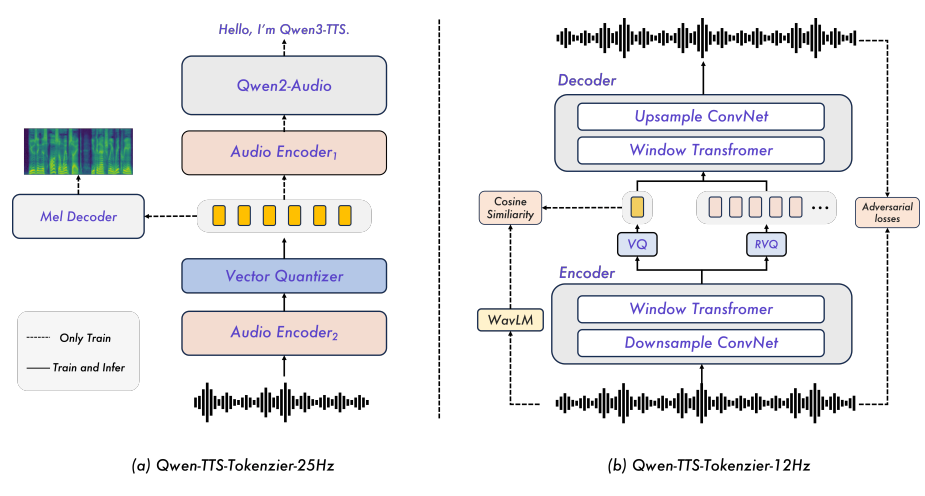

- Qwen3-TTS引入了两种类型的语音标记器,Qwen-TTS-Tokenizer-25Hz和Qwen-TTS-Tokenizer-12Hz。前者强调语义内容,后者则通过多码本设计和轻量级因果ConvNet实现超低延迟流式推理,兼顾了表达能力和实时性。

文章目录

一、Qwen3-TTS模型

ModerScope:https://www.modelscope.cn/collections/Qwen/Qwen3-TTS

HuggingFace:https://huggingface.co/collections/Qwen/qwen3-tts

Github:https://github.com/QwenLM/Qwen3-TTS

1、模型的输入类型

核心输入:文本内容(纯文字、带标点的自然语句、多语言混合文本)。

控制指令(可选):自然语言描述的音色、情感、语速、音量、方言 / 语言类型等,例如:

文本:"今天天气真好"

指令:"男生青年音,开心的情绪,语速 1.2 倍,粤语"

音色样本(可选):用于音色克隆的短音频片段(3 秒以上)。

2、模型的输出类型

核心输出:音频文件 / 音频流,主流格式为 WAV、MP3,采样率多为 24kHz/16kHz,音质接近真人。

附加输出(部分模型):韵律标记、音素数据、梅尔频谱图等,供二次开发或声学优化使用。

Qwen3-TTS是由Qwen开发的一系列功能强大的语音生成,全面支持音色克隆、音色创造、超高质量拟人化语音生成,以及基于自然语言描述的语音控制,为开发者与用户提供最全面的语音生成功能。

依托创新的 Qwen3-TTS-Tokenizer-12Hz 多码本语音编码器,Qwen3-TTS 实现了对语音信号的高效压缩与强表征能力,不仅完整保留副语言信息和声学环境特征,还能通过轻量级的非 DiT 架构实现高速、高保真的语音还原。Qwen3-TTS 采用 Dual-Track 双轨建模,达成了极致的双向流式生成速度,首包音频仅需等待一个字符。

Qwen3-TTS 多码本全系列模型均已开源,包含1.7B和0.6B两种尺寸,1.7B可以达到极致性能,具有强大的控制能力,0.6B均衡性能与效率。模型覆盖 10 种主流语言(中文、英文、日语、韩语、德语、法语、俄语、葡萄牙语、西班牙语、意大利语)及多种方言音色,满足全球化应用需求。同时,模型具备强大的上下文理解能力,可根据指令和文本语义自适应调整语气、节奏与情感表达,并对输入文本噪声的鲁棒性有显著提升。目前已经在Github上开源同时也可通过Qwen API体验。

二、模型架构

1、模型特点

主要特点:

- 强大的语音表征:基于自研 Qwen3-TTS-Tokenizer-12Hz,实现语音信号的高效声学压缩与高维语义建模,完整保留副语言信息及声学环境特征,并可通过轻量级的非 DiT 架构实现高效、高保真语音还原。

- 通用的端到端架构:采用离散多码本 LM 架构,实现语音全信息端到端建模,彻底规避传统 LM+DiT 方案的信息瓶颈与级联误差,显著提升模型的通用性、生成效率与效果上限。

- 高极致的低延迟流式生成:基于创新的 Dual-Track 混合流式生成架构,单模型同时兼容流式与非流式生成,最快可在输入单字后即刻输出音频首包,端到端合成延迟低至 97ms,满足实时交互场景的严苛需求。

- 智能的文本理解与语音控制:支持自然语言指令驱动的语音生成,灵活调控音色、情感、韵律等多维声学属性;同时深度融合文本语义理解,自适应调节语气、节奏、情感与韵律,实现"所想即所听"的拟人化表达。

2、tokenizer

Qwen-TTS-Tokenizer-25Hz:该标记器采用25 Hz的单码本表示,通过块流匹配实现波形重建。为了支持流式解码,提出了一种滑动窗口块注意力机制,限制每个标记的上下文范围。

Qwen-TTS-Tokenizer-12Hz:该标记器采用12.5 Hz的多码本方案,结合了语义和声学线索。通过轻量级因果卷积网络(ConvNet)实现波形重建,支持超低延迟流式推理。

训练过程:训练过程分为预训练和后训练两个阶段。预训练包括三个阶段:一般阶段(S1)、高质量阶段(S2)和长上下文阶段(S3)。后训练包括三个阶段:直接偏好优化(DPO)、基于规则的奖励和轻量级说话人微调。

三、模型效果

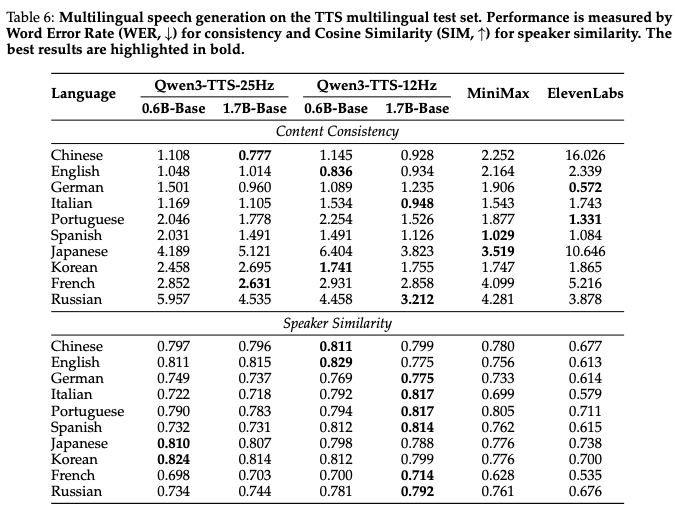

实验评估分为语音标记器和语音生成两个主要类别。语音标记器的评估包括自动语音识别(ASR)任务,语音生成的评估包括零样本语音生成、多语言语音生成、跨语言语音生成、可控语音生成、目标说话人语音生成和长语音生成。

对 Qwen3-TTS 在音色克隆、创造、控制等方面进行了全面评估,结果显示其在多项指标上都达到了SOTA性能。具体来说:

- 音色创造任务上,Qwen3-TTS-VoiceDesign 在 InstructTTS-Eval 中指令遵循能力和生成表现力都整体超越 MiniMax-Voice-Design 闭源模型,并大幅领先其余开源模型。

- 在音色控制任务上,Qwen3-TTS-Instruct 不仅具备单人多语言的泛化能力,平均词错率 2.34%;同时具备保持音色的风格控制能力,InstructTTS-Eval 取得了 75.4% 的分数;此外,也展现出卓越的长语音生成能力,一次性合成 10 分钟语音的中英词错率为 2.36/2.81%。

- 在音色克隆任务上,Qwen3-TTS-VoiceClone 在 Seed-tts-eval 上中英文克隆的语音稳定性表现上均超越MiniMax和SeedTTS;在 TTS multilingual test set 上 10 个语项上取得了 1.835% 的平均词错误率和 0.789 的说话人相似度,超越 MiniMax 和 ElevenLabs;跨语种音色克隆也超越 CosyVoice3 位居 SOTA。

比如多语言语音生成任务评测:

Reference

1\] [Qwen3-TTS全家桶开源上线](https://mp.weixin.qq.com/s/96-RgV4jAimmvREYaM9N3Q) \[2\] ModerScope:https://www.modelscope.cn/collections/Qwen/Qwen3-TTS HuggingFace:https://huggingface.co/collections/Qwen/qwen3-tts Github:https://github.com/QwenLM/Qwen3-TTS \[3\] https://arxiv.org/pdf/2601.15621