目录

[方法论:从 ELBO 推导出自监督和判别式监督联合学习框架](#方法论:从 ELBO 推导出自监督和判别式监督联合学习框架)

前言

在工业级推荐系统的实际应用中,用户偏好会随时间动态变化,这就要求模型必须持续更新以适应数据分布的变化。理想情况下,经过充分训练后的模型能够准确预测用户行为。然而现实情况是:虽然模型在每日新增数据上的训练AUC持续提升,但在未来样本上的预测性能却会出现断崖式下跌,呈现出类似"过拟合"每日数据的情况。特别是在电商平台大促期间,数据分布的剧烈波动往往导致模型表现显著下降。

针对推荐模型在持续训练中的"记忆衰退"问题,以及如何帮助模型在数据分布迁移中有效提取关键信息这一挑战,Shopee傅聪团队与新加坡管理大学(SMU)合作,深入研究了工业级推荐系统的数据分布迁移规律,并据此提出了一种与模型架构无关的学习框架------ELBO_TDS(面向时序分布变化的证据下界目标)。

这项研究成果一经发表,立即引起了人工智能领域核心平台Hugging Face的高度关注。作为业界公认的重要开源平台,Hugging Face主动邀请傅聪团队将研究成果上传至其平台:论文收录至论文库,配套的推荐系统时间分布偏移工业基准数据集则托管至数据集平台。这一举措充分印证了该研究在理论创新与工程实践领域的双重价值。

傅聪团队的研究方法从真实场景数据分析出发,重新解读了推荐系统场景下,用户交互数据的 "生成过程",并提出了一种 ELBO 建模目标,将增强表征时间尺度鲁棒性的自监督学习,与训练模型个性化能力的标签监督学习,无缝统一在了一个因果学习框架中,为持续学习、甚至 life-long 学习提供了一个新的视角。

正文

时间维度分布迁移分析:改写推荐系统数据认知

推荐数据在时间维度上的分布漂移会阻碍模型的稳定学习,尤其是在 Shopee 的场景,每月一大促、半月一小促的周期让模型的训练 AUC 曲线如同 "过山车"。想要解决问题,首先需要理解问题的本质。

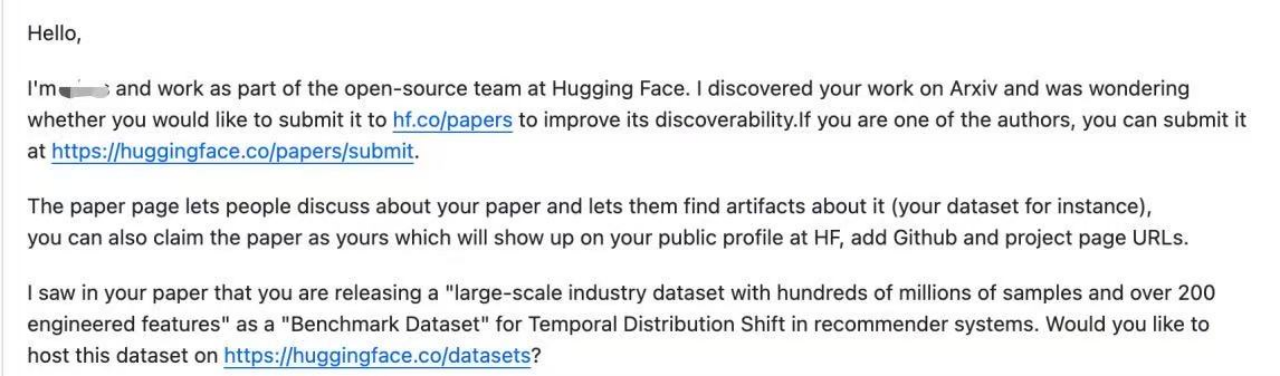

论文对 30 天周期的训练数据进行了深入分析,将部分结果可视化后,如下图所示:

推荐系统模型的训练数据本质上是用户行为与各类特征的组合记录。在特征工程领域,最常用的特征主要分为三类:统计特征、类别特征和序列特征。这些特征在迁移过程中的表现可归纳为以下规律:

-

统计特征(如商品近3天点击率CTR)的item CV分布呈现单峰形态。CV(变异系数)用于衡量数值波动程度,单峰分布表明该特征具有"边界效应"------即特征值在绝大多数情况下保持稳定,出现极端异常值的概率较低。

-

序列特征中,与目标商品关联的item数量(如在swing商品关系图中存在连接边的关联商品数)的CV分布同样呈现左偏单峰形态。

-

类别特征(如商品ID、用户ID)的分布特性表现为:跨天JSD(衡量分布差异的香农熵)呈现缓慢增长趋势。以商品ID为例,相邻两天的JSD值稳定在0.53左右,而从第0天到第13天的累积JSD仅增长至0.59。

从上面的数据分析我们可以看出,任意一种特征的数值或分布,在天与天之间切换时,都呈现了不弱的抖动(CV 数值在 2~4)。但长周期来看,数值的波动烈度又是相对稳定的(CV 单峰、JSD 增长缓慢)。

这像极了一拳超人的绝技:超级反复横跳。

为什么数据会 "反复横跳" 呢?这个横跳过程中的那个相对稳定的 "均值" 又代表什么呢?

一般情况下,可以假定参与到推荐系统 "协同过滤" 过程的用户,是 "理性" 和 "感性" 掺杂的个体,但多数情况下理性占主导,尤其是电商场景,涉及到真实交易支付。一个商品的质量等本质属性不会突变,所以不会今天畅销、明天滞销、后天又畅销;同样,一个用户,也可以认为其文化背景、生活环境、年龄履历、经济状况,不会经常突变。因此,论文认为,这个稳定的均值代表参与到推荐系统的对象(用户和物品)的 "稳定内核",而横持续跳着的 "方差",则是由各种因素带来的 "干扰",例如社交媒体的流行趋势、热点讯息、用户不定期的访问习惯、广告促销、系统 Bias 和不确定性等等。

由此看来,我们需要对推荐系统的数据模型 进行重新认知。

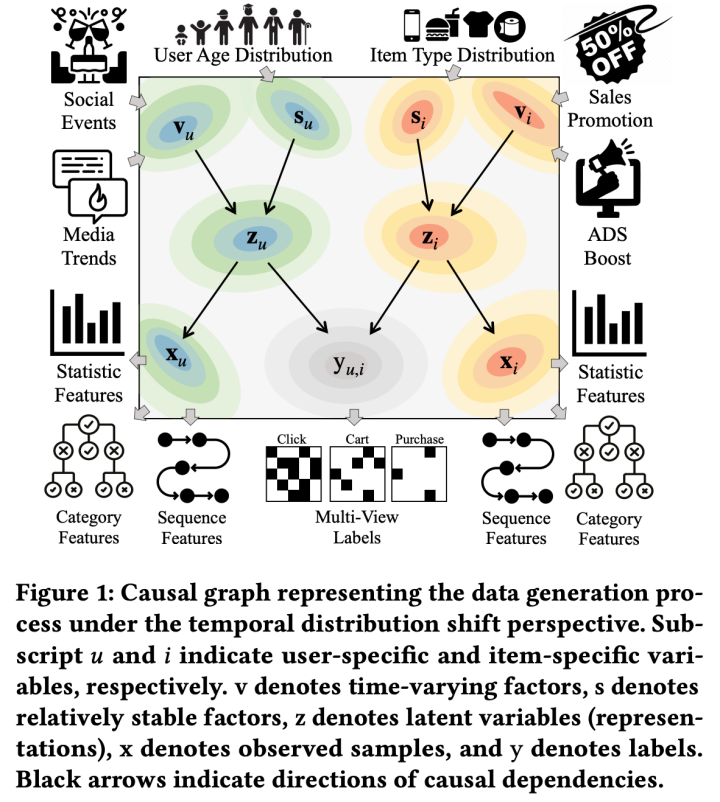

传统的理解里,推荐模型建模的是 P(Y|X),把 X 作为数据的 "真实",以此 X 来推断标签 Y,那么数据的 "因果" 流向是 X -> Y。但论文认为,X 中的绝大多数 "手工特征" 是对真实属性、偏好的带噪声的表达,而不是数据的 "真实"。那么,推荐系统的真实数据生成过程可能是下面这张图:

论文认为参与到推荐系统的对象 ------ 用户和物品都包含两面性。一种是稳定因素,代表对象的内核、本质,例如商品的类目、质量、功能,或用户的性别、年龄段(相对稳定)。另一种是波动因素,代表对象的表象、某种视角的观测,例如商品的销量一般会持续上涨至其生命周期结束,用户的即时兴趣会收到社会属性的影响。

为了方便建模,论文方法引入隐变量 Z。这个视角下的数据生成过程,或者因果关系,是稳定因素 S 和波动因素 V 共同作用于隐变量,即 S -> Z,V -> Z。而再经由 Z,形成了大家对数据表象的观测 X 和 Y,即 Z -> X, Z -> Y。

因此,论文方法希望模型能够捕捉到 Z 的分布,从而建模好 X 和 Y 的联合分布。因此,论文方法追究的这个过程,更接近与 "生成式建模" 的思路(注,不同于目前业界很多所谓的生成式推荐,其本质都还是建模条件分布 P(Y|X),严格意义上属于判别式模型)。

方法论:从 ELBO 推导出自监督和判别式监督联合学习框架

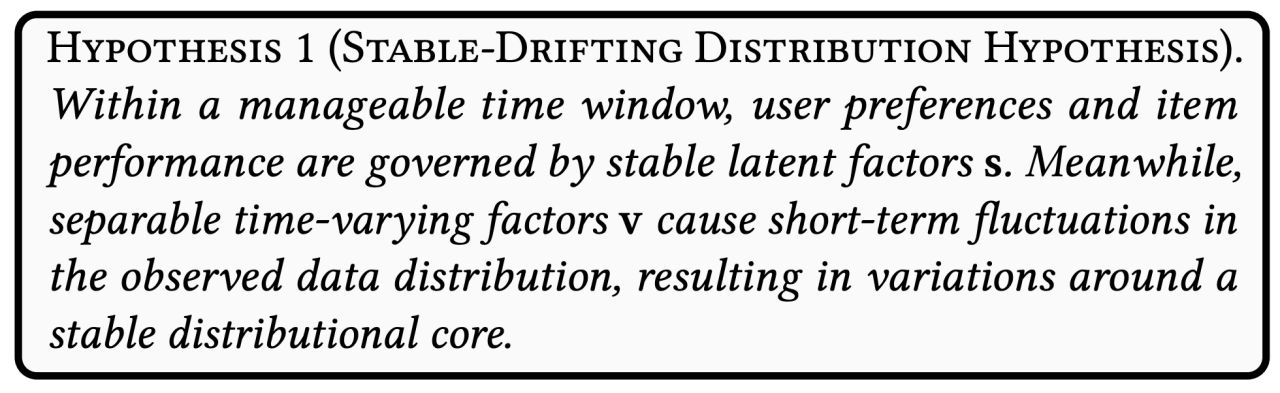

首先,论文基于对数据的观察总结提出了稳态 - 波动假设:

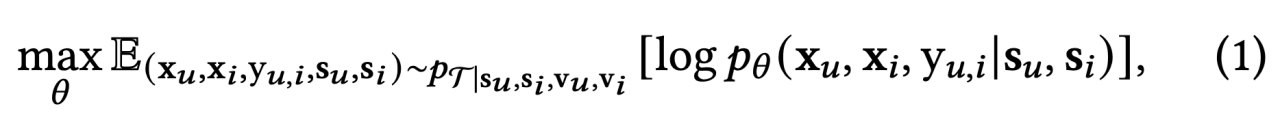

接着,基于这个假设,论文方法希望模型建模联合分布的时候可以过滤掉波动因素 V 的干扰,从而让预测更稳定,从这个角度来看,论文提出了以下极大似然估计目标:

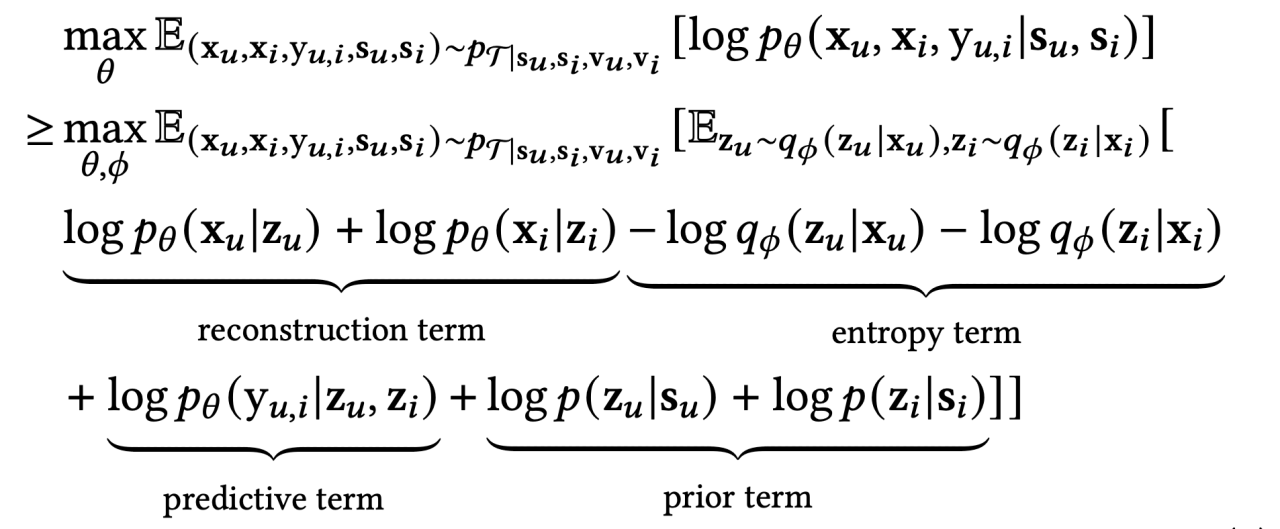

这个目标的含义是,从一个带有噪声 V 的数据分布上采样得到样本,但让模型试图仅仅学习 given 稳定因素 S,X 和 Y 的联合概率分布。上述目标不可直接优化,为了方便 VAE 形式的建模,引入隐变量 Z,稍加推导,可以得到新的目标 ELBO:

这个 ELBO 包含 4 个小项目,从语义理解看:

- 重构项:从隐变量 Z 重构出样本 X,

- 熵约束项:对隐变量 Z 的方差进行有效约束,保证表征坍塌。

- 预测(判别式)项:从隐变量 Z 预测标签 Y。

- 先验约束:使得隐变量 Z 尽可能只与稳定因素 S 有关,从而让表征 Z 具备应对时间维度分布迁移的鲁棒性。

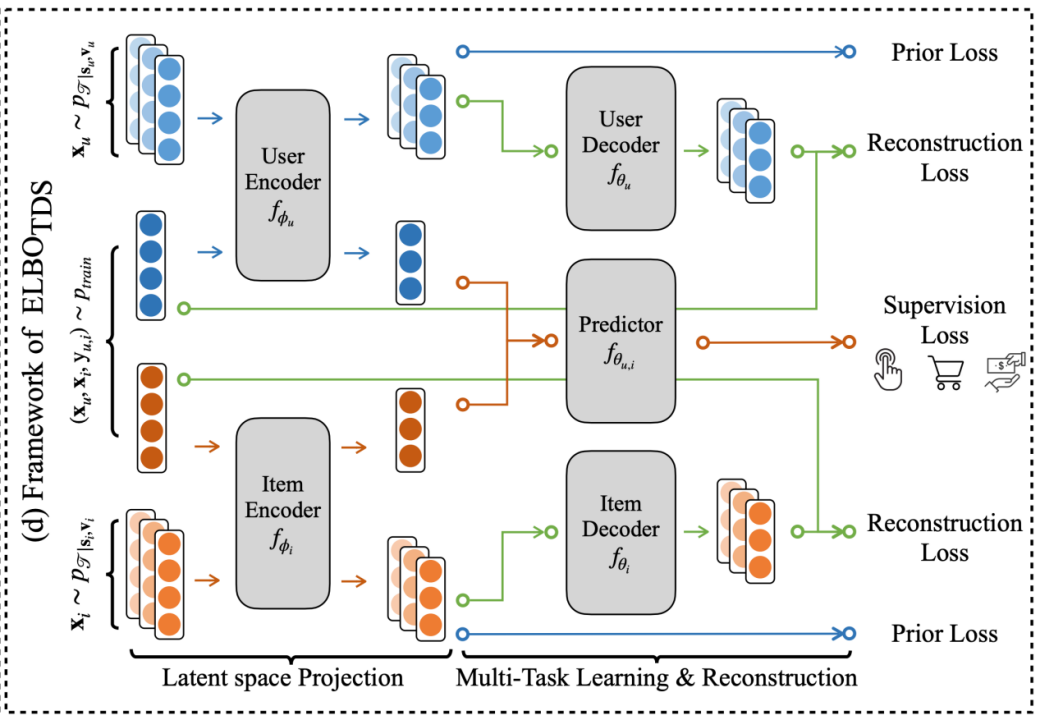

优化上述 ELBO,模型就可以得到具有这样特性的表征 Z,既包含了重构 X 的能力,最大限度的保留信息,防止表征坍塌;又保留了有助于判别式任务的有效信息,助力下游任务;还排挤掉了与 V 有关的信息,强化了应对时间分布迁移(Temporal Distribution Shift,TDS)的鲁棒性,可以说是全能表征。更具体地,模型的训练框架如下:

多视图数据增强策略

从上述模型结构图可以看到,模型的输入包含带有波动因素 V 的数据样本。获得这样的样本,最简单的方法就是,从历史样本中获取和构造。然而,这样做费时费力非存储不说,还有一个非常严重的缺点,就是 One-Epoch 过拟合问题。

所谓 One-Epoch 过拟合问题,是在工业界不同场景被广泛发现的问题:模型在同一天数据上训练超过一次就容易过拟合到当天样本,造成预测未来时间的样本的 AUC 明显下降。

为了不产生类似的问题,论文提出了在线增强策略,针对不同类型的特征:

- 统计类型 的特征进行数据分桶(工业界常规操作),增强视图样本则通过扰动真实样本产生,根据之前的数据观测分析,可以把真实样本的桶号随机扰动到其附近的分桶号上。

- 类比类型的特征,随机替换或者 zero mask。

- 序列类型的特征,对序列 item 进行随机 mask

上述操作随机进行多次,可以得到一条样本的多个 "视图"。这就好像图片预训练模型的随机裁剪、旋转、变色等数据增强操作。

上述样本生成过程不需要参考历史样本,可以在训练时并行计算,对样本训练带来的成本几乎可忽略不计。

实验数据和结果分析

推荐系统数据的时间分布迁移(TDS)是一个新兴且小众的研究领域,相关可比较的方法较少。本研究重点关注与该领域最相关的机器学习方向------不变性学习(Invariant Learning 或 Invariant Risk Minimization for covariant shift)。相比之下,传统推荐模型通常隐含着数据分布随时间保持独立同分布(i.i.d.)的假设,这类方法可统称为经验风险最小化(ERM)。此外,研究还将相似的对比学习自监督方法,以及从图像预训练领域迁移到搜索推荐领域的Dino方法,统一纳入基线模型进行比较。

实验在公开数据集和工业级数据上均进行了验证。公开数据集的选择受到以下限制:首先,要对特征进行有效"扰动"需要理解其特征语义;其次,数据采集需要保证时间连续性,避免用户偏好发生显著偏移;最后,数据不能经过主观性强的过度采样,以免导致分布失真。因此,传统推荐基准数据集如Amazon Reviews和MovieLens存在时间跨度长且不连续、采样过度的问题;而AliCCP、AE等电商数据则面临时间戳不明确、特征含义模糊的挑战。最终选用快手发布的kuairand系列数据。针对该数据集因用户访问频率不稳定导致的时间区间分布不均问题(例如4-5月间多个自然日无数据),我们按时间戳排序后将数据重新等分为数量相近的若干部分,定义为虚拟"自然日"数据。

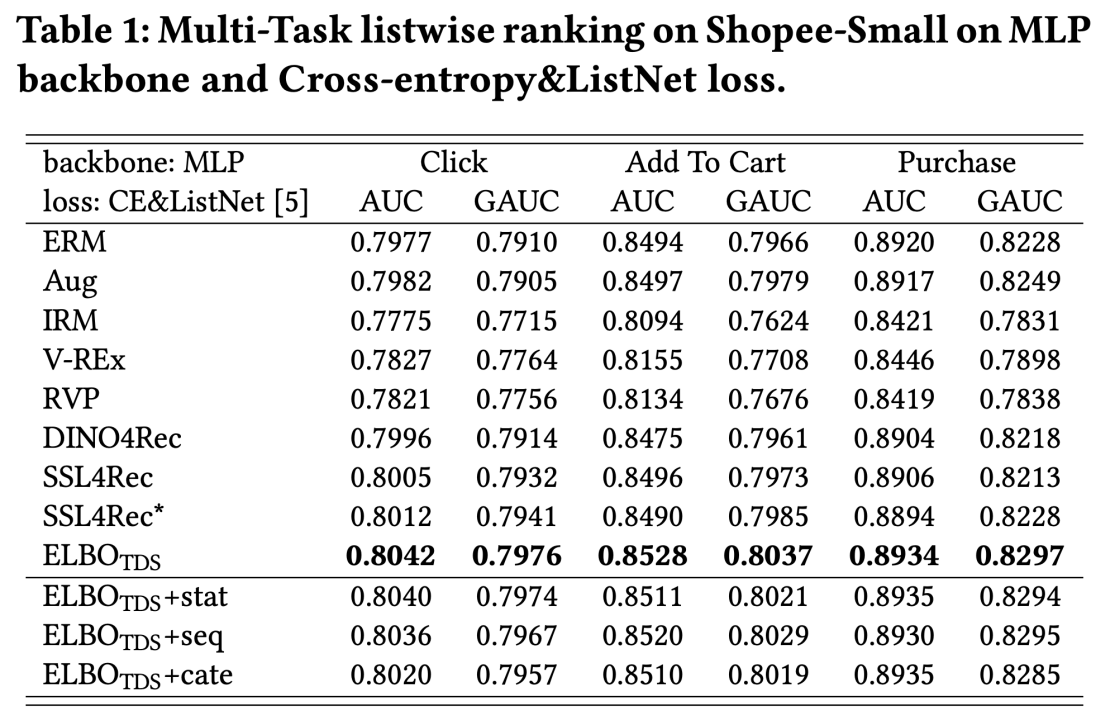

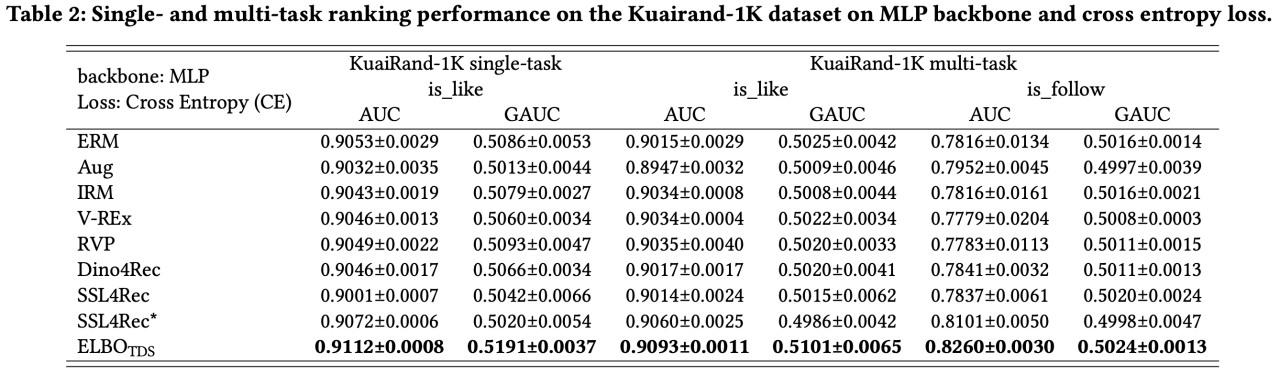

实验结果如下:

首先,从上述数据我们可以看到论文提出的 ELBO_TDS 框架,相较于 baseline,均取得了显著提升。这说明 ELBO_TDS 可以有效低去除数据中与用户核心兴趣无关、与时间迁移有关的噪声,从而更好地预测用户的偏好。

其次,ELBO_TDS 在视频、电商两类模态的数据上均取得有效提升,也说明了 TDS 问题在各类推荐系统中广泛存在。

另外,IRM 类方法例如 IRM、V-REx、RVP 等效果均低于在数据上增量训练的 ERM(模拟现实推荐场景的天级更新)。说明 TDS 问题不是传统的 IRM 问题,需要有新的解决方案。

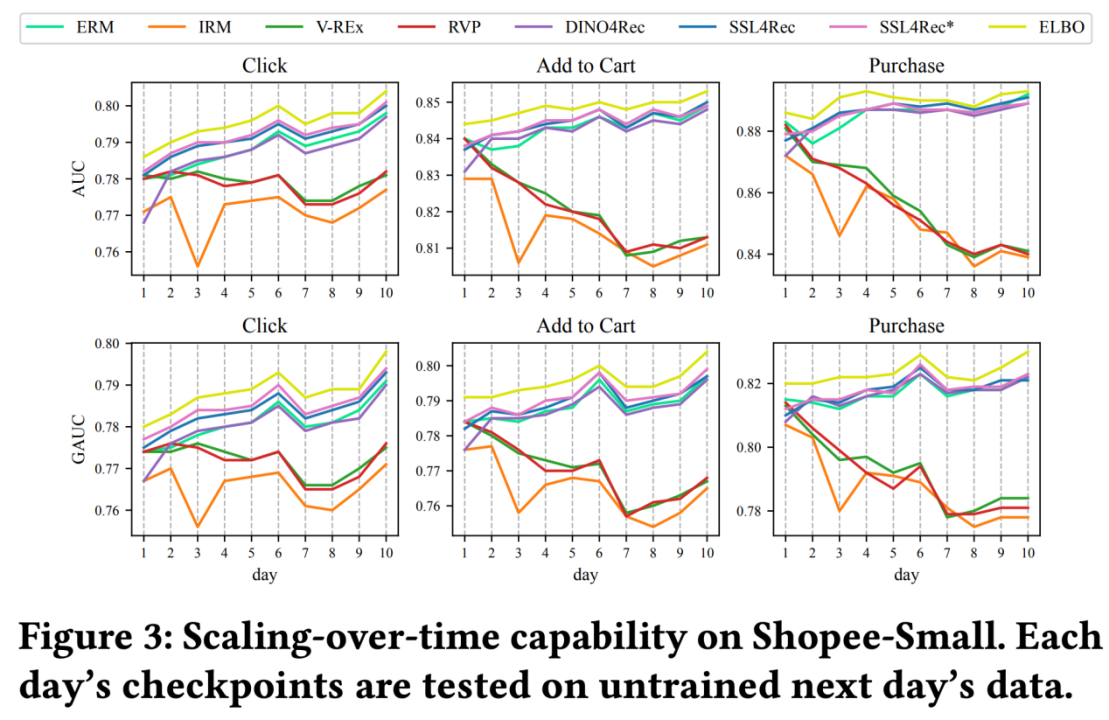

因为所有方法都是按照时间顺序,在数据的一个一个 partition 上增量训练的,我们用 "前一天" 的 checkpoint 去预测 "下一天" 的位置样本,将曲线画了出来:

我们可以看到,ERM、自监督、以及 ELBO_TDS 都是随着时间训练,表现越来越好;但 IRM 类方法基本都是越训练越差。

这是因为 IRM 类方法假设数据集的不同 partition 之间存在绝对不变的 "内核",试图用某种 regularization + 对其它 partition 数据的重复访问,来学到这个 "绝对不变" 的隐变量。然而,这个假设并不适用于搜推广的情形。从理论上,TDS 不是单纯的 covariant shift 的问题,TDS 不假设稳定因子 S 绝对不变。从经验分析上,论文的数据分析也表明,除了剧烈波动的 V 因子,S 因子也在随着时间漂移,只是相对来说非常缓慢。

针对 covariant shift 的 IRM 类方法失效的原因,一方面是 "不允许" 用户偏好迁移,这与任务目标违背;另一方面是参考了 "历史" 数据 partition,触发了搜推广常见的 one-epoch 过拟合问题。

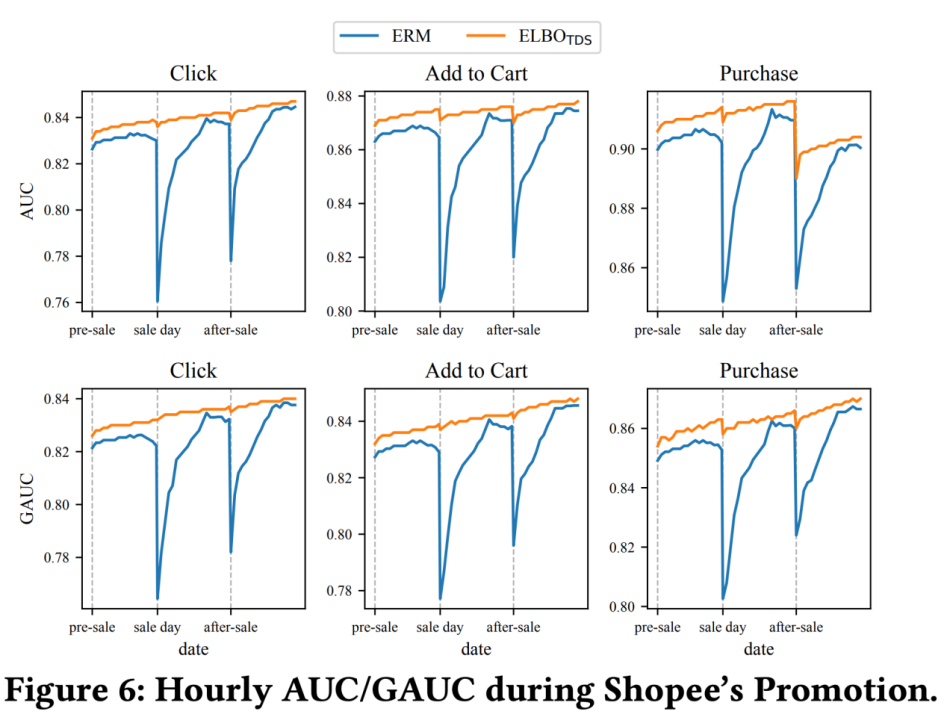

ELBO_TDS 的另一个优势在于,对大促来带的剧烈数据分布地震不敏感:

线上采用的ERM方法(Baseline)即便采用小时级更新策略进行快速分布适应,仍在大促前后的关键时段出现AUC指标断崖式下跌,影响了大促前几小时的收入表现。相比之下,ELBO_TDS方案则实现了近乎无损的效果。在为期两周的实验中,ELBO_TDS最终实现了2.33%的GMV/用户提升并完成全量上线。