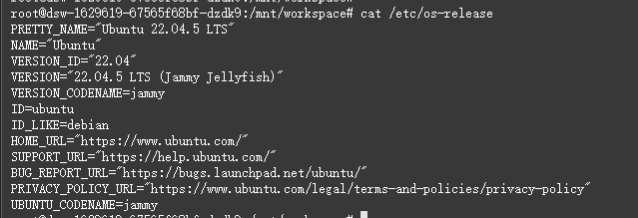

cat /etc/os-release

Ubuntu 22.04.5 LTS (Jammy Jellyfish) ------ 这是一个长期支持(LTS)且完全受支持的现代 Linux 发行版 ,非常适合部署 llama.cpp + llama-server。Ubuntu 22.04 自带较新的 GCC(11+)、CMake(3.22+)和 Python 3.10+,无需手动升级工具链,部署过程非常顺畅。

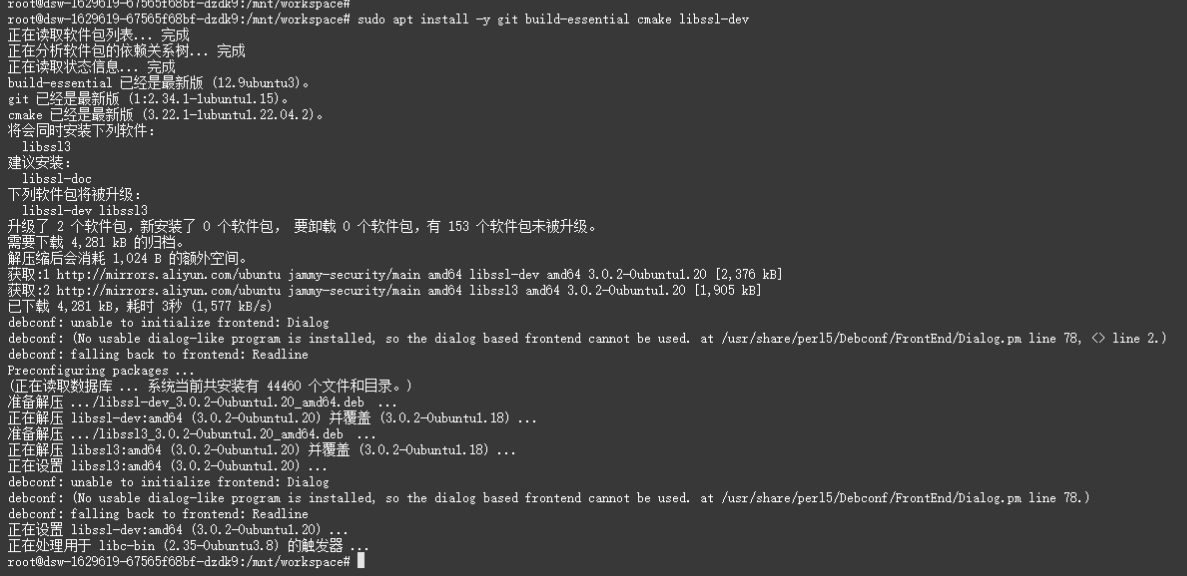

一、安装系统依赖

sudo apt update

sudo apt install -y git build-essential cmake libssl-dev

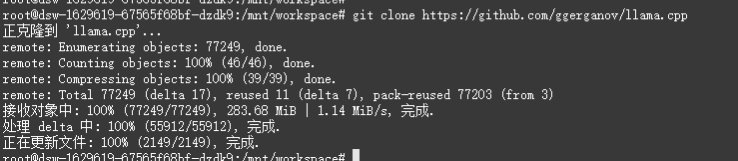

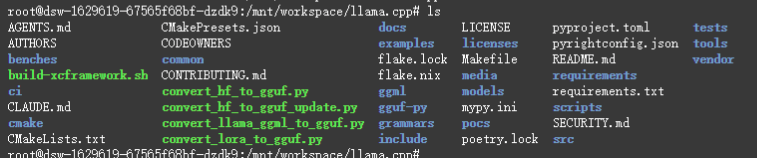

二、克隆并编译 llama.cpp

1. 克隆仓库

git clone https://github.com/ggerganov/llama.cpp

cd llama.cpp

步骤 3:使用 CMake 构建 server

mkdir build

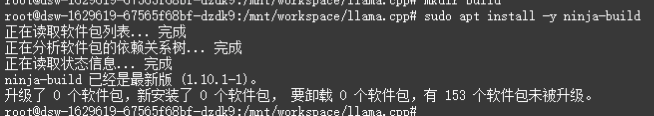

sudo apt install -y ninja-build

cd build

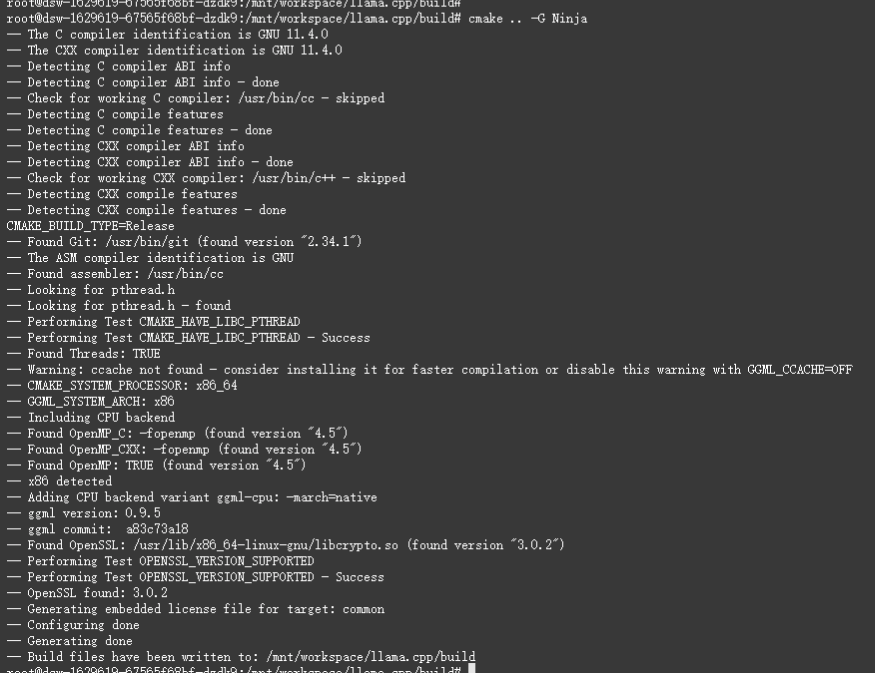

cmake .. -G Ninja

ninja server 报错了

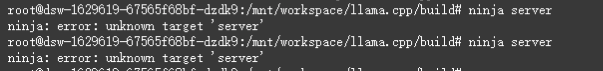

rm -rf build

重新来

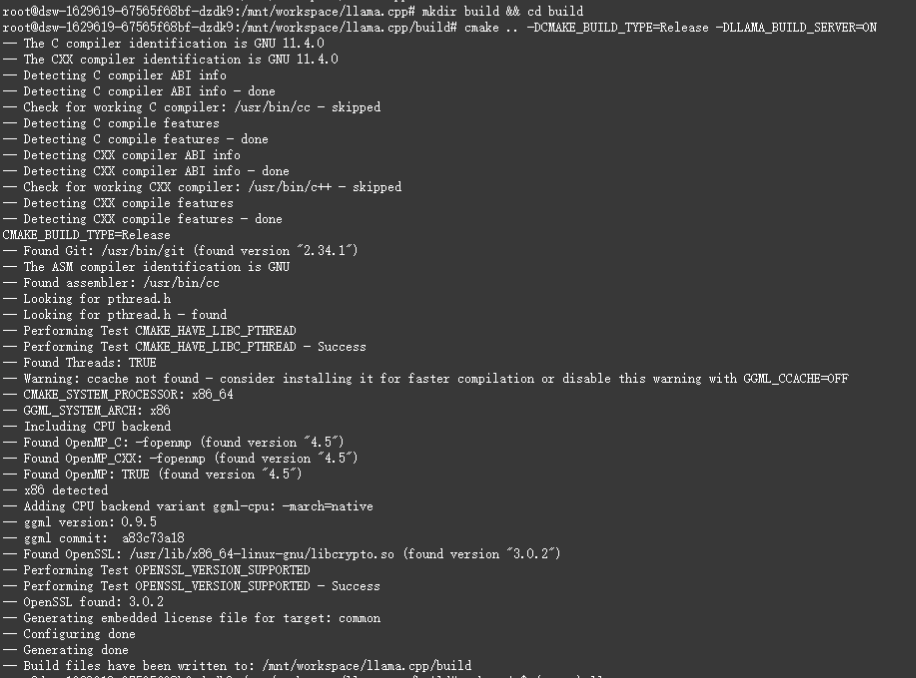

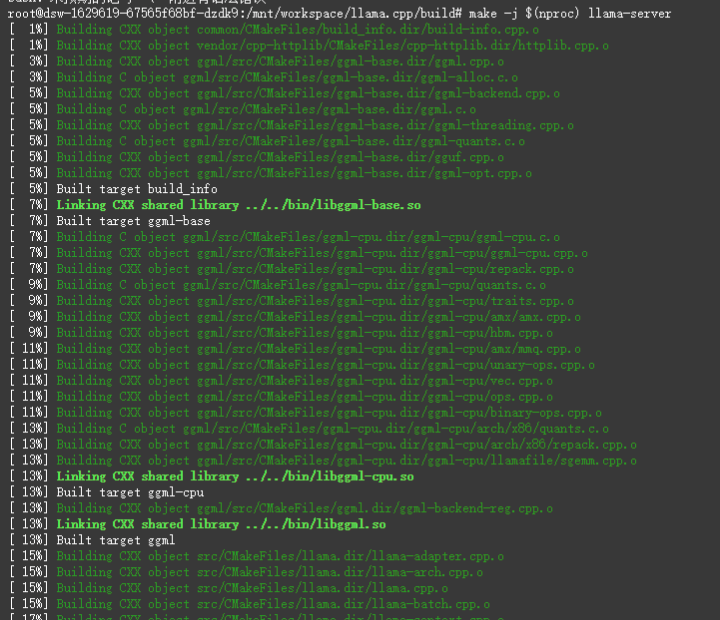

mkdir build && cd build

cmake .. -DCMAKE_BUILD_TYPE=Release -DLLAMA_BUILD_SERVER=ON

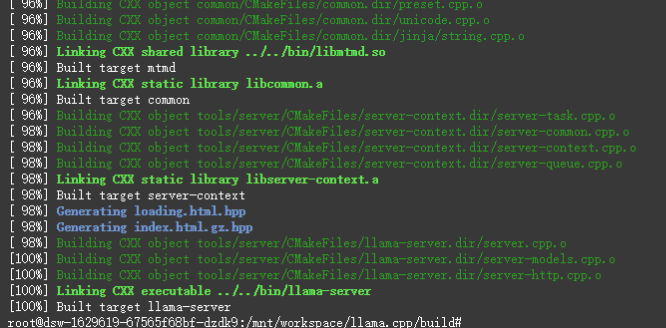

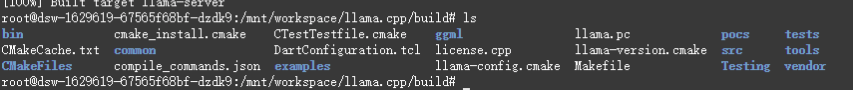

make -j $(nproc) llama-server

三、准备 GGUF 模型

下载量化模型(以 Llama-3-8B-Instruct Q4_K_M 为例)

cd /mnt/data/

启动

./bin/llama-server -m /mnt/data/model.gguf --port 8080 --host 0.0.0.0