本文系统地梳理了YOLO系列实时目标检测架构 从2016年诞生到2026年预见性的十年演进历程。文章核心聚焦于从传统的"分治法"向端到端单回归模型 的哲学转变,详细解析了各代版本如何通过优化主干网络、引入锚框机制 及后续转向无锚框设计 ,在检测精度与推理速度之间寻找动态平衡。技术演进的主线涵盖了重参数化技术 、梯度信息保护以及最终消除非极大值抑制(NMS)计算瓶颈的工程突破。本文不仅提供了各版本核心贡献与局限性的横向对比,更洞察了实时检测器正朝着硬件感知设计与极致推理效率发展的未来工业趋势。

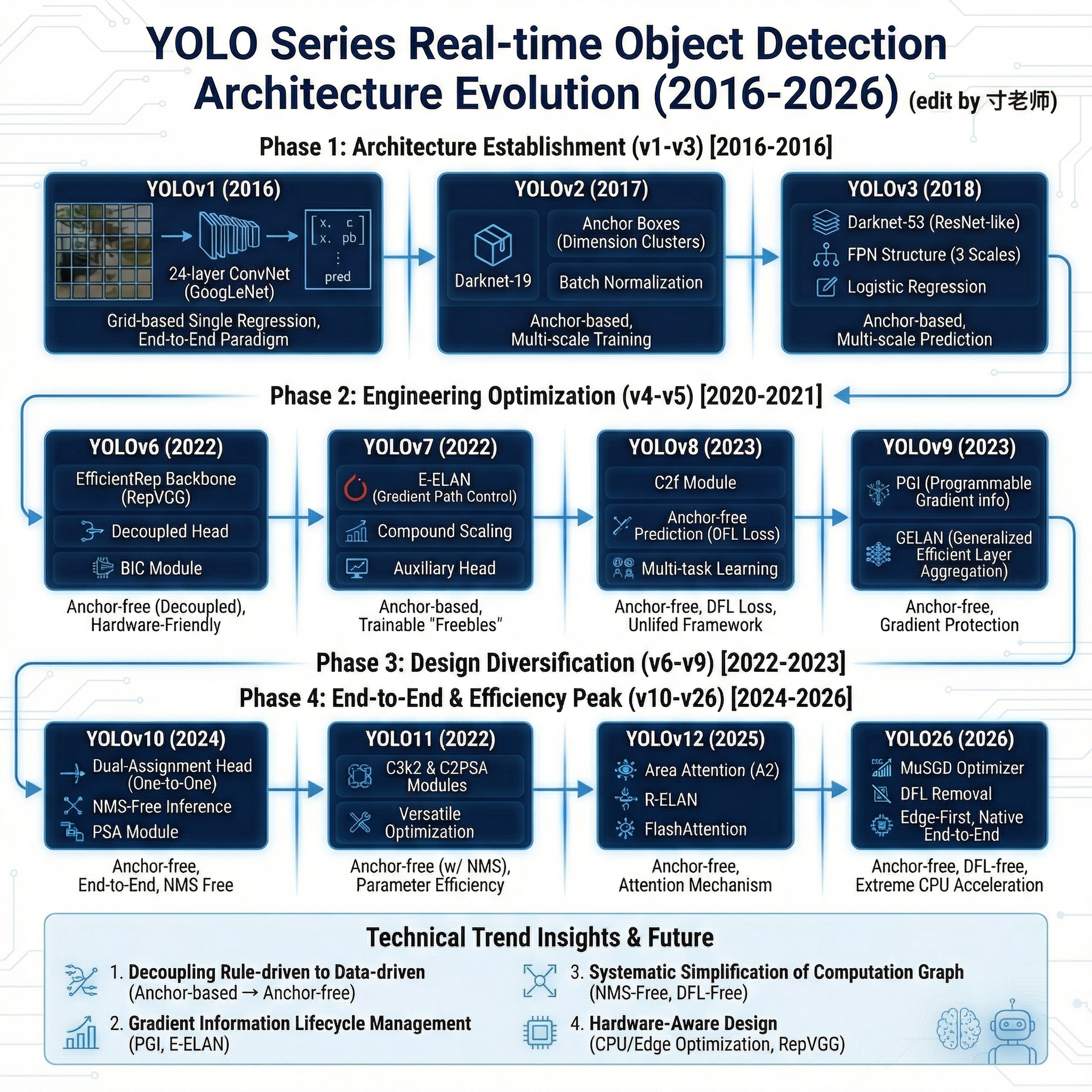

先放上一张精心绘制的演变路线图:

实时检测范式的起源:从区域提议到统一回归的哲学转变

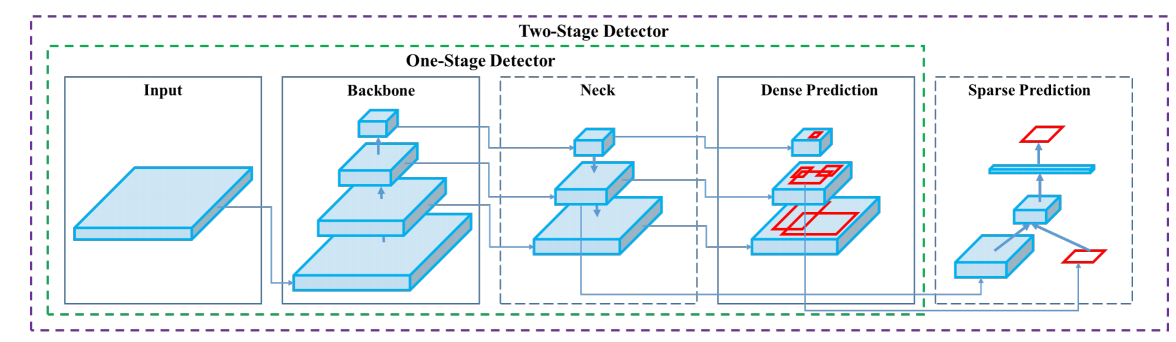

实时目标检测领域的发展史可以被视为一场在精度、速度与计算资源之间寻找最优平衡的长期探索。在二阶段检测器如R-CNN系列主导的早期阶段,检测任务被拆分为候选区域提取与分类回归两个独立的计算密集型步骤,这种设计虽然保证了检测质量,但难以满足自动驾驶或机器人等领域的实时性需求 [1, 2, 3]。2016年,Joseph Redmon等人提出的"You Only Look Once"(YOLO)模型彻底颠覆了这一现状,其核心思想是将目标检测重新定义为一个单一的回归问题,通过一个全卷积神经网络直接从原始图像像素预测边界框及类别概率 [1, 4, 5, 6]。

这种从二阶段(Two-stage)到一阶段(One-stage)的范式演进,体现了计算机视觉领域从"分治法"向"端到端学习"的哲学转变 [2, 3, 5]。YOLO系列后续长达十年的迭代过程,始终贯穿着这一主线:如何通过改进主干网络(Backbone)、增强颈部特征聚合(Neck)、优化预测头(Head)以及改进训练策略(Bag of Freebies),使模型在极低的延迟下依然能捕捉到图像中复杂的语义信息 [1, 7, 8, 9, 10]。

整体演进思想的纵向综述

YOLO系列的整体演进路线可以被提炼为四个关键技术阶段。第一阶段是"架构建立期"(v1-v3),确立了网格预测、锚框机制(Anchor-based)和多尺度特征融合的基础框架 [2, 4, 11, 12]。第二阶段是"工程优化期"(v4-v5),通过系统性引入数据增强、跨阶段局部连接(CSP)和更成熟的训练流程,使模型在工业界大规模落地 [4, 13, 14, 15, 16]。第三阶段是"设计多样化期"(v6-v9),重参数化技术(RepVGG)、高效层聚合(ELAN)以及针对梯度信息丢失的深入研究(PGI)成为了技术重心,同时也完成了从锚框到无锚框(Anchor-free)的重大转型 [4, 8, 17, 18, 19, 20]。第四阶段是"端到端与效率巅峰期"(v10-YOLO26),其目标是消除最后的手后处理瓶颈------非极大值抑制(NMS),并引入注意力机制与大语言模型优化技术,实现极致的推理效率 [7, 21, 22, 23, 24, 25]。

下表总结了YOLO系列关键版本的核心技术变迁,体现了从初创到现代智能架构的跨越式发展:

| 版本 | 核心架构特色 | 预测模式 | 关键贡献 | 推理瓶颈 |

|---|---|---|---|---|

| YOLOv1 | GoogLeNet启发, 24层卷积 | 网格化单回归 | 开创实时一阶段检测范式 [1] | 小目标与密集场景精度差 [6] |

| YOLOv2 | Darknet-19, 引入锚框 | Anchor-based | 维度聚类, 批归一化 [26] | 多尺度处理能力不足 [11] |

| YOLOv3 | Darknet-53, FPN结构 | Anchor-based | 残差连接, 三尺度预测 [12] | 结构逐渐臃肿, 速度略降 [12] |

| YOLOv4 | CSPDarknet, Mosaic增强 | Anchor-based | 系统化BoF/BoS优化策略 [14] | 架构复杂度极高 [18] |

| YOLOv5 | PyTorch原生, C3模块 | Anchor-based | AutoAnchor, 极致工程化 [15] | 依赖NMS后处理算力 [7] |

| YOLOv7 | E-ELAN, 复合缩放 | Anchor-based | 梯度路径控制, 训练优化 [18] | 手动锚框超参调优复杂 [19] |

| YOLOv8 | C2f模块, 解耦预测头 | Anchor-free | 无锚框预测, DFL损失函数 [15] | NMS后处理延迟波动 [7] |

| YOLOv10 | 一对一匹配, PSA模块 | Anchor-free | 真正实现端到端NMS-Free推理 [21] | 极端重叠场景精度波动 [27] |

| YOLO26 | MuSGD优化器, DFL移除 | Anchor-free | 彻底消除DFL, 极致CPU加速 [24] | 尚未经过大规模长期验证 [28] |

1.奠基之作:YOLOv1与一阶段检测的开端

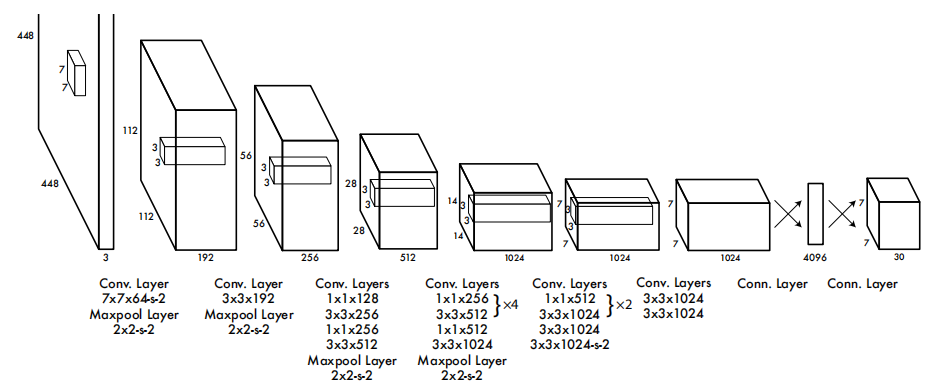

YOLOv1的出现标志着目标检测从"先搜索再分类"进入了"全局预测"时代。其模型原理基于将输入图像划分为 S ×S 的网格,每个网格单元负责预测中心点落在该单元内的目标 [2, 5, 11]。

1.1 模型原理解析

以前的检测(如R-CNN)是"看两眼"(先找框,再分类)。YOLO v1创造性地将图像划分为 S × S S \times S S×S 的网格(Grid)。如果物体的中心落在某个网格中,该网格就负责预测该物体。

在YOLOv1的输出张量中,每个网格包含 B B B个边界框的坐标 、置信度得分以及 C C C个类别的概率预测 [11, 29]。置信度反映了模型对该框包含物体的把握程度及其定位的准确性: C o n f i d e n c e = P ( O b j e c t ) × I o U p r e d t r u t h Confidence=P(Object)\times\mathrm{IoU}{pred}^{truth} Confidence=P(Object)×IoUpredtruth[29]。主干网络受GoogLeNet启发,使用了24个卷积层后接两个全连接层。为了使模型能够同时兼顾回归和分类,损失函数采用了误差平方和公式,并赋予坐标预测更高的权重 λ c o o r d = 5 \lambda{coord}=5 λcoord=5,而对不含目标的网格预测赋予较低的权重 λ n o o b j = 0.5 \lambda_{noobj}=0.5 λnoobj=0.5,以平衡样本分布 [6, 29]。

1.2 存在的问题与历史局限性

虽然YOLOv1在速度上达到了惊人的45 FPS,但在实际应用中暴露出显著的弱点 [4, 11]。由于每个网格只能预测一个类别的物体,模型在处理密集物体(如鸟群)时力不从心 [6, 11]。此外,它对小目标的泛化能力较差,且边界框回归的准确度明显逊色于同时代的Faster R-CNN,这主要是因为直接回归绝对坐标在模型训练初期极不稳定 [1, 11, 26]。

2.锚框机制的引入:YOLOv2与YOLO9000

为了解决v1定位不准和召回率低的问题,Joseph Redmon于2017年发布了YOLOv2(YOLO9000)。 引入了大量当且仅时髦的"炼丹技巧",重点解决了召回率低和定位误差大的问题。。这一版本引入了锚框(Anchor Boxes)的概念,将原本的直接坐标回归转变为基于先验形状的偏移量回归 [4, 11, 26]。

2.1 相比v1的改进与模型原理

YOLOv2在架构上实现了"全卷积化",移除了最后的全连接层,从而支持多尺度训练(从320到608像素) [26]。其核心改进包括:

- 批归一化 (Batch Normalization):在所有卷积层中加入BN层,使网络收敛更稳定,mAP提升了2%以上 [26]。

- 维度聚类 (Dimension Clusters):放弃手动设置锚框大小,改用K-means聚类分析训练集目标,自动选出最具代表性的5个锚框,从而提高了IOU [11, 26]。

- 约束预测机制:为了防止锚框在预测时"漂移"到网格之外,v2限制了预测中心相对于网格左上角的偏移在(0, 1)之间,通过Sigmoid激活函数确保预测的稳定性 [26]。

- 特征融合 (Passthrough Layer):通过将 26×26 的浅层高分辨率特征拼接到 13×13 的深层特征中,模型能够更好地识别细微特征 [26]。

- Anchor Boxes(锚框): 引入类似Faster R-CNN的锚框机制,不再直接预测宽高的绝对值,而是预测相对于Anchor的偏移量。

- Darknet-19: 提出了新的分类骨干网络。

2.2 存在的问题

尽管引入了锚框和特征融合,YOLOv2在处理多尺度物体方面依然不够完善。由于只有一个最终检测层(13×13),模型在检测极小目标时依然感到吃力,且Darknet-19虽然高效,但在更复杂的特征提取任务中受限于深度 [4, 11]。

3.多尺度预测的巅峰:YOLOv3

2018年发布的YOLOv3是该系列的经典里程碑,它通过引入深度残差网络(Darknet-53)和类似特征金字塔(FPN)的三尺度预测机制,大幅提升了检测能力 [4, 12, 26]。V3是均衡之王,很长一段时间内的工业界标准。

3.1 相比v2的改进与原理

YOLOv3摒弃了池化层,转而通过步长卷积实现降采样。其核心进步体现在:

- Darknet-53主干:受ResNet启发,大量使用残差连接(Skip Connections),解决了深层网络的梯度消失问题,性能接近ResNet-152但速度快两倍 [12, 26]。

- FPN (Feature Pyramid Networks)思想多尺度预测头:在三个不同的下采样阶段(32×、16×、8×)分别进行检测,分别对应 13×13、26×26 和 52×52 的分辨率,极大地增强了对小目标的检测成功率 [11, 12]。

- 类别预测优化:用独立的逻辑回归(Binary Cross-Entropy)取代Softmax,这使得模型能够处理多标签分类(如一个物体既是"卡车"也是"汽车") [12]。

3.2 存在的问题

虽然YOLOv3几乎解决了此前版本的所有精度短板,但随着模型层数的增加,推理延迟相比v2有所增长 [12]。此外,在边界框损失函数上,v3依然使用均方误差(MSE),忽略了长宽比和中心距离的几何约束,导致边界框回归不够精细 [11, 30]。

4.策略整合与工程化:YOLOv4

Redmon退出CV界后,AlexeyAB和Ultralytics接过了大旗,注重工程化落地。YOLOv4由Alexey Bochkovskiy提出,它更像是一份"武林秘籍",系统地集成了大量当时被证明有效的计算机视觉优化技术 [13, 14, 31]。

4.1 相比v3的改进与技术体系

YOLOv4确立了现代检测器的"主干-颈部-头"三段式架构,采用了CSPDarknet53主干和PANet颈部。其贡献主要:

CSPDarknet53: 引入CSP(Cross Stage Partial)结构,减少计算量,增强梯度传播。

Mosaic Augmentation: 拼图数据增强,将4张图拼成一张训练,极大提升了模型对背景的鲁棒性。

Mish Activation & CIoU Loss: 更平滑的激活函数和考虑了重叠面积、中心距离、长宽比的Loss。

4.2 存在的问题

YOLOv4的架构由于堆叠了过多异构组件,使得模型不仅难以像前几代那样简洁易懂,而且对开发者的硬件要求较高(通常需要高性能GPU进行多卡训练) [14, 18]。同时,它在PyTorch等流行框架中的迁移效率最初略逊于原生设计的模型 [31]。

5.工业标准的确立:YOLOv5

由Ultralytics发布,虽在学术创新上争议(没发正式论文),但在工程易用性上做到了极致。YOLOv5将重点放在了开发体验和部署灵活性上。它虽然在学术创新上不如前代激进,但在实际应用中成为了全球最受欢迎的版本 [4, 6, 15, 16]。

5.1 相比v4的改进与模型特色

YOLOv5完全基于PyTorch框架开发,其模型思想强调"自适应":

- 自适应锚框 (AutoAnchor):训练前自动计算最佳锚框形状,减少了对手工超参数的依赖 [6, 15]。

- C3模块:引入了更精简的跨阶段局部瓶颈模块,减少了计算冗余,同时使用了SiLU激活函数,使推理更平滑 [15, 16]。

- 多尺度缩放策略:推出了Nano、Small、Medium、Large、XLarge五个版本,覆盖从嵌入式设备到高性能服务器的所有场景 [7, 15, 16]。

5.2 存在的问题

YOLOv5依然沿用传统的锚框机制,在处理极端长宽比的目标时仍有局限 [7, 15]。此外,它依然高度依赖非极大值抑制(NMS)后处理,在目标极其密集的图像中,后处理过程可能成为系统延迟的瓶颈 [7, 34]。

6.工业重参数化的兴起:YOLOv6

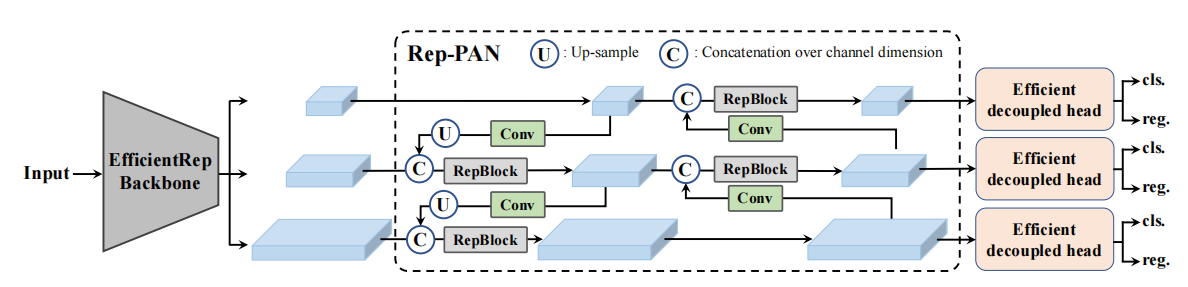

各大厂(美团、百度等)入局,结构发生本质变化。美团视觉团队发布的YOLOv6旨在通过硬件友好的设计,提高模型在特定工业显卡(如NVIDIA T4)上的吞吐量 [4, 8, 35]。

6.1 相比v5的改进与重参数化思想

YOLOv6实现了多项底层架构优化, 针对GPU和CPU分别优化,追求极致的推理速度。

- 重参数化骨干网络 (EfficientRep):训练时采用多分支结构捕获丰富特征,推理时通过重参数化技术将其融合为单一卷积路径,实现了"鱼和熊掌兼得"的速度与精度 [8, 18, 35]。

- 解耦检测头 (Decoupled Head):将分类和定位任务分开进行特征提取,缓解了两个任务之间的训练竞争 [8, 36]。

- BiC模块与SimCSPSPPF:在颈部引入双向连接增强定位信息,同时简化了SPPF模块以降低延迟 [35, 37]。

6.2 存在的问题

YOLOv6高度针对特定的推理平台(如TensorRT加速的GPU)进行优化,这导致其在通用的CPU或非专用硬件上的加速效果并不明显,且在小模型(Nano版)上的精度优势相对微弱 [16, 18]。

7.梯度路径的控制者:YOLOv7

2022年,王建尧博士等人推出的YOLOv7再次将目标检测推向了当时的SOTA(State-of-the-Art)。其模型思想核心在于对"计算成本"的极致榨取 [4, 18, 19, 38]。

7.1 相比v6的改进与E-ELAN原理

由YOLOv4原作者团队(WongKinYiu)推出,强调架构设计的优雅。YOLOv7并不依赖重参数化这一单一技术,而是提出了:

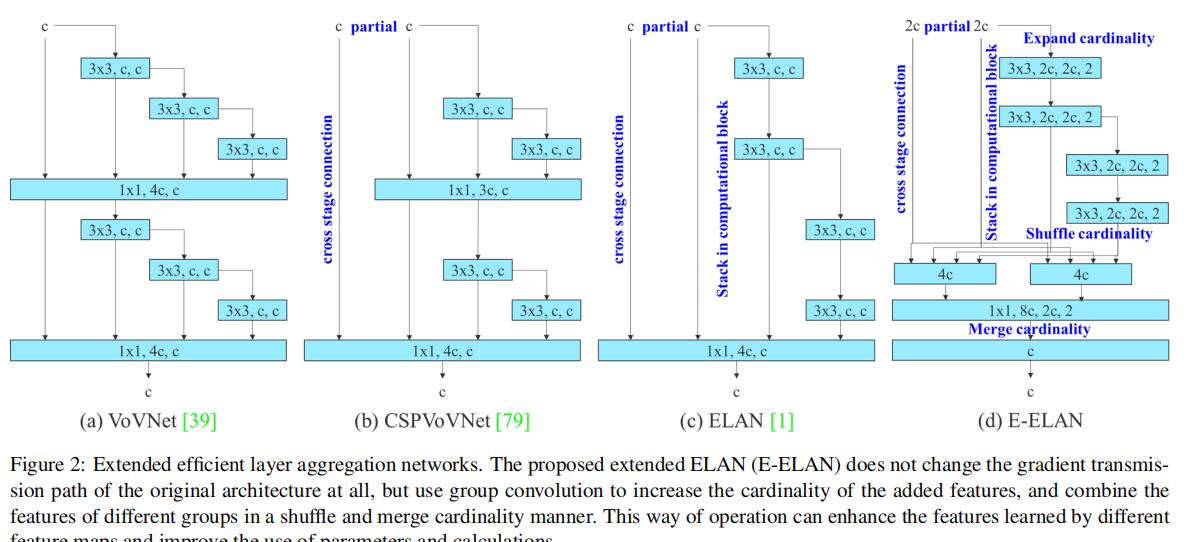

- 扩展高效层聚合网络 (E-ELAN):通过控制梯度的最短和最长路径,让深度网络学到更多样化的特征,解决了模型加深后的学习效率问题 [18, 19, 38]。

- 复合缩放 (Compound Scaling):在缩放模型大小时,同时调整深度、宽度和分辨率,保持模型各组件之间的比例平衡 [4, 18, 19]。

- 可训练的"免费赠品":包括模型重参数化策略的优化和带辅助头的导向学习(Lead Head Guided Label Assignment) [18, 19]。

- 辅助头 (Auxiliary Head): 训练时在中间层加监督信号,推理时去掉。

7.2 存在的问题

由于追求极致的架构优化,YOLOv7的实现代码比v5复杂得多,且由于依然属于锚框检测器,其在处理自适应数据集时的灵活性不如随后的无锚框版本 [18, 19, 38]。

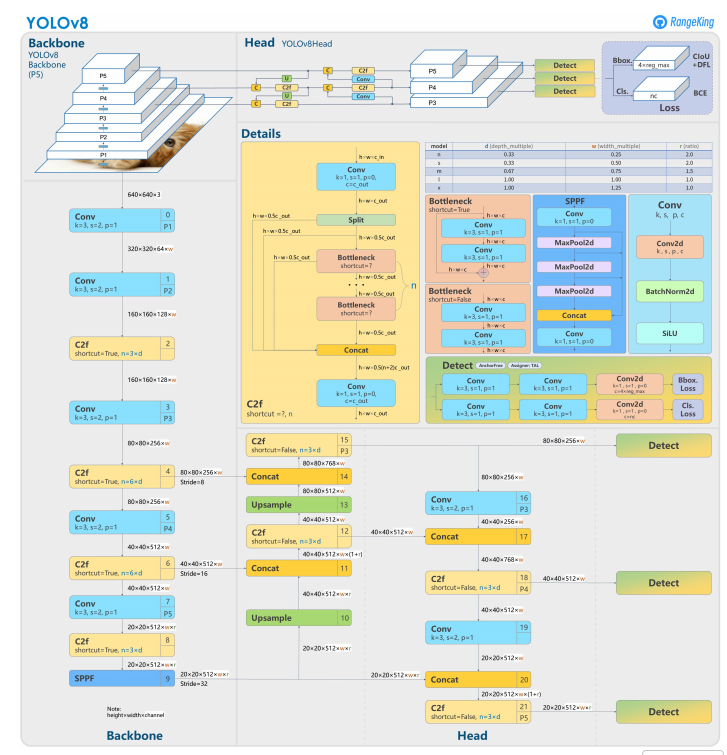

8. 无锚框时代的开启:YOLOv8

Ultralytics于2023年推出的YOLOv8标志着该系列在架构设计上的又一次彻底变革。它通过彻底转向无锚框(Anchor-free)范式,极大地简化了检测流程 [4, 15, 17, 38]。 目前应用最广泛的版本之一,结构简单高效。

8.1 相比v7的改进与无锚框原理

YOLOv8引入了全新的C2f模块,其改进点包括:

- 无锚框预测:直接预测目标的中心点及其与四个边界的距离,不再需要复杂的预设锚框和维度聚类,这使模型对各种形状的目标具有更强的泛化能力 [6, 19, 36, 38]。

- 分布焦距损失 (DFL):引入积分形式的框回归损失,使模型能够输出每个坐标的概率分布,从而在定位模糊的目标上表现更稳健 [6, 7, 36]。

- 多任务集成:在一个框架内原生支持分类、检测、分割、姿态估计和OBB,为开发者提供了统一的工具链 [7, 16, 19, 27]。

8.2 存在的问题

虽然v8在精度上取得了巨大飞跃,但由于引入了更复杂的DFL损失和解耦预测头,其在部分极低算力的嵌入式设备上的前向推理开销略有增加 [7, 39]。此外,模型依然未解决NMS依赖带来的计算冗余 [7, 15]。

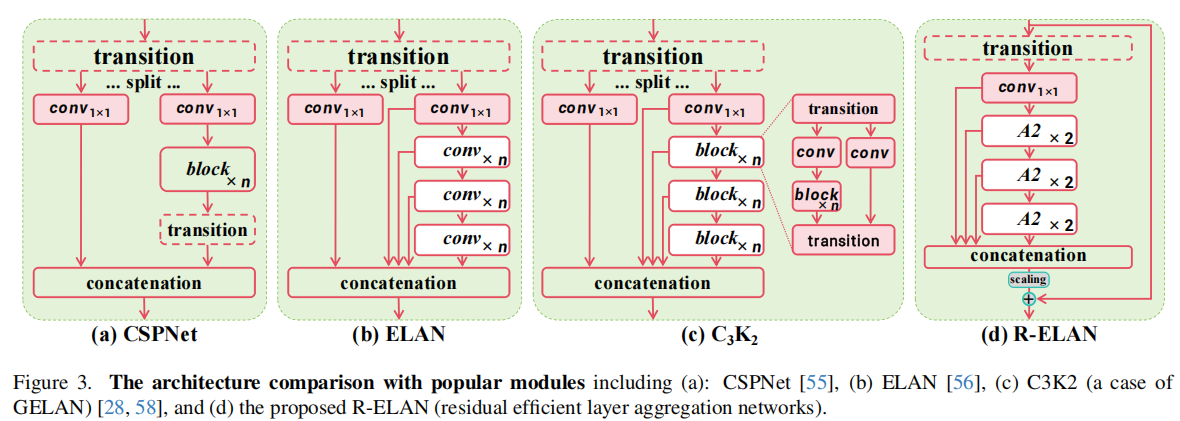

9. 梯度信息的守护者:YOLOv9

YOLOv9针对深层神经网络中的"信息瓶颈"问题提出了独特的解决方案,强调从源头保护梯度信息 [4, 20, 40, 41]。

9.1相比v8的改进与PGI/GELAN原理

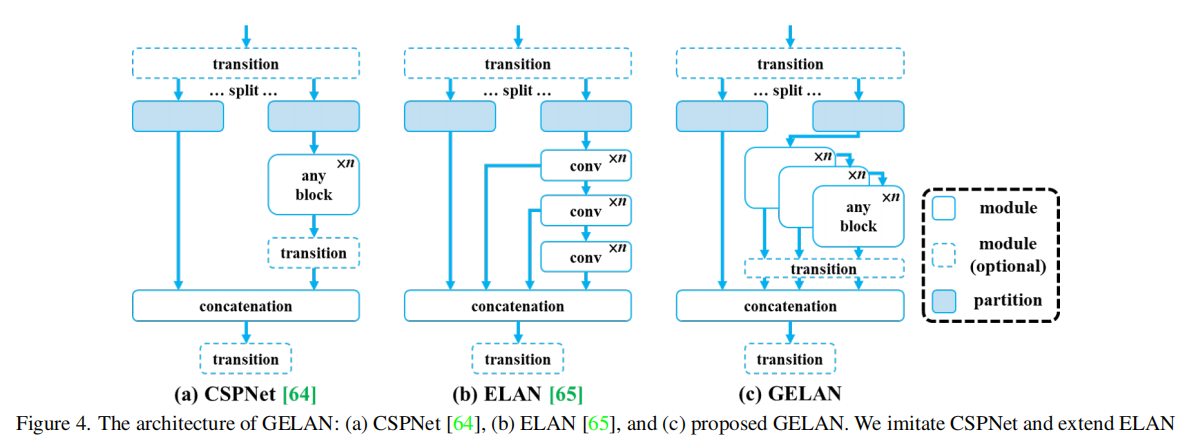

YOLOv9的核心在于:

- 可编程梯度信息 (PGI):通过辅助监督路径,在训练时为深层网络提供可靠的指导,防止关键特征信息在逐层传递中丢失 [20, 40, 41, 42]。

- 广义高效层聚合网络 (GELAN):这种架构不仅优化了参数利用率,还结合了CSPNet的高效和ELAN的强表达能力,实现了更轻量但更强大的特征提取 [4, 20, 42]。

9.1 存在的问题

PGI在训练时需要额外的显存开销,这对于训练资源有限的用户来说是一个挑战。同时,在推理阶段,虽然辅助分支可以剪掉,但GELAN结构的复杂度依然高于v8的C2f,在追求极致推理速度的场景下表现中规中矩 [41, 42]。

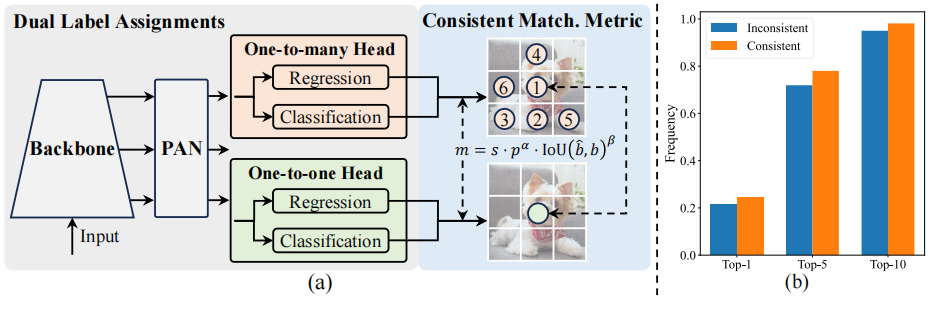

10.终结NMS的先锋:YOLOv10

2024年5月,清华大学研究团队推出的YOLOv10解决了困扰实时检测器长达十年的瓶颈:后处理中的非极大值抑制(NMS) [4, 13, 17, 21, 22]。

10.1 相比v9的改进与端到端原理

YOLOv10引入了创新的"一致双标签分配"策略:

- 双头预测 (Dual Annotation Architecture):模型包含两个并行的检测头。一个头采用传统的"一对多"匹配(TAL),提供丰富的监督信号以辅助模型学习;另一个头采用"一对一"匹配,强制每个目标只产生一个预测结果 [17, 21, 22, 27]。

- NMS-Free推理:在推理时,直接丢弃一对多头。由于一对一头已经学习到了排他性的预测能力,模型输出的结果不再需要NMS进行去重,从而将延迟降低了高达70% [21, 22, 40]。

- 高效性设计:引入了空间-通道解耦下采样、轻量化分类头和大核深度卷积,全方位压缩冗余计算 [17, 21, 22]。

10.2 存在的问题

作为学术界的首个成熟端到端方案,YOLOv10在极端密集的目标重叠场景下,由于缺乏NMS的最后一道"物理过滤",偶尔会出现漏检或置信度不稳定的情况 [27, 43]。同时,新颖的架构对某些编译器的自动优化不够友好 [34]。

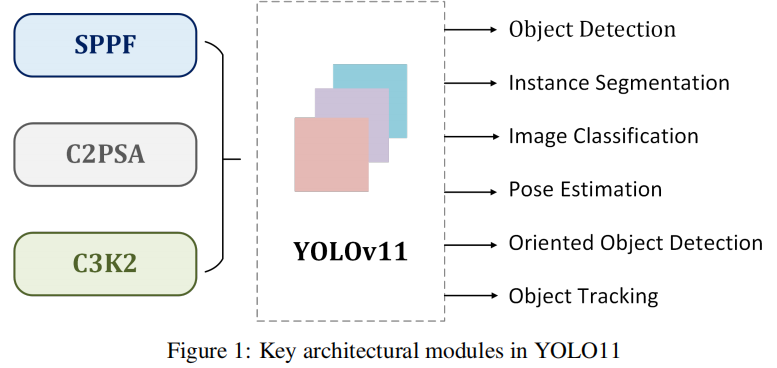

11.全能选手的精炼:YOLO11

2024年底由Ultralytics发布的YOLO11,虽然在推理流程上回归了NMS以追求极致的鲁棒性,但在模型结构的精简度和特征捕捉效率上达到了新的工业巅峰 [13, 22, 27, 43, 44]。

11.1 相比v10的改进与原理

YOLO11针对实际部署场景进行了多项微调:

- C3k2与C2PSA模块:利用更小的内核构建CSP块,并引入并行空间注意力(C2PSA)机制,这使得模型在处理空中图像中小目标或遮挡目标时,能够更精准地聚焦核心特征 [13, 22, 41, 43]。

- 参数效率跨越:YOLO11m在参数量比YOLOv8m减少22%的情况下,依然实现了更高的mAP分值 [13, 22, 27]。

- 全平台优化:优化的Neck结构确保模型在从NVIDIA显卡到边缘侧显卡(如Jetson Orin)上都能保持稳定的高FPS [13, 43, 45]。

11.2 存在的问题

由于回归了NMS,在目标数量达到数百上千的特殊应用中(如人群计数),后处理波动问题再次显现 [7, 27, 40]。此外,其虽然全能,但在特定高精度任务中可能不如引入了注意力机制的v12 [10]。

12.注意力机制的整合:YOLOv12

2025年发布的YOLOv12代表了该系列向Transformer/注意力机制迈出的重要一步,旨在通过大视野特征聚合解决卷积固有的局限性 [10, 25, 46, 47]。

12.1 相比v11的改进与A2/R-ELAN原理

YOLOv12的创新点在于:

- 区域注意力 (Area Attention, A2):这种机制允许模型在保持实时速度的前提下,捕捉长程空间依赖关系,极大地提升了模型对复杂背景下目标的辨识度 [10, 25, 46]。

- R-ELAN架构:在ELAN的基础上引入残差缩放连接,不仅增强了特征聚合的稳定性,还允许构建更深层的网络而不会发生训练振荡 [10, 25, 46]。

- FlashAttention优化:通过优化内存访问模式,降低了注意力计算产生的计算开销 [10]。

12.2 存在的问题

注意力机制的加入不可避免地增加了推理时的中间张量显存占用(VRAM)。在一些对显存极其敏感的嵌入式SoC(System on Chip)上,YOLOv12的部署难度高于纯卷积架构的v11或v26 [25]。

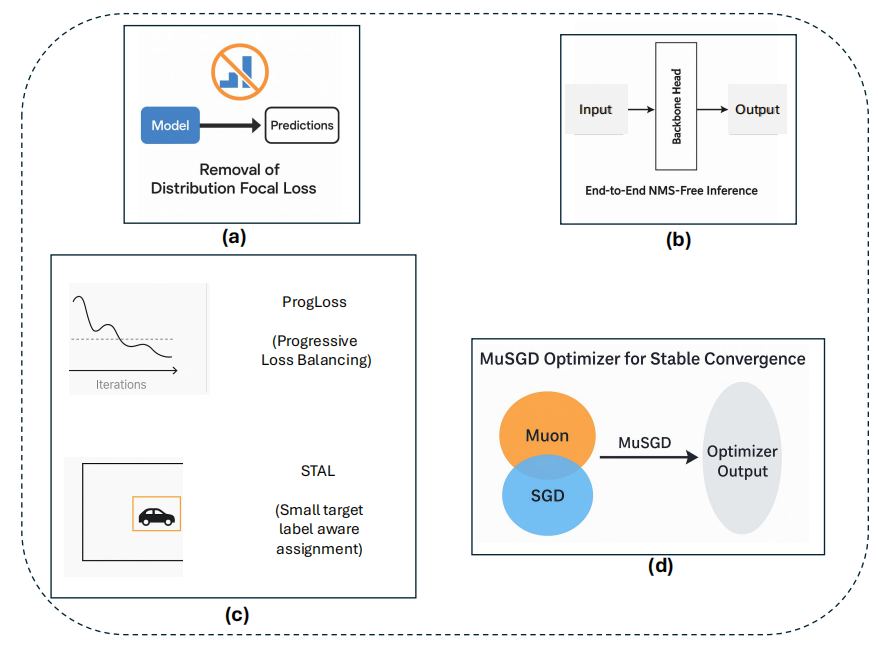

13. 面向未来的演进:YOLO26

发布于2026年初的YOLO26不仅是名字上的跨越,更是对实时检测器底层逻辑的再次重构。它结合了端到端推理、大模型优化技术和极致的硬件友好性 [7, 23, 24, 40, 48]。

13.1 相比v11/v12的改进与MuSGD原理

YOLO26通过激进的简化实现了效率飞跃,Edge-First (边缘优先) & Native End-to-End (原生端到端)。

- DFL与NMS的双重移除:YOLO26彻底抛弃了自v8以来标配的分布焦距损失(DFL),回归了更简洁、更硬核的坐标回归方式,极大地简化了ONNX/TensorRT的算子导出图结构 [7, 23, 24, 40, 48]。

- MuSGD 优化器:受大语言模型(如Kimi K2)训练启发,YOLO26引入了混合SGD与Muon的优化器。这种优化器利用二阶曲率信息加速收敛,使模型能够更快地达到精度峰值,并减少了后期训练的振荡 [23, 24, 40, 48]。

- CPU 推理王:通过对图中冗余操作的极致修剪,YOLO26在纯CPU上的推理速度比v11提升了高达43%,真正实现了在无显卡环境下的实时部署 [24, 40, 48]。

- ProgLoss + STAL:渐进式损失平衡和针对小目标的自适应标签分配,确保了在移除DFL后,模型对极微小物体的敏感度不降反升 [7, 23, 24, 48, 49]。

13.2 存在的问题

尽管其在边缘侧展现出统治力,但由于去除了复杂的分布式回归(DFL),在一些需要极致定位精度(如医疗影像分析)的亚像素回归场景中,其定位一致性可能略低于v12或v9 [28]。

YOLO系列核心技术规格与性能演进横向对比

为了直观展现各代模型之间的传承与技术跨越,下表基于COCO val2017数据集和同等测试环境(NVIDIA T4 GPU / 640px输入)整理了核心性能指标:

| 模型版本 | 模型大小 (n/s) | mAP (50-95) | 典型延迟 (T4, ms) | 参数量 (M) | 核心技术标签 |

|---|---|---|---|---|---|

| YOLOv5n | Nano | 28.0 | 1.12 | 2.6 | CSPNet, Anchor-based [34] |

| YOLOv8n | Nano | 37.3 | 1.47 | 3.2 | C2f, Anchor-free, DFL [15] |

| YOLOv10n | Nano | 39.5 | 1.56 | 2.3 | Dual-Assignment, NMS-free [22] |

| YOLO11n | Nano | 39.5 | 1.50 | 2.6 | C3k2, C2PSA, Versatile [22] |

| YOLO12n | Nano | 40.6 | 1.64 | 2.6 | Area Attention, R-ELAN [25] |

| YOLO26n | Nano | 39.8 | 0.95 (CPU加速) | 2.1 | MuSGD, DFL-free, End-to-End [7, 23] |

数据背后的技术趋势洞察

通过分析上述数据可以看出,YOLO系列的发展呈现出显著的"非线性"特征。一方面,参数量在减少的同时精度在飞速攀升,这得益于更高效的层连接策略(如从C3到C2f再到C3k2) [13, 15]。另一方面,尽管NMS-free架构(v10, v26)在单帧延迟上略微增加了网络本身的计算时间,但它通过消除变长的后处理耗时,使系统在处理视频流时的总吞吐量更稳定,这一点在边缘设备(如无人机、移动机器人)上具有决定性意义 [21, 22, 24, 50]。

结论:十年演进的技术逻辑与工业未来

YOLO系列的十年演进过程,实际上是计算机视觉研究从"关注模型深度"向"关注梯度流与信息熵"转变的过程 [4, 18, 40]。

v1-v3: 解决"有没有"的问题,确立Grid和Anchor机制。

v4-v5: 解决"好不好用"的问题,引入数据增强和工程化部署。

v6-v8: 解决"结构优不优"的问题,引入重参数化、解耦头和Anchor-Free。

v9-v10: 解决"训练与后处理"的问题,引入PGI和去NMS。

YOLO26: 解决"边缘落地与极简"的问题,回归硬件友好性。

其技术演进思想可以归纳为以下四点深度见解:

- 从规则驱动到数据驱动的解耦:从v2/v3复杂的预设锚框回归到v8/v11的无锚框设计,体现了研究者希望通过网络自学习目标形状,而非依靠人工先验知识。

- 梯度信息的全生命周期管理:无论是v7的路径控制,还是v9的PGI辅助分支,本质上都是在确保网络在变得极深后,底层特征依然能够被有效更新,解决了训练端的"信息丢失" [18, 40]。

- 计算图的系统化简约:YOLO26对DFL的移除和v10对NMS的终结,标志着一阶段检测器正致力于将所有后处理步骤"内化"到模型权重中,使检测器变成一个真正的闭环函数。

- 硬件感知设计 (Hardware-Aware Design):YOLOv6的重参数化和YOLO26的CPU加速,证明了现代视觉模型的发展已不再局限于学术指标,而是深度介入底层硬件的算子执行逻辑。

未来的YOLO可能会进一步融合大规模视觉基础模型(Foundation Models)的知识蒸馏技术,并在多模态理解与开集检测(Open-vocabulary Detection)领域继续探索,为通向通用人工智能(AGI)提供实时、高效的感知基石 [1, 13, 51]。

参考文献

本文写作参考了如下资源,在此表示感谢

- YOLOv1 to YOLOv11: A Comprehensive Survey of Real-Time Object Detection Innovations and Challenges - arXiv, https://arxiv.org/html/2508.02067v1

- YOLO Object Detection Explained: Evolution, Algorithm, and Applications - Encord, https://encord.com/blog/yolo-object-detection-guide/

- What is YOLO? The Ultimate Guide [2026] - Roboflow Blog, https://blog.roboflow.com/guide-to-yolo-models/

- (PDF) The Evolution of YOLO: from YOLOv1 to YOLOv11 with a Focus on YOLOv7's Innovations in Object Detection - ResearchGate, https://www.researchgate.net/publication/388050343_The_Evolution_of_YOLO_from_YOLOv1_to_YOLOv11_with_a_Focus_on_YOLOv7's_Innovations_in_Object_Detection

- The Evolution of YOLO: Object Detection Algorithms | Mindy Support Outsourcing, https://mindy-support.com/news-post/the-evolution-of-yolo-object-detection-algorithms/

- Comparative Analysis of YOLO Variants Based on Performance Evaluation for Object Detection - ITM Web of Conferences, https://www.itm-conferences.org/articles/itmconf/pdf/2025/01/itmconf_dai2024_03008.pdf

- Ultralytics YOLO Evolution: An Overview of YOLO26, YOLO11, YOLOv8, and YOLOv5 Object Detectors for Computer Vision and Pattern Recognition - arXiv, https://arxiv.org/html/2510.09653v2

-

22.09\] YOLOv6 - DOCSAID, [https://docsaid.org/en/papers/object-detection/yolov6/](https://www.google.com/url?sa=E&q=https%3A%2F%2Fdocsaid.org%2Fen%2Fpapers%2Fobject-detection%2Fyolov6%2F)

- Comparative Analysis of Deep Neural Networks YOLOv11 and YOLOv12 for Real-Time Vehicle Detection in Autonomous Vehicles - ResearchGate, https://www.researchgate.net/publication/390917463_Comparative_Analysis_of_Deep_Neural_Networks_YOLOv11_and_YOLOv12_for_Real-Time_Vehicle_Detection_in_Autonomous_Vehicles

- YOLO Object Detection Model Overview - Emergent Mind, https://www.emergentmind.com/topics/yolo-object-detection-model

- YOLO V3 Explained | Towards Data Science, https://towardsdatascience.com/yolo-v3-explained-ff5b850390f/

- YOLO11 to Its Genesis: A Decadal and Comprehensive Review of The You Only Look Once (YOLO) Series - arXiv, https://arxiv.org/html/2406.19407v5

- YOLOv4: High-Speed and Precise Object Detection - Ultralytics Docs, https://docs.ultralytics.com/models/yolov4/

- YOLOv8 vs. YOLOv5: A Comprehensive Technical Comparison - Ultralytics YOLO Docs, https://docs.ultralytics.com/compare/yolov8-vs-yolov5/

- YOLOv5 vs. YOLOv6-3.0: A Comprehensive Technical Comparison - Ultralytics Docs, https://docs.ultralytics.com/compare/yolov5-vs-yolov6/

- YOLOv10: Real-Time End-to-End Object Detection - Ultralytics YOLO Docs, https://docs.ultralytics.com/models/yolov10/

- YOLOv7 vs YOLOv6-3.0: Architectural Evolution and Performance Analysis - Ultralytics Docs, https://docs.ultralytics.com/compare/yolov7-vs-yolov6/

- YOLOv8 vs YOLOv7: Architectural Evolution and Performance Analysis - Ultralytics Docs, https://docs.ultralytics.com/compare/yolov8-vs-yolov7/

- YOLOv9: SOTA Object Detection Model Explained - Encord, https://encord.com/blog/yolov9-sota-machine-learning-object-dection-model/

-

24.05\] YOLOv10 \| DOCSAID, [https://docsaid.org/en/papers/object-detection/yolov10/](https://www.google.com/url?sa=E&q=https%3A%2F%2Fdocsaid.org%2Fen%2Fpapers%2Fobject-detection%2Fyolov10%2F)

- Ultralytics YOLO Evolution: An Overview of YOLO26, YOLO11, YOLOv8, and YOLOv5 Object Detectors for Computer Vision and Pattern Recognition - arXiv, https://arxiv.org/html/2510.09653v1

- Ultralytics YOLO26 - Ultralytics YOLO Docs, https://docs.ultralytics.com/models/yolo26/

- YOLO12: Attention-Centric Object Detection - Ultralytics YOLO Docs, https://docs.ultralytics.com/models/yolo12/

- A Comprehensive Review of YOLO Architectures in Computer ..., https://www.mdpi.com/2504-4990/5/4/83

- Comparing Ultralytics YOLO11 vs previous YOLO models, https://www.ultralytics.com/blog/comparing-ultralytics-yolo11-vs-previous-yolo-models

- The New YOLO26 is Finally Released! Slower Results, but Intelligent! | by Zain Shariff, https://medium.com/@zainshariff6506/the-new-yolo26-is-finally-released-slower-results-but-intelligent-d3733c536748

- Yolo Loss function explanation - Cross Validated - Stats StackExchange, https://stats.stackexchange.com/questions/287486/yolo-loss-function-explanation

- YOLOv4 --- Version 1: Bag of Freebies - Object Detection - Medium, https://medium.com/visionwizard/yolo-v4-bag-of-freebies-dc126623fc2d

- What is YOLOv4? A Detailed Breakdown. - Roboflow Blog, https://blog.roboflow.com/a-thorough-breakdown-of-yolov4/

- YOLOv4: A Breakthrough in Real-Time Object Detection - arXiv, https://arxiv.org/html/2502.04161v1

- Introduction to YOLOv4: Research review - Fritz ai, https://fritz.ai/introduction-to-yolov4-research-review/

- YOLOv5 vs YOLOv10: A Technical Comparison of Real-Time Object Detectors, https://docs.ultralytics.com/compare/yolov5-vs-yolov10/

- Understanding YOLOv6: Efficient Object Detection Model - Viso Suite, https://viso.ai/deep-learning/yolov6/

- Explore YOLOv8: Latest in Object Detection Tech - Viso Suite, https://viso.ai/deep-learning/yolov8-guide/

- Meituan YOLOv6 - Ultralytics YOLO Docs, https://docs.ultralytics.com/models/yolov6/

- YOLOv7 vs YOLOv8: Evolution of Real-Time Object Detection - Ultralytics Docs, https://docs.ultralytics.com/compare/yolov7-vs-yolov8/

- Unraveling YOLO v8: Benefits and Challenges in Object Detection - Medium, https://medium.com/@masadnadeem23/unraveling-yolo-v8-benefits-and-challenges-in-object-detection-1ec762debefd

- YOLOv10 vs. YOLOv9: Advancing Real-Time Object Detection - Ultralytics YOLO Docs, https://docs.ultralytics.com/compare/yolov10-vs-yolov9/

- YOLO11 vs. YOLOv9: Deep Dive into Architecture and Performance - Ultralytics Docs, https://docs.ultralytics.com/compare/yolo11-vs-yolov9/

- YOLOv9 vs YOLO11: Bridging Architectural Innovation and Production Readiness - Ultralytics YOLO Docs, https://docs.ultralytics.com/compare/yolov9-vs-yolo11/

- YOLOv11 Object Detection - Emergent Mind, https://www.emergentmind.com/topics/yolov11-object-detection

- (PDF) A Comparative Review of the Next-Generation YOLO Models: YOLOv10 and YOLO11 - ResearchGate, https://www.researchgate.net/publication/392217475_A_Comparative_Review_of_the_Next-Generation_YOLO_Models_YOLOv10_and_YOLO11

- A Comparative Evaluation of YOLOv9, YOLOv10, and YOLOv11 on NVIDIA Jetson Orin for Real-Time Service Robotics - Even3, https://static.even3.com/anais/brahurbrasero2025_paper_3.9ea63eaa84804c93ac7b.pdf?v=639010982278771247

- Comparing YOLOv11 and YOLOv12: A Deep Dive into the Next-Generation Object Detection Models - SO Development, https://so-development.org/comparing-yolov11-and-yolov12-a-deep-dive-into-the-next-generation-object-detection-models/

- YOLO Evolution: A Comprehensive Benchmark and Architectural Review of YOLOv12, YOLO11, and Their Previous Versions - arXiv, https://arxiv.org/html/2411.00201v4

- Model Comparisons: Choose the Best Object Detection Model for Your Project, https://docs.ultralytics.com/compare/

- Ultralytics YOLO26 Trains Smarter with ProgLoss, STAL, and MuSGD!, https://www.ultralytics.com/blog/how-ultralytics-yolo26-trains-smarter-with-progloss-stal-and-musgd

- YOLO11 vs. YOLOv10: Bridging Evolution and Revolution in Real-Time Object Detection, https://docs.ultralytics.com/compare/yolo11-vs-yolov10/

- Ultralytics YOLO Docs: Home, https://docs.ultralytics.com/