文章目录

- 前言

- 问题介绍

- 指标分析

- 诊断过程

- 原因分析

-

- 有可能报错的就是我添加的5列吗

- 为什么刚好只有我添加5列以前的Partition报错,而添加5列以后的Partition均不报错?

- 为什么我添加这5列以前,那些partition都不出错

- [ClickHouse会对part中不存在但是表中存在的列进行Vertical Merge吗](#ClickHouse会对part中不存在但是表中存在的列进行Vertical Merge吗)

- MergeTreeSequentialSource的构造和依赖列的添加

- IMergeTreeReader的构造和子流的添加

- [第一次补列: IMergeTreeReader::fillMissingColumns()方法对缺失列进行填充](#第一次补列: IMergeTreeReader::fillMissingColumns()方法对缺失列进行填充)

-

- IMergeTreeReader::fillMissingColumns()填充类型默认值

- DB::fillMissingColumns()中的默认值填充

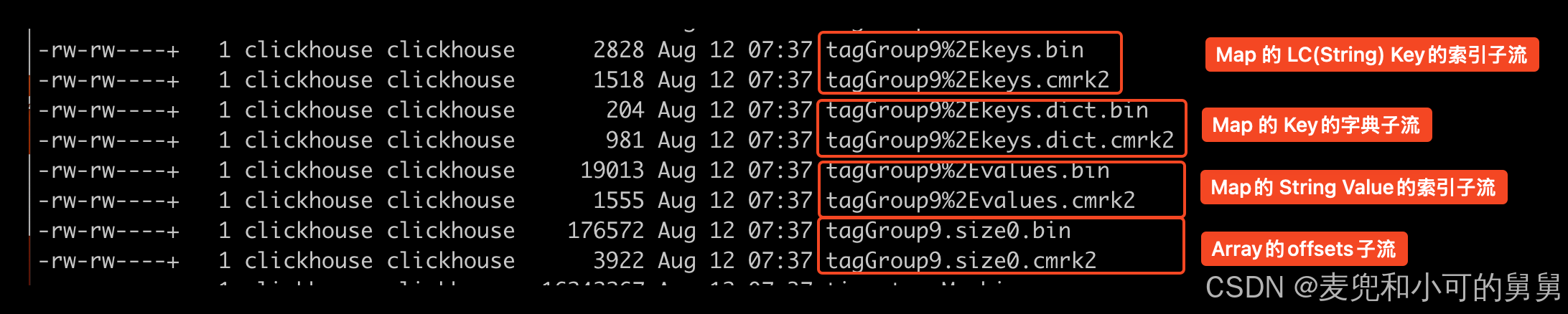

- IDataType::forEachSubcolumn()收集获取所有的subcolumn列

- [举例说明复合类型的 offsets 复用与默认值补齐](#举例说明复合类型的 offsets 复用与默认值补齐)

- [第二次补列: 通过IMergeTreeReader::evaluateMissingDefaults()来评估默认值计算](#第二次补列: 通过IMergeTreeReader::evaluateMissingDefaults()来评估默认值计算)

-

- IMergeTreeReader::evaluateMissingDefaults()的基本流程

- 构造基列数据时为Map构造默认数据,产生ColumnNothing类型

- [getSubcolumnData: 通过构造出来的基列数据来获取子列数据并发生转换错误](#getSubcolumnData: 通过构造出来的基列数据来获取子列数据并发生转换错误)

- SELECT失败的原因分析

- 添加日志解释疑惑并找到整个异常发生的原因

前言

我们经常对ClickHouse中的表的字段进行修改,其中最常进行的是增加列,因为列的增加在逻辑上是没有impact的。

在我们的一次增加列操作完成以后,ClickHouse看起来正常,但是随后,ClickHouse的Mutate操作被阻塞,Merge操作大量失败,ClickHouse负载逐渐恶化,重启ClickHouse Server无法解决问题。

本文详细讲述了我们遇到问题、尝试解决问题并无效、然后分析日志和堆栈、重新解决问题的整个过程,以及在问题被解决以后,通过添加日志、重新编译ClickHouse从而最终找到问题根因的基本过程。然后,我们以此过程为基础,在代码层面介绍了ClickHouse的Merge的基本概念以及Substream的基本概念,对默认值进行填充的基本原理。

希望读者能从本文中看到我们对一个分布式系统进行监控分析、日志分析、堆栈分析的基本过程,通过添加日志和重新编译进而让问题重新并找到根本原因的过程,以及我们理解ClickHouse在代码层面实现Merge、缺省值补充、复杂类型解析的基本原理。

从这个问题的解决过程中,我们总结到:

- 发生问题时先解决问题以降低影响,事后再分析原因;

- 问题发生时尽量保存现场,尤其是重启以前需要先打印堆栈,以便进行事后分析;

- 一个异常问题的发生,往往是环环相扣的各种因果相互串联导致的最后结果;

- 复杂问题的发生从触发到最后发生,要想理解整个过程,需要大量的知识准备,比如,本文中需要理解Merge的调度,需要理解Vertical Merge的机制,需要理解复杂类型(Array, Map, Tuple等等)的Substream的处理机制,需要理解默认值表达式和类型默认值的处理机制,需要理解Block的概念等等。

- 很多问题无法根据当时的现场就直接找到根本原因,因此最好是能够重现问题。只要问题能够重现,我们就可以添加日志并重新编译运行,那么根本原因就一定能找到。

问题介绍

我们对表进行的修改操作如下所示:

sql

ALTER TABLE {{ DATABASE NAME PLACEHOLDER }}.emo_mdm_flowwork_pt1m_local ON CLUSTER {{ CLUSTER NAME PLACEHOLDER FOR ALL HOSTS }}

ADD COLUMN IF NOT EXISTS `host` String DEFAULT '' CODEC(ZSTD(1)) AFTER connType,

ADD COLUMN IF NOT EXISTS `path` String DEFAULT '' CODEC(ZSTD(1)) AFTER host,

ADD COLUMN IF NOT EXISTS `referrer` String DEFAULT '' CODEC(ZSTD(1)) AFTER path,

ADD COLUMN IF NOT EXISTS `title` String DEFAULT '' CODEC(ZSTD(1)) AFTER referrer,

ADD COLUMN IF NOT EXISTS `referrerHost` String DEFAULT '' CODEC(ZSTD(1)) AFTER title;可以看到:

- 我们新增的列的类型都是简单类型String,同时也不是LowCardinarity

- 我们后面在堆栈中看到的Merge失败全是LowCardinaltity类型相关,这说明,堆栈中所抛出的LowCardinaltity异常的列(堆栈中并没有指出具体列名)根本不是我们新增的这5列,但是,这并不代表这个异常不是因为我们新增这5列所间接导致的。

- 我们新增的类型都显式提供了默认值,这意味着,对于缺少这些列的Part,ClickHouse不需要根据类型默认值去设置这些列的实际值,而只需要根据默认值表达式(即我们设置的

'')来设置他们的值。 - 我们后面看堆栈可以看出来,堆栈的入口

evaluateMissingDefaults()正是在进行默认值推断,即对缺少这些新增的5列的part进行默认值的计算(尽管我们的默认值设置为'',但其实也是一个表达式,一个最简单的表达式)以设置这些新增列的值

Mutation被阻塞

我们最初发现问题既不是从Dashboard上看到Merge的暴增,也不是从日志中看到了Merge的异常,而是,我们突然发现,我们的一些Regular Mutation Job的Mutation操作总是长期被Block住。

我们(Team B)的ETL Pipeline是将HDFS中存放的Parquet文件(由Team A生成)转换成ClickHouse的格式,每分钟一个batch的数据。这样,我们对于每分钟的数据,会通过attach的方式,bulkload到ClickHouse中,这种Bulkload的方式可以以极小的代价实现大量数据的插入,避免对查询造成影响。

当上游的Parquet文件出现问题,Team A会重新生成Parquet文件,然后我们会负责对数据进行修复。Repair过程和Regular Ingestion的过程的唯一区别是,Repair需要再Regular Ingestion以前先进行数据的删除。

这种删除我们采用的是异步软删除的方式,即异步删除,然后阻塞等待删除完成(即显式查询到数据量为0)。我们发现,在由7*2的物理架构下(7个Shard,每个Shard有两个Replica),只有两个Shard能完成数据的删除,其余5个Shard的数据删除全部被block住,并且看起来是永久阻塞,没有恢复的迹象。

在很多情况下,数据删除超时是由于Pool的大小不足导致的,这个不足不仅仅是延迟了删除的进行,因为根据ClickHouse的设计动机,Merge的优先级是高于Mutate的,因此,在Pool不足的情况下,如果Merge长期占有系统Pool,那么Mutate的确可能无法进行,但是不至于永久无法进行。

所以,我们经过代码分析并结合Metrics监控,增大了Merge/Mutate Pool的大小(Merge和Mutate共享一个Pool),但是并没有解决问题,Mutate操作依然处于被block的装填。

排除Pool资源限制导致阻塞

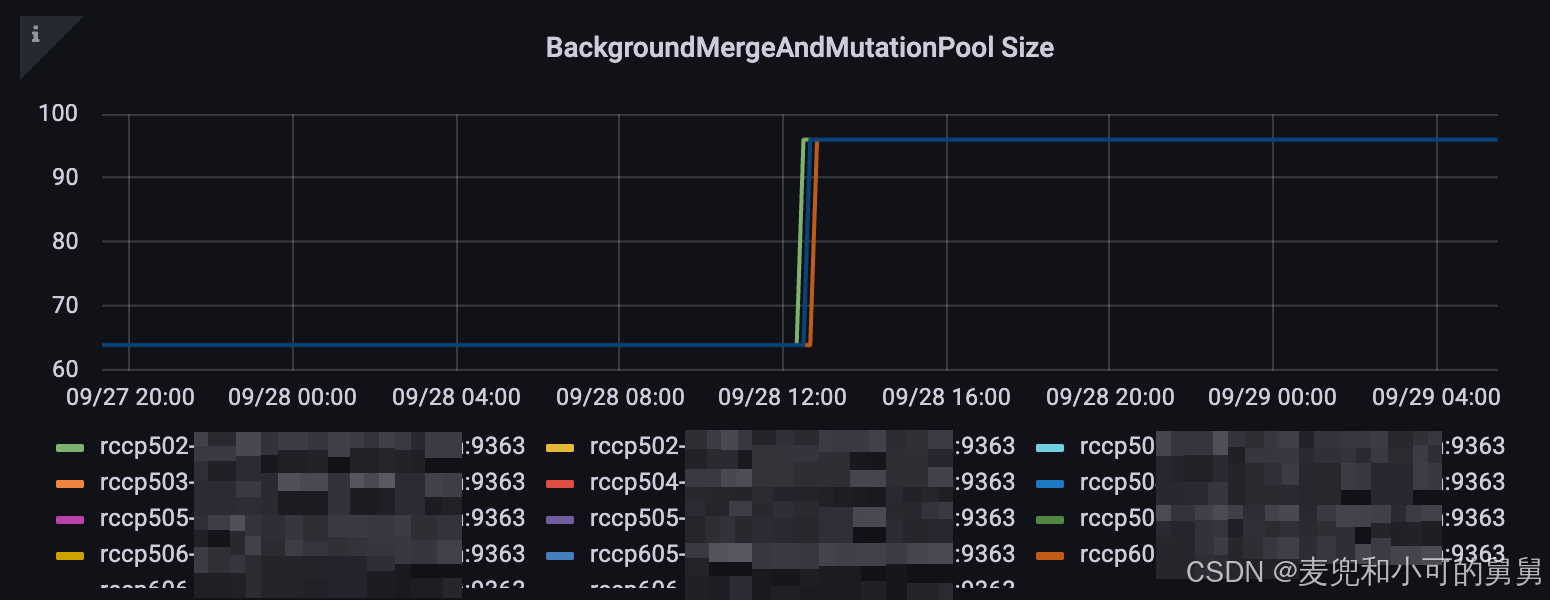

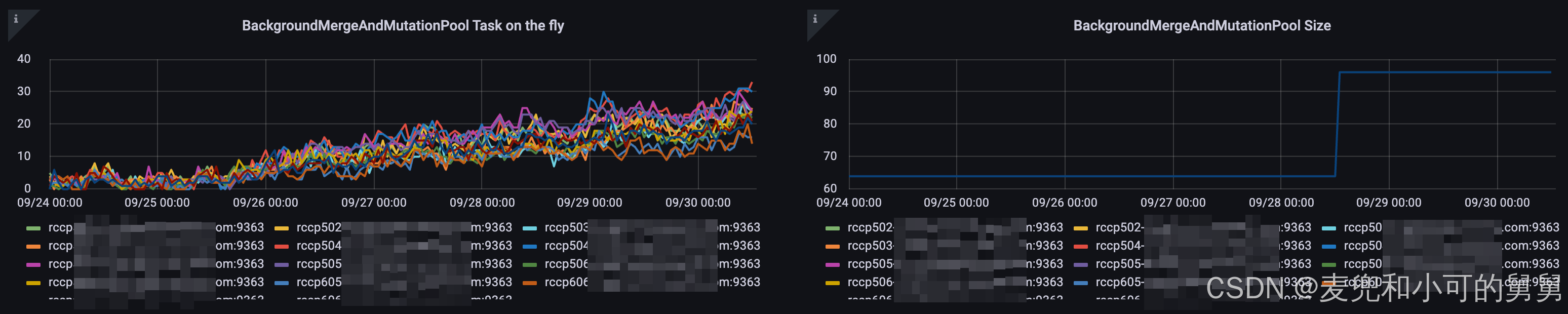

在ClickHouse里面,这个MergeAndMutatePool是通过background_pool_size参数在Server级别调整的,并且,这个调整如果是增大,则不需要重启ClickHouse,ClickHouse会动态加载这个变更,然后根据增大的值去创建新的Pool。如果是减小,则是需要重启ClickHouse的。

我们将background_pool_size的大小从当前的32设置到了48。

下图显示的是ClickHouse中对应的Gauge Metrics ClickHouseMetrics_BackgroundMergesAndMutationsPoolSize的值,可以看到,当我们将 background_pool_size的值从32调整到48以后,对应的ClickHouseMetrics_BackgroundMergesAndMutationsPoolSize的值从64变成了96,具体为什么 ClickHouseMetrics_BackgroundMergesAndMutationsPoolSize的值是background_pool_size的4倍,在我的另外一篇文章会具体讲解。

在增大了Pool的大小以后,效果很明显,又有好几个Shard的删除操作完成了(但是依然用了一些时间,只是在我们设置的超时发生以前完成)。但是也很遗憾,居然还有一个Shard的删除操作始终无法完成。

发现Merge操作大量报错

我们看到,无法进行删除的表正好是我们加了列的表,其它所有表都没有发生这个问题。这说明这个删除问题和我们添加列有关。

mutation操作无法顺利完成,我们查询system.mutations表,查看对应mutation操作的详细信息:

sql

SELECT *

FROM system.mutations

WHERE is_done = '0'结果如下:

shell

rcmp501-1.iad7.prod.corp.com :) select * from system.mutations where is_done = '0'

Query id: 75f439d6-0ab4-4a3b-916a-30e66adb0126

┌─database───┬─table───────────────────────────┬─mutation_id─┬─command─────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────┬─────────create_time─┬─block_numbers.partition_id─┬─block_numbers.number─┬─parts_to_do_names─────────┬─parts_to_do─┬─is_done─┬─is_killed─┬─latest_failed_part─┬────latest_fail_time─┬─latest_fail_reason─┐

1. │ dsi_iad_c2 │ emo_mdm_flowwork_pt1m_local │ 0000000012 │ UPDATE _row_exists = 0 IN PARTITION 20250925 WHERE (timestampMs >= '2025-09-25 05:00:00') AND (timestampMs < '2025-09-25 05:01:00') │ 2025-09-30 03:23:58 │ ['20250925'] │ [1441] │ ['20250925_0_667_10_204'] │ 1 │ 0 │ 0 │ │ 1970-01-01 00:00:00 │ │注意, system.mutations中的parts_to_do_names 指的是进行merge或者mutate生成的目标part,而不是source part。

由于我们的所有表都是ReplicatedMergeTree,因此,我们希望查询system.replication_queue表,看看当前有哪些正在执行的RepliatedMergeTree任务,即,我们hang住的mutate操作到底现在什么状态:

sql

SELECT

database,

`table`,

replica_name,

position,

node_name,

create_time,

source_replica,

new_part_name,

parts_to_merge,

is_currently_executing

FROM system.replication_queue

WHERE last_exception LIKE '%Bad cast from type DB%'

ORDER BY create_time DESC

LIMIT 20我们看到 system.replication_queue中有一些正在进行的并且抛出异常的replication任务。

我们看到,在system.mutations表里面无法完成的这个mutation的parts_to_do_names 20250925_0_667_10_204,正好出现在system.replication_queue表中的new_part_name字段中:

shell

rcmp501-1.iad7.prod.corp.com :) SELECT database, table, replica_name, position, node_name, create_time, source_replica, new_part_name, parts_to_merge, is_currently_executing

FROM system.replication_queue

WHERE last_exception like '%Bad cast from type DB%' -- get the replication_queue which has exception like Bad cast from type DB::ColumnNothing to DB::ColumnLowCardinality:

ORDER BY create_time desc

LIMIT 20;

Query id: 51564cfb-1e90-4d8d-a9a7-02cecf63e130

┌─database───┬─table──────────────────────────────┬─replica_name────────────────────┬─position─┬─node_name────────┬─────────create_time─┬─source_replica──────────────────┬─new_part_name───────────────────────────────┬─parts_to_merge─────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────┬─is_currently_executing─┐

1. │ dsi_iad_c1 │ emo_mdm_flowwork_pt30m_local │ rcmp501-1.iad7.prod.corp.com │ 6 │ queue-0000009389 │ 2025-09-29 15:45:13 │ rcmp501-1.iad7.prod.corp.com │ 20250924_46_47_1 │ ['20250924_46_46_0','20250924_47_47_0'] │ 1 │

.....

12. │ dsi_iad_c2 │ emo_mdm_flowwork_pt1m_local │ rcmp501-1.iad7.prod.corp.com │ 2 │ queue-0000042457 │ 2025-09-25 11:12:38 │ rcmp501-2.iad7.prod.corp.com │ 20250925_0_667_10_204 │ ['20250925_0_148_9_204','20250925_149_345_8_204','20250925_346_524_8','20250925_525_583_6','20250925_584_657_7','20250925_658_667_2'] │ 1 │ └────────────┴────────────────────────────────────┴─────────────────────────────────┴──────────┴──────────────────┴─────────────────────┴─────────────────────────────────┴─────────────────────────────────────────────┴────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────────┴────────────────────────┘

12 rows in set. Elapsed: 0.002 sec.从 system.replication_queue中可以看到,这里的mutate的source part是['20250925_0_148_9_204','20250925_149_345_8_204','20250925_346_524_8','20250925_525_583_6','20250925_584_657_7','20250925_658_667_2'],目标part是20250925_0_667_10_204,这个目标part正好就是我们的mutate操作的目标part。

所以我们初步怀疑,这个mutation无法完成的原因,就是底层的Merge操作无法完成,而底层的Merge操作无法完成的原因,就体现在堆栈中。我们需要分析堆栈,来试图找到原因。

的确,我们检查日志,发现日志在大量报类似以下的错误:

shell

2025.09.28 11:29:54.720651 [ 1885500 ] {} <Error> MergeTreeBackgroundExecutor: Exception while executing background task {196977f5-53bc-43eb-b79b-e54898814be5::20250831_4221_4390_4}: Code: 49. DB::Exception: Bad cast from type DB::ColumnNothing to DB::ColumnLowCardinality: (while reading from part /mycorp/data/nvme2/clickhouse/store/196/196977f5-53bc-43eb-b79b-e54898814be5/20250831_4221_4248_3/ located on disk disk2 of type local): While executing MergeTreeSequentialSource. (LOGICAL_ERROR), Stack trace (when copying this message, always include the lines below):

0. DB::Exception::Exception(DB::Exception::MessageMasked&&, int, bool) @ 0x000000000daffc3b

1. DB::Exception::Exception(PreformattedMessage&&, int) @ 0x0000000007e59fcc

2. DB::Exception::Exception<String, String>(int, FormatStringHelperImpl<std::type_identity<String>::type, std::type_identity<String>::type>, String&&, String&&) @ 0x0000000007e5bdcb

3. _Z11typeid_castIRKN2DB20ColumnLowCardinalityEKNS0_7IColumnEQsr3stdE14is_reference_vIT_EES6_RT0_ @ 0x00000000081b10c4

4. DB::SerializationLowCardinality::enumerateStreams(DB::ISerialization::EnumerateStreamsSettings&, std::function<void (DB::ISerialization::SubstreamPath const&)> const&, DB::ISerialization::SubstreamData const&) const @ 0x00000000111abbb0

5. DB::SerializationNamed::enumerateStreams(DB::ISerialization::EnumerateStreamsSettings&, std::function<void (DB::ISerialization::SubstreamPath const&)> const&, DB::ISerialization::SubstreamData const&) const @ 0x00000000111b7bba

6. DB::SerializationTuple::enumerateStreams(DB::ISerialization::EnumerateStreamsSettings&, std::function<void (DB::ISerialization::SubstreamPath const&)> const&, DB::ISerialization::SubstreamData const&) const @ 0x00000000111f5f02

7. DB::SerializationArray::enumerateStreams(DB::ISerialization::EnumerateStreamsSettings&, std::function<void (DB::ISerialization::SubstreamPath const&)> const&, DB::ISerialization::SubstreamData const&) const @ 0x000000001117f49d

8. DB::SerializationMap::enumerateStreams(DB::ISerialization::EnumerateStreamsSettings&, std::function<void (DB::ISerialization::SubstreamPath const&)> const&, DB::ISerialization::SubstreamData const&) const @ 0x00000000111b70e7

9. DB::IDataType::getSubcolumnData(std::basic_string_view<char, std::char_traits<char>>, DB::ISerialization::SubstreamData const&, bool) @ 0x0000000011140e8e

10. DB::IDataType::getSubcolumn(std::basic_string_view<char, std::char_traits<char>>, COW<DB::IColumn>::immutable_ptr<DB::IColumn> const&) const @ 0x0000000011141a88

11. DB::IMergeTreeReader::evaluateMissingDefaults(DB::Block, std::vector<COW<DB::IColumn>::immutable_ptr<DB::IColumn>, std::allocator<COW<DB::IColumn>::immutable_ptr<DB::IColumn>>>&) const @ 0x0000000012b403e8

12. DB::MergeTreeSequentialSource::generate() @ 0x0000000012b601ec

13. DB::ISource::tryGenerate() @ 0x000000001303219b

14. DB::ISource::work() @ 0x0000000013031ea7

15. DB::ExecutionThreadContext::executeTask() @ 0x000000001304b0e7

16. DB::PipelineExecutor::executeStepImpl(unsigned long, std::atomic<bool>*) @ 0x000000001303f9b0

17. DB::PipelineExecutor::executeStep(std::atomic<bool>*) @ 0x000000001303f3c8

18. DB::PullingPipelineExecutor::pull(DB::Chunk&) @ 0x000000001304f437

19. DB::PullingPipelineExecutor::pull(DB::Block&) @ 0x000000001304f639

20. DB::MergeTask::VerticalMergeStage::executeVerticalMergeForAllColumns() const @ 0x000000001298615f

21. DB::MergeTask::VerticalMergeStage::execute() @ 0x000000001298596e

22. DB::MergeTask::execute() @ 0x0000000012985122

23. DB::ReplicatedMergeMutateTaskBase::executeStep() @ 0x0000000012c47640

24. DB::MergeTreeBackgroundExecutor<DB::DynamicRuntimeQueue>::threadFunction() @ 0x000000001299d7bd

25. ThreadPoolImpl<ThreadFromGlobalPoolImpl<false, true>>::worker(std::__list_iterator<ThreadFromGlobalPoolImpl<false, true>, void*>) @ 0x000000000dbd4649

26. void std::__function::__policy_invoker<void ()>::__call_impl<std::__function::__default_alloc_func<ThreadFromGlobalPoolImpl<false, true>::ThreadFromGlobalPoolImpl<void ThreadPoolImpl<ThreadFromGlobalPoolImpl<false, true>>::scheduleImpl<void>(std::function<void ()>, Priority, std::optional<unsigned long>, bool)::'lambda0'()>(void&&)::'lambda'(), void ()>>(std::__function::__policy_storage const*) @ 0x000000000dbd8791

27. void* std::__thread_proxy[abi:v15007]<std::tuple<std::unique_ptr<std::__thread_struct, std::default_delete<std::__thread_struct>>, void ThreadPoolImpl<std::thread>::scheduleImpl<void>(std::function<void ()>, Priority, std::optional<unsigned long>, bool)::'lambda0'()>>(void*) @ 0x000000000dbd7509这个堆栈的含义是

-

试图将source part

20250831_4221_4248_3进行merge操作生成一个target part20250831_4221_4390_4。我们根据ClickHouse中part的命名规则可以知道,这个part的partition是20250831, block index的范围是[4221,4248],这个source part的version是3,合并以后即将生成的part的version是4,会加1 -

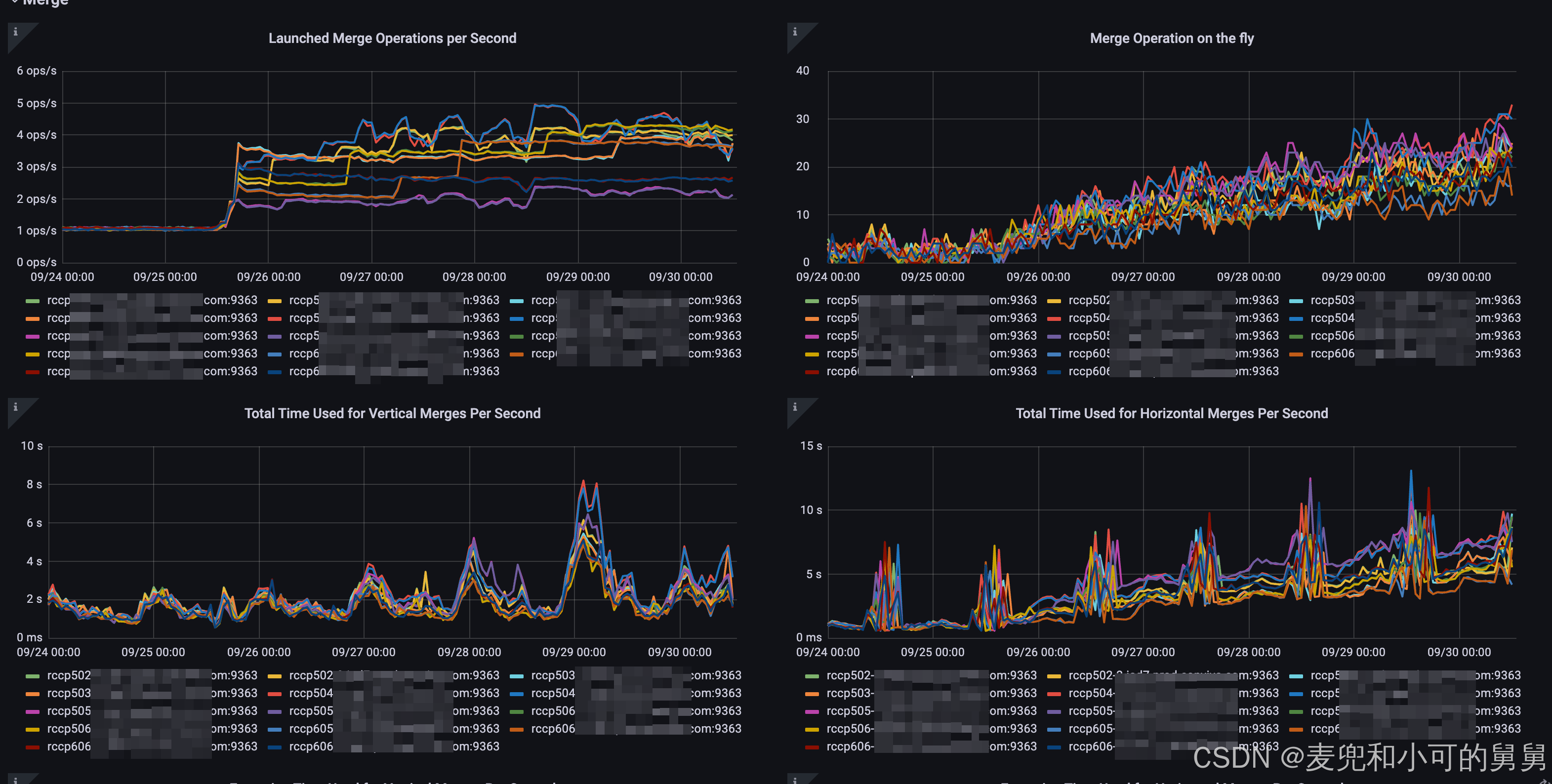

出问题的Merge Stage是

VerticalMergeStage。这个从堆栈片段上可以看到:shell20. DB::MergeTask::VerticalMergeStage::executeVerticalMergeForAllColumns() const @ 0x000000001298615f 21. DB::MergeTask::VerticalMergeStage::execute() @ 0x000000001298596e 22. DB::MergeTask::execute() @ 0x0000000012985122在我的另外一篇文章中讲到,无论是

HorizontalMerge还是VerticalMerge都会经历的3个Stage,ExecuteAndFinalizeHorizontalPart,VerticalMergeStage和MergeProjectionsStage。其中-

到底是使用Vertical还是Horizontal Merge的决策发生在第一个Stage即

ExecuteAndFinalizeHorizontalPart的准备(prepare())阶段; -

无论决策出来的是Horizontal Merge还是Vertical Merge,都会走完这三个阶段;

-

但是,如果决策出来的是

Horizontal Merge,第二个Stage(VerticalMergeStage)没有实质性的执行代码。比如,如果是HorizontalMerge,那么在执行第二个Stage的3个Task的时候,都会首先检查当前的Merge Algorithm, 如果是Horizontal Merge,直接返回成功:bool MergeTask::VerticalMergeStage::executeVerticalMergeForAllColumns() const { /// No need to execute this part if it is horizontal merge. if (global_ctx->chosen_merge_algorithm != MergeAlgorithm::Vertical) return false; // 返回false,代表执行完成,无需再次调用 .... } -

所以,堆栈里面的

VerticalMergeStage在进行实质性的执行,说明这里决策出来的是Vertical Merge

-

-

这个merge失败了,失败的原因似乎是,在原始数据里面看到的是

DB::ColumnNothing,但是在进行merge操作的时候,发现目标的type居然是DB::ColumnLowCardinality,类型不匹配,因此失败。

查询也发生了问题

同时,我们后来发现,query也有问题:

shell

2025.10.21 09:14:27.151626 [ 3560516 ] {1a5dc00f-bd2f-414e-a73b-20e8e439058f} <Error> TCPHandler: Code: 49. DB::Exception: Bad cast from type DB::ColumnNothing to DB::ColumnLowCardinality: (while reading from part /nvme6n1/clickhouse/store/95c/95c035af-e614-4fca-9fba-ab871235e324/20250925_0_201_3_2847/ located on disk disk5 of type local): While executing MergeTreeSelect(pool: ReadPool, algorithm: Thread). (LOGICAL_ERROR), Stack trace (when copying this message, always include the lines below):

0. DB::Exception::Exception(DB::Exception::MessageMasked&&, int, bool) @ 0x000000000daffc3b

1. DB::Exception::Exception(PreformattedMessage&&, int) @ 0x0000000007e59fcc

2. DB::Exception::Exception<String, String>(int, FormatStringHelperImpl<std::type_identity<String>::type, std::type_identity<String>::type>, String&&, String&&) @ 0x0000000007e5bdcb

3. _Z11typeid_castIRKN2DB20ColumnLowCardinalityEKNS0_7IColumnEQsr3stdE14is_reference_vIT_EES6_RT0_ @ 0x00000000081b10c4

4. DB::SerializationLowCardinality::enumerateStreams(DB::ISerialization::EnumerateStreamsSettings&, std::function<void (DB::ISerialization::SubstreamPath const&)> const&, DB::ISerialization::SubstreamData const&) const @ 0x00000000111abbb0

5. DB::SerializationNamed::enumerateStreams(DB::ISerialization::EnumerateStreamsSettings&, std::function<void (DB::ISerialization::SubstreamPath const&)> const&, DB::ISerialization::SubstreamData const&) const @ 0x00000000111b7bba

6. DB::SerializationTuple::enumerateStreams(DB::ISerialization::EnumerateStreamsSettings&, std::function<void (DB::ISerialization::SubstreamPath const&)> const&, DB::ISerialization::SubstreamData const&) const @ 0x00000000111f5f02

7. DB::SerializationArray::enumerateStreams(DB::ISerialization::EnumerateStreamsSettings&, std::function<void (DB::ISerialization::SubstreamPath const&)> const&, DB::ISerialization::SubstreamData const&) const @ 0x000000001117f49d

8. DB::SerializationMap::enumerateStreams(DB::ISerialization::EnumerateStreamsSettings&, std::function<void (DB::ISerialization::SubstreamPath const&)> const&, DB::ISerialization::SubstreamData const&) const @ 0x00000000111b70e7

9. DB::IDataType::getSubcolumnData(std::basic_string_view<char, std::char_traits<char>>, DB::ISerialization::SubstreamData const&, bool) @ 0x0000000011140e8e

10. DB::IDataType::getSubcolumn(std::basic_string_view<char, std::char_traits<char>>, COW<DB::IColumn>::immutable_ptr<DB::IColumn> const&) const @ 0x0000000011141a88

11. DB::IMergeTreeReader::evaluateMissingDefaults(DB::Block, std::vector<COW<DB::IColumn>::immutable_ptr<DB::IColumn>, std::allocator<COW<DB::IColumn>::immutable_ptr<DB::IColumn>>>&) const @ 0x0000000012b403e8

12. DB::MergeTreeRangeReader::read(unsigned long, DB::MarkRanges&) @ 0x0000000012b4d96a

13. DB::MergeTreeRangeReader::read(unsigned long, DB::MarkRanges&) @ 0x0000000012b4c5ec

14. DB::MergeTreeRangeReader::read(unsigned long, DB::MarkRanges&) @ 0x0000000012b4c5ec

15. DB::MergeTreeRangeReader::read(unsigned long, DB::MarkRanges&) @ 0x0000000012b4c5ec

16. DB::MergeTreeReadTask::read(DB::MergeTreeReadTask::BlockSizeParams const&) @ 0x0000000012b6dfa8

17. DB::MergeTreeThreadSelectAlgorithm::readFromTask(DB::MergeTreeReadTask&, DB::MergeTreeReadTask::BlockSizeParams const&) @ 0x000000001346c28f

18. DB::MergeTreeSelectProcessor::read() @ 0x0000000012b6af7d

19. DB::MergeTreeSource::tryGenerate() @ 0x00000000134a2ca8

20. DB::ISource::work() @ 0x0000000013031ea7

21. DB::ExecutionThreadContext::executeTask() @ 0x000000001304b0e7

22. DB::PipelineExecutor::executeStepImpl(unsigned long, std::atomic<bool>*) @ 0x000000001303f9b0

23. void std::__function::__policy_invoker<void ()>::__call_impl<std::__function::__default_alloc_func<DB::PipelineExecutor::spawnThreads()::$_0, void ()>>(std::__function::__policy_storage const*) @ 0x000000001304106e

24. ThreadPoolImpl<ThreadFromGlobalPoolImpl<false, true>>::worker(std::__list_iterator<ThreadFromGlobalPoolImpl<false, true>, void*>) @ 0x000000000dbd4649

25. void std::__function::__policy_invoker<void ()>::__call_impl<std::__function::__default_alloc_func<ThreadFromGlobalPoolImpl<false, true>::ThreadFromGlobalPoolImpl<void ThreadPoolImpl<ThreadFromGlobalPoolImpl<false, true>>::scheduleImpl<void>(std::function<void ()>, Priority, std::optional<unsigned long>, bool)::'lambda0'()>(void&&)::'lambda'(), void ()>>(std::__function::__policy_storage const*) @ 0x000000000dbd8791

26. void* std::__thread_proxy[abi:v15007]<std::tuple<std::unique_ptr<std::__thread_struct, std::default_delete<std::__thread_struct>>, void ThreadPoolImpl<std::thread>::scheduleImpl<void>(std::function<void ()>, Priority, std::optional<unsigned long>, bool)::'lambda0'()>>(void*) @ 0x000000000dbd7509

27. ? @ 0x00007f962f528609

28. ? @ 0x00007f962f44d353我们发现,如果查询条件中有新增的这5列,那么会报和Merge一样的错误,错误本身不是发生在新增的列上,而是发生在复合列上(Map -> Array -> Tuple -> Named, 参考上面的堆栈),而如果查询条件中没有我们新增的这5列,则不会报错。

比如,当查询条件中不包含我们新增的5列的时候,查询没有问题:

select count(1)

FROM emo_mdm_flowwork_pt30m_dist AS mdm_flowwork

WHERE mdm_flowwork.customerId = 343821232 AND

mdm_flowwork.timestampMs >= '2025-09-25 00:00:00' AND

mdm_flowwork.timestampMs < '2025-10-25 00:00:00' AND

mdm_flowwork.platform = 'web' and

mdm_flowwork.flowId IN('f_5333_5842') AND

mdm_flowwork.platform = 'web' and mdm_flowwork.appBuild = 'ddd'

SELECT count(1)

FROM emo_mdm_flowwork_pt30m_dist AS mdm_flowwork

WHERE (mdm_flowwork.customerId = 343821232) AND (mdm_flowwork.timestampMs >= '2025-09-25 00:00:00') AND (mdm_flowwork.timestampMs < '2025-10-25 00:00:00') AND (mdm_flowwork.platform = 'web') AND (mdm_flowwork.flowId IN ('f_5333_5842')) AND (mdm_flowwork.platform = 'web') AND (mdm_flowwork.appBuild = 'ddd')

Query id: 1c2402fe-7bcd-4741-9074-3c32e5f196ec

┌─count()─┐

1. │ 0 │

└─────────┘但是,当查询条件中包含了我们新增的5列(mdm_flowwork.referrer = 'ddd')的时候,查询报错,且报错和我们的Merge报错一模一样:

sql

rcmp502-2.iad7.prod.corp.com :) select count(1)

FROM emo_mdm_flowwork_pt30m_dist AS mdm_flowwork

WHERE mdm_flowwork.customerId = 343821232 AND

mdm_flowwork.timestampMs >= '2025-09-25 00:00:00' AND

mdm_flowwork.timestampMs < '2025-10-25 00:00:00' AND

mdm_flowwork.platform = 'web' and

mdm_flowwork.flowId IN('f_5333_5842') AND

mdm_flowwork.platform = 'web' and mdm_flowwork.referrer = 'ddd'

SELECT count(1)

FROM emo_mdm_flowwork_pt30m_dist AS mdm_flowwork

WHERE (mdm_flowwork.customerId = 343821232) AND (mdm_flowwork.timestampMs >= '2025-09-25 00:00:00') AND (mdm_flowwork.timestampMs < '2025-10-25 00:00:00') AND (mdm_flowwork.platform = 'web') AND (mdm_flowwork.flowId IN ('f_5333_5842')) AND (mdm_flowwork.platform = 'web') AND (mdm_flowwork.referrer = 'ddd')

Query id: f2db63ff-db3a-48e5-bbca-54f70c0983d1

Elapsed: 0.057 sec.

Received exception from server (version 24.8.4):

Code: 49. DB::Exception: Received from localhost:9000. DB::Exception: Bad cast from type DB::ColumnNothing to DB::ColumnLowCardinality: (while reading from part /nvme6n1/clickhouse/store/95c/95c035af-e614-4fca-9fba-ab871235e324/20250925_0_201_3_2847/ located on disk disk5 of type local): While executing MergeTreeSelect(pool: ReadPool, algorithm: Thread). (LOGICAL_ERROR)为了让Merge成功进行,并且考虑到出问题的Merge都是Vertical Merge,因此,在将这个表的Merge方法设置为Hoizontal Merge以后,我们对这个出问题的partition进行OPTIMIZE操作。我们预计Merge完成以后的Part会为这些新增的5列生成对应的Column。这样,基于OPTIMIZE完成的Parts进行查询,就根本不会走到evaluateMissingDefaults()的code path。

所以,我们对这张表的Partition 20250925进行OPTIMIZE操作(对应的OPTIMIZE SQL这里不展示),然后查询system.merges表查看进度:

sql

rcmp502-2.iad7.prod.corp.com :) SELECT database,

table,

partition,

merge_algorithm,

source_part_names,

result_part_name,

progress,

result_part_path,

FROM system.merges

WHERE partition = '20250925' format vertical

Query id: 11c09536-f4dc-4a7a-844b-f6d15be01c02

Row 1:

──────

database: default

table: emo_mdm_flowwork_pt30m_local

partition: 20250925

merge_algorithm: Horizontal

source_part_names: ['20250925_0_201_3_2847','20250925_202_383_3_2847','20250925_384_542_3_2847','20250925_543_549_1_2847','20250925_550_1767_4_2847','20250925_1768_1986_3_2847','20250925_1987_2194_3_2847','20250925_2195_2442_3_2847','20250925_2443_2588_3_2847','20250925_2589_2846_81_2847']

result_part_name: 20250925_0_2846_82_2847

progress: 0.34351304050416925

result_part_path: /nvme2n1/clickhouse/store/95c/95c035af-e614-4fca-9fba-ab871235e324/20250925_0_2846_82_2847/

1 row in set. Elapsed: 0.001 sec.可以看到,由于我们设置了以下参数导致Merge的确开始走Horizontal Merge而不是Vertical Merge, 当前Merge正在进行:

vertical_merge_algorithm_min_rows_to_activate = 2000000000, vertical_merge_algorithm_min_bytes_to_activate = '536870912000'同时,我们查看Merge对应的Target Part,已经含有了新增的这五列:

root@rcmp502-2:/data/log/clickhouse-server# ls -lh /nvme2n1/clickhouse/store/95c/95c035af-e614-4fca-9fba-ab871235e324/tmp_merge_20250925_0_2846_82_2847|grep refer

-rw-r----- 1 clickhouse clickhouse 0 Oct 21 09:19 referrer.bin

-rw-r----- 1 clickhouse clickhouse 16K Oct 21 10:10 referrer.cmrk2

-rw-r----- 1 clickhouse clickhouse 0 Oct 21 09:19 referrerHost.bin

-rw-r----- 1 clickhouse clickhouse 16K Oct 21 10:10 referrerHost.cmrk2

-rw-r----- 1 clickhouse clickhouse 0 Oct 21 09:19 referrerHost.sparse.idx.bin

-rw-r----- 1 clickhouse clickhouse 60K Oct 21 10:10 referrerHost.sparse.idx.cmrk2

-rw-r----- 1 clickhouse clickhouse 0 Oct 21 09:19 referrer.sparse.idx.bin

-rw-r----- 1 clickhouse clickhouse 60K Oct 21 10:10 referrer.sparse.idx.cmrk2而在出问题的这个source part 20250925_0_201_3_2847上,的确不包含我们新增的这5列,因此,如果读取操作touch到这个source part,并且查询条件包含了我们新增的这5列中的任意一列,就会触发到evaluateMissingColumns的代码:

shell

root@rcmp502-2:/data/log/clickhouse-server# ls -lh /nvme6n1/clickhouse/store/95c/95c035af-e614-4fca-9fba-ab871235e324/20250925_0_201_3_2847/|grep refer

root@rcmp502-2:/data/log/clickhouse-server#我们需要查看这些有问题的Parts是否有一些共同特征。

首先,我们需要知道受到影响的表是哪些,比如,这些表是否的确是我们运行了ALTER TABLE ADD COLUMN的那些表。

shell

root@rcmp501-3:~# zgrep -h "Bad cast from type DB::ColumnNothing to DB::ColumnLowCardinality" /var/log/clickhouse-server/clickhouse-server.log 2>/dev/null | sed -nE 's#^([0-9]{4}\.[0-9]{2}\.[0-9]{2}) ([0-9:.]+).* \{[^:]+::([^}]+)\}.*reading from part .*/([0-9]{8}_[0-9]+_[0-9]+_[0-9]+)/.*#\1 \2 \3 <- \4#p'

2025.09.29 01:08:22.922473 20250925_6_11_1 <- 20250925_6_6_0

2025.09.29 01:08:22.926772 20250925_202_272_6 <- 20250925_202_232_5

2025.09.29 01:08:22.998776 20250924_45_47_1 <- 20250924_45_45_0

2025.09.29 01:08:23.105324 20250925_202_272_6 <- 20250925_202_232_5

2025.09.29 01:08:23.195743 20250924_45_47_1 <- 20250924_45_45_0

2025.09.29 01:08:23.252058 20250919_28_47_2 <- 20250919_28_33_1

2025.09.29 01:08:23.379854 20250925_6_11_1 <- 20250925_6_6_0

.......然后,我们针对这些part,搜索system.parts表,看看他们是否都属于某些或者某一张表:

shell

rcmp504-3.iad7.prod.corp.com :) WITH '

20250904_0_2877_5

20250904_0_801_4

20250905_0_2247_5

...

20250925_811_811_0

20250925_811_819_1

' AS parts_str

SELECT

names.part_name,

ap.source,

ap.database,

ap.`table`,

ap.active,

ap.partition_id,

ap.min_block_number,

ap.max_block_number,

ap.level,

ap.path

FROM

(SELECT arrayJoin(splitByChar('\n', parts_str)) AS part_name) AS names

LEFT JOIN

(

SELECT 'active' AS source, database, `table`, name AS part_name, active, partition_id, min_block_number, max_block_number, level, path

FROM system.parts

UNION ALL

SELECT 'detached' AS source, database, `table`, name AS part_name, 0 AS active, partition_id, min_block_number, max_block_number, level, path

FROM system.detached_parts

) AS ap USING part_name

WHERE names.part_name != ''

ORDER BY names.part_name, ap.source, ap.database, ap.`table`;

......

Query id: 680585fa-32f9-4545-b996-dd83808fa088

┌─part_name────────────┬─source─┬─database─┬─table───────────────────────────┬─active─┬─partition_id─┬─min_block_number─┬─max_block_number─┬─level─┬─path───────────────────────────────────────────────────────────────────────────────────────────────────┐

1. │ 20250904_0_2877_5 │ │ │ │ 0 │ ᴺᵁᴸᴸ │ ᴺᵁᴸᴸ │ ᴺᵁᴸᴸ │ ᴺᵁᴸᴸ │ │

2. │ 20250904_0_801_4 │ active │ default │ emo_mdm_flowwork_pt1m_local │ 1 │ 20250904 │ 0 │ 801 │ 4 │ /nvme7n1/clickhouse/store/03b/03b9bab7-a53b-416d-94a5-02e2a211f5db/20250904_0_801_4/ │

3. │ 20250905_0_2247_5 │ │ │ │ 0 │ ᴺᵁᴸᴸ │ ᴺᵁᴸᴸ │ ᴺᵁᴸᴸ │ ᴺᵁᴸᴸ │ │

4. │ 20250905_0_829_4 │ active │ default │ emo_mdm_flowwork_pt1m_local │ 1 │ 20250905 │ 0 │ 829 │ 4 │ /nvme2n1/clickhouse/store/03b/03b9bab7-a53b-416d-94a5-02e2a211f5db/20250905_0_829_4/ │

5. │ 20250909_2015_2057_2 │ active │ default │ emo_mdm_flowwork_pt30m_local │ 1 │ 20250909 │ 2015 │ 2057 │ 2 │ /nvme12n1/clickhouse/store/95c/95c035af-e614-4fca-9fba-ab871235e324/20250909_2015_2057_2/ │

6. │ 20250909_2015_2129_3 │ │ │ │ 0 │ ᴺᵁᴸᴸ │ ᴺᵁᴸᴸ │ ᴺᵁᴸᴸ │ ᴺᵁᴸᴸ │ │

7. │ 20250911_0_2758_5 │ │ │ │ 0 │ ᴺᵁᴸᴸ │ ᴺᵁᴸᴸ │ ᴺᵁᴸᴸ │ ᴺᵁᴸᴸ │我们确认,这些出问题的表都发生在以emo_mdm_flowwork*开头的表中,而在25/Sep的时候,我们的确专门针对这几张表做过变更,但是变更很简单,就是加了几个Column而已:

sql

ALTER TABLE {{ DATABASE NAME PLACEHOLDER }}.emo_mdm_flowwork_pt1m_local ON CLUSTER {{ CLUSTER NAME PLACEHOLDER FOR ALL HOSTS }}

ADD COLUMN IF NOT EXISTS `host` String DEFAULT '' CODEC(ZSTD(1)) AFTER connType,

ADD COLUMN IF NOT EXISTS `path` String DEFAULT '' CODEC(ZSTD(1)) AFTER host,

ADD COLUMN IF NOT EXISTS `referrer` String DEFAULT '' CODEC(ZSTD(1)) AFTER path,

ADD COLUMN IF NOT EXISTS `title` String DEFAULT '' CODEC(ZSTD(1)) AFTER referrer,

ADD COLUMN IF NOT EXISTS `referrerHost` String DEFAULT '' CODEC(ZSTD(1)) AFTER title;同时,我们从part的partition信息可以看到,所有出问题的part的partition都是25/Sep和以前,所有在这个日期以后的part都没有发生问题。所以,我们在25/Sep的变更行为影响到了已有的旧part,没有影响后来新ingest的part。

我们的pt1m的表的retention大概是1个星期,这意味着这些出问题的part其实已经快要被drop了。但是我们的pt30m的表的retention是1年左右,离被drop的时间还远。按照我们随后看到的系统恶化的速度,我们不可能不处理这个问题。

从我们添加column的语句可以看到,新添加的这几个column都不是LowCardinality的Column,这些Column都是普通的String类型,都有一个空字符串作为默认值。

既然是这样,说明堆栈中所报的错误的Column并不是我们新添加的这5个Column,但是这不能排除异常发生的原因是我们添加Column的行为所间接导致的。

同时,我们查询system.columns,可以看到表的所有的列。我们可以看到,我们的表的确是有大量的LowCardinality列,有一部分的LowCardinality存在于复杂类型(注意区分复杂类型和嵌套列Nested Column),比如Map(LowCardinality(String), String),我们从堆栈里面看到报错的就是这种复合类型的报错,而不是简单类型的LowCardinality报错。

rcmp504-3.iad7.prod.corp.com :) SELECT

c.name,

c.type AS table_type,

p.type AS part_type,

p.serialization_kind,

p.default_kind

FROM system.columns c

LEFT JOIN system.parts_columns p

ON p.database=c.database AND p.table=c.table AND p.column=c.name

AND p.active AND p.path LIKE '%/20250911_0_863_4/%'

WHERE c.database='default' AND c.table='emo_mdm_flowwork_pt1m_local'

ORDER BY c.name;

SELECT

c.name,

c.type AS table_type,

p.type AS part_type,

p.serialization_kind,

p.default_kind

FROM system.columns AS c

LEFT JOIN system.parts_columns AS p ON (p.database = c.database) AND (p.`table` = c.`table`) AND (p.column = c.name) AND p.active AND (p.path LIKE '%/20250911_0_863_4/%')

WHERE (c.database = 'default') AND (c.`table` = 'emo_mdm_flowwork_pt1m_local')

ORDER BY c.name ASC

Query id: 3701d30c-45d2-435d-8645-a2363e388ec8

┌─name─────────────────────────┬─table_type───────────────────────────┬─part_type────────────────────────────┬─serialization_kind─┬─p.default_kind─┐

1. │ appBuild │ LowCardinality(String) │ LowCardinality(String) │ Default │ │

5. │ asn │ Int32 │ Int32 │ Default │ DEFAULT │

6. │ browserName │ LowCardinality(String) │ LowCardinality(String) │ Default │ DEFAULT │

...

27. │ host │ String │ │ │ │

28. │ inSession │ UInt8 │ UInt8 │ Default │ │

29. │ inUserSession │ UInt8 │ UInt8 │ Default │ │

....

....

77. │ tagGroup11 │ Map(LowCardinality(String), String) │ ....

90. │ timestampMs │ DateTime64(3) │ DateTime64(3) │ Default │ │

....

95. │ watermarkMs │ DateTime64(3) │ DateTime64(3) │ Sparse │ │

└─name─────────────────────────┴─table_type───────────────────────────┴─part_type────────────────────────────┴─serialization_kind─┴─p.default_kind─┘指标分析

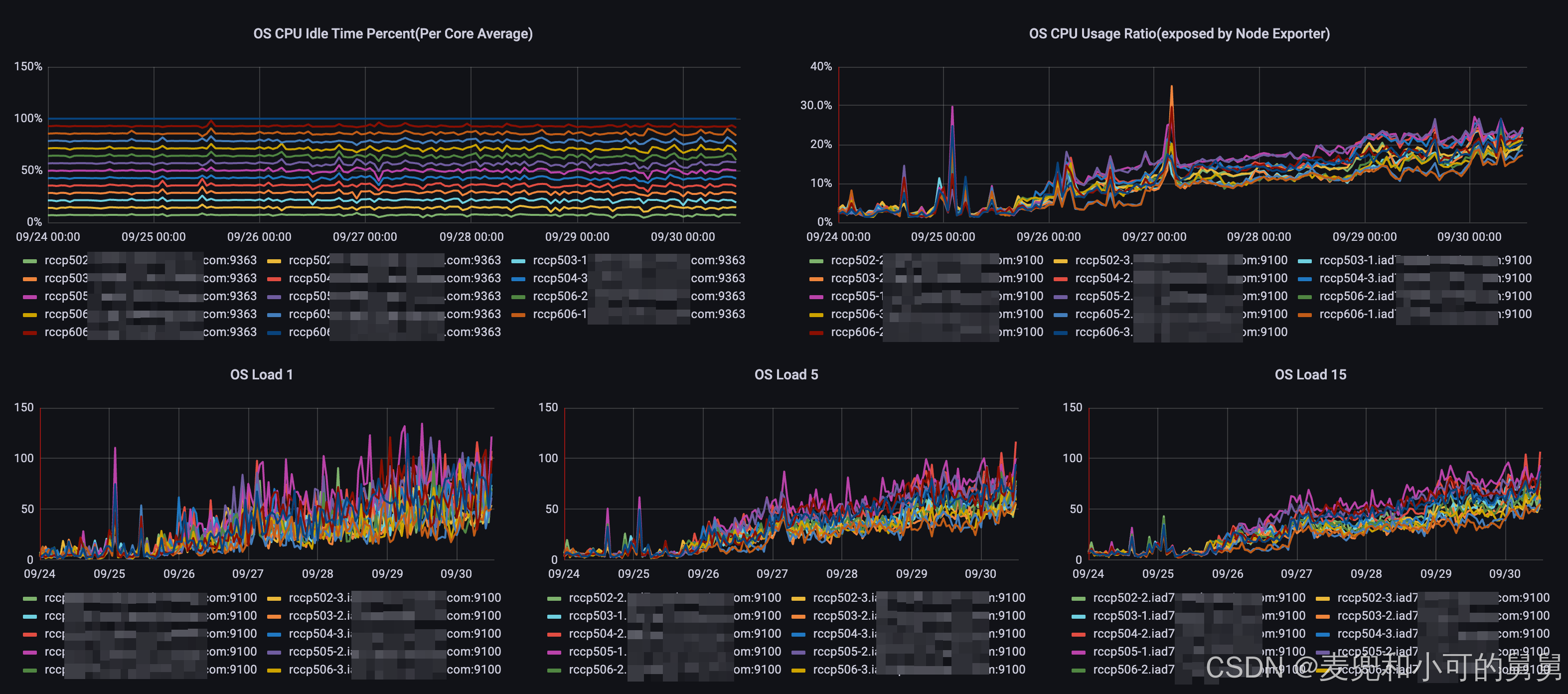

我们从25/Sep开始对系统做了以上变更以后,尽管查询和数据插入目前都能正常进行,但是系统的多项指标都显示整个系统处于不健康状态,并且该状态在逐渐恶化,如果不进行处理,系统将有崩溃的风险。

-

CPU使用率和CPU Load逐渐升高

-

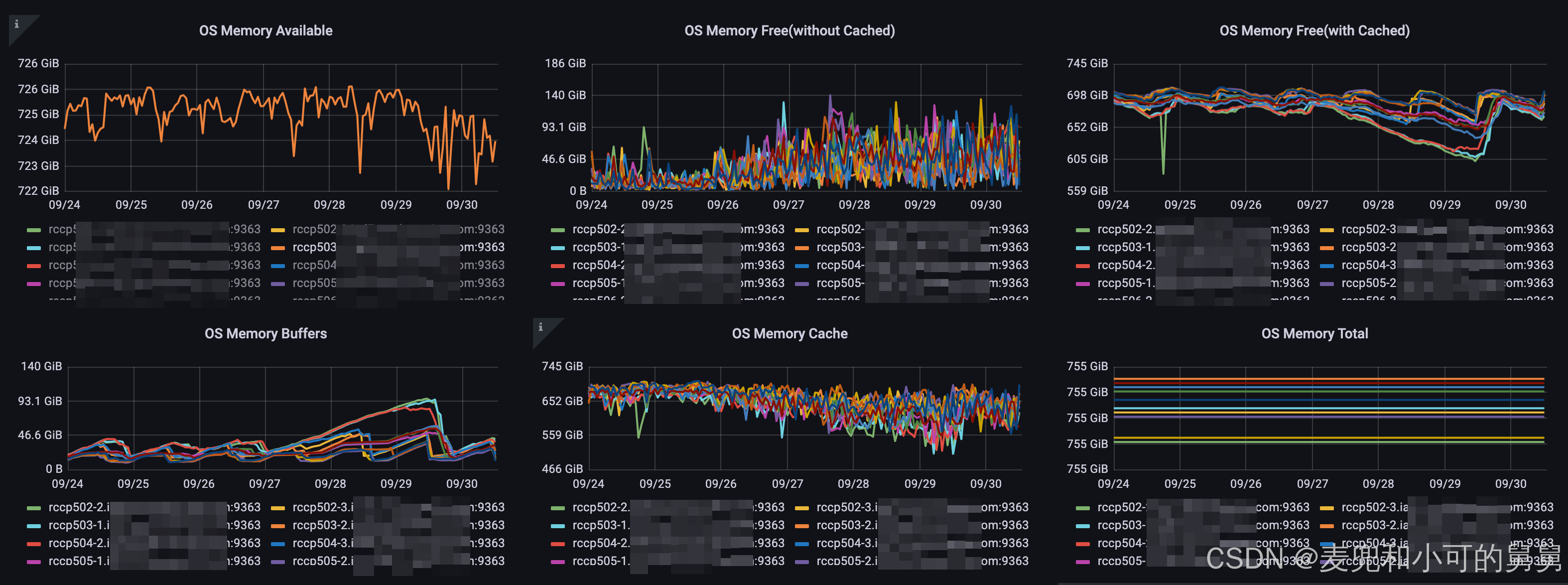

操作系统内存

我们的每台机器是被ClickHouse服务器独占,因此操作系统的内存使用情况就是ClickHouse进程的内存使用情况。可以看到,内存层面没有发生明显变化,整个的Cached Memory在增加,说明系统在发生大量的数据读取操作,但是整个的available memory没有呈现明显变化,说明实际的内存使用(不包含cache)没有明显变化。

-

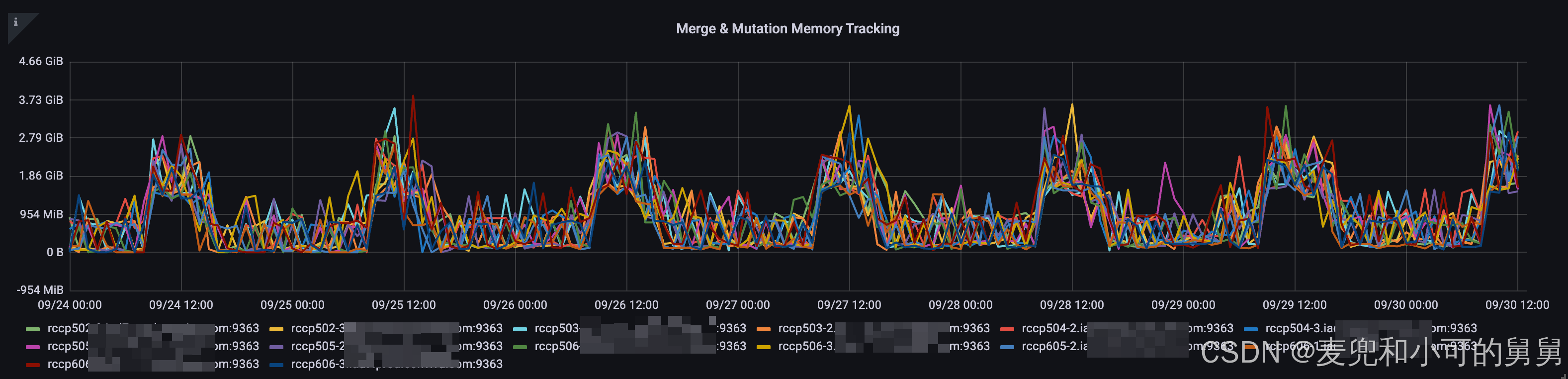

MergeAndMutation Memory Tracking

我们知道,在ClickHouse里面,有一个针对Merge和Mutation总的内存使用量的Metrics信息,因为Merge和Mutation是一起做的,所以并没有对他们分开进行track。

我们可以看到,整个Merge Mutate Memory在每天的一定时段出现高峰,这主要是由于数据输入量的变化导致的,与我们的系统问题无关。但是,我们横向对比每一天的高峰时段可以看到,在25/Sep以后,整个MergeMutate的Memory使用量是稍微高于25/Sep以前的同一时段的MergeMutate的Memory的。但是总的说来,Merge & Mutate Memory的使用量不大,高峰时段也就3GB左右。

-

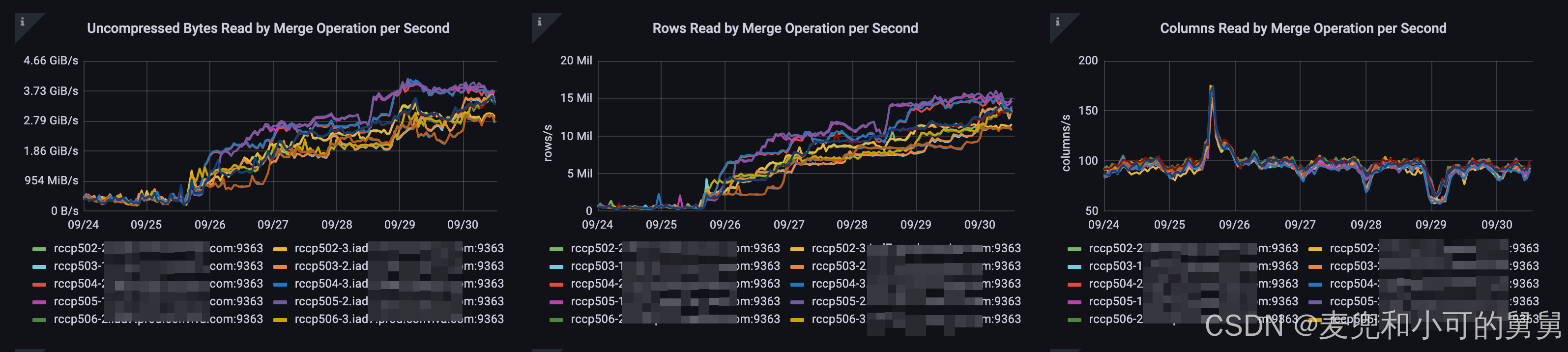

Merge的输入数据量

我们可以看到,自从25/Sep以后,整个Merge的输入数据量在明显升高,行数和数据大小都随着时间升高在不断上升。

这可能是由于失败的Merge在反复重试导致的。

这可能是由于失败的Merge在反复重试导致的。 -

后台正在运行的Merge Task的数量

我们可以看到,自从25/Sep以后,整个并行运行的Merge Task的数量也在不断升高:

这可能是由于失败的Merge在反复重试导致的。

这可能是由于失败的Merge在反复重试导致的。 -

启动的Merge任务的频率

这可能是由于失败的Merge在反复重试导致的。

这可能是由于失败的Merge在反复重试导致的。

诊断过程

由于是ReplicatedMergeTree,因此所有的Merge 任务都会进入到replicaion_queue,因此,我们查询replication_queue,可以看到大量的发生了异常的replication任务。

例如,我们在上面说过,我们可以搜索到带有%Bad cast from type DB%'异常信息的replication任务。

由于我们已经可以从日志中知道具体发生问题的part,因此,我们专门基于这些问题part进行查询,看看基本的查询是否正常(其实已经基本可以预测到查询不会受影响,否则我们早就收到来自上游业务方的报警了):

rcmp504-3.iad7.prod.corp.com :) SELECT *

FROM default.emo_mdm_flowwork_pt1m_local

WHERE _part='20250911_0_863_4'

LIMIT 1;

SELECT *

FROM default.emo_mdm_flowwork_pt1m_local

WHERE _part = '20250911_0_863_4'

LIMIT 1

Query id: eb3141b3-79a0-47bb-865c-09a281da09d0

┌─────────────timestampMs─┬─flowId───┬─────────flowStartTimeMs─┬─customerId─┬─clientId──────────────────────────────┬─more_columns─┐

│ 2025-09-11 05:09:59.999 │ life_min │ 2025-09-11 00:40:25.446 │ 1960181845 │ 1494324132.198588879.1376786135.1431512500 │ ... │

└──────────────────────────┴──────────┴──────────────────────────┴────────────┴──────────────────────────────────────┴──────────────┘读这个 part 的大部分的"普通查询路径"没触发异常,但是上文讲过,假如我们的查询条件中含有我们新增的5列,那么查询会抛出和Merge一模一样的异常。异常只在 Vertical merge/mutate 的写入路径里出现(堆栈在 VerticalMergeStage 和SerializationLowCardinality)

原因分析

有可能报错的就是我添加的5列吗

上文已经说过了: 不可能。我们新增的5列都不是LowCardinality列,也不是复合列,而报错显然跟LowCardinality相关,并且是复合列。

为什么刚好只有我添加5列以前的Partition报错,而添加5列以后的Partition均不报错?

对于这个问题,我们首先想到的最简单的可能性是,有没有可能我们添加这5列以前,表都是进行HorizontalMerge,而在添加了这5列以后,表都是进行Vertical Merge,因此触发了VerticalMerge 的bug呢?

于是,我们看了一下chooseMergeAlgorithm()的选择算法:

cpp

MergeAlgorithm MergeTask::ExecuteAndFinalizeHorizontalPart::chooseMergeAlgorithm() const

{

.....

bool enough_ordinary_cols = global_ctx->gathering_columns.size() >= data_settings->vertical_merge_algorithm_min_columns_to_activate;

bool enough_total_rows = total_rows_count >= data_settings->vertical_merge_algorithm_min_rows_to_activate;

bool enough_total_bytes = total_size_bytes_uncompressed >= data_settings->vertical_merge_algorithm_min_bytes_to_activate;

bool no_parts_overflow = global_ctx->future_part->parts.size() <= RowSourcePart::MAX_PARTS;

auto merge_alg = (is_supported_storage && enough_total_rows && enough_total_bytes && enough_ordinary_cols && no_parts_overflow) ?

MergeAlgorithm::Vertical : MergeAlgorithm::Horizontal;

return merge_alg;

}可以看到,Vertical/Horizontal Merge的决策与数据的行数(vertical_merge_algorithm_min_rows_to_activate)、与数据的大小(vertical_merge_algorithm_min_bytes_to_activate)以及列的数量(vertical_merge_algorithm_min_columns_to_activate)有关:

总之,Horizontal Merge 是默认的"稳妥通用路径",Vertical Merge是在特定情况下为了降低 merge 成本才启用的"优化路径"。

它用一组条件去判断 Vertical 是否"值得且安全":

- merge 的规模足够大(行数大、数据量大),才有可能抵消 Vertical 自身带来的额外流程成本;如果 merge 很小,用 Vertical 反而可能更慢,所以直接用 Horizontal。

- 待处理的普通列足够多(宽表),Vertical 才能通过"先处理少量关键列、再补齐其它列"的方式显著减少无谓的 IO/CPU;列不多时 Vertical 收益不明显。

- 存储实现本身支持 Vertical;不支持就只能走 Horizontal。

- 参与 merge 的 part 数量不能太多,因为 Vertical Merge 需要记录"每行来自哪个 source part"的来源信息,part 太多会超出它能承载/编码的范围,因此必须回退 Horizontal

Vertical Merge:

在一次 merge 里,Merge的输入不是一份数据,而是 多份 source part(比如 part A、part B、part C)按顺序合成一个新 part。

Vertical merge 的过程通常是"两阶段"的:

第一阶段只读/处理"关键列"(主要是排序键相关列),并决定输出新 part 的行顺序以及哪些行会被保留/丢弃(例如在 Collapsing / Replacing 等场景会影响)。

第二阶段需要把其它列(非关键列)也写进新 part。为了做到这一点,它必须知道:新 part 的第 N 行,原本是来自哪一个 source part 的哪一行,这样才能回到对应的 source part 去把那一行的其它列取出来并写入。

所以,对新生成 part 的每一行,Vertial Merge需要记录一个"来源标记",至少包含:

这一行的来源 part 的编号/索引(A/B/C 中的哪一个)

这一行在该 part 内的行位置(或等价的定位信息)

我们添加列的行为根本没有改变数据的行数和数据的大小,因此如果是Horizontal/Vertical Merge导致的,那只有可能跟vertical_merge_algorithm_min_columns_to_activate有关,即,当列的数量增多的时候,ClickHouse的确开始倾向于进行Vertical Merge: 当gathering_columns列的数量增加到超过 vertical_merge_algorithm_min_columns_to_activate的时候,就开始倾向于使用Vertical Merge。

cpp

M(UInt64, vertical_merge_algorithm_min_rows_to_activate, 16 * 8192, "Minimal (approximate) sum of rows in merging parts to activate Vertical merge algorithm.", 0) \

M(UInt64, vertical_merge_algorithm_min_bytes_to_activate, 0, "Minimal (approximate) uncompressed size in bytes in merging parts to activate Vertical merge algorithm.", 0) \

M(UInt64, vertical_merge_algorithm_min_columns_to_activate, 11, "Minimal amount of non-PK columns to activate Vertical merge algorithm.", 0) \可是,我们清楚的看到,即使在添加这一列以前,我们表中的gathering_column的数量也在30+,所以,不可能是由于添加了列导致chooseMergeAlgorithm()的决策结果变化导致的。我们查看监控也可以看到,历史上也都是进行的Vertical Merge。

为什么我添加这5列以前,那些partition都不出错

后面我们会讲解,我们的加列行为导致了加列以前的partition的part中缺失这些列,即这些列在part中存在但是在表中不存在,正是因为在part中这些列不存在,才导injectRequiredColumns()对Map(LowCardinality(String), String)列的添加,进而导致在evaluateMissingColumns()这个堆栈的过程中发生了LowCardinality(String)到String的转换异常。

ClickHouse会对part中不存在但是表中存在的列进行Vertical Merge吗

答案是,会。

我们本身的例子就证明(后面添加日志会证明),问题发生的时候正是因为对host列进行merge的时候发生的,而发生类型转换错误正是因为host在part中不存在。

我们在讲解Merge的时候会专门讲解,ClickHouse在进行Vertical Merge的时候,会对Merging Column(比如,sorting column)进行Horizontal Merge,而对Gather Column(普通的非排序键)进行逐列的vertical merge。所以,回答Vertial Merge是否会对host进行merge,其实就是回答Vertical Merge是否会对那种在表中存在但是在part中不存在的列进行merge?

我们看一下生成Merging Column和生成Gathering Column的方法MergeTask::ExecuteAndFinalizeHorizontalPart::extractMergingAndGatheringColumns()进行分析:

cpp

/// PK columns are sorted and merged, ordinary columns are gathered using info from merge step

void MergeTask::ExecuteAndFinalizeHorizontalPart::extractMergingAndGatheringColumns() const

{

.....

/// TODO: also force "summing" and "aggregating" columns to make Horizontal merge only for such columns

for (const auto & column : global_ctx->storage_columns)

{

// 如果这个列是Sorting Column

if (key_columns.contains(column.name))

{

// 加入到merging_columns中去

global_ctx->merging_columns.emplace_back(column);

/// If column is in horizontal stage we need to calculate its indexes on horizontal stage as well

auto it = global_ctx->skip_indexes_by_column.find(column.name);

// 如果这个column同时也是被某一个二级索引所独立依赖(即这个二级索引独立依赖这个column)

if (it != global_ctx->skip_indexes_by_column.end())

{

// 遍历 独立依赖这个column的所有的 index(即可能我们为这个column创建了多个index,每个index都独立依赖这个column), 把这个index都加入到merging_skip_indexes中,这样,这个index就不会延迟到vertical merge阶段处理了

for (auto & index : it->second) //

global_ctx->merging_skip_indexes.push_back(std::move(index));

// 把这个column从skip_indexes_by_column这个map中删除,这样,所有独立依赖这个column的index都不会被延迟到vertical处理了,因为这个column是一个merging_column,不会被延迟处理

global_ctx->skip_indexes_by_column.erase(it);

}

}

else

{

// gathering_columns,会在vertical merge阶段处理

global_ctx->gathering_columns.emplace_back(column);

}

}

}我们可以清楚的看到,这里的for循环的列来源是global_ctx->storage_columns,熟悉ClickHouse代码的就会明白,在ClickHouse中,Storrage Column指的就是表的Column定义,与Part中的定义无关 。global_ctx->storage_columns 就是表结构里的完整列描述(StorageSnapshot::metadata->getColumns().getAllPhysical())。它反映的是"表里有哪些物理列",跟当前 part 是否实际有这些文件无关,因此列表里当然包含那些"在表里定义、但在某些 part 上缺失"的列。后续 merging_columns/gathering_columns 的划分,是在这个完整列表的基础上按排序键、延迟读取等规则拆分;真正判断某列在 part 上有没有文件,是在 Reader 层通过 hasColumnFiles()、tryGetColumnOrSubcolumn() 等接口去做的。

而Vertical Merge会以协程的方式,反复调用prepareVerticalMergeForAllColumns()方法,不断从gathering_columns中获取列,进行一列一列的merge:

cpp

bool MergeTask::VerticalMergeStage::prepareVerticalMergeForAllColumns() const

{

....

if (ctx->use_prefetch && ctx->it_name_and_type != global_ctx->gathering_columns.end())

ctx->prepared_pipe = createPipeForReadingOneColumn(ctx->it_name_and_type->name);

return false;

}MergeTreeSequentialSource的构造和依赖列的添加

构造的基本过程

在我的关于Merge的文章中讲解过,对于一个VerticalMerge,它其实会对Sorting Key进行Horizontal Merge,即对Sorting Key进行同时读取,而对非Sorting Key(ClickHouse叫做Gathering Columns)进行Vertical Merge,即一列一列进行单独的Merge。

Merge的读取过程是通过MergeTreeSequentialSource类来封装的,即,**一个MergeTreeSequentialSource对象封装了对某一个Part中的一列(比如Gathering Column)或者多列(比如Merging Columns)的读取,而对这个Part中的某一列的真正读取,则是由IMergeTreeReader对象负责的,下文会讲解:

-

如果是进行Horizontal Merge,那么会创建

MergeTreeSequentialSource这个ISource实现,负责读取一个Part中这个Horizontal Merge所负责的所有列。可以看到,这个发生在Merge的三个Stage中的 第一个Stage即ExecuteAndFinalizeHorizontalPart的prepare()中的:cpp// 在 ExecuteAndFinalizeHorizontalPart::prepare()中被调用 void MergeTask::ExecuteAndFinalizeHorizontalPart::createMergedStream() { ...... for (const auto & part : global_ctx->future_part->parts) { Pipe pipe = createMergeTreeSequentialSource( MergeTreeSequentialSourceType::Merge, *global_ctx->data, global_ctx->storage_snapshot, part, global_ctx->merging_columns.getNames(), // 对应的merging_columns,对于Vertical Merge,这个merging column仅仅是索引列,而对于horizontal merge,这个merging_column就是所有的Physical Columns .....); pipes.emplace_back(std::move(pipe)); } -

如果是进行Vertical Merge,那么会创建

MergeTreeSequentialSource这个ISource实现并进一步封装成Pipeline,这个MergeTreeSequentialSource对象就负责读取一个Part中的HorizontalMerge所对应的某一列。可以看到,这里是在 Merge的第二个Stage 即VerticalMergeStage中进行的:cppPipe MergeTask::VerticalMergeStage::createPipeForReadingOneColumn(const String & column_name) const { Pipes pipes; for (size_t part_num = 0; part_num < global_ctx->future_part->parts.size(); ++part_num) { Pipe pipe = createMergeTreeSequentialSource( MergeTreeSequentialSourceType::Merge, *global_ctx->data, global_ctx->storage_snapshot, global_ctx->future_part->parts[part_num], // 需要读取的part Names{column_name}, // 对于Vertical Merge, ....); pipes.emplace_back(std::move(pipe)); } return Pipe::unitePipes(std::move(pipes)); }由于

createPipeForReadingOneColumn()是对gathering column进行vertical merge所触发的。上文我们讲到过,这里的Gathering Column就是非Sorting Key的column,并且,这个Column包含我们新增的那5列,即那种在表中存在但是Part中不存在Column。

下文我们会通过日志证明,在我们的失败场景下,这里传入的Column就是我们通过ALTER TABLE .. ADD COLUMN所添加的host列,由于host列在当前part中不存在,才导致了后续的evaluateMissingDefault()调用链的触发,以及随后的异常的发生。

我们看一下createMergeTreeSequentialSource(...)方法中构造MergeTreeSequentialSource的过程:

```cpp

Pipe createMergeTreeSequentialSource(

MergeTreeSequentialSourceType type,

const MergeTreeData & storage,

const StorageSnapshotPtr & storage_snapshot,

MergeTreeData::DataPartPtr data_part, // 需要读取的part

Names columns_to_read, // 需要读取的列,可以看到,在Vertical Merge中,这个列是merging_columns,而不是gathering_columns

std::optional<MarkRanges> mark_ranges,

std::shared_ptr<std::atomic<size_t>> filtered_rows_count,

bool apply_deleted_mask,

bool read_with_direct_io,

bool prefetch)

{

/// The part might have some rows masked by lightweight deletes

const bool need_to_filter_deleted_rows = apply_deleted_mask && data_part->hasLightweightDelete();

const bool has_filter_column = std::ranges::find(columns_to_read, RowExistsColumn::name) != columns_to_read.end();

if (need_to_filter_deleted_rows && !has_filter_column)

columns_to_read.emplace_back(RowExistsColumn::name);

auto column_part_source = std::make_shared<MergeTreeSequentialSource>(type,

storage, storage_snapshot, data_part, columns_to_read, std::move(mark_ranges),

/*apply_deleted_mask=*/ false, read_with_direct_io, prefetch);

Pipe pipe(std::move(column_part_source));

....

return pipe;

}

```我们可以看到,MergeTreeSequentialSource 是一个ISource的实现(关于ClickHouse的ISource接口的作用,参考我的另外一篇文章),

cpp

/// Lightweight (in terms of logic) stream for reading single part from

/// MergeTree, used for merges and mutations.

///

/// NOTE:

/// It doesn't filter out rows that are deleted with lightweight deletes.

/// Use createMergeTreeSequentialSource filter out those rows.

class MergeTreeSequentialSource : public ISource在Merge/Mutate的时候,会构造对应每一个part的读取流到整个Pipeline中,其中每一个Part的读取被封装成一个ISource的实例MergeTreeSequentialSource。

在构造MergeTreeSequentialSource实例的时候,传入了它所负责读取的source part MergeTreeData::DataPartPtr data_part_:

cpp

MergeTreeSequentialSource::MergeTreeSequentialSource(

MergeTreeSequentialSourceType type,

const MergeTreeData & storage_,

const StorageSnapshotPtr & storage_snapshot_,

MergeTreeData::DataPartPtr data_part_,

Names columns_to_read_, // 在Vertical Merge的场景下,这个columns_to_read_是当前需要进行merge的一个单独列,只有horizontal merge才会是多个列

std::optional<MarkRanges> mark_ranges_,

bool apply_deleted_mask,

bool read_with_direct_io_,

bool prefetch)

: ISource(storage_snapshot_->getSampleBlockForColumns(columns_to_read_))

, storage(storage_)

, storage_snapshot(storage_snapshot_)

, data_part(std::move(data_part_))

, columns_to_read(std::move(columns_to_read_)) // 需要进行处理的列

, read_with_direct_io(read_with_direct_io_)

, mark_ranges(std::move(mark_ranges_))

, mark_cache(storage.getContext()->getMarkCache())

{

auto options = GetColumnsOptions(GetColumnsOptions::AllPhysical) // 只考虑真正定义的列,不考虑alias这种表达式

.withExtendedObjects()

.withVirtuals() // 允许虚拟列,比如_part, _partition_id等

.withSubcolumns(storage.supportsSubcolumns()); // 允许子列,比如允许a.b这类子列名作为合法列来解析

// 设置此次需要请求读取的列,这些列不一定在当前的Part中存在,如果不存在,最后就会导致

// 设置此次需要请求读取的列,这些列不一定在当前的Part中存在,如果不存在,最后就会导致

auto columns_for_reader = storage_snapshot->getColumnsByNames(options, columns_to_read);

....

MergeTreeReaderSettings reader_settings =

{

.read_settings = read_settings,

.save_marks_in_cache = false,

.apply_deleted_mask = apply_deleted_mask,

.can_read_part_without_marks = true,

};

if (!mark_ranges)

mark_ranges.emplace(MarkRanges{MarkRange(0, data_part->getMarksCount())});

// 构造一个IMergeTreeReader对象,用来对特定的一个Part进行读取。

// IMergeTreeReader实现了一部分功能,但是有些功能放在了它的子类MergeTreeReaderWide和MergeTreeReaderCompact中

reader = data_part->getReader(

columns_for_reader, // 需要请求进行读取的列,这些列不一定真的就在part中存在

storage_snapshot,

*mark_ranges,

/*virtual_fields=*/ {},

/*uncompressed_cache=*/ {},

mark_cache.get(),

alter_conversions,

reader_settings,

/*avg_value_size_hints=*/ {},

/*profile_callback=*/ {});

if (prefetch)

reader->prefetchBeginOfRange(Priority{});

}我们从构造方法MergeTreeSequentialSource::MergeTreeSequentialSource()中可以看到

-

一个

MergeTreeSequentialSource对象是针对某一个part的ISource实现类,即针对某一个Part的读取操作; -

columns_to_read是在构造MergeTreeSequentialSource的时候由调用者传入。我们在下文会详细讲到,在VerticalMergeStage(所有Merge的3个Stage中的第二个Stage)中构造MergeTreeSequentialSource的时候,传入的是针对这个Part的Gathering Colum中的某一个Column,columns_to_read此时仅仅是一个Column。我们在讲解Merge的文章中会详细讲解,这是Gathering Columns中的某一个Column! -

根据传入的

columns_to_read,转换成一个NamesAndTypesList columns_for_reader对象,即为当前的Column赋予了对应的类型信息:auto columns_for_reader = storage_snapshot->getColumnsByNames(options, columns_to_read); -

然后,针对这个Part的这个Column,调用了

IMergeTreeDataPart::getReader()方法,该方法返回了用来读取这个Part的IMergeTreeReader,具体的,会根据part是wide还是compact类型,调用IMergeTreeReaderWide::getReader()或者IMergeTreeReaderCompact::getReader()方法:cppusing MergeTreeReaderPtr = std::unique_ptr<IMergeTreeReader>; virtual MergeTreeReaderPtr getReader( const NamesAndTypesList & columns_, // column的list const StorageSnapshotPtr & storage_snapshot, const MarkRanges & mark_ranges, const VirtualFields & virtual_fields, UncompressedCache * uncompressed_cache, MarkCache * mark_cache, const AlterConversionsPtr & alter_conversions, const MergeTreeReaderSettings & reader_settings_, const ValueSizeMap & avg_value_size_hints_, const ReadBufferFromFileBase::ProfileCallback & profile_callback_) const = 0;

所以,问题的关键是从evaluateMissingDefaults()开始的。我们根据堆栈,看一下它的调用者MergeTreeSequentialSource::generate()对DB::IMergeTreeReader::evaluateMissingDefaults()方法的调用逻辑:

cpp

Chunk MergeTreeSequentialSource::generate()

try

{

.....

bool should_evaluate_missing_defaults = false;

reader->fillMissingColumns(columns, should_evaluate_missing_defaults, rows_read);

reader->performRequiredConversions(columns);

if (should_evaluate_missing_defaults)

reader->evaluateMissingDefaults({}, columns);从代码中可以看到:

是否调用 evaluateMissingDefaults() 由 IMergeTreeReader::fillMissingColumns(...) 返回的 should_evaluate_missing_defaults 决定: should_evaluate_missing_defaults在"请求列中有缺失列/子列"时为 true,没有缺失列或者缺失子列的时候为false。

在我们新增 5 个列后,如果在merge的时候发现有缺失列,就会把 should_evaluate_missing_defaults 置为 true,从而进入 evaluateMissingDefaults()。

我们下文以及我们在专门讲解Merge的文章中会讲到,对于一个Vertical Merge ,它在第一个Stage(ExecuteAndFinalizeHorizontalPart)其实是针对所有的Merging Columns的Horizontal Merge,这时候构造的IMergeTreeReader中的columns_就是所有的Merging Columns的集合,而在第二个Merge Stage(VerticalMergeStarge),它会对GatheringColumn一个一个读取,这时候IMergeTreeReader的columns_就是当前正在处理的某一个Gathering Column。

我们看一下IMergeTreeReader::fillMissingColumns()方法的具体实现:

cpp

/// Add columns from ordered_names that are not present in the block.

/// Missing columns are added in the order specified by ordered_names.

/// num_rows is needed in case if all res_columns are nullptr.

void IMergeTreeReader::fillMissingColumns(Columns & res_columns, bool & should_evaluate_missing_defaults, size_t num_rows) const

{

// 将columns_to_read这个列的列表封装成NamesAndTypesList,即 列名+类型的列表

NamesAndTypesList available_columns(columns_to_read.begin(), columns_to_read.end());

// 调用 DB::fillMissingColumns,将列信息写入到res_columns中,缺失的列以nullptr进行占位

DB::fillMissingColumns(

res_columns, num_rows,

Nested::convertToSubcolumns(requested_columns), // 请求的列

Nested::convertToSubcolumns(available_columns), // 当前Part中的列

partially_read_columns, storage_snapshot->metadata);

// 判断 返回的res_columns中是否有缺失列

should_evaluate_missing_defaults = std::any_of(

res_columns.begin(), res_columns.end(), [](const auto & column) { return column == nullptr; });对于该方法,我们可以看到这涉及到了IMergeTreeReader中的两个成员变量:

cpp

/// Actual column names and types of columns in part,

/// which may differ from table metadata.

/// 将传入的original_requested_columns解析为在Part中实际的Column信息,这是因为

/// 传入的Column名字也许和Part中的有所不同,因此这里需要进行转换

NamesAndTypes columns_to_read;

/// Columns that are requested to read.

/// 调用者请求读取的Column

NamesAndTypesList original_requested_columns;

/// The same as above but with converted Arrays to subcolumns of Nested.

/// 调用者请求读取的Column,但是已经将Arrays的展开类型转换成subcolumns,

/// 从而可以时候后面对offsets的共享,并维护了子列和基列之间的关系

NamesAndTypesList requested_columns;即:

requested_columns:Query/Merge需要使用的Column List(按存储层名字,子列已展开)。columns_to_read:从当前 part 实际能读到的列(同样按子列展开)。

所以,IMergeTreeReader::fillMissingColumns()方法的基本逻辑为:

- 调用

DB::fillMissingColumns(...),对已经请求但是在当前part中不存在(即,在requested_columns中存在但是在available_columns中不存在)的列,就在引用res_columns放入"空占位"(这里用 nullptr 表示;下游会把它理解为ColumnNothing) - 设置

should_evaluate_missing_defaults:如果res_columns中存在任何nullptr,即存在缺列,需要后续执行 DEFAULT 表达式补值

既然是因为缺列,那么我们需要知道预期的列是什么和实际的列又是什么。显然,实际的列就是part中实际存在的列。那么,我们来看一下预期的列requested_columns是什么来的。

IMergeTreeReader设置requested_columns的过程是:

-

在

MergeTreeSequentialSource::MergeTreeSequentialSource()构造方法中,会设置需要请求进行读取的列:cppauto options = GetColumnsOptions(GetColumnsOptions::AllPhysical) // 只考虑真正定义的列,不考虑alias这种表达式 .withExtendedObjects() .withVirtuals() // 允许虚拟列,比如_part, _partition_id等 .withSubcolumns(storage.supportsSubcolumns()); // 允许子列,比如允许a.b这类子列名作为合法列来解析 // 设置此次需要请求读取的列,这些列不一定在当前的Part中存在,如果不存在,最后就会导致 auto columns_for_reader = storage_snapshot->getColumnsByNames(options, columns_to_read);columns_for_reader是"本次Merge/Mutate在读取的时候所需要的列名集合",而不一定是这个表的全部列。getColumnsByNames(...)会把这些列名解析成NamesAndTypesList,并按需要展开子列/虚拟列;这段

GetColumnsOptions的作用是:告诉 storage_snapshot->getColumnsByNames(...) 在"按列名取列定义"时,允许把哪些类别的列也一起纳入考虑范围,从而保证 merge/mutation 这种后台读 part 的场景不会因为"列类型特殊"而漏读或拿不到正确的列描述。 -

然后,调用

IMergeTreeDataPart::getReader()来构造对应的IMergeTreeReader对象,具体实现可能是MergeTreeReaderWide或者MergeTreeReaderCompact。我们看一下MergeTreeDataPartWide::getReader()的具体实现:cppIMergeTreeDataPart::MergeTreeReaderPtr MergeTreeDataPartWide::getReader( const NamesAndTypesList & columns_to_read, const StorageSnapshotPtr & storage_snapshot, const MarkRanges & mark_ranges, const VirtualFields & virtual_fields, UncompressedCache * uncompressed_cache, MarkCache * mark_cache, const AlterConversionsPtr & alter_conversions, const MergeTreeReaderSettings & reader_settings, const ValueSizeMap & avg_value_size_hints, const ReadBufferFromFileBase::ProfileCallback & profile_callback) const { auto read_info = std::make_shared<LoadedMergeTreeDataPartInfoForReader>(shared_from_this(), alter_conversions); return std::make_unique<MergeTreeReaderWide>( read_info, columns_to_read, // 请求读取的列 virtual_fields, storage_snapshot, uncompressed_cache, mark_cache, mark_ranges, reader_settings, avg_value_size_hints, profile_callback); }其中,

MergeTreeReaderWide和MergeTreeReaderCompact都是IMergeTreeReader的子类。所以,我们看一下IMergeTreeReader的构造方法:cppIMergeTreeReader::IMergeTreeReader( MergeTreeDataPartInfoForReaderPtr data_part_info_for_read_, const NamesAndTypesList & columns_, // 这次merge需要读取的Column,显然,对于Vertical Merge的VerticalMergeStage阶段,这个columns就是gathering_columns 中的某一个Column const VirtualFields & virtual_fields_, const StorageSnapshotPtr & storage_snapshot_, UncompressedCache * uncompressed_cache_, MarkCache * mark_cache_, const MarkRanges & all_mark_ranges_, const MergeTreeReaderSettings & settings_, const ValueSizeMap & avg_value_size_hints_) : data_part_info_for_read(data_part_info_for_read_) , avg_value_size_hints(avg_value_size_hints_) , uncompressed_cache(uncompressed_cache_) , mark_cache(mark_cache_) , settings(settings_) , storage_snapshot(storage_snapshot_) , all_mark_ranges(all_mark_ranges_) , alter_conversions(data_part_info_for_read->getAlterConversions()) /// For wide parts convert plain arrays of Nested to subcolumns /// to allow to use shared offset column from cache. , original_requested_columns(columns_) // 原始的请求的Column,一个 NamesAndTypesList , requested_columns(data_part_info_for_read->isWidePart() // 如果是Wide Part,那么如果是复合列,还需要对复合列进行拆分,拆分以后放到requested_columns中 ? Nested::convertToSubcolumns(columns_) // 对columns_中的列进行规范化处理,返回 NamesAndTypesList : columns_) , part_columns(data_part_info_for_read->isWidePart() // 设置这个part的column信息,如果是wide part,那么就收集包含Nested Column的 ? data_part_info_for_read->getColumnsDescriptionWithCollectedNested() // 对这个Part中的所有列进行规范化处理,返回ColumnDescription,ColumnDescription其实就是封装了规范化以后的NamesAndTypesList : data_part_info_for_read->getColumnsDescription()) , virtual_fields(virtual_fields_) { columns_to_read.reserve(requested_columns.size()); serializations.reserve(requested_columns.size()); for (const auto & column : requested_columns) { columns_to_read.emplace_back(getColumnInPart(column)); serializations.emplace_back(getSerializationInPart(column)); } }可以看到,

IMergeTreeReader在构造的时候(其实是通过子类MergeTreeReaderWide和MergeTreeReaderCompact的构造函数中进行间接构造的),传入了以下重要参数:-

MergeTreeDataPartInfoForReaderPtr data_part_info_for_read_: 当前正在处理的这个Part的信息cppusing MergeTreeDataPartInfoForReaderPtr = std::shared_ptr<IMergeTreeDataPartInfoForReader>; -

const NamesAndTypesList & columns_: 当前需要读取的part的column。我们已经说过多次,对于Vertical Merge的三个Merge Stage,第一个Stage是Horizontal Merge,这时候的columns_就是这个Stage的所有merging_columns(一般是对应的sorting key),第二个Stage(VerticalMergeStage),由于是对gathering_column进行逐列读取,因此此时这里的columns_就仅仅是当前正在读取的这一列。

在

IMergeTreeReader构造的时候:-

将原始传入进来的

columns_保存在original_requested_columns中,即未做任何转换的列信息cpp/// For wide parts convert plain arrays of Nested to subcolumns /// to allow to use shared offset column from cache. , original_requested_columns(columns_) // 原始的请求的Column,一个 NamesAndTypesList -

既然有original,那么就有转换后的column,这就是转换的动机主要是针对嵌套列(Nested Columns,下文会举例讲解Nested Columns的相关使用方法):

cpprequested_columns(data_part_info_for_read->isWidePart() // 如果是Wide Part,那么如果是复合列,还需要对复合列进行拆分,拆分以后放到requested_columns中 ? Nested::convertToSubcolumns(columns_) // 对columns_中的列进行规范化处理,返回 NamesAndTypesList : columns_)可以看到,对于普通的Wide Part,这里的

requested_columns是通过调用Nested::convertToSubcolumns(columns_)来将原始的columns_处理得到的,这里主要是针对Nested Columns的原始列转换成子列的结构,便于通过子列 获取对应的基列 信息,以及让不同的子列都共享同一份offsets信息:cpp/** * class NamesAndTypesList : public std::list<NameAndTypePair> * 对 Nested 来说,它的子字段是以 Array(T) 形式出现(Nested 物理上拆成多列的 Array),convertToSubcolumns方法 利用这一点把像 "n.a: Array(T)","n.b: Array(T)" * 规范化为"子列表示"(基名 n + 子列 a),以便共享 offsets、精确到子列读取。 * 它不会把任意复合类型"转成 Array";只在检测到 type 是 Array 且名字形如 base.child(Nested 场景)时做规范化。 * @param names_and_types std::list<NameAndTypePair>,这里的列是没有拆解的列,即加入是复合列,那么这里还没有拆解 * @return */ NamesAndTypesList convertToSubcolumns(const NamesAndTypesList & names_and_types) { // using NameToDataType = std::map<String, DataTypePtr>; // 在names_and_types中 收集每个 Nested 基名对应的 Nested 类型,形成一个map,如 n -> DataTypeNested(n). auto nested_types = getSubcolumnsOfNested(names_and_types); auto res = names_and_types; for (auto & name_type : res) // 对于参数中的列(基列,是对Nested已经拆解成多个Array以后的列) { // 若该项类型不是 Array,跳过(Nested 的每个字段物理上是 Array(...))。 if (!isArray(name_type.type)) continue; // 把名字拆成 (基名, 子列名),如 "n.a" -> ("n","a") auto split = splitName(name_type.name); // 已是子列表示(isSubcolumn())或没有子列名(split.second 为空),跳过 if (name_type.isSubcolumn() || split.second.empty()) continue; // 查找基名信息 auto it = nested_types.find(split.first); if (it != nested_types.end()) // 找到了这个基名信息 // 把当前的NameAndTypePair替换成一个新的NameAndTypePair,包含 name_type = NameAndTypePair{split.first, // 基名 split.second, // 子列名 it->second, // 这个基名对应的 DataTypeNested it->second->getSubcolumnType(split.second) // 这个基名对应的子列名的类型 }; } return res; }可以看到,

convertToSubcolumns(...)方法的参数就是传入到IReaderMergeTree中的原始列,我们说过,这里的原始列中对于Nested是平铺的,即n.a: Array(T),n.b: Array(T)分别作为不同的列。convertToSubcolumns()会 :-

通过

getSubcolumnsOfNested(...)对平铺以后的n.a: Array(T),n.b: Array(T)进行信息聚合,返回一个std::map<String, DataTypePtr>,这里的map key就是复合列的基名,value就是对这个基列下面所有的子列的描述信息,包含每一个子列的名字和类型:cppusing NameToDataType = std::map<String, DataTypePtr>; /** * 传入普通的NamesAndTypesList,筛选出对应的Nested列,并以 unordered_map<String, NamesAndTypesList>返回 * @param names_and_types * @return unordered_map<String, NamesAndTypesList>,这个key是对应的Nested的基列的名字,value是多个子列的类型信息 */ NameToDataType getSubcolumnsOfNested(const NamesAndTypesList & names_and_types) { // nested是一个map,map的key是父列的基名,NamesAndTypesList是对应的子列的列表 std::unordered_map<String, NamesAndTypesList> nested; for (const auto & name_type : names_and_types) { const auto * type_arr = typeid_cast<const DataTypeArray *>(name_type.type.get()); /// Ignore true Nested type, but try to unite flatten arrays to Nested type. if (!isNested(name_type.type) && type_arr) { // 对复合子列进行拆分,比如, n.a 拆分成("n", "a"), // 这样,split.first = "n"(基列名称), split.second = "a"(子列名称) auto split = splitName(name_type.name); if (!split.second.empty()) // 如果有子列, 则保存到 unordered_map<String, NamesAndTypesList> nested 中去 nested[split.first].emplace_back(split.second, type_arr->getNestedType()); } } // 构造nested,key是基列的名称,value是createNested(...)的返回值, // 即类似一个DataTypeNestedCustomName的封装,描述了每一个Array列的列名和类型 for (const auto & [name, elems] : nested) nested_types.emplace(name, createNested(elems.getTypes(), elems.getNames())); return nested_types; } -

然后开始遍历参数中传入的所有列,即原始列(前面说过,对于Vertical Merge,这里的列就是

ExecuteAndFinalizeHorizontalPart中的merging_columns,以及VerticalMergeStage中的gathering_columns中的某一列 ),试图将其中的原始的子列n.a: Array(T),n.b: Array(T)进行转换,转换以后,每一个子列的信息都被替换成了更加规范的NameAndTypePair信息:cpp// 把当前的NameAndTypePair替换成一个新的NameAndTypePair,包含了这个子列的等价规范的信息 name_type = NameAndTypePair{split.first, // 基名字符串 n split.second, // 子列名字符串 a it->second, // 这个基列对应的 DataTypeNested,DataTypeNested中是包含了这个基列的所有子列信息的 it->second->getSubcolumnType(split.second) // 这个基名对应的子列名的类型 };

这样,经过

convertToSubcolumns(...)->getSubcolumnsOfNested(...)处理,就将原始的列转换成了更加规范的列信息,主要做的其实是针对Nested Column进行规范化处理,形成了subcolumn的层级结构,以便多个子列识别其Nested 父列,以及共享 offsets 等共享对应的offset信息。 -

-

-

在构造

IMergeTreeReader的时候,还有对part_columns的处理:cpp, part_columns(data_part_info_for_read->isWidePart() // 设置这个part的column信息,如果是wide part,那么就收集包含Nested Column的 ? data_part_info_for_read->getColumnsDescriptionWithCollectedNested() // 对这个Part中的所有列进行规范化处理,返回ColumnDescription,ColumnDescription其实就是封装了规范化以后的NamesAndTypesList : data_part_info_for_read->getColumnsDescription())显然,这里

IMergeTreeReader的part_columns是当前part的所有columns,而不是构造函数传入的参数columns_。columns_表达的是当前正在进行Vertical Merge的Column信息。我们看一下

IMergeTreeDataPart::getColumnsDescriptionWithCollectedNested(...)方法:// 在 IMergeTreeDataPart::setColumns 中设置 const ColumnsDescription & getColumnsDescriptionWithCollectedNested() const { return columns_description_with_collected_nested; }可以看到,

columns_description_with_collected_nested是在IMergeTreeDataPart::setColumns中通过调用Nested::collect(columns)将原始的平铺的column信息转换成subcolumn信息,然后封装成为ColumnsDescription形成的,其基本过程和convertToSubcolumns(...)基本一致:cppvoid IMergeTreeDataPart::setColumns(const NamesAndTypesList & new_columns, const SerializationInfoByName & new_infos, int32_t metadata_version_) { .... columns_description_with_collected_nested = ColumnsDescription(Nested::collect(columns)); }可以看到,这里是调用

Nested::collect(...)来实现对原始的part columns进行转换成subcolumn的结构并设置到columns_description_with_collected_nested中:cppNamesAndTypesList collect(const NamesAndTypesList & names_and_types) { NamesAndTypesList res; // 按基名聚合出每个 Nested 父列的 DataTypeNested(子字段列表) 映射:n -> Nested(a T, b U)。 auto nested_types = getSubcolumnsOfNested(names_and_types); // 对每个 name_type for (const auto & name_type : names_and_types) { auto split = splitName(name_type.name); // 如果不是 Array,或没有子名,或基名不在 nested_types,则保留该列到 res。 // 否则(这是 Nested 的子列,如 n.a Array(T)),跳过,不放进 res。 if (!isArray(name_type.type) || split.second.empty() || !nested_types.contains(split.first)) res.push_back(name_type); // 普通列,直接放到res中 } /** * 把 nested_types 里收集到的每个父列(n, DataTypeNested(...)) 追加进 res * name_type.first: Nested 父列的基名(例如 "n") * name_type.second: 对应的 DataTypeNested 类型(包含该 Nested 的子字段定义,如 a T, b U)。 */ for (const auto & name_type : nested_types) res.emplace_back(name_type.first, name_type.second); /** * 非 Nested 的列保持原样 * 属于 Nested 的子列不再单独出现,转而以一个父列 n: Nested(a T, b U) 出现在列表中。 * 常用于 Wide part 的"逻辑视图"重建(配合 GetColumnsOptions::All),便于识别 Nested 父列、共享 offsets 等。 */ return res; }

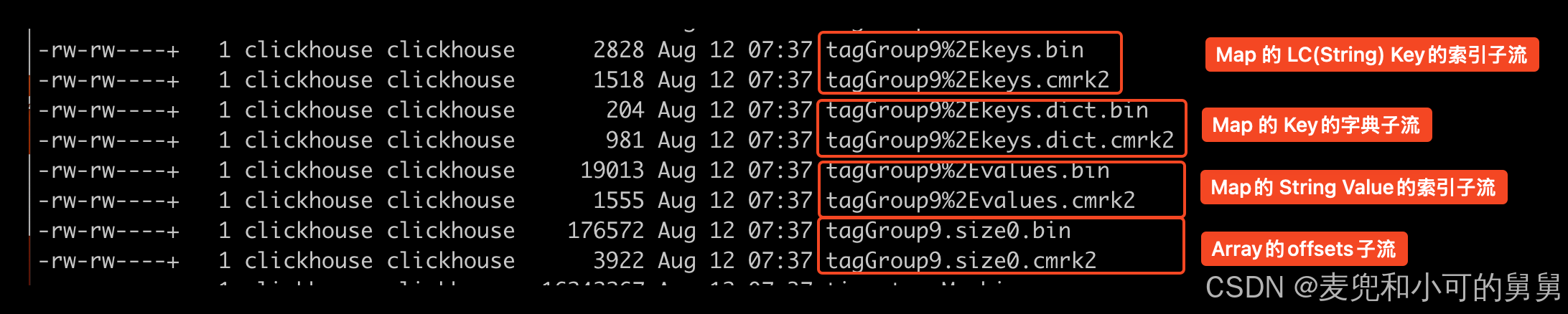

嵌套列

Nested 是用来表达"数组的结构体"的语法糖,比如 n Nested(a T1, b T2) 等价于多列 Array(Ti),要求每行里这些数组长度一致。

物理上,ClickHouse会把这个Nested列n拆成多列:n.a Array(T1), n.b Array(T2)(T1, T2是对应的数组的元素类型),由于长度必须相同,因此他们其实共享同一套偏移子流 n.size0(数组边界)。

所以,n.a和n.b 各自有自己的数据子流,但是两列共享n.size0偏移子流,读取任一子列需要偏移信息,同时读多个子列的时候偏移信息可以被复用,即只需要读取一次偏移信息。

Nested 列的典型用法

- 建表

sql

CREATE TABLE t

(

id UInt64,

n Nested(

a Int32,

b String

)

) ENGINE=MergeTree ORDER BY id;- 写入(同一行 n.a 与 n.b 的数组长度必须一致)

sql

INSERT INTO t VALUES (1, [10,20], ['x','y']);- 读取与展开

sql

-- 直接访问子列

SELECT n.a, n.b FROM t;

-- 展开为多行

SELECT id, arrayJoin(n.a) AS a, arrayJoin(n.b) AS b FROM t;- 偏移子列

sql

SELECT n.size0 FROM t; -- 每行数组的累计偏移(内部共享用,一般不直接查)总之:

- Nested = 多个 Array 列 + 共享偏移;每行各数组等长是不变式。

- Reader 会把 Nested 子列规范化,自动处理并复用 n.size0。

- Map/Tuple/LowCardinality 的子流拆解在序列化层;Nested 的"子列规范化"仅用于共享偏移与精细读取。

那么, 在我们的vertical merge发生异常的时候,对应的IMergeTreeReader的requested_column到底是什么呢?

我们知道,vertical merge在VerticalMergeStage(即所有的Merge的三个Stage中的第二个Stage)的merge是一个Column一个Column进行处理的。

我们看一下createMergeTreeSequentialSource()的调用链,从而获知在构造MergeTreeSequentialSource的时候传入的列的信息:

java

(调度/挑任务:把"队列/选择结果"变成 IExecutableTask 并投递到执行器)

SchedulePool (周期性触发)

└─ BackgroundJobsAssignee::threadFunc()

└─ data.scheduleDataProcessingJob(assignee) // data 是具体 Storage 的 MergeTreeData

├─ [非 Replicated 路径] StorageMergeTree::scheduleDataProcessingJob()

│ ├─ selectPartsToMerge()/selectPartsToMutate()

│ └─ assignee.scheduleMergeMutateTask(

│ std::make_shared<MergePlainMergeTreeTask / MutatePlainMergeTreeTask>(...)

│ )

│ └─ Context::getMergeMutateExecutor()->trySchedule(task) // MergeTreeBackgroundExecutor 入队

│

└─ [Replicated 路径] StorageReplicatedMergeTree::scheduleDataProcessingJob()

├─ selected_entry = queue.selectEntryToProcess(...) // 来自 replication queue(system.replication_queue)

└─ 按 entry.type 包装成 IExecutableTask 并投递:

├─ MERGE_PARTS → assignee.scheduleMergeMutateTask(std::make_shared<MergeFromLogEntryTask>(selected_entry,...))

├─ MUTATE_PART → assignee.scheduleMergeMutateTask(std::make_shared<MutateFromLogEntryTask>(selected_entry,...))

└─ (GET_PART/ATTACH_PART 走 fetches executor,这里略)

--------------------------------------------------------------------------------

(执行器背景线程) MergeTreeBackgroundExecutor::routine

└─ task->executeStep() // 虚派发:后台执行器只推进 IExecutableTask,不关心具体是 merge 还是 replicate/mutate

├─ MergePlainMergeTreeTask::executeStep() // 本地执行 OPTIMIZE,或非 Replicated 表的后台 merge

│ └─ merge_task->execute() // MergeTask:一次"合并若干 source parts → 生成一个新 part"的执行体

│ ├─ Stage1 ExecuteAndFinalizeHorizontalPart::createMergedStream()

│ │ └─ createMergeTreeSequentialSource(...) ← 构造点(一):横向阶段为每个源 part 构建顺序读取源(一次读多列)

│ │ └─ MergeTreeSequentialSource::MergeTreeSequentialSource(...)

│ └─ Stage2 VerticalMergeStage // 仅当选择 Vertical merge 时才进入

│ ├─ prepareVerticalMergeForOneColumn() // Vertical 的第一个 subtask:为单列建立读取/处理管道

│ │ └─ createPipeForReadingOneColumn(col)

│ │ └─ createMergeTreeSequentialSource(Names{col}) ← 构造点(二):垂直阶段逐列读取(每次只读一个列)

│ │ └─ MergeTreeSequentialSource::MergeTreeSequentialSource(...)

│ └─ (对 gathering_columns 逐列重复上面构造)

└─ ReplicatedMergeMutateTaskBase::executeStep() // Replicated merges/mutates 的统一基类:队列条目状态机 + 重试/记录异常/收尾

├─ MergeFromLogEntryTask::executeInnerTask() // 子类(1):处理 replication queue 的 MERGE_PARTS 条目

│ └─ merge_task->execute() // 仍然复用同一个 MergeTask → 同上两处构造点(一)/(二)

└─ MutateFromLogEntryTask::executeInnerTask() // 子类(2):处理 replication queue 的 MUTATE_PART 条目

└─ mutate_task->execute() // MutateTask:一次"读取 source part → 应用 mutation → 写临时 part → replace"的执行体

└─ (读取源 part 时同样会调用 createMergeTreeSequentialSource(...))

(区别在于:读出来之后接的是 mutation 的执行管道,而不是 merge 的合并逻辑)上面这张图的含义是:

- 后台 merge/mutate 的执行分成两层:一层"挑选并创建任务",一层"只负责推进任务"。

BackgroundJobsAssignee是上层调度器,它是"挑选并创建任务"这一层的入口。它本身不执行 merge,也不执行 mutation;它周期性地调用storage.scheduleDataProcessingJob(),让具体的 Storage 决定"此刻有没有需要做的后台工作"。如果 Storage 选出了工作,就会在scheduleDataProcessingJob()里创建一个实现了IExecutableTask的任务对象,并通过assignee.scheduleXXXTask(...)把这个任务投递到对应的后台执行器队列里。- 上层调度器/队列逻辑(

BackgroundJobsAssignee)产生一个具体任务对象会根据表的类型(Storage不同,比如StorageReplicatedMergeTree/StorageMergeTree)来产生不同的IMergeTreeTask(例如非 Replicated 的MergePlainMergeTreeTask,或Replicated的MergeFromLogEntryTask/MutateFromLogEntryTask)。

- 上层调度器/队列逻辑(

MergeTreeBackgroundExecutor是任务执行器,它是"只负责推进任务"这一层,它会被后台线程反复调用,调用的时候,他会从内部队列取出一个IExecutableTask,调用task->executeStep()推进任务:executeStep()返回"未完成" → 之后继续推进(下一轮再执行一步);executeStep()返回"已完成" → 任务结束,并触发对应的完成回调/状态更新

其中:- 如果是简单的本地Merge,那么

IExecutableTask的实现类是MergePlainMergeTreeTask,对应executeStep()方法是MergePlainMergeTreeTask::executeStep(), - 如果这个merge是后台线程在

scheduleDataProcessingJob()里从system.replication_queue对应的 ZooKeeper 队列里选出一条待执行任务(selectQueueEntry()),那么IExecutableTask的实现类就是ReplicatedMergeMutateTaskBase,从而调用对应的ReplicatedMergeMutateTaskBase::executeStep()- 对应的

ReplicatedMergeMutateTaskBase::executeStep()内部会调用具体的自己的子类MergeFromLogEntryTask/MutateFromLogEntryTask的executeInnerTask()来执行具体的工作

- 对应的

可以看到,对于Vertical Merge,createMergeTreeSequentialSource()的调用发生在两个地方:

-

在第一个Stage即

ExecuteAndFinalizeHorizontalPart会调用。我们在讲解Merge的文章中介绍过,对于Vertical Merge,第一个Stage其实是针对Merging Columns的Horizontal Merge。创建对应的Stream是通过方法createMergedStream()完成的:cppvoid MergeTask::ExecuteAndFinalizeHorizontalPart::createMergedStream() { /** Read from all parts, merge and write into a new one. * In passing, we calculate expression for sorting. */ Pipes pipes; ..... for (const auto & part : global_ctx->future_part->parts) { Pipe pipe = createMergeTreeSequentialSource( MergeTreeSequentialSourceType::Merge, *global_ctx->data, global_ctx->storage_snapshot, part, global_ctx->merging_columns.getNames(), // 对应的merging_columns,对于Vertical Merge,这个merging column仅仅是索引列,而对于horizontal merge,这个merging_column就是所有的Physical Columns /*mark_ranges=*/ {}, global_ctx->input_rows_filtered, /*apply_deleted_mask=*/ true, ctx->read_with_direct_io, /*prefetch=*/ false); ... pipes.emplace_back(std::move(pipe)); }可以看到,此时

createMergeTreeSequentialSource()方法传入的是merging_columns。我们在讲解Merge的文章中介绍过,对于Vertical Merge,那么merging_columns指的是这张表的Sorting Keys组成的Column,而剩下的Columns就是Gathering Columns -

在第二个Stage即

VerticalMergeStage中会调用。我们在讲解Merge的文章中介绍过,对于Vertical Merge,第二个Stage其实是针对Gathering Columns的逐个Merge。如上所示,这里的调用链条是prepareVerticalMergeForOneColumn(...)->createPipeForReadingOneColumn(col)->createMergeTreeSequentialSource(Names{col}):cpp// 处理当前正在处理的Column Pipe MergeTask::VerticalMergeStage::createPipeForReadingOneColumn(const String & column_name) const { Pipes pipes; for (size_t part_num = 0; part_num < global_ctx->future_part->parts.size(); ++part_num) // 遍历future_part中的所有part,为这些part的当前的Column建立 MergeTreeSequentialSource 对象 { Pipe pipe = createMergeTreeSequentialSource( MergeTreeSequentialSourceType::Merge, *global_ctx->data, global_ctx->storage_snapshot, global_ctx->future_part->parts[part_num], Names{column_name}, // 传入对应的column /*mark_ranges=*/ {}, global_ctx->input_rows_filtered, /*apply_deleted_mask=*/ true, ctx->read_with_direct_io, ctx->use_prefetch); pipes.emplace_back(std::move(pipe)); } return Pipe::unitePipes(std::move(pipes)); }所以,可以看到,

VerticalMergeStage中通过VerticalMergeStage::createPipeForReadingOneColumn()来构造MergeTreeSequentialSource对象的时候,是对某一个单独的part的某一个单独的Column 创建对应的MergeTreeSequentialSource对象,即此时,requested_column是某一个Part的某一个单独的列 ,而不是多个列,即MergeTreeSequentialSource是Per Part Per Column的。由于我们添加的列不是LowCardinality列,但是报错中显示的是LowCardinality转换问题,所以,我们之前的推断是这样的:

- 由于异常堆栈中有默认值推测,而part中缺失的只有可能是我们新增的5列,因此,Merge发生异常的时候,一定有我们新增的列参与进来

- 由于异常信息中有Map(LowCardinality, String)类型,而我们新增的5列都是简单列,因此,Merge发生异常的时候,一定有Map(LowCardinality, String)类型的列参与进来

- 无论是我们新增的5列,还是Map(LowCardinality, String),都不是sorting columns,因此,异常一定发生在第二个Stage即

VerticalMergeStage中

但是,根据我们上文对

VerticalMergeStage的理解,如果是VerticalMerge,那么每一次merge的一定是一个Column,不可能是两个column。所以,代码看到的行为与我们异常日志和堆栈反印出来的信息完全相互矛盾。所以,缺失的这一列不是我们新增的5列中的列,即还有其他的列缺失,缺失的原因可能是:

由于我们从堆栈里已经能确定这次 merge 读取会启用"缺失列用默认值补齐"的路径(should_evaluate_missing_defaults = true),在这个模式下,只要 ClickHouse 判断"某一列在某个 part 上读不到",就会先把它当成缺失处理,后面再用默认值或默认结构把它补出来,保证 merge 能继续往下走。

在 merge 过程中,一个列之所以会被判断为"在这个 part 上缺失",常见原因主要有下面几类:

- 这个 part 生成时本来就没有写这个列(或这个复杂类型的某个分量)。复杂类型在不同 part 里可能只落盘了一部分子数据流,所以某些 part 里确实可能找不到对应的物理文件。在我们的case下,part中的列缺失的确是由于我们新增了5列导致的,因此part中的确不含有这5列。

- 这个列在这个 part 里全是默认值/空值,写入阶段为了节省空间把对应的列文件省略了,磁盘上就表现为"文件为空或大小为 0"(你在

system.parts_columns.column_bytes_on_disk = 0里经常能看到这种情况),LowCardinality、Map 相关列更容易遇到。 - 表做过 ALTER,读取时会按当前表结构去找列;如果这个列名在旧 part 里经过映射/重命名之后对不上当前的物理列文件,就会出现"按名字找不到",于是被当成缺失,靠默认补齐来兼容旧 part。

- 对于 Array/Nested 这类复杂类型,除了主数据文件外,还依赖一些内部配套的结构数据文件(用来描述元素边界等结构信息)。如果这些配套文件在某些 part 里缺失或不可用,读取阶段也会把相关数据视为缺失,然后由默认补齐逻辑生成一份合理的默认结构,使 merge 不至于因为结构数据缺失而中断。

下文中,我们将会详细讲解,为什么Part中缺失了我们新增的5列(预期之内),会导致看起来完全与之无关的DB::ColumnNothing to DB::ColumnLowCardinality的类型转换错误的发生。

因为列缺失因此添加外部列

我们看一下 injectRequiredColumns()方法的具体实现:

cpp

NameSet injectRequiredColumns(

const IMergeTreeDataPartInfoForReader & data_part_info_for_reader,

const StorageSnapshotPtr & storage_snapshot,

bool with_subcolumns,

Names & columns // columns 是上层给出的"本轮需要的列名单",在我的抛出异常的例子中,它是host列

)

{

/**

* 这一行是用 columns 里当前已有的列名初始化集合,所以会把列表里的内容拷贝进去(不是空集)。

* NameSet 构造函数接受两个迭代器,std::begin(columns) 到 std::end(columns) 之间的元素都会被插入,起到"已经被请求的列"基线集合的作用。

*/

NameSet required_columns{std::begin(columns), std::end(columns)};

NameSet injected_columns;

bool have_at_least_one_physical_column = false;

AlterConversionsPtr alter_conversions;

if (!data_part_info_for_reader.isProjectionPart())

alter_conversions = data_part_info_for_reader.getAlterConversions();

auto options = GetColumnsOptions(GetColumnsOptions::AllPhysical)

.withExtendedObjects()

.withVirtuals()

.withSubcolumns(with_subcolumns);

/**

* 逐个把初始需要进行merge的column喂给 injectRequiredColumnsRecursively,在Vertical Merge的场景下,这个column只有tagGroup1.value

*/

for (size_t i = 0; i < columns.size(); ++i)

{

/// We are going to fetch physical columns and system columns first

if (!storage_snapshot->tryGetColumn(options, columns[i]))

throw Exception(ErrorCodes::NO_SUCH_COLUMN_IN_TABLE, "There is no column or subcolumn {} in table", columns[i]);

/**

* 会去 storage_snapshot 查看列定义,再看这个 part 是否包含对应的物理列。

* 如果列存在,则返回true

* 如果列缺失,但在表定义里有 DEFAULT/MATERIALIZED, 那就继续递归它 default 表达式依赖的列,把这些依赖列都塞进 columns,同时记录到 injected_columns。

* 只要在上层的for循环中有一次injectRequiredColumnsRecursively返回true,那么have_at_least_one_physical_column就返回true

*/

have_at_least_one_physical_column |= injectRequiredColumnsRecursively(

columns[i], storage_snapshot, alter_conversions,

data_part_info_for_reader, options, columns, required_columns, injected_columns);

}

/** Add a column of the minimum size.

* Used in case when no column is needed or files are missing, but at least you need to know number of rows.

* Adds to the columns.

*/

if (!have_at_least_one_physical_column)

{

/**

* 虽然当前这个 Merge 阶段并没有直接请求它,但表结构中 host 有 DEFAULT '',而这个 part 上完全没有 host 的物理数据,

* 所以只有靠 "补列" 才能在后面 evaluateMissingDefaults 阶段算出默认值。

* injectRequiredColumns 在扫描列定义时发现 host 符合"缺物理列但有 default"的条件,

* 就把 host 这个名字插入到 columns(以及返回值 injected_columns)里

*/

auto available_columns = storage_snapshot->metadata->getColumns().get(options);

const auto minimum_size_column_name = data_part_info_for_reader.getColumnNameWithMinimumCompressedSize(available_columns);

columns.push_back(minimum_size_column_name); // 添加一列

/// correctly report added column

injected_columns.insert(columns.back()); //把MinimumCompressedSize的column添加到columns中,也添加到injected_columns中

}

return injected_columns; // injected_columns中包含的就是新注入的这一列,而columns也被修改了,新注入的这一列也被添加进来了

}总之, injectRequiredColumns(...) 负责"补全这轮读取所需的列",这就大概解释了为什么Vertical Merge的时候会出现两列。

injectRequiredColumns(...)的参数含义如下所示:

-

data_part_info_for_reader:当前 part 的元信息,能判断某列在这个 part 里是否存在/被重命名等。 -

storage_snapshot:表的列定义快照,可以拿到 DEFAULT/MATERIALIZED 表达式。 -

with_subcolumns:是否允许补进子列。 -

columns:上层传入的"本轮需要处理的列"的列表。我们可以这样解释,VerticalMerge在调用injectRequiredColumns(...)的时候,会传入当前正在处理的列(host),但是经过injectRequiredColumns(...)调用以后,新增了另外的列(tagGroup1.values)。

-

把现有的 columns 复制到

required_columns(避免重复注入),并初始化一个空的数组injected_columns,用来记录新注入的列:cppNameSet required_columns{std::begin(columns), std::end(columns)}; NameSet injected_columns; -

遍历传入所有的columns,对每列调用

injectRequiredColumnsRecursively()。这个递归会检查这个请求列(可能是基列,可能是子列,在我们的case下面,是简单列host)是否存在于 part 中;若存在,则返回true,若缺失,但有DEFAULT/MATERIALIZED表达式,这个表达式有可能依赖其他列,那么就沿着表达式递归往下遍历,把它依赖的列加进columns,并在injected_columns中记录下来。have_at_least_one_physical_column用来判断"最终有没有至少一列真实存在"的标志。cppfor (size_t i = 0; i < columns.size(); ++i) { ...... have_at_least_one_physical_column |= injectRequiredColumnsRecursively( columns[i], storage_snapshot, alter_conversions, data_part_info_for_reader, options, columns, required_columns, injected_columns); }可以看到,只要在遍历的过程中有一列的

injectRequiredColumnsRecursively()返回true,就会导致have_at_least_one_physical_column为true。 -

如果所有列(其实

Vertical Merge只有一列传进来)都不存在于此 part(后面我们会证明,在我们的异常中,是因为Vertical Merge只处理host,而这个 part 没有host),就走 fallback:在表定义里挑"压缩体积最小的物理列"来充数,使读取流程至少能读到一列真实数据。我们后面的日志会证明这个过程:cppif (!have_at_least_one_physical_column) // 如果没有任何一列物理存在 { // 获取表中的所有列, auto available_columns = storage_snapshot->metadata->getColumns().get(options); // 获取size最小的列 const auto minimum_size_column_name = data_part_info_for_reader.getColumnNameWithMinimumCompressedSize(available_columns); columns.push_back(minimum_size_column_name); // 把这一列添加到columns中 injected_columns.insert(columns.back()); }

从上面可以看到,对columns中进行遍历,然后对每一列调用injectRequiredColumnsRecursively()进行递归遍历,最终获得了所依赖的所有列。由于列与列之间的依赖关系是可以递归的,比如,我们要收集列A所依赖的列,依赖关系是A -> B -> C,因此必须递归进行,最终获取到B和C。

injectRequiredColumnsRecursively(...) 的目标是,对于"缺失但又必须可用"的列,递归地把它们的物理依赖列加入读取列表,从而确保 IMergeTreeReader在执行默认值/物化表达式时,手头有足够的数据。它还会检查 part 是否真的拥有某个列,从而避免读不到任何实际数据。

怎么理解"缺失但是又必须可用"? 我们举一个简单例子:

sql

CREATE TABLE demo_deps

(

ts DateTime,

x Int32,

y Int32 DEFAULT x + 1

) ENGINE = MergeTree

ORDER BY ts;可以看到,列y有default值,并且,default值是一个表达式,并且,表达式依赖其他列,所以:

- 当写入数据时,如果没有显式提供

y,ClickHouse 会在写入阶段计算x + 1,把结果直接存进 part 的y数据文件里。也就是说每个 data part 上都持有y的实际数值。 - 查询或后续 merge/mutation 时,

y不需要再次按表达式求值,只需像普通列一样读取它的值; - 但是,如果某个旧的 part 在

y列建立前就存在(比如,列y是我们后续添加进去的),那么那类 part 上y物理数据就是缺失的,这时候如果VerticalMerge 开始对这一个y进行merge的时候,得依靠方法injectRequiredColumns()配合 DEFAULT 表达式去补值,因此就需要把依赖的x也注入进来。

所以,我们看一下方法injectRequiredColumnsRecursively()的具体实现:

cpp

/// Columns absent in part may depend on other absent columns so we are

/// searching all required physical columns recursively. Return true if found at

/// least one existing (physical) column in part.

bool injectRequiredColumnsRecursively(

const String & column_name, // 当前的Merge所请求的某一列

const StorageSnapshotPtr & storage_snapshot, // 表结构快照,用来查询列定义及 DEFAULT/MATERIALIZED 表达式

const AlterConversionsPtr & alter_conversions,

const IMergeTreeDataPartInfoForReader & data_part_info_for_reader, // 当前读取的 part 信息(含 getColumns(),判定这个 part 是否有某列或某子列)。

const GetColumnsOptions & options, // 指定查列时要包含物理列/虚拟列/子列等。

Names & columns, // 本轮merge/select所请求的列集合

NameSet & required_columns,

NameSet & injected_columns // 在上层循环调用的时候,不断将需要注入的列存进来

)

{

/// This is needed to prevent stack overflow in case of cyclic defaults or

/// huge AST which for some reason was not validated on parsing/interpreter

/// stages.

checkStackSize();

// 传入的column_name的NameAndTypePair,可能是父列,可能是子列

auto column_in_storage = storage_snapshot->tryGetColumn(options, column_name);

if (column_in_storage) // 这个column在表定义中存在

{

// 获取这一列在表中的名字(存储名),一定是基列名

auto column_name_in_part = column_in_storage->getNameInStorage();

if (alter_conversions && alter_conversions->isColumnRenamed(column_name_in_part)) // 如果这个column曾经被rename过,那么就要使用在part中的名字(part中的名字在alter的时候没有被修改)

column_name_in_part = alter_conversions->getColumnOldName(column_name_in_part);

// 获取这个基列column(如果这个column之前被renmame过,那么这个column_in_part就是rename以前在part中的名字)在part中的NameAndValuePair

auto column_in_part = data_part_info_for_reader.getColumns().tryGetByName(column_name_in_part);

if (column_in_part // 如果这个column在part中存在 , 并且

&& (!column_in_storage->isSubcolumn() // 请求的column不是子列,或者虽然是子列,但是在part中的这个列的确有这个子列的信息