在数字经济与人工智能深度融合的当下,数据作为核心生产要素的价值日益凸显,但数据隐私保护也越来越重要。联邦学习作为隐私计算领域的核心技术方向,通过数据不出域、模型协同训练的创新模式,为数据隐私保护提供了有效路径,已成为金融、医疗、政务等敏感数据密集型行业的关注热点。

然而,当前联邦学习技术在实际应用过程中,仍面临局部模型参数集成效率低、全局模型时效性不足、训练过程安全可控性差等关键技术瓶颈,制约了其规模化应用。

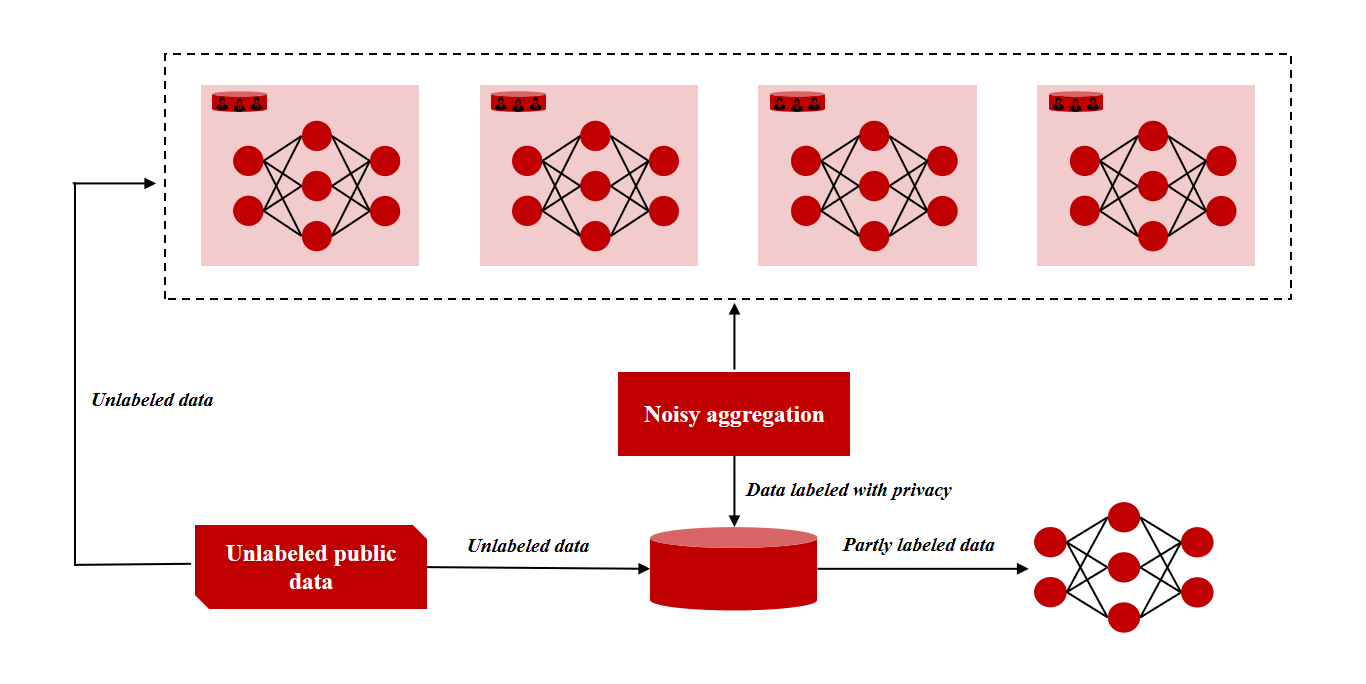

据了解,微美全息(NASDAQ:WIMI)正在探索基于区块链的差分优化联邦增量学习算法,通过多技术融合创新,突破传统联邦学习的技术局限,为隐私保护的协同训练提供了全新的技术范式。联邦学习的核心挑战在于如何在保障各参与方数据隐私不泄露的前提下,实现分散式训练模型的有效聚合,同时确保模型的时效性与训练过程的安全性。

传统联邦学习方案中,局部模型参数因训练数据分布异质性、特征空间差异等因素,导致集成过程中易出现模型偏差累积、收敛速度缓慢等问题;而静态的训练框架难以适配动态增长的数据场景,使得全局模型无法及时吸收新数据的有效信息,时效性差;此外,训练过程中梯度更新传输、参数存储等环节存在潜在的数据泄露风险,且缺乏有效的去中心化监管机制,进一步限制了其在高安全等级场景的应用。

微美全息研究的基于区块链的差分优化联邦增量学习算法,通过差分隐私增强局部训练、增量学习提升模型时效、区块链赋能安全协同的三层技术架构,实现联邦学习的升级。在局部模型训练阶段,算法创新性地将差分隐私技术与加权随机森林模型深度融合,通过对加权随机森林的决策树权重分配、分裂阈值等核心参数进行针对性优化,有效缓解了差分隐私机制引入的噪声对模型精度的负面影响。差分隐私技术通过在模型参数中加入噪声扰动,确保攻击者无法通过模型参数反推原始数据信息,参数优化策略则通过动态调整噪声强度与模型结构参数的匹配度,在保障隐私安全的前提下,最大限度保留局部模型的表征能力,为后续的模型集成奠定了基础。

在局部模型集成模块,采用多策略集成学习框架,通过引入自适应权重分配、联邦平均改进算法等多种集成策略,对各参与方上传的局部模型参数进行动态整合。相较于传统单一的集成方案,该多策略集成机制能够根据不同局部模型的性能表现、数据分布特征等因素,自适应调整各模型的权重占比,有效降低了因数据异质性导致的集成偏差,显著提升了全局模型的收敛精度与泛化能力。

为解决传统联邦学习模型时效性不足的问题,算法将增量学习技术引入联邦学习框架,构建了动态自适应的模型更新机制。增量学习能够使模型在不重新训练全部历史数据的前提下,高效吸收新增数据的有效信息,实现模型的增量式迭代升级。

微美全息研究的技术方案通过设计轻量化的增量更新策略,在保障模型精度的同时,大幅降低了动态数据场景下的模型训练成本与迭代时间,使全局模型能够实时适配数据分布的变化,显著提升了模型的实际应用价值。

同时,基于区块链的智能合约机制能够自动执行模型训练任务的权限管控、参数验证、聚合触发等流程,实现了联邦学习训练过程的自动化与透明化,有效防范了恶意节点篡改模型参数、伪造训练数据等安全风险。此外,区块链的共识机制确保了各参与方对全局模型聚合结果的共同认可,进一步提升了协同训练的可信度与安全性。

微美全息研究的基于区块链的差分优化联邦增量学习算法,通过差分隐私、增量学习与区块链技术的创新性融合,可解决传统联邦学习在模型集成精度、时效性、安全性等方面的问题,构建了隐私安全有保障、协同训练更高效的联邦学习新架构。未来,微美全息将持续深耕联邦学习、区块链、差分隐私等技术的融合应用,将推动联邦学习技术走向产业应用,共建隐私保护与智能协同并存的数字生态。