图论和高阶拓扑学

| 特征维度 | 图论 (描述成对关系) | 高阶拓扑学 (描述高阶交互) |

|---|---|---|

| 核心要素 | 节点、边 | 单形/细胞、洞、贝蒂数 |

| 关系抽象 | 二元连接(点对点) | 群体交互(如三角形、四面体结构) |

| 结构分析 | 连通性、路径、中心度 | 同调群、贝蒂数(量化"洞"的数量) |

| 关键工具 | 邻接矩阵、最短路径算法 | 持续同调、边界算子 |

| 优势 | 直观、计算效率相对较高 | 捕捉复杂系统的高阶依赖关系 |

1.1 从连接到结构:高阶拓扑的核心工具

高阶拓扑学的核心在于使用一系列强大的工具来揭示数据的内在结构。

-

持续同调 :这是拓扑数据分析(TDA)的主力方法。它通过逐渐改变尺度参数(如连接点的距离阈值),系统性地观察拓扑特征(如连通组件、环状结构)的"出生"与"死亡"。那些在多个尺度下持续存在的特征,很可能代表了数据中稳健的结构,而短暂的特征则可能是噪声。其结果常以条形码 或持久图直观展示,条形码的长度直接体现了拓扑特征的稳定性。

-

单纯复形与细胞复形 :这些是图的高维推广。单纯复形 由点、边、三角形、四面体等"单形"构成,并遵循特定规则(例如,一个三角形存在,则其三条边也必须存在)。细胞复形则更为灵活,允许粘贴更一般的二维或多维细胞。它们为描述复杂的群体交互提供了自然的框架。

-

霍奇拉普拉斯算子:该算子是图拉普拉斯算子向高维的推广。它不仅刻画了节点之间的关系,还描述了高维单元(如边、三角形)之间的互动。分析其频谱特性,有助于理解复杂网络中的扩散过程和高维结构。

洞察复杂系统的高阶拓扑

高阶拓扑分析方法已在多个领域展现出独特价值。

-

脑网络分析 :在研究人脑结构连接组时,科学家发现除了成对的神经纤维连接,大脑中存在由多个脑区形成的密集连接子图(团 )以及被连接通路环绕的拓扑洞。这些洞可能对应于功能相对隔离的脑区,其存在和持续性(通过持续同调分析)与大脑的信息处理机制密切相关。例如,在阿尔茨海默症等疾病中,可以观察到这些拓扑特征的异常变化。

-

复杂系统建模:在社交网络中,单纯复形可以模拟"同辈压力"(三个或更多人的相互影响);在化学反应中,一个三角形可以表示三种反应物之间的协同作用。这些超越成对交互的情形,是图论难以直接描述的。

-

图神经网络(GNN)的增强 :传统的GNN表达能力受限于WL同构测试。通过将输入图"提升"到细胞复形,在包含高维单元的新结构上进行拓扑信息传递,可以使GNN能够感知三角形、环等子结构,从而显著提升其区分和表示复杂关系的能力。

当高阶拓扑遇见图神经网络

将高阶拓扑结构与图神经网络结合,是当前一个非常前沿的方向。

-

拓扑信息传递 :在细胞复形上,信息传递可以发生在不同维度的单元之间。不仅是节点之间,信息还可以从节点传递到边,从三角形传递到其边界上的边等。这种分层、跨维度的信息流动,使得模型能够更精细地刻画局部结构。

-

表达力的突破 :基于细胞复形的细胞Weisfeiler-Lehman测试,其区分不同图结构的能力严格强于标准WL测试。这意味着,搭载了拓扑结构的GNN能够解决更多图论无法区分的结构问题。

-

缓解过度平滑:普通GNN在层数过深时,节点特征会趋向一致,称为"过度平滑"。高维细胞在图中创造了"捷径",使得信息能在更少的步骤内远距离传播,有助于缓解此问题。

挑战与未来方向

尽管前景广阔,高阶拓扑学也面临一些挑战。首先是计算复杂度 ,高维拓扑不变量的计算成本远高于图算法。其次,如何为特定领域问题选择合适的拓扑表示 (如超图、单纯复形、细胞复形)仍需探索。最后,将这些复杂的数学工具集成到现有机器学习管道中,并使其可解释,也是一个重要的研究方向。

未来的发展可能会更深入地融合代数拓扑、微分几何的工具,并探索"蜂窝滑轮"等更抽象的结构。同时,也将更注重在生物、化学、社会科学等领域的实际应用,解决图论无法应对的复杂建模问题。

1.2 同调群和贝蒂数

1.2.1 在地图搜索算法的作用

同调群和贝蒂数这些来自代数拓扑的概念,为地图搜索算法提供了全新的视角。它们不再仅仅关注点对点的最短路径,而是通过分析道路网络整体的"形状"和"连通性",来优化搜索效率和处理复杂空间关系。

下面这个表格总结了它们在地图搜索中的核心作用。

| 拓扑概念 | 在地图搜索算法中的作用 | 直观理解与地图对应 |

|---|---|---|

| **同调群 (Homology Group)** | 识别路网中的环形结构 (如环岛、封闭街区)和无法连通的区域(如被河流、围墙隔开的区域)。 | 分析路网的"空洞"与"圈"的整体结构。 |

| **贝蒂数 (Betti Number)** | β₀ :连通分量数(如孤立的岛屿)。β₁:独立环路的数量(如环岛、大型环路的个数)。 | β₀ :地图被分割成几大块不连通的部分。β₁:地图上有多少个绕不开的"圈"。 |

如何优化地图搜索

基于上述核心作用,同调群和贝蒂数可以从以下几个层面优化传统的图搜索算法(如Dijkstra或A*算法):

-

预处理与路径可行性验证

在开始复杂的路径计算前,可以先计算地图的0维同调群(即计算β₀)。如果起点和终点位于不同的连通分量中(β₀ ≥ 2且分属不同分量),算法能立即判断出路径不存在,避免无谓的全局搜索。这对于处理包含大型障碍物(如山脉)或跨海地图尤其有效。

-

指导搜索空间剪枝

高β₁值意味着路网中存在大量环路。传统的搜索算法可能会在这些环路中"兜圈子"。利用同调信息,可以为算法添加约束,例如,避免重复穿过由同调环定义的区域边界,从而引导算法更直接地朝向目标方向搜索,减少探索的分支数量。

-

提升复杂环境下的鲁棒性

当GPS信号漂移或地图数据局部缺失时,仅靠几何距离的匹配算法容易出错。结合了拓扑关系的匹配算法,会优先考虑道路的连通性(同调关系),从而避免将车辆位置匹配到拓扑结构不连贯的道路上(例如,突然跳到河对岸没有桥连接的路上),提高了导航的稳定性和准确性。

前沿视角:持续同调

对于动态变化或大规模的地图,**持续同调(Persistent Homology)** 这一工具更为强大。它通过一个"尺度参数"来观察拓扑特征(连通分量、环)的"出生"与"死亡"。

-

原理:想象一下,围绕每个道路交叉口画一个逐渐变大的圆圈。随着圆圈半径增大,孤立的点会逐渐连接成片,小的环路会被覆盖,而那些持续存在时间最长的连通分量和环路,就代表了路网最稳定的拓扑结构。

-

应用:在路径规划中,那些在多个尺度下都存在的"持久"环路(如城市主干道环线),可以被识别为关键路径。算法可以优先利用这些主干道进行长距离导航,因为它们拓扑结构稳定,能有效提升路径的可靠性和效率。

总而言之,同调群和贝蒂数作用于地图搜索算法,是从全局拓扑结构的层面提供深层指导。它们将搜索问题从纯粹的"几何距离优化"部分地转向了"拓扑结构分析",通过识别关键的连通分量和环形回路,为算法提供了预处理、剪枝和鲁棒性增强的强大工具。

1.3 从图到单纯复形:为何需要高阶视角?

1.3.1 利用单纯复形对数据中心网络中的多点故障传播进行建模

利用单纯复形对数据中心网络中的多点故障传播进行建模,确实是一个深刻且前沿的视角。它超越了传统图论对"点对点"连接的描述,能够精准捕捉"多个组件同时失效"这一高阶协同故障的本质。

传统上,数据中心网络被抽象为一张图,节点代表服务器、交换机等设备,边代表物理或逻辑连接。当某个节点故障时,模型会模拟其影响如何沿边传播到邻居节点。

然而,现实中的故障往往更为复杂。例如:

-

冗余失效 :一个由三台服务器构成的冗余集群(A、B、C),设计上允许任意一台故障。但若A、B同时故障,则可能导致整个集群服务中断。这种"三节点组"的集体失效效应,用传统的边(两两关系)无法完整描述。

-

共享依赖:多个虚拟机(VM)运行在同一台物理主机上,或者共享同一个电源模块。物理主机或电源的故障,会同时影响其上的所有虚拟机。

这时,单纯复形 的概念就派上了用场。一个 k-单纯形 是由 (k+1) 个节点构成的完全连接图,它能够直接表示这 (k+1) 个节点之间存在的高阶相互作用。

-

1-单纯形:就是一条边,描述两个节点间的成对关系。

-

2-单纯形:是一个实心三角形,描述三个节点之间不可分割的协同关系(如上述的冗余集群)。

-

单纯复形:则由这些不同维度的单纯形组合而成,但要求任何单纯形的面(例如三角形的边)也必须包含在该复形中。

建模步骤与核心方法

基于单纯复形构建故障传播模型,核心是定义一个负载-容量的动态级联过程。其关键步骤可概括为下表:

| 步骤 | 核心任务 | 关键说明 |

|---|---|---|

| 1. 网络抽象 | 将数据中心网络表示为单纯复形 | 识别系统中的高阶交互关系,例如,将共享同一关键资源(如交换机、电源)的一组设备建模为一个高阶单纯形。 |

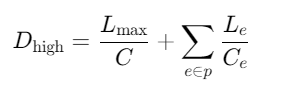

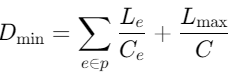

| 2. 定义负载与容量 | 为每个节点定义初始负载 Li(0)和容量 Ci | 负载可正比于节点的"广义度"(考虑其所属的1-单纯形和2-单纯形数量)。容量通常设定为初始负载的一个冗余比例,即 Ci=(1+T)⋅Li(0),其中 T>0是容量参数。 |

| 3. 触发与重分配 | 模拟初始故障节点失效后的负载重分配 | 失效节点的负载会按一定规则分配给与之关联的单纯形(而不仅仅是邻居节点)。例如,与失效节点同属一个2-单纯形的另外两个节点会接收到额外的负载。 |

| 4. 级联传播 | 动态检查并传播故障 | 每次负载重分配后,检查所有节点是否满足 Li(t)>Ci。新失效的节点会触发新一轮的负载重分配,形成级联效应,直到网络重新稳定。 |

| 5. 评估影响 | 计算稳定后的网络连通度等指标 | 通过模拟不同节点失效、调整容量参数T或单纯形结构,可以评估网络的鲁棒性,识别脆弱环节。 |

案例示意

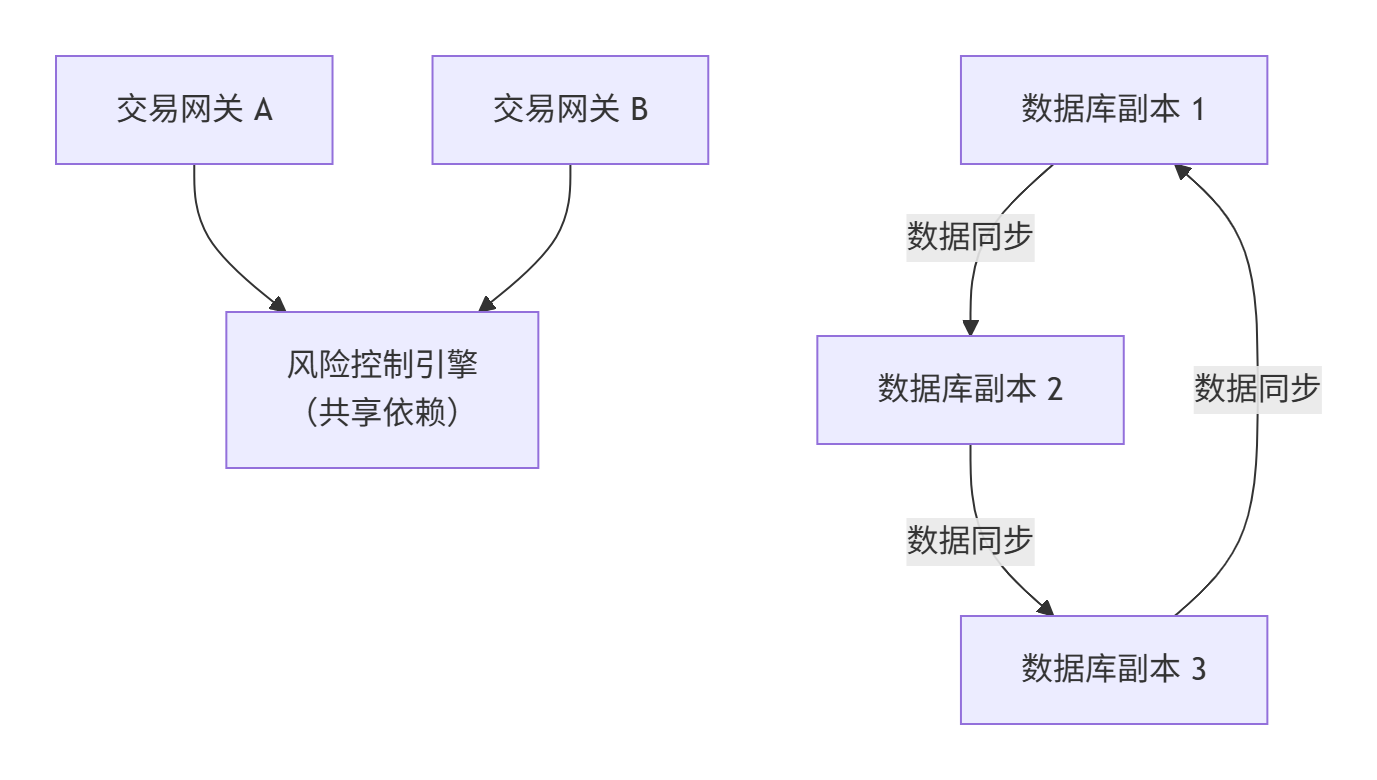

假设一个微型的金融交易系统包含6个节点,其逻辑关系如下图所示(请注意,下图是对拓扑关系的示意性表达):

-

网络抽象:

-

{交易网关A, 交易网关B, 风险控制引擎C}构成一个 2-单纯形(三角形)。因为两个网关高度依赖于同一个风控引擎,三者协同工作。 -

{数据库副本1, 2, 3}构成另一个 2-单纯形。它们组成一个数据库集群,依赖数据同步(三边关系)。 -

这两个2-单纯形通过风控引擎C与数据库副本1之间的连接(1-单纯形)相关联。

-

-

故障模拟:

-

假设 风险控制引擎C 因软件bug发生故障(初始故障)。

-

根据模型,C的负载会重分配。由于C位于一个2-单纯形中,其负载会显著影响交易网关A和B。

-

A和B在接收到C的负载后,可能因过载而相继失效。此时,故障已从C传播至A和B。

-

由于A/B的失效,以及C的失效,它们与数据库副本1的连接中断。数据库副本1可能因失去外部心跳或负载激增而失效。

-

最终,故障通过高阶依赖(2-单纯形)和普通连接(1-单纯形)传播,可能导致整个数据库集群不可用,造成大规模服务中断。

-

总结与价值

通过单纯复形建模,我们能够更真实地反映数据中心网络因共享依赖、组协作 等产生的协同故障风险。这种模型的价值在于:

-

精准识别脆弱点:不仅能找到易故障的单个设备,还能识别出那些看似冗余但实际存在高阶依赖的"脆弱模块"。

-

优化资源布局:为网络规划提供理论依据,例如,避免创建过多包含关键资源的高阶单纯形,或有意将关键负载分散到拓扑上更独立的区域。

-

指导容灾策略:帮助设计更有效的故障隔离和切换方案,确保当高阶故障发生时,影响范围能被有效控制。

1.3.2 单纯复形在数据中心容灾领域的应用

单纯复形在数据中心容灾领域的应用,核心在于它提供了一种强大的数学工具,能够精准描述系统中组件之间复杂的高阶依赖关系,并在此基础上建模故障的传播过程,特别是负载-容量的动态级联失效。

| 拓扑概念 | 在数据中心容灾中的对应物 | 核心价值 |

|---|---|---|

| **0-单形 (点)** | 单个IT组件,如一台物理服务器、一个虚拟机、一个存储设备或一个网络交换机。 | 描述系统的基本构成单元。 |

| **1-单形 (边)** | 两个组件之间的双向依赖关系,例如一台应用服务器与其后端数据库服务器的连接。 | 描述传统的成对依赖,故障可能沿边传播。 |

| **2-单形 (实心三角形)** | 三个组件之间不可分割的协同关系,例如一个由三台服务器构成的冗余集群(A、B、C),任意两台故障会导致集群失效。 | 捕捉高阶依赖 ,这是图论难以描述的集体失效风险。 |

| **k-单形 (k≥2)** | 更复杂的群体交互,如多个微服务共同构成一个业务应用。 | 描述更广泛的系统性风险。 |

| 单纯复形 | 整个数据中心所有组件及其复杂依赖关系的统一拓扑模型。 | 为系统级的脆弱性分析和容灾规划提供整体框架。 |

负载-容量动态级联过程详解

单纯复形模型的价值,在于它能动态模拟一个初始故障如何因组件间的依赖关系,通过负载再分配引发连锁反应。其核心是一个负载-容量的动态级联过程,具体流程如下面的序列图所示:

flowchart TD

A[初始节点故障] --> B[负载重分配规则触发]

B --> C[负载重分配给关联的单纯形]

C --> D[检查关联节点新负载]

D --> E{"新负载 > 节点容量?"}

E -- 是 --> F[节点失效]

F --> G[新一轮负载重分配]

G --> C

E -- 否 --> H[系统恢复稳定]上述流程中的关键环节包括:

-

初始化:为每个节点(服务器等)定义两个关键参数:

-

初始负载 Li(0) : 节点

i在正常状态下所承担的工作量。 -

容量 Ci : 节点

i能够承受的最大负载,通常设定为 Ci=(1+α)⋅Li(0),其中 α≥0是容量缓冲参数(Tolerance),代表节点的冗余能力。

-

-

触发与重分配(核心) :当一个或多个节点因故障失效时(如上图所示),它们原本承担的负载并不会消失,而是会根据预设规则重新分配 给与之关联的其他节点。关键在于,负载不仅是分配给邻居节点(1-单形),更重要的是分配给包含该故障节点的所有高阶单纯形(如2-单形、3-单形)中的其他成员。例如,在一个2-单形(三角形)中,一个节点失效,其负载可能会由另外两个节点共同承担。

-

级联传播 :每次负载重分配后,系统会检查所有节点。如果某个节点接收到的新负载 Li(t)超过了其容量 Ci,则该节点会因过载而失效。这些新失效的节点会触发新一轮的负载重分配,如流程图中的循环所示,从而可能引发链式反应,导致故障在整个网络中扩散。

-

稳定与评估 :当再也没有节点因过载而失效时,级联过程停止。此时,可以评估此次事件造成的最终影响,例如计算最终失效的节点比例、网络连通性损失等,从而量化系统的鲁棒性。

应用价值与总结

通过基于单纯复形的建模,我们能够更真实地模拟和评估数据中心在面临故障时的行为。这种方法的价值在于:

-

识别系统性脆弱点 :不仅能找到易故障的单点,还能识别出那些因高阶依赖而存在的潜在"脆弱模块"。

-

指导容灾资源规划:通过调整容量缓冲参数 α或改变网络拓扑(例如,有意识地减少高风险的高阶单纯形),可以在成本与可靠性之间找到最优平衡,为容灾策略提供定量依据。

-

优化故障隔离与切换策略:帮助设计更有效的应急预案,确保当高阶故障发生时,能快速隔离影响范围,实现业务平滑切换。

总而言之,单纯复形通过将数据中心抽象为包含高阶相互作用的拓扑结构,并定义负载-容量的动态级联规则,为我们提供了一种超越传统图论的、更强大的系统风险分析框架。这有助于从"形状"和"结构"的深层角度,构建更具韧性的数据中心容灾体系。

1.3.3 数据中心容灾体系与图论

数据中心容灾体系本质上是一个确保数据持久可用和业务连续性的复杂系统。

| 理论工具 | 在容灾体系中的核心角色 | 关键价值 |

|---|---|---|

| 集合与关系 | 定义容灾资源池(服务器、存储、网络设备等)及其亲和/反亲和规则。 | 形式化描述资源间的依赖与隔离约束,是自动化部署与调度的基础。 |

| 图与网络流 | 建模数据中心网络拓扑(如Spine-Leaf)、数据流与故障传播路径。 | 优化数据同步路径、分析故障影响范围、保障关键链路带宽。 |

| 编码理论 | 实现跨数据中心的高效数据容灾,如纠删码技术。 | 以远低于多副本的存储开销,获得更高的数据可靠性。 |

| 有限状态机 | 描述容灾流程(正常、切换、恢复等)中各实体的状态迁移。 | 使容灾流程标准化、可预测、可验证,避免因状态混乱导致操作失败。 |

1.3.3.1 集合与关系:资源管理的基石

容灾系统管理的所有实体,如物理服务器、虚拟机、存储卷、网络链路等,都可以抽象为元素 。这些元素根据其属性(如地理位置、性能、功能)被划分到不同的集合中,例如"北京Region的所有服务器"或"用于数据库的SSD存储卷"。

更重要的是元素间的关系,这直接决定了容灾策略的有效性:

-

亲和性:要求某些应用对象必须部署在同一数据中心或可用区(AZ)内,以减少交互延迟。例如,一个Web服务器和其缓存服务可能存在亲和性关系。

-

反亲和性:要求关键应用的应用对象必须分散在不同的故障域。例如,一个应用的三副本应该部署在三个不同的可用区,甚至不同的地域(Region),以避免单一故障点导致服务完全中断。自动化容灾配置系统正是基于这些预定义的规则进行最优资源选择的。

1.3.3.2 图与网络流:拓扑与流量的蓝图

图论是分析数据中心网络结构的天然工具。

-

拓扑建模 :现代数据中心普遍采用Spine-Leaf 的Clos架构,这本身就是一个二分图。服务器连接到Leaf交换机,Leaf交换机再全连接到Spine交换机。这种结构保证了任意两点间路径的等长短,避免了网络瓶颈。

-

流量优化 :容灾过程中的数据同步可以建模为网络流问题。源数据中心是"源点",目标数据中心是"汇点",网络链路是带有带宽属性的"边"。运用最大流最小割定理,可以计算出数据中心间最大的数据同步能力,并规划最优的同步路径。

-

故障分析:通过分析图的连通性,可以快速模拟某个网络设备或链路故障后,哪些节点会变得不可达,从而评估故障的爆炸半径。

1.3.3.3 编码理论:数据可靠性的引擎

跨数据中心的容灾存储需要平衡可靠性、存储开销和网络带宽 。相较于简单的多副本技术(如3副本带来200%的存储开销),纠删码 技术展现出巨大优势。

其核心思想是:将一份数据分割成 k个数据块,通过编码计算生成 m个校验块,并将这 n=k+m个块分散存储在不同数据中心的不同节点上。只要任意 k个块存活,原始数据就可以完整恢复。例如,采用 (10,6) 纠删码,将数据分为10份并生成6份校验数据,然后分散到16个位置。即使同时损坏6份数据,数据依然可恢复,存储开销仅为60%,远低于多副本。

研究重点在于优化跨数据中心的修复流量。当某个数据块丢失时,高效的编码方法(如LDPC码、再生码)可以最小化重建数据所需从其他数据中心传输的数据量,从而大幅降低恢复时间。

1.3.3.4 有限状态机:流程控制的规范者

容灾切换与恢复不是一个单一动作,而是一个严格的状态转换过程。有限状态机 为此提供了精确的建模工具。

以主备数据中心切换为例,可以定义以下几个核心状态:

-

Normal(正常):主中心运行,备中心同步数据。

-

Failure Detected(故障已检测):监控系统发现主中心异常。

-

Switchover Initiated(切换已启动):容灾管控端发出切换指令。在极端情况下,此指令甚至可通过带宽有限的卫星链路传输,并需有过滤机制确保只有关键指令通过。

-

Standby Promoted(备中心已升级):备中心接管业务,变为新的主中心。

-

Recovery(恢复中):原主中心修复后,重新同步数据并准备就绪。

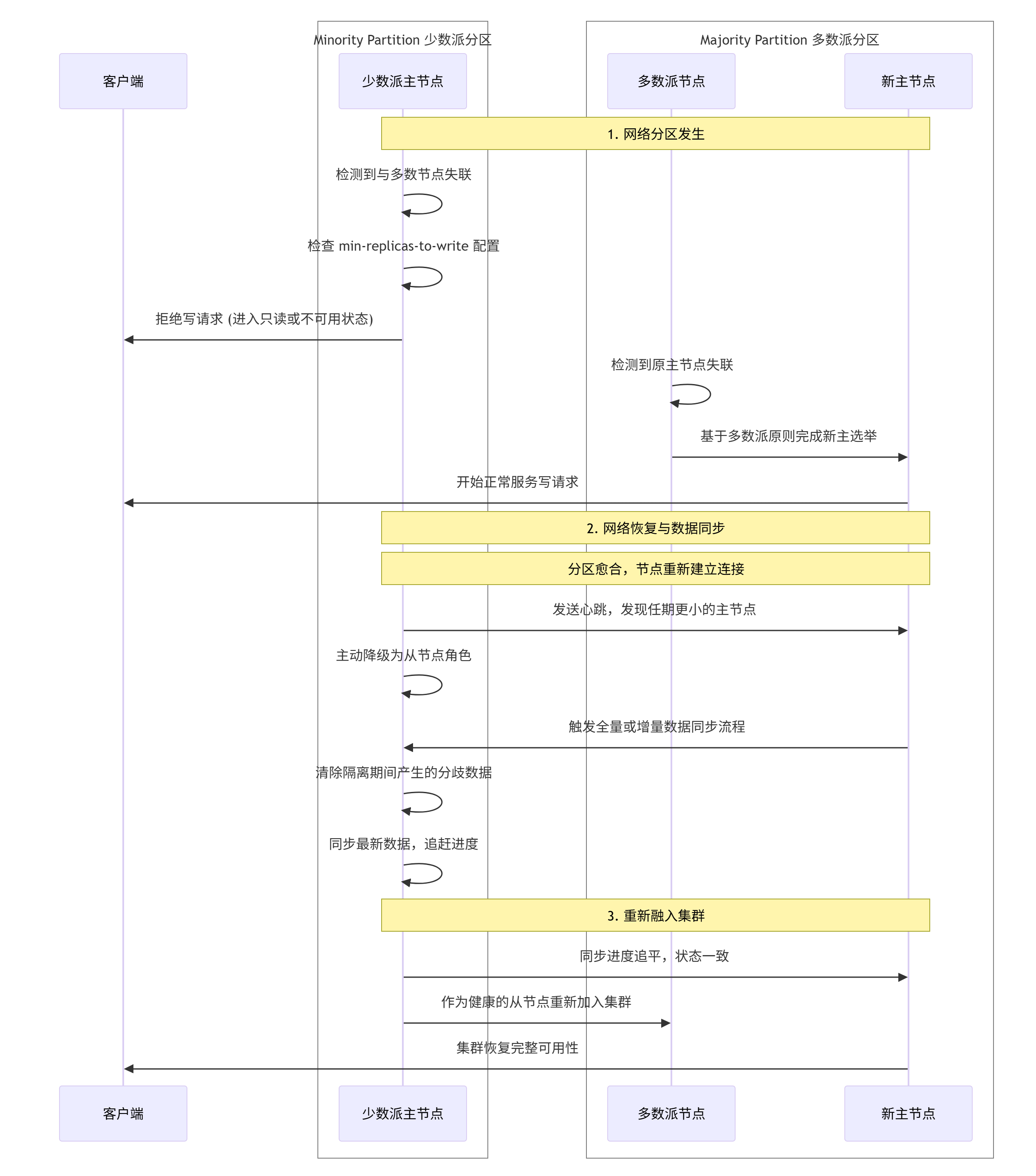

FSM明确了每个状态的含义、触发状态迁移的事件(如"心跳丢失"、"手动切换命令")、以及迁移时应执行的动作(如"挂起原主中心写入")。这确保了整个流程的有序性和可预测性,避免了因状态混乱导致"脑裂"(即两个数据中心同时认为自己是主中心)等灾难性后果。

在真实的容灾系统中,这些理论并非孤立存在,而是紧密交织,共同构筑了体系的韧性。例如,一个容灾决策流程可能是:基于集合论 筛选出符合反亲和性规则的候选服务器集合 ;利用图论 分析这些服务器间的网络延迟和带宽,并通过网络流 算法验证数据同步效率;最终,所有组件和流程的状态变迁都由有限状态机严格定义和控制。

1.3.3.5网络流算法与图论、单纯复形、几何学及复杂网络等数学理论在不同计算中心场景下的深层联系

网络流算法与图论、单纯复形、几何学及复杂网络等数学理论在不同计算中心场景下的深层联系。这些理论并非孤立的工具,而是共同构成了分析和优化现代大规模计算网络的基础。

| 应用场景 | 核心挑战 | 图论的角色 | 单纯复形的作用 | 几何学视角 | 复杂网络特性 |

|---|---|---|---|---|---|

| 数据中心容灾 | 跨中心数据同步的带宽优化、故障隔离与快速恢复(RTO/RPO) | 将网络抽象为有向图(节点=设备,边=链路,容量=带宽),应用最大流/最小割算法(如Dinic算法)找瓶颈和最优数据路由。 | 建模多点协同故障(如共享同一电源的多台服务器同时宕机),描述超越成对连接的高阶依赖关系,从而更精准模拟故障传播范围。 | 将网络拓扑视为几何空间 ,利用网络坐标系统 估算延迟,或将对偶图理论应用于平面化网络拓扑(如Fat-Tree),将最大流问题转化为最短路径问题,提升计算效率。 | 分析容灾网络的异构性 (服务器、交换机、链路混合)与小世界特性(快速路由),设计健壮且高效的数据复制路径。 |

| 智算中心网络 | 满足AI训练(All-Reduce通信)、HPCC(计算/存储流水线)等密集型任务的高吞吐、低延迟需求。 | 不仅用图建模物理连接,更通过有向无环图(DAG) 描述任务依赖关系,运用拓扑排序 和关键路径法 优化任务调度与资源分配。 | 对计算任务间的复杂协作模式(如多个Worker节点在参数服务器上的同步更新)进行建模,捕捉超越简单二元关系的群体交互行为。 | 在物理布局优化中,利用几何规划 最小化服务器间通信距离;在逻辑上,将超立方体 等拓扑嵌入网络,以优化大规模并行计算的全交换(All-to-All)通信。 | 智算中心网络是典型的异构(GPU/CPU/NIC) 、高密度连接 的复杂网络。其度分布 、聚集系数 等特性直接影响专用算法(如用于AI训练的流量调度算法)的设计。 |

| 智算中心组网需求 | 根据不同业务目标(如高性能计算、云服务、边缘协同)设计最优网络架构。 | 图划分算法 (如Metis)用于将大规模计算任务映射到物理节点,最小化跨机柜流量。图谱理论 可用于分析网络连通性和稳定性。 | 需求:需要能描述群体智能 或集体负载 的模型,以优化资源协同。如基于单纯复形的模型可帮助理解"多打一"(Incast)流量模式的内在结构。 | 需求:网络架构(如Dragonfly, Slim Fly)的设计本身依赖于离散几何 (如使用有限几何构造低直径、高吞吐的网络图)。需求:通过微分几何 工具分析网络流量的"曲率",以识别潜在拥塞点。 | 需求:组网必须考虑网络的演化性 (方便扩展)和韧性 (抵抗攻击/故障的能力)。这需要利用复杂网络的鲁棒性分析 方法进行设计评估。 |

核心关系解读

数据中心容灾方案中的协同

在数据中心容灾方案中,网络流算法 是实现资源优化调配的核心数学工具。例如,通过Dinic算法 或Edmonds-Karp算法 可以精确计算出在有限的跨数据中心带宽下,数据同步的最大可行流量 ,从而评估能否满足RPO(恢复点目标) 。最小割定理则能快速识别出网络中的脆弱环节,即那些一旦被切断就会导致数据同步中断的关键链路,为容灾链路的规划提供关键洞察。

然而,传统图论将依赖关系简化为点与点的连线,难以描述现实中"多个组件因共享同一底层资源而同时失效"的协同故障 场景。单纯复形 的引入,正好弥补了这一缺陷。它将一个由多个组件(如三台互为备份的服务器)构成的冗余单元 建模为一个高阶单纯形(如三角形),从而能够更精确地模拟和评估故障在系统内的传播范围和影响深度。此外,在评估跨数据中心延迟时,几何学 视角(如将网络节点映射到欧几里得空间)有助于优化网关选择和路径规划。而整个容灾网络作为一个复杂网络 ,其异构性 (混合设备)和小世界特性(快速路由)决定了容灾策略的设计必须考虑其整体拓扑特性。

智算中心网络的内在联系

智算中心网络是上述理论与方法集大成的场景。其核心任务是高效处理AI训练、高性能计算等产生的复杂数据流。图论 不仅是描述网络物理拓扑的基础,其**有向无环图(DAG)** 更是对计算任务本身进行建模、调度和优化的标准工具。

同时,智算中心内计算任务间的高度协同特性,需要单纯复形 这类工具来建模群体交互行为 。例如,一个分布式机器学习任务中,多个参数服务器和工作节点之间形成的复杂同步模式,就是一个典型的高阶交互场景。几何学 的影响则更为直接:许多高性能网络拓扑(如Dragonfly)本身的设计就源于离散几何学 (如利用有限域上的线性代数构造出具有极大图规模的网络),旨在为大规模并行计算(如All-to-All通信)提供低延迟、高带宽的物理基础。自然,智算中心网络也是一个典型的复杂网络 ,其度分布 、聚集系数 等统计特性直接影响着专用流量调度算法的设计,而网络自身的演化性与韧性也是组网时必须考虑的核心因素。

总结与前瞻

总而言之,网络流算法提供了在约束条件下进行最优分配的计算方法 ;图论是描述网络组件关联的基础语言 ;单纯复形弥补了图论在描述群体高阶相互作用 方面的不足;几何学为网络物理拓扑和逻辑结构 提供了优化设计的深层原理;而复杂网络理论则从系统全局的统计规律和动力学行为角度,指导构建更健壮、更高效的计算中心基础设施。

这几者之间并非孤立,而是层层递进、相互补充的。对于一个智算中心的网络问题,我们既可以用图论 描述其设备连接,用网络流算法 计算最大吞吐,也可以用单纯复形 分析其多节点通信模式的内在结构,还可以从几何学 角度优化其物理布局,并最终将其置于复杂网络的框架下评估其全局鲁棒性。

不同智算中心的组网架构,可以理解为在构建"超级计算机大脑"的"神经网络"时采用的不同布线蓝图。每种蓝图在连接效率、成本和控制信号(路由算法)的复杂性上有着根本性的差异。

| 架构特性 | **Spine-Leaf (CLOS)** | **Dragonfly / Dragonfly+** | Slim Fly | **DDC (轨道优化架构)** |

|---|---|---|---|---|

| 核心拓扑比喻 | 规则网格:像摩天大楼的承重结构,层级分明,路径固定且可预测。 | 航空枢纽:城市间直飞(全局链路)与市内交通(本地组)结合,追求最短跨组跳数。 | 高速公路网 :基于数学(图论)精心设计的主干道,实现理论上任意两点间的最短路径。 | 多轨立交:为AI流量定制多条并行高速通道,大部分流量在"轨道"内直接交换。 |

| 网络直径 | 相对固定(例如3层架构直径为6跳)。 | 极低 :任意两点间通信最多仅需 2跳(本地1跳 + 全局1跳)。 | 理论最优 :基于数学(如Moore bound)优化,在给定节点和度下实现可能的最小直径。 | 可变:通过"轨道"化设计,目标是让大部分通信(>85%)在1跳内完成,优化All-to-All流量。 |

| 扩展性 | 优秀且线性:通过增加Spine或Leaf交换机数量即可平滑扩容,规则清晰。 | 极强 :通过增加组内交换机数量或全局链路,可支持超10万卡的集群规模。 | 中等偏上:受限于其严格的数学构造,大规模扩展时可能不如Dragonfly灵活。 | 为AI定制:专为大规模AI训练(万卡级以上)设计,扩展性优秀。 |

| **路径多样性 (对偶图复杂度)** | 极高且均匀 :任意两点间存在大量等价多路径,便于ECMP负载均衡。 | 混合型 :组内路径丰富,但组间路径依赖有限的全局链路,易成瓶颈。 | 高度结构化:路径多样性由其数学定义(如凯莱图)决定,可能不如CLOS均匀。 | 聚焦局部:通过设计使高概率的通信模式(如AI训练中的All-Reduce)路径极短且确定。 |

| 关键优势 | 结构规则、易于管理和故障诊断、多路径负载均衡成熟可靠。 | 超低延迟(尤其对于跨组通信)、设备数量少、总体拥有成本低。 | 在给定的网络度(设备端口数)下,实现了理论上的最低直径和最高效率。 | 为AI流量量身定制,显著降低大规模训练的通信延迟和成本。 |

| 潜在挑战 | 规模极大时,交换机数量和布线成本较高;网络层数可能增加延迟。 | 全局链路拥塞 风险;需要复杂的非最小路径路由算法来避免热点。 | 拓扑结构相对固定,硬件生态和支持度目前可能不如前两者成熟。 | 拓扑特异性强,与通用业务的兼容性、运维工具链需重新构建。 |

深入理解关键差异

以上表格中的特性,源于这些架构根本的设计哲学,这直接影响了它们的"复杂网络特性"和"对偶图"分析。

-

复杂网络特性的体现

-

小世界特性与网络直径 :Slim Fly 和 Dragonfly 的核心目标就是打造一个"小世界网络",即网络的平均直径非常小。这意味着信息从任何一个节点到另一个节点所需要经过的"中转站"(交换机)数量极少,这对于降低AI分布式训练中频繁的全局通信(All-Reduce)延迟至关重要。

-

度分布 :在 Spine-Leaf 中,Leaf交换机的"度"(连接数)较小且固定,Spine交换机的"度"很大。这是一种异构 的度分布。而 Slim Fly 的度分布可能更为均匀,因为其设计目标之一就是在固定度下最大化网络规模。

-

拥塞与鲁棒性 :Dragonfly 的挑战在于其全局链路 可能成为瓶颈。当多个组同时需要相互通信时,这些有限的直连链路容易发生拥塞,需要高级的路由算法(如VALIANT )将流量随机分散到其他组进行"绕行"(非最小路径路由)。而 Spine-Leaf 的鲁棒性来自于其丰富的等价多路径,单条链路或单台交换机的故障很容易被绕过。

-

-

对偶图视角的洞察

"对偶图"是将原网络中的交换机视为节点,将链路视为边,重新绘制的一张图。这个视角对于分析路由效率 和网络可分区性至关重要。

-

在 Spine-Leaf 的对偶图中,会呈现出一个标准的二分图,结构非常规则,这使得路由算法(如ECMP)可以简单高效地工作。

-

Dragonfly 的对偶图会呈现出若干个全连接的完全子图(代表每个组内部),这些子图之间再通过少量的边(全局链路)连接。这个结构清晰地揭示了其脆弱性:那些连接子图的边是网络的关键。

-

Slim Fly 的对偶图则可能对应着某种强正则图 或凯莱图,具有优异的代数性质,这保证了其优越的性能。

-

如何为智算中心选择合适的架构?

选择哪种架构,取决于你的核心目标:

-

追求极致性能与大规模扩展 :当你的目标是构建万卡乃至十万卡级别的超大规模集群以训练千亿参数大模型时,Dragonfly+ (或其变种 Groupwise Dragonfly+ )和专为AI优化的 DDC 架构是优先选择。它们能以更少的设备数量、更低的延迟实现超大规模互联,显著降低总拥有成本。

-

平衡通用性与可管理性 :如果你的集群规模在数千卡以内,或者需要同时承载AI训练、HPC、云计算等多种混合工作负载,Spine-Leaf 是久经考验的稳妥选择。其规则的结构和成熟的运维工具链能大大降低管理复杂度。

-

探索前沿与理论最优 :如果在特定规模下追求理论上的最低延迟和最高效率,并且愿意接受一定的技术风险,Slim Fly 这样的基于高级图论设计的架构是一个值得关注的前沿方向。

Slim Fly 通过网络图论中的 Moore 边界(Moore Bound) 这一极限来指导其数学构造,从而在给定路由器度数(即每个路由器的端口数)的前提下,逼近理论上可能实现的最小网络直径 。其核心在于,它并非直接使用凯莱图或强正则图,而是采用了另一类能逼近 Moore 边界的图(如 MMS 图),这些图与强正则图类似,都具有高度的对称性和优良的组合性质。下面我们通过一个表格和具体解释来说明其数学构造如何保证直径的理论最优性。

| 数学概念 | 在 Slim Fly 构造中的角色 | 对网络直径最优性的保证 |

|---|---|---|

| 度-直径问题 | 定义了设计目标:在给定路由器度数 k和网络直径 D的约束下,最大化网络能连接的终端节点数量 N。 |

明确了优化方向,即寻找在给定 k和 D下能使 N最大化的图结构,此时的直径 D对于该 k和 N而言是理论最优的。 |

| Moore 边界 | 提供了节点数量 N的理论上限。例如,当目标直径 D=2 时,Moore 边界规定最大节点数 Nmax≈k2。 |

为"理论最优性"提供了绝对尺规。任何网络的规模都无法超越此边界。Slim Fly 使用的图(如 MMS 图)的节点数非常接近这个上限。 |

| MMS 等图的构造 | 提供了一类具体的、可构造的图,这些图具有已知的度数 k和直径 D,并且其节点数接近 Moore 边界。 |

通过具体的数学构造方案,实例化了接近理论极限的网络拓扑。这使得 Slim Fly 能用较少的链路(低度数)连接大量节点,并确保任意两点间通信最多只需经过非常少的跳数(低直径)。 |

| 图的高度对称性 | MMS 等图通常具有类似强正则图的对称性,即任意两个相邻节点(或非相邻节点)具有相同数量的公共邻居。 | 这种对称性保证了网络没有性能瓶颈和单点热点,使得负载能均匀分布 across 全网,从而在实践中也能实现理论上的低延迟和高带宽。 |

核心机制:逼近 Moore 边界

Moore 边界是图论中的一个经典概念,它回答了"在不超过既定直径的前提下,一个网络最多能有多大?"这个问题。Slim Fly 的设计哲学正是直接瞄准这个理论极限。其数学构造流程可以概括为:

-

设定目标:首先确定网络的设计目标,例如,要构建一个直径 D=2的大规模网络。

-

依据边界计算规模:根据 Moore 边界公式 N≈k2(对于 D=2),计算出使用特定端口数 k的路由器所能支持的最大理论节点规模。

-

寻找最优图:寻找或构造一种图,其度数正好是 k,直径正好是 2,并且其节点数 N尽可能接近 k2。MMS 图就是这样一类经过数学证明的、能出色逼近 Moore 边界的图。

-

实例化为网络:将这种图的顶点映射为网络中的路由器,边映射为路由器间的链路,就得到了 Slim Fly 网络拓扑。

通过这一过程,Slim Fly 的构造从数学上就保证了其直径是对于给定设备端口数和网络规模而言接近最优的。例如,研究表明,使用 108 端口的商用交换机构建的 Slim Fly 网络,可以支持近 20,000 个端点,而网络直径仅为 2。

强正则图的启示与联系

虽然 Slim Fly 主要采用 MMS 图进行构造,但其追求低直径的思想与强正则图 一脉相承。一个著名的强正则图例子是 Petersen 图,它具有 10 个节点,每个节点度为 3,直径为 2。Petersen 图本身规模很小,但其优美的对称性和最优性启发了广义 Petersen 图等网络模型的研究,用于构建更大规模的互连网络。Slim Fly 可以看作是这种思想在高阶图(节点数远多于 Petersen 图)上的推广和实践,其本质是运用了更深刻的数学工具来求解度-直径问题,从而实现了在大规模下的直径最优性。

总而言之,Slim Fly 架构网络直径的理论最优性并非偶然,而是其底层数学构造------基于能逼近 Moore 边界 的图(如 MMS 图)------的必然结果。这种构造方法确保了在硬件成本(由路由器端口数决定)和网络性能(由通信延迟,即直径决定)之间达到了一个近乎极致的平衡。

从对偶图视角分析,DDC(Distributed Disaggregated Chassis)架构的轨道化设计通过重构网络拓扑的本质连接关系,显著优化了AI训练中All-Reduce通信模式的延迟、带宽利用率和容错性。其核心在于将物理网络的组织方式转化为在对偶图上更优的连通结构,从而匹配All-Reduce的通信特性。以下是详细分析:

- DDC轨道化设计与对偶图映射

-

轨道化设计本质 :DDC架构将传统机框解耦为独立的盒式单元(如NCP、NCF),并采用"轨道"概念组织网络。具体来说,多个服务器上相同序号的GPU网卡被连接到同一个ToR(Leaf)交换机,形成一个"轨道"(Rail)。整个网络因此被划分为多个并行轨道,每个轨道内部实现高速互联(如通过NVLink),轨道间通过Spine交换机通信。

-

对偶图视角的转换:在对偶图中,网络设备(交换机)被视为节点,设备间的连接视为边。DDC的轨道化设计在对偶图中体现为:

-

形成高度模块化的子图:每个ToR交换机及其连接的GPU构成一个局部完全子图(Clique),代表一个轨道。这些轨道子图通过Spine交换机(对偶图中的"超节点")互联。

-

降低对偶图直径 :由于轨道内通信仅需1跳(经由ToR),轨道间通信最多2跳(ToR→Spine→ToR),整个对偶图的网络直径被压缩到极低水平(通常为2)。这与理想的小世界网络特性接近。

-

- 如何优化All-Reduce通信?

All-Reduce操作需要所有节点参与数据聚合与同步,其性能严重依赖网络拓扑的路径多样性和延迟。DDC的轨道化设计通过以下机制实现优化:

| 优化维度 | 对偶图上的表现 | 对All-Reduce的收益 |

|---|---|---|

| 局部性优先 | 轨道内的ToR交换机及其连接设备形成密集连接的子图(团结构) | All-Reduce可优先在轨道内完成局部聚合(如Reduce-Scatter阶段),减少跨轨道流量,降低Spine层负载。 |

| 路径多样性 | Spine交换机在对偶图中作为高阶连接点,提供轨道间多路径 | 进行全局同步时,流量可通过多个Spine并行传输,避免单路径拥塞,充分利用等价多路径(ECMP)。 |

| 延迟优化 | 对偶图直径小(2跳),节点间通信距离短 | 显著降低同步延迟,尤其对于All-Reduce中关键的全局归约步骤。 |

-

具体通信流程优化:

-

阶段1(轨道内Reduce):每个轨道内的GPU首先在本地ToR下完成部分梯度聚合。由于轨道内带宽高且延迟低,此阶段快速完成。

-

阶段2(轨道间All-Reduce):局部聚合结果通过Spine层在轨道间进行全局同步。Spine层的高带宽和多路径保障了全局操作的效率。

-

整体效果 :这种分层操作减少了全局通信的数据量,并通过并行化降低了端到端延迟。

-

- 容错性与负载均衡的增强

-

容错性 :在对偶图中,单个轨道或Spine链路的故障仅影响局部子图。DDC架构支持快速故障检测与路径切换(如DPSH技术),故障轨道内的流量可瞬时重路由到其他健康轨道,避免All-Reduce中断。

-

动态负载均衡 :DDC的FGLB(灵活全局负载均衡)技术允许Spine设备监控远端链路负载,并动态调整ECMP权重。在对偶图层面,这相当于根据实时流量优化边权重,避免部分超节点(Spine)过载,确保All-Reduce流量均匀分布。

理论依据:与ZCube拓扑的类比

DDC的轨道化设计与新型拓扑ZCube(见)理念相似。ZCube通过数学构造(如利用凯莱图)实现低直径和高容错性,其在对偶图上的模块化组织与DDC的轨道化设计异曲同工:

-

ZCube通过分层交换机构建维度化的连接,使All-Reduce等操作可沿不同维度并行执行。

-

DDC的轨道本质上是一种简化的、工程友好的实现,同样旨在优化集合通信的拓扑基础。

总结

总而言之,从对偶图视角看,DDC架构的轨道化设计通过将网络组织为多个局部高连通子图(轨道),并由高阶节点(Spine)高效互联 ,构建了一个逼近理论最优的网络拓扑。这种结构显著优化了All-Reduce通信的局部性、路径多样性和延迟,同时通过动态负载均衡和快速容错机制保障了稳定性。这使DDC特别适合大规模AI训练场景,其中All-Reduce是性能关键路径。

1.3.4 纠删码技术在跨数据中心数据同步中的作用、数据中心容灾中的应用

纠删码技术在跨数据中心数据同步中,主要通过其独特的编码方式和数据放置策略来优化带宽消耗。下面这个表格可以帮你快速对比它与多副本方案的核心差异。

| 特性维度 | 多副本方案 (如三副本) | 纠删码技术 (以RS(10,4)为例) |

|---|---|---|

| 带宽消耗原理 | 需同步完整的多个数据副本 | 将数据编码分割成多个数据块 和校验块 |

| 跨中心同步流量 | 高 (例如,三副本需额外传输200%的数据量) | 较低 (仅需传输数据块和少量校验块,总流量远低于多副本) |

| 存储效率 | 低 (磁盘利用率仅为1/副本数,如三副本约为33%) | 高 (磁盘利用率通常可达70%以上,如10+4配置利用率约为71%) |

| 数据恢复带宽 | 较低 (只需完整拷贝一个现存副本) | 较高 (需从多个节点读取数据块和校验块进行解码计算) |

| 计算开销 | 几乎无 (简单数据复制) | 高 (涉及复杂的编码/解码计算,消耗CPU资源) |

| 适用场景 | 热数据、对写入延迟和恢复速度要求高的场景 | 温/冷数据、对存储成本敏感、数据体量巨大的场景 |

纠删码如何节省带宽

纠删码技术之所以能在跨数据中心的场景下显著节省带宽,主要依赖于以下几个核心机制:

-

数据切片与编码

纠删码技术将一份完整数据分割成k个数据块 ,然后通过数学算法(如Reed-Solomon码)计算出m个校验块,总共生成n=k+m个数据块。在跨数据中心同步时,无需同步整个数据的多个完整副本,而是将这些数据块和校验块分散到不同的数据中心。恢复数据时,只要任意k个块存活,就能还原出原始数据。这意味着同步网络流量从多副本的数倍数据量,降低为仅需传输这些数据块和校验块。

-

局部校验与智能布局

为了进一步优化跨数据中心的带宽消耗,特别是数据恢复时的流量,出现了如LRC(局部校验码) 等更高级的纠删码。LRC在全局校验块之外,还会为一部分数据块生成局部校验块。这样,当某个数据块丢失需要修复时,有很大概率只需在同一个数据中心或区域网络内,利用局部校验块和存活的数据块完成修复,从而避免了昂贵的跨数据中心带宽消耗。

-

数据放置与传输优化

优化的数据放置策略对降低带宽消耗也至关重要。研究提出了通过建模优化数据块的放置策略,综合考虑用户访问延迟和数据恢复时的传输延迟。例如,将访问频率高的"热"数据块放置在更靠近用户的数据中心,同时保证数据块分布能满足高效恢复的需求。此外,像数据归并传输(将多个小数据对象的备份请求打包成一个大数据包再传输)这样的策略,可以有效减少跨数据中心网络传输中小数据包带来的高昂延迟和协议开销,从而提升带宽的有效利用率。

如何选择适合的方案

选择多副本还是纠删码,关键在于平衡您的业务需求。

-

追求极致性能与低延迟 :若您的业务涉及频繁访问的热数据 (如在线交易系统、实时分析),且对I/O延迟和快速恢复有极高要求,多副本方案更具优势,因为它能提供更低的读写延迟和更快的恢复速度。

-

关注成本与海量数据 :若您需要存储的是温数据或冷数据 (如备份归档、大数据分析的历史数据),数据体量巨大且对存储成本敏感,纠删码技术是更经济的选择,它能以更低的存储开销提供更高的数据可靠性。

纠删码的编码和解码计算开销对业务性能的影响确实非常显著,尤其是在高吞吐或高并发的场景下。下面这个表格通过一个对比测试,可以让你对计算开销的影响有个直观的感受。

| 性能维度 | 低冗余场景 (如 RS(10,1)) | 高冗余场景 (如 RS(6,6)) | 说明 |

|---|---|---|---|

| 编码吞吐量 | 极高 (可达 3500 MB/s以上) | 急剧下降 (可低至 200 MB/s以下) | 生成校验块越多,计算越复杂,速度越慢。 |

| 解码吞吐量 | 较高 (可达 2000 MB/s以上) | 较低 (可低至 140 MB/s) | 数据块丢失越多,需要恢复的计算量越大,速度越慢。 |

| CPU 占用率 | 较低 | 显著增高 (可达60%或更高) | 复杂的编解码运算会大量消耗CPU计算资源。 |

| 写惩罚 | 较低 (如 RS(4,1) 为4) | 很高 (如 RS(4,2) 为6) | 单次数据写入需触发多次磁盘I/O和计算,放大I/O压力。 |

计算开销从何而来?

纠删码的计算开销主要源于其数学本质。它不是简单复制数据,而是通过矩阵乘法 等算法(如在伽罗华域上的运算)将 k个原始数据块计算出 m个校验块。这个过程可以简单理解为解一个复杂的多元一次方程组。

-

冗余度是关键因素 :上表中性能的巨大差异,核心原因就是冗余度。

m值(校验块数量)越大,需要计算的校验数据就越多,矩阵运算越复杂,导致CPU计算量急剧增加。例如,RS(10,2)的编码吞吐量远高于RS(6,6),因为后者需要生成更多的校验块。 -

算法优化的作用 :为了降低开销,业界不断优化算法。例如,原始的范德蒙RS编码 计算复杂度高,而改进后的柯西RS编码通过将运算转换到二进制域,利用异或操作代替部分复杂运算,能大幅提升编解码速度。在一些测试中,优化后的柯西编码吞吐量可以是原始范德蒙编码的5倍以上。

权衡的艺术:存储效率 vs. 计算性能

选择纠删码本质上是用计算资源 和写入延迟 去换取存储空间。这种权衡在以下业务场景中需要特别考量:

-

海量温冷数据存储 :这是纠删码的"主战场"。适用于视频、图片、备份归档等访问频率低但体量巨大的数据。这些场景对读取延迟不敏感,存储成本是首要考虑因素,纠删码以计算开销换取高得盘率的优势得以充分发挥。

-

高性能热数据存储 :对于数据库、在线交易系统 等要求低延迟、高IOPS的业务,**多副本(Replication)** 通常是更佳选择。因为多副本的读写路径更直接(近乎零计算开销),性能更高,故障恢复速度也快得多。

-

写密集型业务:需要重点关注纠删码的"写惩罚"。一次数据写入会引发多次I/O和计算,可能成为性能瓶颈。如果业务是写密集型的,需要评估集群的CPU和I/O负载能力。

如何优化与选型?

在实际应用中,可以通过以下策略来优化和决策:

-

数据分层存储:采用"热-温-冷"数据管理策略。热数据用多副本,确保性能;温冷数据迁移到纠删码池,节约成本。

-

利用硬件加速 :采用支持Intel ISA-L等专用指令集的CPU,可以极大加速编解码过程。现代分布式存储系统(如Ceph, HDFS)都已支持这类优化。

-

针对性测试 :理论数据仅供参考,最终决策必须基于实际业务数据的测试。在你的硬件环境和典型工作负载下,测试不同纠删码策略(如RS(6,3)、RS(8,4))的实际吞吐量和延迟,看是否能满足业务SLA(服务等级协议)。

总而言之,纠删码的计算开销是真实存在且不可忽视的,它会直接转化为更高的CPU占用和更长的请求延迟。决策的关键在于精准判断你的业务属于哪种类型:

-

若业务追求极致的存储成本效益 ,且能接受一定的性能代价,纠删码是理想选择。

-

若业务追求极致的性能和低延迟 ,多副本是更稳妥的方案。

最佳实践往往是混合使用这两种策略,并根据数据的重要性、访问频率动态调整,从而实现成本与性能的最佳平衡。

高并发小文件场景下的问题

在高并发小文件场景下,标准配置的纠删码技术确实会面临性能挑战,但通过一系列巧妙的优化策略,可以有效改善其表现。下面这个表格汇总了核心的性能瓶颈与相应的优化方向,希望能帮你快速建立起整体认知。

| 性能维度 | 纠删码的挑战 (小文件场景) | 核心优化目标 |

|---|---|---|

| 写入性能 | 写放大严重:一个小文件也需编码成K+M个数据块,分散写入多个节点,产生大量小IO。 | 减少写入IOPS,避免直接在线EC写入。 |

| 读取性能 | 读放大严重:读取任何小文件,都需要从至少K个节点成功获取数据块并解码,延迟高且易受慢节点影响。 | 优化读取路径,减少网络交互和解码开销。 |

| 元数据压力 | 元数据爆炸:海量小文件产生海量元数据,对元数据服务器的查询和管理造成巨大压力。 | 设计高效的元数据管理系统,并合并小文件。 |

| 存储利用率 | 条带利用率低:小文件可能无法填满一个条带,造成存储空间浪费。 | 提高单次写入的数据量,提升条带利用率。 |

纠删码的本质是将数据切成K个数据块,并计算生成M个校验块,然后将这K+M个块分散存储。对于一个大文件,这种分布式的读写能充分利用多节点带宽。但对于小文件,这种机制却成了性能"杀手"。

-

写入瓶颈 :想象一下,一个1MB的小文件,如果采用RS(6,3)策略(即9个块),它需要被切分、编码,然后发起9次网络写入。这相当于为了存储1MB有效数据,系统实际要处理9次I/O操作,写放大非常严重。

-

读取瓶颈与长尾延迟 :读取时更麻烦。系统必须从9个节点中成功取回任意6个块,才能解码出原始文件。只要有一个节点响应慢,整个读取请求就会被拖慢,这就是所谓的长尾延迟问题,在高并发下会急剧放大。

-

计算开销:高频的编解码运算会给CPU带来持续压力。

纠删码核心优化策略

针对以上痛点,业界提出了几种有效的优化思路。

- 元数据与管理优化

海量小文件带来的海量元数据是首要瓶颈。优化方向包括采用分布式元数据服务(如基于Raft协议构建)来取代单点元数据管理,并将元数据存储在SSD上以加速访问。

- 数据组织与IO优化

这是提升性能的关键,核心思想是 "化零为整"。

-

小文件合并 (Object Merging) :这是最核心的优化之一。系统在写入时,不再将每个小文件直接进行EC编码,而是先将一段时间内的多个小文件在内存或缓存中拼接成一个更大的逻辑对象(例如几MB或几十MB),再对这个大对象执行EC条带化写入。这样做的好处是:

-

大幅减少IOPS:将N次随机小IO合并成一次顺序大IO。

-

提高条带利用率:使每个EC条带都被有效数据填满。

-

降低元数据数量:多个小文件合并后,可能只对应一份EC条带的元数据。

-

-

智能条带放置策略 :为了优化读取,在合并小文件时可以采用更智能的放置策略。例如,纵向条带搁置策略会尽量让单个小文件的数据块集中在少数几个节点上。这样在读取这个文件时,可能只需访问1-2个节点而非K个节点,极大地减少了网络交互,降低了读取延迟和长尾风险。

-

备份请求 (Backup Request):为应对读取时的慢节点问题,可以在发起读取请求时,同时向超过K个(例如K+1或K+2个)节点请求数据块。无论哪K个块先返回,都立即开始解码并响应应用,从而有效抵消个别节点高延迟的影响。

- 系统架构优化

-

分层存储/离线EC (Offline EC) :对延迟极其敏感的在线写入,可以采用折中方案。数据先高速写入一个多副本缓存层 (如SSD),快速响应客户端。然后,后台有异步任务将缓存层的数据批量合并、转换为EC编码,再存入持久化的EC存储池。这用空间换取了时间,实现了写入性能和经济性的平衡。

-

Quorum写入机制 :在线EC写入时,不要求所有K+M个块都写入成功才返回。可以设定一个法定数量(如K+1个块写入成功),就向应用报告写入成功。失败的数据块由后台进程异步修复,这能显著提升写入请求的成功率和降低延迟。

总结与建议

总而言之,面对高并发小文件场景,直接使用原生纠删码通常不是最佳选择 。但其通过 **"合并写入、智能放置、缓存加速、异步转换"** 等优化策略后,纠删码系统完全可以胜任此类场景,并在存储成本和控制长尾延迟方面取得良好平衡。

选择建议:

-

若您的业务纯粹追求极致的读写延迟和吞吐量 ,且对存储成本不敏感,多副本方案仍是更简单直接的选择。

-

若您的业务数据体量巨大 ,对存储成本敏感 ,同时能够接受经过优化后依然略高于多副本的延迟(尤其是在读路径上),那么采用上述优化策略的纠删码方案是非常经济的选择,特别适用于图片、短视频、日志文件等温冷数据的存储场景。

纠删码技术在分布式存储系统中,确实需要根据不同的数据规模、访问模式和性能要求来灵活调整策略。

| 数据场景类型 | 典型数据规模与访问特点 | 纠删码核心策略 | 性能表现与优化重点 |

|---|---|---|---|

| 海量小文件/元数据 | 文件尺寸小(如小于128KB),数量极多,随机读取为主,要求低延迟和高TPS(每秒事务数)。 | 小对象合并 、非系统化MSR编码 、纵向条带搁置 、离线批处理。 | 写放大 和读放大是主要挑战。通过合并小文件为逻辑大对象再编码,大幅减少IOPS;通过优化数据局部性,使多数读取能在少数节点完成,降低延迟。 |

| 大文件/流式数据 | 文件尺寸大(如GB级以上),顺序读写为主,追求高吞吐带宽(Throughput)。 | 系统化MSR编码 、横向条带搁置 、大条带参数(如16+4)。 | 性能瓶颈主要在网络带宽 和磁盘顺序IO能力。条带化写入能充分利用多节点带宽。关注点在于降低跨数据中心同步的流量和提升数据修复效率。 |

| 混合负载/在线服务 | 数据规模与类型混合,要求兼顾读/写延迟(Latency)与吞吐量,保证服务稳定性。 | 数据分层 (热数据多副本+温冷数据EC)、参数自适应 、Backup Request机制 、异构集群感知。 | 核心是平衡与稳定。通过自适应算法为不同文件选择最佳EC参数;采用备份请求抵御慢节点引发的长尾延迟;在异构硬件环境中智能放置数据以实现负载均衡。 |

性能表现与优化策略探析

纠删码的性能挑战根源于其机制:数据被分片编码并分散存储,任何读写操作都可能涉及多个节点。

-

小文件场景的挑战与优化

小文件场景下,每个文件都可能触发一次完整的EC编码和跨网络写入,产生巨大的写放大 。读取时,即使获取一个极小文件,也可能需要从多个节点读取数据块进行解码,导致读放大 和长尾延迟。

优化策略核心是"化零为整"。小对象合并(Object Merging) 是将多个小文件在逻辑上打包成一个大对象再进行EC编码,从而将大量随机小IO转化为少量顺序大IO。纵向条带搁置(Contiguous Placement) 策略则尽可能让单个小文件的数据集中在少数节点上,多数读取操作只需访问1-2个节点即可完成,显著降低了网络交互和延迟。对于延迟敏感性极高的在线写入,可采用 **"离线写在线读"** 架构,数据先写入高性能的多副本缓存层,再由后端服务异步合并、转换为EC格式,实现性能与成本的平衡。

-

大文件场景的挑战与优化

大文件场景追求高吞吐。横向条带搁置(Stripe Placement) 策略将文件数据顺序切分后分布到大量节点上,写入和读取时可以并行利用所有节点的聚合带宽,非常适合流式数据传输。此时,选择较大的K、M值(如10+4,16+6)能获得更高的存储利用率,但需注意,过大的K值会在节点故障时增加修复带宽和数据不可用时间。对于跨数据中心的容灾,**LRC(局部校验码)** 等高级编码方案能在局部区域内完成大部分数据修复,极大减少昂贵的跨数据中心带宽消耗。

-

混合负载场景的挑战与优化

混合负载场景要求系统具备弹性和智能。基于CRITIC客观权重法的参数自适应选择 是一类先进方案,它通过数学模型综合评估文件大小、可靠性目标、存储成本等多个性能指标,动态为每个文件或每类数据选择最优的EC参数(K, M),实现全局最优权衡。备份请求(Backup Request) 机制是应对长尾延迟的有效手段,当向某个节点请求数据超时,可同时向其他存有相同数据块的节点发送备份请求,取最快返回的结果,从而有效屏蔽慢节点的影响。在硬件异构的环境中,异构感知数据放置策略 将性能相近的节点分组,确保一个EC条带内的数据块尽可能分布在同一组内,避免木桶效应,提升任务执行效率。

数据中心级容灾设计要点

在数据中心级别部署纠删码容灾方案,需从全局视角规划数据分布与修复流程。

-

数据放置与风险感知 :简单的跨数据中心均匀分布数据块并非最优。先进的策略会引入风险感知,综合考虑地理分布的灾害风险对数据中心和通信链路的影响,建立数据安全放置的数学模型。目标是避免将所有数据块放置在同一个高危区域,而是分散在风险概率较低且相对独立的故障域中,从而在灾备层面降低数据整体丢失的风险。

-

修复流程的优化 :当某个数据中心或大量节点同时故障时,高效的修复机制至关重要。传统逐块修复方式会产生巨大网络流量。优化方案如**高效修复树(ERT)** 被提出,通过在修复过程中尽早使数据块在网络中间节点进行智能合并(如异或操作),显著减少修复流量的传输。同时,采用动态调整修复树根节点的策略,能更好地适应网络拓扑,实现负载均衡,加速整体修复过程。

-

系统架构与硬件加速 :在系统层面,可以采用扁平化数据中心存储架构 ,认为在网络带宽足够高的前提下,数据的局部性不再是最关键因素,存储与计算可分离。同时,利用Intel ISA-L等专用指令集库对编解码过程进行加速,能极大降低CPU开销,这对于处理大量数据的场景性能提升非常关键。

核心原则总结

选择与优化纠删码策略,本质上是持续在存储效率、性能、可靠性之间进行权衡。核心原则可总结为:

-

小文件 :首要目标是降低IOPS放大和延迟,核心思路是合并与缓存。

-

大文件 :首要目标是最大化吞吐量和修复效率,核心思路是条带化并行和智能编码。

-

混合负载 :首要目标是实现智能均衡与稳定,核心思路是自适应、感知环境和冗余请求。

风险感知数据放置模型的具体实现方法

这类模型的核心目标,是将数据智能地放置在最能支持其风险识别与预警功能的位置,这通常涉及对数据来源、特征、关联关系的系统化处理。

任何数据放置模型的第一步都是理解数据。以监控大型工业设备(如风机、水泵)的振动信号为例,我们需要定义数据的层次和风险指标:

-

原始数据层:直接从传感器采集的、带有时间戳的连续振动信号。

-

特征指标层:从原始信号中提取的、与设备健康状态相关的关键指标,例如:

-

时域特征:有效值(RMS,反映总体振动能量)、峰值(反映冲击性故障)、偏度/峭度(反映信号分布形状,对早期损伤敏感)。

-

频域特征:通过傅里叶变换得到的频谱,可以识别特定频率成分(如轴承的故障特征频率、齿轮的啮合频率),这是诊断故障类型的核心依据。

-

-

风险标签层:基于特征指标和历史经验设定的阈值或模型输出,为数据打上标签,如"正常"、"预警"、"报警"。

🧠 核心:三种典型的数据放置模型实现路径

基于上述数据层次,我们可以选择不同的技术路径来构建数据放置模型。

- 参数化规则模型 (适用于机理明确、规则清晰的场景)

这种方法的核心是 **"如果...那么..."** 的专家规则。它将领域知识(如设备维护手册中的振动标准)固化为可执行的逻辑。

-

实现举例:

-

数据放置策略 :将振动峰值 和轴承故障特征频率的幅值这两个关键特征指标,存储在高速时序数据库中,以便实时计算和规则判断。

-

模型规则:

-

IF振动RMS值 > 7.1 mm/sAND峭度指标 < 3.5THEN状态 = "预警",数据流向 = "预警数据库"并触发工单系统。 -

IF频谱中检测到轴承外圈故障特征频率THEN状态 = "报警",数据流向 = "高优先级报警队列"并通知维护工程师,同时将完整的原始波形数据归档至"故障案例库"以供深度分析。

-

-

这种方法逻辑清晰、解释性强,非常适合机理明确的常规故障。但当设备增多、故障模式复杂后,维护成千上万条规则会变得非常困难。

- 机器学习判别模型 (适用于从数据中学习复杂模式的场景)

当故障征兆与正常运行状态差异微小,难以用简单规则描述时,机器学习模型可以自动从海量历史数据中学习出正常的"模式",并识别出偏离该模式的异常。

-

实现举例:

-

模型选择与训练 :使用隔离森林(Isolation Forest) 或**一类支持向量机(One-Class SVM)** 等无监督异常检测算法。模型使用设备正常运行时的大量振动特征数据(如RMS、峰值、多频段能量等)进行训练,学习"健康"的数据分布。

-

数据放置策略 :将所有用于模型推理的特征指标 放置在模型的输入侧特征库 中。当模型判定某个设备的数据点为"异常"时,该设备的所有相关数据(包括原始波形)会被自动标记并**放置到"嫌疑故障数据池"** 中,供专家进行复核和诊断。

-

这种方法能发现人难以定义的复杂异常模式,但模型决策过程如同"黑箱",解释性较差。

- 知识图谱关联模型 (适用于需要理解全局关联性的场景)

对于复杂系统,单一设备的故障可能引发连锁反应。知识图谱擅长表达"实体"和"关系",能将分散的风险信息连接成一张全局网络。

-

实现举例:

-

图谱构建 :以设备(如"水泵A")、部件("轴承B")、传感器("振动传感器S1")、测点、报警事件等为节点 。以它们之间的关系("隶属于"、"安装于"、"采集自"、"曾发生")为边,构建知识图谱。

-

数据放置策略 :当传感器S1产生报警时,系统不仅查看S1的数据,还会通过知识图谱自动关联查询:

-

与水泵A通过同一管道连接的"水泵C"和"阀门D"最近是否有异常?

-

轴承B的历史维修记录 和同类设备的故障案例有哪些?

-

-

所有被关联到的实体数据,会被动态地、临时性地"放置"在一个统一的分析视图中,帮助分析人员快速定位根本原因。

-

这种方法极大地增强了风险情境的感知能力,能够揭示隐藏的依赖关系和传播路径,实现从"点状预警"到"全局洞察"的飞跃。

💡 如何选择与融合使用?

在实际应用中,通常不会只采用一种模型,而是根据需求进行组合:

-

追求快速响应和明确规则 时,可首选参数化规则模型。

-

需要检测未知故障或复杂模式 时,可结合机器学习判别模型。

-

当系统复杂、需要理解风险的全景和关联 时,知识图谱关联模型能提供更深入的洞察。

这三种模型也常常协同工作,例如,用规则模型进行实时阈值判断,用机器学习模型进行周期性深度扫描,最后将所有报警和资产信息用知识图谱进行关联分析,形成一套层次化的风险感知数据管理体系。

平衡纠删码参数 (K, M) 与容灾指标(RTO/RPO)

在实际部署中,平衡纠删码参数 (K, M) 与容灾指标(RTO/RPO)是一个核心的架构决策。下面这个表格清晰地展示了这种权衡关系,可以帮助你快速把握核心思路。

| 关键指标 | 偏向高可用性/低延迟 (低RTO/RPO) | 偏向存储效率/成本优化 | 内在权衡逻辑 |

|---|---|---|---|

| **数据冗余量 (M)** | 倾向较大的M值 (如4或6),以容忍多个节点或整个机架甚至数据中心故障。 | 倾向较小的M值 (如2或3),以减少存储开销和网络传输量。 | **M ↗** → 可靠性↗,跨数据中心带宽消耗↗,写入延迟可能↗。 |

| **数据块数量 (K)** | 倾向较小的K值 。单个数据块较大,修复时需读取的节点数少,解码计算量小,能加快恢复速度。 | 倾向较大的K值。有利于提高存储效率(冗余度 = (K+M)/K),K越大,效率越高。 | K ↗ → 存储效率↗,但单点故障需联系更多节点(K个)修复,恢复时间可能延长。 |

| 典型应用场景 | 核心交易库、实时在线服务。常采用多副本+纠删码分层 或LRC码。 | 备份归档、大数据分析、温冷数据存储。可采用RS码并设置较大的K值。 | 需要在业务连续性与存储成本之间找到最佳平衡点。 |

深入理解权衡机制

表格中的关系源于纠删码的工作原理。RPO(恢复点目标)衡量数据丢失量,主要由数据保护频率决定。而RTO(恢复时间目标)衡量服务恢复速度,在纠删码场景下,受以下因素显著影响:

-

恢复带宽 :当发生故障,需要修复或重建数据时,传统RS码需要从至少 K 个存活节点读取数据。如果K值很大,就意味着需要传输更多的数据,这会直接拉长恢复时间,不利于实现低RTO。

-

局部修复能力 :这是优化RTO的关键。像LRC码 这样的编码方式,通过创建局部校验组 ,使得当组内单个数据块丢失时,只需从组内少数几个节点读取数据即可恢复,而无需联系所有的K个节点。这极大地减少了修复时的网络传输量,从而显著降低了数据恢复的延迟,有助于实现更低的RTO。

-

计算开销:编解码过程需要CPU计算。在恢复时间紧迫的情况下,巨大的计算量可能成为瓶颈。因此,选择计算效率更高的编码库(如Intel ISA-L)或利用硬件加速(FPGA)对满足低RTO至关重要。

容灾场景下的参数配置策略

基于以上理解,可以形成以下部署策略:

-

为不同数据分级设定策略

这是最有效的方法。不要试图用一种配置满足所有需求。

-

热数据 (要求极低RTO/RPO) :对性能敏感,通常采用多副本 策略。若要使用纠删码,可考虑K=4, M=2 这类小参数配置,或采用LRC码(如Azure云采用的LRC),将局部组设置在同一机架内,实现快速修复。

-

温数据 (平衡成本与性能) :可采用标准的RS码,例如RS(6,3) 或 RS(10,4)。这样在存储效率和恢复时间之间取得了较好平衡。

-

冷数据/归档数据 (成本优先) :主要目标是降低存储开销,可以容忍较长的RTO。此时可采用**RS(14,10)** 或更大的K值,以追求极高的存储效率。

-

-

跨数据中心容灾的特殊考量

在跨数据中心的场景下,网络带宽通常是昂贵且有限的稀缺资源。

-

优化跨中心流量 :采用LRC码,并将局部校验组与单个数据中心对齐。这样,当某个数据中心内发生单块故障时,修复流量被限制在该数据中心内部,避免了昂贵的跨数据中心带宽消耗,这对保护RPO和降低成本非常关键。

-

利用WAN加速技术:结合数据压缩、重复数据删除等技术,减少实际需要同步的数据量,间接优化恢复时间。

-

-

利用现代编码技术优化

-

局部修复码 (LRC):如前所述,LRC通过牺牲少量存储空间(增加局部校验块)来换取修复速度的极大提升,是平衡RTO和存储效率的利器。

-

持续数据保护 (CDP):对于RPO要求极高的核心系统,纠删码可与CDP技术结合。CDP近乎连续地捕获数据变化,实现近乎零的RPO;纠删码则作为底层的经济存储方案。

-

核心总结

总而言之,纠删码参数(K, M)与RTO/RPO的平衡,本质上是存储效率、计算资源、网络带宽与业务连续性要求之间的权衡。

决策时,最关键的步骤是对数据进行分级 ,并为不同级别的数据制定明确的RTO/RPO目标。然后,基于这些目标去选择最合适的纠删码类型(如RS、LRC)和参数。在跨数据中心场景下,重点考虑LRC等能减少跨域流量的方案,并充分利用硬件加速和WAN优化技术。

存储系统的容灾规划中:RAID(独立磁盘冗余阵列)与纠删码(Erasure Coding)

在存储系统的容灾规划中,RAID(独立磁盘冗余阵列)与纠删码(Erasure Coding)是两种核心的数据保护技术。它们分别适用于不同的场景,共同构建了从单机到分布式系统的多层次容灾体系。

下面这个表格直观地对比了它们在容灾规划中的关键特性,帮助您快速把握核心差异。

| 特性维度 | RAID (冗余磁盘阵列) | 纠删码 (Erasure Coding) |

|---|---|---|

| 冗余机制 | 主要在单节点或磁盘阵列内部通过镜像或奇偶校验实现冗余。 | 跨节点/机架/数据中心,将数据分块编码后分散存储。 |

| 容错粒度 | 通常针对磁盘故障(如RAID 5容忍1块盘故障,RAID 6容忍2块盘故障)。 | 可针对节点故障、机柜故障甚至数据中心级故障,容错能力由编码参数决定(如"8+2"配置可容忍2个组件故障)。 |

| 存储效率 | 相对较低(例如,RAID 1的存储利用率仅为50%,RAID 5约为(N-1)/N)。 | 更高(例如,与三副本相比,采用RS编码可能仅需1.5倍存储空间即可实现相当的容错能力)。 |

| 典型应用场景 | 本地存储、数据库服务器、对低延迟和高性能要求高的关键业务。 | 云存储、大数据平台(如Hadoop、Ceph)、海量温冷数据 存储,优先考虑存储成本效益。 |

💡 规划要点:如何选择与结合使用

在实际的容灾系统规划中,RAID和纠删码并非互斥,而是常常协同工作。

-

数据分层策略是关键

根据数据的热温冷属性采用不同的保护机制是通用最佳实践。

-

热数据(访问频繁) :对性能要求极高,通常建议采用多副本 或高性能的RAID 10(RAID 1+0)。在分布式系统中,新写入的热数据也可先采用多副本策略,再异步转换为纠删码。

-

温/冷数据(访问频次低) :对存储成本敏感,非常适合采用纠删码技术,如Ceph中常见的"8+2"、"10+4"等配置。这能在保证可靠性的前提下显著提升存储空间利用率。

-

-

关注恢复速度与"写惩罚"

-

恢复时间:RAID在重建大容量故障磁盘时可能耗时较长。纠删码的数据修复需要读取较多数据块并进行解码计算,会占用网络和CPU资源。规划时需评估并确保恢复速度能满足业务连续性要求(RTO)。

-

写惩罚:RAID 5/6等级别在写入数据时需更新奇偶校验信息,会产生"写惩罚",影响随机写入性能。纠删码的数据更新过程也相对复杂。在写入密集型场景下,这一点需要重点考量。

-

-

利用先进编码技术优化

为了克服标准纠删码(如RS码)在修复开销方面的不足,可以采用更先进的编码方案。例如,**LRC(局部校验码)** 通过增加局部校验块,使得大部分数据修复操作能在系统局部完成,大幅减少了跨节点或跨机柜的数据传输量,有效降低了修复带宽和延迟。

🛠️ 实施建议

-

明确业务需求:首先定义关键业务的RPO(恢复点目标)和RTO(恢复时间目标)。例如,医院核心系统(HIS)可能追求RPO=0和RTO≈0,这需要通过双活数据中心等架构来实现。

-

硬件与软件选型:对于RAID,选择支持所需RAID级别且带有电池保护缓存的高质量硬件RAID卡,有助于提升性能与可靠性。对于纠删码,选择成熟稳定的分布式存储软件(如Ceph)至关重要。

-

监控与维护:建立完善的监控系统,实时监控RAID阵列健康状况和分布式存储集群的存储池状态。制定定期的数据备份和容灾演练计划。

混合云环境中RAID 与纠删码组合使用

在混合云环境中,将 RAID 与纠删码组合使用,核心目标是平衡性能、成本、可靠性和可扩展性。下面这个表格清晰地展示了它们在不同场景下的角色与协作方式,可以帮助你快速掌握核心策略。

| 存储层级/数据类型 | 核心目标 | 推荐技术组合 | 部署位置与说明 |

|---|---|---|---|

| **热数据 (高频访问)** | 极致性能与低延迟 | RAID (如10/50/60) 或 多副本 | 私有云/本地数据中心。为保证关键应用(如数据库)的响应速度,采用硬件RAID卡或基于NVMe的RAID卸载技术,将计算开销从主机CPU卸载。 |

| **温数据 (中低频访问)** | 性能与成本的平衡 | **纠删码 (如RS(8,4), LRC)** | 私有云/本地集群。用于大数据分析、内部文件共享等场景。纠删码能以较低存储开销(如1.5倍)提供高可靠性。 |

| **冷数据 (归档备份)** | 极致的存储成本优化 | 纠删码 + 公有云对象存储 | 公有云。将备份、归档数据迁移至支持纠删码的公有云对象存储(如AWS S3 Standard-IA/Glacier)。利用其近乎无限的扩展性和按需付费模型。 |

💡 策略核心:分层治理与动态流动

上述实践的成功,依赖于两个关键原则:分层治理 和动态流动。

-

分层治理:承认不同类型的数据有不同价值,不应采用"一刀切"的存储方案。核心交易库需要RAID提供的毫秒级延迟,而历史合规数据则优先考虑纠删码的经济性。

-

动态流动 :数据的价值会随时间变化。最佳实践是建立自动化的数据生命周期管理策略。例如,可设定规则让生产数据在30天后从高性能的RAID存储池自动迁移至温数据纠删码池,一年后再归档至公有云。这确保了资源被高效利用。

🛠️ 实施路径与注意事项

将策略落地时,以下几点至关重要:

-

数据分类是基石 :首先必须与业务部门协同,根据访问频率、性能要求和业务重要性对数据进行清晰分类。这是所有后续决策的基础。

-

利用现代硬件卸载计算开销 :在私有云中处理热数据时,为充分发挥NVMe SSD的性能并解放主机CPU,应考虑采用新一代硬件加速技术。例如,使用专为NVMe设计的RAID卡或基于GPU的RAID协处理器,将奇偶校验计算任务卸载,从而为应用释放宝贵的CPU资源。

-

统一管理平面 :理想的混合云存储方案应提供一个统一的管理界面,能够同时管理本地RAID阵列、分布式纠删码集群和多个公有云的存储资源。这能极大降低运维复杂度。

-

网络是隐形基石 :混合云架构严重依赖网络连接。必须确保私有云和公有云之间有高质量、高带宽、低延迟的网络链路。对于数据同步和迁移,网络的稳定性和带宽直接决定了RTO(恢复时间目标)和RPO(恢复点目标)。

💎 总结

总而言之,RAID与纠删码在混合云中并非替代关系,而是互补伙伴。核心策略是:利用RAID保护对性能敏感的热数据,利用纠删码高效存储温冷数据,并通过自动化生命周期策略让数据在"热-温-冷"分层间自由流动,最终在整体上实现性能、成本与可靠性的最佳平衡。

1.3.5 容灾方案对业务RTO(恢复时间目标)和RPO(恢复点目标)的影响

量化评估容灾方案对业务RTO(恢复时间目标)和RPO(恢复点目标)的影响,是一个系统性的过程。它始于对业务自身的深刻理解,终于对技术方案的持续验证。下面这个表格概括了评估流程中的核心环节,希望能帮助您快速建立整体认知。

| 评估环节 | 核心任务 | 关键产出/量化方法 |

|---|---|---|

| 1. 业务影响分析 | 识别关键业务,评估中断影响,确定其固有的RTO/RPO需求。 | 业务系统分级(如Tier 1-4)、各业务可容忍的最大中断时间与数据丢失量。 |

| 2. 技术方案映射 | 将容灾技术能力(如备份、复制、多活)与业务需求进行匹配。 | 不同技术方案可实现的理论RTO/RPO范围(如同步复制可实现RPO≈0)。 |

| 3. 成本效益分析 | 量化实现特定RTO/RPO目标的投入与不达标的潜在损失。 | 容灾方案总拥有成本(TCO)、因停机与数据丢失造成的预期经济损失。 |

| 4. 测试与演练 | 通过模拟故障,实际测量方案的真实恢复能力。 | 实测的恢复时间、数据丢失量、成功率,并与预设目标对比。 |

第一步:明确业务的真实需求

任何容灾方案的起点都不是技术,而是业务。您需要先回答:"如果系统中断,对业务意味着什么?" 这就是业务影响分析(BIA)。

-

识别关键业务系统:并非所有系统都同等重要。您可以参考行业实践,将系统分为不同等级。例如:

-

Tier 1-核心交易系统 :如支付、证券撮合引擎。中断会直接导致收入损失和重大声誉风险,要求RTO/RPO极低(如RTO<30秒,RPO=0)。

-

Tier 2-重要业务系统 :如电商订单、CRM系统。中断影响业务运营,但有一定缓冲时间,通常要求RTO/RPO在分钟到小时级。

-

Tier 3-内部支持系统 :如内部邮件、开发测试系统。中断影响效率,但可接受较长的恢复时间,RTO/RPO可达数小时或更长。

-

-

量化中断影响:与业务部门协作,估算每小时中断可能导致的经济损失(收入、违约金)、客户流失风险以及合规处罚金额。这为后续的成本效益分析提供依据。

第二步:分析容灾技术方案的影响

不同的容灾技术直接决定了RTO/RPO的天花板。下表对比了主流方案的特性:

| 容灾方案 | 典型RPO(数据丢失) | 典型RTO(恢复时间) | 核心技术原理 | 适用场景 |

|---|---|---|---|---|

| 备份与恢复 | 数小时 ~ 数天 | 数小时 ~ 数天 | 定期生成数据副本,恢复时完整还原。 | 非核心数据、归档、可接受长时间中断的系统。 |

| 异步复制 | 秒级 ~ 分钟级 | 分钟级 ~ 小时级 | 数据在主节点处理后,异步复制到备节点。 | 重要业务系统,可容忍少量数据丢失。 |

| 同步复制/双活 | ≈ 0 | 秒级 ~ 分钟级 | 数据必须在主备节点同时写入成功后才确认。 | 核心交易系统,要求零数据丢失和快速切换。 |

| 多活架构 | ≈ 0 | **秒级(甚至用户无感)** | 多个节点同时提供服务,故障时流量直接切至存活节点。 | 对连续性和扩展性有极高要求的互联网核心业务。 |

量化影响的关键 :评估方案时,需重点关注其自动化程度。任何需要人工干预的步骤(如手动确认故障、执行切换脚本)都会显著增加RTO。全自动化的故障检测与切换流程是实现低RTO的基石。

第三步:进行成本效益分析

更低的RTO/RPO意味着更高的技术复杂度和成本。您需要权衡"投入"与"风险"。

-

投入成本:包括硬件/软件采购、网络带宽(尤其是跨数据中心的同步复制对带宽质量和延迟要求极高)、运维人力成本等。

-

风险成本 :即第一步中估算的业务中断损失 。其计算公式可参考为:总损失 = (中断时间 × 单位时间收入损失) + (数据丢失量 × 数据价值) + 商誉/合规损失。

-

平衡点 :容灾设计的目标不是追求"零中断",而是找到业务的风险容忍度 与控制措施成本之间的最优平衡点。例如,一个每小时损失10万元的系统,投入200万元建设容灾是合理的;而一个每小时损失1000元的系统,则可能选择更经济的方案。

第四步:通过演练进行实测与验证

"纸上得来终觉浅",所有理论评估都必须通过定期的容灾演练来验证。

-

演练指标监控:

-

RTO达成率:实际恢复时间是否满足预设目标?

-

RPO达成率:恢复后的数据是否与故障发生点一致?

-

业务恢复成功率:所有关键业务是否都成功恢复?

-

流程规范性:切换过程是否顺畅,有无意外情况?

-

-

持续优化:演练结果应直接用于优化容灾方案和应急预案。例如,阿里云通过混沌工程工具AHAS-Chaos主动注入故障,不断验证和打磨其多活容灾架构MSHA的可靠性。

总结

总而言之,量化评估容灾方案的影响是一个闭环过程:从业务需求出发,映射到技术方案,权衡其成本效益,并最终通过实战演练进行验证和持续优化。清晰的定义、科学的分析和持续的验证,是确保您的容灾方案真正能为业务连续性保驾护航的关键。

1.4 拓扑数据分析

1.4.1 持续同调

持续同调(Persistent Homology)是拓扑数据分析(TDA)中的核心工具,它通过一种称为"条形码 "的直观方式,来量化数据在不同尺度下的拓扑特征。当应用于道路网络时,这些条形码就像给网络做了一次"CT扫描",能深刻揭示其结构的稳定性、冗余度以及脆弱环节。

下面这个表格可以帮助你快速理解不同类型的条形码及其在道路网络中的直观含义。

| 条形码类型 | 代表的拓扑特征 | 在道路网络中的直观比喻与稳定性含义 |

|---|---|---|

| 0维条形码 | 连通分支 | 将每个交叉口视为点,随着连通距离增大,孤立的区域会连接起来。长条码代表稳定的、联系紧密的社区或区域。 |

| 1维条形码 | 环状结构 | 代表网络中的"环路"。长条码表示稳定存在的大环(如城市环线),意味着冗余路径多,稳定性强。 |

| 高阶条形码 | 高维空洞 | 在更复杂的空间结构中存在,道路网络中较罕见,可能对应特殊的立体交通枢纽。 |

如何生成道路网络的条形码

理解条形码的含义后,我们来看看它是如何从具体的道路网络中产生的。这个过程就像用不同的"放大镜"来观察网络:

-

构建网络 :首先,将道路网络抽象为一个图,其中交叉口作为节点 ,道路段作为边。

-

定义"尺度" :选择一个尺度参数(通常用交叉口之间的距离或通行时间来表示)。

-

逐步"连接":从尺度为0开始,此时每个交叉口都是孤立的点。然后逐渐增大尺度参数,当两个交叉口间的距离小于等于当前尺度时,就在它们之间连上一条边。

-

追踪特征变化:在这个尺度由小变大的过程中,拓扑特征(连通区域、环路)会随之"出生"和"死亡"。例如,一个连通区域的"出生"是尺度增大到足以连接其中某些点时,"死亡"则是其与另一个区域合并时。一个环路的"出生"是形成封闭圈时,"死亡"则是圈内区域被完全填满时。

-

记录为条形码:为每个观测到的拓扑特征在数轴(尺度参数)上画一条线段,起点是其"出生"的尺度,终点是其"死亡"的尺度。所有特征的线段集合就构成了条形码。

通过分析这些条形码,我们可以超越传统的图论指标,从"形状"的角度深刻理解道路网络的本质特性。

量化评估稳定性的关键指标

要从条形码中提取具体的稳定性数值,通常关注以下几个核心指标:

| 评估目标 | 关键指标 | 指标解读 |

|---|---|---|

| 整体鲁棒性 | 持久性寿命均值/方差 | 计算所有条码(或某维条码)的"死亡时间-出生时间"的统计值。均值越大,表示网络整体拓扑特征越稳定;方差越小,说明网络结构越均匀。 |

| 特征重要性 | 单个条码的持久性 | 重点关注那些"寿命"极长的条码。例如,一个从很小尺度产生直到尺度极大才"死亡"的1维条码,可能对应着城市的核心环线,是网络稳定性的关键支柱。 |

| 结构复杂性 | 各维贝蒂数条形码数量 | 在特定尺度下,存活的条码数量即为该维的贝蒂数。通过观察不同尺度下贝蒂数的变化,可以了解网络结构的层次性。 |

实际应用与价值

在实际的城市路网分析中,这种方法能提供独特的洞察:

-

识别关键基础设施 :通过寻找那些"寿命"最长的1维条码,可以精准定位对网络连通性至关重要的环线或主干道。这些道路是网络的"骨架",它们的拥堵或损坏会对全局稳定性造成巨大冲击。

-

评估不同区域的结构稳定性 :可以对城市不同区域(如老城区与新建开发区)的路网分别进行持续同调分析。通过比较其条形码特征,可以量化评估哪个区域的路网结构更鲁棒,这对城市规划有重要指导意义。

-

模拟故障影响 :通过模拟移除某些路段或交叉口(这在拓扑上相当于改变过滤规则),然后重新计算条形码,通过对比"手术"前后拓扑特征的稳定性变化,可以定量评估局部故障对全局结构的影响,识别出潜在的脆弱点。

总结

总而言之,持续同调中的条形码提供了一种强大且直观的数学工具,它将道路网络的几何连接信息,转化为关于其深层结构稳定性的拓扑洞察。通过分析条码的"长短"和"分布",我们能够超越传统的网络指标,从"形状"的维度评估网络的冗余性、鲁棒性,并识别出对稳定性至关重要的核心结构和潜在的脆弱环节。

1.5 智算中心DDC(Distributed Disaggregated Chassis)架构

1.5.1 DDC架构数学基础、业务场景映射以及性能界限

DDC(Distributed Disaggregated Chassis)架构通过其独特的网络拓扑和资源调度方式,在现代智算中心承载着关键任务。理解其背后的图论、复形几何原理及网络流特性,对于优化各类业务场景(如All-reduce)的性能至关重要。数学基础、业务场景映射以及性能界限三个层面,系统解析DDC架构的核心原理与约束。

数学基础与分析方法

DDC架构的核心数学思想是将物理资源(CPU、GPU、交换机、链路)及其连接关系抽象为复杂的网络模型,以便用严谨的数学工具进行分析和优化。

-

图论与复形几何抽象

DDC网络本质上是一个有向图 G=(V,E),其中顶点集 V代表各种计算和交换设备,边集 E代表它们之间的物理或逻辑连接。基于此基础抽象,更高级的模型得以构建:

-

对偶图视角 :在分析网络流路径时,我们常使用对偶图 。在对偶图中,原图的边(物理链路)变为顶点,原图中路径的连续性变为对偶图中的边。这种视角转换有助于优化全局路由策略,特别是在为All-to-All这种通信模式寻找最优多路径时非常有效。

-

单纯复形建模 :为了描述设备间超越成对连接的高阶相互作用 (例如,多个GPU协同执行一个计算任务),可以引入单纯复形。一个k维单纯形由k+1个顶点及其所有子集构成,这非常适合对计算任务、数据流和故障域之间的群体依赖关系进行建模。其链复形 和 同调群 可用于分析网络的连通性,同调群中的非平凡元素可能指示着网络中存在潜在的通信瓶颈或冗余路径。

-

-

网络流算法与关键指标

网络流算法旨在优化数据在DDC这个图上的传输。

-

局部性与路径多样性 :局部性旨在将通信频繁的节点(如通过NVLink直连的GPU)在拓扑上放置得更近,以减少跳数。这常通过图划分算法 (如Metis)将图划分为多个模块(类似DDC中的节点组),并最大化模块内连接,最小化模块间连接。路径多样性则通过多商品流问题 建模,目标是在满足所有流量需求的同时,最小化最大链路利用率或总延迟。DDC中采用的信元喷洒技术 ,可视为将大数据流分解为微小的、不可再分的信元,从而在对偶图 上运用最大流算法(如Dinic算法)来动态寻找可用路径,有效避免拥塞。

-

延迟建模:端到端延迟 De2e可初步估算为 De2e=Dprop+Dtrans+Dqueue,其中 Dprop是传播延迟(与物理距离和跳数正相关),Dtrans是传输延迟(与数据包大小和带宽负相关),Dqueue是排队延迟(与网络拥塞程度相关)。DDC的目标是通过拓扑和流控机制,有效降低这三项,尤其是 Dqueue。

-

业务场景的数学映射与优化

不同的集体通信模式(Collective Communication Pattern)对DDC网络提出了不同的挑战,其优化策略也深深根植于上述数学原理。

不同业务场景下的核心挑战与DDC的数学优化思路。

| 业务场景 | 核心挑战 | 图论/复形几何分析 | 网络流与局部性优化策略 |

|---|---|---|---|

| **All-Reduce (Scatter + AllGather)** | 避免全局同步点 成为瓶颈;最小化树形通信的深度。 | 建模为在生成树 (如最小生成树MST)或最优广播树上的操作。复形几何用于分析多个节点组(Simplex)在归约过程中的协同。 | 利用图划分 将节点分为多个局部组,先在组内进行局部归约 (优化局部子图),再进行全局归约。路径多样性用于构建多棵并行广播树。 |

| All-to-All | 绝对的带宽密集型,要求所有节点对之间都有高效路径。 | 对偶图视角至关重要,需要检查图的边连通度 是否足够高。可视为在超立方体 等拓扑上寻找节点不相交路径的问题。 | DDC的信元喷洒 本质上是将单流拆分为多流,在对偶图上实现等效多路径(ECMP)的极致利用,避免热点。 |

| Scatter / Gather | 根节点的出口带宽和连接数可能成为瓶颈。 | 分析图的出度 和最短路径树。目标是最小化树的高度和最大节点度。 | 采用多根节点 或构建更优的散射树(如双树散射算法),分散根节点压力。 |

- 故障容错性与快速恢复 :DDC的高可用性依赖于其快速故障检测与路径切换能力。这可以通过图论中的连通性 概念来形式化。例如,若网络拓扑是k-点连通 或k-边连通 的,则意味着至少需要k个点(或边)发生故障才会使网络不连通。基于此,可以设计算法,在检测到边 e失效后,在多项式时间 O(∣E∣+∣V∣log∣V∣)内计算出一条避开故障边的最短路径。更为先进的策略是利用预计算的不相交路径 。例如,为关键流量计算多条边不相交 或节点不相交 的路径(可用Suurballe算法 求解)。一旦主路径故障,可瞬时切换至备用路径。从复形几何的视角看,一个健壮的DDC网络 ,其对应拓扑的一阶同调群应当是平凡的(即没有"洞"),这意味着任何局部故障都能被快速绕开,数据流仍能找到通路。

性能的界限与约束因素

任何设计都有其理论极限和实际约束,DDC架构也不例外。

-

理论上界(Upper Bounds)

-

Bisection带宽 :这是衡量网络容量的关键指标,指将网络分成两个相等部分所需切割的最小链路容量之和。它决定了All-to-All通信的最大聚合带宽。

-

图的直径 :图中任意两点间最短路径的最大值。它决定了理论最小延迟的下界,因为数据包至少需要经过"直径"数量的跳数。

-

扩展性限制:随着节点数 N的增加,若要保持常数度的拓扑(如超立方体,度数为 logN),其直径也会以 logN增长。而若想保持小直径(如Dragonfly拓扑),则节点度数可能需要随 N增长,对交换机端口数提出挑战。

-

-

实际约束与下界(Lower Bounds & Practical Constraints)

-

交换机端口数 :这是最硬的物理约束,直接限制了每个交换机能够连接的设备数量,从而影响拓扑结构的选择和局部子图的规模。

-

链路带宽 :物理链路的带宽上限构成了单条路径的吞吐量上限。

-

控制平面开销 :维护全局网络状态(如SDN控制器)、执行分布式路由算法都会引入开销。当网络规模极大、流量模式极度动态时,这些开销可能成为瓶颈,使得理论上的最优流难以在现实中实现。

-

故障恢复时间下界 :故障检测(如通过BFD协议)和收敛需要时间,这决定了**服务恢复时间(RTO)** 存在一个不可逾越的下界。

-

总结

总而言之,DDC架构的性能和可靠性深植于图论、复形几何和网络流算法的数学基础之上。

1.5.2 DDC架构中,路径多样性与延迟之间的权衡

在DDC架构中,路径多样性与延迟之间的权衡是一个核心的优化问题。这种关系可以通过一个结合了网络流理论 和排队论的数学模型来定量描述。

为了直观地展示这种权衡关系以及关键参数的数学表达,请先看下表:

| 符号 | 含义 | 与DDC架构的关联 |

|---|---|---|

| K | 源节点与目标节点间并行的可用路径数量 | 代表了路径多样性。DDC中通过多轨道或端口绑定实现。 |

| λ | 数据流的总到达率(单位:数据包/秒) | 表示需要传输的总负载。 |

| λi | 第 i条路径上分配的数据流到达率 | λ=∑i=1Kλi,即总负载被分配到各路径。 |

| μi | 第 i条路径的服务率(由链路带宽、传播延迟等决定) | 表示单条路径的理论最大处理能力。 |

| ρi=μiλi | 第 i条路径的利用率 | 必须满足 ρi<1,否则队列将无限增长,延迟趋于无穷。 |

| Di | 数据包在第 i条路径上的平均端到端延迟 | 是路径多样性与延迟权衡的最终体现。 |

延迟的定量模型

基于上表参数,单条路径上的平均延迟 Di可以建模为几个关键延迟分量的和:

Di=Dprop,i+Dtrans,i+Dqueue,i其中:

-

Dprop,i是传播延迟,由物理距离和光速决定,对于一个固定的网络拓扑是常量。

-

Dtrans,i是传输延迟,与数据包大小 L和路径带宽 Bi相关(Dtrans,i=L/Bi)。

-

Dqueue,i是排队延迟,这是受路径负载影响最大的变量。在M/M/1排队模型下,其期望值为 Dqueue,i=μi(1−ρi)ρi。

因此,单路径总延迟为:

Di=Dprop,i+BiL+μi(1−ρi)ρi而整个连接的总体验延迟 Dtotal,可以近似为各路径延迟的加权平均(按负载分配比例):

Dtotal≈i=1∑K(λλi⋅Di)权衡关系的数学表达

路径多样性 K如何影响总延迟 Dtotal?关键在于负载分配。

-

低路径多样性(K小)的风险 :如果可用路径少,总流量 λ必然集中在少数路径上,导致这些路径的 λi很大,利用率 ρi很高。根据排队延迟公式,当 ρi→1时,Dqueue,i→∞,从而显著增大 Dtotal。这就是拥塞导致的延迟爆炸。

-

高路径多样性(K大)的收益与成本 :增加 K意味着可以将总流量 λ分散 到更多路径上,从而降低每条路径上的负载 λi和利用率 ρi。这能有效降低排队延迟 Dqueue,i。

然而,这并非没有代价:

-

控制开销:管理和协调 K条路径需要额外的控制信息交换。这部分开销可建模为总流量的一個函数,例如 C(K)=c⋅K⋅λ,其中 c是一个很小的系数。这会导致有效吞吐的轻微下降。

-

路径差异:不同的路径可能具有不同的固有属性(如 Dprop,i和 Bi)。如果某些路径的固有延迟很高,将流量引入这些路径反而会增加平均延迟。

-

优化模型与设计不等式

因此,DDC架构中的路径选择问题,可以转化为在给定总流量 λ和网络路径集的情况下,寻找一个最优的流量分配方案 {λ1,λ2,...,λK},以最小化总延迟 Dtotal。这通常表述为一个凸优化问题:

minimizeDtotal=i=1∑K(λλi⋅Di(λi))subject toi=1∑Kλi=λ,and0≤λi<μi∀i在实际工程中,一个关键目标是避免网络进入排队延迟主导的非线性增长区 。这引出了一个重要的设计不等式:

ρi=μiλi≤ρthreshold通常设定 ρthreshold∈[0.5,0.8]。这个不等式意味着,要控制高延迟,就需要确保有足够多的路径 K,使得每条路径上的负载 λi满足:

λi≤ρthreshold⋅μi因此,所需的最小路径数 Kmin应满足:

K≥Kmin=⌈ρthreshold⋅μavgλ⌉其中 μavg是平均路径服务率。这个公式定量地描述了为满足特定延迟目标(隐含在 ρthreshold的选择中),所需的最低路径多样性。

总结

总而言之,DDC架构中路径多样性与延迟的定量关系,可以清晰地通过基于网络流和排队论的数学模型来描述。增加路径多样性(K↑)通过分流负载来降低排队延迟,但可能引入额外的控制开销和次优路径风险。 工程上的最佳点,就是通过优化流量分配,在满足 Dtotal≤SLA(服务等级协议)约束 的前提下,找到使排队延迟和控制开销之和最小的那个 K值。

1.5.3 用凸优化方法求解最优流量分配问题

在DDC架构中,使用凸优化方法求解最优流量分配问题,核心思想是将物理网络的复杂约束和目标转化为一个可以高效求解的数学模型。其目标通常是在满足链路容量和流量守恒等硬约束的前提下,优化网络的整体性能,例如最小化最大链路利用率或总延迟。

模型基础:符号定义

首先,我们明确模型中的变量和集合:

-

图模型:将DDC网络抽象为一个有向图 G=(V,E)。其中,V是节点(NCP和NCF)的集合,E是链路(如NCP与NCF之间的SFI接口)的集合。

-

流量需求:设有一组需要传输的数据流 F。对于某条流 f∈F,sf表示其源节点,tf表示其目标节点,df表示其流量需求(速率)。

-

决策变量:xfe表示数据流 f在链路 e上分配的流量。这是我们需要优化的变量。

-

链路容量:ce表示链路 e的物理带宽容量。

凸优化问题建模

接下来,我们建立凸优化问题,其标准形式包含一个目标函数和若干约束条件。

目标函数

一个常见且实用的目标是最小化最大链路利用率。这能有效防止网络中出现局部瓶颈,实现负载均衡,与DDC通过信元喷洒实现高效负载均衡的设计目标高度一致。

MinimizeαSubject to:f∈F∑xfe≤α⋅ce,∀e∈E其中,α是一个辅助变量,代表所有链路中的最大利用率。最小化 α就是迫使流量尽可能均匀地分布在各条链路上。

约束条件

-

链路容量约束:任何链路上的总流量不得超过其物理容量。这在目标函数的约束中已体现:∑f∈Fxfe≤ce(当 α≤1时)。

-

流量守恒约束:对于每个流 f和每个网络中的中间节点 v(即既非源点 sf也非汇点 tf的节点),流入的流量必须等于流出的流量。这保证了数据不会在中间节点无故消失或产生。

e∈δ−(v)∑xfe−e∈δ+(v)∑xfe=0,∀f∈F,∀v∈V∖{sf,tf}其中,δ−(v)和 δ+(v)分别表示指向节点 v和从节点 v指出的链路集合。

-

需求满足约束:对于每个流 f,从源点 sf流出的净流量应等于其流量需求 df,而流入汇点 tf的净流量也应等于 df。

e∈δ+(sf)∑xfe−e∈δ−(sf)∑xfe=df,∀f∈Fe∈δ−(tf)∑xfe−e∈δ+(tf)∑xfe=df,∀f∈F -

非负约束:链路上的流量不能为负。

xfe≥0,∀f∈F,∀e∈E

模型与DDC架构的深度融合

上述模型是一个基础框架。要精准刻画DDC的特性,还需引入来自其核心机制的特定约束:

-

VOQ信用机制约束 :DDC采用VOQ技术,发送端NCP在转发数据前需要先接收来自接收端NCF的信用,以确保对方有足够缓存。这可以建模为对每条链路 e上瞬时流量 xfe的短期突发约束。例如,可以添加约束限制在特定时间窗口 T内,链路 e上流入的流量总和不超过接收端缓存大小 Be:

∫tt+Tf∈F∑xfe(τ)dτ≤Be,∀e∈E,∀t在离散时间的优化模型中,这可以简化为对 xfe的额外上限约束。

-

信元喷洒的负载均衡 :DDC将数据包切片为信元,并通过轮询机制喷洒到所有可用路径上。这意味着对于同一个数据流 f,其在多条等价路径 上的分配应尽可能均匀。这可以引导我们在求解上述优化问题后,制定相应的流表规则,使最终流量分布接近理论最优解 xfe∗,从而实现类似信元喷洒的效果。

求解与部署

-

问题性质 :这个优化模型(以最小化最大链路利用率为例)是一个线性规划问题,它是凸优化的一种特例,存在非常成熟的高效求解算法(如内点法)。

-

求解器:可以使用专业的数学规划求解器(如Gurobi, CPLEX)或专门的网络流算法库进行求解。

-

部署流程:

-

集中式优化:由一个中央控制器(如SDN控制器或DDC架构中的NCC)收集全局网络状态(拓扑、容量、当前流量需求)。

-

求解问题:控制器运行优化算法,计算出最优的流量分配方案 {xfe∗}。

-

下发策略:控制器将计算出的路径和带宽分配策略转化为具体的流表规则,通过南向接口(如NetConf)下发到各个NCP设备上。

-

NCP执行:NCP设备根据收到的策略,结合VOQ和信元交换机制,执行精确的流量调度与转发。

-

总结

通过上述凸优化模型,DDC架构可以从宏观上科学地指导流量分配,使其与底层VOQ、信元喷洒等转发机制紧密结合。最终在满足各种物理和协议约束的前提下,达成网络全局负载均衡、避免拥塞、提升吞吐量的目标,从而支撑AI训练等高负载业务对网络的高要求。

1.5.4 几种关键模型及其在 DDC 网络中的应用侧重点

在 DDC 这种复杂的网络架构中,传统的 M/M/1 模型确实显得过于理想化了。为了更精确地描述其延迟行为,我们需要一系列更贴近现实的排队论模型。几

| 模型类型 | 核心特征 | 为何更适合 DDC 网络 | 解决的 DDC 关键问题 |

|---|---|---|---|

| M/M/c | 多个并行的相同服务节点(服务器) | DDC 中计算、存储或转发资源常以资源池形式存在,并非单点服务。 | 精确计算当任务请求到达时,在多个可用服务单元前的排队等待时间。 |

| M/D/c | 服务时间是确定的,非随机,多个并行服务器 | 适用于处理时间近乎恒定的操作,如交换机在固定端口速率下的数据包转发。 | 更准确地刻画数据传输延迟中相对固定的部分,降低预测方差。 |

| 优先级排队 | 根据任务关键程度(如控制信令 vs 数据同步)划分服务等级 | DDC 需要区分不同 SLA 的业务流量,确保高优先级任务的低延迟。 | 实现服务差异化,保证关键任务(如资源调度信令)不被普通数据流阻塞。 |

| 级联排队网络 | 将网络视为多个串联或更复杂连接的排队节点 | DDC 中的数据包通常需要经过多个处理节点(如多个交换机或虚拟网络功能)。 | 准确分析数据包在整条路径上的端到端总延迟,而不仅仅是单点延迟。 |

M/M/c 模型:描述资源池的并行处理能力

当 DDC 架构中存在多个功能相同的服务节点(如一组执行相同任务的服务器或一个多端口交换机)时,M/M/c 模型比 M/M/1 更为精确。

-

核心思想 :该系统有

c个并行且相同的服务台。任务到达后,如果存在空闲服务台,则立即被服务;如果所有服务台都忙,则任务进入一个公共队列等待。 -

DDC 应用场景 :非常适合模拟一个多核服务器 处理到达的请求,或者一个多端口交换机处理来自多个上游设备的数据流。

-

优势 :它能更准确地反映资源池的规模效应。随着

c(服务台数量)的增加,系统的整体服务能力增强,在相同负载下,任务的平均等待时间会显著低于 M/M/1 模型预测的结果。这对于 DDC 中水平扩展的资源池的性能评估至关重要。

M/D/c 模型:刻画恒定服务时间

在许多硬件处理环节,服务时间是高度确定而非随机的。例如,网络交换机在特定端口速率下转发一个固定长度的数据帧所需时间是常量。

-

核心思想 :该模型假设服务时间是固定 的(Deterministic, 故为 D),而非指数分布。结合

c个并行服务台,它描述了处理时间可预测的场景。 -

DDC 应用场景 :精确模拟交换机端口的数据转发延迟 、某些专用硬件 (如智能网卡)的处理时间,或执行时间高度可预测的轻量级计算任务。

-

优势 :由于服务时间无波动,M/D/c 模型预测的延迟方差远小于 M/M/c 模型。这有助于更准确地评估 DDC 网络数据传输的最坏情况延迟,对于保证确定性延迟需求的业务(如实时控制)非常关键。

优先级排队模型:实现服务等级差异化

DDC 网络需要同时承载对延迟敏感程度不同的多种业务流(如虚拟机迁移大数据流与实时健康检查信令)。简单的先到先服务(FCFS)规则无法满足需求。

-

核心思想 :任务被划分为不同的优先级等级。高优先级任务到达时,可以中断正在服务的低优先级任务(强占式),或至少在其之后优先获得服务(非强占式)。

-

DDC 应用场景 :用于实现服务质量 策略。例如,确保网络控制平面的信令(高优先级)永远比数据平面的普通流量(低优先级)优先处理,从而保证网络的稳定性和响应速度。

-

优势 :该模型允许网络管理员为不同类型的流量提供差异化的延迟保证。这对于在共享的 DDC 基础设施上同时运行关键任务应用和普通业务至关重要。

级联排队网络:分析端到端路径延迟

在 DDC 中,一个任务或数据包通常需要经过一系列处理节点,例如:计算节点 -> 虚拟交换机 -> 物理交换机 -> ... -> 目标存储节点。其总延迟是路径上各节点延迟之和。

-

核心思想 :将整个数据路径建模为多个排队系统的串联或更复杂的网络连接。数据包在每个节点都会经历排队和处理延迟。

-

DDC 应用场景 :这是分析 DDC 端到端延迟 最准确的模型之一。通过将每个网络设备(交换机、路由器)和处理单元(服务器)抽象为一个排队节点,可以计算出一个数据包从源到目的地的总时间。

-

优势 :它揭示了延迟的累积效应。即使每个节点的平均延迟都很低,但多个节点的延迟叠加,或者某个节点成为瓶颈,都可能导致显著的端到端延迟。这对于性能瓶颈定位和系统容量规划极其重要。

如何选择适合的模型

选择哪种模型取决于您的具体分析目标:

-

若要分析单个资源池 (如一组服务器)的吞吐量和延迟,M/M/c 是很好的起点。

-

若关心硬件转发 等具有确定服务时间的环节,M/D/c 能提供更精确的估计。

-

若需评估不同业务流的服务质量 和延迟保障,优先级排队模型是必然选择。

-

若要进行全局性能优化 和瓶颈分析,则必须采用级联排队网络来建模完整的数据路径。

1.5.5 DDC架构中的路径多样性

在DDC架构中,路径多样性(通常由参数 K 表征,可理解为等价并行路径的数量)的取值,确实会显著影响网络的可扩展性和总体成本。这个"K"可以被理解为构建网络"骨架"时核心的并行路径数量,它决定了网络的扩展潜力和经济性。

| 特性维度 | 小K值(路径少) | 大K值(路径多) | 核心影响机制 |

|---|---|---|---|

| 可扩展性 | 较低:网络规模易受限于初始设计,扩容可能需改变基础拓扑。 | 较高:提供丰富连接,支持通过增加设备"横向"平滑扩展至超大规划(如万卡集群)。 | K值决定了网络"分支"能力。高K值架构(如多级POD)能像搭建积木一样扩展。 |

| 硬件成本 | 相对较低:所需互联端口和线缆较少,初始投入可能更低。 | 显著增高:每台NCP需上联到更多NCF,且NCF间需大量高速互联,导致端口数、线缆、功耗激增。 | 成本与K值非简单线性,可能呈指数增长。大K方案需评估"规模经济"能否摊薄单端口成本。 |

| 布线与管理复杂度 | 相对简单:物理布线和逻辑配置的复杂度可控。 | 极其复杂:设备间大量高速线缆互联,布线挑战大;集中控制面故障风险高,需分布式OS管理。 | 复杂度随K值增加而飙升,是制约K值上限的关键工程因素。 |

| 理论性能潜力 | 相对受限:易在核心路径出现瓶颈,All-to-All等通信模式效率较低。 | 极高:信元喷洒(Cell Spraying)等技术支持流量在K条路径上实现近乎理想的负载均衡,提供巨大聚合带宽。 | 高K值是实现无阻塞、高吞吐网络的基础,但需VOQ和信元交换等高级机制配合。 |

理解K值的含义

在DDC架构中,路径多样性(K)并不仅指物理链路的数量,它更核心地体现在网络逻辑层面的并行通道 上。DDC通过将传统框式交换机的交换网板和业务线卡解耦 为独立的NCF 和NCP设备,再通过高速网络互联,形成了灵活的"盒盒"组网。路径多样性(K)在此背景下,深刻影响了网络的扩展性和成本。

寻找最优K值范围

关于"理论上的最优K值范围",并不存在一个"放之四海而皆准"的精确数字 。最优K值是特定业务目标、技术可行性和经济成本之间权衡的结果。

-

业务需求是首要决定因素

-

当前与未来集群规模 :这是决定K值的首要因素。若目标仅是支撑数百卡 的AI训练集群,一个中等K值的单POD设计可能已足够高效且经济。但如果规划是数千至数万卡的超大规模集群,则必须采用高K值的设计(如多级POD互联),否则网络将成为无法扩展的瓶颈。

-

通信模式:如果业务以All-to-All(如大规模分布式训练)、All-Reduce等通信模式为主,对网络吞吐和延迟极其敏感,那么更高的K值所带来的路径多样性和负载均衡能力几乎成为必选项。

-

-

技术水平的约束

-

运维能力:K值越高,网络拓扑和流量调度越复杂,对运维团队的技能要求也呈指数级增长。选择超出团队运维能力的K值,会导致网络稳定性灾难。

-

协议与设备成熟度:高K值架构依赖于VOQ(虚拟输出队列)、信元交换、分布式控制平面等技术的成熟度。这些技术的可靠性和性能,决定了实际K值能取到的上限。

-

-

成本效益的平衡点

-

最优K值是一个动态范围 ,而非固定值。它需要根据每单位有效带宽的成本(Cost per Usable Bandwidth) 来确定。目标是找到扩展性提升带来的收益(如训练时间缩短、GPU利用率提升)与硬件及运维成本增加之间的拐点。

-

业界一些设计(如新华三的方案)通过优化,在单POD内实现了9216个400G端口的规模,这本身就是对其特定技术条件下"较优K值"的一种工程实践。

-

总结与决策建议

总的来说,路径多样性K值的选取,本质是在网络性能与扩展性 和实现成本与复杂度 之间寻求最佳平衡。

-

明确业务规模 :首先精准定义当前及未来3-5年所需支撑的最大计算集群规模 和主流通信模式。

-

设定性能目标 :明确网络需要达到的吞吐量 和延迟目标,特别是要满足GPU利用率的要求。

-

评估约束条件 :清晰评估预算上限 和团队的技术储备与运维能力。

-

参考最佳实践 :研究现有成熟方案(如厂商提供的POD设计参考)。例如,一个旨在支撑万卡级别 集群的方案,其K值(反映在NCP上联NCF的数量、POD间互联的丰富程度)通常会显著高于一个仅为千卡级别设计的方案。

1.6 万卡级别的超大规模集群的扩展性方法

对于万卡级别的超大规模集群,要实现真正的可扩展性,确实不能仅仅依赖增加路径数量(K值)。这需要一个从网络拓扑、资源组织方式,到协议与控制平面,乃至散热供电等基础设施的系统性协同设计。

| 设计方向 | 核心目标 | 代表性架构或思路 |

|---|---|---|

| 网络拓扑创新 | 降低网络直径,避免瓶颈,实现成本与规模的亚线性增长 | 阿里HPN(双层CLOS)、华为UB-Mesh(分层局部多维全互联) |

| 资源组织方式 | 将庞大集群划分为可管理、可独立扩展的故障域和资源池 | 模块化设计(POD/Block)、计算/存储/网络解耦 |

| 协议与控制平面 | 让网络从"静态管道"变为可智能调度、自愈的"动态系统" | 端网协同(如TCCL/GOR)、集中式+分布式混合控制 |

| 基础设施与平台 | 保障集群在高功率密度下的稳定运行与高效运维 | 液冷散热、智能电控、自动化运维与健康监测 |

网络拓扑的创新

传统多层CLOS拓扑在规模极大时,成本和复杂度会急剧上升。业界正探索更扁平、更智能的拓扑。

-

更扁平的层次 :阿里的HPN架构 致力于用两层网络 实现超万卡互联。通过双平面设计 (将网络逻辑划分为两个平面)和多轨道连接(使服务器内每张GPU都有专属的高速网络通道),不仅减少了交换机数量以降低成本,还显著降低了通信延迟和哈希冲突风险。

-

异构混合拓扑 :华为的UB-Mesh 构想了一种混合结构,在不同层级采用不同连接策略。其核心优势在于,规模扩展时成本呈亚线性增长,即规模扩大百倍,成本远低于百倍,为实现更大规模集群提供了经济可行的路径。

资源组织与调度优化

将集群视为一个整体"黑盒"会带来运维和效率挑战,需要通过模块化和智能调度来优化。

-

模块化与分层治理 :将整个万卡集群划分为多个POD 或Block 。每个模块包含一定数量的计算、存储和网络资源,可独立运行和故障隔离。集群规模扩展时,以模块为单位进行扩容,极大简化了管理和故障定位。同时,阿里等厂商采用计算、存储、网络解耦的设计,各资源池可独立扩展,提升了灵活性。

-

调度器感知网络拓扑 :先进的调度系统(如Kubernetes的定制调度器)能够感知底层网络拓扑。在分配任务时,会优先将通信紧密的Pod调度到网络距离最近的节点上,从而减少跨核心交换机的流量,优化通信效率。

协议与控制的智能化

网络设备的硬件能力需要智能的软件和协议来驱动。

-

端网协同技术 :这是提升大规模集群效率的关键。以阿里的TCCL/GOR组合为例:

-

TCCL:是运行在服务器上的"通信大脑",能感知整个集群的网络拓扑。在发起通信前,它会智能规划路径,优先选择同一交换机下的短路径通信,并避免流量冲突。

-

GOR :是集群的"网络总指挥",实时监控全网流量。一旦检测到拥塞,能在毫秒级内计算出新路径,并通知TCCL切换流量,实现动态负载均衡。

-

-

拥塞控制的优化 :为避免传统无损网络中PFC机制带来的"广播风暴"风险,业界趋势是采用更智能的端到端拥塞控制算法(如HPCC),在保持低延迟的同时避免网络死锁。

基础设施与运维保障

强大的算力离不开稳定、高效的基础设施支撑。

-

绿色节能技术 :万卡集群功耗巨大,液冷技术 (特别是浸没式冷却)因其散热效率远高于风冷,已成为超大规模集群的标配。它能有效控制芯片温度,保障计算稳定性,并有助于降低数据中心的PUE,实现节能目标。

-

全面的可观测性与自动化 :在万卡规模下,硬件故障是常态而非例外。构建覆盖GPU、网络、存储等各层的实时监控系统 至关重要。通过采集大量数据,系统能自动预测、诊断故障,并结合调度系统实现故障自动隔离、任务自动迁移,从而将硬件故障对训练任务的影响降至最低,保障集群有效算力。

端网协同技术(如腾讯星脉网络中的TCCL和GOR)是现代万卡级AI集群的核心技术,它通过端侧(服务器)和网侧(网络设备)的深度协作,智能地调度网络流量,从而极大提升了大规模AI训练的效率和稳定性。

| 组件 | 核心职能 | 部署位置 | 关键价值 |

|---|---|---|---|

| TCCL | 端侧执行引擎:感知拓扑,规划最优通信路径,智能分配流量。 | GPU服务器端 | 将AI训练的通信需求与物理网络拓扑精准匹配,实现静态最优路径规划。 |

| GOR | 网侧调度大脑:监控全网状态,实时感知拥塞,动态调度流量。 | 集中式控制器 | 赋予网络全局视角和实时反应能力 ,实现动态的拥塞规避与故障自愈。 |

工作机制详解

TCCL和GOR的协同工作,可以比作一个由"智能导航系统"和"全局交通管制中心"配合的高效体系。

TCCL:端侧的智能导航系统

TCCL运行在每个GPU服务器上,在通信开始前就进行精细优化。

-

拓扑感知与路径规划 :传统集合通信库对网络物理拓扑不敏感。TCCL则从GOR获取全局网络拓扑图,在规划All-Reduce等操作时,遵循轨道亲和性原则,优先让同一交换机下的GPU进行通信,最大化利用本地链路带宽,最小化需要经过核心交换机的跨子网流量。

-

异构网络协同 :服务器内部GPU间通过高速NVLink互联,而服务器之间通过RoCE网络互联。TCCL能够感知这种异构性,通过动态滑动窗口机制,根据NVLink和RoCE的带宽差异,智能地将待传输的数据切片,并同时利用这两类网络通道进行传输,从而压榨整体带宽。

-

哈希正交与冲突避免 :为避免多条大数据流被网络设备的ECMP哈希算法映射到同一条物理链路上造成拥塞,TCCL会主动为并行的数据流分配一组哈希正交源端口号。这确保这些流能被均匀地分散到所有可用的物理链路上,从源头避免哈希冲突。

GOR:网侧的全局交通管制中心

GOR作为一个集中式控制器,实时监控并调度整个网络。

-

实时监控与毫秒级感知:GOR通过Telemetry、sFlow等技术,以毫秒级精度实时采集全网每条链路的负载和ECN拥塞标记数量,从而快速发现拥塞点。

-

精准定位与智能决策 :一旦检测到拥塞,GOR会迅速定位到导致问题的Top-N"大象流"。随后,它基于实时网络拓扑和流量信息,为这些流计算新的、拥塞更少的路径。在决策前,GOR会进行"沙盘推演",模拟流量切换后的效果,并递归验证新路径不会引发二次拥塞。

-

无损调度与路径切换 :计算出新路径后,GOR通过控制通道通知源端服务器的TCCL。TCCL随即调整相应数据流的源端口号,引导流量无缝切换至新路径。整个过程对上层AI训练任务是无感且无损的,通常在一次训练迭代内完成。

性能提升数据

这套端网协同机制在实际部署中带来了显著的性能提升。

-

通信性能 :在腾讯的大模型集群中,与NVIDIA的NCCL方案相比,星脉网络实现了25%的集合通信带宽提升 ,并将由流量冲突造成的网络拥塞问题减少了80%。

-

训练效率 :对于All-Reduce这一关键通信操作,性能提升近20% 。对于更复杂的All-to-All通信,性能提升可达30%至50%。

-

故障恢复 :GOR的动态调度能将网络拥塞的持续时间缩短超过90% ,告警恢复时间可控制在3分钟以内,显著提升了训练的稳定性和GPU的有效利用率。

总而言之,TCCL和GOR代表的端网协同技术,通过将网络的全局控制智能与服务器端的本地执行能力紧密结合,实现了从"被动承载"到"主动优化"的范式转变。它通过静态预规划 和动态重路由相结合,有效解决了万卡集群规模下的哈希冲突、拓扑盲点和拥塞抖动三大核心挑战,为大规模、长周期的AI训练任务提供了高效、稳定的网络底座。

通信模式的性能界限与数学约束

| 通信模式 / 业务场景 | 核心性能上界 (理论最优) | 典型性能下界 (常见瓶颈) | 关键约束与数学原理 |

|---|---|---|---|

| All-Reduce (规约操作) | O( (α + β * M / P) * log P ) • α: 延迟,β: 带宽倒数,M: 数据量,P: 进程数。理想对数缩放。 | O( (α + β * M) * P ) • 网络直径大、路径多样性差时,退化为线性缩放,性能急剧下降。 | 网络直径 (图论)、对分带宽 。优化依赖通信调度树 (图) 的构造,避免链路冲突。 |

| All-to-All (全交换) | O( M * P / B ) • B: 对分带宽。理想时均匀占用所有链路。 | O( M * P² / B ) • 拓扑盲点、哈希冲突导致流量局部聚集,有效对分带宽骤降。 | 对分带宽 (图论)、ECMP哈希均匀性 。需强正则图等高对称性拓扑避免热点。 |

| Scatter / Gather (散射/聚集) | O( α * log P + β * M ) • 最优散射树深度为对数阶。 | O( α * P + β * M * P ) • 根节点成为单点瓶颈,序列化操作导致线性延迟。 | 节点度 、网络直径 。利用多根节点 或最优生成树 (图算法) 分散压力。 |

各类集合通信模式的性能上界,主要由网络拓扑这一"物理硬件"决定。

-

理论性能上界的基础

-

对分带宽 :这是评估All-to-All类通信的黄金指标。它指将网络节点分为两个相等部分所需切割的最小链路容量之和 。一个网络的对分带宽直接决定了其All-to-All通信的最大聚合吞吐量。

-

网络直径 :指网络中任意两点间最短路径的最大值 。它决定了单次点对点通信的理论最小延迟,是影响Scatter/Gather和All-Reduce等操作延迟下界的关键。

-

-

性能下界的成因:从理论到现实的差距

现实中的性能往往远离理论上界,核心原因在于流量竞争。例如,在非理想拓扑中,All-to-All通信可能因流量局部聚集导致有效对分带宽远低于理论值。同样,若All-Reduce的通信树构建不当(如深度过大或分支不均),其实际耗时将远高于O(log P)。

网络流优化:从静态规划到动态重路由

为逼近理论上界,需要一系列复杂的优化算法,其核心思想是感知状态,动态调整。

-

静态预规划与凸优化应用

在任务执行前,系统会进行静态规划。例如,TCCL 会从全局控制器GOR 获取全网拓扑信息,为All-Reduce任务构建一个拓扑感知的最优通信树 。这个过程可建模为一个凸优化问题(如最小化最大链路利用率)。

-

目标函数 :例如,

Minimize α(最大链路利用率)。 -

约束条件:包括流量守恒、链路容量限制等。通过求解该问题,可获得初始的最优流量分配方案 xfe∗。

-

-

动态重路由与协同控制

静态规划无法应对实时变化。因此,需要GOR这类控制器进行动态重路由。其核心机制可概括为:

-

感知:通过Telemetry、sFlow等技术,以毫秒级精度实时监控网络状态(如链路利用率、ECN标记)。

-

决策:一旦检测到拥塞,GOR会利用内置的ECMP哈希算法模拟器进行"沙盘推演",递归验证新路径不会引发二次拥塞后,计算出最优的重路由路径。

-

执行:通过控制通道通知源端(如服务器的TCCL)修改流的源端口号,无感地将流量切换至新路径。

这种机制将端到端的通信延迟降低了17.6%,并将平均排队分组数目减少了38.3%。

-

容错与快速恢复的数学本质

在万卡规模下,故障是常态。容错机制的核心数学本质是保持网络连通性。

-

故障检测、隔离与图论

故障检测可建模为网络连通性 的实时判断问题。系统持续监控,一旦发现节点或链路失效,即将其标记为"故障",并在网络拓扑图 G中将其暂时移除。关键在于,剩余图的连通性 必须依然能满足业务需求,这依赖于初始拓扑设计时的高冗余度(如k-点/边连通)。

-

任务迁移与同调群

当故障导致一个计算节点失效,其上的任务需要迁移。从拓扑视角看,这相当于在单纯复形中移除一个单形(节点、边或面)。同调群 工具可以精确判断这一操作是否在网络中创造了"空洞"(即非平凡的拓扑障碍)。一个健壮的网络设计,应能保证在单个或少量组件故障后,其一阶同调群仍保持平凡,意味着数据流总能找到替代路径,从而保障任务的快速迁移和恢复。

统一的数学理论框架展望

-

(协同)对偶图视角

这是分析网络流问题的强大工具。在对偶图 中,原网络的边变为顶点,边的相邻关系变为新边。网络流问题在此视角下常可转化为更易解决的最短路径问题。例如,DDC架构中的信元喷洒机制,可理解为在对偶图上执行流分配。

-

同调群与连通性损伤分析

同调论 是代数拓扑中研究"空洞"的强大工具。在网络中,可用来量化故障模式对网络连通性的损伤程度。

-

0维同调群 :其维度(Betti数 β₀ )等于网络的连通分量个数。β₀ 增大意味着网络发生分裂。

-

1维同调群 :其维度(Betti数 β₁ )反映了网络中存在的"不可收缩的环"的数量,可用于量化冗余路径的丰富性。

通过计算故障前后网络拓扑的同调群,可以精确定位网络的脆弱环节,并从拓扑层面进行加固。

-

-

概率图模型与不确定性推理

万卡集群的运行充满不确定性(负载波动、瞬时故障)。概率图模型 (如贝叶斯网络、马尔可夫随机场)非常适合对该系统进行建模。节点和链路状态可视为随机变量,其依赖关系用边表示。基于此模型,可以推理在部分观测信息下,网络全局状态的可能性,从而实现故障预测 和主动规避 。华为的数字化风洞 正是此类建模仿真思想的工程化体现,能够在部署前预演各种故障和负载场景,找到系统最优配置。

万卡/十万卡集群的通信优化,是一个在多层约束 下寻求全局最优的复杂系统工程。

-

性能目标 受限于由图论定义的网络拓扑基本属性(直径、对分带宽)。

-

优化方法 涵盖了从凸优化 (静态规划)到强化学习(动态决策)的算法谱系。

-

容错设计 则深深植根于代数拓扑 (同调论)和概率图模型,以确保系统的韧性。

在万卡乃至十万卡级别的超大规模AI集群中,确保训练任务的高效与稳定运行,确实需要一整套环环相扣的精密设计。这其中涉及了从底层网络拓扑、动态路由算法,到高层容错机制的复杂协同。

| 核心挑战领域 | 关键问题描述 | 核心解决方案与技术 |

|---|---|---|

| 拓扑设计与流量优化 | 如何降低延迟、避免瓶颈,并应对ECMP哈希冲突导致的流量不均? | 分层CLOS拓扑、双平面设计、多轨连接、定制拥塞控制算法 |

| 动态路由与重路由 | 如何实时感知网络状态,动态规避拥塞,实现流量全局最优? | 集中式控制器(如GOR)动态路径计算、端网协同(如TCCL感知拓扑)、基于实时遥测(Telemetry)的快速重路由 |

| 故障诊断与自愈 | 在万卡规模下,软硬件故障常态化的背景下,如何实现分钟级甚至秒级的故障发现、定位、隔离与恢复? | 多层次监控与心跳机制、轻量级诊断测试、基于图论的故障域隔离、两阶段检查点技术 |

拓扑设计与流量优化

网络拓扑是集群的"骨架",其设计直接决定了理论上的性能上限和可扩展性。

-

分层CLOS拓扑 :诸如字节MegaScale等系统普遍采用类似CLOS的多层(如Spine-Leaf)交换架构 。这种架构的核心优势在于无阻塞转发 和多路径。任意两个节点之间存在多条等价路径,为实现负载均衡和冗余容错打下了坚实基础。

-

应对哈希冲突 :传统的ECMP(等价多路径路由)在遇到大量并行的、特征相似的流量时(如All-Reduce通信),容易发生哈希冲突,导致链路负载不均。解决方案包括:

-

精细化的拓扑设计 :如阿里HPN架构采用双平面设计,将一个大Pod划分为两个逻辑平面,从物理上隔离流量,极大降低了流量在核心层冲突的概率。

-

硬件层级优化:将一个大端口(如400G)拆分为多个小端口(如2个200G),以增加路径多样性。

-

-

智能拥塞控制:为避免全网拥塞,系统会采用结合了Swift和DCQCN原理的定制拥塞控制算法。这些算法能够更精确地测量网络状态并快速响应,从而显著提升吞吐量。

动态规划与重路由机制

静态规划再好,也无法应对动态变化。因此,需要一套"智能"的系统实时调度流量。

-

集中式控制与端网协同 :理想的模式是"集中决策,分布式执行"。一个集中式控制器 (概念上类似华为的GOR)实时收集全网链路状态。部署在服务器端的智能通信库 (概念上类似TCCL)会从控制器获取全局拓扑视图,从而在发起通信时,能够依据实时网络状态进行静态预规划,例如优先选择同一交换机下的路径,减少跨核心交换机的跳跃。

-

动态重路由 :当控制器通过Telemetry等技术检测到拥塞或故障时,会立即计算新的最优路径,并通知相关端点调整流量路径(例如通过更新源端口号来改变ECMP哈希结果)。这种 **"感知-决策-执行"** 的闭环,实现了网络流量的动态优化和故障的快速规避。

稳定性保障与故障自愈

在万卡规模下,"故障是常态,而非异常"。系统的韧性至关重要。

-

快速故障检测与诊断:

-

全栈监控:建立毫秒级精度的监控系统,从网卡端口、交换机队列到GPU进程的心跳,实现全方位覆盖。

-

精准诊断 :一旦检测到异常(如心跳超时),系统会触发一系列轻量级诊断测试(如主机内网络环回测试、节点间NCCL All-Reduce测试),快速定位是网卡、线缆还是GPU的问题。

-

-

故障隔离与任务迁移:

-

基于图论的隔离 :系统将集群资源抽象为图模型。当某个节点(Vertex)或链路(Edge)故障时,管理系统能快速识别其影响的子图(如一个机架内的所有GPU),并通过图操作 将其从资源池中"剔除"。阿里HPN架构中,通过单个GPU的网卡(NIC)双端口连接到不同的ToR交换机,提供了物理层面的冗余路径,本身就是一种基于局部连通图的高明设计。

-

快速检查点与恢复 :采用两阶段检查点技术。训练状态先被快速写入本地NVMe存储,再由后台进程异步上传至分布式文件系统。恢复时,通过优化策略(如让同一数据并行组内的一个进程读取检查点并广播),避免所有进程同时访问存储瓶颈,从而将万卡集群的恢复时间从数小时缩短至分钟级。

-

在万卡乃至十万卡级别的超大规模AI集群中,为了实现极高的效率与稳定性,需要一套深度融合了排队理论、网络拓扑、数学优化和代数拓扑的精密系统。下面这个表格梳理了其核心机制与理论体系,希望能帮助您快速建立整体认知。

| 核心维度 | 关键挑战 | 核心技术方法 | 理论基础与目标 |

|---|---|---|---|

| 业务流服务质量与调度 | 多租户、多类型任务(训练/推理)对资源的需求和优先级不同,需避免低优先级任务阻塞关键任务。 | 优先级排队模型 (如Slurm的多因子优先级计算)、抢占式调度 、Gang Scheduling(All-or-Nothing)。 | 基于排队论 ,目标是最小化关键任务排队等待时间,保障SLA,最大化集群有效产出。 |

| 网络路径与性能 | 单一路径易成瓶颈,网络延迟会随路径跳数和拥塞而累积叠加,影响All-Reduce等集合操作效率。 | 路径多样性 (ECMP, 多轨道设计)、拓扑优化 (Clos/Fat-Tree)、端网协同(如TCCL/GOR)。 | 图论 、网络流理论。目标是提供高对分带宽、低直径网络,实现负载均衡,避免局部瓶颈。 |

| 流量分配与优化 | "信元喷洒"等负载均衡机制在路径不对称或拥塞时可能失效,导致哈希冲突和尾延迟。 | 凸优化 进行离线流量规划,数值分析进行在线实时路由调整。 | 将流量分配建模为凸优化问题,在链路容量等约束下最小化最大链路利用率或总延迟。 |

| 网络健壮性分析 | 组件故障(链路、节点、交换机)常态发生,需量化其对网络连通性的损伤并快速恢复。 | 同调群 分析连通性损伤,故障域 隔离,快速重路由。 | 代数拓扑 。通过计算故障前后拓扑的Betti数变化,量化网络"空洞"的生成,评估容错能力。 |

| 集合通信性能界限 | 不同通信模式(All-Reduce, All-to-All)在给定网络拓扑下存在理论上的性能上限和下限。 | 性能建模,理论证明(基于直径 、对分带宽等图论不变量)。 | 建立理论证明体系,明确性能与拓扑的关系,为架构设计和优化提供理论依据和评估基准。 |

优先级排队与服务质量保障

在万卡集群中,任务队列管理是保证资源分配公平性和效率的核心。其目标是在多租户环境下,确保高优先级的紧急任务(如在线推理服务)能够优先获得资源,同时避免大型训练任务因长时间排队而"饿死"。

-

多因子优先级模型 :如Slurm调度器采用复杂的公式动态计算任务优先级,综合考虑作业等待时间 、用户或项目的资源配额使用情况 、作业规模 以及指定的服务质量等级等多个因素。这使得调度决策不再是简单的先到先得,而是更智能地满足多样化的业务目标。

-

Gang Scheduling与抢占机制 :对于大规模分布式训练任务,需要同时启动数百个GPU副本。Gang Scheduling 策略确保所有资源都到位后才启动任务,防止部分任务启动造成的资源死锁和浪费。同时,结合抢占机制,高优先级任务可以抢占低优先级任务占用的资源,并由平台负责为被抢占的任务创建检查点,以便后续无缝恢复,从而显著提升关键任务的交付速度。

路径多样性与延迟优化

网络是超大规模集群的神经系统,其设计的核心是为海量的东西向流量提供充足、高速且可靠的连接。

-

非阻塞拓扑与多路径 :现代万卡集群普遍采用 Clos或Fat-Tree 等非阻塞网络拓扑 ,从而在任意两个节点间提供大量等价多路径 。结合端网协同技术,智能网卡和通信库可以感知网络实时状态,动态选择最优路径,有效规避拥塞点。

-

延迟累积与控制 :一次分布式训练迭代的延迟取决于最慢的GPU。因此,不仅要降低单跳延迟,更要通过拓扑感知调度 (将通信频繁的Pod调度到同一机架或交换机下)来减少通信跳数,从而控制路径延迟的叠加效应。研究表明,优化的调度策略可带来超过20%的性能收益。

流量分配与数学优化

"信元喷洒"等动态负载均衡技术虽然能有效利用多路径,但在网络状态不均时可能导致流量不均衡。这就需要更精细的数学工具进行指导和优化。

-

凸优化模型 :流量分配问题可被建模为一个凸优化问题,例如以最小化最大链路利用率为目标,以流量守恒和链路容量为约束条件。求解该模型可获得全局最优的流量分配策略,从理论上避免局部瓶颈。

-

数值分析与在线调整 :凸优化通常用于离线规划。在线运行时,则需采用基于实时网络遥测的数值分析方法,持续监测链路利用率、丢包率、延迟等指标,并运用控制算法动态调整流表,实现自适应的流量工程。

同调群与网络健壮性

在万卡规模下,硬件故障是常态。代数拓扑中的工具为量化评估和增强网络的容错能力提供了强大视角。

-

同调群分析 :可以将网络抽象为一个单纯复形 。同调群 ,特别是一维同调群 ,能揭示网络中的"环状"结构。其Betti数直观反映了网络中存在多少独立的、未被填充的"环"。当链路或节点发生故障时,可以通过计算同调群的变化来量化网络连通性的损伤程度。一个健壮的网络设计,应能保证在发生一定数量的故障后,其同调群结构保持稳定,即网络仍能保持良好连通。

-

故障模拟与韧性评估 :通过模拟不同类型的故障模式(如单链路中断、整机柜故障),并观察同调群的变化,可以识别出网络中的关键脆弱点,从而有针对性地加强这些区域的冗余性。

集合通信的性能界限

各类集合通信操作的性能并非无限,其在特定集群架构下存在理论上的上限和下限。

-

性能上界 :通常由网络的对分带宽 和直径 等拓扑属性决定。例如,All-Reduce 操作的理论最优时间受限于数据量大小、网络延迟以及对分带宽。

-

性能下界与证明体系 :通过图论 和复杂性理论 可以建立不同通信模式在特定网络模型下的性能下界。这构成了一个理论证明体系,用于判断某个调度算法或通信库的实现是否已经接近理论最优,从而指导优化方向。

万卡/十万卡集群的高效稳定运行,是排队论、图论、凸优化和代数拓扑等多个数学工具在工程上深度融合的结果。优先级排队模型 和调度策略 保障了任务级别的服务质量;路径多样性 和流量优化 确保了网络数据通路的高效与可靠;而同调群等高级数学工具则从拓扑层面深刻揭示了系统的内在健壮性,并为容灾设计提供了理论依据。

优先级排队模型中的多因子权重动态调整,确实是一个直接影响系统效率和公平性的核心问题。

多因子权重动态调整的核心数学模型

动态权重的核心思想是:权重不应是固定值,而应成为连接系统状态与调度目标的"调节器"。一个经典且实用的动态权重模型可以表示为如下公式,它综合考虑了业务属性、实时状态和系统负载:

综合优先级分数 P = α(Load) × F₁ + β(Load) × F₂ + γ(Load) × F₃ + ...

其中,F₁, F₂, F₃ 代表不同的业务维度因子(如任务紧迫度、用户等级、资源需求等),而 α, β, γ 就是与系统实时负载 Load相关的动态权重。

-

任务紧迫度因子 (F₁) :通常与任务的截止期限 负相关。例如,

F₁ = 1 / (1 + max(0, 剩余时间 - 当前时间))。距离截止时间越近,该因子值越大,任务越紧迫。 -

用户/业务等级因子 (F₂):这是一个由业务策略决定的静态值。例如,VIP用户发起的任务或核心业务对应的任务,该因子值更高。

-

资源需求因子 (F₃) :通常与任务所需的资源量(如CPU、内存、GPU)正相关。关键在于,系统可以根据总体负载情况,动态改变这些因子的权重。

-

当系统负载较高时(如 >80%) :应提升资源利用率因子的权重,鼓励系统接纳那些计算量大但能显著提升整体资源利用率的任务,避免资源闲置。同时,可适当降低对绝对延迟敏感的任务的权重,因为高负载下延迟难免会增加。

-

当系统负载较低时(如 <30%) :应提升响应速度/任务紧迫度的权重。此时资源充裕,调度目标可以转向尽可能快地完成任务,优化用户体验。

-

下面这个表格展示了不同业务场景下的动态调整策略。

| 业务场景 | 核心目标 | 权重调整策略(示例) | 预期效果 |

|---|---|---|---|

| **电商峰值(如双11)** | 保证交易链路稳定,最大化吞吐量 | 提升"业务关键性"和"系统吞吐量"权重,降低"资源消耗"权重。即使资源需求大,但支付、订单等核心任务也必须优先。 | 核心业务不中断,系统整体吞吐量最大。 |

| AI训练集群 | 提高GPU利用率,保证大型作业完成时间 | 动态平衡"任务剩余耗时"和"资源利用率"。负载高时,优先运行能快速释放大量GPU的计算任务;负载低时,则优先运行大规模训练任务以避免资源碎片化 。 | 提高GPU平均利用率,保障关键实验进度。 |

| **实时数据处理(如风控)** | 稳定且极低的处理延迟 | 显著提升"任务延迟"权重 ,并采用强占式调度。一旦有新的风控分析任务到达,可中断低优先级的批处理任务 。 | 满足风控等实时业务的低延迟要求。 |

| 在离线混合部署 | 离线任务充分利用资源,但不影响在线服务 | 根据日峰谷动态调节。日间在线服务流量大,提升在线任务权重;夜间流量低,则提升离线计算任务的权重,充分利用资源 。 | 实现资源分时复用,大幅降低成本。 |

动态调优实战案例

1. 基于负载预测的GPU资源调度

某AI计算平台为了应对工作日白天研究模型调试(短任务、高优先级)和夜间大规模模型训练(长任务、资源消耗大)的混合负载,设计了如下动态权重策略:

-

日间高负载期:权重偏向"任务延迟"和"用户等级"。教授或高工的交互式调试任务能获得快速响应,保证研究效率。

-

夜间低负载期:权重偏向"资源利用率"和"任务规模"。调度器会优先启动需要占用大量GPU的大型训练作业,从而提升整个集群的夜间资源利用率。

其权重更新算法可简化为:

如果 平均负载 > 预设阈值:

α = α * 1.1 # 提升资源利用率权重

β = β * 0.9 # 适当降低其他权重

否则:

α = α * 0.9

β = β * 1.1*(α, β 代表不同因子的权重)*通过这种方式,该平台在夜间低负载时段的有效计算利用率提升了近20%.

同调群分析为量化网络连通性损伤提供了强大的数学工具。它通过计算网络拓扑中的"空洞"数量(Betti数)来精确反映故障导致的连通性变化。下面我结合一个数学示例来说明其计算过程。

理解同调群与连通性的关联

首先,我们需要理解不同维数的同调群所揭示的网络结构信息:

-

0维同调群 :其维度(0维Betti数 β₀ )直接等于网络的连通分量个数。β₀ 增大,意味着网络发生了分裂。

-

1维同调群 :其维度(1维Betti数 β₁ )反映了网络中存在的"不可收缩的环"的数量。β₁ 可以直观地理解为冗余路径的丰富性。一个环意味着存在一条替代路径,即使某条边失效,信息仍可流通。

因此,通过计算故障前后网络拓扑的 Betti 数变化,可以精确定量连通性的损伤程度。

数学计算示例:一个简单网络的故障分析

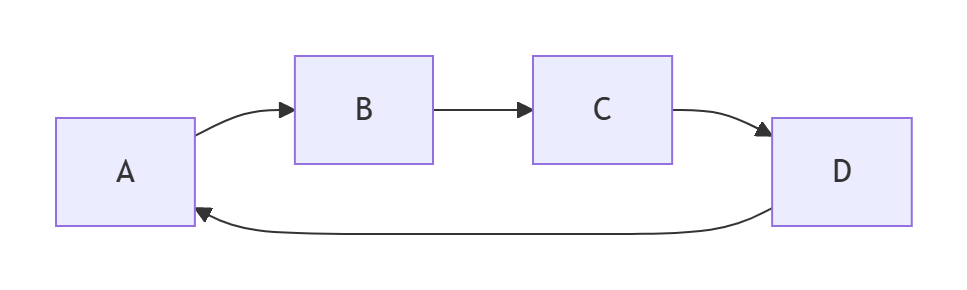

考虑一个简单的环形网络拓扑(如下图所示),它包含4个节点(A, B, C, D)和4条边,构成一个闭环。

-

故障前:构建单纯复形与计算同调群

-

拓扑结构:这个网络有 4 个节点 (0-单形) 和 4 条边 (1-单形)。它本身形成一个最大的 1-单形(一个环)。

-

计算 Betti 数:

-

β₀ : 所有节点通过环路连接在一起,因此只有一个连通分量。β₀ = 1。

-

β₁ : 网络中恰好有 1个 独立的环。β₁ = 1。

-

-

拓扑解释:该网络连通性很好,并且具有一条冗余路径(环路本身)。

-

-

故障模式1:节点故障导致网络分裂

假设节点 C 发生故障并被移除。由于边 B-C 和 C-D 都依赖于节点 C,它们也随之失效。

-

故障后拓扑:网络分裂为两个部分:一个是由节点 A, B 和边 A-B 构成的片段;另一个是孤立的节点 D。

-

计算 Betti 数:

-

β₀ : 现在网络中有 2个 连通分量(A-B 片段和节点 D)。β₀ = 2。

-

β₁ : 两个片段中均不存在任何环。β₁ = 0。

-

-

连通性损伤量化:

-

Δβ₀ = 2 - 1 = 1 (连通分量数量增加了1,表明网络发生分裂)。

-

Δβ₁ = 0 - 1 = -1 (网络的冗余环路全部丢失)。

-

-

结论 :节点故障导致网络连通性严重受损,表现为连通性分裂 (β₀↑ ) 和冗余性丧失 (β₁↓)。

-

-

故障模式2:边故障削弱冗余性

假设边 A-B 发生故障中断,但所有节点均正常。

-

故障后拓扑:网络不再是一个完整的环,但所有节点仍然通过路径 B-C-D-A 保持连接。网络结构变为一条"线"形总线拓扑。

-

计算 Betti 数:

-

β₀ : 所有节点仍然连通。β₀ = 1。

-

β₁ : 唯一的环因为边 A-B 的断开而被破坏。β₁ = 0。

-

-

连通性损伤量化:

-

Δβ₀ = 1 - 1 = 0 (全局连通性未受影响,所有节点仍可通信)。

-

Δβ₁ = 0 - 1 = -1 (冗余路径被破坏)。

-

-

结论 :边故障虽然未直接分裂网络,但使其变得脆弱。β₁ 降至 0 意味着网络从有环网络变为无环网络,任何进一步的边故障都可能导致通信中断。

-

通过上面的例子可以看到,同调群分析能够:

-

精确定位损伤类型 :通过观察 β₀ 和 β₁ 的变化,可以清晰区分是网络发生了分裂 (β₀增加),还是仅仅是冗余度下降(β₁减少)但整体连通性尚存。

-

量化损伤程度 :Betti 数的变化量 Δβ₀ 和 Δβ₁ 提供了连通性损伤的明确数值指标,优于"连通/不连通"的简单定性描述。

这种方法特别适用于分析万卡/十万卡级大规模计算集群或关键基础设施网络。通过将网络抽象为单纯复形并计算其同调群,运维人员可以快速评估不同故障场景下网络结构的鲁棒性,识别出那些对全局连通性影响最大的关键节点或链路(即其失效会导致 β₀ 显著增加或 β₁ 显著减少的元件),从而进行有针对性的加固。

核心通信模式的拓扑依赖与性能界限

不同通信模式对网络拓扑有着不同的依赖关系和性能极限。

-

Scatter(广播)与 All-gather(全收集)

-

拓扑依赖与理想结构 :这两种操作通常依赖于树形拓扑 (如二叉树或胖树)来高效实现。树的高度 直接决定了操作的延迟复杂度 ,理论上最优可达到 O(log P),其中 P 是进程数。而树的扇出 则影响着带宽利用率。

-

性能界限:

-

上界 :在完全二叉树 或超立方体 等理想拓扑中,可以实现 O(log P) 的延迟。

-

下界 :即便在最优拓扑下,Scatter 操作的延迟也受限于树的深度,其通信量复杂度为 O(M * P),其中 M 是消息大小。瓶颈通常出现在根节点,其上行带宽可能成为制约整体速度的关键。

-

-

-

All-to-All(全交换)

-

拓扑依赖与理想结构 :这种模式极度考验网络的对分带宽 。全连接拓扑 虽然理想但成本高昂。在实际中,Clos 网络 或超立方体 等拓扑通过提供丰富的等价多路径来逼近其性能。

-

性能界限:

-

上界:在具有高对分带宽的网络中,理想吞吐量可达 O(P * M / B),其中 B 是对分带宽。

-

下界 :如果网络对分带宽不足,或存在哈希冲突 导致流量分布不均,实际吞吐量可能退化至 O(P² * M / B)。All-to-All 是对网络对称性和负载均衡能力最严峻的考验。

-

-

-

All-reduce(全局归约)

-

拓扑依赖与理想结构 :这是最复杂的操作之一,通常分阶段进行。其性能依赖于底层拓扑的直径 和链路带宽 。双环 、超立方体 或 Clos 网络 都是常见的选择。

-

性能界限:

-

上界:在超立方体等低直径拓扑中,优化良好的算法(如 Ring-Allreduce、Recursive-Doubling)可达到 O(log P) 的延迟和 O(M) 的通信量。

-

下界 :其性能下界受限于网络直径 和最慢链路的带宽。任何拓扑上的瓶颈都可能导致操作时间远高于理论最优。

-

-

容错性与网络连通性的数学表达

在万卡集群中,故障是常态,因此系统的容错能力至关重要。

-

部分连通性与高连通子图 :当网络出现故障,导致原本的全连通图被分割,就出现了部分连通性 。此时,网络可能被分割为多个连通分支 (子图)。系统的韧性取决于剩余的最大连通子图是否仍能支撑关键任务。k-点连通 或 k-边连通 的拓扑设计(即移除至少 k 个点或边后网络仍连通)能保证在有限故障下的服务连续性。

-

快速故障检测与路径切换 :这依赖于高效的路由协议 和控制平面 。数学上,这可以建模为在对偶图 上寻找替代路径的问题。当原路径 (u, v) 失效,控制平面需要在剩余图 G' = (V, E \ {e_fault}) 中快速计算一条新路径,其时间复杂度应尽可能低(如使用 Dijkstra 算法为 O(|E| + |V| log |V|)),以实现毫秒级收敛。

-

故障"轨道"流检测与容错 :您提到的"故障轨道流"可以理解为故障域 的概念。通过图论中的图划分 算法,将节点预先划分为多个局部子图(如机架、可用区)。当监控系统检测到某个子图内故障集中时,可以触发特定策略(如隔离整个故障机架),这类似于在单纯复形中移出一个高阶单形,从而控制影响范围。

对偶性视角与数学构造方法

从对偶性视角和抽象数学工具出发,可以为网络设计提供深层指导。

-

对偶性 :在图论中,一个平面图 G 有其对应的对偶图 G 。G 中的面对应 G 的点,G 中的边对应 G* 的边。在网络流中,最大流最小割定理 就是一个经典的对偶关系,它揭示了网络的最大传输能力与其最脆弱的瓶颈是等价的。

-

数学构造方法:

-

Cayley 图:利用群论构造的对称图(如超立方体是 Cayley 图的一种),具有顶点传递、直径小、正则性好等优异性质,非常适合作为互连网络拓扑的理论模型。

-

强正则图 :具有极强的对称性,参数为 (n, k, λ, μ)。这类图在有限节点数下能实现最大的均匀连通性,是构建高连通子图的理想研究对象。

-

单纯复形 :比图更具一般性,可以描述节点间的高阶相互作用(如三个节点构成的"三角形"关系)。持续同调 等工具可以度量网络拓扑的"空洞"结构,帮助识别在多次链路/节点故障后网络的整体连通性损伤。

-

缺陷、限制与性能上下界

没有任何一种设计是完美的,明确其边界至关重要。

| 通信模式 / 拓扑 | 关键优势 (上界可达性) | 固有缺陷与限制因素 (下界约束) |

|---|---|---|

| Scatter / 树形拓扑 | 延迟低,逻辑简单。 | 单点瓶颈/故障 :根节点是致命弱点。带宽受限:非叶子节点带宽压力大。 |

| All-to-All / Clos网络 | 高对分带宽,多路径。 | 成本 :需要大量交换设备。流量均衡:严重依赖ECMP等负载均衡算法,哈希冲突会导致性能下降。 |

| All-reduce / 超立方体 | 理论直径最小,对数级延迟。 | 扩展性 :节点数必须是2的幂次,扩展不灵活。路由复杂度:节点度随规模对数增长,硬件成本高。 |

-

有条件上界 :这通常指在理想条件下(如无故障、流量完美均衡、无同步开销)才能达到的理论最优值。例如,All-to-All 的理论上界假设流量能均匀分布在所有链路上。

-

下界 :这是由物理定律或数学原理决定的绝对极限。例如:

-

传播延迟下界:由光速和传输距离决定,无法逾越。

-

网络直径下界 :对于给定的节点数 P 和交换机端口数 d,其Moore 界 给出了网络直径的理论最小值,这限制了延迟的进一步降低。

-

系统视角

总而言之,设计超大规模智算网络是一门在性能、成本、可靠性和可扩展性 之间寻求平衡的艺术。不存在"唯一最优解",而应根据主导的工作负载特征 (是All-Reduce多还是All-to-All多)和可靠性要求来选择或组合不同的拓扑与容错策略。

未来的方向是构建自适应网络 ,能够根据实时运行的应用模式动态调整逻辑拓扑和路由策略,并利用代数拓扑等高级数学工具进行更深刻的脆弱性评估和韧性设计。

flowchart TD

A[数据采集层] --> B[分析引擎层]

B --> C[策略生成层]

C --> D[控制执行层]

D --> A

subgraph A [数据采集层]

A1[网卡/交换机] --> A2[PMU/监控代理]

end

subgraph B [分析引擎层]

B1[同调群分析<br>识别拓扑"空洞"]

B2[群论分析<br>识别对称性与结构]

B3[拓扑数据分析<br>量化全局特征]

end

subgraph C [策略生成层]

C1[路径优化]

C2[负载均衡]

C3[故障自愈]

end

subgraph D [控制执行层]

D1[集中式控制器<br>(如SDN控制器)]

end反射与演化机制如何运作

这个闭环系统的"大脑"是分析引擎层,它通过一系列数学工具将采集到的原始数据转化为对网络深层结构的洞察。

-

同调群分析:识别网络的"骨架"与"空洞"

同调群是一种来自代数拓扑的工具,它能识别网络拓扑中的高维连通性 。在智算中心网络中,可以将其抽象为一个单纯复形。同调群分析的核心是计算贝蒂数 ,例如Betti 1数可以量化网络中存在的、不被边界包围的"环"的数量。这些"环"代表着冗余路径。Betti 1数的增加可能意味着网络出现了需要绕行的故障点,而它的减少则可能提示部分冗余路径已失效,网络脆弱性增加。控制器可以据此优先保障关键环路的畅通,或在故障发生时快速评估连通性损伤程度 。

-

群论分析:洞察网络的对称性与结构

群论是研究对称性的数学。许多高性能网络拓扑(如Dragonfly、Torus)本身具有特定的群结构(如循环群、对称群)。通过群论分析,可以理解网络固有的对称性,从而优化通信模式。例如,在Dragonfly拓扑中,利用其群结构特性,可以实现高效的自适应路由。当控制器感知到流量不均时,可以依据群的对称性,将负载均匀地分散到对称的路径上,避免局部拥塞,实现近乎最优的流量调度 。

-

拓扑数据分析:从"形状"把握全局

拓扑数据分析是近年来兴起的强大工具,它通过持续同调 等技术,在不同尺度下分析数据(此处指网络状态数据)的拓扑特征。它能生成一种称为持久图的可视化结果,图中那些远离对角线、长期存在的点,对应着网络中最稳固的拓扑特征(如核心骨干连接)。反之,短暂出现的点则可能是瞬时拥塞或噪声。这帮助控制器区分随机抖动和结构性瓶颈,从而做出更智能的决策 。

采用何种采集协议满足要求

要将分析引擎的洞察转化为行动,需要依赖采集协议将分析结果高效、可靠地传递给控制器。

-

推送模式 vs. 拉取模式

-

推送模式 :网元(交换机、网卡)在事件发生时或定时主动将数据发送给采集器。这种模式延迟极低 ,适用于紧急事件(如链路故障、缓存溢出),代表协议有 gNMI/gNOI(gRPC Network Management Interface) 和 sFlow。

-

拉取模式 :控制器向网元轮询请求数据。这种模式更易于管理 ,适合采集不常变化的配置或性能基线数据,代表协议有 SNMP(简单网络管理协议)。

-

-

关键协议选型

对于万卡集群,低延迟、高效率、大数据量 支持是必须的。

-

gNMI (gRPC Network Management Interface) :这是现代数据中心网络的首选 。它基于高性能的gRPC框架,支持双向流式传输,既能实现配置的下发,也能让网元将连续的实时遥测数据流推送给控制器。其编码采用高效的Protocol Buffers,大幅减少了开销 。

-

sFlow :这是一种高效的流量抽样协议。交换机/路由器仅复制数据包的一小部分(如512个字节)加上接口计数器,发送给分析器。虽然不提供每个流的完整视图,但能以极低开销快速勾勒出全网流量分布和瓶颈,非常适合宏观负载均衡和异常流量检测 。

-

IPFIX (Internet Protocol Flow Information Export) :与sFlow抽样不同,IPFIX通常提供基于流的详细记录。它更适合用于精准的计费、安全分析和复杂的流量工程。

-

结果如何传递并作用于控制器

分析结果需要以结构化的方式传递给控制器,才能最终形成控制策略。

-

结构化数据模型

采集到的原始数据和分析生成的高级洞察(如Betti数变化、路径对称性索引),会通过 YANG 等数据建模语言定义的结构,封装在gNMI或IPFIX的消息中。这使得控制器能够"理解"数据的含义,从而进行可编程的处理 。

-

控制器的决策与执行

控制器在接收到这些富含语义的数据后,便可执行智能决策:

-

动态重路由 :当同调群分析检测到某条路径的"环"结构变得不稳定(预示潜在故障)时,控制器可通过 gNMI 或 P4 等接口,即时下发流表修改指令,将流量切换至更稳定的冗余路径。

-

负载均衡优化 :结合sFlow的宏观流量数据和群论分析出的对称路径,控制器可以动态调整 ECMP 的权重,或将大象流调度到空闲链路,实现全局负载优化。

-

主动故障预测与自愈:TDA可能识别出某种流量模式正在形成未来的拥塞"空洞"。控制器可据此提前进行流量整形或扩容,实现主动式运维。

-

同调群分析在 Dragonfly 等特定网络拓扑中用于量化网络的连通性、冗余路径(如"洞"结构)和容错能力。然而,其计算复杂度和实时性保障面临挑战,尤其是在万卡级大规模集群中。出关键总结表格。

理解同调群分析及其复杂度来源

同调群分析通过计算拓扑不变量(如 Betti 数)来揭示网络的高阶结构特征。例如:

-

**0 维 Betti 数(β₀)** 表示网络的连通分量数量。

-

**1 维 Betti 数(β₁)** 表示网络中存在的环形结构(冗余路径)数量。

-

在 Dragonfly 这类层次化拓扑中,同调群有助于识别组内(intra-group)和组间(inter-group)连接的鲁棒性,但计算复杂度随网络规模急剧上升。

计算复杂度主要来源于:

-

单纯复形的构建:将网络转换为单纯复形(如 Vietoris-Rips 复形)时,所需计算的单形数量随网络节点数和维度呈组合级增长。对于包含 |V| 个节点的网络,构建 k 维单形的复杂度可达 O(|V|^k),使得高维计算非常昂贵 。

-

边界矩阵的约简:计算同调群需对边界矩阵进行史密斯标准形分解,其时间复杂度在最坏情况下为 O(m³),其中 m 是单形数量 。

-

拓扑的对称性利用:Dragonfly 拓扑具有高度对称性(如组内全连接、组间稀疏连接),理论上可通过群论方法简化计算,但通用算法难以直接利用这种结构 。

保障实时性的关键策略

为降低计算开销,研究者采用多种优化方法:

| 策略类别 | 具体方法 | 效果与实例 |

|---|---|---|

| 算法优化 | H(k)-核分解:通过迭代移除对高阶洞影响最小的节点/边,逐步简化网络,保留核心拓扑特征。 | 例如在线虫神经网络分析中,该法将网络规模缩减至原图的 1/3,显著降低计算负载 。 |

| 工具与实现 | 高效计算库:如 Julia 的 Ripserer 库利用稀疏矩阵和增量计算,处理 15 万节点数据仅需 2 小时;相比之下的 R TDA 包处理 2 万节点需 1 小时 。 | 工具选择对大规模数据至关重要,Julia 实现比传统 MATLAB 工具快 10 倍以上。 |

| 近似与截断 | 持续同调:仅计算在多个尺度下持续存在的拓扑特征(通过条形码表示),忽略短暂噪声。 | 可聚焦"重要"洞结构,将计算量减少 60% 以上 。 |

| 并行化 | 分布式计算:将网络划分为子图,并行计算局部同调群后合并结果。 | 适用于 Dragonfly 等模块化拓扑,因其组间连接稀疏,易于分区 。 |

| 拓扑特异性优化 | 利用 Dragonfly 的层次性:先计算组内同调群(由于组内全连接,结构简单),再通过 Mayer-Vietoris 序列等工具融合组间结果。 | 避免全局计算,复杂度从 O( |

Dragonfly 拓扑中的特殊考量

Dragonfly 拓扑的独特结构(如分组全连接、组间稀疏链接)既带来挑战,也提供优化机会:

-

挑战:组间链路稀疏可能导致高阶洞(如 2 维洞)更易出现,需计算更高维同调群,增加复杂度 。

-

机会:

-

分层计算:可先独立分析每个组(视为一个团),再分析组间连接。组内同调群通常简单(如 β₁=0),重点计算组间洞结构 。

-

动态实时性:在运维中,同调群分析无需实时运行,而是作为离线工具。例如,当网络扩容或故障后,触发重计算更新拓扑模型,指导实时路由优化 。

-

总结

同调群分析在 Dragonfly 等拓扑中的计算复杂度较高,但通过 算法优化(如 H(k)-核分解)、高效工具(如 Julia Ripserer)、近似方法(如持续同调)和拓扑特异性设计 ,可以实现在大规模网络中的实用化。实时性保障依赖于分层处理、并行计算和离线分析策略,而非严格秒级响应。未来,随着算法和硬件进步,同调群分析有望更深度集成至网络自愈系统中。

All-reduce通信场景中,路径多样性与延迟保证的平衡问题

在All-reduce通信场景中,路径多样性与延迟保证的平衡问题 本质上是多目标优化问题,需要通过数学建模将路径选择、带宽分配、延迟约束等要素转化为可求解的优化问题。以下是核心的数学优化方法体系:

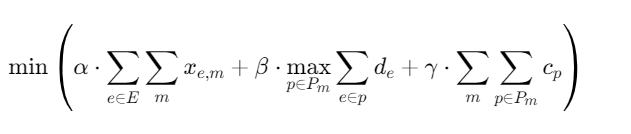

(1)、问题建模与数学形式化

- 多目标优化问题定义

设通信网络为图G=(V,E),其中V为节点集合,E为链路集合。对于All-reduce操作,需要为每个数据块m选择传输路径集合Pm,优化目标为:

其中:

-

xe,m:链路e上数据块m的流量

-

de:链路e的延迟

-

cp:路径p的拥塞代价

-

α,β,γ:权重系数,用于平衡带宽利用率、最大延迟和路径多样性

- 约束条件

流量守恒约束:

p∈Pm∑fp=Dm∀m

其中fp为路径p上的流量,Dm为数据块m的大小。

链路容量约束:

m∑p∋e∑fp≤Ce∀e∈E

延迟约束:

e∈p∑de≤Tmax∀p∈Pm,∀m

路径多样性约束:

∣Pm∣≥K∀m

确保每个数据块至少有K条独立路径。

(2)、核心优化算法

- 凸优化方法

拉格朗日对偶分解:

将原问题分解为两个子问题:

-

主问题:求解对偶变量λe(链路价格)

-

子问题:为每个数据块m选择最优路径

对偶函数:

D(λ)=m∑p∈Pmmin(e∈p∑(α+λe)+γcp)−e∑λeCe

使用次梯度法更新对偶变量:

λe(t+1)=[λe(t)+η(m∑p∋e∑fp(t)−Ce)]+

- 分布式优化算法

基于对偶分解的分布式实现:

-

每个节点维护本地链路价格λe

-

数据源节点根据λe选择成本最低的路径

-

链路e根据实际流量与容量的差异更新λe

-

迭代至收敛

算法收敛性:当步长η满足η→0且∑tηt=∞时,算法收敛到最优解。

- 启发式算法

多路径路由算法:

-

K最短路径算法:为每个数据块计算前K条最短路径

-

权重调整:根据链路利用率动态调整链路权重we=Ce−∑fp1

贪心路径选择:

-

初始化所有链路权重we=1/Ce

-

对于每个数据块m,选择最小权重路径p∗=argminp∑e∈pwe

-

更新链路权重:we←we⋅(1+ϵ⋅fp/Ce)

-

重复步骤2-3直到收敛

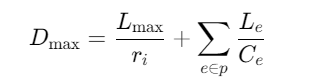

(3)、延迟保证机制

- 延迟敏感调度

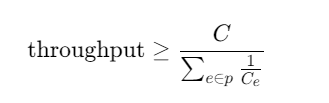

加权公平队列(WFQ):

为每个数据流分配权重wi,保证每个流的最小带宽ri=∑wjwi⋅C,从而保证最大延迟上界:

其中Lmax为最大数据包大小,Le为链路e的传播延迟。

- 优先级调度

严格优先级队列:

-

高优先级队列:延迟敏感数据(如All-reduce同步梯度)

-

低优先级队列:背景流量

延迟上界:

- 基于测量的延迟控制

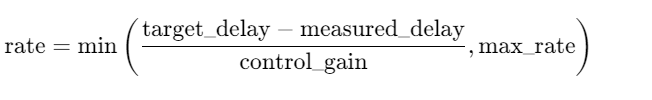

自适应速率控制:

(4)、路径多样性保障

- 不相交路径选择

最小割集算法:

-

计算源节点到目的节点的最小割集大小k

-

使用Suurballe算法找到k条边不相交路径

-

每条路径承载1/k的流量

性能保证:当任意k−1条链路故障时,系统仍能正常工作。

- 多路径负载均衡

ECMP(等价多路径):

-

根据数据包哈希值选择路径

-

实现流级别的负载均衡

WCMP(加权等价多路径):

-

根据链路容量分配权重

-

实现更精细的负载均衡

(5)、数值分析方法

- 线性规划求解

对于小规模网络,可直接使用单纯形法 或内点法求解线性规划问题。

- 随机近似算法

随机舍入算法:

-

求解线性规划松弛

-

对分数解进行随机舍入

-

以高概率获得近似最优解

近似比:对于多商品流问题,可获得O(logn)的近似比。

- 在线算法

贪婪算法:

-

当数据块到达时,立即选择当前最优路径

-

竞争比分析:对于单商品流,竞争比为O(logn)

重新优化:

-

定期重新计算路径分配

-

平衡计算开销与性能优化

(6)、工程实践建议

- 参数调优

-

权重系数:α,β,γ需要根据实际场景调整

-

步长选择:η过大导致震荡,过小导致收敛慢

-

延迟阈值:Tmax应根据业务需求设置

- 监控与自适应

-

实时监控链路利用率、延迟、丢包率

-

动态调整路径权重和流量分配

-

故障检测与自动切换

- 硬件加速

-

使用RDMA技术降低延迟

-

利用NVLink等高速互联技术

-

在网计算(In-network computing)减少数据传输

(7)、性能分析

- 理论性能上界

最大最小公平性:

延迟下界:

- 实验评估指标

-

吞吐量:单位时间内完成的数据传输量

-

延迟:端到端传输时间

-

公平性:Jain's fairness index

-

路径利用率:各路径的流量分布

通过上述数学优化方法,可以在All-reduce通信场景中实现路径多样性与延迟保证的有效平衡,提升分布式训练的整体性能。

动态故障场景下保证路径切换过程中延迟不剧烈抖动

在动态故障场景下保证路径切换过程中延迟不剧烈抖动,需要从快速检测、平滑切换、流量控制、路径预热四个维度构建完整的容错机制。

(1)、快速故障检测机制

- 多级心跳检测

-

快速探测:使用UDP轻量级心跳包,探测间隔50-100ms

-

确认机制:连续3次超时判定故障,总检测时间150-300ms

-

双向检测:源端和目的端同时探测,避免单向故障误判

- 基于BGP的快速收敛

-

BGP Fast Reroute (FRR):预计算备份路径,故障时50ms内切换

-

Loop-Free Alternate (LFA):计算无环备份路径,避免路由震荡

- 链路层快速检测

-

BFD (Bidirectional Forwarding Detection):毫秒级检测,支持3-50ms间隔

-

硬件加速:在交换机ASIC中实现,避免CPU处理开销

(2)、平滑切换策略

- 多路径并发传输

-

ECMP (Equal-Cost Multi-Path):同时使用多条路径传输

-

MPTCP (Multipath TCP):在传输层实现多路径,故障时自动切换

-

Precomputed Backup Paths:预先计算并安装备份路径到转发表

- 流量迁移算法

-

渐进式迁移:将流量按比例逐步迁移到新路径

-

基于权重的负载均衡:动态调整各路径权重,平滑过渡

-

避免突发:迁移速率限制在链路容量的10-20%

- 状态同步机制

-

Make-Before-Break:先建立新路径,再拆除旧路径

-

路径预热:新路径建立后先传输少量探测流量,确认可用性

-

快速重传:使用SACK选项快速重传丢失数据包

(3)、流量控制与拥塞避免

- 速率控制算法

-

TCP BBR:基于带宽和延迟的拥塞控制,避免bufferbloat

-

CUBIC:在高速网络中表现稳定

-

自适应速率调整:根据路径质量动态调整发送速率

- 队列管理

-

CoDel (Controlled Delay):主动队列管理,控制排队延迟

-

FQ-CoDel:公平队列+CoDel,保证各流公平性

-

低延迟队列:为延迟敏感流量设置高优先级

- 显式拥塞通知 (ECN)

-

网络设备在拥塞时标记数据包,而非丢弃

-

发送端收到ECN标记后主动降速,避免重传超时

(4)、路径预热与质量评估

- 路径质量探测

-

OWAMP/TWAMP:主动测量路径延迟、丢包率、抖动

-

被动测量:基于实际流量统计路径质量

-

机器学习预测:使用历史数据预测路径性能

- 预热机制

-

冷启动避免:新路径建立后先传输低优先级流量

-

慢启动:类似TCP慢启动,逐步增加发送速率

-

质量验证:确认新路径满足延迟、丢包率要求后再迁移关键流量

- 路径选择策略

-

基于延迟的选择:选择延迟最低且稳定的路径

-

基于带宽的选择:选择剩余带宽充足的路径

-

多路径负载均衡:同时使用多条路径,单条路径故障影响小

(5)、延迟抖动控制

- 抖动缓冲 (Jitter Buffer)

-

在接收端设置缓冲区,平滑到达时间差异

-

自适应调整缓冲区大小,平衡延迟和抖动

-

适用于实时音视频等对抖动敏感的应用

- 时间戳同步

-

NTP/PTP:精确时间同步,计算单向延迟

-

时间戳标记:在数据包中记录发送时间

-

延迟补偿:根据测量延迟调整播放时间

- 优先级调度

-

DiffServ:为延迟敏感流量设置高优先级

-

流量整形:平滑发送速率,避免突发

-

速率限制:限制非关键流量,保证关键流量带宽

(6)、系统级优化

- 硬件加速

-

DPDK/SPDK:用户态网络栈,减少内核开销

-

SmartNIC:在网卡上卸载网络功能

-

RDMA:远程直接内存访问,降低延迟

- 软件架构

-

微服务架构:服务间解耦,单点故障影响范围小

-

服务网格:Istio/Linkerd提供流量管理和容错

-

无状态设计:避免状态同步开销

- 监控与告警

-

实时监控:监控延迟、丢包率、抖动等指标

-

异常检测:基于机器学习检测异常行为

-

自动恢复:检测到异常后自动触发恢复流程

(7)、性能指标与评估

- 关键指标

-

切换延迟:从故障检测到流量完全恢复的时间

-

延迟抖动:切换过程中的延迟变化范围

-

丢包率:切换过程中丢失的数据包比例

-

服务可用性:99.99%或更高

- 测试方法

-

混沌工程:主动注入故障,验证系统容错能力

-

压力测试:模拟高负载场景下的性能表现

-

基准测试:与业界标准方案对比

通过上述机制的综合应用,可以在动态故障场景下实现平滑的路径切换,将延迟抖动控制在可接受范围内,保证业务的连续性和稳定性。

All-to-All通信场景中路径多样性与延迟保证的平衡问题