大语言模型,即Large Model, LLM,一般是指那种基于海量文本数据来训练的,参数规模能达到数十亿甚至千亿级别的深度神经网络模型。自2017年架构出现以来,模型参数量呈现出指数级的增长。截止到2026年第一季度,主流开源模型的参数规模普遍分布在70亿至6700亿这个区间,部分商业模型已经突破了万亿参数。

依技术架构的维度去看,当下大模型主要被划分成稠密模型与混合专家也就是MoE模型这两类,稠密模型于每次进行前向推理之际会激活全部参数,其典型的代表是Meta的Llama系列以及阿里巴巴的通义千问Qwen系列,而MoE模型是由多个专家子网络构建而成的,每次仅仅激活其中的部分专家,在同等的算力开销状况当中达成更大的有效参数量。以-R1系列作为例子,它采用了MoE架构,在各种复杂推理任务当中体现出显著优势,然而像Qwen3-30B-A3B这类混合架构模型,却在代码生成与修复场景之下展示了较高效率。模型属于另一重要分支,它专门致力于把文本映射成为高维向量,为检索增强生成也就是RAG提供基础支撑。

从集中式云端朝着分布式边缘演进这样一个显著的变化,发生在了大模型的推理部署过程之中。传统云端推理把全部计算都集中于少数大型数据中心,请求要经过长距离骨干网进行传输,哪怕是在最优的网络条件之下,端到端时延常常也会超过500毫秒。边缘云推理架构是把模型预先部署到地理分散的边缘节点,借助智能调度算法将用户请求路由到距离其最近的节点。实测数据表明,该架构能够把单次推理的响应时间压缩至300毫秒以内。这一提升是源于两项关键技术,其一为服务网关的全网感知调度,在此项调度中,系统不但能够实时监测节点负载,还能够实时监测网络状态以及模型需求,与此同时对流量进行动态分配;其二是异构算力弹性调度,经过在虚拟化层面针对GPU、NPU等诸多资源开展池化管理,该类实例的启动时间实现了缩短,缩短至5秒以内,凭借这一缩短后的时间,能够处理百万级并发的突发流量。

影响用户体验的关键之中,模型文件的加载效率占据一席之地。大模型权重文件常常高达数十甚至数百GB,传统冷启动进程需要从中心存储去拉取完整的模型,所耗费的时间能够达到10分钟以上。为了解决这个瓶颈,分布式缓存与数据集编排技术被引入进来,借助把模型文件切片缓存在多级边缘节点,再结合亲和性调度策略,冷启动时长久已被压缩到20秒以内。在单节点的层面上,推理优化技术也取得了突破。经由把预填充()跟解码()阶段拆分开来,并且允许许多模型在多卡环境当中混合着运行,GPU利用率从行业平均的大约25%提高到56%,单节点推理效率提高超过2倍。

在应用场景这一方面,大模型一开始是用于文本生成、对话交互的,此后扩展到诸多专业领域。于智能客服系统而言,边缘节点所拥有的低延迟特征把实时交互变为能够实现的事情,企业能够在本地做完高频请求之后,仅仅是把繁琐的问题转交给云端知识库。在内容创作这个领域,拥有多语言能力的模型对文章撰写、摘要生成、风格迁移等任务予以支持,兼顾了创意工作的即时性以及数据隐私。在教育科研场景当中,代码生成模型能够辅助达成数学题演算以及编程作业批改,数据在 进行处理符合了部分院校的数据合规需求。另一重要落地点是工业自动化的边缘推理,围绕故障模式识别,设备传感器在边缘节点即时完成数据处理,诊断响应从分钟级别降低到秒级别,生产线连续性因此获得了有力保障的呈现。

大模型服务的付费模式,因部署架构的演进,发生了结构性变化,早期企业自建大模型基础设施,要承担数千万元级别的GPU采购支出,还面临算力利用率波动的挑战,按API调用量计费的按需模式,把资本支出转化为运营支出,多租户架构与算力池化技术,进一步降低了边际成本,当前,单次百万token推理的调用成本,已降至十元级别,这让中小规模开发团队,也能以较低门槛接入前沿模型能力。

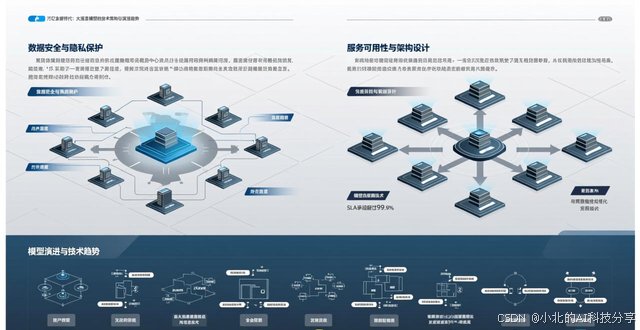

对于大模型规模化落地来说,数据安全与隐私保护是必经的一道门槛。边缘云架构有着天然的数据分散处理特性,用户请求不用汇集到中心节点,这样就降低了批量泄露风险。主流模型服务平台整合了全链路加密、运行时隔离、安全网关以及Web应用防火墙的复合防护体系,形成了从传输、存储到计算的三层防护结构。在服务可用性方面,分布式设计与智能负载均衡让大多数平台的SLA承诺超过了99.9%,模型热更新技术达成了业务无感知的版本迭代。

关键阶段正来临,当前大模型行业,正从"参数竞赛"趋向"工程优化"转变了。模型规模仍持续按著秩序在扩张,然而更受重视的是啥呢,是怎样能够以更低成本、更高效率去把已经有的机型的能力给释放出来。自2025年下半年始以来,好多家机构陆陆续续推出了参数规模处于30亿至100亿之间的高效能模型,它在通用任务里的表现已经快要接近一年前的百亿级模型了。边缘计算与模型轻量化技术二者相结合,正在催生出一批完全运行于终端设备之上的大模型应用。在接下来的三年时间里,大模型届时将不会单单是由云端算力层层堆叠所形成的产物,而是会摇身一变成为在各个地方都能存在的数字基础设施。