一、前言:从"懂原理"到"能落地"

在上篇内容中企业级 Prompt 工程实战指南(上):别让模糊指令浪费你的AI算力,我们拆解了 Prompt 的底层逻辑、四大核心要素,以及四大典型避坑技巧,解决了"怎么写才不踩坑"的基础问题。

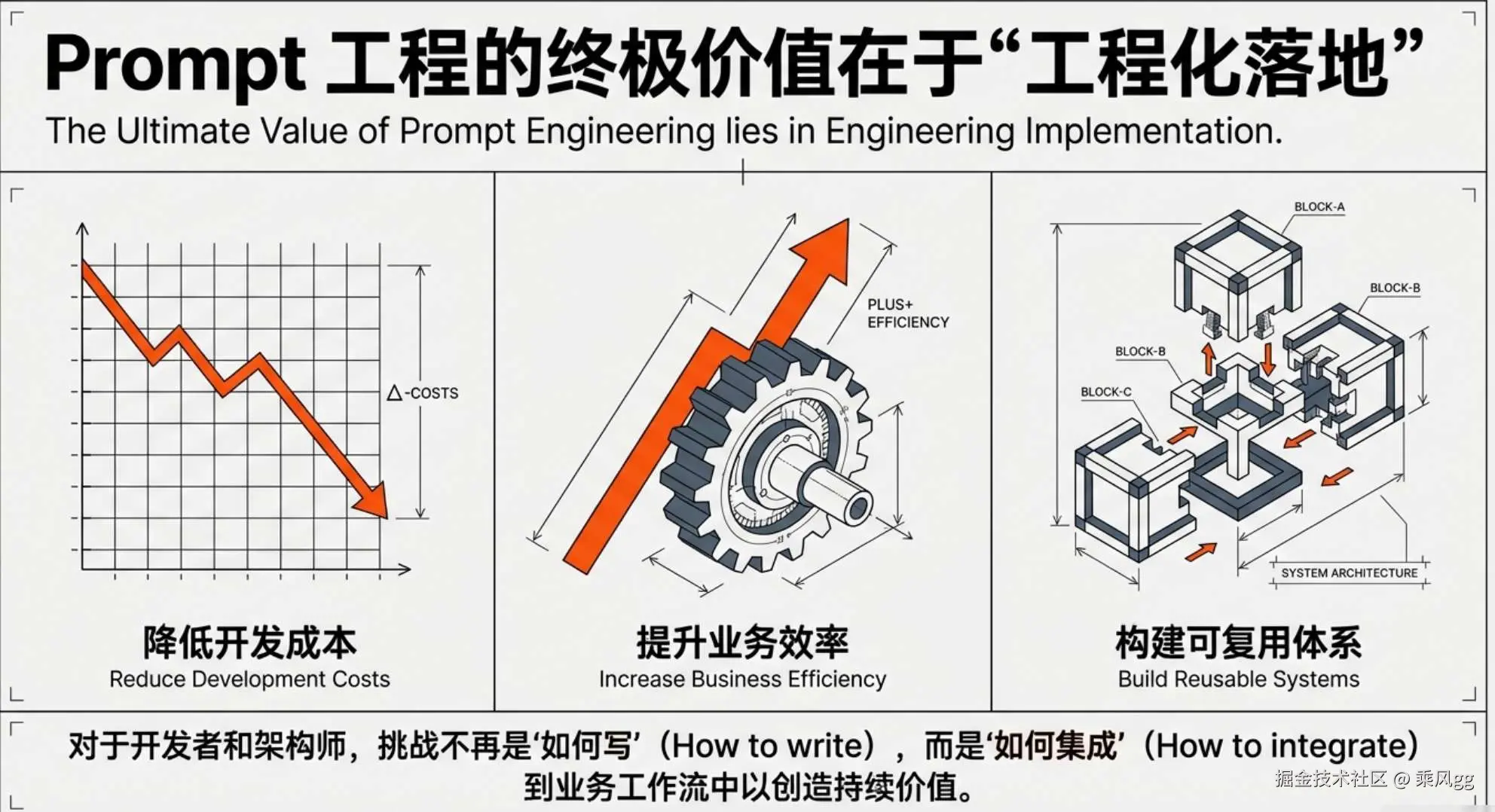

但对一线开发者和架构师而言,Prompt 工程的最终价值,不在于"懂原理 ",而在于"能落地"------如何将 Prompt 设计融入实际业务,降低开发成本、提升效率,构建可复用、可迭代的 Prompt 体系?

本篇将聚焦实战,通过完整业务案例拆解落地流程,对比不同技术路径的优劣,分享工程化落地技巧,并展望未来发展趋势,真正把 Prompt 技术转化为业务竞争力。

二、实战案例:企业客服工单自动分类与摘要生成

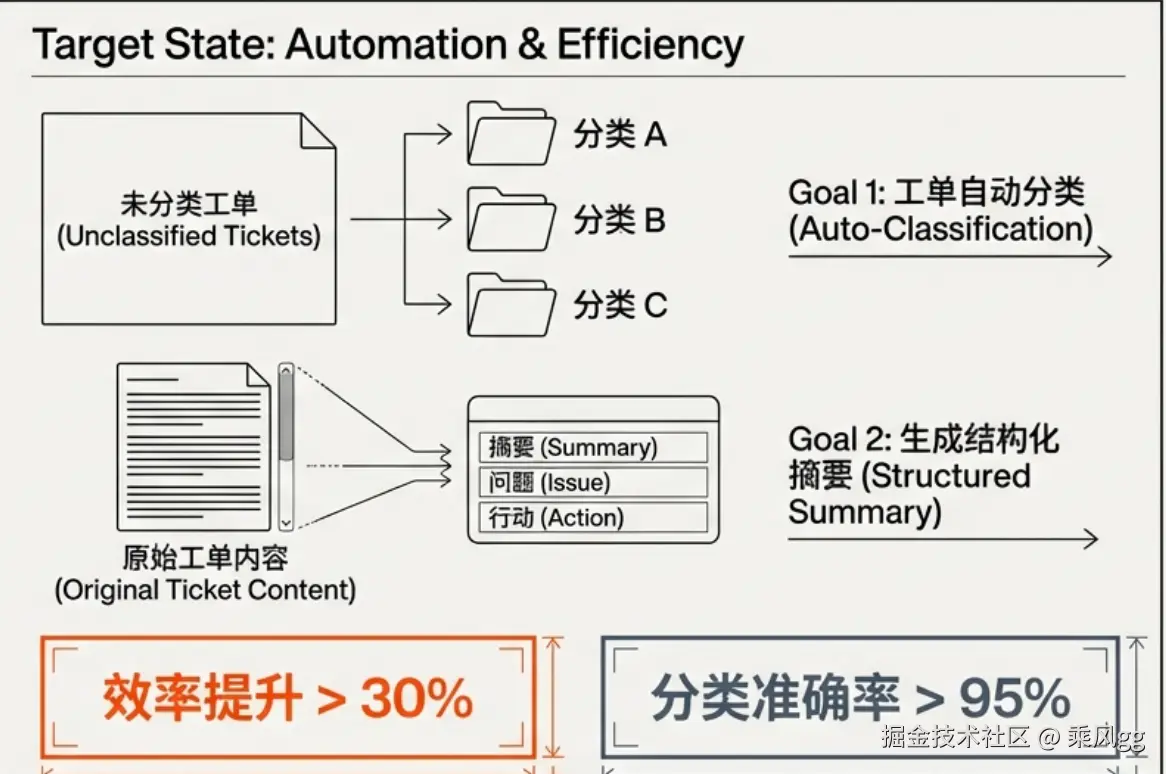

为了更直观地展示 Prompt 工程在实际业务中的应用效果,我们以一家电商企业的售后客服场景为例,详细拆解如何通过精心设计的 Prompt 实现工单的自动分类与摘要生成,大幅提升客服工作效率。

2.1 场景角色

- AI 应用产品经理(Prompt 设计者) :负责设计和优化 Prompt,确保大语言模型能够准确理解业务需求并生成高质量的输出。

- 客服团队(需求方) :每天需要处理大量的售后工单,希望借助 AI 技术实现工单的自动分类和摘要生成,以减轻工作负担,提高服务效率。

- 大模型(执行主体) :选用市面上成熟的大语言模型,如 ChatGPT、Gemini、通义千问等,作为执行任务的核心引擎,根据输入的 Prompt 和工单文本进行分析和处理。

- 服务对象:日均产生 500 + 售后工单的电商售后部门,涵盖各类复杂的客户问题和诉求。

2.2 核心目标

通过优化 Prompt 设计,让大语言模型自动将杂乱无章的售后工单 准确分类为 "物流问题 ""产品故障 ""退换货申请" 三类,并为每个工单生成 50 字以内的结构化处理摘要,清晰概括核心诉求与关键信息。目标是替代人工分类,将整体工作效率提升 30% 以上,同时保证分类准确率达到 95% 以上,摘要关键信息覆盖率达到 90% 以上。

2.3 输入

-

原始输入:无结构化的售后工单文本,例如 "我买的衣服尺码不对,昨天收到的,想换大一码,请问需要寄回吗?" 这类文本通常表述随意,包含大量冗余信息,需要模型进行信息提取和分类。

-

辅助输入(少样本学习) :为了引导模型更好地理解任务,提供 3 条分类示例,如:

- 示例 1 :"我买的手机三天了还没收到,单号查不到,啥情况?" - 分类:物流问题;摘要:用户反映手机未收到且单号查询无果。

- 示例 2 :"刚用的吹风机,突然冒烟了,不敢再用了。" - 分类:产品故障;摘要:用户反馈吹风机使用中冒烟。

- 示例 3 :"买的电脑配置和宣传不符,申请退货。" - 分类:退换货申请;摘要:用户因电脑配置不符申请退货。

2.4 处理流程(工具调用逻辑)

- 第一步:编写系统 Prompt:"你是电商售后工单分类专家,需完成 2 个任务:1. 将工单分为物流问题 / 产品故障 / 退换货申请三类;2. 生成 50 字内处理摘要,包含核心诉求与关键信息。" 此系统 Prompt 明确了模型的角色和任务范围,为后续处理奠定基础。

- 第二步:加入少样本示例:将上述 3 条分类示例加入 Prompt 中,让模型通过少样本学习掌握分类和摘要生成的模式与规则,增强模型对任务的理解和适应性。

- 第三步:输入用户工单文本:将实际的售后工单文本输入给模型,与系统 Prompt 和少样本示例共同构成完整的输入信息,触发模型的处理流程。

- 第四步:输出结构化结果:模型根据输入信息进行分析处理,输出结构化的结果,格式为 "分类:[具体类别];摘要:[处理摘要]"。整个过程无需对模型进行微调,仅通过精心设计的 Prompt 即可实现高效的任务处理。

2.5 输出与校验

-

输出格式:"分类:退换货申请;摘要:用户购买衣服尺码不符,昨日收货,需求换货大一码,咨询寄回流程"。这种结构化的输出便于客服人员快速理解工单内容,提高处理效率。

-

校验标准:

- 分类准确率:通过人工抽样复核 100 条工单,对比模型分类结果与人工标注结果,要求分类准确率达到 95% 以上。

- 摘要关键信息覆盖率:同样抽样 100 条工单,检查摘要是否涵盖用户核心诉求和关键信息,如问题类型、涉及产品、关键时间等,覆盖率需达到 90% 以上。

三、技术路径对比:不同 Prompt 策略的适用场景与成本分析

3.1 三类主流 Prompt 技术路径对比表

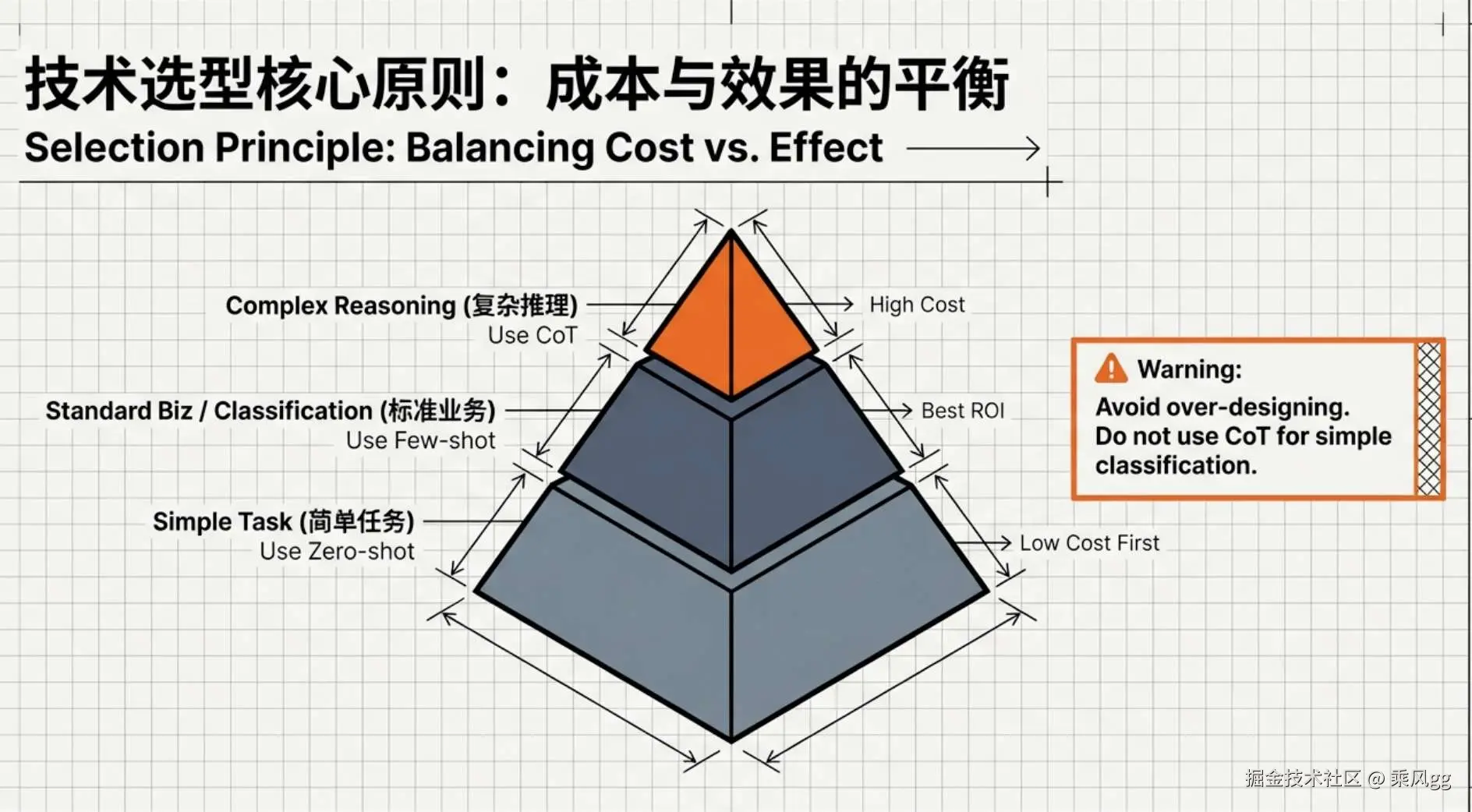

在实际应用中,零样本、少样本和思维链(CoT)这三类 Prompt 技术路径各有优劣,适用于不同的业务场景。下面通过表格对比,我们可以更清晰地了解它们在设计思路、优势、劣势、适用场景以及技术成本等方面的差异。

| 技术路径 | 设计思路 | 优势 | 劣势 | 适用场景 | 技术成本 | 实现复杂度 | 落地可行性 |

|---|---|---|---|---|---|---|---|

| 零样本 Prompt | 仅输入任务描述,无示例 | 成本最低、无需准备样本、迭代快 | 准确率低、复杂任务易失控 | 简单文本生成、基础问答 | 极低(仅需指令设计) | 低 | 极高(即写即用) |

| 少样本 Prompt | 加入 3-5 个示例引导模型 | 准确率高于零样本、适配多数场景 | 需准备标注示例、指令长度受限 | 文本分类、摘要生成、格式标准化 | 低(样本标注成本低) | 中 | 高(中小规模业务首选) |

| 思维链(CoT)Prompt | 引导模型分步推理,展示思考过程 | 适配复杂逻辑任务、推理准确率高 | 指令设计复杂、token 消耗大、速度慢 | 数学计算、故障排查、多步骤决策 | 中(需设计推理框架) | 高 | 中(适合专业场景) |

3.2 技术选型核心原则:成本与效果的平衡

从高层往下看视角看,技术选型需遵循 "低成本优先" 原则:优先用零样本 Prompt 解决简单任务;中等复杂度任务采用少样本 Prompt,以最低标注成本提升准确率;仅复杂推理任务考虑思维链 Prompt,同时需评估 token 消耗带来的算力成本,避免过度设计。在实际应用中,我们要根据任务的复杂度、数据资源、算力成本等多方面因素,综合评估选择最合适的 Prompt 技术路径,以实现最佳的性价比。例如,在一个简单的文本分类任务中,如果使用思维链 Prompt,虽然可能会提高准确率,但由于其指令设计复杂、token 消耗大,会增加不必要的成本,此时选择少样本 Prompt 可能更为合适。

四、Prompt 工程化落地:从 "一次性指令" 到 "可复用架构"

当我们在实际业务中大规模应用 Prompt 技术时,就不能仅仅满足于 "一次性" 的指令设计,而需要从工程化的角度构建一套可复用、可迭代、低成本的 Prompt 架构体系。这不仅关系到开发效率与成本控制,更是决定 AI 应用能否在复杂业务环境中持续稳定运行的关键。

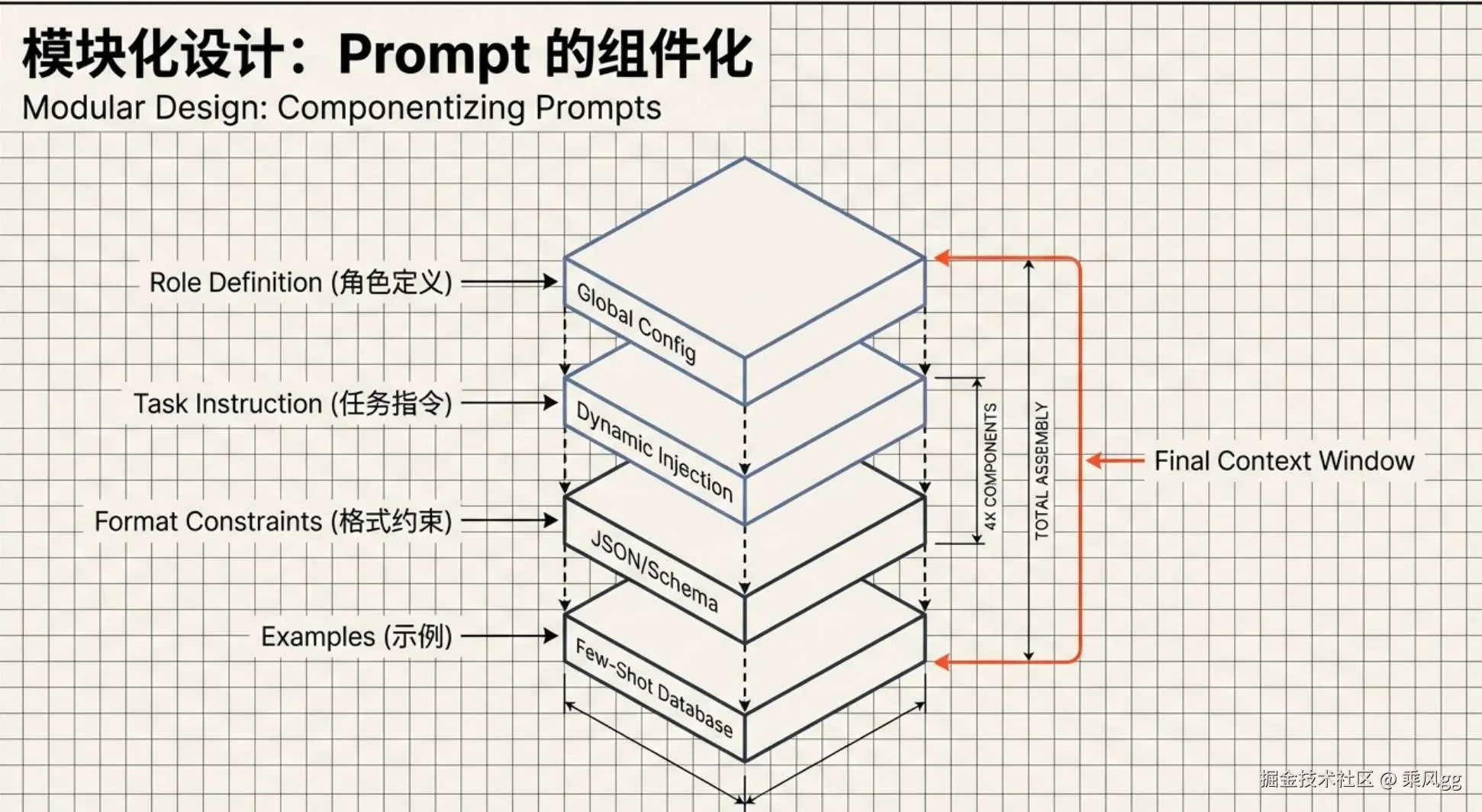

4.1 模块化设计:Prompt 模板化与组件化

从工程实践看,将 Prompt 拆分为多个可复用组件是提高开发效率与灵活性的关键。一个典型的 Prompt 可以拆解为 "角色定义 + 任务指令 + 格式约束 + 示例 " 四大组件。以电商客服场景为例,我们可以将 "你是专业电商客服" 这一角色定义固化为通用组件;任务指令部分则根据不同工单类型(如物流咨询、产品售后等)动态替换;格式约束(如 "输出为 JSON 格式")和示例(如常见问题及解答示例)也可按需调整。通过这种组件化设计,我们可以快速搭建针对不同业务场景的 Prompt,实现跨工单类型的快速适配,大幅降低重复开发成本。这种方式就像是搭积木,每个组件都是一个独立的模块 ,我们可以根据不同的业务需求,灵活地组合这些模块,快速构建出满足需求的 Prompt。在这之后还会专门搭建 Prompt 平台,专门存储和编写 Prompt,一键更新到 AI 应用里面,方便 Prompt 各种环境使用和进行版本管理。

从工程实践看,将 Prompt 拆分为多个可复用组件是提高开发效率与灵活性的关键。一个典型的 Prompt 可以拆解为 "角色定义 + 任务指令 + 格式约束 + 示例 " 四大组件。以电商客服场景为例,我们可以将 "你是专业电商客服" 这一角色定义固化为通用组件;任务指令部分则根据不同工单类型(如物流咨询、产品售后等)动态替换;格式约束(如 "输出为 JSON 格式")和示例(如常见问题及解答示例)也可按需调整。通过这种组件化设计,我们可以快速搭建针对不同业务场景的 Prompt,实现跨工单类型的快速适配,大幅降低重复开发成本。这种方式就像是搭积木,每个组件都是一个独立的模块 ,我们可以根据不同的业务需求,灵活地组合这些模块,快速构建出满足需求的 Prompt。在这之后还会专门搭建 Prompt 平台,专门存储和编写 Prompt,一键更新到 AI 应用里面,方便 Prompt 各种环境使用和进行版本管理。

4.2 迭代优化:基于输出反馈的指令调优

Prompt 并非一成不变,而是需要根据模型输出结果持续优化。建立 "指令 - 输出 - 反馈 - 优化" 的闭环迭代流程是实现这一目标的核心。例如,在工单分类任务中,如果模型将某个 "产品故障" 工单误分类为 "物流问题",我们需要深入分析指令设计的漏洞,比如是否存在未覆盖的边缘场景、示例是否足够典型等。

针对这些问题,我们可以补充更多边缘场景的示例,细化分类规则,逐步提高模型的准确率。这种迭代优化的过程就像是对产品进行持续改进,通过不断收集用户反馈,优化产品功能,提升用户体验。

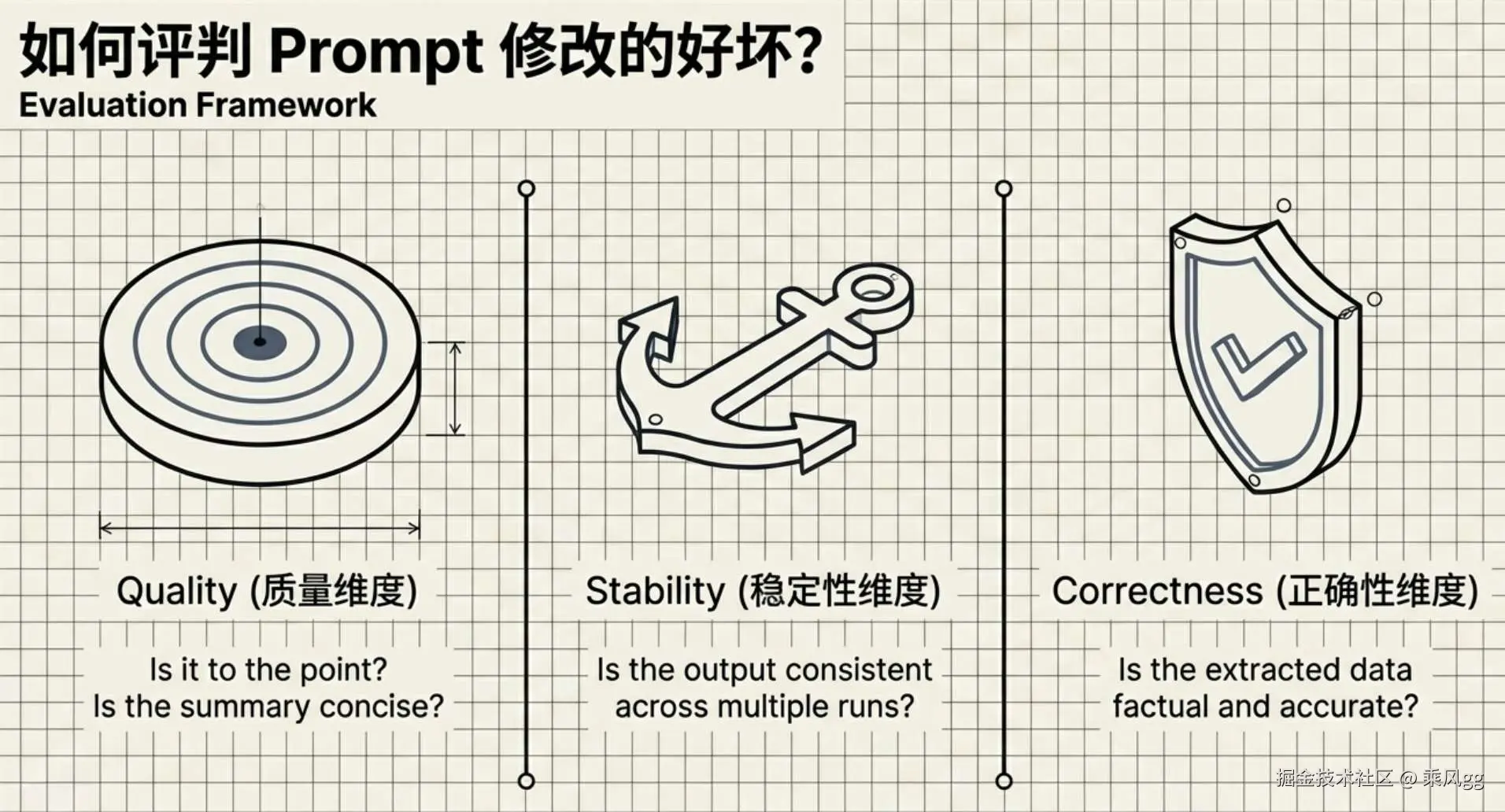

在这里,我想额外问一个问题 在进行 prompt 更新的时候,如何去评判 Prompt 前后两次修改的质量好坏呢? 我列出三个纬度供大家参考

- 质量维度,能说到重点上吗?

- 稳定性纬度,每次问都回答一样吗?

- 正确性纬度,回答的数据正确吗?

4.3 成本控制:减少无效 token 消耗

在实际应用中,token 消耗不单单会影响大模型幻觉,还会直接关系到算力成本,因此从工程化角度优化 token 使用至关重要。首先,要精简指令内容,避免冗长复杂的表述,确保每一个 token 都传递有效信息;

其次,合理利用模型上下文窗口特性,优先保留系统 Prompt 中的核心规则与约束,对用户输入中的冗余信息进行预处理;对于超长文本任务,结合检索增强生成(RAG)技术,将长文本拆分为多个短文本分批次输入,避免一次性输入导致的 token 溢出。这就好比在装修房子时,合理规划空间,避免浪费,让每一寸空间都得到充分利用。通过这些策略,可以在保证模型性能的前提下,有效降低 token 成本,提高应用的性价比。

五、总结与展望:Prompt 工程的现在与趋势

5.1 核心观点总结

Prompt 工程的本质是 "用工程化思维替代感性经验 ",核心在于明确角色、拆解任务、约束格式、补充示例,而非依赖模型参数提升。对于多数企业级应用,优质 Prompt 设计带来的效果提升,远高于盲目追求大模型升级的收益。在实际应用中,我们不应过分关注模型的参数规模和性能指标,而应将更多的精力放在如何设计有效的 Prompt 上。通过合理的 Prompt 设计,我们可以引导模型更好地理解任务需求,提高输出的质量和准确性,从而实现更高的性价比。

5.2 当前局限性

现有 Prompt 技术仍存在边界:无法突破模型预训练知识范围 ,易产生 "幻觉" ;复杂任务的指令设计依赖专业经验;多模态场景下的 Prompt 设计尚未形成标准化方案。例如,当我们询问模型关于未来的科技发展趋势时,由于模型的知识截止于训练时间,它无法提供最新的信息,可能会产生不准确或过时的回答。在多模态场景下,如结合图像和文本的应用中,如何设计有效的 Prompt 以实现多模态信息的融合和交互,仍然是一个待解决的问题。

5.3 目前趋势展望

目前 Prompt 工程将向 "自动化" 与 "融合化" 发展:自动化方面,AI 将自主生成并优化 Prompt,降低人工设计门槛;融合化方面,Prompt 将与 RAG 深度结合,形成 "Prompt+RAG 解决知识时效性的 SOP。随着技术的不断发展,我们可以期待 AI 能够根据用户的需求自动生成和优化 Prompt,进一步提高效率和准确性。Prompt 与其他技术的融合也将为 AI 应用带来更多的可能性,推动 AI 技术在各个领域的深入应用和发展。

感谢观看,欢迎大家点赞关注,下期更精彩!