一、CNN 内容总结

基础概念、架构细节、训练流程,到实际应用(尤其是人脸识别)。

- CNN 的基本概念和解决问题

● 什么是 CNN:一个专为处理"空间结构数据"(如图像、视频)的神经网络架构,像一个高效的图像处理管道(pipeline)。它模拟人类视觉:先看局部特征(边缘、纹理),再组合全局理解(物体)。

● 为什么需要 CNN:传统神经网络(全连接网络)处理图片时参数爆炸(高维像素全连,太慢)、忽略空间结构(像素间局部相关)、平移不变性差(物体移位认不出)。CNN 用卷积操作解决:参数共享(复用内核)、局部连接(只看小窗口),效率高 10-100 倍,泛化强。

● 发明与流行:1980s 发明,2012 年 AlexNet 在图像比赛中爆火,推动深度学习时代。

● Java 比喻:像用过滤器(Filter)扫描 BufferedImage,只关注局部像素,减少全连接的暴力计算。 - CNN 的核心架构(一层一层展开)

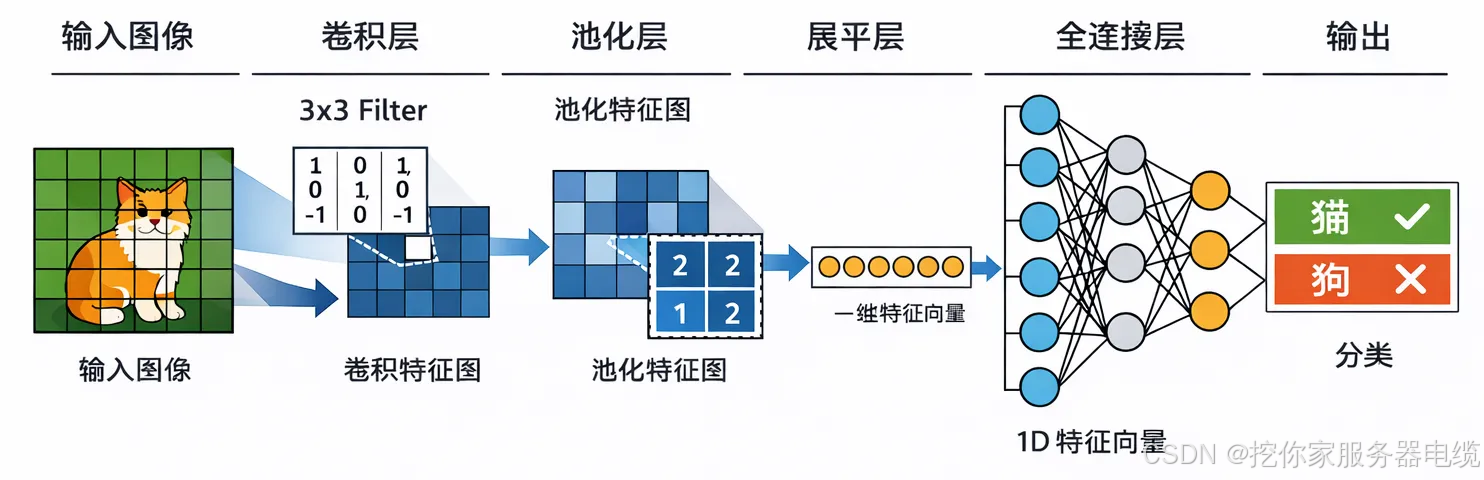

CNN 像多层过滤系统:输入 → 特征提取 → 决策输出。典型结构:卷积 + 激活 + 池化(重复) → 全连接 → 输出。

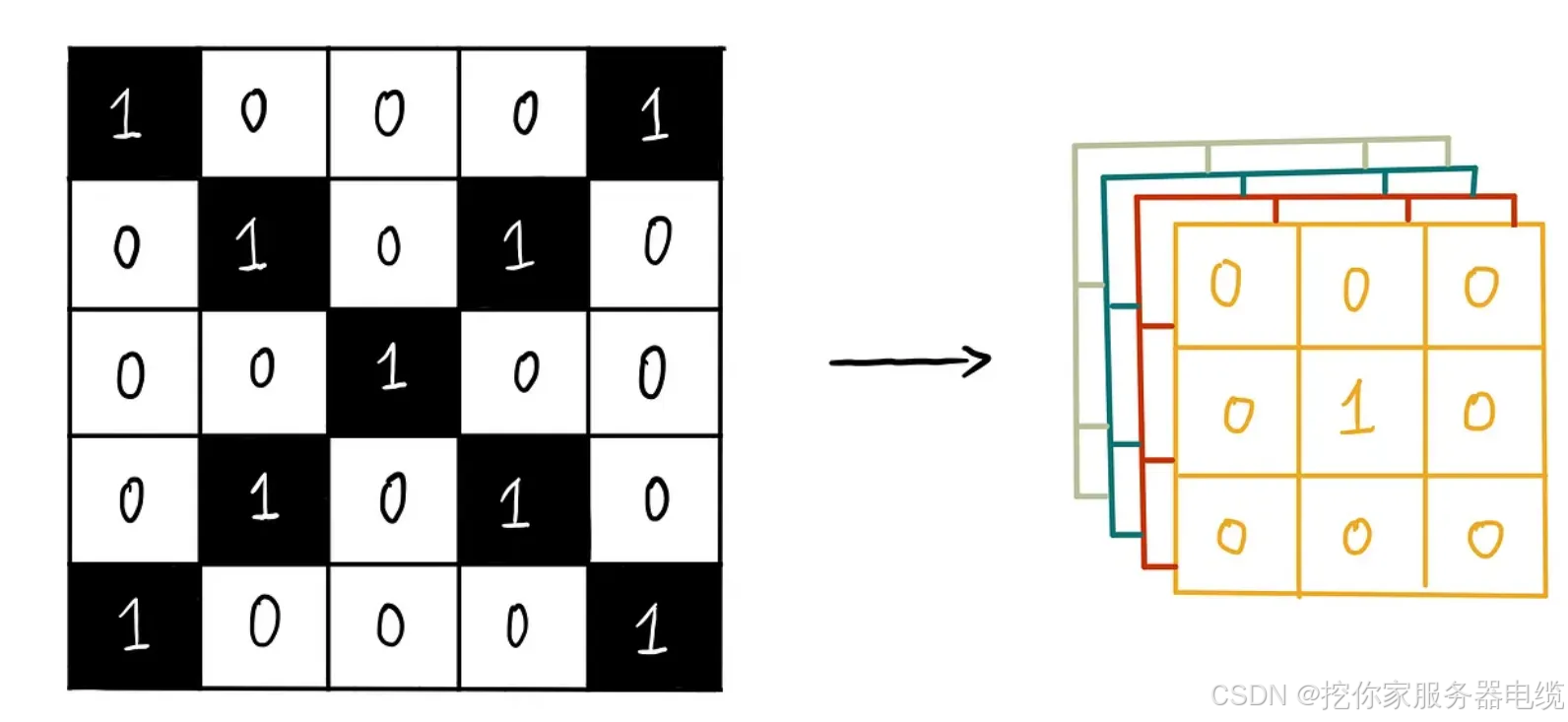

● 输入层:原始图像(H x W x 通道,e.g., RGB 是 3 通道),像加载 int[][][] 数组。

● 卷积层:核心,用小内核(e.g., 3x3 矩阵)滑动扫描,计算乘加,提取特征图(e.g., 边缘检测)。参数共享、局部连接是关键。

● 激活层:加非线性(e.g., ReLU:负值变 0),让模型学复杂模式,像 if (value < 0) value = 0;。

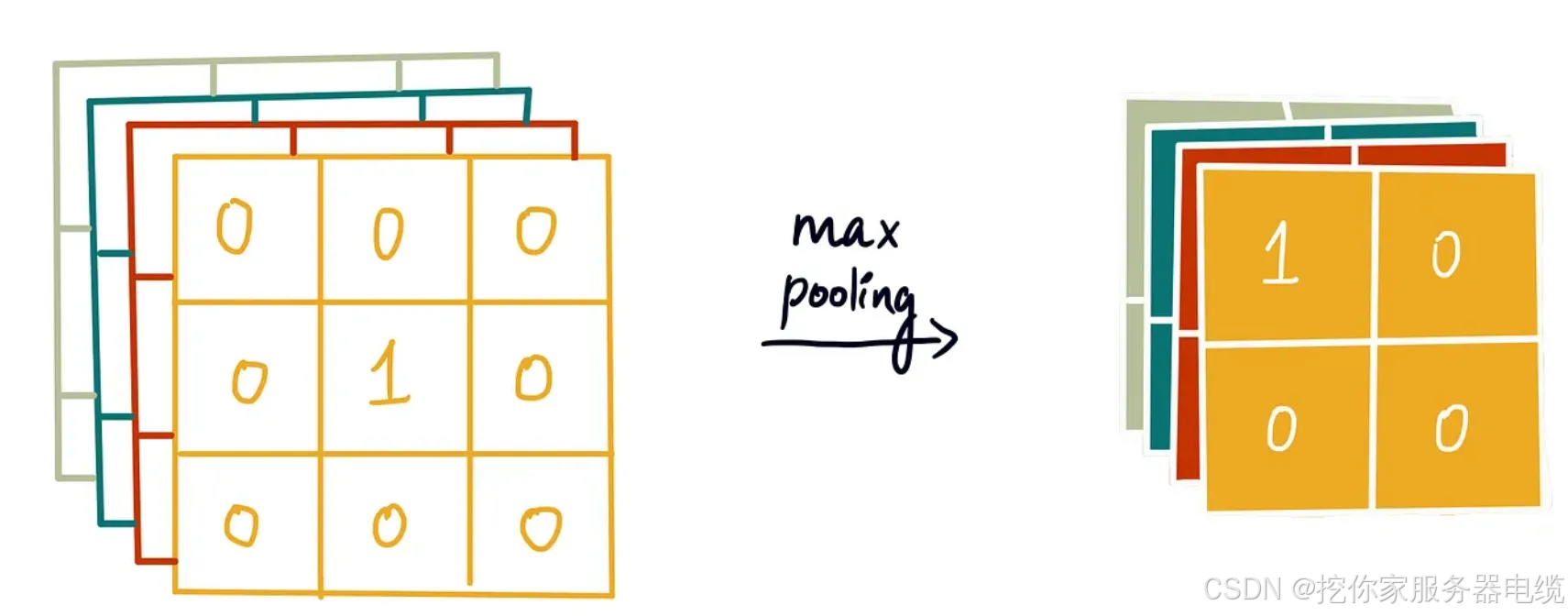

● 池化层:压缩数据(e.g., 最大池化,取窗口 max),降维、防过拟合、加平移不变。

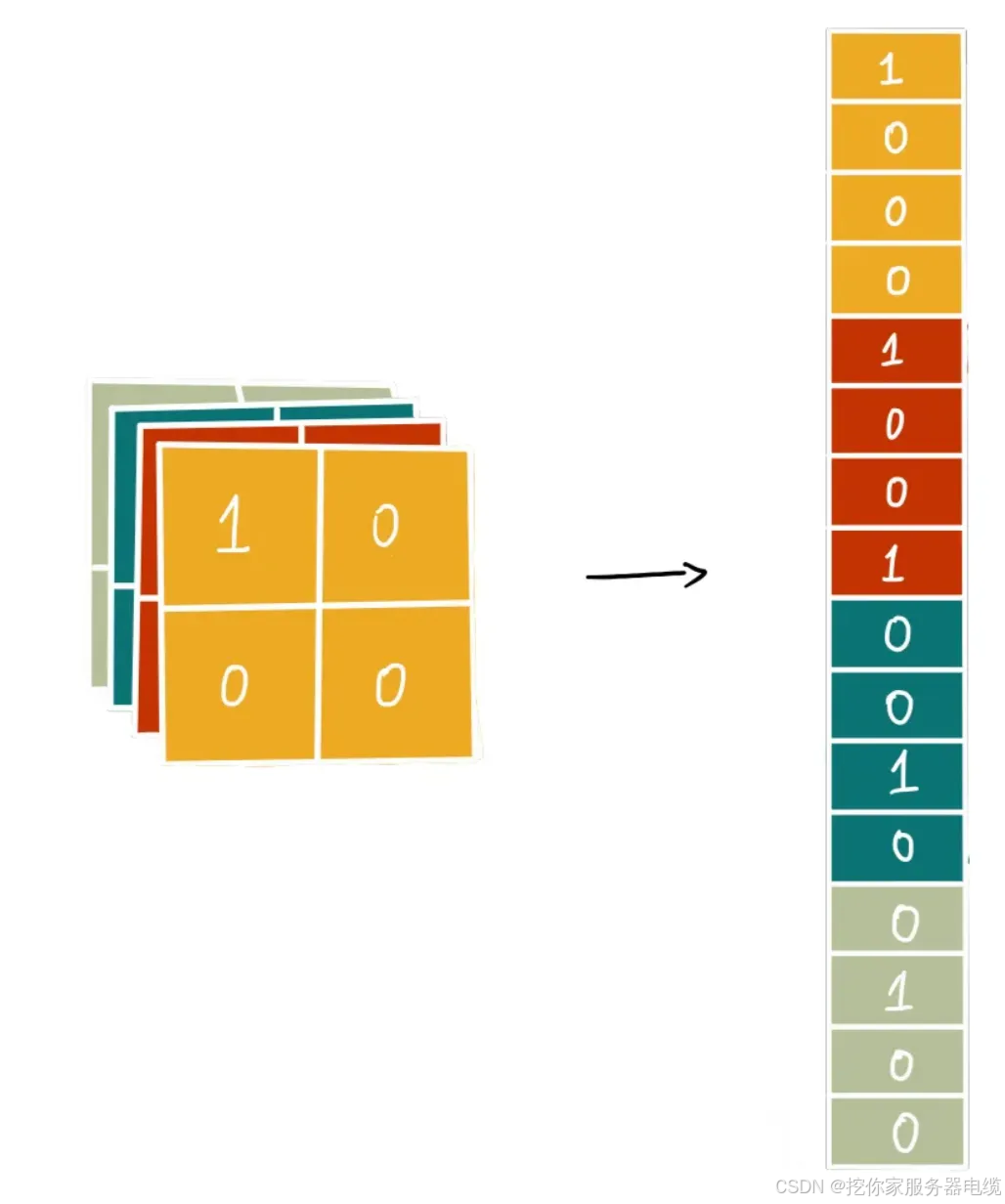

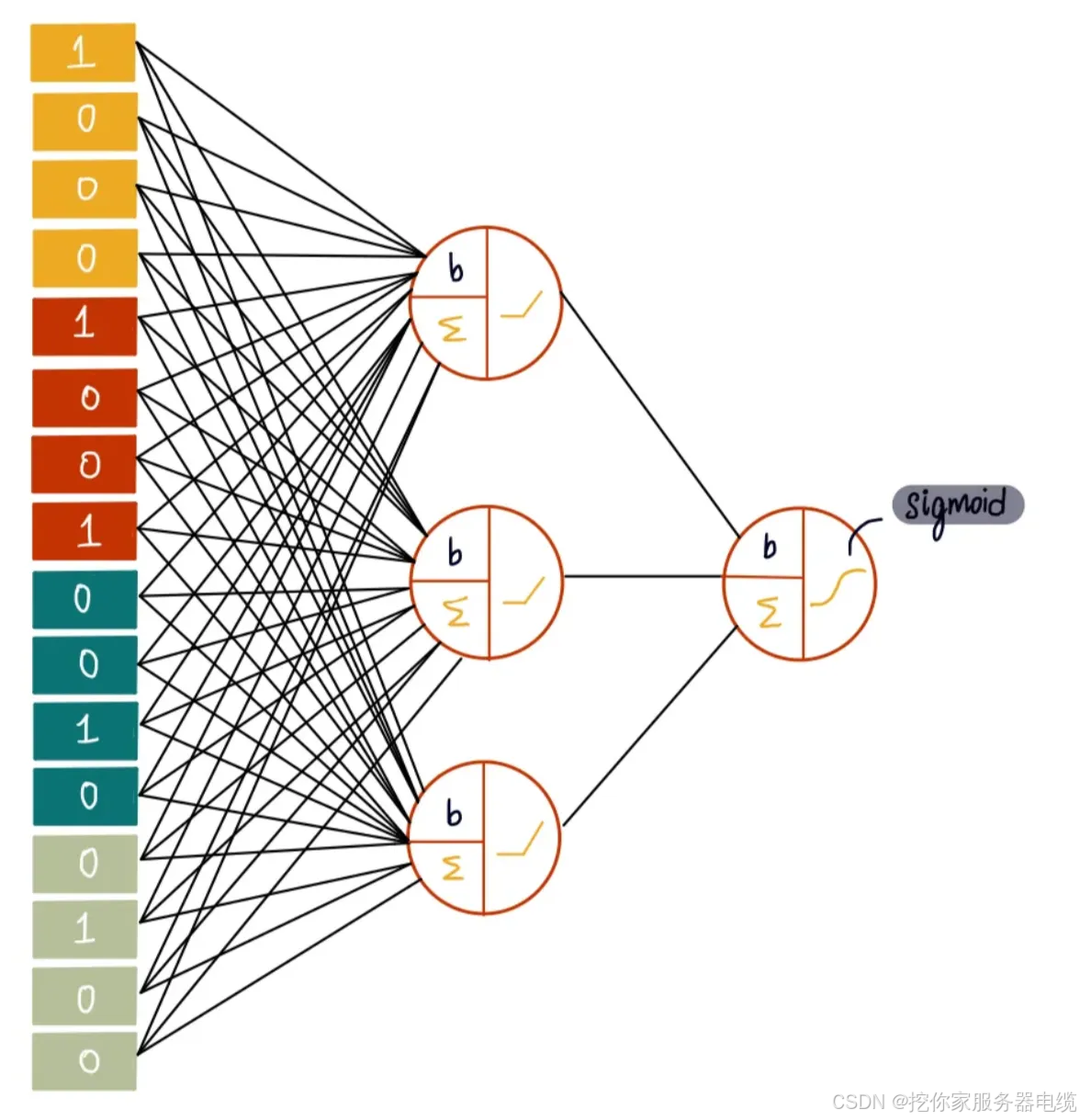

● 全连接层(Fully Connected, FC):把特征图扁平化,全连到输出,像大矩阵乘法整合全局特征。参数多,常在后半部分。

● 输出层:最终结果(e.g., softmax 概率)。

● 变体:如 ResNet 加残差连接,解决深层训练难。

● 例子演示:用 5x5 灰度像素图片(左暗右亮模拟边缘),一步步算:卷积输出特征图突出边缘,激活保持正值,池化浓缩,全连接决策分数。

一句话总结训练循环:

- 前向传播 → 算预测 → 算 Loss

- 反向传播 → 从 Loss 倒推每层梯度

- 更新所有权重 → 进入下一次迭代

- CNN 的训练流程

● 整体目标:从随机参数优化到"聪明"模型,像调试 Java 服务:用数据反复调参,直到准。

● 单次迭代:前向传播(跑数据算预测) + 损失函数(量化错,e.g., MSE 或交叉熵) + 反向传播(从损失反推梯度,追踪每层错) + 参数更新(梯度下降改权重)。

● 多轮迭代:分 batch(小批数据,e.g., 32 张图)处理;epoch(全数据集一轮)。目标收敛(损失降到稳定)。

● 终止条件:固定 epoch、损失阈值、早停(验证集不改善停,防过拟合)。

● 训练输出:不是数据,而是优化好的模型参数(权重文件,e.g., .h5 文件),包含所有内核/权重。加载后用于推理。

● Java 比喻:像循环优化:for each epoch { for each batch { forward(); loss = compute(); backward(); update(); } }。

举个例子:

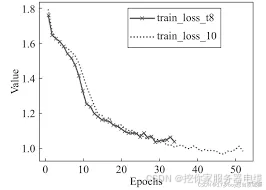

● 横轴是 Epoch 数,纵轴是 Loss

● 曲线不断下降并最终趋于平稳 → 模型收敛

● 一般看到 Loss 不再明显下降 + 验证集准确率最高时,就停止训练(早停)

- CNN 在实际应用中的角色(以人脸识别为例)

● 服务类型:像比对 API:输入图片,输出判断/身份。训好模型集成服务,做检测(有/无人脸)或识别(这是谁)。

● 常见需求(30 名员工打卡人脸比对):绝对可行!用一个 CNN 模型(e.g., FaceNet 变体)提取特征向量("脸的数学指纹",固定维数组,如 512 维),预存 30 个员工向量到数据库,打卡时提取新向量,循环比对相似度(余弦距离),找出匹配。注意:

○ 不是 30 个模型:单一模型提取所有向量,循环的是数据库向量(快,毫秒级)。

○ 特征向量产生环节:前向传播后期,全连接层(或嵌入层)压缩特征图成向量(整合全局五官特征)。

● 注意:加活体检测防骗,隐私考虑(存向量不存照)。

小结(一句话记牢)

CNN 训练 = "前向跑一次看错多少 → 反向算每层该改多少 → 小步更新权重 → 反复多轮直到 Loss 最低"