目录

[一、技术锚点:AI Agent执行断裂的典型场景与核心痛点](#一、技术锚点:AI Agent执行断裂的典型场景与核心痛点)

方案1:基础版------状态快照+定向补偿(低成本落地,适配中小团队)

[1. 方案逻辑图](#1. 方案逻辑图)

[2. 通用伪代码](#2. 通用伪代码)

[3. 方案说明](#3. 方案说明)

方案2:进阶版------分层反思机制+动态分支规划(中成本,适配中大型团队)

[1. 方案逻辑图](#1. 方案逻辑图)

[2. 通用伪代码](#2. 通用伪代码)

[3. 方案说明](#3. 方案说明)

方案3:高级版------Plan-Execute-Verify(PEV)闭环+修正边界控制(高成本,适配头部企业)

[1. 方案逻辑图](#1. 方案逻辑图)

[2. 通用伪代码](#2. 通用伪代码)

[3. 方案说明](#3. 方案说明)

[五、结语:鲁棒性,是AI Agent工业化落地的核心技术壁垒](#五、结语:鲁棒性,是AI Agent工业化落地的核心技术壁垒)

在AI Agent工业化落地的过程中,多数开发者都会陷入一个共性技术困境:精心设计的全流程SOP(如自动化任务调度、数据处理、业务流程履约等),Agent在前序步骤执行流畅,却常常在中间节点因突发异常(依赖故障、参数变更、规则迭代、接口超时)而"卡死"------要么推倒重来浪费Token与时间,要么原地循环陷入报错,最终导致自动化流程断裂,无法形成稳定的工业级落地能力。

核心技术症结在于:普通Agent仅具备"线性执行"能力,缺乏应对复杂业务流/任务流动态变化的"鲁棒性"(Robustness);而真正能适配多行业、多场景的工业级Agent,其核心竞争力不在于"完美执行预设步骤",而在于"遭遇异常时的局部修正与断点续跑"能力。

本文将聚焦AI Agent鲁棒性设计这一技术问题,以跨境电商自动化运营(新品上架、库存预警、订单履约)为辅助理解示例,深度拆解鲁棒性设计的核心逻辑,提供3套可直接落地的局部修正方案,搭配伪代码、逻辑图强化技术表达,明确异常处理边界,帮你摆脱Agent"执行断裂"困境,实现工业级稳定落地。

一、技术锚点:AI Agent执行断裂的典型场景与核心痛点

无论是跨境电商、金融数据处理、企业办公自动化,还是工业流程调度,AI Agent的执行断裂困局都具备共性------本质是"线性执行逻辑"与"动态外部环境"的矛盾。以下结合场景+辅助示例,拆解最典型的执行困局(示例仅为辅助理解,核心聚焦技术本身)。

通用场景:多步骤自动化任务Agent

预设通用SOP(5步线性流程,适配多数自动化场景):

- 数据/指令抓取:从指定数据源(接口、数据库、文档)提取任务所需核心信息、参数;

- 数据处理/转换:对抓取的信息进行清洗、格式转换、本地化适配(如文本翻译、数据校准);

- 规则/风控校验:校验处理后的数据/指令是否符合预设规则、合规要求、权限限制;

- 核心任务执行:调用对应工具、接口,执行核心业务操作(如素材生成、指令下发、数据推送);

- 结果同步/归档:将执行结果同步至目标系统,归档任务日志、中间成果。

典型异常瞬间:执行至第3步校验时,触发2类高频报错------① 数据含违规/不合规内容,校验不通过;② 执行至第4步时,依赖的工具/接口调用失败、参数异常,核心任务无法推进。

辅助理解示例:跨境电商新品上架Agent

对应通用SOP的具体落地示例,方便直观理解异常场景:

- 抓取:从供应商ERP提取产品信息(对应"数据/指令抓取");

- 翻译与本地化:将产品描述翻译为目标市场语言(对应"数据处理/转换");

- 风控校验:校验敏感词、侵权风险(对应"规则/风控校验");

- 素材生成:调用AI生成营销图(对应"核心任务执行");

- 发布与同步:推送至平台后台、归档日志(对应"结果同步/归档")。

对应异常:第3步敏感词命中、第4步AI素材生成接口超时(与通用场景异常本质一致)。

核心技术痛点

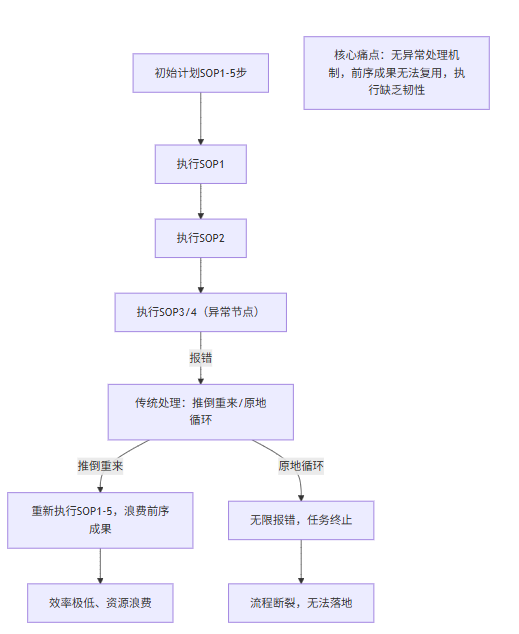

传统Agent的线性执行逻辑,面对上述异常时,存在3个核心技术短板,也是鲁棒性设计需解决的核心问题,可用逻辑图直观呈现:

-

无中间成果留存:前序步骤的执行成果(如处理后的数据、翻译文本)未留存,异常后需重新执行,浪费Token与时间;

-

异常判断模糊:无法精准识别异常类型(临时故障/可补偿异常/无法解决异常),盲目重试或终止;

-

缺乏修正机制:异常后无定向修正逻辑,仅能"全量重跑"或"直接终止",无法实现断点续跑。

二、核心技术破局:3套鲁棒性方案(附伪代码+逻辑图)

鲁棒性设计的核心逻辑:不轻易放弃前序执行成果,针对异常节点进行定向修正,实现"断点续跑",同时避免无效循环与资源浪费。以下3套方案从易到难,适配不同开发成本、业务复杂度,均提供通用伪代码、逻辑图,可直接复用至任意行业场景。

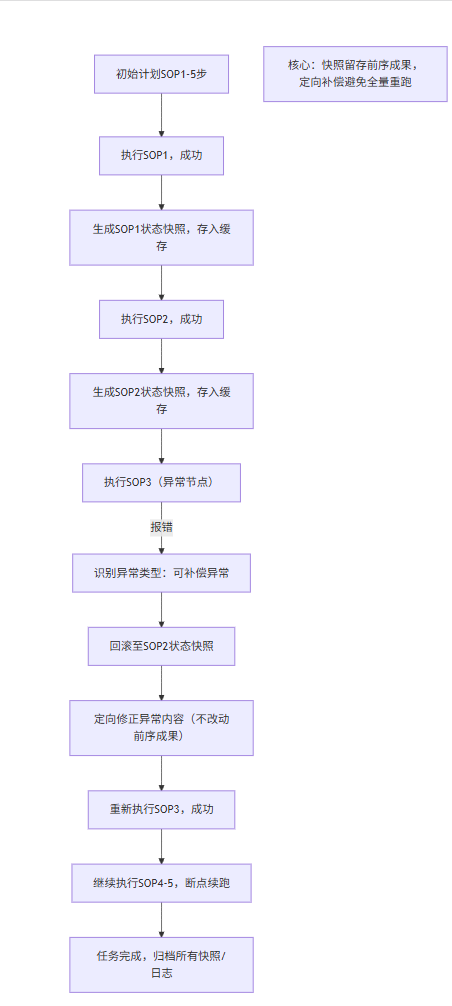

方案1:基础版------状态快照+定向补偿(低成本落地,适配中小团队)

通用核心思路:在每一步执行成功后,留存"状态快照"(关键变量、中间成果);异常时回滚至前一步快照,仅针对异常点补偿,不触动全局流程(通用无行业限制)。

1. 方案逻辑图

2. 通用伪代码

|----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

| python # 基础版:状态快照+定向补偿(通用鲁棒性方案) import redis # 推荐用Redis缓存快照,支持快速回滚 # 1. 初始化快照缓存(通用配置) snapshot_cache = redis.Redis(host='localhost', port=6379, db=0) MAX_RETRY = 2 # 补偿最大重试次数 def agent_execution(sop_steps): """ 通用Agent执行函数,支持状态快照、定向补偿、断点续跑 sop_steps: 列表,存储Agent的全流程SOP步骤(通用格式) """ current_step = 0 # 当前执行步骤索引 snapshot_data = {} # 存储所有步骤的快照数据 while current_step < len(sop_steps): step = sop_steps[current_step] step_name = step["name"] step_func = step["func"] # 步骤执行函数(通用,可适配任意场景) step_params = step["params"] # 步骤参数 try: # 执行当前步骤 step_result = step_func(** step_params) print(f"步骤{current_step+1} [{step_name}] 执行成功") # 生成当前步骤快照(留存中间成果,通用逻辑) snapshot_key = f"agent_snapshot_step_{current_step+1}" snapshot_data = { "step": current_step + 1, "result": step_result, # 步骤执行成果(如处理后的数据) "timestamp": datetime.now().strftime("%Y-%m-%d %H:%M:%S"), "params": step_params # 步骤参数,用于回滚后复用 } # 存入缓存(持久化,避免服务重启丢失) snapshot_cache.set(snapshot_key, json.dumps(snapshot_data)) # 执行下一步 current_step += 1 except Exception as e: # 捕获异常,触发局部修正逻辑 error_msg = str(e) print(f"步骤{current_step+1} [{step_name}] 执行失败:{error_msg}") # 1. 识别异常类型(通用判断逻辑,可扩展) if is_compensable_error(error_msg): # 可补偿异常(如内容违规、参数错误),执行定向补偿 retry_count = 0 while retry_count < MAX_RETRY: try: # 回滚至前一步快照(核心逻辑) if current_step == 0: # 第一步失败,无前置快照,直接重试当前步骤 step_params = adjust_params(step_params, error_msg) # 定向调整参数 continue else: # 回滚至前一步快照,复用前序成果 prev_snapshot_key = f"agent_snapshot_step_{current_step}" prev_snapshot = json.loads(snapshot_cache.get(prev_snapshot_key)) # 基于前序成果,定向修正异常 corrected_params = correct_error(prev_snapshot["result"], error_msg) # 更新当前步骤参数,重新执行 step["params"] = corrected_params retry_count += 1 continue except: retry_count += 1 # 补偿失败,推送人工提醒 if retry_count >= MAX_RETRY: send_alert(f"步骤{current_step+1} 补偿失败,请人工介入:{error_msg}") break else: # 不可补偿异常,直接推送人工提醒 send_alert(f"步骤{current_step+1} 执行失败(不可补偿):{error_msg}") break # 通用辅助函数(可直接复用,适配所有场景) def is_compensable_error(error_msg): """判断异常是否可补偿(通用逻辑,可扩展异常类型)""" compensable_errors = ["违规", "敏感词", "参数错误", "格式错误", "同义词替换"] return any(err in error_msg for err in compensable_errors) def correct_error(prev_result, error_msg): """定向修正异常(通用逻辑,可根据具体场景扩展)""" # 示例:敏感词/违规内容修正(通用,适配文本类校验异常) if "敏感词" in error_msg or "违规" in error_msg: sensitive_words = extract_sensitive_words(error_msg) # 提取异常关键词 for word in sensitive_words: prev_result = prev_result.replace(word, get_synonym(word)) # 同义词替换修正 # 示例:参数错误修正(通用) elif "参数错误" in error_msg: prev_result["params"] = adjust_params(prev_result["params"], error_msg) return prev_result # 示例:辅助理解------跨境电商场景的函数适配(仅示例,非核心) def extract_sensitive_words(error_msg): """提取敏感词(示例函数,可替换为任意场景的异常提取逻辑)""" return re.findall(r"敏感词:([^,。]+)", error_msg) |

3. 方案说明

优势:开发成本低,无需修改Agent核心架构,仅需增加快照缓存与补偿逻辑;可节省60%-80%的无效Token消耗,大幅提升执行效率,适配所有中小团队、简单自动化场景。

注意事项:仅适用于"内容类、参数类异常"(如敏感词、接口参数错误),无法应对"前提条件变更"(如依赖工具下线、核心规则迭代)。

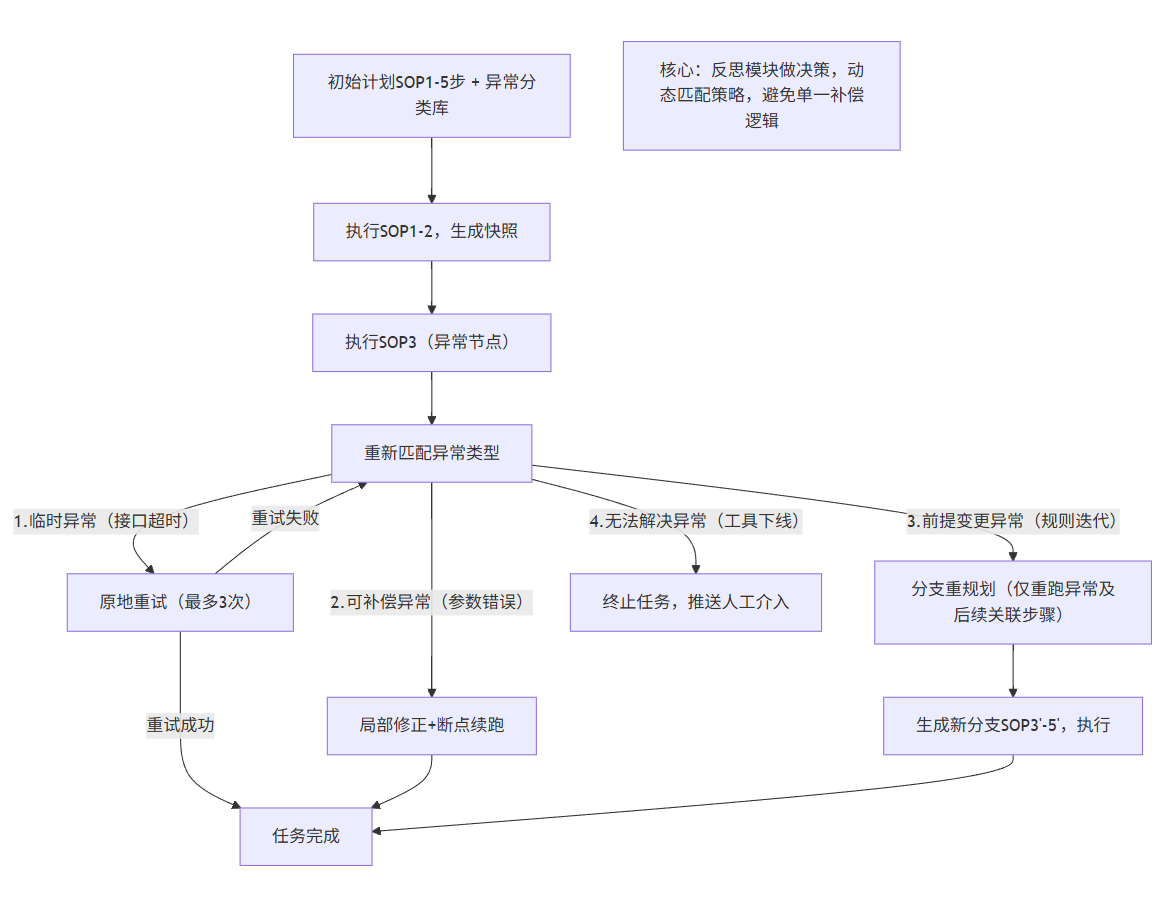

方案2:进阶版------分层反思机制+动态分支规划(中成本,适配中大型团队)

通用核心思路:引入"反思模块"(Agent的"异常决策中枢"),基于通用异常分类库,自动匹配异常处理策略(原地重试、局部修正、分支重规划),突破基础版方案的局限性,适配更复杂的动态场景。

1. 方案逻辑图

2. 通用伪代码

|--------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

| python # 进阶版:分层反思机制+动态分支规划(通用鲁棒性方案) import redis from typing import List, Dict # 1. 初始化:通用异常分类库(核心,可扩展至任意行业异常) EXCEPTION_CLASSIFY = { "临时可恢复异常": { "keywords": ["接口超时", "网络波动", "临时维护", "卡顿"], "strategy": "retry", # 处理策略:原地重试 "params": {"max_retry": 3, "interval": 30} # 重试参数(秒) }, "可补偿异常": { "keywords": ["敏感词", "违规", "参数错误", "格式错误"], "strategy": "local_correction" # 处理策略:局部修正 }, "前提变更异常": { "keywords": ["规则变更", "工具下线", "备货周期变更", "渠道停运"], "strategy": "branch_replan" # 处理策略:分支重规划 }, "无法解决异常": { "keywords": ["停产", "严重侵权", "账号受限", "权限不足"], "strategy": "terminate" # 处理策略:终止任务 } } # 2. 反思模块(通用,核心决策逻辑) class ReflectionModule: def init(self, exception_classify: Dict): self.exception_classify = exception_classify def classify_exception(self, error_msg: str) -> Dict: """通用异常分类:根据错误信息,匹配异常类型与处理策略""" for exception_type, config in self.exception_classify.items(): if any(keyword in error_msg for keyword in config["keywords"]): return {"exception_type": exception_type, "strategy": config["strategy"], "params": config.get("params", {})} # 未匹配到分类,默认推送人工介入 return {"exception_type": "未知异常", "strategy": "terminate", "params": {}} def decide_strategy(self, error_msg: str, current_step: int, snapshot_data: Dict) -> Dict: """通用决策逻辑:根据异常类型、当前步骤、快照数据,确定处理方案""" classify_result = self.classify_exception(error_msg) strategy = classify_result["strategy"] params = classify_result["params"] if strategy == "retry": return {"strategy": "retry", "max_retry": params["max_retry"], "interval": params["interval"]} elif strategy == "local_correction": # 定向修正,复用前序快照 prev_step = current_step - 1 if current_step > 0 else 0 prev_snapshot = snapshot_data.get(f"step_{prev_step}", {}) return { "strategy": "local_correction", "prev_snapshot": prev_snapshot, "error_msg": error_msg } elif strategy == "branch_replan": # 分支重规划,仅重跑异常及后续关联步骤 return { "strategy": "branch_replan", "current_step": current_step, "snapshot_data": snapshot_data, "error_msg": error_msg } else: return {"strategy": "terminate", "error_msg": error_msg} # 3. 通用Agent执行函数(集成反思模块) def advanced_agent_execution(sop_steps: List[Dict]): snapshot_cache = redis.Redis(host='localhost', port=6379, db=0) reflection_module = ReflectionModule(EXCEPTION_CLASSIFY) # 初始化反思模块 current_step = 0 snapshot_data = {} # 存储所有步骤快照 while current_step < len(sop_steps): step = sop_steps[current_step] step_name = step["name"] step_func = step["func"] step_params = step["params"] try: # 执行当前步骤,生成快照(同基础版,通用逻辑) step_result = step_func(** step_params) snapshot_key = f"step_{current_step}" snapshot_data[snapshot_key] = { "result": step_result, "params": step_params } snapshot_cache.set(snapshot_key, json.dumps(snapshot_data[snapshot_key])) print(f"步骤{current_step+1} [{step_name}] 执行成功") current_step += 1 except Exception as e: error_msg = str(e) print(f"步骤{current_step+1} [{step_name}] 执行失败:{error_msg}") # 反思模块决策,获取处理策略(通用核心) strategy = reflection_module.decide_strategy(error_msg, current_step, snapshot_data) # 执行对应处理策略(通用逻辑) if strategy["strategy"] == "retry": # 原地重试 for i in range(strategy["max_retry"]): time.sleep(strategy["interval"]) try: step_result = step_func(** step_params) print(f"重试{i+1}次,步骤{current_step+1}执行成功") # 更新快照,执行下一步 snapshot_data[f"step_{current_step}"] = {"result": step_result, "params": step_params} snapshot_cache.set(f"step_{current_step}", json.dumps(snapshot_data[f"step_{current_step}"])) current_step += 1 break except: continue else: send_alert(f"步骤{current_step+1} 重试{strategy['max_retry']}次失败,请人工介入") break elif strategy["strategy"] == "local_correction": # 局部修正,断点续跑 prev_snapshot = strategy["prev_snapshot"] corrected_params = correct_error(prev_snapshot["result"], error_msg) # 通用修正函数 step["params"] = corrected_params continue # 重新执行当前步骤 elif strategy["strategy"] == "branch_replan": # 分支重规划,生成新的后续步骤(通用逻辑) current_step_idx = strategy["current_step"] # 基于前序快照,重新规划当前及后续步骤 new_sop_steps = replan_steps( sop_steps, current_step_idx, strategy["snapshot_data"], error_msg ) # 替换原SOP,从当前步骤重新执行 sop_steps = new_sop_steps continue else: # 终止任务,推送人工介入 send_alert(f"步骤{current_step+1} 执行失败,无法解决:{error_msg}") break # 通用辅助函数(可扩展) def replan_steps(original_sop: List[Dict], current_step: int, snapshot_data: Dict, error_msg: str) -> List[Dict]: """通用分支重规划函数,根据异常调整后续步骤(可适配任意场景)""" new_sop = original_sop[:current_step] # 保留前序成功步骤 # 基于异常信息,重新生成当前及后续步骤(示例逻辑,可扩展) current_step_info = original_sop[current_step] if "规则变更" in error_msg: # 规则变更,更新校验步骤参数 current_step_info["params"]["rule_version"] = "latest" elif "工具下线" in error_msg: # 工具下线,替换核心执行函数 current_step_info["func"] = alternative_tool_func # 备选工具函数 # 追加重新规划的步骤 new_sop.append(current_step_info) new_sop.extend(original_sop[current_step+1:]) return new_sop |

3. 方案说明

优势:适配多类型异常,避免无效重试与单一补偿的局限;分支重规划可保留无关联的前序成果,灵活性更高,适配中大型团队、复杂自动化场景(如多工具联动、多规则约束)。

注意事项:需维护通用异常分类库,及时更新新增异常类型;反思模块的决策逻辑需持续优化,避免误判异常类型。

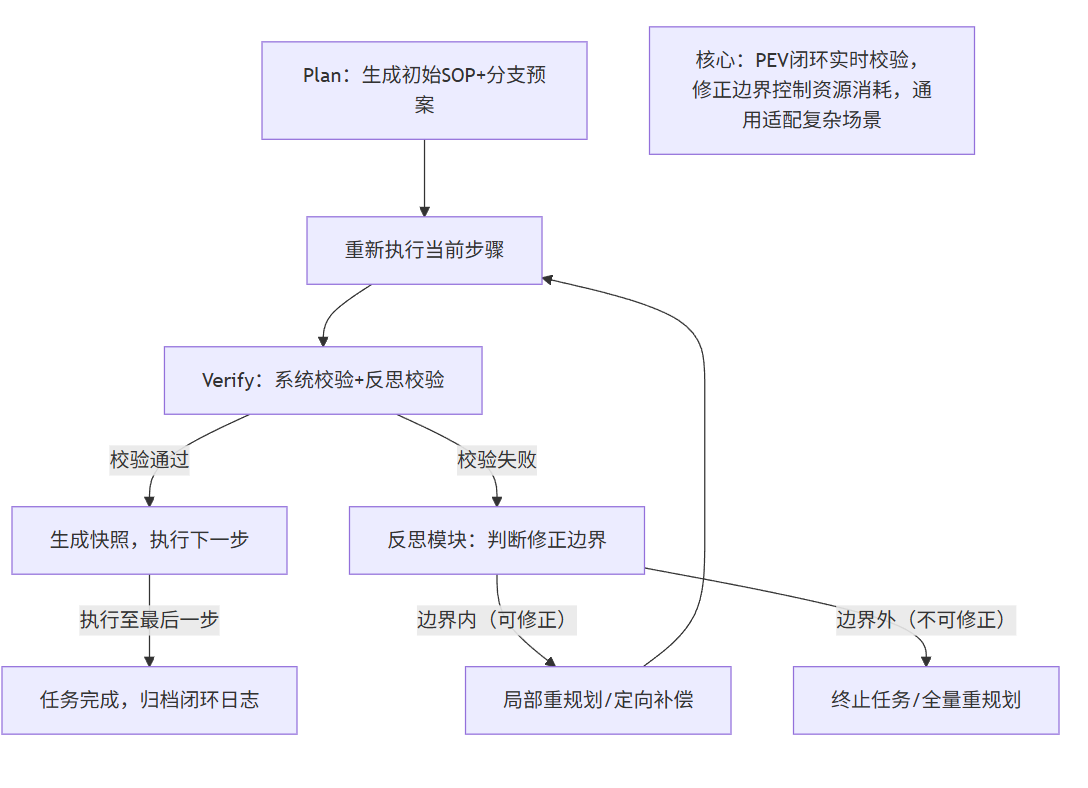

方案3:高级版------Plan-Execute-Verify(PEV)闭环+修正边界控制(高成本,适配头部企业)

通用核心思路:打破"线性执行"模式,构建"计划-执行-校验"通用闭环,每一步执行后均进行双重校验(系统校验+反思校验),异常时立即触发重规划;同时设置"通用修正边界",避免过度修正导致的资源浪费,实现"该修则修,该弃则弃"。

1. 方案逻辑图

2. 通用伪代码

|----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

| python # 高级版:PEV闭环+修正边界控制(通用鲁棒性方案) import redis import time # 1. 通用修正边界配置(核心,可适配所有场景) CORRECTION_BOUNDARY = { "max_correction_times": 2, # 单步骤最大修正次数(避免过度修正) "max_resource_cost": 100, # 最大资源消耗阈值(Token/时间,单位:Token) "abandon_threshold": 0.5, # 修正成本/重新执行成本 > 0.5,直接弃用局部修正 } # 2. PEV闭环核心类(通用,可复用) class PEVAgent: def init(self, exception_classify: Dict, correction_boundary: Dict): self.reflection_module = ReflectionModule(exception_classify) # 复用反思模块 self.boundary = correction_boundary self.snapshot_cache = redis.Redis(host='localhost', port=6379, db=0) self.resource_cost = 0 # 累计资源消耗(Token) self.correction_record = {} # 修正记录,key:步骤索引,value:修正次数 def plan(self, base_sop: List[Dict]) -> List[Dict]: """Plan:生成初始SOP+通用分支预案(基于历史异常数据)""" # 通用分支预案(可扩展,适配所有场景) branch_plans = { "tool_error": self._tool_error_plan, # 工具异常预案 "rule_error": self._rule_error_plan, # 规则异常预案 "param_error": self._param_error_plan # 参数异常预案 } # 为初始SOP添加预案关联 for step in base_sop: step["branch_plans"] = branch_plans return base_sop def execute(self, step: Dict) -> tuple[bool, any]: """Execute:执行步骤,返回执行结果(成功/失败)、执行成果""" step_func = step["func"] step_params = step["params"] try: self.resource_cost += 10 # 模拟消耗Token(每步固定消耗) result = step_func(** step_params) return True, result except Exception as e: self.resource_cost += 5 # 异常执行额外消耗Token return False, str(e) def verify(self, step: Dict, execute_result: any, step_index: int) -> tuple[bool, Dict]: """Verify:双重校验(系统校验+反思校验),通用逻辑""" # 1. 系统校验:执行结果是否符合预期 system_verify = self._system_verify(step, execute_result) if not system_verify: error_msg = f"系统校验失败:执行结果不符合预期" return False, {"error_msg": error_msg, "verify_type": "system"} # 2. 反思校验:是否存在潜在异常(如资源消耗过高、参数隐患) reflection_verify = self._reflection_verify(step, execute_result, step_index) if not reflection_verify: error_msg = f"反思校验失败:存在潜在异常" return False, {"error_msg": error_msg, "verify_type": "reflection"} return True, {"status": "success"} def _system_verify(self, step: Dict, result: any) -> bool: """通用系统校验逻辑(可扩展,适配任意场景)""" # 示例:校验执行结果非空、格式正确 if result is None: return False if step["name"] in ["数据处理/转换", "规则/风控校验"]: return isinstance(result, (dict, str, list)) # 校验数据格式 return True def _reflection_verify(self, step: Dict, result: any, step_index: int) -> bool: """通用反思校验逻辑(可扩展)""" # 1. 校验资源消耗是否超出阈值 if self.resource_cost > self.boundary["max_resource_cost"]: return False # 2. 校验当前步骤修正次数是否超出上限 correction_times = self.correction_record.get(step_index, 0) if correction_times > self.boundary["max_correction_times"]: return False return True def control_boundary(self, step_index: int, error_msg: str) -> str: """通用修正边界控制:判断是否继续修正(核心逻辑)""" correction_times = self.correction_record.get(step_index, 0) # 1. 修正次数超出上限,终止修正 if correction_times >= self.boundary["max_correction_times"]: return "terminate" # 2. 计算修正成本与重新执行成本的比例 correction_cost = 10 # 模拟单次修正成本 retry_all_cost = (step_index + 1) * 10 # 重新执行前序所有步骤的成本 if correction_cost / retry_all_cost > self.boundary["abandon_threshold"]: # 修正成本过高,放弃局部修正 return "abandon" # 3. 边界内,可继续修正 return "continue" # 通用分支预案(可扩展) def _tool_error_plan(self, step: Dict) -> Dict: """工具异常通用预案:替换备选工具""" step["func"] = alternative_tool_func # 备选工具函数 return step def _rule_error_plan(self, step: Dict) -> Dict: """规则异常通用预案:更新至最新规则""" step["params"]["rule_version"] = "latest" return step def _param_error_plan(self, step: Dict) -> Dict: """参数异常通用预案:自动校准参数""" step["params"] = adjust_params(step["params"]) return step def run(self, base_sop: List[Dict]): """通用Agent执行入口(集成PEV闭环、边界控制)""" sop_steps = self.plan(base_sop) # Plan:生成初始SOP+预案 current_step = 0 while current_step < len(sop_steps): step = sop_steps[current_step] step_name = step["name"] print(f"开始执行步骤{current_step+1} [{step_name}]") # Execute:执行步骤 execute_success, execute_result = self.execute(step) if not execute_success: error_msg = execute_result verify_result = (False, {"error_msg": error_msg, "verify_type": "execute"}) else: # Verify:双重校验 verify_success, verify_result = self.verify(step, execute_result, current_step) if verify_success: # 校验通过,生成快照,执行下一步 self._save_snapshot(current_step, execute_result, step["params"]) print(f"步骤{current_step+1} 执行、校验均通过") current_step += 1 continue else: error_msg = verify_result["error_msg"] # 异常处理:边界控制+策略执行 boundary_result = self.control_boundary(current_step, error_msg) if boundary_result == "terminate": send_alert(f"步骤{current_step+1} 修正次数超出上限,终止任务") break elif boundary_result == "abandon": send_alert(f"步骤{current_step+1} 修正成本过高,建议重新执行") break # 边界内,执行修正/重规划 self.correction_record[current_step] = self.correction_record.get(current_step, 0) + 1 strategy = self.reflection_module.decide_strategy(error_msg, current_step, self.load_snapshots()) if strategy["strategy"] == "local_correction": # 局部修正 corrected_step = correct_error(strategy["prev_snapshot"]["result"], error_msg) sop_steps[current_step]["params"] = corrected_step["params"] elif strategy["strategy"] == "branch_replan": # 分支重规划(复用预案) if "工具异常" in error_msg: sop_steps[current_step] = step["branch_plans"]["tool_error"](step) elif "规则异常" in error_msg: sop_steps[current_step] = step["branch_plans"]["rule_error"](step) print(f"步骤{current_step+1} 修正完成,重新执行") def save_snapshot(self, step_index: int, result: any, params: Dict): """通用快照保存逻辑""" snapshot_key = f"pev_snapshot_step{step_index}" snapshot_data = {"result": result, "params": params, "cost": self.resource_cost} self.snapshot_cache.set(snapshot_key, json.dumps(snapshot_data)) def load_snapshots(self) -> Dict: """通用快照加载逻辑""" snapshot_data = {} keys = self.snapshot_cache.keys() for key in keys: step_index = int(key.decode().split("")[-1]) snapshot_data[f"step{step_index}"] = json.loads(self.snapshot_cache.get(key)) return snapshot_data # 通用执行示例(可直接复用) if name == "main": # 定义通用SOP(适配任意场景) base_sop = [ { "name": "数据/指令抓取", "func": data_extract, # 通用数据抓取函数(可替换) "params": {"source": "interface", "url": "https://example.com/api/data"} }, { "name": "数据处理/转换", "func": data_process, # 通用数据处理函数(可替换) "params": {"format": "json"} }, # 可继续添加其他步骤... ] # 初始化PEV Agent,执行任务 pev_agent = PEVAgent(EXCEPTION_CLASSIFY, CORRECTION_BOUNDARY) pev_agent.run(base_sop) |

3. 方案说明

优势:鲁棒性最强,PEV闭环可实时捕获异常(避免执行完成后才发现问题),通用修正边界控制可避免过度修正、浪费资源;适配头部企业、超复杂自动化场景(如多系统联动、高并发任务、严格资源约束)。

注意事项:开发成本高,需构建PEV闭环架构、通用分支预案系统;需基于大量历史异常数据,优化校验逻辑、边界参数。

三、关键补充:异常修正边界判断

鲁棒性设计的核心技术误区:过度追求"局部修正",导致Agent在无效修正中循环,浪费更多资源。以下是修正边界判断标准,可直接嵌入Agent的反思模块、边界控制逻辑:

|---------|-------------------------|-----------------------|------------------------------------|

| 异常类型 | 具体场景示例 | 处理建议 | 判断依据 |

| 临时可恢复异常 | 接口超时、网络波动、平台/工具临时维护、卡顿 | 原地重试(最多3次,间隔30-60秒) | 异常不影响核心前提(如规则、工具、数据),且可在短时间内恢复 |

| 可补偿异常 | 敏感词命中、参数错误、格式错误、文本不通顺 | 局部修正(定向修改内容/参数)+ 断点续跑 | 异常仅影响当前步骤,不改变任务核心目标,修正成本低于重新执行前序步骤 |

| 前提变更异常 | 规则迭代、工具下线、核心参数变更、依赖故障 | 分支重规划(重执行异常节点及后续关联步骤) | 异常导致任务前提条件变更,但核心目标未消失,局部修正无法解决 |

| 无法解决异常 | 工具永久下线、权限不足、核心数据缺失、严重违规 | 终止任务 + 推送人工介入提醒 | 异常导致任务核心目标无法实现,或修正成本远超重新启动任务 |

四、落地避坑:鲁棒性设计的4个核心技术技巧

结合AI Agent工业化落地的经验,补充4个核心技术技巧,避免开发、落地踩坑,适配所有行业场景:

技巧1:缓存"高频异常修正模板",提升通用适配性

无论哪个行业,Agent的异常场景都具有高频重复性(如参数错误、接口超时、格式错误),可提前缓存修正模板,Agent触发异常时直接调用,无需重新生成修正方案,降低开发成本:

- 修正模板:参数错误修正模板、文本违规修正模板、接口超时重试模板;

- 落地方式:将模板存入配置文件,异常时根据异常类型匹配调用,无需针对不同行业单独开发。

技巧2:限制"修正次数+资源消耗"双阈值,避免无效循环

在Agent底层配置双阈值:① 单步骤最大修正次数(建议2次);② 累计资源消耗阈值(Token/时间),若超出任一阈值,立即终止修正、推送人工提醒,避免无限循环浪费资源。

技巧3:引入"人工介入触发阈值",平衡自动化与安全性

针对高风险异常(如权限不足、严重违规、核心工具故障),设置通用人工介入触发阈值,Agent无法判断或修正时,立即触发人工介入,避免因Agent误判导致的业务损失、合规风险(适配所有对安全性有要求的场景)。

技巧4:设计"通用异常分类库迭代机制",适配动态变化

无论是规则迭代、工具更新,还是新增异常类型,都需建立通用异常分类库的迭代机制(每周更新),补充新的异常类型、处理策略、修正模板,避免Agent因异常分类滞后导致的执行失败,提升通用适配性。

五、结语:鲁棒性,是AI Agent工业化落地的核心技术壁垒

AI Agent的工业化落地,核心不在于"能执行多少步骤",而在于"能稳定执行多少步骤"------无论跨境电商、金融、工业,还是企业办公,动态变化的外部环境(规则、工具、数据)都是Agent执行的"必经考验"。

本文聚焦的鲁棒性设计,本质是解决一个通用技术问题:如何让AI Agent摆脱"线性执行"的局限,具备"异常感知、定向修正、断点续跑"的能力。从基础版的状态快照,到进阶版的分层反思,再到高级版的PEV闭环,3套方案梯度适配不同团队、不同场景,搭配通用伪代码、逻辑图,可直接复用、快速落地。

对于开发者而言,与其追求"完美的初始SOP",不如聚焦"鲁棒性这一通用技术核心"------无需针对不同行业重复开发异常处理逻辑,基于本文的通用方案、伪代码、边界标准,即可快速适配任意场景,让AI Agent真正实现工业级稳定落地,成为可信赖的"数字员工"。