在音视频SDK的选型中,"能跑Demo"和"能上线系统"之间,隔着的不是一行代码,而是一整套工程化的架构决策。本文以大牛直播SDK(SmartMediaKit)为蓝本,从协议栈原理出发,逐模块拆解其技术设计,探讨一套全自研流媒体内核如何在超低延迟、跨平台、模块化三个维度上同时做到极致。

一、为什么还需要谈RTMP/RTSP?

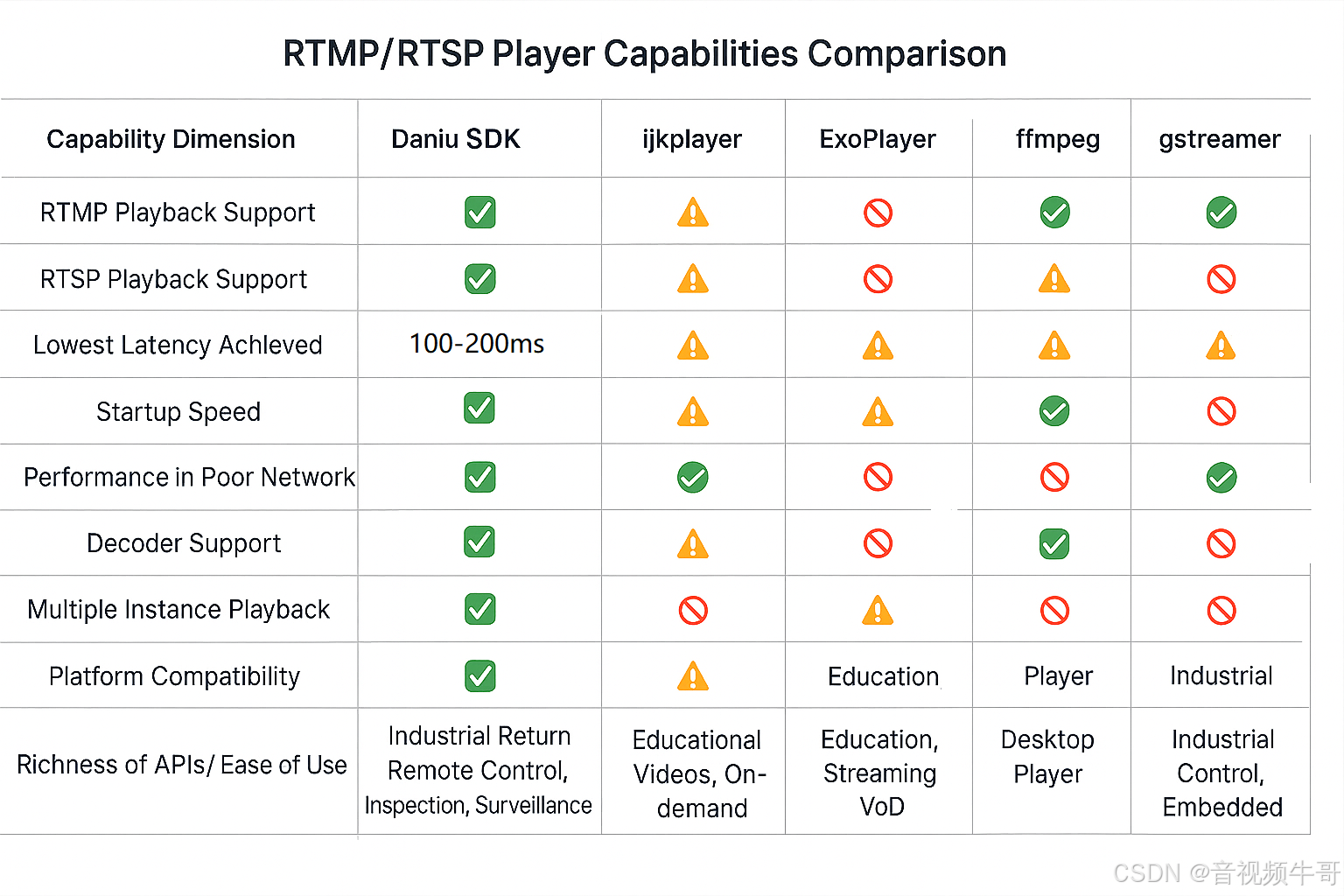

WebRTC如日中天,SRT势头正猛,WHIP/WHEP标准呼之欲出------在这样的背景下,谈论RTMP和RTSP似乎显得"过时"。但真实的产业场景告诉我们另一个故事:

安防监控领域 ,全球数十亿路IPC摄像头中,RTSP仍然是绝对的主力协议。ONVIF标准下的设备发现与媒体流获取,底层就是RTSP/RTP。工业互联网场景 ,电力巡检、智慧水利、管廊隧道中的嵌入式终端,往往运行在受限的ARM Linux环境上,WebRTC那套ICE/DTLS/SRTP的协议栈既臃肿又不必要------内网环境下根本不需要NAT穿透。教育与会议场景,无纸化推屏、电子教室的同屏方案,对延迟的要求是毫秒级的确定性,而不是WebRTC那种"统计意义上的低延迟"。

大牛直播SDK的技术定位,恰恰锚定在这个被很多人忽视的工程地带:在绝大多数低延迟业务中,RTSP+RTMP已经足够,关键在于你的实现够不够极致。

Windows平台毫秒级延迟RTSP播放器延迟测试

二、模块全景:一张图看懂SmartMediaKit

大牛直播SDK自2015年起持续演进,目前形成了覆盖Windows、Linux(x86_64/aarch64)、Android、iOS全平台的模块矩阵。其核心设计哲学可以概括为八个字:功能正交,自由组合。

bash

┌─────────────────────────────────────────────────────────────┐

│ 大牛直播SDK 模块全景 │

├──────────────┬──────────────┬──────────────┬────────────────┤

│ 采集与推送层 │ 服务与转发层 │ 播放与渲染层 │ 扩展功能层 │

├──────────────┼──────────────┼──────────────┼────────────────┤

│ RTMP推流SDK │ 轻量级RTSP │ RTMP播放器 │ SEI扩展数据 │

│ RTSP推流SDK │ 服务SDK │ RTSP播放器 │ 收发SDK │

│ 屏幕/摄像头 │ 内网RTSP │ HTTP-FLV │ 一对一互动SDK │

│ 采集 │ 网关SDK │ 播放器 │ 导播/合流SDK │

│ Unity3D推送 │ 多路RTSP/ │ Unity3D │ 录像SDK │

│ GB28181接入 │ RTMP转RTMP │ 播放器 │ 音频混音 │

│ │ 转发SDK │ │ 噪音抑制 │

└──────────────┴──────────────┴──────────────┴────────────────┘这里的"正交"不是修辞------推送、播放、录像、转发、内置RTSP服务这五大核心能力,在代码层面是完全解耦的。你可以只推送不播放,可以只录像不推送,可以一边转发一边录像,任意组合不会产生耦合冲突。这在工程上意味着:集成方只引入需要的模块,包体积可控,运行时资源占用最小化。

三、推送端:不止是把数据丢出去

3.1 RTMP推流的工程细节

表面上看,RTMP推流就是"采集→编码→封装→发送"四步。但工程落地时,每一步都有大量的决策点。

编码策略的权衡 :大牛直播SDK在Windows和Android平台均支持RTMP扩展H.265推送。Windows端针对摄像头采集场景使用H.265可变码率软编码,相比H.264能节省30%~50%的带宽,画质效果直逼传统H.265编码摄像头。Android端则走H.265硬编码路线,利用SoC的硬件编码器降低CPU占用。这里体现的是一个朴素但重要的原则:同一个功能在不同平台上的最优实现路径可能完全不同。

采集源的多样性:Windows平台推送SDK支持摄像头采集、屏幕采集(支持裁剪和窗口级采集)、摄像头与屏幕的画面合成,甚至支持多图层叠加。Android平台则支持屏幕录制(屏幕投影)、音频播放采集、麦克风采集等多种数据源。这种对采集源的充分抽象,使得SDK能适配从常规直播到工业巡检、从远程教学到执法记录等差异极大的业务场景。

外部编码数据接入:SDK提供了扩展数据接口,允许上层应用将已编码的H.264/H.265/AAC/PCMA/PCMU数据直接注入推流通道。这个设计至关重要------它意味着SDK不强制绑定自己的编码器,第三方模块编码后的数据可以直接对接推送,整个链路不涉及解码和重编码,延迟和资源占用都降到了最低。

3.2 RTSP推流的差异化实现

RTSP推流SDK在功能上对齐了RTMP推流SDK的全部能力(除协议栈差异外),并在此基础上增加了RTSP特有的能力:TCP/UDP传输模式可配置、RTSP鉴权模式与401挑战响应处理、断网重连与异常网络状态机管理。Windows端64位库还支持RTSP H.265视频输出。

一个容易被忽略的工程点是:RTSP推流和轻量级RTSP服务是两个不同的模块,解决的是不同的问题。RTSP推流是把本地数据推送到远端RTSP服务器,而轻量级RTSP服务是把本端变成一个RTSP服务器供其他客户端拉取。搞清楚这个区别,在做内网方案选型时至关重要。

安卓采集摄像头和麦克风实现低延迟RTMP推流

四、轻量级RTSP服务:边缘计算时代的杀手级模块

如果只能推荐大牛直播SDK的一个模块,我会选轻量级RTSP服务SDK。它解决的问题极其精准:内网场景下,如何在不部署任何服务器的前提下,实现超低延迟的一对多音视频分发?

4.1 架构原理

传统的内网直播方案是"推送端→RTMP服务器→播放端"三节点架构,这意味着你需要部署和维护一台流媒体服务器(如SRS、Nginx-RTMP等),还要承担服务器带来的额外延迟。

轻量级RTSP服务SDK的做法是:在推送端内嵌一个RTSP Server。推送端SDK原本支持的所有功能(摄像头/屏幕采集、H.264/H.265编码、音频处理等)继续生效,同时数据被注入到内置的RTSP服务中。其他设备通过标准RTSP协议直接拉流,无需中间服务器,延迟降到最低。

bash

传统方案: 推送端 ──RTMP──→ 服务器 ──RTMP/RTSP──→ 播放端(延迟叠加)

轻量级RTSP: 推送端(内置RTSP Server) ←──RTSP──── 播放端(直连,超低延迟)4.2 内网RTSP网关:进一步的架构延伸

在轻量级RTSP服务的基础上,大牛直播SDK还提供了内网RTSP网关SDK。它的工作原理是:从外部拉取RTSP/RTMP流(比如公网的摄像头),将数据注入到内置的轻量级RTSP服务中,内网客户端直接从网关获取数据,无需每个客户端都去公网拉流。

这个设计在带宽受限的场景下价值巨大。假设你需要让内网设备同时观看一路公网摄像头,没有网关的情况下需要多条公网连接;有了网关,只需1条公网连接加内网转发。同时,网关还承担了协议转换的角色,支持将RTSP/RTMP的H.265数据透传给内网客户端。

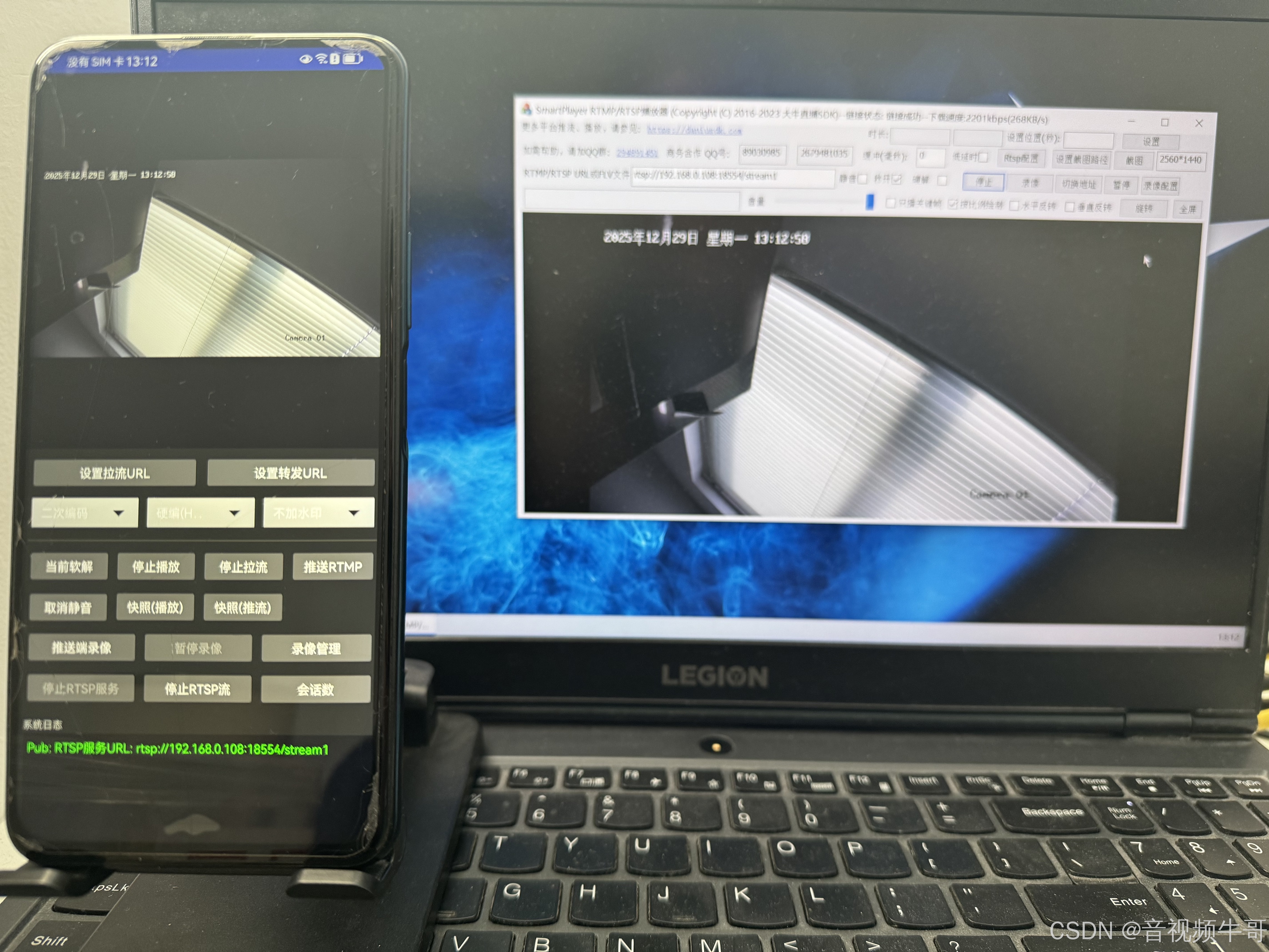

iOS平台RTSP播放器时延测试(100-200ms延迟)

五、播放端:延迟的最后一公里

5.1 超低延迟的实现路径

大牛直播SDK的播放端在RTMP协议下可实现100-200ms的端到端延迟(低延迟模式),RTSP协议下Android端实测可达100-200ms。这个数字在业内处于第一梯队。

实现超低延迟的核心不是某一个"黑科技",而是整条链路上每个环节的精细优化:

协议层:RTMP播放SDK实现了"秒开"机制------连接建立后,快速定位到最新的关键帧开始解码,跳过缓冲区中的历史数据。这需要对RTMP的FLV tag结构有精确的解析和控制能力。

解码层:支持软解码和硬解码的自动切换策略。以iOS平台为例,优先尝试H.265硬解码,如果设备不支持则自动降级到软解码,整个过程对上层透明。Android平台对不同SoC芯片的硬解码器做了大量的兼容性适配。

渲染层:Windows平台优先使用D3D渲染,相比GDI模式绘制更细腻、效率更高、CPU占用更低。SDK内部会检测系统是否支持D3D,不支持时自动切换到GDI模式。

缓冲策略:提供buffer状态回调和实时带宽占用接口,上层应用可以据此实现自适应的缓冲策略。在娃娃机等对操控实时性要求极高的场景中,可以配置零缓冲模式。

5.2 功能的完备性

播放端SDK的接口覆盖了工程部署中几乎所有常见需求:实时快照、播放端录像、实时静音/取消静音、View旋转(0°/90°/180°/270°)、快速切换URL(同参数配置下切换URL时录像不中断)、音视频数据回调(用于AI算法对接)、超高帧率播放支持等。

值得一提的是播放端录像这个功能。它与推送端录像完全独立------你可以在播放的同时录像,也可以不播放只录像,甚至可以在同一参数配置的多个URL间实时切换时,持续录制到同一个MP4文件中。这在安防回放、执法取证等场景中,解决了"URL切换导致录像文件碎片化"的痛点。

六、转发模块:不解码、不重编、零损耗

多路RTSP/RTMP转RTMP推送SDK在架构上非常精巧:播放端SDK拉取RTSP/RTMP流,将编码后的音视频数据回调到上层,然后通过推送端SDK的扩展数据接口完成RTMP转发。整个过程不涉及解码和重编码。

这意味着:

- 画质零损耗:数据是编码态的直接透传,不存在"解码→重编码"带来的代际质量损失。

- 资源占用极低:不需要解码器和编码器的运算开销,单机可轻松支持多路并发转发。

- 延迟最小化:省去了解码和重编码的处理时间,转发引入的额外延迟几乎可以忽略。

Windows平台还提供了官方定制版的多路转发工具,图形化配置转发参数,并内置守护进程和开机自启动能力,适合无人值守的部署场景。

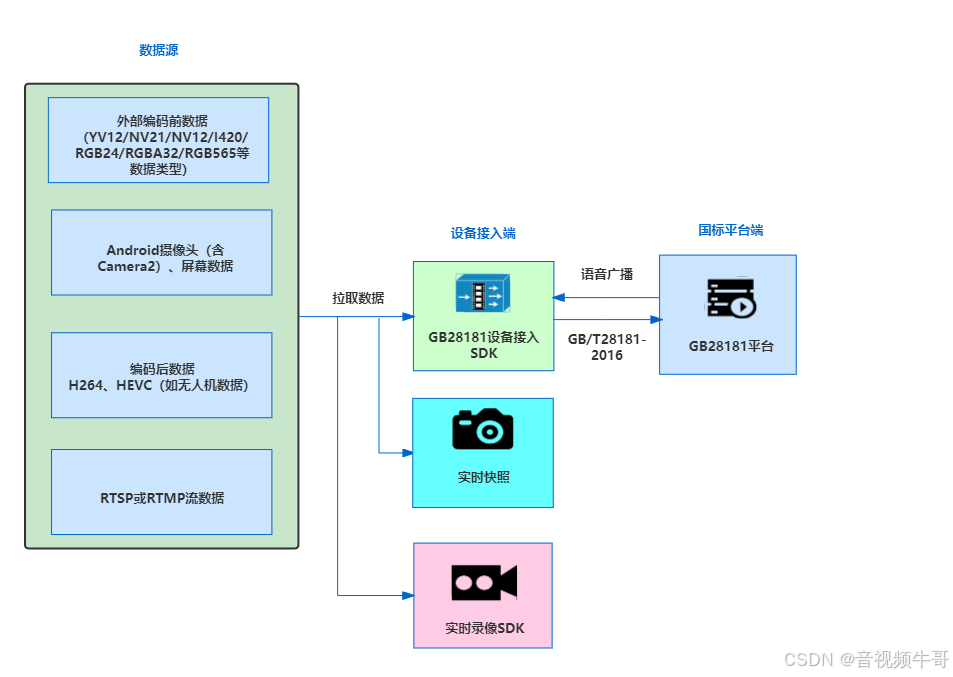

七、GB28181接入:让Android终端说"国标语言"

GB28181(GB/T 28181-2016)是公安部主导的视频监控联网标准,在智慧城市、安防、应急指挥等领域是刚性要求。传统上,GB28181接入是大型NVR/DVR设备和专用嵌入式硬件的能力。

大牛直播SDK推出的Android平台GB28181接入SDK(SmartGBD),让不具备国标音视频能力的Android终端------比如执法记录仪、车载设备、手持智控器------能够通过标准的SIP信令流程注册接入到GB28181服务平台。

从技术实现上看,这个模块需要处理几个难点:

SIP信令栈:实现REGISTER注册、INVITE媒体协商、BYE会话释放等标准SIP事务,以及GB28181特有的目录查询(Catalog)、设备控制(DeviceControl)等扩展消息。

媒体传输:按照国标要求,通过PS(Program Stream)封装音视频数据,使用RTP协议传输。这与RTMP/RTSP的封装方式完全不同,需要独立的封装和传输模块。

语音对讲:GB28181平台的语音广播和语音对讲是高频需求但实现难度大的功能。尤其是语音对讲,不仅要解决跨网段传输问题,还需要处理回音消除、噪音抑制、自动增益控制等音频处理。大牛直播SDK在这些音频处理算法上有多年的技术积累,能够在复杂网络环境下实现稳定的双向语音通信。

八、SEI扩展数据:音视频流中的"暗通道"

SEI(Supplemental Enhancement Information)是H.264/H.265标准中定义的补充增强信息,大牛直播SDK利用这个机制实现了一套数据透传方案:推送端将文本或二进制数据嵌入到视频流的SEI NAL单元中,播放端解析后回调给上层应用。

这个看似简单的功能,在实际业务中打开了很多想象空间:

- 实时字幕/公告广播:推送端将字幕文本或公告内容通过SEI分发,所有播放端实时接收并展示,无需额外的信令通道。

- 时间戳同步:推送端将绝对时间戳嵌入SEI,播放端据此实现精确的音画同步校验。

- 在线教育互动:推送端将激光笔的坐标、涂鸦的笔迹数据通过SEI传输,播放端实时渲染划线、划圈等标注效果。

- 题目分发:在直播答题场景中,通过SEI将题目信息同步到所有观众端,保证题目展示与视频画面严格对齐。

相比WebSocket等独立的数据通道,SEI方案的优势在于:数据与视频帧天然绑定,不存在时间对齐问题。这在对同步精度要求高的场景中(如教育互动、远程标注)是不可替代的。

九、Unity3D集成:打通虚拟与现实的最后一环

Unity3D作为游戏引擎在虚拟仿真、VR/AR教育、数字孪生等领域的广泛应用,催生了在Unity环境下进行低延迟音视频推拉流的刚性需求。

大牛直播SDK的Unity3D方案覆盖了Windows、Linux、Android、iOS四个平台:

- 推送端:采集Unity窗体画面(Windows/Android)、摄像头或屏幕数据(Windows),通过原生RTMP推流SDK编码传输,同时支持内置轻量级RTSP服务。

- 播放端:在Unity场景中嵌入RTMP/RTSP低延迟播放器,将视频帧渲染到Unity的Texture上,支持快照、录像、静音、旋转等全部播放端功能。

工程层面的关键挑战在于Unity的渲染线程与SDK的解码线程之间的数据同步。大牛直播SDK在native层完成解码后,通过高效的纹理共享机制将帧数据传递给Unity的渲染管线,避免了CPU端的像素拷贝开销。

Android平台Unity3D下RTMP播放器延迟测试

十、导播与合流:多路流的实时编排

导播SDK(Windows平台)支持从多种数据源------RTMP/RTSP音视频流、本地摄像头/屏幕、FLV文件------拉取数据,经过实时合成、画面布局、音频混音后,输出为单路RTMP流推送。

这个模块的技术含量主要体现在:

实时解码与合成的流水线设计:多路流需要同时解码、缩放、合成到一个画布上,每一帧的处理时间必须严格控制在一帧周期内(如30fps下约33ms),否则就会出现卡顿。

音频混音的同步问题:不同来源的音频流可能有不同的采样率和帧长,混音前需要进行重采样和时间对齐。SDK支持音频格式的自动转换(如PCMU/PCMA/Speex转AAC),混音后统一输出。

动态布局切换:支持在直播过程中实时切换画面布局------单屏、画中画、分屏------不中断推流,对观看端透明。

十一、录像模块:被低估的工程关口

录像看起来是最"简单"的功能------不就是把数据写到文件里吗?但在工程实践中,录像模块承载的需求远比想象的复杂:

- 格式兼容:支持H.265录制到MP4,这在业内并不普遍,很多SDK只支持H.264的录制。

- 音频转码:支持将PCMU、PCMA、Speex等音频格式转AAC后再录制,确保MP4文件的通用播放兼容性。

- 纯音频/纯视频/音视频三种模式:安防场景可能只需要视频,会议纪要可能只需要音频,常规直播需要音视频同录。

- 录像与推送/播放完全解耦:可以随时开启/停止录像,不影响推送和播放状态。

- 文件大小控制:支持设置单个录像文件的最大大小,自动分片切割。

- 跨URL持续录制:同参数配置下切换URL时,自动录制到同一个MP4文件,不产生新的文件碎片。

十二、跨平台的代价与收益

大牛直播SDK覆盖Windows、Linux(x86_64+aarch64)、Android、iOS五个平台(Linux算两个架构),对外提供C++/C#(Windows/Linux)和Java/Objective-C(移动端)接口。

跨平台不是简单的"同一套代码编译到不同平台"。核心流媒体内核可以跨平台复用,但采集层(摄像头/屏幕/音频设备的访问方式)、编解码层(硬件编解码器的接口和行为差异)、渲染层(D3D/OpenGL ES/Metal的选择)都需要针对每个平台做专门的实现和深度优化。

大牛直播SDK选择的是统一接口、平台适配的策略:对上层暴露一致的API语义(C++和C#接口一一对应),内部针对每个平台的特性选择最优的实现路径。比如Windows端支持D3D/GDI双渲染引擎自动切换,Android端针对不同SoC的硬解码器做兼容性矩阵测试,iOS端利用VideoToolbox进行H.265硬解。

这种策略的收益是显著的:集成方只需要学习一套API,即可在多个平台上部署;SDK内部吸收了平台差异带来的复杂度,上层应用不需要为每个平台写不同的适配代码。

十三、写在最后:关于"做底座不做平台"

"我们选择做底座不做平台。我们的使命是让别人可以放心地基于我们构建平台。"

流媒体SDK市场上不乏功能华丽的产品,但真正在生产环境中长时间稳定运行的方案并不多。大牛直播SDK选择了一条看起来"笨"但长远来看更扎实的路径:全自研内核,模块化解耦设计(每个功能可独立使用),坚持标准协议(不造私有协议的轮子),以及持续的工程化打磨。

对于正在做技术选型的开发者,不要被Demo的效果迷惑,要看SDK在你的目标平台、目标网络环境、目标并发规模下的表现。 拿一路RTSP流跑起来播放很简单,同时拉16路1080p流在一块4K屏上稳定渲染30分钟不掉帧不涨内存------这才是区分工程级SDK和Demo级SDK的试金石。

📎 CSDN官方博客:音视频牛哥-CSDN博客