随着大语言模型(LLMs)的快速发展,从技术原理到工程实践,一系列核心问题成为学习者与开发者的重点关注方向。本文将针对11个大模型高频问题,逐一拆解原理、补充细节、梳理逻辑,涵盖激活函数、生成问题、长文本处理、模型体系、训练优化等关键维度,帮你构建完整的大模型知识框架。

一、大模型常用激活函数汇总

激活函数是大模型引入非线性表达能力的核心组件,直接影响模型训练效率、泛化能力与收敛稳定性。主流激活函数及特性如下:

1. ReLU(Rectified Linear Unit)

最基础且经典的激活函数,公式为 f(x)=max(0,x)。核心优势在于计算高效、无梯度饱和问题,能有效缓解深层网络的梯度消失,大幅加快训练速度。但存在"死亡ReLU"缺陷------当输入长期为负时,神经元永久失效,后续模型多通过变种(如Leaky ReLU、PReLU)优化这一问题。

2. GeLU(Gaussian Error Linear Unit)

基于高斯分布设计的平滑非线性激活函数,公式为 f(x)=0.5x[1+erf(2x)](erf 为误差函数)。相较于ReLU,GeLU具备自适应性与平滑性,能提供更优的泛化能力和训练稳定性,是BERT、GPT系列、LLaMA等主流大模型的首选激活函数。

3. Swish

融合自门控机制的激活函数,公式为 f(x)=x⋅σ(βx)(σ 为sigmoid函数,β 为可训练参数或固定值)。通过sigmoid对输入进行门控调节,能自适应增强有效特征、抑制冗余信息,非线性表达能力更强,在部分大模型微调场景中性能优于ReLU和GeLU。

二、LLMs"复读机"问题:成因与本质

"复读机"问题指大模型生成文本时,重复输出已生成内容(短语、句子甚至段落),是生成式大模型的常见缺陷,核心成因源于模型训练与结构特性:

核心诱因

- 训练数据影响:训练语料中存在大量重复模式(如宣传文案、重复表述),模型会学习并复刻这些模式,生成时陷入局部最优解。

- 注意力机制失效:处理长序列时,自注意力机制难以有效捕捉全局上下文,对过往生成信息的权重分配失衡,导致过度聚焦于局部片段。

- 上下文依赖过度:因果语言模型(Causal LM)仅依赖前文生成后续内容,缺乏对全局语义的把控,若前文存在重复元素,模型易陷入循环生成。

- 生成概率偏向:部分高频词汇/短语的生成概率过高,模型在采样时反复选择这些元素,形成重复输出。

三、大模型处理长文本的核心方案

大模型的上下文窗口长度存在天然限制(如GPT-3为2048 Token),处理超长文本(如书籍、报告)需通过针对性策略突破限制,主流方案分为两类:

1. 内存机制优化

通过外部存储扩展模型的"记忆能力",实现长文本信息的存储与高效检索:

- 外部记忆模块:引入独立的记忆库(如向量数据库、缓存队列),将长文本拆解为片段存入,生成时通过检索机制调用相关片段,而非依赖模型内部上下文窗口。

- 缓存复用策略:对已处理的文本片段特征进行缓存,后续处理关联内容时直接复用,减少重复计算,同时保留关键上下文信息。

2. 文本分块处理

将长文本分割为符合模型上下文窗口的小块,通过分治思想逐一处理,再融合结果:

- 基础分块:按固定Token长度拆分(如每块1024 Token),处理后通过摘要、拼接等方式整合结果,适用于对上下文连贯性要求较低的任务(如文本分类、信息提取)。

- 智能分块:基于语义边界(句子、段落、主题)拆分,避免破坏文本语义完整性,搭配交叉注意力机制融合块间信息,适用于长文本生成、问答等任务。

补充:近年来也出现了原生支持超长上下文的模型(如GPT-4 Turbo支持128k Token),通过优化注意力机制(如FlashAttention)降低长序列计算成本,从模型结构层面突破限制。

四、主流开源大模型体系盘点

目前开源大模型形成了三大核心体系,各自基于Transformer架构衍生,适配不同任务场景:

1. GPT系列(Generative Pre-trained Transformer)

由OpenAI提出的Decoder-only架构模型,核心定位为生成式任务。采用因果语言模型(Causal LM)训练,擅长文本生成、多轮对话、代码生成等场景,开源生态以社区复刻版(如Llama系列、Falcon)为主,具备良好的工程化适配性。

2. BERT系列(Bidirectional Encoder Representations from Transformers)

由Google提出的Encoder-only架构模型,基于双向注意力机制训练,核心优势在于理解类任务(如文本分类、命名实体识别、语义检索)。开源版本丰富(如DistilBERT、RoBERTa),参数量从数百万到数十亿不等,适配轻量与高性能场景。

3. T5系列(Text-to-Text Transfer Transformer)

由Google提出的Encoder-Decoder架构模型,将所有NLP任务统一转化为"文本到文本"格式(如分类任务输出标签文本、翻译任务输出目标语言文本)。通用性极强,支持生成、理解、翻译等多类任务,开源生态完善,是跨任务微调的优选模型。

五、Prefix LM 与 Causal LM 的核心区别

Prefix LM(前缀语言模型)与Causal LM(因果语言模型)是大模型两种核心训练范式,本质差异在于生成方式、训练目标与上下文利用能力:

1. Causal LM(因果语言模型)

- 核心特性:自回归生成模型,仅能基于前文(左侧上下文)预测后续内容,无法利用后文信息,注意力矩阵为下三角矩阵(屏蔽后文信息)。

- 训练目标:给定前序Token序列,预测下一个Token的概率,即 P(xt+1∣x1,x2,...,xt)。

- 适用场景:文本生成、多轮对话、代码生成,典型代表为GPT系列、Llama系列。

2. Prefix LM(前缀语言模型)

- 核心特性:混合生成范式,将输入序列分为"前缀部分"与"生成部分",前缀部分可利用双向上下文(类似BERT),生成部分采用自回归方式(类似Causal LM)。

- 训练目标:基于前缀部分的双向上下文,预测生成部分的后续Token,兼顾理解能力与生成能力。

- 适用场景:兼具理解与生成的任务(如文本摘要、机器翻译、对话生成),典型代表为PrefixGPT、UniLM。

核心区别总结

Causal LM 仅依赖前文,专注生成任务,工程实现简单;Prefix LM 可利用前缀双向上下文,兼顾理解与生成能力,灵活性更强,但模型结构与训练复杂度更高。

六、LLMs Tokenizer 详解:BPE算法核心流程

Tokenizer(分词器)是大模型处理文本的前置核心模块,负责将自然语言转化为模型可识别的Token序列,主流大模型(如GPT、BERT)均采用BPE(Byte-Pair Encoding,字节对编码)算法,兼具字符级与词级分词的优势。

BPE算法核心流程(以"hello world"为例)

- 初始化词典:将文本拆分为最小单位(字符),构建初始词典。示例:{'h', 'e', 'l', 'o', ' ', 'w', 'r', 'd'}。

- 统计频率:统计语料库中所有相邻字符对的出现频率。示例"hello world"中,频率统计为:h:1, e:1, l:3, o:2, ' ':1, w:1, r:1, d:1,相邻字符对"el":1、"ll":2、"lo":1等。

- 合并高频对:找到频率最高的相邻字符对,合并为新子词,加入词典。示例中"ll"频率最高,合并为"ll",更新词典为{'h', 'e', 'l', 'o', ' ', 'w', 'r', 'd', 'll'}。

- 更新文本与重复:用新子词替换原文本中的对应字符对,重复"统计频率-合并高频对"步骤,直至达到预设合并次数或词典大小上限。

- 构建最终词典:经过多轮合并,词典包含字符、高频子词、短语等,既能覆盖常见词汇,又能处理未登录词(如新词、生僻词)。

BPE算法优势

通过动态合并子词,平衡词典大小与分词精度,避免词级分词的未登录词问题和字符级分词的语义割裂问题,是大模型处理多语言、复杂文本的最优解之一。

七、RLHF 实践中的核心不足

RLHF(Reinforcement Learning from Human Feedback,基于人类反馈的强化学习)是大模型对齐人类偏好的核心技术,但在工程实践中存在诸多痛点,限制其大规模落地:

- 人类反馈成本高昂:RLHF需大量高质量人类标注(如对模型生成结果打分、排序、修正),标注人员需具备专业能力(尤其是垂直领域),且标注过程耗时耗力,导致反馈数据的获取成本极高,难以规模化扩展。

- 错误反馈的连锁影响:人类反馈存在主观性、偏差性(如标注人员认知差异、疲劳导致的错误),若错误反馈被模型学习,会导致模型生成偏差,且这种偏差在强化学习迭代中会被放大,难以修正。

- 反馈数据分布不均:反馈数据多集中于常见场景(如日常对话、通用问答),垂直领域(如医疗、法律)反馈数据稀缺,导致模型在小众场景下的偏好对齐效果差,泛化能力不足。

- 训练稳定性与收敛问题:RLHF训练流程复杂(分为SFT监督微调、RM奖励模型训练、RL强化学习三阶段),各阶段参数易出现不兼容,导致模型训练震荡、收敛缓慢,甚至出现性能退化。

八、Self-Attention:公式、参数量与缩放因子的意义

自注意力机制是Transformer模型的核心,负责捕捉序列内任意位置的依赖关系,其公式设计、参数量计算与缩放因子的引入均直接影响模型性能。

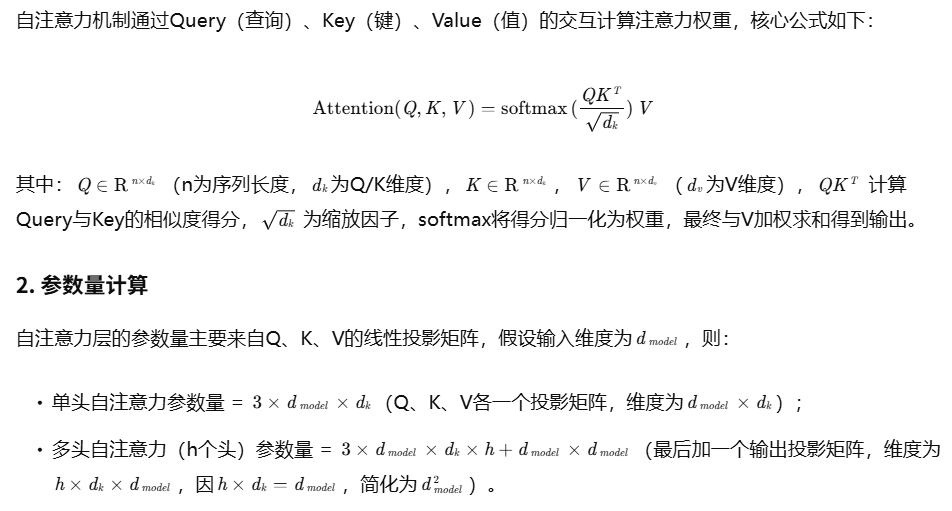

1. 核心公式

3. 除以根号dk的原因

核心目的是保证数值稳定性,避免softmax梯度消失:

- 若不缩放,QKT 的结果会随dk增大而增大(因Q、K元素服从均值0、方差1的分布,内积均值为0、方差为dk),导致得分过大。

- 过大的得分会使softmax函数输出趋近于0或1,进入梯度饱和区,梯度消失,模型难以训练。

- 除以根号dk 可将QKT 的方差归一化为1,使得分分布更合理,softmax梯度保持稳定,提升模型训练效率。

九、大模型为何偏爱 Decoder-only 架构?

当前主流大模型(GPT、Llama、Falcon)均采用Decoder-only架构,而非Encoder-Decoder或Encoder-only,核心源于工程实践、任务适配与性能成本的综合考量:

- 工程适配性强:Decoder-only架构天然支持自回归生成,无需额外适配即可处理多轮对话、文本生成等核心场景,工程实现简单,部署效率高。

- 零样本生成能力优异:在无微调场景下,Decoder-only模型能更好地捕捉序列生成规律,零样本(Zero-shot)、少样本(Few-shot)任务表现更优,适配通用场景需求。

- 性能与成本平衡:Encoder-Decoder架构参数量更大(需同时维护编码器与解码器),计算成本更高;Decoder-only架构参数量更精简,在相同硬件资源下,训练与推理速度更快,更易规模化。

- 表达能力更强:Encoder的注意力矩阵为满矩阵但易呈现低秩特性(信息冗余),而Decoder-only的注意力矩阵为下三角矩阵(屏蔽后文),天然为满秩,能更高效地捕捉前序上下文依赖,表达能力更优。

十、大模型生成内容重复的解决方案

针对"复读机"问题,可从模型训练、生成策略、结构优化三个维度入手,结合具体场景选择方案,详细可参考 《大模型生成重复问题的解决方案》,核心策略如下:

- 生成策略优化:调整采样方式(如降低温度系数、使用Top-p/Top-k采样),引入重复惩罚机制(对已生成Token降低采样概率)。

- 训练层面优化:清洗训练语料中的重复数据,引入对比学习(Contrastive Learning)让模型区分重复与多样化表达,优化损失函数抑制重复生成。

- 结构与机制优化:增强注意力机制对全局上下文的捕捉能力,引入记忆模块记录已生成内容,动态调整生成权重。

- 后处理修正:通过规则引擎、语义去重模型,对生成结果进行过滤,删除重复片段,优化文本流畅性。

十一、领域大模型 LLM 训练 Trick

领域大模型(如医疗、法律、金融)的训练需结合垂直领域特性,优化数据、模型与训练流程,提升领域适配性,详细可参考 《领域大模型训练实战技巧》,核心Trick如下:

- 数据优化:构建高质量领域语料库(去噪、去重、标注),采用领域适配预训练(Domain-Adaptive Pre-training, DAPT),补充领域术语、规则等知识。

- 模型微调策略:采用增量预训练+指令微调的两阶段方案,使用LoRA、QLoRA等低秩适配技术,在不增加过多参数量的前提下提升领域性能。

- 训练参数调优:调整学习率(领域数据少可降低学习率)、批次大小、预热步数,采用梯度裁剪抑制梯度爆炸,提升训练稳定性。

- 评估体系适配:构建领域专属评估指标(如医疗领域的准确率、合规性),引入领域专家反馈,优化模型生成结果的专业性与可靠性。