前言

各位小伙伴新年好!新的一年祝大家龙马精神、阖家幸福、身体健康、事业进步!2025 年 DeepSeek 发布的 DeepSeek-R1 模型震惊全球,此后国内各大厂商充分发挥"能征善战"的拼劲,纷纷选择重大节日推出新品。今年除夕夜,阿里 Qwen 团队再次放出大招------Qwen3.5 模型正式开源,为国产大模型阵营再添一员猛将。

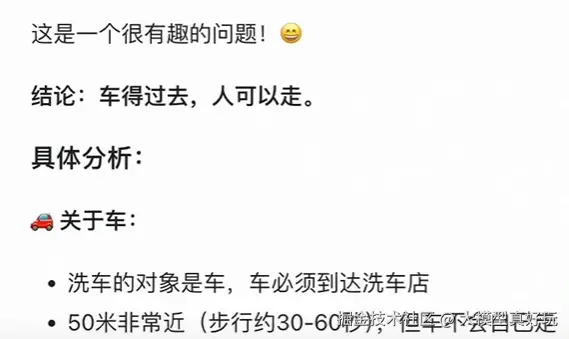

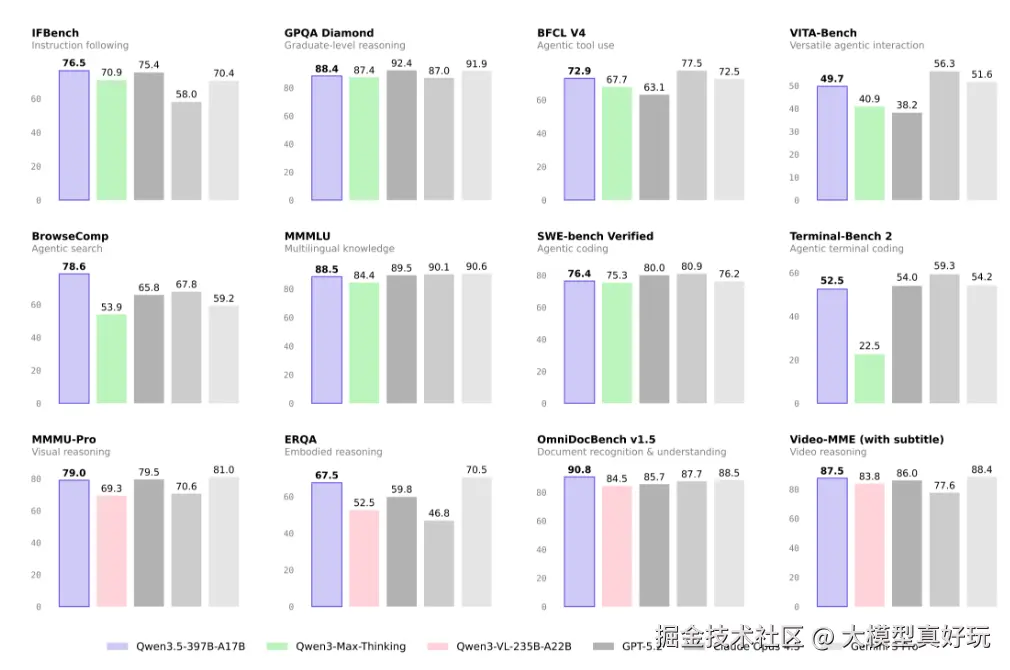

Qwen3.5 是目前全球最强的原生多模态开源大模型,不仅支持图片和视频的多模态输入,在对话、推理、编程、Agent 构建等方面也样样精通。其综合能力已达到 GPT-5.2、Gemini 3.0 Pro 的平均水平,推理能力尤为突出。例如那道曾让无数模型"翻车"的逻辑题------"50 米距离该走路还是开车去洗车",Qwen3.5 也能轻松作答。

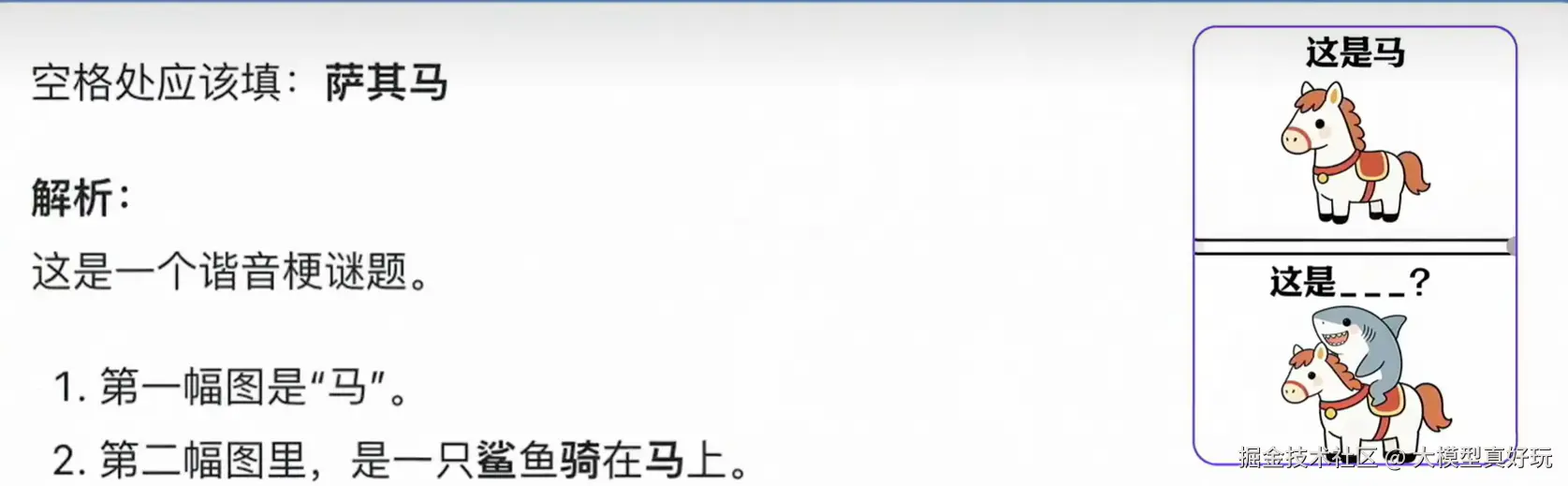

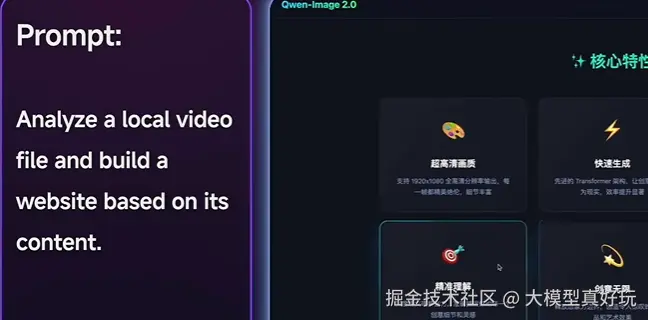

在 Vibe Coding 方面,凭借国内最强开源多模态模型的实力,Qwen3.5 可借助 Remotion Skills 一键生成视频;在 Agentic Coding 方面,其强悍的 Agent 性能即使用户使用最简略的需求描述,它也能自动调用各类工具,完成复杂应用开发。视觉推理能力相较 Qwen3-VL 大幅提升,连"鲨鱼骑马 = 沙琪玛"这种梗图都能精准识别。

更令人惊艳的是,Qwen3.5 能够将视觉与代码能力结合,一步到位将视频内容"转译"为一个可交互的网页。可以说,Qwen3.5 的发布不仅填补了国内多模态开源大模型的空白,也为未来多模态 Agent 的开发奠定了坚实基础。本文笔者将对 Qwen3.5 的核心特性和性能进行详细解读,带大家一探究竟!

一、Qwen3.5-397B-A17B 核心特性

1.1 预训练:能力、效率与通用性的全面升级

Qwen3.5 在预训练阶段从三个维度进行了深度优化:

- 能力(Power) :在更大规模的视觉-文本语料上训练,并加强中英文、多语言、STEM 与推理数据的比重,采用更严格的过滤策略。最终,Qwen3.5-397B-A17B 与参数量超过 1T 的 Qwen3-Max-Base 表现相当,实现了跨代持平。

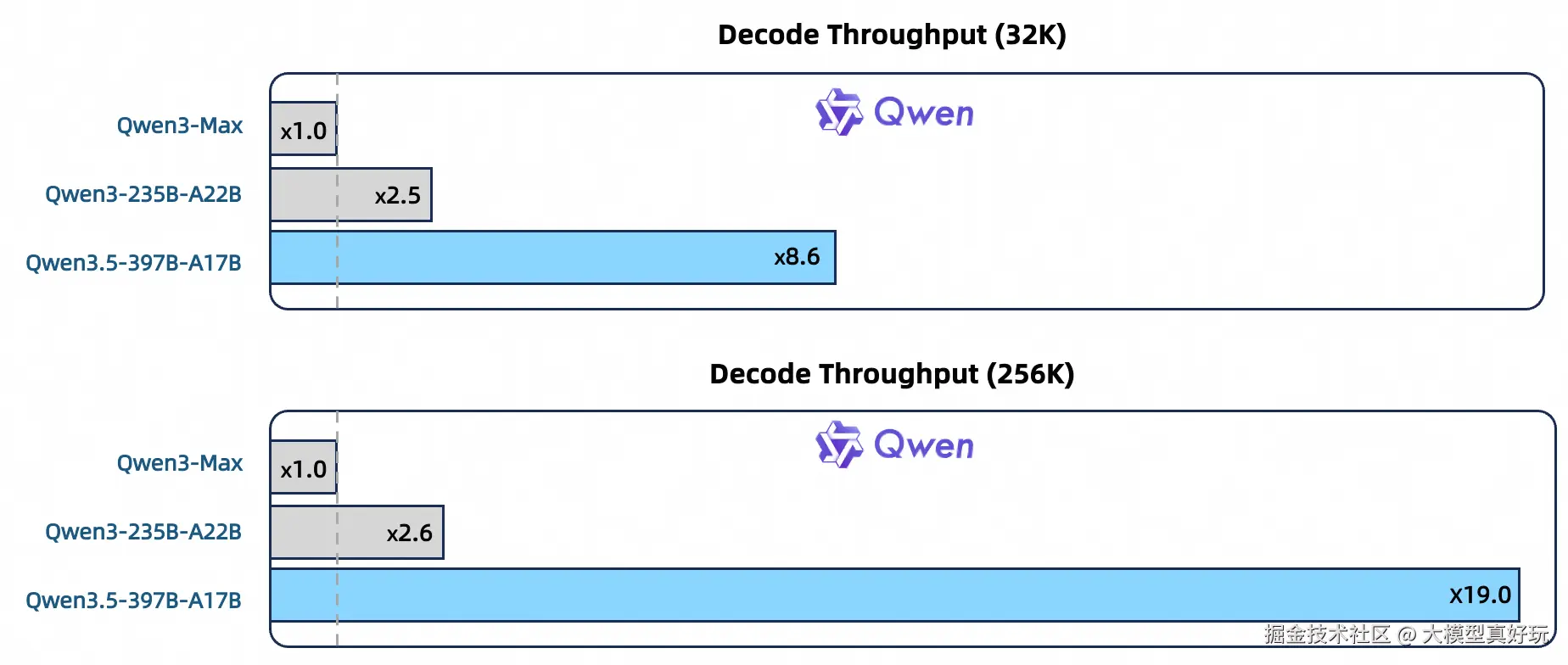

- 效率(Efficiency) :基于 Qwen3-Next 架构,引入更高稀疏度的 MoE、Gated DeltaNet + Gated Attention 混合注意力机制,配合稳定性优化与多 token 预测。在 32k/256k 上下文长度下,Qwen3.5-397B-A17B 的解码吞吐量分别达到 Qwen3-Max 的 8.6 倍/19.0 倍,以及 Qwen3-235B-A22B 的 3.5 倍/7.2 倍,性能不变但效率大幅提升。

- 通用性(Versatility) :通过早期文本-视觉融合与扩展的视觉/STEM/视频数据,实现了原生多模态能力,在相近规模下显著优于 Qwen3-VL。多语言支持从 119 种增至 201 种语言/方言;词表从 15 万扩展至 25 万,在多数语言上带来了约 10%~60% 的编码/解码效率提升。

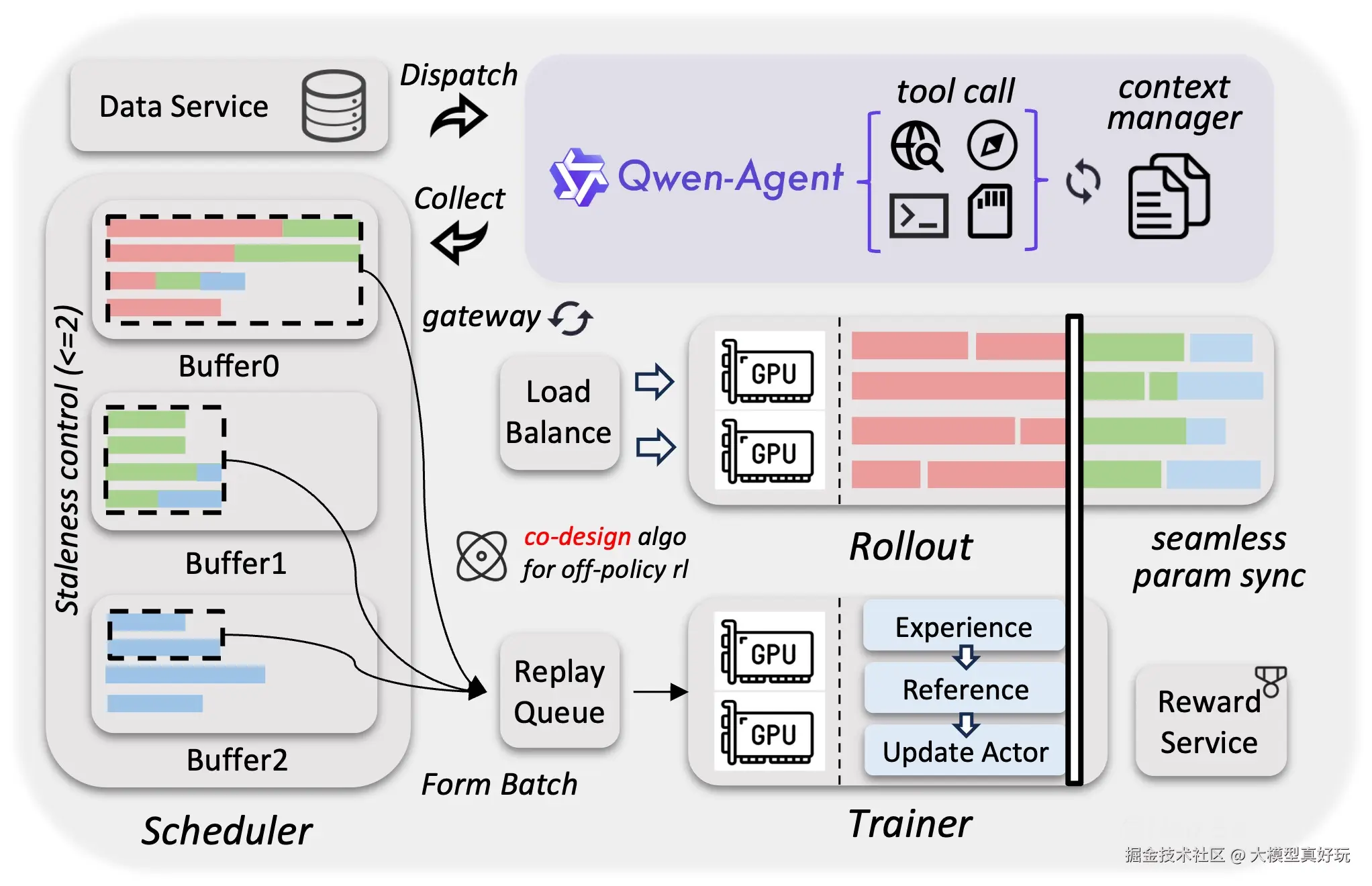

1.2 异构基础设施:高效训练与强化学习的系统支撑

Qwen3.5 通过异构基础设施设计,实现了高效的原生多模态训练:

- 解耦并行策略:针对视觉与语言组件采用不同的并行策略,避免统一方案带来的低效,实现跨模块计算重叠。在混合文本-图像-视频数据上,训练吞吐量相比纯文本基线几乎无损(接近 100%)。

- 原生 FP8 流水线:对激活、MoE 路由与 GEMM 运算采用低精度 FP8,同时通过运行时监控在敏感层保持 BF16,从而降低约 50% 的激活显存占用,并获得超过 10% 的加速。该设计稳定支持了数万亿 token 的训练扩展。

- 可扩展异步强化学习框架 :为持续释放强化学习的潜力,构建了训推分离的异步强化学习框架,全面覆盖文本、多模态及多轮交互场景。该框架通过动态负载均衡、细粒度故障恢复,以及 FP8 训推、Rollout 路由回放、投机采样、多轮 Rollout 锁定等技术,实现了 3×--5× 的端到端加速,同时显著提升了训练曲线的稳定性和性能上限。框架原生支持百万级规模的智能体工作流与环境交互,为模型泛化能力的增强提供了坚实基础。

二、Qwen3.5-397B-A17B 性能详解

除夕夜开源的 Qwen3.5-397B-A17B 是 Qwen3.5 系列的首款模型。未来,Qwen3.5 还将陆续开源一系列小尺寸模型,同时保留 Qwen3.5-Max 的商业旗舰地位(该模型不会开源)。

2.1 模型架构与部署

-

参数规模:模型拥有近 4000 亿总参数,采用极致稀疏 MoE 架构,每次推理仅激活 170 亿参数,大幅降低计算开销。

-

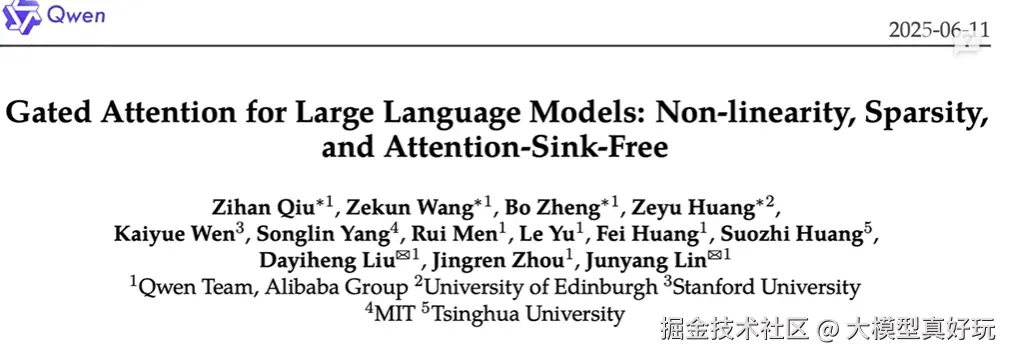

技术创新 :引入注意力门控机制(该技术获 2025 年 NeurIPS 最佳论文奖),实现了降本增效。与上一代商业旗舰 Qwen3-Max-Thinking(近 1T 参数)相比,Qwen3.5-397B-A17B 在性能超越的同时,部署显存占用降低 60%,最大推理吞吐量提升至原来的 19 倍。

-

硬件需求:尽管极致稀疏,但完整运行仍需至少 8 卡 A100(80G)集群;不过 17B 的激活参数使得实际推理效率极高。

2.2 推理模式与上下文

- 混合推理模型 :Qwen3.5 默认进行推理,与 Qwen3 不同的是,它不支持通过

<no_thinking>前缀取消推理,只能通过修改内置提示词模板(通常位于tokenizer_config.json中)切换至 Chat 模式(内置提示词模板通常在大模型tokenizer_config.json文件中, 大家不熟悉的可以看笔者文章大模型训练全流程实战指南基础篇(二)------大模型文件结构解读与原理解析)。 - 超长上下文:默认上下文长度为 256K,通过配置最多可扩展至 1M,相当于可一次性处理约 2 小时的视频内容。

2.3 性能对比与亮点

- 全能型表现:Qwen3.5-397B-A17B 是目前国最强的一款全能型开源大模型,对话、编程、视觉识别、视觉理解、Agent 搭建等能力均已追平 GPT-5.2、Gemini 3.0 Pro 和 Claude Opus4.5。在编程专项上,与最新的 GPT-5.3-CodeX、Claude Opus4.6 相比仍有约 10% 的差距,但依然是国内最佳。

- 原生多模态优势:文本、图像、视频在统一语义空间处理,对图文混排的 PDF 等文档可直接识别与检索,无需传统的多模态 RAG 流程。视觉推理能力极强,有博主实验证明 Qwen3.5 能高精度识别复杂的 Agent 项目架构图,并准确分析功能、关联和内在逻辑,甚至可以借助其强大的编程能力复刻相同架构的 Agent------类似 Claude 的视觉编程魅力,国人终于也能体验到了!

2.4 开源与 API

-

模型下载:Qwen3.5-397B-A17B 已全面开源,可在魔搭社区(ModelScope)或 Hugging Face 下载模型权重。

-

API 服务:阿里百炼平台同步上线了模型 API,注意区分两个版本:

- Qwen3.5(开源模型) :原始开源模型版本。

- Qwen3.5-Plus:开源模型搭配基础工具(如网络搜索)后的通用 Agent,并非纯模型。

-

定价:API 定价极低,输入百万 tokens 仅 0.8 元,输出百万 tokens 仅 4.8 元,性价比是同性能 Gemini 3.0 Pro 的 1/18,真正"拉满"性价比。

三、总结

Qwen3.5-397B-A17B 的发布,为 2026 年春节的国产大模型赛道打响了头炮。与此同时,万众期待的 DeepSeek-V4 也即将来袭,这个春节可谓"神仙打架"。正是这些公司雄厚的技术积淀,撑起了我国大模型在世界舞台上的领先地位。为国产大模型公司点赞,也祝愿新的一年里,我国大模型产业继续马到成功!

大模型时代的到来注定是颠覆世界的第四次工业革命,也希望大家可以紧跟AI时代的潮流,把握AI时代的风口。2026注定是大模型接续爆发的一年!为了让大家彻底搞懂大模型的作用原理,笔者也发布了《数据到模型到应用:大模型训练全流程实战指南》专栏,预计会有50期内容,将系统拆解从数据处理、模型训练到强化学习与智能体开发的全流程,并带大家从零实现模型,帮助大家掌握大模型训练的全技能,真正掌握塑造智能的能力!感兴趣大家可关注笔者掘金账号,更可关注笔者同名微信公众号:大模型真好玩,更多教程和大量大模型学习资料分享~

需要注意的是:大模型训练对计算资源有一定要求,尤其是GPU显存。为降低学习门槛,笔者与国内主流云平台合作,大家可以通过打开链接: Lab4AI ,体验H100 GPU 6.5小时的算力。本系列所有实战教程均将在该平台上完成,帮助大家低成本上手实践。