前言

今26年2.16是除夕,我司于过去三年完成了在具身领域的奠基

- 24年,从大模型应用开发切入具身机器人

- 25年,技术上完成多轮突飞猛进

- 26年,不遗余力,继续全力做具身,用十年时间让所有机器人都有一个聪明的大脑

回归正题,如果说上一篇文章《GigaBrain-0------通过世界模型GigaWorld增强VLA的泛化能力:基于RGBD输入建模,及通过具身CoT增强推理能力》介绍的GigaBrain-0,可对标π0.5

那么此文介绍的GigaBrain-0.5M*,便可对标π0.6

第一部分

1.1 引言与相关工作

1.1.1 引言

如原论文所说,主流 VLA 架构中仍然存在一个根本性的局限:它们在长时程动作规划中对短视观测的过于依赖,这一缺陷源于体系结构在设计上偏向于反应式控制,而非前瞻性规划

相反,在大规模视频语料库上训练的基础世界模型已经展示出在预测合理未来状态方面的非凡能力,这类预测先验为赋予 VLA 前瞻能力提供了一条途径

对此,来自GigaBrain Team ( alphabetical order**)的研究者提出 GigaBrain-0.5M***,这是一种通过基于世界模型的强化学习训练得到的 VLA 模型

- 其paper地址为:GigaBrain-0.5M*: a VLA That Learns From World Model-Based Reinforcement Learning

作者包括

Boyuan Wang, Chaojun Ni, Guan Huang, Guosheng Zhao, Hao Li, Jie Li, Jindi Lv, Jingyu Liu, Lv Feng, Mingming Yu, Peng Li, Qiuping Deng, Tianze Liu, Xinyu Zhou, Xinze Chen, Xiaofeng Wang, Yang Wang, Yifan Li, Yifei Nie, Yilong Li, Yukun Zhou, Yun Ye, Zhichao Liu, Zheng Zhu - 其项目地址为:gigabrain05m.github.io

其GitHub地址为:github.com/open-gigaai/giga-brain-0

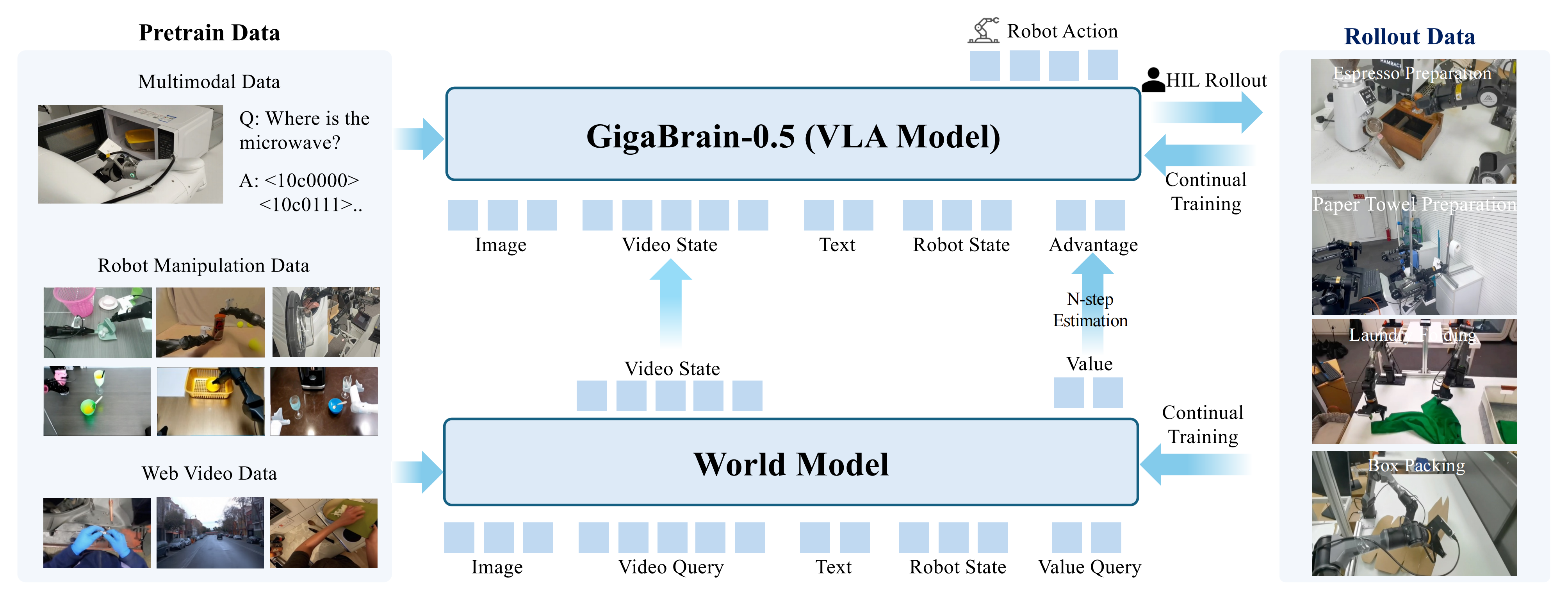

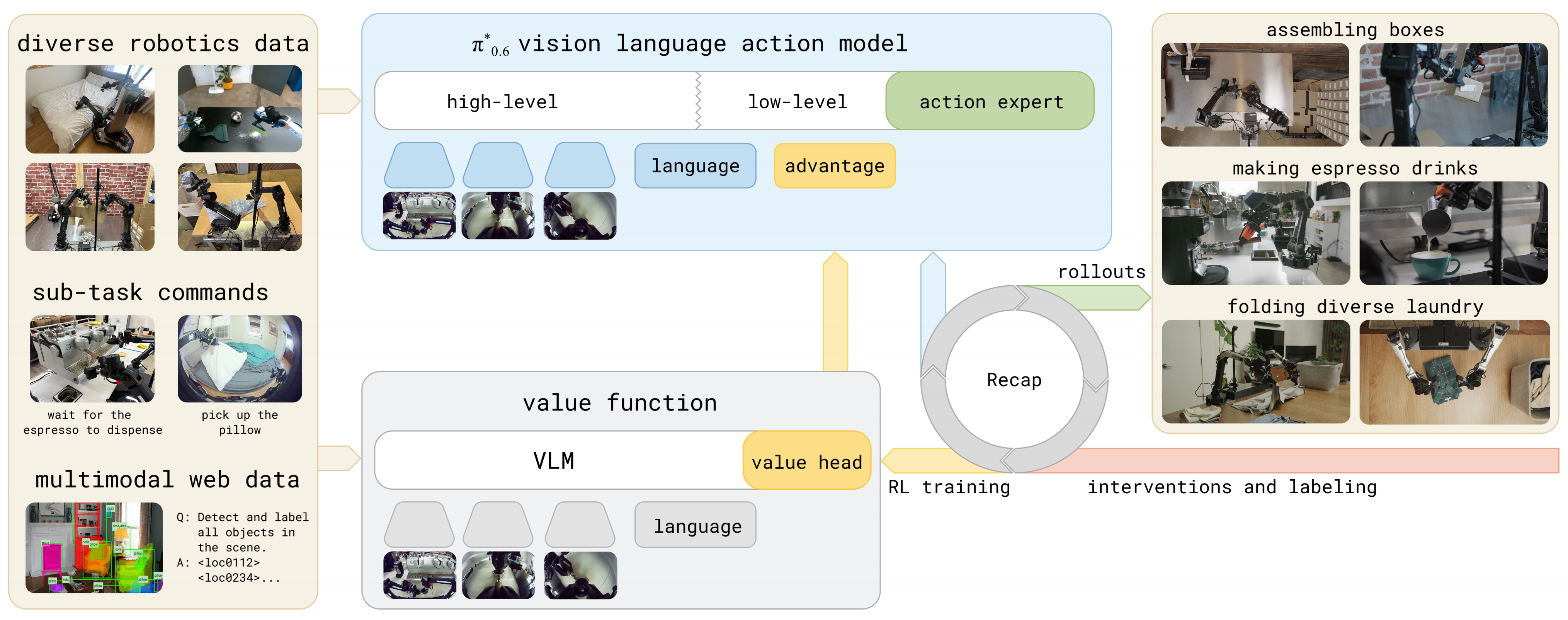

具体而言,GigaBrain-0.5M* 在 GigaBrain-0.5M(最新的、在超过 1 万小时真实世界机器人交互数据上预训练的 VLA)基础上,受π∗0.6 中的RECAP(Intelligence et al.,2025)启发,引入 RAMP(Reinforcement leArning via world Model-conditioned Policy)

RAMP 流水线包含四个迭代阶段:

- 使用大规模机器人操作数据预训练世界模型,使其能够预测价值和未来状态

- 在世界模型所预测的价值和未来状态条件下,对策略进行微调以生成动作

- 将策略部署到真实环境中,在人类在环干预的情况下生成机器人的执行轨迹(rollout)数据

- 利用这些 rollout 数据持续训练世界模型和策略

这种迭代训练范式使系统能够实现自我提升

π∗0.6 中的RECAP和GigaBrain-0.5M*中的RAMP这两种方法都使用额外信息作为VLA 模型的条件

- 然而,RECAP 仅使用稀疏优势(0 or 1)作为输入,所提供的信息增益有限

详见此π∗0.6解读一文的「1.3 基于RECAP的π∗0.6的实现、模型与系统细节」 - 相比之下,***GigaBrain-0.5M****提出的RAMP 利用经过良好预训练的世界模型所预测的未来状态,从而带来可观的信息增益

此外,作者在理论上验证了RECAP 是RAMP 的一个特例

1.1.2 相关工作

首先,对于 ++视觉-语言-动作模型++

近年来,基础语言模型的进展催生了 VLA 模型的发展

-

Bjorck et al., 2025,即Gr00t n1

-

Black et al., 2024,即π0

-

Cheang et al., 2025,即Gr-3 technical report

-

Doshi et al., 2024,即Scaling cross-embodied learning: One policy for manipulation, navigation, locomotion and aviation

-

Intelligence et al., 2025,即π*0.6

-

Kim et al., 2024,即Openvla

-

Li et al., 2024,即Cogact

-

Liu et al., 2024,即Rdt-1b

-

Ni et al., 2025,即Swiftvla

-

O'Neill et al., 2024,即Open x-embodiment

-

Pertsch et al., 2025,即Fast_π0

-

Qu et al., 2025,即SpatialVLA

-

Team etal., 2025, 2024,即**GigaBrain/GigaWorld

-

Wang et al., 2024,即Scaling proprioceptive-visual learning with heterogeneous pre-trained transformers,该研究探讨了如何利用异构Transformer结构有效融合机器人的身体感官与视觉信息

这类模型通过同时扩展模型参数规模和训练语料规模,追求更强的跨任务与跨具身形态泛化能力。此类系统通常利用冻结或微调的视觉-语言骨干网络

- Alayrac et al.,2022,即Flamingo

- Bai et al.,2025,即Qwen2. 5-vl technical report

- Beyer et al.,2024,即Paligemma

- Liu etal.,2023,即Visual instruction tuning

- Marafioti et al.,2025,即Smolvlm

- Peng et al.,2023,即Kosmos-2

- Steiner et al.,2024,即Paligemma 2

用于处理异构感知输入并生成可执行的运动指令,其方法

-

要么采用自回归token化策略

-

要么采用通过基于流的生成范式

Lipman et al.,2022-即Flow matching for generative modeling

Liu,2022-即Rectified flow: A marginal preserving approach to optimal transport构造的连续动作空间

尽管当代 VLA 融合了大规模跨具身数据集

- Dasari et al.,2019,即Robonet: Large-scale multi-robot learning

- Ebert et al.,2021,即Bridge data: Boosting generalization of robotic skills with cross-domain datasets

- Khazatsky et al.,2024,即Droid: A large-scale in-the-wild robot manipulation dataset

- O'Neill etal.,2024,即

- Walke et al.,2023,即Bridgedata v2: A dataset for robot learning at scale

以及大量专有数据资源以增强其泛化能力,但在处理时间上具有延展性的推理方面仍存在根本性局限

具体而言,在解决长时序操作任务时,这类模型在动作生成上往往主要依赖于当前的观测输入

其次,对于 ++用于策略模型的世界模型++

近期在世界建模方面的突破

- Agarwal et al.,2025,即Cosmos world foundation model platform for physical ai

- Alhaija et al.,2025,即Cosmos-transfer1: Conditional world generation with adaptive multimodal control,该研究展示了如何通过文本、图像等多种模态条件生成连贯的未来视频序列

- Assran et al.,2025,即V-jepa 2: Self-supervised video models enable understanding, prediction and planning,采用自监督视频模型(V-JEPA 2)实现理解、预测和规划的世界模型

- Janget al.,2025,即Dreamgen: Unlocking generalization in robot learning through video world models

- Jiang et al.,2025,即Galaxea open-world dataset and go dual-system vla model

- Kong et al.,2024,即Hunyuanvideo: A systematic framework for large video generative models

- Liao et al.,2025,即Genie envisioner: A unified world foundation platform for robotic manipulation

- Wang et al.,2025,即Wan: Open and advanced large-scale video generative models

加速了在具身智能系统中采用生成数据,以弥合从仿真到现实的鸿沟(Zhu et al.,2024-即sora)

-

在自动驾驶中,世界模型被用来生成极端边缘案例(corner cases)数据

Gao et al.,2023,2024

Magicdrive : Street view generation with diverse 3d geometry control,提出了一种支持多样化3D几何控制的街景生成模型MagicDrive

Vista : A generalizable driving world model with high fidelity and versatile controllability,Vista通过高保真的环境模拟,为自动驾驶系统提供了丰富的长尾场景训练数据

Hu etal.,2023,即Gaia-1 : A generative world model for autonomous driving,Gaia-1是自动驾驶领域的一个生成式世界模型

Ren et al.,2025,即Cosmos-drive-dreams : Scalable synthetic driving data generation with world foundation models,利用世界基础模型实现可扩展的合成驾驶数据生成

Russell et al.,2025,即Gaia-2 : A controllable multi-view generative world model for autonomous driving,提出了一种可控的多视角驾驶场景生成世界模型

Wang et al.,2024,即Drivedreamer : Towards real-world-drive world models for autonomous driving,探索迈向真实驾驶能力的自动驾驶世界模型

Zhao et al.,2025,即Drivedreamer-2: Llm-enhanced world models for diverse driving video generation,通过大语言模型增强,生成多样化的驾驶视频并构造交通情境

Ni et al.,2024,2025,即Recondreamer 、Swiftvla

Zhao et al.,2024,2025,即Drivedreamer4d : World models are effective data machines for 4d driving scene representation、Recondreamer++: Harmonizing generative and reconstructive models for driving scene representation -

在具身机器人场景中,诸如(Team etal.,2025-即Gigabrain-0: A world model-powered vision-language-action model)等技术利用世界模型生成的样本,这些样本覆盖纹理多样的场景

Dong et al.,2025,即Emma : Generalizing real-world robot manipulation via generative visual transfer,通过生成式视觉迁移使真实世界的机器人操作实现泛化

Liu et al.,2025,即Robotransfer : Geometry-consistent video diffusion for robotic visual policy transfer,提出几何一致的视频扩散模型用于机器人视觉策略迁移

Yuan et al.,2025,即Roboengine: Plug-and-play robot data augmentation with semantic robot segmentation and background generation,通过分割与背景生成实现即插即用的机器人数据增强多视角渲染

Xu et al.,2025,即Egodemogen: Novel egocentric demonstration generation enables viewpoint-robust manipulation以及以自我为中心视角的转换

Li et al.,2025,即Mimicdreamer: Aligning human and robot demonstrations for scalable vla training,对齐人类与机器人演示以扩展VLA训练规模

从而丰富 VLA 模型的训练数据另一种不同的范式是通过世界模型预测未来的视觉轨迹

例如

DreamGen,通过视频世界模型预测轨迹来解锁机器人学习的泛化能力

ViDAR,利用基础视频扩散模型实现通用的双臂机器人操作控制随后通过逆动力学模型(Inverse Dynamics Models,IDMs)推断可执行的运动控制命令

这类流水线的有效性在很大程度上取决于生成序列的视觉保真度和物理合理性 -

除了数据生成之外,新兴方法还在探索世界模型与策略学习之间更紧密的集成

诸如

Bi et al.,2025,即Motus : A unified latent action world model,提出了一种统一的潜在动作世界模型Motus

Cen et al.,2025,即Worldvla: Towards autoregressive action world model,探索面向自回归动作世界模型的WorldVLA框架

Li et al.,2026,2025,即Causal world modeling for robot control,研究用于机器人控制的因果世界建模技术

Pai et al.,2025,即mimic-video : Video-action models for generalizable robot control beyond vlas,提出超越VLA的视频-动作模型以用于通用的机器人控制

Wang et al.,2024,即Scaling proprioceptive-visual learning with heterogeneous pre-trained transformers,融合本体表征与预测型世界模型的潜表征以提高效率

等方法,将预测型世界模型的潜在表征与策略网络融合,以提高样本效率和泛化能力更具雄心的是,诸如Kim et al.,2026

Cosmos policy: Fine-tuning video models for visuomotor control and planning,该工作证明了微调后的视频生成模型本身就可以作为高性能的闭环视觉运动控制器等框架干脆绕过显式的策略网络,直接将世界模型的预测映射为动作序列

最后,对于++面向VLA的强化学习++

模仿学习策略由于分布偏移而遭受误差累积Ross et al. (2011-即A reduction of imitation learning and structured prediction to no-regret online learning,该论文提出了著名的DAgger算法,通过在线专家干预将模仿学习转化为在线学习问题,以解决复合误差问题),其性能本质上受限于示范数据的质量

尽管DAgger 及其变体

- Jang et al. (2022),即Bc-z: Zero-shot task generalization with robotic imitation learning,该研究展示了如何通过大规模任务条件的模仿学习实现机器人的零样本任务泛化

- Kelly et al. (2019),Hg-dagger: Interactive imitation learning with human experts,提出了 HG-DAgger,一种人类专家仅在系统即将进入不安全状态时才介入干预的交互式学习范式

通过在线专家干预缓解了这一问题,它们仍然依赖于持续的人类监督,并且缺乏用于策略自主改进的机制

-

为了超越模仿学习的局限性,强化学习已被广泛用于机器人策略优化。传统方法采用基于on-policy 的算法Schulman et al. (2017-即PPO) ,或基于off-policy 的方法

Kalashnikov et al. (2018),即QT-Opt: Scalable deep reinforcement learning for vision-based robotic manipulation,一种能够处理视觉输入的、可大规模扩展的 Q 学习框架,用于复杂的机器人操纵任务通过与环境交互来优化策略

-

近期工作将这些范式扩展到VLA 模型上,通过直接策略梯度优化

Lu et al. (2025),即Vla-rl : Towards masterful and general robotic manipulation with scalable reinforcement learning,将强化学习范式扩展到 VLA 模型,通过直接策略梯度进行优化

Tan et al. (2025),Interactive post-training for vision-language-action models,近期**通过直接策略梯度优化扩展 VLA 模型性能的工作之一或在冻结骨干上的残差策略学习Guo et al. (2025),即Improving vision-language-action model with online reinforcement learning,在冻结的 VLA 骨干模型上进行残差策略学习(Residual Policy Learning)的研究

然而,将策略梯度方法扩展到大规模VLA 仍然具有挑战性,原因在于训练不稳定和样本效率低下 -

一个新兴方向通过将动作生成条件化在价值信号上来规避显式的策略梯度计算

涵盖了基于回报条件的策略Kumaret al. (2019),即Reward-conditioned policies

和基于优势条件的形式化

Kuba et al. (2023);

即Advantage-conditioned diffusion: Offline rl via generalization ,利用优势条件(Advantage-conditioned)公式进行动作生成的离线强化学习方法

Wu et al. (2023)最近,π∗0.6 Intelligence et al.(2025) 提出了RECAP 框架,表明基于优势条件的强化学习能够通过在机器人上的数据收集,使VLA 在下游任务中获得高性能

这由此激励了作者探索基于世界模型的强化学习,其中世界模型联合预测价值和未来状态,以作为丰富的策略条件

1.2 GigaBrain-0.5M*的完整方法论

在基础 VLA 模型 GigaBrain-0.5 之上,作者提出了 GigaBrain-0.5M*,这是一种增强型策略模型,集成了基于世界模型的 RL:RAMP(Reinforcement leArning via world Model-conditionedPolicy)

和原论文的介绍顺序一致,本节首先详细介绍 GigaBrain-0.5 的架构和预训练数据构成,随后给出 RAMP------这是一种训练方法论,它利用世界模型的预测,通过经验和纠正性反馈信号迭代式地优化策略行为

1.2.1 GigaBrain-0.5

GigaBrain-0.5 继承了GigaBrain-0 (Team et al., 2025) 的端到端VLA 架构

该架构旨在将视觉观测和语言指令映射为双臂机器人的动作序列

-

它采用mixture-of-transformers (Liang et al., 2024) 作为骨干网络,利用预训练的PaliGemma-2 (Steiner et al., 2024) 视觉-语言模型(VLM) 对多模态输入进行编码,并使用结合flow matching (Lipman et al., 2022) 的动作Diffusion Transformer (DiT)来预测动作块

-

为了增强推理能力,GigaBrain-0.5 生成一个Embodied Chain-of-Thought (Embodied CoT),其由自回归子目标语言, 离散动作tokens (Pertsch et al.,2025), 以及2D 操作轨迹t1:10 组成

语言和离散tokens 通过VLM 头部进行解码,而2D 轨迹则通过轻量级GRU 解码器从可学习的tokens 中回归得到

在该版本中,深度信息和2D 轨迹被视为可选状态,使模型能够适应多样的传感器模态和任务需求

所有组件在统一目标下进行联合优化

其中

是训练数据集,

是一个逐token 的掩码,指示位置

是否属于CoT 推理流(子目标语言或离散动作)

- 对于扩散过程,

是flow-matching 时间步,

是高斯噪声,且

表示加噪后的动作片段

- 项

和

分别表示预测的和真实的轨迹关键点,由超参数λ 进行平衡

值得注意的是,Knowledge Insulation (Driess et al.,2025) 从机制上防止了语言项与动作预测项之间的优化干扰

1.2.2 RAMP:RAMP 形式化、RAMP 的实现

在本节中,作者

首先形式化提出的 RAMP 框架,并证明 RECAP(Intelligence et al., 2025)是在该形式化下的一个特例

随后,详细介绍 RAMP 的实现,它包括四个迭代训练阶段:

- 世界模型预训练

- 策略预训练

- 人类在环 Rollout(HILR)数据收集

- 使用 Rollout 数据进行策略训练

1.2.2.1 RAMP 形式化

为了推导一个可扩展的、能够利用世界模型潜变量的训练目标,作者将KL 正则化强化学习框架扩展到增强后的状态空间,其中

表示由世界模型提取的潜在表示

-

作者的目标是在通过 KL 散度约束策略 π 不偏离参考策略

的情况下,最大化预期回报,且借鉴正则化强化学习中的标准结果,最优策略的闭式解由(Intelligence 等人,2025 年)给出:

-

为减轻直接估计指数优势项所带来的数值不稳定性,作者引入一个二元改进指示器

,并假设观察到改进事件的概率

与该动作的指数优势成正比

------------

通过应用贝叶斯定理,作者将这个难以处理的优势项重新表述为条件概率的比值:

将该比值代回最优策略方程, 可以把重新表示为无条件分布和条件改进分布的组合

-

因此,作者参数化一个神经网络πθ 来同时拟合这些分布,从而得到最终的训练目标,即最小化加权负对数似然------定义为公式3

其中作为改进信号

这意味着,RECAP 实质上学到的是一种平均策略,在没有具体指导的情况下,它必须隐式地对所有可能的未来演化进行整合并在其间作出折中

相比之下,RAMP 通过显式地以世界模型的预测

为条件来消除这种不确定性,将问题从对未来的大致猜测转变为针对特定物理状态的精确规划

此外,从信息论的角度来看,引入时空潜变量为动作生成提供了显著的信息增益

虽然RECAP 仅依赖稀疏的二进制优势信号() 进行粗略的信用分配,但RAMP 利用

注入稠密的几何结构和物理动力学先验,从而显著降低动作生成的条件熵

1.2.2.2 RAMP 的实现

RAMP 在整个训练生命周期内引入世界模型的引导,使 VLA 模型能够从经验中学习。从大规模离线预训练到基于自主 rollout 数据的多轮迭代微调,作者的方法实现了策略的逐步改进

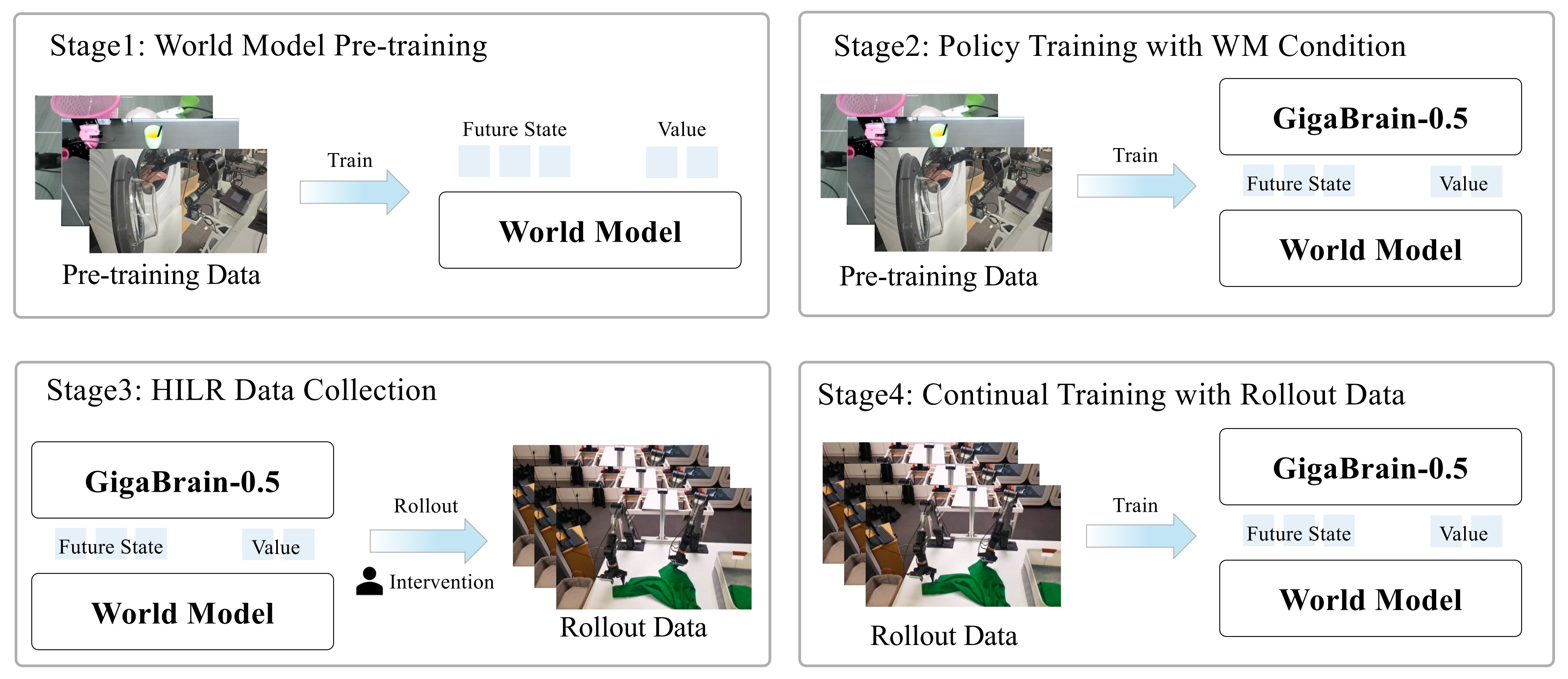

如图 Fig.2 所示,整个流程被组织为四个循序递进的阶段:

RAMP 框架通过一个四阶段流水线运行

- 世界模型预训练为未来状态预测和值估计建立一个统一的表示空间

- 带世界模型条件的策略训练,用显式的世界模型条件来初始化 GigaBrain-0.5 策略

- 人类在环 Rollout(HILR)数据收集通过先进行自主执行、随后由专家纠正,生成多样且高质量的轨迹

- 使用 Rollout 数据的持续训练利用带标注的轨迹数据来更新策略,同时结合成功示范和纠正信号

这个紧密集成的闭环过程促进策略的持续精炼和自我改进

++阶段1:世界模型预训练++

初始阶段构建一个世界模型,能够联合预测未来视觉状态和值估计。遵循Intelligence 等人(2025) 的方法,作者从基于完整回合成功标签中提取稀疏奖励,使得价值函数对应于期望完成步数的相反数

具体而言,奖励函数定义为:

其中 表示该回合的终止时间步,而

是一个较大的正数常数,用于确保失败回合获得的累计回报显著低于成功回合

这样的稀疏奖励设计鼓励策略在优先完成任务而非取得部分进展的前提下最小化执行时间。遵循潜在帧注入策略(Kim et al., 2026),作者将价值信号嵌入为一个额外的潜在帧,在输入世界模型之前与视觉潜在状态进行拼接

该方法无需对底层的Diffusion Transformer 进行任何架构修改

- 具体而言,未来的视觉观测

首先通过一个预训练的VAE 编码为空间-时间视觉潜在变量 - 同时,包括当前价值估计

和本体感受状态

在内的标量和低维辅助信号,通过空间平铺投影

进行变换

该投影在空间维度上复制并广播这些低维向量,使其形状与视觉潜在变量相匹配

完整的潜在状态随后被构造为:

其中表示按通道拼接。这样的统一表征使世界模型能够在一次前向传播中,同时推理视觉动态、任务进展(通过 value 表示)以及机器人运动学

且作者采用Wan2.2 (Wang et al., 2025) 作为世界模型 的骨干架构。该模型通过flow matching(Lipman et al., 2022) 进行训练

通过将未来的视觉状态和值估计视为时间上扩展的视频帧,DiT 骨干网络自然地利用其时空自注意力机制来建模当前观测、动作和未来任务结果之间的关系:

其中

表示在源噪声

与真实潜在状态序列

之间进行线性插值,其中

- 目标项

对应于噪声分布与数据分布之间沿最优传输路径的恒定速度向量场

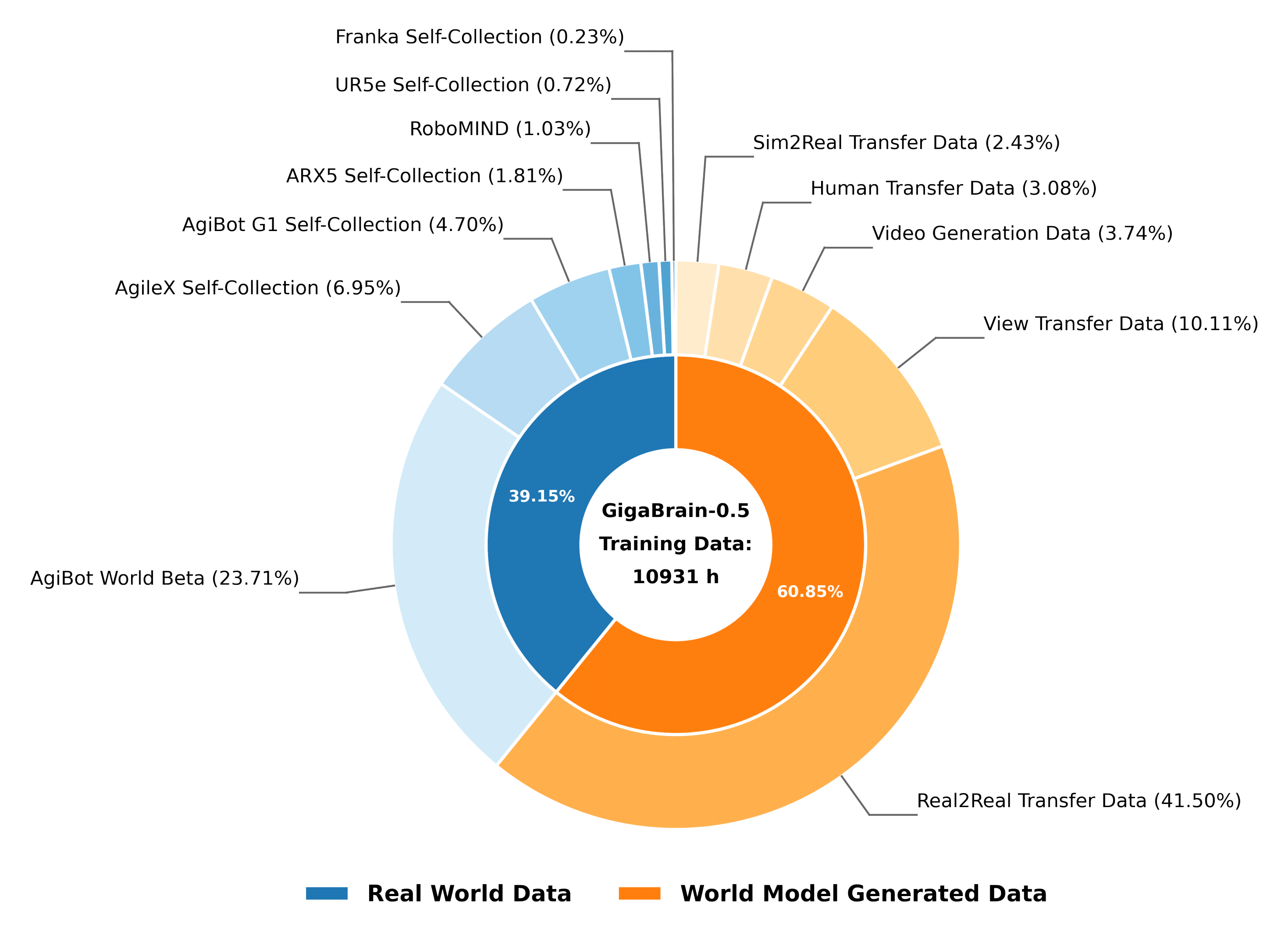

作者利用4K 小时的真实机器人操作数据来训练世界模型,数据分布如图3 所示

++阶段2:基于世界模型条件的策略训练++

第二阶段从预训练的GigaBrain-0.5 检查点初始化策略,并在此基础上结合世界模型条件进行进一步微调(训练细节在原论文Sec. 4.2 中给出)

具体来说,策略接收由世界模型 预测的两个辅助信号:

- 未来状态tokens

- 价值估计

对于前者,未来状态tokens 通过一个轻量级MLP 进行投影,以使其维度与策略的视觉编码器输出对齐

对于后者,价值估计则通过使用 步时序差分估计被转换为动作优势

其中

和

分别表示状态

和

的价值预测,

为折扣因子

- 为在简化条件依赖的同时保持偏好结构,将优势函数离散化为一个二值指示器

,其中阈值为

然后,通过最小化在公式3:中定义的监督微调目标,训练策略在给定元组

的条件下生成动作

为防止过度依赖合成世界模型信号并确保部署的灵活性,作者在训练过程中采用了两种互补的策略

- 首先,世界模型在推理时仅执行单步去噪,以最小化计算开销

- 其次,我们在训练中实现了随机注意力掩码机制,以概率

随机抑制世界模型的tokens。这样迫使策略在世界模型输入部分或完全不可用时仍能保持稳健的性能,从而实现一种在推理时可以绕过世界模型条件的高效推理模式

++阶段 3:人类在环 Rollout 数据采集++

在第三阶段,作者部署策略,通过人类在环的rollouts 来收集轨迹。所得数据集由自主执行和专家干预的混合组成

- 与传统的遥操作相比,自主 rollouts 在动作分布上的差距显著减小,因为策略生成的是其自身原生分布中的动作,而非简单模仿人类演示,从而为 VLA 学习提供了更有效的监督信号

- 然而,自主执行不可避免地会遇到需要人类纠正的失败模式

为缓解人工干预引入的时间不连续性,作者开发了一套人类在环 rollout 数据采集软件,能够在干预边界处自动检测并移除过渡伪影

该平滑机制确保整条轨迹在时间上的连贯性,生成干净、连续的数据集,在保留专家纠正教学价值的同时,有助于在随后的训练阶段实现稳定的策略更新

++阶段4:利用rollout 数据的持续训练++

在这一阶段,作者使用整理好的HILR 数据集对策略进行微调,以掌握由多样化的自主执行和专家纠正混合产生的复杂长时序行为

关键的是,为了防止优势项塌缩趋近于零,世界模型

与HILR 数据集和基础数据进行联合训练

对于策略训练,与阶段2 保持一致,作者在优势指示器 和未来潜在标记

上都施加掩码概率为

的随机注意力掩码

这一正则化具有双重作用:

- 通过在条件输入缺失时强制策略保持鲁棒性,防止策略过度依赖世界模型信号

- 确保预训练与微调阶段在架构和训练过程上的一致性,从而避免在推理时出现分布偏移

rollout-标注-训练循环以迭代方式运行,构建了一个自我改进的闭环:随着策略的提升,其自主rollout 将涵盖越来越复杂且成功的行为,进而为后续迭代生成更高质量的训练数据

最后,对于推理

在部署期间,作者通过将优势指示器固定为来实施一种乐观控制策略

关于潜在条件,由随机掩蔽所促成的架构解耦支持两种灵活的执行模式:

- 一种高效模式,在该模式下跳过世界模型以最大化推理频率

在这种设置下,注意力掩码被配置为使未来的潜在token对 不可见策略,被迫只能基于当前观测来行动 - 标准模式,在该模式下,世界模型会主动生成

,以提供稠密的前瞻性指导

在这种设置中,注意力掩码允许对预测的未来状态进行完全可见,从而使策略能够利用这些潜在的上下文来进行复杂的、长时域的规划

1.3 实验:基础模型的性能、RAMP的性能

1.3.1 基础模型GigaBrain-0.5的性能:预训练、后训练、内部评估

第一,对于预训练细节

- GigaBrain-0.5 在一个超过 10,000 小时的多样化数据集上进行预训练,该数据集包含超过 6,000 小时的世界模型生成数据,以及约 4,000 小时的真实机器人采集数据。详细的数据构成如图 3 所示

- 作者使用训练框架 GigaTrain1 对 GigaBrain-0.5 进行训练,批大小为 3,072,共进行100,000 次优化步。为降低单 GPU 的内存占用,且采用 Fully Sharded Data Parallel (FSDP)v2,对所有 SiglipEncoderLayer 模块以及 Gemma2DecoderLayerWithExpert 的前 16 层选择性地应用分片

第二,对于后训练细节

为了评估 GigaBrain-0.5 在实体机器人上的性能,作者在目标机器人平台上采集特定的示范数据,并执行后训练以使模型适应各个任务

- 作者在内部设计的八个任务上进行了全面评估,并在公共基准 RoboChallenge 中的 30 个任务上对模型进行了额外的后训练

RoboChallenge 任务及其评测协议的详细信息见(RoboChallenge Team) - 这八个内部评测任务包括:果汁制作、搬运纸箱、清理餐桌、纸巾准备、折叠衣物、收集衣物、装箱以及意式浓缩咖啡制作

对于每个任务,作者采用批量大小为 256,进行了 20,000个优化步骤的后训练

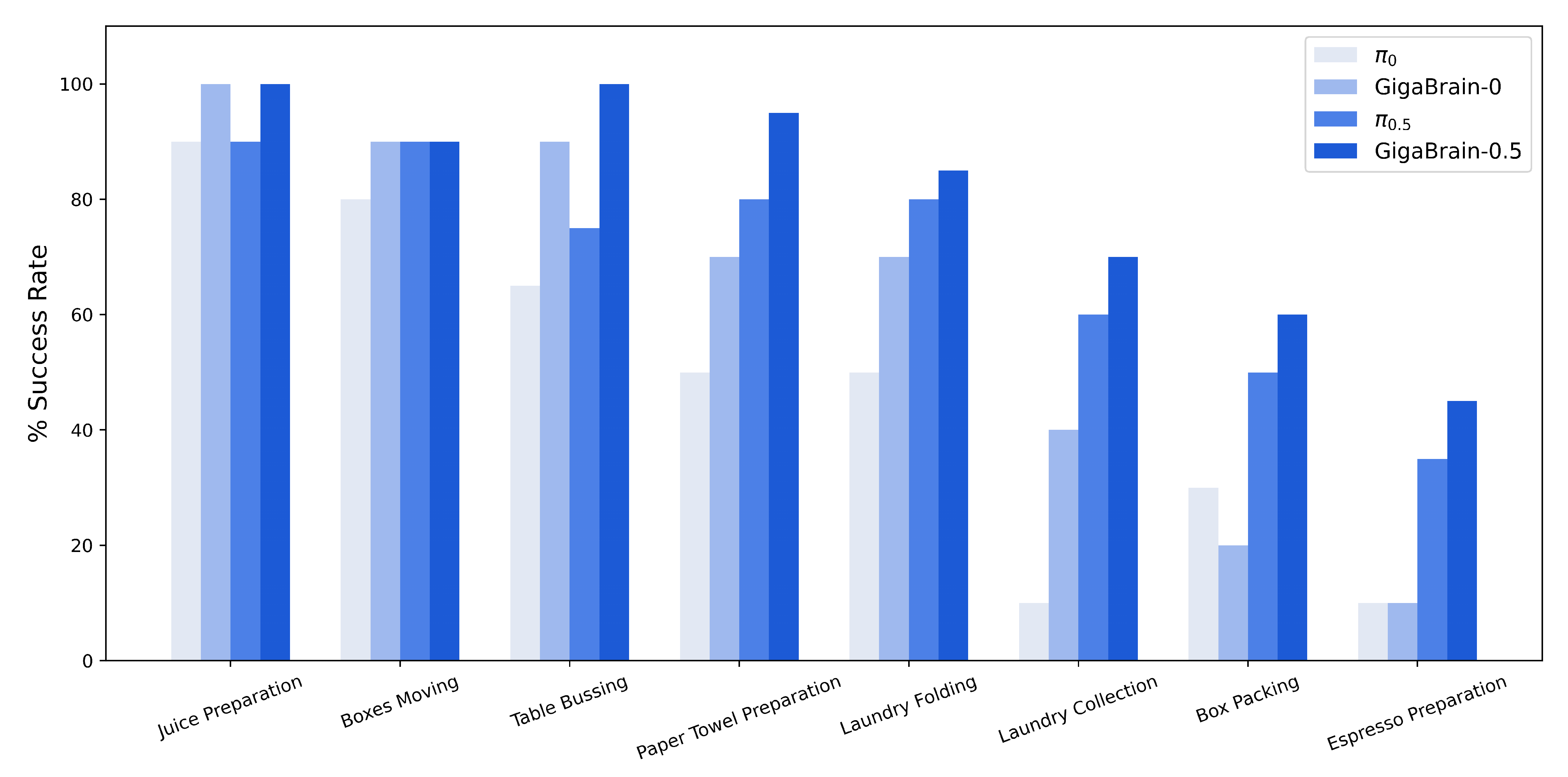

第三,对于内部评估

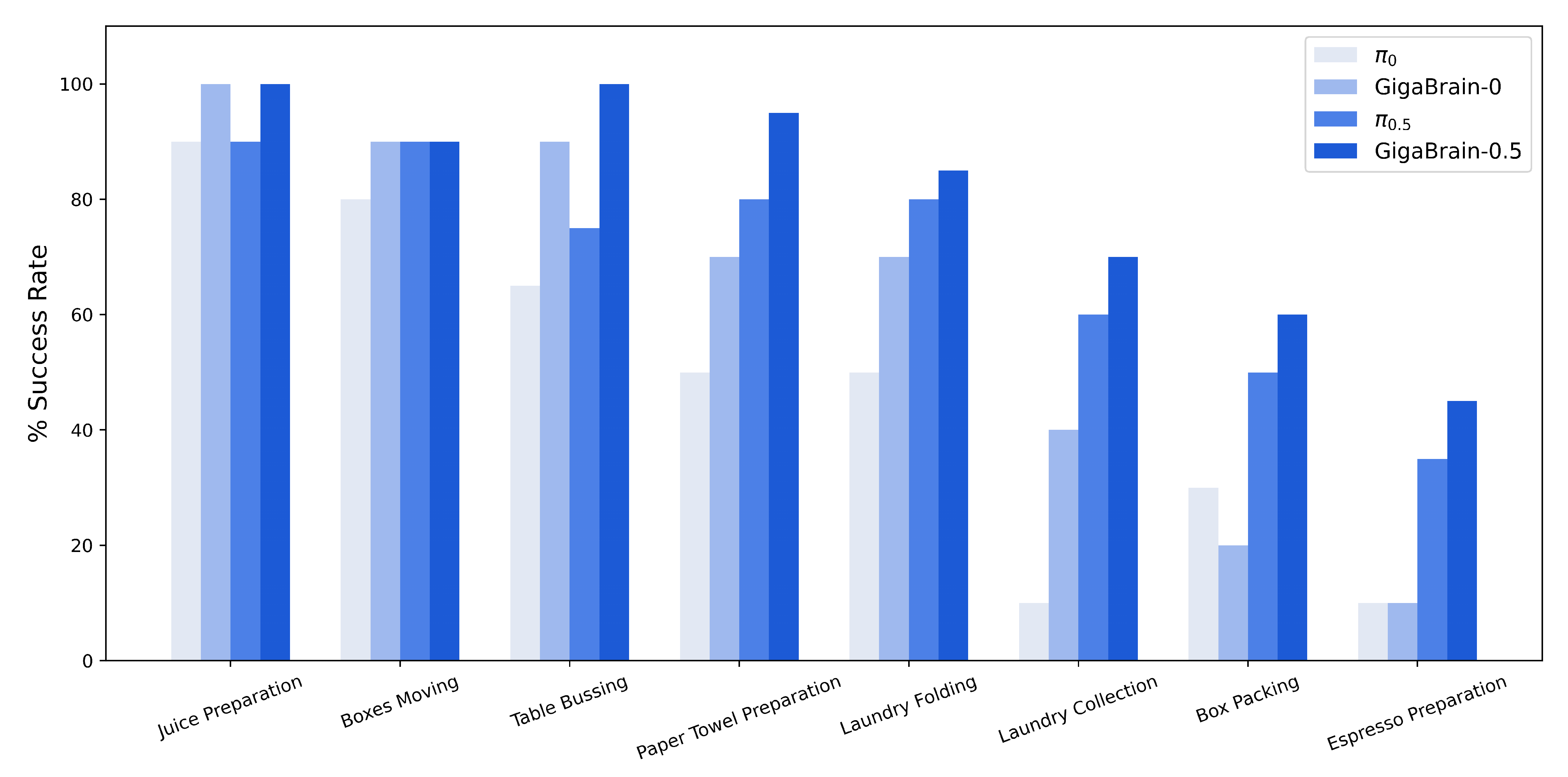

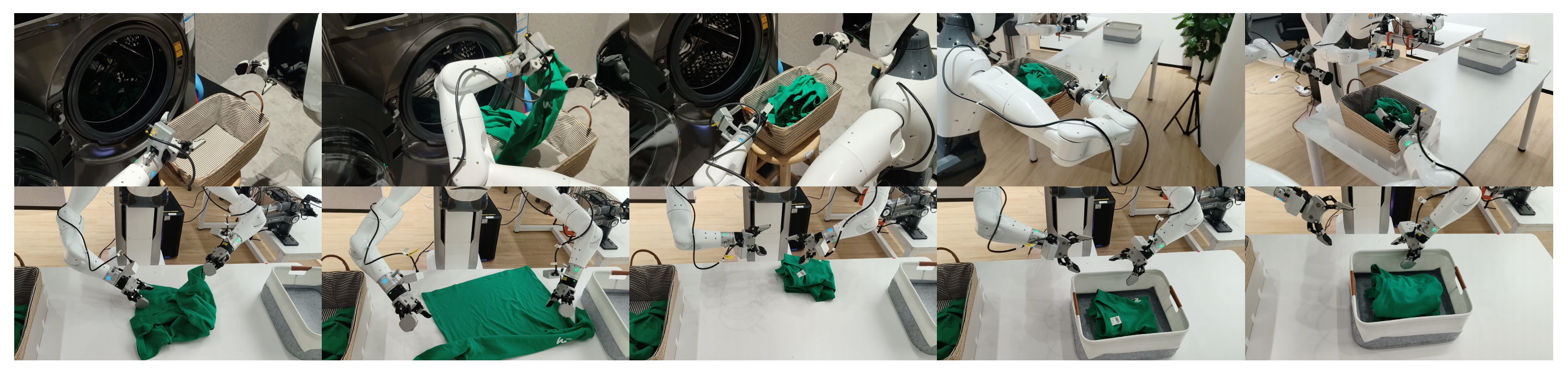

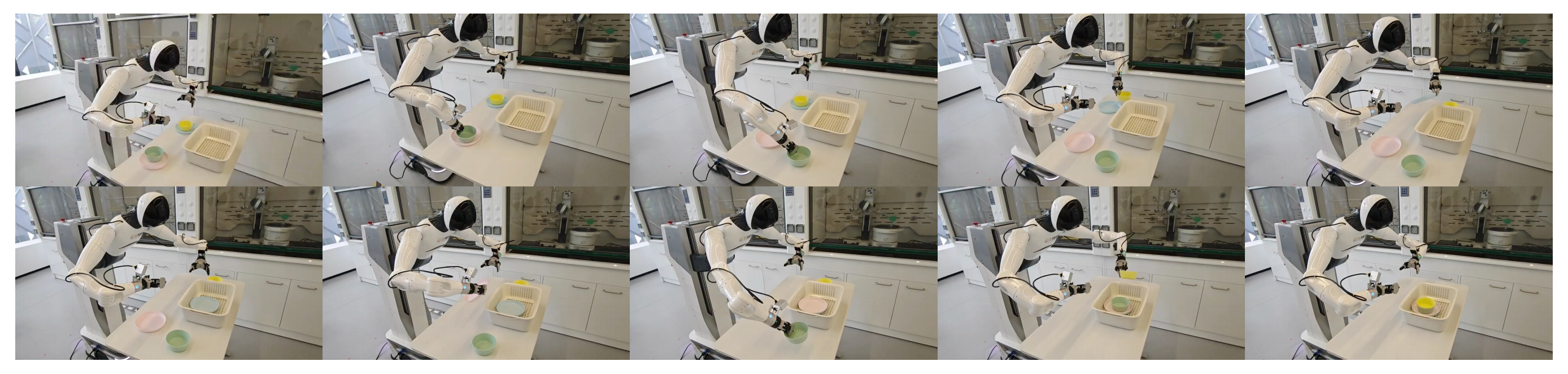

在作者的实验中,作者将GigaBrain-0.5 与若干强有力的基线进行了对比,包括π0(Black etal.,2024)、π0.5 和GigaBrain-0(Team et al.,2025)。结果汇总于图4

GigaBrain-0.5 在所有评估任务上都相较其前身GigaBrain-0(Team et al., 2025) 取得了持续且显著的提升,在每一种情形中都获得了最高的成功率,尤其在复杂的多步流程中有着格外显著的增益

-

例如,在图8所示的Juice Preparation(果汁制作)这一需要按顺序处理和混合原料的任务中

GigaBrain-0.5 达到了100 % 的成功率,超过了GigaBrain-0 的90 % -

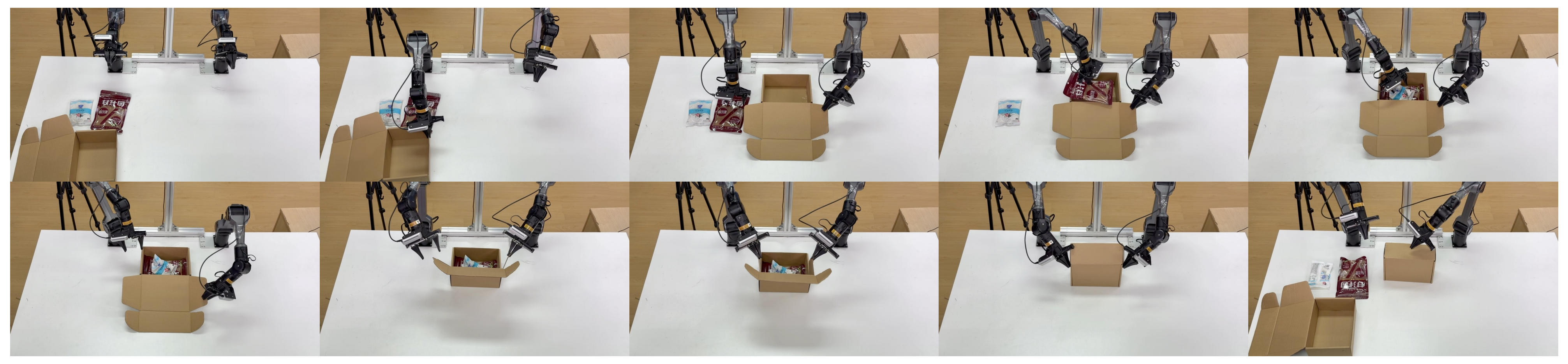

对于诸如

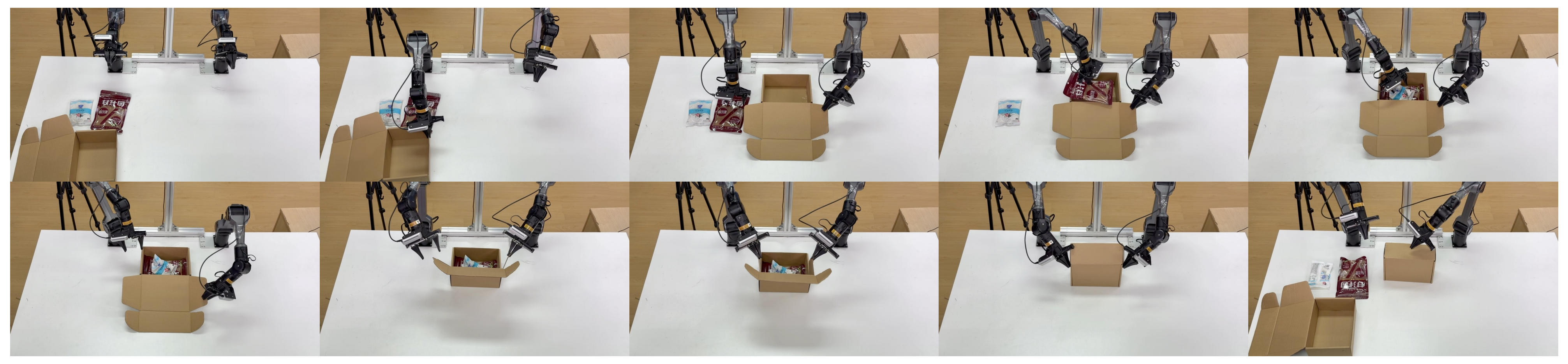

图5所示的++Box Packing++

和

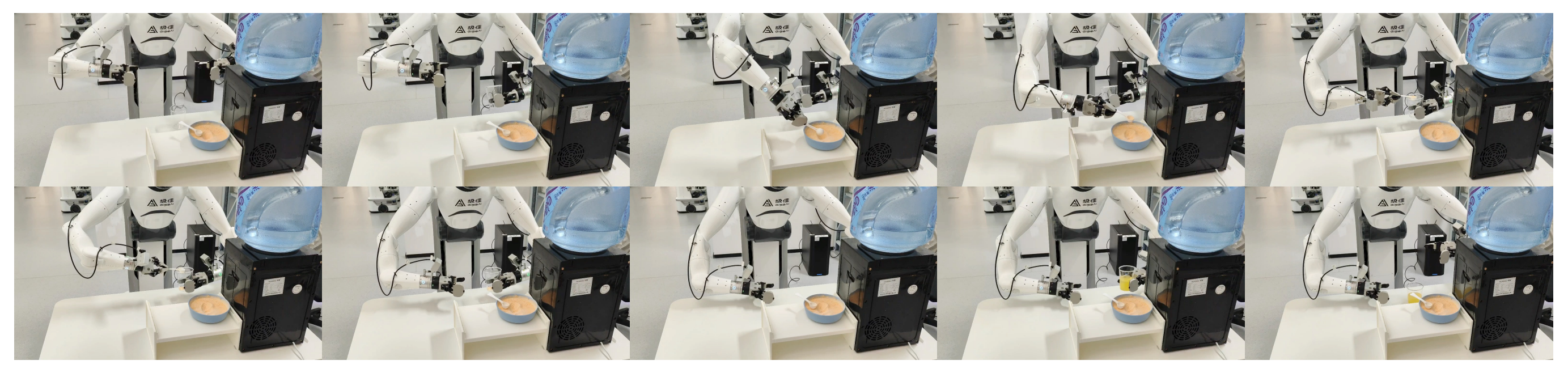

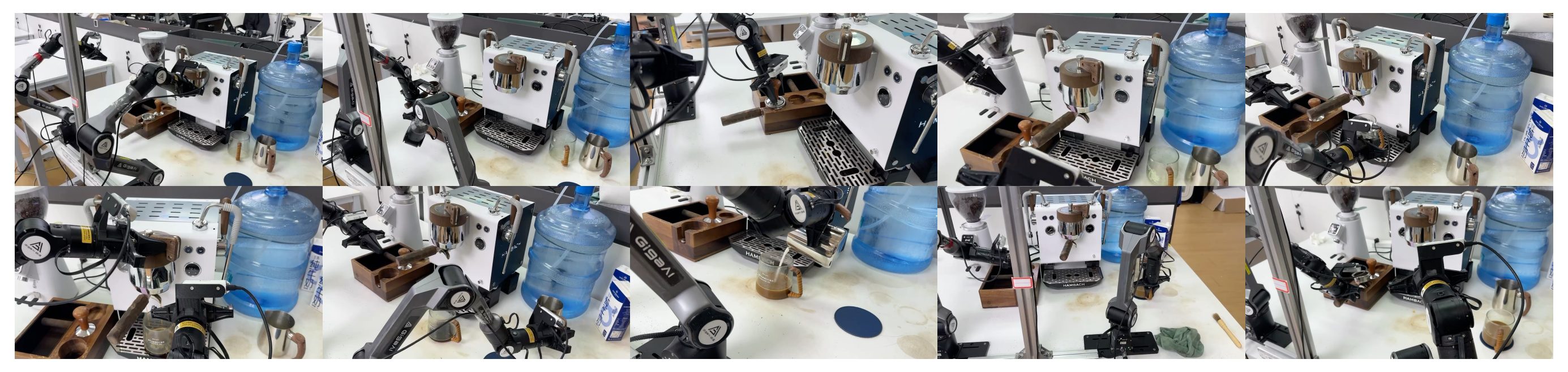

图7所示的Espresso Preparation(意式浓缩咖啡制作)

之类的具有挑战性的任务,GigaBrain-0.5 将成功率分别提高了10 % 和20 % , 相比于π0.5类似地, 在高度灵巧的操作任务

图11所示的Paper Towel Preparation(纸巾准备任务)

图10所示的Laundry Folding(洗衣折叠)

图9所示的Laundry Collection(洗衣收集)

中,GigaBrain-0.5 的成功率皆超过了80 % , 分别比π0.5 高出15 %,5 %, 和10 %。

此外, 作者还做了以下任务

比如图6所示的Box Moving

再比如图12所示的Table Bussing(餐桌清洁)

1.3.2 RAMP 性能:价值预测、用于策略学习的 World Model 条件化、与RL基线的比较

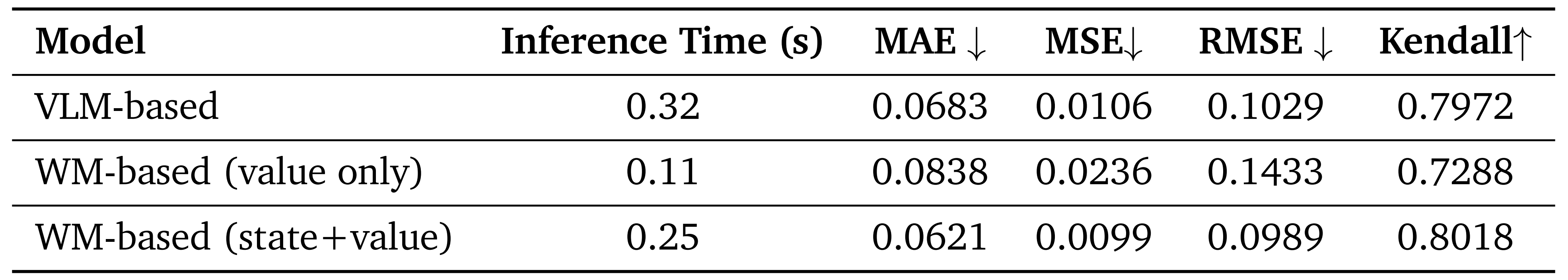

在本节中,作者通过系统的实证评估来回答三个核心问题:

- 与π∗0.6 中采用的基于VLM 的方法相比,基于世界模型的价值预测在准确性和效率方面是否具有优势?

- 世界模型条件化是否增强了视觉-语言-动作策略在跨任务中的泛化能力?

- 在真实机器人环境中,作者提出的RAMP 算法与其他强化学习方法相比表现如何?

第一,价值预测性能

为评估基于世界模型的价值预测效果,作者将其与一个基于 VLM 的基线方法(Intelligence et al., 2025)以及作者的世界模型方法进行对比

-

对于 VLM 中的价值预测,作者在视觉 token 序列末尾插入一个可学习的 [CLS] token,用于聚合全局场景表征,然后将该标记的隐藏状态通过一个回归头投影,产生一个位于 [0,1] 区间的标量数值预测

-

模型使用均方误差进行优化。基于 VLM 与基于世界模型的价值预测器均在相同的预训练数据上进行训练,且一个验证集由图4所示的八个操作任务中约 100 万帧组成

作者使用四种互为补充的度量指标来评估预测质量:MAE、MSE、RMSE(这三项越低越好)以及 Kendall's tau 秩相关系数(该值越高越好,其中 1 表示完美的秩保持)

在所有任务上取平均的结果汇总于表1中

作者宣称,他们揭示了三个关键发现

- 首先,尽管采用了轻量级的VLM(Intelligence et al., 2025------即π0.6),但基于VLM的方法由于SigLIP「Zhai et al., 2023-即Sigmoid loss for language image pre-training」视觉编码器的计算开销,在逐帧推理延迟方面最高(0.32 s,基于A800 GPU)

- 其次,仅预测价值的world model 变体实现了最快的推理速度(0.11s),但预测精度有所下降(MAE=0.0838, Kendall=0.7288),这表明仅基于价值的建模无法充分利用world model 中固有的未来预测能力

- 第三,作者提出的联合预测方案同时预测价值与未来状态,在各方面取得了最佳平衡

它在保持有竞争力的推理速度(0.25s)的同时,实现了最高的Kendall's tau(0.8018)和最低的MAE(0.0621)

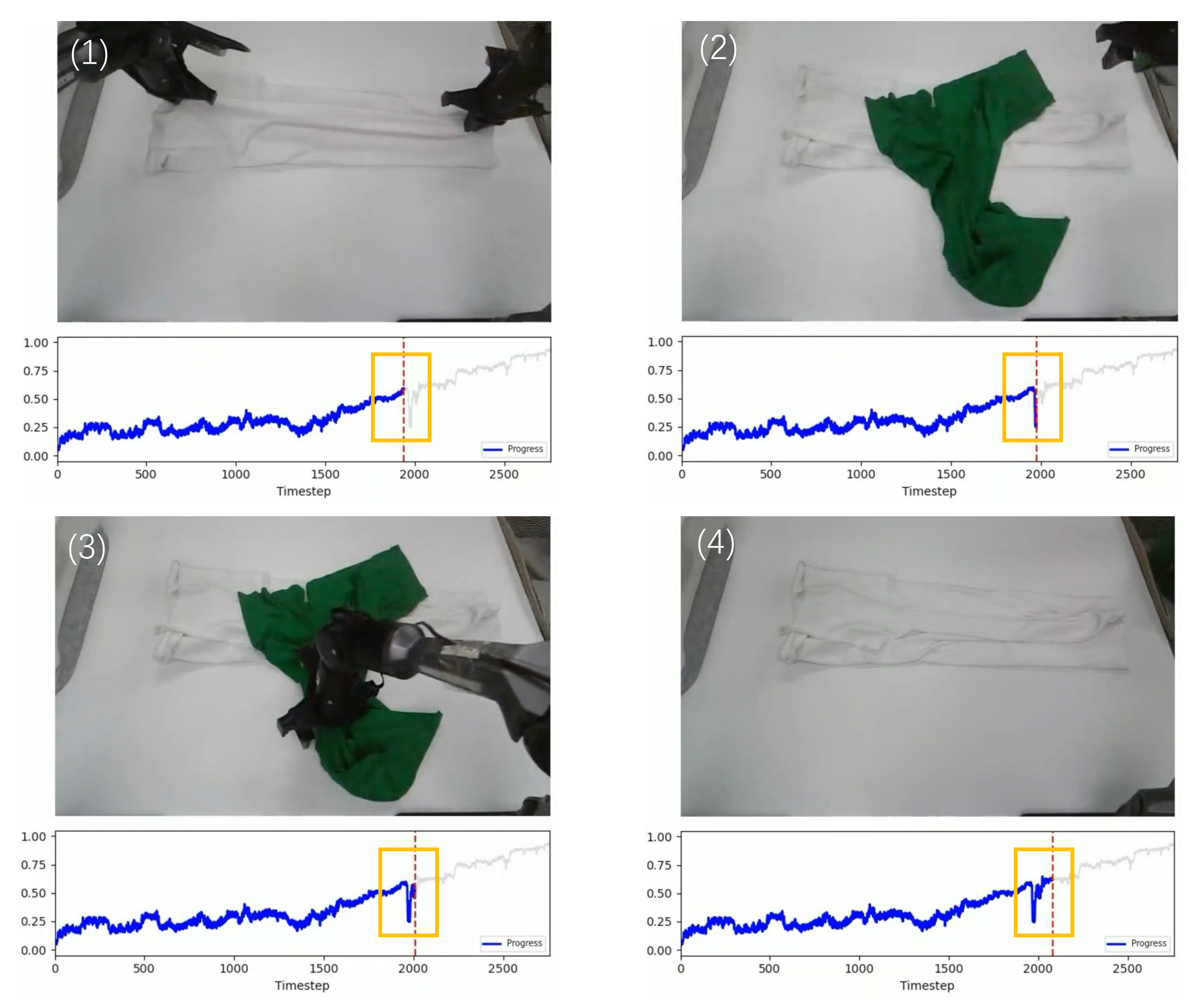

这表明,利用未来状态预测为精确的价值估计提供了关键的上下文支撑。代表性任务的定性价值预测可视化结果如图13 所示

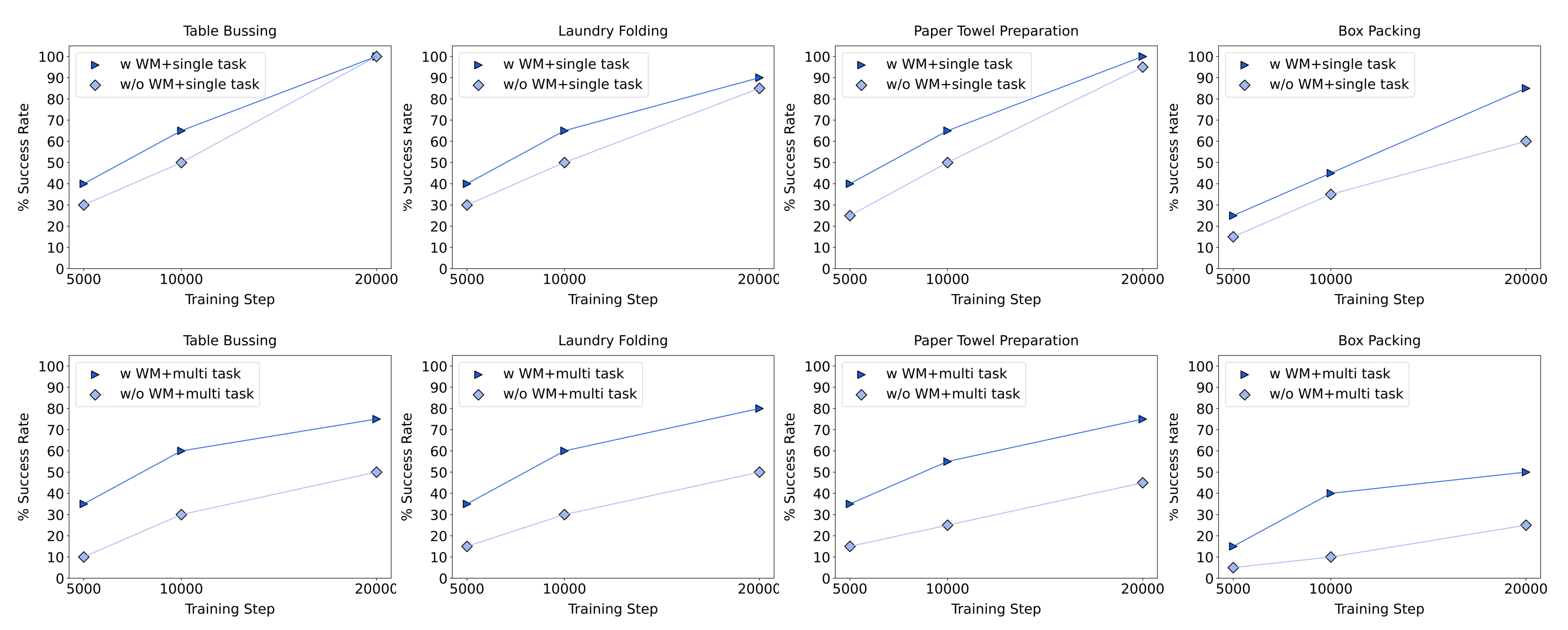

第二,用于策略学习的 World Model 条件化

为了评估 world model 条件化是否能够提升多任务泛化能力,我们在单任务与多任务训练范式之间进行了受控对比实验

作者选取了四个具有代表性的操作任务进行评估:

- Table Bussing(餐桌清理)

- Laundry Folding(洗衣折叠)

- Paper Towel Preparation(纸巾准备)

- Box Packing

为确保公平对比并隔离 world model 条件化本身的影响,作者对所有策略只在 RAMP 的 Stage-2 数据集上进行训练,而不引入任何生成的 rollout数据

- 对于单任务训练,每个策略独立训练 20000 步,batch size 为 256

- 对于多任务训练,作者将来自这四个任务的数据均匀混合,并使用相同的 batch size 训练一个单一策略60000 步

实验结果如图 14 所示,表明引入 world model 条件的方式在单任务和多任务两种训练场景下都能持续优于基线

- 具体而言,引入 world model 在所有评估任务中都带来了显著的性能提升,从 5000 到 20000 步的整个训练过程中都可以持续观察到明显的改进

值得注意的是,这种性能提升在多任务设置下尤为突出:随着训练推进,world model 方法与基线之间的成功率差距不断扩大,在类似 Box Packing 这样的任务上,在第20000 步时成功率最高可提升约 30% - 这表明,world model 条件能够有效促进跨多个任务的知识迁移,同时在单任务场景中也能保持稳健的性能增益

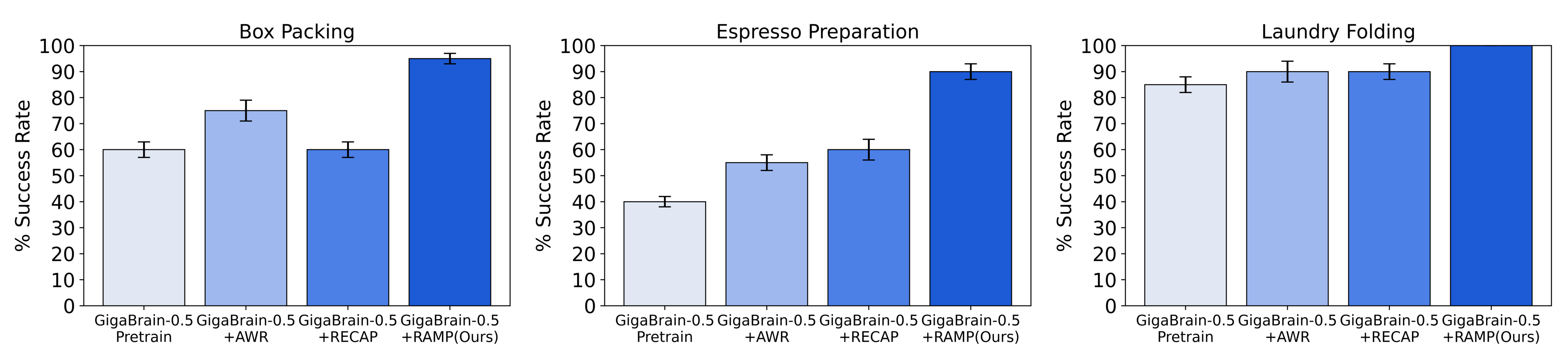

第三,与强化学习基线的比较

作者将 RAMP 与当前最先进的强化学习基线方法进行了基准测试

- GigaBrain-0.5 + AWR (Peng et al., 2019)

一种离线RL 基线方法,使用加权模仿学习微调GigaBrain-0.5 策略,并利用当前策略生成的rollout - GigaBrain-0.5 + RECAP (Intelligence et al., 2025)

一种优势条件化的离线RL 方法,将GigaBrain-0.5骨干网络扩展为带有优势输入,作为去除状态预测后的本方法的消融变体 - GigaBrain-0.5 + RAMP (GigaBrain-0.5M*)

所提出的通过世界模型条件化策略的强化学习框架,使GigaBrain-0.5 策略以预测价值和未来状态潜变量为条件,从而优化长时程任务性能

作者的RAMP 框架在三个高度具有挑战性的操作任务------Box Packing、EspressoPreparation 和 Laundry Folding------上均达到了顶尖性能

如图 15 所示,RAMP 在所有评估任务上都取得了接近完美的成功率,显著优于所有基线方法(GigaBrain-0.5、GigaBrain-0.5+AWR 和 GigaBrain-0.5+RECAP)

- 值得注意的是,RAMP 在 Box Packing和 Espresso Preparation 任务上表现出尤为显著的提升,相比 RECAP 基线高出约 30 个百分点

- 更为关键的是,GigaBrain-0.5M* 模型(即将 GigaBrain-0.5 与作者的 RAMP 框架集成而成)展现出稳健且一致的任务执行能力,在真实世界部署中能够可靠地完成任务,这一点已由作者项目页面上的补充执行视频进行了实证验证

在多种复杂操作任务上取得的这一前所未有的性能,凸显了 RAMP 在解决具有挑战性的真实世界机器人问题方面的有效性

总之,在本研究中,作者提出了 GigaBrain-0.5 及其基于世界模型增强的后继模型GigaBrain-0.5M*,通过大规模预训练和基于模型的强化学习推进 VLA 学习的前沿

- GigaBrain-0.5 在超过 10,000 小时的多样化机器人数据上进行了预训练

在 8 个内部操作任务和 RoboChallenge 基准上的 30 个标准化任务中展现出最先进的性能,取得了51.67% 的平均成功率,并位列公共排行榜首位- 在这一坚实基础之上,GigaBrain-0.5M*引入了一种新颖的、受世界模型条件约束的架构,通过利用未来状态预测来弥补传统 VLA模型固有的有限前瞻能力

通过与 RAMP 相结合,引入基于模型的强化学习,最终,作者表示,他们的方法在跨任务泛化方面表现出强大的鲁棒性,并且能够可靠地执行复杂的长时间跨度任务,例如顺序装箱和制作浓缩咖啡- 展望未来,GigaBrain 系列将探索更高效地利用模型rollout 数据,以在降低计算开销的同时最大化合成轨迹的信息价值

此外,作者还计划研究更具可扩展性的自演化范式,使系统能够通过闭环交互实现数据的自动整理、策略优化以及世界模型的持续更新

// 待更