文章目录

- 一、卷积的概念

-

- 1.卷积

- 2.信号处理

- 3.深度学习中的卷积

- 4.卷积的应用

-

- (1)图像分类、目标检测、语义分割

- (2)卫星图

- [(3)防复印技术 CWM、OWM](#(3)防复印技术 CWM、OWM)

- 二、卷积神经网络的概念

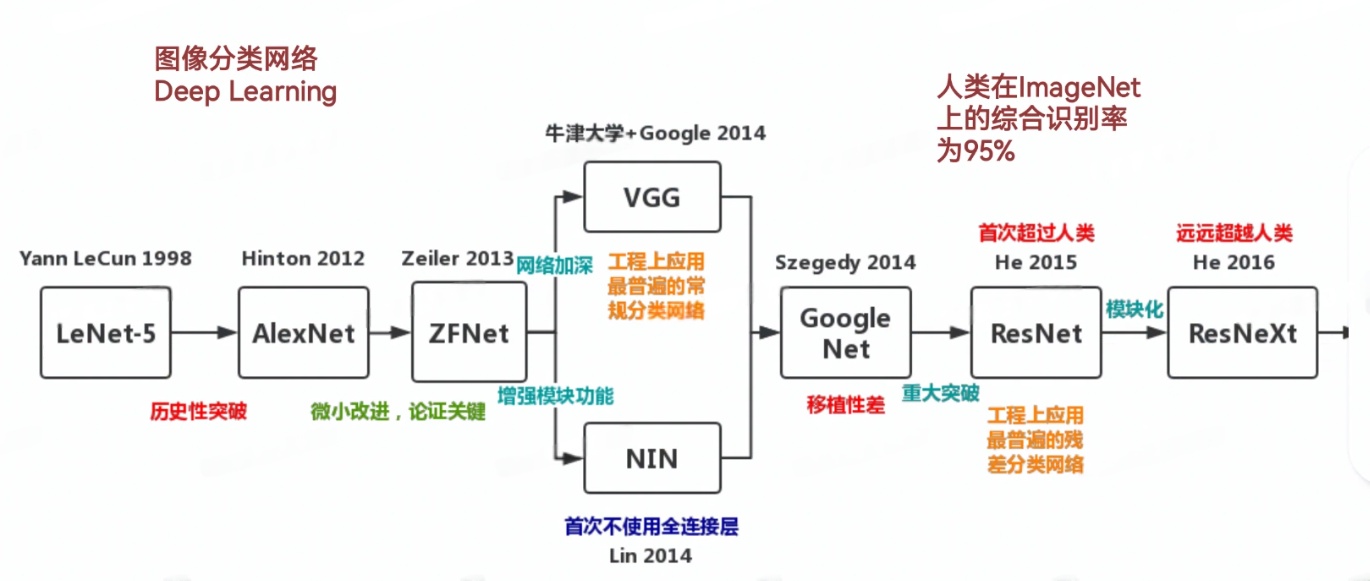

- 三、CNN类的神经网络

-

- 1.AlexNet (2012)

- 2.VGG (2014)

- 3.GoogLeNet (2014)

- 4.ResNet:残差网络,分类 (2015)

- 5.U-Net:分割 (2015)

- 6.MobileNet (2017)

- [7.R-CNN (2014)、Fast R-CNN (2015)、Faster R-CNN(2015):目标检测](#7.R-CNN (2014)、Fast R-CNN (2015)、Faster R-CNN(2015):目标检测)

一、卷积的概念

1.卷积

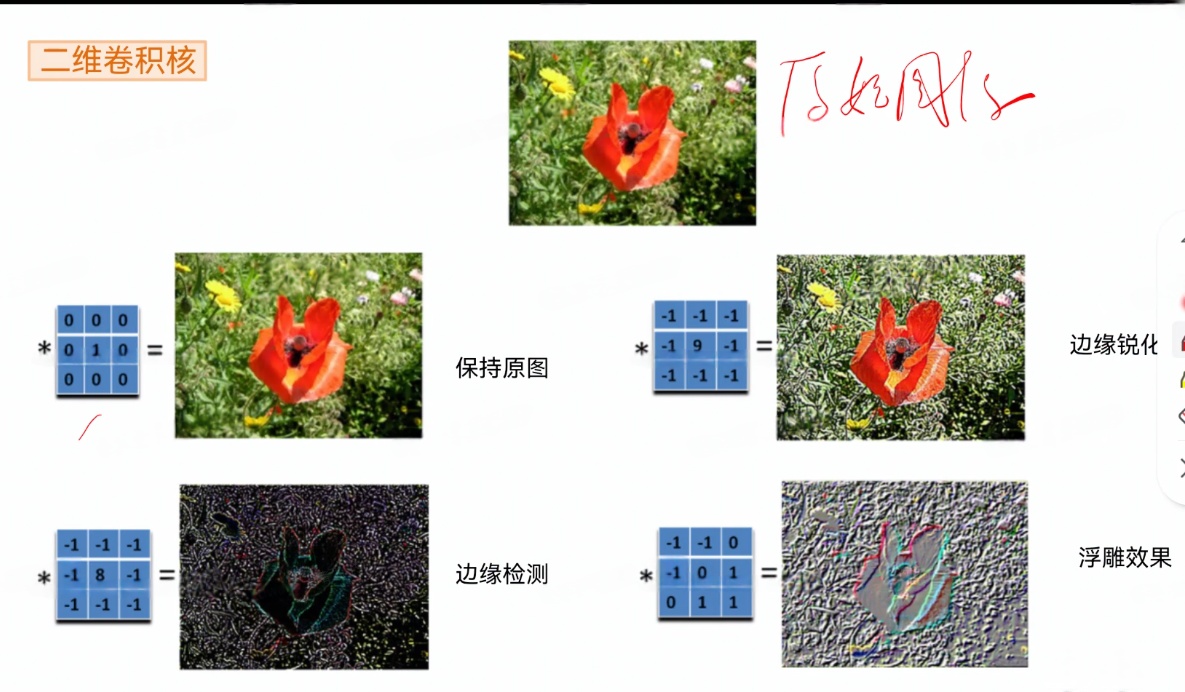

1.卷积的作用:

利用卷积核,可以改变输入信号。

通过调整卷积核,可以达到特定的信号改变的效果。

2.信号处理

(1)三大变换

- 拉普拉斯变换

- 傅里叶变换:与卷积是互通的

- Z变换

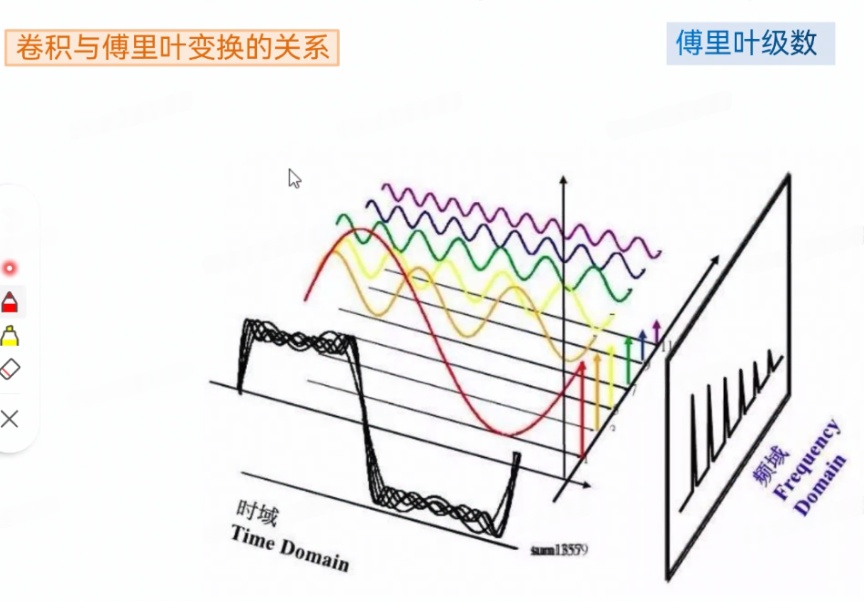

(2)卷积与傅里叶变换的关系

高通滤波,低通滤波 (例如音响设备的频响特性)

傅里叶变换 和 卷积 存在数学上的对应关系,利用这个关系可以构造具备期望频率滤波特性的卷积核。

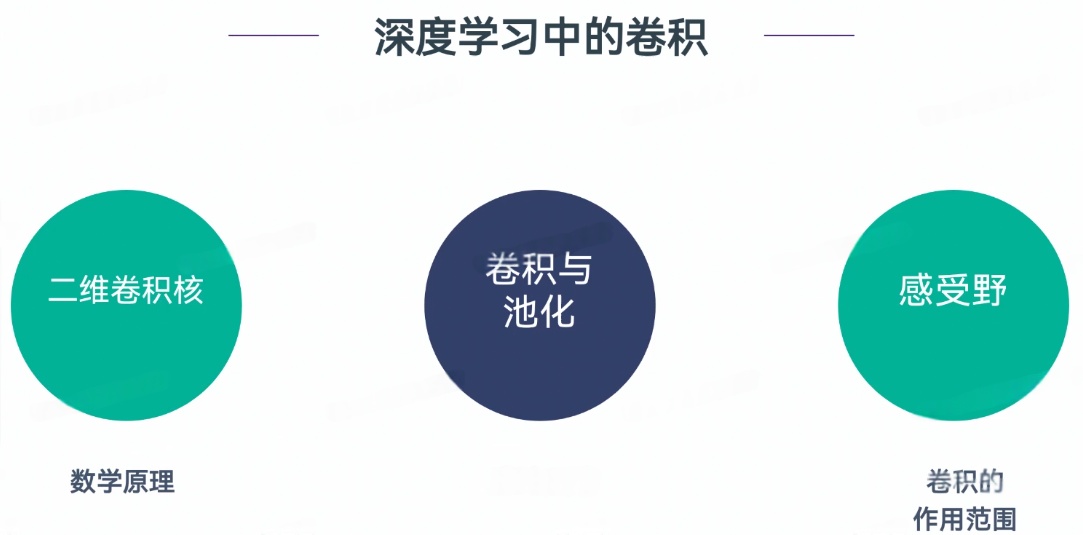

3.深度学习中的卷积

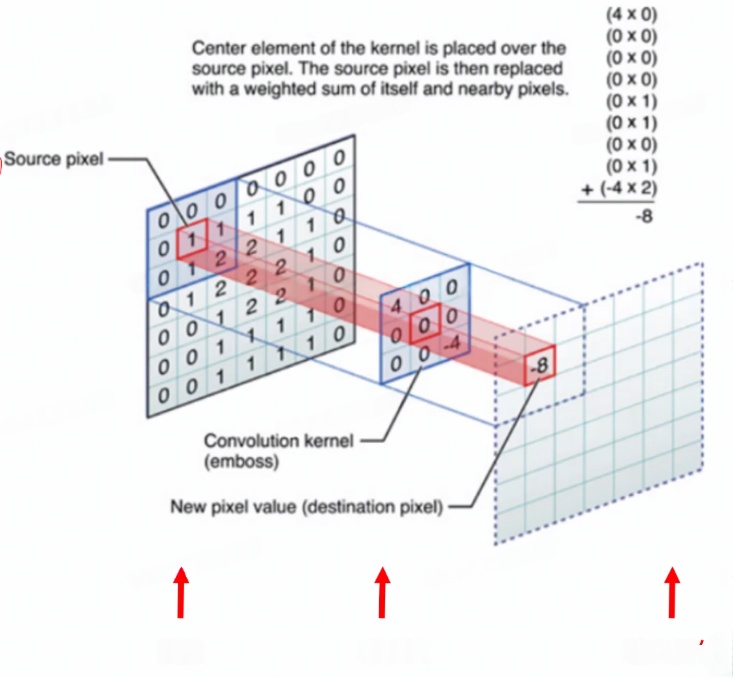

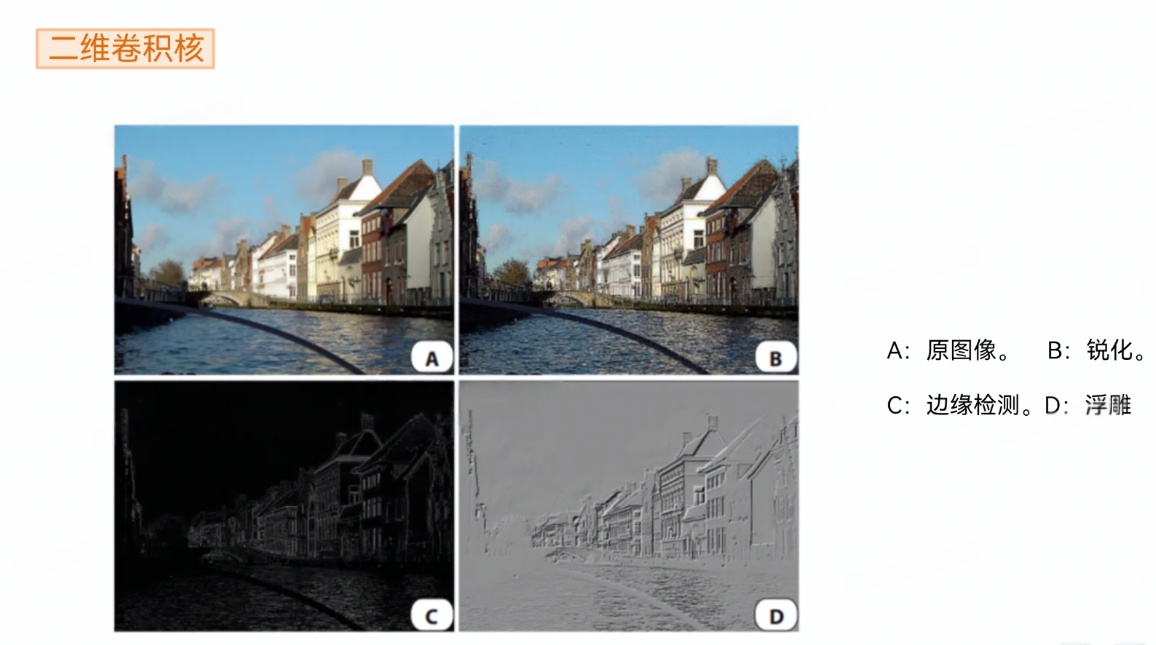

(1)二维卷积核

深度学习中的卷积核是二维的。

借用了卷积这个名词,但不是数学上严格意义的卷积。

1.翻转 (省去)

2.滑动

3.加权平均 (对应相乘再相加)

例如:3×3的卷积核:对应相乘再相加

(2)卷积与池化

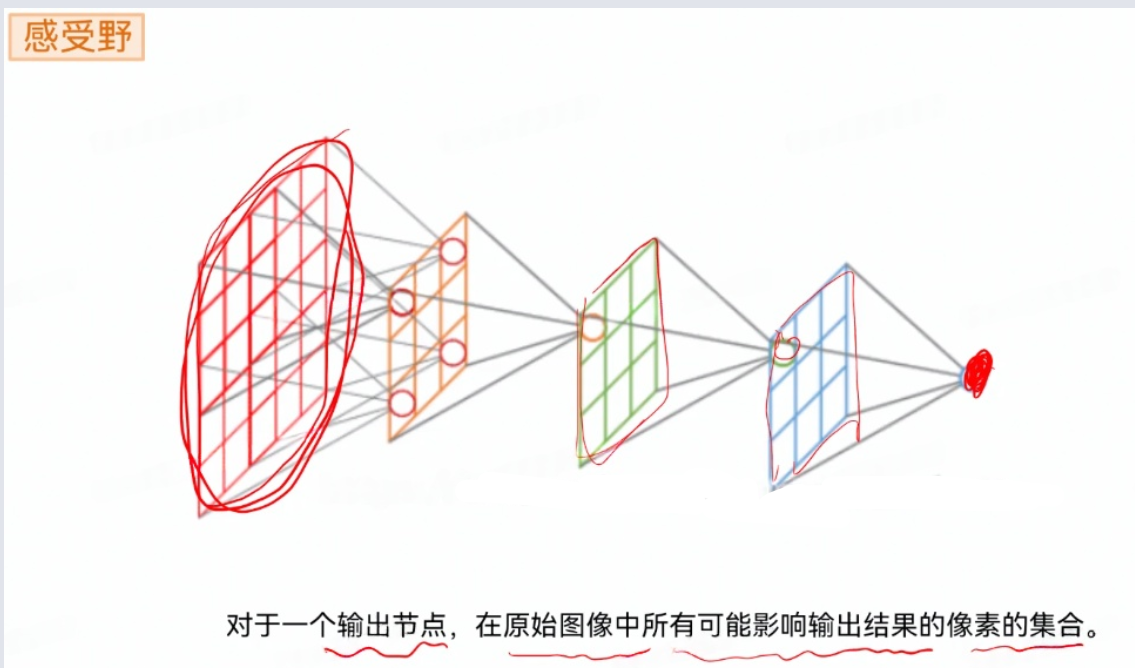

(3)感受野

实现AI造脸

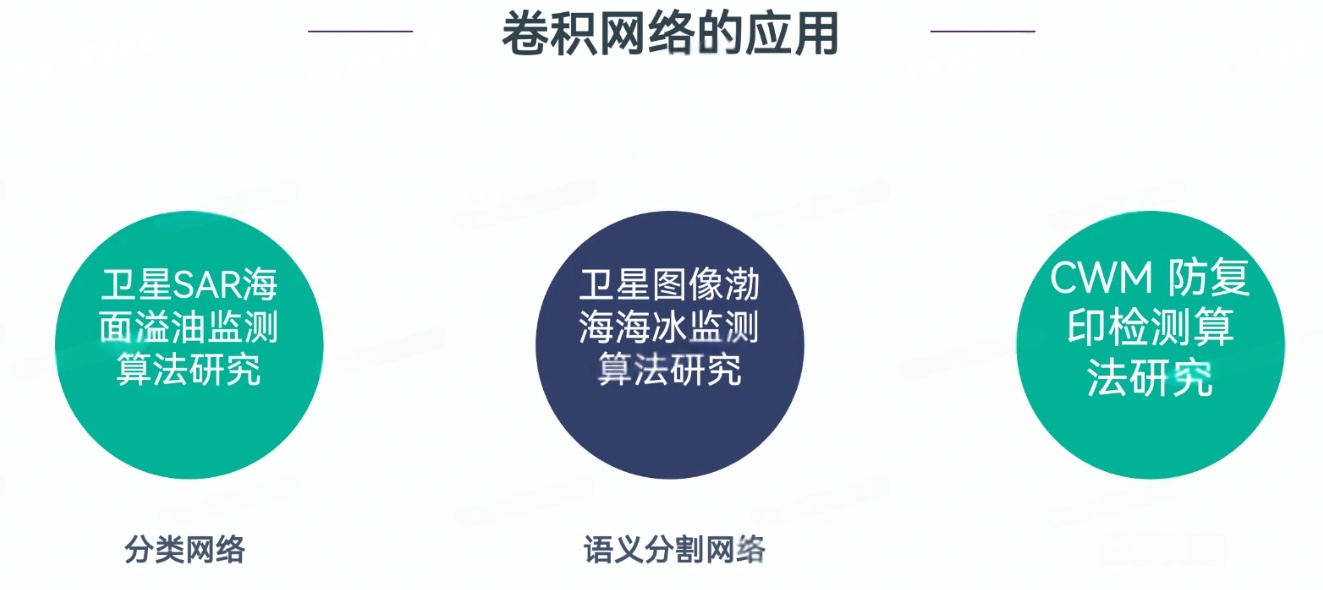

4.卷积的应用

(1)图像分类、目标检测、语义分割

YOLOv7 :

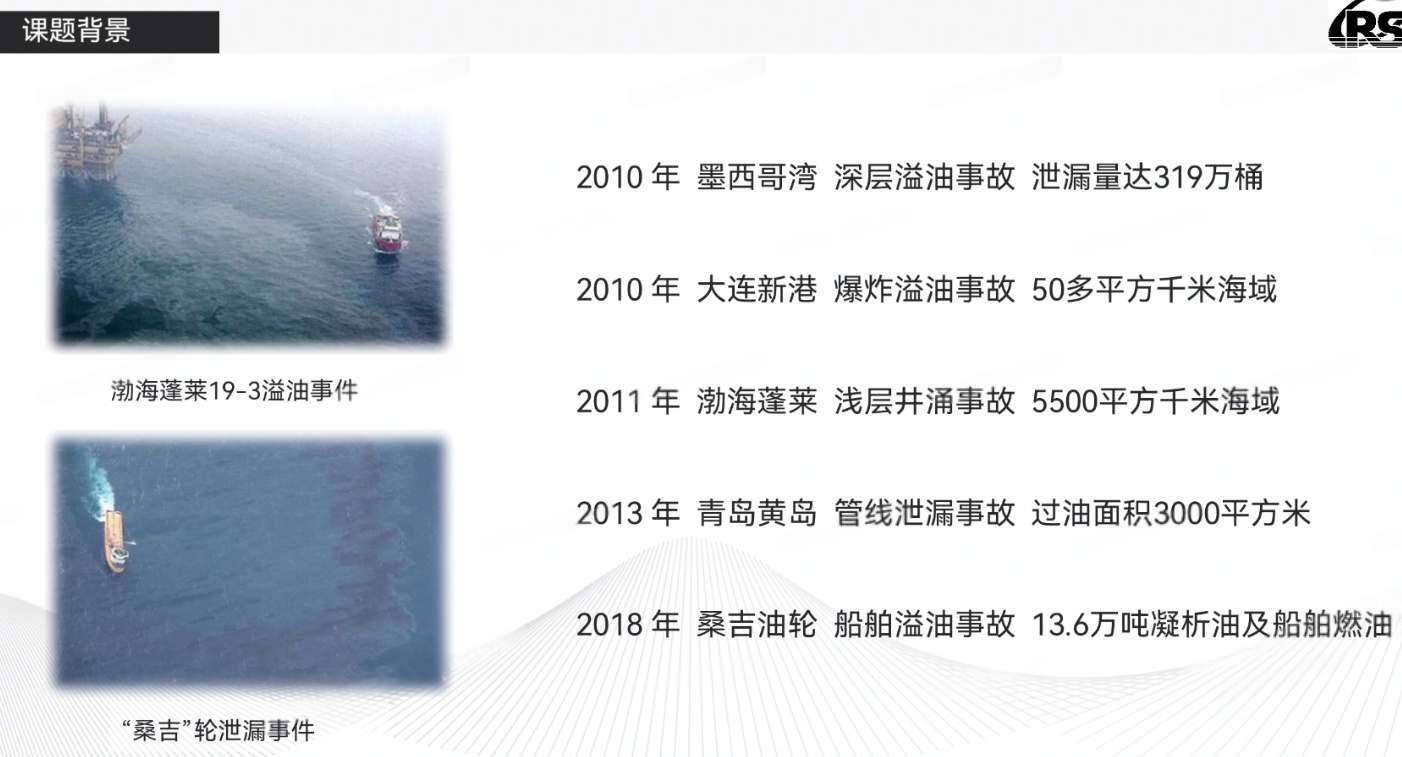

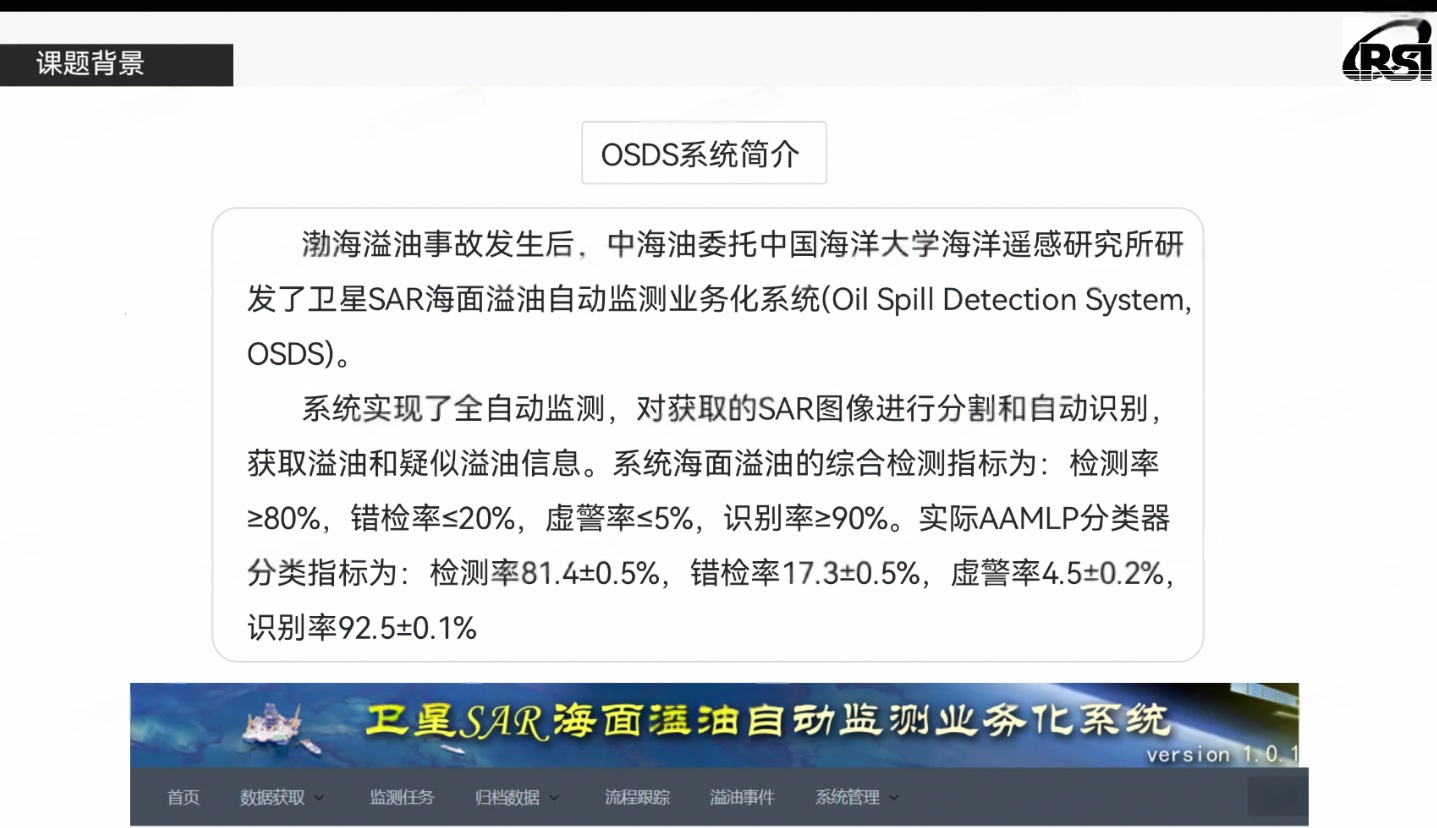

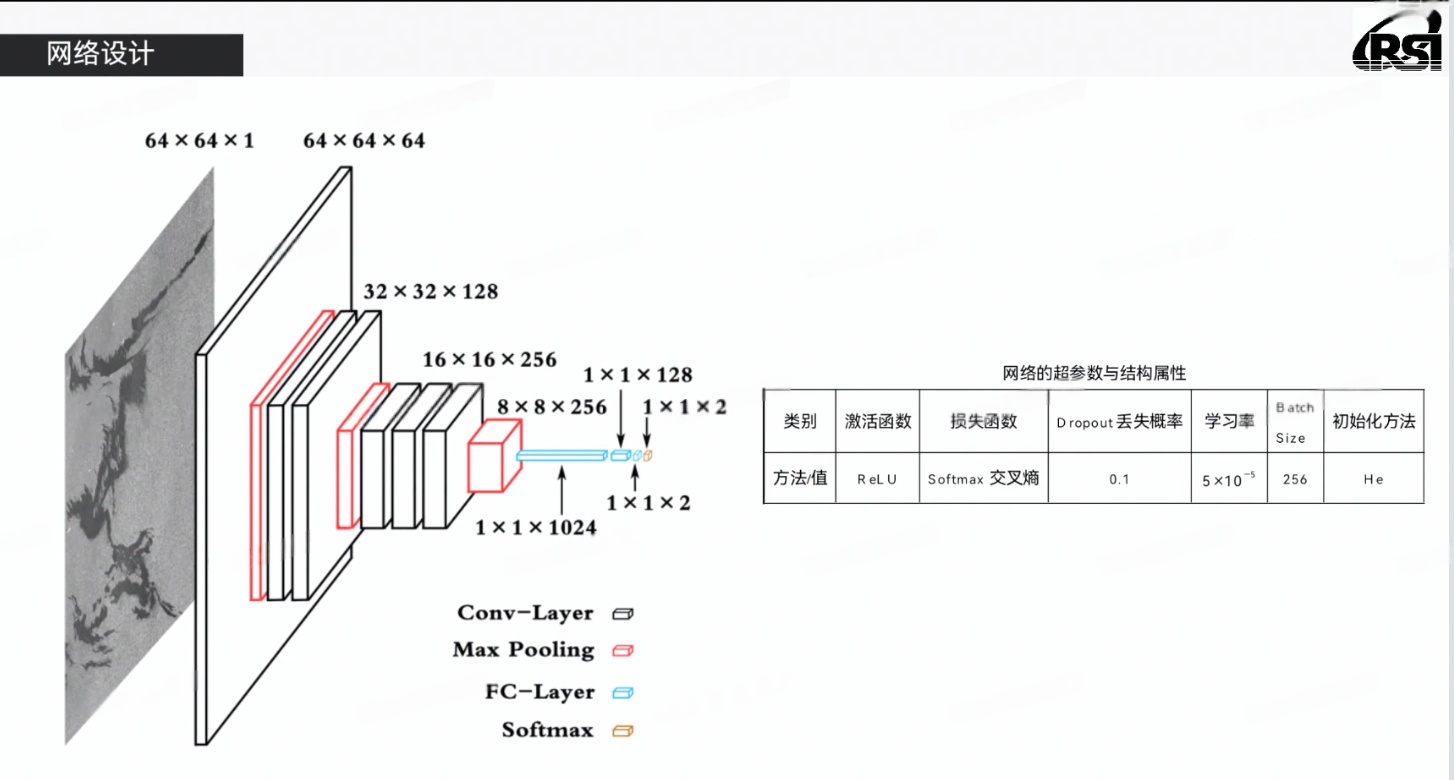

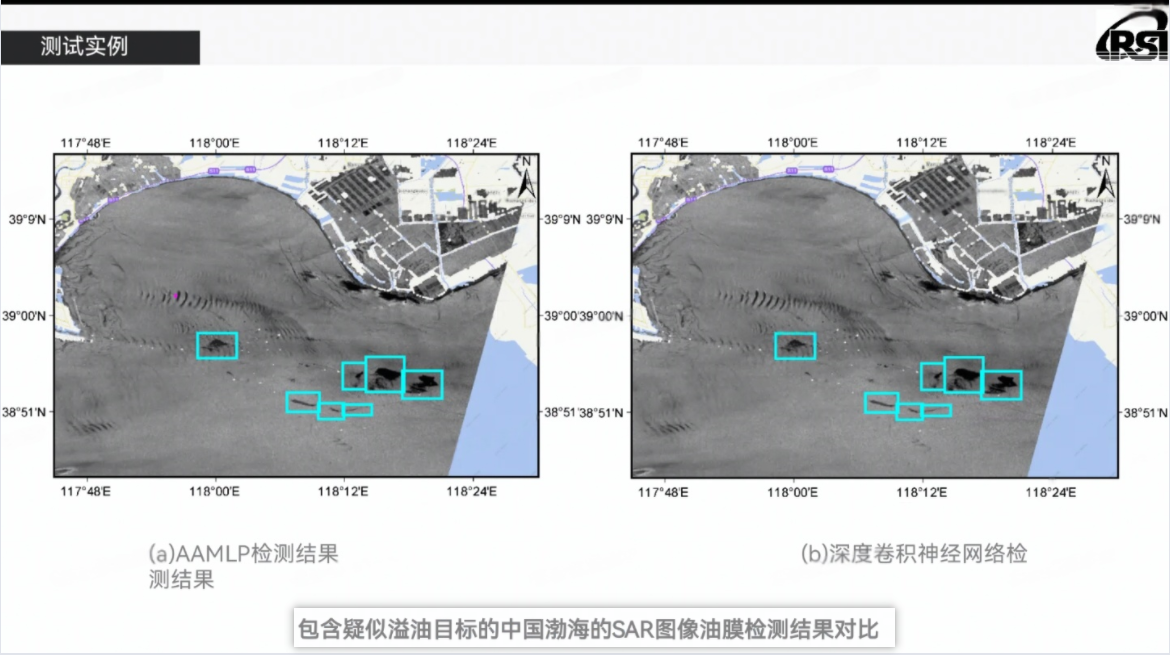

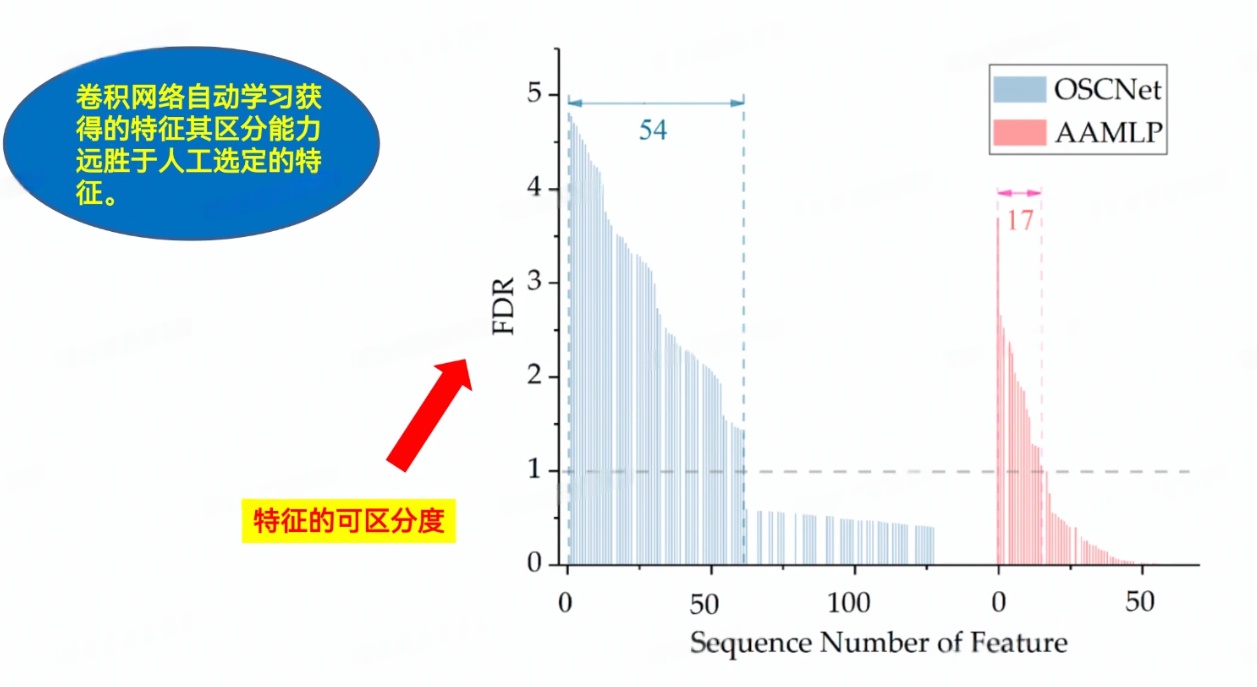

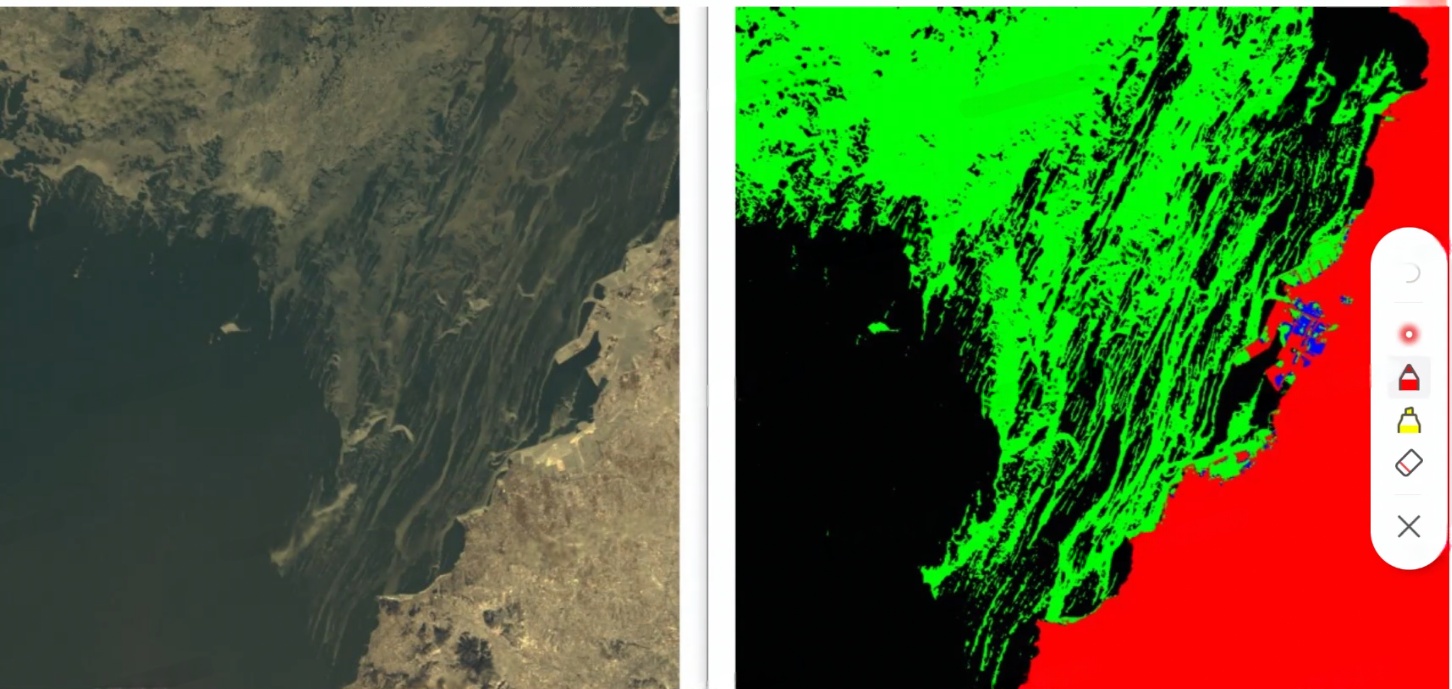

(2)卫星图

卫星图:区分白色是海冰还是云

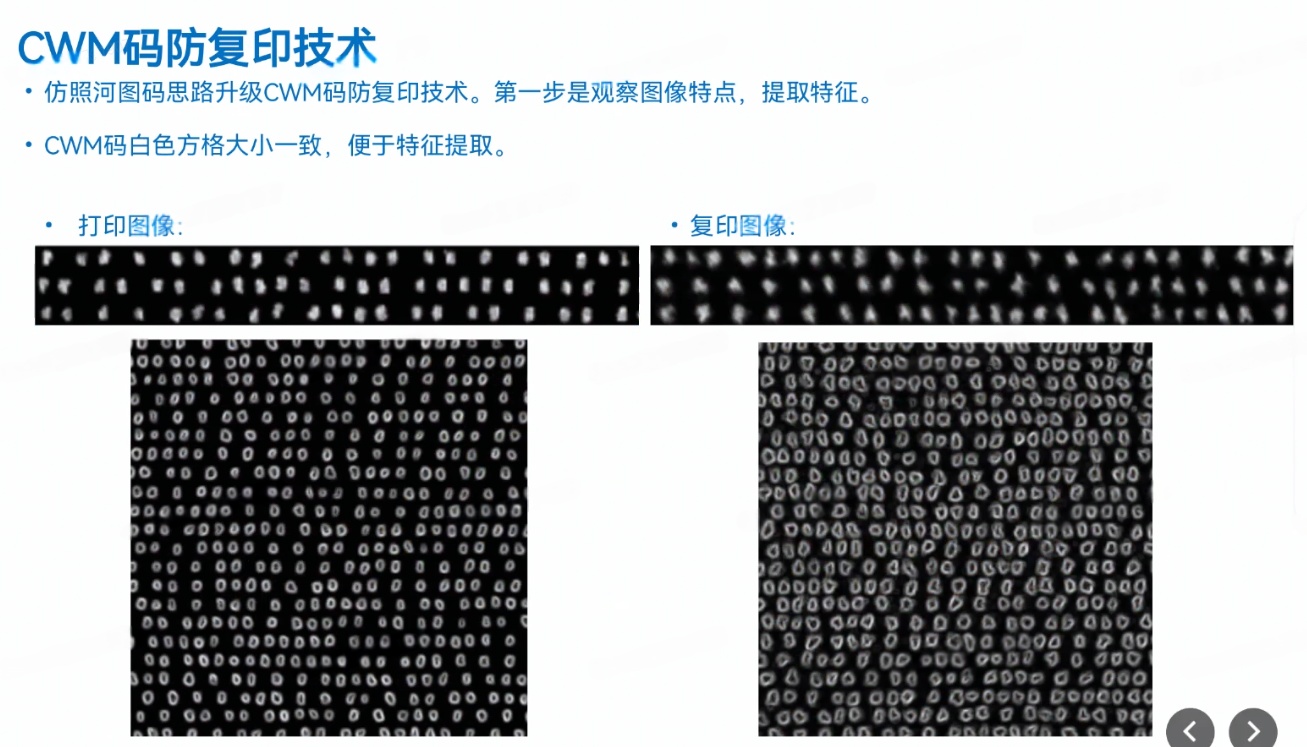

(3)防复印技术 CWM、OWM

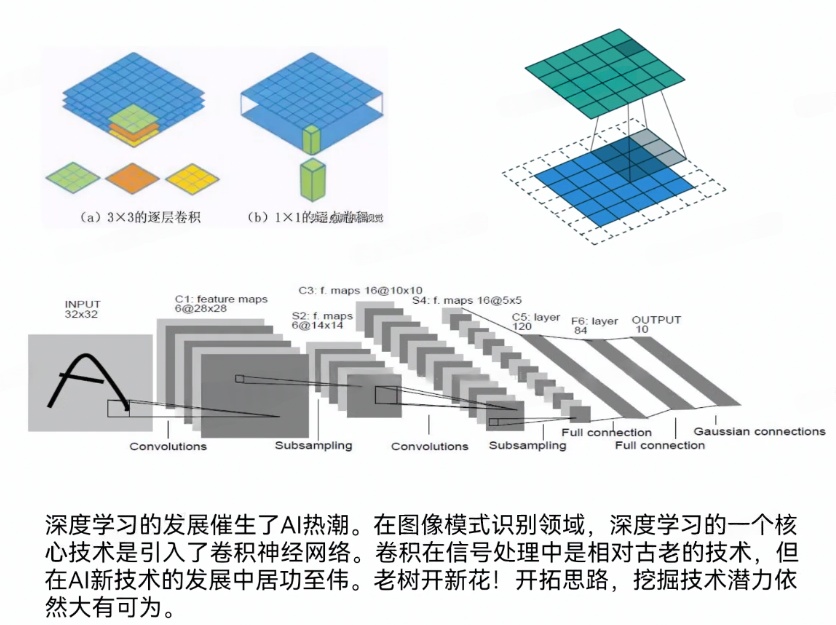

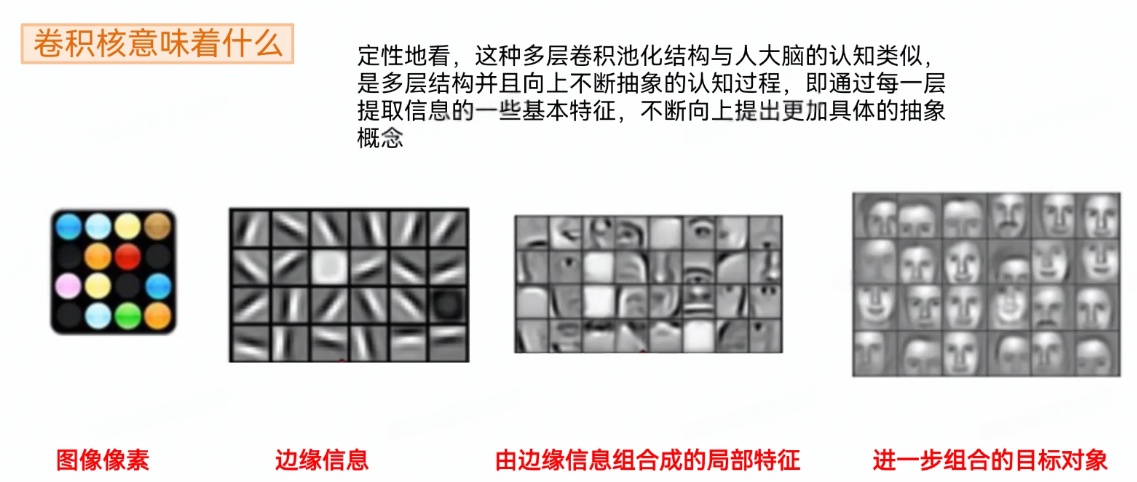

二、卷积神经网络的概念

1.CNN的定义

卷积神经网络(Convolutional Neural Network,CNN)是一类深度学习模型,广泛应用于图像处理、计算机视觉、语音识别、自然语言处理等领域。

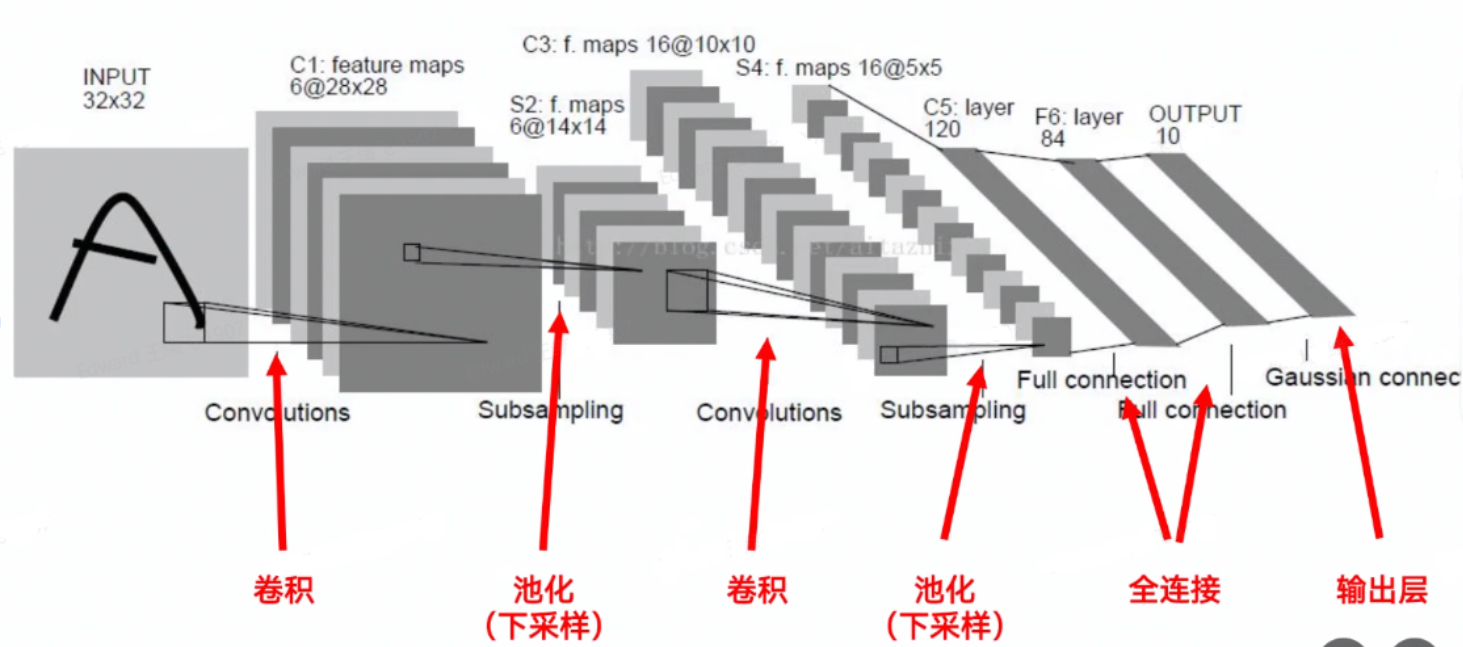

2.CNN的工作流程

CNN的工作流程:

①输入层 :图像数据作为输入进入网络,通常是一个多维数组 (如RGB图像为高度 × 宽度 × 通道数)

②卷积层 :应用卷积核进行局部特征提取,生成特征图。

③池化层 :通过池化操作对特征图进行降维,减少计算量和特征图的尺寸。

④全连接层 :将高层次的特征进行整合,输出最终的分类结果(如猫或狗)。

⑤输出层:网络的最终输出,通常是类别标签(如Softmax层输出的概率分布)。

3.CNN的应用

①检测任务

②分类与检索

③超分辨率重建 (SR,Super-resolution Reconstruction)

④医学任务:OCR

⑤自动驾驶 (无人驾驶、智能驾驶)

⑥人脸识别

4.CNN的相关概念

1.概念

卷积(Convolution)

①卷积核 :size

②步长 :stride >1,图像尺寸就会减小。

③填充 :padding

填充(padding)是指在输入高和宽的两侧填充元素(通常是 0 元素)。为了避免卷积之后图片尺寸变小,通常会在图片的外围进行填充(padding),如下图所示:

④channel:提高

填充可以增加输出的高和宽。这常用来使输出与输入具有相同的高和宽。

步幅可以减小输出的高和宽

2.CNN:随着网络深度增加(不停地Conv),空间尺寸会变小,通道数channels会变大。

过拟合(overfitting):模型太强大了,模型参数过多,数据不足。模型在训练集上表现非常好,但在验证集或测试集上的表现较差。

三、CNN类的神经网络

1.AlexNet (2012)

- 提出年份:2012年

- 特点:AlexNet是第一个成功应用在大规模图像分类任务(ImageNet)的深度神经网络。它通过多个卷积层和全连接层叠加,并使用ReLU激活函数,大大提高了训练效率。此外,AlexNet引入了Dropout和数据增强来防止过拟合。

- 结构:包含5个卷积层和3个全连接层。AlexNet通过最大池化层逐渐减少特征图大小,使得计算效率较高。

2.VGG (2014)

1.参数

cpp

TOTAL params: 138M parameters2.卷积核尺寸 3×3

- 提出年份:2014年

- 特点:VGG网络进一步加深了网络结构,使用小卷积核(3×3)和更深的网络结构(例如16或19层)。其设计思想是通过多个3×3卷积层堆叠来提取特征,而不是使用大卷积核,从而增强了模型的表征能力。

- 结构:典型的 VGG-16 和 VGG-19 都是深度卷积神经网络,包含16层或19层卷积层和全连接层。相比AlexNet,VGG的结构更深,但也因此计算量更大。

3.GoogLeNet (2014)

1.参数

cpp

only 5M parameters!

Total: 358M ops2.计算量的计算

feature map → output size ??补

- 提出年份:2014年

- 特点:GoogleNet的创新之处在于引入了Inception模块,在同一层中使用不同大小的卷积核来提取不同尺度的特征。此外,GoogleNet的结构相较于VGG和AlexNet更复杂,但参数量更少。

- 结构:由多个Inception模块组成,每个模块包含1×1、3×3和5×5卷积核,允许模型自动学习特征图的多尺度信息,减少了参数量的同时保持了较高的表现。

4.ResNet:残差网络,分类 (2015)

ResNet (何恺明,2015)

1.参数

cpp

Total depths of 34,50,101 layers2.过程:

四个残差块

3.功能

分类、分割

5.U-Net:分割 (2015)

U-Net 主要应用于图像分割 任务,特别是在医学图像分割中表现突出。编码器、解码器。

ResNet 更侧重于图像分类及深度网络训练的优化。

6.MobileNet (2017)

轻量化网络

7.R-CNN (2014)、Fast R-CNN (2015)、Faster R-CNN(2015):目标检测

RPN:Region Proposal Network

预测:两阶段 (Two Stage Detection )、一阶段 (One-Stage Detection )

①backbone + Region Proposal Network

②预测object

Faster R-CNN 对比 End-to-End Object Detection with Transformer

简单场景、小物体为主:CNN(如Faster R-CNN)更为适合。

复杂场景、大物体为主或需要全局推理:Transformer(如DETR)具有更大潜力。

DETR的创新在于直接采用Transformer将目标检测简化为集合预测问题,展示了在未来目标检测系统中全面采用自注意力机制的可能性。