从第一性原理与工程控制论看AI Agent开发:步骤、误区与设计之道

AI Agent开发正处于从"玩具"到"工具"的演进阶段,许多团队陷入"过度设计""架构先行"的泥潭。本文结合第一性原理(回归事物本质)与工程控制论(强调系统的可控性、稳定性与反馈),系统论述Agent开发的正确步骤、常见错误及设计原则,帮助开发者构建真正务实、可成长的智能系统。

一、第一性原理:AI Agent的本质是什么?

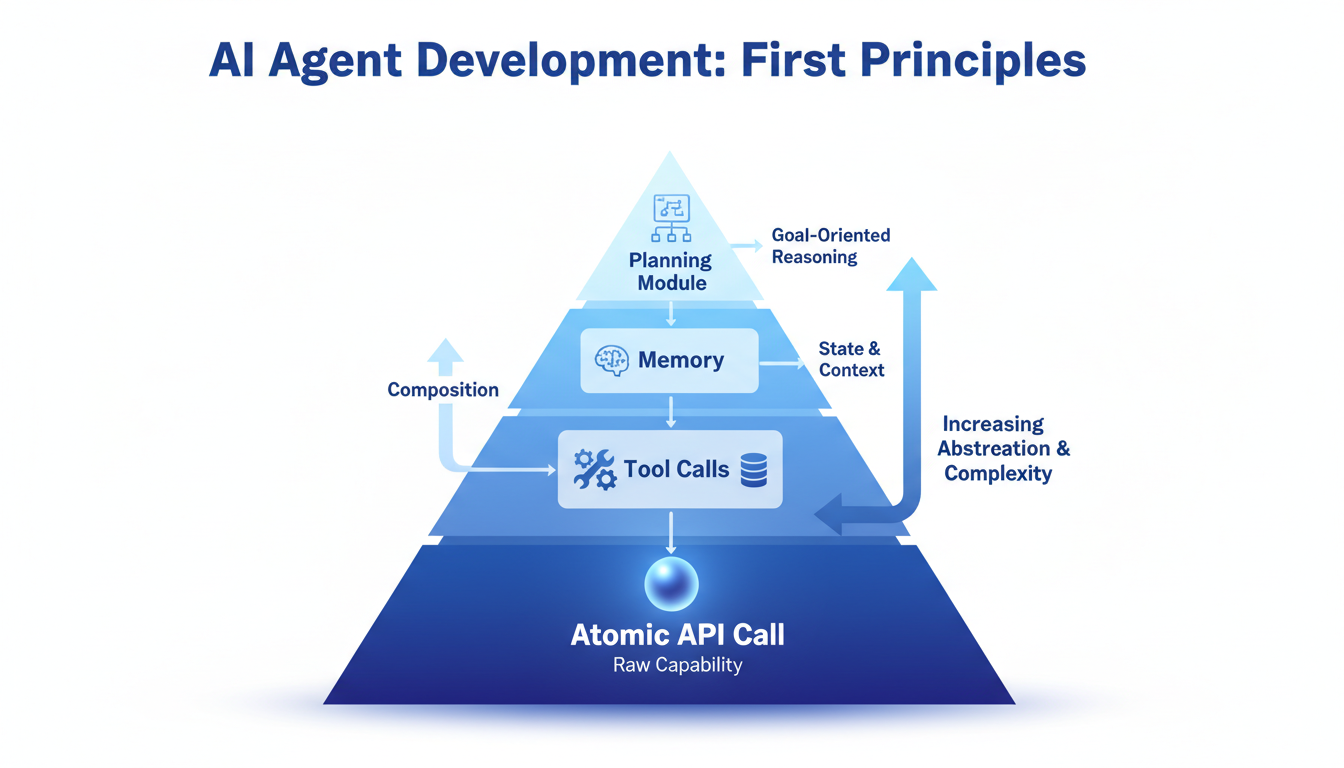

第一性原理要求我们剥离表象,直击核心。AI Agent的本质可拆解为:

- 基础能力:调用大语言模型(LLM)完成一次"输入-输出"转换(即单次API调用)。这是所有Agent能力的原子单元。

- 非确定性:LLM的输出具有概率性,即使相同输入也可能产生不同结果。这是与传统软件(确定性系统)的根本区别。

- 扩展性:通过串联多次调用、引入外部工具、维护记忆等,可实现更复杂任务。

第一性原理启示 :任何Agent系统都应从最简单的原子能力出发,只有当原子能力无法满足需求时,才考虑叠加复杂性。任何脱离原子能力的架构设计都是"空中楼阁"。

二、工程控制论视角:如何让Agent系统可控?

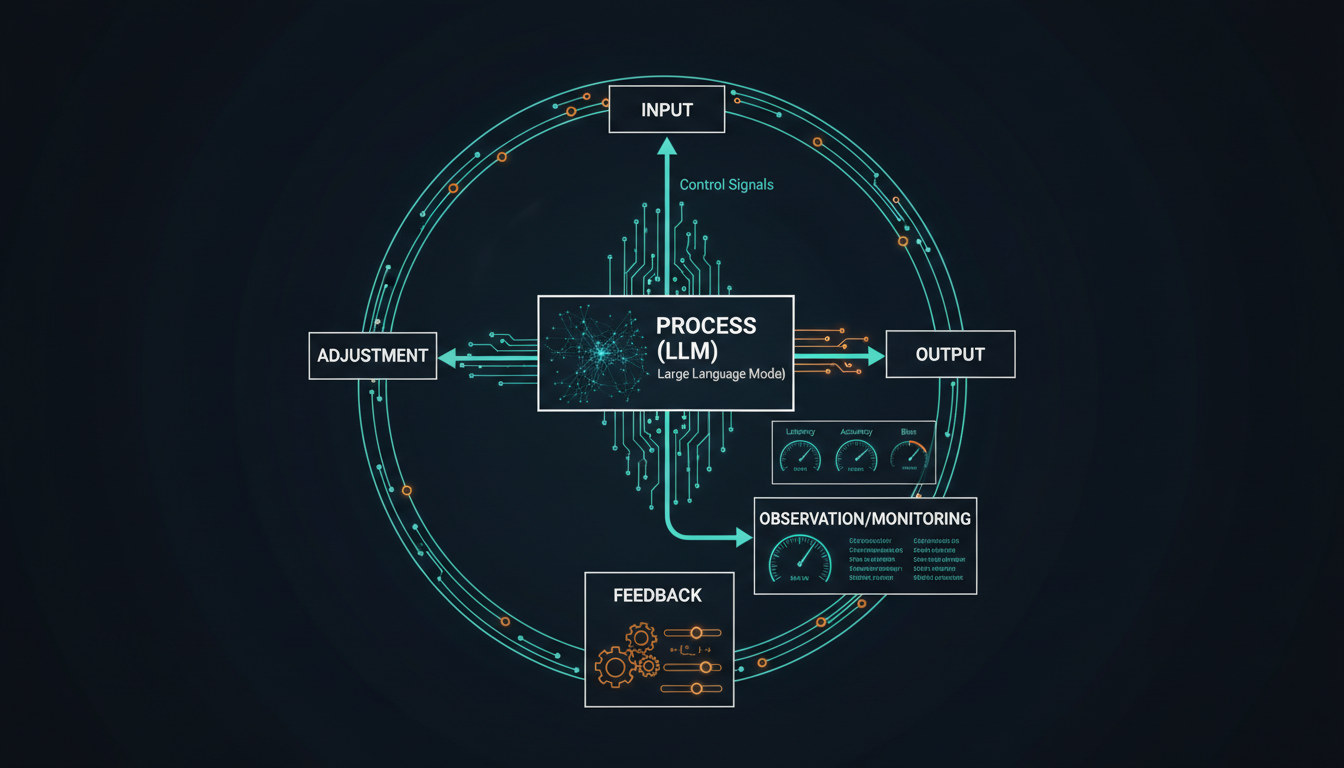

工程控制论研究系统的调节、稳定与优化。将控制论思想应用于Agent开发,需关注:

- 可控性:系统行为能否被预期和调整?复杂链路会降低可控性。

- 可观测性:系统内部状态和失败原因能否被追踪?黑盒系统无法调试。

- 稳定性:系统在输入变化或部分失效时能否保持核心功能?非确定性叠加易引发振荡。

- 反馈调节:通过实际运行结果调整系统设计,而非一次性完美规划。

控制论启示 :Agent系统应设计为可观测、可调试的闭环,通过小步快跑、反馈迭代来逼近稳定,而非一次性开环设计。

三、结合第一性原理与控制论的开发步骤

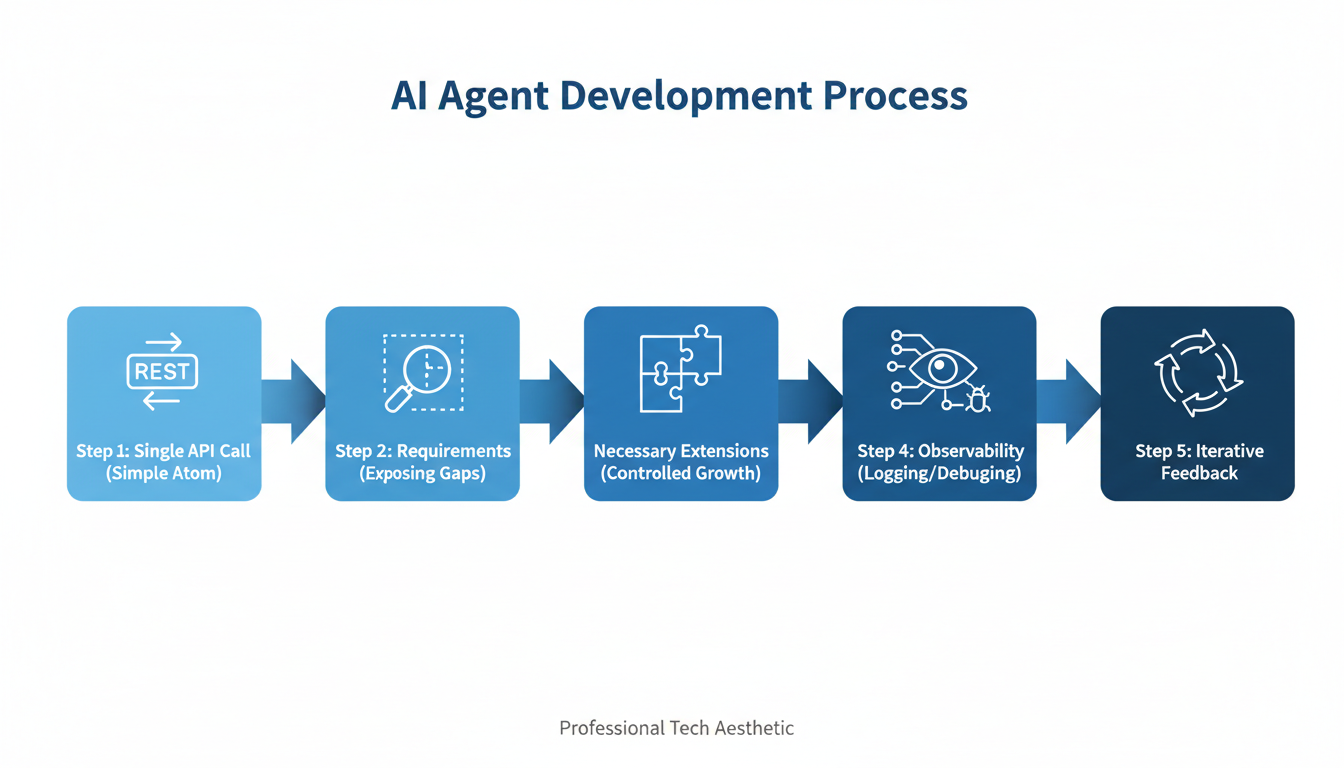

步骤1:定义最小可行问题,从单次API调用起步

- 做法:无论最终目标多宏大,先找到最核心、最简单的需求(如"生成标题""提取关键词"),用一次API调用实现。

- 原理:第一性原理要求从原子能力开始;控制论强调先建立可观测的基线系统。

- 文档案例:许多任务(如视频封面生成)本可一次调用解决,却被强行拆分为多步Agent流程。

步骤2:引入实际需求,逐步暴露复杂性缺口

- 做法:将最小系统投入真实场景,观察哪些需求无法满足(如需要多步骤推理、需要调用外部工具、需要记忆上下文)。

- 原理:控制论中的"需求驱动反馈"------复杂性应由问题本身逼迫产生,而非预设。

- 文档案例:视频剪辑中需删除语气词和冗余内容,单一API无法处理长上下文,才催生了多步骤处理的需求。

步骤3:每次扩展遵循"必要性+可控性"原则

- 做法:针对暴露的缺口,引入最小化的新组件(如增加一个工具调用、添加短期记忆)。每增加一个模块,必须确保其可观测、可调试,并评估对系统不确定性的放大效应。

- 原理:第一性原理要求每个组件都有不可替代的必要性;控制论要求新组件不破坏系统可控性。

- 文档案例:避免"给蚊子装火箭助推器"------为简单任务引入计划-执行模式,导致失败点增多且无法调试。

步骤4:建立可观测性,优先处理失败案例

- 做法:为每一步调用添加日志、追踪ID,隔离上下文,使失败链路可回溯。对常见失败模式进行专项优化(如重试、降级)。

- 原理:控制论的核心是反馈,而反馈依赖可观测性。没有可观测性,系统就是黑盒,无法改进。

- 文档案例:复杂架构导致"有些失败无法debug",正是违背可观测性的后果。

步骤5:通过实际反馈持续迭代,而非重构

- 做法:基于线上数据,识别瓶颈,以最小代价调整(如修改提示词、替换工具)。避免大规模重构,除非当前架构已无法承载需求。

- 原理:控制论中的"小步调节"优于"大幅震荡";第一性原理要求保持核心简单。

- 文档案例:Agent应从"小问题"一步步"被逼着长大",而非一开始设计完美架构。

四、常见错误与反模式

| 错误类型 | 第一性原理/控制论视角 | 案例 |

|---|---|---|

| 过度设计 | 违背原子能力优先原则,为简单任务添加复杂框架,导致不确定性叠加。 | 一句话总结任务使用计划-执行模式,成本上升且效果下降。 |

| 盲目模仿权威 | 忽略自身阶段,直接复制大厂架构,相当于在未建立基线时引入复杂控制回路。 | 照搬Anthropic的"完美架构",却不知其演进路径。 |

| 技术炫技 | 以架构为导向而非问题为导向,引入不必要的模块,破坏系统最小性。 | "给蚊子装火箭助推器"------为标题生成引入记忆和工具链。 |

| 忽视调试 | 系统不可观测,无法获取反馈,导致失败累积且无法改进。 | 复杂链路失败无法debug。 |

| 一次性完美设计 | 违反控制论的反馈调节原则,试图开环规划,结果与实际情况脱节。 | 前期规划完备架构,却忽略了Agent的非确定性本质。 |

五、设计方式建议:构建可成长的Agent系统

1. 架构分层:核心-扩展-适配

- 核心层:单次API调用,封装最稳定的原子能力。

- 扩展层:按需添加的工具调用、记忆模块、规划器,每个模块独立且可插拔。

- 适配层:针对不同场景的提示词模板、后处理逻辑,保持灵活性。

2. 控制策略:隔离与缓冲

- 上下文隔离:每一步调用使用独立上下文,避免长链路污染。

- 失败缓冲:对非关键步骤失败设置降级策略(如跳过或使用默认值),保证核心任务完成。

- 观测点:在每个模块入口和出口埋点,记录输入、输出、耗时、Token消耗。

3. 演进路径:从MVP到复杂系统

- 阶段1:单API调用 + 简单后处理(如正则过滤)。

- 阶段2:多步串联(如先总结后翻译),但每一步仍是独立API调用,无状态管理。

- 阶段3:引入工具调用(如搜索、计算),需处理工具返回结果与LLM的交互。

- 阶段4:加入短期记忆(如对话历史),管理上下文窗口。

- 阶段5:复杂规划(如ReAct、Plan-and-Execute),但需严格评估必要性。

4. 调试工具链

- 日志追踪:为每个请求生成唯一ID,记录完整链路。

- 失败回放:可复现失败输入,便于优化提示词或调整流程。

- 性能监控:关注Token消耗、延迟、成功率,作为架构调整的依据。

六、结论

AI Agent开发不是传统软件工程的简单迁移,而是需要回归第一性原理理解其非确定性本质,并运用工程控制论实现可控演进。核心经验可概括为:

- 始于最小:从单次API调用起步,这是所有复杂度的源头。

- 需求驱动:让实际问题逼迫系统成长,而非预设架构。

- 可观测优先:没有调试能力,任何复杂度都是灾难。

- 小步迭代:通过反馈不断微调,避免大起大落。

唯有如此,Agent才能像生命体一样,从简单的单细胞逐步进化成适应复杂环境的智能系统,而非一开始就背负沉重骨架的"恐龙"。