本篇技术博文摘要 🌟

- 文章首先阐明文本预处理的必要性,并回顾了字符串操作、正则表达式等基础工具。

- 核心部分详细解析了文本向量化的全过程,包括创建向量化层、选择不同模式(如词频、TF-IDF)及处理词汇表外词(OOV)的策略。

- 进而深入探讨了分词 与子词分词 等高级技术,介绍了

tensorflow_text库的安装与应用。- 文章通过构建情感分析数据处理管道的完整示例,将理论转化为可运行的实践,演示了从原始文本到模型可用张量的端到端流程。

- 最后,针对工程实践中常见痛点,文章总结了最佳实践,并提供了多语言文本处理、性能优化等具体问题的解决方案,形成了一套从理论认知、工具使用到问题排查的完整方法论。

引言 📘

- 在这个变幻莫测、快速发展的技术时代,与时俱进是每个IT工程师的必修课。

- 我是盛透侧视攻城狮,一个"什么都会一丢丢"的网络安全工程师,目前正全力转向AI大模型安全开发新战场。作为活跃于各大技术社区的探索者与布道者,期待与大家交流碰撞,一起应对智能时代的安全挑战和机遇潮流。

上节回顾

目录

[本篇技术博文摘要 🌟](#本篇技术博文摘要 🌟)

[引言 📘](#引言 📘)

[1.何为TensorFlow 文本数据处理?](#1.何为TensorFlow 文本数据处理?)

[3.TensorFlow 文本处理工具](#3.TensorFlow 文本处理工具)

[5.1.1安装 tensorflow_text](#5.1.1安装 tensorflow_text)

[9.TensorFlow 文本数据处理总结](#9.TensorFlow 文本数据处理总结)

1.何为TensorFlow 文本数据处理?

本文将详细介绍如何使用 TensorFlow 处理文本数据,包括文本预处理、向量化和模型输入等关键步骤。

文本数据是机器学习中最常见的数据类型之一,但计算机无法直接理解原始文本,因此需要将其转换为数值形式。

TensorFlow 提供了一系列工具和 API 来简化这一过程。

2.文本预处理基础

2.1为什么需要文本预处理

- 原始文本数据通常包含许多噪声和不一致性,例如

- 大小写不一致

- 标点符号

- 停用词(如"的"、"是"等)

- 特殊字符

- 拼写错误

- 预处理的目标是将原始文本转换为干净、一致的格式,便于后续的特征提取和模型训练

3.TensorFlow 文本处理工具

- TensorFlow 提供了多个用于文本处理的模块

tf.strings:基础字符串操作tf.keras.layers.TextVectorization:文本向量化层tf.data.TextLineDataset:从文本文件创建数据集tensorflow_text:高级文本处理库(需单独安装)

3.1安装必要的库

python

import tensorflow as tf

from tensorflow.keras.layers import TextVectorization

import tensorflow_text as tf_text # 可选,用于高级处理

3.2字符串基本操作

- TensorFlow 的

tf.strings模块提供了常见的字符串操作

python

# 创建字符串张量

text = tf.constant(["TensorFlow 文本处理", "深度学习自然语言处理"])

# 转换为小写

lower_case = tf.strings.lower(text)

# 输出: ['tensorflow 文本处理', '深度学习自然语言处理']

# 分割字符串

words = tf.strings.split(text)

# 输出: [['TensorFlow', '文本处理'], ['深度学习', '自然语言处理']]

# 字符串长度

length = tf.strings.length(text)

# 输出: [10, 11]

3.3正则表达式处理

python

# 移除标点符号

def remove_punctuation(text):

return tf.strings.regex_replace(text, '[%s]' % re.escape(string.punctuation), '')

text = tf.constant("Hello, World!")

clean_text = remove_punctuation(text)

# 输出: "Hello World"

4.文本向量化

- 将文本转换为数值表示是文本处理的核心步骤。TensorFlow 提供了

TextVectorization层来实现这一功能

4.1创建向量化层

python

# 定义文本向量化层

vectorize_layer = TextVectorization(

max_tokens=10000, # 最大词汇量

output_mode='int', # 输出整数索引

output_sequence_length=50 # 统一序列长度

)

# 示例文本数据

text_dataset = tf.data.Dataset.from_tensor_slices([

"这是第一个句子",

"这是另一个不同的句子",

"添加第三个示例句子"

])

# 适配数据并构建词汇表

vectorize_layer.adapt(text_dataset)4.2向量化文本

python

# 向量化单个句子

vectorized_text = vectorize_layer("这是一个示例句子")

print(vectorized_text)

# 输出类似: [ 5, 3, 10, 8, 0, 0, ... ] (后面补零到长度50)

# 获取词汇表

vocab = vectorize_layer.get_vocabulary()

print(vocab[:10]) # 打印前10个词汇4.3向量化模式选项

TextVectorization层支持多种输出模式

| 模式 | 描述 | 适用场景 |

|---|---|---|

| 'int' | 输出单词索引 | 嵌入层输入 |

| 'binary' | 多热编码 | 小词汇量分类 |

| 'count' | 词频计数 | 词袋模型 |

| 'tf-idf' | TF-IDF 权重 | 信息检索 |

5.高级文本处理

- 对于更复杂的文本处理需求,可以使用

tensorflow_text库

5.1分词器

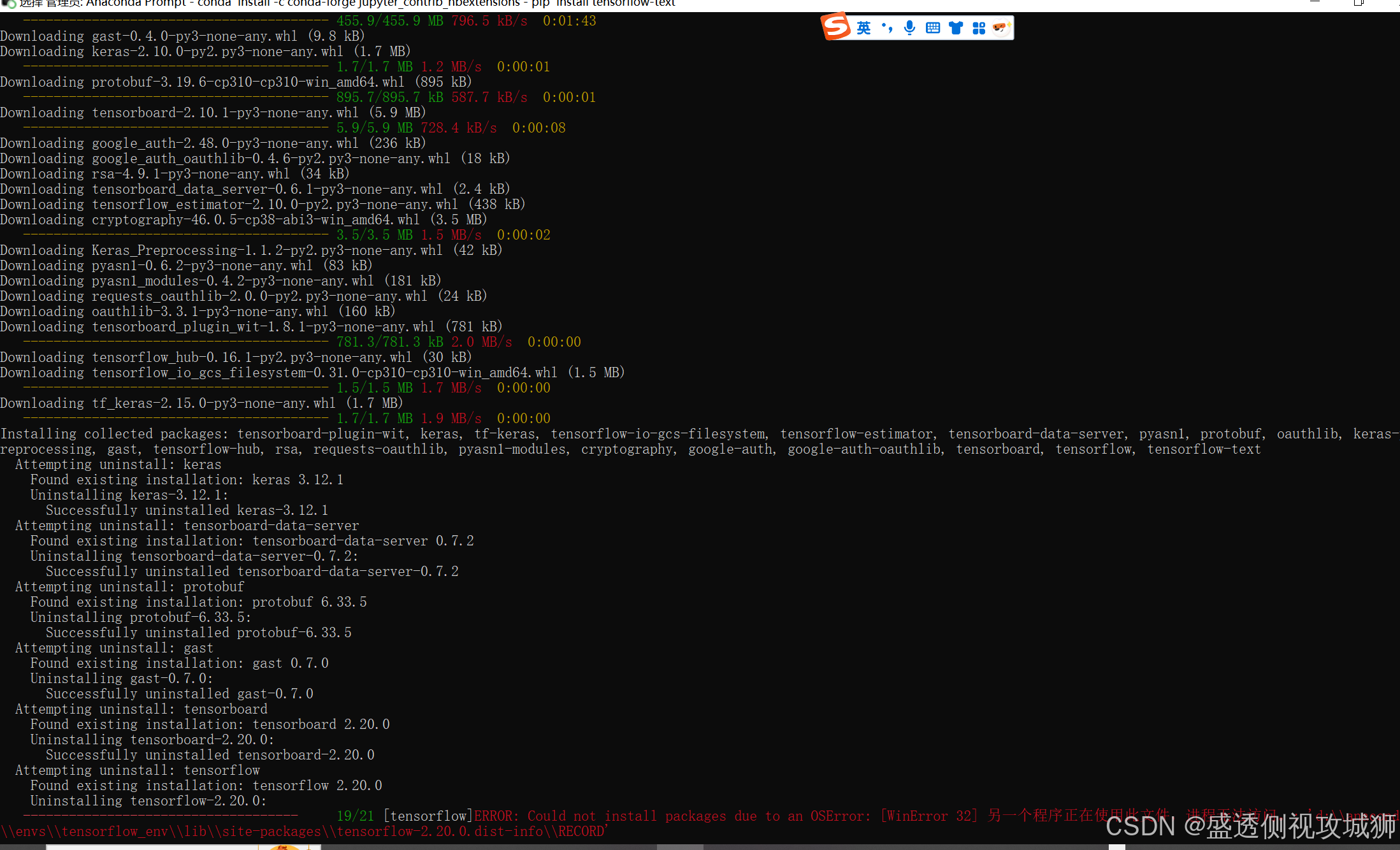

5.1.1安装 tensorflow_text

bash

pip install tensorflow-text

- 另一个程序忘记了,基本是21进度条满后是不会出错的

python

import tensorflow_text as tf_text

# 创建分词器

tokenizer = tf_text.WhitespaceTokenizer()

# 分词

tokens = tokenizer.tokenize(["TensorFlow 文本处理", "深度学习 NLP"])

print(tokens)

# 输出: [['TensorFlow', '文本处理'], ['深度学习', 'NLP']]5.2子词分词

python

# 使用 BERT 分词器

bert_tokenizer = tf_text.BertTokenizer(

vocab_lookup_table="path/to/vocab.txt",

token_out_type=tf.int32

)

tokens = bert_tokenizer.tokenize(["自然语言处理很有趣"])

print(tokens)

6.构建文本处理管道

- 完整的文本处理通常包含多个步骤,可以通过

tf.data和预处理层构建管道

python

def preprocess_text(text):

# 转换为小写

text = tf.strings.lower(text)

# 移除标点

text = tf.strings.regex_replace(text, '[^a-zA-Z0-9\u4e00-\u9fa5]', ' ')

return text

# 创建处理管道

def make_text_pipeline(text_ds, batch_size=32):

# 预处理

text_ds = text_ds.map(preprocess_text)

# 向量化

text_ds = text_ds.map(vectorize_layer)

# 批处理

text_ds = text_ds.batch(batch_size)

return text_ds

# 使用管道

processed_ds = make_text_pipeline(text_dataset)7.情感分析数据处理

python

# 1. 加载数据

(train_text, train_labels), (test_text, test_labels) = tf.keras.datasets.imdb.load_data()

# 2. 创建向量化层

max_features = 10000

sequence_length = 250

vectorize_layer = TextVectorization(

max_tokens=max_features,

output_mode='int',

output_sequence_length=sequence_length

)

# 3. 适配数据 (只使用训练数据构建词汇表)

text_ds = tf.data.Dataset.from_tensor_slices(train_text).batch(128)

vectorize_layer.adapt(text_ds)

# 4. 构建模型

model = tf.keras.Sequential([

vectorize_layer,

tf.keras.layers.Embedding(max_features, 16),

tf.keras.layers.GlobalAveragePooling1D(),

tf.keras.layers.Dense(1, activation='sigmoid')

])

# 5. 编译和训练模型

model.compile(optimizer='adam',

loss='binary_crossentropy',

metrics=['accuracy'])

model.fit(train_text, train_labels, epochs=10)8.最佳实践与常见问题及方案

8.1最佳实践

- 词汇表大小:根据数据集大小选择适当的词汇量,通常 10,000-50,000 足够

- 序列长度:分析文本长度分布,选择覆盖大多数样本的长度

- 预处理一致性:确保训练和推理时使用相同的预处理步骤

- 内存优化:对于大型数据集,使用生成器或 tf.data 的缓存功能

8.2常见问题

8.2.1对于词汇表外词(OOV)该如何处理

python

vectorize_layer = TextVectorization(

max_tokens=10000,

output_mode='int',

output_sequence_length=50,

pad_to_max_tokens=True # 确保所有输出长度一致

)8.2.2如何处理多语言文本

- 统一编码为 UTF-8

- 考虑语言特定的预处理(如中文分词)

8.2.3如何进行性能优化

- 使用

tf.data的 prefetch 和 cache- 考虑离线预处理大型数据集

9.TensorFlow 文本数据处理总结

TensorFlow 提供了全面的文本处理工具链,从基础字符串操作到高级向量化技术。

通过合理使用这些工具,可以高效地将原始文本转换为适合深度学习模型输入的数值表示。关键步骤包括:

- 文本清洗和标准化

- 选择合适的向量化策略

- 构建可复用的处理管道

- 与模型训练流程集成

欢迎各位彦祖与热巴畅游本人专栏与技术博客

你的三连是我最大的动力

点击➡️指向的专栏名即可闪现

➡️计算机组成原理****

➡️操作系统

➡️****渗透终极之红队攻击行动********

➡️ 动画可视化数据结构与算法

➡️ 永恒之心蓝队联纵合横防御

➡️****华为高级网络工程师********

➡️****华为高级防火墙防御集成部署********

➡️ 未授权访问漏洞横向渗透利用

➡️****逆向软件破解工程********

➡️****MYSQL REDIS 进阶实操********

➡️****红帽高级工程师

➡️红帽系统管理员********

➡️****HVV 全国各地面试题汇总********