本篇技术博文摘要 🌟

- 文章以环境准备开篇,详细说明了必要的Python库安装、关键模块导入以及TensorFlow版本确认步骤。

- 随后,聚焦于经典的IMDB电影评论数据集 ,系统阐述了数据加载、探索性分析(如查看数据维度与标签分布)以及关键的文本数据预处理流程。

- 在模型构建 核心环节,指南深入解析了适用于文本分类的神经网络架构设计(如嵌入层、全局池化与全连接层的组合),并逐一说明了模型编译时损失函数、优化器与评估指标的选择与参数配置。

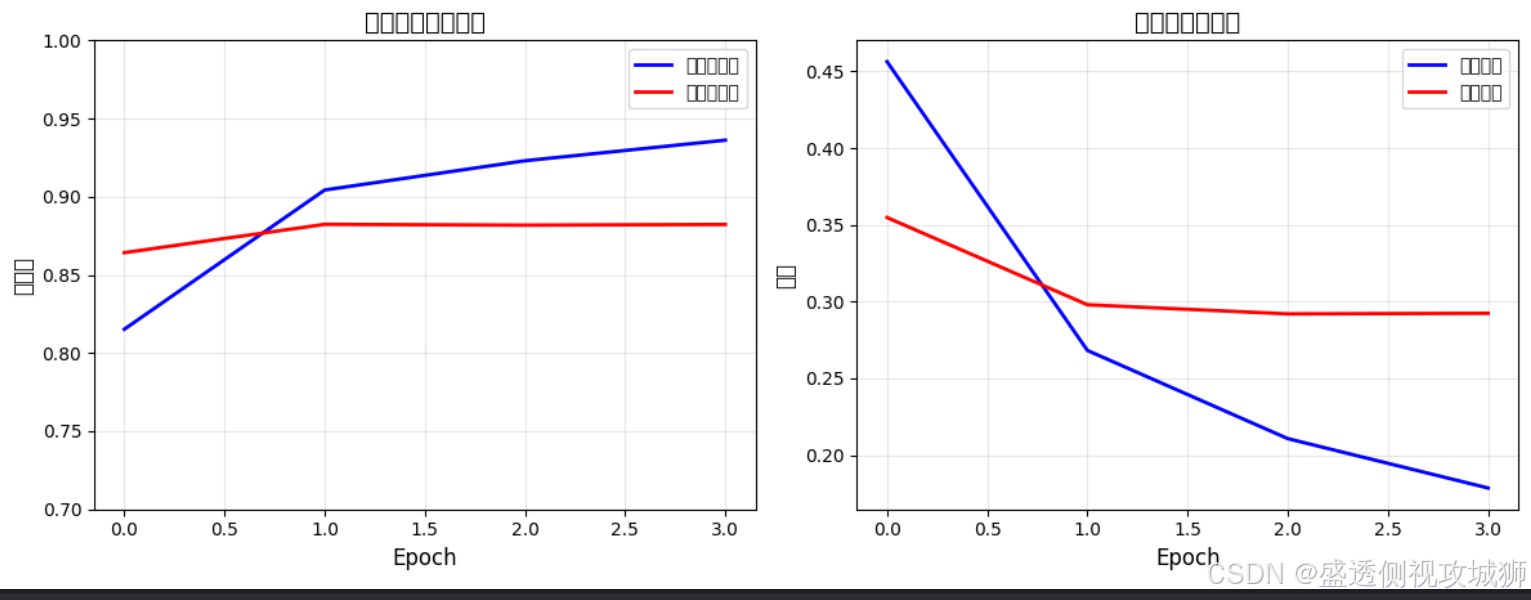

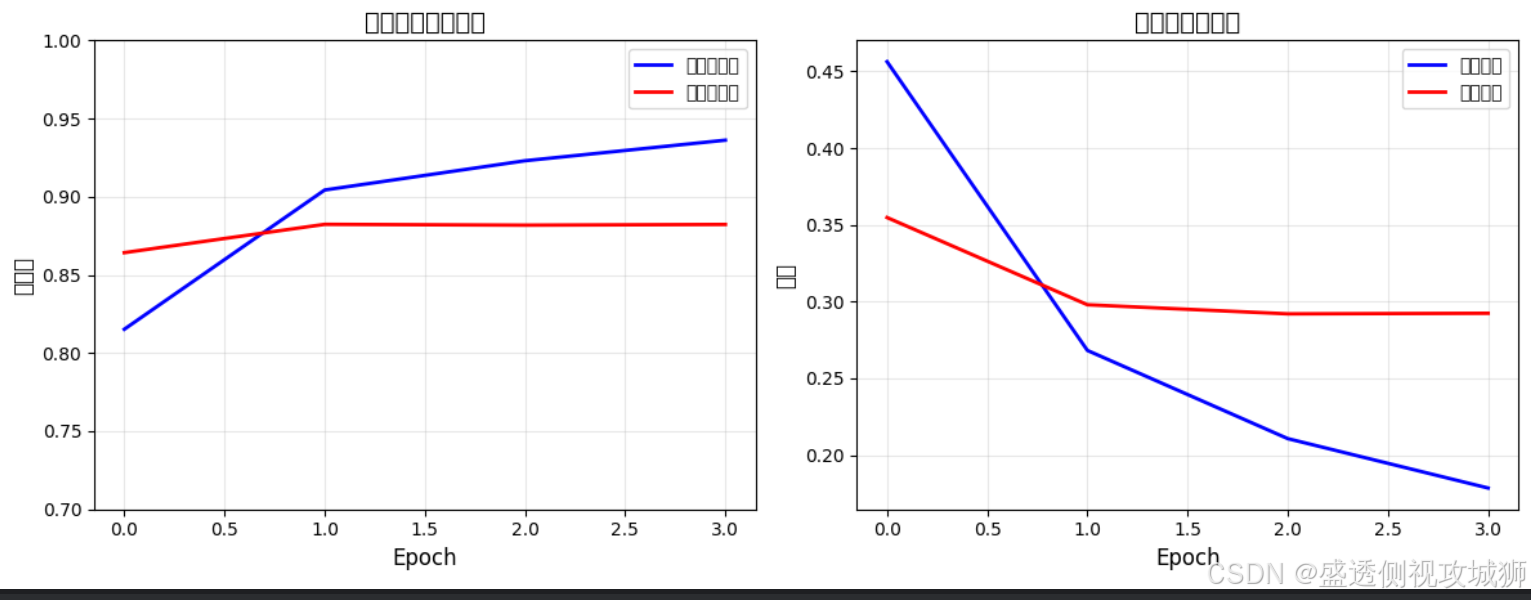

- 训练模型部分不仅介绍了验证集的创建方法,还完整展示了训练过程的执行、监控以及通过可视化工具(如准确率与损失曲线)对训练结果进行分析的技巧。

- 模型训练完成后,文章进一步指导读者进行严格的模型评估与预测,以检验其在实际测试集上的泛化能力与实用价值。

- 最后,本文提供了完整的项目代码汇总 ,并针对模型性能提升给出了切实可行的优化建议,涵盖网络架构调整、正则化技术应用、优化器对比选择以及文本预处理流程的改进策略,形成从理论到实践、从基础到优化的闭环指导。

引言 📘

- 在这个变幻莫测、快速发展的技术时代,与时俱进是每个IT工程师的必修课。

- 我是盛透侧视攻城狮,一个"什么都会一丢丢"的网络安全工程师,目前正全力转向AI大模型安全开发新战场。作为活跃于各大技术社区的探索者与布道者,期待与大家交流碰撞,一起应对智能时代的安全挑战和机遇潮流。

上节回顾

目录

[本篇技术博文摘要 🌟](#本篇技术博文摘要 🌟)

[引言 📘](#引言 📘)

[1.TensorFlow 实战之文本分类项目](#1.TensorFlow 实战之文本分类项目)

1.TensorFlow 实战之文本分类项目

- 文本分类是自然语言处理(NLP)中的基础任务,指将文本文档自动分类到一个或多个预定义类别中。在实际应用中,文本分类被广泛用于

- 垃圾邮件检测

- 情感分析

- 新闻分类

- 客服对话分类

- 产品评论分类

2.项目步骤通常如下:

- 数据准备与预处理

- 文本向量化

- 模型构建

- 模型训练

- 模型评估

- 模型部署

3.环境准备

3.1安装必要Python库

- 开始项目前,得确保已安装以下Python库

python

pip install tensorflow

pip install numpy

pip install pandas

pip install matplotlib

3.2导入必要的库

python

import tensorflow as tf

from tensorflow.keras import layers

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt3.3检查TensorFlow版本

python

print(tf.__version__)

4.数据集准备-IMDB电影评论数据集

- 使用IMDB电影评论数据集,这是一个经典的二分类数据集,包含50,000条电影评论,标记为正面(1)或负面(0)评价

4.1加载数据集及示例

python

# 从TensorFlow数据集加载IMDB数据

imdb = tf.keras.datasets.imdb

# 只保留前10000个最常出现的单词

(train_data, train_labels), (test_data, test_labels) = imdb.load_data(num_words=10000)4.2数据探索及示例

- 如何来查看数据格式

python

print("训练样本数: {}, 测试样本数: {}".format(len(train_data), len(test_data)))

# 输出:训练样本数: 25000, 测试样本数: 25000

# 查看第一条评论

print(train_data[0])

# 输出:[1, 14, 22, 16, 43, 530, 973, 1622, 1385, 65, ...]

4.3数据预处理及示例

- 将整数序列转换为多热编码

python

def vectorize_sequences(sequences, dimension=10000):

results = np.zeros((len(sequences), dimension))

for i, sequence in enumerate(sequences):

results[i, sequence] = 1.

return results

x_train = vectorize_sequences(train_data)

x_test = vectorize_sequences(test_data)

# 将标签转换为浮点数

y_train = np.asarray(train_labels).astype('float32')

y_test = np.asarray(test_labels).astype('float32')

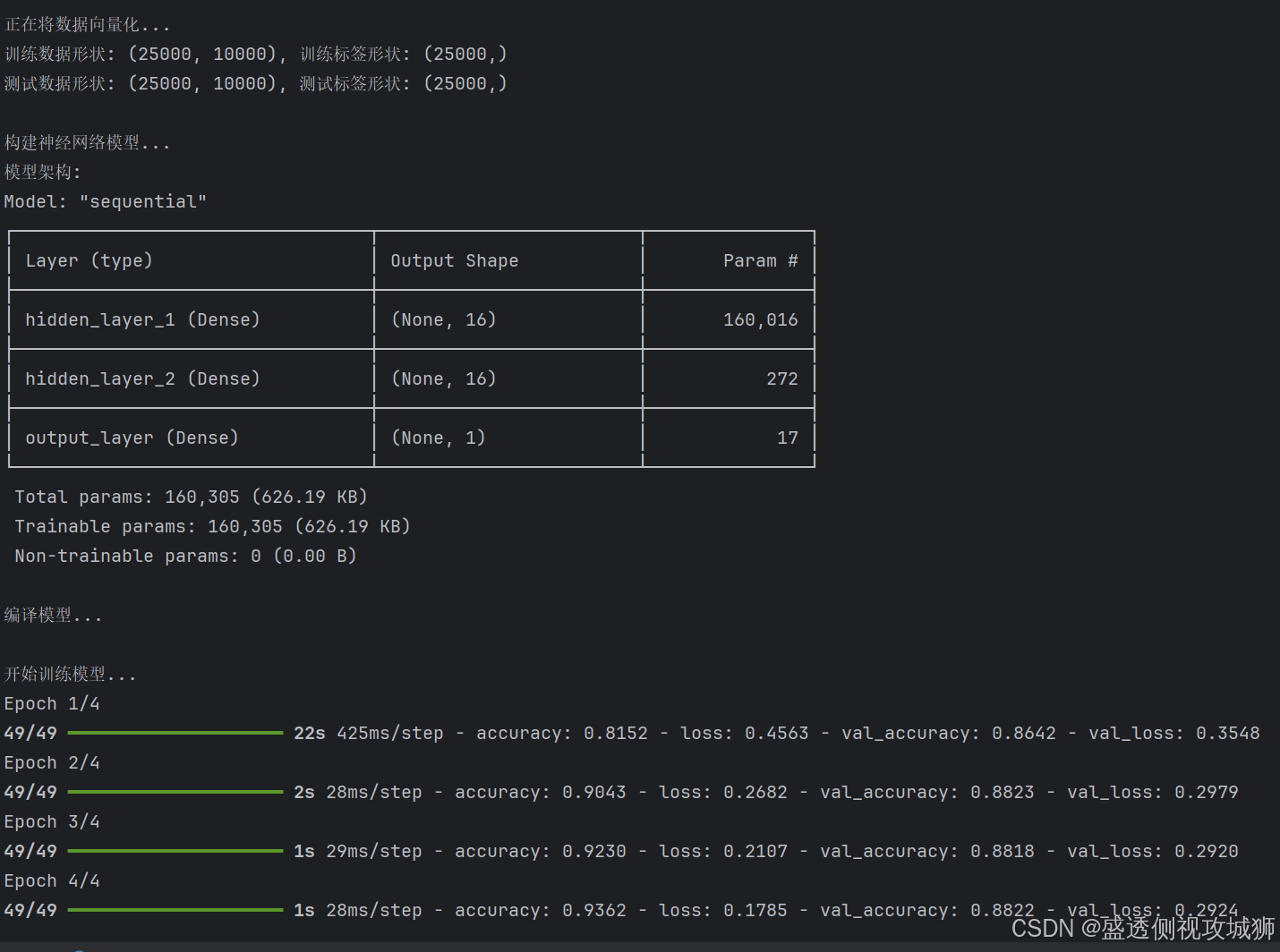

5.构建模型

5.1模型架构及示例

- 我们将构建一个简单的全连接神经网络

python

model = tf.keras.Sequential([

layers.Dense(16, activation='relu', input_shape=(10000,)),

layers.Dense(16, activation='relu'),

layers.Dense(1, activation='sigmoid')

])5.2模型编译及示例

python

model.compile(optimizer='rmsprop',

loss='binary_crossentropy',

metrics=['accuracy'])5.2.1参数说明

optimizer: 优化器,控制学习过程loss: 损失函数,衡量模型预测与真实标签的差异metrics: 评估指标,监控训练和测试步骤

6.训练模型

6.1创建验证集及示例

python

x_val = x_train[:10000]

partial_x_train = x_train[10000:]

y_val = y_train[:10000]

partial_y_train = y_train[10000:]6.2训练过程及示例

python

history = model.fit(partial_x_train,

partial_y_train,

epochs=20,

batch_size=512,

validation_data=(x_val, y_val))6.3训练结果可视化及示例

python

history_dict = history.history

# 绘制训练损失和验证损失

plt.plot(history_dict['loss'], 'bo', label='Training loss')

plt.plot(history_dict['val_loss'], 'b', label='Validation loss')

plt.title('Training and validation loss')

plt.xlabel('Epochs')

plt.ylabel('Loss')

plt.legend()

plt.show()

# 绘制训练准确率和验证准确率

plt.plot(history_dict['accuracy'], 'bo', label='Training acc')

plt.plot(history_dict['val_accuracy'], 'b', label='Validation acc')

plt.title('Training and validation accuracy')

plt.xlabel('Epochs')

plt.ylabel('Accuracy')

plt.legend()

plt.show()7.模型评估与预测

7.1评估测试集性能及示例

python

results = model.evaluate(x_test, y_test)

print(results)

# 输出示例:[0.3245, 0.8732] 表示损失和准确率7.2进行预测及示例

python

predictions = model.predict(x_test)

print(predictions[0]) # 第一条测试样本的预测概率

8.项目代码汇总

python

import os

# 设置环境变量以减少TensorFlow日志输出

os.environ['TF_CPP_MIN_LOG_LEVEL'] = '2' # 只显示错误和警告

os.environ['TF_ENABLE_ONEDNN_OPTS'] = '0' # 禁用oneDNN自定义操作提示

import tensorflow as tf

from tensorflow.keras import layers, datasets

import numpy as np

import matplotlib.pyplot as plt

# 1. 加载IMDB电影评论数据集

print("加载IMDB电影评论数据集...")

imdb = datasets.imdb

(train_data, train_labels), (test_data, test_labels) = imdb.load_data(num_words=10000)

print(f"训练样本数: {len(train_data)}, 测试样本数: {len(test_data)}")

# 2. 将整数序列转换为one-hot编码向量

def vectorize_sequences(sequences, dimension=10000):

"""将整数序列转换为one-hot编码向量"""

results = np.zeros((len(sequences), dimension))

for i, sequence in enumerate(sequences):

results[i, sequence] = 1. # 将索引位置设置为1

return results

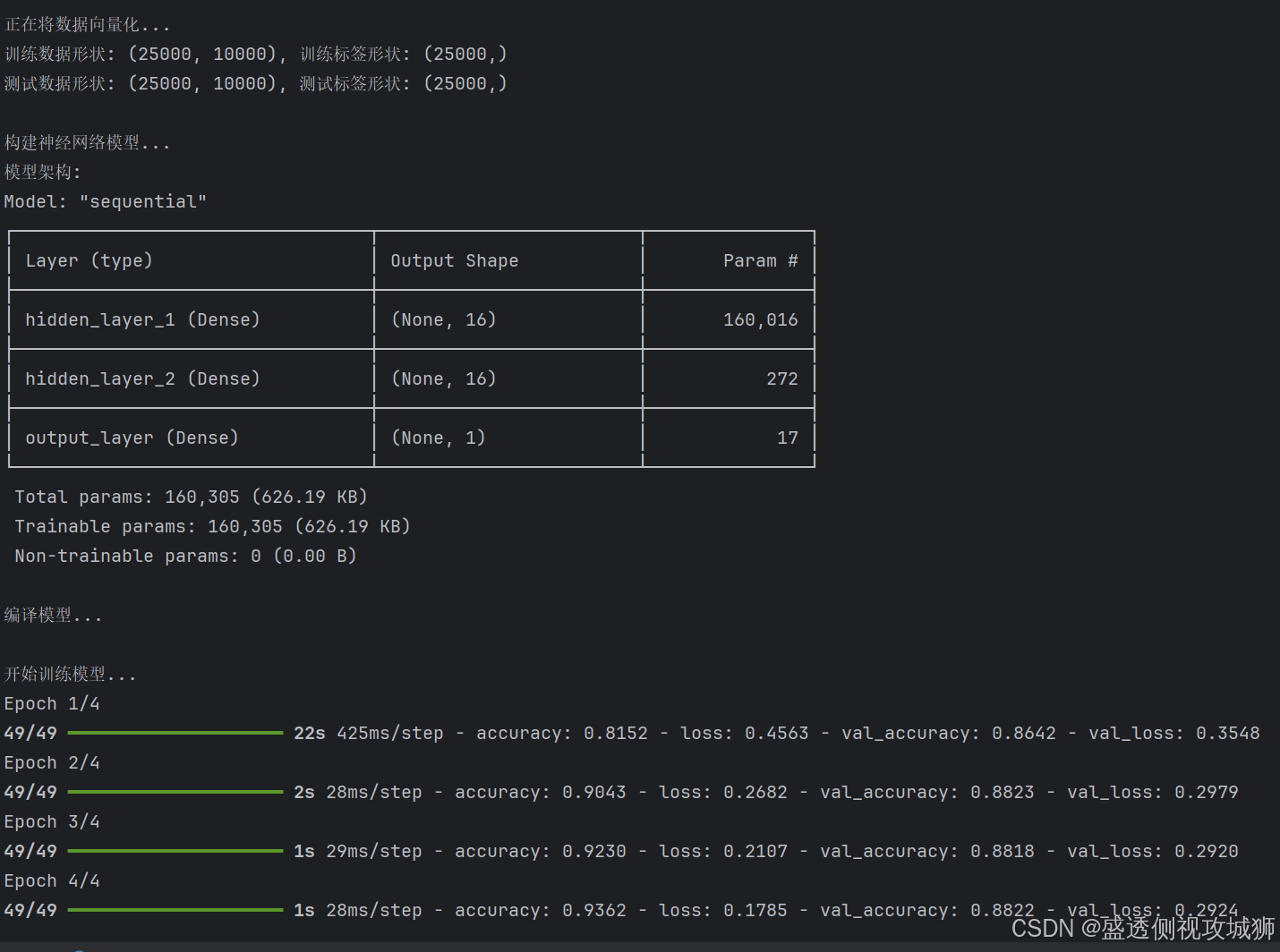

print("\n正在将数据向量化...")

x_train = vectorize_sequences(train_data, dimension=10000)

x_test = vectorize_sequences(test_data, dimension=10000)

y_train = np.asarray(train_labels).astype('float32')

y_test = np.asarray(test_labels).astype('float32')

print(f"训练数据形状: {x_train.shape}, 训练标签形状: {y_train.shape}")

print(f"测试数据形状: {x_test.shape}, 测试标签形状: {y_test.shape}")

# 3. 构建神经网络模型

print("\n构建神经网络模型...")

# 修正版本:使用Input层作为第一层

model = tf.keras.Sequential([

# 输入层:指定输入形状为10000维的向量

layers.Input(shape=(10000,), name='input_layer'),

# 第一个全连接层:16个神经元,ReLU激活函数

layers.Dense(16, activation='relu', name='hidden_layer_1'),

# 第二个全连接层:16个神经元,ReLU激活函数

layers.Dense(16, activation='relu', name='hidden_layer_2'),

# 输出层:1个神经元,Sigmoid激活函数(用于二分类)

layers.Dense(1, activation='sigmoid', name='output_layer')

])

# 显示模型架构

print("模型架构:")

model.summary()

# 4. 编译模型

print("\n编译模型...")

model.compile(

optimizer='rmsprop', # 优化器:RMSprop

loss='binary_crossentropy', # 损失函数:二元交叉熵

metrics=['accuracy'] # 评估指标:准确率

)

# 5. 训练模型

print("\n开始训练模型...")

history = model.fit(

x_train, y_train, # 训练数据和标签

epochs=4, # 训练轮数

batch_size=512, # 批大小

validation_data=(x_test, y_test), # 验证数据

verbose=1 # 显示训练进度

)

# 6. 绘制训练历史

print("\n绘制训练历史图表...")

# 创建子图

fig, (ax1, ax2) = plt.subplots(1, 2, figsize=(12, 5))

# 绘制准确率变化

ax1.plot(history.history['accuracy'], 'b-', label='训练准确率', linewidth=2)

ax1.plot(history.history['val_accuracy'], 'r-', label='验证准确率', linewidth=2)

ax1.set_xlabel('Epoch', fontsize=12)

ax1.set_ylabel('准确率', fontsize=12)

ax1.set_title('训练和验证准确率', fontsize=14)

ax1.set_ylim([0.7, 1.0])

ax1.legend()

ax1.grid(True, alpha=0.3)

# 绘制损失变化

ax2.plot(history.history['loss'], 'b-', label='训练损失', linewidth=2)

ax2.plot(history.history['val_loss'], 'r-', label='验证损失', linewidth=2)

ax2.set_xlabel('Epoch', fontsize=12)

ax2.set_ylabel('损失', fontsize=12)

ax2.set_title('训练和验证损失', fontsize=14)

ax2.legend()

ax2.grid(True, alpha=0.3)

plt.suptitle('IMDB情感分析模型训练历史', fontsize=16, y=1.02)

plt.tight_layout()

plt.show()

# 7. 评估模型

print("\n评估模型在测试集上的表现...")

test_loss, test_accuracy = model.evaluate(x_test, y_test, verbose=0)

print(f"测试损失: {test_loss:.4f}")

print(f"测试准确率: {test_accuracy:.4f}")

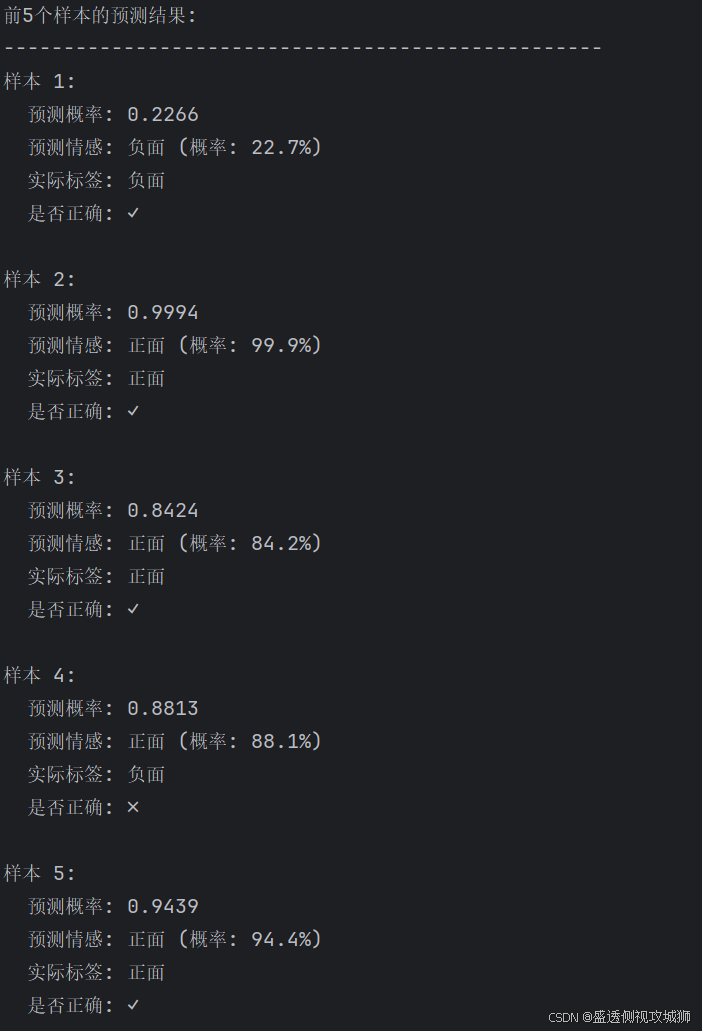

# 8. 进行预测

print("\n对测试集进行预测...")

predictions = model.predict(x_test[:10]) # 只预测前10个样本

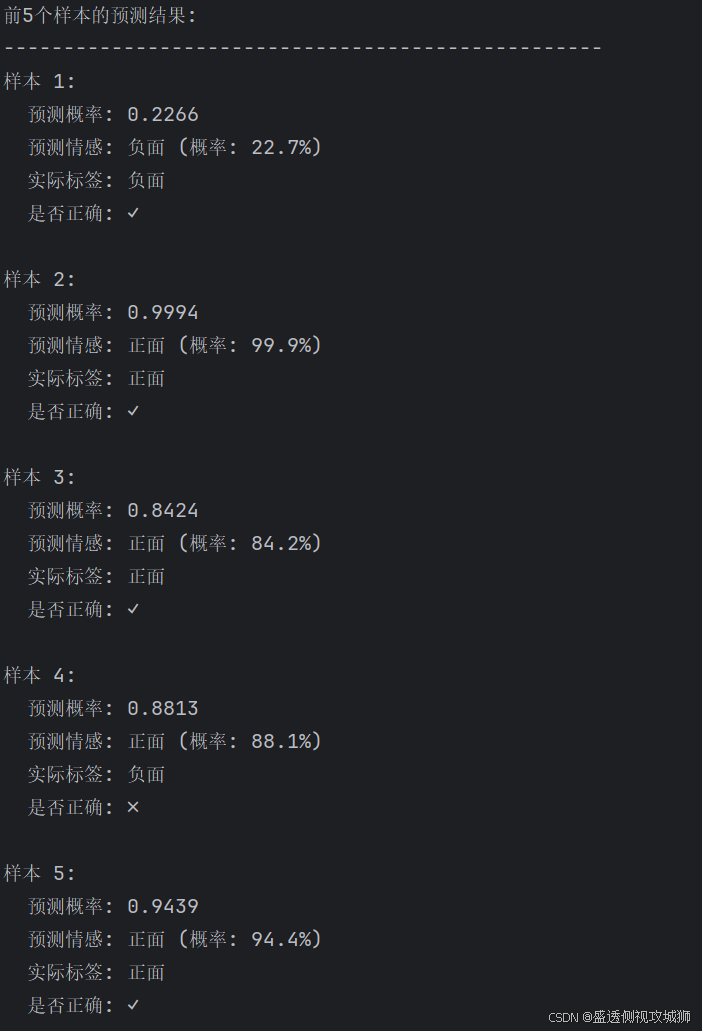

# 显示前5个样本的预测结果

print("\n前5个样本的预测结果:")

print("-" * 50)

for i in range(5):

probability = predictions[i][0]

actual_label = y_test[i]

predicted_label = 1 if probability > 0.5 else 0

sentiment = "正面" if predicted_label == 1 else "负面"

print(f"样本 {i + 1}:")

print(f" 预测概率: {probability:.4f}")

print(f" 预测情感: {sentiment} (概率: {probability * 100:.1f}%)")

print(f" 实际标签: {'正面' if actual_label == 1 else '负面'}")

print(f" 是否正确: {'✓' if predicted_label == actual_label else '✗'}")

print()

# 9. 保存模型

print("保存模型...")

model.save('imdb_sentiment_model.h5')

print("模型已保存为 'imdb_sentiment_model.h5'")

# 10. 加载模型并进行测试

print("\n测试加载的模型...")

loaded_model = tf.keras.models.load_model('imdb_sentiment_model.h5')

# 测试加载的模型

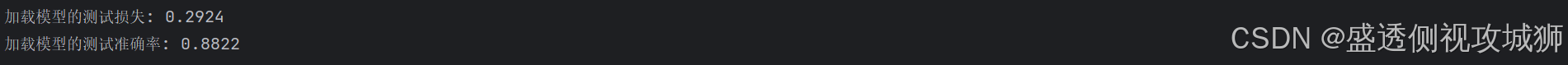

test_loss_loaded, test_accuracy_loaded = loaded_model.evaluate(x_test, y_test, verbose=0)

print(f"加载模型的测试损失: {test_loss_loaded:.4f}")

print(f"加载模型的测试准确率: {test_accuracy_loaded:.4f}")

# 11. 使用模型进行单个评论的预测

def predict_sentiment(text_vector, model):

"""预测单个文本向量的情感"""

prediction = model.predict(np.array([text_vector]), verbose=0)

probability = prediction[0][0]

return probability

# 创建一个简单的测试向量

print("\n自定义测试...")

# 创建一个随机向量(实际应用中应该是经过预处理的文本向量)

test_vector = np.random.rand(10000)

# 设置前10个位置为1(模拟有10个高频词)

test_vector[:10] = 1

probability = predict_sentiment(test_vector, model)

print(f"自定义测试向量的情感概率: {probability:.4f}")

print(f"情感倾向: {'正面' if probability > 0.5 else '负面'}")

print("\n" + "=" * 50)

print("IMDB情感分析项目完成!")

print("=" * 50)

9.模型优化建议

9.1调整网络架构

- 增加或减少隐藏层数量

- 尝试不同的神经元数量

- 使用不同的激活函数

9.2正则化技术

- 添加Dropout层防止过拟合

- 使用L1/L2正则化

9.3优化器选择

- 尝试Adam、SGD等其他优化器

- 调整学习率

9.4文本预处理改进

- 使用词嵌入(Embedding)代替多热编码

- 尝试预训练词向量(如Word2Vec, GloVe)

欢迎各位彦祖与热巴畅游本人专栏与技术博客

你的三连是我最大的动力

点击➡️指向的专栏名即可闪现

➡️计算机组成原理****

➡️操作系统

➡️****渗透终极之红队攻击行动********

➡️ 动画可视化数据结构与算法

➡️ 永恒之心蓝队联纵合横防御

➡️****华为高级网络工程师********

➡️****华为高级防火墙防御集成部署********

➡️ 未授权访问漏洞横向渗透利用

➡️****逆向软件破解工程********

➡️****MYSQL REDIS 进阶实操********

➡️****红帽高级工程师

➡️红帽系统管理员********

➡️****HVV 全国各地面试题汇总********